递推最小二乘法算法

递推最小二乘法推导(RLS)——全网最简单易懂的推导过程

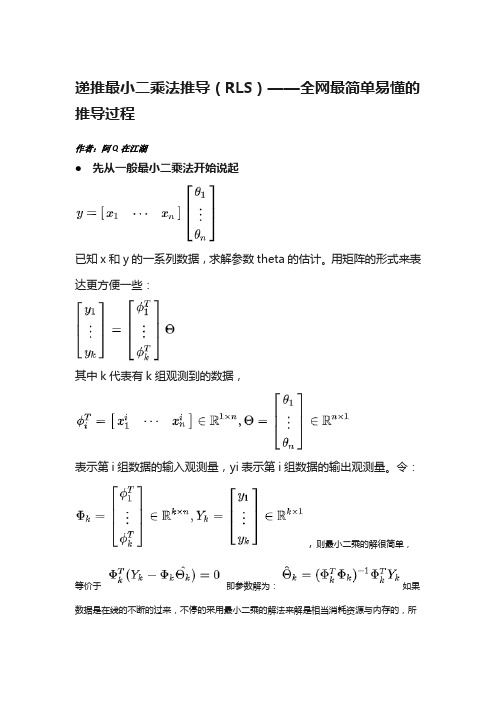

递推最小二乘法推导(RLS)——全网最简单易懂的推导过程作者:阿Q在江湖先从一般最小二乘法开始说起已知x和y的一系列数据,求解参数theta的估计。

用矩阵的形式来表达更方便一些:其中k代表有k组观测到的数据,表示第i组数据的输入观测量,yi表示第i组数据的输出观测量。

令:,则最小二乘的解很简单,等价于即参数解为:如果数据是在线的不断的过来,不停的采用最小二乘的解法来解是相当消耗资源与内存的,所以要有一种递推的形式来保证对的在线更新。

进一步推导出递推最小二乘法(RLS)我们的目的是从一般最小二乘法的解推导出的递推形式。

一定要理解这里的下标k代表的意思,是说在有k组数据情况下的预测,所以k比k-1多了一组数据,所以可以用这多来的一组数据来对原本的估计进行修正,这是一个很直观的理解。

下面是推导过程:先看一般最小二乘法的解下面分别对和这两部分进行推导变换,令得到下面公式(1)下面来变换得到公式(2)下面再来,根据一般最小二乘法的解,我们知道下式成立,得到公式(3)(注:后续公式推导用到)好了,有了上面最主要的三步推导,下面就简单了,将上面推导的结果依次代入公式即可:至此,终于变成的形式了。

通过以上推导,我们来总结一下上面RLS方程:注:以上公式7中,左边其实是根据公式1,右边I为单位矩阵公式(5)和(7)中,有些文献资料是用右边的方程描述,实际上是等效的,只需稍微变换即可。

例如(5)式右边表达式是将公式(1)代入计算的。

为简化描述,我们下面还是只讨论左边表达式为例。

上面第7个公式要计算矩阵的逆,求逆过程还是比较复杂,需要用矩阵引逆定理进一步简化。

矩阵引逆定理:最终RLS的方程解为:好了,至此完毕!以上应该算是最简单的推导过程了,相信都能看得懂了。

后续有时间将增加带遗忘因子的RLS推导步骤,毕竟工程上的实际用途很多用此方法,比如在线辨识电池系统等效电路模型的参数,用于卡尔曼滤波算法估算SOC……。

递推最小二乘辨识概要

N 1

输 出 信 息

PN

递推最小二乘 参数估计算法

PN 1

开始 产生输入数据u和 输出数据z

初始化P(0)、θ(0)、w和ε

计算P(k),θ(k)和K(k)

(k 1) (k )

P(k 1) P(k )

否

max

i

ˆ (k ) ˆ ( k 1) i i ˆ ( k 1) i

D. 数据饱和

在辨识递推计算过程中,协方差矩阵P(k)随着递推的进程将衰减 很快,此时算法的增益矩阵K(k)也急剧衰减,使得新数据失去对参 数估计值的修正能力. 这种现象称为数据饱和. 因此需要考虑修正方案,以保持新数据对参数估计值的一定的 修正能力,使得能得到更准确的参数估计值,或能适应对慢时 变参数的辨识.

P(k ) [ P -1 (k -1) (k -1) (k -1)]-1

(3)

由式(3)和矩阵反演公式(4),可得P(k)的如下递推计算式

P (k ) P (k - 1) - P (k - 1) (k - 1)[1 (k - 1) P (k - 1) (k - 1)] 1 (k - 1) P (k - 1) P (k - 1) (k - 1) (k - 1) I P ( k - 1) 1 (k - 1) P (k - 1) (k - 1) (5)

选择如下的辨识模型进行递推最小二乘参数辨识。

z(k ) a1 z(k 1) a2 z(k 2) b1u(k 1) b2u(k 2) V (k )

Matlab 程序: %最小二乘的递推算法 %Z(k+2)=1.5*Z(k+1)-0.7*Z(k)+u(k+1)+0.5*u(k)+v(k) %======================================== clear clc %==========400 个产生M 序列作为输入=============== x=[0 1 0 1 1 0 1 1 1]; %initial value n=403; %n 为脉冲数目 M=[]; %存放M 序列 for i=1:n temp=xor(x(4),x(9)); M(i)=x(9); for j=9:-1:2 x(j)=x(j-1); end x(1)=temp; end %===========产生均值为0,方差为1 的高斯白噪声========= v=randn(1,400); %==============产生观测序列z=================

递推最小二乘法_协方差矩阵_概述说明以及解释

递推最小二乘法协方差矩阵概述说明以及解释1. 引言1.1 概述在统计学和计量经济学中,递推最小二乘法(Recursive Least Squares,简称RLS)是一种常用的参数估计方法。

它通过不断更新样本数据进行参数的估计,并且可以适用于非静态数据场景。

协方差矩阵是统计分析中重要的概念,它描述了变量之间的线性关系强度和方向,并且在许多领域具有广泛应用。

1.2 文章结构本文首先介绍递推最小二乘法的定义和原理,在此基础上详细解释算法的步骤以及其应用领域。

接着,我们将引入协方差矩阵的概念并介绍其计算方法,同时探讨了它在实际问题中所起到的作用和应用场景。

最后,我们将对递推最小二乘法与协方差矩阵之间的关系进行解释,并通过实例分析来说明它们如何相互影响。

1.3 目的本文旨在全面介绍递推最小二乘法和协方差矩阵,并深入探讨它们之间的联系。

通过对这两个概念及其应用的理解,我们可以更好地理解参数估计方法和变量间关系的描述与分析。

此外,我们还将展望相关领域未来可能的研究方向,以促进学术和实践的进一步发展。

2. 递推最小二乘法2.1 定义和原理:递推最小二乘法是一种用于估计线性模型参数的方法。

它可以通过历史数据的不断更新来逐步拟合模型,以使得估计值与观测值之间的误差达到最小化。

该方法可以被形式化地描述为以下步骤:1. 初始化模型参数的初始值。

2. 从历史数据中选择一个样本,并使用当前参数估计出该样本对应的输出值。

3. 计算该样本的预测误差。

4. 根据预测误差对参数进行调整,使得预测误差尽量减小。

5. 重复步骤2至4,直到所有样本都被处理过一遍,或者满足终止条件。

递推最小二乘法是基于最小二乘原理,即将真实观测值与模型预测值之间的差异平方求和并最小化这个目标函数。

通过迭代地更新参数,递推最小二乘法可以逐渐优化模型,并获得更准确的参数估计。

2.2 算法步骤:具体而言,在每次迭代中,递推最小二乘法按照以下步骤进行操作:1. 根据历史数据选择一个样本,并根据当前的参数估计出预测值。

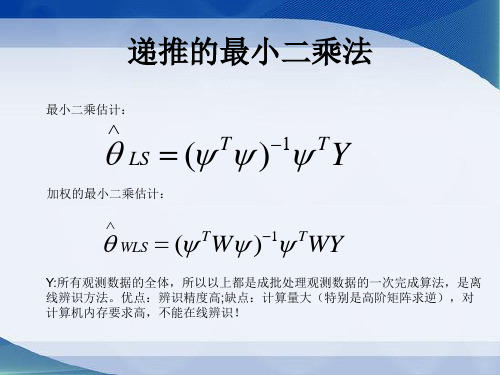

递推的最小二乘法

式中

….(2)

W (N ) 0 W ( N 1) ................ ( N 1) 0

.

0 ,其中 为很大的正实数(比如1010) .

(N ) ( N 1) ........... T ( N 1)

( N , ) ( N 1, ) ........... e ( N 1, )

T ( N 1) y( N ) y( N 1) ... y( N n 1) u( N ) u( N 1) ... u( N n 1)

1、递推的最小二乘法基本思想:

• 本次(新)的估计值

(k )

=上次(老)的估计值

(k 1)

+修正项

•

可以观察随着时间的推移,新的输入、输出信息不断增加的情况下,参数估计的变化情况,特别适用于 在线实时辨识。

设原先得到的参数估计用 WLS ( N ) 表示,则

WLS ( N ) ( T ( N )W ( N ) ( N )) 1 T ( N )W ( N )Y ( N )

从

WLS ( N )

到

WLS ( N 1)

的递推公式过程(略P191)

递推公式:

T ★ ① WLS ( N 1) WLS ( N ) L( N 1) y ( N 1) ( N 1) WLS ( N ) ② L( N 1) P( N 1) ( N 1) ( N 1)

几种最小二乘法递推算法的小结

几种最小二乘法递推算法的小结最小二乘法是一种常见的参数估计方法,广泛应用于各个领域的数学和统计模型的拟合问题。

在实际应用中,我们常常需要递推地计算最小二乘法的结果,以便能够在实时数据到来的情况下,快速地更新参数估计值。

以下是几种常见的最小二乘法递推算法的小结。

1. 递推最小二乘法(Recursive least squares, RLS)递推最小二乘法是一种在线参数估计方法,可以在每次新数据到来时,快速地更新参数估计值。

RLS算法利用递推的方式,将历史数据和新数据的信息结合起来,从而得到最新的参数估计值。

该算法基于递归迭代过程,迭代公式中的权重矩阵可以由历史数据的协方差矩阵递推得到。

递推最小二乘法具有良好的收敛性和较低的计算复杂度。

2.递推最小二乘法的变种算法(RLS的变种算法)递推最小二乘法的变种算法是对传统的RLS算法进行改进和优化的方法。

其中,经典的改进算法有递归正交最小二乘法(Recursive orthogonal least squares, ROLS)和递推快速QR分解法(Recursive fast QR factorization, RFQR)。

ROLS算法通过引入正交化处理,解决了经典RLS算法中信号相关性较高时,参数估计不稳定的问题。

RFQR算法则通过对历史数据进行快速QR分解的方法,进一步提高了算法的计算速度,并降低了计算复杂度。

3. 渐进最小二乘法(Asymptotic least squares, ALS)渐进最小二乘法是一种常见的在线参数估计算法,用于解决参数估计问题的收敛速度较慢的情况。

ALS算法通过估计参数的渐进协方差矩阵,然后利用资料增益矩阵计算最新的参数估计值。

由于ALS算法不需要存储和计算全部历史数据的相关矩阵,因此可以在实时数据到来的情况下,快速地进行参数估计。

4. 数据辅助递推最小二乘法(Data-augmented recursive least squares, DARLS)数据辅助递推最小二乘法是一种常见的递推最小二乘法的改进算法,适用于当历史数据缺失或者不完整时。

递推最小二乘法

取二 E ( ) 为 的 合目 函 相 的 的 合目 函 : =, j 作 新 拟 标 数, 应 新 拟 标 数为 Dw

jO ( ) J 艺z艺:( 】 习回 ) Q 加 司一 一 e } j = 。+ G 阶川 = D叭

权最小二乘拟合。 (3 ) (3 0 把式( .和( .) 3 9 3 1 代入式(3 3 . . ( .) 3 1 则有: .

度函数。 下面仅举出第一种计算相关函数法的计算过程。 用这个方法进行相关分析辨识

系统模型的计算分为三个步骤:

1 根 输 和 出 随 数 计 相 函 R )互 关 数 = ) ) 据 入 输 的 机 据 算自 关 数 , 和 相 函 R令; , 卜 r

2 求 ,) R(的 立 变 Sj 凡行) ) *: s)傅 叶 换 x 、 (和 3 , r () 。; ) 0 和

把 宪G 做型,把一实值模值差 “ O 模值并每点测与型之 j 州 ( )

: E . = J j() =( , - + , j )P ( Q. -

( ..1 331 )

称为拟合误 差,再取全部采样频率。上的 拟合误差s 平方和厂作为 , 的 拟合目 标函数。

,rn 、。、下不二不} '-厂 J ‘ Bol }. v\ 、 G , l . W厂 _ _ : Vw } k 一YE t-L]1 G ) ' 二 ' U i - -, ' i

二 ( + ( v } jr ) u mm )

( ..0 33 1 )

现要定数, 以d2 由j(所示频特 在 参bi, i., ’ j 表的率性 确 p. 及, 使 ( . bm . 得 劣 ) . . b dn . 0 d

函 与 验 得 频 特 加 + ) 接 如 把P 和Q , 做 测 而 数 实 求 的 率 性p ) .最 近。 果 阮) () 实 值, M .叫

递推最小二乘法

递推最小二乘法递推最小二乘法是一种避免精度损失的迭代计算方法,在最小二乘法的基础上加以改进,主要用于拟合复杂的数据,解决拟合时出现精度下降问题。

一、什么是递推最小二乘法递推最小二乘法是一种迭代计算方法,利用多项式曲线拟合曲线数据,对于某个曲线,只需要实施最小二乘法的迭代计算,而不需要考虑精度的损失。

递推最小二乘法的主要工作是根据给定的拟合曲线,把它拟合到数据集中,从而使数据集距离拟合曲线最小。

二、递推最小二乘法的原理递推最小二乘法的核心原理是,利用多项式拟合曲线,按照“最小二乘法”的原理,以当前拟合曲线为参照,不断进行前进和后退,以达到拟合曲线将数据集中的数据最佳拟合的目的。

这个最佳拟合目标就是实现拟合曲线与数据集之间的最小误差,其中,最小误差就是拟合曲线与实际数据集之间的最小差值。

递推最小二乘法的实现方式主要有两种,一种是基于递推的方式,另一种是基于函数的方式。

前者大致的实现方法是:先计算出多项式拟合曲线的每一个系数,然后再利用这些系数计算出多项式拟合曲线的最终拟合曲线,最后比较拟合曲线与实际数据集之间的实际差异,根据差异再调整系数,不断循环,直到最后拟合曲线与实际数据集之间的实际差异达到预期值为止。

函数的实现方式也很类似,只是在计算过程中,会使用函数的方式,将拟合曲线的系数表示为函数的形式,然后再比较拟合曲线与实际数据集之间的实际差异,根据差异再调整函数系数,最后实现拟合曲线与实际数据集之间的最小差异。

三、应用递推最小二乘法在实际应用中可以用来拟合复杂的数据曲线,以求得更好的拟合效果,解决拟合时出现精度下降问题。

它具有计算量小、运算简单、拟合结果较好的优点,因此在实际应用中得到了广泛的使用,比如在众多植物物种的遗传分析中,用递推最小二乘法来拟合植物的遗传规律,以获得更准确的估计结果;在探测地球大气层时,也可以用最小二乘法来拟合大气层中的湿度数据,以获取更加准确的湿度数据;在搜索引擎中,对查询结果也可以用最小二乘法拟合出来,以获得更准确的查询结果等等。

渐消记忆递推最小二乘算法

是相互独立,服从N(0,)分布的随机变量。 1

M序列产生方法

X1

移位脉冲 XOR

X2

X3

X4

输出

1111 0111 0010 1001 1010 1101

0011 1100 1110

0001 0110 1111

14

1000 0100 1011 0101

111100010011010

M序列的性质

(1)由n级移位寄存器产生的M序列是确定的周期性序 列,它的周期长度为N=2n-1。 (2)n级移位寄存器中必须避免全部为“0”的状态,M 序列一个周期内状态“0”出现的次数比状态“1” 少1。 (3)M序列中,状态“0”或“1”连续出现的段称为游程。 游程中“0”或“1”的个数称为游程长度。

y0(t)+yw(t)

白噪声

Xw(t)

K g(τ)

延迟τ

Xw(t-τ)

乘法器

积分器

具有正常输入时的系统辨识原理图

23

用M序列辨识系统脉冲响应

(1) 计算方法 M序列的循环周期为N,移位脉冲的周期为t

a 2 , Rx ( ) a 2 , N

回顾

0, N ,2 N , 0, N ,2 N ,

1 N 1 RyM (k ) M ( j k )y( j ) N j 0

工程上:

a 2 t N 1 ˆ ( j) c g N j 0

25

c RyM ( NP 1)

(2)通过脉冲响应求传递函数

G(s)为系统的传递函数

G(s) C (s) M (s) R( s) N ( s)

阶跃响应法

输入 x(t) (a)

x(t)

各种最小二乘算法总结

各种最小二乘算法总结1. 一般最小二乘法例 1 考虑如下仿真对象z k 2 1.5 z k 1 0.7 z k u k1 0.5u k v k 其中,v k 为服从N 01 分布的白噪声。

输入信号u k采用M 序列,幅度为1。

M 序列由9 级移位寄存器产生,xi xi 4⊕xi 9 。

选择如下的辨识模型z k 2 a1 z k 1 a2 z k b1u k 1 b2u k vk 观测数据长度取L 400 。

加权阵取∧I 。

1.1. 一次计算最小二乘算法a1 -1.4916 θ LS a 2 H T H 1 H T Z 0.7005 1.1 L L L L 1.0364 b10.4268 b2 Z 3 hT 3 Z 2 Z 1 u 2 u 1 T其中,Z L Z 4 ,H h 4 Z 3 Z 2 u3 u 2 ... L ... ... ... ... ... Z 402 hT 402 Z 401 Z 400 u 401 u 400Matlab程序见附录1。

1.2. 递推最小二乘算法递推最小二乘算法公式:θ k θ kK k P k 1hk h k P k 1hk 1.2 ∧k Pk I K k h k Pk 11 K k z k h k θ k 1 1 13 盛晓婷最小二乘算法总结报告a1 3 初始条件θ 0 a 2 3 P0 100I 。

3 4×4 b1 3 b2经过编程计算,各个参数的估计值为a1 -1.4976 a2程序见附录2。

待估参数0.6802θ LS 1.0284 1.3 b1 0.3341 b2Matlab过渡过程 3 2.5 2 1.5 b1 1 a2 0.5 0 b2 -0.5 -1 a1 -1.5 -2 0 50 100 150200 250 300 350 400 450 图 1 一般最小二乘参数过渡过程 4 盛晓婷最小二乘算法总结报告估计方差变化过程100908070605040302010 0 0 50 100 150 200 250 300 350 400 450 图2 一般最小二乘方差变化过程 5 盛晓婷最小二乘算法总结报告 2.遗忘因子最小二乘算法采用的辨识模型与例1相同。

带遗忘因子的递推最小二乘法

带遗忘因子的递推最小二乘法引言在统计学和机器学习中,最小二乘法是一种常用的优化方法,用于拟合数据点与理论模型之间的差异。

它通过最小化残差平方和来寻找最佳拟合曲线或平面。

然而,在某些情况下,我们可能希望在拟合过程中考虑时间因素,即对于过去数据点的权重进行衰减。

这就引入了带遗忘因子的递推最小二乘法。

遗忘因子遗忘因子是指在时间序列中,随着时间推移,对较早期数据点的权重进行衰减的程度。

它可以看作是一个衰减参数,控制着过去数据点对拟合结果的影响力。

常见的遗忘因子取值范围为0到1之间,其中0表示完全遗忘过去数据点,1表示完全保留过去数据点。

递推最小二乘法递推最小二乘法是一种利用历史观测值来预测未来观测值的方法。

它通过将当前观测值与先前预测值之间的误差进行修正,并根据遗忘因子对历史观测值的权重进行衰减,来逐步更新预测结果。

递推最小二乘法可以用于时间序列预测、信号处理、滤波等领域。

带遗忘因子的递推最小二乘法算法带遗忘因子的递推最小二乘法算法可以分为以下步骤:1.初始化参数:设置初始权重矩阵和观测值向量。

2.根据当前观测值和先前预测值计算残差。

3.根据残差和遗忘因子,更新权重矩阵。

4.根据更新后的权重矩阵,计算新的预测结果。

5.重复步骤2-4,直到达到停止条件(如误差收敛或达到最大迭代次数)。

下面是带遗忘因子的递推最小二乘法算法的伪代码:Initialize:Set initial weight matrix WSet observation vector ySet forgetting fa ctor λRepeat until convergence or maximum iterations reached:Calculate the residual e = y - XWUpdate the weight matrix W = (λX^T*X)^(-1)*X^T*yCalculate the new prediction vector y_hat = XW其中,X是设计矩阵,包含了观测变量的历史数据。

递推最小二乘法[整理版]

![递推最小二乘法[整理版]](https://img.taocdn.com/s3/m/bb7c26feb9f67c1cfad6195f312b3169a451eafc.png)

线性方程组的最优求解方法一.递推最小二乘法设线性方程组b Ax = (1)则有k b k =x :A ),(, (n k ,2,1=) (2)其中,[]kn k k a a a k ,,,:),(21 =A ,[]Tn x x x ,,,21 =x 。

设x :A ),()(k k f = (3)下面采用基于递推最小二乘法(RLS)的神经网络算法来训练权值向量x ,以获得线性方程组(1)的解x 。

由式(3)可知,若以)(k f 为神经网络输出,以k b 为神经网络训练样本,以x 为神经网络权值向量,[]kn k k a a a k ,,,:),(21 =A 为神经网络输入向量,则解线性方程组的神经网络模型如同1所示。

图1 神经网络模型采用RLS 算法训练神经网络权值向量x ,其算法如下:(1)神经网络输出:x :A ),()(k k f = (4)(2)误差函数:)()(k f b k e k -= (5)(3)性能指标:∑==n k k e J 12)(21 (6)(4)使min =J 的权值向量x ,即为所求的神经网络权值向量x ,这是一个多变量线性优化问题,为此,由0=∂∂xJ可得最小二乘递推法(RLS ):]),([1k k k k k k b x :A Q x x -+=+ (7)),(),(1),(:A P :A :A P Q k k k Tk T k k+= (8)k k k k P :A Q I P )],([1-=+ (9)()n k ,,2,1 =随机产生初始权值向量)1,(0n rand =x ,设n n ⨯∈=R I P α0(α是足够大的正数(一般取10610~10=α),n n ⨯∈R I 是单位矩阵),通过对样本数据训练,即可获得神经网络权值向量x ,此即为线性方程组(1)的解。

二.具有遗忘因子的递推最小二乘估计公式为:]),([1k k k k k k b x :A Q x x -+=+ (10)),(),(),(:A P :A :A P Q k k k Tk T k k+=λ (11)k k k k P :A Q I P )],([11-=+λ(12)式中,1:)],(:),([)(-=k A k A k T W P ,W 为加权对角阵:⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎣⎡=--10021λλλn n W(nn ⨯∈=R I P α0,10610~10=α)。

预测控制算法范文

预测控制算法范文预测控制算法是一种基于过去的观测数据来预测未来系统行为的控制方法。

它可以用于各种领域,如工业控制、金融市场预测、天气预报等。

本文将介绍几种常用的预测控制算法,包括递推最小二乘法、基于神经网络的算法和基于深度学习的算法。

1. 递推最小二乘法(Recursive Least Squares, RLS):递推最小二乘法是一种经典的预测控制算法。

它通过不断更新一个递推系数来预测未来系统行为。

具体而言,它通过最小化观测数据与预测输出之间的误差平方和来更新递推系数。

递推最小二乘法在实际应用中被广泛使用,因为它具有较好的收敛性和计算效率。

2.基于神经网络的算法:基于神经网络的预测控制算法基于一种称为前馈神经网络的模型,该模型可以学习和预测复杂的非线性系统行为。

算法首先使用一组历史观测数据来训练神经网络模型,然后使用该模型来预测未来系统行为。

该算法的优点是能够处理复杂系统并具有较高的预测精度,但需要大量的训练数据和计算资源。

3.基于深度学习的算法:基于深度学习的预测控制算法是近年来新兴的算法。

它使用一种称为深度神经网络的模型来学习和预测系统行为。

与传统的神经网络不同,深度神经网络拥有多个隐藏层,可以学习更加复杂的系统关系。

该算法在处理大规模数据集和高维数据方面具有很大优势,并在图像识别、语音识别等领域取得了显著的成果。

4.其他预测控制算法:除了上述提到的算法外,还有许多其他预测控制算法可供选择。

例如,基于卡尔曼滤波的算法可以处理系统中的噪声和不确定性,并提供准确的预测。

遗传算法可以通过模拟进化过程来最优的控制参数。

模糊控制算法可以处理模糊和模糊输入,适用于复杂和不确定的系统。

综上所述,预测控制算法在实际应用中起到了重要的作用。

根据不同的应用场景和需求,我们可以选择合适的算法来进行预测和控制。

未来随着科技的发展和算法的改进,预测控制算法将能够更好地处理复杂系统和大规模数据,并提供更准确的预测和控制结果。

rls算法原理

rls算法原理RLS(Recursively Least Square)算法,又称递推最小二乘法,是广泛应用于自适应信号处理、滤波、预测和识别等领域的一种算法。

RLS算法的核心思想是利用已知的数据来递推估计某一未知参数的值。

在实际应用中,经常需要从一系列观测数据中,准确地估计出某个未知参数或者变量,例如找到某个物体的位置、估计某个信号的频率和幅度等等。

此时,常常需要利用数学模型推导出最优的估计方法,而RLS算法就是基于最小二乘法推导出来的一种递推算法,可以有效地解决这类问题。

具体地说,RLS算法的实现主要包括三个步骤:1.建立估计模型估计模型是指在已知的观测数据和所要估计的未知参数之间建立的联系模型。

对于一个n维的模型来说,有如下形式:$$\boldsymbol{y}(n)=\boldsymbol{x}^T(n)\cdot\boldsymbol{w}(n)+\boldsymbol{v}(n)$$其中,$\boldsymbol{y}(n)$是观测数据,$\boldsymbol{x}(n)$是一组特征变量(也称为自变量),$\boldsymbol{w}(n)$是待估参数,$\boldsymbol{v}(n)$是噪声项。

该模型的估计目标是通过已知的$\boldsymbol{y}(n)$和$\boldsymbol{x}(n)$来递推估计$\boldsymbol{w}(n)$的值。

2.递推计算参数采用递推计算的方式,计算出每一时刻的参数估计值。

具体地说,假设当前时刻为$n$,则根据已知的先验信息,我们可以得到关于$\boldsymbol{w}(n)$的先验分布$I(n)$,同时我们也已经获得了观测数据$\boldsymbol{y}(n)$和自变量$\boldsymbol{x}(n)$。

因此,我们可以根据贝叶斯理论,推导出后验分布$P(\boldsymbol{w}(n)|\boldsymbol{y}(n),\boldsymbol{x}(n),I(n))$以及最小二乘估计公式。

递推最小二乘法

递推最小二乘法递推最小二乘法是用于拟合函数的一种最广泛和有效的方法。

递推最小二乘法(RecursiveLeastSquares,RLS)是针对给定样本进行线性拟合的一种机器学习算法,它在求解具有最小均方差的最优参数时用于模型的更新。

递推最小二乘法以更新参数的方式估计参数,从而将当前参数和新数据结合起来。

它可以用来求解给定样本具有最小平均方差的最优参数表达式,以解决传统最小二乘法的计算开销大的问题。

递推最小二乘法的基本原理是求解通过要拟合的数据图形的几何图案的最小二乘参数,并逐渐拟合出数据图形的最小二乘参数。

它使用一种迭代计算的方法,用新的样本点替换旧的样本点,以不断更新拟合函数参数。

该方法有利于跟踪变化快的参数。

递推最小二乘法的思想很简单:从给定的样本中求出最小二乘拟合参数,并以迭代和递推的方式求解最优拟合参数,不断地更新最小二乘拟合参数,以达到拟合数据的最优状态。

此外,递推最小二乘法也可以利用状态空间表示来改进拟合性能,尤其是在模型存在时滞性和高阶非线性性质时,能更好地拟合函数从而获得更详细的函数图形。

在应用递推最小二乘法时,我们需要注意它存在的一些局限性。

首先,它要求拟合的模型必须是线性的,这意味着参数的变化关系必须是线性的。

其次,它的迭代方式容易出现收敛速度慢的问题。

在实际应用中,一般用共轭梯度法或牛顿法加速收敛速度。

最后,它只能处理维度为n的数据,而不能处理大规模的数据。

因此,在实际应用中,在使用递推最小二乘法之前,需要结合其他方法,以减少数据维度,从而提高计算效率。

总之,递推最小二乘法是一种应用广泛、计算量小、拟合效果好的数据拟合算法,它主要用于模型参数在时间上有变化,并且有高阶非线性特性时,拟合函数参数的更新。

由于这种算法的收敛速度慢,因此,在实际应用中,一般要结合其他方法或技术进行优化,以进一步提高拟合的准确性和稳定性。

递推最小二乘法

1

最小二乘法辨识

回顾

考虑系统模型:

y(k) a1y(k 1) a2 y(k 2) L an y(k n)

b0u(k) b1u(k 1) L bnu(k n) (k)

2

最小二乘法:

a1

2n+1维 参数向量

N维输出向量

y

y(n 1)

y(n

2)

,

M

y(n

4

递推最小二乘 参数辨识算法

u(k)

y(k)

动态系统模型

反馈控制律

图4.1 动态系统递推最小二乘在线辨识过程原理图

2020/6/27

5

递推最小二乘法

令 PN (TN N )1 ,则递推最小二乘算法

) )

)

θN 1 θN K N 1 ynN 1 ψTN 1θN

K N1 PN ψN1

ψ

T N

1PN

ψN

1

1

PN 1

1

PN

PN ψN 1

ψTN 1PN ψN 1

1

ψTN

1PN

2ΦTNΦN

N

1

T N

1

1

1

2

ΦTN ΦN

1 1

2

ΦTN Φ N

1

N 1

1

T N 1

1

2

ΦTN ΦN

1

N 1

1

T N 1

1

2

ΦTN ΦN

1

1

2

ΦTN ΦN

1 1

)

N

ΦTN ΦN

1 N 1

2

T N

1

ΦTN ΦN

1

递推阻尼最小二乘法辨识算法公式的详细推导与说明

控制理论与控制工程学位课程《系统辨识》考试报告递推阻尼最小二乘法公式详细推导专业:控制理论与控制工程班级:2011双控(研)学生姓名:江南学号:20110201016任课教师:蔡启仲老师2012年06月29 日摘要在参数辨识中,递推最小二乘法是用得最多的一种算法。

但是,最小二乘法存在一些缺点,如随着协方差矩阵的减小,易产生参数爆发现象;参数向量和协方差矩阵的处置选择不当会使得辨识过程在参数收敛之前结束;在存在随机噪声的情况下,参数易产生漂移,出现不稳定等。

为了防止参数爆发现象,Levenberg 提出在参数优化算法中增加一个阻尼项,以增加算法的稳定性。

本文在一般的最小二乘法中增加了阻尼因子,构成了阻尼最小二乘法。

又根据实时控制的要求,详细推到了递推阻尼最小二乘公式,实现在线辨识。

关键字:系统辨识,最小二乘法,递推算法正文1.题目的基本要求已知单入单出系统的差分方程以及噪声,在应用最小二乘法进行辨识的时候,在性能指标中加入阻尼因子,详细推导阻尼最小二乘法的递推公式。

2.输入辨识信号和系统噪声的产生方法和理论依据 2.1系统辩识信号输入选择准则(1)输入信号的功率或副度不宜过大,以免使系统工作在非线性区,但也不应过小,以致信噪比太小,直接影响辩识精度;(2)输入信号对系统的“净扰动”要小,即应使正负向扰动机会几乎均等; (3)工程上要便于实现,成本低。

2.2白噪声及其产生方法 (1) 白噪声过程(2)白噪声是一种均值为0、谱密度为非0常数的平稳随机过程。

(3)白噪声过程定义:如果随机过程()t ω的均值为0,自相关函数为()()2R t t ωσδ= (2.2.1)式中()t δ 为狄拉克(Dirac) 分布函数,即(){(),00,01t t t dt δδ∞∞=≠∞==⎰-且t (2.2.2)则称该随机过程为白燥声过程。

2.3白噪声序列 (1) 定义 如果随机序列{()}w t 均值为0,并且是两两不相关的,对应的自相关函数为()2,0,1,2w l R l l σδ==±± 式中{1,00,0l l l δ=≠=则称这种随机序列{()}w t 为白噪声序列。

递推最小二乘法算法

题目(递推最小二乘法)考虑如下系统:y(k) -1.5y(k -1) 0.7y(k -2) = u(k -3) 0.5u(k -4) (k)式中,(k)为方差为0.1的白噪声。

取初值P(0) =1061、二(0) = 0。

选择方差为1的白噪声作为输入信号u(k),米用PLS法进行参数估计。

Matlab代码如下:clear allclose allL=400; %仿真长度uk=zeros(4,1); %输入初值:uk(i)表示u(k-i) yk=zeros(2,1); %输出初值u=randn (L,1); %输入采用白噪声序列xi=sqrt(0.1)*randn(L,1); % 方差为0.1 的白噪声序列theta=[-1.5;0.7;1.0;0.5]; %对象参数真值thetae_ 1= zeros(4,1); % ()初值P=10A6*eye(4); %题目要求的初值for k=1:Lphi=[-yk;uk(3:4)]; %400 4矩陳phi第k行对应的y(k-1),y(k-2),u(k-3), u(k-4) y(k)=phi'*theta+xi(k); % 采集输出数据%递推最小二乘法的递推公式K=P*phi/(1+phi'*P*phi);thetae(:,k)=thetae_1+K*(y(k)-phi'*thetae_1);P=(eye(4)-K*phi')*P;%更新数据thetae_1=thetae(:,k);for i=4:-1:2uk(i)=uk(i-1);enduk(1)=u(k);for i=2:-1:2火i)=yk(i-1);end yk(1)=y(k);endplot([1:L],thetae); %line([1,L],[theta,theta]); xlabel('k'); ylabel('参数估计a、b'); lege nd('a_1','a_2','b_0','b_1');%axis([0 L -2 2]);结果分析如下系统方程为y(k) -1.5y(k -1) 0.7y(k -2) = u(k -3) 0.5u(k -4) (k)由CAR模型:y(k) =1.5y(k _1) _0.7y(k _2) u(k _3) 0.5u(k _4) (k)可以得到:-1-1 -2A(z ) =1 1.5z -0.7zB(z 斗)=z,(1 0.5z4)我们可以知道纯迟延为3T,na=2,nb=1,d=3,phi(k,:)=[-yk;uk(3:4)]'; 400 4矩阵phi第k行对应的y(k-1),y(k-2),u(k-3), u(k-4)y(k)=phi*theta+xi(k);输出等于矩阵phi与真值矩阵相乘加上白噪声。

几种最小二乘法递推算法的小结

递推最小二乘法的一般步骤:1. 根据输入输出序列列出最小二乘法估计的观测矩阵ϕ:] )(u ... )1( )( ... )1([)(T b q n k k u n k y k y k ------=ϕ没有给出输出序列的还要先算出输出序列。

本例中, 2)]-u(k 1),-u(k 2),-1),-y(k -[-y(k )(T =k ϕ。

2. 给辨识参数θ和协方差阵P 赋初值。

一般取0θ=0或者极小的数,取σσ,20I P =特别大,本例中取σ=100。

3. 按照下式计算增益矩阵G :)()1()(1)()1()(k k P k k k P k G T ϕϕϕ-+-= 4. 按照下式计算要辨识的参数θ:)]1(ˆ)()()[()1(ˆ)(ˆ--+-=k k k y k G k k T θϕθθ5. 按照下式计算新的协方差阵P :)1()()()1()(---=k P k k G k P k P T ϕ6. 计算辨识参数的相对变化量,看是否满足停机准则。

如满足,则不再递推;如不满足,则从第三步开始进行下一次地推,直至满足要求为止。

停机准则:εϑϑϑ<--)(ˆ)1(ˆ)(ˆmax k k k i i i i 本例中由于递推次数只有三十次,故不需要停机准则。

7. 分离参数:将a 1….a na b 1….b nb 从辨识参数θ中分离出来。

8. 画出被辨识参数θ的各次递推估计值图形。

为了说明噪声对递推最小二乘法结果的影响,程序5-7-2在计算模拟观测值时不加噪声, 辨识结果为a1 =1.6417,a2 = 0.7148,b1 = 0.3900,b2 =0.3499,与真实值a1 =1.642, a2 = 0.715, b1 = 0.3900,b2 =0.35相差无几。

程序5-7-2-1在计算模拟观测值时加入了均值为0,方差为0.1的白噪声序列,由于噪声的影响,此时的结果为变值,但变化范围较小,现任取一组结果作为辨识结果。

实验4 递推最小二乘法的实现

位矩阵,则经过若干次递推之后能得到较好的参数估计。

3

4.实验对象或参数 给定系统

y (k ) a1 y (k 1) a2 y ( k 2) b0u ( k ) b1u (k 1) b2u (k 2) (k ) (15)

即 n 2 。假设实际系统的参数为 a1 2 , a2 1.3 , b0 0.4 , b1 0.88 , b2 2.2 , 但是不已知,即不可测。取 (k ) [0.1, 0.1] 的零均值白噪声。输入信号取为

u (k ) 1.5sin 0.2k

(16)

要求编制 MATLAB 程序,运用递推最小二乘法对这一系统的参数进行在线辨识,并 将辨识结果与实际参数进行对比。

5.程序框图

开始

程序初始化与赋初值

由先前输入输出生成 ΨN+1

用户输入初值设定常数c

由系统模型计算获得yN+1

设定初值θ0和P0

由递推最小二乘辨识公式得到 KN+1、PN+1、θN+1

y (1) u (n 1) u (1) y ( n) y (n 1) y (2) u (n 2) u (2) y (n N 1) y ( N ) u (n N ) u ( N )

(1)

其中 a1,a2…an,b0,b1,b2…bn 为待辨识的未知参数, ( k ) 是不相关随机序列。y 为系 统的输出, u 为系统的输入。 分别测出 n+N 个输出、 n+N 输入值 y(1), y(2)…y(n+N), u(1), u(2)…u(n+N),则可写出 N 个方程,具体写成矩阵形式,有

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

题目:

(递推最小二乘法)

考虑如下系统:

)()4(5.0)3()2(7.0)1(5.1)(k k u k u k y k y k y ξ+-+-=-+--

式中,)(k ξ为方差为0.1的白噪声。

取初值I P 610)0(=、00=∧

)(θ。

选择方差为1的白噪声作为输入信号)(k u ,采用PLS 法进行参数估计。

Matlab 代码如下:

clear all

close all

L=400; %仿真长度

uk=zeros(4,1); %输入初值:uk(i)表示u(k -i)

yk=zeros(2,1); %输出初值

u=randn(L,1); %输入采用白噪声序列

xi=sqrt(0.1)*randn(L,1); %方差为0.1的白噪声序列

theta=[-1.5;0.7;1.0;0.5]; %对象参数真值

thetae_1=zeros(4,1); %()θ初值

P=10^6*eye(4); %题目要求的初值

for k=1:L

phi=[-yk;uk(3:4)]; %400×4矩阵phi 第k 行对应的y(k-1),y(k-2),u(k-3), u(k-4) y(k)=phi'*theta+xi(k); %采集输出数据

%递推最小二乘法的递推公式

K=P*phi/(1+phi'*P*phi);

thetae(:,k)=thetae_1+K*(y(k)-phi'*thetae_1);

P=(eye(4)-K*phi')*P;

%更新数据

thetae_1=thetae(:,k);

for i=4:-1:2

uk(i)=uk(i -1);

end

uk(1)=u(k);

for i=2:-1:2

yk(i)=yk(i -1);

end

yk(1)=y(k);

end

plot([1:L],thetae); %line([1,L],[theta,theta]);

xlabel('k'); ylabel('参数估计a 、b');

legend('a_1','a_2','b_0','b_1');

%axis([0 L -2 2]);

结果

分析如下

系统方程为

)()4(5.0)3()2(7.0)1(5.1)(k k u k u k y k y k y ξ+-+-=-+--

由CAR 模型:

)()4(5.0)3()2(7.0)1(5.1)(k k u k u k y k y k y ξ+-+-+---=

可以得到:

2117.05.11)(----+=z z z A

)5.01()(131---+=z z z B

我们可以知道纯迟延为3T ,na=2,nb=1,d=3,

phi(k,:)=[-yk;uk(3:4)]'; 400×4矩阵phi第k行对应的y(k-1),y(k-2),u(k-3), u(k-4)

y(k)=phi*theta+xi(k);输出等于矩阵phi与真值矩阵相乘加上白噪声。

在这里phi是列向量不需要用phi(k,:)形式

这是循环的主体,接下来

一开始我们赋给初值给输入以及输出

初始输入u(0)=u(-1)=u(-2)=u(-3)=0;初始输出y(0)=y(-1)=0;

所以

=u

-

+

u

+

y

y

y

+

)2-(

5.0

)3-(

)1-(

7.0

)1(

5.1

)0(

)1(ξ

经过白噪声的更新代码后,以及输入输出值得更新后我们有,也就是把计算出来的y(1)给到下一组y(2)的计算中区去:

-

+

+

=u

y

+

y

y

u

)2(

)1-(

5.0

)2-(

)2(ξ

)0(

5.1

)1(

7.0

于是我让程序中显示phi以便只观的表现递推最小二乘法和批处理最小二乘法的不同:

>> phi

phi =

-1.9333

-3.3952

-0.4448

-0.4710

递推最小二乘法phi截图如下:

相比于第一次作业的批处理最小二乘法的phi:

可以发现递推最小二乘法和批处理最小二乘法的运算结果在L数据长度是一样的情况下是相同的,两者的实质原理相同,仅仅是数学原理上的差别。

但是优点在于后一种办法,取一组数据用一组,避免了矩阵求逆的过程,减轻了计算机软件的负担,因为在matlab中求逆是应该避免的。