基于JAVA的小型中文分词系统

IKAnalyzer中文分词器介绍

IKAnalyzer3.2.8中文分词器介绍2012年3月2日1.IKAnalyzer简介IKAnalyzer是一个开源基于JA V A语言的轻量级的中文分词第三方工具包,从2006年推出已经经历了三个较为完整的版本,目前最新版本为3.2.8,它基于lucene为应用主体,但是,它也支持脱离lucene,成为一个独立的面向JA V A的分词工具。

2.IKAnalyzer结构图3.IKAnalyzer特性a.算法采用“正向迭代最细粒度切分算法”,支持细粒度和最大词长两种分词方式,速度最大支持80W字/秒(1600KB/秒)。

b.支持多子处理器分析模式:中文、数字、字母,并兼容日文、韩文。

c.较小的内存占用,优化词库占有空间,用户可自定义扩展词库。

d.扩展lucene的扩展实现,采用歧义分析算法优化查询关键字的搜索排列组合,提高lucene检索命中率。

4.关键类介绍org.wltea.analyzer.lucene.IKAnalyzerIK分词主类,基于Lucene的Analyzer接口实现。

org.wltea.analyzer.lucene.IKQueryParserIK分词器提供的Query解析、构造工具类,其中parseMultiField函数(所有的重载函数)为关键函数。

org.wltea.analyzer.IKSegmentationIK分词器的核心类,真正分词的实现类。

5.IK分词算法理解根据作者官方说法IK分词器采用“正向迭代最细粒度切分算法”,分析它的源代码,可以看到分词工具类IKQueryParser起至关重要的作用,它对搜索关键词采用从最大词到最小词层层迭代检索方式切分,比如搜索词:“中华人民共和国成立了”,首先到词库中检索该搜索词中最大分割词,即分割为:“中华人民共和国”和“成立了”,然后对“中华人民共和国”切分为“中华人民”和“人民共和国”,以此类推。

最后,“中华人民共和国成立了”切分为:“中华人民| 中华| 华人| 人民| 人民共和国| 共和国| 共和| 成立| 立了”,当然,该切分方式为默认的细粒度切分,若按最大词长切分,结果为:“中华人民共和国| 成立| 立了”。

ik分词器原理

ik分词器原理

ik分词器是一种基于Java语言开发的开源中文分词工具。

它

采用了先进的NLP技术和基于规则的分词算法,能够将一段

连续的中文文本切分成有意义的词语。

ik分词器的原理主要包括以下几个步骤:

1. 文本预处理:首先,ik分词器会对输入的文本进行预处理,包括去除空格、标点符号和特殊字符等。

2. 正向匹配:ik分词器会从文本的开头开始逐个字符进行遍历,将所有可能的词语按照最大匹配原则进行切分。

例如,对于文本“我爱自然语言处理”,先从开头的“我”开始匹配,如果“我”

是一个有效的词语,则继续匹配下一个字符。

如果不是词语,则向下一个字符进行匹配,直到找到一个合适的词语或者遍历结束。

3. 逆向匹配:正向匹配得到的结果可能存在一些不准确的情况,因此ik分词器还会进行逆向匹配,以获得更准确的切分结果。

逆向匹配是从文本的末尾开始,逐个字符进行遍历,将所有可能的词语按照最大匹配原则进行切分。

4. 歧义消除:在正向匹配和逆向匹配之后,ik分词器会对切分结果进行歧义消除。

当一个词语可以被多种方式切分时,ik分词器会根据一些规则和词典进行判断,选择最合理的切分结果。

5. 结果输出:最后,ik分词器会将切分得到的词语以字符的形

式输出,供后续的文本处理和分析使用。

综上所述,ik分词器通过正向匹配、逆向匹配和歧义消除等步骤,能够准确地将中文文本切分成有意义的词语。

它具有较高的分词准确率和较好的分词效果,在中文信息处理和文本挖掘等领域得到广泛应用。

ansj分词原理

ansj分词原理随着互联网的发展,信息爆炸的时代已经到来。

在这样的环境下,对于搜索引擎来说,如何有效地处理海量的文本数据,成为了一项重要的技术挑战。

而分词技术作为搜索引擎处理文本数据的基础,也越来越受到关注。

ansj分词是一种基于Java语言的中文分词工具。

它的特点在于速度快、准确率高,而且支持自定义词典。

在这篇文章中,我们将介绍ansj分词的原理和实现。

一、分词原理ansj分词的分词原理主要基于两个算法:正向最大匹配算法和逆向最大匹配算法。

这两个算法都是基于词典的匹配算法,具体的流程如下:1. 正向最大匹配算法正向最大匹配算法是指从左到右扫描文本,每次取出最长的词语作为分词结果,并将已经分出的词语从文本中删除。

这种算法的优点是速度快,缺点是可能会出现歧义,比如“中国人民银行”这个词语,按照正向最大匹配算法可能会被分成“中国人民”和“银行”两个词语。

2. 逆向最大匹配算法逆向最大匹配算法是指从右到左扫描文本,每次取出最长的词语作为分词结果,并将已经分出的词语从文本中删除。

这种算法的优点是可以避免歧义,缺点是速度较慢。

ansj分词采用的是双向最大匹配算法,即同时采用正向最大匹配算法和逆向最大匹配算法,然后根据一定的规则来决定最终的分词结果。

二、分词实现ansj分词的实现主要包括三个方面:词典的构建、分词算法的实现和规则的设计。

1. 词典的构建词典是分词的基础。

ansj分词采用的是基于内存的双数组Trie 树来实现词典。

Trie树是一种树形结构,用于存储字符串集合。

在Trie树中,每个节点代表一个字符串的前缀,而从根节点到叶子节点的路径表示一个完整的字符串。

由于Trie树的查询效率非常高,因此ansj分词采用了这种数据结构来实现词典。

2. 分词算法的实现ansj分词采用的是双向最大匹配算法。

具体来说,算法的流程如下:(1)首先将待分词的文本按照一定的规则进行切割,得到一些基本的词语。

(2)然后将这些词语分别用正向最大匹配算法和逆向最大匹配算法进行分词,并得到两个分词结果。

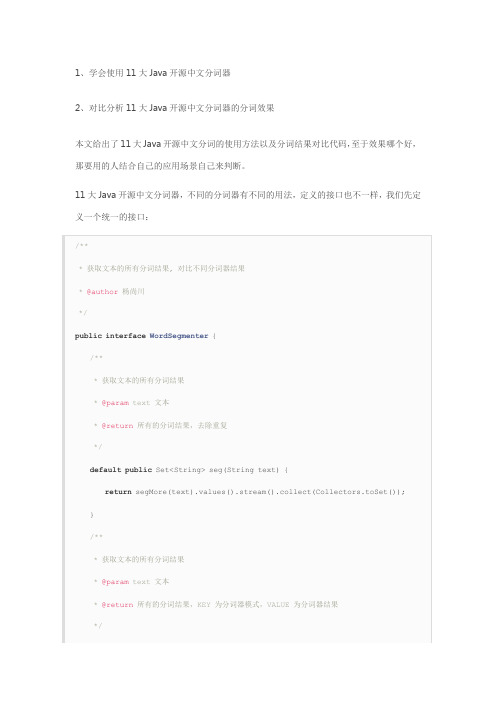

11个Java开源中文分词器使用方法和分词效果对比

1、学会使用11大Java开源中文分词器

2、对比分析11大Java开源中文分词器的分词效果

本文给出了11大Java开源中文分词的使用方法以及分词结果对比代码,至于效果哪个好,那要用的人结合自己的应用场景自己来判断。

11大Java开源中文分词器,不同的分词器有不同的用法,定义的接口也不一样,我们先定义一个统一的接口:

从上面的定义我们知道,在Java中,同样的方法名称和参数,但是返回值不同,这种情况不可以使用重载。

这两个方法的区别在于返回值,每一个分词器都可能有多种分词模式,每种模式的分词结果都可能不相同,第一个方法忽略分词器模式,返回所有模式的所有不重复分词结果,第二个方法返回每一种分词器模式及其对应的分词结果。

在这里,需要注意的是我们使用了Java8中的新特性默认方法,并使用stream把一个map 的value转换为不重复的集合。

下面我们利用这11大分词器来实现这个接口:

1、word分词器

2、Ansj分词器

3、Stanford分词器

4、FudanNLP分词器

5、Jieba分词器

6、Jcseg分词器

7、MMSeg4j分词器

8、IKAnalyzer分词器

9、Paoding分词器

10、smartcn分词器

11、HanLP分词器

现在我们已经实现了本文的第一个目的:学会使用11大Java开源中文分词器。

最后我们来实现本文的第二个目的:对比分析11大Java开源中文分词器的分词效果,程序如下:。

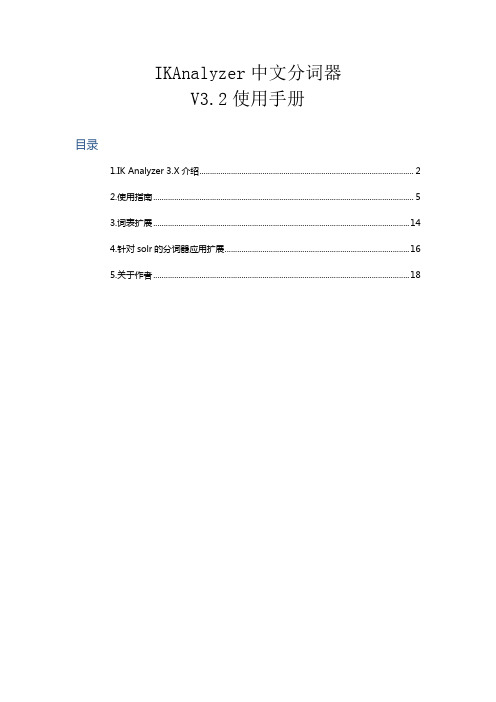

IKAnalyzer中文分词器V3.2.8使用手册

IKAnalyzer中文分词器V3.2使用手册目录1.IK Analyzer 3.X介绍 (2)2.使用指南 (5)3.词表扩展 (14)4.针对solr的分词器应用扩展 (16)5.关于作者 (18)1.IK Analyzer 3.X介绍IK Analyzer是一个开源的,基于java语言开发的轻量级的中文分词工具包。

从2006年12月推出1.0版开始,IKAnalyzer已经推出了3个大版本。

最初,它是以开源项目Luence为应用主体的,结合词典分词和文法分析算法的中文分词组件。

新版本的IK Analyzer 3.X则发展为面向Java的公用分词组件,独立于Lucene项目,同时提供了对Lucene的默认优化实现。

1.1 IK Analyzer 3.X结构设计1.2 IK Analyzer 3.X特性●采用了特有的“正向迭代最细粒度切分算法“,具有80万字/秒的高速处理能力。

●采用了多子处理器分析模式,支持:英文字母(IP地址、Email、URL)、数字(日期,常用中文数量词,罗马数字,科学计数法),中文词汇(姓名、地名处理)等分词处理。

●优化的词典存储,更小的内存占用。

支持用户词典扩展定义●针对Lucene全文检索优化的查询分析器IKQueryParser(作者吐血推荐);采用歧义分析算法优化查询关键字的搜索排列组合,能极大的提高Lucene检索的命中率。

1.3 分词效果示例IK Analyzer 3.2.8版本支持细粒度切分和最大词长切分,以下是两种切分方式的演示样例。

文本原文1:IKAnalyzer是一个开源的,基于java语言开发的轻量级的中文分词工具包。

从2006年12月推出1.0版开始,IKAnalyzer已经推出了3个大版本。

●最大词长分词结果:ikanalyzer | 是| 一个| 开源| 的| 基于| java | 语言| 开发| 的| 轻量级| 的| 中文| 分词| 工具包| 从| 2006 | 年| 12 | 月| 推出| 1.0 | 版| 开始| ikanalyzer | 已经| 推出| 出了| 3 | 个| 大| 版本●最细粒度分词结果:ikanalyzer | 是| 一个| 一| 个| 开源| 的| 基于| java | 语言| 开发| 的| 轻量级| 量级| 的| 中文| 分词| 工具包| 工具| 从| 2006 | 年| 12 | 月| 推出|1.0 | 版| 开始| ikanalyzer | 已经| 推出| 出了| 3 | 个| 大| 版本文本原文2:作者博客: 电子邮件:linliangyi2005@●最大词长分词结果:作者| 博客| | 电子邮件| linliangyi2005@●最细粒度分词结果:作者| 博客| | linliangyi | 2007 | javaeye | com | 电子邮件| linliangyi2005@ | linliangyi | 2005 | gmail | com文本原文3古田县城关六一四路四百零五号●最大词长分词结果:古田县| 县城| 城关| 六一四| 路| 四百零五| 号●最细粒度分词结果:古田县| 古田| 县城| 城关| 六一四| 六一| 四| 路| 四百零五| 四| 百| 零| 五| 号文本原文4曙光天阔I620r-G /A950r-F 夏普SH9020C●最大词长分词结果:曙光| 天| 阔| i620r-g | a950r-f | 夏普| sh9020c●最细粒度分词结果:曙光| 天| 阔| i620r-g | i | 620 | r | g | a950r-f | a | 950 | r | f | 夏普| sh9020c | sh |9020 | c2.使用指南2.1下载地址GoogleCode开源项目:/p/ik-analyzer/ GoogleCode SVN下载:/svn/trunk/2.2与相关项目的版本兼容IK分词器版本Lucene 版本Solr版本3.1.3GA及先前版兼容2.9.1及先前版本没有solr接口3.1.5GA 兼容2.9.1及先前版本对solr1.3提供接口实现(详细请参考对应版本使用手册)3.1.6GA 兼容2.9.1及先前版本对solr1.3、solr1.4提供接口实现(详细请参考对应版本使用手册)3.2.0G及后续版本兼容Lucene2.9及3.0版本不支持Lucene2.4及先前版本仅对solr1.4提供接口实现(请参考本手册solr部分说明)2.3安装部署IK Analyzer安装包包含:1.《IKAnalyzer中文分词器V3.X使用手册》(即本文档)2.IKAnalyzer3.X.jar(主jar包)3.IKAnalyzer.cfg.xml(分词器扩展配置文件)4.ext_stopword.dic(扩展的stopword词典,3.2以上版本提供)它的安装部署十分简单,将IKAnalyzer3.X.jar部署于项目的lib目录中;IKAnalyzer.cfg.xml 与ext_stopword.dic文件放置在代码根目录(对于web项目,通常是WEB-INF/classes 目录,同hibernate、log4j等配置文件相同)下即可。

中文分词器的java函数

中文分词器的java函数以下是一个简单的基于Java 的中文分词器实现:import java.util.ArrayList;import java.util.List;public class ChineseTokenizer {private static final String[] stopWords = {"的", "是", "在", "和", "了", "有", "中"};public static List<String> tokenize(String text) {List<String> words = new ArrayList<>();String[] wordsArray = text.split("\\s+");for (String word : wordsArray) {if (!isStopWord(word)) {words.add(word);}}return words;}private static boolean isStopWord(String word) {for (String stopWord : stopWords) {if (stopWord.equals(word)) {return true;}}return false;}}这个分词器使用空格作为分隔符将文本拆分成单词,然后通过一个简单的停用词过滤器来去除常见的无意义词。

你可以将文本作为字符串传递给tokenize 方法,它将返回一个包含所有单词的列表。

请注意,这个分词器很简单,不能处理一些复杂的中文句子结构。

如果需要更准确的分词器,请考虑使用专业的中文分词库,例如Jieba。

基于JAVA的小型中文分词系统(全文)

基于JV的小型中文分词系统XX:1674-9324(20XX)24-0151-04一、绪论对于搜索引擎来说,最重要的并不是找到所有结果,因为在上百亿的XX页中找到所有结果没有太多的意义,也没有人能看得完,最重要的是把最相关的结果排在最前面,这也称为相关度排序。

中文分词的准确与否,常常直接影响到对搜索结果的相关度排序。

例如在搜索引擎上输入“和服”,得到的结果中就发现了下面这句话“通信信息报:卡巴斯基以技术和服务开拓XX络安全市场”,这就是由于分词不准确所造成的问题。

从这里看到中文分词的准确度,对搜索引擎结果相关性和准确性有相当大的关系。

另外,在整个搜索过程中进场要进行词典的查询,所以分词对于搜索引擎的速度也是有影响的。

二、分词的方法1.分词的意义。

由于中文语句没有自然的将词语分开,所以计算机无法了解用户输入文字串的意思,我们需要将用户输入的内容拆分成词,这样计算机才能通过词语的比对来实现对信息的检索和查找。

而这个将用户输入文字串拆分成词的过程就是分词。

2.目前的分词算法。

现有的分词算法可分为三大类:基于字符串匹配、基于理解和基于统计的分词算法。

基于字符串匹配的分词算法又叫做机械分词算法,它是按照一定的策略将待分析的汉字串与一个“充分大的”机器词典中的词条进行匹配,若在词典中找到某个字符串,则匹配成功(识别出一个词)。

常用的几种机械分词算法有正向最大匹配法、逆向最大匹配法、最少切分。

一般说来,逆向匹配的切分精度略高于正向匹配,遇到的歧义现象也较少。

这种分词方法目前使用较多,我的程序也使用的是这种分词算法。

三、分词词典的构造1.词典的作用。

为了进行分词,我们首先要构建一个文本文件,这个文本文件中存放用来构造具体的词典所用的词,这些词可以通过词典程序构造一个词典,再通过分词程序的加载进行输入文本的分词操作。

2.目前的几种词典构造方法、简介及优缺点。

目前分词主要有以下几种实现方法:整词二分法、TRIE索引树、逐字二分法、双哈希算法。

中文分词器的java函数 -回复

中文分词器的java函数-回复如何使用Java进行中文分词中文分词是中文自然语言处理(NLP)中的重要任务,它将连续的中文文本切分成一个个具有语义的词汇单元。

在Java中,我们可以使用不同的分词器来实现中文分词功能。

本文将详细介绍如何使用Java进行中文分词的具体步骤和相关的函数。

一、导入依赖首先,在Java代码中使用中文分词器,我们需要导入相关的依赖库。

常用的中文分词器有Ansj、HanLP和Jieba等,我们可以根据自己的需求选择适合的分词器。

以Ansj为例,可以通过以下方式将其导入到项目中:javaimport org.ansj.splitWord.analysis.ToAnalysis;二、加载词典中文分词器通常基于词典进行分词,因此在使用分词器之前,我们需要加载预定义的词典。

对于Ansj分词器,可以通过以下方法加载默认的词典:javaToAnalysis.parse(text);其中,text为需要进行分词的中文文本。

如果需要使用自定义的词典,可以使用以下方法加载:javaToAnalysis.parse(text, userDefinePath);其中,userDefinePath为自定义词典的路径。

三、分词一旦加载了词典,我们就可以使用分词函数来进行中文分词了。

Ansj提供了多个分词方法,包括基本分词、精准分词、NLP分词等。

我们可以根据自己的需求选择合适的方法。

以基本分词为例,可以使用以下方式进行中文分词:javaString result = ToAnalysis.parse(text).toString();其中,result为分词结果。

需要注意的是,Ansj默认将结果以空格分隔的形式返回,如果需要以其他形式展示,可以根据需要进行处理。

四、处理分词结果在得到分词结果后,我们可能需要对其进行进一步的处理。

例如,我们可以通过过滤停用词、提取关键词等方式来优化和完善分词结果。

过滤停用词是一种常用的方法,其主要目的是去除一些常见且无实际意义的词语,例如“的”、“是”等。

IKAnalyzer中文分词器介绍

IKAnalyzer3.2.8中文分词器介绍2012年3月2日1.IKAnalyzer简介IKAnalyzer是一个开源基于JA V A语言的轻量级的中文分词第三方工具包,从2006年推出已经经历了三个较为完整的版本,目前最新版本为3.2.8,它基于lucene为应用主体,但是,它也支持脱离lucene,成为一个独立的面向JA V A的分词工具。

2.IKAnalyzer结构图3.IKAnalyzer特性a.算法采用“正向迭代最细粒度切分算法”,支持细粒度和最大词长两种分词方式,速度最大支持80W字/秒(1600KB/秒)。

b.支持多子处理器分析模式:中文、数字、字母,并兼容日文、韩文。

c.较小的内存占用,优化词库占有空间,用户可自定义扩展词库。

d.扩展lucene的扩展实现,采用歧义分析算法优化查询关键字的搜索排列组合,提高lucene检索命中率。

4.关键类介绍org.wltea.analyzer.lucene.IKAnalyzerIK分词主类,基于Lucene的Analyzer接口实现。

org.wltea.analyzer.lucene.IKQueryParserIK分词器提供的Query解析、构造工具类,其中parseMultiField函数(所有的重载函数)为关键函数。

org.wltea.analyzer.IKSegmentationIK分词器的核心类,真正分词的实现类。

5.IK分词算法理解根据作者官方说法IK分词器采用“正向迭代最细粒度切分算法”,分析它的源代码,可以看到分词工具类IKQueryParser起至关重要的作用,它对搜索关键词采用从最大词到最小词层层迭代检索方式切分,比如搜索词:“中华人民共和国成立了”,首先到词库中检索该搜索词中最大分割词,即分割为:“中华人民共和国”和“成立了”,然后对“中华人民共和国”切分为“中华人民”和“人民共和国”,以此类推。

最后,“中华人民共和国成立了”切分为:“中华人民| 中华| 华人| 人民| 人民共和国| 共和国| 共和| 成立| 立了”,当然,该切分方式为默认的细粒度切分,若按最大词长切分,结果为:“中华人民共和国| 成立| 立了”。

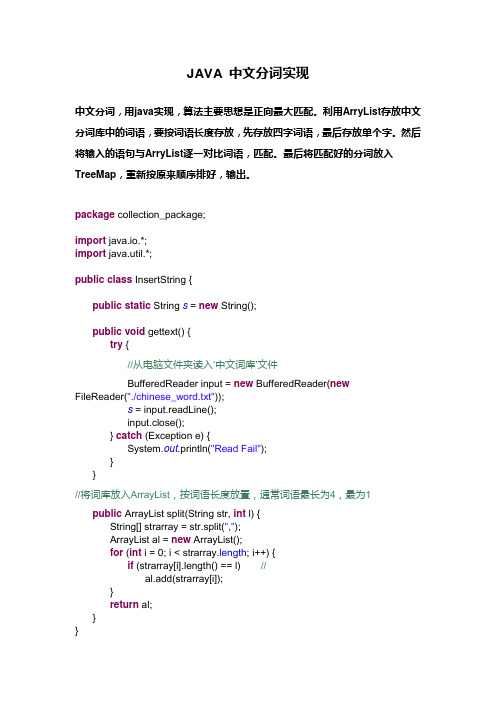

JAVA-中文分词

JAVA 中文分词实现中文分词,用java实现,算法主要思想是正向最大匹配。

利用ArryList存放中文分词库中的词语,要按词语长度存放,先存放四字词语,最后存放单个字。

然后将输入的语句与ArryList逐一对比词语,匹配。

最后将匹配好的分词放入TreeMap,重新按原来顺序排好,输出。

package collection_package;import java.io.*;import java.util.*;public class InsertString {public static String s = new String();public void gettext() {try {//从电脑文件夹读入‘中文词库’文件BufferedReader input = new BufferedReader(newFileReader("./chinese_word.txt"));s = input.readLine();input.close();} catch (Exception e) {System.out.println("Read Fail");}}//将词库放入ArrayList,按词语长度放置,通常词语最长为4,最为1 public ArrayList split(String str, int l) {String[] strarray = str.split(",");ArrayList al = new ArrayList();for (int i = 0; i < strarray.length; i++) {if (strarray[i].length() == l) //al.add(strarray[i]);}return al;}}import java.util.*;public class StringAnalysis {public static String sen;public ArrayList al = new ArrayList();public void get() {System.out.println("Please input the sentence");// 读入语句,读取要分析的句子Scanner scanner = new Scanner(System.in);sen = scanner.nextLine();}public String compare(String str, ArrayList<String> list, int n) { String stemp;String strre;String strresult;//将句子与ArrayList对比,匹配的add进另一个ArrayListfor (int i = 0; i < str.length() - n + 1; i++) {stemp = str.substring(i, i + n);if (list.contains(stemp))al.add(stemp);}strre = al.toString(); //删去已经匹配的词语strre = strre.replace(" ", "");strre = strre.replace(",", "|");strre = strre.substring(1, strre.length() - 1);// System.out.println(strre);strresult = str.replaceAll(strre, "");// System.out.println(strresult);return strresult;}}import java.util.*;public class TestAnalysis {public static void main(String[] ary) {StringAnalysis sa = new StringAnalysis();InsertString is = new InsertString();is.gettext();// System.out.println(is.s);sa.get();String sretain;sretain = sa.sen;//将词库放入ArrayList,按词语长度放置,通常词语最长为4,最短长度为1 for (int i = 4; i > 0; i--)sretain = pare(sretain, is.split(is.s, i), i);// System.out.println(sa.al);//新建一个TreeMap,为了可以使匹配了的分词重新按原先的顺序排列TreeMap tm = new TreeMap();Iterator it = sa.al.iterator();while (it.hasNext()) {String s = (String) it.next();tm.put(sa.sen.indexOf(s), s); //将匹配了的ArrayList放入TreeMap }//输出TreeMap的values,即分拆好的句子System.out.println(tm.values());}}中文词库文件chinese_word.txt昨天,星期一,我,今天,你,在,上午,个,餐厅,一顿,一,下午,部,去,晚上,他,苹果手机,她,中午,的,买,吃饭,了,电脑,买了,在,吃,两,饭,手机,顿,吃了(逗号为英语状态)理论上,中文词库越详细,词条越多,分词越准确。

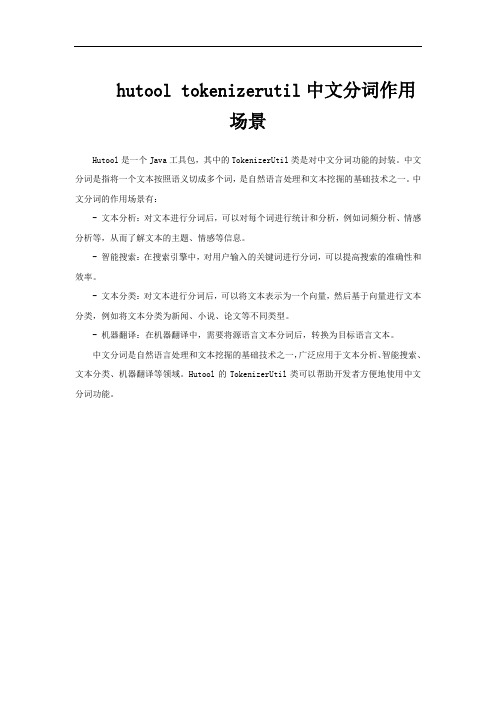

hutool tokenizerutil中文分词作用场景

hutool tokenizerutil中文分词作用

场景

Hutool是一个Java工具包,其中的TokenizerUtil类是对中文分词功能的封装。

中文分词是指将一个文本按照语义切成多个词,是自然语言处理和文本挖掘的基础技术之一。

中文分词的作用场景有:

- 文本分析:对文本进行分词后,可以对每个词进行统计和分析,例如词频分析、情感分析等,从而了解文本的主题、情感等信息。

- 智能搜索:在搜索引擎中,对用户输入的关键词进行分词,可以提高搜索的准确性和效率。

- 文本分类:对文本进行分词后,可以将文本表示为一个向量,然后基于向量进行文本分类,例如将文本分类为新闻、小说、论文等不同类型。

- 机器翻译:在机器翻译中,需要将源语言文本分词后,转换为目标语言文本。

中文分词是自然语言处理和文本挖掘的基础技术之一,广泛应用于文本分析、智能搜索、文本分类、机器翻译等领域。

Hutool的TokenizerUtil类可以帮助开发者方便地使用中文分词功能。

11大Java开源中文分词器的分词效果对比

map.put("Stanford分词器",newStanfordEvaluation().segMore(text));

map.put("Ansj分词器",newAnsjEvaluation().segMore(text));

});

});

}

publicstaticvoidmain(String[] args){

show(contrast("我爱楚离陌"));

showMore(contrastMore("我爱楚离陌"));

}

运行结果如下:

********************************************

1、【smartcn】我爱楚离陌

FudanNLP分词器的分词结果:

1、【FudanNLP】我爱楚离陌

Jieba分词器的分词结果:

1、【SEARCH】我爱楚离陌

2、【INDEX】我爱楚离陌

Jcseg分词器的分词结果:

1、【简易模式】我爱楚离陌

2、【复杂模式】我爱楚离陌

MMSeg4j分词器的分词结果:

1、【SimpleSeg】我爱楚离陌

2、【ComplexSeg】我爱楚离陌

3、【MaxWordSeg】我爱楚离陌

IKAnalyzer分词器的分词结果:

1、【智能切分】我爱楚离陌

2、【细粒度切分】我爱楚离陌

********************************************

map.keySet().forEach(k->{

friso中文分词

friso中文分词

Friso是一个基于Java的中文分词工具,它可以帮助用户对中

文文本进行分词处理。

Friso使用了基于词典的分词算法,通过加

载中文词典来进行分词操作。

用户可以通过调用Friso的API来实

现中文分词的功能,从而对中文文本进行分词处理。

Friso的中文分词功能可以帮助用户实现对中文文本的分词操作,将连续的中文字符序列切分成有意义的词语。

这对于中文文本

的处理和分析非常重要,可以帮助用户理解文本的含义,进行文本

挖掘和信息检索等操作。

Friso中文分词工具的优点之一是它支持用户自定义词典,用

户可以根据自己的需求,添加特定领域的词汇到词典中,从而提高

分词的准确性和适用性。

此外,Friso还支持对未登录词的识别,

能够较好地处理一些新出现的词汇。

除此之外,Friso还提供了多种分词模式,包括最大匹配模式、最小匹配模式和搜索引擎模式等,用户可以根据具体需求选择合适

的分词模式。

这些模式的灵活性可以满足不同场景下的分词需求。

总的来说,Friso作为一个基于Java的中文分词工具,具有较高的准确性和灵活性,可以帮助用户实现对中文文本的有效分词处理。

它的特点包括支持用户自定义词典、对未登录词的识别以及多种分词模式选择,这些特性使得Friso在中文文本处理领域具有一定的竞争优势。

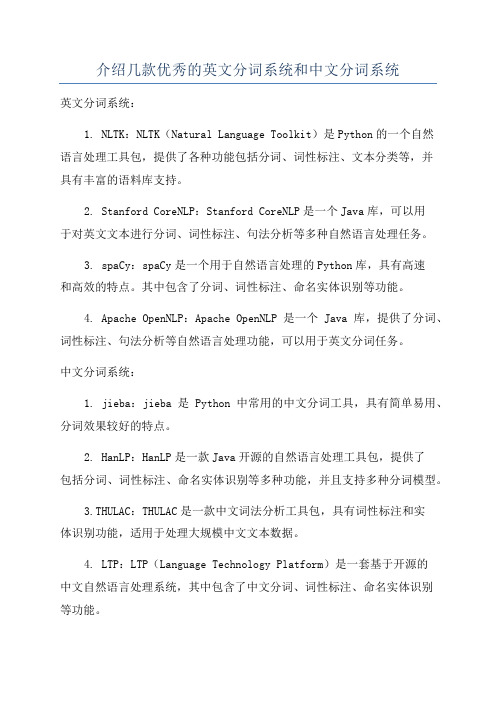

介绍几款优秀的英文分词系统和中文分词系统

介绍几款优秀的英文分词系统和中文分词系统

英文分词系统:

1. NLTK:NLTK(Natural Language Toolkit)是Python的一个自然

语言处理工具包,提供了各种功能包括分词、词性标注、文本分类等,并

具有丰富的语料库支持。

2. Stanford CoreNLP:Stanford CoreNLP是一个Java库,可以用

于对英文文本进行分词、词性标注、句法分析等多种自然语言处理任务。

3. spaCy:spaCy是一个用于自然语言处理的Python库,具有高速

和高效的特点。

其中包含了分词、词性标注、命名实体识别等功能。

4. Apache OpenNLP:Apache OpenNLP是一个Java库,提供了分词、词性标注、句法分析等自然语言处理功能,可以用于英文分词任务。

中文分词系统:

1. jieba:jieba是Python中常用的中文分词工具,具有简单易用、分词效果较好的特点。

2. HanLP:HanLP是一款Java开源的自然语言处理工具包,提供了

包括分词、词性标注、命名实体识别等多种功能,并且支持多种分词模型。

3.THULAC:THULAC是一款中文词法分析工具包,具有词性标注和实

体识别功能,适用于处理大规模中文文本数据。

4. LTP:LTP(Language Technology Platform)是一套基于开源的

中文自然语言处理系统,其中包含了中文分词、词性标注、命名实体识别

等功能。

以上是一些较为常用和优秀的英文分词系统和中文分词系统,可以根据具体的需求选择使用。

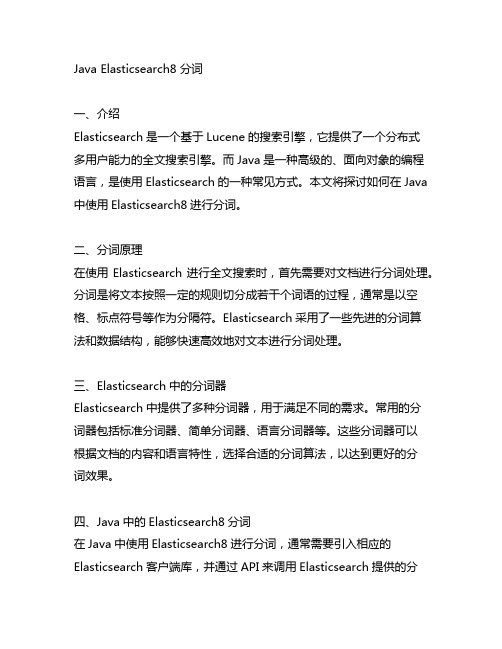

java elasticsearch8 分词

Java Elasticsearch8 分词一、介绍Elasticsearch是一个基于Lucene的搜索引擎,它提供了一个分布式多用户能力的全文搜索引擎。

而Java是一种高级的、面向对象的编程语言,是使用Elasticsearch的一种常见方式。

本文将探讨如何在Java 中使用Elasticsearch8进行分词。

二、分词原理在使用Elasticsearch进行全文搜索时,首先需要对文档进行分词处理。

分词是将文本按照一定的规则切分成若干个词语的过程,通常是以空格、标点符号等作为分隔符。

Elasticsearch采用了一些先进的分词算法和数据结构,能够快速高效地对文本进行分词处理。

三、Elasticsearch中的分词器Elasticsearch中提供了多种分词器,用于满足不同的需求。

常用的分词器包括标准分词器、简单分词器、语言分词器等。

这些分词器可以根据文档的内容和语言特性,选择合适的分词算法,以达到更好的分词效果。

四、Java中的Elasticsearch8分词在Java中使用Elasticsearch8进行分词,通常需要引入相应的Elasticsearch客户端库,并通过API来调用Elasticsearch提供的分词功能。

以下是一个简单的示例代码:```// 创建一个Elasticsearch客户端RestHighLevelClient client = new RestHighLevelClient(RestClient.builder(new HttpHost("localhost", 9200, "网络协议")));// 创建一个分词请求AnalyzeRequest request =AnalyzeRequest.withIndexAnalyzer("index", "standard", "Elasticsearch is a distributed search engine.");// 执行分词请求AnalyzeResponse response = client.indices().analyze(request, RequestOptions.DEFAULT);// 处理分词结果List<AnalyzeResponse.AnalyzeToken> tokens = response.getTokens();for (AnalyzeResponse.AnalyzeToken token : tokens) {System.out.println(token.getTerm());}// 关闭Elasticsearch客户端client.close();```以上示例代码中,首先创建了一个Elasticsearch客户端,并指定了连接的位置区域和端口。

Java实现简易的分词器功能

Java实现简易的分词器功能业务需求:⽣活中常见的搜索功能⼤概可分为以下⼏类:单关键词。

如“Notebook”双关键词加空格。

如“Super Notebook”多关键词加多空格。

如“Intel Super Notebook”当然,还有四甚⾄五关键词,这些搜索场景在⽣活中可以⽤罕见来形容,不在我们的讨论范围。

我们今天就以上三种⽣活中最常见的搜索形式进⾏探讨分析。

业务需求也很简单,假设我们要完成⼀个搜索功能,业务层、持久层、控制层不在我们讨论的范围,仅讨论分词功能如何实现。

分析:假设⽤户键⼊的搜索内容为以下内容:Intel Super Notebook我们可以利⽤Java中String强⼤⽽丰富的⽅法来慢慢拼凑⼀个⼩算法来达到⽬的。

String中⼤多数⽅法的参数和返回值都与下标相关,那么,分析上述语句的下标,我们可发现如下内容:上述内容红⾊是我们分词的关键内容。

对于⼀个语句⽽⾔(不是语⾔学上通俗的语句,因为该句没有主谓宾),重要的就是各单词或词组的⾸字母下标与该单词或词组后⾯最近⼀个空格。

我们发现,Intel这个单词⾸字母下标为0,距离该单词后⾯最近的⼀个空格下标为5;Super⾸字母下标为距离该单词前⾯最近的⼀个空格的下标加1,也就是6;Notebook⾸字母下标为距离该单词前⾯最近的⼀个空格的下标加1,也就是12;最后就是该语句的尾下标,也就是19。

当然,实际情况会有⽤户多输⼊了两个甚⾄三个空格在某两个单词之间,例如如下形式:Intel Super Notebook(注意这⾥的空格为每个单词之间为2个)这个问题很容易解决,我们把两个或三个空格替换为⼀个空格即可(为什么不是四个或者更多?因为现实情况是⽤户不太可能在各个单词之间连按多个空格),如下:sentence = sentence.replace(" ", " ");sentence = sentence.replace(" ", " ");这样以来语句中就只存在单个空格了。

分词器——精选推荐

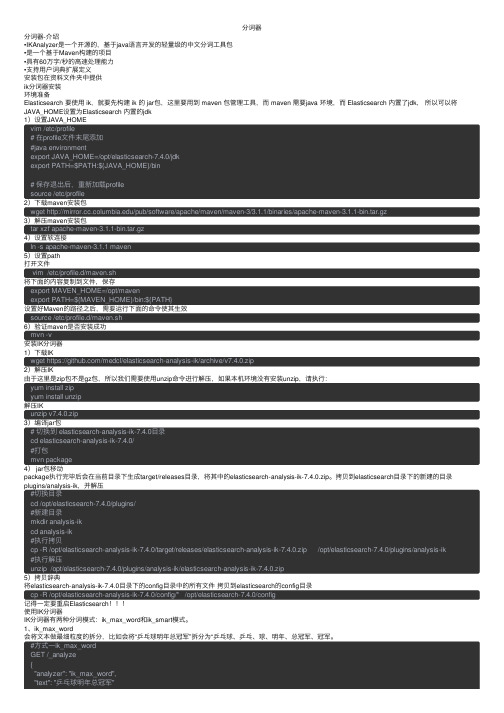

分词器分词器-介绍•IKAnalyzer是⼀个开源的,基于java语⾔开发的轻量级的中⽂分词⼯具包•是⼀个基于Maven构建的项⽬•具有60万字/秒的⾼速处理能⼒•⽀持⽤户词典扩展定义安装包在资料⽂件夹中提供ik分词器安装环境准备Elasticsearch 要使⽤ ik,就要先构建 ik 的 jar包,这⾥要⽤到 maven 包管理⼯具,⽽ maven 需要java 环境,⽽ Elasticsearch 内置了jdk,所以可以将JAVA_HOME设置为Elasticsearch 内置的jdk1)设置JAVA_HOMEvim /etc/profile# 在profile⽂件末尾添加#java environmentexport JAVA_HOME=/opt/elasticsearch-7.4.0/jdkexport PATH=$PATH:${JAVA_HOME}/bin# 保存退出后,重新加载profilesource /etc/profile2)下载maven安装包wget /pub/software/apache/maven/maven-3/3.1.1/binaries/apache-maven-3.1.1-bin.tar.gz3)解压maven安装包tar xzf apache-maven-3.1.1-bin.tar.gz4)设置软连接ln -s apache-maven-3.1.1 maven5)设置path打开⽂件vim /etc/profile.d/maven.sh将下⾯的内容复制到⽂件,保存export MAVEN_HOME=/opt/mavenexport PATH=${MAVEN_HOME}/bin:${PATH}设置好Maven的路径之后,需要运⾏下⾯的命令使其⽣效source /etc/profile.d/maven.sh6)验证maven是否安装成功mvn -v安装IK分词器1)下载IKwget https:///medcl/elasticsearch-analysis-ik/archive/v7.4.0.zip2)解压IK由于这⾥是zip包不是gz包,所以我们需要使⽤unzip命令进⾏解压,如果本机环境没有安装unzip,请执⾏:yum install zipyum install unzip解压IKunzip v7.4.0.zip3)编译jar包# 切换到 elasticsearch-analysis-ik-7.4.0⽬录cd elasticsearch-analysis-ik-7.4.0/#打包mvn package4) jar包移动package执⾏完毕后会在当前⽬录下⽣成target/releases⽬录,将其中的elasticsearch-analysis-ik-7.4.0.zip。

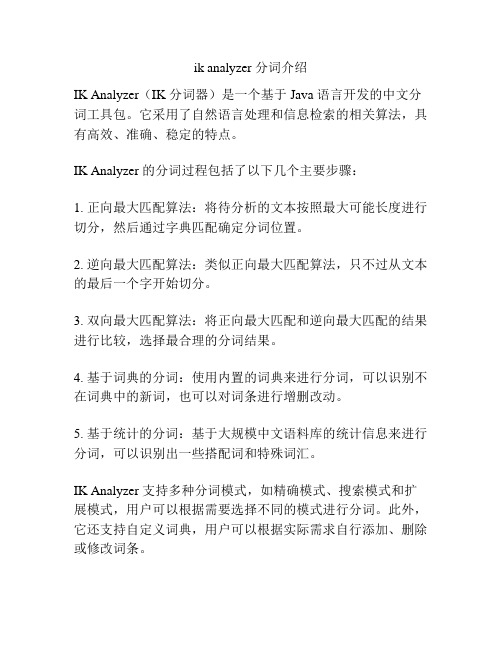

ik analyzer 分词介绍

ik analyzer 分词介绍

IK Analyzer(IK 分词器)是一个基于 Java 语言开发的中文分词工具包。

它采用了自然语言处理和信息检索的相关算法,具有高效、准确、稳定的特点。

IK Analyzer 的分词过程包括了以下几个主要步骤:

1. 正向最大匹配算法:将待分析的文本按照最大可能长度进行切分,然后通过字典匹配确定分词位置。

2. 逆向最大匹配算法:类似正向最大匹配算法,只不过从文本的最后一个字开始切分。

3. 双向最大匹配算法:将正向最大匹配和逆向最大匹配的结果进行比较,选择最合理的分词结果。

4. 基于词典的分词:使用内置的词典来进行分词,可以识别不在词典中的新词,也可以对词条进行增删改动。

5. 基于统计的分词:基于大规模中文语料库的统计信息来进行分词,可以识别出一些搭配词和特殊词汇。

IK Analyzer 支持多种分词模式,如精确模式、搜索模式和扩展模式,用户可以根据需要选择不同的模式进行分词。

此外,它还支持自定义词典,用户可以根据实际需求自行添加、删除或修改词条。

总之,IK Analyzer 是一款功能强大且易于使用的中文分词工具,可以帮助用户对中文文本进行高效、准确的分词处理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

关键 词 : 中文 分词 ; 词典; 最 大 匹配 ; 双 哈 希 中 图分类 号 : G 6 4 2 . 0 文献标 志码 : A

一

文章 编 号 : 1 6 7 4 — 9 3 2 4 ( 2 0 1 3 ) 2 4 — 0 1 5 1 — 0 4

、

深入 地积 累 实践 经验 , 为 学生 在 未来 的创 意产 业 实 践 中起 到很 好 的铺 垫和 指 引作 用 。三 要 建全 管 理 机制 , 包 括 完善

人才引进机制 , 实施系统的培训机制 , 健全科学 的绩效考 核机制 , 建立有效 的分配激励机制 , 使 高校对师 资队伍 的

管理 更加 科 学 、 高效。 在高等教育内涵式发展 的理念下 , 高校的创意人才培 养必须建立多元化 的人才培养模式 , 调整专业结构 优化

课程体系, 全面提高教学质量 , 加强教师队伍建设 , 坚持走 内涵式发展的道路 , 不断为文化创意产业发展提供强有力

的人 才保 证 和智 力支 撑 。

“ 和服” , 得到 的结果中就发现了下面这句话“ 通信信息报 : 卡 巴斯基以技术和服务开拓网络安全市场” ,这就是 由于

分 词 不 准确 所 造 成 的 问题 。从 这 里 看 到 中文 分 词 的准 确 度, 对搜索引擎结果相关性和准确性有相当大的关系。另

的比对来实现对信息的检索和查找 。 而这个将用户输入文 字 串拆分 成 词 的过程 就 是分 词 。 2 . 目 前 的分词算法。现有 的分词算法可分为三大类 : 基于字符 串匹配 、 基于理解和基于统计 的分词算法 。基 于 字符串匹配的分词算法又叫做机械分词算法 , 它是按照一 定 的策 略 将 待分 析 的汉 字 串与 一 个 “ 充 分大的” 机 器 词 典

绪论

对 于 搜索 引 擎 的速度 也 是有 影 响 的 。

二、 分 词 的方 法

对 于搜 索 引擎 来说 ,最重 要 的并 不 是 找到 所 有结 果 , 因为在 上 百亿 的 网页 中找 到所 有结 果 没 有太 多 的 意义 , 也 没 有人 能看 得 完 ,最重 要 的是 把 最 相关 的结 果 J A V A 的小型 中文分词 系统

宋哲伦

( 河北 大学 附属 医 院 , 河北 保定 0 7 1 0 0 0 )

摘要 : 互联 网信 息飞速 增 长 , 网络 资 源不 断增 加 , 于是 搜 索 引擎应 运 而 生 , 它 的 出现 为我 们 在 网络 上 搜 集我 们 所 需要 的 资 源提供 了很 大 的方 便 , 但是 人 们 并不 满足 于早 期 的搜 索引 擎的 功 能和 速度 , 于是 搜 索 引 擎开 始 不 断地被 更新 和 完善 , 而 分词 对 于搜 索 引擎 的更新 和 完善 起 着很 重要 的作 用。 分词 作 为搜 索引 擎的 重要 组成 部 分 , 对搜 索 引擎 的查 找 正确 率 以及 查 找速 度具 有很 大的影 响 。 它将 用 户输入 的语 句分 割成 一 个个 词语 和 单 字 , 这 样检 索程 序 就 能很 容 易地 理解 用 户所 需要 的信 息. 从 而为 用 户返 回正确 且有 价值 的 信 息资料 。 本 文 通过 对 正 向最 大 匹配 、 逆 向最 大 匹配等 分 词算 法 以及 词典 的 整词 二 分 、 T RI E索引树 、 逐 字二 分和 双哈 希构 造 方 法进 行 理 论 分析 , 了解各 种 分 词 算 法和 词 典 构 造 方 法的 优 点和 缺 点 , 并用J a v a 编 程 实现 正 向最 大匹 配 、 逆 向 最大 匹配 的分 词 算 法 以及 一 维 线性 表 、 首 字哈 希 、 双 哈 希 三 种词 典 构 造 方 法 , 最 终 整合 实现 了

生 自主学 习 、 独 立思 考 和 创 新 的 意识 , 激 发 学 生 的学 习 热 情, 提高学生 的实际操作能力 。②高校要学会用现代化 的 教 学手 段来 辅 助教 学 ,要 推进 信 息技 术 在教 学 中的应 用 , 增 强学 生运 用 网络 资源 学 习 的能力 。 ③ 高校 可 以通 过开 展

外, 在整个搜索过程 中进场要进行词典 的查询 , 所 以分词

不难看出今后我国高等教育发展将以全 面提高教学质量 为重点 , 走 内涵式发展之路。 高校加快教学改革势在必行 , 可 以从 以下 几 个方 面着 手 : ① 要 重视 学 生 在教 学 活 动 中 的 主体地位 , 充分调动学生学习的积极性 、 主动性 。 在教学过 程 中要 改革 “ 填 鸭式 ” 的教 学 方 法 , 积极 实践 启 发 式 、 讨 论 式等生动活泼 的教学方法 , 要重视实践教学环节 , 培养学

1 . 分词 的意义。由于 中文语句没有 自然的将词语分 开, 所 以计算 机无法 了解用户输入文字 串的意思 , 我们需

要 将 用户 输 入 的 内容 拆 分成 词 , 这样 计 算 机才 能 通 过词 语

面, 这也称为相关度排序 。 中文分词的准确与否 , 常常直接 影响到对搜索结果 的相关度排序。 例如在搜索引擎上输入

2 0 1 2 , ( 2 ) : 1 2 9 — 1 2 9 .

参考 文献 :

课外实践活动以及建立教学实 习制度 , 打造培养学生实践 能力的多维平台。高校要加强与企业 的合作 , 可 以组织教 师和学生参与企业调研 ,将理论学习与企业实践结合 , 从

而 提升 学生 的创 新 意识 和 实践 能力 。

【 1 1 7 - 9琦. 谈文化创 意产业发展 与高校文化创意人才培养U l l 艺术 教育 , 2 0 1 0 , ( 1 2 ) : 1 5 1 - 1 5 1 . 【 2 】 曹丹 高校 文化创 意类专业人才培养模 式探 析 U 】 _ 天 中学刊 ,