求解大规模矩阵特征问题的并行算法研究

高性能计算中的大规模矩阵运算技巧

大规模矩阵运算技巧是高性能计算中的重要研究领域,其在科学计算、工程仿真等领域具有广泛应用。

本文将从优化算法、并行计算以及降低存储需求等方面探讨大规模矩阵运算的技巧,以期帮助读者更好地理解和应用这一领域的知识。

一、优化算法矩阵乘法是大规模矩阵运算中的最基本操作之一。

针对大规模矩阵乘法,传统的算法复杂度较高,运算时间较长。

因此,研究者们提出了多种优化算法,以加速矩阵乘法的运算。

一种常见的优化算法是Strassen算法,其基于一个关键的观察:两个矩阵相乘,可以将它们划分为四个子矩阵的乘法。

通过递归地应用这一划分方法,可以将矩阵乘法的时间复杂度从O(n^3)降低到O(n^log2(7)),提高了计算效率。

此外,还有一类基于快速傅里叶变换的算法,如著名的Cooley-Tukey算法。

这种算法利用了傅里叶变换的分治思想,将矩阵乘法问题转化为复数相乘的问题,并利用快速傅里叶变换的高效性质,将计算复杂度降低到O(n^log2(n))。

二、并行计算并行计算是解决大规模矩阵运算问题的重要手段。

利用多个处理器或计算节点同时进行计算,可以大大缩短计算时间,提高计算效率。

通常,可以通过两种方式进行并行计算:数据并行和任务并行。

数据并行是将矩阵划分为多个子矩阵,每个处理器或节点对应处理一个子矩阵的计算;任务并行是将矩阵乘法分解为多个子任务,每个处理器或节点负责处理一个子任务的计算。

两种并行方式各有优势,根据具体情况选择适合的方式。

在实际应用中,还需要考虑并行计算中的负载均衡问题。

负载均衡是指在多个处理器或节点之间,使得每个处理器或节点的计算任务尽可能均衡。

避免出现某个处理器或节点计算任务过重而导致整体计算效率下降的情况。

三、降低存储需求大规模矩阵的存储需求通常很大,而存储效率的提高对于高性能计算来说至关重要。

矩阵压缩是一种常用的降低存储需求的技术。

其中,最常用的是稀疏矩阵压缩技术。

稀疏矩阵是指矩阵中大部分元素为零的矩阵。

传统存储方法将所有元素都存储下来,但这样会浪费大量存储空间。

基础科研训练报告基于CUDA的矩阵求逆并行算法

基础科研训练报告——基于CUDA的矩阵求逆并行算法研究学院:英才实验学院训练目的基于NVIDIA CUDA实现大规模矩阵求逆的并行算法。

在过程中熟悉NVIDIA CUDA并行运算平台,掌握C++面向对象的程序设计,并且深刻理解矩阵求逆并行算,将其在CUDA平台上实现出来。

需要在运行过后展示出算法中每一部分的运行时间,从而找到瓶颈,为进一步优化算法提供依据和方向。

理论基础Firstly, we introduce several practical ways to compute the inverse of a matrix. Let us review how one particular algorithm for the Cholesky factorization is usually motivated.We consider A = RTR andBy substituting the matrices A and R into A = RTR, we find thatfrom which we conclude thatConsider that before every iteration, quadrant ATL has already been overwritten by RTL . In the body of the loop, a next row and column are exposed, and updated. The row and the column are then included in ATL so that at the end of the iteration, again ATL contains the result RTL . Eventually ATL envelops the entire matrix, at which point A contains the desired R. In order to attain high performance, the computation is typically cast in terms of matrix-matrix multiplications. For the Cholesky factorization, a blocked version of the algorithm can be derived by partitioningwhere A11 and R11 are b*b . By substituting into A = RTR, we find thatwhich is the algorithm we aim to get.The other way of computing the inverse of a matrix is that we assume A to be a matrix of m*k, and B is a matrix of k*n, remarking that C=AB. To get the parallel matrix invasion algorithm of C=AB, based on the p processors we have, we firstly divide the A and B into several blocks. LikeA =(A 1T ,A 2T ,A 3T ...A P T)and B =(B 1,B 2,B 3...B P )Where Ai is a matrix of mi*k, and Bi is a matrix of k*ni, so that we can represent C intoC =AB =A 1A 2...A p æèççççöø÷÷÷÷(B 1,B 2,B 3...B P )then it ’s transparent to find that we can compute each block of C separately, following the stepswe need.① Firstly, we put the data of Ai, Bi into processor i, setting the initial k=1② Then, it is the part for transmission, where the processor I transmit the element in Bi intoprocessor i+1. Obviously, the last processor p transmits the data into the first processor. ③ Each processor computes the product of each group of AiBi, saving the results into Ci, whereremarking that The saving process is based on the sequence of AiBi. ④ When each processor receiving the data from the former processor, the data has to be savedinto the Bi matrix, covering the former data. ⑤ If k<p then set k=k+1 and continue step 2, else if k=p, each processor then compute theproduct of AiBi, and to the end.训练过程说明本次训练分为四个阶段,第一阶段是学习C++面向对象的编程,这一个阶段大概持续了1个月,我们一边看谭浩强的教材,一面找一些例子练习,不久就基本掌握了C++这门语言。

高性能计算中的大规模矩阵运算技巧(十)

高性能计算中的大规模矩阵运算技巧1. 引言高性能计算在科研和工业领域中扮演着至关重要的角色,尤其是在大规模数据处理和分析中。

而大规模矩阵运算作为高性能计算中的关键部分,对于提高运算效率和加速计算过程具有重要意义。

本文将从优化算法、矩阵分解和并行计算等方面介绍一些在高性能计算中常用的大规模矩阵运算技巧。

2. 优化算法在处理大规模矩阵运算时,选择合适的优化算法对于提高计算效率至关重要。

常见的优化算法包括奇异值分解(SVD)、特征值分解(EVD)和QR分解等。

这些算法能够将复杂的矩阵运算问题转化为更简单的形式,并通过特殊的数学变换降低计算复杂度。

3. 矩阵分解矩阵分解是一种将大规模矩阵拆分成多个小规模矩阵或向量的方法,以便在分布式系统中进行并行计算。

常用的矩阵分解方法包括LU分解、Cholesky分解和奇异值分解等。

通过将矩阵分解为更小的部分,可以减少计算所需的时间和资源消耗,提高计算效率。

4. 并行计算在大规模矩阵运算中,利用并行计算的方式可以提高计算速度和效率。

并行计算可以分为任务并行和数据并行两种方式。

在任务并行中,将整个矩阵运算任务分解为多个小任务,使得多个处理器可以同时计算不同部分的矩阵。

而在数据并行中,将矩阵分解为多个子矩阵,并将这些子矩阵分配给不同的处理器进行并行计算。

通过合理选择并行计算的方式,可以充分利用计算资源,提高大规模矩阵运算的效率和速度。

5. 存储和访问优化在大规模矩阵运算中,存储和访问数据的效率对于计算速度和效率也具有重要影响。

通过合理的存储和访问优化策略,可以减少磁盘读写次数和数据传输量,提高访问效率。

常见的优化措施包括数据局部性原理、矩阵压缩存储和缓存技术等。

6. 精度和精确度控制在大规模矩阵运算中,精度和精确度控制是一个需要考虑的重要问题。

由于矩阵运算涉及大量的数据和计算,误差和舍入误差的累积可能导致运算结果的不准确性。

因此,在高性能计算中,确定和控制计算过程中所需的精度和精确度是非常重要的。

大规模稀疏矩阵并行计算

非零元的分布带状分布按块分布……正定性对称性

矩阵的存储方式求解方法的选择求解速度……

直接法

矩阵图重排:一般分为两大类,带宽缩减算法(也常称为外形缩减)和区域分解算法,应用较多的带宽缩减算法CM,RCM,GPS,Rosen算法。一般建议多重方法结合使用:全局方法的全局平衡性、局部方法的局部最优特性。符号分解:确定非零元结构以及相应的消元索引,以便在实际数值分解前确定所需存储资源大小,避免数值分解中动态分配存储空间和复杂的索引策略。构建消去树(elimination tree):确定分解节点之间的分解依赖,即确定分解的顺序并构成并行分解的层次结构。

5/31/2024

大规模稀疏矩阵并行计算

10

代数多重网格法方法选择

对于非结构化网格形成的矩阵,SGS,SSOR方法不易并行,即使使用顶点着色技术,因其粗粒度的并行更适合于传统的多核处理器,并不非常适合GPU这样的细粒度并行的架构。Jacobi方法不具有低通滤波性,因此推荐使用damp-Jacobi和PCG方法作为迭代子,其中damp-Jacobi方法的权值一般取为2/3。在最粗网格上的计算推荐使用直接解法。通常对于二阶椭圆边值问题,几何多重网格法具有更好的计算效率以及收敛速度。

5/31/2024

大规模稀疏矩阵并行计算

16

大规模稀疏矩阵GPU计算程序优化设计探索

分支优化 消除分支结构的小技巧 例如: if( a>b ){ a=c; } else { a=0; } 可以替换为: a=( a>b )*c;

5/31/2024

大规模稀疏矩阵并行计算

17

大规模稀疏矩阵GPU计算程序优化设计探索

12

代数多重网格法方法选择

5/31/2024

超级计算技术中的并行算法与矩阵运算

超级计算技术中的并行算法与矩阵运算在现代科学和工程领域中,超级计算技术发挥着至关重要的作用。

为了解决复杂问题,超级计算机采用了并行算法和矩阵运算等技术,以实现高效的计算和分析。

本文将探讨超级计算技术中的并行算法和矩阵运算,并分析其应用与发展趋势。

首先,我们来了解一下超级计算技术中的并行算法。

并行算法是指将复杂的计算任务分解成多个子任务,然后并发地运行于多个计算单元上,以提高计算效率和性能。

并行算法的设计需要考虑任务分解、通信和同步等关键问题。

常用的并行算法包括分治法、并行排序和并行搜索等。

对于矩阵运算来说,超级计算技术也发挥着重要的作用。

矩阵运算是指对矩阵进行基本的数学运算,诸如加法、减法、乘法和求逆等。

这些矩阵运算在科学计算、图像处理和人工智能等领域中广泛应用。

超级计算技术能够利用并行算法加速矩阵运算的速度,提高计算效率。

在超级计算技术中,矩阵乘法是一种常见且重要的矩阵运算。

矩阵乘法的基本思想是将两个矩阵相乘,得到一个新的矩阵。

然而,传统的矩阵乘法算法在大规模矩阵计算时效率较低,因此需要并行算法的支持。

并行矩阵乘法算法采用了多种策略,如按块分配、循环分配和网络划分等,以充分利用计算资源。

除了矩阵乘法,超级计算技术还可以应用于其他矩阵运算,如矩阵分解和特征值计算等。

矩阵分解是将一个矩阵分解成多个部分矩阵的过程,常见的矩阵分解包括LU分解、QR分解和SVD分解。

这些分解可以帮助我们更好地理解和处理复杂的数学问题。

而特征值计算则是计算一个矩阵的特征值和特征向量,对于解决线性方程组和优化问题都具有重要意义。

随着科学技术的不断发展,超级计算技术中的并行算法和矩阵运算也在不断演进。

首先,随着计算单元和存储器的不断增加,我们可以使用更大规模的矩阵进行计算,从而解决更加复杂的科学问题。

其次,新的并行算法和矩阵运算技术的提出,使得超级计算机能够更快速地处理大规模数据,实现更高效的计算。

最后,超级计算技术的发展也推动了云计算和人工智能等领域的进步,使得计算资源得到充分利用。

高性能计算中的矩阵计算优化与并行算法研究

高性能计算中的矩阵计算优化与并行算法研究概述高性能计算是一项重要的领域,研究人员一直致力于提高计算机系统的运算速度和效率。

在高性能计算的应用中,矩阵计算是一项经常需要处理的任务。

矩阵计算涉及大规模的矩阵操作,如矩阵乘法、矩阵分解等,因此研究和优化矩阵计算算法具有重要的意义。

本文将探讨高性能计算中矩阵计算的优化与并行算法的研究。

矩阵计算优化的挑战在高性能计算中,矩阵计算往往需要处理大规模的矩阵,这就带来了一系列的挑战。

首先,矩阵计算的存储和计算需求非常高,在有限的存储和计算资源下,如何高效地利用这些资源成为了一个关键问题。

其次,大规模矩阵计算的计算复杂度较高,需要大量的计算时间,如何提高计算速度是另一个亟待解决的问题。

此外,矩阵计算涉及大量的数据传输和通信操作,如何降低通信开销,提高算法的并行性也是一个重要的研究方向。

矩阵计算优化策略为了解决上述挑战,研究人员提出了各种优化策略和算法。

下面将介绍一些常用的矩阵计算优化策略。

1. 内存优化内存优化是提高矩阵计算效率的关键一步。

在高性能计算中,借助数据局部性原理,研究人员提出了一系列的内存优化策略。

例如,使用分块矩阵存储方法可以减少数据访问带宽,提高矩阵乘法的计算效率。

此外,研究人员还探索了压缩存储和稀疏矩阵存储方法,以降低存储空间开销。

2. 并行计算并行计算是提高矩阵计算效率的重要手段。

通过将计算任务划分为多个子任务,并利用多个计算节点同时进行计算,可以显著提高计算速度。

在矩阵计算中,研究人员经常使用并行计算模型,如MPI和OpenMP等,以实现矩阵的并行计算。

例如,在矩阵乘法中,可以将矩阵划分成多个子矩阵,分布到不同的计算节点上进行并行计算。

3. 矩阵算法优化优化矩阵算法可以显著提高矩阵计算的效率。

研究人员提出了一系列的矩阵算法优化方法,如Strassen算法、Coppersmith-Winograd算法等。

这些算法利用了矩阵的特殊结构和性质,减少了计算的复杂度。

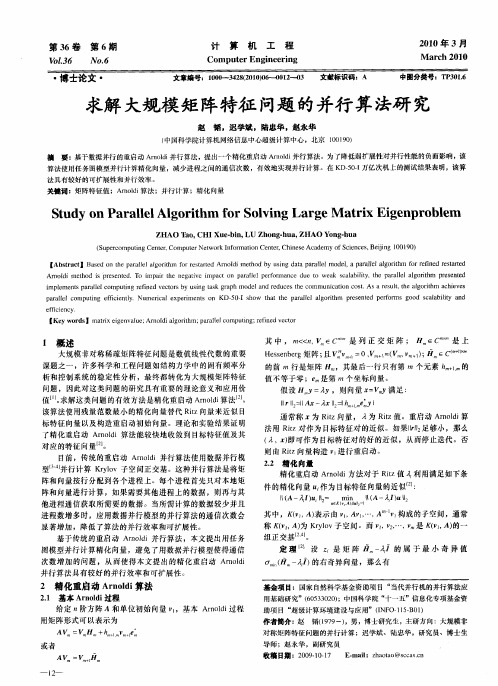

求解大规模矩阵特征问题的并行算法研究

中 图分类号: P0. T 31 6

求解 大规模 矩 阵特征 问题 的并行 算 法研 究

赵 韬 ,迟学斌 ,陆忠华 ,赵永华

( 中国科学院计算机网络信息中心超 级计算 中心,北京 10 9 ) 0 10

摘

要: 基于 数据并行 的重启动 A nli ro 并行算法, 出一个精化重启 动 A n l 并行算法。为了降低弱扩展性对并行性能 的负面影响, d 提 r d o i 该

算法使用任务 图模型并行计算精化 向量 , 减少进程之间的通信次数 ,有效地实现并行计算。在 K 一 一 万亿次机上的测试结果表明 , D5 I 0 该算

法具有较好 的可扩展性 和并行效率 。 关键词 :矩阵特征值 ;A li mod 算法 ;并行计算 ;精化 向量

S u y 0 r l l g rt m o o v n r eM a rx Ei e p o lm t d n Pa al o ih f rS l i g La g t i g n r b e e Al

第3 6卷 第 6期

V 13 o.6

・

计

算

机

工

程

21 0 0年 3月

M a c 01 r h2 0

No. 6

Co pu e m t rEng ne r ng i ei

博 士论 文 ・

文章 编号:l 0’ 2( l) J 2 0 文献标识 A I _3 8 00 一o — 3 J _4 2 0 1 0 码;

[ ywod ]ma i egn au ; rod loi m; aallo uig rf e etr Ke rs tx iev [ A n li g rh prl mp t ;e ndvco r e a t ec n i

矩阵分解理论与算法的并行实现

矩阵分解理论与算法的并行实现矩阵分解是一种重要的数学方法,广泛应用于数据分析、机器学习、推荐系统等领域。

近年来,随着计算机硬件的发展和并行计算技术的成熟,矩阵分解的并行实现得到了越来越广泛的应用和研究。

本文将探讨矩阵分解理论与算法的并行实现,并介绍一些常见的并行算法。

一、矩阵分解理论的基础矩阵分解是将一个复杂的矩阵分解为多个简单的子矩阵,以便更好地解决问题或进行计算。

常见的矩阵分解方法包括奇异值分解(SVD)、QR分解、LU分解等。

这些方法可以将一个矩阵分解为不同的形式,用于不同的应用场景。

二、矩阵分解算法的串行实现在传统的计算环境中,矩阵分解算法通常以串行的方式实现。

串行算法的基本思想是按照某种顺序逐步对矩阵进行分解,直至达到期望的结果。

然而,随着问题的规模不断增大,串行算法的计算效率逐渐变得低下。

三、矩阵分解算法的并行实现为了提高矩阵分解算法的计算效率,研究者们开始将并行计算技术引入到矩阵分解算法中。

并行算法的基本思想是将计算任务分配给多个处理单元,并行地进行计算。

通过充分利用计算资源,可以加速矩阵分解的过程。

常见的矩阵分解算法的并行实现包括以下几种:1. 并行奇异值分解(Parallel SVD)并行奇异值分解是一种将SVD算法进行并行实现的方法。

该方法通过将矩阵分割为多个子矩阵,然后将这些子矩阵分别送至不同的处理单元进行计算,最后将结果合并得到最终的奇异值分解结果。

并行奇异值分解可以显著提高计算效率,尤其适用于大规模矩阵的分解。

2. 并行QR分解(Parallel QR)并行QR分解是一种将QR分解算法进行并行实现的方法。

该方法通过将矩阵分割为多个子矩阵,然后将这些子矩阵分别送至不同的处理单元进行计算,最后将结果合并得到最终的QR分解结果。

与串行算法相比,并行QR分解能够以更快的速度完成分解过程。

3. 并行LU分解(Parallel LU)并行LU分解是一种将LU分解算法进行并行实现的方法。

超大规模数据计算中的并行算法研究

超大规模数据计算中的并行算法研究随着计算机技术的不断发展和普及,数据产生的速度不断增长,数据存储和处理的能力也越来越强。

超大规模数据计算在当今社会中日益普及,对于解决许多实际问题起着至关重要的作用。

而在超大数据规模的处理中,数据量巨大,处理速度慢,如何在最短的时间内完成数据处理,成为了亟待解决的问题。

并行算法成为了其中重要的解决方案。

本文主要对超大规模数据计算中的并行算法进行探讨。

一、背景数据处理的规模不断扩大并带来了超大规模数据计算的需求。

科学家和工程师们需要处理一个庞大的数据集合,以回答许多问题。

例如,需要对各种传感器收集的数据进行处理,以获得对环境的深刻理解。

需要快速对一个生物数据集进行处理,以找到对治疗癌症有帮助的新医药。

所有这些问题都越来越需要具有超大数据计算的能力。

二、并行计算超大数据计算的核心在于并行计算。

并行计算是指在处理同一问题的多个实例时,每个实例使用各自的处理器和内存,以同时完成该问题的不同部分处理的计算方式。

并行计算通过协同多个处理器的计算能力,使得处理程序的执行时间可以线性缩短。

同时,由于超大数据计算的硬件和网络是高度分布式的,大量的数据仍然可以分布在多台计算机或数据中心中。

并行算法的实现需要解决多个问题。

第一个问题是如何分解和安排计算任务,以便它们可以在处理器上并行执行。

第二个问题是如何使用通信来在任务之间共享数据,以便建立一个相互协作的计算结构。

第三个问题是如何平衡计算任务与与之相关的数据挪动。

三、并行算法的分类通常,我们将并行算法分为以下两类:数据并行和任务并行。

一、数据并行数据并行是将数据集分成多个均匀的部分,并将每个部分分配到不同的处理器上。

每个处理器都使用相同的计算代码,以对分配给它的数据子集进行计算。

在数据并行中,每个处理器对其分配的数据执行相同的操作。

因此,数据并行算法的时间复杂度与数据集的大小成比例。

二、任务并行任务并行是将执行相同或相关操作的程序分解为不同的任务,并将每个任务分配到不同的处理器上。

一种大规模数据并行计算方法的改进研究

在图 1 所示的大规模数据的分布式数据结构传输模型构 建的基础上,构建大规模数据的信息流模型,构建 Hash、 Prefix 和 Shit 表,对大规模数据信息流通过最小二乘分解写 成矩阵形式为: Y=Xβ+e (4) 其中 Y 为 n×1 的大规模数据并行计算的时间成本,X 为 n×m 的空间特征向量矩阵,β 为 m×1 的测量向量,e 为 n×1 的随机误差向量。通过将大数据信息流的高维矩阵转换 为低维矩阵,降低数据并行计算成本,考虑数据在并行计算 中融特征亏损的情况,即 r < m,则在网格空间中数据的融 合子空间∑可表示为:

云计算是通过网格式的并行计算方式实现数据的多线程

1 大规模数据的分布式结构特征分析和信息流模型 构建

为了实现对大规模数据的并行计算处理,首先构建大 规模数据的并行计算数据流的传输调度和控制模型,构建 HDFS 平台进行大规模数据的分片处理,采用 Hadoop 分布 式文件得到大规模数据的核心函数,假设 Y 为大规模数据的 状态特征变量,X1,X2…Xm-1 为 HDFS 输入的数据分片自变量, HDFS 在执行数据分片过程中的输入输出线性关系描述为: Y=β0+β1X1+β2X2…βm-1Xm-1+e (1) 其中 e 为单模式匹配扰动误差项,它表示小于块大小的 数据时间片的测量误差。采用 Hash 列表分解方法得到大规 模数据集的 n 组观测值为: (xi1,xi2,…xi,m-1,yi),i=1,2,…,n 当满足以下数学模型: (2)

2 大规模数据并行计算改进设计与实现

在上述进行的大规模数据信息流并行计算的数据分布式 结构分析和信息流模型构建的基础上,进行并行计算的算法 改进设计,提出基于奇异值特征分解的大规模数据并行计算 方法。基于奇异值特征分解对大规模数据信息流进行特征分 解,首先构建模糊隶属函数,根据特征空间奇异值的正交矩 阵的保范性,得到大规模数据的每个特征值混合融合矩阵为:

矩阵特征值分解算法实现的并行化与优化

矩阵特征值分解算法实现的并行化与优化矩阵特征值分解是一种重要的数值计算方法,可以将一个矩阵拆解为特征向量和对应的特征值。

这一算法的应用广泛,涵盖了数学、物理、工程等多个领域。

然而,矩阵特征值分解的计算复杂度较高,限制了其在大规模数据和实时计算场景中的应用。

因此,实现并行化与优化的研究成为目前的热点之一。

在本文中,我们将探讨矩阵特征值分解算法的并行化与优化方法。

首先,我们介绍传统的特征值分解算法,然后讨论并行化的思路和方法。

最后,我们将针对不同的优化需求,提出相应的优化策略。

一、传统的特征值分解算法传统的特征值分解算法主要有幂法、QR方法和雅可比方法等。

这些方法在串行计算环境下运行,计算复杂度较高。

幂法是最简单的特征值分解算法,但它在实际应用中存在精度不高和收敛速度慢的问题。

QR方法通过将矩阵分解为正交矩阵和上三角矩阵的乘积,然后迭代求得特征值。

雅可比方法将矩阵通过相似变换转化为对角矩阵,再求得其特征值。

然而,这些方法在大规模矩阵计算时,计算时间较长,效率较低。

二、并行化思路和方法为了提高特征值分解算法的计算效率,研究者们开始将并行计算引入其中。

并行化可以通过使用多个处理器或者分布式计算系统来实现。

其中,多核并行化和GPU并行化是两种主要的方向。

1. 多核并行化多核并行化的思路是利用多个处理器并行计算。

可以将矩阵分成多个子矩阵,然后分别在不同的处理器上计算特征向量和特征值。

这样可以大大缩短计算时间。

此外,还可以采用线程池和任务调度等技术来合理管理计算资源,提高并行计算效率。

2. GPU并行化GPU并行化是利用图形处理器的并行计算能力来加速特征值分解算法。

GPU具有大量的计算单元和高带宽的内存,适合于并行计算。

可以将矩阵的计算任务分配给不同的GPU核心,并采用适当的并行算法来提高计算效率。

此外,还可以通过利用GPU的共享内存和纹理内存等特性来加速计算过程。

三、优化策略除了并行化计算,还有一些优化策略可以提高矩阵特征值分解算法的计算效率。

高性能计算中的并行线性代数运算研究与实现

高性能计算中的并行线性代数运算研究与实现1. 引言随着科学技术的不断发展,高性能计算在各个领域中起着越来越重要的作用。

线性代数作为数学的一个重要分支,广泛应用于各个学科领域中的计算问题。

然而,传统的线性代数运算方法在大规模数据计算和高维度问题上效率低下。

为了解决这个问题,研究人员提出了并行线性代数算法,以提高计算效率和缩短计算时间。

2. 并行线性代数算法的概述并行线性代数算法是将线性代数中的运算拆分为多个并行任务,并通过多个处理器同步执行,以加快计算速度。

它主要包括并行矢量操作、并行矩阵运算和并行线性方程求解三个部分。

2.1 并行矢量操作并行矢量操作是指对向量进行并行计算的过程。

通过将向量拆分为多个子向量,并将每个子向量分配给不同的处理器,可以实现向量运算的并行化。

在并行矢量操作中,一些基本的运算包括向量的加法、减法、点积和范数计算等。

2.2 并行矩阵运算并行矩阵运算是指对矩阵进行并行计算的过程。

通过将矩阵划分为多个子矩阵,并将每个子矩阵分配给不同的处理器,可以实现矩阵运算的并行化。

在并行矩阵运算中,一些基本的运算包括矩阵的加法、减法、乘法和求逆等。

2.3 并行线性方程求解并行线性方程求解是指通过多个处理器同时计算线性方程组的解。

并行线性方程求解方法包括直接法和迭代法。

直接法是通过矩阵的LU分解或QR分解等方法,将线性方程组转化为简化形式,并通过多个处理器进行并行计算。

迭代法是通过迭代求解方法,逐步逼近线性方程组的解。

3. 并行线性代数算法的实现并行线性代数算法的实现需要考虑到算法的可扩展性、负载平衡、通信开销和数据局部性等问题。

3.1 可扩展性可扩展性是指算法在增加处理器数量时,能够保持计算速度的线性增长。

为了提高算法的可扩展性,研究人员需要对任务划分和负载均衡进行优化,并采用适当的通信方式。

3.2 负载平衡负载平衡是指在并行计算过程中,使每个处理器上的计算任务尽可能均衡。

为了实现负载平衡,可以采用动态任务划分和任务调度策略,根据处理器的计算能力和通信开销来分配任务。

随机矩阵特征值分解算法并行实现与优化

随机矩阵特征值分解算法并行实现与优化随机矩阵特征值分解算法 (Random Matrix Eigenvalue Decomposition Algorithm) 是一种用于解决大规模矩阵特征值分解问题的有效方法。

随机矩阵特征值分解算法的并行实现和优化是提高算法性能的关键。

本文将对随机矩阵特征值分解算法的并行实现与优化进行探讨。

一、算法原理随机矩阵特征值分解算法是一种基于随机投影和子空间迭代的近似算法。

其基本原理是通过随机投影将原始高维空间映射为低维子空间,然后在低维子空间中进行迭代计算,最终得到原始矩阵的特征值估计。

二、并行实现随机矩阵特征值分解算法具有天然的并行性,可以通过并行计算加速算法的执行速度。

具体而言,可以通过以下方式实现并行计算:1. 数据并行:将原始矩阵分割成多个子矩阵,每个子矩阵由不同的处理单元进行计算。

这样可以将计算任务分配给多个处理单元并行执行,从而提高计算效率。

2. 任务并行:将算法的不同阶段分配给不同的处理单元并行执行。

例如,可以将随机投影和迭代计算阶段分配给不同的处理单元,实现计算的并行化。

三、并行优化为了进一步提高随机矩阵特征值分解算法的并行计算性能,可以采取以下优化策略:1. 数据布局优化:合理调整数据的存储方式和分布,减少数据间的通信和同步开销,提高数据访问效率。

2. 并行任务划分优化:根据不同处理单元的计算能力和负载情况,合理划分算法的并行任务,使得各个处理单元的计算开销均衡,充分利用系统资源。

3. 算法参数调优:通过调整算法的参数,如随机投影的维度、迭代次数等,优化算法的收敛速度和精度,提高算法的计算效率。

四、实验结果与分析对比实验结果表明,并行实现和优化能够显著提高随机矩阵特征值分解算法的计算性能。

通过合理的数据并行和任务并行策略,可以将算法的执行时间减少到原来的一半甚至更少。

同时,通过数据布局优化、并行任务划分优化和算法参数调优,还可以进一步提高算法的计算效率和精度。

高性能计算中的大规模矩阵运算技巧(七)

高性能计算中的大规模矩阵运算技巧引言:随着计算机科学和技术的迅猛发展,高性能计算成为了解决复杂问题和大规模数据分析的重要工具。

在高性能计算中,大规模矩阵运算是一项关键技术。

本文将探讨在高性能计算中实现大规模矩阵运算的技巧和策略,涵盖了并行计算、存储优化和算法选择等方面。

一、并行计算在高性能计算中,使用并行计算是提高矩阵运算效率的必要手段。

并行计算通过将任务分解为多个子任务并同时进行处理,充分利用多核处理器和分布式计算节点的计算能力。

在大规模矩阵运算中,常见的并行计算策略有数据并行和任务并行。

1. 数据并行数据并行是指将矩阵划分为多个子矩阵,并将子矩阵分配到不同的计算节点上进行并行计算。

数据并行可以减少通信开销,提高计算效率。

常用的数据并行方法有行划分、列划分和块划分等。

2. 任务并行任务并行是指将不同的矩阵运算任务分配到不同的计算节点上进行并行计算。

任务并行可以充分利用计算资源,提高计算速度。

常见的任务并行策略有并行求解线性方程组、并行矩阵乘法和并行特征值求解等。

二、存储优化在大规模矩阵运算中,存储优化是提高计算效率的关键。

合理的存储方案和算法设计可以减少数据访问时间和内存消耗,提高计算速度和节约资源。

1. 内存对齐内存对齐是指将数据存储在内存中的连续地址上,以提高访问效率。

在进行大规模矩阵运算时,合理的内存对齐可以减少存取时间、提高缓存利用率,从而提高运算速度。

2. 缓存优化缓存优化是通过合理的数据访问模式和算法设计,减少数据在缓存中的失效次数,提高缓存的命中率。

在大规模矩阵运算中,可以使用局部性原理、循环优化等手段进行缓存优化,进一步提高计算效率。

三、算法选择在大规模矩阵运算中,选择合适的算法也对提高计算效率至关重要。

不同的矩阵运算任务需要选用不同的算法,以便充分发挥计算资源的优势。

1. 并行算法并行算法是在多个计算节点上同时进行计算的算法。

在大规模矩阵运算中,可以选择一些经典的并行算法,如并行矩阵乘法算法、并行特征值求解算法等。

如何优化算法解决大规模数据处理问题(四)

优化算法解决大规模数据处理问题随着互联网技术的飞速发展,大数据已经成为当今社会中不可忽视的重要组成部分。

然而,随之而来的是海量数据的处理问题,如何高效地处理这些大规模数据成为了亟待解决的难题。

优化算法应运而生,成为解决大规模数据处理问题的有效工具。

本文将探讨如何优化算法来解决这一问题。

1. 并行计算并行计算是处理大规模数据的常用方法之一。

它通过同时运行多个计算任务来提高整体计算速度。

在并行计算中,任务被分成多个子任务,并通过多个处理单元或者计算节点进行并行处理,最后将结果进行整合。

通过充分利用多台计算机或者多核处理器的计算能力,可以显著提高数据处理的效率。

为了最大程度地利用并行计算的优势,关键是将任务划分为合理的子任务,并进行任务之间的协调和通信。

例如,可以将数据划分为多个块,并为每个处理单元分配不同的块进行计算。

另外,还可以考虑使用一些常用的并行计算框架,如MapReduce和Spark等,来简化并行计算的实现。

2. 数据压缩与采样大规模数据往往具有较高的维度和冗余,因此可以通过数据压缩和采样等方法来减少数据量,从而提高算法的效率。

数据压缩可以通过消除冗余信息来减少数据的存储和传输量。

常用的数据压缩算法包括哈夫曼编码、Lempel-Ziv-Welch(LZW)算法等。

通过选择合适的数据压缩算法,可以大大减少处理大规模数据所需的时间和空间。

数据采样是从大规模数据集中选择一部分样本进行处理和分析的方法。

通过合理选择采样样本,可以在保证数据的代表性的同时,大大减少计算量。

常用的数据采样方法包括随机采样、分层采样和聚类采样等。

通过合理选择采样方法和样本数量,可以在保证算法结果准确性的前提下,提高计算速度。

3. 分布式计算分布式计算是一种将任务分发到不同的计算节点进行并行处理的方法。

通过利用多台计算机的计算能力,可以有效地处理大规模数据。

在分布式计算中,关键是任务的划分和调度。

可以将任务划分为多个子任务,并将这些子任务分发到不同的计算节点进行处理。

大规模图分析中的图计算算法与优化研究

大规模图分析中的图计算算法与优化研究随着数据量的指数级增长,大规模图分析成为了现代计算领域的一个重要研究方向。

图计算算法和优化成为了解决大规模图分析的关键因素。

本文将探讨大规模图分析中的图计算算法与优化的研究现状和挑战。

一、图计算算法1. 图的存储表示方式在图计算中,选择合适的图的存储表示方式对算法的效率有着重要影响。

目前常用的图的存储方式有邻接矩阵和邻接表。

邻接矩阵适用于稠密图,可以快速地进行图的遍历和连接判断。

邻接表适用于稀疏图,能够有效地节省存储空间和提高遍历效率。

2. 图的遍历算法图的遍历算法是图计算中最基本的操作,包括深度优先搜索(DFS)和广度优先搜索(BFS)。

DFS适用于查找路径、寻找连通分量等问题;BFS适用于广度优先搜索最短路径等问题。

优化遍历算法的关键是减少遍历的时间和空间复杂度,在大规模图上进行高效的遍历操作。

3. 图的聚集与分割算法在大规模图分析中,经常需要将图分割为更小的图进行分析,或将小图聚集为大图进行规模扩展。

图的聚集与分割算法可以减少图计算的复杂度和通信开销。

常用的聚集方法有图的合并、图的压缩和图的约化等。

而图的分割方法有基于顶点的分割和基于边的分割等。

二、图计算优化1. 并行计算大规模图的计算通常需要运用并行计算技术来加速计算过程。

并行计算可以分为顶点并行和边并行两种方式。

顶点并行将计算任务划分为多个顶点,每个顶点独立执行计算;边并行将计算任务划分为多个边,每个边独立执行计算。

并行计算可以充分利用计算资源,提高图计算的效率。

2. 内存与磁盘优化大规模图计算需要处理海量的数据,在资源有限的情况下,如何有效地利用内存和磁盘成为了一个挑战。

内存与磁盘优化包括数据的压缩、分布式存储和内存管理等方面。

压缩算法可以减少数据的存储空间和传输开销;分布式存储可以将数据分布在多个计算节点上,实现数据的并行访问;内存管理可以合理分配内存资源,减少数据交换和IO操作。

3. 基于采样的优化方法对于大规模图的计算,可以采用采样方法来减少计算量。

求解大规模矩阵特征问题的并行算法研究

【Abstract】Based on the parallel algorithm for restarted Arnoldi method by using data parallel model, a parallel algorithm for refined restarted Arnoldi method is presented. To impair the negative impact on parallel performance due to weak scalability, Tthe parallel algorithm presented implements parallel computing refined vectors by using task graph model and reduces the communication cost. As a result, the algorithm achieves parallel computing efficiently. Numerical experiments on KD-50-I show that the parallel algorithm presented performs good scalability and efficiency. 【Key words】matrix eigenvalue; Arnoldi algorithm; parallel computing; refined vector

对于精化重启动 Arnoldi 算法,注意到每个处理器进程

本地都有矩阵 Hm 及其特征值。设需要求解 k 个特征对。如果 将计算一个精化向量作为一个任务,那么每个处理器进程都

可以根据式式(1)式和式式(2)式独立完成 k/P 个任务,而不需

求解大型矩阵特征值问题的并行精化Davidson方法

求解大型矩阵特征值问题的并行精化Davidson方法王顺绪;戴华【摘要】针对共享主存的并行计算环境和微机网络并行计算环境,本文给出了求解人型稀疏对称矩阵的部分极端特征对的并行精化Davidson方法,分析了该法的内在并行性.各处理器利用矩阵的行块和投影了空间的正交皋所组成矩阵的行块进行运算,结合重新启动策略求解矩阵多个特征对的近似值,并用以计算某型号机翼的固有频率,在微机网络并行计算环境和拥有共享土存并行计算环境IBM-P650上进行了数值试验.【期刊名称】《工程数学学报》【年(卷),期】2009(026)005【总页数】7页(P922-928)【关键词】并行计算;特征值问题;Dayidson方法;精化方法【作者】王顺绪;戴华【作者单位】南京航空航天大学理学院,南京,210016;淮海工学院数理系,连云港,222005;南京航空航天大学理学院,南京,210016【正文语种】中文【中图分类】O241;O2461 引言在科学和工程技术领域中,经常需要计算大型稀疏对称矩阵的若干个特征对。

解决这一问题的有效方法是正交投影方法,包括子空间迭代法,Lanczos方法,Arnoldi方法,Davidson方法和Jacobi-Davidson方法[1,2]。

为进一步提高Lanczos方法和Davidson方法的可靠性,Underwood提出了块Lanczos方法[3],戴等提出了预处理块Lanczos方法[4],Crouzeix等人提出了块Davidson 方法[5,6]。

用正交投影方法计算特征值问题的部分特征对时,Ritz向量˜xi可能收敛很慢甚至发散,针对这一问题,贾提出了保留Ritz值˜λi,用满足的精化向量ˆxi代替Ritz向量˜xi的精化思想[7-12],并继而指出其中ˆxi=Viˆzi,ˆzi 是矩阵(A−˜λiI)Vi的最小奇异值σmin对应的右奇异向量,且即不难证明ˆxi=Viˆzi是对应于Ritz值的使本次迭代的残量范数最小的向量,此时的残量范数为σmin,特征值的近似可取为大型矩阵特征值问题的计算是一项很耗时的工作,尽管人们采用多种方法降低计算量,但终因串行思想的限制难以有更大的提高,采用并行计算是一条必由之路。

计算电磁学中的超大规模并行矩量法

计算电磁学中的超大规模并行矩量法超大规模并行矩量法是一种在电磁学中广泛应用的计算方法,它能够高效地求解电磁场问题。

本文将对超大规模并行矩量法进行详细介绍,包括其基本原理、应用领域以及优缺点。

超大规模并行矩量法是一种基于矩量理论的数值计算方法,它通过将电磁场问题离散化为大规模的线性方程组,利用并行计算的方式高效地求解这个方程组,从而得到电磁场的数值解。

与传统的有限元法相比,超大规模并行矩量法具有计算速度快、内存占用少等优点,尤其适用于处理大规模电磁场问题。

在超大规模并行矩量法中,首先需要将电磁场问题离散化为一个线性方程组。

这个方程组的未知数是电磁场的各个节点上的电磁量,而系数矩阵则描述了电磁场的传播关系。

通过求解这个线性方程组,我们可以得到电磁场在离散节点上的数值解。

超大规模并行矩量法的并行计算是该方法的核心特点之一。

由于电磁场问题的规模往往非常大,传统的串行计算方法往往效率低下。

而超大规模并行矩量法通过将大规模计算任务分解为多个小任务,并利用多个计算节点同时进行计算,大大提高了计算效率。

这种并行计算的方式能够充分利用计算资源,加速电磁场问题的求解过程。

超大规模并行矩量法在电磁学中有着广泛的应用。

例如,在天线设计中,我们需要计算天线的辐射特性,而超大规模并行矩量法可以帮助我们高效地求解天线辐射问题。

此外,在电磁散射、微波传输等领域,超大规模并行矩量法也能够提供准确且高效的数值计算结果。

尽管超大规模并行矩量法在电磁学中有着广泛的应用,但它也存在一些限制和挑战。

首先,超大规模并行矩量法在处理非线性问题时会遇到困难,因为非线性问题的求解通常需要更复杂的数值方法。

其次,超大规模并行矩量法的计算效率受到硬件条件的限制,包括计算节点数量和通信带宽等。

因此,在实际应用中需要合理配置计算资源,以充分发挥超大规模并行矩量法的优势。

超大规模并行矩量法是一种在电磁学中应用广泛的计算方法。

它通过离散化电磁场问题并利用并行计算的方式高效地求解了大规模的线性方程组,从而得到电磁场的数值解。

eigen百万级矩阵运算

eigen百万级矩阵运算eigen是一个用于线性代数的C++模板库,提供了丰富的功能和高效的算法,特别适用于大规模矩阵运算。

本文将探讨eigen在处理百万级矩阵运算时的应用和优势。

在科学计算和工程领域,经常需要处理大规模矩阵运算问题。

传统的方法往往面临着计算速度慢、内存占用大等问题。

而eigen通过利用模板元编程和优化算法设计,使得其在处理大规模矩阵运算时表现出色。

eigen提供了高效的矩阵和向量操作接口。

通过简洁的API,我们可以方便地进行矩阵的初始化、赋值、加减乘除等操作。

此外,eigen 还支持矩阵的转置、逆运算、特征值计算等功能,使得我们能够轻松地进行复杂的线性代数运算。

eigen在内存管理和计算优化方面做了很多工作。

对于大规模矩阵运算,内存占用往往是一个关键问题。

eigen通过采用延迟分配内存的策略,能够高效地管理内存空间,避免了不必要的内存浪费。

此外,eigen还利用SIMD指令集进行并行计算,充分发挥了现代处理器的计算能力,加速了矩阵运算的速度。

eigen还提供了丰富的矩阵分解和求解器算法。

矩阵分解是线性代数中的重要问题,可以用于求解线性方程组、最小二乘问题等。

eigen支持常见的矩阵分解算法,如LU分解、QR分解、奇异值分解等,并提供了高效的求解器接口,能够快速求解复杂的线性方程组和优化问题。

eigen还支持并行计算和分布式计算。

eigen可以与OpenMP、MPI等并行计算库进行集成,利用多核和分布式计算资源,进一步提高矩阵运算的效率。

这对于处理百万级矩阵运算尤为重要,能够使得运算时间大大缩短。

eigen还具有良好的可移植性和扩展性。

eigen是一个开源项目,完全基于C++标准实现,可以在多种平台上运行。

同时,eigen还支持自定义运算符和函数,可以根据具体需求进行扩展,使得其适应不同领域和应用场景的需求。

eigen在百万级矩阵运算中具有诸多优势。

通过其高效的矩阵和向量操作接口、内存管理和计算优化策略、丰富的矩阵分解和求解器算法、并行计算和分布式计算支持,以及良好的可移植性和扩展性,eigen能够快速、高效地处理大规模矩阵运算问题。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

iter=iter+1;

6 if t < alpha*z and iter < 2, then go to 3

7 hj+1, j=sqrt(t);

8

; v

r j+1

=w

r j+1

/h

j+1,j

end

在算法 1 中,H(1:j, j)表示(h1, j, h2, j,…, hj, j)T;func(A, vrj )

数,若所有残量范数均小于允许误差,则停止迭代。否则转

第(5)步。

(5)计算 ur = λ1u1 + λ2u2 +" + λk / Puk / P ,, r=1,2,…,P,使用 全局归约求和函数得到 u=u1+u2+…+up,然后将 u 全局广播

σ min (H m − λi I) 的右奇异向量,那么有

ui = Vm zi

(

1

)

|| ( A − λi I )ui ||2 = σ min (H m − λi I)

(2)

其中, I 的前 m 行是 m 阶单位矩阵,最后一行的元素的值均

等于零。

该定理说明了求解精化向量只需只须计算(m+1)×m 阶矩 阵的奇异值分解。,并且用 σ min (H m − λi I) 判断 Ritz 值和精化

( λ , x)即可作为目标特征对的好的近似,从而停止迭代。否

则由 Ritz 向量构造 v1 进行重启动。

2.2 精化向量

精化重启动 Arnoldi 方法对于 Ritz 值 λi 利用满足如下条

件的精化向量 ui 作为目标特征向量的近似[2]:。

||

(A

−

λi I )ui

||2 =

min

u∈K (v1,A),||u||2 =1

素 hm+1,m 的值不等于零;em 是第 m 个坐标向量。

假设 Hm y = λ y ,则向量 x=Vmy 满足:

|| r ||2 =|| Ax − λ x ||2 =| hm+1,mem* y |

通常称 x 为 Ritz 向量, λ 为 Ritz 值。重启动 Arnoldi 算

法用 Ritz 对作为目标特征对的近似。如果||r||2 足够小,那么

基金项目:国家自然科学基金资助项目 “当代并行机的并行算法应 用基础研究”(60533020);中国家科学院“十一五”信息化专项基金 资助项目“超级计算环境建设与应用”(INFO-115-B01) 作者简介:赵 韬(1979-),男,博士研究生,主研方向:大规模非 对称矩阵特征问题的并行计算;迟学斌、陆忠华,研究员、博士生 导师;赵永华,副研究员 收稿日期:2009-10-17 E-mail:zhaotao@

器进程得到 Hm 和 Vm+1 相应的行块。 (3)若 hm+1,m=0,则计算 Hm 的全部特征值 λi 和 Ritz 向量

xi,并且用( λi , xi)作为目标特征对的近似,停止迭代。否则 只计算 Hm 的全部特征值 λi ,转第(4)步。

(4)选择 k 个 Ritz 值 λi 作为目标特征值的近似。每个处理 器进程用式式(1)式和式式(2)式计算 k/P 个精化向量及残量范

基于传统的重启动 Arnoldi 并行算法,本文提出用任务 图模型并行计算精化向量,避免了用数据并行模型使得通信 次数增加的问题。,从而使得本文提出的精化重启动 Arnoldi 并行算法具有较好的并行效率和可扩展性。

2 精化重启动 Arnoldi 算法

2.1 基本 Arnoldi 过程 给定 n 阶方阵 A 和单位初始向量 v1,基本 Arnoldi 过程

第 36 卷 第 6 期 Vol.36 No.6 ·博士论文·

计算机工程 Computer Engineering

文章编号:1000—3428(2010)06—0012—03

文献标识码:A

2010 年 3 月 March 2010

中图分类号:TP301.6

求解大规模矩阵特征问题的并行算法研究

赵 韬,迟学斌,陆忠华,赵永华

对于精化重启动 Arnoldi 算法,注意到每个处理器进程

本地都有矩阵 Hm 及其特征值。设需要求解 k 个特征对。如果 将计算一个精化向量作为一个任务,那么每个处理器进程都

可以根据式式(1)式和式式(2)式独立完成 k/P 个任务,而不需

要与其他处理器进程通信。如果( λi , ui)满足收敛条件,则停 止迭代。这时每个处理器进程本地拥有全部 Ritz 值和部分精

化向量。如果不收敛,那么使用精化向量和全局归约函数构

造 v1 进行重启动。精化重启动 Arnoldi 并行算法描述如下。 算法 2:

(1)设置目标特征对的个数为 k,基本 Arnoldi 过程的迭代

步数为 m,允许误差为 tol;给出第 1 次重启动的单位初始向

量 v1。 (2)用算法 1 并行计算 m 步基本 Arnoldi 过程。每个处理

目前,传统的重启动 Arnoldi 并行算法使用数据并行模 型[3-4]并行计算 Krylov 子空间正交基。这种并行算法是将矩 阵和向量按行分配到各个处理器进程上。每个处理器进程首 先只对本地矩阵和向量进行计算,如果需要其他处理器进程 上的数据,则再与其他处理器进程通信获取所需要的数据。 当所需计算的数据较少并且处理器进程数增多时,应用数据 并行模型的并行算法的通信次数会显著增加,降低了算法的 并行效率和可扩展性。

用矩阵形式可以表示为 AVm = Vm Hm + hm+1,mvm+1em*

或者

—12—

AVm = Vm+1H m

其 中 , m<<n, Vm ∈ Cn×m 是 列 正 交 矩 阵 ; Hm ∈ Cm×m 是 上

Hessenberg 矩 阵 ; 且 VmHvm+1 = 0 , , Vm+1=(Vm, vm+1) ; H m ∈ C(m+1)×m 的前 m 行是矩阵 Hm,其最后一行只有第 m 个元

向量是否收敛。如果 σ min 足够小,那么( λi , ui)即可作为目标

特征对的好的近似。,否则由精化向量构造 v1 进行重启动。

3 精化重启动 Arnoldi 并行算法

基本 Arnoldi 过程的主要计算部分是 Gram-Schmidt 正交 化过程[4-5]。为了降低全局通信次数和调用 2 级 BLAS 以有效

化算法构造 K(v1, A)的正交基。 算法 1:

for j = 1,…, m

1

w

r j+1

=

func

(A,v

r j

)

,

zr

=||w

|| r 2

j+1 2

,

r=1,2,…,

P,

reduce: z = z1+ z2+…+ zP,, broadcast: z;

2 iter =stract】Based on the parallel algorithm for restarted Arnoldi method by using data parallel model, a parallel algorithm for refined restarted Arnoldi method is presented. To impair the negative impact on parallel performance due to weak scalability, Tthe parallel algorithm presented implements parallel computing refined vectors by using task graph model and reduces the communication cost. As a result, the algorithm achieves parallel computing efficiently. Numerical experiments on KD-50-I show that the parallel algorithm presented performs good scalability and efficiency. 【Key words】matrix eigenvalue; Arnoldi algorithm; parallel computing; refined vector

||

(A

−

λi I )u

||2

其中,K(v1, A)表示由 v1, A v1,…, Am-1 v1 构成的子空间,通常

称 K(v1, A)为 Krylov 子空间。而 v1, v2,…, vm 是 K(v1, A)的一

组正交基[2,4]。 定 理 [2] 设 zi 是 矩 阵 H m − λi I 的 属 于 最 小 奇 异 值

(中国科学院计算机网络信息中心超级计算中心,北京 100190)

摘 要:基于数据并行的重启动 Arnoldi 并行算法,基于使用数据并行模型的重启动 Arnoldi 并行算法,提出一个精化重启动 Arnoldi 并行 算法。为了降低弱扩展性对并行性能的负面影响,该算法使用任务图模型并行计算精化向量,减少处理器进程之间的通信次数,有效地实 现并行计算。在 KD-50-I 万亿次机上的测试结果表明,该算法具有较好的可扩展性和并行 效率。 关键词:矩阵特征值;Arnoldi 算法;并行计算;精化向量

3

sr=

(Vjr

)

H

w

r j+1

,

r=1,2,…,

P;

4 reduce: H(1:j, j)=H(1:j, j)+ s1+ s2+…+sP,