单目标定-opencv-单目相机标定

相机标定方法汇总

相机的标定还是很重要的,特把用过的工具和方法进行一次汇总,以便加深理解,希望和大家多多讨论。

(本人扣扣1256635840)————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————————1.MATLAB camera calibration toolbox工具箱下载和学习网址:标定测试集的下载网址:我只各使用了13张图片将TOOLBOX_calib放入MATLAB的toolbox目录下,工作目录设为含标定图集的目录。

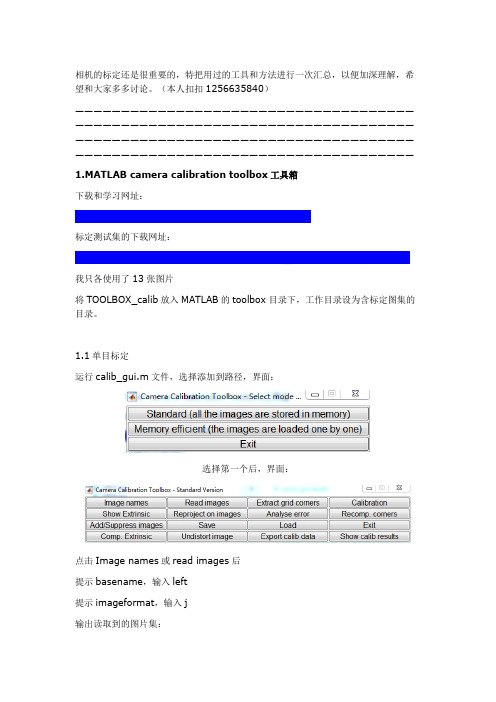

1.1单目标定运行calib_gui.m文件,选择添加到路径,界面:选择第一个后,界面:点击Image names或read images后提示basename,输入left提示imageformat,输入j输出读取到的图片集:点击extract grid corners(提取角点)提示角点拾取窗大小,我选择了默认的5*5 弹出角点拾取窗口界面,拾取4个边界点:提示输入方格的x向和y向的实际尺寸,这里的棋盘格实际大小为30mm*30mm,以及X向和Y向的方格个数,输入5和8,设置后得到角点提取的效果:后续的12张图片进行同样的操作。

(后续MATLAB自己出了个标定工具箱camera calibrator,以及opencv、halcon 的角点都是自动提取,稍后详细说明)完成后点击calibration进行初始标定标定的初始化如下:Calibration parameters after initialization:Focal Length: fc = [ 532.49170 532.49170 ]Principal point: cc = [ 319.50000 239.50000 ]Skew: alpha_c = [ 0.00000 ] => angle of pixel = 90.00000 degrees Distortion: kc = [ 0.00000 0.00000 0.00000 0.00000 0.00000 ]得到的标定结果如下:Calibration results after optimization (with uncertainties):Focal Length: fc = [ 534.97637 536.20121 ] +/- [ 3.71984 3.92117 ] Principal point: cc = [ 343.26051 233.07723 ] +/- [ 4.11643 4.58569 ] Skew: alpha_c = [ 0.00000 ] +/- [ 0.00000 ] => angle of pixel axes =90.00000 +/- 0.00000 degreesDistortion: kc = [ -0.32075 0.27300 0.00104 -0.00074 0.00000 ] +/- [ 0.02040 0.07372 0.00103 0.00126 0.00000 ]Pixel error: err = [ 0.55364 0.23137 ]这里对这5个参数进行说明(详见链接(1)fc为焦距的像素尺寸,计算为F/DX,F/DY,F为几何焦距尺寸,DX,DY为像元尺寸。

相机标定过程(opencv)+matlab参数导入opencv+matlab标定和矫正

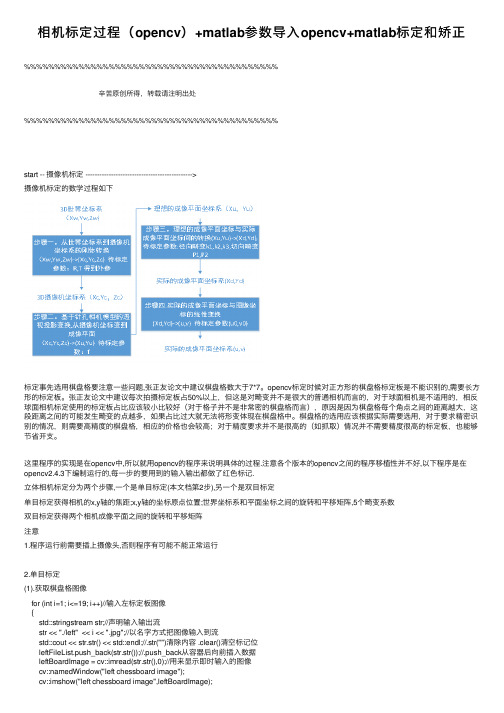

相机标定过程(opencv)+matlab参数导⼊opencv+matlab标定和矫正%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%⾟苦原创所得,转载请注明出处%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%start -- 摄像机标定 ---------------------------------------------->摄像机标定的数学过程如下标定事先选⽤棋盘格要注意⼀些问题,张正友论⽂中建议棋盘格数⼤于7*7。

opencv标定时候对正⽅形的棋盘格标定板是不能识别的,需要长⽅形的标定板。

张正友论⽂中建议每次拍摄标定板占50%以上,但这是对畸变并不是很⼤的普通相机⽽⾔的,对于球⾯相机是不适⽤的,相反球⾯相机标定使⽤的标定板占⽐应该较⼩⽐较好(对于格⼦并不是⾮常密的棋盘格⽽⾔),原因是因为棋盘格每个⾓点之间的距离越⼤,这段距离之间的可能发⽣畸变的点越多,如果占⽐过⼤就⽆法将形变体现在棋盘格中。

棋盘格的选⽤应该根据实际需要选⽤,对于要求精密识别的情况,则需要⾼精度的棋盘格,相应的价格也会较⾼;对于精度要求并不是很⾼的(如抓取)情况并不需要精度很⾼的标定板,也能够节省开⽀。

这⾥程序的实现是在opencv中,所以就⽤opencv的程序来说明具体的过程.注意各个版本的opencv之间的程序移植性并不好,以下程序是在opencv2.4.3下编制运⾏的,每⼀步的要⽤到的输⼊输出都做了红⾊标记.⽴体相机标定分为两个步骤,⼀个是单⽬标定(本⽂档第2步),另⼀个是双⽬标定单⽬标定获得相机的x,y轴的焦距;x,y轴的坐标原点位置;世界坐标系和平⾯坐标之间的旋转和平移矩阵,5个畸变系数双⽬标定获得两个相机成像平⾯之间的旋转和平移矩阵注意1.程序运⾏前需要插上摄像头,否则程序有可能不能正常运⾏2.单⽬标定(1).获取棋盘格图像for (int i=1; i<=19; i++)//输⼊左标定板图像{std::stringstream str;//声明输⼊输出流str << "./left" << i << ".jpg";//以名字⽅式把图像输⼊到流std::cout << str.str() << std::endl;//.str("")清除内容 .clear()清空标记位leftFileList.push_back(str.str());//.push_back从容器后向前插⼊数据leftBoardImage = cv::imread(str.str(),0);//⽤来显⽰即时输⼊的图像cv::namedWindow("left chessboard image");cv::imshow("left chessboard image",leftBoardImage);cv::waitKey(10);}(2).定义棋盘格的⾓点数⽬cv::Size boardSize(14,10)(3).程序定位提取⾓点这⾥建⽴的是理想成像平⾯(三维,第三维为0,单位为格⼦数)和图像坐标系(⼆维,单位是像素)之间的关系(a)⾸先声明两个坐标容器std::vector<cv::Point2f> imageCorners;//⼆位坐标点std::vector<cv::Point3f> objectCorners;//三维坐标点(b)初始化棋盘⾓点,令其位置位于(x,y,z)=(i,j,0),⼀个棋盘格为⼀个坐标值for (int i=0; i<boardSize.height; i++){for (int j=0; j<boardSize.width; j++){objectCorners.push_back(cv::Point3f(i, j, 0.0f));}}(c)直接使⽤opencv内函数找到⼆维⾓点坐标,并建⽴标定标定格⼦和实际坐标间的关系(像素级别)这个函数使⽤时,当标定板是长⽅形时可以找到⾓点,但是标定板是正⽅形时,就找不到,原因还未知.cv::findChessboardCorners(image, boardSize, imageCorners);(d)获得像素精度往往是不够的,还需要获得亚像素的精度cv::cornerSubPix(image,imageCorners, //输⼊/输出cv::Size(5,5),//搜索框的⼀半,表⽰在多⼤窗⼝定位⾓点cv::Size(-1,-1), //死区cv::TermCriteria(cv::TermCriteria::MAX_ITER + cv::TermCriteria::EPS,30, // max number of iterations//迭代最⼤次数0.01)); // min accuracy//最⼩精度注:TermCriteria模板类,取代了之前的CvTermCriteria,这个类是作为迭代算法的终⽌条件的,这个类在参考⼿册⾥介绍的很简单,我查了些资料,这⾥介绍⼀下。

相机模型与标定(七)--LM算法在相机标定中的使用

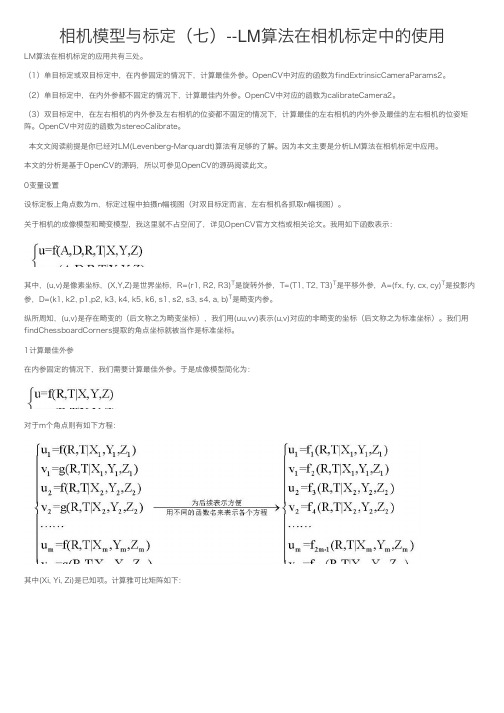

相机模型与标定(七)--LM算法在相机标定中的使⽤LM算法在相机标定的应⽤共有三处。

(1)单⽬标定或双⽬标定中,在内参固定的情况下,计算最佳外参。

OpenCV中对应的函数为findExtrinsicCameraParams2。

(2)单⽬标定中,在内外参都不固定的情况下,计算最佳内外参。

OpenCV中对应的函数为calibrateCamera2。

(3)双⽬标定中,在左右相机的内外参及左右相机的位姿都不固定的情况下,计算最佳的左右相机的内外参及最佳的左右相机的位姿矩阵。

OpenCV中对应的函数为stereoCalibrate。

本⽂⽂阅读前提是你已经对LM(Levenberg-Marquardt)算法有⾜够的了解。

因为本⽂主要是分析LM算法在相机标定中应⽤。

本⽂的分析是基于OpenCV的源码,所以可参见OpenCV的源码阅读此⽂。

0变量设置设标定板上⾓点数为m,标定过程中拍摄n幅视图(对双⽬标定⽽⾔,左右相机各抓取n幅视图)。

关于相机的成像模型和畸变模型,我这⾥就不占空间了,详见OpenCV官⽅⽂档或相关论⽂。

我⽤如下函数表⽰:其中,(u,v)是像素坐标,(X,Y,Z)是世界坐标,R=(r1, R2, R3)T是旋转外参,T=(T1, T2, T3)T是平移外参,A=(fx, fy, cx, cy)T是投影内参,D=(k1, k2, p1,p2, k3, k4, k5, k6, s1, s2, s3, s4, a, b)T是畸变内参。

纵所周知,(u,v)是存在畸变的(后⽂称之为畸变坐标),我们⽤(uu,vv)表⽰(u,v)对应的⾮畸变的坐标(后⽂称之为标准坐标)。

我们⽤findChessboardCorners提取的⾓点坐标就被当作是标准坐标。

1计算最佳外参在内参固定的情况下,我们需要计算最佳外参。

于是成像模型简化为:对于m个⾓点则有如下⽅程:其中(Xi, Yi, Zi)是已知项。

计算雅可⽐矩阵如下:由J可得J和J T J。

单目相机标定原理

单目相机标定原理

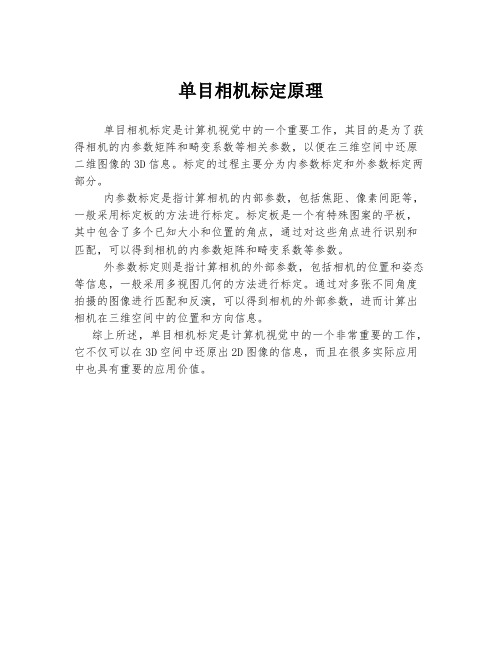

单目相机标定是计算机视觉中的一个重要工作,其目的是为了获得相机的内参数矩阵和畸变系数等相关参数,以便在三维空间中还原二维图像的3D信息。

标定的过程主要分为内参数标定和外参数标定两部分。

内参数标定是指计算相机的内部参数,包括焦距、像素间距等,一般采用标定板的方法进行标定。

标定板是一个有特殊图案的平板,其中包含了多个已知大小和位置的角点,通过对这些角点进行识别和匹配,可以得到相机的内参数矩阵和畸变系数等参数。

外参数标定则是指计算相机的外部参数,包括相机的位置和姿态等信息,一般采用多视图几何的方法进行标定。

通过对多张不同角度拍摄的图像进行匹配和反演,可以得到相机的外部参数,进而计算出相机在三维空间中的位置和方向信息。

综上所述,单目相机标定是计算机视觉中的一个非常重要的工作,它不仅可以在3D空间中还原出2D图像的信息,而且在很多实际应用中也具有重要的应用价值。

opencv坐标转换标定

opencv坐标转换标定OpenCV是一款广泛应用于计算机视觉和图像处理中的开源库,在许多应用领域都有广泛应用,如机器人导航、人脸识别、图像分割等。

在使用OpenCV进行图像处理时,往往需要进行坐标转换和标定,以便准确地定位和测量图像中的物体。

本文将详细介绍OpenCV的坐标转换和标定方法,帮助读者更好地理解和应用该技术。

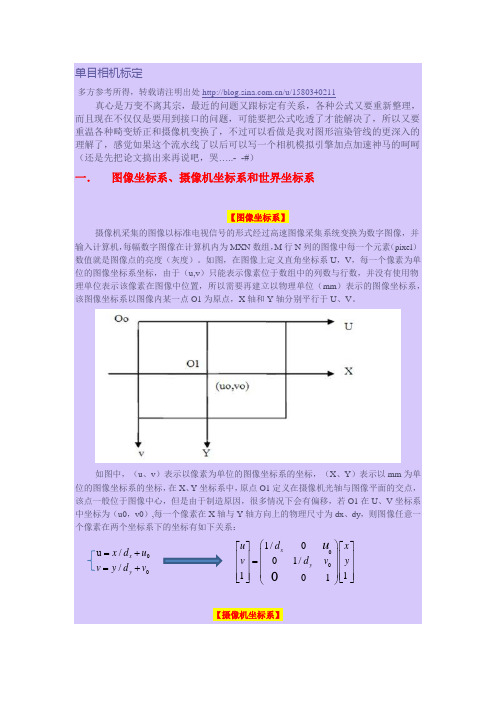

一、坐标转换方法1. 图像坐标系和世界坐标系在进行坐标转换之前,需要明确图像坐标系和世界坐标系的概念。

图像坐标系是指图像中某一点的坐标表示,通常以像素为单位,原点通常位于图像的左上角。

世界坐标系是指实际物体的坐标表示,通常以米或毫米为单位,原点的位置可以根据实际情况确定。

2. 相机坐标系和像素坐标系的转换在实际应用中,需要将相机坐标系中的点转换为像素坐标系中的点,以便在图像上进行显示和分析。

相机坐标系是指相机的坐标表示,通常以相机的光心为原点,光轴为Z轴,X轴和Y轴垂直光轴,构成一个右手坐标系。

像素坐标系是指图像上像素点的坐标表示。

在OpenCV中,可以通过相机标定得到相机的内外参数,从而进行相机坐标系和像素坐标系之间的转换。

具体步骤如下:(1)使用棋盘格等已知模式在不同位置拍摄图像。

(2)通过findChessboardCorners等函数找到每张图像中的角点。

(3)使用calibrateCamera函数计算相机的内外参数。

(4)通过projectPoints函数将相机坐标系中的点投影到像素坐标系中。

3. 坐标系旋转和平移在进行坐标转换时,可能存在坐标系旋转和平移的情况,特别是在机器人导航和目标跟踪等场景中,需要将相对于机器人或目标物体的坐标转换为图像坐标。

在OpenCV中,可以使用旋转矩阵和平移矩阵对坐标进行旋转和平移。

具体步骤如下:(1)定义旋转矩阵和平移矩阵。

(2)使用cv::Rodrigues函数将旋转向量转换为旋转矩阵。

(3)使用cv::transform函数将坐标通过旋转矩阵进行旋转。

opencv的相机标定方法

opencv的相机标定方法

OpenCV提供了多种相机标定方法,其中最常用的是棋盘格标

定法。

下面是使用棋盘格标定相机的步骤:

1. 准备一副棋盘格图片,棋盘格的每个方格必须是完整的黑白交替的。

2. 使用摄像机拍摄多幅图片,确保棋盘格图片处于不同的位置和角度,同时保持棋盘格在整个图像中都可见。

3. 初始化标定板格点的三维坐标数组和图像中对应点的二维坐标数组。

4. 使用OpenCV的函数`findChessboardCorners()`在每个图像中

查找棋盘格的角点,并将其保存在图像对应的二维坐标数组中。

5. 使用OpenCV的函数`drawChessboardCorners()`在每个图像

上绘制出检测到的角点。

6. 使用OpenCV的函数`calibrateCamera()`计算相机的畸变系数和相机矩阵。

7. 使用OpenCV的函数`undistort()`去除图像的畸变。

8. 使用OpenCV的函数`imshow()`显示校正前后的图像进行对比。

9. 使用OpenCV的函数`getOptimalNewCameraMatrix()`获取校正后图像的新相机矩阵。

10. 使用OpenCV的函数`initUndistortRectifyMap()`获取校正后图像的映射矩阵。

11. 使用OpenCV的函数`remap()`将原始图像映射到校正后图像。

通过以上方法,可以完成相机的标定和校正,得到更准确的图像处理结果。

单目相机标定方法

单目相机标定方法在计算机视觉中,单目相机标定是一项极其重要的技术,它是相机应用的关键基础之一。

单目相机标定指的是根据已知物体的三维坐标和对应的图像坐标,对相机内参、畸变参数等进行精确校准的过程。

以下是单目相机标定的步骤:Step1:制备标定板标定板是这个过程中非常重要的一部分。

它需要是具有不同的特征点以及明确的大小和形状的物体,例如黑白方格板。

标定板中的特征点可以帮助程序识别其在图像中的位置和方位,并通过这些点的位置和方向得出相机内部的参数。

Step2:拍摄标定板将制作好的标定板放置在相机平面上,平行于图像平面拍下多张底片,换取不同的轴角度和物体位置,然后将拍摄到的图像保存下来。

Step3:读取图片信息将标定板拍摄的图像读取到计算机中,并解析出其中的特征点作为后续步骤的输入数据。

Step4:计算角点的位置坐标角点是标定板中一个非常重要的特征点,它们可以根据计算的方式在图像中求得。

从每张图片中提取角点位置信息,以便后续处理。

Step5:校准相机内部参数将标定板的标准定义进行数学建模,并使用标定板中的特征点和相应的图像来确定相机内部参数,例如焦距、畸变、旋转矩阵和平移向量等。

Step6:测试标定效果最后一步是测试标定的效果,通常采用一些标准的度量来计算标定误差。

例如,对于每张图片,使用标定结果进行还原,然后将还原结果与真实值进行比较。

如果误差很小,说明标定效果比较好。

总之,单目相机标定是计算机视觉中的一个关键技术,可以帮助我们准确地校准相机的内部参数,提高图像处理的准确度。

在实际应用中,需要仔细考虑标定板的选择和制备、拍摄条件等多个因素,以确保标定的精度和准确性。

单目摄像头标定

#include "cv.h"

#include "highgui.h"

#include <string>

#include <iostream>

using namespace std;

int main()

{

CV_CALIB_CB_ADAPTIVE_THRESH|CV_CALIB_CB_FILTER_QUADS);

if(found==0){

cout<<"第"<<a<<"帧图片无法找到棋盘格所有角点!\n\n";

int total_per_image=board_width*board_height;

CvPoint2D32f * image_points_buf = new CvPoint2D32f[total_per_image];

CvMat * image_points=cvCreateMat(number_image*total_per_image,2,CV_32FC1);

for(int i=step,j=0;j<total_per_image;++i,++j){

CV_MAT_ELEM(*image_points,float,i,0)=image_points_buf[j].x;

CV_MAT_ELEM(*image_points,float,i,1)=image_points_buf[j].y;

cvShowImage("RePlay",show);

opencv的相机标定方法

(原创实用版4篇)编制人员:_______________审核人员:_______________审批人员:_______________编制单位:_______________编制时间:____年___月___日序言下面是本店铺为大家精心编写的4篇《opencv的相机标定方法》,供大家借鉴与参考。

下载后,可根据实际需要进行调整和使用,希望能够帮助到大家,谢射!(4篇)《opencv的相机标定方法》篇1相机标定是计算机视觉中一个重要的问题,它的目的是确定相机的内部参数和外部参数。

在 OpenCV 中,可以使用 cv::calibrateCamera() 函数进行相机标定。

该函数需要输入标定板的角点坐标和相机拍摄到的图像,然后可以计算出相机的内部参数(如焦距、主点坐标等)和外部参数(如相机的旋转和平移矩阵)。

具体地,相机标定的过程可以分为以下几个步骤:1. 准备标定板:标定板应该是一个平面板,上面有一些精确的几何形状(如圆形或棋盘格),以便于在图像中进行角点检测。

2. 拍摄标定板:使用相机拍摄标定板,并获取相机的内部参数和外部参数。

3. 角点检测:在获取到的图像中,使用角点检测算法(如 Harris 角点检测)检测出标定板上的角点。

4. 计算变换矩阵:根据标定板上的角点坐标和相机拍摄到的图像,可以计算出相机的旋转和平移矩阵。

5. 相机标定:使用 cv::calibrateCamera() 函数,将计算出的变换矩阵输入到函数中,即可计算出相机的内部参数和外部参数。

需要注意的是,相机标定的结果可能会受到多种因素的影响,如标定板的形状、大小、标定时的光照条件等。

《opencv的相机标定方法》篇2相机标定是计算机视觉中一个重要的问题,它的目的是确定相机内部参数和外部参数,以便于后续图像处理和计算机视觉任务。

在 OpenCV 中,相机标定可以采用多种方法,其中比较常见的包括:1. 张正友标定法(Zhang Z. et al. A flexible camera calibration method for non-coplanar cameras. ICCV 99):该方法适用于非平面相机标定,需要标定板放置在不同的位置和角度,通过解方程组来求解相机内部参数和外部参数。

opencv的相机标定方法

opencv的相机标定方法相机标定是计算机视觉中的一个重要步骤,它的目标是通过对相机进行一系列的测量来确定相机的内部参数和外部参数,从而提高图像处理和计算机视觉任务的精确度和稳定性。

OpenCV是一个广泛使用的计算机视觉库,提供了多种相机标定方法。

1.单目相机标定方法:单目相机标定是指使用一个相机拍摄多张不同的棋盘格图像,通过提取图像中的棋盘格角点来确定相机的内部参数和外部参数。

OpenCV中提供了函数`cv::calibrateCamera(`来进行单目相机标定。

该函数需要输入一组棋盘格图像,每幅图像中的棋盘格角点坐标,以及每个角点在现实世界中的坐标。

函数根据这些数据计算相机的内部参数矩阵、畸变系数和每幅图像的旋转矩阵和平移向量。

2.双目相机标定方法:双目相机标定是指使用一对相机拍摄同一场景的图像,并通过识别这些图像中的共享特征点来计算相机的内部参数和外部参数。

OpenCV中提供了函数`cv::stereoCalibrate(`来进行双目相机标定。

该函数需要输入两个相机拍摄的图像,每幅图像中的特征点坐标,以及每个特征点在现实世界中的坐标。

函数根据这些数据计算两个相机的内部参数矩阵、畸变系数和旋转矩阵、平移向量之间的转换关系。

3.深度相机标定方法:深度相机标定是指使用深度相机(如Kinect)拍摄不同的场景,并通过识别图像中的特征点来确定深度相机的内部参数和外部参数。

OpenCV 中提供了函数`cv::rgbd::calibrate(`来进行深度相机标定。

该函数需要输入一系列深度图像和对应的RGB图像,以及特征点的坐标。

函数根据这些数据计算深度相机的内部参数矩阵和旋转矩阵、平移向量之间的转换关系。

4.灰度相机标定方法:灰度相机标定是指使用灰度相机(只能获取灰度图像)进行标定。

与单目相机标定类似,灰度相机标定也是通过拍摄多张棋盘格图像,提取角点坐标进行计算。

OpenCV中提供了函数`cv::calibrateCamera(`来进行灰度相机标定,其使用方式与单目相机标定相似。

opencv标定注意事项

opencv标定注意事项

在使用OpenCV进行相机标定时,需要注意以下几点:

1、棋盘格角点检测:确保棋盘格角点检测的顺序一致,以避免影响标定结果。

同时,需要注意棋盘格的旋转和平移,以计算相机的内部和外部参数。

2、棋盘格尺寸:棋盘格的尺寸会影响角点检测的精度,进而影响标定结果。

因此,在制作棋盘格时,需要保证每个格子的尺寸尽可能准确。

3、标定图像数量:标定图像的数量会影响标定结果的精度和稳定性。

为了获得更准确的结果,建议使用尽可能多的不同角度和位置的标定图像。

4、相机内参:相机内参包括焦距、主点坐标等参数,这些参数对标定结果有很大的影响。

因此,在标定过程中,需要仔细调整这些参数,以获得最佳的标定效果。

5、标定环境:标定环境的光线、色彩等因素会影响相机捕捉到的图像,进而影响标定结果。

因此,建议在稳定的环境中进行标定,并确保光线充足且均匀。

6、标定算法:OpenCV提供了多种标定算法,如张氏标定法、基于RANSAC的标定法等。

选择合适的标定算法可以提高标定结果的精度和稳定性。

7、标定结果验证:在完成标定后,需要验证标定结果的准确性。

可以通过比较标定结果与实际场景中的测量值来评估标定的精度和可靠性。

总之,在使用OpenCV进行相机标定时,需要注意棋盘格角点检测、棋盘格尺寸、标定图像数量、相机内参、标定环境、标定算法以及标定结果验证等方面的问题。

这些注意事项将有助于获得更准确和可靠的标定结果。

OpenCV相机标定坐标系详解

OpenCV相机标定坐标系详解在OpenCV中,可以使⽤calibrateCamera函数,通过多个视⾓的2D/3D对应,求解出该相机的内参数和每⼀个视⾓的外参数。

使⽤C++接⼝时的输⼊参数如下:objectPoints - 每⼀个视⾓中,关键点的世界坐标系。

可以使⽤vector < vector <Point3f> >类型,第⼀层vector表⽰每⼀个视⾓,第⼆层vector表⽰每⼀个点。

如果使⽤OpenCV⾃带的棋盘格,可以直接传⼊交叉点(不包括边⾓)的实际坐标,以物理世界尺度(例如毫⽶)为单位。

写坐标时,要保证z轴为0,按照先x变化,后y变化,从⼩到⼤的顺序来写。

如果⽹格尺⼨为5厘⽶,写作:(0,0,0),(5,0,0), (10,0,0)...(0,5,0), (5,5,0), (10,5,0),...如下图例⼦,x⽅向是8个交叉点,y⽅向3个较差点。

imagePoints - 每⼀个视⾓中,关键点的图像坐标系。

可以使⽤vector < vector <Point2f> >类型。

这个值可以通过findChessboardCorners函数从图像中获得。

注意:传⼊findChessboardCorners函数的patternSize参数,要和objectPoints 中的⾏列数统⼀。

imageSize - 图像尺⼨。

flags - 参数。

决定是否使⽤初始值,扭曲参数个数等。

输出参数如下:cameraMatrix - 3*3的摄像机内矩阵。

distCoeffs - 4*1(具体尺⼨取决于flags)。

对图像坐标系进⾏进⼀步扭曲。

这两个参数是内参数,可以把摄像机坐标系转换成图像坐标系。

rvecs - 每⼀个视图的旋转向量。

vector<Mat>类型,每个vec为3*1,可以⽤Rodrigues函数转换为3*3的旋转矩阵。

tvecs - 每⼀个视图的平移向量。

单目摄像头标定的原理和方法

单目摄像头标定的原理和方法嘿,咱今儿就来讲讲单目摄像头标定的原理和方法。

你知道吗,这单目摄像头啊,就像是我们的眼睛,但它可没我们的眼睛那么智能,它得经过一番标定,才能更好地看清这个世界呢!想象一下,单目摄像头就像是一个小侦探,它要去观察、去测量周围的一切。

那怎么才能让它更准确呢?这就需要标定啦!标定的原理呢,其实就是建立一个模型,让摄像头知道自己看到的东西在真实世界里的位置和大小。

就好像我们要去一个陌生的地方,得先有张地图一样。

这张地图就是摄像头的标定模型。

通过一系列的操作和计算,让摄像头明白它看到的每个点在实际中的位置关系。

那具体咋标定呢?方法有好几种呢!比如说,可以用一些特制的标定板,上面有很多规则排列的标记点。

摄像头对着这些标定板拍照,然后通过分析这些照片,就能得出很多重要的信息啦。

这就好比是给摄像头出了一套专门的测试题,它通过回答这些问题,来提升自己的能力。

是不是挺有意思的?还有啊,在标定的过程中,可不能马虎。

就像我们做事情一样,得认真仔细,稍有差错,那结果可能就差之千里啦!而且啊,不同的应用场景可能需要不同的标定方法呢。

就像我们穿衣服,不同的场合要穿不同的衣服,总不能穿着睡衣去上班吧!标定好了之后,单目摄像头就能更准确地识别物体、测量距离等等。

它就像是被赋予了超能力一样,可以帮我们做很多事情呢。

比如说在自动驾驶中,单目摄像头可以帮助汽车识别道路、车辆和行人,让汽车更安全地行驶。

这多重要啊,关乎着我们的生命安全呢!在工业生产中,它可以检测产品的质量,确保每个产品都符合标准。

这可不简单,得靠它那精准的“眼光”呢!总之,单目摄像头标定可不是一件小事,它关系到很多领域的发展和应用。

我们得重视它,让它更好地为我们服务。

所以啊,大家可别小看了这小小的单目摄像头标定,它里面的学问大着呢!你说是不是呀?。

单目相机畸变处理原理

单目相机畸变处理原理

一、相机标定

相机标定是畸变处理的第一步,其目的是为了获取相机的内部参数(如焦距、光心等)和外部参数(如旋转矩阵和平移向量等)。

通过相机标定,可以确定相机的几何模型,为后续的畸变校正提供基础数据。

常用的相机标定方法有传统相机标定和张氏相机标定等。

二、图像采集

图像采集是使用单目相机拍摄图像的过程。

由于单目相机的视角有限,拍摄的图像可能会出现畸变。

因此,在图像采集过程中,需要注意相机的拍摄角度和拍摄距离,以便更好地采集高质量的图像。

三、图像预处理

图像预处理的目的是对采集的图像进行初步处理,以消除噪声、增强图像特征等。

常见的图像预处理方法有灰度化、对比度增强、滤波等。

通过图像预处理,可以改善图像质量,提高后续畸变校正的准确性和稳定性。

四、畸变校正

畸变校正是在获取相机内外参数的基础上,根据相机的几何模型对图像进行畸变校正的过程。

常见的畸变校正方法有直接线性变换、二次曲线变换和径向畸变等。

在实际应用中,需要根据具体的相机和拍摄环境选择合适的畸变校正方法。

五、图像后处理

图像后处理的目的是对校正后的图像进行进一步处理,以改善图

像质量。

常见的图像后处理方法有色彩空间转换、直方图均衡化、边缘检测等。

通过图像后处理,可以提高图像的视觉效果和特征提取的准确性。

总之,单目相机畸变处理原理包括相机标定、图像采集、图像预处理、畸变校正和图像后处理等方面。

在实际应用中,需要根据具体的相机和拍摄环境选择合适的处理方法,以获得高质量的图像。

cv 单目标定 畸变矫正 理想模型 12个参数

cv 单目标定畸变矫正理想模型 12个参数CV单目标定是计算机视觉领域中的一个重要概念,它在机器人导航、三维重建、增强现实等领域有着广泛的应用。

在CV单目标定中,畸变矫正是一个至关重要的步骤,它能够有效地提高图像的质量,使得目标的定位更加准确。

理想模型和12个参数在单目标定中也扮演着非常重要的角色,它们能够帮助我们更好地理解相机成像的原理,从而提高定位的准确性。

接下来,我们将从简到繁地探讨CV单目标定、畸变矫正、理想模型和12个参数,帮助您更深入地理解这些概念。

1. CV单目标定在计算机视觉中,单目标定是指通过一张单目图像来确定目标在三维空间中的位置和姿态。

这个过程需要考虑到相机的内参矩阵、外参矩阵以及目标的特征点等因素,通过这些信息来计算目标在三维空间中的位置和姿态。

2. 理想模型在单目标定中,我们通常使用相机投影模型来描述相机成像的过程。

理想模型是一种简化的模型,它假设了相机成像过程中不存在畸变等因素,可以很好地帮助我们理解相机成像的原理。

3. 畸变矫正然而,在实际情况中,相机成像过程中经常会受到畸变的影响,导致图像中的目标形状发生扭曲。

畸变矫正是一种校正图像畸变的方法,它能够有效地提高图像的质量,使得目标的定位更加准确。

4. 12个参数在畸变矫正中,我们通常使用12个参数的模型来描述相机的畸变情况。

这12个参数包括了径向畸变和切向畸变等因素,通过它们可以更精确地对图像进行畸变校正。

总结回顾通过本文的探讨,我们深入地了解了CV单目标定、畸变矫正、理想模型和12个参数。

CV单目标定是计算机视觉中的一个重要概念,畸变矫正能够提高图像的质量,理想模型和12个参数对于理解相机成像原理也起着至关重要的作用。

对于这些概念,我们深入地探讨了它们的原理和应用,希望能够对您有所帮助。

个人观点和理解个人认为,在计算机视觉领域,CV单目标定、畸变矫正和理想模型是非常重要的概念,它们为我们理解相机成像原理和提高图像定位的准确性提供了重要的理论基础。

单目摄像机标定方法

单目摄像机标定方法《嘿,单目摄像机标定秘籍来啦!》嘿,我的好哥们儿/好姐妹儿!今天我来给你唠唠单目摄像机标定这个神奇的事儿,这可是我的独家秘籍哦!首先啊,咱得准备好工具,就像你出门得带钥匙一样重要。

咱得有个标定板,这玩意儿就像是单目摄像机的好朋友,能帮它找到自己的定位。

然后呢,把这个标定板放好,放得稳稳当当的,可别让它东倒西歪的,不然单目摄像机都不知道该咋对焦啦!这就好比你走路,路要是歪歪扭扭的,你不得摔跟头啊。

接下来,就是让单目摄像机开始工作啦!让它对着标定板一顿猛拍,就像你看到好吃的猛吃一样。

哈哈,别笑,真的很形象好不好!这时候单目摄像机就会把标定板的各种信息都记录下来。

在这过程中啊,你可得注意了,别让什么奇怪的东西挡在摄像机前面,不然它就像被人蒙上了眼睛,啥都看不清啦。

我跟你说,我有一次就不小心把我的臭袜子扔到镜头前面了,哎呀妈呀,那拍出来的都是啥呀!拍完之后呢,就得开始分析这些照片啦。

这就像是你考试完了要改卷子一样。

看看单目摄像机拍得清不清楚,有没有啥问题。

然后根据这些照片和一些专业的软件,算出各种参数。

这可有点像解方程,你得一步一步来,不能着急。

这时候你可能会问啦,“哎呀,这么多参数,我咋记得住啊?”嘿嘿,别担心,你就把它们想象成你喜欢的明星的电话号码,肯定能记住!哈哈,开个玩笑啦。

算完参数之后,可别以为就大功告成了哦!还得检验一下呢。

就像你做好了一道菜,得尝尝味道对不对。

如果检验没问题,那恭喜你,你成功掌握了单目摄像机标定的方法啦!要是有问题,别着急,咱再重新来一遍,就当是复习了。

总之呢,单目摄像机标定就是这么个事儿,听起来好像很复杂,其实只要你按照我说的步骤一步一步来,肯定能学会。

就像走路一样,一步一步走稳了,就能走到目的地。

好啦,我的好哥们儿/好姐妹儿,赶紧去试试吧!祝你成功哦!。

单目相机标定

如图,Oc 点为摄像机光心,Xc 轴和Yc 轴与图像的X 轴与Y 轴平行,Zc 轴为摄像机光轴,它与图像平面垂直。

光轴与图像平面的交点,极为图像坐标系的原点,由点Oc 与Xc 、Yc 、Zc 轴组成的直角坐标系称为摄像机坐标系,OOc 为摄像机焦距:由于摄像机可以安放在环境中任意位置,所以在环境中选择一个基准坐标系来描述摄像机位置,并用它描述环境中任何物体的位置,该坐标系为世界坐标系。

它有Xw 、Yw 和Zw 轴组成,摄像机坐标系与世界坐标系之间的关系可以用旋转矩阵R 与平移向量t 来描述。

0111C W C W T C W X X Y Y Rt Z Z ⎡⎤⎡⎤⎢⎥⎢⎥⎛⎫⎢⎥⎢⎥= ⎪⎢⎥⎢⎥⎝⎭⎢⎥⎢⎥⎣⎦⎣⎦总体来说,世界坐标系到图像坐标系的关系可总结如下:摄像头成像几何关系,其中Oc点称为摄像头(透镜)的光心,Xc轴和Yc轴与图像的x轴和Y轴平行,Zc轴为摄像头的光轴,它与图像平面垂直。

光轴与图像平面的交点O1,即为图像坐标系的原点。

由点Oc与Xc、Yc、Zc轴组成的坐标系称为摄像头坐标系,Oc O1的距离为摄像头焦距,用f表示。

图像坐标系是一个二维平面,又称为像平面,实际上就是摄像头的CCD传感器的表面。

每个CCD传感器都有一定的尺寸,也有一定的分辨率,这个就确定了毫米与像素点之间的转换关系。

举个例子,CCD的尺寸是8mm X 6mm,帧画面的分辨率设置为640X480,那么毫米与像素点之间的转换关系就是80pixel/mm。

”设CCD传感器每个像素点的物理大小为dx*dy,相应地,就有dx=dy=1/80。

二.针孔模型【针孔模型】又称为线性摄像机模型,任何空间点M在图像中的投影位置m,为光心Oc与M的连线OcM与图像平面的交点(各种相似三角形有木有,但是要注意像平面和现在讨论的其实是关于Oc对称的哦,所以计算的时候不要忘记了负号,不然出来的图像就是倒着的啦),这种关系也称为重心摄影或者透视投影。

单目相机标定

单目相机标定展开全文相机标定目的:获取摄像机的内参和外参矩阵,同时也会得到每一副标定图像的旋转和平移矩阵。

内参和外参可以对之后相机拍摄的图像就进行矫正,得到畸变相对很小的图像。

原理:成像模型的坐标系为:世界坐标系 --> 相机坐标系 --> 图像坐标系 --> 像素坐标系先说从相机坐标系到图像坐标系的变换:从针孔成像模型说起:————————————————————————————相机坐标系中实际的点坐标为Q(X, Y, Z)对应的图像(坐标系)平面上的点为 q(x, y , f)理想情况如上所示,但实际上成像芯片的中心通常不在光轴上。

原本的焦距是f,这里把f拆成2个不同的焦距,一个是x轴的焦距,一个是y轴的焦距因此最终计算的结果为:将实际中的点Q(X, Y, Z)映射到投影平面上坐标为(x , y)的点的过程称为投影变换。

这种变换可以使用齐次坐标。

给q(x, y)增加了一个维度w,即为q(x, y, w)下图所示,网上一些资料中也有这种形式:x0、y0为在图像平面上的主点坐标,是Cx,Cy的另一种形式,其中s为坐标轴倾斜参数,理想情况下为0,其他参数都是一样的。

—————————————————————————————————我们已经得到了内参矩阵,能够从相机坐标系转换到图像坐标系上,接下来说如何得到外参矩阵,将其从世界坐标系转换到相机坐标系上从世界坐标系转换到相机坐标系上属于刚体变换,即不会发生形变,也就是说只有旋转和平移。

公式符号说明:带有下标 w 的是世界坐标系带有下标 c 的是相机坐标系设旋转矩阵为 R,平移矩阵为 T再把偏移矩阵T加上即可,偏移矩阵T为 [Tx, Ty, Tz]的转置,是X、Y、Z方向上的平移。

将旋转矩阵R和偏移矩阵T合起来即得外参矩阵即为:——————————————————————————————————图像坐标系和像素坐标系之间的转换:像素坐标系和图像坐标系都在成像平面上,只是各自的原点和度量单位不一样。

单目相机标定

单⽬相机标定(1)从世界坐标系到相机坐标系的变换:可以由⼀个旋转矩阵R和⼀个平移向量t来描述:化为齐次坐标:(2)相机坐标系到图像物理坐标系:其中f是焦距。

化成齐次坐标为:所以可以得到从世界坐标系到图像坐标系的转换:其中是相机的内参数,是外参数。

2、透镜畸变实际的摄像机由于镜头制作⼯艺等原因,使摄像机获取的原始图像存在畸变,畸变有两种,径向畸变和切向畸变。

径向畸变来⾃透镜形状,切向畸变来⾃于整个摄像机的组装过程。

径向畸变可以由三个参数k1,k2,k3确定,切向畸变可由两个参数p1,p2确定。

3、总结相机标定的⽬的就是建⽴摄像机图像像素位置与场景点位置之间的关系,即世界坐标系与图像坐标系之间的关系。

⽅法就是根据摄像机模型,由已知特征点的图像坐标求解摄像机的模型参数,从⽽可以从图像出发恢复出空间点三维坐标,即三维重建。

所以要求解的参数包括4个内参数和5个畸变参数,对于外参数,即旋转矩阵的三个旋转参数和平移向量的三个参数。

内参数直接与期盼所在空间的3D⼏何相关,即外参数。

⽽畸变参数则与点集如何畸变的2D集合相关。

对于外参数,需要知道棋盘的位置,对棋盘的6个不同的视场图像,需要这6个参数,总之,在每个视场中,需要计算4个内参数和6个外参数。

4、opencv中要⽤到的函数Opencv中使⽤的求解焦距和偏移的算法是基于zhang的⽅法,求解畸变参数是基于Brown的⽅法。

Opencv不是使⽤基于3D构造物体的视场,⽽是使⽤平⾯物体的多个视场,使⽤⿊⽩⽅块交替排列的模式能保证在测量上任何⼀边都没有偏移,并且格线⾓点也让亚像素定位函数的使⽤更⾃然。

1、给定⼀个棋盘图像,可以使⽤opencv函数findChessboardCorner()来定位棋盘的⾓点:i n t cvFindChessboardCorners(const void* image, CvSize patternSize, CvPoint2D32f* corners, nt* cornerCount=NULL, int flags=CV_CALIB_CB_ADAPTIVE_THRESH)参数的意义为:image:是⼀个输⼊变量,包含棋盘的单幅图像,必须为8位灰度图像。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

" \n"

"<?xml version=\"1.0\"?>\n"

"<opencv_storage>\n"

"<images>\n"

"view000.png\n"

"view001.png\n"

"<!-- view002.png -->\n"

" # - name of video file with a video of the board\n"

" # if input_data not specified, a live view from the camera is used\n"

double totalErr = 0, err;

perViewErrors.resize(objectPoints.size());

for( i = 0; i < (int)objectPoints.size(); i++ )

{

projectPoints(Mat(objectPoints[i]), rvecs[i], tvecs[i],

" [-p] # fix the principal point at the center\n"

" [-v] # flip the captured images around the horizontal axis\n"

" [-V] # use a video file, and not an image list, uses\n"

" # [input_data] string for the video file name\n"

" [-n=<number_of_frames>] # the number of frames to use for calibration\n"

" # (if not specified, it will be set to the number\n"

perViewErrors[i] = (float)std::sqrt(err*err/n);

totalErr += err*err;

totalPoints += n;

}

return std::sqrt(totalErr/totalPoints);

cameraMatrix, distCoeffs, imagePoints2);

err = norm(Mat(imagePoints[i]), Mat(imagePoints2), NORM_L2);

int n = (int)objectPoints[i].size();

corners.push_back(Point3f(float(j*squareSize),

float(i*squareSize), 0));

" <ESC>, 'q' - quit the program\n"

" 'g' - start capturing images\n"

" 'u' - switch undistortion on/off\n";

static void help()

"view003.png\n"

"view010.png\n"

"one_extra_view.jpg\n"

"</images>\n"

"</opencv_storage>\n";

const char* liveCaptureHelp =

"When the live video from camera is used as input, the following hot-keys may be used:\n"

const Mat& cameraMatrix, const Mat& distCoeffs,

vector<float>& perViewErrors )

{

vector<Point2f> imagePoints2;

int i, totalPoints = 0;

static double computeReprojectionErrors(

const vector<vector<Point3f> >& objectPoints,

const vector<vector<Point2f> >& imagePoints,

const vector<Mat>& rvecs, const vector<Mat>& tvecs,

" calibration -w=4 -h=5 -s=0.025 -o=camera.yml -op -oe image_list.xml\n"

" where image_list.xml is the standard OpenCV XML/YAML\n"

" use imagelist_creator to create the xml or yaml list\n"

#include "opencv2/core/core.hpp"

#include "opencv2/imgproc/imgproc.hpp"

#include "opencv2/calib3d/calib3d.hpp"

#include "opencv2/video/video.hpp"

#include "opencv2/highgui/highgui.hpp"

" [-oe] # write extrinsic parameters\n"

" [-zt] # assume zero tangential distortion\n"

" [-a=<aspectRatio>] # fix aspect ratio (fx/fy)\n"

{

printf( "This is a camera calibration sample.\n"

"Usage: calibration\n"

" -w=<board_width> # the number of inner corners per one of board dimension\n"

switch(patternType)

{

case CHESSBOARD:

case CIRCLES_GRID:

for( int i = 0; i < boardSize.height; i++ )

for( int j = 0; j < boardSize.width; j++ )

"\n" );

printf("\n%s",usage);

printf( "\n%s", liveCaptureHelp );

}

enum { DETECTION = 0, CAPTURING = 1, CALIBRATED = 2 };

enum Pattern { CHESSBOARD, CIRCLES_GRID, ASYMMETRIC_CIRCLES_GRID };

" -h=<board_height> # the number of inner corners per another board dimension\n"

" [-pt=<pattern>] # the type of pattern: chessboard or circles' grid\n"

" # - text file with a list of the images of the board\n"

" # the text file can be generated with imagelist_creator\n"

}

static void calcChessboardCorners(Size boardSize, float squareSize, vector<Point3f>& corners, Pattern patternType = CHESSBOARD)

{

corners.resize(0);

" # (used only for video capturing)\n"

" [-s=<squareSize>] # square size in some user-defined units (1 by default)\n"

" # of board views actually available)\n"

" [-d=<delay>] # a minimum delay in ms between subsequent attempts to capture a next view\n"