CDH4.6安装文档

cdh安装hadoop教程

cdh安装hadoop教程CDH(Cloudera's Distribution including Apache Hadoop)是一种基于Apache Hadoop的大数据处理平台,它提供了一套完整的Hadoop生态系统工具和组件。

CDH安装教程一共包含以下几个步骤:1. 系统准备:在开始安装之前,我们需要确保系统满足CDH的最低要求。

CDH要求操作系统为RHEL / CentOS 6或7,并且至少有8GB的内存,2个vCPU,100GB的磁盘空间和64位操作系统。

此外,还需要配置主机名、网络和防火墙设置。

2. JDK安装:CDH依赖于Java运行环境。

首先需要在系统上安装JDK。

可以从Oracle官方网站或OpenJDK获取JDK安装包。

安装JDK后,还需要设置JAVA_HOME环境变量。

3. CDH下载:在安装CDH之前,我们需要从Cloudera官网下载CDH安装包。

Cloudera提供了几个版本,包括CDH4、CDH5和CDH6。

根据需要选择合适的版本下载。

4. 安装CDH:解压CDH安装包,并根据官方文档进行安装。

安装过程中需要指定一个安装目录和一个临时目录,还需要配置Hadoop配置文件如core-site.xml、hdfs-site.xml、yarn-site.xml等。

这些配置文件用于定义Hadoop集群的相关属性,如数据节点、名称节点、资源管理器等。

5. 启动Hadoop集群:完成CDH安装后,我们需要启动Hadoop集群。

首先启动HDFS服务,然后启动YARN服务。

可以使用启动脚本启动Hadoop集群,或者使用Cloudera Manager进行管理。

6. 验证集群状态:一旦Hadoop集群成功启动,我们需要验证集群的状态。

可以通过命令行工具hdfs dfs -ls /或yarn node -list来检查HDFS和YARN的状态。

如果一切正常,应该能够看到节点列表和文件系统的目录。

cdh的搭建流程

cdh的搭建流程

CDH的搭建流程如下:

1. 准备环境:确保所有节点都具备相应的硬件和软件要求,包括内存、存储、操作系统等。

2. 安装Cloudera Manager Server:在主节点上安装Cloudera Manager Server,可以按照官方文档的指引进行安装。

3. 配置节点:配置节点以供Cloudera Manager使用,包括设置主机名、

IP地址、端口等。

4. 安装Parcel:将CDH相关的Parcel包放到主节点的

/opt/cloudera/parcel-repo/目录中。

5. 配置Cloudera Manager:配置Cloudera Manager的各项参数,包括

集群名称、节点信息、用户权限等。

6. 启动服务:在主节点上启动Cloudera Manager Server,并在各个节点

上启动相应的服务。

7. 验证安装:通过浏览器访问Cloudera Manager的管理界面,检查各项

服务是否正常运行。

以上是CDH的搭建流程,具体步骤可能会因为不同的环境和版本而有所不同,建议参考Cloudera官方文档进行操作。

CDH大数据集群环境搭建步骤

CDH大数据集群环境搭建步骤搭建CDH大数据集群环境需要进行以下步骤:1.准备硬件和操作系统:- 硬件要求:至少3台服务器,其中一台作为master节点,其他作为worker节点。

每台服务器至少具有4个CPU核心、16GB内存、100G以上硬盘空间。

- 操作系统要求:集群中的所有服务器需要运行相同的操作系统版本,推荐使用CentOS 7或者Red Hat Enterprise Linux 72.安装基础组件:- 使用root用户登录所有服务器,执行以下命令更新系统:`yum update -y`- 安装JDK:在每台服务器上执行以下命令安装JDK:`yum install-y java-1.8.0-openjdk-devel`- 安装其他依赖包:在每台服务器上执行以下命令安装其他依赖包:`yum install -y wget vim curl ntp`- 授予安装脚本执行权限:`chmod +x cloudera-manager-installer.bin`- 运行安装脚本:`./cloudera-manager-installer.bin`4.配置CDH集群管理器:- 打开Web浏览器,输入master节点的IP地址和端口号7180(默认)访问Cloudera Manager Web控制台。

- 在“Install a New Cluster”页面上,按照提示配置集群名称、选择操作系统等信息,并选择需要安装的组件(如HDFS、YARN、HBase 等)。

- 提供worker节点的主机名或IP地址,在设置完所有配置项后,点击“Continue”按钮。

5.配置集群节点:- 在“Choose Services”页面上,选择需要在集群中安装的服务。

- 在“Assign Roles”页面上,将角色分配给master节点和worker节点。

- 在“Check Configuration”页面上,检查配置项是否正确,如有错误,根据提示进行修改。

cdh运维手册

cdh运维手册摘要:一、前言二、CDH概述1.CDH的定义2.CDH的组成3.CDH的功能三、CDH的安装与配置1.安装环境准备2.安装过程详解3.配置CDH四、CDH的运维管理1.监控CDH2.维护CDH3.备份与恢复CDH五、CDH的常见问题及解决方法六、CDH的安全策略七、CDH的优化与调优八、总结与展望正文:一、前言随着大数据时代的到来,数据处理和存储的需求日益增长。

Cloudera Data Platform(CDH)是一个开源的、完整的、高度可扩展的大数据平台,为企业提供了数据采集、存储、处理、分析和应用等功能。

为了帮助用户更好地使用CDH,本文将详细介绍CDH的运维管理方法。

二、CDH概述1.CDH的定义Cloudera Data Platform(CDH)是Cloudera公司推出的一款大数据平台,它包含了Hadoop、Hive、HBase、Spark等众多大数据组件,为用户提供了一整套大数据解决方案。

2.CDH的组成CDH主要由以下几个组件构成:(1)Hadoop:分布式存储和计算框架(2)Hive:数据仓库工具(3)HBase:分布式NoSQL数据库(4)Spark:大规模数据处理框架(5)其他组件:如Impala、Presto、Sentry等3.CDH的功能CDH提供了数据存储、数据处理、数据分析和数据应用等功能,适用于企业级大数据应用场景。

三、CDH的安装与配置1.安装环境准备(1)硬件环境:CPU、内存、磁盘空间等(2)软件环境:操作系统、Java等2.安装过程详解(1)下载CDH安装包(2)解压安装包(3)配置CDH(4)启动CDH服务(5)验证CDH安装成功3.配置CDH(1)配置Hadoop(2)配置Hive(3)配置HBase(4)配置其他组件四、CDH的运维管理1.监控CDH(1)性能监控(2)状态监控(3)日志监控2.维护CDH(1)升级CDH组件(2)优化CDH配置(3)处理故障3.备份与恢复CDH(1)备份策略(2)备份工具(3)恢复过程五、CDH的常见问题及解决方法1.Hadoop组件问题2.Hive组件问题3.HBase组件问题4.Spark组件问题六、CDH的安全策略1.访问控制2.数据加密3.审计与日志4.安全组件七、CDH的优化与调优1.Hadoop性能优化2.Hive性能优化3.HBase性能优化4.Spark性能优化八、总结与展望本文详细介绍了CDH的运维管理方法,包括安装与配置、监控与维护、备份与恢复、安全策略以及优化与调优等内容,希望对CDH用户有所帮助。

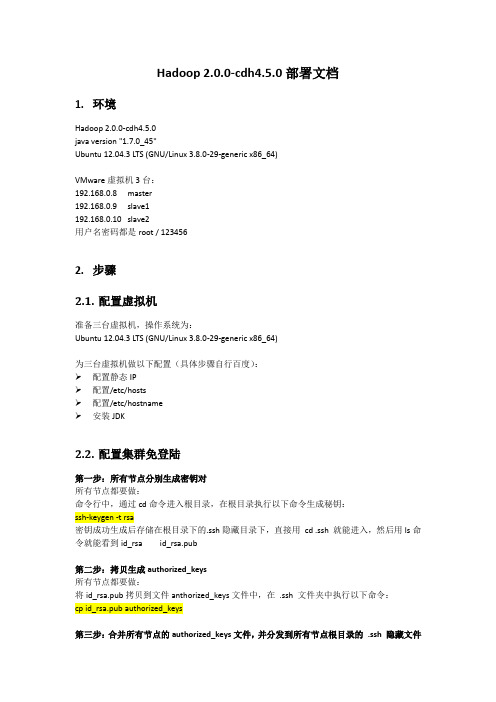

Hadoop_2.0.0-cdh4.5.0部署文档

Hadoop 2.0.0-cdh4.5.0部署文档1.环境Hadoop 2.0.0-cdh4.5.0java version "1.7.0_45"Ubuntu 12.04.3 LTS (GNU/Linux 3.8.0-29-generic x86_64)VMware虚拟机3台:192.168.0.8 master192.168.0.9 slave1192.168.0.10 slave2用户名密码都是root / 1234562.步骤2.1.配置虚拟机准备三台虚拟机,操作系统为:Ubuntu 12.04.3 LTS (GNU/Linux 3.8.0-29-generic x86_64)为三台虚拟机做以下配置(具体步骤自行百度):配置静态IP配置/etc/hosts配置/etc/hostname安装JDK2.2.配置集群免登陆第一步:所有节点分别生成密钥对所有节点都要做:命令行中,通过cd命令进入根目录,在根目录执行以下命令生成秘钥:ssh-keygen -t rsa密钥成功生成后存储在根目录下的.ssh隐藏目录下,直接用cd .ssh就能进入,然后用ls命令就能看到id_rsa id_rsa.pub第二步:拷贝生成authorized_keys所有节点都要做:将id_rsa.pub拷贝到文件anthorized_keys文件中,在.ssh文件夹中执行以下命令:cp id_rsa.pub authorized_keys第三步:合并所有节点的authorized_keys文件,并分发到所有节点根目录的.ssh隐藏文件夹下slave1中将authorized_keys发送到master的temp1临时文件中:scpauthorized_keysroot@master:~/.ssh/temp1slave2中将authorized_keys发送到master的temp2临时文件中:scpauthorized_keysroot@master:~/.ssh/temp2master中将temp1和temp2附加到authorized_keys文件中,这样的话master的authorized_keys文件就包含了所有节点的公钥:cat temp1 >>authorized_keyscat temp2 >>authorized_keysrmtemp1rm temp2master中将合并好的authorized_keys文件分发到各节点:scpauthorized_keysroot@slave1:~/.ssh/scpauthorized_keysroot@slave2:~/.ssh/第四步:所有系统配置/etc/ssh/sshd_config文件,使得系统使用公钥认证,并能识别authorized_keyscd /etc/ssh/ 以后,sudovisshd_config在文件中找到以下几行RSAAuthentication yesPubkeyAuthentication yes#AuthorizedKeysFile%h/.ssh/authorized_keys把#去掉即可,系统就能通过authorized_keys来识别公钥了第五步:检查sshd是否运行/安装,如果未安装将不能成功相互连接运行ps -e | grepssh,查看是否有sshd进程如果没有,说明server没启动,通过/etc/init.d/ssh -start 启动server进程如果提示ssh不存在那么就是没安装server通过sudo apt-get install openssh-server命令安装即可第六步:解决Agent admitted failure to sign using the key如果出现该错误,则需要在所有的节点都执行ssh-add ~/.ssh/id_rsa将私钥加入ssh。

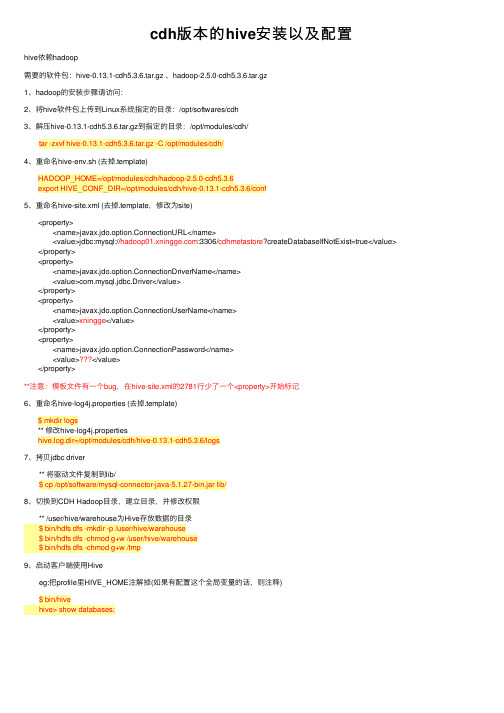

cdh版本的hive安装以及配置

cdh版本的hive安装以及配置hive依赖hadoop需要的软件包:hive-0.13.1-cdh5.3.6.tar.gz 、hadoop-2.5.0-cdh5.3.6.tar.gz1、hadoop的安装步骤请访问:2、将hive软件包上传到Linux系统指定的⽬录:/opt/softwares/cdh3、解压hive-0.13.1-cdh5.3.6.tar.gz到指定的⽬录:/opt/modules/cdh/ tar -zxvf hive-0.13.1-cdh5.3.6.tar.gz -C /opt/modules/cdh/4、重命名hive-env.sh (去掉.template)HADOOP_HOME=/opt/modules/cdh/hadoop-2.5.0-cdh5.3.6export HIVE_CONF_DIR=/opt/modules/cdh/hive-0.13.1-cdh5.3.6/conf5、重命名hive-site.xml (去掉.template,修改为site)<property> <name>javax.jdo.option.ConnectionURL</name> <value>jdbc:mysql://:3306/cdhmetastore?createDatabaseIfNotExist=true</value> </property><property> <name>javax.jdo.option.ConnectionDriverName</name> <value>com.mysql.jdbc.Driver</value></property><property> <name>javax.jdo.option.ConnectionUserName</name> <value>xningge</value></property><property> <name>javax.jdo.option.ConnectionPassword</name> <value></value></property>**注意:模板⽂件有⼀个bug,在hive-site.xml的2781⾏少了⼀个<property>开始标记6、重命名hive-log4j.properties (去掉.template)$ mkdir logs** 修改hive-log4j.propertieshive.log.dir=/opt/modules/cdh/hive-0.13.1-cdh5.3.6/logs7、拷贝jdbc driver ** 将驱动⽂件复制到lib/ $ cp /opt/software/mysql-connector-java-5.1.27-bin.jar lib/8、切换到CDH Hadoop⽬录,建⽴⽬录,并修改权限 ** /user/hive/warehouse为Hive存放数据的⽬录 $ bin/hdfs dfs -mkdir -p /user/hive/warehouse $ bin/hdfs dfs -chmod g+w /user/hive/warehouse $ bin/hdfs dfs -chmod g+w /tmp9、启动客户端使⽤Hive eg:把profile⾥HIVE_HOME注解掉(如果有配置这个全局变量的话,则注释) $ bin/hive hive> show databases;。

cdh运维手册

cdh运维手册摘要:一、CDH运维手册简介二、CDH安装与配置1.安装步骤2.配置参数三、CDH组件与架构1.组件介绍2.架构解析四、CDH运维管理1.日常运维任务1.数据存储管理2.数据查询优化3.集群监控与报警2.故障排查与处理1.常见问题分析2.故障处理方法五、CDH性能优化与调整1.性能评估方法2.性能优化策略3.调整参数实例六、CDH安全与防护1.安全措施2.数据保护策略3.防范攻击方法七、CDH运维最佳实践1.运维团队建设2.运维流程规范3.运维工具应用八、CDH运维案例分享1.成功案例2.经验总结九、CDH未来发展展望1.技术发展趋势2.行业应用前景正文:一、CDH运维手册简介CDH(Cloudera Distribution of Hadoop)是一款基于Apache Hadoop的开源大数据处理平台,提供了完整的分布式计算和存储解决方案。

本运维手册旨在为CDH用户提供一个全面的运维指南,帮助用户更好地部署、管理和发展CDH集群。

二、CDH安装与配置1.安装步骤请参考CDH官方文档或相关教程,进行完整的安装过程。

主要包括以下步骤:- 准备环境- 下载并安装CDH- 配置Java环境- 配置Hadoop核心配置文件- 配置CDH相关组件2.配置参数在CDH安装完成后,需要对各个组件进行参数配置,以满足实际业务需求。

主要包括:- Hadoop核心参数配置- Hive、HBase、Pig等组件参数配置- 存储节点、数据节点、NameNode等参数配置三、CDH组件与架构1.组件介绍CDH包含了Hadoop生态圈中的众多组件,如Hadoop、Hive、HBase、Pig、Spark等。

cdh运维手册

cdh运维手册摘要:CDH运维手册概述I.简介A.CDH简介B.运维手册目的II.环境搭建A.硬件与环境要求B.软件安装与配置C.集群搭建与验证III.集群管理A.节点管理B.资源管理C.集群状态监控IV.数据存储与管理A.HDFS使用与维护B.Hive数据仓库C.HBase分布式数据库V.数据处理与计算A.MapReduce编程与调试B.Spark使用与优化C.实时计算框架VI.安全与权限管理A.用户与角色管理B.数据安全C.访问控制与审计VII.性能优化与调试A.性能监控B.存储优化C.查询优化VIII.故障排查与维护A.故障分类B.故障排查流程C.维护策略与实践IX.备份与恢复A.备份策略与实施B.数据恢复流程C.完整备份与增量备份X.最佳实践与推荐A.运维规范B.性能提升技巧C.运维案例分享正文:CDH运维手册是一份针对Cloudera Distribution of Hadoop(CDH)的运维指南。

本手册旨在帮助企业和个人更好地部署、管理、优化和维护CDH 平台,确保系统稳定、高效地运行。

一、简介1.1 CDH简介CDH是Cloudera公司推出的一款Hadoop发行版,包含了Hadoop的核心组件,如HDFS、MapReduce、Hive、HBase等。

相较于其他Hadoop 发行版,CDH更注重稳定性和安全性,适用于企业级大数据处理需求。

1.2 运维手册目的本手册为运维人员提供了一套完整的CDH平台运维知识体系,包括环境搭建、集群管理、数据存储与管理、数据处理与计算、安全与权限管理、性能优化与调试、故障排查与维护等内容,旨在提高运维效率,降低运维成本,确保系统安全稳定运行。

二、环境搭建2.1 硬件与环境要求详细介绍了CDH的硬件需求,包括服务器、存储、网络等方面的配置。

同时,还阐述了CDH对操作系统、JDK、Python等软件的环境要求。

2.2 软件安装与配置本章节介绍了如何在一台新服务器上安装CDH,包括下载、安装、配置等步骤。

cdh运维手册

cdh运维手册一、简介CDH是指Cloudera Distribution Including Apache Hadoop,是一个大数据分析平台。

本手册旨在提供有关CDH运维的详细指南,包括安装、配置、监控、故障排除等方面的内容。

二、安装与配置1. 硬件要求CDH运维需要一定的硬件要求。

建议服务器拥有至少8GB内存、4核处理器和100GB可用磁盘空间。

2. 操作系统要求CDH支持多种操作系统,如CentOS、Red Hat Enterprise Linux等。

确保所选操作系统符合CDH的要求。

3. 安装步骤a) 下载CDH软件包并解压。

b) 配置操作系统环境变量。

c) 启动CDH安装向导,并按照提示进行安装和配置。

确保正确设置Hadoop、Hive、HBase等组件。

4. 高可用性设置对于大规模的部署,建议配置CDH集群的高可用性(HA)。

HA 可确保在故障发生时服务的连续性。

详细的HA配置步骤请参考官方文档。

三、监控与维护1. 集群监控CDH集成了Cloudera Manager,提供了全面的集群监控功能。

通过Cloudera Manager,可以实时查看集群各组件的状态、资源使用情况等。

2. 日志管理CDH将各个组件的日志集中管理,方便运维人员进行故障排查。

通过Cloudera Manager的日志管理功能,可以快速定位和解决问题。

3. 故障排除a) 检查集群状态和组件运行状况,确认是否有异常。

b) 查看日志文件,寻找异常或错误信息。

c) 根据错误信息和文档进行问题诊断和解决。

四、性能优化1. 资源管理合理配置集群的资源管理机制,如YARN和Fair Scheduler,以充分利用集群资源。

2. 数据压缩对于大型数据集,可以考虑启用数据压缩来减少存储空间的占用和提高读写效率。

3. 数据分区对数据进行合理的分区可以提高查询效率。

根据数据特点和查询需求,选择合适的分区策略。

五、安全与权限管理1. 集群安全CDH提供了多种安全机制,如Kerberos认证、SSL加密等,用于保护集群的安全性。

CDH集群安装步骤

环境准备192.168.200.41 cpu:2.6GHZ*2,ram:16G,rom:500G hostname: hadoop1192.168.200.42 cpu:2.6GHZ*2,ram:16G,rom:500G hostname: hadoop2192.168.200.43 cpu:2.6GHZ*2,ram:16G,rom:500G hostname: hadoop3192.168.200.44 cpu:2.6GHZ*2,ram:16G,rom:500G hostname: hadoop4192.168.200.45 cpu:2.6GHZ*2,ram:16G,rom:500G hostname: hadoop5root/iscs2016关闭防火墙:chkconfig iptables off,重启生效关闭SELINUX:使用getenforce命令查看是否关闭,关闭前显示为enforcing。

修改/etc/selinux/config 文件将SELINUX=enforcing改为SELINUX=disabled,执行该命令后重启机器生效修改5台机器网络设置重启网络:service network restart检查IP是否修改:ifconfig检查能否联网:设置机器名:vi /etc/sysconfig/network,每台分别对应一个机器名,以此类推设置HOST文件:vi /etc/hosts对网络设置进行重启:sudo /etc/init.d/network restart互ping验证是否设置正确:所有节点增加用户adduser iscs设置密码:passwd iscs (iscs2016)所有节点设置iscs用户无密码sudo到root权限:1、给文件赋予写权限chmod u+w /etc/sudoers2、增加一行3、给文件删除写权限给文件赋予写权限chmod u-w /etc/sudoers4、OKNTP时间同步SSH无密码验证设置(用户iscs):1、在每个节点中使用ssh-keygen -t rsa生成私钥和公钥;连续点击回车即可2、在5个节点中分别把公钥命名为authorized_keys_hadoop1、authorized_keys_hadoop2、authorized_keys_hadoop3、authorized_keys_hadoop4、authorized_keys_hadoop53、以第一个节点hadoop1为例,把其他四个节点的公钥使用scp authorized_keys_hadoop2 iscs@hadoop1:/home/iscs/.ssh 命令传送到hadoop1节点的/home/iscs/.ssh文件夹中4、把五个节点的公钥信息保存到authorized_key文件中,使用cat authorized_keys_hadoop1 >> authorized_keys命令5、把该文件分发到其他四个从节点上使用scp authorized_keys iscs@hadoop2:/home/iscs/.ssh把密码文件分发出去6、测试ssh免密码登录是否生效7、设置ntp时间同步1) 安装NTP(每个节点)yum install ntp2) 配置NTPVim /etc/ntp.confMater配置(选用复旦大学ntp服务器)Slave配置(每个slave节点):3) 开启ntp服务/bin/systemctl start ntpd.service4) 查看同步效果ntpstat所有节点设置httpd启动:开机启动:sudo chkconfig httpd on手动启动:sudo service httpd start安装依赖包:yum -y install postgresql-serveryum -y install postgresqlyum -y install httpdyum -y install perlyum -y install bind-utilsyum -y install libxsltyum -y install cyrus-sasl-gssapiyum -y install redhat-lsbyum -y install cyrus-sasl-plainyum -y install portmapyum -y install fuseyum -y install fuse-libsyum -y install nc yum -y install python-setuptools yum install openssh-clientsCloudera Manager安装下载Cloudera Manager 安装软件下载Cloudera Manager所需要的rpm包将上述软件与报上传至Linux环境,我这里上传到/root/p01/cdhrpm (注:路径随意)在此路径下:执行:yum localinstall --nogpgcheck *.rpm(安装rpm包)执行:chmod u+x cloudera-manager-installer.bin(给下载的bin文件权限)执行:./cloudera-manager-installer.bin(大约十分钟左右,按提示选择即可)安装好后,执行jps -l,查看服务是否启动浏览器输入192.168.200.41:7180,进入manager界面(具体IP视个人而定,端口为7180,初始用户名密码均为admin)Cloudera Manager文件配置及本地源配置配置config.ini文件修改主机名(只针对mater节点,slave节点server_host指定为master的IP)vi /etc/cloudera-scm-agent/config.ini修改前为:localhost 修改后为:localhost.localdomain本地源配置Parcel的可以从如下网址获得,下载.parcel文件和manifest.json文件:注意:Parcel文件对应不同的系统版本l 把以下载的.parcel文件和manifest.json文件拷贝到/opt/cloudera/parcel-repo/文件夹下l 新建文件命名为:CDH-5.0.1-1.cdh5.0.1.p0.47-el6.parcel.shal 打开manifest.json文件查看CDH-5.0.1-1.cdh5.0.1.p0.47-el6.parcel对应的编号,并拷贝到CDH-5.0.1-1.cdh5.0.1.p0.47-el6.parcel.sha文件中/cdh5/parcels/5.0.1/CDH-5.0.1-1.cdh5.0.1.p0.47-el6.parcel;service cloudera-scm-agentIgnoring non-compliant parcel manifestexport JAVA_HOME=/usr/java/jdk1.6.0_31export PATH=$JAVA_HOME/bin:$PATHexport CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar如果页面找不到主机,修改vi /etc/cloudera-scm-agent/config.ini,server_host 修改为master的IP,重启service cloudera-scm-agent restart即可、Password:iscs2016Kafka:Heap Size of Broker修改server.properties中的broker id Find / -name meta.propertiesrpm -ivh *.rpm --nodeps --force。

安装GCC-4.6.1详细教程

安装GCC-4.6.1详细教程一、什么是GccLinux系统下的Gcc(GNU C Compiler)是GNU推出的功能强大、性能优越的多平台编译器,是GNU的代表作品之一。

gcc是可以在多种硬体平台上编译出可执行程序的超级编译器,其执行效率与一般的编译器相比平均效率要高20%~30%。

Gcc编译器能将C、C++语言源程序、汇程式化序和目标程序编译、连接成可执行文件,如果没有给出可执行文件的名字,gcc将生成一个名为a.out的文件。

在Linux系统中,可执行文件没有统一的后缀,系统从文件的属性来区分可执行文件和不可执行文件。

二、gcc所遵循的部分约定规则前面提到便宜的后缀问题,而gcc则通过后缀来区别输入文件的类别,下面我们来介绍gcc 所遵循的部分约定规则。

.c为后缀的文件,C语言源代码文件;.a为后缀的文件,是由目标文件构成的档案库文件;.C或.cc或.cxx为后缀的文件,是C++源代码文件;.h为后缀的文件,是程序所包含的头文件;.i为后缀的文件,是已经预处理过的C源代码文件;.ii为后缀的文件,是已经预处理过的C++源代码文件;.m为后缀的文件,是Objective-C源代码文件;.o为后缀的文件,是编译后的目标文件;.s为后缀的文件,是汇编语言源代码文件;.S为后缀的文件,是经过预编译的汇编语言源代码文件。

三、Gcc的执行过程虽然我们称Gcc是C语言的编译器,但使用gcc由C语言源代码文件生成可执行文件的过程不仅仅是编译的过程,而是要经历四个相互关联的步骤∶预处理(也称预编译,Preprocessing)、编译(Compilation)、汇编(Assembly)和连接(Linking)。

●命令gcc首先调用cpp进行预处理,在预处理过程中,对源代码文件中的文件包含(include)、预编译语句(如宏定义define等)进行分析。

●接着调用cc1进行编译,这个阶段根据输入文件生成以.o为后缀的目标文件。

CDH大数据平台搭建终极版

CDH⼤数据平台搭建终极版经过⽆数次的失败,终于将CDH安装到两台普通的笔记本电脑上,主要失败原因有以下⼏点:1. 不熟悉安装过程,官⽅给出的安装⽅法有三种,所以都尝试了⼀遍,浪费了⼤量时间,所以有时候⽅法多不见得是⼀件好事。

2. 安装设备太差,有时会因为占⽤内存或者CPU占⽤过⾼⽽死机。

3. 安装⽹络环境太差,导致传输过程可能出现超时失败现象。

4. 安装时间过久,导致出错后重新再来时间付出太多。

以下讲的⽅法不是最优的⽅法,但是是我们最后的⽅法,可供参考。

1.搭建环境两台笔记本电脑A和B,⾃带内存分别为12G和8G,安装VMware 12。

A开⼀个虚拟机,2*CPU,8G内存,使⽤桥接⽹卡模式,安装CentOS6.5,充当主机Master。

B开两个虚拟机,1*CPU,2G内存,使⽤桥接⽹卡模式,安装CentOS6.5,充当分机Slave1,Slave2。

两台电脑通过⽹线连接到学校内⽹,使⽤内⽹⽹络环境搭建,三台虚拟机的root密码必须⼀致。

2.安装前的准备⾸先先下载以下安装包cloudera-manager-el6-cm5.8.0_x86_64.tar.gz (Cloudera Manager 安装包,el6代表使⽤的CentOs6.x,cm-5.8.0代表使⽤的Cloudera Manager版本为5.8.0)CDH-5.8.0-1.cdh5.8.0.p0.42-el6.parcel (CDH离线资源包)CDH-5.8.0-1.cdh5.8.0.p0.42-el6.parcel.sha1manifest.jsoncm5.8.0-centos6.tar.gz (⾥⾯有⼀些必要的环境)mysql-connector-java-5.1.6-bin.jar (JDBC)下载路径分别为注意:不要图⽅便少下什么,或者少安装什么,尤其是JDK⼀定要安装官⽅的,要不会导致后⾯Spark配制出错,这个地⽅我们起码失败了5、6次,⼀定要全部下下来,重来的代价会更⾼3.安装前的配置⾸先进⼊root权限:输⼊su,再输⼊密码即可3.1.配置主机名分别修改各节点/etc/sysconfic/network⽂件,设置主机名为Master,Slave1,Slave2。

cloudera 安装部署手册

clouderaCDH安装修订记录目录1.导言 (5)1.1.说明 (5)1.2.集群节点 (5)1.3.硬件 (5)1.4.软件版本 (5)2.准备工作 (5)2.1.操作系统 (5)2.2.磁盘 (5)2.2.1.是否需要raid (5)2.2.2.磁盘划分 (5)2.2.3.磁盘裸设备的挂载 (6)2.3.关闭防火墙 (6)2.4.修改主机名并配置Hosts (7)2.4.1.修改主机名 (7)2.4.2.设置每台主机的hosts (7)2.5.ssh免登陆配置 (7)2.5.1.创建公钥和密钥 (7)2.5.2.配置与其他机器的免密码登陆 (8)2.6.同步集群时间ntp (9)2.6.1.配置ntp server集群时钟 (9)2.6.2.ntp客户端配置 (10)2.6.3.测试 (11)2.7.上传安装包以及搭建yum源 (12)2.7.1.安装cloudera需要的文件如下安装包 (12)2.7.2.上传yum源需要的文件到/var/www/html目录下 (12)2.7.3.启动httpd服务 (13)2.7.4.测试HTTPD (13)2.7.5.编辑yum源配置文件 (14)2.7.6.安装createrepo (15)2.7.7.创建源索引 (15)3.cm安装 (15)3.1.上传cm安装启动程序 (15)3.2.安装cm的install.bin (16)4.cdh安装 (19)4.1.登陆CM (19)4.2.指定主机 (20)4.3.群集安装 (21)4.4.安装parcel (21)4.4.1.配置CDH-5.3.0-1.cdh5.3.0.p0.30-el6.parcel.sha1 (21)4.4.2.配置parcel (22)4.5.选择parcel和cm等 (24)4.6.安装CM JDK和分发数据包等 (26)4.7.分配parcel (28)4.8.检查各个主机 (28)4.9.选择需要安装的服务 (29)4.10.分配角色并安装 (30)5.验证和使用 (33)5.1.zookeeper (33)5.2.hbase (33)5.3.hdfs (33)5.4.使用shell验证hbase安装 (34)1.导言1.1.说明本指导书以潍坊交警hadoop集群为例,指导安装CDH1.2.集群节点见hadoop服务器角色清单1.3.硬件共14台“华为RH2288-HV2 Xeon E5-2620,内存容量:192G,4块2T SATA 硬盘”1.4.软件版本cdh5.3.02.准备工作2.1.操作系统操作系统使用64位CentOS6.52.2.磁盘2.2.1.是否需要raid集群datanode不需要安装raid磁盘,hadoop的hdfs本身具有冗余和并发机制,namenode为了保证数据安全,需要安装raid。

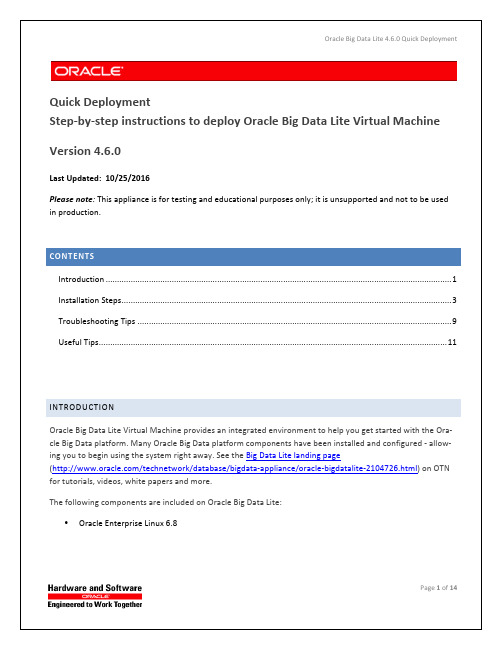

Oracle Big Data Lite 4.6.0 快速部署指南说明书

Big Data Lite includes software products that are optional on the Oracle Big Data Appliance (BDA), including Oracle NoSQL Database Enterprise Edition, Oracle Big Data SQL, Oracle Big Data Discovery, Oracle Big Data Spatial and Graph and Oracle Big Data Connectors.

Version 4.6.0

Last Updated: 10/25/2016 Please note: This appliance is for testing and educational purposes only; it is unsupported and not to be used in production. C O N T E N T S

To get started, you should perform the following high level tasks:

• Ensure your host computer meets the requirements for running the virtual machine • Download and install VirtualBox and VirtualBox Extension Pack – which is a cross-‐platform virtualiza-‐

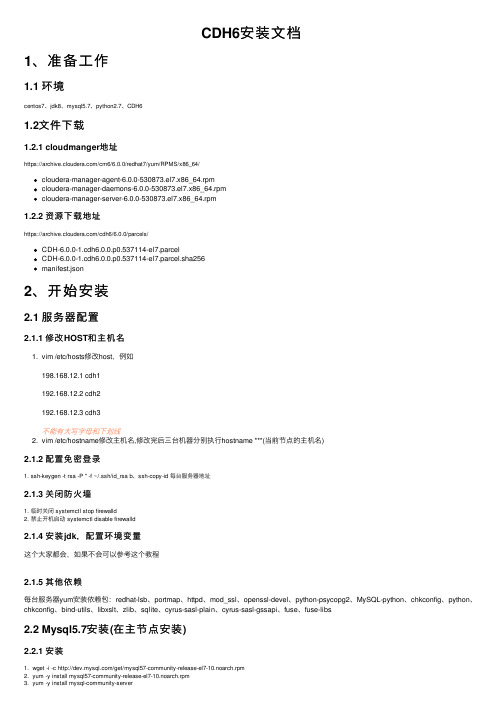

CDH6安装文档

CDH6安装⽂档1、准备⼯作1.1 环境centos7、jdk8、mysql5.7、python2.7、CDH61.2⽂件下载1.2.1 cloudmanger地址https:///cm6/6.0.0/redhat7/yum/RPMS/x86_64/cloudera-manager-agent-6.0.0-530873.el7.x86_64.rpmcloudera-manager-daemons-6.0.0-530873.el7.x86_64.rpmcloudera-manager-server-6.0.0-530873.el7.x86_64.rpm1.2.2 资源下载地址https:///cdh6/6.0.0/parcels/CDH-6.0.0-1.cdh6.0.0.p0.537114-el7.parcelCDH-6.0.0-1.cdh6.0.0.p0.537114-el7.parcel.sha256manifest.json2、开始安装2.1 服务器配置2.1.1 修改HOST和主机名1. vim /etc/hosts修改host,例如198.168.12.1 cdh1192.168.12.2 cdh2192.168.12.3 cdh3不能有⼤写字母和下划线2. vim /etc/hostname修改主机名,修改完后三台机器分别执⾏hostname ***(当前节点的主机名)2.1.2 配置免密登录1. ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa b、ssh-copy-id 每台服务器地址2.1.3 关闭防⽕墙1. 临时关闭 systemctl stop firewalld2. 禁⽌开机启动 systemctl disable firewalld2.1.4 安装jdk,配置环境变量这个⼤家都会,如果不会可以参考这个教程2.1.5 其他依赖每台服务器yum安装依赖包:redhat-lsb、portmap、httpd、mod_ssl、openssl-devel、python-psycopg2、MySQL-python、chkconfig、python、chkconfig、bind-utils、libxslt、zlib、sqlite、cyrus-sasl-plain、cyrus-sasl-gssapi、fuse、fuse-libs2.2 Mysql5.7安装(在主节点安装)2.2.1 安装1. wget -i -c /get/mysql57-community-release-el7-10.noarch.rpm2. yum -y install mysql57-community-release-el7-10.noarch.rpm3. yum -y install mysql-community-server4. 启动 systemctl start mysqld.service5. 查看运⾏状态 systemctl status mysqld.service6. 查看初始密码 grep "password" /var/log/mysqld.log7. 登录后修改密码(尽量复杂⼀点,太简单了验证不通过,也可以查看如何关闭mysql校验规则) ALTER USER 'root'@'localhost' IDENTIFIED BY 'new password';8. 卸载yum源防⽌⾃动更新 yum -y remove mysql57-community-release-el7-10.noarch</br>9. 安装MySQL-shared-compat或MySQL-shared软件包(这是Cloudera Manager Agent软件包安装所必需的)yum install MySQL-shared-advanced2.2.2 创建CDH相关数据库create database scm default character set utf8 default collate utf8_general_ci;grant all on scm.* to 'scm'@'%' identified by 'password';create database amon default character set utf8 default collate utf8_general_ci;grant all on amon.* to 'amon'@'%' identified by 'password';create database rman default character set utf8 default collate utf8_general_ci;grant all on rman.* to 'rman'@'%' identified by 'password';create database hue default character set utf8 default collate utf8_general_ci;grant all on hue.* to 'hue'@'%' identified by 'password';create database metastore default character set utf8 default collate utf8_general_ci;grant all on metastore.* to 'hive'@'%' identified by 'password';create database sentry default character set utf8 default collate utf8_general_ci;grant all on sentry.* to 'sentry'@'%' identified by 'password';create database nav default character set utf8 default collate utf8_general_ci;grant all on nav.* to 'nav'@'%' identified by 'password';create database oozie default character set utf8 default collate utf8_general_ci;grant all on oozie.* to 'oozie'@'%' identified by 'password';2.3 CDH安装1. mkdir /opt/cloudera-manager2. 将cloudera-manager-agent-6.0.0-530873.el7.x86_64.rpm、cloudera-manager-daemons-6.0.0-530873.el7.x86_64.rpm 、cloudera-manager-server-6.0.0-530873.el7.x86_64.rpm 复制到/opt/cloudera-manager⽂件夹中3. 按 daemons、server、agent顺序解压4. 修改⽂件/etc/cloudera-scm-agent/config.ini中serverhost指定server节点5. 下载mysql-connector-java-5.1.47.jar包并复制为/usr/share/java/mysql-connector-java.jar6. 在主节点执⾏/opt/cloudera/cm/schema/scmpreparedatabase.sh mysql -h 主节点ip --scm-host 主节点ip scm scm7. mkdir -p /opt/cloudera/parcel-repo8. 将CDH-6.0.0-1.cdh6.0.0.p0.537114-el7.parcel、CDH-6.0.0-1.cdh6.0.0.p0.537114-el7.parcel.sha256、manifest.json复制到/opt/cloudera/parcel-repo9. 将CDH-6.0.0-1.cdh6.0.0.p0.537114-el7.parcel.sha256 重命名为 CDH-6.0.0-1.cdh6.0.0.p0.537114-el7.parcel.sha10. 在manifest.json⽂件中,找到对应版本的秘钥,复制到CDH-6.0.0-1.cdh6.0.0.p0.537114-el7.parcel.sha⽂件中。

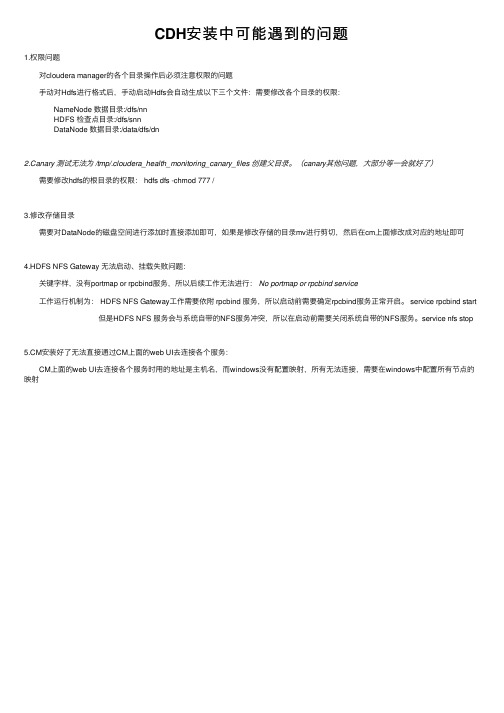

CDH安装中可能遇到的问题

CDH安装中可能遇到的问题1.权限问题 对cloudera manager的各个⽬录操作后必须注意权限的问题 ⼿动对Hdfs进⾏格式后,⼿动启动Hdfs会⾃动⽣成以下三个⽂件:需要修改各个⽬录的权限: NameNode 数据⽬录:/dfs/nn HDFS 检查点⽬录:/dfs/snn DataNode 数据⽬录:/data/dfs/dn2.Canary 测试⽆法为 /tmp/.cloudera_health_monitoring_canary_files 创建⽗⽬录。

(canary其他问题,⼤部分等⼀会就好了) 需要修改hdfs的根⽬录的权限: hdfs dfs -chmod 777 /3.修改存储⽬录 需要对DataNode的磁盘空间进⾏添加时直接添加即可,如果是修改存储的⽬录mv进⾏剪切,然后在cm上⾯修改成对应的地址即可4.HDFS NFS Gateway ⽆法启动、挂载失败问题: 关键字样,没有portmap or rpcbind服务,所以后续⼯作⽆法进⾏:No portmap or rpcbind service ⼯作运⾏机制为: HDFS NFS Gateway⼯作需要依附 rpcbind 服务,所以启动前需要确定rpcbind服务正常开启。

service rpcbind start 但是HDFS NFS 服务会与系统⾃带的NFS服务冲突,所以在启动前需要关闭系统⾃带的NFS服务。

service nfs stop5.CM安装好了⽆法直接通过CM上⾯的web UI去连接各个服务: CM上⾯的web UI去连接各个服务时⽤的地址是主机名,⽽windows没有配置映射,所有⽆法连接,需要在windows中配置所有节点的映射。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CDH4.6安装文档

安装前准备工作

1)修改防火墙,添加过滤端口

修改防火墙,添加过滤端口(7180,7181,9000,9001等,其中7180主要是cdh控制台用的,9000和9001是通讯用的,可以在安装过程中报错之后再去添加或者直接关闭防火墙)

2)配置系统互信

●在做namenode的机器上运行ssh-keygen -t rsa然后选择保存路径以及验证口令

(随意),生成密钥,注意记住保存路径以及验证口令

●复制公钥到其他datanode上执行

namenode: scp .ssh/id_rsa.pub hadoop@slave:~/master_keys

(使用默认22端口,也可以在scp 后加-P 端口号)

登录所有的datanode执行:

datanode: mkdir ~/.ssh

chmod 700 ~/.ssh

mv ~/master_keys ~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

最后验证一下能不能互联:

ssh hadoop@slave date

回车就能登录到slave机器(如果有输入口令还要输入口令)

注:最后记得下载私钥到本机,后续安装需要用到

3)创建免密码的sudo用户

每台机器上配置一个名称相同的用户,并且配置该用户可以免密码sudo(如果想直接使用root用户的话可以省略这一步骤)

e.g.: useradd hadoop

passwd hadoop

visudo(编辑添加%hadoop ALL=(ALL) NOPASSWORD:ALL##hadoop群组的用户都可以免密码sudo了)

4)修改/etc/hosts文件

修改各个主机上的/etc/hosts文件,增加集群内所有主机的ip-主机名映射

注,此处的主机名必须与每台机器的主机名一致,否则后续的安装可能会报错

5)安装postgresql8.1以上版本数据库

6)安装系统rpm包

安装CM4.8.2程序

1)到cloudera官网下载安装文件cloudera-manager-installer.bin

2)执行sudo chmod u+x cloudera-manager-installer.bin

然后执行sudo ./cloudera-manager-installer.bin开始安装cloudera manager,一路选yes、回车就行了

安装CDH4.6程序

1)安装完成之后会提示登录到控制台上继续操作,打开浏览器输入地址,一般是安装

cloudera manager主机的ip+端口(7180)

如果打不开控制台的网页,查看iptables是否禁用了端口,并修改iptables过滤7180端口,重启iptables即可

默认用户名密码为admin/admin

2)登录之后开始安装集群以及CDH

首先选择免费版,点继续

地址)选择继续

一般选择使用包裹(parcel),同时选择CDH4,不用选择Solr和Impala

4)输入用户名密码

根据一、准备工作中创建的用户来选择是用root用户还是其他用户,是所有主机相同密码还是接受相同私钥

5)向每台主机安装一些元包(jdk,cloudera-agent等等)

这个过程可能会耗时很长,主要是要下载几个安装包总共有几百兆,且每台机都要下载,同时还有可能会安装失败(有时可能是下载超时,或者防火墙问题)

注,可参考三、问题汇总快速通过此步骤

6)安装完成后会继续下载CDH包(7百多兆)后点继续,此时要求选择在CDH上的服务,

根据需要选择,一般选择核心服务就行了,后续可以再添加

7)数据库设置,可以选择使用嵌入式数据库(PostgreSQL,已经包含在cloudera中不用安

装)也可以使用外部的数据库,点击测试连接,成功后点继续

注,此处有可能会在点击测试连接之后提示Unknown host ':7432'. Unable to find it from host...,这个应该是个bug,解决方法在后面

后续的安装一路点继续就可以了,最后安装成功。