Andrew Ng机器学习课程目录(带翻译)

AndrewNg机器学习笔记

编程练习1:线性回归机器学习介绍在这个练习中,您将实现线性回归,并能看到它的数据。

开始对这种编程练习之前,我们强烈建议观看视频讲座,并完成对相关主题的复习题。

要开始使用的练习中,您将需要的内容下载启动代码,并解压到你想要完成练习的目录。

如果需要,可使用 光盘 在八度/ MATLAB命令来开始这个练习前切换到该目录。

您也可以Fi,可在课程网站的“环境安装说明”安装八度/ MATLAB次指令。

文件包含在此锻炼ex1.m - 八度/ MATLAB程序,引导您完成练习EX1 multi.m - 八度/ MATLAB脚本演练的后面部分ex1data1.txt - 数据集用于与一个变量线性回归ex1data2.txt - 数据集用于与多个变量线性回归submit.m - 提交脚本发送您的解决方案,我们的服务器warmUpExercise.m [?] - 在八度/ MATLAB简单的例子功能plotData.m [?] - 功能来显示数据集computeCost.m [?] - 函数来计算线性回归的成本gradientDescent.m [?] - 函数运行梯度下降[ †] computeCostMulti.m - 多变量成本函数[ †] gradientDescentMulti.m - 梯度下降的多个变量[ †] featureNormalize.m - 功能正常化的功能[ †] normalEqn.m - 函数来计算法方程? 表明科幻LES,你将需要完成† 表示可选演习在整个练习中,您将使用脚本 ex1.m 和 EX1 multi.m。

这些脚本建立数据集的问题,并作出你会写函数的调用。

你并不需要修改其中任何。

您只需要修改的功能在其他科幻LES,按照此任务的指示。

对于这种编程练习中,您只需要完成练习的第一个部分来实现线性回归一个变量。

运动,这是可选的第二部分,覆盖多变量线性回归。

从哪里获得帮助本课程的练习用八度 1 或MATLAB,一个高级语言非常适合于数字计算。

Ng机器学习课程

Ng机器学习课程(/materials.html) Notes理论要点,并且给出所有课程exercise的作业code和实验结果分析。

”游泳是游会的“,希望通过这个系列可以深刻理解机器学习算法,并且自己动手写出work高效的机器学习算法code应用到真实数据集做实验,理论和实战兼备。

Part 1 Linear Regression1. Supervised Learning在Supervise Learning的Setting中,我们有若干训练数据(x^(i),y^(i)) i= 1,...,m ,这里i用于index training example。

监督学习的任务就是要找到一个函数(又称为模型或者假设hypothesis)H: X -> Y, 使得h(x)是相应值y的好的预测。

整个过程可以描述为下图当待预测的目标变量是连续型数据时,我们称之为回归(regression)问题;当待预测的目标变量是离散型数据时,我们称之为分类(classification)问题。

因此回归问题和分类问题是监督学习针对连续型数据预测和离散型数据预测的两种典型学习问题。

2 Linear Regression一般而言,我们会用feature向量来描述训练数据X,我们用x_j^i来表示,其中j用于index feature, i用于index训练样本。

在监督学习里面,我们需要找到一个最佳的预测函数h(x),比如我们可以选取feature的线性组合函数那么我们的问题就变成了要寻找最优的参数\theta可以使得预测的error最小。

把这个函数用向量表示机器学习里面一般默认变量为列向量,因此这里是参数向量\theta的转置矩阵。

同时我们还加上了”feature 0“即x_0 = 1 以便方便表示成为向量乘积的形式。

为了寻找最优的参数\theta,我们可以最小化error function即cost function这个就是least-squares cost function,通过最小化这个函数来寻找最优参数。

吴恩达深度学习课程:神经网络和深度学习

吴恩达深度学习课程:神经网络和深度学习[中英文字幕+ppt课件]内容简介吴恩达(Andrew Ng)相信大家都不陌生了。

2017年8 月8 日,吴恩达在他自己创办的在线教育平台Coursera 上线了他的人工智能专项课程(Deep Learning Specialization)。

此课程广受好评,通过视频讲解、作业与测验等让更多的人对人工智能有了了解与启蒙,国外媒体报道称:吴恩达这次深度学习课程是迄今为止,最全面、系统和容易获取的深度学习课程,堪称普通人的人工智能第一课。

关注微信公众号datayx 然后回复“深度学习”即可获取。

第一周深度学习概论:学习驱动神经网络兴起的主要技术趋势,了解现今深度学习在哪里应用、如何应用。

1.1 欢迎来到深度学习工程师微专业1.2 什么是神经网络?1.3 用神经网络进行监督学习1.4 为什么深度学习会兴起?1.5 关于这门课1.6 课程资源第二周神经网络基础:学习如何用神经网络的思维模式提出机器学习问题、如何使用向量化加速你的模型。

2.1 二分分类2.2 logistic 回归2.3 logistic 回归损失函数2.4 梯度下降法2.5 导数2.6 更多导数的例子2.7 计算图2.8 计算图的导数计算2.9 logistic 回归中的梯度下降法2.10 m 个样本的梯度下降2.11 向量化2.12 向量化的更多例子2.13 向量化logistic 回归2.14 向量化logistic 回归的梯度输出2.15 Python 中的广播2.16 关于python / numpy 向量的说明2.17 Jupyter / Ipython 笔记本的快速指南2.18 (选修)logistic 损失函数的解释第三周浅层神经网络:学习使用前向传播和反向传播搭建出有一个隐藏层的神经网络。

3.1 神经网络概览3.2 神经网络表示3.3 计算神经网络的输出3.4 多样本向量化3.5 向量化实现的解释3.6 激活函数3.7 为什么需要非线性激活函数?3.8 激活函数的导数3.9 神经网络的梯度下降法3.10 (选修)直观理解反向传播3.11 随机初始化第四周深层神经网络:理解深度学习中的关键计算,使用它们搭建并训练深层神经网络,并应用在计算机视觉中。

机器学习过程

转载]机器学习的经典教程(不断更新中)(2014-07-15 16:29:34)转载▼标签:转载初学者转载原文地址:机器学习的经典教程(不断更新中)作者:MachineLearner如今机器学习的学习资源越来越多,对于入行的朋友们来说,他们只需要关注自己从事的具体研究方向最新的国际会议、杂志上的paper就差不多了,而对于那些想要入行的朋友们,选择经典的教程入手可能会事半功倍。

以下这些教程,是我这些年接触机器学习以来觉得比较经典的,也欢迎朋友们补充。

一、公开课Andrew Ng教授的机器学习课程。

多啰嗦几句Andrew Ng,他虽然没出过啥书,但是他对这两年接触机器学习的人应该帮助最大了。

这哥们是机器学习界大牛Michael Jordan的最得意的门生(据说没有之一),最早只是把公开课视频放到网上,国内网易公开课做了翻译,课程内容安排的真是深入浅出,只要有点微积分和线性代数基础,都能够看明白一些复杂算法的推导(其实这点很重要,一些大牛的paper或者书籍由于篇幅所限,往往一个公式推导需要10步,他只会写最重要的两步,对于初学者来说还是很痛苦的)。

由于这个公开课视频受众甚广,好评如潮,Andrew Ng老师伙同斯坦福另一位同事Daphne Koller创建了Coursera这个在线教育平台,和公开课视频相比这个平台更注重和学生交互,能够帮助学生更好地掌握所follow的课程。

公开课推荐:1、https:///course/ml Andrew Ng在coursera上的机器学习课程,相比公开课来说,内容更简单一些,入门甚佳。

2、/special/opencourse/machinelearning.html Andrew Ng的公开课视频3、https:///course/pgm Daphne Koller在course上图模型的课程4、https:///course/neuralnets Geoffrey Hinton的神经网络的课。

《机器学习》教学大纲

《机器学习》教学大纲课程编号:课程名称:机器学习英文名称:Machine Learning先修课程:高等数学(数学分析)、线性代数(高等代数)、概率论与数理统计、程序设计基础总学时数:54学时一、教学目的本课程可作为计算机科学与技术、智能科学与技术相关本科专业的必修课,也可作为其它本科专业的选修课,或者其它专业低年级研究生的选修课。

本课程的教学目的是使学生理解机器学习的基本问题和基本算法,掌握它们的实践方法,为学生今后从事相关领域的研究工作或项目开发工作奠定坚实的基础。

具体来讲,要使学生理解聚类、回归、分类、标注相关算法并掌握它们的应用方法;理解概率类模型并掌握它们的应用方法;理解神经网络类模型并掌握它们的应用方法;理解深度学习模型并掌握它们的应用方法;理解距离度量、模型评价、过拟合、最优化等机器学习基础知识;掌握特征工程、降维与超参数调优等机器学习工程应用方法。

二、教学要求总体上,本课程的教学应本着理论与实践相结合的原则,深入浅出,突出重点,在重视基础理论的同时,注意培养学生独立思考和动手能力。

在内容设计上,应以示例入手,逐步推进,详尽剖析算法思想与基本原理。

在实施方法上,应采取启发式教学方法,在简要介绍算法思想和流程的基础上,引导学生自行运行并分析实现代码。

在教学手段上,应结合板书、多媒体、网络资源等多种传授方法,提高学生兴趣。

在实验教学上,应促进学生对讲授知识的理解,开拓眼界,提升实践能力。

三、教学内容本课程内容共分为八章。

(一)绪论(1学时)【内容】机器学习的基本概念,机器学习算法及其分类,课程内容介绍,编程环境及工具包。

【重点】机器学习的基本概念,机器学习算法分类。

(二)聚类(11学时,含4学时实验课)【内容】K均值聚类及其改进算法,聚类的任务,样本点常用距离度量,聚类算法评价指标,聚类算法分类,DBSCAN算法及其派生算法,AGNES算法。

【重点】距离度量,聚类算法评价指标,K均值算法,DBSCAN算法。

andrew ng的讲义中文

andrew ng的讲义中文

摘要:

1.介绍Andrew Ng 和他在机器学习领域的贡献

2.阐述深度学习的基本概念

3.介绍深度学习的发展历程

4.深度学习在计算机视觉、自然语言处理等领域的应用

5.讨论深度学习未来的发展趋势和挑战

正文:

Andrew Ng 是机器学习领域的知名专家,曾是斯坦福大学的人工智能实验室主任,后来创立了谷歌大脑项目,为推动深度学习的发展做出了巨大贡献。

在Andrew Ng 的讲义中,他首先介绍了深度学习的基本概念。

深度学习是一种基于神经网络的机器学习方法,它通过多层神经网络对数据进行学习,能够自动提取数据中的特征,从而实现复杂的模式识别和预测。

接下来,讲义回顾了深度学习的发展历程。

从最初的神经网络研究,到后来的深度学习复兴,Andrew Ng 详细介绍了这一领域的重要里程碑和关键技术。

他强调了反向传播算法、激活函数、优化方法等核心概念的重要性。

在讲义的后半部分,Andrew Ng 重点介绍了深度学习在计算机视觉、自然语言处理等领域的应用。

他以图像识别、语音识别、机器翻译等具体任务为例,生动地展示了深度学习如何解决实际问题,并取得了显著的成果。

最后,Andrew Ng 讨论了深度学习未来的发展趋势和挑战。

他认为,虽

然深度学习在许多领域取得了成功,但仍然存在一些问题,如模型的可解释性、数据依赖性等。

他呼吁研究人员继续探索新的方法,以解决这些问题,进一步推动深度学习的发展。

斯坦福大学公开课:机器学习课程note1翻译

斯坦福大学公开课:机器学习课程note1翻译第一篇:斯坦福大学公开课:机器学习课程note1翻译CS229 Lecture notesAndrew Ng 监督式学习让我们开始先讨论几个关于监督式学习的问题。

假设我们有一组数据集是波特兰,俄勒冈州的47所房子的面积以及对应的价格我们可以在坐标图中画出这些数据:给出这些数据,怎么样我们才能用一个关于房子面积的函数预测出其他波特兰的房子的价格。

为了将来使用的方便,我们使用x表示“输入变量”(在这个例子中就是房子的面积),也叫做“输入特征”,y表示“输出变量”也叫做“目标变量”就是我们要预测的那个变量(这个例子中就是价格)。

一对(x,y)叫做一组训练样本,并且我们用来学习的---一列训练样本{(x,y);i=1,…,m}--叫做一个训练集。

注意:这个上标“(i)”在这个符号iiiiii表示法中就是训练集中的索引项,并不是表示次幂的概念。

我们会使用χ表示输入变量的定义域,使用表示输出变量的值域。

在这个例子中χ=Y=R为了更正式的描述我们这个预测问题,我们的目标是给出一个训练集,去学习产生一个函数h:X→ Y 因此h(x)是一个好的预测对于近似的y。

由于历史性的原因,这个函数h被叫做“假设”。

预测过程的顺序图示如下:当我们预测的目标变量是连续的,就像在我们例子中的房子的价格,我们叫这一类的学习问题为“回归问题”,当我们预测的目标变量仅仅只能取到一部分的离散的值(就像如果给出一个居住面积,让你去预测这个是房子还是公寓,等等),我们叫这一类的问题是“分类问题”PART I Linear Reression 为了使我们的房子问题更加有趣,我们假设我们知道每个房子中有几间卧室:在这里,x是一个二维的向量属于R。

例如,x1i就是训练集中第i个房子的居住面积,i是训练集中第i个房子的卧室数量。

(通常情况下,当设计一个学习问题的时候,这些输x22入变量是由你决定去选择哪些,因此如果你是在Portland收集房子的数据,你可能会决定包含其他的特征,比如房子是否带有壁炉,这个洗澡间的数量等等。

《机器学习》课程教学大纲

《机器学习》课程教学大纲一、课程基本信息课程代码:21133600课程中文名称:机器学习课程英文名称:Machine Learning讲课学时/学分:32/2课内实验学时/学分: 8课外实验/科研实践学时:8课外研讨学时:课外素质拓展学时:课程类别:专业选修课课程性质:选修授课语种:中文适用专业:软件工程开设学期:第五学期先修课程:无责任单位:二、课程地位与作用《机器学习》课程是软件工程专业的专业选修课。

2017年7月8日国务院发布关于印发新一代人工智能发展规划的通知,宣布我国人工智能技术的战略目标:2025年人工智能基础理论实现重大突破,2030年人工智能理论、技术与应用总体达到世界领先水平。

2018年4月2日教育部发布关于印发《高等学校人工智能创新行动计划》的通知,指出加快机器学习等核心关键技术研究,形成新一代人工智能技术体系。

机器学习作为人工智能技术的基础,是一门多学科融合的技术,通过机器学习,使计算机系统具有从数据中“学习”经验的能力以便实现人工智能。

通过本课程的学习,学生将理解机器学习的原理,掌握常见机器学习方法中主要算法、较新的深度学习网络,通过实验提高机器学习算法编程和应用的能力,能够跟踪机器学习发展前沿,为学生将来从事人工智能相关工作或研究打下基础。

三、课程内容简介本课程涵盖了机器学习的大部分内容,从机器学习原理到实际应用,从传统机器学习方法到深度学习等该领域近年来较新的研究。

具体包括:机器学习基础、数据预处理、分类算法、决策树、支持向量机、回归分析、聚类分析、神经网络训练与深度学习、卷积神经网络、循环神经网络、图神经网络、生成对抗网络等内容。

四、课程目标及对毕业要求的支撑通过本课程的学习,应达到的目标及能力如下:目标1:掌握机器学习相关的专业术语,了解机器学习的发展动态,能够查阅该领域的中英文文献。

目标2:了解监督/无监督学习方法,了解回归任务和分类任务,了解人工神经网络的原理和基本结构。

吴恩达 《机器学习秘籍》(MLY-zh-cn)

机器学习训练秘籍属于 deeplearning.ai 项目.=======中文PDF相关信息=======项目地址: 点击此处文件版本: 0.5.0 draft最后更新: 2018/10/31译者水平有限,如有翻译不当之处,恳请读者指正,联系邮箱:acdoge.cao@=========================© 2018 Andrew Ng. All Rights Reserved.目录1 机器学习为什么需要策略?2 如何使用此书来帮助你的团队3 先修知识与符号说明4 规模驱动机器学习发展5 开发集和测试集的定义6 开发集和测试集应该服从同一分布7 开发集和测试集应该有多大??8 使用单值评估指标进行优化9 优化指标和满意度指标10 通过开发集和度量指标加速迭代11 何时修改开发集、测试集和指标12 小结:建立开发集和测试集13 快速构建并迭代你的第一个系统14 误差分析:根据开发集样本评估想法15 在误差分析时并行评估多个想法16 清洗误标注的开发集和测试集样本17 将大型开发集拆分为两个子集,专注其一18 Eyeball 和 Blackbox 开发集该设置多大?19 小结:基础误差分析20 偏差和方差:误差的两大来源21 偏差和方差举例22 与最优错误率比较23 处理偏差和方差24 偏差和方差间的权衡25 减少可避免偏差的技术26 训练集误差分析27 减少方差的技术28 诊断偏差与方差:学习曲线29 绘制训练误差曲线30 解读学习曲线:高偏差31 解读学习曲线:其它情况32 绘制学习曲线33 为何与人类表现水平进行对比34 如何定义人类表现水平35 超越人类表现水平36 何时在不同的分布上训练与测试37 如何决定是否使用你所有的数据38 如何决定是否添加不一致的数据39 给数据添加权重40 从训练集泛化到开发集41 辨别偏差、方差和数据不匹配误差42 解决数据不匹配问题43 人工合成数据44 优化验证测试45 优化验证测试的一般形式46 强化学习举例47 端到端学习的兴起48 端到端学习的更多例子49 端到端学习的优缺点50 流水线组件的选择:数据可用性51 流水线组件的选择:任务简单性52 直接学习更为丰富的输出53 根据组件进行误差分析54 误差归因至某个组件55 误差归因的一般情况56 组件误差分析与人类水平对比57 发现有缺陷的机器学习流水线58 建立超级英雄团队 - 让你的队友阅读这本书吧!1 机器学习为什么需要策略?机器学习(machine learning)已然成为无数重要应用的基石——如今,在网络搜索、垃圾邮件检测、语音识别以及产品推荐等领域,你都能够发现它的身影。

Andrew Ng机器学习课程目录(带翻译)

I. Introduction (Week 1)一、引言(第1周)•Welcome (7 min)•欢迎(7分钟)•What is Machine Learning? (7 min)•机器学习是什么?(7分钟)•Supervised Learning (12 min)•监督学习(12分钟)•Unsupervised Learning (14 min)•无监督学习(14分钟)II. Linear Regression with One Variable (Week 1)二、一元线性回归(第1周)•Model Representation (8 min)•模型表示(8分钟)•Cost Function (8 min)•成本函数(8分钟)•Cost Function - Intuition I (11 min)•成本函数的直观理解I(11分钟)•Cost Function - Intuition II (9 min)•成本函数的直观理解II(9分钟)•Gradient Descent (11 min)•梯度下降(11分钟)•Gradient Descent Intuition (12 min)•梯度下降的直观理解(12分钟)•Gradient Descent For Linear Regression (10 min) •梯度下降的线性回归(10分钟)•What's Next (6 min)•接下来的内容(6分钟)III. Linear Algebra Review (Week 1, Optional)三、线性代数回顾(第1周,可选)•Matrices and Vectors (9 min)•矩阵和向量(9分钟)•Addition and Scalar Multiplication (7 min)•加法和标量乘法(7分钟)•Matrix Vector Multiplication (14 min)•矩阵向量乘法(14分钟)•Matrix MatrixMultiplication (11 min)•矩阵乘法(11分钟)•Matrix Multiplication Properties (9 min)•矩阵乘法的性质(9分钟)•Inverse and Transpose (11 min)•逆、转置(11分钟)IV. Linear Regression with Multiple Variables (Week 2)四、多变量线性回归(第2周)•Multiple Features (8 min)•多特征(8分钟)•Gradient Descent for Multiple Variables (5 min)•梯度下降的多变量(5分钟)•Gradient Descent in Practice I - Feature Scaling (9 min) •梯度下降法实践1-特征尺度(9分钟)•Gradient Descent in Practice II - Learning Rate (9 min)•梯度下降法实践2-学习速率(9分钟)•Features and Polynomial Regression (8 min)•特征和多项式回归(8分钟)•Normal Equation (16 min)•正规方程(16分钟)•Normal Equation Noninvertibility (Optional) (6 min)•正规方程不可逆性(可选)(6分钟)V. Octave Tutorial (Week 2)五、Octave教程(第2周)•Basic Operations (14 min)•基本操作(14分钟)•Moving Data Around (16 min)•移动数据(16分钟)•Computing on Data (13 min)•计算数据(13分钟)•Plotting Data (10 min)•绘图数据(10分钟)•Control Statements: for, while, if statements (13 min)•控制语句:for,while,if语句(13分钟)•Vectorization (14 min)•矢量化(14分钟)•Working on and Submitting Programming Exercises (4 min) •工作和提交的编程练习(4分钟)VI. Logistic Regression (Week 3)六、Logistic回归(第3周)•Classification (8 min)•分类(8分钟)•Hypothesis Representation (7 min)•假说表示(7分钟)•Decision Boundary (15 min)•决策边界(15分钟)•Cost Function (11 min)•成本函数(11分钟)•Simplified Cost Function and Gradient Descent (10 min) •简化的成本函数和梯度下降(10分钟)•Advanced Optimization (14 min)•Multiclass Classification: One-vs-all (6 min)•多类分类:一个对所有(6分钟)VII. Regularization (Week 3)七、正则化(第3周)•The Problem of Overfitting (10 min)•过拟合的问题(10分钟)•Cost Function (10 min)•成本函数(10分钟)•Regularized Linear Regression (11 min)•正则线性回归(11分钟)•Regularized Logistic Regression (9 min)•正则化的逻辑回归模型(9分钟)VIII. Neural Networks: Representation (Week 4)第八、神经网络:表述(第4周)•Non-linear Hypotheses (10 min)•非线性假设(10分钟)•Neurons and the Brain (8 min)•神经元和大脑(8分钟)•Model Representation I (12 min)•模型表示1(12分钟)•Model Representation II (12 min)•模型表示2(12分钟)•Examples and Intuitions I (7 min)•例子和直观理解1(7分钟)•Examples and Intuitions II (10 min)•例子和直观理解II(10分钟)•Multiclass Classification (4 min)•多类分类(4分钟)IX. Neural Networks: Learning (Week 5)九、神经网络的学习(第5周)•Cost Function (7 min)•成本函数(7分钟)•Backpropagation Algorithm (12 min)•反向传播算法(12分钟)•Backpropagation Intuition (13 min)•反向传播算法直观理解(13分钟)•Implementation Note: Unrolling Parameters (8 min) •实现注意:展开参数(8分钟)•Gradient Checking (12 min)•梯度检测(12分钟)•Random Initialization (7 min)•随机初始化(7分钟)•Putting It Together (14 min)•Autonomous Driving (7 min)•自主驾驶(7分钟)X. Advice for Applying Machine Learning (Week 6)十、应用机器学习的建议(第6周)•Deciding What to Try Next (6 min)•决定下一步做什么(6分钟)•Evaluating a Hypothesis (8 min)•评估一个假设(8分钟)•Model Selection and Train/Validation/Test Sets (12 min)•模型的选择和培训/测试集(12分钟)•Diagnosing Bias vs. Variance (8 min)•诊断偏差和方差(8分钟)•Regularization and Bias/Variance (11 min)•正则化和偏差/方差(11分钟)•Learning Curves (12 min)•学习曲线(12分钟)•Deciding What to Do Next Revisited (7 min)•决定下一步做什么(7分钟)XI. Machine Learning System Design (Week 6)十一、机器学习系统的设计(第6周)•Prioritizing What to Work On (10 min)•优先要做什么(10分钟)•Error Analysis (13 min)•误差分析(13分钟)•Error Metrics for Skewed Classes (12 min)•误差度量的偏斜类别(12分钟)•Trading Off Precision and Recall (14 min)•交易精度和召回(14分钟)•Data For Machine Learning (11 min)•数据的机器学习(11分钟)XII. Support Vector Machines (Week 7)十二、支持向量机(第7周)•Optimization Objective (15 min)•优化目标(15分钟)•Large Margin Intuition (11 min)•大边界的直观理解(11分钟)•Mathematics Behind Large Margin Classification (Optional) (20 min) •数学背后的大边界分类(可选)(20分钟)•Kernels I (16 min)核函数1(16分钟)•Kernels II (16 min)•核函数2(16分钟)•Using An SVM (21 min)•使用支持向量机(21分钟)XIII. Clustering (Week 8)十三、聚类(第8周)•Unsupervised Learning: Introduction (3 min)•无监督的学习:简介(3分钟)•K-Means Algorithm (13 min)•k-均值算法(13分钟)•Optimization Objective (7 min)•优化目标(7分钟)•Random Initialization (8 min)•随机初始化(8分钟)•Choosing the Number of Clusters (8 min)•选择簇的数量(8分钟)XIV. Dimensionality Reduction (Week 8)十四、降维(8周)•Motivation I: Data Compression (10 min)•动机1:数据压缩(10分钟)•Motivation II: Visualization (6 min)•动机2:可视化(6分钟)•Principal Component Analysis Problem Formulation (9 min)•主成分分析问题(9分钟)•Principal Component Analysis Algorithm (15 min)•主成分分析算法(15分钟)•Choosing the Number of Principal Components (11 min)•从主成分选择数(11分钟)•Reconstruction from Compressed Representation (4 min)•重建的压缩表示(4分钟)•Advice for Applying PCA (13 min)•主成分分析法的应用建议(13分钟)XV. Anomaly Detection (Week 9)十五、异常检测(第9周)•Problem Motivation (8 min)•问题的动机(8分钟)•Gaussian Distribution (10 min)•高斯分布(10分钟)•Algorithm (12 min)•算法(12分钟)•Developing and Evaluating an Anomaly Detection System (13 min) •开发和评价一个异常检测系统(13分钟)•Anomaly Detection vs. Supervised Learning (8 min)•异常检测与监督学习(8分钟)•Choosing What Features to Use (12 min)•选择使用什么特征(12分钟)•Multivariate Gaussian Distribution (Optional) (14 min)•多元高斯分布(可选)(14分钟)•Anomaly Detection using the Multivariate Gaussian Distribution (Optional) (14 min) 使用多变量的高斯分布进行异常检测(可选)(14分钟)XVI. Recommender Systems (Week 9)十六、推荐系统(第9周)•Problem Formulation (8 min)•问题(8分钟)•Content Based Recommendations (15 min)•基于内容的推荐(15分钟)•Collaborative Filtering (10 min)•协同过滤(10分钟)•Collaborative Filtering Algorithm (9 min)•协同过滤算法(9分钟)•Vectorization: Low Rank Matrix Factorization (8 min)•矢量化:低秩矩阵分解(8分钟)•Implementational Detail: Mean Normalization (9 min)•推行工作上的细节:均值归一化(9分钟)XVII. Large Scale Machine Learning (Week 10)十七、大规模机器学习(第10周)•Learning With Large Datasets (6 min)大型数据集的学习•(6分钟)•Stochastic Gradient Descent (13 min)•随机梯度下降(13分钟)•Mini-Batch Gradient Descent (6 min)•迷你批处理梯度下降(6分钟)•Stochastic Gradient Descent Convergence (12 min)•随机梯度下降法收敛(12分钟)•Online Learning (13 min)•在线学习(13分钟)•Map Reduce and Data Parallelism (14 min)•减少图和数据并行(14分钟)XVIII. Application Example: Photo OCR十八、应用实例:照片的OCR•Problem Description and Pipeline (7 min)•问题描述和传播途径(7分钟)•Sliding Windows (15 min)•滑动窗口(15分钟)•Getting Lots of Data and Artificial Data (16 min)•获取数据和大量人造数据(16分钟)•Ceiling Analysis: What Part of the Pipeline to Work on Next (14 min)•上限分析:哪部分管道的接下去做(14分钟)XIX. Conclusion十九、结论•Summary and Thank You (5 min)•总结和致谢(5分钟)。

吴恩达机器学课程笔记

吴恩达机器学课程笔记吴恩达Andrew Ng是人工智能领域的著名学者,他在Coursera上开设了一门叫做《机器学习》的课程,成为了世界各地很多学生学习机器学习知识的入门必修课程,在学习机器学习方面有重要的作用。

下面我将给大家分享一些我在学习这门课程期间的笔记和体验。

笔记这门课程教授了很多机器学习的基础知识和应用,包括线性回归、逻辑回归、神经网络、支持向量机、聚类等等。

我把这些知识点都记录在笔记本里,以便以后温习。

其中,我学的比较深入的有神经网络部分。

在课程视频中,吴恩达讲解了神经网络的原理、编程细节,以及如何使用神经网络来解决实际问题。

学习过程中我还发现机器学习包括很多数学和统计学知识,例如线性代数和概率论等等。

所以我也把这些基础知识记录在笔记本里进行复习。

体验通过学习这门课程,我感觉到自己的编程能力和机器学习知识都得到了很大的提高。

因为这门课程全程使用的是Matlab语言,而Matlab一直以来被广泛应用于科学计算中,特别是在数学分析和科学实验中。

在这门课程的内容比较复杂和有难度的情况下,吴恩达讲师的授课很亲切、易懂、讲解深入浅出,让人在学习中感到很放松。

他讲解的案例都基于真实的数据集,通过实例让学生更好的了解机器学习中的各个概念和方法。

总的来说,这门课程对于初学者来说是非常友好、易于理解的。

同时,这门课程也有相应的练习和课程作业,帮助学生锻炼实际操作能力,这也是学习的一大收获。

嘀嘀咕咕通过学习这门课程,我也认识了很多同行的朋友,跟他们交流讨论,收获很多。

课程在线上,学生只需要一个稳定的网络连接,通过视频播放就可以完整地学习知识。

得益于这个课程的普及度,机器学习也正慢慢地被认为是一个非常有前途的领域,目前也已广泛应用于许多行业和领域。

因此,这门课程也可以说是一个被广泛评价和认可的课程,在人工智能领域具有很高的参考价值。

结语笔者学完《机器学习》课程后受益匪浅。

这不仅仅在于知识的学习,还包括人脉和职业发展的机会。

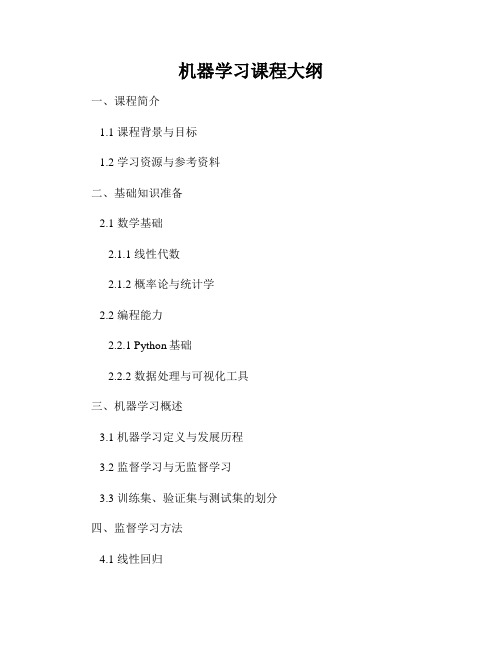

机器学习课程大纲

机器学习课程大纲一、课程简介1.1 课程背景与目标1.2 学习资源与参考资料二、基础知识准备2.1 数学基础2.1.1 线性代数2.1.2 概率论与统计学2.2 编程能力2.2.1 Python基础2.2.2 数据处理与可视化工具三、机器学习概述3.1 机器学习定义与发展历程3.2 监督学习与无监督学习3.3 训练集、验证集与测试集的划分四、监督学习方法4.1 线性回归4.1.1 最小二乘法4.1.2 正规方程解4.2 逻辑回归4.2.1 二分类与多分类4.2.2 损失函数与梯度下降4.3 决策树4.3.1 特征选择与节点划分4.3.2 剪枝与过拟合4.4 支持向量机4.4.1 线性可分与线性不可分情况4.4.2 软间隔与核函数五、无监督学习方法5.1 聚类分析5.1.1 K-means算法5.1.2 层次聚类算法5.2 主成分分析与降维5.2.1 特征值分解与奇异值分解5.2.2 主成分分析算法5.3 关联规则挖掘5.3.1 Apriori算法5.3.2 FP-growth算法六、深度学习基础6.1 神经网络简介6.2 反向传播算法6.3 常见激活函数与优化器七、深度学习模型7.1 卷积神经网络(CNN)7.1.1 卷积层、池化层与全连接层 7.1.2 图像分类与目标检测7.2 循环神经网络(RNN)7.2.1 LSTM与GRU7.2.2 应用于自然语言处理7.3 生成对抗网络(GAN)7.3.1 生成模型与判别模型7.3.2 图像生成与风格迁移八、模型评估与调优8.1 训练集与测试集的划分8.2 误差度量与评估指标8.3 过拟合与欠拟合8.4 超参数调优与模型选择九、应用案例与实战项目9.1 图像分类与目标检测案例9.2 自然语言处理案例9.3 推荐系统案例十、课程总结与展望10.1 机器学习的应用领域10.2 学习资源与继续深造的方向以上是《机器学习课程大纲》的详细内容,课程涵盖了机器学习的基础知识、监督学习和无监督学习方法、深度学习基础与模型等内容。

AndrewNg机器学习课程笔记--week3(逻辑回归正则化参数)

AndrewNg机器学习课程笔记--week3(逻辑回归正则化参数)Logistic Regression⼀、内容概要Classification and RepresentationClassificationHypothesis RepresentationDecision BoundaryLogistic Regression Model损失函数(cost function)简化损失函数和梯度下降算法Advanced Optimization(⾼级优化⽅法)Solving the problem of Overfitting什么是过拟合?正则化损失函数(cost function)正则化线性回归(Regularized Linear Regression)正则化逻辑回归(Regularized Logistic Regression)⼆、重点&难点1. Classification and Representation1) Hypothesis Representation这⾥需要使⽤到sigmoid函数--g(z):hθ(x)=g(θT x)z=θT xg(z)=11+e−z2) Decision Boundary决策边界:hθ(x)≥0.5→y=1hθ(x)<0.5→y=0等价于g(z)≥0.5→y=1g(z)<0.5→y=0等价于z≥0→y=1z<0→y=02. Logistic Regression Model1)逻辑回归的损失函数这⾥之所以再次提到损失函数,是因为线性回归中的损失函数会使得输出呈现起伏,造成许多局部最优值,也就是说线性回归中的cost function在运⽤到逻辑回归时,将可能不再是凸函数。

逻辑回归的cost function如下:Jθ=1m∑Cost(hθ(x(i),y(i)))Cost(hθ(x),y))=−log(hθ(x))if y=1Cost(hθ(x),y))=−log(1−hθ(x))if y=0结合图来理解:y=1由上图可知,y=1,hθ(x)是预测值,- 当其值为1时,表⽰预测正确,损失函数为0;- 当其值为0时,表⽰错的⼀塌糊涂,需要⼤⼤的惩罚,所以损失函数趋近于∞。

“机器学习”课程教学大纲(质量标准)

课程名称

对先修课应知应会具体要求

先修课程 概率论与数理统计 掌握概率统计的基本概念、基本方法和基本思想。

Python 程序设计 掌握 Python 基本语法和程序设计的思想

后续课程

课程目标

毕业要求 3456

课程目标 1. 熟悉机器学习在大数据中的应用领域。

0.1 0.1 0.1 0.1

及与毕业 2. 掌握机器学习的基本概念和常用方法。

133

内容要求

授课建议:4 课时,上机。

(实验部分) 任务三:集成学习实验(支撑课程目标 1、2、3、4)

知识要点:Boosting 学习;Bagging 算法。

学习目标:掌握 AdaBoost 算法原理,编程实现 AdaBoost 算法并能解决实际问题;掌握

bagging 算法过程,编程实现 bagging 算法并能解决实际问题。

任务四:支持向量机(支撑课程目标 1、2、3、4) 知识要点:间隔与支持向量;对偶问题;核函数。 学习目标:理解支持向量、间隔、最大间隔的含义,掌握支持向量机的基本型和使用方法;

了解拉格朗日乘子法求解“对偶问题”;了解核函数定义及定理;了解软间隔的原理与使用方 法。

授课建议:4 学时,讲授。 任务五:集成学习(支撑课程目标 1、2、3、4)

感和责任感。 授课建议:4 学时,讲授。

任务二:模型评估与选择(支撑课程目标 1、2、3、4) 知识要点:经验误差与过拟合;模型评估方法;性能度量。 学习目标:理解经验误差与泛化误差、过拟合与欠拟合的含义;掌握常用评估方法;理解

错误率与精度、查准率与查全率、P-R 曲线的含义。 思政内容:合理的度量指标才能学得合理的模型,每个人都有无限潜能,只有清晰人生方

132

机器学习课程表

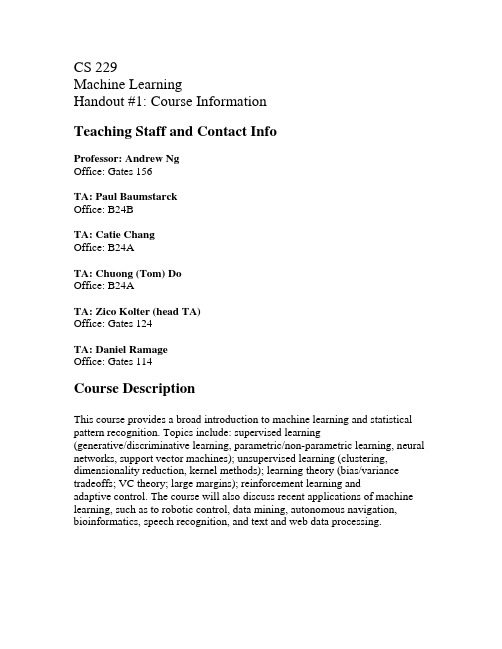

CS 229Machine LearningHandout #1: Course InformationTeaching Staff and Contact InfoProfessor: Andrew NgOffice: Gates 156TA: Paul BaumstarckOffice: B24BTA: Catie ChangOffice: B24ATA: Chuong (Tom) DoOffice: B24ATA: Zico Kolter (head TA)Office: Gates 124TA: Daniel RamageOffice: Gates 114Course DescriptionThis course provides a broad introduction to machine learning and statistical pattern recognition. Topics include: supervised learning(generative/discriminative learning, parametric/non-parametric learning, neural networks, support vector machines); unsupervised learning (clustering, dimensionality reduction, kernel methods); learning theory (bias/variance tradeoffs; VC theory; large margins); reinforcement learning andadaptive control. The course will also discuss recent applications of machine learning, such as to robotic control, data mining, autonomous navigation, bioinformatics, speech recognition, and text and web data processing.PrerequisitesStudents are expected to have the following background:Knowledge of basic computer science principles and skills, at a level sufficient to write a reasonably non-trivial computer program.Familiarity with the basic probability theory. (Stat 116 is sufficient but not necessary.)Familiarity with the basic linear algebra (any one of Math 51, Math 103, Math 113, or CS 205 would be much more than necessary.)Course MaterialsThere is no required text for this course. Notes will be posted periodically on the course web site. The following books are recommended as optional reading: Christopher Bishop, Pattern Recognition and Machine Learning. Springer, 2006. Richard Duda, Peter Hart and David Stork, Pattern Classification, 2nd ed. John Wiley & Sons, 2001.Tom Mitchell, Machine Learning. McGraw-Hill, 1997.Richard Sutton and Andrew Barto, Reinforcement Learning: An introduction. MIT Press, 1998Homeworks and GradingThere will be four written homeworks, one midterm, and one major open-ended term project. The homeworks will contain written questions and questions that require some Matlab programming. In the term project, you will investigate some interesting aspect of machine learning or apply machine learning to a problem that interests you. We try very hard to make questions unambiguous, but some ambiguities may remain. Ask if confused or state your assumptions explicitly. Reasonable assumptions will be accepted in case of ambiguous questions.A note on the honor code: We strongly encourage students to form study groups. Students may discuss and work on homework problems in groups. However, each student must write down the solutions independently, and without referring to written notes from the joint session. In other words, each student must understand the solution well enough in order to reconstruct it by him/herself. In addition, each student should write on the problem set theset of people with whom s/he collaborated. Further, because we occasionally reuse problem set questions from previous years, we expect students not to copy, refer to, or look at the solutions in preparing their answers. It isan honor code violation to intentionally refer to a previous year's solutions. Late homeworks: Recognizing that students may face unusual circumstances and requiresome flexibility in the course of the quarter, each student will have a total of seven free late (calendar) days to use as s/he sees fit. Once these late days are exhausted, any homework turned in late will be penalized 20% per late day. However, no homework will be accepted more than four days after its due date, and late days cannot be used for the final project writeup. Each 24 hours or part thereof that a homework is late uses up one full late day. To hand in a late homework, write down the date and time of submission, and leave it in the submission box at the bottom of the Gates A-wing stairwell.To get into the basement after the building is locked, slide your SUID card in the card reader by the main basement entrance.) It is an honor code violation to write down the wrong time. Regular (non-SCPD) students should submit hardcopies of all four written homeworks. Please do not email your homework solutions to us. Off-campus (SCPD) students should fax homework solutions to us at the fax number given above, and write "ATTN: CS229 (Machine Learning)" on the cover page. The term project may be done in teams of up to three persons. The midterm is openbook/ open-notes, and will cover the material of the first part of the course. It will take place on 11/8 at 6 pm, exact location to be determined.Course grades will be based 40% on homeworks (10% each), 20% on the midterm, and 40% on the major term project. Up to 3% extra credit may be awarded for class participation.SectionsTo review material from the prerequisites or to supplement the lecture material, there will occasionally be extra discussion sections held on Friday. An announcement will be made whenever one of these sections is held. Attendance at these sections is optional.Communication with the Teaching StaffWe strongly encourage students to come to office hours. If that is not possible, questions should be sent to the course staff list (consisting of the TAs andthe professor). By having questions sent to all of us, you will get answers much more quickly. Of course, more personal questions can still be sent directly to Professor Ng or the TAs.For grading questions, please talk to us after class or during office hours. If you want a regrade, write an explanation and drop the homework and the explanation into the submission box at the bottom of the Gates A-wing stairwell Answers to commonly asked questions and clarifications to the homeworks will be posted on the FAQ. It is each student's responsibility to check the FAQ on a regular basis. Major changes (e.g., bugs in the homework) will also be posted to the class mailing list.。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

I. Introduction (Week 1)一、引言(第1周)•Welcome (7 min)•欢迎(7分钟)•What is Machine Learning? (7 min)•机器学习是什么?(7分钟)•Supervised Learning (12 min)•监督学习(12分钟)•Unsupervised Learning (14 min)•无监督学习(14分钟)II. Linear Regression with One Variable (Week 1)二、一元线性回归(第1周)•Model Representation (8 min)•模型表示(8分钟)•Cost Function (8 min)•成本函数(8分钟)•Cost Function - Intuition I (11 min)•成本函数的直观理解I(11分钟)•Cost Function - Intuition II (9 min)•成本函数的直观理解II(9分钟)•Gradient Descent (11 min)•梯度下降(11分钟)•Gradient Descent Intuition (12 min)•梯度下降的直观理解(12分钟)•Gradient Descent For Linear Regression (10 min) •梯度下降的线性回归(10分钟)•What's Next (6 min)•接下来的内容(6分钟)III. Linear Algebra Review (Week 1, Optional)三、线性代数回顾(第1周,可选)•Matrices and Vectors (9 min)•矩阵和向量(9分钟)•Addition and Scalar Multiplication (7 min)•加法和标量乘法(7分钟)•Matrix Vector Multiplication (14 min)•矩阵向量乘法(14分钟)•Matrix MatrixMultiplication (11 min)•矩阵乘法(11分钟)•Matrix Multiplication Properties (9 min)•矩阵乘法的性质(9分钟)•Inverse and Transpose (11 min)•逆、转置(11分钟)IV. Linear Regression with Multiple Variables (Week 2)四、多变量线性回归(第2周)•Multiple Features (8 min)•多特征(8分钟)•Gradient Descent for Multiple Variables (5 min)•梯度下降的多变量(5分钟)•Gradient Descent in Practice I - Feature Scaling (9 min) •梯度下降法实践1-特征尺度(9分钟)•Gradient Descent in Practice II - Learning Rate (9 min)•梯度下降法实践2-学习速率(9分钟)•Features and Polynomial Regression (8 min)•特征和多项式回归(8分钟)•Normal Equation (16 min)•正规方程(16分钟)•Normal Equation Noninvertibility (Optional) (6 min)•正规方程不可逆性(可选)(6分钟)V. Octave Tutorial (Week 2)五、Octave教程(第2周)•Basic Operations (14 min)•基本操作(14分钟)•Moving Data Around (16 min)•移动数据(16分钟)•Computing on Data (13 min)•计算数据(13分钟)•Plotting Data (10 min)•绘图数据(10分钟)•Control Statements: for, while, if statements (13 min)•控制语句:for,while,if语句(13分钟)•Vectorization (14 min)•矢量化(14分钟)•Working on and Submitting Programming Exercises (4 min) •工作和提交的编程练习(4分钟)VI. Logistic Regression (Week 3)六、Logistic回归(第3周)•Classification (8 min)•分类(8分钟)•Hypothesis Representation (7 min)•假说表示(7分钟)•Decision Boundary (15 min)•决策边界(15分钟)•Cost Function (11 min)•成本函数(11分钟)•Simplified Cost Function and Gradient Descent (10 min) •简化的成本函数和梯度下降(10分钟)•Advanced Optimization (14 min)•Multiclass Classification: One-vs-all (6 min)•多类分类:一个对所有(6分钟)VII. Regularization (Week 3)七、正则化(第3周)•The Problem of Overfitting (10 min)•过拟合的问题(10分钟)•Cost Function (10 min)•成本函数(10分钟)•Regularized Linear Regression (11 min)•正则线性回归(11分钟)•Regularized Logistic Regression (9 min)•正则化的逻辑回归模型(9分钟)VIII. Neural Networks: Representation (Week 4)第八、神经网络:表述(第4周)•Non-linear Hypotheses (10 min)•非线性假设(10分钟)•Neurons and the Brain (8 min)•神经元和大脑(8分钟)•Model Representation I (12 min)•模型表示1(12分钟)•Model Representation II (12 min)•模型表示2(12分钟)•Examples and Intuitions I (7 min)•例子和直观理解1(7分钟)•Examples and Intuitions II (10 min)•例子和直观理解II(10分钟)•Multiclass Classification (4 min)•多类分类(4分钟)IX. Neural Networks: Learning (Week 5)九、神经网络的学习(第5周)•Cost Function (7 min)•成本函数(7分钟)•Backpropagation Algorithm (12 min)•反向传播算法(12分钟)•Backpropagation Intuition (13 min)•反向传播算法直观理解(13分钟)•Implementation Note: Unrolling Parameters (8 min) •实现注意:展开参数(8分钟)•Gradient Checking (12 min)•梯度检测(12分钟)•Random Initialization (7 min)•随机初始化(7分钟)•Putting It Together (14 min)•Autonomous Driving (7 min)•自主驾驶(7分钟)X. Advice for Applying Machine Learning (Week 6)十、应用机器学习的建议(第6周)•Deciding What to Try Next (6 min)•决定下一步做什么(6分钟)•Evaluating a Hypothesis (8 min)•评估一个假设(8分钟)•Model Selection and Train/Validation/Test Sets (12 min)•模型的选择和培训/测试集(12分钟)•Diagnosing Bias vs. Variance (8 min)•诊断偏差和方差(8分钟)•Regularization and Bias/Variance (11 min)•正则化和偏差/方差(11分钟)•Learning Curves (12 min)•学习曲线(12分钟)•Deciding What to Do Next Revisited (7 min)•决定下一步做什么(7分钟)XI. Machine Learning System Design (Week 6)十一、机器学习系统的设计(第6周)•Prioritizing What to Work On (10 min)•优先要做什么(10分钟)•Error Analysis (13 min)•误差分析(13分钟)•Error Metrics for Skewed Classes (12 min)•误差度量的偏斜类别(12分钟)•Trading Off Precision and Recall (14 min)•交易精度和召回(14分钟)•Data For Machine Learning (11 min)•数据的机器学习(11分钟)XII. Support Vector Machines (Week 7)十二、支持向量机(第7周)•Optimization Objective (15 min)•优化目标(15分钟)•Large Margin Intuition (11 min)•大边界的直观理解(11分钟)•Mathematics Behind Large Margin Classification (Optional) (20 min) •数学背后的大边界分类(可选)(20分钟)•Kernels I (16 min)核函数1(16分钟)•Kernels II (16 min)•核函数2(16分钟)•Using An SVM (21 min)•使用支持向量机(21分钟)XIII. Clustering (Week 8)十三、聚类(第8周)•Unsupervised Learning: Introduction (3 min)•无监督的学习:简介(3分钟)•K-Means Algorithm (13 min)•k-均值算法(13分钟)•Optimization Objective (7 min)•优化目标(7分钟)•Random Initialization (8 min)•随机初始化(8分钟)•Choosing the Number of Clusters (8 min)•选择簇的数量(8分钟)XIV. Dimensionality Reduction (Week 8)十四、降维(8周)•Motivation I: Data Compression (10 min)•动机1:数据压缩(10分钟)•Motivation II: Visualization (6 min)•动机2:可视化(6分钟)•Principal Component Analysis Problem Formulation (9 min)•主成分分析问题(9分钟)•Principal Component Analysis Algorithm (15 min)•主成分分析算法(15分钟)•Choosing the Number of Principal Components (11 min)•从主成分选择数(11分钟)•Reconstruction from Compressed Representation (4 min)•重建的压缩表示(4分钟)•Advice for Applying PCA (13 min)•主成分分析法的应用建议(13分钟)XV. Anomaly Detection (Week 9)十五、异常检测(第9周)•Problem Motivation (8 min)•问题的动机(8分钟)•Gaussian Distribution (10 min)•高斯分布(10分钟)•Algorithm (12 min)•算法(12分钟)•Developing and Evaluating an Anomaly Detection System (13 min) •开发和评价一个异常检测系统(13分钟)•Anomaly Detection vs. Supervised Learning (8 min)•异常检测与监督学习(8分钟)•Choosing What Features to Use (12 min)•选择使用什么特征(12分钟)•Multivariate Gaussian Distribution (Optional) (14 min)•多元高斯分布(可选)(14分钟)•Anomaly Detection using the Multivariate Gaussian Distribution (Optional) (14 min) 使用多变量的高斯分布进行异常检测(可选)(14分钟)XVI. Recommender Systems (Week 9)十六、推荐系统(第9周)•Problem Formulation (8 min)•问题(8分钟)•Content Based Recommendations (15 min)•基于内容的推荐(15分钟)•Collaborative Filtering (10 min)•协同过滤(10分钟)•Collaborative Filtering Algorithm (9 min)•协同过滤算法(9分钟)•Vectorization: Low Rank Matrix Factorization (8 min)•矢量化:低秩矩阵分解(8分钟)•Implementational Detail: Mean Normalization (9 min)•推行工作上的细节:均值归一化(9分钟)XVII. Large Scale Machine Learning (Week 10)十七、大规模机器学习(第10周)•Learning With Large Datasets (6 min)大型数据集的学习•(6分钟)•Stochastic Gradient Descent (13 min)•随机梯度下降(13分钟)•Mini-Batch Gradient Descent (6 min)•迷你批处理梯度下降(6分钟)•Stochastic Gradient Descent Convergence (12 min)•随机梯度下降法收敛(12分钟)•Online Learning (13 min)•在线学习(13分钟)•Map Reduce and Data Parallelism (14 min)•减少图和数据并行(14分钟)XVIII. Application Example: Photo OCR十八、应用实例:照片的OCR•Problem Description and Pipeline (7 min)•问题描述和传播途径(7分钟)•Sliding Windows (15 min)•滑动窗口(15分钟)•Getting Lots of Data and Artificial Data (16 min)•获取数据和大量人造数据(16分钟)•Ceiling Analysis: What Part of the Pipeline to Work on Next (14 min)•上限分析:哪部分管道的接下去做(14分钟)XIX. Conclusion十九、结论•Summary and Thank You (5 min)•总结和致谢(5分钟)。