负载均衡配置步骤

路由器的负载均衡配置

路由器的负载均衡配置在网络通信中,负载均衡是一种重要的技术手段,可以有效地提高网络性能和可靠性。

路由器作为网络中的关键设备,负载均衡配置对于实现网络流量的平衡分担至关重要。

本文将介绍路由器的负载均衡配置方法,以及相关注意事项。

一、负载均衡的概念和作用负载均衡是一种将网络流量分散到多个服务器或链路上的技术。

它通过有效地分配流量,使得每个服务器或链路都能得到较均衡的负载,从而提高网络的吞吐量和响应速度。

负载均衡可以避免单一服务器或链路的过载,提高系统的可靠性和可用性。

二、路由器的负载均衡配置方法1. 链路负载均衡链路负载均衡是指将网络流量根据规则分配到多个链路上。

一般来说,路由器可以通过以下两种方式实现链路负载均衡:(1)静态路由静态路由是指通过手动配置路由器的路由表来实现负载均衡。

管理员可以根据实际需求设置路由器的下一跳地址,将流量分发到多个链路上。

这种方式适用于网络结构稳定,流量分布相对固定的情况。

(2)动态路由动态路由是指路由器根据网络状态自动调整路由表,实现负载均衡。

常用的动态路由协议有OSPF、BGP等。

动态路由可以根据链路状态和流量情况,实时调整最佳的路由路径,从而实现负载均衡。

2. 服务器负载均衡除了链路负载均衡,路由器还可以实现对服务器的负载均衡。

在这种情况下,路由器将流量根据一定的规则分发给多个服务器,从而提高服务器的处理能力和可靠性。

常用的服务器负载均衡方法有以下几种:(1)基于源地址的负载均衡基于源地址的负载均衡是指根据发送请求的源IP地址进行负载均衡。

路由器可以通过源地址哈希算法将相同源地址的请求分发给同一台服务器,从而实现流量的均衡分担。

(2)基于目标地址的负载均衡基于目标地址的负载均衡是指根据请求的目标IP地址进行负载均衡。

路由器可以通过目标地址哈希算法将相同目标地址的请求分发给同一台服务器,从而实现流量的均衡分担。

(3)基于会话的负载均衡基于会话的负载均衡是指根据请求的会话信息进行负载均衡。

负载均衡配置方法

负载均衡配置方法在现代的计算机系统中,负载均衡是保证高性能和可靠性的重要因素之一。

通过合理的负载均衡配置,可以最大程度地利用系统资源,提高系统响应速度和可扩展性。

本文将介绍一些常见的负载均衡配置方法,帮助您更好地理解和应用负载均衡技术。

一、负载均衡概述负载均衡是一种通过在多个服务器之间分配工作负载,以达到提高系统性能和可用性的技术。

它可以确保每台服务器都能够平均分担任务,避免单个服务器过载,从而提高系统的整体性能。

二、硬件负载均衡配置方法硬件负载均衡通常通过专门的硬件设备来实现,如负载均衡器。

以下是一些常用的硬件负载均衡配置方法:1. 服务器冗余:在配置硬件负载均衡之前,建议先将系统中的服务器设置为冗余模式。

这意味着将每个功能模块配置为备份模式,以确保在故障发生时可以无缝切换到备份服务器。

2. 负载均衡器选择:根据实际需求选择适当的负载均衡器。

常见的负载均衡器有硬件负载均衡器和软件负载均衡器。

硬件负载均衡器通常具有更高的性能和可靠性,但价格较高。

软件负载均衡器则更加灵活和经济实惠。

3. 负载均衡算法选择:负载均衡器通常使用一些算法来决定如何将任务分配给服务器。

常见的算法有轮询、最小连接和最少响应时间等。

根据应用场景的特点选择合适的负载均衡算法,以确保任务能够平均分配给服务器,并提高整体性能。

4. 健康检查和故障恢复:负载均衡器通常会周期性地检查服务器的健康状态,以便及时发现故障和性能问题。

一旦发现故障,负载均衡器将自动将任务重新分配给其他正常工作的服务器,并通过故障恢复机制尽快恢复故障服务器的功能。

三、软件负载均衡配置方法除了硬件负载均衡器,还可以使用软件来实现负载均衡。

以下是一些常用的软件负载均衡配置方法:1. 反向代理:通过将负载均衡器配置为反向代理服务器,可以将客户端的请求分发给多个后端服务器。

反向代理服务器可以根据不同的策略选择请求目标服务器,并将响应返回给客户端。

2. DNS负载均衡:通过在DNS服务器中配置多个IP地址,可以将客户端的请求平均分配给这些IP地址,并最终分发到不同的服务器。

网络防火墙的负载均衡配置方法

网络防火墙的负载均衡配置方法随着互联网的迅猛发展,网络安全问题日益突出。

作为维护网络安全的重要工具之一,网络防火墙起到了至关重要的作用。

然而,仅靠一个防火墙可能无法满足大量数据流的处理需求,因此,负载均衡配置方法成为提高网络防火墙性能的重要手段。

负载均衡是指将网络流量分散到多个服务器上以达到均衡负载的目的。

在网络防火墙中,负载均衡可以实现对流量的分流和分担,提高防火墙的整体性能和可靠性。

一、硬件负载均衡配置方法硬件负载均衡是常见的一种方式,其基本原理是将网络流量通过路由器、交换机等硬件设备进行分流,使得防火墙能够平均地处理对应的数据。

1. 硬件设备选择:为了实现负载均衡,需要选购支持此功能的硬件设备。

常见的有路由器、交换机、负载均衡器等。

2. 网络架构设计:在网络设计过程中,需要考虑负载均衡的需求。

一般来说,建议采用多层次的网络架构,将不同的网络流量分流到不同的服务器上,同时避免单点故障。

3. 多服务器配置:在网络防火墙中,需要部署多个服务器来完成负载均衡的任务。

在配置过程中,需要为每个服务器分配一个唯一的IP地址,并确保网络流量能正常地路由到对应的服务器。

二、软件负载均衡配置方法除了硬件负载均衡之外,软件负载均衡也是一种常见的配置方法。

软件负载均衡是通过在防火墙上安装负载均衡软件来实现的。

1. 负载均衡软件选择:市面上有许多负载均衡软件可供选择。

常见的有Nginx、HAProxy等。

选择适合自己需求的负载均衡软件非常重要。

2. 安装配置软件:根据软件的使用说明,进行安装和配置。

通常需要设置负载均衡的算法、服务器的IP地址和端口等信息。

3. 监控和调优:在配置完负载均衡软件之后,需要进行监控和调优来确保系统的稳定性和高性能。

根据实际情况,可以通过调整负载均衡算法、增加服务器数量等方法来优化负载均衡效果。

三、虚拟化负载均衡配置方法虚拟化负载均衡是在虚拟化环境中实现负载均衡的一种方式。

在网络防火墙中,使用虚拟化技术可以将多个防火墙虚拟机实例部署在不同的物理服务器上,提高整体性能。

配置负载均衡器实现多层次的负载均衡路由(七)

配置负载均衡器实现多层次的负载均衡路由背景介绍:在现代互联网应用中,负载均衡是一项非常重要的技术,它可以帮助分布式系统实现高可用性和可伸缩性。

而配置负载均衡器则是实现负载均衡的一种常见方式。

本文将讨论如何配置负载均衡器实现多层次的负载均衡路由。

概念解释:负载均衡器是一种位于客户端和服务器之间的设备或软件,它可以将流量均匀地分发到多个服务器上,从而提高系统的性能和可靠性。

而负载均衡路由则是指在分发流量时,根据不同的策略将请求路由到不同的服务器上。

实现多层次负载均衡路由的步骤:1. 第一层负载均衡:配置全局负载均衡器在一个分布式系统中,通常会有多个数据中心或区域的服务器集群。

为了实现更高的可用性和容错能力,我们可以在不同的数据中心或区域之间设置一个全局负载均衡器。

全局负载均衡器监听所有请求,并决定将请求路由到哪个数据中心或区域的负载均衡器上。

2. 第二层负载均衡:配置区域负载均衡器在每个数据中心或区域内部,我们可以再次使用负载均衡器来分发请求到具体的服务器。

这些负载均衡器通常会根据服务器的性能负载、响应时间等指标进行动态调整,以确保流量分发的均衡。

3. 第三层负载均衡:配置服务器集群负载均衡器在每个服务器集群内部,我们可以使用服务器集群负载均衡器将请求分发到实际的服务器上。

这些负载均衡器会在服务器间进行负载均衡,并通过监控服务器的状态来实现故障转移。

4. 策略配置:根据需求选择路由策略在配置负载均衡器时,我们还需要根据实际需求选择合适的路由策略。

常见的路由策略有轮询、权重、源IP、最小连接数等。

根据业务需求,可以选择最适合的路由策略来优化负载均衡效果。

总结:通过配置负载均衡器实现多层次的负载均衡路由,可以提高系统的性能、可靠性和可扩展性。

具体的实施步骤包括配置全局负载均衡器、配置区域负载均衡器、配置服务器集群负载均衡器以及选择合适的路由策略。

在实际应用中,我们需要根据业务需求和系统规模来灵活配置负载均衡器,以达到最佳的负载均衡效果。

负载均衡器的部署与配置教程

负载均衡器的部署与配置教程一、引言在当今互联网时代,许多企业和网站面临着大量用户访问的压力。

为了提高系统的可靠性和性能,负载均衡器成为了不可或缺的一环。

本文将介绍负载均衡器的部署与配置教程,以帮助读者更好地理解和应用负载均衡技术。

二、什么是负载均衡器负载均衡器是一种用于平衡网络流量的设备或软件。

它将传入的用户请求分摊到多个服务器上,以保证各个服务器的负载均衡。

负载均衡器通过使用各种算法,如轮询、加权轮询、最小连接数等,将请求分发到可用服务器上,从而提高系统的可用性和性能。

三、负载均衡器的部署1. 设定负载均衡器的网络拓扑在部署负载均衡器之前,需要确定网络拓扑结构。

一般来说,负载均衡器位于前端,用户访问负载均衡器,然后负载均衡器再将请求分发给后端的多个服务器。

2. 选择适合的负载均衡器软件或设备根据业务需求和预算,可以选择自建负载均衡器软件或购买商用的负载均衡器设备。

常见的负载均衡器软件包括Nginx、HAProxy等;常见的负载均衡器设备包括F5、Citrix等。

3. 部署并配置负载均衡器根据所选择的负载均衡器软件或设备的文档,进行相应的部署和配置。

通常的步骤包括安装软件或设备、设置监听端口、配置后端服务器和负载均衡算法等。

四、负载均衡器的配置1. 设置监听端口负载均衡器监听指定的端口,将用户请求分发给后端服务器。

可以根据实际需要设置监听端口,如HTTP协议的80端口、HTTPS协议的443端口等。

2. 配置后端服务器将后端服务器添加到负载均衡器的服务器池中。

可以手动添加服务器的IP地址和端口,也可以通过域名解析自动发现服务器。

在配置后端服务器时,可以为每个服务器设置权重,以便更灵活地控制流量的分发。

3. 选择负载均衡算法负载均衡器根据负载均衡算法将请求分发到后端服务器。

常见的负载均衡算法有轮询、加权轮询、最小连接数等。

根据实际业务需求选择合适的负载均衡算法。

4. 设置健康检查负载均衡器通过健康检查来确定后端服务器的可用性。

f5负载均衡配置

F5负载均衡配置概述在分布式系统中,负载均衡是一种常见的技术,它可以将流量分发到多个服务器上,以实现更好的性能和可靠性。

F5负载均衡器是一种常用的硬件设备,它可以提供高可用、高性能的负载均衡服务。

本文将介绍如何配置F5负载均衡器以实现一个可靠的负载均衡环境。

确定需求在开始配置前,我们首先需要确定我们的需求。

这包括但不限于以下几个方面:1.服务类型:我们需要确定我们要分发的流量是什么类型的服务,例如Web服务、数据库服务等。

2.负载均衡策略:我们需要确定我们要使用的负载均衡策略,例如轮询、最小连接数等。

3.服务器配置:我们需要确定我们要使用的服务器的数量和配置。

在本文中,我们将以一个Web服务为例来进行讲解。

安装F5负载均衡器首先,我们需要安装F5负载均衡器。

这个过程可能因为具体的型号和版本而有所不同,具体的安装步骤可以参考F5负载均衡器的官方文档。

配置服务一旦安装完成,我们就可以开始配置服务了。

以下是一个基本的配置示例:1. 登录到F5负载均衡器的管理界面。

2. 在主菜单中,选择“虚拟服务”。

3. 点击“添加虚拟服务”按钮。

4. 配置虚拟服务的属性,包括名称、端口和协议等。

5. 配置服务器池,添加要分发流量的服务器。

可以手动添加,也可以使用自动发现功能。

6. 配置负载均衡算法,选择适合的负载均衡策略。

7. 完成配置,保存并应用更改。

配置监控为了保证负载均衡器的可靠性,我们需要配置监控。

这样,负载均衡器可以定期检查服务器的可用性,以及确保流量只被分发到健康的服务器上。

以下是一个基本的监控配置示例:1. 登录到F5负载均衡器的管理界面。

2. 在主菜单中,选择“监控”。

3. 创建一个新的监控类型,例如HTTP检查。

4. 配置监控属性,包括服务器的IP和端口,以及检查的间隔和超时时间等。

5. 保存并应用更改。

高级配置除了基本的配置外,F5负载均衡器还提供了一些高级配置选项,可以进一步优化负载均衡环境的性能和可靠性。

路由器的双WAN负载均衡设置指南

路由器的双WAN负载均衡设置指南随着互联网的快速发展和普及,网络对于人们生活和工作的重要性不言而喻。

而作为连接网络的核心设备之一,路由器起到了至关重要的作用。

越来越多的用户希望能够同时利用多个网络供应商提供的宽带,以实现更高的带宽和稳定性。

在这种需求下,双WAN负载均衡技术应运而生。

本文将为您介绍如何设置路由器的双WAN负载均衡,以优化网络使用体验。

一、双WAN负载均衡的原理双WAN负载均衡技术,顾名思义,即将两个或多个宽带连接绑定为一个逻辑连接,均衡地分担网络流量,从而提供更高的带宽和可用性。

当路由器接收到用户发送的数据请求时,它会根据一定的算法将请求分配到合适的宽带连接上,使得各个连接的负载均衡。

同时,当某个连接发生故障或中断时,路由器会智能地将流量切换到其他可用的连接上,以确保网络的连续性。

二、双WAN负载均衡的设置步骤要在路由器上实现双WAN负载均衡,您需要按照以下步骤进行设置:步骤一:连接宽带和配置路由器首先,将两个宽带供应商提供的宽带连接分别插入路由器的WAN 口1和WAN口2。

然后,通过电脑连接路由器的LAN口,并将其设置为静态IP地址。

接下来,打开浏览器,输入路由器的默认IP地址,进入路由器的管理界面。

根据路由器的品牌和型号,登录账号和密码可能会有所不同。

步骤二:启用双WAN负载均衡功能在路由器的管理界面中,找到“网络设置”或类似的选项。

在此页面上,您应该能够找到双WAN负载均衡的设置选项。

根据路由器的不同,该选项可能存在于“负载均衡”、“WAN设置”或其他类似的菜单中。

找到该选项后,将其启用,并保存设置。

步骤三:配置负载均衡算法和策略在启用双WAN负载均衡功能后,您需要选择适合您网络情况的负载均衡算法和策略。

常见的负载均衡算法包括轮询、加权轮询、最小连接和最小负载等。

根据您的需求和网络环境选择合适的算法。

此外,您还可以基于应用程序或服务来制定负载均衡策略,例如通过端口或IP地址来分配流量。

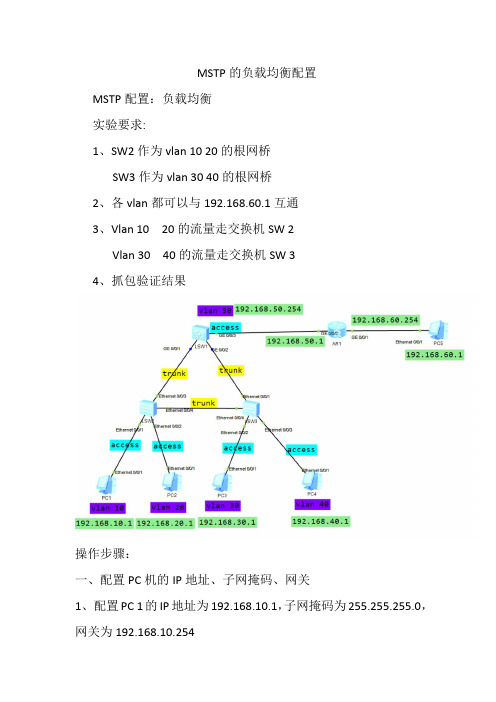

MSTP的负载均衡配置

MSTP的负载均衡配置MSTP配置:负载均衡实验要求:1、SW2作为vlan 10 20的根网桥SW3作为vlan 30 40的根网桥2、各vlan都可以与192.168.60.1互通3、Vlan 10 20的流量走交换机SW 2Vlan 30 40的流量走交换机SW 34、抓包验证结果操作步骤:一、配置PC机的IP地址、子网掩码、网关1、配置PC 1的IP地址为192.168.10.1,子网掩码为255.255.255.0,网关为192.168.10.2542、配置PC 2的IP地址为192.168.20.1,子网掩码为255.255.255.0,网关为192.168.20.2543、配置PC 3的IP地址为192.168.30.1,子网掩码为255.255.255.0,网关为192.168.30.2544、配置PC 4的IP地址为192.168.40.1,子网掩码为255.255.255.0,网关为192.168.40.2545、配置PC 5的IP地址为192.168.60.1,子网掩码为255.255.255.0,网关为192.168.60.254二、配置交换机LSW2、LSW31、配置交换机LSW22、配置交换机LSW3三、配置三层交换机LSW1四、配置路由器AR1五、抓包分析结果1、分别在接口g0/0/1和接口g0/0/2进行抓包2、用PC 1pingPC 5,查看接口g0/0/1和接口g0/0/2的抓包3、用PC 2pingPC 5,查看接口g0/0/1和接口g0/0/2的抓包4、用PC 3pingPC 5,查看接口g0/0/1和接口g0/0/2的抓包5、用PC 4pingPC 5,查看接口g0/0/1和接口g0/0/2的抓包如出现有PC 1、PC2 无法ping 通 PC 5和自身的网关,而且PC 1pingPC 2也不通第一步先查看配置是否出错如配置没有出错,则是如图所示的情况:。

如何设置路由器的双WAN口负载均衡

如何设置路由器的双WAN口负载均衡路由器的双WAN口负载均衡是一种在企业网络中常用的技术,它可以提高网络的可靠性和速度。

在本文中,我将为您详细介绍如何设置路由器的双WAN口负载均衡。

一、概述路由器的双WAN口负载均衡是指路由器通过同时使用两个广域网(Wide Area Network,WAN)接口来分摊网络负载,提高网络性能。

通过将数据流量平均分配到两个WAN口上,可以提高网络的可用性,减少单个WAN口的负载,从而提高网络的速度和稳定性。

二、硬件准备在设置路由器的双WAN口负载均衡之前,您需要确保以下硬件已经准备就绪:1. 一台支持双WAN口负载均衡功能的路由器;2. 两个宽带接入点(如ADSL、光纤等);3. 适配器和网线等连接设备。

三、设置双WAN口负载均衡以下是设置路由器的双WAN口负载均衡的详细步骤:1. 连接硬件:将两个宽带连接到路由器的两个WAN口上,确保连接正确并且稳定。

2. 访问路由器管理页面:打开您的浏览器,在地址栏中输入路由器的IP地址,按下回车键,进入路由器的管理页面。

3. 登录路由器:输入管理员用户名和密码,进行登录。

如果您没有设置过用户名和密码,可以使用默认的登录凭据。

4. 导航到负载均衡设置:在管理页面中,找到负载均衡或宽带配置等设置选项。

不同的路由器品牌可能有稍微不同的设置名称,但基本原理都是相同的。

5. 启用负载均衡:在负载均衡设置页面中,找到启用负载均衡选项,将其选择为开启状态。

此时,您可能需要选择双WAN口的工作模式,通常有主备模式和负载均衡模式可供选择。

在这里,选择负载均衡模式。

6. 配置负载均衡规则:根据您的具体需求和网络环境,配置适合的负载均衡规则。

一般来说,可以设置基于源IP、目标IP、端口等因素进行负载均衡。

您可以根据网络流量的特点和需求,灵活地配置负载均衡规则。

7. 保存设置并重启路由器:在配置完负载均衡规则后,点击保存或应用设置按钮,使设置生效。

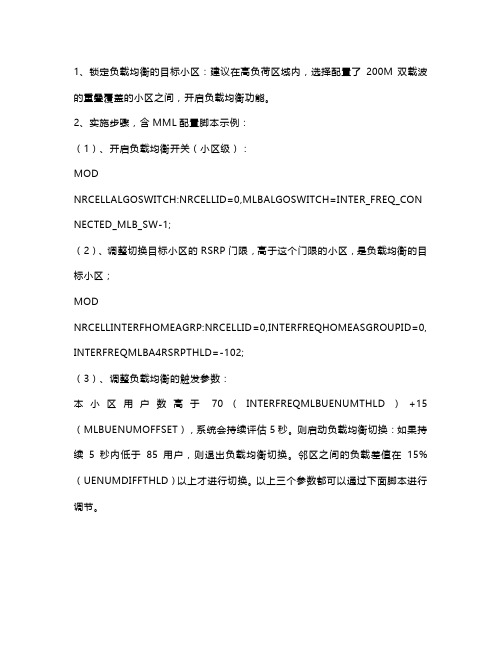

华为5G负载均衡的原理说明

1、锁定负载均衡的目标小区:建议在高负荷区域内,选择配置了200M双载波的重叠覆盖的小区之间,开启负载均衡功能。

2、实施步骤,含MML配置脚本示例:(1)、开启负载均衡开关(小区级):MODNRCELLALGOSWITCH:NRCELLID=0,MLBALGOSWITCH=INTER_FREQ_CON NECTED_MLB_SW-1;(2)、调整切换目标小区的RSRP门限,高于这个门限的小区,是负载均衡的目标小区;MODNRCELLINTERFHOMEAGRP:NRCELLID=0,INTERFREQHOMEASGROUPID=0, INTERFREQMLBA4RSRPTHLD=-102;(3)、调整负载均衡的触发参数:本小区用户数高于70(INTERFREQMLBUENUMTHLD)+15(MLBUENUMOFFSET),系统会持续评估5秒。

则启动负载均衡切换:如果持续5秒内低于85用户,则退出负载均衡切换。

邻区之间的负载差值在15%(UENUMDIFFTHLD)以上才进行切换。

以上三个参数都可以通过下面脚本进行调节。

MODNRCELLMLB:NRCELLID=0,INTERFREQMLBUENUMTHLD=70,MLBUENUMO FFSET=15,UENUMDIFFTHLD=15;3、切换出的候选邻区配置需求,候选邻区用户进行负载交互:•与当前小区配置了邻区关系,且允许切换•与当前小区同基站•与当前小区异频•小区状态为可用•候选邻区也需要开启INTER_FREQ_CONNECTED_MLB_SW开关4、负载交互,确定可以切换的目标小区,满足一下条件允许切换:•当前小区与候选邻区之间的负载差> NRCellMLB.UENUMDIFFTHLD (15%)•候选邻区的连接态UE比例< 90%(即:小区当前的连接态UE数/小区最大支持的连接态UE数)5、UE的选择,UE必须满足以下条件:•UE处于连接态•UE是非VoNR语音用户•UE是非NSA用户•UE是非CA用户•UE支持负载均衡。

如何设置路由器的网络负载均衡

如何设置路由器的网络负载均衡在现代的网络环境中,网络负载均衡是一种重要的技术手段,可以实现对网络流量的均衡分配,提高网络的性能和稳定性。

路由器作为网络连接的核心设备,具备负载均衡功能,对于企业和家庭用户来说,如何设置路由器的网络负载均衡是一个关键问题。

本文将介绍如何设置路由器的网络负载均衡,以实现更好的网络性能。

一、了解网络负载均衡的基本概念与原理网络负载均衡是指将网络流量分散到多个服务器或设备上,以达到负载分担、提高系统性能和可用性的技术。

在路由器上实现网络负载均衡,通常采用多种策略,如基于流量、基于连接数、基于服务器负载等。

了解网络负载均衡的基本概念与原理,有助于合理配置路由器,满足实际需求。

二、选购适合负载均衡的路由器设备在设置路由器的网络负载均衡之前,需要先选购适合负载均衡的路由器设备。

一般而言,中高端路由器具备负载均衡的功能,可根据实际需求选购合适的设备。

在选购时,需要考虑网络规模、带宽要求、连接数等因素,并选择具备强大处理能力和稳定性的设备。

三、登录路由器管理界面设置路由器的网络负载均衡需要登录路由器的管理界面。

通常,打开浏览器,在地址栏输入默认的IP地址(一般为192.168.1.1或192.168.0.1),按下回车键即可打开路由器管理界面。

根据路由器的型号,可能需要输入用户名和密码进行登录验证。

四、进入网络负载均衡设置页面在路由器的管理界面中,找到相应的设置项,进入网络负载均衡设置页面。

不同品牌、型号的路由器可能设置路径稍有差异,但通常在“高级设置”、“负载均衡”或“流量控制”等菜单下可以找到。

五、配置网络负载均衡策略在网络负载均衡设置页面中,根据实际需求配置网络负载均衡策略。

常见的网络负载均衡策略有以下几种:1. 基于流量的负载均衡:根据流量大小将网络流量分配到不同的出口线路,实现负载均衡。

可以设置不同出口线路的权重,调整流量分配比例。

2. 基于连接数的负载均衡:根据连接数将网络流量分配到不同的服务器或设备,均衡负载。

配置网络负载均衡优化网络性能

配置网络负载均衡优化网络性能随着网络应用的不断发展,网络流量的规模和复杂性也在不断增加。

为了满足用户的需求,提升网络的稳定性和可靠性,网络负载均衡成为了一个重要的技术手段。

配置网络负载均衡可以优化网络性能,提高用户体验。

本文将介绍网络负载均衡的原理和常用的配置方法,以及如何进行优化。

一、网络负载均衡的原理网络负载均衡是一种将网络流量分配到多个服务器上的方法,从而达到提高性能和可靠性的目的。

其原理基于以下几个方面:1. 分流:将用户的请求流量分散到多个服务器上,避免单一服务器过载,提高系统的吞吐量。

2. 调度算法:通过选择合适的调度算法,将请求流量合理地分配到各个服务器上,以达到负载均衡的效果。

3. 健康检查:定期检测服务器的状态,如果出现故障或超载情况,将其剔除或降低权重,保证用户的请求能够被正确地处理。

4. 高可用性:通过使用冗余服务器和备用链路,确保故障时能够及时切换到备用服务器,提高系统的可用性。

二、常用的网络负载均衡配置方法根据负载均衡的实现方式,常见的网络负载均衡配置方法包括硬件负载均衡和软件负载均衡。

1. 硬件负载均衡:硬件负载均衡器是一种专门用于负载均衡的设备,可以实现高性能的负载均衡功能。

其配置一般包括以下几个步骤:a. 配置VIP(虚拟IP地址):将多台服务器绑定到一个虚拟IP地址上,使得用户的请求可以通过这个VIP访问到后端的多台服务器。

b. 配置服务器池:将实际的服务器添加到服务器池中,配置健康检查和调度算法等参数。

c. 配置服务端口:指定负载均衡器监听的端口和协议类型。

d. 调优配置:根据实际需求,调整负载均衡器的性能参数,如连接数、超时时间等。

2. 软件负载均衡:软件负载均衡是通过在服务器上安装负载均衡软件来实现的,常见的软件负载均衡器有Nginx、HAProxy等。

其配置一般包括以下几个步骤:a. 安装负载均衡软件:根据实际需求选择适合的软件,并进行安装和配置。

b. 配置后端服务器:将实际的服务器添加到负载均衡软件中,并配置运行参数。

5G网络中的负载均衡策略

在5G网络中,负载均衡策略是确保系统性能和可扩展性的重要组成部分。

负载均衡是一种技术,它根据需求和资源可用性将流量分配给网络中的多个服务器或组件,以确保所有资源都得到充分利用,同时减少单个服务器的压力。

在5G网络中,负载均衡策略的实施通常包括以下几个步骤:1. 确定负载均衡算法:选择合适的负载均衡算法是实施负载均衡策略的关键。

常见的算法包括轮询、最少连接数、加权轮询等。

这些算法根据服务器的性能、可用性、处理能力等因素进行权衡,以确定哪个服务器应该接收流量。

2. 配置服务器:根据所选的负载均衡算法,配置服务器以接收流量。

这可能涉及设置服务器IP地址、端口号、权重等参数。

通过这些配置,服务器被赋予不同的权重,以反映其性能和可用性。

3. 监测和调整:实施负载均衡策略后,需要定期监测网络性能和服务器状态,以确保所有资源都在最佳状态下运行。

如果出现性能瓶颈或服务器故障,需要立即调整负载均衡策略,重新分配流量,以避免系统崩溃。

除了上述步骤,以下是一些具体的负载均衡策略在5G网络中的应用:* 多区域负载均衡:在5G网络中,由于设备分布广泛,实施多区域负载均衡可以确保流量在各个区域之间均匀分配,从而提高网络的整体性能。

* 动态调整策略:随着网络环境和需求的变化,负载均衡策略也需要动态调整。

例如,当某个区域的服务器出现故障时,可以自动将流量转移到其他健康的服务器上。

* 流量整形:通过流量整形技术,可以确保高流量的峰值不会对系统造成过大的压力。

在流量较低的时段,可以减少服务器的负载,从而延长服务器的使用寿命。

* 容错设计:通过负载均衡策略实现容错设计,可以确保系统在单个服务器故障时仍能正常运行。

这可以通过将流量分散到其他健康的服务器来实现。

总的来说,5G网络的负载均衡策略旨在确保系统的高效性和可扩展性,通过合理配置服务器、监测和调整网络性能、动态调整策略以及实现容错设计等手段,确保所有资源得到充分利用,同时减少系统崩溃的风险。

如何设置双WAN负载均衡

如何设置双WAN负载均衡在网络连接中,负载均衡是一种常见的技术,可以通过同时使用多个宽带连接来提高整体的网络性能和可靠性。

而双WAN负载均衡是其中一种常见的架构,本文将介绍如何设置双WAN负载均衡的步骤和注意事项。

一、双WAN负载均衡的基本原理双WAN负载均衡是一种通过同时使用两个或以上的广域网接口来实现网络负载分担和容错的技术,其中WAN代表广域网。

在该架构中,两个广域网接口通过一定的算法和配置来均衡地分担网络数据的传输负载,同时提高网络的可靠性和稳定性。

二、双WAN负载均衡的设置步骤1.选择合适的硬件设备:在部署双WAN负载均衡之前,首先需要选择合适的硬件设备,通常是一台能够支持多个广域网接口并具备负载均衡功能的路由器。

可以根据实际情况选择不同厂商和型号的设备。

2.连接广域网接口:将两个或以上的广域网接口连接到路由器的WAN口,确保连接正常并获得了IP地址。

3.配置网络接口:在路由器的控制台中,进入网络接口的配置页面,配置每个广域网接口的IP地址、子网掩码、网关和DNS信息。

确保每个接口的配置正确,并能够正常通信。

4.配置负载均衡算法:在路由器的控制台中,进入负载均衡的配置页面,选择合适的负载均衡算法。

常见的算法包括基于连接数、基于带宽、基于响应时间等。

根据实际情况选择合适的算法,并进行相应的配置。

5.配置策略路由:在路由器的控制台中,进入策略路由的配置页面,配置双WAN负载均衡的策略。

策略路由可以根据源IP地址、目标IP地址、源端口、目标端口等条件来指定数据包的路由方式。

根据实际需求配置相应的策略,确保网络流量能够按照设定的负载均衡算法进行分担。

6.测试和优化:配置完成后,进行网络连接测试,确保双WAN负载均衡正常工作。

如果发现问题或者性能不理想,可以根据实际情况进行调整和优化。

三、双WAN负载均衡的注意事项1.带宽要求:在选择双WAN负载均衡的方案时,需要确保两个或以上的广域网接口的带宽能够满足实际需求。

负载均衡器的部署与配置教程(一)

负载均衡器的部署与配置教程引言随着互联网的快速发展,越来越多的企业和组织需要部署自己的网站或应用程序。

然而,单个服务器的性能和可用性常常无法满足高负载的需求。

为了解决这个问题,负载均衡器成为了一个不可或缺的工具。

本文将详细介绍负载均衡器的部署与配置。

一、负载均衡器的概念与原理负载均衡器是一种常见的网络设备,通过在多个服务器之间分配传入的网络流量,从而实现请求的平衡分发。

它可以提高网站或应用程序的性能、可用性以及灵活性,同时降低服务器的负荷。

负载均衡器的工作原理主要包括两个方面:1.请求转发:当用户发送请求时,负载均衡器会将请求转发给后端的多个服务器之一。

这种转发方式可以基于多种策略,如轮询、权重、最小连接数等。

2.健康检查:负载均衡器会对后端服务器进行健康状态检查,以确保只有正常运行的服务器才会接收到请求。

当有服务器发生故障或不可用时,负载均衡器会自动将请求转发给其他正常的服务器。

二、负载均衡器的部署方案1.硬件负载均衡器硬件负载均衡器通常是一种专门的网络设备,具有高性能和稳定性。

常见的硬件负载均衡器厂商有F5、Cisco等。

部署硬件负载均衡器需要购买相应的设备,并进行配置和管理。

这种方式适用于大型企业和具有高要求的应用场景。

2.软件负载均衡器软件负载均衡器是一种基于软件的解决方案,可以在普通的服务器上部署。

常见的软件负载均衡器有Nginx、HAProxy等。

这种方式相对于硬件负载均衡器更加灵活和便宜,适用于小型企业和中小型应用场景。

三、负载均衡器的配置步骤以下是一个简单的软件负载均衡器Nginx的配置步骤示例:1.安装Nginx软件:在服务器上安装Nginx软件,并进行基本的配置。

2.配置后端服务器:编辑Nginx的配置文件,添加后端服务器的信息。

这些信息包括服务器的IP地址和端口号。

3.配置负载均衡策略:选择适合的负载均衡策略,如轮询、权重、最小连接数等。

根据具体需求进行配置。

4.配置健康检查:添加健康检查的配置,以确保只有正常的后端服务器接收到请求。

负载均衡操作步骤

负载均衡操作步骤负载均衡是一种通过将网络流量分散到多个服务器上来提高系统性能和可靠性的技术。

负载均衡操作步骤可能会因具体的实施方式而有所差异,下面是一个较为通用的负载均衡操作步骤的示例:1.确定负载均衡需求:首先需要明确负载均衡的目标和需求。

例如,是为了提高系统性能还是为了提高系统可靠性,需要分散哪些类型的流量等。

2.选择负载均衡算法:根据具体需求选择适合的负载均衡算法。

常见的负载均衡算法有轮询、最少连接数、源IP哈希等。

轮询算法简单公平,最少连接数算法能优先分配给连接数最少的服务器,源IP哈希算法根据客户端IP地址进行哈希运算来选择服务器。

3.设计负载均衡架构:根据需求和算法选择合适的负载均衡架构。

常见的负载均衡架构有局域网负载均衡、全局负载均衡和云负载均衡等。

局域网负载均衡适用于单一数据中心内部的流量分发,全局负载均衡适用于多个数据中心间的流量分发,云负载均衡适用于云环境中的流量分发。

4. 部署负载均衡硬件或软件:根据设计的负载均衡架构选择合适的负载均衡硬件设备或软件工具进行部署。

负载均衡硬件一般包括硬件负载均衡器设备和交换机,常见的软件工具有Nginx、HAProxy等。

5.配置负载均衡设备:根据具体的负载均衡硬件或软件的要求进行配置。

配置内容包括监听端口、转发策略、服务器健康检查、负载均衡算法等。

6.部署多台服务器:根据负载均衡的需求和算法,部署多台承担服务的服务器。

服务器的数量和配置应根据流量的大小和需求的变化进行调整。

7.验证负载均衡配置:通过测试和验证确保负载均衡配置的正确性和可行性。

可以使用工具模拟多个客户端请求,并观察负载均衡设备的工作状态和流量的分配情况。

8.监控和维护:设置监控系统对负载均衡设备和服务器进行实时监控,及时发现和解决问题。

定期进行系统维护和升级,确保负载均衡系统的稳定性和可靠性。

9.故障处理和容错:当出现故障时,需要根据具体情况采取相应的故障处理措施。

例如,当一个服务器故障时,负载均衡设备可以暂时将流量分发给其他正常工作的服务器。

路由器的多WAN口和负载均衡设置解析

路由器的多WAN口和负载均衡设置解析随着互联网的普及和发展,越来越多的设备和用户需要连接到互联网。

为了提高网络的可靠性和性能,路由器经常配备了多个WAN口,并且支持负载均衡设置。

本文将解析这些功能的概念、原理和设置方法。

一、多WAN口的概念和原理多WAN口是指路由器具备多个广域网接口的功能。

广域网口通常是指用于连接Internet或其他WAN网络的接口,例如ADSL、光纤、4G等。

通过多个WAN口,路由器可以同时连接不同的网络提供商或连接方式,提高网络的冗余性和带宽利用率。

多WAN口的工作原理是通过路由器的流量转发机制,将网络流量分配到不同的WAN口上。

路由器会根据预设的规则和算法,将流量均匀地分配到各个WAN口上,实现负载均衡。

当某个WAN口发生故障或带宽不足时,路由器会自动调整流量分配,确保网络的稳定性和可用性。

二、负载均衡的概念和原理负载均衡是指将网络流量均匀地分配到多个网络路径上,以实现流量的平衡和优化。

通过负载均衡的设置,可以提高网络的带宽利用率,避免某一个路径过载,同时提高网络的可靠性和性能。

负载均衡的原理是根据流量分配规则和算法,在多个路径上均匀地分配流量。

常见的负载均衡算法包括轮询、加权轮询、最少连接等。

通过这些算法,路由器可以根据设定的规则,将流量分配到多个WAN 口或路径上,实现负载均衡。

三、设置多WAN口和负载均衡的步骤设置多WAN口和负载均衡需要按照以下步骤进行:1. 确定路由器支持多WAN口和负载均衡功能。

一些商用路由器和高端家用路由器支持这些功能,但低端或入门级路由器可能不支持。

2. 连接不同的广域网接口到路由器的WAN口。

根据网络提供商提供的接入方式,例如插入ADSL或光纤模块,或连接4G网卡。

3. 进入路由器的管理界面,通常通过浏览器访问路由器的IP地址即可。

在管理界面中,找到多WAN口和负载均衡设置的选项。

4. 根据路由器的界面和设置选项,配置多WAN口和负载均衡的相关参数。

nacos负载均衡算法配置

Nacos 是一个开源的注册中心和配置中心,用于实现微服务架构中的服务注册、发现和配置管理。

Nacos 提供了一种简单的方式来配置负载均衡算法。

在Nacos 中,负载均衡算法可以通过配置实现。

以下是一个简单的步骤,演示如何在Nacos 中配置负载均衡算法:1. **在Nacos 控制台中创建配置集(Config):**- 登录Nacos 控制台,选择"配置管理",然后选择"配置列表"。

- 点击"新建配置",选择要配置的Data ID 和Group(可以理解为配置文件的唯一标识)。

2. **编写负载均衡算法配置:**- 在创建的配置集中,添加负载均衡算法的配置。

例如,可以添加一行类似于以下的配置:```propertiesloadBalance=your.custom.LoadBalanceClass```这里的`your.custom.LoadBalanceClass` 是你自定义的负载均衡算法类的全限定名。

3. **在应用中使用Nacos 配置:**- 在你的微服务应用中,使用Nacos 客户端获取配置。

这通常涉及到在应用中引入Nacos 客户端的相关依赖。

- 从Nacos 获取负载均衡算法配置,并在负载均衡器中使用它。

4. **示例代码(Java):**- 在Java 中,可以使用Nacos 提供的Java 客户端SDK 获取配置,然后在负载均衡器中设置相应的算法。

示例代码可能如下:```javaimport com.alibaba.nacos.api.config.ConfigService;import com.alibaba.nacos.api.config.listener.Listener;import com.alibaba.nacos.api.exception.NacosException;public class NacosConfigExample {public static void main(String[] args) throws NacosException {String serverAddr = "localhost:8848";String dataId = "your-data-id";String group = "your-group";ConfigService configService = new ConfigService(serverAddr);String content = configService.getConfig(dataId, group, 5000);System.out.println("Config content: " + content);// 在负载均衡器中使用content 中的配置// ...}}```请注意,上述示例代码中的`your-data-id` 和`your-group` 需要替换为你在Nacos 控制台中创建的配置集的实际Data ID 和Group。

阿里云负载均衡配置方案

阿里云负载均衡配置方案介绍---负载均衡是一种用于在多个服务器之间分配负载的技术。

阿里云提供了负载均衡服务,可以帮助用户提高应用的可扩展性和可用性。

本文档将介绍如何配置阿里云负载均衡以实现高效的负载均衡解决方案。

配置步骤---1. 创建负载均衡实例- 登录阿里云控制台- 导航到负载均衡的控制台页面- 点击"创建负载均衡实例"- 根据需求选择地域、网络类型等参数,并设置访问控制规则- 确认配置信息并创建负载均衡实例2. 配置监听规则- 在负载均衡控制台,点击已创建的负载均衡实例- 在实例详情页面,点击"监听"标签页- 点击"添加监听"按钮- 根据实际需求配置监听协议、监听端口和后端服务器协议- 确认配置信息并保存监听规则3. 添加后端服务器- 在负载均衡控制台,点击已创建的负载均衡实例- 在实例详情页面,点击"后端服务器"标签页- 点击"添加后端服务器"按钮- 输入后端服务器的IP地址和权重- 确认配置信息并添加后端服务器4. 配置健康检查- 在负载均衡控制台,点击已创建的负载均衡实例- 在实例详情页面,点击"后端服务器"标签页- 点击"健康检查"标签页- 配置健康检查的相关参数,如检查协议、检查端口和检查路径- 确认配置信息并保存健康检查设置5. 配置会话保持- 在负载均衡控制台,点击已创建的负载均衡实例- 在实例详情页面,点击"会话保持"标签页- 配置会话保持的相关参数,如超时时间和Cookie名称- 确认配置信息并保存会话保持设置6. 配置转发策略- 在负载均衡控制台,点击已创建的负载均衡实例- 在实例详情页面,点击"转发策略"标签页- 点击"添加转发策略"按钮- 根据需要配置转发策略,如根据请求路径、源IP、会话保持等进行转发- 确认配置信息并保存转发策略7. 测试负载均衡- 根据配置的监听规则和转发策略,通过访问负载均衡的公网地址进行测试- 检查负载均衡是否正常工作,并确保请求能够正确转发到后端服务器总结---通过以上的配置步骤,您可以成功创建和配置阿里云负载均衡实例,并实现高效的负载均衡解决方案。

vip keepalive负载均衡原理

vip keepalive负载均衡原理

VIP keepalive负载均衡是一种基于虚拟IP(VIP)和心跳检测的负载均衡方案。

它的工作原理主要包括以下几个步骤:

1. 配置VIP:在负载均衡设备上配置一个虚拟IP地址(VIP),该VIP将作为客户端访问的入口。

2. 服务节点注册:将多个后端服务器节点注册到负载均衡设备上,每个节点都有自己的真实IP地址。

3. 心跳检测:负载均衡设备会周期性地向每个后端服务器发送心跳检测请求,用于检测服务器的可用性。

常用的心跳检测方式包括PING、TCP连接检测等。

4. 请求转发:当有客户端请求到达负载均衡设备时,设备会根据负载均衡算法选择一个可用的后端服务器,并将请求转发至该服务器的真实IP地址。

5. 响应返回:后端服务器处理完请求后,将响应返回给负载均衡设备,设备再将响应返回给客户端,完成整个请求-响应过程。

6. 节点失效处理:如果负载均衡设备检测到某个后端服务器不可用(例如心跳检测失败),则会将该节点从可用节点列表中移除,不再将请求转发给该服务器。

通过VIP keepalive负载均衡方案,可以实现高可用性和负载均衡。

当某个后端服务器出现故障或负载过高时,负载均衡设备会自动将请求转发给其他可用的服务器,提高系统的稳定性和可靠性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

<Membership className="org.apache.catalina.tribes.membership.McastService"

address="228.0.0.4"

worker.tomcat2.activation=disabled#tomcat2不接收请求,只作为session备份

以上两个配置可以实现主备或双机HA,也可以配合适当的session复制策略实现灵活的失效转移策略。

1.2mod_proxy方式

编辑httpd.conf,取消以下语句的注释

LoadModule proxy_module modules/mod_proxy.so

LoadModule proxy_http_module modules/mod_proxy_http.so

在最后添加如下:

#The ProxyRequests directive should usually be set off when using ProxyPass.

ProxyRequests Off

BalancerMember http://localhost:28080/webcluster loadfactor=1 route=tomcat3

</proxy>

以上为http协议转发,将http://localhost:18080/webcluster改为ajp://localhost:18009/webcluster即可实现ajp协议转发。

<Interceptor className="org.apache.catalina.tribes.group.interceptors.MessageDispatch15Interceptor"/>

</Channel>

<Valve className="org.apache.catalina.ha.tcp.ReplicationValve" filter=""/>

#指定分担请求的tomcat名称,此名称必须与tomcat配置的jvmRoute相同

worker.controller.balanced_workers=tomcat1,tomcat2

#session亲和,每次请求转发的路径都相同,保持session在一个tomcat上

worker.controller.sticky_session=1

<?xml version="1.0" encoding="UTF-8"?>

<Context distributable="true">

</Context>

如果tomcat中的所有应用都需要Session共享,也可以把conf/context.xml中的<Context>改为<Context distributable="true">,这样就不需对所有应用的web.xml再进行单独配置。

JkWorkersFile conf/workers.properties #分发处理配置文件

JkLogFile logs/mod_jk.log #日志文件

JkLogLevel error #日志级别

JkMount /jkstatus jkstatus #转发到mod_jk监控

JkMount /* controller #转发到负载均衡控制器

2Tomcat Session复制

编辑tomcat的server.xml,取消以下段注释

<Cluster className="org.apache.catalina.ha.tcp.SimpleTcpCluster"/>

即可实现

此为tomcat默认实现,完整配置如下

<Cluster className="org.apache.catalina.ha.tcp.SimpleTcpCluster"

#========tomcat1========

worker.tomcat1.port=18009 #ajp端口号,在tomcat下server.xml配置,默认8009

worker.tomcat1.host=localhost #tomcat的主机地址,如不为本机,请填写ip地址

worker.tomcat1.type=ajp13

<ClusterListener

className="org.apache.catalina.ha.session.ClusterSessionListener"/>

</Cluster>

注意:需要做session复制的应用其web.xml中必须添加<distributable/>标签,且session中的属性值必须都实现java.io.Serializable。

1.1mod_jk方式

在tomcat官网下载mod_jk的so文件(注意区分操作系统平台),复制到apache的modules目录下

修改apache的http.conf文件

在最后添加如下:

LoadModule jk_module modules/mod_jk-1.2.30-httpd-2.2.3.so #so文件名

编辑workers.properties文件,保存到conf目录

#workers.properties

worker.list=controller,jkstatus

#========controller,负载均衡控制器========

#worker类型为负载均衡控制器

worker.controller.type=lb

deployDir="/tmp/war-deploy/"

watchDir="/tmp/war-listen/"

watchEnabled="false"/>

<ClusterListener

className="org.apache.catalina.ha.session.JvmRouteSessionIDBinderListener"/>

例:

<?xml version="1.0" encoding="UTF-8"?>

<web-app xmlns:xsi="/2001/XMLSchema-instance" xmlns="/xml/ns/javaee" xmlns:web="/xml/ns/javaee/web-app_2_5.xsd" xsi:schemaLocation="/xml/ns/javaee /xml/ns/javaee/web-app_2_5.xsd" id="WebApp_ID" version="2.5">

<Transport className="org.apache.catalina.tribes.transport.nio.PooledParallelSender"/>

</Sender>

<Interceptor className="org.apache.catalina.tribes.group.interceptors.TcpFailureDetector"/>

worker.tomcat2.type=ajp13

worker.tomcat2.lbfactor=1 #server的加权比重,值越高,分得的请求越多

worker.jkstatus.type=status#mod_jk监控

另可以配置

worker.tomcat1.redirect=tomcat2#tomcat1失效后原分发给tomcat1的请求会转而分发给tomcat2

#代理路径,stickysession=JSESSIONID为session亲和

ProxyPass /webcluster balanceபைடு நூலகம்://webcluster/ stickysession=JSESSIONID

<Location /webcluster>

#使用反向代理

ProxyPassReverse /

port="45564"

frequency="500"

dropTime="3000"/>

<Receiver className="org.apache.catalina.tribes.transport.nio.NioReceiver"

address="192.168.1.7" #默认为auto,改为自己的ip地址,区分多网卡

程序中如果存在全局变量(ServletContext中),需要考虑多个Tomcat间变量同步的问题

3其它负载均衡

3.1Nginx

编辑nginx.conf,在http段中增加,weight为权重

upstream webcluster {

ip_hash;

server localhost:18080 weight=1;

<Valve className="org.apache.catalina.ha.session.JvmRouteBinderValve"/>