matlab实现Kmeans聚类算法

matlab中kmeans代码

一、前言在数据分析和机器学习领域,k-means算法是一种常用的聚类算法,它可以将数据集分成不同的簇,每个簇内的数据点彼此相似,而不同簇之间的数据点相似度较低。

在matlab中,可以利用其强大的数学计算功能来实现k-means聚类算法。

本文将介绍如何在matlab中编写k-means聚类算法的代码。

二、matlab中的k-means算法1. 初始化数据集需要准备好要进行聚类分析的数据集。

这些数据可以是一组二维或多维的点,代表不同的特征。

在matlab中,可以使用矩阵来表示这些数据集,每一行代表一个数据点,每一列代表一个特征。

2. 设置聚类数量在进行k-means聚类算法之前,需要先确定要分成的簇的数量。

这个数量可以根据业务需求或者领域知识来确定。

在matlab中,可以使用kmeans函数来执行聚类分析,该函数需要指定数据集和聚类数量。

3. 运行k-means算法一旦准备好了数据集和聚类数量,就可以调用matlab中的kmeans 函数来执行k-means算法。

该函数会根据数据集和聚类数量来计算出不同簇的中心点,并将每个数据点分配到最近的簇中。

4. 可视化聚类结果完成k-means算法之后,可以将聚类结果可视化出来,以便更直观地理解不同簇之间的分布情况。

在matlab中,可以使用plot函数来绘制数据点和聚类中心,以及不同簇的分布情况。

三、示例代码以下是一个简单的matlab代码示例,演示了如何使用kmeans函数来执行k-means聚类算法:```matlab读取数据data = load('data.txt');设置聚类数量k = 3;运行k-means算法[idx, centers] = kmeans(data, k);可视化聚类结果figure;gscatter(data(:,1), data(:,2), idx);hold on;plot(centers(:,1), centers(:,2), 'kx', 'MarkerSize', 15, 'LineWidth', 3); ```以上代码首先读取了名为data.txt的数据集,然后设置了聚类数量为3。

kmeans matlab 最佳聚类数

K-means算法是一种常用的聚类算法,它通过迭代将数据集划分为K个不同的簇,使得每个数据点都属于与其最近的簇。

在实际应用中,确定最佳的聚类数K是非常重要的,因为它直接影响了聚类的效果和结果的可解释性。

在Matlab中,我们可以使用kmeans函数来实现K-means聚类算法。

然而,对于给定的数据集,如何选择最佳的聚类数K仍然是一个挑战。

下面将介绍一些常用的方法来确定最佳的聚类数K,并结合Matlab的实现来说明。

1. 肘部法则(Elbow method)肘部法则是一种直观的方法,它通过绘制不同聚类数K下的聚类效果图,并观察随着K的增大,聚类效果的提升趋势。

当K增大到一定程度之后,聚类效果的提升趋势会变得平缓,这一点通常被称为“肘部”,也就是最佳的聚类数K。

在Matlab中,可以使用kmeans函数计算不同K下的聚类效果,并结合绘图函数plot来实现肘部法则的判断。

2. 轮廓系数(Silhouette coefficient)轮廓系数是一种定量的方法,它通过衡量每个数据点与所属簇的相似度,来评估聚类的效果。

轮廓系数的取值范围在[-1, 1]之间,值越大表示聚类效果越好。

在Matlab中,可以使用silhouette函数来计算轮廓系数,并结合绘图函数bar来对不同聚类数K下的轮廓系数进行可视化分析。

3. 间隔统计量(Gap statistic)间隔统计量是一种比较复杂的方法,它通过对比原始数据集和随机生成数据集的聚类效果来评估最佳的聚类数K。

在Matlab中,可以使用evalclusters函数来计算间隔统计量,并结合绘图函数plot来确定最佳的聚类数K。

总结而言,确定最佳的聚类数K是K-means算法中的一个重要问题,对于不同的数据集和应用场景,选择合适的方法来确定最佳的K是非常重要的。

在Matlab中,可以结合肘部法则、轮廓系数和间隔统计量等方法来进行综合分析,从而确定最佳的聚类数K。

希望本文介绍的方法能够为使用Matlab进行K-means聚类分析的研究人员和工程师提供一些参考和帮助。

聚类算法matlab实现

聚类算法matlab实现英文回答:Clustering algorithms are widely used in data analysis and machine learning to group similar data points together. MATLAB provides several built-in functions and tools for implementing clustering algorithms. Here, I will discuss two commonly used clustering algorithms in MATLAB: k-means clustering and hierarchical clustering.1. K-means Clustering:K-means clustering is a popular algorithm for partitioning a dataset into k distinct clusters. MATLAB provides the function `kmeans` for implementing this algorithm. The basic steps to perform k-means clustering in MATLAB are as follows:Load or generate the dataset.Specify the number of clusters, k.Call the `kmeans` function with the dataset and k as input arguments.Retrieve the cluster assignments and cluster centroids from the output of the `kmeans` function.Here is an example of how to perform k-means clustering in MATLAB:matlab.% Generate a sample dataset.data = [randn(100,2); randn(100,2)+5];% Perform k-means clustering with k=2。

matlab kmeans聚类算法代码

一、引言在机器学习和数据分析中,聚类是一种常用的数据分析技术,它可以帮助我们发现数据中的潜在模式和结构。

而k均值(k-means)聚类算法作为一种经典的聚类方法,被广泛应用于各种领域的数据分析和模式识别中。

本文将介绍matlab中k均值聚类算法的实现和代码编写。

二、k均值(k-means)聚类算法简介k均值聚类算法是一种基于距离的聚类算法,它通过迭代的方式将数据集划分为k个簇,每个簇内的数据点与该簇的中心点的距离之和最小。

其基本思想是通过不断调整簇的中心点,使得簇内的数据点与中心点的距离最小化,从而实现数据的聚类分布。

三、matlab实现k均值聚类算法步骤在matlab中,实现k均值聚类算法的步骤如下:1. 初始化k个簇的中心点,可以随机选择数据集中的k个点作为初始中心点。

2. 根据每个数据点与各个簇中心点的距离,将数据点分配给距离最近的簇。

3. 根据每个簇的数据点重新计算该簇的中心点。

4. 重复步骤2和步骤3,直到簇的中心点不再发生变化或者达到预定的迭代次数。

在matlab中,可以通过以下代码实现k均值聚类算法:```matlab设置参数k = 3; 设置簇的个数max_iter = 100; 最大迭代次数初始化k个簇的中心点centroids = datasample(data, k, 'Replace', false);for iter = 1:max_iterStep 1: 计算每个数据点与簇中心点的距离distances = pdist2(data, centroids);Step 2: 分配数据点给距离最近的簇[~, cluster_idx] = min(distances, [], 2);Step 3: 重新计算每个簇的中心点for i = 1:kcentroids(i, :) = mean(data(cluster_idx == i, :)); endend得到最终的聚类结果cluster_result = cluster_idx;```四、代码解释上述代码实现了k均值聚类算法的基本步骤,其中包括了参数设置、簇中心点的初始化、迭代过程中的数据点分配和中心点更新。

matlab中的kmeans函数

matlab中的kmeans函数MATLAB是一个广泛使用的数学软件,其机器学习算法库完全支持k-means。

k-means 是聚类算法的基本形式之一,用于将数据集分成k个簇或组。

K-means算法的目标是最小化每个簇内数据点的方差或欧几里得距离。

MATLAB中的kmeans函数是一个实用的工具,可以帮助用户轻松实现k-means算法。

本文将从以下方面介绍MATLAB中的kmeans函数:函数基本结构、函数参数说明、算法流程和示例代码。

一。

函数基本结构:kmeans函数的基本结构如下:[idx, C] = kmeans (X, k)idx是一个列向量,指示数据点属于哪个簇,C是一个k x n矩阵,其中每行都是一个簇的质心。

二。

函数参数说明:kmeans函数的主要输入参数是数据集X和所需簇的数量k。

其他可用的选项还包括:Distance:指定所需距离度量的类型。

默认情况下,此选项设置为欧几里得距离。

Replicates:指定要运行的簇的数量。

kmeans函数默认运行一次,但是通过设置此选项可以运行任意数量的副本,并根据最小方差选择一个最佳结果。

此选项的值必须是正整数,建议设置为至少10。

Start:指定初始簇质心的算法。

默认情况下,此选项设置为“簇中心”方法,但也可以使用其他算法,例如随机初始化或指定初始质心。

Display:设置显示每次迭代时结果的详细程度。

默认情况下,此选项的值为'off'(不显示任何内容),但也可以设置为'true'(在MATLAB命令行窗口中显示迭代信息)或'final'(仅在计算完成时显示结果)。

三。

算法流程:下面是kmeans算法的流程:1. 设置k值(所需簇的数量),并选择每个簇的初始质心。

2. 循环以下步骤,直到满足停止标准:(a)将每个数据点分配到最近的质心。

(b)重新计算每个簇的质心。

(c)如果当前方案已经满足停止标准,则停止算法。

kmeans算法的matlab代码

K-means算法是一种常用的聚类算法,在数据挖掘和机器学习领域有着广泛的应用。

它的主要思想是将数据分成K个簇,使得同一簇内的数据相似度较高,不同簇之间的数据相似度较低。

在本文中,我们将介绍K-means算法的原理,并给出其在Matlab中的实现代码。

下面是K-means算法在Matlab中的代码实现:1. 初始化簇中心```function [centroids] = initCentroids(X, K)随机初始化K个簇中心[m, n] = size(X);centroids = X(randperm(m, K), :);end```2. 分配样本到最近的簇```function [idx] = findClosestCentroids(X, centroids)根据当前簇中心,将每个样本分配到最近的簇中K = size(centroids, 1);idx = zeros(size(X,1), 1);m = size(X,1);for i=1:mmin_dist = inf;for j=1:Kdist = sum((X(i,:) - centroids(j,:)).^2);if dist < min_distmin_dist = dist;idx(i) = j;endendendend```3. 更新簇中心```function [centroids] =puteCentroids(X, idx, K) 对每个簇重新计算簇中心[m, n] = size(X);centroids = zeros(K, n);for i=1:Kcentroids(i, :) = mean(X(idx == i, :));endend```4. K-means算法主函数```function [centroids, idx] = runkMeans(X, initial_centroids,max_iters)K-means算法的主函数[m, n] = size(X);K = size(initial_centroids, 1);centroids = initial_centroids;previous_centroids = centroids;idx = zeros(m, 1);for i=1:max_iters计算每个样本到簇中心的最短距离idx = findClosestCentroids(X, centroids);更新簇中心centroids =puteCentroids(X, idx, K);endend```通过以上代码,我们可以在Matlab中实现K-means算法,并对数据进行聚类分析。

matlab的kmeans函数

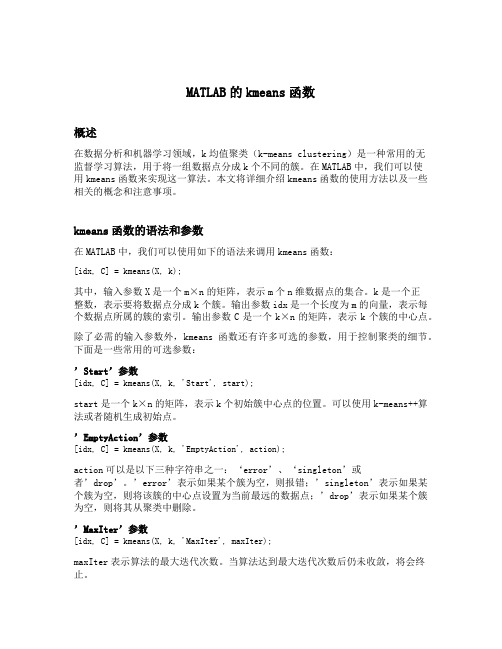

MATLAB的kmeans函数概述在数据分析和机器学习领域,k均值聚类(k-means clustering)是一种常用的无监督学习算法,用于将一组数据点分成k个不同的簇。

在MATLAB中,我们可以使用kmeans函数来实现这一算法。

本文将详细介绍kmeans函数的使用方法以及一些相关的概念和注意事项。

kmeans函数的语法和参数在MATLAB中,我们可以使用如下的语法来调用kmeans函数:[idx, C] = kmeans(X, k);其中,输入参数X是一个m×n的矩阵,表示m个n维数据点的集合。

k是一个正整数,表示要将数据点分成k个簇。

输出参数idx是一个长度为m的向量,表示每个数据点所属的簇的索引。

输出参数C是一个k×n的矩阵,表示k个簇的中心点。

除了必需的输入参数外,kmeans函数还有许多可选的参数,用于控制聚类的细节。

下面是一些常用的可选参数:’Start’参数[idx, C] = kmeans(X, k, 'Start', start);start是一个k×n的矩阵,表示k个初始簇中心点的位置。

可以使用k-means++算法或者随机生成初始点。

’EmptyAction’参数[idx, C] = kmeans(X, k, 'EmptyAction', action);action可以是以下三种字符串之一:‘error’、‘singleton’或者’drop’。

’error’表示如果某个簇为空,则报错;’singleton’表示如果某个簇为空,则将该簇的中心点设置为当前最远的数据点;’drop’表示如果某个簇为空,则将其从聚类中删除。

’MaxIter’参数[idx, C] = kmeans(X, k, 'MaxIter', maxIter);maxIter表示算法的最大迭代次数。

当算法达到最大迭代次数后仍未收敛,将会终止。

(完整版)matlab实现Kmeans聚类算法

题目:matlab实现Kmeans聚类算法姓名学号背景知识1.简介:Kmeans算法是一种经典的聚类算法,在模式识别中得到了广泛的应用,基于Kmeans的变种算法也有很多,模糊Kmeans、分层Kmeans 等。

Kmeans和应用于混合高斯模型的受限EM算法是一致的。

高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。

Kmeans 的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定标记样本调整类别中心向量。

K均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。

Kmeans在某种程度也可以看成Meanshitf的特殊版本,Meanshift 是一种概率密度梯度估计方法(优点:无需求解出具体的概率密度,直接求解概率密度梯度。

),所以Meanshift可以用于寻找数据的多个模态(类别),利用的是梯度上升法。

在06年的一篇CVPR文章上,证明了Meanshift方法是牛顿拉夫逊算法的变种。

Kmeans 和EM算法相似是指混合密度的形式已知(参数形式已知)情况下,利用迭代方法,在参数空间中搜索解。

而Kmeans和Meanshift相似是指都是一种概率密度梯度估计的方法,不过是Kmean选用的是特殊的核函数(uniform kernel),而与混合概率密度形式是否已知无关,是一种梯度求解方式。

k-means是一种聚类算法,这种算法是依赖于点的邻域来决定哪些点应该分在一个组中。

当一堆点都靠的比较近,那这堆点应该是分到同一组。

使用k-means,可以找到每一组的中心点。

当然,聚类算法并不局限于2维的点,也可以对高维的空间(3维,4维,等等)的点进行聚类,任意高维的空间都可以。

上图中的彩色部分是一些二维空间点。

上图中已经把这些点分组了,并使用了不同的颜色对各组进行了标记。

这就是聚类算法要做的事情。

这个算法的输入是:1:点的数据(这里并不一定指的是坐标,其实可以说是向量)2:K,聚类中心的个数(即要把这一堆数据分成几组)所以,在处理之前,你先要决定将要把这一堆数据分成几组,即聚成几类。

matlab k均值 聚类 实现

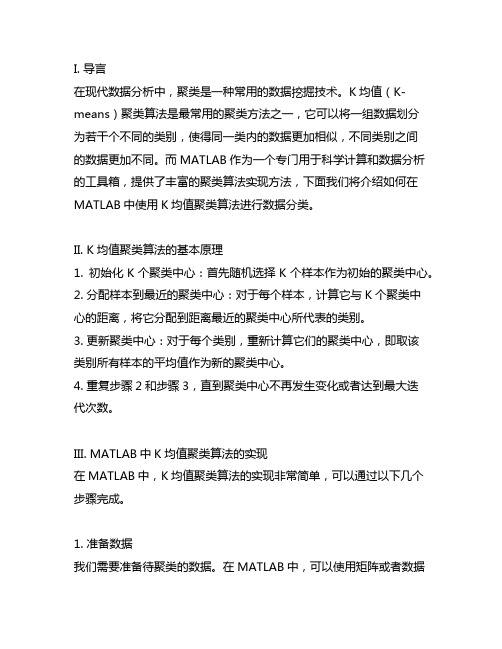

I. 导言在现代数据分析中,聚类是一种常用的数据挖掘技术。

K均值(K-means)聚类算法是最常用的聚类方法之一,它可以将一组数据划分为若干个不同的类别,使得同一类内的数据更加相似,不同类别之间的数据更加不同。

而MATLAB作为一个专门用于科学计算和数据分析的工具箱,提供了丰富的聚类算法实现方法,下面我们将介绍如何在MATLAB中使用K均值聚类算法进行数据分类。

II. K均值聚类算法的基本原理1. 初始化K个聚类中心:首先随机选择K个样本作为初始的聚类中心。

2. 分配样本到最近的聚类中心:对于每个样本,计算它与K个聚类中心的距离,将它分配到距离最近的聚类中心所代表的类别。

3. 更新聚类中心:对于每个类别,重新计算它们的聚类中心,即取该类别所有样本的平均值作为新的聚类中心。

4. 重复步骤2和步骤3,直到聚类中心不再发生变化或者达到最大迭代次数。

III. MATLAB中K均值聚类算法的实现在MATLAB中,K均值聚类算法的实现非常简单,可以通过以下几个步骤完成。

1. 准备数据我们需要准备待聚类的数据。

在MATLAB中,可以使用矩阵或者数据集来表示数据,假设我们有一个N维的数据集X,其中包含M个样本。

X = [x1, x2, ..., xm]2. 初始化K个聚类中心接下来,我们需要随机选择K个样本作为初始的聚类中心。

在MATLAB中,可以使用randperm函数来生成一个随机的样本索引序列,然后取前K个样本作为初始聚类中心。

idx = randperm(M, K);centroids = X(idx, :);3. 分配样本到最近的聚类中心我们需要计算每个样本与K个聚类中心的距离,并将每个样本分配到距离最近的聚类中心所代表的类别。

在MATLAB中,可以使用pdist2函数来计算样本与聚类中心之间的距禂,然后使用min函数找到每个样本距离最近的聚类中心。

distances = pdist2(X, centroids);[~, labels] = min(distances, [], 2);4. 更新聚类中心我们需要重新计算每个类别的聚类中心,即取每个类别所有样本的平均值作为新的聚类中心。

(完整版)matlab实现Kmeans聚类算法

(完整版)matlab实现Kmeans聚类算法题目:matlab实现Kmeans聚类算法姓名学号背景知识1.简介:Kmeans算法是一种经典的聚类算法,在模式识别中得到了广泛的应用,基于Kmeans的变种算法也有很多,模糊Kmeans、分层Kmeans 等。

Kmeans和应用于混合高斯模型的受限EM算法是一致的。

高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。

Kmeans 的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定标记样本调整类别中心向量。

K均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。

Kmeans在某种程度也可以看成Meanshitf的特殊版本,Meanshift 是一种概率密度梯度估计方法(优点:无需求解出具体的概率密度,直接求解概率密度梯度。

),所以Meanshift可以用于寻找数据的多个模态(类别),利用的是梯度上升法。

在06年的一篇CVPR文章上,证明了Meanshift方法是牛顿拉夫逊算法的变种。

Kmeans 和EM算法相似是指混合密度的形式已知(参数形式已知)情况下,利用迭代方法,在参数空间中搜索解。

而Kmeans和Meanshift相似是指都是一种概率密度梯度估计的方法,不过是Kmean选用的是特殊的核函数(uniform kernel),而与混合概率密度形式是否已知无关,是一种梯度求解方式。

k-means是一种聚类算法,这种算法是依赖于点的邻域来决定哪些点应该分在一个组中。

当一堆点都靠的比较近,那这堆点应该是分到同一组。

使用k-means,可以找到每一组的中心点。

当然,聚类算法并不局限于2维的点,也可以对高维的空间(3维,4维,等等)的点进行聚类,任意高维的空间都可以。

上图中的彩色部分是一些二维空间点。

上图中已经把这些点分组了,并使用了不同的颜色对各组进行了标记。

这就是聚类算法要做的事情。

matlab kmeans 聚类 用法

matlab kmeans 聚类用法在MATLAB中,可以使用kmeans函数进行聚类。

以下是kmeans函数的使用方法:[k, centroids] = kmeans(X, k)其中,X是n个d维样本的矩阵,k是聚类的数量。

该函数将返回聚类的标签k和聚类中心centroids。

另一种用法是:[idx, centroids] = kmeans(X, k)这种用法会返回每个样本的类别索引idx,以及聚类中心centroids。

可以通过设置额外的参数来进一步控制kmeans函数的行为,例如:- 'Start':指定初始聚类中心的位置。

可以是一个聚类中心矩阵,或者是一个值为'plus'的字符串,表示使用k-means++算法来选择初始聚类中心。

- 'MaxIter':指定最大迭代次数,默认值为100。

- 'Replicates':指定重复次数,默认值为1。

重复次数越多,得到的聚类结果越稳定。

- 'EmptyAction':指定空聚类的处理方式。

可以是以下四个选项之一:'error'(默认值),'singleton','drop'或'zero'。

例如,使用k-means++算法和最大迭代次数为200的初始聚类中心,可以使用以下代码:opts = statset('MaxIter', 200);[idx, centroids] = kmeans(X, k, 'Start', 'plus', 'Options', opts)。

kmeans聚类算法matlab

kmeans聚类算法matlabK-Means聚类算法是一种常用的聚类分析算法,它可以优化数据空间中数据点的结构,将数据分组,形成划分聚类。

K-Means聚类算法于1966年由斯坦福大学的比纳尔格雷开发出来,它的工作原理是:先将给定的数据集初始分组,然后通过不断调整聚类中心的位置,将数据点尽可能的放入其所属的簇,从而得到最优的聚类结果,有效的解决了高维数据空间中线性不可分问题。

K-Means聚类算法是一种直观、简单、可扩展性强的聚类算法,普遍存在于数据挖掘、计算机视觉等领域。

MATLAB是目前最为广泛应用的科学计算语言,它可以将高深的科学计算做成容易理解的程序代码,直接用于各种科学计算任务包括数值计算、科学可视化、直观交互、数据处理以及模拟建模。

其中,K-Means聚类算法也被完美的支持,该算法的MATLAB实现非常简单,因此广受广大科研人员、数据挖掘以及计算机视觉领域的欢迎。

K-Means聚类算法在MATLAB中的实例程序下面是一个K-Means聚类算法在MATLAB中的实例程序:clear all;close all;clc;% The following example shows the use of k-means clustering to% segregate the data into two clusters.% Step 1: Generate the data pointsx=randn(50,2);% Step 2: Label the data pointsy=[ones(25,1);2*ones(25,1)];% Step 3: Apply k-means clustering[idx,centroids]=kmeans(x,2);% Step 4: Plot the original data pointsfigurescatter(x(:,1),x(:,2),50,y,filledtitle(Original Data% Step 5: Plot the cluster data pointsfigurescatter(x(:,1),x(:,2),50,idx,filledtitle(Clustered Data% Step 6: Evaluate the clustering performance[accuracy] = evalClusters(y,idx);程序实现了K-Means聚类算法,包括数据生成、聚类计算、聚类效果可视化和聚类分析等部分,可以很好的说明K-Means聚类算法在MATLAB中的应用。

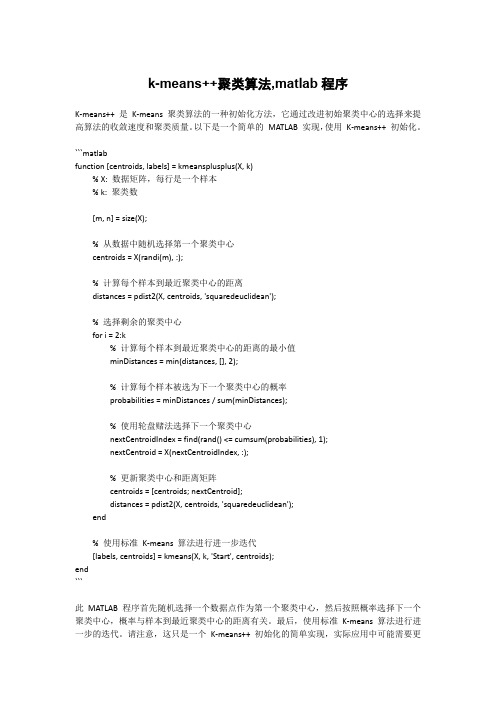

k-means++聚类算法,matlab程序

k-means++聚类算法,matlab程序K-means++ 是K-means 聚类算法的一种初始化方法,它通过改进初始聚类中心的选择来提高算法的收敛速度和聚类质量。

以下是一个简单的MATLAB 实现,使用K-means++ 初始化。

```matlabfunction [centroids, labels] = kmeansplusplus(X, k)% X: 数据矩阵,每行是一个样本% k: 聚类数[m, n] = size(X);% 从数据中随机选择第一个聚类中心centroids = X(randi(m), :);% 计算每个样本到最近聚类中心的距离distances = pdist2(X, centroids, 'squaredeuclidean');% 选择剩余的聚类中心for i = 2:k% 计算每个样本到最近聚类中心的距离的最小值minDistances = min(distances, [], 2);% 计算每个样本被选为下一个聚类中心的概率probabilities = minDistances / sum(minDistances);% 使用轮盘赌法选择下一个聚类中心nextCentroidIndex = find(rand() <= cumsum(probabilities), 1);nextCentroid = X(nextCentroidIndex, :);% 更新聚类中心和距离矩阵centroids = [centroids; nextCentroid];distances = pdist2(X, centroids, 'squaredeuclidean');end% 使用标准K-means 算法进行进一步迭代[labels, centroids] = kmeans(X, k, 'Start', centroids);end```此MATLAB 程序首先随机选择一个数据点作为第一个聚类中心,然后按照概率选择下一个聚类中心,概率与样本到最近聚类中心的距离有关。

K-Means聚类算法若干实例Matlab代码

要用matlab做聚类,找了几个资源,列在这里。

一、方法1: 用matlab自带的函数,IDX = kmeans(X,k)二、参照一段网友写的代码function y=kMeansCluster(m,k,isRand)%%%%%%%%%%%%%%%%%% kMeansCluster - Simple k means clustering algorithm% Author: Kardi Teknomo, Ph.D.%% Purpose: classify the objects in data matrix based on the attributes% Criteria: minimize Euclidean distance between centroids and object points% For more explanation of the algorithm, see /kardi/tutorial/kMean/index.html% Output: matrix data plus an additional column represent the group of each object%% Example: m = [ 1 1; 2 1; 4 3; 5 4] or in a nice form% m = [ 1 1;% 2 1;% 4 3;% 5 4]% k = 2% kMeansCluster(m,k) produces m = [ 1 1 1;% 2 1 1;% 4 3 2;% 5 4 2]% Input:% m - required, matrix data: objects in rows and attributes in columns % k - optional, number of groups (default = 1)% isRand - optional, if using random initialization isRand=1, otherwise input any number (default)% it will assign the first k data as initial centroids%% Local Variables% f - row number of data that belong to group i% c - centroid coordinate size (1:k, 1:maxCol)% g - current iteration group matrix size (1:maxRow)% i - scalar iterator% maxCol - scalar number of rows in the data matrix m = number of attributes % maxRow - scalar number of columns in the data matrix m = number of objects % temp - previous iteration group matrix size (1:maxRow)% z - minimum value (not needed) %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%if nargin<3, isRand=0; endif nargin<2, k=1; end[maxRow, maxCol]=size(m)if maxRow<=k,y=[m, 1:maxRow]else% initial value of centroidif isRand,p = randperm(size(m,1)); % random initializationfor i=1:kc(i,:)=m(p(i),:)endelsefor i=1:kc(i,:)=m(i,:) % sequential initializationendendtemp=zeros(maxRow,1); % initialize as zero vectorwhile 1,d=DistMatrix(m,c); % calculate objcets-centroid distances[z,g]=min(d,[],2); % find group matrix gif g==temp,break; % stop the iterationelsetemp=g; % copy group matrix to temporary variableendfor i=1:kf=find(g==i);if f % only compute centroid if f is not emptyc(i,:)=mean(m(find(g==i),:),1);endendendy=[m,g];endThe Matlab function kMeansCluster above call function DistMatrix as shown in the code below. It works for multi-dimensional Euclidean distance. Learn about other type of distance here.function d=DistMatrix(A,B)%%%%%%%%%%%%%%%%%%%%%%%%%% DISTMATRIX return distance matrix between points in A=[x1 y1 ... w1] and in B=[x2 y2 (2)% Copyright (c) 2005 by Kardi Teknomo, /kardi/%% Numbers of rows (represent points) in A and B are not necessarily the same.% It can be use for distance-in-a-slice (Spacing) or distance-between-slice (Headway),%% A and B must contain the same number of columns (represent variables of n dimensions),% first column is the X coordinates, second column is the Y coordinates, and so on.% The distance matrix is distance between points in A as rows% and points in B as columns.% example: Spacing= dist(A,A)% Headway = dist(A,B), with hA ~= hB or hA=hB% A=[1 2 3; 4 5 6; 2 4 6; 1 2 3]; B=[4 5 1; 6 2 0]% dist(A,B)= [ 4.69 5.83;% 5.00 7.00;% 5.48 7.48;% 4.69 5.83]%% dist(B,A)= [ 4.69 5.00 5.48 4.69;% 5.83 7.00 7.48 5.83]%%%%%%%%%%%%%%%%%%%%%%%%%%%[hA,wA]=size(A);[hB,wB]=size(B);if wA ~= wB, error(' second dimension of A and B must be the same'); endfor k=1:wAC{k}= repmat(A(:,k),1,hB);D{k}= repmat(B(:,k),1,hA);endS=zeros(hA,hB);for k=1:wAS=S+(C{k}-D{k}').^2;endd=sqrt(S);三、另外一个网友写的代码%这是一个简单的k均值聚类批处理函数%待分类的样本x=mvnrnd(mu,siguma,20)%idx3=kmeans(x,3,'distance','city');或者%idx4=kmeans(x,4,'dist','city','display','iter');这个可以显示出每次迭代的距离和%显示分类轮廓图[silh4,h]=silhouette(x,idx4,'city');xlable('silhouette% value');ylable('cluster')%mean(silh5) 结果越接近1越好mu1=[1,1];sigma1=[0.5 0;0 0.5];x1=mvnrnd(mu1,sigma1,10);mu2=[7,7];sigma2=[0.5 0;0 0.5];x2=mvnrnd(mu2,sigma2,10);x=[x1;x2]plot(x(:,1),x(:,2),'bo');[idx2,c]=kmeans(x,2,'dist','city','display','iter');figure(2);[silh2,h]=silhouette(x,idx2,'city');%xlable('silhouette value')%ylable('cluster')figure(3);plot(x(idx2==1,1),x(idx2==1,2),'r+',x(idx2==2,1),x(idx2==2,2),'b.');'分类水平:(1为最好):'a=mean(silh2);a'图心矩阵为:'c。

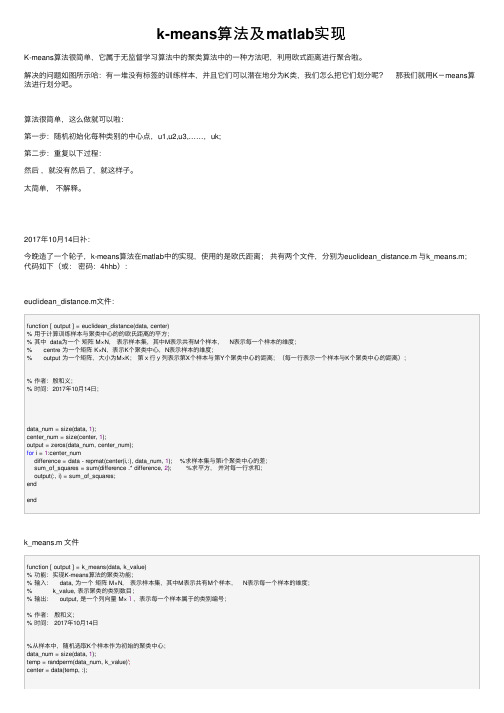

k-means算法及matlab实现

k-means算法及matlab实现K-means算法很简单,它属于⽆监督学习算法中的聚类算法中的⼀种⽅法吧,利⽤欧式距离进⾏聚合啦。

解决的问题如图所⽰哈:有⼀堆没有标签的训练样本,并且它们可以潜在地分为K类,我们怎么把它们划分呢?那我们就⽤K-means算法进⾏划分吧。

算法很简单,这么做就可以啦:第⼀步:随机初始化每种类别的中⼼点,u1,u2,u3,……,uk;第⼆步:重复以下过程:然后,就没有然后了,就这样⼦。

太简单,不解释。

2017年10⽉14⽇补:今晚造了⼀个轮⼦,k-means算法在matlab中的实现,使⽤的是欧⽒距离;共有两个⽂件,分别为euclidean_distance.m 与k_means.m;代码如下(或:密码:4hhb):euclidean_distance.m⽂件:function [ output ] = euclidean_distance(data, center)% ⽤于计算训练样本与聚类中⼼的的欧⽒距离的平⽅;% 其中 data为⼀个矩阵 M×N,表⽰样本集,其中M表⽰共有M个样本, N表⽰每⼀个样本的维度;% centre 为⼀个矩阵 K×N,表⽰K个聚类中⼼,N表⽰样本的维度;% output 为⼀个矩阵,⼤⼩为M×K;第x⾏y列表⽰第X个样本与第Y个聚类中⼼的距离;(每⼀⾏表⽰⼀个样本与K个聚类中⼼的距离);% 作者:殷和义;% 时间:2017年10⽉14⽇;data_num = size(data, 1);center_num = size(center, 1);output = zeros(data_num, center_num);for i = 1:center_numdifference = data - repmat(center(i,:), data_num, 1); %求样本集与第i个聚类中⼼的差;sum_of_squares = sum(difference .* difference, 2); %求平⽅,并对每⼀⾏求和;output(:, i) = sum_of_squares;endendk_means.m ⽂件function [ output ] = k_means(data, k_value)% 功能:实现K-means算法的聚类功能;% 输⼊: data, 为⼀个矩阵 M×N,表⽰样本集,其中M表⽰共有M个样本, N表⽰每⼀个样本的维度;% k_value, 表⽰聚类的类别数⽬;% 输出: output, 是⼀个列向量 M×1,表⽰每⼀个样本属于的类别编号;% 作者:殷和义;% 时间: 2017年10⽉14⽇%从样本中,随机选取K个样本作为初始的聚类中⼼;data_num = size(data, 1);temp = randperm(data_num, k_value)';center = data(temp, :);%⽤于计数迭代次数:iteration = 0;while1%获得样本集与聚类中⼼的距离;distance = euclidean_distance(data, center);%将距离矩阵的每⼀⾏从⼩到⼤排序,获得相应的index值,其实我们只需要index的第⼀列的值;[~, index] = sort(distance, 2, 'ascend');%接下来形成新的聚类中⼼;center_new = zeros(k_value, size(data, 2));for i = 1:k_valuedata_for_one_class = data(index(:, 1) == i, :);center_new(i,:) = mean(data_for_one_class, 1); %因为初始的聚类中⼼为样本集中的元素,所以不会出现某类别的样本个数为0的情况; end%输出迭代次数,给眼睛⼀个反馈;iteration = iteration + 1;fprintf('进⾏迭代次数为:%d\n', iteration);% 如果这两次的聚类中⼼不变,则停⽌迭代,跳出循环;if center_new == centerbreak;endcenter = center_new;endoutput = index(:, 1);end。

matlab k-means聚类算法

matlab k-means聚类算法

K 均值聚类算法(K-Means)是一种简单但实用的聚类算法,它是一种迭代的、无监督的、分组的聚类方法,它将数据分成k 个簇,使数据在同一簇内相似度较高,在不同簇间相似度较低。

在MATLAB 中,可以使用kmeans 函数来实现K 均值聚类算法。

该函数的调用格式如下:

idx = kmeans(X, k)

其中X 是一个n ×m 的矩阵,n 表示数据点的数量,m 表示每个数据点的维度;k 表示聚类的数量,idx 是一个n ×1 的向量,表示每个数据点所属的簇的编号。

例如,假设有如下数据集:

x1 = [2, 3]

x2 = [3, 4]

x3 = [4, 5]

x4 = [10, 11]

x5 = [11, 12]

x6 = [12, 13]

可以将这些数据点放在一个6 ×2 的矩阵中:

X = [2, 3;

3, 4;

4, 5;

10, 11;

11, 12;

12, 13]

然后可以使用kmeans 函数对这些数据进行聚类:idx = kmeans(X, 2)

运行结果为:

idx = 1

1

1

2

2

2

这表示前三个数据点属于一个簇,后三个数据点属于另一个簇。

可以使用plot 函数将这些点绘制出来,以便观察聚类的结果:

scatter(X(:,1), X(:,2), [], idx)。

kmeans评价指标matlab

K-means 聚类算法是一种常用的无监督学习方法,可以将数据分成多个类别。

在实际应用中,为了评估 K-means 算法的性能,需要使用一些评价指标来衡量聚类的效果。

MATLAB 作为一种强大的数学建模和数据分析工具,可以用于实现 K-means 聚类算法,并且提供了丰富的评价指标计算函数。

本文将探讨如何使用 MATLAB 实现 K-means 算法,并且介绍常用的评价指标。

一、K-means 算法简介K-means 算法是一种迭代的聚类算法,其基本思想是将数据点分为 K 个不同的类别,使得每个数据点到其所属类别的中心的距离最小化。

算法的具体步骤如下:1. 初始化 K 个类别的中心点。

2. 将每个数据点分配到与其最近的类别。

3. 更新每个类别的中心点。

4. 重复步骤 2 和 3,直到类别中心点不再发生变化或者达到预定的迭代次数。

K-means 算法的优点是简单易理解,计算速度快,适用于大规模数据集。

然而,K-means 算法也存在一些缺点,例如对初始中心点的敏感性、对异常值的敏感性等。

二、MATLAB 实现 K-means 算法MATLAB 提供了 kmeans() 函数来实现 K-means 聚类算法。

该函数的基本语法为:[idx, C] = kmeans(X, k)其中,X 是输入的数据矩阵,每一行代表一个数据点;k 是指定的类别数;idx 是每个数据点所属的类别索引;C 是最终的类别中心点。

通过调用 kmeans() 函数,可以方便地实现 K-means 算法并得到聚类的结果。

三、常用的 K-means 聚类评价指标在对 K-means 算法的效果进行评估时,常用的评价指标包括以下几种:1. 轮廓系数(Silhouette Coefficient):用于衡量类别之间的分离程度和类别内部的紧密程度。

轮廓系数的取值范围在 -1 到 1 之间,值越大表示聚类效果越好。

2. Calinski-Harabasz 指数:用于衡量类别内部数据的离散程度和类别间数据的分散程度,值越大表示聚类效果越好。

Matlab实现K-Means聚类算法

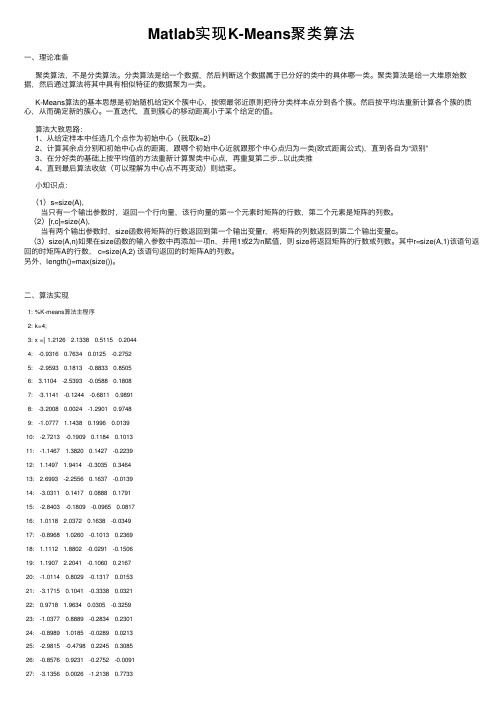

Matlab实现K-Means聚类算法⼀、理论准备聚类算法,不是分类算法。

分类算法是给⼀个数据,然后判断这个数据属于已分好的类中的具体哪⼀类。

聚类算法是给⼀⼤堆原始数据,然后通过算法将其中具有相似特征的数据聚为⼀类。

K-Means算法的基本思想是初始随机给定K个簇中⼼,按照最邻近原则把待分类样本点分到各个簇。

然后按平均法重新计算各个簇的质⼼,从⽽确定新的簇⼼。

⼀直迭代,直到簇⼼的移动距离⼩于某个给定的值。

算法⼤致思路:1、从给定样本中任选⼏个点作为初始中⼼(我取k=2)2、计算其余点分别和初始中⼼点的距离,跟哪个初始中⼼近就跟那个中⼼点归为⼀类(欧式距离公式),直到各⾃为“派别”3、在分好类的基础上按平均值的⽅法重新计算聚类中⼼点,再重复第⼆步...以此类推4、直到最后算法收敛(可以理解为中⼼点不再变动)则结束。

⼩知识点:(1)s=size(A),当只有⼀个输出参数时,返回⼀个⾏向量,该⾏向量的第⼀个元素时矩阵的⾏数,第⼆个元素是矩阵的列数。

(2)[r,c]=size(A),当有两个输出参数时,size函数将矩阵的⾏数返回到第⼀个输出变量r,将矩阵的列数返回到第⼆个输出变量c。

(3)size(A,n)如果在size函数的输⼊参数中再添加⼀项n,并⽤1或2为n赋值,则 size将返回矩阵的⾏数或列数。

其中r=size(A,1)该语句返回的时矩阵A的⾏数, c=size(A,2) 该语句返回的时矩阵A的列数。

另外,length()=max(size())。

⼆、算法实现1: %K-means算法主程序2: k=4;3: x =[ 1.2126 2.1338 0.5115 0.20444: -0.9316 0.7634 0.0125 -0.27525: -2.9593 0.1813 -0.8833 0.85056: 3.1104 -2.5393 -0.0588 0.18087: -3.1141 -0.1244 -0.6811 0.98918: -3.2008 0.0024 -1.2901 0.97489: -1.0777 1.1438 0.1996 0.013910: -2.7213 -0.1909 0.1184 0.101311: -1.1467 1.3820 0.1427 -0.223912: 1.1497 1.9414 -0.3035 0.346413: 2.6993 -2.2556 0.1637 -0.013914: -3.0311 0.1417 0.0888 0.179115: -2.8403 -0.1809 -0.0965 0.081716: 1.0118 2.0372 0.1638 -0.034917: -0.8968 1.0260 -0.1013 0.236918: 1.1112 1.8802 -0.0291 -0.150619: 1.1907 2.2041 -0.1060 0.216720: -1.0114 0.8029 -0.1317 0.015321: -3.1715 0.1041 -0.3338 0.032122: 0.9718 1.9634 0.0305 -0.325923: -1.0377 0.8889 -0.2834 0.230124: -0.8989 1.0185 -0.0289 0.021325: -2.9815 -0.4798 0.2245 0.308526: -0.8576 0.9231 -0.2752 -0.009127: -3.1356 0.0026 -1.2138 0.773329: 2.9143 -1.7951 0.1992 -0.2146 30: 3.4961 -2.4969 -0.0121 0.1315 31: -2.9341 -0.1071 -0.7712 0.8911 32: -2.8105 -0.0884 -0.0287 -0.1279 33: 3.1006 -2.0677 -0.2002 -0.1303 34: 0.8209 2.1724 0.1548 0.3516 35: -2.8500 0.3196 0.1359 -0.1179 36: -2.8679 0.1365 -0.5702 0.7626 37: -2.8245 -0.1312 0.0881 -0.1305 38: -0.8322 1.3014 -0.3837 0.2400 39: -2.6063 0.1431 0.1880 0.0487 40: -3.1341 -0.0854 -0.0359 -0.2080 41: 0.6893 2.0854 -0.3250 -0.1007 42: 1.0894 1.7271 -0.0176 0.6553 43: -2.9851 -0.0113 0.0666 -0.0802 44: 1.0371 2.2724 0.1044 0.3982 45: -2.8032 -0.2737 -0.7391 1.0277 46: -2.6856 0.0619 -1.1066 1.0485 47: -2.9445 -0.1602 -0.0019 0.0093 48: 1.2004 2.1302 -0.1650 0.3413 49: 3.2505 -1.9279 0.4462 -0.2405 50: -1.2080 0.8222 0.1671 0.1576 51: -2.8274 0.1515 -0.9636 1.0675 52: 2.8190 -1.8626 0.2702 0.0026 53: 1.0507 1.7776 -0.1421 0.0999 54: -2.8946 0.1446 -0.1645 0.3071 55: -1.0105 1.0973 0.0241 0.1628 56: -2.9138 -0.3404 0.0627 0.1286 57: -3.0646 -0.0008 0.3819 -0.1541 58: 1.2531 1.9830 -0.0774 0.2413 59: 1.1486 2.0440 -0.0582 -0.0650 60: -3.1401 -0.1447 -0.6580 0.9562 61: -2.9591 0.1598 -0.6581 1.1937 62: -2.9219 -0.3637 -0.1538 -0.2085 63: 2.8948 -2.2745 0.2332 -0.0312 64: -3.2972 -0.0219 -0.0288 -0.1436 65: -1.2737 0.7648 0.0643 0.0858 66: -1.0690 0.8108 -0.2723 0.3231 67: -0.5908 0.7508 -0.5456 0.0190 68: 0.5808 2.0573 -0.1658 0.1709 69: 2.8227 -2.2461 0.2255 -0.3684 70: 0.6174 1.7654 -0.3999 0.4125 71: 3.2587 -1.9310 0.2021 0.0800 72: 1.0999 1.8852 -0.0475 -0.0585 73: -2.7395 0.2585 -0.8441 0.9987 74: -1.2223 1.0542 -0.2480 -0.2795 75: -2.9212 -0.0605 -0.0259 0.259177: 0.8476 1.8760 -0.2894 -0.0354 78: 2.9205 -2.2418 0.4137 -0.2499 79: 2.7656 -2.1768 0.0719 -0.1848 80: -0.8698 1.0249 -0.2084 -0.0008 81: -1.1444 0.7787 -0.4958 0.3676 82: -1.0711 1.0450 -0.0477 -0.4030 83: 0.5350 1.8110 -0.0377 0.1622 84: 0.9076 1.8845 -0.1121 0.5700 85: -2.7887 -0.2119 0.0566 0.0120 86: -1.2567 0.9274 0.1104 0.1581 87: -2.9946 -0.2086 -0.8169 0.6662 88: 1.0536 1.9818 -0.0631 0.2581 89: -2.8465 -0.2222 0.2745 0.1997 90: -2.8516 0.1649 -0.7566 0.8616 91: -3.2470 0.0770 0.1173 -0.1092 92: -2.9322 -0.0631 -0.0062 -0.0511 93: -2.7919 0.0438 -0.1935 -0.5023 94: 0.9894 1.9475 -0.0146 -0.0390 95: -2.9659 -0.1300 0.1144 0.3410 96: -2.7322 -0.0427 -1.0758 0.9718 97: -1.4852 0.8592 -0.0503 -0.1373 98: 2.8845 -2.1465 -0.0533 -0.1044 99: -3.1470 0.0536 0.1073 0.3323 100: 2.9423 -2.1572 0.0505 0.1180 101: -3.0683 0.3434 -0.6563 0.8960 102: 1.3215 2.0951 -0.1557 0.3994 103: -0.7681 1.2075 -0.2781 0.2372 104: -0.6964 1.2360 -0.3342 0.1662 105: -0.6382 0.8204 -0.2587 0.3344 106: -3.0233 -0.1496 -0.2607 -0.0400 107: -0.8952 0.9872 0.0019 0.3138 108: -0.8172 0.6814 -0.0691 0.1009 109: -3.3032 0.0571 -0.0243 -0.1405 110: 0.7810 1.9013 -0.3996 0.7374 111: -0.9030 0.8646 -0.1498 0.1112 112: -0.8461 0.9261 -0.1295 -0.0727 113: 2.8182 -2.0818 -0.1430 -0.0547 114: 2.9295 -2.3846 -0.0244 -0.1400 115: 1.0587 2.2227 -0.1250 0.0957 116: 3.0755 -1.7365 -0.0511 0.1500 117: -1.3076 0.8791 -0.3720 0.0331 118: -2.8252 -0.0366 -0.6790 0.7374 119: -2.6551 -0.1875 0.3222 0.0483 120: -2.9659 -0.1585 0.4013 -0.1402 121: -3.2859 -0.1546 0.0104 -0.1781 122: -0.6679 1.1999 0.1396 -0.3195 123: -1.0205 1.2226 0.1850 0.0050124: -3.0091 -0.0186 -0.9111 0.9663125: -3.0339 0.1377 -0.9662 1.0664126: 0.8952 1.9594 -0.3221 0.3579127: -2.8481 0.1963 -0.1428 0.0382128: 1.0796 2.1353 -0.0792 0.6491129: -0.8732 0.8985 -0.0049 0.0068130: 1.0620 2.1478 -0.1275 0.3553131: 3.4509 -1.9975 0.1285 -0.1575132: -3.2280 -0.0640 -1.1513 0.8235133: -0.6654 0.9402 0.0577 -0.0175134: -3.2100 0.2762 -0.1053 0.0626135: 3.0793 -2.0043 0.2948 0.0411136: 1.3596 1.9481 -0.0167 0.3958137: -3.1267 0.1801 0.2228 0.1179138: -0.7979 0.9892 -0.2673 0.4734139: 2.5580 -1.7623 -0.1049 -0.0521140: -0.9172 1.0621 -0.0826 0.1501141: -0.7817 1.1658 0.1922 0.0803142: 3.1747 -2.1442 0.1472 -0.3411143: 2.8476 -1.8056 -0.0680 0.1536144: -0.6175 1.4349 -0.1970 -0.1085145: 0.7308 1.9656 0.2602 0.2801146: -1.0310 1.0553 -0.2928 -0.1647147: -2.9251 -0.2095 0.0582 -0.1813148: -0.9827 1.2720 -0.2225 0.2563149: -1.0830 1.1158 -0.0405 -0.1181150: -2.8744 0.0195 -0.3811 0.1455151: 3.1663 -1.9241 0.0455 0.1684152: -1.0734 0.7681 -0.4725 -0.1976];153: [n,d] = size(x);154: bn=round(n/k*rand);%第⼀个随机数在前1/K的范围内155: %;表⽰按列显⽰,都好表⽰按⾏显⽰156: nc=[x(bn,:);x(2*bn,:);x(3*bn,:);x(4*bn,:)];%初始聚类中⼼157: %x(bn,:) 选择某⼀⾏数据作为聚类中⼼,其列值为全部158:159: %x数据源,k聚类数⽬,nc表⽰k个初始化聚类中⼼160: %cid表⽰每个数据属于哪⼀类,nr表⽰每⼀类的个数,centers表⽰聚类中⼼161: [cid,nr,centers] = kmeans(x,k,nc)%调⽤kmeans函数162: %认为不该是150,或者说不该是个确定值,该是size(x,1)就是x⾏数163: for i=1:150164: if cid(i)==1,165: plot(x(i,1),x(i,2),'r*') % 显⽰第⼀类166: %plot(x(i,2),'r*') % 显⽰第⼀类167: hold on168: else169: if cid(i)==2,170: plot(x(i,1),x(i,2),'b*') %显⽰第⼆类171: % plot(x(i,2),'b*') % 显⽰第⼀类172: hold on173: else174: if cid(i)==3,175: plot(x(i,1),x(i,2),'g*') %显⽰第三类176: % plot(x(i,2),'g*') % 显⽰第⼀类177: hold on178: else179: if cid(i)==4,180: plot(x(i,1),x(i,2),'k*') %显⽰第四类181: % plot(x(i,2),'k*') % 显⽰第⼀类182: hold on183: end184: end185: end186: end187: end188: strt=['红⾊*为第⼀类;蓝⾊*为第⼆类;绿⾊*为第三类;⿊⾊*为第四类' ];189: text(-4,-3.6,strt);1: %BasicKMeans.m主类2: %x数据源,k聚类数⽬,nc表⽰k个初始化聚类中⼼3: %cid表⽰每个数据属于哪⼀类,nr表⽰每⼀类的个数,centers表⽰聚类中⼼4: function [cid,nr,centers] = kmeans(x,k,nc)5: [n,d] = size(x);6: % 设置cid为分类结果显⽰矩阵7: cid = zeros(1,n);8: % Make this different to get the loop started.9: oldcid = ones(1,n);10: % The number in each cluster.11: nr = zeros(1,k);12: % Set up maximum number of iterations.13: maxgn= 100;14: iter = 1;15: %计算每个数据到聚类中⼼的距离 ,选择最⼩的值得位置到cid16: %我记得是聚类中⼼近乎不再变化迭代停⽌17: while iter < maxgn18: for i = 1:n19: %repmat 即 Replicate Matrix ,复制和平铺矩阵,是 MATLAB ⾥⾯的⼀个函数。

Matlab用k-means实现聚类算法

课程设计课程名称MATLAB应用专项实践题目利用聚类算法实现对数据的分类学院信息工程学院专业电子科学与技术班级电子1303班姓名指导教师吴皓莹2016 年 1 月13 日课程设计任务书学生姓名:专业班级:电子1303班指导教师:吴皓莹工作单位:信息工程学院题目: 利用聚类算法实现对数据的分类初始条件:1.Matlab7.1以上版本软件;2.专业基础实践辅导资料:“MA TLAB神经网络43个案例说明”、“模式识别与智能计算的MATLAB 实现”、“模式识别与智能计算——MATLAB技术实现”相关书籍等;3.先修课程:高等数学、线性代数、电路、MATLAB应用实践及信号处理类基础课程。

要求完成的主要任务:题目:1 利用多种神经网络(如BP神经网络、自组织网络等)实现对数据的分类2 利用聚类算法(即非监督算法,如k-means等)实现对数据的分类3 利用监督算法(如决策树、贝叶斯、最近邻算法等)实现对数据的分类4 利用集成算法(如Boosting、Bagging、Random Subspace等)实现对数据的分类5 利用Svm算法实现对数据的分类要求:1 学习并掌握各种分类算法的分类原理;2 至少实现两种算法,并对比分析各自分类性能;A 若题目2中只实现了一种聚类算法,可另外再实现任一种监督算法进行比较分析;B 题目5中,也可任选另一种分类算法进行对比,或者具体分析SVM算法中核函数等多个参数的选择对分类性能的影响;3 要实现PCA算法,对比是否才有PCA算法对分类结果的影响;4 各个分类算法的参数设置对分类结果也有影响,实验过程中要注意参数的选择;5 分类过程及结果需要有丰富的图示说明。

时间安排:1周指导教师签名:年月日系主任(或责任教师)签名:年月日摘要本次课程设计为应用专项实践课程设计,专业基础实践涉及方面很广泛,包括信号系统、物理光学、电磁场与电磁波等各方面知识的相互结合与实际运用。

旨在利用MATLAB 软件解决相应的问题或完成相关的设计。

matlab实现Kmeans聚类算法

kmeans函数:输入为类别数量k和数据矩阵A;输出为聚类结果A,和迭代次数,并将聚类结果数据以excel形式保存在工作路径下function km(k,A)%函数名里不要出现“-”warning off[n,p]=size(A);%输入数据有n个样本,p个属性cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性%A(:,p+1)=100;A(:,p+1)=0;for i=1:k%cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心m=i*floor(n/k)-floor(rand(1,1)*(n/k))cid(i,:)=A(m,:);cid;endAsum=0;Csum2=NaN;flags=1;times=1;while flagsflags=0;times=times+1;%计算每个向量到聚类中心的欧氏距离for i=1:nfor j=1:kdist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离end%A(i,p+1)=min(dist(i,:));%与中心的最小距离[x,y]=find(dist(i,:)==min(dist(i,:)));[c,d]=size(find(y==A(i,p+1)));if c==0 %说明聚类中心变了flags=flags+1;A(i,p+1)=y(1,1);elsecontinue;endendiflagsfor j=1:kAsum=0;[r,c]=find(A(:,p+1)==j);cid(j,:)=mean(A(r,:),1);for m=1:length(r)Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2)); endCsum(1,j)=Asum;endsum(Csum(1,:))%if sum(Csum(1,:))>Csum2% break;%endCsum2=sum(Csum(1,:));Csum;cid; %得到新的聚类中心endtimesdisplay('A矩阵,最后一列是所属类别');Afor j=1:k[a,b]=size(find(A(:,p+1)==j));numK(j)=a;endnumKtimesxlswrite('',A); %把矩阵A写到excel文件中,保存在工作路径下display('数据已保存为excel格式');。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

kmeans函数:输入为类别数量k和数据矩阵A;输出为聚类结果A,和迭代次数,并将聚类结果数据以excel形式保存在工作路径下

function km(k,A)%函数名里不要出现“-”

warning off

[n,p]=size(A);%输入数据有n个样本,p个属性

cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性

%A(:,p+1)=100;

A(:,p+1)=0;

for i=1:k

%cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心

m=i*floor(n/k)-floor(rand(1,1)*(n/k))

cid(i,:)=A(m,:);

cid;

end

Asum=0;

Csum2=NaN;

flags=1;

times=1;

while flags

flags=0;

times=times+1;

%计算每个向量到聚类中心的欧氏距离

for i=1:n

for j=1:k

dist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离

end

%A(i,p+1)=min(dist(i,:));%与中心的最小距离

[x,y]=find(dist(i,:)==min(dist(i,:)));

[c,d]=size(find(y==A(i,p+1)));

if c==0 %说明聚类中心变了

flags=flags+1;

A(i,p+1)=y(1,1);

else

continue;

end

end

i

flags

for j=1:k

Asum=0;

[r,c]=find(A(:,p+1)==j);

cid(j,:)=mean(A(r,:),1);

for m=1:length(r)

Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2));

end

Csum(1,j)=Asum;

end

sum(Csum(1,:))

%if sum(Csum(1,:))>Csum2

% break;

%end

Csum2=sum(Csum(1,:));

Csum;

cid; %得到新的聚类中心

end

times

display('A矩阵,最后一列是所属类别');

A

for j=1:k

[a,b]=size(find(A(:,p+1)==j));

numK(j)=a;

end

numK

times

xlswrite('data.xls',A); %把矩阵A写到excel文件中,保存在工作路径下display('数据已保存为excel格式');。