SAS实现SEM分析

SAS简介,Univariate,Means,Freq过程

data aaaa; input x @@; cards; 1 2 3 4 5 ; proc print; var x; run; 第1~5句构成数据步,其功能是新建一个数 据集,数据集名称为aaaa,并且输入数据, 第6~8句构成过程步,其功能是将数据集 aaaa中变量x的数值在output窗口中输出。

四、SAS中的命名

数据集要有名字,变量要有名字,所以SAS中

对名字(数据集名、变量名、数据库名,等 等)有约定:SAS名字由英文字母、数字、下 划线组成,第一个字符必须是字母或下划线, 名字最多用8个字符,大写字母和小写字母不 区分。比如,name,abc,aBC,x1,year12, _NULL_等是合法的名字,且abc和aBC是同一 个名字,而class-1(不能有减号)、a bit (不能有空格)、serial#(不能有特殊字 符)、Documents (超长)等不是合法的名 字。

SAS程序(Editor窗口)

另一个统计描述的过程:

proc means data=student; *调用means过程; var height; *对变量x进行分析; Class *按sex变量分组统计; by sex; run;

by语句要求数据集按by后的变量排序

SAS程序(Editor窗口)

课外作业:

按性别分组,对本班同学身高,体重, 上网时间,四级成绩等所有定量变量进 行统计描述。

SAS程序(Editor窗口)

编制频数表:

proc freq data=t; *调用freq过程; tables x0/out=t1; *生成一维频数表,并生成 包含频数表数据的数据集t1; run; 必需语句

运行结果(output窗口)

sas数据分析案例

sas数据分析案例SAS数据分析案例。

在实际工作中,数据分析是一项非常重要的工作。

SAS作为一种常用的数据分析工具,被广泛应用于各个行业中。

本文将通过一个实际案例来介绍SAS在数据分析中的应用。

案例背景:某电商公司希望了解其用户的购物行为,以便更好地制定营销策略和提升用户体验。

为了实现这一目标,他们收集了大量的用户购物数据,包括用户的基本信息、购买记录、浏览记录等。

数据准备:首先,我们需要对收集到的数据进行清洗和整理。

这包括去除重复数据、处理缺失值、统一数据格式等工作。

在SAS中,我们可以使用数据步和PROC SQL等工具来完成这些任务。

数据分析:一、用户购买行为分析。

我们可以通过对用户购买记录的统计分析,来了解用户的购买习惯和偏好。

比如,我们可以计算用户的购买频次、购买金额分布、购买时间分布等指标,从而找出用户的消费特点。

二、用户行为路径分析。

除了购买行为,用户在网站上的浏览行为也是非常重要的。

我们可以利用SAS的数据挖掘功能,对用户的浏览记录进行分析,找出用户的行为路径,了解用户在网站上的行为轨迹。

三、用户画像分析。

通过对用户的基本信息进行分析,我们可以建立用户的画像,包括用户的性别、年龄、地域分布等特征。

这些信息对于制定个性化营销策略非常有帮助。

结果呈现:在数据分析完成后,我们需要将分析结果进行可视化呈现。

SAS提供了丰富的图表和报表功能,可以将分析结果直观地展现出来,帮助决策者更好地理解数据。

结论与建议:通过对用户购物数据的分析,我们可以得出一些结论和建议,比如哪些产品更受用户欢迎、哪些时段用户购物活跃度更高、哪些地区的用户消费能力更强等。

这些结论可以为公司的营销策略和产品推广提供参考。

总结:本文通过一个实际案例,介绍了SAS在数据分析中的应用。

SAS作为一种强大的数据分析工具,可以帮助企业更好地理解和利用数据,从而实现商业目标。

以上就是关于SAS数据分析案例的全部内容,希望对大家有所帮助。

应用SASEM进行数据挖掘

成本较高:由于SAS EM是商业软件,其价格相对较高,可能不适合 小型企业和个人用户。

04

开放性不足:与其他开源工具相比,SAS EM的开放性较低,限制了 用户对其进行定制和扩展的能力。

SAS EM的未来发展前景

1 2 3

持续优化与升级

随着技术的不断发展,SAS EM将继续优化算法 和界面,提高数据挖掘的效率和准确性。

案例三:销售预测

总结词

利用SAS EM进行销售预测,通过分析历 史销售数据和市场趋势,预测未来的销 售情况,帮助企业制定合理的生产和销 售计划。

VS

详细描述

在销售预测中,SAS EM通过时间序列分 析方法,分析历史销售数据和市场趋势, 预测未来的销售情况。通过对不同产品、 地区、销售渠道的销售数据进行整合和分 析,SAS EM能够发现销售规律和市场变 化趋势,为企业制定合理的生产和销售计 划提供依据,提高企业的市场竞争力。

应用SAS EM进行数据挖掘

目录

• SAS EM简介 • 数据挖掘流程在SAS EM中的实现 • 案例分析 • SAS EM与其他数据挖掘工具的比较 • 结论

01

SAS EM简介

SAS EM是什么

SAS Enterprise Miner(EM)是SAS公司开发的一款数据挖掘 软件,它提供了一套完整的数据挖掘解决方案,包括数据预处 理、模型构建、模型评估和部署等。

它基于图形化界面,用户可以通过拖放节点的方式进行数据 挖掘任务的构建,无需编写复杂的代码,大大降低了数据挖 掘的门槛。

SAS EM的特点与优势

易用性

高效性

SAS EM提供了直观的图形化界面,用户可 以通过简单的拖放操作完成数据挖掘流程 的构建,无需具备深厚的编程基础。

sas统计分析系统

03 sas统计分析系统的进阶 功能

高级统计分析

多元统计分析

包括多元方差分析、协方差分 析、因子分析、对应分析等, 用于处理多个变量之间的关系

。

生存分析

用于研究生存时间、生存率等 指标,常用于医学、生物学等 领域。

贝叶斯统计

基于贝叶斯定理的统计推断方 法,能够处理不完全数据和复 杂模型。

复杂样本设计分析

适用于复杂样本设计的统计分 析,如分层抽样、聚类抽样等

。

宏编程与自动化

SAS宏语言

使用SAS宏语言编写程序,实现复杂的数据 处理和统计分析流程自动化。

定制报告

使用SAS宏语言定制各种统计报告,满足不 同需求。

批量处理

通过宏编程实现多个任务或程序的批量执行, 提高工作效率。

数据转换

使用SAS宏语言实现数据格式转换、数据清 洗等功能。

数据整理

SAS支持对数据进行分组、排序、合 并等操作,以便更好地组织和展示数 据。

描述性统计分析

频数分析

SAS提供了FREQ和TABULATE过程, 用于计算分类变量的频数和百分比。

描述性统计

PROC MEANS过程可以计算数值变 量的均值、中位数、标准差等描述性 统计量。

推论性统计分析

参数估计

良好的可视化效果

SAS提供了丰富的图表和图形, 可以将数据分析结果以直观的方 式呈现出来,方便用户理解和解 释。

sas统计分析系统的应用领域

商业分析

SAS在商业领域应用广泛,可用 于市场调查、客户分析、销售预 测等方面,帮助企业做出科学决 策。

科研领域

SAS在科研领域主要用于数据管 理和统计分析,如生物医学、社 会科学、经济学等学科的研究。

SAS数据分析常用操作指南

SAS数据分析常用操作指南在当今数据驱动的时代,数据分析成为了企业决策、科学研究等领域的重要手段。

SAS 作为一款功能强大的数据分析软件,被广泛应用于各个行业。

本文将为您介绍 SAS 数据分析中的一些常用操作,帮助您更好地处理和分析数据。

一、数据导入与导出数据是分析的基础,首先要将数据导入到 SAS 中。

SAS 支持多种数据格式的导入,如 CSV、Excel、TXT 等。

以下是常见的导入方法:1、通过`PROC IMPORT` 过程导入 CSV 文件```sasPROC IMPORT DATAFILE='your_filecsv'OUT=your_datasetDBMS=CSV REPLACE;RUN;```在上述代码中,将`'your_filecsv'`替换为实际的 CSV 文件路径,`your_dataset` 替换为要创建的数据集名称。

2、从 Excel 文件导入```sasPROC IMPORT DATAFILE='your_filexlsx'OUT=your_datasetDBMS=XLSX REPLACE;RUN;```导出数据同样重要,以便将分析结果分享给他人。

可以使用`PROC EXPORT` 过程将数据集导出为不同格式,例如:```sasPROC EXPORT DATA=your_datasetOUTFILE='your_filecsv'DBMS=CSV REPLACE;RUN;```二、数据清洗与预处理导入的数据往往存在缺失值、异常值等问题,需要进行清洗和预处理。

1、处理缺失值可以使用`PROC MEANS` 过程查看数据集中变量的缺失情况,然后根据具体情况选择合适的处理方法,如删除包含缺失值的观测、用均值或中位数填充等。

2、异常值检测通过绘制箱线图或计算统计量(如均值、标准差)来检测异常值。

对于异常值,可以选择删除或进行修正。

3、数据标准化/归一化为了消除不同变量量纲的影响,常常需要对数据进行标准化或归一化处理。

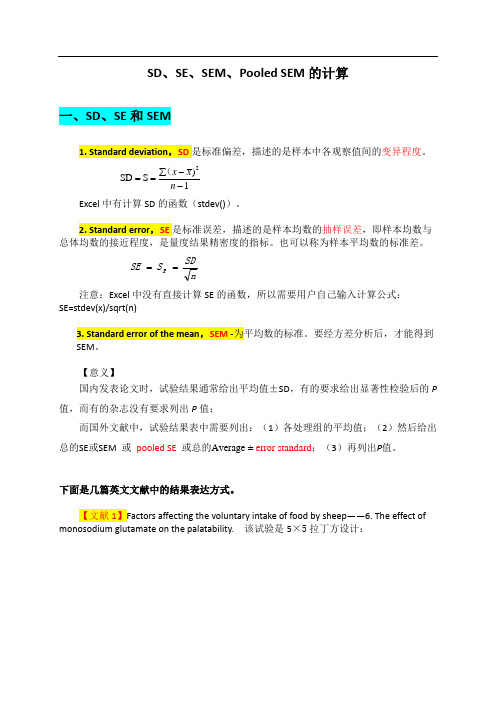

SD、SE、SEM、pooles-SEM的计算

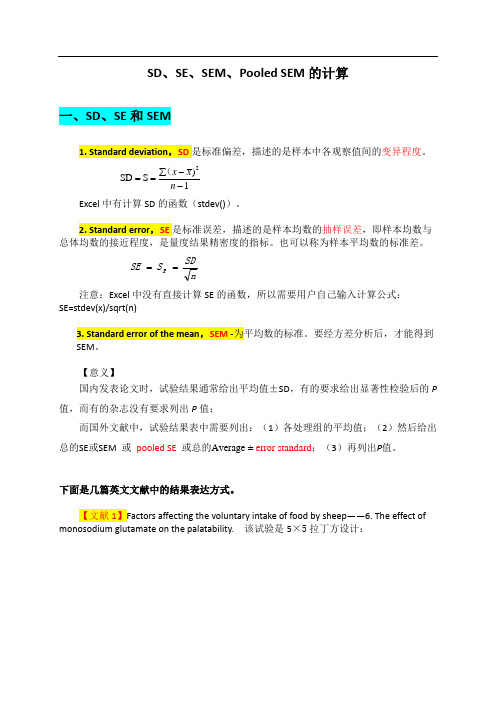

SD 、SE 、SEM 、Pooled SEM 的计算一、SD 、SE 和SEM1. Standard deviation ,SD 是标准偏差,描述的是样本中各观察值间的变异程度。

1)S SD 2--∑==n x x (Excel 中有计算SD 的函数(stdev())。

2. Standard error ,SE 是标准误差,描述的是样本均数的抽样误差,即样本均数与总体均数的接近程度,是量度结果精密度的指标。

也可以称为样本平均数的标准差。

nSD S SE x == 注意:Excel 中没有直接计算SE 的函数,所以需要用户自己输入计算公式:SE=stdev(x)/sqrt(n)3. Standard error of the mean ,SEM -为平均数的标准。

要经方差分析后,才能得到SEM 。

【意义】国内发表论文时,试验结果通常给出平均值±SD ,有的要求给出显著性检验后的P 值,而有的杂志没有要求列出P 值;而国外文献中,试验结果表中需要列出:(1)各处理组的平均值;(2)然后给出总的SE 或SEM 或 pooled SE 或总的Average ± error standard ;(3)再列出P 值。

下面是几篇英文文献中的结果表达方式。

【文献1】Factors affecting the voluntary intake of food by sheep ——6. The effect of monosodium glutamate on the palatability. 该试验是5×5拉丁方设计:表中解释:SE=SQRT (误差均方/n )= SQRT (MSe/n )文献1表2中的SE 即是SEM ,就是方差分析表中的误差均方除以n 再开方,即SEM=,也即x s 即在进行邓肯氏多重比较时的检验样本平均数的标准误(n=5)此处。

SEM 的计算(1)SPSS 分析系统的输出结果中,SEM 为“估计边际均值”表中“标准 误差”项【例1】 四种饲料对仔猪增重的影响group gain (kg ) 2 33 39 41 33 34 35 3 23 25 23 29 28 20 42824252220231)当重复数相等(均衡数据)时,获得SEM 的操作是:选择“GLM ”,在“选项”,在“估计边际均值”框,将“group ”变量选入右侧“显著均值”框中。

SASSAS基本统计分析功能

方差齐时,检验两样本的均值是否相同的零假设为H0:

两个独立样本的来自均值相等的总体,即 1 2 ,

检验统计量为

t X1 X2

Sc

11 n1 n2

t(n1 n2 2)

其中 Sc

为合并方差。 (n1 1)S12 (n2 1)S22

n1 n2 2

方差不齐时,检验两样本的均值是否相同,用校正t检验。

W值越接近于1,P值越大,表明资料越服从正态分布

当n>2000时,应用Kolmogorov-smirnov 检验法,检验统计

量为

D max 1in

fn ( Xi ) F (x) , fn ( Xi1) F(x)

D值越小,P值越大,表明资料越服从正态分布。

第2页/共97页

2.举例 在proc univariate语句中加上normal选项可

1.背景原理:正态分布是一种最常见的连续型分布 它以均值为对称轴呈对称的钟型分布。

检验的零假设Ho:数据资料服从正态分布。备择假设H1:

数据资料不服从正态分布。

当样本量n≤2000时,应选用shapiro-wilk检验法,检验统计

量为 W ai (X(xi1) Xi )2 / (Xi X )2

4.1 假设检验

正态性检验(univariate过程) 单样本均值的T检验(univariate过程) 两 独 立 样 本 均 值 检 验 ( TTest 过 程 \npar1way过程 ) 两 相 关 样 本 均 值 检 验 ( Univariate 过 程)

返回

第1页/共97页

4.1.1 正态性检验(univariate过程)

第25页/共97页

2.实例分析

为了检验两个相关样本的均值是否有显著差异,先用一个 数据步计算差值,然后对差值变量用univariate过程可以 实现检验差值变量的均值是否显著为零。

SAS EM实例进阶

SAS EM实例进阶Created by:Ning Gang****************HP GDCC GAPSE2008-12-29 1.SAS Enterprise Miner简介1.1. 数据挖掘简介数据仓库的发展,为分析人员提供了在各种层次上、历史回溯的数据信息。

对未来的信息要进行预测,这就演化出来数据挖掘技术。

数据挖掘(Data Mining)就是从大量的、不完全的、有噪声的、模糊的、随机的实际应用数据中,提取隐含在其中的、人们事先不知道的、但又是潜在有用的信息和知识的过程。

目前数据挖掘应用于很多行业中,来解决众多的商业问题,如数据库营销(Database Marketing)、客户群体划分(Customer Segmentation & Classification)、背景分析(Profile Analysis)、交叉销售(Cross-selling)等市场分析行为,以及客户流失性分析(Churn Analysis)、客户信用记分(Credit Scoring)、欺诈发现(Fraud Detection)等等。

1.2. EM简介SAS Enterprise Miner简称EM,它把统计分析系统和图形用户界面(GUI)紧密结合,对用户友好、直观、灵活、使用方便,使对统计学无经验的用户也可以理解和使用。

SAS定义了数据挖掘方法——SEMMA方法,即抽样(Sample)、探索(Explore)、修改(Modify)、建模(Model)、评价(Assess)。

以下SEMMA方法从SAS Help文档中拷贝,不再翻译以求理解准确。

∙Sample the data by creating one or more data tables. The sample should be large enough to contain the significant information, yet smallenough to process.∙Explore the data by searching for anticipated relationships, unanticipated trends, and anomalies in order to gain understanding and ideas.∙Modify the data by creating, selecting, and transforming the variables to focus the model selection process.∙Model the data by using the analytical tools to search for a combination of the data that reliably predicts a desired outcome.Assess the data by evaluating the usefulness and reliability of the findings from the data mining process.EM建立分析流程中,不必包含SEMMA方法每一步,同时其中的步骤可以重复出现。

掌握使用SAS软件进行统计分析和数据挖掘的技巧与方法

掌握使用SAS软件进行统计分析和数据挖掘的技巧与方法第一章:SAS软件简介SAS(Statistical Analysis System)软件是一款功能强大的统计分析和数据挖掘工具。

它提供了丰富的功能模块和强大的数据处理能力,广泛应用于各个行业中的数据分析领域。

本章将介绍SAS软件的基本特点、应用领域以及安装和配置方法。

第二章:数据导入和预处理在进行统计分析和数据挖掘之前,首先需要将原始数据导入SAS软件,并进行一系列的预处理操作。

本章将介绍如何使用SAS软件导入各种数据文件(如CSV、Excel、数据库等),并对数据进行清洗、缺失值处理、异常值处理等预处理工作。

第三章:基本统计分析SAS软件提供了丰富的统计分析功能,包括描述性统计、假设检验、方差分析、回归分析等。

本章将介绍如何使用SAS软件进行基本的统计分析,包括计算各种统计指标、进行假设检验、分析方差源等。

第四章:数据挖掘数据挖掘是从大量的数据中发现隐藏的模式和规律,并进行预测和决策的过程。

SAS软件提供了多种数据挖掘算法和工具,包括聚类、分类、关联规则挖掘等。

本章将介绍如何使用SAS软件进行数据挖掘,包括选择合适的算法、调整参数、评估模型效果等。

第五章:高级统计分析除了基本的统计分析方法,SAS软件还提供了一些高级的统计分析工具,如因子分析、主成分分析、判别分析等。

这些方法可以帮助用户更好地理解数据和变量之间的关系,挖掘潜在的因素和结构。

本章将介绍如何使用SAS软件进行高级的统计分析,并提供一些案例来说明其应用。

第六章:可视化展示数据可视化是将数据以直观的图表形式展现,有助于用户更好地理解数据之间的关系和趋势。

SAS软件提供了丰富的可视化工具和图形语法,可以方便快捷地生成各种图表。

本章将介绍如何使用SAS软件进行数据可视化,并提供一些实例来说明不同图表的应用场景。

第七章:自动化和批处理对于大规模的数据分析和处理任务,手动操作无疑是非常耗时和繁琐的。

sas案例分析

sas案例分析SAS案例分析。

SAS(Statistical Analysis System)是一种统计分析系统,被广泛应用于数据分析、数据挖掘、预测分析等领域。

它提供了丰富的数据处理和分析功能,能够帮助用户有效地进行数据探索和建模分析。

下面我们将通过一个实际案例来展示SAS在数据分析中的应用。

某电商公司希望通过分析用户行为数据,提高用户留存率和购买转化率。

为了实现这一目标,他们收集了大量的用户数据,包括用户的浏览记录、购买记录、点击广告的行为等。

接下来,我们将使用SAS对这些数据进行分析,以期找到一些有益的信息。

首先,我们将对用户的浏览记录进行分析。

通过SAS的数据处理功能,我们可以对用户的浏览行为进行统计,比如哪些商品被浏览次数最多,用户在网站停留的平均时间等。

这些信息可以帮助我们了解用户的兴趣和偏好,从而为后续的推荐系统提供依据。

其次,我们可以利用SAS对用户的购买记录进行分析。

通过对用户购买行为的统计分析,我们可以找到哪些商品的销量最好,哪些用户购买频率较高,哪些商品组合销售效果较好等。

这些信息可以帮助我们优化商品推荐和营销策略,提高用户的购买转化率。

此外,我们还可以通过SAS对用户的点击广告行为进行分析。

通过对广告点击率、转化率等指标的统计分析,我们可以找到哪些广告的效果较好,哪些广告的点击率较高,哪些广告的转化率较低等。

这些信息可以帮助我们优化广告投放策略,提高广告的转化效果。

最后,我们可以利用SAS进行用户群体分析。

通过对用户数据的聚类分析,我们可以找到不同用户群体的特征和行为模式,从而为不同群体的用户制定个性化的营销策略和推荐策略。

通过以上分析,我们可以看到SAS在数据分析中的强大功能。

它能够帮助我们从海量的数据中找到有用的信息,为企业决策提供有力支持。

希望通过这个案例的介绍,能够让大家对SAS在数据分析中的应用有一个更深入的了解。

学习使用SAS进行数据处理与分析

学习使用SAS进行数据处理与分析第一章:介绍SAS及其应用领域SAS(Statistical Analysis System)是由SAS Institute开发的一种统计分析软件。

它是一个功能强大的工具,用于数据处理、数据分析和预测建模等任务。

SAS广泛应用于各个领域,如金融、医疗、市场研究等,可以帮助用户从数据中挖掘有价值的信息。

第二章:SAS环境及基本操作在开始使用SAS之前,我们首先需要了解SAS的运行环境和基本操作。

SAS提供了多种版本,包括SAS Base和SAS Enterprise。

在Windows操作系统上,我们可以通过SAS界面进行操作,也可以通过编写SAS程序进行批量处理。

在本章中,我们将介绍SAS的安装和配置,以及SAS界面和常用的命令。

第三章:数据导入与导出数据导入是数据处理的第一步,也是最重要的一步。

SAS支持导入多种数据格式,如CSV、Excel、Access等。

我们可以使用SAS提供的导入工具,也可以通过编写SAS程序进行导入。

此外,SAS还支持将处理结果导出为各种数据格式,方便与其他软件进行交互。

第四章:数据清洗与转换在实际应用中,原始数据往往存在一些问题,如缺失值、异常值、重复值等。

数据清洗是为了使数据符合分析的要求,需要进行缺失值填充、异常值处理、数据规范化等操作。

SAS提供了丰富的函数和工具,可以方便地进行数据清洗和转换。

第五章:数据探索与可视化数据探索是数据分析的关键步骤之一。

通过统计指标、频率分布、散点图等方式,我们可以了解数据的分布情况、变量之间的关系等。

SAS提供了多种统计分析和可视化功能,如描述统计、相关分析、箱线图、直方图等,可以帮助用户深入了解数据。

第六章:数据建模在数据分析的过程中,我们往往需要基于数据构建一个模型,用于预测或分类。

SAS提供了多种建模技术,包括线性回归、逻辑回归、决策树、支持向量机等。

在本章中,我们将介绍SAS中常用的建模方法和建模步骤,并通过实例演示如何进行模型构建和验证。

医用SAS统计分析(五)

SAS在临床试验中的应用

SAS在临床试验中被广泛应用于数据管理和分析。它可以帮助研究人员设计试 验、收集和清理数据,并进行有效的统计分析,从而得出准确的结论和研究 结果。

SAS混合效应模型

SAS混合效应模型是一种适用于具有多层次数据结构的统计方法。它可以同时 考虑固定效应和随机效应,并帮助我们理解不同级别的变量对观察结果的影 响。

SAS的结构方程模型(SEM)

SAS的结构方程模型(SEM)是一种多变量统计方法,用于研究变量之间的因果关系。它可以帮助我们建立和 验证复杂的理论模型,从而深入理解变量之间的相互关系。

SAS的因分析

SAS的因子分析是一种用于提取变量之间潜在关系的统计方法。它可以帮助我 们降维,理解变量背后的共享信息,并发现潜在的构建性维度。

其他SAS的分类和聚类方法

SAS还提供了其他分类和聚类方法,如K-means聚类、决策树、支持向量机等。这些方法可以帮助我们对数据进 行分类和预测,并获得有关数据结构的深入了解。

医用SAS统计分析(五)

SAS的Logistic Regression分析是一种常用的统计方法,可用于预测二元变量的 概率。通过分析自变量和因变量之间的关系,可以得到预测结果并进行推断。

Survival Analysis分析

Survival Analysis是一种用于研究个体在特定时间内存活或发生事件的统计方法。 通过对生存数据进行建模和分析,可以得出不同因素对生存时间的影响。

SAS-EM决策树案例

SAS-EM决策树案例决策树主要用来描述将数据划分为不同组的规则。

第一条规则首先将整个数据集划分为不同大小的子集,然后将另外的规则应用在子数据集中,数据集不同相应的规则也不同,这样就形成第二层数据集的划分。

一般来说,一个子数据集或者被继续划分或者单独形成一个分组。

1 预测模型案例概述一家金融服务公司为客户提供房屋净值贷款。

该公司在过去已经拓展了数千净值贷款服务。

但是,在这些申请贷款的客户中,大约有20%的人拖欠贷款。

通过使用地理、人口和金融变量,该公司希望为该项目建立预测模型判断客户是否拖欠贷款。

2 输入数据源分析数据之后,该公司选择了12个预测变量来建立模型判断贷款申请人是否拖欠。

回应变量(目标变量)标识房屋净值贷款申请人是否会拖欠贷款。

变量,以及它们的模型角色、度量水平、描述,在下表中已经显示。

SAMPSIO.HMEQ数据集中的变量,SAMPSIO库中的数据集HMEQ包括5960个观测值,用来建立和比较模型。

该数据集被划分为训练集、验证集和测试集,从而对数据进行分析。

3 创建处理流程图添加结点连接结点定义输入数据为了定义输入数据,右键输入数据源结点,选择打开菜单,弹出输入数据对话框。

默认情况下,数据选项卡是激活的。

点击select按钮选择数据集,4 理解原数据样本所有分析包在分析过程中必须定义如何使用这些变量。

为了先对这些变量进行评估,EM采用元数据方式处理。

默认方式下,它从原始数据集中随即抽取2000个观测样本,用这些信息给每个变量设置模型角色和度量水平。

它也计算一些简单统计信息显示在附加选项卡中。

如果需要更多的样本量,点击右下角的Change按钮,设置样本量。

评估这些元数据创建的赋值信息,可以选择变量选项卡查看相关信息。

从图中可以发现,Name列和Type列不可用。

这些列表示来自SAS数据集的信息在这个结点中不能修改。

名称必须遵循命名规范。

类型分为字符型和数值型,它将影响该变量如何使用。

多重链式中介效应stata的sem命令

多重链式中介效应是指一个或多个中介因素在一个或多个关系之间发挥作用的过程。

在社会科学研究中,此类效应经常被用来研究复杂的因果关系。

为了分析这种效应,研究者需要使用统计软件来进行数据分析。

Stata是一种常用的统计分析软件,它提供了一个命令叫做sem,用于进行结构方程建模分析。

在本文中,我们将介绍如何在Stata中使用sem命令来分析多重链式中介效应。

1. 理解多重链式中介效应在开始之前,首先需要理解多重链式中介效应的概念。

多重链式中介效应是指一个或多个中介变量在一个或多个关系中起着中介作用。

假设我们想研究情绪对工作绩效的影响,我们可能会发现情绪通过影响员工满意度,从而影响工作绩效。

在这种情况下,员工满意度就是一个中介变量,在情绪和工作绩效之间发挥作用。

在实际研究中,可能存在多个这样的中介变量,它们形成了多重链式中介效应。

2. 输入数据在使用Stata进行多重链式中介效应分析之前,首先需要准备好数据。

数据应该包括所有需要分析的变量,包括自变量、中介变量和结果变量。

一般来说,变量应该以数值形式输入,并且可以进行缺失值处理。

一旦数据准备好,就可以开始使用Stata进行分析。

3. 运行sem命令在Stata中,sem命令用于进行结构方程建模分析。

结构方程建模是一种统计方法,用于评估观察变量之间的因果关系。

在进行多重链式中介效应分析时,可以使用sem命令来构建一个包含自变量、中介变量和结果变量的模型,并评估它们之间的关系。

sem命令提供了丰富的参数设置选项,可以根据实际需求来进行调整。

4. 检验模型拟合度在运行sem命令后,需要对模型的拟合度进行检验。

模型的拟合度可以通过多种指标来评估,包括卡方拟合度检验、比较拟合指数、根均方误差等。

这些指标可以帮助研究者判断模型是否合理拟合观察数据,从而进行后续的参数估计和效应检验。

5. 估计参数和效应检验一旦模型的拟合度得到确认,就可以开始估计模型参数并进行效应检验。

数据分析方法 sas

数据分析方法sas

SAS(Statistical Analysis System)是一种常用的数据分析方法,它是一套软件系统,利用统计分析和数据管理等技术,对大规模复杂数据进行处理、分析和挖掘。

以下是SAS的一些常见数据分析方法:

1. 描述性统计分析:通过计算各种统计指标(如均值、中位数、标准差等)来描述数据的特征和分布。

2. 数据预处理:对原始数据进行清洗、处理和转换,包括处理缺失值、异常值和重复值,变量的标准化或归一化等。

3. 假设检验:通过对比实际数据和理论假设,判断某个因素对数据的显著影响,例如t检验、方差分析、卡方检验等。

4. 方差分析(ANOVA):用于分析多个因素对数据之间差异的影响,并判断因素之间是否存在显著差异。

5. 回归分析:通过建立回归模型,探究自变量与因变量之间的关系,并预测因变量的值。

6. 聚类分析:将数据按照相似性进行分组,发现其中的内在结构和模式。

7. 因子分析:将大量的变量简化为少数几个综合指标(因子),以揭示变量背后的潜在变量结构。

8. 决策树:通过构建分类或回归树,对数据进行分组或预测。

9. 关联规则分析:通过挖掘大量事务数据中的频繁项集,找出项集之间的关联关系,用于市场篮子分析、交叉销售等。

以上只是SAS的一部分数据分析方法,SAS还包括更多的统计方法和机器学习算法,可以根据具体问题和需求选择合适的方法进行数据分析。

SAS案例分析于应用

Using SAS Enterprise Miner (Version 4.2) - SEMMA1. Starting Enterprise Miner 22. SEMMA – Data Mining Process Used in Enterprise Miner 33.S ample 73.1 Input Data Source node 73.2 Data Partition node 134.E xploration with INSIGHT node 145.M odify 175.1 Modify with Transformation node 175.2 Modify with Replacement node 226. Fitting Candidate M odels 267.A ssessing Candidate Models and Scoring New Data Set 28 Appendix 1 Data Used in Lecture 33 Appendix 2 References 341. Starting Enterprise Miner1.Type Miner in the command box (or by Selecting Solutions -> Analysis ->Enterprise Miner) to start Enterprise Miner2.Select File -> New -> Project to start a new project3. Before select the Create, you need to•Type your project title (such as My Project) in the Name box•Check the box for Client/Server project only if you want to create a client server project•Modify the location of the project if desired by selecting Browse2. SEMMA – Data Mining Process Used in Enterprise MinerSEMMA stands for S ample, E xplore, M odify, M odel, and A ssess. Enterprise Miner arranged data mining tools according SEMMA.•S ample:¾Input Data Source Node: The "Input Data Source" node reads data sources and defines their attributes.It enables the user to access SAS data sets and data marts.It automatically creates the meta-data sample for each variable when you import a data set with the Input Data Source node.It sets the initial values for the measurement level and the model role for each variable.It displays summary statistics for interval and class variables.It enables you to define target profiles and prior probabilities for each target variable.We will examine this node again in Section 3.1.¾Sampling Node: The "Sampling" node enables you to take simple random, stratified random, and cluster samples from the origin data set. For extremelylarge database, it is very important to select a sample because it can savemodel-training time significantly. In addition, the result found from a sampleshould be expected to be similar to the result found with the entire data if thissample is representative. However, we will not use this node much inclassroom instruction since most classroom data sets have relatively small insize.¾Data Partition Node: The "Data Partition" node enables you to partition the entire data set into three subsets: training, testing, and validation data sets.The training data set is used for model fitting. The validation data set is usedto monitor and tune the model during estimation and it can be used for modelassessment. The test data set is an additional holdout data set that can be usedfor model assessment. This node uses simple random, stratified random, oruser defined method to create partitioned data sets. This node will beaddressed in Section 3.2.•E xplore:¾Distribution Explore Node: The "Distribution Explore" node is a visualization tool that enables you quickly and easily to explore large volumeof data in multidimensional histograms. You can view distribution of up tothree variables at a time with this node. It also allows you to exclude extremevalues for interval and ordinal variables.¾Multiplot Node: The “Multiplot” node is another visualization tool that enables you to explore larger volume of data graphically. Unlike two othervisualization tools, Insight and Distribution Explore, the Multiplot node automatically creates bar charts and scatter plots for the input and target variables without asking any user input and the SAS code used to create these plots are available for batch run as well.¾Insight Node: SAS/INSIGHT is an interactive tool for data exploration and descriptive analysis. One can analyze univariate distributions, investigate multivariate distributions, and fit explanatory models using generalized linear models. This node will be examined in Section 4.¾Association Node: The association node enables you to identify association relationships within the data.¾Variable Selection Node: The “Variable Selection” node enables you to evaluate the importance of input variables in predicting or classifying the target variable. Both Chi-square (tree based) and R-square selection criteria are available. Although this node is part of the data exploration tools, it is more like a data preparation tool and will be discussed when we discussed how to perform variable selection.•M odify:¾Data Attributes Node: The data set attributes node enables one to modify data set attributes, such as data set names, descriptions, and roles.¾Transform Variable Node: This node enables one to transform variables.Variable transformation can improve the performance of some data mining techniques such as decision trees, neural network and logistic regression.This nodes support user defined formulas for variable transformation.This nodes support several standard variable transformation methods such as log transformation and square root transformation.This nodes support bins interval variables into buckets using a decision tree based algorithm.We will discuss this node in Section 5.1.¾Filter Outliers Node: This node enables one to identify and remove outliers from data sets.¾Replacement Node: This node enables one to impute values for observations that have missing values. We will discuss this node in Section 5.2.¾Clustering Node: This node enables one to segment data. Observations that are similar to each other tend to be in the same cluster and observations that are different to each other tend to be in different cluster. The cluster identifier for each observation can be passed to other nodes for use as an input, ID, or target variable.It can also be passed as a group variable that enables you toautomatically construct separate models for each group. We will examine this node when we discuss clustering analysis.¾SOM/Kohonen Node: This node can generate self-organizing map, Kohonen networks, and vector quantization networks. This node can be used to understand the structure of the data. In addition, it provides a report that indicates of the importance of each variable. We will examine this node when we discuss clustering analysis.•M odel:¾Regression Node: This node enables one to fit both linear and logistic regression models. The target variable can be continuous, nominal, and binary variables. The input variables can be either interval (continuous) or classification (discrete) variables. The node supports stepwise, forward, and backward selection methods. It also has interaction builder to help one to create higher-order and interaction terms for the model.¾Tree Node: This node enables one to build CART like tree, CHAD like tree, and hybrid tree and will be examined when we discuss “Decision Trees”modeling technique.¾Neural Network Node: This node enables you to build, train, and validate multilayer feed-forward neural networks. Neural network is a universal model builder, i.e.; it can be used to build any generalized linear models or non-linear models.¾User Defined Node: This node allows you to generate assessment statistics using predicted values from a model that you build with SAS code node or the variable select node. The predicted values can also be saved to a SAS data set and then imported into the process flow with Input Data source node.¾Ensemble Node: This node uses bagging or boosting technique to create new model by averaging the posterior probabilities (for discrete target variable) or the predicted values (for continuous target variable) from multiple models.The new model has the potential to have better performance than each of the original input model.•A ssess:¾Assessment Node: The “Assessment” node provides a common framework for comparing models and predictions from any of the modeling nodes. The comparison is based on the expected and actual profits or losses that would result from implementing the model. The node produces the following charts that help to describe the usefulness of the model: lift profit, return of investment, receiver operating curve, diagnostic charts, and threshold-based chart.¾Score Node: The Score node enables you to generate and manage predicted values from a trained model. Scoring formula is created for both assessmentand prediction.¾Reporter Node: The Reporter node assembles the results from a process flow analysis into a HTML report that can be viewed with your favorite webbrowser.In addition, there are some utility nodes to help you to organize your data mining flow. The utility nodes include SAS Code node, Control Point node, Subdiagram node, Data Mining Data Base node, and Group Processing node.•Utility Nodes:¾Group Processing Node: This node enables the user to perform analysis for each level of a class variable and process the same data source repeatly.¾Data Mining Database Node: This node enables the user to create a data-mining database (DMDB) for batch processing.¾SAS Code Node: This node can be used to incorporate new or existing SAS code into process flow diagram.¾Control Point Node: This node enables the user to establish a control to reduce the number of connections in the process flow diagram.¾Sub-diagram Node: This node enables the user to group a portion of a diagram into a sub-diagram. The user can organize very complicate processflow easier with sub-diagram node.3. S ample3.1 Input Data Source node:•Click SELECT to select the data setIn this example, you can choice the library, "DLEC1" and data set, "DONORS". •This data set has 6,974 observations (rows) and 21 variables (columns).There is a metadata sample that has 2000 observations.¾The Enterprise Miner utilizes metadata in order to make a preliminary assessment of how to use each variable. By default, it takes a random sampleof 2000 observations from the entire data set.¾Any numerical variable with more than 10 distinct levels in the metadata sample will assign the measurement level to interval and the model role toinput by default.¾Any variable with two non-missing levels in the metadata sample will assign the model role to input and the measurement level to binary by default.¾Any character variable that has more than two non-missing levels will assign the measurement level to nominal and model role to input.¾Any numerical variable with more than two and less than ten distinct levels in metadata sample will assign the measurement levels to ordinal and the modelrole to input.¾Any variable with only one non-missing level will assign the measurement level to unary and the model role to “rejected”.¾For a variable with nominal measurement level and has distinct value for every observation in the metadata sample will assign the model role to id.¾The metadata sample is not able to assign model role target to any variable. You have to set the model role “target” by yourself.¾Observe that there are two gray columns, “Name” and “Type”. These two columns represent information from the SAS data set that cannot be changedin this node. All the rest information can be changed.•Inspecting Distributions with Metadata SampleYou can do data exploration in this node as well. For example, you can view thedistribution of variable “TARGET_B”.interval variables¾Select the “Class Variables”tab to view the descriptive statistics for class variables such as PET and PCOWNERS¾Although data exploration can be partially performed in “Data Source” node, the main goal for inspecting variables in this node is to specify the correct model role and measurement level for each variable. Data exploration can be performed with other nodes such as “INSIGHT” and “Distribution Explore”node.•Modifying Model Role and Measurement Levels¾Modify the model role and measurement levels for PETS and PCOWNERS ¾Set the model role for both variables to input and the measurement levels to binary¾Set the model role for TARGET_B to “target” and the model role for TARGET_D to “rejected”•Using the Target ProfileWhen building predictive models, the "best" model often varies according to the criteria used for evaluation or comparison. The most popular criterion of selecting the best model is “prediction accuracy”. However, this criterion might not suitable in many applications because different mistakes cost differently. The recommend criterion method is to define a profit matrix based on the cost-profit structure for each mistakes and then to use the highest expected profit as a basis of selecting the best model.¾Specify the Profit Matrix:For example, the cost of sending someone a mailing is $0.68 and the median donation for a donor is $13.00. Therefore, to send a mailing to someone that would not respond costs $0.68, but failing to mail to someone that would have responded costs $12.32 in lost revenue.The following steps can set the profit matrix:Position the mouse over the row for TARGET_B and right-clickSelect Edit Target ProfileSelect Yes if no target profile found message appearsEnter “My Profile” as the description for the new profile (current called profile)Position the mouse over the newly create profile and right-click and select “Set to use” if it is not in useSelect the Target tab to see the information about the target variable, Target_BSelect the Levels subtab to view the frequency information of the target variableSelect the Assessment Information tab to add the Profit Matrix1.Right-click in the open area where the vectors and matrices are listedand select Add2. A new Profit Matrix is formed3.Type My matrix is the name field and press the Enter key4.Type 12.32 in (1,1) cell, -0.68 in (0,1) cell, and 0 in (0,0) cell to reflectthe profit discussed5.Right-click on My matrix and select Set to use6.You can select the Edit Decisions subtab when you want to change thedefault to maximum profit with cost or minimum loss options¾Specify the Prior Probabilities:To have balance data in each category of the target variable is a good practice in building prediction or classification models. Typically, one would like to over sample the category that has less than 50% in the population. For example, the true response rate for donation requests is 5%. Since the data used in building the classification model in this example has 47.94% response rate, we must specify the prior probabilities in the target profile to reflect the difference.The following steps can set the prior probabilities:Select the Prior tab to modify the prior probabilities1.Right-click in the open area where the prior profiles are activated andselect Add to add a new prior vector2.Highlight the new prior profile by selecting Prior vector3.Modify the prior vector to represent the true proportion in thepopulation (0.05 when target value is 1 and 0.95 when target value is0)4.Right-click the Prior vector and select Set to Use3.2 Data Partition nodeData partition is necessary in building a predictive model because you need to reserve some data to honestly evaluate the performance of the model. Since some model building tools such as neural network and decision tree need to use a portion of data to monitor and tune the model building process, an additional sub-dataset is needed. By default, Enterprise Miner takes a simple random sampling to divide the input data set into training (40%), validation (30%), and testing (30%) data sets. However, it also supports stratified random sampling and user-defined sampling. In addition, you can use either “Clustering” or “SOM/Kohonen” node before the “Data Partition” node to perform cluster sampling.In data partition nodes, you can•select the sampling methods•select the seed for initializing the sampling process•select the percentages of the data to be allocated to training, validation, and testing data sets.In this example, you need to•select the “Stratified” sampling method•click the “Stratification” Tab and set “Target_B” to “use”•keep the default seed, “12345”•change the percentage of the data to be allocated to training (67%), validation (33%), and testing (0%) data sets.4. Data Exploration with Insight NodeBy default the Insight node will select a random sample of 2000 observations from the training data set. In SAS Enterprise Miner, the name of the training data set created by the Data Partition node will have a prefix TRN and other five random alphanumeric characters. Similarly, the name of the validation data set will have a prefix VAL followed by five random alphanumeric characters.In this example, you might want to use the entire training data set to perform preliminary examination because the entire training data set only has 4673 observations. You can select the radio button next to Entire data set to run Insight using the entire training data set.After run the Insight nodes, you can look at the distribution for each of the variables as follows:1.Select Analyze -> Distribution (Y)2.Highlight all the variables except IDCODE in the variable list3.Click Y4.Highlight IDCODE5.Select Label6.Select OKCharts for continuous variables include histograms, box and whisker plots, and assorted descriptive statistics. Charts for categorical variables include histograms.Some general comments about these distributions are as follows:1.AGE: roughly symmetric and no need to do any transformation2.HOMEOWNR: There are three categories, "H" (home owner), "U"(unknown), and "Missing". Since both missing and unknown provide sameinformation, we can combine these two categories together.3.INCOME: INCOME should be treated as a numerical variable, i.e., has themeasurement levels should be set to interval if it is not.4.GENDER: There are more female than male in the training data set. Themissing level for GENDER should be recoded to FEMALE or use the method discussed in Lecture 2 to recode the GENDER variable.5.MALEMILI: The MALEMILI is a very skew numerical variable. It might bebetter to be binned into three or four bins. Section 5.1 will discussed how to perform optimal binning based ob the relationship with the target variable.6.MALEVET: This variable is symmetric if there is not a spike close to 0.7.LOCALGOV, STATEGOV, and FEDGOV: All three variables are skew tothe right and log transformation should be used.8.PETS and PCOWNERS: The missing values for both variables should berecoded to "U", unknown.9.CARDPROM and NUMPROM: Both variables look fine.10.CARDGIFT and TIMELAG: Both are skew to the right and should performlog transformation.11.AVGGIFT: This variable is very skew. The best way to handle this variableis to use bins.STT: It is okay.13.FIRSTT: It has an extreme large value that can be deleted.14.TARGET_B and TARGET_D: It does not matter so far.5. ModifyData exploration offers you an opportunity to explore the data. Typically, you will find some problems about the data such as missing value, skewness, and outliers. In Section 4, you found that HOMEOWNR, GENDER, MALEMILI, LOCAOLGOV, STATEGOV, FEDGOV, PETS, PCOWNERS, CARDGIFT. TIMELAG, AVGGIFT, and FIRSTT all have problems and need to be modified before building any predictive model. You can use “Transformation Variable” node and “Replacement” node to fix these problems.5.1 Modify with Transform Variable NodeThe Transform Variables node enables you to create new variables that are transformations of existing variables in data. You can choose from the following types of transformations in the Transform Variables node:•Simple Transformations: log, square root, inverse, square, exponential, and standardize•Binning Transformations: bucket, quantiles, and optimal binning for relationship to targetBucket: It creates cutoffs at approximately equally spaced intervals.Quantiles: It creates bins with approximately equal frequencies.Optimal Binning Based on Relationship with Target variable: The “Optimal Binning for Relationship to Target” transformation uses the decisiontrees methodology to optimally split a variable into n groups with regards to abinary target. This binning transformation is useful when there is a nonlinearrelationship between the input variable and the binary target. An ordinalmeasurement level is assigned to the transformed variable. To create the noptimal groups, the node applies a recursive process of splitting the variableinto groups that maximize the association with the target values. To determinethe optimum groups and to speed processing, the node uses the metadata asinput. To create the first split (grouping), the node divides the variable valuesinto 64 equally spaced bins. The 64 bins are then split into 2 groups at thepoint that maximizes the Chi-square value on a Chi-square test ofindependence. The binary target values form the rows of the 2 by 2 table andthe group values form the columns. For example, the maximized Chi-squarevalue may be obtained by dividing the 64 bins into one group that contains 20bins and another group that contains 44 bins.Example Contingency Table for the Chi-square TestBinary Target Group 1 (20 bins)Group 2 (44 bins)Yes18040No84200The split (grouping) is made if the Chi-square value exceeds a cutoff value of3.84. If the Chi-square value for the initial split does not exceed the cutoffvalue, then the input variable is not transformed, and the process stops.After using any binning method to perform transformation, a new variable withordinal measurement level is created to replace the original variable.•Best Power Transformations: maximize normality, maximize correlation with target, and equalize spread with target levelsYou may also create your own transformation or modify a transformation by defining a formula in the Customize window. To transform a transformed variable, you should add another Transform Variables node to the process flow. For example, you may want to transform the target and then transform selected input variables to maximize their relationship with the transformed target.In this example, you need to perform the log transformation on LOCALGOV, STATEGOV, FEDGOV, CARDGIFT, and TIMELAG because the distributions of all these variables are skew to the right. For example, the distribution for the variable TIMLAG after the log transformation looks much better.Then, you can use the bucket-binning method to bin variable MALEMILI. Suppose the optimal choice is to bin values into the interval 0-0, 0-4, and 4+. To do so, you can use the following steps:1.Position the mouse over the row of MALEMILI2.Right-click and choose Transform -> BUCKET3.Change the number of buckets to 34.Select Close5.Enter 0 in the value field for BIN 16.Enter 4 in the value field for BIN 27.Close the plot to return to the previous windowThe distribution for the transformed variable looks much better.Finally, you can use the optimal binning method to bin the variable AVGGIFT. You can use the default number of bins to get the following bins. If some of these bins with only a small percentage of observations, you can reduce the number of bins again to get an optimal number of bins.When you complete, the window should look like the following.5.2 Modify with Replacement NodeThe Replacement node allows you to perform missing value imputation. This replacement is necessary to utilize all of the observations in the training data for building a regression or neural network model. Otherwise, any observations with missing values on any of the input variables will be ignored when building a regression or neural network model.To create missing value indicator variables for all variables with missing values before performing missing value imputation, you need to check the box for “Create imputed indicator variables” and use the arrow to change the Role field to input as shown below. Each of the missing value indicator variables has a prefix "M_" and has a value of "1" when an observation has a missing value for the associated variable and "0" otherwise.Since we want to use the entire training data set for data imputation, we need to follow the following steps. Otherwise the default setting, a meta sample of 2000 observations will be used.1.Select the Data subtab2.Select the Training subtab under the Data tab3.Check the button next to Entire data set4.Return to the Default tabNow, we start to apply imputation method to impute missing values. Replacement node provides the following imputation methods for interval variable:1.Mean(default): the arithmetic average2.Median: the 50th percentile3.Midrange: the sum of maximum and minimum divided by two4.Distribution-based: replacement values are calculated based on the randompercentiles of the variable's distribution5.Tree Imputation: replacement values are estimated using a decision tree basedalgorithm6.Tree Imputation with Surrogates: same as above except using surrogate variables forsplitting whenever a split variable has a missing values7.Mid-minimum spacing:8.Tukey's biweigh, Huber's, and Andrew's wave: these are robust M-estimators of thelocation9.Default constant: set a default constant for some or all variables10.None: turn off the imputation for all interval variablesFor classification variables, Enterprise Miner provides six imputation methods, most frequently values, distribution based, tree imputation, tree imputation with surrogate, default constant, and none.In this example, we use tree imputation as the default imputation method for all variables. To do so, you need to click the Imputation methods subtab under the Defaults tab and change the default method to tree imputation with surrogates for both interval variables and class variables. After you make the above changes, it should look likeSuppose we want to change the imputation method for AGE to mean and CARDPROM to a fix constant 20. We can do so as follows:1.Select the Interval Variables tab2.Position the mouse on the row for AGE in the Imputation Method column and right-click3.Select Select Method -> Mean4.Position the mouse on the row for CARDPROM in the Imputation Method columnand right-click5.Select Select Method -> Set Value6.Type 20 in the N ew value field7.Specify None as the Imputation method for TARGET_D8.Select OKWhen you complete, the window should look like the following.Suppose we want to set the missing value for HOMEOWNR to “U”, for GENDER to “F” and to use the default constant "U" on PCOWNERS and PETS. We need to do the following1.Select the Constant values subtab under the Default tab2.Enter U in the field of Character variables as the default constant3.Select Class Variables tab4.Right click on the row for HOMEOWNR in the Imputation methods column5.S elect SELECT method -> Set value6.Select the radio button next to Data Valuee the arrow to choose "U" from the list of data values8.Right click on the row for GENDER in the Imputation methods column9.S elect SELECT method -> Set value10.Select the radio button next to Data Valuee the arrow to choose "F" from the list of data values12.Right click on the row for PETS in the Imputation methods column13.S elect SELECT method -> Default constant14.Right click on the row for PCOWNERS in the Imputation methods column15.S elect SELECT method -> Default constant16.Right click on the row for TARGET_B in the Imputation methods column17.Specify None as the Imputation method for TARGET_B18.Select OKWhen you complete the window should look like。

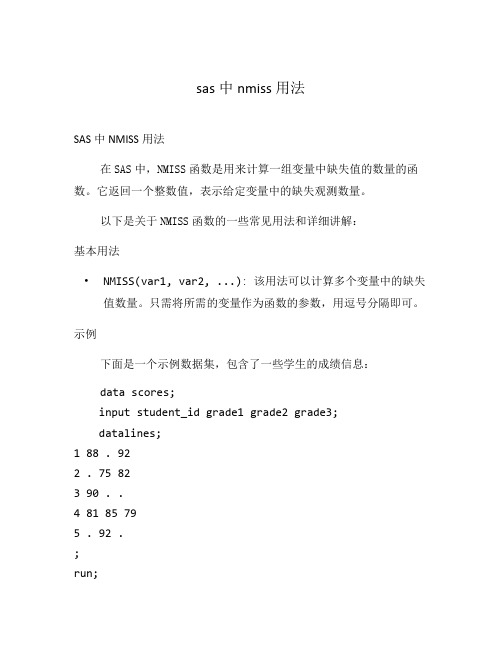

sas中nmiss用法

sas中nmiss用法SAS中NMISS用法在SAS中,NMISS函数是用来计算一组变量中缺失值的数量的函数。

它返回一个整数值,表示给定变量中的缺失观测数量。

以下是关于NMISS函数的一些常见用法和详细讲解:基本用法•NMISS(var1, var2, ...): 该用法可以计算多个变量中的缺失值数量。

只需将所需的变量作为函数的参数,用逗号分隔即可。

示例下面是一个示例数据集,包含了一些学生的成绩信息:data scores;input student_id grade1 grade2 grade3;datalines;1 88 . 922 . 75 823 90 . .4 81 85 795 . 92 .;run;我们将使用NMISS函数来计算每个学生的成绩缺失值数量。

data missing_count;set scores;missing_count = NMISS(grade1, grade2, grade3); run;上述代码将计算每个观测中成绩变量的缺失值数量,并将结果存储在新创建的missing_count变量中。

进一步操作我们可以在使用NMISS函数时进行进一步的操作,例如:•使用NMISS函数进行条件筛选•将NMISS函数与其他函数结合使用使用NMISS函数进行条件筛选我们可以使用NMISS函数对数据集的特定观测进行筛选。

例如,我们可以使用NMISS函数找出缺失值数量大于等于2的观测。

data missing_count;set scores;where NMISS(grade1, grade2, grade3) >= 2;run;上述代码将保留缺失值数量大于等于2的观测,将结果存储在新的数据集missing_count中。

将NMISS函数与其他函数结合使用我们可以将NMISS函数与其他函数结合使用,以获得更多有用的信息。

例如,我们可以使用NMISS函数计算每个观测中缺失值的百分比。

SD、SE、SEM、pooles-SEM的计算

SD 、SE 、SEM 、Pooled SEM 的计算一、SD 、SE 和SEM1. Standard deviation ,SD 是标准偏差,描述的是样本中各观察值间的变异程度。

1)S SD 2--∑==n x x (Excel 中有计算SD 的函数(stdev())。

2. Standard error ,SE 是标准误差,描述的是样本均数的抽样误差,即样本均数与总体均数的接近程度,是量度结果精密度的指标。

也可以称为样本平均数的标准差。

nSD S SE x == 注意:Excel 中没有直接计算SE 的函数,所以需要用户自己输入计算公式:SE=stdev(x)/sqrt(n)3. Standard error of the mean ,SEM -为平均数的标准。

要经方差分析后,才能得到SEM 。

【意义】国内发表论文时,试验结果通常给出平均值±SD ,有的要求给出显著性检验后的P 值,而有的杂志没有要求列出P 值;而国外文献中,试验结果表中需要列出:(1)各处理组的平均值;(2)然后给出总的SE 或SEM 或 pooled SE 或总的Average ± error standard ;(3)再列出P 值。

下面是几篇英文文献中的结果表达方式。

【文献1】Factors affecting the voluntary intake of food by sheep ——6. The effect of monosodium glutamate on the palatability. 该试验是5×5拉丁方设计:表中解释:SE=SQRT (误差均方/n )= SQRT (MSe/n )文献1表2中的SE 即是SEM ,就是方差分析表中的误差均方除以n 再开方,即SEM=,也即x s 即在进行邓肯氏多重比较时的检验样本平均数的标准误(n=5)此处。

SEM 的计算(1)SPSS 分析系统的输出结果中,SEM 为“估计边际均值”表中“标准 误差”项【例1】 四种饲料对仔猪增重的影响group gain (kg ) 2 33 39 41 33 34 35 3 23 25 23 29 28 20 42824252220231)当重复数相等(均衡数据)时,获得SEM 的操作是:选择“GLM ”,在“选项”,在“估计边际均值”框,将“group ”变量选入右侧“显著均值”框中。

SAS统计分析教程方法总结

对定量结果进行差异性分析1.单因素设计一元定量资料差异性分析1.1.单因素设计一元定量资料t检验与符号秩和检验T检验前提条件:定量资料满足独立性和正态分布,若不满足则进行单因素设计一元定量资料符号秩和检验。

1.2.配对设计一元定量资料t检验与符号秩和检验配对设计:整个资料涉及一个试验因素的两个水平,并且在这两个水平作用下获得的相同指标是成对出现的,每一对中的两个数据来自于同一个个体或条件相近的两个个体。

1.3.成组设计一元定量资料t检验成组设计定义:设试验因素A有A1,A2个水平,将全部n(n最好是偶数)个受试对象随机地均分成2组,分别接受A1,A2,2种处理。

再设每种处理下观测的定量指标数为k,当k=1时,属于一元分析的问题;当k≥2时,属于多元分析的问题。

在成组设计中,因2组受试对象之间未按重要的非处理因素进行两两配对,无法消除个体差异对观测结果的影响,因此,其试验效率低于配对设计。

T检验分析前提条件:独立性、正态性和方差齐性。

1.4.成组设计一元定量资料Wilcoxon秩和检验不符合参数检验的前提条件,故选用非参数检验法,即秩和检验。

1.5.单因素k(k>=3)水平设计定量资料一元方差分析方差分析是用来研究一个控制变量的不同水平是否对观测变量产生了显著影响。

这里,由于仅研究单个因素对观测变量的影响,因此称为单因素方差分析。

方差分析的假定条件为:(1)各处理条件下的样本是随机的。

(2)各处理条件下的样本是相互独立的,否则可能出现无法解析的输出结果。

(3)各处理条件下的样本分别来自正态分布总体,否则使用非参数分析。

(4)各处理条件下的样本方差相同,即具有齐效性。

1.6.单因素k(k>=3)水平设计定量资料一元协方差分析协方差分析(Analysis of Covariance)是将回归分析与方差分析结合起来使用的一种分析方法。

在这种分析中,先将定量的影响因素(即难以控制的因素)看作自变量,或称为协变量(Covariate),建立因变量随自变量变化的回归方程,这样就可以利用回归方程把因变量的变化中受不易控制的定量因素的影响扣除掉,从而,能够较合理地比较定性的影响因素处在不同水平下,经过回归分析手段修正以后的因变量的样本均数之间的差别是否有统计学意义,这就是协方差分析解决问题的基本计算原理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

CAS=932; VAR=6; ME=ML;

/LABEL

V1=ANOMIE67; V2=POWRLS67;

V3=ANOMIE71; V4=POWRLS71;

/EQUATIONS

V3 = 1*V1 + 1*V2 + E3;

V4 = 1*V1 + 1*V2 + E4;

/VARIANCES

V2 = .833 F1 + E2;

V3 = F2 + E3;

V4 = .833 F2 + E4;

V5 = F3 + E5;

V6 = .5 *F3 + E6;

F1 = -.5 *F3 + D1;

F2 = .5 *F1 - .5*F3 + D2;

/VARIANCES

D1 TO D2 = 4*;

F3 = 6*;

V1 TO V2 = 10*;

E3 TO E4 = 2*;

/COVARIANCES

V2,V1= 7*;

/MATRIX

11.834

6.947 9.364

6.819 5.091 12.532

4.783 5.028 7.495 9.986

-3.839 -3.889 -3.841 -3.625 9.610

-2.189 -1.883 -2.175 -1.878 3.552 4.503

run;

Example 3: A Factor Analysis Model on page 29

EQScode: manul3.eqs

SAScode

/TITLE

FACTOR ANALYSIS MODEL

(EXAMPLE IN EQS MANUAL P.29)

/SPECIFICATIONS

CAS=932; VAR=6; ME=GLS;

F3 = 1;

F3 = 1;

D1 TO D2 = 1*;

E1 TO E4 = 3*;

/CONSTRAINTS

(F1,F3) = (F2,F3);

/MATRIX

11.834

6.947 9.364

6.819 5.091 12.532

4.783 5.028 7.495 9.986

-3.839 -3.889 -3.841 -3.625 9.610

E1 TO E4 = 3*;

/COVARIANCES

F2,F1= .3*;

e3,e1 = *;

e4,e2 = *;

/MATRIX

11.834

6.947 9.364

6.819 5.091 12.532

4.783 5.028 7.495 9.986

-3.839 -3.889 -3.841 -3.625 9.610

tlocation=bottom;

orientation=landscape;

border=yes;

postscript='MANUL3.PS';

layout=E1 b E2 E3 b E4 &

V1 b V2 V3 b V4 &

b F1 b b F2;

/END

/**********************************************

run;

Example 4: A Complete Latent Variable Modelon page 33

EQScode: manul4.eqs

SAScode

/TITLE

A COMPLETE LATENT VARIABLE MODEL

(EXAMPLE IN EQS MANUAL P.33)

/SPECIFICATIONS

proc calis cov data=power method = gls nobs=932;

lineqs

V1 = F1 + E1,

V2 = c1 F1 + E2,

V3 = F2 + E3,

V4 = c2 F2 + E4,

F1 = c3 F3 + D1,

F2 = c3 F3 + D2;

std

F3 = 1,

CAS=932; VAR=6; ME=ML; MAT=COV;

data='MANUL4.DAT';

/LABEL

V1=ANOMIA67; V2=POWRLS67;

V3=ANOMIA71; V4=POWRLS71;

V5=EDUCATON; V6=OCCUPATN;

/EQUATIONS

V1 = F1 + E1;

/MATRIX

11.834

6.947 9.364

6.819 5.091 12.532

4.783 5.028 7.495 9.986

-3.839 -3.889 -3.841 -3.625 9.610

-2.189 -1.883 -2.175 -1.878 3.552 4.503

/END

data power(TYPE=COV);

EQScode: manul5.eqs

SAScode

/TITLE

A SECOND-ORDER FACTOR ANALYSIS MODEL

(EXAMPLE IN EQS MANUAL P.38)

/SPECIFICATIONS

CAS=932; VAR=6; ME=GLS;

/LABEL

V1=ANOMIA67; V2=POWRLS67;

/diagram

title='Diagram from Manul2';

orientation=landscape;

border=yes;

tlocation=bottom;

layout= v1 b v3 e3&

v2 b v4 e4;

/end

/*********************************************

lineqs

V1 = F1 + E1,

V2 = .833 F1 + E2,

V3 = F2 + E3,

V4 = .833 F2 + E4,

V5 = F3 + E5,

V6 = a6 F3 + E6,

F1 = c1 F3 + D1,

F2 = c2 F1 + c3 F3 + D2;

std

D1 - D2 = ed:,

v6 -2.189 -1.883 -2.175 -1.878 3.552 4.503

;

run;

proc calis cov data = power method = ls nobs = 932 ;

Lineqs

V4 = b1 v2 + b2 v5 + E4;

Std

v2 = ev2(9),

v5 = ev5(9),

proc calis cov data=power method = ml nobs = 932;

Lineqs

v3 = a3 v1 + b3 v2 + e3,

v4 = a4 v1 + b4 v2 + e4;

Std

v1 - v2 = ev1 - ev2,

e3 - e4 = ee3 - ee4;

Cov

v1 v2 = Theta (.7);

e4 = ee4(2);

Cov

v2 v5 = Theta (-4);

run;

Example 2: A Two-Equation Path Model on page 22

EQScode: manul2.eqs

SAScode

/TITLE

PATH ANALYSIS MODEL

(EXAMPLE IN EQS MANUAL P.22)

lineqs

v1 = a1 f1 + e1,

v2 = a2 f1 + e2,

v3 = a1 f2 + e3,

v4 = a2 f2 + e4;

std

f1- f2 = 1.0,

e1 e3 = ee1,

e2 e4 = ee2;

cov

f1 f2 = theta1,

e1 e3 = theta2,

e2 e4 = theta2;

SASLibrarySolving Examples from EQS Manual UsingProc Calis

Example 1: A Simple Regression Model on page 15

EQScode: manul1.eqs

SAScode

/TITLE

STABILITY OF POWERLESSNESS

D1 - D2 = ed:,

E1 - E4 = ee:;

run;

Example 6: A Nonstandard Modelon page 104

EQScode: manul6.eqs

(EXAMPLE IN EQS MANUAL P.15)

/SPECIFICATIONS

CAS=932; VAR=6; ME=LS;

/EQUATIONS

V4 = 1*V2 - 1*V5 + E4;

/VARIANCES

V2 = 9*; V5 = 9*; E4 = 2*;

/COVARIANCES

V5,V2 = -4*;

This example uses the same covariance matrix

from the example above.