bp神经网络的c#语言实现

bp神经网络

bp神经网络BP神经网络(Backpropagation Network)是一种被广泛应用于分类、预测和优化问题中的人工神经网络模型。

BP神经网络具有简单易懂、易于理解和易于实现的特点,因此在工程实践中被广泛应用。

BP神经网络的基本思想是将信息通过一层层的神经元传递,然后反向调节神经元的权重和偏置,从而实现对模型参数的优化。

BP神经网络通常包含输入层、隐层和输出层三个层次。

其中输入层用于接收输入数据,隐层用于处理输入数据,输出层用于给出模型的预测结果。

BP神经网络通过不断反向传播误差信号来调整各层神经元之间的连接权重,从而实现对模型参数的逐步优化。

BP神经网络的训练过程通常分为前向传播和反向传播两个阶段。

在前向传播阶段,输入数据被输入到神经网络中,经过一系列计算后得到输出结果。

在反向传播阶段,将输出结果与真实值进行比较,计算误差信号,并通过反向传播算法将误差信号逐层传递回到输入层,从而实现对神经网络参数(权重和偏置)的不断调整。

通过多次迭代,直到神经网络的输出结果与真实值的误差达到一定的精度要求为止。

BP神经网络的优点在于可以处理非线性问题,并且可以自适应地调整模型参数。

然而,BP神经网络也存在一些缺点,例如容易陷入局部极小值,训练速度较慢,需要大量的训练数据等等。

在实际应用中,BP神经网络已经被广泛应用于分类、预测和优化等方面。

例如,BP神经网络可以用于识别手写数字、预测股票市场走势、自动驾驶和机器人控制等方面。

另外,BP 神经网络还可以与其他机器学习算法相结合,共同解决各种复杂问题。

总之,BP神经网络是一种简单实用的人工神经网络模型,具有广泛的应用前景。

在实际应用中,需要根据具体问题对模型进行适当的改进和优化,以提高其预测精度和鲁棒性。

BP神经网络的C++实现及其在故障诊断中的应用

BP神经网络的C++实现及其在故障诊断中的应用王三明蒋军成(南京化工大学南京 210009)摘要:采用面向对象的程序设计方法(OOP),利用C++构造实现了优化BP神经网络通用故障诊断程序,介绍了该程序构造的关键技术和重要诊断程序模块的设计;该程序具有良好操作性、扩展性和通用性,诊断实例表明此神经网络故障诊断模型的准确性。

关键词:面向对象的程序设计 BP神经网络故障诊断1.引言人工神经网络具有自组织、自适应和并行处理等特点以及很强的输入输出非线形映射能力和易于学习和训练的优点,已被广泛应用于多个领域。

面向对象的程序设计(OOP)风格,具有良好的概括、分类和抽象能力,该方法已被广泛应用于程序设计语言、形式定义、操作系统、人工智能、实时系统、数据库等多种领域。

现存多种类型的神经网络,在拓扑结构和神经元权值信息的整体表现形式上具有很大的共性,而采用OOP 实现这些共性是非常有效的。

本文采用OOP法,利用C++语言实现了BP神经网络通用程序,以促进神经网络的在故障诊断中的更好应用。

2.OOP方法简介[3]OOP(Oject-Oriented Programming)是模块设计的一种有效程序设计方法。

OOP的包括几个重要概念:对象(object)它不仅代表了普遍使用的物体的直接抽象,而且对用户掩遮了实现的复杂性;类(class) ;继承(inheritance) ;多态性(polymorphism),在C++中主要体现在虚函数的应用上;类模板(template)在C++中允许单个的类处理通用的数据类型T。

OOP中的类结构通过类接口和类实现分离开来支持信息隐藏,这种分离允许类接口映射到多种不同实现,对用户掩蔽了实现的复杂性。

继承机制使对象具有很好的可扩展性,也易于实现软件的重用。

这些特性都非常适合于神经网络的实现。

3.BP故障诊断神经网络模型及其C++实现3.1 BP故障诊断神经网络模型BP网络由多个网络层构成,其中包括一个输入层、一个或几个隐层、一个输出层,层与层之间采用全互连接,同层神经元之间不存在相互连接。

BP神经网络C程序代码

BP神经网络C程序在该题的程序设计中采用了文件相关的操作,记录了相关学习和测试信息数据。

权值用伪随机数函数随机产生(范围是(0,0.5))采用结构体及链表来实现神经网络的结构分为实例结构体、层结构体和网络结构体数据结构的设计参照了《人工神经网络原理》(马锐编著,北京:机械工业出版社,2010,7)一书学习算法的优化也参照该书采用学习效率自适应调整算法优化源程序的学习算法,以减少学习次数由于能力和知识有限,该程序存在较大漏洞误差,在调整学习率时,不好掌握调节系数初始权值的限定范围适中,则程序的学习次数将明显减少在随机赋初始权值(0,0.5)时,学习次数可调节至135,但对测试数据的判别效果不理想,没有采用#include<stdio.h>#include<stdlib.h>#include<math.h>#include<malloc.h>#define TRUE 1#define FALSE 0#define NUM_LAYERS 4#define NUM 20 //训练实例个数#define N 2 //输入层单元数#define M 2 //输出层单元数int Units[NUM_LAYERS] = {N,3,3,M}; //每层单元数FILE *fp,*fb;typedef struct //训练实例{float x[N];float y[M];}TRAIN;typedef struct //网络层结构{int Units; //该层中单元的个数float *Output; //第i 个单元的输出float *Error; //第i 个单元的校正误差float **Weight; //第i 个单元的连接权值typedef struct //网络{LAYER **Layer; //隐层定义LAYER *Inputlayer; //输入层LAYER *Outputlayer; //输出层float Error; //允许误差float Eta; //学习率}NET;//初始化伪随机数发生器void InitializeRandoms(){srand(4711);return;}//产生随机实数并规范化float RandomReal() //产生(-0.5,0.5)之间的随机数{return (float)((rand()%100)/200.0);}//初始化训练数据void InitializeTrainingData(TRAIN *training){int i,j;char filename[20];printf("\n请输入训练实例的数据文件名: \n");gets(filename);fb = fopen(filename,"r");fprintf(fp,"\n\n--Saving initialization training datas ...\n");for(i=0;i<NUM;i++){for(j=0;j<N;j++){fscanf(fb,"%f",&(training+i)->x[j]);fprintf(fp,"%10.4f",(training+i)->x[j]);}for(j=0;j<M;j++){fscanf(fb,"%f",&(training+i)->y[j]);fprintf(fp,"%10.4f",(training+i)->y[j]);fprintf(fp,"\n");}fclose(fb);return;}//应用程序初始化void InitializeApplication(NET *Net){Net->Eta = (float)0.3;Net->Error = (float)0.0001;fp = fopen("BPResultData.txt","w+");return;}//应用程序关闭时终止打开的文件void FinalizeApplication(NET *Net){fclose(fp);return;}//分配内存,建立网络void GenerateNetwork(NET *Net){int l,i;Net->Layer = (LAYER **)calloc(NUM_LAYERS,sizeof(LAYER *));for(l=0;l<NUM_LAYERS;l++){Net->Layer[l] = (LAYER *)malloc(sizeof(LAYER));Net->Layer[l]->Units = Units[l];Net->Layer[l]->Output = (float *) calloc(Units[l]+1,sizeof(float));Net->Layer[l]->Error = (float *) calloc(Units[l]+1,sizeof(float));Net->Layer[l]->Weight = (float **)calloc(Units[l]+1,sizeof(float *));Net->Layer[l]->Output[0] = 1;if(l != 0)for(i=1;i <= Units[l];i++) //下标从"1"开始Net->Layer[l]->Weight[i] = (float *)calloc(Units[l-1]+1,sizeof(float));}Net->Inputlayer = Net->Layer[0];Net->Outputlayer = Net->Layer[NUM_LAYERS - 1];return;}//产生随机实数作为初始连接权值void RandomWeights(NET *Net){int l,i,j;for(l=1;l<NUM_LAYERS;l++)for(i=1;i <= Net->Layer[l]->Units;i++)for(j=0;j <= Net->Layer[l-1]->Units;j++)Net->Layer[l]->Weight[i][j] = RandomReal();return;}//设置输入层的输出值void SetInput(NET *Net,float *Input){int i;for(i=1;i <= Net->Inputlayer->Units;i++)Net->Inputlayer->Output[i] = Input[i-1]; //输入层采用u(x) = xreturn;}//设置输出层的输出值void GetOutput(NET *Net,float *Output){int i;for(i=1;i <= Net->Outputlayer->Units;i++)Output[i-1] = (float)(1/(1 + exp(-Net->Outputlayer->Output[i]))); //输出层采用f(x)=1/(1+e^(-x))return;}//层间顺传播void PropagateLayer(NET *Net,LAYER *Lower,LAYER *Upper){int i,j;float sum;for(i=1;i <= Upper->Units;i++){sum = 0;for(j=1;j <= Lower->Units;j++)sum += (Upper->Weight[i][j] * Lower->Output[j]);Upper->Output[i] = (float)(1/(1 + exp(-sum)));}return;}//整个网络所有层间的顺传播void PropagateNet(NET *Net){int l;for(l=0;l < NUM_LAYERS-1;l++)PropagateLayer(Net,Net->Layer[l],Net->Layer[l+1]);return;}//计算输出层误差void ComputeOutputError(NET *Net,float *target){int i;float Out,Err;for(i=1;i <= Net->Outputlayer->Units;i++){Out = Net->Outputlayer->Output[i];Err = target[i-1] - Out;Net->Outputlayer->Error[i] = Out*(1-Out)*Err;}return;}//层间逆传播void BackpropagateLayer(NET *Net,LAYER *Upper,LAYER *Lower) {int i,j;float Out,Err;for(i=1;i <= Lower->Units;i++){Out = Lower->Output[i];Err = 0;for(j=1;j <= Upper->Units;j++)Err += (Upper->Weight[j][i] * Upper->Error[j]);Lower->Error[i] = Out*(1-Out)*Err;}return;}//整个网络所有层间的逆传播void BackpropagateNet(NET *Net){int l;for(l=NUM_LAYERS-1;l>1;l--)BackpropagateLayer(Net,Net->Layer[l],Net->Layer[l-1]);return;}//权值调整void AdjustWeights(NET *Net){int l,i,j;float Out,Err;for(l=1;l<NUM_LAYERS;l++)for(i=1;i <= Net->Layer[l]->Units;i++)for(j=0;j <= Net->Layer[l-1]->Units;j++){Out = Net->Layer[l-1]->Output[j];Err = Net->Layer[l]->Error[i];Net->Layer[l]->Weight[i][j] += (Net->Eta*Err*Out);}return;}//网络处理过程void SimulateNet(NET *Net,float *Input,float *Output,float *target,int TrainOrNot) {SetInput(Net,Input); //输入数据PropagateNet(Net); //模式顺传播GetOutput(Net,Output); //形成输出ComputeOutputError(Net,target); //计算输出误差if(TrainOrNot){BackpropagateNet(Net); //误差逆传播AdjustWeights(Net); //调整权值}return;}//训练过程void TrainNet(NET *Net,TRAIN *training){int l,i,j,k;int count=0,flag=0;float Output[M],outputfront[M],ERR,err,sum;do{flag = 0;sum = 0;ERR = 0;if(count >= 1)for(j=0;j<M;j++)outputfront[j]=Output[j];SimulateNet(Net,(training+(count%NUM))->x,Output,(training+(count%NUM))->y,TRUE);if(count >= 1){k = count%NUM;for(i=1;i <= Net->Outputlayer->Units;i++){sum += Net->Outputlayer->Error[i];err = (training+k-1)->y[i-1] - outputfront[i-1];ERR += (outputfront[i-1] * (1 - outputfront[i-1]) * err);}if(sum <= ERR)Net->Eta = (float)(0.9999 * Net->Eta);elseNet->Eta = (float)(1.0015 * Net->Eta);}if(count >= NUM){for(k=1;k <= M;k++)if(Net->Outputlayer->Error[k] > Net->Error){ flag=1; break; }if(k>M)flag=0;}count++;}while(flag || count <= NUM);fprintf(fp,"\n\n\n");fprintf(fp,"--training results ... \n");fprintf(fp,"training times: %d\n",count);fprintf(fp,"\n*****the final weights*****\n");for(l=1;l<NUM_LAYERS;l++){for(i=1;i <= Net->Layer[l]->Units;i++){for(j=1;j <= Net->Layer[l-1]->Units;j++)fprintf(fp,"%15.6f",Net->Layer[l]->Weight[i][j]);fprintf(fp,"\n");}fprintf(fp,"\n\n");}}//评估过程void EvaluateNet(NET *Net){int i;printf("\n\n(");fprintf(fp,"\n\n(");for(i=1;i <= Net->Inputlayer->Units;i++){printf(" %.4f",Net->Inputlayer->Output[i]);fprintf(fp,"%10.4f",Net->Inputlayer->Output[i]);}printf(")\t");fprintf(fp,")\t");for(i=1;i <= Net->Outputlayer->Units;i++){if(fabs(Net->Outputlayer->Output[i] - 1.0) <= 0.0499){printf("肯定是第%d 类, ",i);fprintf(fp,"肯定是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.9) <= 0.0499){printf("几乎是第%d 类, ",i);fprintf(fp,"几乎是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.8) <= 0.0499){printf("极是第%d 类, ",i);fprintf(fp,"极是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.7) <= 0.0499){printf("很是第%d 类, ",i);fprintf(fp,"很是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.6) <= 0.0499){printf("相当是第%d 类, ",i);fprintf(fp,"相当是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.5) <= 0.0499){printf("差不多是第%d 类, ",i);fprintf(fp,"差不多是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.4) <= 0.0499){printf("比较像是第%d 类, ",i);fprintf(fp,"比较像是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.3) <= 0.0499){printf("有些像是第%d 类, ",i);fprintf(fp,"有些像是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.2) <= 0.0499){printf("有点像是第%d 类, ",i);fprintf(fp,"有点像是第%d 类, ",i);}if(fabs(Net->Outputlayer->Output[i] - 0.1) <= 0.0499){printf("稍稍像是第%d 类, ",i);fprintf(fp,"稍稍像是第%d 类, ",i);}if(Net->Outputlayer->Output[i] <= 0.0499){printf("肯定不是第%d 类, ",i);fprintf(fp,"肯定不是第%d 类, ",i);}}printf("\n\n");fprintf(fp,"\n\n\n");return;}//测试过程void TestNet(NET *Net){TRAIN Testdata;float Output[M];int i,j,flag=0;char select;fprintf(fp,"\n\n--Saving test datas ...\n");do{printf("\n请输入测试数据(x1 x2 ... y1 y2 ...): \n");for(j=0;j<N;j++){scanf("%f",&Testdata.x[j]);fprintf(fp,"%10.4f",Testdata.x[j]);}for(j=0;j<M;j++){scanf("%f",&Testdata.y[j]);fprintf(fp,"%10.4f",Testdata.y[j]);}fprintf(fp,"\n");SimulateNet(Net,Testdata.x,Output,Testdata.y,FALSE);fprintf(fp,"\n--NET Output and Error of the Test Data ....\n");for(i=1;i <= Net->Outputlayer->Units;i++)fprintf(fp,"%10.6f %10.6f\n",Net->Outputlayer->Output[i],Net->Outputlayer->Error[i]);EvaluateNet(Net);printf("\n继续测试?(y/n):\n");getchar();scanf("%c",&select);printf("\n");if((select == 'y')||(select == 'Y'))flag = 1;elseflag=0;}while(flag);return;}//主函数void main(){TRAIN TrainingData[NUM];NET Net;InitializeRandoms(); //初始化伪随机数发生器GenerateNetwork(&Net); //建立网络RandomWeights(&Net); //形成初始权值InitializeApplication(&Net); //应用程序初始化,准备运行InitializeTrainingData(TrainingData); //记录训练数据TrainNet(&Net,TrainingData); //开始训练TestNet(&Net);FinalizeApplication(&Net); //程序关闭,完成善后工作return;}。

BP神经网络基本原理与应用

BP神经网络基本原理与应用BP神经网络,即反向传播神经网络(BackPropagation Neural Network),是一种常用的人工神经网络模型,由几层节点相互连接而成,通过输入与输出之间的连接进行信息传递与处理。

BP神经网络广泛应用于模式识别、数据挖掘、预测分析等领域,具有较好的非线性映射能力和逼近复杂函数的能力。

BP神经网络的基本原理是参考人脑神经元的工作方式,通过模拟大量神经元之间的连接与传递信息的方式进行数据处理。

BP神经网络通常由输入层、隐藏层和输出层组成,其中输入层接收外部输入的数据,输出层返回网络最终的结果,隐藏层通过多个节点进行信息传递和加工。

在前向传播阶段,输入数据从输入层进入神经网络,通过各层节点之间的连接,经过各层节点的加权和激活函数处理,最终输出到输出层。

此过程权值是固定的,只有输入数据在网络中的传递。

在反向传播阶段,通过计算输出层的误差与目标输出之间的差异,反向传播至隐藏层和输入层,根据误差大小调整各层节点之间的权值。

这种反向传播误差的方式可以不断减小输出误差,并逐渐调整网络的权值,使得网络的输出结果更加准确。

BP神经网络的应用非常广泛,可以有效地处理非线性问题。

例如,在模式识别领域,可以用于人脸识别、声纹识别等方面,通过学习大量的样本数据,提取出特征并建立模型,实现对特定模式的识别和分类。

在数据挖掘领域,可以用于聚类分析、分类预测等方面,通过训练网络,建立数据模型,对未知数据进行分类或者预测。

在预测分析领域,可以用于股票预测、销售预测等方面,通过学习历史数据,建立预测模型,对未来的趋势进行预测。

总的来说,BP神经网络作为一种常用的人工神经网络模型,具有强大的非线性映射能力和逼近复杂函数的能力,其基本原理是通过输入与输出之间的连接进行信息传递与处理,并通过不断调整权值来减小输出误差。

在实际应用中,可以广泛应用于模式识别、数据挖掘、预测分析等领域,为我们解决复杂问题提供了有力的工具和方法。

神经网络BP算法程序C语言实现

/************************************************ Back Propagation Algorithm************************************************/ #include "stdio.h"#include "stdlib.h"#include "math.h"/************************************************ The Definition of User Data************************************************/ #define MAXINPUT 1#define MAXHIDE 3#define MAXOUTPUT 1#define MAX 1#define MIN -1#define T 100#define CA 4double a=0.8;double b=0.05;double k=0;double error=0;int t=0;double sout[MAXOUTPUT];double shide[MAXHIDE];double m=2;double howchange[MAXHIDE][MAXOUTPUT];double ihwchange[MAXINPUT][MAXHIDE];double CatalogueOut[CA][MAXOUTPUT];double CatalogueIn[CA][MAXINPUT];/************************************************ The Definition of Data Structure************************************************/ struct theBP{double input[MAXINPUT];double hide[MAXHIDE];double output[MAXOUTPUT];double ihw[MAXINPUT][MAXHIDE];double how[MAXHIDE][MAXOUTPUT];};struct theBP bpa;/************************************************ Definition of Prototype************************************************/ void WeightInitial();void InitialError();void InPutCatalogue();void CalculateOut(int k);void CalculateError(int k);void ReverseHideError();void CalculateChange();void CalculateNewWeight();void Test();void TestCalculateOut();void camain();void main(){WeightInitial();// InitialError();InPutCatalogue();//doint m=0;while(1){printf("请选择要进行的操作\n");printf("0----------------学习\n");printf("1----------------测试\n");printf("2----------------退出\n");scanf("%d",&m);switch(m){case 0:camain();break;case 1:Test();break;case 2:exit(0);}//while((error)>k);;}}void camain(){for(t=0;t<T;t++){for(int k=0;k<CA;k++){CalculateOut(k);CalculateError(k);ReverseHideError();CalculateChange();CalculateNewWeight();}for(k=0;k<CA;k++){CalculateOut(k);}}}/************************************************Function:initial the weight************************************************/void WeightInitial(){//产生输入层到隐藏层的权值for(int i=0;i<MAXINPUT;i++){for(int j=0;j<MAXHIDE;j++){bpa.ihw[i][j]=0.3;//((double)rand()/(double)(RAND_MAX))*(MAX-MIN)+MIN;}}//产生从隐藏层到输出层的权值for(i=0;i<MAXHIDE;i++){for(int j=0;j<MAXOUTPUT;j++){bpa.how[i][j]=0.2;//((double)rand()/(double)(RAND_MAX))*(MAX-MIN)+MIN;}}}/************************************************Function:input the Catalogue************************************************/void InPutCatalogue(){for(int k=0;k<CA;k++){printf("请输入第%d个样本的输入值:\n",k);for(int i=0;i<MAXINPUT;i++){scanf("%lf",&bpa.input[i]);CatalogueIn[k][i]=bpa.input[i];}printf("请输入第%d个样本的输出值:\n",k);for(i=0;i<MAXOUTPUT;i++){scanf("%lf",&CatalogueOut[k][i]);}}}/************************************************Function:calculate the out************************************************/void CalculateOut(int k){//计算隐藏层的输出for(int j=0;j<MAXHIDE;j++){double sum2=0;for(int i=0;i<MAXINPUT;i++){bpa.input[i]=CatalogueIn[k][i];sum2+=bpa.ihw[i][j]*bpa.input[i];//计算输入}bpa.hide[j]=1/(1+exp(-sum2));//计算输出}//计算每输出层个单元的输入和输出for(j=0;j<MAXOUTPUT;j++){double sum3=0;for(int i=0;i<MAXHIDE;i++){sum3+=bpa.how[i][j]*bpa.hide[i];//计算输入}bpa.output[j]=m*sum3;//计算输出bpa.output[j]=1/(1+exp(-sum3))printf("第%d个样本的最后输出%lf\n",k,bpa.output[j]);}}void TestCalculateOut(){//计算隐藏层的输出for(int j=0;j<MAXHIDE;j++){double sum1=0;for(int i=0;i<MAXINPUT;i++){sum1=sum1+bpa.ihw[i][j]*bpa.input[i];//计算输入}bpa.hide[j]=1/(1+exp(-sum1));//计算输出}//计算每输出层个单元的输入和输出for(j=0;j<MAXOUTPUT;j++){double sum2=0;for(int i=0;i<MAXHIDE;i++){sum2=sum2+bpa.how[i][j]*bpa.hide[i];//计算输入}bpa.output[j]=m*sum2;//计算输出bpa.output[j]=1/(1+exp(sum2))printf("最后输出%lf\n",bpa.output[j]);}}/************************************************Function:对输出层Calculate************************************************/void CalculateError(int k){double temp=0;error=0;for(int i=0;i<MAXOUTPUT;i++){temp=(CatalogueOut[k][i]-bpa.output[i])*(CatalogueOut[k][i]-bpa.output[i]);error=(0.5)*temp+error;}for(i=0;i<MAXOUTPUT;i++){sout[i]=(CatalogueOut[k][i]-bpa.output[i])*bpa.output[i]*(1-bpa.output[i]);}}/************************************************Function: 从后向前对隐藏层************************************************/void ReverseHideError(){for(int i=0;i<MAXHIDE;i++){double sum=0;for(int j=0;j<MAXOUTPUT;j++){sum+=sout[j]*bpa.how[i][j];}shide[i]=(bpa.hide[i])*(1-bpa.hide[i])*sum;}}/************************************************Function:Calculate the 权值的变化量************************************************/void CalculateChange(){int j=0;//隐藏层到输出层for(int i=0;i<MAXHIDE;i++){for(j=0;j<MAXOUTPUT;j++){howchange[i][j]=a*(howchange[i][j])+b*(sout[i])*(bpa.hide[i]);// }}//对输入层到隐藏层for(i=0;i<MAXINPUT;i++){for(j=0;j<MAXHIDE;j++){ihwchange[i][j]=a*(ihwchange[i][j])+b*(shide[i])*(bpa.input[i]);// }}}/************************************************Function:Calculate the 新的权值************************************************/void CalculateNewWeight(){int j=0;//隐藏层到输出层for(int i=0;i<MAXHIDE;i++){for(j=0;j<MAXOUTPUT;j++){bpa.how[i][j]=bpa.how[i][j]+howchange[i][j];}}//对输入层到隐藏层for(i=0;i<MAXINPUT;i++){for(j=0;j<MAXHIDE;j++){bpa.ihw[i][j]=bpa.ihw[i][j]+ihwchange[i][j];}}}void Test(){printf("请输入测试数据的输入值:\n");for(int i=0;i<MAXINPUT;i++){scanf("%lf",&bpa.input[i]);}TestCalculateOut();}。

BP神经网络原理及应用

BP神经网络原理及应用BP神经网络,即反向传播神经网络(Backpropagation Neural Network),是一种基于梯度下降算法的多层前馈神经网络,常用于分类与回归等问题的解决。

BP神经网络通过反向传播算法,将误差从输出层往回传播,更新网络权值,直至达到误差最小化的目标,从而实现对输入模式的分类和预测。

BP神经网络的结构包括输入层、隐藏层和输出层。

输入层接收外部输入的特征向量,隐藏层负责将输入特征映射到合适的高维空间,输出层负责输出网络的预测结果。

每个神经元与其前后的神经元相连,每个连接都有一个权值,用于调整输入信号的重要性。

BP神经网络利用激活函数(如sigmoid函数)对神经元的输出进行非线性变换,增加网络的非线性表达能力。

1.前向传播:将输入信号传递给网络,逐层计算每个神经元的输出,直至得到网络的输出结果。

2.计算误差:将网络输出与期望输出比较,计算误差。

常用的误差函数包括平方误差和交叉熵误差等。

3.反向传播:根据误差,逆向计算每个神经元的误差贡献,从输出层往回传播到隐藏层和输入层。

根据误差贡献,调整网络的权值和阈值。

4.更新权值和阈值:根据调整规则(如梯度下降法),根据误差贡献的梯度方向,更新网络的权值和阈值。

1.模式识别与分类:BP神经网络可以通过训练学习不同模式的特征,从而实现模式的自动分类与识别。

例如,人脸识别、文本分类等。

2.预测与回归:BP神经网络可以通过历史数据的训练,学习到输入与输出之间的映射关系,从而实现对未知数据的预测与回归分析。

例如,股票价格预测、天气预测等。

3.控制系统:BP神经网络可以用于建模和控制非线性系统,实现自适应、自学习的控制策略。

例如,机器人控制、工业过程优化等。

4.信号处理与图像处理:BP神经网络可以通过学习复杂的非线性映射关系,实现信号的去噪、压缩和图像的识别、处理等。

例如,语音识别、图像分割等。

5.数据挖掘与决策支持:BP神经网络可以根据历史数据学习到数据之间的相关关系,从而帮助决策者进行数据挖掘和决策支持。

浅析BP神经网络基本模型的C语言实现

89 2013年第01期,第46卷通信技术 Vol.46,No.01,2013 总第253期 Communications Technology No.253,Totally 浅析BP神经网络基本模型的C语言实现﹡赵朝凤,令晓明(兰州交通大学光电技术与智能控制教育部重点实验室,甘肃兰州 730070)【摘要】BP神经网络已经成为应用最为广泛的神经网络模型之一。

而人工神经网络是对人脑真正神经工作的简化生物模型。

为了加深对神经网络的理解,利用推导公式来详细分析其最后的输出值和误差。

这里旨在阐述用C语言实现BP神经网络基本模型,在BP神经网络的初始化函数中采用了归一化处理的方法,另外就是对神经元的权重初始化;而BP神经网络训练函数是整个BP神经网络形成的引擎,驱动着样本训练过程的执行。

【关键词】BP神经网络;基本模型;C【中图分类号】TP183 【文献标识码】A 【文章编号】1002-0802(2013)01-0089-03 Discussionm on Implementing the Basic Model of BP NeuralNetworks with C LanguageZHAO Chao-feng, LING Xiao-ming(ME Lab of Optical-Electric Tech & Inteligent Control, Lanzhou Jiaotong Univ., Lanzhou Gansu 730070, China) 【Abstract】Nowadays BP Neural Network becomes one of the most widely used neural network models, while the artificial neural network is the simplified biological model of human-brain’s real work. For deepening the understanding of neural network, the last output value and error of the neural network is analyzed with the deduction formula. This paper describes basic model of BP neural networks implemented with C language. The normalized method is adopted in the initial function of BP neural network, and the training function of BP neural network is the forming engine of the whole network, and thus it could drive the successful execution of sample training process.【Key words】BP neural networks; basic model; C language1 BP神经网络1.1 BP神经网络的基本模型人大脑信息的传递、对外界刺激产生反应都由神经元控制的,人脑就是由上百亿个的这样神经元构成。

BP神经网络算法的C语言实现代码

BP神经网络算法的C语言实现代码以下是一个BP神经网络的C语言实现代码,代码的详细说明可以帮助理解代码逻辑:```c#include <stdio.h>#include <stdlib.h>#include <math.h>#define INPUT_SIZE 2#define HIDDEN_SIZE 2#define OUTPUT_SIZE 1#define LEARNING_RATE 0.1//定义神经网络结构体typedef structdouble input[INPUT_SIZE];double hidden[HIDDEN_SIZE];double output[OUTPUT_SIZE];double weights_ih[INPUT_SIZE][HIDDEN_SIZE];double weights_ho[HIDDEN_SIZE][OUTPUT_SIZE];} NeuralNetwork;//激活函数double sigmoid(double x)return 1 / (1 + exp(-x));//创建神经网络NeuralNetwork* create_neural_networNeuralNetwork* nn =(NeuralNetwork*)malloc(sizeof(NeuralNetwork));//初始化权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}return nn;//前向传播void forward(NeuralNetwork* nn)//计算隐藏层输出for (int i = 0; i < HIDDEN_SIZE; i++)double sum = 0;for (int j = 0; j < INPUT_SIZE; j++)sum += nn->input[j] * nn->weights_ih[j][i];}nn->hidden[i] = sigmoid(sum);}//计算输出层输出for (int i = 0; i < OUTPUT_SIZE; i++)double sum = 0;for (int j = 0; j < HIDDEN_SIZE; j++)sum += nn->hidden[j] * nn->weights_ho[j][i];}nn->output[i] = sigmoid(sum);}void backpropagation(NeuralNetwork* nn, double target)//计算输出层误差double output_error[OUTPUT_SIZE];for (int i = 0; i < OUTPUT_SIZE; i++)double delta = target - nn->output[i];output_error[i] = nn->output[i] * (1 - nn->output[i]) * delta;}//更新隐藏层到输出层权重for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] += LEARNING_RATE * nn->hidden[i] * output_error[j];}}//计算隐藏层误差double hidden_error[HIDDEN_SIZE];for (int i = 0; i < HIDDEN_SIZE; i++)double delta = 0;for (int j = 0; j < OUTPUT_SIZE; j++)delta += output_error[j] * nn->weights_ho[i][j];}hidden_error[i] = nn->hidden[i] * (1 - nn->hidden[i]) * delta;}//更新输入层到隐藏层权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] += LEARNING_RATE * nn->input[i] * hidden_error[j];}}void train(NeuralNetwork* nn, double input[][2], double target[], int num_examples)int iteration = 0;while (iteration < MAX_ITERATIONS)double error = 0;for (int i = 0; i < num_examples; i++)for (int j = 0; j < INPUT_SIZE; j++)nn->input[j] = input[i][j];}forward(nn);backpropagation(nn, target[i]);error += fabs(target[i] - nn->output[0]);}//判断误差是否已达到允许范围if (error < 0.01)break;}iteration++;}if (iteration == MAX_ITERATIONS)printf("Training failed! Error: %.8lf\n", error); }void predict(NeuralNetwork* nn, double input[]) for (int i = 0; i < INPUT_SIZE; i++)nn->input[i] = input[i];}forward(nn);printf("Prediction: %.8lf\n", nn->output[0]); int maiNeuralNetwork* nn = create_neural_network(; double input[4][2] ={0,0},{0,1},{1,0},{1,1}};double target[4] =0,1,1,};train(nn, input, target, 4);predict(nn, input[0]);predict(nn, input[1]);predict(nn, input[2]);predict(nn, input[3]);free(nn);return 0;```以上代码实现了一个简单的BP神经网络,该神经网络包含一个输入层、一个隐藏层和一个输出层。

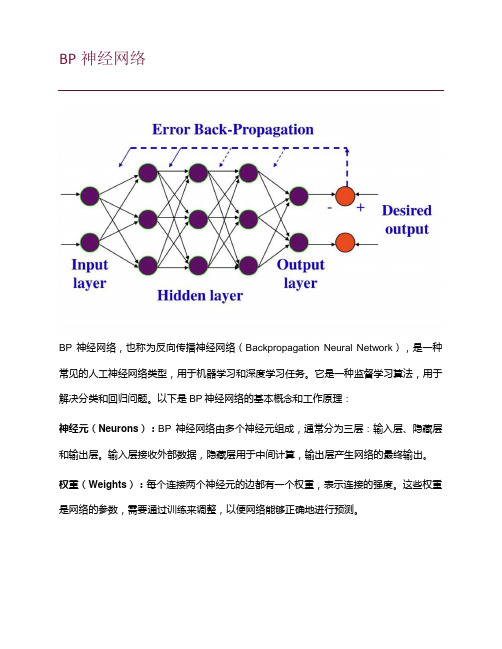

机器学习-BP(back propagation)神经网络介绍

BP神经网络BP神经网络,也称为反向传播神经网络(Backpropagation Neural Network),是一种常见的人工神经网络类型,用于机器学习和深度学习任务。

它是一种监督学习算法,用于解决分类和回归问题。

以下是BP神经网络的基本概念和工作原理:神经元(Neurons):BP神经网络由多个神经元组成,通常分为三层:输入层、隐藏层和输出层。

输入层接收外部数据,隐藏层用于中间计算,输出层产生网络的最终输出。

权重(Weights):每个连接两个神经元的边都有一个权重,表示连接的强度。

这些权重是网络的参数,需要通过训练来调整,以便网络能够正确地进行预测。

激活函数(Activation Function):每个神经元都有一个激活函数,用于计算神经元的输出。

常见的激活函数包括Sigmoid、ReLU(Rectified Linear Unit)和tanh(双曲正切)等。

前向传播(Forward Propagation):在训练过程中,输入数据从输入层传递到输出层的过程称为前向传播。

数据经过一系列线性和非线性变换,最终产生网络的预测输出。

反向传播(Backpropagation):反向传播是BP神经网络的核心。

它用于计算网络预测的误差,并根据误差调整网络中的权重。

这个过程分为以下几个步骤:1.计算预测输出与实际标签之间的误差。

2.将误差反向传播回隐藏层和输入层,计算它们的误差贡献。

3.根据误差贡献来更新权重,通常使用梯度下降法或其变种来进行权重更新。

训练(Training):训练是通过多次迭代前向传播和反向传播来完成的过程。

目标是通过调整权重来减小网络的误差,使其能够正确地进行预测。

超参数(Hyperparameters):BP神经网络中有一些需要人工设置的参数,如学习率、隐藏层的数量和神经元数量等。

这些参数的选择对网络的性能和训练速度具有重要影响。

BP神经网络在各种应用中都得到了广泛的使用,包括图像分类、语音识别、自然语言处理等领域。

bp神经网络c++代码

AfxMessageBox("ALLOC_2D_DBL: Couldn't allocate array of dbl ptrs\n");

return (NULL);

}

for (i = 0; i < m; i++) {

if (newnet == NULL) {

printf("BPNN_CREATE: Couldn't allocate neural network\n");

return (NULL);

}

newnet->input_n = n_in;

free((char *) net->input_prev_weights);

for (i = 0; i <= n2; i++) {

free((char *) net->hidden_weights[i]);

free((char *) net->hidden_prev_weights[i]);

free((char *) net->hidden_delta);

free((char *) net->output_delta);

free((char *) net->target);

for (i = 0; i <= n1; i++) {

{

free((char *) net->input_weights[i]);

free((char *) net->input_prev_weights[i]);

}

BP神经网络的基本原理_一看就懂

BP神经网络的基本原理_一看就懂BP神经网络(Back propagation neural network)是一种常用的人工神经网络模型,也是一种有监督的学习算法。

它基于错误的反向传播来调整网络权重,以逐渐减小输出误差,从而实现对模型的训练和优化。

1.初始化网络参数首先,需要设置网络的结构和连接权重。

BP神经网络通常由输入层、隐藏层和输出层组成。

每个神经元与上下层之间的节点通过连接权重相互连接。

2.传递信号3.计算误差实际输出值与期望输出值之间存在误差。

BP神经网络通过计算误差来评估模型的性能。

常用的误差计算方法是均方误差(Mean Squared Error,MSE),即将输出误差的平方求和后取平均。

4.反向传播误差通过误差反向传播算法,将误差从输出层向隐藏层传播,并根据误差调整连接权重。

具体来说,根据误差对权重的偏导数进行计算,然后通过梯度下降法来更新权重值。

5.权重更新在反向传播过程中,通过梯度下降法来更新权重值,以最小化误差。

梯度下降法的基本思想是沿着误差曲面的负梯度方向逐步调整权重值,使误差不断减小。

6.迭代训练重复上述步骤,反复迭代更新权重值,直到达到一定的停止条件,如达到预设的训练轮数、误差小于一些阈值等。

迭代训练的目的是不断优化模型,使其能够更好地拟合训练数据。

7.模型应用经过训练后的BP神经网络可以应用于新数据的预测和分类。

将新的输入数据经过前向传播,可以得到相应的输出结果。

需要注意的是,BP神经网络对于大规模、复杂的问题,容易陷入局部最优解,并且容易出现过拟合的情况。

针对这些问题,可以采用各种改进的方法,如加入正则化项、使用更复杂的网络结构等。

综上所述,BP神经网络通过前向传播和反向传播的方式,不断调整权重值来最小化误差,实现对模型的训练和优化。

它是一种灵活、强大的机器学习算法,具有广泛的应用领域,包括图像识别、语音识别、自然语言处理等。

(完整版)人工神经网络bp算法C语言程序可出图

for (k = 0; k < h; k++)

v[j][k] = v[j][k] + a * x[i][j] * ChgH[k];

}

if (n % 10 == 0)

printf("误差: %f\n", Ep[n]);

}

printf("总共循环次数:%d\n", n);

}

int TrainBp(bp_nn *bp, float x[COUT][IN_COUT], int y[COUT][OUT_COUT])

{

//训练bp网络,样本为x,理想输出为y

double f = (*bp).b; //精度控制参数

double a = (*bp).a; //学习率

int h = (*bp).h; //隐层节点数

(*bp).v[i][j] = rand() / (double)(RAND_MAX);

for (i = 0; i < (*bp).h; i++)

for (j = 0; j < OUT_COUT; j++)

(*bp).w[i][j] = rand() / (double)(RAND_MAX);

return 1;

int i, j, k, n,d;

double temp;

double e = f + 1;

double c;

double Ep[10000];

for (i = 0; i < IN_COUT; i++) //复制结构体中的权矩阵

写好的BP神经网络的C程序

#include "stdlib.h"

#include "math.h"

#include "stdio.h"

#include "time.h"

#include "fstream.h"

#define N 800 //学习样本个数

#define IN 3 //输入层神经元数目

}

return 1;

}//子程序O_I_O()结束

////////////////////////////////////

//输出层至隐层的一般化误差子程序////

////////////////////////////////////

double d_err[ON];

int Err_O_H(int m)

int Err_H_I()

{

double sigma1;

for (int j=0;j<HN;j++)

{

sigma1=0.0;

for (int k=0;k<ON;k++)

{

sigma1=d_err[k]*V[k][j];

}

e_err[j]=sigma1*H[j]*(1-H[j]);//隐层各神经元的一般化误差

for (int k=0;k<ON;k++)

{

sigma2=0.0;

for (int j=0;j<HN;j++)

{

sigma2+=V[k][j]*H[k];//求输出层内积

BP神经网络C语言代码 可以直接VC++上运行

//输出只有一个,如果多个,增加输出

return sum*(Maxout[0]-Minout[0]+1)+Minout[0]-1; //数据反归一化,回来到原来的值 }

void writeNeuron() {

FILE *fp1; int i,j; if((fp1=fopen("neuron.txt","w"))==NULL) {

//输入数据归一化处理 for (i = 0; i < In; i++)

for(j = 0; j < Data; j++) d_in[j][i]=(d_in[j][i]-Minin[i]+1)/(Maxin[i]-Minin[i]+1);

//输出数据归一化处理 for (i = 0; i < Out; i++)

writeNeuron();

return 0;

//测试数据 1

}

for (i = 0; i < Neuron; ++i) for (j = 0; j < Out; ++j){ fprintf(fp1,"%lf ",v[j][i]); }

fclose(fp1); }

void trainNetwork() {

int i,c=0;

do{

e=0;

for (i = 0; i < Data; ++i)

}

void computO(int var) //var 为某一个样本数据 {

int i,j; double sum,y; for (i = 0; i < Neuron; ++i) 个神经元的值 {

BP神经网络算法的C语言实现代码

//BP神经网络算法,c语言版本//VS2010下,无语法错误,可直接运行//添加了简单注释//欢迎学习交流#include <yerNum>#include <yerNum>#include <yerNum>#include <yerNum>#define N_Out 2 //输出向量维数#define N_In 3 //输入向量维数#define N_Sample 6 //样本数量//BP人工神经网络typedef struct{int LayerNum; //中间层数量double v[N_In][50]; //中间层权矩阵i,中间层节点最大数量为50 double w[50][N_Out]; //输出层权矩阵double StudyRate; //学习率double Accuracy; //精度控制参数int MaxLoop; //最大循环次数} BPNet;//Sigmoid函数double fnet(double net){return 1/(1+exp(-net));}//初始化int InitBpNet(BPNet *BP);//训练BP网络,样本为x,理想输出为yint TrainBpNet(BPNet *BP, double x[N_Sample][N_In], int y[N_Sample][N_Out]) ;//使用BP网络int UseBpNet(BPNet *BP);//主函数int main(){//训练样本double x[N_Sample][N_In] = {{0.8,0.5,0},{0.9,0.7,0.3},{1,0.8,0.5},{0,0.2,0.3},{0.2,0.1,1.3},{0.2,0.7,0.8}};//理想输出int y[N_Sample][N_Out] = {{0,1},{0,1},{0,1},{1,1},{1,0},{1,0}};BPNet BP;InitBpNet(&BP); //初始化BP网络结构TrainBpNet(&BP, x, y); //训练BP神经网络UseBpNet(&BP); //测试BP神经网络return 1;}//使用BP网络int UseBpNet(BPNet *BP){double Input[N_In];double Out1[50];double Out2[N_Out]; //Out1为中间层输出,Out2为输出层输出//持续执行,除非中断程序while (1){printf("请输入3个数:\n");int i, j;for (i = 0; i < N_In; i++)scanf_s("%f", &Input[i]);double Tmp;for (i = 0; i < (*BP).LayerNum; i++){Tmp = 0;for (j = 0; j < N_In; j++)Tmp += Input[j] * (*BP).v[j][i];Out1[i] = fnet(Tmp);}for (i = 0; i < N_Out; i++){Tmp = 0;for (j = 0; j < (*BP).LayerNum; j++)Tmp += Out1[j] * (*BP).w[j][i];Out2[i] = fnet(Tmp);}printf("结果:");for (i = 0; i < N_Out; i++)printf("%.3f ", Out2[i]);printf("\n");}return 1;}//训练BP网络,样本为x,理想输出为yint TrainBpNet(BPNet *BP, double x[N_Sample][N_In], int y[N_Sample][N_Out]) {double f = (*BP).Accuracy; //精度控制参数double a = (*BP).StudyRate; //学习率int LayerNum = (*BP).LayerNum; //中间层节点数double v[N_In][50], w[50][N_Out]; //权矩阵double ChgH[50], ChgO[N_Out]; //修改量矩阵double Out1[50], Out2[N_Out]; //中间层和输出层输出量int MaxLoop = (*BP).MaxLoop; //最大循环次数int i, j, k, n;double Tmp;for (i = 0; i < N_In; i++)// 复制结构体中的权矩阵for (j = 0; j < LayerNum; j++)v[i][j] = (*BP).v[i][j];for (i = 0; i < LayerNum; i++)for (j = 0; j < N_Out; j++)w[i][j] = (*BP).w[i][j];double e = f + 1;//对每个样本训练网络for (n = 0; e > f && n < MaxLoop; n++){e = 0;for (i= 0; i < N_Sample; i++){//计算中间层输出向量for (k= 0; k < LayerNum; k++){Tmp = 0;for (j = 0; j < N_In; j++)Tmp = Tmp + x[i][j] * v[j][k];Out1[k] = fnet(Tmp);}//计算输出层输出向量for (k = 0; k < N_Out; k++){Tmp = 0;for (j = 0; j < LayerNum; j++)Tmp = Tmp + Out1[j] * w[j][k];Out2[k] = fnet(Tmp);}//计算输出层的权修改量for (j = 0; j < N_Out; j++)ChgO[j] = Out2[j] * (1 - Out2[j]) * (y[i][j] - Out2[j]);//计算输出误差for (j = 0; j < N_Out ; j++)e = e + (y[i][j] - Out2[j]) * (y[i][j] - Out2[j]);//计算中间层权修改量for (j = 0; j < LayerNum; j++){Tmp = 0;for (k = 0; k < N_Out; k++)Tmp = Tmp + w[j][k] * ChgO[k];ChgH[j] = Tmp * Out1[j] * (1 - Out1[j]);}//修改输出层权矩阵for (j = 0; j < LayerNum; j++)for (k = 0; k < N_Out; k++)w[j][k] = w[j][k] + a * Out1[j] * ChgO[k];for (j = 0; j < N_In; j++)for (k = 0; k < LayerNum; k++)v[j][k] = v[j][k] + a * x[i][j] * ChgH[k];}if (n % 10 == 0)printf("误差: %f\n", e);}printf("总共循环次数:%d\n", n);printf("调整后的中间层权矩阵:\n");for (i = 0; i < N_In; i++){for (j = 0; j < LayerNum; j++)printf("%f ", v[i][j]);printf("\n");}printf("调整后的输出层权矩阵:\n");for (i = 0; i < LayerNum; i++) {for (j = 0; j < N_Out; j++)printf("%f ", w[i][j]);printf("\n");}//把结果复制回结构体for (i = 0; i < N_In; i++)for (j = 0; j < LayerNum; j++)(*BP).v[i][j] = v[i][j];for (i = 0; i < LayerNum; i++)for (j = 0; j < N_Out; j++)(*BP).w[i][j] = w[i][j];printf("BP网络训练结束!\n");return 1;}//初始化int InitBpNet(BPNet *BP){printf("请输入中间层节点数,最大数为100:\n");scanf_s("%d", &(*BP).LayerNum);printf("请输入学习率:\n");scanf_s("%lf", &(*BP).StudyRate); //(*BP).StudyRate为double型数据,所以必须是lfprintf("请输入精度控制参数:\n");scanf_s("%lf", &(*BP).Accuracy);printf("请输入最大循环次数:\n");scanf_s("%d", &(*BP).MaxLoop);int i, j;srand((unsigned)time(NULL));for (i = 0; i < N_In; i++)for (j = 0; j < (*BP).LayerNum; j++)(*BP).v[i][j] = rand() / (double)(RAND_MAX);for (i = 0; i < (*BP).LayerNum; i++)for (j = 0; j < N_Out; j++)(*BP).w[i][j] = rand() / (double)(RAND_MAX);return 1;}---精心整理,希望对您有所帮助。

C++实现简单BP神经网络

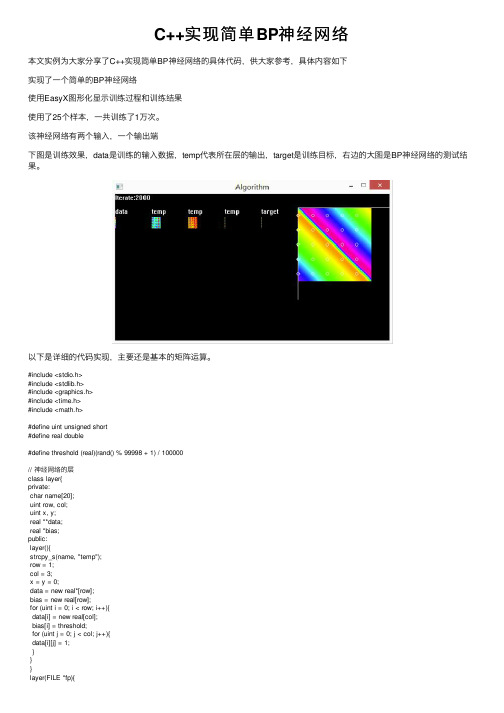

C++实现简单BP神经⽹络本⽂实例为⼤家分享了C++实现简单BP神经⽹络的具体代码,供⼤家参考,具体内容如下实现了⼀个简单的BP神经⽹络使⽤EasyX图形化显⽰训练过程和训练结果使⽤了25个样本,⼀共训练了1万次。

该神经⽹络有两个输⼊,⼀个输出端下图是训练效果,data是训练的输⼊数据,temp代表所在层的输出,target是训练⽬标,右边的⼤图是BP神经⽹络的测试结果。

以下是详细的代码实现,主要还是基本的矩阵运算。

#include <stdio.h>#include <stdlib.h>#include <graphics.h>#include <time.h>#include <math.h>#define uint unsigned short#define real double#define threshold (real)(rand() % 99998 + 1) / 100000// 神经⽹络的层class layer{private:char name[20];uint row, col;uint x, y;real **data;real *bias;public:layer(){strcpy_s(name, "temp");row = 1;col = 3;x = y = 0;data = new real*[row];bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = threshold;for (uint j = 0; j < col; j++){data[i][j] = 1;}}}layer(FILE *fp){fscanf_s(fp, "%d %d %d %d %s", &row, &col, &x, &y, name); data = new real*[row];bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = threshold;for (uint j = 0; j < col; j++){fscanf_s(fp, "%lf", &data[i][j]);}}}layer(uint row, uint col){strcpy_s(name, "temp");this->row = row;this->col = col;this->x = 0;this->y = 0;this->data = new real*[row];this->bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = threshold;for (uint j = 0; j < col; j++){data[i][j] = 1.0f;}}}layer(const layer &a){strcpy_s(name, );row = a.row, col = a.col;x = a.x, y = a.y;data = new real*[row];bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = a.bias[i];for (uint j = 0; j < col; j++){data[i][j] = a.data[i][j];}}}~layer(){// 删除原有数据for (uint i = 0; i < row; i++){delete[]data[i];}delete[]data;}layer& operator =(const layer &a){// 删除原有数据for (uint i = 0; i < row; i++){delete[]data[i];}delete[]data;delete[]bias;// 重新分配空间strcpy_s(name, );row = a.row, col = a.col;x = a.x, y = a.y;data = new real*[row];bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = a.bias[i];for (uint j = 0; j < col; j++){data[i][j] = a.data[i][j];}}return *this;}layer Transpose() const {layer arr(col, row);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[j][i] = data[i][j];}}return arr;}layer sigmoid(){layer arr(col, row);arr.x = x, arr.y = y;for (uint i = 0; i < x.row; i++){for (uint j = 0; j < x.col; j++){arr.data[i][j] = 1 / (1 + exp(-data[i][j]));// 1/(1+exp(-z)) }}return arr;}layer operator *(const layer &b){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = data[i][j] * b.data[i][j];}}return arr;}layer operator *(const int b){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = b * data[i][j];}}return arr;}layer matmul(const layer &b){layer arr(row, b.col);arr.x = x, arr.y = y;for (uint k = 0; k < b.col; k++){for (uint i = 0; i < row; i++){arr.bias[i] = bias[i];arr.data[i][k] = 0;for (uint j = 0; j < col; j++){arr.data[i][k] += data[i][j] * b.data[j][k];}}}return arr;}layer operator -(const layer &b){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = data[i][j] - b.data[i][j];}}return arr;}layer operator +(const layer &b){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = data[i][j] + b.data[i][j];}}return arr;}layer neg(){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = -data[i][j];}}return arr;}bool operator ==(const layer &a){bool result = true;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){if (abs(data[i][j] - a.data[i][j]) > 10e-6){result = false;break;}}}return result;}void randomize(){for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){data[i][j] = threshold;}bias[i] = 0.3;}}void print(){outtextxy(x, y - 20, name);for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){COLORREF color = HSVtoRGB(360 * data[i][j], 1, 1);putpixel(x + i, y + j, color);}}}void save(FILE *fp){fprintf_s(fp, "%d %d %d %d %s\n", row, col, x, y, name); for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){fprintf_s(fp, "%lf ", data[i][j]);}fprintf_s(fp, "\n");}}friend class network;friend layer operator *(const double a, const layer &b); };layer operator *(const double a, const layer &b){layer arr(b.row, b.col);arr.x = b.x, arr.y = b.y;for (uint i = 0; i < arr.row; i++){for (uint j = 0; j < arr.col; j++){arr.data[i][j] = a * b.data[i][j];}}return arr;}// 神经⽹络class network{int iter;double learn;layer arr[3];layer data, target, test;layer& unit(layer &x){for (uint i = 0; i < x.row; i++){for (uint j = 0; j < x.col; j++){x.data[i][j] = i == j ? 1.0 : 0.0;}}return x;}layer grad_sigmoid(layer &x){layer e(x.row, x.col);e = x*(e - x);return e;}public:network(FILE *fp){fscanf_s(fp, "%d %lf", &iter, &learn);// 输⼊数据data = layer(fp);for (uint i = 0; i < 3; i++){arr[i] = layer(fp);//arr[i].randomize();}target = layer(fp);// 测试数据test = layer(2, 40000);for (uint i = 0; i < test.col; i++){test.data[0][i] = ((double)i / 200) / 200.0f;test.data[1][i] = (double)(i % 200) / 200.0f;}}void train(){int i = 0;char str[20];data.print();target.print();for (i = 0; i < iter; i++){sprintf_s(str, "Iterate:%d", i);outtextxy(0, 0, str);// 正向传播layer l0 = data;layer l1 = arr[0].matmul(l0).sigmoid();layer l2 = arr[1].matmul(l1).sigmoid();layer l3 = arr[2].matmul(l2).sigmoid();// 显⽰输出结果l1.print();l2.print();l3.print();if (l3 == target){break;}// 反向传播layer l3_delta = (l3 - target ) * grad_sigmoid(l3);layer l2_delta = arr[2].Transpose().matmul(l3_delta) * grad_sigmoid(l2);layer l1_delta = arr[1].Transpose().matmul(l2_delta) * grad_sigmoid(l1);// 梯度下降法arr[2] = arr[2] - learn * l3_delta.matmul(l2.Transpose());arr[1] = arr[1] - learn * l2_delta.matmul(l1.Transpose());arr[0] = arr[0] - learn * l1_delta.matmul(l0.Transpose());}sprintf_s(str, "Iterate:%d", i);outtextxy(0, 0, str);// 测试输出// selftest();}void selftest(){// 测试layer l0 = test;layer l1 = arr[0].matmul(l0).sigmoid();layer l2 = arr[1].matmul(l1).sigmoid();layer l3 = arr[2].matmul(l2).sigmoid();setlinecolor(WHITE);// 测试例for (uint j = 0; j < test.col; j++){COLORREF color = HSVtoRGB(360 * l3.data[0][j], 1, 1);// 输出颜⾊putpixel((int)(test.data[0][j] * 160) + 400, (int)(test.data[1][j] * 160) + 30, color); }// 标准例for (uint j = 0; j < data.col; j++){COLORREF color = HSVtoRGB(360 * target.data[0][j], 1, 1);// 输出颜⾊setfillcolor(color);fillcircle((int)(data.data[0][j] * 160) + 400, (int)(data.data[1][j] * 160) + 30, 3); }line(400, 30, 400, 230);line(400, 30, 600, 30);}void save(FILE *fp){fprintf_s(fp, "%d %lf\n", iter, learn);data.save(fp);for (uint i = 0; i < 3; i++){arr[i].save(fp);}target.save(fp);}};#include "network.h"void main(){FILE file;FILE *fp = &file;// 读取状态fopen_s(&fp, "Text.txt", "r");network net(fp);fclose(fp);initgraph(600, 320);net.train();// 保存状态fopen_s(&fp, "Text.txt", "w");net.save(fp);fclose(fp);getchar();closegraph();}上⾯这段代码是在2016年初实现的,⾮常简陋,且不利于扩展。

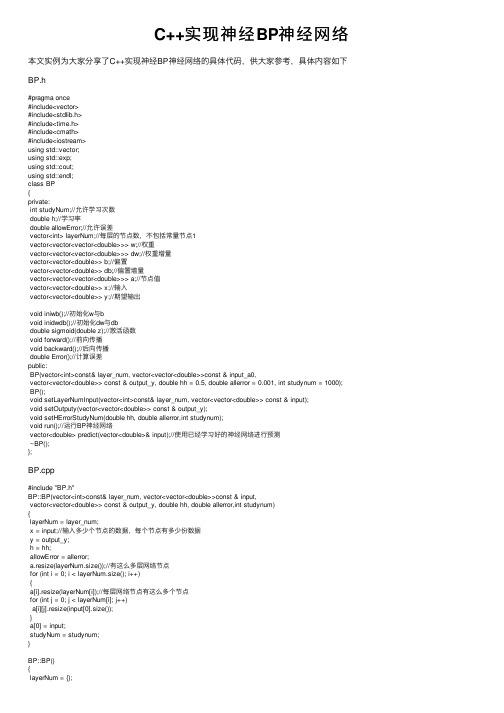

C++实现神经BP神经网络

C++实现神经BP神经⽹络本⽂实例为⼤家分享了C++实现神经BP神经⽹络的具体代码,供⼤家参考,具体内容如下BP.h#pragma once#include<vector>#include<stdlib.h>#include<time.h>#include<cmath>#include<iostream>using std::vector;using std::exp;using std::cout;using std::endl;class BP{private:int studyNum;//允许学习次数double h;//学习率double allowError;//允许误差vector<int> layerNum;//每层的节点数,不包括常量节点1vector<vector<vector<double>>> w;//权重vector<vector<vector<double>>> dw;//权重增量vector<vector<double>> b;//偏置vector<vector<double>> db;//偏置增量vector<vector<vector<double>>> a;//节点值vector<vector<double>> x;//输⼊vector<vector<double>> y;//期望输出void iniwb();//初始化w与bvoid inidwdb();//初始化dw与dbdouble sigmoid(double z);//激活函数void forward();//前向传播void backward();//后向传播double Error();//计算误差public:BP(vector<int>const& layer_num, vector<vector<double>>const & input_a0,vector<vector<double>> const & output_y, double hh = 0.5, double allerror = 0.001, int studynum = 1000); BP();void setLayerNumInput(vector<int>const& layer_num, vector<vector<double>> const & input);void setOutputy(vector<vector<double>> const & output_y);void setHErrorStudyNum(double hh, double allerror,int studynum);void run();//运⾏BP神经⽹络vector<double> predict(vector<double>& input);//使⽤已经学习好的神经⽹络进⾏预测~BP();};BP.cpp#include "BP.h"BP::BP(vector<int>const& layer_num, vector<vector<double>>const & input,vector<vector<double>> const & output_y, double hh, double allerror,int studynum){layerNum = layer_num;x = input;//输⼊多少个节点的数据,每个节点有多少份数据y = output_y;h = hh;allowError = allerror;a.resize(layerNum.size());//有这么多层⽹络节点for (int i = 0; i < layerNum.size(); i++){a[i].resize(layerNum[i]);//每层⽹络节点有这么多个节点for (int j = 0; j < layerNum[i]; j++)a[i][j].resize(input[0].size());}a[0] = input;studyNum = studynum;}BP::BP(){a = {};y = {};h = 0;allowError = 0;}BP::~BP(){}void BP::setLayerNumInput(vector<int>const& layer_num, vector<vector<double>> const & input) {layerNum = layer_num;x = input;a.resize(layerNum.size());//有这么多层⽹络节点for (int i = 0; i < layerNum.size(); i++){a[i].resize(layerNum[i]);//每层⽹络节点有这么多个节点for (int j = 0; j < layerNum[i]; j++)a[i][j].resize(input[0].size());}a[0] = input;}void BP::setOutputy(vector<vector<double>> const & output_y){y = output_y;}void BP::setHErrorStudyNum(double hh, double allerror,int studynum){h = hh;allowError = allerror;studyNum = studynum;}//初始化权重矩阵void BP::iniwb(){w.resize(layerNum.size() - 1);b.resize(layerNum.size() - 1);srand((unsigned)time(NULL));//节点层数层数for (int l = 0; l < layerNum.size() - 1; l++){w[l].resize(layerNum[l + 1]);b[l].resize(layerNum[l + 1]);//对应后层的节点for (int j = 0; j < layerNum[l + 1]; j++){w[l][j].resize(layerNum[l]);b[l][j] = -1 + 2 * (rand() / RAND_MAX);//对应前层的节点for (int k = 0; k < layerNum[l]; k++)w[l][j][k] = -1 + 2 * (rand() / RAND_MAX);}}}void BP::inidwdb(){dw.resize(layerNum.size() - 1);db.resize(layerNum.size() - 1);//节点层数层数for (int l = 0; l < layerNum.size() - 1; l++){dw[l].resize(layerNum[l + 1]);db[l].resize(layerNum[l + 1]);//对应后层的节点for (int j = 0; j < layerNum[l + 1]; j++){dw[l][j].resize(layerNum[l]);db[l][j] = 0;for (int k = 0; k < layerNum[l]; k++)w[l][j][k] = 0;}}}//激活函数double BP::sigmoid(double z){return 1.0 / (1 + exp(-z));}void BP::forward(){for (int l = 1; l < layerNum.size(); l++){for (int i = 0; i < layerNum[l]; i++){for (int j = 0; j < x[0].size(); j++){a[l][i][j] = 0;//第l层第i个节点第j个数据样本//计算变量节点乘权值的和for (int k = 0; k < layerNum[l - 1]; k++)a[l][i][j] += a[l - 1][k][j] * w[l - 1][i][k];//加上节点偏置a[l][i][j] += b[l - 1][i];a[l][i][j] = sigmoid(a[l][i][j]);}}}}void BP::backward(){int xNum = x[0].size();//样本个数//daP第l层da,daB第l+1层davector<double> daP, daB;for (int j = 0; j < xNum; j++){//处理最后⼀层的dwdaP.clear();daP.resize(layerNum[layerNum.size() - 1]);for (int i = 0, l = layerNum.size() - 1; i < layerNum[l]; i++){daP[i] = a[l][i][j] - y[i][j];for (int k = 0; k < layerNum[l - 1]; k++)dw[l - 1][i][k] += daP[i] * a[l][i][j] * (1 - a[l][i][j])*a[l - 1][k][j]; db[l - 1][i] += daP[i] * a[l][i][j] * (1 - a[l][i][j]);}//处理剩下层的权重w的增量Dwfor (int l = layerNum.size() - 2; l > 0; l--){daB = daP;daP.clear();daP.resize(layerNum[l]);for (int k = 0; k < layerNum[l]; k++){daP[k] = 0;for (int i = 0; i < layerNum[l + 1]; i++)daP[k] += daB[i] * a[l + 1][i][j] * (1 - a[l + 1][i][j])*w[l][i][k]; //dwfor (int i = 0; i < layerNum[l - 1]; i++)dw[l - 1][k][i] += daP[k] * a[l][k][j] * (1 - a[l][k][j])*a[l - 1][i][j]; //dbdb[l-1][k] += daP[k] * a[l][k][j] * (1 - a[l][k][j]);}}}//计算dw与db平均值{//对应后层的节点for (int j = 0; j < layerNum[l + 1]; j++){db[l][j] = db[l][j] / xNum;//对应前层的节点for (int k = 0; k < layerNum[l]; k++)w[l][j][k] = w[l][j][k] / xNum;}}//更新参数w与bfor (int l = 0; l < layerNum.size() - 1; l++){for (int j = 0; j < layerNum[l + 1]; j++){b[l][j] = b[l][j] - h * db[l][j];//对应前层的节点for (int k = 0; k < layerNum[l]; k++)w[l][j][k] = w[l][j][k] - h * dw[l][j][k];}}}double BP::Error(){int l = layerNum.size() - 1;double temp = 0, error = 0;for (int i = 0; i < layerNum[l]; i++)for (int j = 0; j < x[0].size(); j++){temp = a[l][i][j] - y[i][j];error += temp * temp;}error = error / x[0].size();//求对每⼀组样本的误差平均 error = error / 2;cout << error << endl;return error;}//运⾏神经⽹络void BP::run(){iniwb();inidwdb();int i = 0;for (; i < studyNum; i++){forward();if (Error() <= allowError){cout << "Study Success!" << endl;break;}backward();}if (i == 10000)cout << "Study Failed!" << endl;}vector<double> BP::predict(vector<double>& input) {vector<vector<double>> a1;a1.resize(layerNum.size());for (int l = 0; l < layerNum.size(); l++)a1[l].resize(layerNum[l]);a1[0] = input;for (int l = 1; l < layerNum.size(); l++)for (int i = 0; i < layerNum[l]; i++){a1[l][i] = 0;//第l层第i个节点第j个数据样本//计算变量节点乘权值的和for (int k = 0; k < layerNum[l - 1]; k++)a1[l][i] += a1[l - 1][k] * w[l - 1][i][k];//加上节点偏置a1[l][i] = sigmoid(a1[l][i]);}return a1[layerNum.size() - 1];}验证程序:#include"BP.h"int main(){vector<int> layer_num = { 1, 10, 1 };vector<vector<double>> input_a0 = { { 1,2,3,4,5,6,7,8,9,10 } };vector<vector<double>> output_y = { {0,0,0,0,1,1,1,1,1,1} };BP bp(layer_num, input_a0,output_y,0.6,0.001, 2000);bp.run();for (int j = 0; j < 30; j++){vector<double> input = { 0.5*j };vector<double> output = bp.predict(input);for (auto i : output)cout << "j:" << 0.5*j <<" pridict:" << i << " ";cout << endl;}system("pause");return 0;}输出:以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

C++实现的BP神经网络代码

#pragma hdrstop#include <stdio.h>#include <iostream.h>const A=30.0;const B=10.0;const MAX=500;//最大训练次数const COEF=0.0035; //网络的学习效率const BCOEF=0.001;//网络的阀值调整效率const ERROR=0.002; // 网络训练中的允许误差const ACCURACY=0.0005;//网络要求精度double sample[41][4]={{0,0,0,0},{5,1,4,19.020},{5,3,3,14.150},{5,5,2,14.360},{5,3,3,14.150},{5,3,2,15.390},{5,3,2,15.390},{5,5,1,19.680},{5,1,2,21.060},{5,3,3,14.150},{5,5,4,12.680},{5,5,2,14.360},{5,1,3,19.610},{5,3,4,13.650},{5,5,5,12.430},{5,1,4,19.020},{5,1,4,19.020},{5,3,5,13.390},{5,5,4,12.680},{5,1,3,19.610},{5,3,2,15.390},{1,3,1,11.110},{1,5,2,6.521},{1,1,3,10.190},{1,3,4,6.043},{1,5,5,5.242},{1,5,3,5.724},{1,1,4,9.766},{1,3,5,5.870},{1,5,4,5.406},{1,1,3,10.190},{1,1,5,9.545},{1,3,4,6.043},{1,5,3,5.724},{1,1,2,11.250},{1,3,1,11.110},{1,3,3,6.380},{1,5,2,6.521},{1,1,1,16.000},{1,3,2,7.219},{1,5,3,5.724}};double w[4][10][10],wc[4][10][10],b[4][10],bc[4][10];double o[4][10],netin[4][10],d[4][10],differ;//单个样本的误差double is; //全体样本均方差int count,a;void netout(int m, int n);//计算网络隐含层和输出层的输出void calculd(int m,int n); //计算网络的反向传播误差void calcalwc(int m,int n);//计算网络权值的调整量void calcaulbc(int m,int n); //计算网络阀值的调整量void changew(int m,int n); //调整网络权值void changeb(int m,int n);//调整网络阀值void clearwc(int m,int n);//清除网络权值变化量wcvoid clearbc(int m,int n);//清除网络阀值变化量bc-void initialw(void);//初始化NN网络权值Wvoid initialb(void); //初始化NN网络阀值void calculdiffer(void);//计算NN网络单个样本误差void calculis(void);//计算NN网络全体样本误差void trainNN(void);//训练NN网络//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*计算NN网络隐含层和输出层的输出*/void netout(int m,int n){int i,j,k;//隐含层各节点的的输出for (j=1,i=2;j<=m;j++) //m为隐含层节点个数{netin[i][j]=0.0;for(k=1;k<=3;k++)//隐含层的每个节点均有三个输入变量netin[i][j]=netin[i][j]+o[i-1][k]*w[i][k][j];netin[i][j]=netin[i][j]-b[i][j];o[i][j]=A/(1+exp(-netin[i][j]/B));}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------////输出层各节点的输出for (j=1,i=3;j<=n;j++){netin[i][j]=0.0;for (k=1;k<=m;k++)netin[i][j]=netin[i][j]+o[i-1][k]*w[i][k][j];netin[i][j]=netin[i][j]-b[i][j];o[i][j]=A/(1+exp(-netin[i][j]/B)) ;}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*计算NN网络的反向传播误差*/void calculd(int m,int n){int i,j,k;double t;a=count-1;d[3][1]=(o[3][1]-sample[a][3])*(A/B)*exp(-netin[3][1]/B)/pow(1+exp(-netin[3][1]/B),2);//隐含层的误差for (j=1,i=2;j<=m;j++){t=0.00;for (k=1;k<=n;k++)t=t+w[i+1][j][k]*d[i+1][k];d[i][j]=t*(A/B)*exp(-netin[i][j]/B)/pow(1+exp(-netin[i][j]/B),2);}}/*计算网络权值W的调整量*/void calculwc(int m,int n){int i,j,k;// 输出层(第三层)与隐含层(第二层)之间的连接权值的调整for (i=1,k=3;i<=m;i++){for (j=1;j<=n;j++){wc[k][i][j]=-COEF*d[k][j]*o[k-1][i]+0.5*wc[k][i][j];}// printf("\n");}//隐含层与输入层之间的连接权值的调整for (i=1,k=2;i<=m;i++){for (j=1;j<=m;j++){wc[k][i][j]=-COEF*d[k][j]*o[k-1][i]+0.5*wc[k][i][j];}//printf("\n");}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*计算网络阀值的调整量*/void calculbc(int m,int n){int j;for (j=1;j<=m;j++){bc[2][j]=BCOEF*d[2][j];}for (j=1;j<=n;j++){bc[3][j]=BCOEF*d[3][j];}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*调整网络权值*/void changw(int m,int n){int i,j;for (i=1;i<=3;i++)for (j=1;j<=m;j++){w[2][i][j]=0.9*w[2][i][j]+wc[2][i][j];//为了保证系统有较好的鲁棒性,计算权值时乘惯性系数0.9printf("w[2][%d][%d]=%f\n",i,j,w[2][i][j]);}for (i=1;i<=m;i++)for (j=1;j<=n;j++){w[3][i][j]=0.9*w[3][i][j]+wc[3][i][j];printf("w[3][%d][%d]=%f\n",i,j,w[3][i][j]);}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*调整网络阀值*/void changb(int m,int n){int j;for (j=1;j<=m;j++)b[2][j]=b[2][j]+bc[2][j];for (j=1;j<=n;j++)b[3][j]=b[3][j]+bc[3][j];}//------------------------------------------------------------------------------------------------- ---------------////------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*清除网络权值变化量wc*/void clearwc(void){for (int i=0;i<4;i++)for (int j=0;j<10;j++)for (int k=0;k<10;k++)wc[i][j][k]=0.00;}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*清除网络阀值变化量*/void clearbc(void){for (int i=0;i<4;i++)for (int j=0;j<10;j++)bc[i][j]=0.00;}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*初始化网络权值W*/void initialw(void){int i,j,k,x;double weight;for (i=0;i<4;i++)for (j=0;j<10;j++)for (k=0;k<10;k++){randomize();x=100+random(400);weight=(double)x/5000.00;w[i][j][k]=weight;}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*初始化网络阀值*/void initialb(void){int i,j,x;double fazhi;for (i=0;i<4;i++)for (j=0;j<10;j++){randomize();for (int k=0;k<12;k++){x=100+random(400);}fazhi=(double)x/50000.00;b[i][j]=fazhi;}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*计算网络单个样本误差*/void calculdiffer(void){a=count-1;differ=0.5*(o[3][1]-sample[a][3])*(o[3][1]-sample[a][3]);}void calculis(void){is=0.0;for (i=0;i<=19;i++){o[1][1]=sample[i][0];o[1][2]=sample[i][1];o[1][3]=sample[i][2];netout(8,1);is=is+(o[3][1]-sample[i][3])*(o[3][1]-sample[i][3]);}is=is/20;}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------///*训练网络*/void trainNN(void){long int time;initialw();initialb();for (time=1;time<=MAX;time++){count=0;while(count<=40){o[1][1]=sample[count][0];o[1][2]=sample[count][1];o[1][3]=sample[count][2];count=count+1;clearwc();clearbc();netout(8,1);calculdiffer();while(differ>ERROR)calculd(8,1);calculwc(8,1);calculbc(8,1);changw(8,1);changb(8,1);netout(8,1);calculdiffer();}}printf("This is %d times training NN...\n",time);calculis();printf("is==%f\n",is);if (is<ACCURACY) break;}}//------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// //------------------------------------------------------------------------------------------------- ---------------// #pragma argsusedint main(int argc, char* argv[]){double result;int m,test[4];char ch='y';cout<<"Please wait for the train of NN:"<<endl;trainNN();cout<<"Now,this modular network can work for you."<<endl;while(ch=='y' || ch=='Y'){cout<<"Please input data to be tested."<<endl;for (m=1;m<=3;m++)cin>>test[m];ch=getchar();o[1][1]=test[1];o[1][2]=test[2];o[1][3]=test[3];netout(8,1);result=o[3][1];printf("Final result is %f.\n",result); printf("Still test?[Yes] or [No]\n"); ch=getchar();}return 0;}。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

}

rate=0.8;

e=0.0;

in_rate=1.0;

}

//训练函数

public void train(double [,] p,double [,] t)

{

e=0.0;

yd[i]=t[isamp,i]/in_rate;

}

//计算隐层的输入和输出

for(int j=0;j<hideNum;j++)

{

o1[j]=0.0;

for(int i=0;i<inNum;i++)

Console.WriteLine("输入节点数目: "+inNum);

Console.WriteLine("隐层节点数目:"+hideNum);

Console.WriteLine("输出层节点数目:"+outNum);

Console.ReadLine();

db1=new double[hideNum];

db2=new double[outNum];

pp=new double[hideNum];

qq=new double[outNum];

yd=new double[outNum];

{

for(int i=0;i<w.GetLength(0);i++)

{

for(int j=0;j<w.GetLength(1);j++)

{

w[i,j]+=dw[i,j];

}

}

public double [] db2;//输出层阈值矩阵

double [] pp;//输出层的误差

double [] qq;//隐层的误差

double [] yd;//输出层的教师数据

public double e;//均方误差

double in_rate;//归一化比例系数

{

b2[k]+=rate*qq[k];

}

//更新b1

for(int j=0;j<hideNum;j++)

{

b1[j]+=rate*pp[j];

}

int hideNum;//隐层节点数

public int outNum;//输出层节点数

public int sampleNum;//样本总数

Random R;

double [] x;//输入节点的输入数据

double [] x1;//隐层节点的输出

{

pMax=Math.Abs(p[isamp,i]);

}

}

for(int j=0;j<outNum;j++)

{

if(Math.Abs(t[isamp,j])>pMax)

public int computeHideNum(int m,int n)

{

double s=Math.Sqrt(0.43*m*n+0.12*n*n+2.54*m+0.77*n+0.35)+0.51;

int ss=Convert.ToInt32(s);

{

o2[k]=0.0;

for(int j=0;j<hideNum;j++)

{

o2[k]+=v[j,k]*x1[j];

}

x2[k]=1.0/(1.0+Math.Exp(-o2[k]-b2[k]));

x=new double[inNum];

x1=new double[hideNum];

x2=new double[outNum];

o1=new double[hideNum];

o2=new double[outNum];

w=new double[inNum,hideNum];

}//end isamp

e=Math.Sqrt(e);

// adjustWV(w,dw);

// adjustWV(v,dv);

}//end train

public void adjustWV(double [,] w,double[,] dw)

{

pMax=Math.Abs(t[isamp,j]);

}

}

in_rate=pMax;

}//end isamp

for(int isamp=0;isamp<sampleNum;isamp++)

}

//计算输出层误差和均方差

for(int k=0;k<outNum;k++)

{

qq[k]=(yd[k]-x2[k])*x2[k]*(1.0-x2[k]);

e+=(yd[k]-x2[k])*(yd[k]-x2[k]);

}

public void adjustWV(double [] w,double[] dw)

{

for(int i=0;i<w.Length;i++)

{

w[i]+=dw[i];

}

{

pp[j]=0.0;

for(int k=0;k<outNum;k++)

{

pp[j]+=qq[k]*v[j,k];

}

pp[j]=pp[j]*x1[j]*(1-x1[j]);

{

//数据归一化

for(int i=0;i<inNum;i++)

{

x[i]=p[isamp,i]/in_rate;

}

for(int i=0;i<outNum;i++)

{

return ((s-(double)ss)>0.5) ? ss+1:ss;

}

public BpNet(double [,] p,double [,] t)

{

// 构造函数逻辑

R=new Random();

{

o1[j]+=w[i,j]*x[i];

}

x1[j]=1.0/(1.0+Math.Exp(-o1[j]-b1[j]));

}

//计算输出层的输入和输出

for(int k=0;k<outNum;k++)

//初始化w

for(int i=0;i<inNum;i++)

{

for(int j=0;j<hideNum;j++)

{

w[i,j]=(R.NextDouble()*2-1.0)/2;

}

}

//初始化v

for(int i=0;i<hideNum;i++)

{

for(int j=0;j<outNum;j++)

{

v[i,j]=(R.NextDouble()*2-1.0)/2;

v=new double[hideNum,outNum];

dw=new double[inNum,hideNum];

dv=new double[hideNum,outNum];

b1=new double[hideNum];

b2=new double[outNum];

using System;

using System.IO;

using System.Text;

namespace BpANNet

{

/// <summary>

/// BpNet 的摘要说明。

/// <Βιβλιοθήκη summary> public class BpNet

{

public int inNum;//输入节点数

//更新W

for(int i=0;i<inNum;i++)

{

w[i,j]+=rate*pp[j]*x[i];

}

}

//更新b2

for(int k=0;k<outNum;k++)

public double [,] dv;//权值矩阵V

public double rate;//学习率

public double [] b1;//隐层阈值矩阵

public double [] b2;//输出层阈值矩阵

public double [] db1;//隐层阈值矩阵

double [] x2;//输出节点的输出

double [] o1;//隐层的输入

double [] o2;//输出层的输入

public double [,] w;//权值矩阵w

public double [,] v;//权值矩阵V

public double [,] dw;//权值矩阵w

//求p,t中的最大值

double pMax=0.0;

for(int isamp=0;isamp<sampleNum;isamp++)

{

for(int i=0;i<inNum;i++)

{

if(Math.Abs(p[isamp,i])>pMax)

//更新V

for(int j=0;j<hideNum;j++)