机器学习4

请介绍至少四种典型的机器学习和数据挖掘算法

请介绍至少四种典型的机器学习和数据挖掘算法

1. 决策树:决策树是最常见的机器学习算法之一,是一种将数据(此

处即有关问题的观察和测量数据)映射到潜在结果(由结论和动作组成)的分类方法。

它通常适用于复杂的问题,可以自动分析和分类数据,从而有助于解决现实世界中的挑战性问题。

2. 聚类分析:聚类分析是一种机器学习和数据挖掘算法,它使用输入

数据创建一组相似元素的分组,并将不相似元素分为不同组。

它是一

种无监督学习,无需有任何先验知识,可以自动分析出模式和结构。

3. 线性回归:线性回归是机器学习中最重要的算法之一,它旨在为某

个变量或结果预测另一个变量或结果的值。

它允许我们预测和解释现

实世界中的客观观察。

通过线性回归,可以找到数据变量之间的关系,并应用该关系预测另一变量的值。

4. 支持向量机:支持向量机(SVM)是一种机器学习技术,它可以用

来解决分类和回归问题。

它不同于传统的感知机技术,能够解决非线

性问题。

它可以用来构建分类器,识别明确的目标和特征,通过拟合

相关性分析,以对不同的对象实行有效的分类。

机器学习的四大核心算法解析

机器学习的四大核心算法解析机器学习是人工智能领域的一个重要分支,通过让计算机具备自主学习和预测能力,使其能够根据过去的经验提供准确的决策和预测。

在机器学习领域中,有四种核心算法起到了至关重要的作用,它们分别是监督学习、无监督学习、半监督学习和强化学习。

以下将对这四大核心算法进行详细解析。

一、监督学习监督学习是机器学习中最常见和最基础的算法之一。

它是通过使用带有标签的训练数据来训练模型,并通过已知的输入和输出对新数据进行预测或分类。

监督学习的核心思想是根据已知的输入输出对建立模型,并利用该模型来预测未知数据的输出值。

最常见的监督学习算法包括决策树、朴素贝叶斯和支持向量机。

二、无监督学习无监督学习是一种没有标签的数据作为输入的机器学习技术。

与监督学习不同的是,无监督学习算法不要求先验的输入输出对。

它可以通过挖掘数据的内在结构和模式来对数据进行分类、聚类或关联分析。

无监督学习的核心思想是从无结构的数据中发现潜在的规律和特征。

常见的无监督学习算法包括聚类算法(如k-means算法)、关联规则算法和主成分分析。

三、半监督学习半监督学习是介于监督学习和无监督学习之间的一种学习方法。

它利用有标签和无标签的数据进行训练,以提高模型的性能。

半监督学习的核心思想是通过使用少量的标签数据和大量的未标签数据来提升模型的泛化能力。

常见的半监督学习算法包括标签传播算法、半监督支持向量机和生成模型。

四、强化学习强化学习是一种通过与环境的交互来学习最佳行为策略的机器学习算法。

它通过试错的方式,通过观察环境的反馈来调整策略,以获得最大的累积奖励。

强化学习的核心思想是在不确定的环境中,通过试错来学习最佳的行为决策。

常见的强化学习算法包括Q学习、深度强化学习和策略梯度方法。

通过对这四大核心算法的解析,我们可以看到它们在不同的问题领域和应用中都具有重要的作用。

监督学习适用于已有标签数据的分类和预测问题,无监督学习适用于数据聚类和关联规则分析,半监督学习适用于标签数据稀缺的情况下提升模型性能,而强化学习则适用于通过反馈机制学习最佳策略的问题。

机器学习第四章答案

Ans. The gradient descent is: ∇E ( w) = [

r

∂E ∂E ∂E , ,..., ] ∂w0 ∂w1 ∂wn

2 = ∑ (td − od )(− xid − xid )

∂E 2 = η ∑ (t d − od )( xid + xid ) ∂wi d ∈D

(2) A XOR B = (A ∧¬ B) ∨ (¬A ∧B) The weights are: Hidden unit 1: w0 = -0.8, w1 = 0.5, w2 = -0.5 Hidden unit 2: w0 = -0.8, w1 = -0.5, w2 = 0.5 Output unit: w0 = 0.3, w1 = 0.5, w2 = 0.5 x1(A) -1 -1 1 1 x2(B) -1 1 -1 1

2.) Ans. True. For each input instance x=(x1, x2), if x is satisfied by B, which means 2x1+x2>0, then we have 2x1+x2 +1>0. Hence, x is also satisfied by the A. 4.5. Derive a gradient descent training rule for a single unit with output o, where

d ∈D

∂E ∂ 1 2 = ∑ (td − od ) ∂wi ∂wi 2 d ∈D ∂ = ∑ (td − od ) (td − od ) ∂wi d ∈D

第4章机器学习

基于演绎的学习 (2) 按推理方式分类 基于归纳的学习 归纳学习 分析学习 连接学习 遗传算法

(3) 按综合属性分类

学习过程与推理过程是紧密相连的,按照

学习中使用推理的多少,机器学习所采用 的策略大体上可分为:机械学习、传授学 习、演绎学习、类比学习和归纳学习。 学习中所用的推理越多,系统的能力越强。

现在是电子计算机,以后还可能是中子 计算机、光子计算机或神经计算机等等。

意义

1、机器学习速度惊人; 2、机器学习可以把学习不断地延续下去,

避免大量的重复学习,使知识积累达到新 的高度; 未来的计算机将有自动获取知识的能力, 直接从书本中学习,通过与人谈话学习, 通过观察学习。通过实践自我完善。

3、机器学习有利于知识的传播:一台计算

机获取的知识很容易复制给任何其他机器。 4、克服人的存储少,效率低,注意力分散, 难以传送所获取知识等局限性。

4.1.2 机器学习的发展史

–机器学习的发展分为4个时期

第一阶段是在50年代中叶到60年代中叶,

属于热烈时期。 第二阶段在60年代中叶至70年代中叶, 被称为机器学习的冷静时期。 第三阶段从70年代中叶至80年代中叶, 称为复兴时期。 机器学习的最新阶段始于1986年。

常用的归纳推理方法有:

枚举归纳 联想归纳 类比归纳

Ⅰ. 枚举归纳 设a1, a2, …是某类事物 A 中的具体事物,若已知 a1, a2, …, an 都有属性 P ,并且没有发生反例,当 n 足 够大时,就可得出“ A 中所有事物都有属性 P ” 的结 论。 这是一种从个别事例归纳出一般性知识的方法, “ A 中所有事物都有属性 P ” 是通过归纳得到的新知 识。 例如:设有如下已知事例: 张三是足球运动员,他的体格健壮。 李四是足球运动员,他的体格健壮。 …… 赵十是足球运动员,他的体格健壮。

机器学习知识点归纳

机器学习知识点归纳机器学习是人工智能的一个重要分支领域,它研究如何设计和构建具有学习能力的算法和模型,使计算机系统可以通过数据和经验来自动提高性能。

在机器学习中,有许多重要的知识点需要掌握。

本文将对机器学习的关键知识点进行归纳总结。

一、监督学习监督学习是机器学习中最常见的一种学习方式。

它通过从已标记的数据集中学习到模型,然后利用这个模型对新的输入数据进行预测或分类。

监督学习的核心是构建一个输入和输出之间的映射关系。

其中常见的算法包括决策树、神经网络、支持向量机等。

二、无监督学习无监督学习是一种让机器从未标记的数据中自主学习的方法。

它不依赖于已有的标签信息,而是通过对数据的聚类、降维、关联分析等方法来发现数据中的隐藏模式和结构。

常见的无监督学习算法包括聚类算法、主成分分析、关联规则挖掘等。

三、半监督学习半监督学习是介于监督学习和无监督学习之间的一种学习模式。

它利用有标签的数据和无标签的数据来构建模型。

这种学习方式在现实场景中很常见,因为获取有标签数据往往比较困难或昂贵。

半监督学习的目标是通过利用无标签数据来提高模型的泛化性能。

四、强化学习强化学习是通过观察环境的反馈而不断调整模型的一种学习方式。

在强化学习中,机器学习系统不仅需要学习输入和输出之间的映射关系,还需要学习在一个动态环境中采取何种动作来最大化长期累积的奖励。

强化学习常用的算法包括Q-learning、SARSA等。

五、特征工程特征工程是机器学习过程中的一个关键环节。

它涉及到从原始数据中提取、选择和构造特征,以供机器学习算法使用。

好的特征可以帮助算法更好地理解数据,提高模型的预测能力。

特征工程的常用技术包括数据清洗、特征选择、特征变换等。

六、模型评估与选择在机器学习中,评估和选择合适的模型是非常重要的。

模型评估涉及到使用一些评估指标来度量模型的性能,如准确率、精确率、召回率等。

而模型选择则需要根据具体问题和数据的特点选择适合的模型算法。

七、模型调优与集成模型调优和集成是提高模型性能的关键技术。

《第一单元 人工智能基础 第4课 机器学习》教学设计

《机器学习》教学设计方案(第一课时)一、教学目标1. 理解机器学习的基本观点和原理。

2. 掌握机器学习算法的基本原理和应用。

3. 培养学生对信息技术课程的兴趣和好奇心。

二、教学重难点1. 重点:理解机器学习的基本观点和原理,掌握常见的机器学习算法。

2. 难点:如何应用机器学习解决实际问题,如何处理数据和算法优化。

三、教学准备1. 准备教学课件和案例素材。

2. 安排实验或小组活动,让学生实际操作机器学习算法。

3. 引导学生自行阅读相关文献,扩展知识面。

4. 安置课后作业,要求学生自主选择机器学习相关主题进行深入钻研。

四、教学过程:(一)课前预习与导入在上课前,要求学生自行预习有关机器学习的观点、定义、分类等相关基础知识,可以通过线上平台发布预习课件,让学生在平台上进行在线答题和讨论。

同时,在教室上进行简单的互动和讨论,引入机器学习的观点,激发学生的学习兴趣。

(二)新课讲解与示范1. 机器学习的基本观点和定义通过展示一些实际应用案例,如人脸识别、智能推荐等,让学生了解机器学习的应用途景和作用。

通过讲解机器学习的基本观点和定义,让学生了解机器学习的基本原理和流程。

2. 机器学习的分类介绍监督学习、无监督学习、强化学习等不同类型的机器学习算法,通过具体案例演示不同的机器学习算法的应用,让学生了解不同类型机器学习的特点和适用途景。

3. 代码实践与操作演示以Python语言为例,传授学生如何应用Scikit-learn库进行简单的监督学习,通过实际操作演示,让学生掌握如何编写代码实现机器学习模型,并分析数据集的结果。

(三)小组讨论与合作将学生分成若干小组,每组4-5人,针对不同的机器学习算法和应用途景进行讨论和合作,让学生自主探索机器学习的应用和实践。

教师可提供一些相关问题和挑战供学生思考和讨论。

(四)教室总结与延伸在教室结束前,总结本节课的重点和难点,强调机器学习的应用前景和未来发展趋势,鼓励学生继续关注和学习机器学习相关知识,为后续课程的学习打下基础。

第四范式平台的机器学习模型训练教程

第四范式平台的机器学习模型训练教程随着人工智能的快速发展,机器学习作为其中的重要分支,正逐渐应用到各个领域。

而第四范式平台作为一家专注于人工智能技术的创新型企业,提供了一套完整的机器学习模型训练教程,帮助用户快速上手并实现自己的模型训练目标。

一、平台简介第四范式平台是一款基于云计算和大数据技术的机器学习平台,旨在为用户提供高效、便捷的机器学习模型训练服务。

该平台拥有丰富的数据集和强大的算法库,用户可以根据自己的需求选择适合的数据集和算法进行模型训练。

二、数据准备在进行机器学习模型训练之前,首先需要准备好训练所需的数据。

第四范式平台支持用户上传自己的数据集,也提供了一些常用的公开数据集供用户选择。

用户可以根据实际需求,选择合适的数据集进行训练。

三、算法选择在数据准备完成后,接下来需要选择合适的算法进行模型训练。

第四范式平台提供了多种常用的机器学习算法,包括决策树、支持向量机、神经网络等。

用户可以根据自己的需求和数据特点选择合适的算法,进行模型训练。

四、模型训练在数据和算法选择完成后,可以开始进行模型训练了。

第四范式平台提供了一套完整的模型训练流程,用户只需要按照平台提供的指导,选择相应的参数和配置,即可开始进行模型训练。

平台还提供了实时的训练进度监控和结果展示,方便用户实时了解训练情况。

五、模型评估模型训练完成后,需要对训练得到的模型进行评估。

第四范式平台提供了多种评估指标和可视化工具,用户可以通过这些工具对模型的性能进行评估和分析。

根据评估结果,用户可以进一步优化模型,提高模型的准确性和泛化能力。

六、模型应用模型训练和评估完成后,用户可以将训练得到的模型应用到实际场景中。

第四范式平台支持将模型导出为可执行文件或API接口,用户可以根据自己的需求选择合适的方式进行模型应用。

平台还提供了一些示例代码和应用案例,方便用户参考和借鉴。

七、模型迭代机器学习模型的训练和应用是一个不断迭代的过程。

第四范式平台提供了模型管理和版本控制功能,用户可以方便地管理和追踪自己的模型。

《第一单元 人工智能基础 第4课 机器学习》教学设计教学反思-2023-2024学年初中信息技术青岛

《机器学习》教学设计方案(第一课时)一、教学目标1. 理解机器学习的基本概念和原理。

2. 掌握机器学习算法的基本步骤和应用场景。

3. 培养运用机器学习解决实际问题的能力。

二、教学重难点1. 重点:理解机器学习的基本原理和应用场景。

2. 难点:运用机器学习解决实际问题,如图像识别、自然语言处理等。

三、教学准备1. 准备教学PPT和相关视频素材。

2. 准备教学用具:计算机、平板电脑、传感器等设备。

3. 安排实践环节,为学生提供动手操作的机会。

4. 准备练习和测试题目,以评估学生的学习效果。

四、教学过程:本节课是《机器学习》教学设计的第一课时,主要目标是让学生了解机器学习的基本概念和基本原理,掌握机器学习算法的基本步骤,并能够初步应用机器学习算法解决实际问题。

1. 导入新课:首先通过一些实际案例,让学生了解机器学习在现实生活中的应用,激发学生对机器学习的兴趣。

2. 讲解机器学习的基本概念和原理:通过讲解线性回归、逻辑回归、决策树等机器学习算法的基本原理,让学生了解机器学习的基本概念和基本原理。

3. 介绍机器学习算法的基本步骤:包括数据收集、数据预处理、模型训练、模型评估等步骤,让学生掌握机器学习算法的基本步骤。

4. 实例讲解:通过具体的实例,让学生了解如何使用机器学习算法解决实际问题,例如如何使用决策树算法进行信用卡欺诈检测。

5. 课堂互动:鼓励学生提问,讨论,加深对机器学习的理解。

6. 课堂小结:回顾本节课的主要内容,让学生总结自己的收获。

7. 布置作业:要求学生阅读相关资料,深入了解机器学习算法的原理和应用,为下一节课做准备。

在教学过程中,应该注重与学生互动,鼓励学生参与讨论,激发学生的学习兴趣和积极性。

同时,应该注重理论与实践相结合,通过实例讲解让学生了解机器学习在实际问题中的应用,加深学生对机器学习的理解。

最后,应该注重学生的反馈和评价,及时调整教学方案,提高教学效果。

教学设计方案(第二课时)一、教学目标1. 理解机器学习的基本概念和原理。

机器学习中的模型部署与监控流程(四)

机器学习模型的部署与监控流程在实际应用中至关重要,它涉及到从训练模型到将其应用于实际业务场景的全过程。

本文将从模型部署和监控两个方面展开讨论,介绍机器学习中的模型部署与监控流程。

一、模型部署模型部署是指将经过训练的模型应用于实际的业务场景中,使得模型能够对新的数据进行预测或分类。

在进行模型部署之前,我们需要考虑模型的环境依赖、性能要求、安全性等因素。

1. 环境依赖模型的环境依赖是指模型在应用时所需的硬件和软件环境。

例如,某些模型可能需要在GPU上运行以获得更好的性能,因此需要将模型部署在支持GPU加速的服务器上。

同时,模型还需要依赖特定的软件库和工具,因此在部署模型之前需要确保目标环境中已经安装了所需的软件依赖。

2. 性能要求在将模型部署到生产环境中时,我们需要考虑模型的性能要求。

例如,某些模型需要在特定的时间内完成预测任务,因此需要对模型进行性能优化以满足实时性要求。

另外,还需要考虑模型的扩展性,即模型能否处理大规模的数据和请求。

3. 安全性模型部署过程中还需要考虑模型的安全性。

这包括对模型进行权限控制,防止未授权的访问和使用;对模型进行数据加密,以保护模型和数据的安全;以及对模型进行漏洞和攻击的检测和防护。

二、模型监控模型部署后,我们需要对模型进行监控,以确保模型的预测结果是准确可靠的。

模型监控主要包括模型性能监控、数据质量监控和模型漂移检测。

1. 模型性能监控模型性能监控是指对模型在生产环境中的性能进行实时监测和分析。

这包括对模型的预测准确率、响应时间、资源利用率等指标进行监控,以及对模型在不同条件下的性能进行对比和分析。

通过模型性能监控,我们可以及时发现模型性能下降或异常,从而采取相应的措施进行修复和优化。

2. 数据质量监控模型的预测结果受到输入数据的质量影响,因此需要对输入数据的质量进行监控。

数据质量监控包括对数据的完整性、准确性、一致性等方面进行监控和分析,以及对数据异常和缺失进行检测和处理。

4阶张量形状

4阶张量形状所谓4阶张量,是指一个具有4个维度的张量。

张量是一个多维数组,可以存储多个数据。

在机器学习和数字图像处理等领域中,4阶张量被广泛应用于表示高维数据。

一个4阶张量的形状可以表示为(m, n, p, q),其中m、n、p和q 分别表示张量的第一、第二、第三和第四维度的大小。

4阶张量可以看作一个多维矩阵的扩展。

与二维矩阵类似,4阶张量可以进行加法、减法、乘法等基本运算操作。

但是,由于其更高的维度,4阶张量具有更丰富的表示能力和更加复杂的计算需求。

在机器学习中,4阶张量通常用于表示多通道图像数据。

在彩色图像中,每个像素由RGB三个通道的数值表示,因此可以将彩色图像表示为一个3阶张量。

但是,对于具有多个通道的图像数据,如卫星遥感图像或医学图像,我们需要使用4阶张量来存储这些数据。

例如,可以将一个具有300个点的卫星遥感图像以及10个通道的信息表示为一个形状为(300, 300, 10, 1)的4阶张量。

其中第一维和第二维表示图像的高度和宽度,第三维表示图像的通道数,第四维表示批次数。

在使用4阶张量进行计算时,我们可以进行各种操作,如切片、拼接、转置等。

切片操作可以提取出感兴趣的部分图像或通道,从而实现图像的裁剪和筛选。

拼接操作则可以将不同的图像或通道合并成一个更大的张量。

转置操作可以改变张量的维度顺序,从而实现数据的转换和重组。

除了图像数据,4阶张量还可以用于表示视频数据、时间序列数据等。

在视频数据中,每帧图像可以看作是一个3维张量,将多个连续帧拼接起来,则可以构成一个4阶张量,用于表示整个视频序列。

而在时间序列数据中,我们可以将不同时间点的数据按照一定顺序排列,构成一个4阶张量,用于表示整个时间序列。

总之,4阶张量是一种非常灵活、丰富的数据表示形式,可以用于存储和处理各种高维数据。

在机器学习和数字图像处理等领域中,对于复杂数据的建模和分析,4阶张量的使用成为了一种常见的做法。

通过合理地选择4阶张量的形状和维度顺序,我们可以更好地表示和操作高维数据,提高数据处理的效率和准确性。

《第一单元第4课机器学习》作业设计方案-初中信息技术青岛版24第六册自编模拟

《机器学习》作业设计方案(第一课时)一、作业目标本次作业的主要目标包括:1. 了解机器学习的基本概念与常见算法;2. 初步体验通过软件工具进行简单的机器学习实践;3. 培养学生的逻辑思维能力和创新能力,为后续深入学习打下基础。

二、作业内容作业内容主要分为以下几个部分:1. 理论学习学生需通过教材或网络资源,自学机器学习的基本概念,包括定义、发展历程、主要应用领域等。

同时,需掌握常见的机器学习算法,如决策树、支持向量机、神经网络等的基本原理。

2. 软件实践学生需使用指定的软件平台(如Python编程环境),完成一个简单的机器学习实践项目。

具体要求如下:(1)选择一个合适的数据集,可以是平台提供的标准数据集或学生自行收集的数据;(2)使用选定的机器学习算法对数据进行训练;(3)根据训练结果进行模型评估和调整参数,以达到较好的预测效果。

3. 作业报告学生需撰写一份简短的作业报告,内容包括:(1)对机器学习基本概念的总结;(2)所选数据集的描述及预处理过程;(3)所使用的机器学习算法的原理及实现过程;(4)训练结果的分析与评估;(5)对本次实践的反思与建议。

三、作业要求1. 学生需在规定时间内独立完成作业,不得抄袭或请他人代做;2. 理论学习部分需充分准备,对基本概念和算法有清晰的理解;3. 软件实践部分需按照要求完成所有步骤,并确保代码的正确性和可读性;4. 作业报告需条理清晰,内容完整,重点突出,语言流畅;5. 提交作业时需同时提交电子版和纸质版,电子版通过指定平台提交,纸质版交至教师处。

四、作业评价作业评价将根据以下标准进行:1. 理论学习部分的掌握程度;2. 软件实践部分的完成情况和代码质量;3. 作业报告的完整性和质量;4. 学生的创新能力和解决问题的能力。

评价结果将分为优秀、良好、及格和不及格四个等级。

五、作业反馈教师将对每位学生的作业进行详细批改,指出存在的问题和不足之处,并给出改进建议。

模流分析MPI4介绍

MPI4的学习曲线较陡峭,需要一定的技术门槛;同时,MPI4在某些应用场景 中可能存在性能瓶颈,需要结合其他技术手段进行优化。

MPI4基本概念

02

MPI4并行计算基础

01

并行计算

并行计算是一种计算方式,它通过将一个任务分解为多 个子任务,并分配给多个处理器或计算机同时处理,以 提高计算效率和速度。

通信协议。

随着计算技术的发展,MPI4 逐渐成为并行计算领域中的 标准接口,广泛应用于科学 计算、工程模拟、数据分析

等领域。

MPI4经历了多个版本的迭代 和发展,不断优化和扩展其 功能,以满足不同应用场景 的需求。

MPI4的应用领域

科学计算

MPI4在科学计算领域中应用广泛, 如气候模拟、物理模拟、生物信 息学等,通过并行计算提高计算 效率和精度。

通信

MPI4提供了各种通信函数和操作符, 用于进程间数据传输和同步。这些函 数包括发送和接收、广播、散播、收 集等。

MPI4函数和操作符

函数

MPI4包含一系列函数,用于实现并行计算的各种功能,如创建和销毁进程、设置进程属性、执行并行操作等。

操作符

MPI4还提供了一组操作符,用于简化并行编程中的一些常见操作,如比较、逻辑运算等。

模流分析mpi4介绍

目录

• MPI4背景介绍 • MPI4基本概念 • MPI4编程实现 • 绍

MPI4的起源和发展

MPI4(Message Passing Interface version 4)起源于 20世纪90年代,最初是为了满 足高性能计算领域对于大规模 并行计算的需求而开发的一种

工程模拟

MPI4用于各种工程模拟,如流体 动力学、结构分析、电磁场模拟 等,帮助工程师更好地理解和优 化设计。

机器学习导论 第4章 支持向量机

4.1 统计学习理论基础

学习过程的数学研究 F. Rosenblatt于1958,1962年把感知器作为一个学习 机器模型

统计学习理论的开始 Novikoff适定问题的正则化原则的发现 Tikhonov(1963), Ivanov(1962), Phillips(1962)

4.1 统计学习理论基础

机器学习 主要研究从采集样本出发得出目前尚不能通过原理分 析得到的规律,并利用这些规律对未来数据或无法观 测的数据进行预测。

模式识别 对表征事务或现象的各种形式(数值、文字及逻辑关系 等)信息进行处理和分析,以对事务或现象进行描述、 辨认、分类和解释的过程。

4.1 统计学习理论基础

第4章 支持向量机

本章学习目标

了解经验风险最小化和结构风险最小化的含义以及它们之间 的区别。

理解“支持向量”的概念以及最大化间隔的基本思想。 掌握支持向量机(SVM)的基本原理。 熟悉核函数的作用以及核方法的原理。 熟悉支持向量机(SVM)的特点及应用场合。

第4章 支持向量机

4.1 统计学习理论基础 4.2 支持向量机的基本原理和特点 4.3 线性SVM 4.4 基于核函数的非线性SVM 4.5 多分类SVM 4.6 支持向量机的训练

传统的机器学习理论基础——统计学

缺点:统计学研究的是样本数目趋于无穷大时的渐近理论 实际问题:样本有限(小样本)

统计学习理论

对小样本统计估计和预测学习的最佳理论

【注意】:这里所说的“小样本”是相对于无穷样本而言的,故 只要样本数不是无穷,都可称为小样本,更严格地说,应该称为 “有限样本”。

密度估计是统计学中的一个全能问题,即知道了密度就可以解决 各 种 问 题 。 一 般 地 , 估 计 密 度 是 一 个 不 适 定 问 题 ( ill-posed problem),需要大量观测才能较好地解决。

周志华《机器学习》课后答案——第4章.决策树

周志华《机器学习》课后答案——第4章.决策树

周志华⽼师的《机器学习》是⼀本⾮常难得的国内学者的好教材。

为了好好学习,博主决定啃⼀啃周⽼师书中的课后习题。

本⼈答案仅供参考,若有错误,请⼤神们不吝指教。

(本系列⽂章实时更新)

1.试证明对于不含冲突数据(即特征向量完全相同但标记不同)的训练集,必存在与训练集⼀致(即训练误差为0)的决策树。

答:不含冲突数据;决策树是按照特征来进⾏划分->可以得到每个叶节点中的样本的所有特征及标记完全相同的决策树->与训练集⼀致。

试析使⽤"最⼩训练误差"作为决策树划分选择准则的缺陷

答:使⽤"最⼩训练误差"作为决策树划分选择准则,由于使⽤的是训练集数据,可能会将训练特征中的⼀些异常或者偶然作为模型的⼀部分,导致过度拟合的问题。

试编程实现基于信息熵进⾏划分选择的决策树算法,并为表4.3中数据⽣成⼀棵决策树。

机器学导论第四版答案

机器学导论第四版答案

1、移动运营商对客户的流失进行预测,可以使用下面哪种机器学习方法比较合适(A)。

A、一元线性回归分析。

B、关联方法。

C、聚类算法。

D、多层前馈网络。

2、下面哪种说法有关机器学习的认识是错误的(C)。

A、高质量的数据、算力和算法对一个机器学习项目是必不可少的。

B、深度学习是机器学习的一类高级算法,可以处理图像、声音和文本等复杂数据。

C、机器学习算法很多,后期出现的算法比早期出现的算法性能好。

D、机器学习可以在一定程度上模仿人的学习,并能增强人的决策能力。

3、以下哪个步骤不是机器学习所需的预处理工作(B)。

A、数值属性的标准化。

B、变量相关性分析。

C、异常值分析。

D、与用户讨论分析需求。

4、数据预处理对机器学习是很重要的,下面说法正确的是(A)。

A、数据预处理的效果直接决定了机器学习的结果质量。

B、数据噪声对神经网络的训练没什么影响。

C、对于有问题的数据都直接删除即可。

D、预处理不需要花费大量的时间。

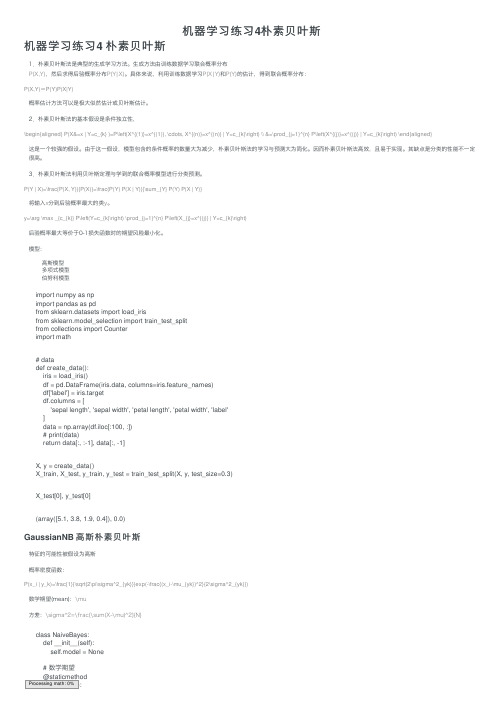

机器学习练习4朴素贝叶斯

机器学习练习4朴素贝叶斯机器学习练习4 朴素贝叶斯1.朴素贝叶斯法是典型的⽣成学习⽅法。

⽣成⽅法由训练数据学习联合概率分布P(X,Y),然后求得后验概率分布P(Y|X)。

具体来说,利⽤训练数据学习P(X|Y)和P(Y)的估计,得到联合概率分布:P(X,Y)=P(Y)P(X|Y)概率估计⽅法可以是极⼤似然估计或贝叶斯估计。

2.朴素贝叶斯法的基本假设是条件独⽴性,\begin{aligned} P(X&=x | Y=c_{k} )=P\left(X^{(1)}=x^{(1)}, \cdots, X^{(n)}=x^{(n)} | Y=c_{k}\right) \\ &=\prod_{j=1}^{n} P\left(X^{(j)}=x^{(j)} | Y=c_{k}\right) \end{aligned}这是⼀个较强的假设。

由于这⼀假设,模型包含的条件概率的数量⼤为减少,朴素贝叶斯法的学习与预测⼤为简化。

因⽽朴素贝叶斯法⾼效,且易于实现。

其缺点是分类的性能不⼀定很⾼。

3.朴素贝叶斯法利⽤贝叶斯定理与学到的联合概率模型进⾏分类预测。

P(Y | X)=\frac{P(X, Y)}{P(X)}=\frac{P(Y) P(X | Y)}{\sum_{Y} P(Y) P(X | Y)}将输⼊x分到后验概率最⼤的类y。

y=\arg \max _{c_{k}} P\left(Y=c_{k}\right) \prod_{j=1}^{n} P\left(X_{j}=x^{(j)} | Y=c_{k}\right)后验概率最⼤等价于0-1损失函数时的期望风险最⼩化。

模型:⾼斯模型多项式模型伯努利模型import numpy as npimport pandas as pdfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_splitfrom collections import Counterimport math# datadef create_data():iris = load_iris()df = pd.DataFrame(iris.data, columns=iris.feature_names)df['label'] = iris.targetdf.columns = ['sepal length', 'sepal width', 'petal length', 'petal width', 'label']data = np.array(df.iloc[:100, :])# print(data)return data[:, :-1], data[:, -1]X, y = create_data()X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3)X_test[0], y_test[0](array([5.1, 3.8, 1.9, 0.4]), 0.0)GaussianNB ⾼斯朴素贝叶斯特征的可能性被假设为⾼斯概率密度函数:P(x_i | y_k)=\frac{1}{\sqrt{2\pi\sigma^2_{yk}}}exp(-\frac{(x_i-\mu_{yk})^2}{2\sigma^2_{yk}})数学期望(mean):\mu⽅差:\sigma^2=\frac{\sum(X-\mu)^2}{N}class NaiveBayes:def __init__(self):self.model = None# 数学期望@staticmethodProcessing math: 0%def mean(X):return sum(X) / float(len(X))# 标准差(⽅差)def stdev(self, X):avg = self.mean(X)return math.sqrt(sum([pow(x - avg, 2) for x in X]) / float(len(X)))# 概率密度函数def gaussian_probability(self, x, mean, stdev):exponent = math.exp(-(math.pow(x - mean, 2) /(2 * math.pow(stdev, 2))))return (1 / (math.sqrt(2 * math.pi) * stdev)) * exponent# 处理X_traindef summarize(self, train_data):summaries = [(self.mean(i), self.stdev(i)) for i in zip(*train_data)]return summaries# 分类别求出数学期望和标准差def fit(self, X, y):labels = list(set(y))data = {label: [] for label in labels}for f, label in zip(X, y):data[label].append(f)self.model = {label: self.summarize(value)for label, value in data.items()}return 'gaussianNB train done!'# 计算概率def calculate_probabilities(self, input_data):# summaries:{0.0: [(5.0, 0.37),(3.42, 0.40)], 1.0: [(5.8, 0.449),(2.7, 0.27)]} # input_data:[1.1, 2.2]probabilities = {}for label, value in self.model.items():probabilities[label] = 1for i in range(len(value)):mean, stdev = value[i]probabilities[label] *= self.gaussian_probability(input_data[i], mean, stdev)return probabilities# 类别def predict(self, X_test):# {0.0: 2.9680340789325763e-27, 1.0: 3.5749783019849535e-26}label = sorted(self.calculate_probabilities(X_test).items(),key=lambda x: x[-1])[-1][0]return labeldef score(self, X_test, y_test):right = 0for X, y in zip(X_test, y_test):label = self.predict(X)if label == y:right += 1return right / float(len(X_test))model = NaiveBayes()model.fit(X_train, y_train)'gaussianNB train done!'print(model.predict([4.4, 3.2, 1.3, 0.2]))0.0model.score(X_test, y_test)1.0scikit-learn实例from sklearn.naive_bayes import GaussianNB, BernoulliNB, MultinomialNB # ⾼斯模型、伯努利模型和多项式模型clf = GaussianNB()clf.fit(X_train, y_train)GaussianNB(priors=None, var_smoothing=1e-09)clf.score(X_test, y_test)1.0clf.predict([[4.4, 3.2, 1.3, 0.2]])array([0.])参考Prof. Andrew Ng. Machine Learning. Stanford University李航,《统计学习⽅法》,清华⼤学出版社。

jpt4人工智能

jpt4人工智能JPT4 人工智能一、引言随着科技的不断发展,人工智能成为了时代的焦点。

JPT4 作为一种优秀的编程语言,也不例外。

本文将介绍 JPT4 在人工智能领域的应用以及未来的发展趋势。

二、JPT4与人工智能JPT4 作为一种功能丰富的编程语言,在人工智能领域也有不少的应用。

它不仅可以用来实现常见的机器学习算法,还可以用来开发智能体、聊天机器人等人工智能应用。

以下是 JPT4 在人工智能领域的几个应用案例。

1. 机器学习机器学习是一种通过训练让计算机自动学习问题解决方式的算法。

JPT4 可以通过其强大的数学库,实现各种机器学习算法。

如逻辑回归、SVM、神经网络等。

这给人工智能研究者提供了非常强大的工具。

2. 智能体开发智能体是一种模拟人类智能的程序,可以模拟智能行为,并根据环境变化作出相应行动。

JPT4 可以开发各种类型的智能体,如机器人、自动驾驶汽车、智能房屋等。

3. 聊天机器人聊天机器人是一种通过计算机与人交互的程序,具有自主回答问题、理解自然语言等功能。

JPT4 可以用来实现聊天机器人的功能,开发出一个让用户可以与之自由交流的智能机器人。

三、未来发展趋势人工智能不断发展,JPT4 也将不断向前发展。

以下是 JPT4 在人工智能未来的发展趋势。

1. 更好的机器学习算法随着人工智能的不断发展,机器学习算法也将越来越复杂化。

JPT4 将不断优化其机器学习算法,以适应更复杂的人工智能场景。

2. 更人性化的交互聊天机器人可以让人与计算机自由交流,但目前仍存在一些问题。

JPT4 将不断优化聊天机器人的交互方式,让其更加自然、人性化。

3. 更好的智能体模拟随着模拟技术的不断提高,JPT4 可以实现更多类型的智能体,如智能医生、智能客服、智能家居等。

这将让人们的生活更加智能化、便捷化。

四、结论随着人工智能的不断发展,JPT4 在人工智能领域的应用也越来越广泛。

未来,JPT4 将不断发展,随着科技的不断创新,新的人工智能应用将不断涌现。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

从概率大小看机器学习

机器学习的任务:在给定训练数据D时,确定 假设空间H中的最佳假设。 最佳假设:一有关知识 下的最可能假设 贝叶斯理论提供了一种计算假设概率的方法

• 基于假设的先验概率、给定假设下观察到不同数 据的概率以及观察到的数据本身

Form 2: (常见的数学描述形式)

电子商务系

机器学习

2011-1-5 ‹#›

五、Bayes决策与经验风险最小化 决策与经验风险最小化

电子商务系

机器学习

2011-1-5 ‹#›

决策的错误率 定义:

• • 条件错误率: 平均错误率(期望错误率):条件错误 率的期望(均值)

电子商务系

机器学习

2011-1-5 ‹#›

问题是:如何求解决策函数 gi(x) ?

电子商务系

机器学习

2011-1-5 ‹#›

Bayes决策函数 Bayes决策函数 已知先验概率P(ωi)和观测值的类条件概 率密度函数p(x|ωi),i=1,2… 则决策函数 决策函数为: 决策函数

电子商务系

机器学习

2011-1-5 ‹#›

Bayes MAP分类判决 MAP分类判决

2011-1-5 ‹#›

例子1 例子1

假设:

• h1: cancer;h2:~cancer

观察到的数据(来自化验结果):

• X={x1,x2}={阳性,阴性}

已知各种概率:

• p(h1)=0.008; p(h2)=0.992; p(x1|h1)=0.98; p(x1|h2)=0.03; …

问题:观测到数据x1=阳性,假设为h1的概率 有多大?(即求p(h1|X=阳性)或p(h1|x1))

机器学习

(Machine Learning)

贝叶斯学习

主讲:杜剑峰 主讲:

电子商务系

机器学习

2011-1-5 ‹#›

提纲

一. 二. 三. 四. 五. 六. 七. 八.

简介 Bayes法则 Bayes概念学习 Bayes决策理论 Bayes决策与经验风险最小化 最优Bayes分类器 朴素Bayes分类器 Bayes信念网(Bayesian Belief Network)

Bayes公式 Bayes公式

但是,如何计算后验概率 P(h|D)? 【答】 Bayes 公式 贝叶斯公式提供了从先验概率P(h)、P(D)和 P(D|h)计算后验概率P(h|D)的方法

P(h|D)随着P(h)和P(D|h)的增长而增长,随着 P(D)的增长而减少

• 即如果D独立于h时被观察到的可能性越大,那么 D对h的支持度越小 电子商务系 机器学习

判别函数 (discriminant function): 相应于每一类定义一个函数,得到一组判别 函数:gi(x), i = 1, 2, …, c

• 通常表征了样本x输入类别ωi的概率 机器学习

2011-1-5 ‹#›

电子商务系

MAP决策准则 MAP决策准则 以后验概率 后验概率为判决函数: 后验概率 相应的MAP决策规则为:

电子商务系 机器学习

2011-1-5 ‹#›

Bayes MAP法则与候选消除算法 MAP法则与候选消除算法

假定

• 训练数据D是无噪声的,即di=c(xi) • 目标概念c包含在假设空间H中 • 每个假设的概率相同

求得

• 由于所有假设的概率之和是1,因此 • 由于训练数据无噪声,那么给定假设h时,与h一 致的D的概率为1,不一致的概率为0,因此

一种自然想到的决策策略:

• 在某种条件下概率最大的假设就是我们想寻找的 假设 电子商务系 机器学习

2011-1-5 ‹#›

先验概率和后验概率

先验概率(prior probability):用P(h)表示在没有训 练数据前假设h拥有的初始概率,P(h) 称为h的先 验概率。

• 先验概率反映了关于h是一正确假设的机会的背景知识 • 如果没有这一先验知识,可以简单地将每一候选假设 赋予相同的先验概率

类似地,P(D)表示训练数据D的先验概率 条件概率:P(D|h)表示假设h成立时D的概率 后验概率(posterior probability ):P(h|D),即给定 D时h成立的概率,称为给定数据D下h的后验概率

• 机器学习中,我们更关心的是后验概率 (Why?) 电子商务系 机器学习

2011-1-5 ‹#›

全概率公式

0.00784 = 0.00784 + 0.0298 = 0.21

电子商务系

机器学习

2011-1-5 ‹#›

例子2 例子2

问题:如果我们观察到桔子,选择红 色盒子的概率是多少? 【解答】以B表示选择盒子的随机变 量(值为r或b),以F表示选择水果 的随机变量(值为o或a),假设 P(B=r)=4/10和P(B=b)=6/10,则

2011-1-5 ‹#›

Bayes学习的应用前提 Bayes学习的应用前提

需要概率的初始知识,当概率预先未知时, 可以基于背景知识、预先准备好的数据以及 基准分布的假定来估计这些概率或概率分布 的参数

电子商务系

机器学习

2011-1-5 ‹#›

二、Bayes法则 法则

电子商务系

机器学习

2011-1-5 ‹#›

基于最小风险的 最小风险的Bayes决策 决策:选择(条件) 最小风险的 决策 风险最小的决策(假设)。 Bayes最小风险决策通过保证每个观测值下 的条件风险最小,使得它的期望风险最小, 是一致最优决策。 决策规则:

电子商务系

机器学习

2011-1-5 ‹#›

风险最小化Bayes决策算法 风险最小化Bayes决策算法

风险分析数学模型

设 {ω1, ω2,…, ωN} 为N个类别(N种假设) 设 {D1, D2,…, DN} 为N种可能的决策 (Decision) 设λ(αi | ωj )为样本实际分类为ωj时采取行为 αi的损失 做出决策 (x)=ωi,但实际上 x ∈ωj,受到 决策D 决策 的损失定义为: 损失矩阵或决策表:

电子商务系

机器学习

2011-1-5 ‹#›

例子1 例子1:解答

Bayes公式 + 全概率公式

P ( h1 | x1 ) =

=

P ( x1 | h1 ) P ( h1 ) P ( x1 )

P ( x1 | h1 ) P ( h1 ) P ( x1 | h1 ) P ( h1 ) + P ( x1 | h2 ) P ( h2 )

电子商务系

机器学习

2011-1-5 ‹#›

为什么要Bayes学习(推理) 为什么要Bayes学习(推理)

贝叶斯学习为衡量多个假设的置信度提供了 定量的方法 贝叶斯学习为基于概率的学习算法提供了基 础,也为相关算法的分析提供了理论框架 贝叶斯学习算法能够计算显式的假设概率, 比如朴素贝叶斯分类 Bayes决策理论在机器学习的许多算法中提供 很好的数学及框架性理论基础

电子商务系

机器学习

2011-1-5 ‹#›

Bayes MAP学习算法 MAP学习算法 Brute-Force MAP 学习算法

• Step 1:对于H中每个假设h,计算后验概 率: • Step 2:输出具有最大后验概率的假设:

MAP : Maximum A Posterior(最大后验 概率准则)

电子商务系

机器学习

2011-1-5 ‹#›

一、简介

电子商务系

机器学习

2011-1-5 ‹#›

简介

现实生活中观察到的样本实例大多数情况下是一个 随机过程产生的概念事件,很多情况下不是一个确 定性事件

• 水上运动 • 金融 • 手写数字,语音,图像,人脸,通信流量….

因此,有必要考察样本的概率特性 根据观测数据样本及相关的概率特性来进行学习, 从而进行最优的决策或分类

电子商务系

机器学习

2011-1-5 ‹#›

四、Bayes决策理论 决策理论

电子商务系

机器学习

2011-1-5 ‹#›

判别函数

以两类分类问题为例:已知先验分布P(ωi) 和观测值的类条件分布 p(x|ωi),i=1,2 问题:对某个样本x,抉择x∈ω1? x∈ω2? 问题

• • 实际上求: p(ωi | x) ,i=1,2 然后进行决策判别

=

2 3

电子商务系

机器学习

2011-1-5 ‹#›

三、Bayes概念学习 概念学习

电子商务系

机器学习

2011-1-5 ‹#›

Bayes法则及Bayes概念学习 Bayes法则及Bayes概念学习 贝叶斯法则为计算给定训练数据下任一 假设的后验概率提供了原则性方法, 因此可以直接将其作为一个基本的学习 方法:计算每个假设的概率,再输出其 中概率最大的。 这个方法称为Brute-Force贝叶斯概念学 习算法。

2个苹果 6个桔子

3个苹果 1个桔子

P( F = o | B = r ) P( B = r ) P ( B = r | F = o) = P ( F = o) P( F = o | B = r ) P( B = r ) = P ( F = o | B = r ) P ( B = r ) + P ( F = o | B = b) P ( B = b) 6 4 8 ⋅ 10 = 6 4 1 6 8 ⋅ 10 + 4 ⋅ 10

1 ∀di , di = h( xi ) P(D | h) = 0 otherwise

电子商务系

机器学习

2011-1-5 ‹#›

Bayes MAP法则与候选消除算法(续) MAP法则与候选消除算法(

考虑Brute-Force MAP算法的第一步

0 ⋅ P (h) • h与D不一致, ( h | D ) = P =0 P(D) • h与D一致, , 1 1 1⋅ 1 | H| | H| P(h| D) = = = |VSH,D | |VSH,D | P(D) | H|