信息论基础教程2

合集下载

第二信息论基础ppt文档

H(x)=-log2(1/M)=log2M=log22N=N

RbM NRB 数字通信原理

2021年4月11日星期日

xn

p(xn)

其中

p(xi ) 1

i 1

数字通信原理

2021年4月11日星期日

离散信源的平均信息量

则x1、x2、…、xn所包含的信息量分别为 -log2P(x1) - log2P(x2) … -log2P(xn)。

数字通信原理

2021年4月11日星期日

离散信源的平均信息量

于是,每个符号所含信息量的统计平均 值,即平均信息量为

H(x)=0.25*log24+ 0.75*log2(4/3)=0.81

数字通信原理

2021年4月11日星期日

二元信号与其概率分布的关系

1 0.9 0.8 0.7 0.6 0.5 0.4 0.3 0.2 0.1

0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1

§3 连续消息的信息量的度量

Ixloagp(1x)loagp(x)

n个码元的总信息量 I = n I x

数字通信原理

2021年4月11日星期日

离散信源的平均信息量

2、非等概离散消息的度量

❖符号集:

组成离散信息源的n个符号xi组成的集合 每个符号xi在消息中是按一定概率P(xi)独立出

现的,设符号集中各符号出现的概率:

x1 x2 p(x1) p(x2)

数字通信原理

2021年4月11日星期日

信息量和概率

❖由概率论可知,事件的不确定性可以用其出 现的概率来描述。

❖因此消息中所含的信息量I与消息出现的概率 P(x)间的关系式应反映如下规律:

信息论第2章PPT(2012z最新版)

们引入平均自信息量来表述信源输出消息的不肯定性。 们引入平均自信息量来表述信源输出消息的不肯定性。

平均自信息量又称为信源熵、 或无条件熵。 平均自信息量又称为信源熵、信息熵 或无条件熵。

表示信源输出消息中的每个符号所含信息量的统计 平均自信息量H (X ) 表示信源输出消息中的每个符号所含信息量的统计 平均值, 平均值,其表达式为 q

[

]

(a1a1 L a2 ) L (aq aq L aq ) X N (a1a1 L a1 ) = P (a a L a ) P (a a L a ) L P (a a L a ) 1 1 1 1 1 2 q q q P (X )

这个概率空间共有 q N 个元素。 个元素。 多符号的离散信源可以分为 多符号的离散信源 可以分为 1) 离散无记忆信源 ) 2) 离散有记忆信源 )

一般情况下, 如果取以 r 为底的对数 r>1) 一般情况下, ( ) , 则

I (ai ) = − log r P (ai )

(r 进制单位)

通常采用“比特”作为信息量的实用单位。 通常采用“比特”作为信息量的实用单位。

已知二元信源输出“ 、 两种符号, 例: 已知二元信源输出“0”、“1”两种符号, 两种符号 出现概率相等, (1)如果“0”、“1”出现概率相等,计算出现 如果“ 、 出现概率相等 的信息量; “0”的信息量; 的信息量 出现概率为1/3 (2)如果“0”出现概率为1/3,计算出现“1”的 如果“ 出现概率为1/3,计算出现“ 的 信息量。 信息量。 根据信息量的定义式, 解:根据信息量的定义式,可以得到

2、平均自信息量H(X) 、平均自信息量

如果一个离散信源输出的消息符号集合为 X = {x i } = {x1 , x 2 , L , x q } , 信源输出的消息符号不同,所含有的信息量就不相同,因此, 信源输出的消息符号不同,所含有的信息量就不相同,因此,自信息量

平均自信息量又称为信源熵、 或无条件熵。 平均自信息量又称为信源熵、信息熵 或无条件熵。

表示信源输出消息中的每个符号所含信息量的统计 平均自信息量H (X ) 表示信源输出消息中的每个符号所含信息量的统计 平均值, 平均值,其表达式为 q

[

]

(a1a1 L a2 ) L (aq aq L aq ) X N (a1a1 L a1 ) = P (a a L a ) P (a a L a ) L P (a a L a ) 1 1 1 1 1 2 q q q P (X )

这个概率空间共有 q N 个元素。 个元素。 多符号的离散信源可以分为 多符号的离散信源 可以分为 1) 离散无记忆信源 ) 2) 离散有记忆信源 )

一般情况下, 如果取以 r 为底的对数 r>1) 一般情况下, ( ) , 则

I (ai ) = − log r P (ai )

(r 进制单位)

通常采用“比特”作为信息量的实用单位。 通常采用“比特”作为信息量的实用单位。

已知二元信源输出“ 、 两种符号, 例: 已知二元信源输出“0”、“1”两种符号, 两种符号 出现概率相等, (1)如果“0”、“1”出现概率相等,计算出现 如果“ 、 出现概率相等 的信息量; “0”的信息量; 的信息量 出现概率为1/3 (2)如果“0”出现概率为1/3,计算出现“1”的 如果“ 出现概率为1/3,计算出现“ 的 信息量。 信息量。 根据信息量的定义式, 解:根据信息量的定义式,可以得到

2、平均自信息量H(X) 、平均自信息量

如果一个离散信源输出的消息符号集合为 X = {x i } = {x1 , x 2 , L , x q } , 信源输出的消息符号不同,所含有的信息量就不相同,因此, 信源输出的消息符号不同,所含有的信息量就不相同,因此,自信息量

第二章 信息论基本概念

XY X Y XY Y

= P(xy)logP(y)/P(y|x)

XY

XY

XY

在这里同样利用自然对数性质:lnω ≤ ω -1 ,ω >0 当且仅当ω =1时,式取等 令ω =P(y)/P(y|x),引用 lnω ≤ ω -1 H(Y|X)-H(Y)≤ P(xy)[P(y)/P(y|x)-1]loge = [P(x)P(y)-P(xy)]loge XY =(1-1)loge=0

第二章 信息论基本概念

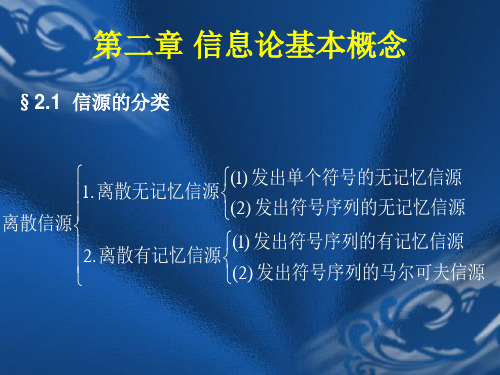

§2.1 信源的分类

(1) 发出单个符号的无记忆信源 1. 离散无记忆信源 (2) 发出符号序列的无记忆信源 离散信源 (1) 发出符号序列的有记忆信源 2. 离散有记忆信源 (2) 发出符号序列的马尔可夫信源

§2.2 自信息量和条件自信息量 一. 自信息量

XY

下面推导说明求条件熵用联合概率加权的理由 先取在一个条件y下,X集合的条件熵H(X|y)为: H(X|y)= P(x|y)I(x|y) X =- P(x|y)logP(x|y) X

进一步把H(X|y)在Y集合上取数学期望,就得条件熵H(X|Y)为:

H(X|Y)= P(y)H(X|y) Y =- P(y)P(x|y)logP(x|y) XY =- P(xy)logP(x|y) XY

由定义式可知,若一个以等概率出现的二进制码元(0,1), 即当P(0)=P(1)=1/2时 1 I(0)=I(1)=- log 2 2 = log 2 =1bit 2 在此引入不确定度概念 若 出现概率 → 1 (发生可能性大,包含的不确定度小) 出现概率 → 0 (发生可能性小,包含的不确定度大) 出现概率 = 1 (包含的不确定度为0) 注意:随机事件的不确定度在数量上等于它的自信息量,两 者单位相同,但含义却不相同。具有某种概率分布的随机事件 不管发生与否,都存在不确定度,不确定度表征了该事件的特 性,而自信息量是在该事件发生后给予观察者的信息量。

= P(xy)logP(y)/P(y|x)

XY

XY

XY

在这里同样利用自然对数性质:lnω ≤ ω -1 ,ω >0 当且仅当ω =1时,式取等 令ω =P(y)/P(y|x),引用 lnω ≤ ω -1 H(Y|X)-H(Y)≤ P(xy)[P(y)/P(y|x)-1]loge = [P(x)P(y)-P(xy)]loge XY =(1-1)loge=0

第二章 信息论基本概念

§2.1 信源的分类

(1) 发出单个符号的无记忆信源 1. 离散无记忆信源 (2) 发出符号序列的无记忆信源 离散信源 (1) 发出符号序列的有记忆信源 2. 离散有记忆信源 (2) 发出符号序列的马尔可夫信源

§2.2 自信息量和条件自信息量 一. 自信息量

XY

下面推导说明求条件熵用联合概率加权的理由 先取在一个条件y下,X集合的条件熵H(X|y)为: H(X|y)= P(x|y)I(x|y) X =- P(x|y)logP(x|y) X

进一步把H(X|y)在Y集合上取数学期望,就得条件熵H(X|Y)为:

H(X|Y)= P(y)H(X|y) Y =- P(y)P(x|y)logP(x|y) XY =- P(xy)logP(x|y) XY

由定义式可知,若一个以等概率出现的二进制码元(0,1), 即当P(0)=P(1)=1/2时 1 I(0)=I(1)=- log 2 2 = log 2 =1bit 2 在此引入不确定度概念 若 出现概率 → 1 (发生可能性大,包含的不确定度小) 出现概率 → 0 (发生可能性小,包含的不确定度大) 出现概率 = 1 (包含的不确定度为0) 注意:随机事件的不确定度在数量上等于它的自信息量,两 者单位相同,但含义却不相同。具有某种概率分布的随机事件 不管发生与否,都存在不确定度,不确定度表征了该事件的特 性,而自信息量是在该事件发生后给予观察者的信息量。

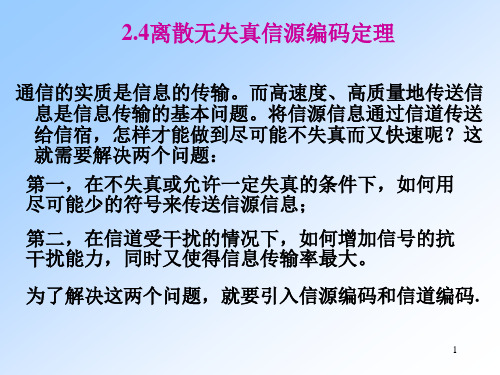

信息论基础课件2.4

10

2.4.1 定长编码定理

所谓信源编码, 所谓信源编码,就是将信源符号序列变换成另一个序列 码字)。设信源输出符号序列长度为L, )。设信源输出符号序列长度为 (码字)。设信源输出符号序列长度为 ,码字的长度 编码的目的, 为KL ,编码的目的,就是要使信源的信息率最小,也就 编码的目的 就是要使信源的信息率最小, 是说,要用最少的符号来代表信源。在定长编码中, 是说,要用最少的符号来代表信源。在定长编码中,对 每一个信源序列,K 都是定值,设等于K, 每一个信源序列 L都是定值,设等于 ,我们的目的是 寻找最小K值 要实现无失真的信源编码, 寻找最小 值。要实现无失真的信源编码,要求信源符 与码字是一一对应的, 号Xi(i=1,2,…q ) 与码字是一一对应的,并要求由码字组 成的符号序列的逆变换也是唯一的(唯一可译码)。 成的符号序列的逆变换也是唯一的(唯一可译码)。

9

即时码的码树图还可以用来译码。 即时码的码树图还可以用来译码。当收到一串码 符号序列后,首先从根节点出发, 符号序列后,首先从根节点出发,根据接收到 的第一个码符号来选择应走的第一条路径, 的第一个码符号来选择应走的第一条路径,再 根据收到的第二个符号来选择应走的第二条路 直到走到终端节点为止, 径,直到走到终端节点为止,就可以根据终端 节点,立即判断出所接收的码字。 节点,立即判断出所接收的码字。然后从树根 继续下一个码字的判断。这样, 继续下一个码字的判断。这样,就可以将接收 到的一串码符号序列译成对应的信源符号序列。 到的一串码符号序列译成对应的信源符号序列。

K log 2 m ≥ H ( X ) + ε L

则当L足够大时, 则当 足够大时,必可使译码差错小于 足够大时

K log L

2

信息论基础第2章离散信源及其信息度量

《信息论基础》

第2章 离散信源及其信息度量

本章内容

2.1 离散信源的分类 2.2 离散信源的统计特性 2.3 离散随机变量的信息度量 2.4 离散信源的N次扩展信源 2.5 离散平稳信源 2.6 马尔可夫信源 2.7 离散信源的相关性和剩余度

《信息论基础》

2.1 离散信源的分类

离散信源的分类

按照离散信源输出的是一个消息符号还是消息符 号序列,可分为单符号离散信源和多符号离散信 源。

,

q2 pn

,

qm ) pn

n

m

其中, pi 1, qj pn 。

i1

j 1

可见,由于划分而产生的不确定性而导致熵的增加量为

pnHm (

q1 pn

,

q2 pn

, qm pn

)

6、上凸性

熵函数 H (p) 是概率矢量 p ( p1, p2 ,

pq ) 的严格∩型凸函数

( 或 称 上 凸 函 数 )。 即 对 任 意 概 率 矢 量 p1 ( p1, p2 , pq ) 和

成 H ( p1) 或 H ( p2 ) 。

和自信息相似,信息熵 H ( X ) 有两种物理含义:

① 信源输出前,信源的信息熵表示信源的平均 不确定度。

② 信源输出后,信源的信息熵表示信源输出一 个离散消息符号所提供的平均信息量。如果信道无噪 声干扰,信宿获得的平均信息量就等于信源的平均信 息量,即信息熵。需要注意的是,若信道中存在噪声, 信宿获得的平均信息量不再是信息熵,而是 2.5 节介 绍的平均互信息。

联合熵 H (XY ) 的物理含义表示联合离散符号集 XY 上

的每个元素对平均提供的信息量或平均不确定性。 单位为“bit/符号对”。 需要注意的是,两个随机变量 X 和 Y 既可以表示两个

第2章 离散信源及其信息度量

本章内容

2.1 离散信源的分类 2.2 离散信源的统计特性 2.3 离散随机变量的信息度量 2.4 离散信源的N次扩展信源 2.5 离散平稳信源 2.6 马尔可夫信源 2.7 离散信源的相关性和剩余度

《信息论基础》

2.1 离散信源的分类

离散信源的分类

按照离散信源输出的是一个消息符号还是消息符 号序列,可分为单符号离散信源和多符号离散信 源。

,

q2 pn

,

qm ) pn

n

m

其中, pi 1, qj pn 。

i1

j 1

可见,由于划分而产生的不确定性而导致熵的增加量为

pnHm (

q1 pn

,

q2 pn

, qm pn

)

6、上凸性

熵函数 H (p) 是概率矢量 p ( p1, p2 ,

pq ) 的严格∩型凸函数

( 或 称 上 凸 函 数 )。 即 对 任 意 概 率 矢 量 p1 ( p1, p2 , pq ) 和

成 H ( p1) 或 H ( p2 ) 。

和自信息相似,信息熵 H ( X ) 有两种物理含义:

① 信源输出前,信源的信息熵表示信源的平均 不确定度。

② 信源输出后,信源的信息熵表示信源输出一 个离散消息符号所提供的平均信息量。如果信道无噪 声干扰,信宿获得的平均信息量就等于信源的平均信 息量,即信息熵。需要注意的是,若信道中存在噪声, 信宿获得的平均信息量不再是信息熵,而是 2.5 节介 绍的平均互信息。

联合熵 H (XY ) 的物理含义表示联合离散符号集 XY 上

的每个元素对平均提供的信息量或平均不确定性。 单位为“bit/符号对”。 需要注意的是,两个随机变量 X 和 Y 既可以表示两个

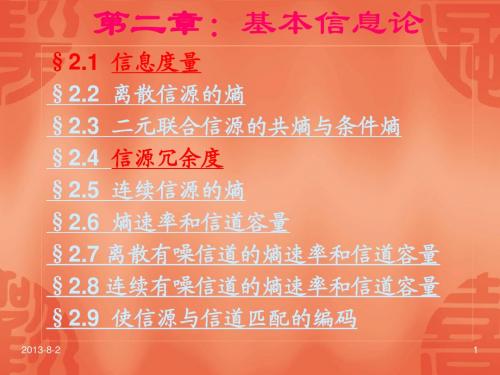

信息论理论基础(第二章)

第二章:基本信息论

§2.1 信息度量 §2.2 离散信源的熵 §2.3 二元联合信源的共熵与条件熵 §2.4 信源冗余度 §2.5 连续信源的熵 §2.6 熵速率和信道容量 §2.7 离散有噪信道的熵速率和信道容量 §2.8 连续有噪信道的熵速率和信道容量 §2.9 使信源与信道匹配的编码

2013-8-2 1

I ( xi ; y j ) I ( xi ) I ( xi | y j ) log p( xi | y j ) p( xi )

(2-5)

互信息量 I ( xi ; y j ) 实际上就是已知事件 y j 后,所消除的关于事件 x i 的不肯定性,它等于事件 x i 本身的不肯定性 I ( xi ) 减去已知事件 y j 后对 x i 仍然存在的不肯定性 I ( xi | y j ) 。 互信息量的引出使信息的传递得到了定量的表示,是信息论发展的一个重要的里程碑。这里还 应指出,互信息量的单位的取法与自信息量的相同,不再详述。

I ( xi | y j ) log p( xi | y j )

2013-8-2

(2-4)

9

自信息量的单位与所用对数的底有关,如下: ⑴ 通常取对数的底为 2,信息量的单位为比特(bit,binary unit)。比特是信息论中最常 用的信息量的单位,当取对数的底为 2 时,2 常省略。 注意:计算机术语中 bit 是位的单位(bit,binary digit),与信息量的单位不同。 ⑵ 若取自然对数(以 e 为底) ,自信息量的单位为奈特(nat,natural unit)。理论推导或 用于连续信源时用以 e 为底的对数比较方便。 1 nat= log2 e bit=1.443bit ⑶ 工程上用以 10 为底较方便。若以 10 为对数底,则信息量的单位为哈特莱(Hartley)。 这是用来纪念哈特莱首先提出用对数来度量信息的。 1 Hartley= log2 e bit=3.322bit

§2.1 信息度量 §2.2 离散信源的熵 §2.3 二元联合信源的共熵与条件熵 §2.4 信源冗余度 §2.5 连续信源的熵 §2.6 熵速率和信道容量 §2.7 离散有噪信道的熵速率和信道容量 §2.8 连续有噪信道的熵速率和信道容量 §2.9 使信源与信道匹配的编码

2013-8-2 1

I ( xi ; y j ) I ( xi ) I ( xi | y j ) log p( xi | y j ) p( xi )

(2-5)

互信息量 I ( xi ; y j ) 实际上就是已知事件 y j 后,所消除的关于事件 x i 的不肯定性,它等于事件 x i 本身的不肯定性 I ( xi ) 减去已知事件 y j 后对 x i 仍然存在的不肯定性 I ( xi | y j ) 。 互信息量的引出使信息的传递得到了定量的表示,是信息论发展的一个重要的里程碑。这里还 应指出,互信息量的单位的取法与自信息量的相同,不再详述。

I ( xi | y j ) log p( xi | y j )

2013-8-2

(2-4)

9

自信息量的单位与所用对数的底有关,如下: ⑴ 通常取对数的底为 2,信息量的单位为比特(bit,binary unit)。比特是信息论中最常 用的信息量的单位,当取对数的底为 2 时,2 常省略。 注意:计算机术语中 bit 是位的单位(bit,binary digit),与信息量的单位不同。 ⑵ 若取自然对数(以 e 为底) ,自信息量的单位为奈特(nat,natural unit)。理论推导或 用于连续信源时用以 e 为底的对数比较方便。 1 nat= log2 e bit=1.443bit ⑶ 工程上用以 10 为底较方便。若以 10 为对数底,则信息量的单位为哈特莱(Hartley)。 这是用来纪念哈特莱首先提出用对数来度量信息的。 1 Hartley= log2 e bit=3.322bit

LN2-信息论基础2

平

均

只

需要H∞

(X

)比

特

。

压

缩

比

极

限

可

达

到

H∞ (X ) H0 (X )

。

这பைடு நூலகம்

个

比

值

也

叫

信

源

的

效

率η,相应定义信源的冗余度为

R

=

1

−

η

=

H0(X) − H∞(X) H0 (X )

=

1

−

H∞ (X ) H0 (X )

实际信源的特征往往是:符号不等概,符号之间有很强的相关性。因此它

一定可以压缩,具体方法的压缩能力或许有区别,最大的压缩程度可由η或R衡

扣除了过去所有符号在XL上的贡献,只传送纯新的增量信息。如果我们只考 虑A个符号,即对于第L个输出符号,只扣除前A−1个符号的贡献,那么效率就

会低一些,平均每符号最少需要的比特数将是HA(X) H(XL|XL−1, · · · , XL−A+1)。

3

H2(X) = H(XL|XL−1)只考虑前一个符号的贡献;H1(X) H(X)只考虑单个 符号,不考虑相关性,但考虑了不等概特性;H0 (X )则连不等概都不考虑,即 不进行压缩。下面的不等式是显而易见的

办法,如课本上的例7.6.2。我们对此不作特别要求,只是再次重申一下信息论

的观点:

传输(或存储)序列{X1, X2, · · · , XL}(L非常大)所需要的比特数最少 是H(X1, X2, · · · , XL),折合到每个符号仅为:

H∞ (X )

lim

L→∞

H (X1 ,

X2, · L

·

信息论基础课件2[1][1].1.1- 2

![信息论基础课件2[1][1].1.1- 2](https://img.taocdn.com/s3/m/5d523fd3360cba1aa811da2f.png)

r i 1

a2

…

ar p(ar)

p(a2) …

0 p(a i ) 1i 1,2, r

p(a i ) 1

信息论与编码-信源熵

需要注意的是,大写字母X,Y,Z代表随机变量,指 的是信源整体,带下标的小写字母代表随机事件的 某一结果或信源的某个元素。两者不可混淆。

信息论与编码-信源熵

(4) 如p(xi)=1,则I(xi) =0 ;(必然事件不含有任何不确定 性,所以不含有任何信息量)

(5) 自信息量也是一个随机变量,它没有确定的值。

信息论与编码-信源熵

例2、 设有12枚同值硬币,其中有一枚为假币,且只知道假币

的重量与真币的重量不同,但不知究竟是轻是重。现采 用天平比较两边轻重的方法来测量(因无法码)。问至 少需要称多少次才能称出假币? 解:用天平每称一次能获得一定的信息量,能消除部分的不 确定性。测量若干次后,能消除全部不确定性,获得全部信 息,也就能确定出假币。 设“在12枚同值硬币中,某一枚为假币”该事件为a, p(a ) 1 / 12 则 p 又设“假币是重、或是轻”该事件为b,则(b) 1 / 2

(5)当X与Y相互独立时,

p( y j / xi ) p( y j ), p( xi / y j ) p( xi ), p( xi y j ) p( xi ) p( y j )

( 6) p( x i / y j ) p( x i y j )

p( x i y j )

i 1

n

p( y j / xi )

i 1 n j 1 i 1 j 1 i 1

n

m

n

m

n

p( xi y j ) p( y j ), p( xi y j ) p( xi )

a2

…

ar p(ar)

p(a2) …

0 p(a i ) 1i 1,2, r

p(a i ) 1

信息论与编码-信源熵

需要注意的是,大写字母X,Y,Z代表随机变量,指 的是信源整体,带下标的小写字母代表随机事件的 某一结果或信源的某个元素。两者不可混淆。

信息论与编码-信源熵

(4) 如p(xi)=1,则I(xi) =0 ;(必然事件不含有任何不确定 性,所以不含有任何信息量)

(5) 自信息量也是一个随机变量,它没有确定的值。

信息论与编码-信源熵

例2、 设有12枚同值硬币,其中有一枚为假币,且只知道假币

的重量与真币的重量不同,但不知究竟是轻是重。现采 用天平比较两边轻重的方法来测量(因无法码)。问至 少需要称多少次才能称出假币? 解:用天平每称一次能获得一定的信息量,能消除部分的不 确定性。测量若干次后,能消除全部不确定性,获得全部信 息,也就能确定出假币。 设“在12枚同值硬币中,某一枚为假币”该事件为a, p(a ) 1 / 12 则 p 又设“假币是重、或是轻”该事件为b,则(b) 1 / 2

(5)当X与Y相互独立时,

p( y j / xi ) p( y j ), p( xi / y j ) p( xi ), p( xi y j ) p( xi ) p( y j )

( 6) p( x i / y j ) p( x i y j )

p( x i y j )

i 1

n

p( y j / xi )

i 1 n j 1 i 1 j 1 i 1

n

m

n

m

n

p( xi y j ) p( y j ), p( xi y j ) p( xi )

信息论基础课件2.1.3

1

(3)最大离散熵定理

定理:信源X中包含n个不同的离散消息时,信源熵 H(X)有 H ( X ) log2 n 当且仅当X中各个消息出现的概率全相等时,上式 取等号。

1 p( xi ) log2 n 证明: H ( X ) log2 n p( x i ) log2 p( x i ) i 1 i 1

r

pi log pi pi log[ pi (1 )qi ]

i 1

r

r

r

i 1

r 1 pi l og (1 ) qi l ogqi pi i 1 i 1

1 (1 ) qi l og[ pi (1 )qi ] (1 ) qi l og qi i 1 i 1

p( x i y j ) log 2 [ p( x i ) p( y j / x i )]

i j

p( x i y j ) log2 p( x i ) p( x i y j ) log 2 p( y j / x i )

i j

i

j

p( x i ) log2 p( x i ) H (Y / X )

i

i

j

H ( X ) H (Y / X )

得证。

8

7、极值性(香农辅助定理)

,q 对于任意n及概率矢量 P ( p1 , p2 ,, pn ) 和 Q (q1 , q2 ,,n ) n n 有如下不等式成立 H ( p1 , p2 ,, pn ) pi log pi pi log qi

l 1

k l 1

k

H ( X ) [ p j log p j ] ( pi ) log(pi ) [ l log l ]

(3)最大离散熵定理

定理:信源X中包含n个不同的离散消息时,信源熵 H(X)有 H ( X ) log2 n 当且仅当X中各个消息出现的概率全相等时,上式 取等号。

1 p( xi ) log2 n 证明: H ( X ) log2 n p( x i ) log2 p( x i ) i 1 i 1

r

pi log pi pi log[ pi (1 )qi ]

i 1

r

r

r

i 1

r 1 pi l og (1 ) qi l ogqi pi i 1 i 1

1 (1 ) qi l og[ pi (1 )qi ] (1 ) qi l og qi i 1 i 1

p( x i y j ) log 2 [ p( x i ) p( y j / x i )]

i j

p( x i y j ) log2 p( x i ) p( x i y j ) log 2 p( y j / x i )

i j

i

j

p( x i ) log2 p( x i ) H (Y / X )

i

i

j

H ( X ) H (Y / X )

得证。

8

7、极值性(香农辅助定理)

,q 对于任意n及概率矢量 P ( p1 , p2 ,, pn ) 和 Q (q1 , q2 ,,n ) n n 有如下不等式成立 H ( p1 , p2 ,, pn ) pi log pi pi log qi

l 1

k l 1

k

H ( X ) [ p j log p j ] ( pi ) log(pi ) [ l log l ]

李梅 李亦农 《信息论基础教程》 课件教案 第二章 信息的度量

第二章:信息的度量

一、自信息和互信息 二、平均自信息 三、平均互信息

第二章:信息的度量

1. 自信息

一、自信息和互信息

二、平均自信息

2. 互信息

三、平均互信息

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

1. 自信息(量)

公理性条件: (1) 如果p(x1) < p(x2),则I(x1) > I(x2), I(xi )是 p(xi) 调递减函数; 的单

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

2. 互信息(量) (续9)

互信息量的性质

1) 互信息的对称性 2) 互信息可为正值、负值,或为0 3) 任何两个事件之间的互信息不可能大于其中任一 事件的自信息

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

2. 互信息(量) (续10)

解:

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

1. 自信息(量) (续6)

p( x1 ) 1 1 n(n 1) 2 p( xn ) n 1 n(n 1) 2

1 I ( x1 ) log n(n 1) 2

1 I ( xn ) log (n 1) 2

自信息和互信息 平均自信息 平均互信息

2. 互信息(量) (续11)

2) 互信息可正可负,可为零

当后验概率大于先验概率时,互信息为正。

说明事件yj的出现有助于消除事件xi的不确定度。

当后验概率小于先验概率时,互信息为负。

说明收信者未收到 yj 以前,对消息xi是否出现的猜测难度较 小,但接收到消息 yj 后对 xi 是否出现的猜测的难度增加了,也 就是收信者接收到消息 yj 后对 xi出现的不确定性反而增加,所 以获得的信息量为负值。

一、自信息和互信息 二、平均自信息 三、平均互信息

第二章:信息的度量

1. 自信息

一、自信息和互信息

二、平均自信息

2. 互信息

三、平均互信息

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

1. 自信息(量)

公理性条件: (1) 如果p(x1) < p(x2),则I(x1) > I(x2), I(xi )是 p(xi) 调递减函数; 的单

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

2. 互信息(量) (续9)

互信息量的性质

1) 互信息的对称性 2) 互信息可为正值、负值,或为0 3) 任何两个事件之间的互信息不可能大于其中任一 事件的自信息

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

2. 互信息(量) (续10)

解:

第二章:信息的度量

自信息和互信息 平均自信息 平均互信息

1. 自信息(量) (续6)

p( x1 ) 1 1 n(n 1) 2 p( xn ) n 1 n(n 1) 2

1 I ( x1 ) log n(n 1) 2

1 I ( xn ) log (n 1) 2

自信息和互信息 平均自信息 平均互信息

2. 互信息(量) (续11)

2) 互信息可正可负,可为零

当后验概率大于先验概率时,互信息为正。

说明事件yj的出现有助于消除事件xi的不确定度。

当后验概率小于先验概率时,互信息为负。

说明收信者未收到 yj 以前,对消息xi是否出现的猜测难度较 小,但接收到消息 yj 后对 xi 是否出现的猜测的难度增加了,也 就是收信者接收到消息 yj 后对 xi出现的不确定性反而增加,所 以获得的信息量为负值。

Thomas信息论基础第二版课件L02(1)

1 I ( xi / y j ) log log P ( xi y j ) P( x y ) i j

1 I ( xi / y j ) log log P( xi y j ) P( x y ) i j

Uncirtainty about xi, after yj recieved

DUT

信息论基础

金明录 教授

-11-

DUT

信息论基础

金明录 教授

-12-

Definition:

Self-Information(自信息)

-logp

Example: Consider a binary source which tosses a fair coin and outputs a 1 if a head (H) appears and a 0 if a tail (T) appears. For this source, source P(1)=P(0)=0.5. (0)=0 5 The information content of each output from the source is I(xi) = -log2P(xi) = -log2(0.5) = 1 bit

P(x0) = P(x1) = 0.5

x0=0 P(y1/x0)=p P(y0/x1)=p x1=1

P(y0/x0)=1) 1p

y0=0

P(y1/x1)=1-p

y1=1

P(y0)=P(x0)P(y0/x0)+P(x1)P(y0/x1)=0.5(1-p)+0.5p=0.5 P(y1)=P(x0)P(y1/x0)+P(x1)P(y1/x1)=0.5(p)+0.5(1-p)=0.5 P(x0/y0) P(x0)P(y0/x0)/P(y1) 1 p P(x0/y0)=P(x0)P(y0/x0)/P(y1)=1-p P(x1/y0)=P(x1)P(y0/x1)/P(y0)=p I(x0;y0)=log[P(x0/y0)/P(x0)]=log[(1-p)/0.5]=log2(1-p) I(x1;y0)=log[P(x1/y0)/P(x1)]=log[p/0.5]=log2p

信息论基础课件chp2

观察者得知输入端发出xi前、后对输出端出现yj的不确

定度的差

观察者站在通信系统总体立场上

通信前:输入随机变量X和输出随机变量Y之间没有任何关 联关系,即X与Y统计独立:p(xi yj)=p(xi)p(yj) 先验不确定度 I'(xiyj)lo2gp(xi)1p(yj)

通信后:输入随机变量X和输出随机变量Y之间由信道的统 计特性相联系,其联合概率密度: p(xi yj)=p(xi)p(yj /xi )= p(yj)p(xi / yj) 后验不确定度

(4)两个独立事件的联合信息量应等于它们分别的信息量 之和。

根据上述条件可以从数学上证明这种函数形式是对数形式。

定义2.1 随机事件的自信息量定义为该事件发生概

率的对数的负值。设事件x i 的概率为 p ( xi ),则它的

自信息定义为

I(xi)deflogp(xi)logp(1xi)

当统计独立时,表明xi和yj之间不存在统计约束关系,从yj 得不到关于的xi任何信息,反之亦然。

I(xiyj)lo2g p(xi)1 p(yj)lo2g p(x1 iyj)0

互信息量可为正值或负值

当后验概率大于先验概率时,互信息量为正

当后验概率小于先验概率时,互信息量为负

当后验概率与先验概率相等时,互信息量为零。这就是 两个随机事件相互独立的情况。

解:(1) I(a)log20.0643.96bit I(c)log20.0225.51 bit

( 2 ) I ( a c ) l o g 2 0 . 0 6 4 0 . 0 2 2 3 . 9 6 5 . 5 1 9 . 4 7 b i t

( 3 )I( c |a ) lo g 2 0 .0 4 4 .6 4 b it

定度的差

观察者站在通信系统总体立场上

通信前:输入随机变量X和输出随机变量Y之间没有任何关 联关系,即X与Y统计独立:p(xi yj)=p(xi)p(yj) 先验不确定度 I'(xiyj)lo2gp(xi)1p(yj)

通信后:输入随机变量X和输出随机变量Y之间由信道的统 计特性相联系,其联合概率密度: p(xi yj)=p(xi)p(yj /xi )= p(yj)p(xi / yj) 后验不确定度

(4)两个独立事件的联合信息量应等于它们分别的信息量 之和。

根据上述条件可以从数学上证明这种函数形式是对数形式。

定义2.1 随机事件的自信息量定义为该事件发生概

率的对数的负值。设事件x i 的概率为 p ( xi ),则它的

自信息定义为

I(xi)deflogp(xi)logp(1xi)

当统计独立时,表明xi和yj之间不存在统计约束关系,从yj 得不到关于的xi任何信息,反之亦然。

I(xiyj)lo2g p(xi)1 p(yj)lo2g p(x1 iyj)0

互信息量可为正值或负值

当后验概率大于先验概率时,互信息量为正

当后验概率小于先验概率时,互信息量为负

当后验概率与先验概率相等时,互信息量为零。这就是 两个随机事件相互独立的情况。

解:(1) I(a)log20.0643.96bit I(c)log20.0225.51 bit

( 2 ) I ( a c ) l o g 2 0 . 0 6 4 0 . 0 2 2 3 . 9 6 5 . 5 1 9 . 4 7 b i t

( 3 )I( c |a ) lo g 2 0 .0 4 4 .6 4 b it

信息论基础教程,李亦农李梅编著,北京邮电大学出版社

物理量称为信号。编码器可分为信源编码器、信道编码器。

信源编码的目的为了提高通信系统的有效性和提高信息传输的可靠 性。在实际的通信系统中,可靠性和有效性常常相互矛盾 。

(3)信道。信道是指通信系统把载荷消息的信号从发送端送到接收 端的媒介或通道,是包括收发设备在内的物理设施。

(4)译码器。译码就是把信道输出的已迭加了干扰的编码信号进行 反变换,变成信宿能够接受的消息。译码器也可分成信源译码器 和信道译码器。

的概率,这样得到的新信xn 源的熵增加,熵增加了一项是由于划分

产生的不确定性。

7. 极值性: H ( p1, p2,

,

pn

)

H

1 n

,

1, n

,

1 n

log

n

式中n是随机变量X的可能取值的个数。

极值性表明离散信源中各消息等概率出现时熵最大,这就是最大离 散熵定理。连续信源的最大熵则与约束条件有关。

, pq ) H (p)

1.对称性:H (p)

H( p1, p2, , pq ) H( p2, p1, , pq )= = H( pq, p1, , pq1) 性说明熵函数仅与信源的总体统计特性有关。

2021/5/20

19

2. 确定性:

H(1, 0) H(1, 0, 0) H(1, 0, 0, 0) H(1, 0, ,0) 0

(2)一般信息论:也称工程信息论。主要也是研究信息传输和处理问题, 除香农信息论的内容外,还包括噪声理论、信号滤波和预测、统计检测 和估计、调制理论、信息处理理论以及保密理论等。

(3)广义信息论:不仅包括上述两方面内容,而且包括所有与信息有关的 自然和社会领域,如模式识别、计算机翻译、心理学、遗传学、神经生 理学、语言学、语义学甚至包括社会学中有关信息的问题。

信源编码的目的为了提高通信系统的有效性和提高信息传输的可靠 性。在实际的通信系统中,可靠性和有效性常常相互矛盾 。

(3)信道。信道是指通信系统把载荷消息的信号从发送端送到接收 端的媒介或通道,是包括收发设备在内的物理设施。

(4)译码器。译码就是把信道输出的已迭加了干扰的编码信号进行 反变换,变成信宿能够接受的消息。译码器也可分成信源译码器 和信道译码器。

的概率,这样得到的新信xn 源的熵增加,熵增加了一项是由于划分

产生的不确定性。

7. 极值性: H ( p1, p2,

,

pn

)

H

1 n

,

1, n

,

1 n

log

n

式中n是随机变量X的可能取值的个数。

极值性表明离散信源中各消息等概率出现时熵最大,这就是最大离 散熵定理。连续信源的最大熵则与约束条件有关。

, pq ) H (p)

1.对称性:H (p)

H( p1, p2, , pq ) H( p2, p1, , pq )= = H( pq, p1, , pq1) 性说明熵函数仅与信源的总体统计特性有关。

2021/5/20

19

2. 确定性:

H(1, 0) H(1, 0, 0) H(1, 0, 0, 0) H(1, 0, ,0) 0

(2)一般信息论:也称工程信息论。主要也是研究信息传输和处理问题, 除香农信息论的内容外,还包括噪声理论、信号滤波和预测、统计检测 和估计、调制理论、信息处理理论以及保密理论等。

(3)广义信息论:不仅包括上述两方面内容,而且包括所有与信息有关的 自然和社会领域,如模式识别、计算机翻译、心理学、遗传学、神经生 理学、语言学、语义学甚至包括社会学中有关信息的问题。

信息论基础2010-第二章

k 1 K

熵的性质(II)

H ( X ) H K ( p1 , p2 ,, pk ) H K ( P) pk log pk

k 1 K

熵的性质(III)

(5)可加性 ={A,B}

={A1,A2,A3,B1,B2}

H ( X 2 ) X H ( X 1 ) X H ( X 2 | X 1 ) X

二个事件X=x与Y=y之间的相互提供的信息量定义 为

p( x | y ) I ( x; y ) log p ( x)

联合随机变量{(X, Y), , p(x,y)} 相互提供的平均信 息量称之为二者之间的平均互信息,简称互信息:

I ( X ;Y ) E{I ( x; y )} p( x | y ) p( x, y ) log q( x ) x y

H (U 1 , U 2 , , U N )

H (U

n 1

N

n

| U 1 , U 2 , , U n 1 )

熵的性质(I)

x1 X ~ p 1

x2 x K p2 pK

H ( X ) H K ( p1 , p2 ,, pk ) H K ( P) pk log pk

事件yy的发生还能再给外界提供的新的信息量事件的联合自信息同时发生对外界提供的信息量事件的互信息发生后提供给外界的信息量事件yy还能提供给外界的新信息量事件yy中包含的有关事件xx信息量事件互信息的性质事件zz已知的条件下事件xx与事件yy相互提供的信息量事件的联合互信息事件yy和zz联合提供的有关事件xx的信息量事件联合互信息的链式法则事件yy和zz联合提供的有关事件xx的信息量等于yy提供的有关事件xx的信息量再加上事件yy已知的条件下事件zz所提供的有关xx的新信息量

熵的性质(II)

H ( X ) H K ( p1 , p2 ,, pk ) H K ( P) pk log pk

k 1 K

熵的性质(III)

(5)可加性 ={A,B}

={A1,A2,A3,B1,B2}

H ( X 2 ) X H ( X 1 ) X H ( X 2 | X 1 ) X

二个事件X=x与Y=y之间的相互提供的信息量定义 为

p( x | y ) I ( x; y ) log p ( x)

联合随机变量{(X, Y), , p(x,y)} 相互提供的平均信 息量称之为二者之间的平均互信息,简称互信息:

I ( X ;Y ) E{I ( x; y )} p( x | y ) p( x, y ) log q( x ) x y

H (U 1 , U 2 , , U N )

H (U

n 1

N

n

| U 1 , U 2 , , U n 1 )

熵的性质(I)

x1 X ~ p 1

x2 x K p2 pK

H ( X ) H K ( p1 , p2 ,, pk ) H K ( P) pk log pk

事件yy的发生还能再给外界提供的新的信息量事件的联合自信息同时发生对外界提供的信息量事件的互信息发生后提供给外界的信息量事件yy还能提供给外界的新信息量事件yy中包含的有关事件xx信息量事件互信息的性质事件zz已知的条件下事件xx与事件yy相互提供的信息量事件的联合互信息事件yy和zz联合提供的有关事件xx的信息量事件联合互信息的链式法则事件yy和zz联合提供的有关事件xx的信息量等于yy提供的有关事件xx的信息量再加上事件yy已知的条件下事件zz所提供的有关xx的新信息量

信息论基础与应用(第2版)

读书笔记

读书笔记

这是《信息论基础与应用(第2版)》的读书笔记模板,可以替换为自己的心得。

精彩摘录

精彩摘录

这是《信息论基础与应用(第2版)》的读书笔记模板,可以替换为自己的精彩内容摘录。

谢谢观看

2.6.1连续信源的相对熵 2.6.2连续信源最大熵定理 2.6.3连续信源的互信息

2.7熵计算及熵应用

2.7.1熵计算 2.7.2熵信息应用

3.1信道分类和参数 表示

3.2离散单符号信道 及其容量

3.3离散序列信道及 其容量

3.4连续信道及其容 量

3.5信道容量计 算及MATLAB程

序实现

习题3

3.2离散单符号信道及其容量

3.2.1信道容量定义 3.2.2离散单符号无噪信道及其容量 3.2.3离散单符号有噪信道及其容量

3.3离散序列信道及其容量

3.3.1并联信道 3.3.2和信道 3.3.3扩展信道

3.4连续信道及其容量

3.4.1时间离散信道及其容量 3.4.2时间连续信道及其容量

3.5信道容量计算及MATLAB程序实现

5.3离散信道编码定理

5.3.1有噪信道编码定理 5.3.2有噪信道编码逆定理

5.4信道编码方法

5.4.1线性分组码 5.4.2循环码 5.4.3卷积码

5.5信道编码MATLAB计算实现

5.5.1 RS码 5.5.2 Turbo码 5.5.3 LDPC码 5.5.4 Polar码

6.1相关信源及可达 速率区域

6.2多址接入信道及 其容量区域

6.3广播信道及其容 量区域

习题6

6.2多址接入信道及其容量区域

6.2.1离散二址接入信道及其容量区域 6.2.2高斯加性二址接入信道及其容量区域 6.2.3离散多址接入信道及其容量区域

信息论基础2

回忆

信源分类;

离散信源、连续信源、波形信源

什么是信息?

通信所消除掉的不确定度是信宿所获得的 信息量。

自信息、信息熵的概念与计算;

I i log p i

H ( X ) p i lo g p i

i 1 m

1.3.1离散信道数学模型

信道是信息的传输媒体。这里存在噪声干 扰,也包含通信设备对信号的作用,是通信 系统最为复杂的部分。 在讨论信道中的信息传输规律这个主要问 题时,对实际信道抽象出三个简化模型: 1. 广义信道模型: 2. 符号映射模型: 3. 传输概率模型:

0和1在信道中的地位 对等,p为错传概率。 a1 a2

1-p p p 1-p

B.二元删除信道(BEC, Binary Erasure Channel)

接收端为三电平码, b3为删除码。 a1 a2

1-p

b1 b2

p q

1-q

b1

b3

b2

(3)有噪无损信道与无噪有损信道:

噪声与损耗都会造成误码。作为数学模型把二者

(6)平均互信息:

I(X;Y)=H(X)-H(X|Y)= 0.881 –0.8558=0.0252 bit/符号

课后复习题

思考题:

为什么说平均互信息是通信的净信息?

作业题:

教材第32页习题一第11、14题;

1.3.3 平均互信息的性质

1. 非负性

平均互信息不会是负值: I(X;Y)≥0

实际上,因为条件熵不大于无条件熵: H(X) ≥H(X|Y) 必然有:I (X;Y)=H(X)-H(X|Y) ≥0 表明通信总可以获得一些信息,至少是零信息, 不会是负信息。

b1 b2

有损信道

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

p( y j xi )

p( xi ) p( y j xi ) log

i 1 j 1

p( x ) p( y

k 1 k

n

j

xk )

平均互信息的性质5

p1 ( xi ) p( y j xi ) log

i 1 j 1 n m n m

p( y j xi )

p ( x ) p( y

j 1 k 1

m

n

1 log p1 ( xk ) 1 p2 ( xk ) p( y j xk )

j 1 k 1

m

n

0

平均互信息的性质6

5. 凸函数性:

定理2.2 对于固定的输入分布 p( xi ),平均互信息量 I ( X ; Y ) 是

2.3.3 数据处理定理

定理2.3 (数据处理定理) 如果随机变量 X , Y , Z 构成一个马尔可夫链,则有以下关系成立:

I ( X ; Z ) I ( X ; Y ), I ( X ; Z ) I (Y ; Z )

等号成立的条件是对于任意的 x, y , z ,有

p( x | yz ) p( x | z )

凸函数在定义域内的极值必为极大值,可以利用熵函数的这个性 质可以证明熵函数的极值性。

2.2.3 联合熵与条件熵

一维随机变量的不确定性可以用熵来表示,可以推广到多维随机 变量。

定义2.4 二维随机变量 XY 的概率空间表示为

XY x1 y1 p( x y ) P XY 1 1

n

j

xk )

p ( x ) p( y

k 1 1 k k j

1 p2 ( xi ) p ( y j xi ) log

i 1 j 1

n

m

p ( x ) 1 p ( x ) p( y p ( x ) p( y

p( z | xy) p( z | x)

2.3.3 数据处理定理

I ( X ; YZ ) I ( X ; Z ) I ( X ; Y | Z ) I ( X ; YZ ) I ( X ; Y ) I ( X ; Z | Y ) I ( X ;Y ) I ( X ; Z | Y ) I ( X ; Z ) I ( X ;Y | Z )

i 1 j 1

m

n

m

n

m

n

m

i 1 j 1

i 1 j 1

p xi y j log 2

i 1 j 1

n

p xi p y j p xi y j

log 2 p xi p y j 0

i 1 j 1

n

m

2.3

平均互信息

3.平均互信息和各类熵的关系: I ( X ;Y ) H ( X ) H ( X | Y )

H (Y ) H (Y | X ) H ( X ) H (Y ) H ( XY ) I ( X ;Y ) 0 当 X , Y 统计独立时,

平均互信息的性质4

4. 极值性:I ( X ;Y ) H ( X ), I ( X ;Y ) H (Y ) 极值性说明从一个事件提取关于另一个事件的信息量,至多只能 是另一个事件的平均自信息量那么多,不会超过另一事件本身所 含的信息量。

i 1 j 1 n m n m

p xi y j log 2 p xi p y j xi

i 1 j 1

n m n m

p xi y j log 2 p xi p xi y j log 2 p y j xi

i 1 j 1 i 1 j 1

k 1 2 k j

xk )

xk )

log

i 1 j 1

n

m

p1 ( xi ) p ( y j xi ) p1 ( xk ) 1 p2 ( xk ) p ( y j xk )

k 1

n

p ( x ) p( y

k 1 1 k n n m k 1 n

条件概率分布 p( y j | xi ) 的下凸函数。

2.3.3 数据处理定理

定义2.7 平均条件互信息

p( x | yz ) I ( X ; Y | Z ) E I ( x; y | z ) p( xyz ) log p( x | z ) x y z 它表示随机变量 Z 给定后,从随机变量 Y 所得到得关于随机变量

i 1 j 1 m i 1 j 1 n n m n m

p ( xi y j ) log

i 1 j 1

n

p( xi | y j ) p ( xi )

p( xi y j ) log

i 1 j 1

m

p( xi y j ) p ( xi ) p ( y j )

平均互信息的性质3

p xi y j log 2

i 1 j 1

n

m

i 1 j 1 n m

n

m

p xi p xi y j

i 1 j 1

log 2

i 1 j 1

n

m

p xi p xi y j p xi y j

n m i 1 j 1

log 2 p xi p y j 0

平均互信息的性质2

2.互易性(对称性): I ( X ;Y )

I (Y ;X )

对称性表示从Y中获得的关于X的信息量等于从X 中获得的关于Y 的信息量。

I ( X ;Y ) H ( X ) H ( X | Y ) p( xi y j ) log p( xi ) p( xi y j ) log p( xi | y j )

n

xi y j p( xi y j )

m

xn ym p( xn ym )

其中 p( xi y j ) 满足概率空间的非负性和完备性:

0 p( xi y j ) 1, p( xi y j ) 1

i 1 j 1

联合熵

二维随机变量 XY 的联合熵定义为联合自信息的数学期望。

X 的信息量。

2.3.3 数据处理定理

定义2.8 平均联合互信息

p( x | yz ) I ( X ; YZ ) E I ( x; yz ) p( xyz ) log p ( x) x y z

它表示从二维随机变量YZ 所得到得关于随机变量 X 的信息量。

2.3.3 数据处理定理

p( x | z ) p( x | yz ) I ( X ; YZ ) p( xyz ) log p( x) p ( x | z ) x y z I ( X ; Z ) I ( X ;Y | Z )

I ( X ; YZ ) I ( X ; Y ) I ( X ; Z | Y )

p xi log 2 p xi p xi y j log 2 p y j xi

i 1 i 1 j 1

n

n

m

各类熵之间的关系2

熵函数的链规则:

H ( X1 X 2

X N ) H ( X1 ) H ( X 2 | X1 )

H ( X N | X1 X 2

p ( p1 , p2 ,

, pq ), p ' ( p1 ', p2 ',

, pq '), pi 1, pi ' 1

i 1 i 1

q

q

则对于任意小于1的正数 ,( 0 1 ) 有以下不等式成立:

H p (1 )p ' H (p) (1 ) H (p ')

2.3.1 平均互信息的概念

定义互信息 I ( xi ; y j ) 在 XY 的联合概率空间中的统计平均值为随机 变量X和Y间的平均互信息:

定义2.6

2.3.2 平均互信息的性质1

1.非负性: I ( X ;Y ) 0 平均互信息是非负的,说明给定随机变量Y后,一般来说总能消 除一部分关于X的不确定性。

各类熵之间的关系3

3 .联合熵和信息熵的关系:

H ( XY ) H ( X ) H (Y )

当X、Y相互独立时等号成立。

H ( XY ) H ( X ) H (Y )

p xi y j log 2 p xi y j p xi y j log 2 p xi p xi y j log 2 p y j

i i j

p( xi y j ) log p( y j | xi )

i j

Y 的平均不确定性。 其中,H (Y | X ) 表示已知 X 时,

各类熵之间的关系1

1.联合熵与信息熵、条件熵的关系:

H ( XY ) H ( X ) H (Y | X )

关系1之证明

H ( XY ) p xi y j log 2 p xi y j

极值性

1 1 , pn ) H , , n n 1 , log n n

7. 极值性:

H ( p1 , p2 ,

式中n是随机变量X的可能取值的个数。 极值性表明离散信源中各消息等概率出现时熵最大,这就是最大 离散熵定理。

上凸性

8. 上凸性: H (p ) 是严格的上凸函数,设

i 1 j 1

p ( x ) 1 p ( x ) p( y

k 1 1 k 2 k

j

xk )

p1 ( xi ) p ( y j xi ) log

p( xi ) p( y j xi ) log

i 1 j 1

p( x ) p( y

k 1 k

n

j

xk )

平均互信息的性质5

p1 ( xi ) p( y j xi ) log

i 1 j 1 n m n m

p( y j xi )

p ( x ) p( y

j 1 k 1

m

n

1 log p1 ( xk ) 1 p2 ( xk ) p( y j xk )

j 1 k 1

m

n

0

平均互信息的性质6

5. 凸函数性:

定理2.2 对于固定的输入分布 p( xi ),平均互信息量 I ( X ; Y ) 是

2.3.3 数据处理定理

定理2.3 (数据处理定理) 如果随机变量 X , Y , Z 构成一个马尔可夫链,则有以下关系成立:

I ( X ; Z ) I ( X ; Y ), I ( X ; Z ) I (Y ; Z )

等号成立的条件是对于任意的 x, y , z ,有

p( x | yz ) p( x | z )

凸函数在定义域内的极值必为极大值,可以利用熵函数的这个性 质可以证明熵函数的极值性。

2.2.3 联合熵与条件熵

一维随机变量的不确定性可以用熵来表示,可以推广到多维随机 变量。

定义2.4 二维随机变量 XY 的概率空间表示为

XY x1 y1 p( x y ) P XY 1 1

n

j

xk )

p ( x ) p( y

k 1 1 k k j

1 p2 ( xi ) p ( y j xi ) log

i 1 j 1

n

m

p ( x ) 1 p ( x ) p( y p ( x ) p( y

p( z | xy) p( z | x)

2.3.3 数据处理定理

I ( X ; YZ ) I ( X ; Z ) I ( X ; Y | Z ) I ( X ; YZ ) I ( X ; Y ) I ( X ; Z | Y ) I ( X ;Y ) I ( X ; Z | Y ) I ( X ; Z ) I ( X ;Y | Z )

i 1 j 1

m

n

m

n

m

n

m

i 1 j 1

i 1 j 1

p xi y j log 2

i 1 j 1

n

p xi p y j p xi y j

log 2 p xi p y j 0

i 1 j 1

n

m

2.3

平均互信息

3.平均互信息和各类熵的关系: I ( X ;Y ) H ( X ) H ( X | Y )

H (Y ) H (Y | X ) H ( X ) H (Y ) H ( XY ) I ( X ;Y ) 0 当 X , Y 统计独立时,

平均互信息的性质4

4. 极值性:I ( X ;Y ) H ( X ), I ( X ;Y ) H (Y ) 极值性说明从一个事件提取关于另一个事件的信息量,至多只能 是另一个事件的平均自信息量那么多,不会超过另一事件本身所 含的信息量。

i 1 j 1 n m n m

p xi y j log 2 p xi p y j xi

i 1 j 1

n m n m

p xi y j log 2 p xi p xi y j log 2 p y j xi

i 1 j 1 i 1 j 1

k 1 2 k j

xk )

xk )

log

i 1 j 1

n

m

p1 ( xi ) p ( y j xi ) p1 ( xk ) 1 p2 ( xk ) p ( y j xk )

k 1

n

p ( x ) p( y

k 1 1 k n n m k 1 n

条件概率分布 p( y j | xi ) 的下凸函数。

2.3.3 数据处理定理

定义2.7 平均条件互信息

p( x | yz ) I ( X ; Y | Z ) E I ( x; y | z ) p( xyz ) log p( x | z ) x y z 它表示随机变量 Z 给定后,从随机变量 Y 所得到得关于随机变量

i 1 j 1 m i 1 j 1 n n m n m

p ( xi y j ) log

i 1 j 1

n

p( xi | y j ) p ( xi )

p( xi y j ) log

i 1 j 1

m

p( xi y j ) p ( xi ) p ( y j )

平均互信息的性质3

p xi y j log 2

i 1 j 1

n

m

i 1 j 1 n m

n

m

p xi p xi y j

i 1 j 1

log 2

i 1 j 1

n

m

p xi p xi y j p xi y j

n m i 1 j 1

log 2 p xi p y j 0

平均互信息的性质2

2.互易性(对称性): I ( X ;Y )

I (Y ;X )

对称性表示从Y中获得的关于X的信息量等于从X 中获得的关于Y 的信息量。

I ( X ;Y ) H ( X ) H ( X | Y ) p( xi y j ) log p( xi ) p( xi y j ) log p( xi | y j )

n

xi y j p( xi y j )

m

xn ym p( xn ym )

其中 p( xi y j ) 满足概率空间的非负性和完备性:

0 p( xi y j ) 1, p( xi y j ) 1

i 1 j 1

联合熵

二维随机变量 XY 的联合熵定义为联合自信息的数学期望。

X 的信息量。

2.3.3 数据处理定理

定义2.8 平均联合互信息

p( x | yz ) I ( X ; YZ ) E I ( x; yz ) p( xyz ) log p ( x) x y z

它表示从二维随机变量YZ 所得到得关于随机变量 X 的信息量。

2.3.3 数据处理定理

p( x | z ) p( x | yz ) I ( X ; YZ ) p( xyz ) log p( x) p ( x | z ) x y z I ( X ; Z ) I ( X ;Y | Z )

I ( X ; YZ ) I ( X ; Y ) I ( X ; Z | Y )

p xi log 2 p xi p xi y j log 2 p y j xi

i 1 i 1 j 1

n

n

m

各类熵之间的关系2

熵函数的链规则:

H ( X1 X 2

X N ) H ( X1 ) H ( X 2 | X1 )

H ( X N | X1 X 2

p ( p1 , p2 ,

, pq ), p ' ( p1 ', p2 ',

, pq '), pi 1, pi ' 1

i 1 i 1

q

q

则对于任意小于1的正数 ,( 0 1 ) 有以下不等式成立:

H p (1 )p ' H (p) (1 ) H (p ')

2.3.1 平均互信息的概念

定义互信息 I ( xi ; y j ) 在 XY 的联合概率空间中的统计平均值为随机 变量X和Y间的平均互信息:

定义2.6

2.3.2 平均互信息的性质1

1.非负性: I ( X ;Y ) 0 平均互信息是非负的,说明给定随机变量Y后,一般来说总能消 除一部分关于X的不确定性。

各类熵之间的关系3

3 .联合熵和信息熵的关系:

H ( XY ) H ( X ) H (Y )

当X、Y相互独立时等号成立。

H ( XY ) H ( X ) H (Y )

p xi y j log 2 p xi y j p xi y j log 2 p xi p xi y j log 2 p y j

i i j

p( xi y j ) log p( y j | xi )

i j

Y 的平均不确定性。 其中,H (Y | X ) 表示已知 X 时,

各类熵之间的关系1

1.联合熵与信息熵、条件熵的关系:

H ( XY ) H ( X ) H (Y | X )

关系1之证明

H ( XY ) p xi y j log 2 p xi y j

极值性

1 1 , pn ) H , , n n 1 , log n n

7. 极值性:

H ( p1 , p2 ,

式中n是随机变量X的可能取值的个数。 极值性表明离散信源中各消息等概率出现时熵最大,这就是最大 离散熵定理。

上凸性

8. 上凸性: H (p ) 是严格的上凸函数,设

i 1 j 1

p ( x ) 1 p ( x ) p( y

k 1 1 k 2 k

j

xk )

p1 ( xi ) p ( y j xi ) log