广义线性模型中不完全数据的参数估计

GLMM:广义线性混合模型(遗传参数评估)

GLMM:广义线性混合模型(遗传参数评估)展开全文0. 飞哥感言这篇文章,主要是介绍了抗性数据,如何利用GLMM模型进行的分析,文中,他将9级分类性状变为了二分类性状,进行分析。

分析中用到了加性效应(A矩阵),空间分析(行列信息)。

对比了SAS和ASReml,结果基本一致。

其实,9分级性状,可以直接使用ASReml进行有序多分类性状分析,用累计Logistic模型分析,也可以考虑系谱数据和空间位置信息。

这样效果应该更好。

回头找下数据,测试一下。

1. 文献Genetic analysis of resistance to Pseudomonas syringae pv. actinidiae (Psa) in a kiwifruit progeny test: an application of generalised linear mixed models (GLMMs)2. 摘要「要点:」o LMM模型可以结合遗传(G矩阵)和空间分析(误差R矩阵),估算BLUP值o SAS中的GLIMMIX可以处理GLMM模型,但是门槛较高o ASReml可以处理GLMM模型3. 介绍「要点:」o介绍病原菌的来源o介绍抗病亲本的利用o如何更有效的评估和利用「后代检验是衡量标准」「要点」o对于抗性数据,在进行分析时,将其变为连续性状o作为连续性状是有信息损失的o可以用二分类性状,用GLMM模型进行遗传评估4. GLMM相对于LMM的优势「对于分类数据,GLMM模型评估遗传评估是标配」5. 常用软件o R中的lme4o SAS中的GLIMMIXo ASRemlo R中的ASReml-R并对Psa易感的附加遗传、环境方差成分和狭义遗传力进行可靠估计。

基于上述原因,我们使用了适用于二进制/二项分布式数据的GLMM方法。

GLMM的基本原理在一段时间前就已经开发出来,但它在广泛可用的统计软件中的实现却发生了很晚。

R lme4包装(Bates等人。

广义矩估计gmm法

广义矩估计gmm法

广义矩估计GMM法是一种用于模型参数估计的非线性最小二乘估计方法。

该方法将问

题的解决方案表示为最小化某种“不匹配度”,这一不匹配度也被称作残差。

这种残差将

被度量来确定无论是模型和数据之间,或者模型和数据之间的匹配程度。

广义矩估计GMM

法是一种一般性回归方法,它对待模型和数据的不匹配来自于一种广义矩矩阵(GMM)中

的曲率,该矩阵有着更复杂、更深层次的特征。

它属于GMM统计,该统计可以被用来比较

并分析不同类之间的差异,并预测各种任务的结果,半监督的、无监督的实值型和分类型

估计也是如此。

许多概念、方法和工具在GMM估计中都具有重要的地位,其中包括n阶差异(nRD)、极值过滤器、梯度下降优化法,以及模拟和分层最优化等。

各种标准和技术应用于估计GMM法中,可以提高模型参数的估计准确性,使回归变得更精确、更稳健。

广义矩估计GMM法提供多种不同的参数估计配置,来处理各种数据情况,这些数据情况包括有标准误

差的数据,有偏差的数据,以及有缺失值的数据等。

它还可以应用于时间序列数据,用来

估计模型参数的随机变动,从而改善模型预测准确性。

总之,广义矩估计GMM法是一种模型参数估计的强大工具,它可以用来估计和拟合各

种数据存在的模型参数。

它也可以应用到时间序列数据上,改善模型预测水平,给出一种

准确稳健的模型参数估计,从而使科学研究得到更优良的结果。

广义线性模型

2 1/ 2 2

1

3 2

伽玛分布

1

ln

1

1

2

二项分布 ln p

ln1 e 1

1 p

Poisson 分布 ln

e

1

p

e 1 e

e

p1 p

负二项分布 ln

e

k

e

k2

何为“广义线性模型”?(续)

一个广义线性模型包括以下三个组成部分: (1)线性成分(linear component ) :

SAS软件中的PROC GENMOD:

The GENMOD Procedure

The GENMOD procedure fits generalized linear models. The class of generalized linear models is an extension of traditional linear models that allows the mean of a population to depend on a linear predictor through a nonlinear link function and allows the response probability distribution to be any member of an exponential family of distributions. Many widely used statistical models are generalized linear models. These include classical linear models with normal errors, logistic and probit models for binary data, and log-linear models for multinomial data. Many other useful statistical models can be formulated as generalized linear models by the selection of an appropriate link function and response probability distribution.

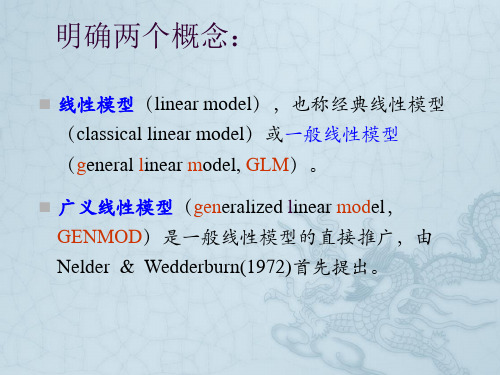

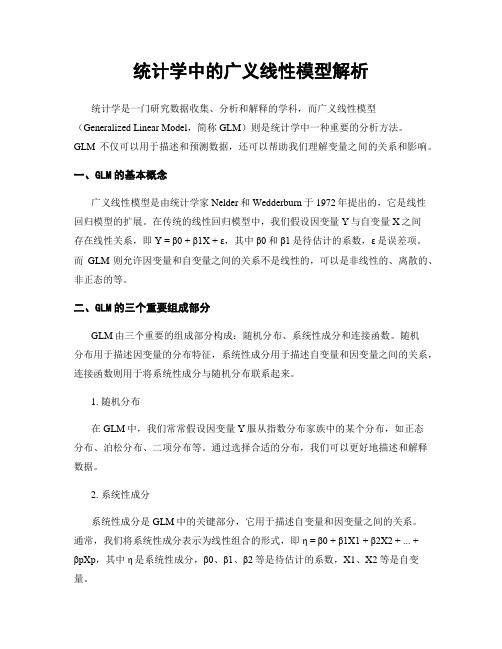

统计学中的广义线性模型解析

统计学中的广义线性模型解析统计学是一门研究数据收集、分析和解释的学科,而广义线性模型(Generalized Linear Model,简称GLM)则是统计学中一种重要的分析方法。

GLM不仅可以用于描述和预测数据,还可以帮助我们理解变量之间的关系和影响。

一、GLM的基本概念广义线性模型是由统计学家Nelder和Wedderburn于1972年提出的,它是线性回归模型的扩展。

在传统的线性回归模型中,我们假设因变量Y与自变量X之间存在线性关系,即Y = β0 + β1X + ε,其中β0和β1是待估计的系数,ε是误差项。

而GLM则允许因变量和自变量之间的关系不是线性的,可以是非线性的、离散的、非正态的等。

二、GLM的三个重要组成部分GLM由三个重要的组成部分构成:随机分布、系统性成分和连接函数。

随机分布用于描述因变量的分布特征,系统性成分用于描述自变量和因变量之间的关系,连接函数则用于将系统性成分与随机分布联系起来。

1. 随机分布在GLM中,我们常常假设因变量Y服从指数分布家族中的某个分布,如正态分布、泊松分布、二项分布等。

通过选择合适的分布,我们可以更好地描述和解释数据。

2. 系统性成分系统性成分是GLM中的关键部分,它用于描述自变量和因变量之间的关系。

通常,我们将系统性成分表示为线性组合的形式,即η = β0 + β1X1 + β2X2 + ... +βpXp,其中η是系统性成分,β0、β1、β2等是待估计的系数,X1、X2等是自变量。

3. 连接函数连接函数是将系统性成分和随机分布联系起来的桥梁。

它的作用是将系统性成分的线性组合映射到随机分布的参数空间中,使得我们可以通过系统性成分来预测和解释因变量的分布特征。

常见的连接函数有恒等函数、对数函数、逆正态函数等。

三、GLM的应用领域广义线性模型在统计学中有着广泛的应用领域。

以下是几个常见的应用示例:1. 生物医学研究在生物医学研究中,研究人员常常需要分析和解释疾病发生的风险因素。

generalized linear model结果解释-概述说明以及解释

generalized linear model结果解释-概述说明以及解释1.引言1.1 概述概述部分的内容可以包括对广义线性模型的简要介绍以及结果解释的重要性。

以下是一种可能的编写方式:在统计学和机器学习领域,广义线性模型(Generalized Linear Model,简称GLM)是一种常用的统计模型,用于建立因变量与自变量之间的关系。

与传统的线性回归模型不同,广义线性模型允许因变量(也称为响应变量)的分布不服从正态分布,从而更适用于处理非正态分布的数据。

广义线性模型的理论基础是广义线性方程(Generalized Linear Equation),它通过引入连接函数(Link Function)和系统误差分布(Error Distribution)的概念,从而使模型能够适应不同类型的数据。

结果解释是广义线性模型分析中的一项重要任务。

通过解释模型的结果,我们可以深入理解自变量与因变量之间的关系,并从中获取有关影响因素的信息。

结果解释能够帮助我们了解自变量的重要性、方向性及其对因变量的影响程度。

通过对结果进行解释,我们可以推断出哪些因素对于观察结果至关重要,从而对问题的本质有更深入的认识。

本文将重点讨论如何解释广义线性模型的结果。

我们将介绍广义线性模型的基本概念和原理,并指出结果解释中需要注意的要点。

此外,我们将提供实际案例和实例分析,以帮助读者更好地理解结果解释的方法和过程。

通过本文的阅读,读者将能够更全面地了解广义线性模型的结果解释,并掌握解释结果的相关技巧和方法。

本文的目的是帮助读者更好地理解和运用广义线性模型,从而提高统计分析和机器学习的能力。

在接下来的章节中,我们将详细介绍广义线性模型及其结果解释的要点,希望读者能够从中受益。

1.2文章结构文章结构部分的内容应该是对整篇文章的结构进行简要介绍和概述。

这个部分通常包括以下内容:文章结构部分的内容:本文共分为引言、正文和结论三个部分。

其中,引言部分主要概述了广义线性模型的背景和重要性,并介绍了文章的目的。

R语言广义线性模型教程

R语言广义线性模型教程广义线性模型(Generalized Linear Models,简称GLM)是一类常用的统计模型,能够对各种类型的数据进行建模和预测。

GLM是线性模型(Linear Model)的拓展,可以处理非正态分布的因变量和非线性的关系。

本教程将介绍如何在R语言中使用GLM进行数据分析。

一、什么是广义线性模型广义线性模型是一种拓展的线性回归模型,通过引入非线性关系和正态分布以外的分布,可以适应更多类型的数据。

广义线性模型的一般形式为Y = g(η) + ε,其中Y是因变量,g(η)是连接函数(link function),η是线性组合的预测值,ε是误差项。

二、GLM的组成部分GLM由三个组成部分构成:随机分布、线性预测子和连接函数。

1. 随机分布(Random distribution):描述因变量的分布形式,常见的分布有正态分布、泊松分布、二项分布等。

2. 线性预测子(Linear predictor):描述自变量与因变量之间的线性关系,可以包含多个自变量。

3. 连接函数(Link function):将线性预测子映射到随机分布的均值上,常见的连接函数有恒等函数、对数函数、逆函数等。

三、GLM的步骤使用R语言进行广义线性模型建模可以分为以下几个步骤:1.数据准备:将需要分析的数据加载到R环境中,并对数据进行清洗和变换,使其符合GLM的要求。

2. 模型拟合:使用glm(函数来拟合广义线性模型,并根据需要选择适当的连结函数和误差分布。

3.模型诊断:对拟合的模型进行诊断,检查是否满足GLM的假设,如线性关系、误差的独立性和方差齐性等。

4.模型解释:根据拟合的模型,通过系数的解释来理解自变量与因变量之间的关系。

5.模型预测:使用拟合的模型对未见过的数据进行预测,并评估模型的拟合优度。

四、R语言中的GLM函数在R语言中,可以使用glm(函数进行广义线性模型的拟合。

该函数的基本语法如下:glm(formula, family, data, ...)其中,formula是模型的公式,family是误差分布的名称,data是数据框对象。

不完整数据估计参数的方法

不完整数据估计参数的方法在统计学中,不完整数据是指样本中存在一些缺失或缺损的观测值。

这种情况下,我们需要使用特定的方法来估计参数。

以下是几种常见的不完整数据估计参数的方法:1. 最大似然估计(Maximum Likelihood Estimation, MLE):最大似然估计是一种常用的参数估计方法,它假设数据的缺失是随机且与完整数据的观测无关的。

该方法通过与已观测到的数据相比较,寻找最大化未观测数据可能性的参数值。

通过最大化似然函数来找到符合已观测数据的最优参数。

2. 指数经验似然估计(Exponential Empirical Likelihood Estimation, EEL):指数经验似然估计是一种鲁棒的参数估计方法,用于处理不完整数据。

该方法利用指数分布来估计未观测数据的概率密度函数,并最大化观测数据的经验似然函数。

3. 多重插补(Multiple imputation):多重插补是一种常见的不完整数据处理方法,它通过生成多个完整的数据集来估计参数。

首先,缺失值被随机插补,然后在每个插补数据集上进行参数估计,最后将多个估计结果合并为一个最终的估计值。

这种方法能够提供更可靠的估计结果和更准确的标准误差。

4. 期望最大化算法(Expectation-Maximization algorithm, EM):期望最大化算法是一种迭代方法,用于估计含有不完整数据的模型参数。

该算法通过迭代地进行两个步骤:期望步骤(E-step)和最大化步骤(M-step)。

在E-step中,通过给出当前的参数估计,计算缺失数据的期望值;在M-step中,通过最大化完整数据的对数似然函数,更新参数估计。

该方法在缺失数据模型中的参数估计中具有良好的性能。

以上所提到的方法是处理不完整数据估计参数常用的方法之一。

根据实际情况和数据特点选择合适的方法,能够有效地提高参数估计的准确性和可靠性。

广义估计方程估计方法

广义估计方程估计方法一、概述广义估计方程(Generalized Estimating Equations,GEE)是一种常用的非参数统计方法,它可以用于处理多变量数据,并且可以考虑到数据的相关性。

该方法主要用于处理长期追踪研究或者重复测量研究中的数据。

二、步骤1. 确定模型在使用广义估计方程进行分析之前,需要先确定所要分析的模型。

通常情况下,我们需要先确定响应变量和自变量,并且需要考虑到相关性因素。

2. 确定协方差结构在进行广义估计方程分析时,需要确定协方差结构。

通常情况下,我们可以使用AR(1)或者Exchangeable两种协方差结构。

3. 构建广义估计方程根据所选定的模型和协方差结构,可以构建出广义估计方程。

该方程包含了响应变量和自变量之间的关系以及协方差结构。

4. 选择似然比检验在进行广义估计方程分析时,需要进行模型检验。

通常情况下,我们会选择似然比检验作为模型检验方法。

5. 进行参数估计在通过似然比检验确认模型合适之后,我们可以进行参数估计。

通常情况下,我们会使用最大似然估计方法进行参数估计。

6. 进行模型诊断在完成参数估计之后,我们需要对模型进行诊断。

通常情况下,我们会使用残差分析和Q-Q图等方法对模型进行诊断。

7. 进行预测在完成模型的构建和参数估计之后,我们可以使用该模型进行预测。

通常情况下,我们会使用交叉验证等方法对模型的预测能力进行评估。

三、注意事项1. 在选择协方差结构时需要注意数据的特点以及研究目的。

2. 在选择广义估计方程时需要考虑到响应变量和自变量之间的关系以及协方差结构。

3. 在进行参数估计时需要注意到数据的分布情况以及样本大小等因素。

4. 在进行模型诊断时需要注意到残差分布是否符合正态分布以及是否存在异常值等问题。

5. 在进行预测时需要注意到数据的稳定性以及预测精度等因素。

不完全信息随机截尾广义线性模型的极大似然估计

摘要:该文在 回归子给 定和随机两种情 形下, 分别定义了不完全信 息随机截尾广义线性模型. 在 一定的条件下,讨论 了这两种模型参数 向量 的似然方程解的存在性和 唯一性 , 获得并证 明了

这两种模型的极大似 然估计 ( E ML )的相 合性 与渐近正态性.

关键词:广义线性模型 ;不完全信息;相合性 ;渐 进正态性 .

2 回I子给定下的模型 J 了

在 本节 ,我们将 构造 回归子 给定 下 的不完全 信 息随机 截尾 广义线性 模 型 . 设 响应变 量 假 为 , = 1… ,, i , n 回归变 量 为 x, = 12… , , ii ,, n 其中 是 一维的 , x ∈ c q 且 i i , 给 定 .他 们满 足下述 要求

收稿 日期:2 0 — 21 ; 0 6 1 —0 修订 日期:2 0 — 43 0 80 - 0

E- ai:xz hs x m l h f ym @ m a lhz u.du. n;l i @ wh e i. a e c qlu u. du. a c

基金项 目: 国家重点支撑项 目 (7 1 1 国家 自 0 7 0 )、 然科学基金 (0 0 0 3 和华 中农业大学博士基金 (2 0 - 2 6 ) 46 17) 5 2 40 0 7

维普资讯

20,8 3: 354 082 A() 5—6 5

.

黝

数学物理学报

不完全信息随机截尾广义线性模型的极大似然估计

肖枝 洪

( 华中农业大学理 学院 武汉 4 0 7 ) 3 00

刘 禄勤

( 武汉大学数学与统计学院 武汉 4 0 7 ) 30 2

.

≥1

显然 E 】 ( ) a[ 】 ( ,i ,, , . =b i V r /=b ) =12… n 因此, b i =E 】 O, Y ( ) =m( ’ . O z 在本 )

广义线性模型的参数估计及其经验应用

广义线性模型的参数估计及其经验应用广义线性模型是统计学中重要的一种模型,它统一了多种线性回归模型,包括普通线性回归、Logistic回归、Poisson回归、Gamma回归等。

广义线性模型的参数估计是模型分析的关键步骤之一,本文将探讨广义线性模型的参数估计及其经验应用。

一、广义线性模型广义线性模型(Generalized Linear Models,简称GLM)的基本表达式为:$g(E(Y))=\beta_0+\sum_{i=1}^{n}\beta_ix_i$其中,$g(E(Y))$是链接函数,$Y$是因变量,$x_i$是自变量,$\beta_i$是系数。

链接函数在不同的模型中有不同的定义,下面介绍几种常见的链接函数及其作用。

1.1. 普通线性回归普通线性回归的链接函数为恒等函数,即:$g(E(Y))=E(Y)$因此,普通线性回归的模型表达式为:$Y=\beta_0+\sum_{i=1}^{n}\beta_ix_i+\epsilon$其中,$\epsilon$为误差项。

1.2. Logistic回归Logistic回归的链接函数为logit函数,即:$g(E(Y))=\log\frac{E(Y)}{1-E(Y)}$Logistic回归用于二分类问题,因此$Y$只有两种取值,通常用0和1表示。

Logistic回归的模型表达式为:$\log\frac{P(Y=1)}{1-P(Y=1)}=\beta_0+\sum_{i=1}^{n}\beta_ix_i$其中,$P(Y=1)$表示$Y$取值为1的概率。

1.3. Poisson回归Poisson回归的链接函数为log函数,即:$g(E(Y))=\log(E(Y))$Poisson回归用于计数数据的分析,因此$Y$只能取非负整数值。

Poisson回归的模型表达式为:$\log(E(Y))=\beta_0+\sum_{i=1}^{n}\beta_ix_i$1.4. Gamma回归Gamma回归的链接函数为倒数函数,即:$g(E(Y))=-\frac{1}{E(Y)}$Gamma回归用于连续正值数据的分析。

广义线性模型的实现与分析

广义线性模型的实现与分析广义线性模型是一种常用的数据分析工具,可用于回归分析、分类、预测等多种实际问题。

在本文中,我们将探讨广义线性模型的实现和分析方法。

一、概述广义线性模型是一种扩展的线性模型,它通过对响应变量的分布进行建模,使得该模型能够适应更多类型的数据。

广义线性模型主要由三个重要组成部分组成:随机部分、系统部分和连接函数。

1、随机部分随机部分是指与响应变量相关的随机分布。

通常情况下,响应变量的分布都会根据其自然属性而确定不同的随机分布类型,如正态分布、泊松分布、二项分布等。

2、系统部分系统部分由自变量和一组参数所组成,用于描述响应变量的均值。

形式上,系统部分一般表示为:η=g(μ)=Xβ,其中,η表示线性预测子,g表示连接函数,μ表示响应变量的均值,X表示自变量矩阵,β表示回归系数。

3、连接函数连接函数将随机部分和系统部分连接起来,将预测值转换为响应变量的实际值。

广义线性模型中常用的连接函数有:恒等函数、对数函数、逆双曲正切函数、逆高斯函数等。

二、实现方法广义线性模型的实现方法分为两种:最大似然估计和贝叶斯估计。

1、最大似然估计最大似然估计法是广义线性模型中最常用的参数估计方法。

最大似然估计的思想是在给定自变量的前提下,寻找一个最符合响应变量的参数值,使得预测值与实际值的差异最小化。

具体来说,假设我们的模型已知,我们要求出回归系数β的值,使得给定自变量矩阵X和响应变量y的情况下,模型的对数似然函数值最大。

最大化对数似然函数可以通过梯度下降、拟牛顿法等算法来实现。

2、贝叶斯估计贝叶斯估计是一种基于贝叶斯统计理论的参数估计方法。

贝叶斯估计可以在多次观测数据的基础上,对未知参数的历史数据进行推断,从而得到该参数的后验分布概率。

贝叶斯估计中一般会引入一些先验分布信息,使得最终的参数估计更准确。

贝叶斯参数估计方法可以通过马尔科夫链蒙特卡罗(MCMC)算法来实现。

三、分析方法广义线性模型分析主要包括模型拟合和模型诊断两部分。

广义线性模型

线性模型也称经典线性模型或一般线性模型,其模型的形式为:

其中, 是因Biblioteka 量的第i次观测, 是自变量,它是一个列向量,表示第i次观测数据。未知系数向量 可以通过对 的最小二乘拟合估计, 是均值为零,方差为常数的随机变量。

模型的几个基本假设:

因变量是连续随机变量

自变量相互独立

每一个数值型自变量与因变量呈线性关系

广义线性模型

广义线性模型

1.概述

广义线性模型是传统的线性模型的延伸,它是总体均值通过一个非线性连接函数依赖于线性预测值,有许多广泛应用的统计模型都属于广义线性模型,其中包括正态误差的经典性模型,二元数据的对数和概率单位模型以及多项数据的对数线性模型,还有其它许多有用的统计模型,如果选择合适的连接函数和响应概率分布,也可以表示为广义线性模型。

连接函数:

参数估计

一般线性模型:参数估计采用极大似然法和最小二乘法

广义线性模型:参数估计采用极大似然法和加权最小二乘

4.因变量常见分布及其常用的连接函数

广义线性模型建立

通过对数据选定因变量和自变量,以及选择合适的连接函数和响应概率分布,既可以建立一个广义线性模型。例如:

一般线性模型

因变量:连续变量

分布:正态分布

连接函数:

Logistic回归模型

因变量:(0,1)

分布:二项分布

连接函数:

Poisson回归模型

因变量:计数和个数

分布:Poisson分布

一般线性模型中,自变量的线性预测值 就是因变量的估计值 ,而广义线性模型中,自变量的线性预测值 是因变量的函数估计值 。

广义线性模型包括一下组成部分:

线性部分正好是一般线性模型所定义的:

广义线性模型

广义线性模型广义线性模型(Generalized Linear Model,GLM)是一种在统计学中常用的模型,它是对普通线性模型的扩展和推广。

在广义线性模型中,因变量不需要满足正态分布的假设,而是通过连接函数(link function)与线性组合的结果进行建模。

广义线性模型的应用领域十分广泛,涵盖了回归分析、分类分析以及其他众多领域。

1. 普通线性模型普通线性模型是一种经典的建模方法,其基本形式为:$$ Y = \\beta_0 + \\beta_1 X_1 + \\beta_2 X_2 + ... + \\beta_k X_k + \\epsilon $$ 其中,Y表示因变量,X1,X2,...,X k表示自变量,$\\beta_0, \\beta_1,\\beta_2, ..., \\beta_k$为模型参数,$\\epsilon$为误差项。

普通线性模型的关键假设是因变量Y服从正态分布。

2. 广义线性模型的基本原理广义线性模型是对普通线性模型的推广,其基本形式为:$$ g(\\mu) = \\beta_0 + \\beta_1 X_1 + \\beta_2 X_2 + ... + \\beta_k X_k $$其中,g()为连接函数(link function),$\\mu$表示期望的因变量Y,其他符号的含义同普通线性模型。

通过连接函数g(),广义线性模型在一般性上不再要求因变量Y服从正态分布。

3. 连接函数(Link Function)连接函数g()的选择是广义线性模型的关键之一,不同的连接函数对应不同的模型形式。

常见的连接函数包括:•恒等连接函数(Identity link function): $g(\\mu) = \\mu$,对应普通线性模型。

•对数连接函数(Log link function): $g(\\mu) = log(\\mu)$,常用于泊松回归等模型。

•逆连接函数(Inverse link function): $g(\\mu) = \\frac{1}{\\mu}$,用于逻辑回归等模型。

线性模型(5)——广义线性模型

我们知道,混合线性模型是一般线性模型的扩展,而广义线性模型在混合线性模型的基础上又做了进一步扩展,使得线性模型的使用范围更加广阔。

每一次的扩展,实际上都是模型适用范围的扩展,一般线性模型要求观测值之间相互独立、残差(因变量)服从正态分布、残差(因变量)方差齐性,而混合线性模型取消了观测值之间相互独立和残差(因变量)方差齐性的要求,接下来广义线性模型又取消了对残差(因变量)服从正态分布的要求。

残差不一定要服从正态分布,可以服从二项、泊松、负二项、正态、伽马、逆高斯等分布,这些分布被统称为指数分布族,并且引入了连接函数,根据不同的因变量分布、连接函数等组合,可以得到各种不同的广义线性模型。

要注意,虽然广义线性模型不要求因变量服从正态分布,但是还是要求相互独立的,如果不符合相互独立,需要使用后面介绍的广义估计方程。

=================================================一、广义线性模型广义线性模型的一般形式为:有以下几个部分组成1.线性部分2.随机部分εi3.连接函数连接函数为单调可微(连续且充分光滑)的函数,连接函数起了"y的估计值μ"与"自变量的线性预测η"的作用,在一般线性模型中,二者是一回事,但是当自变量取值范围受限时,就需要通过连接函数扩大取值范围,因此在广义线性模型中,自变量的线性预测值是因变量的函数估计值。

广义线性模型设定因变量服从指数族概率分布,这样因变量就可以不局限于正态分布一种形式,并且方差可以不稳定。

指数分布族的概率密度函数为其中θ和φ为两个参数,θ为自然参数,φ为离散参数,a,b,c为函数广义线性模型的参数估计:广义线性模型的参数估计一般不能使用最小二乘法,常用加权最小二乘法或极大似然法。

回归参数需要用迭代法求解。

广义线性模型的检验和拟合优度:广义线性模型的检验一般使用似然比检验、Wald检验。

模型的比较用似然比检验,回归系数使用Wald检验。

广义线性模型(GeneralizedLinearModels)

⼴义线性模型(GeneralizedLinearModels)在线性回归问题中,我们假设,⽽在分类问题中,我们假设,它们都是⼴义线性模型的例⼦,⽽⼴义线性模型就是把⾃变量的线性预测函数当作因变量的估计值。

很多模型都是基于⼴义线性模型的,例如,传统的线性回归模型,最⼤熵模型,Logistic回归,softmax回归。

指数分布族在了解⼴义线性模型之前,先了解⼀下指数分布族(the exponential family)指数分布族原型如下如果⼀个分布可以⽤上⾯形式在表⽰,那么这个分布就属于指数分布族,⾸先来定义⼀下上⾯形式的符号:η:分布的⾃然参数(natural parameter)或者称为标准参数(canonical parameter)T (y):充分统计量,通常⽤T(y) = ya(η):对数分割函数(log partition function):本质上是⼀个归⼀化常数,确保概率和为1。

当给定T时,a、b就定义了⼀个以η为参数的⼀个指数分布。

我们变化η就得到指数分布族的不同分布。

论证伯努利分布和⾼斯分布为指数分布族,伯努利分布均值φ,记为Bernoulli(φ),y ∈ {0, 1},所以p(y = 1; φ) = φ; p(y = 0; φ) = 1 − φ对⽐指数分布族的表达式可以得到:η = log(φ/(1-φ)) 我们将φ⽤η表⽰,则:φ=1/(1+e-η),是不是发现和sigmoid函数⼀样了。

这就表明,当我们给定T,a,b,伯努利分布可以写成指数分布族的形式,也即伯努利分布式指数分布族。

同理,在⾼斯分布中,有:对⽐指数分布族,我们得到:因为⾼斯分布的⽅差与假设函数⽆关,因⽽为了计算简便,我们设⽅差=1,这样就得到:所以这也表明,⾼斯分布也是指数分布族的⼀种。

构造⼴义线性模型(Constructing GLMs)怎么通过指数分布族来构造⼴义线性模型呢?要构建⼴义线性模型,我们要基于以下三个假设:1. 给定特征属性和参数后,的条件概率服从指数分布族,即。

EM算法对不完全数据下指数分布的参数估计

EM算法对不完全数据下指数分布的参数预估一、引言EM算法(Expectation-Maximization Algorithm)是一种常用的参数预估方法,它常用于具有隐变量或不完全数据的统计问题。

指数分布是概率密度函数形式简易而广泛应用的一种分布,它具有指数递减的特点,在各种领域都有重要的应用,如生物学、经济学、物理学等。

本文将介绍EM算法在不完全数据下预估指数分布的参数的过程及其应用。

二、EM算法概述EM算法是一个迭代的优化算法,它通过两个步骤交替进行,分别是E步和M步。

在E步,通过已知的观测数据和参数的初始值,计算隐变量的后验分布期望值。

在M步,通过最大化E 步计算得到的隐变量的期望值来更新参数的预估值。

如此迭代进行,直到收敛得到最优的参数预估值。

三、不完全数据下的指数分布不完全数据指的是在观测数据中存在着缺失值或隐变量。

在指数分布中,缺失值可能是由于试验数据采集的限制,或是由于缺失变量难以观测到所导致的。

在不完全数据下,我们无法直接使用观测数据进行参数预估,需要利用EM算法进行预估。

四、EM算法在指数分布中的应用假设我们的观测数据是来自指数分布的随机变量,但其中有一部分数据是缺失的。

我们想通过观测到的数据来预估指数分布的参数λ。

其中,λ是指数分布的一个参数,它代表了指数分布的一个特征,即指数递减的速度。

起首,我们初始化λ的初始值,在E步中,我们通过已知的观测数据计算出隐变量的后验分布期望值。

依据指数分布的概率密度函数,我们可以得到隐变量对应的完全数据的似然函数。

对于缺失的数据,我们使用观测到的数据的似然函数的积分来近似计算。

这样,我们可以得到E步的值。

接下来,在M步中,我们通过最大化E步计算得到的隐变量的期望值来更新参数λ的预估值。

详尽地,我们求解似然函数对λ的偏导数,并令其等于0,从而得到λ的最优预估值。

然后,我们使用这个最优预估值作为新的λ值,继续进行下一轮的迭代。

我们不息地重复进行E步和M步,直到迭代收敛,表示已得到λ的最优预估值。

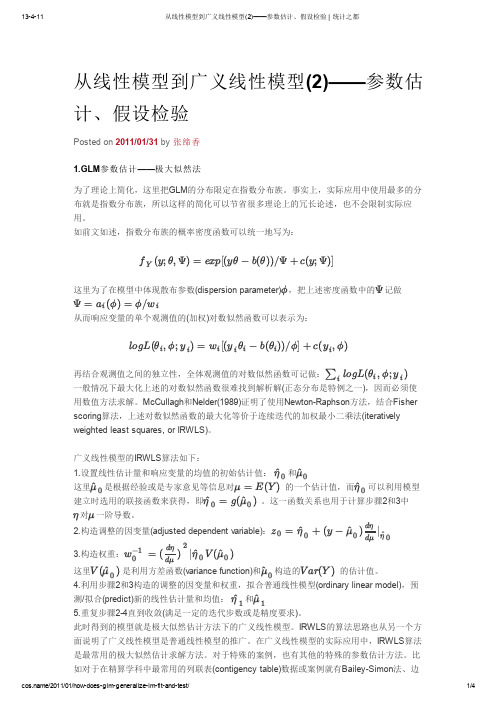

从线性模型到广义线性模型(2)——参数估计、假设检验

从线性模型到广义线性模型(2)——参数估计、假设检验Posted on 2011/01/31 by 张缔香1.GLM 参数估计——极大似然法为了理论上简化,这里把GLM 的分布限定在指数分布族。

事实上,实际应用中使用最多的分布就是指数分布族,所以这样的简化可以节省很多理论上的冗长论述,也不会限制实际应用。

如前文如述,指数分布族的概率密度函数可以统一地写为:这里为了在模型中体现散布参数(dispersion parameter),把上述密度函数中的记做从而响应变量的单个观测值的(加权)对数似然函数可以表示为:再结合观测值之间的独立性,全体观测值的对数似然函数可记做:一般情况下最大化上述的对数似然函数很难找到解析解(正态分布是特例之一),因而必须使用数值方法求解。

McCullagh 和Nelder(1989)证明了使用Newton-Raphson 方法,结合Fisher scoring 算法,上述对数似然函数的最大化等价于连续迭代的加权最小二乘法(iteratively weighted least squares, or IRWLS)。

广义线性模型的IRWLS 算法如下:1.设置线性估计量和响应变量的均值的初始估计值: 和这里是根据经验或是专家意见等信息对的一个估计值,而可以利用模型建立时选用的联接函数来获得,即。

这一函数关系也用于计算步骤2和3中对一阶导数。

2.构造调整的因变量(adjusted dependent variable):3.构造权重:这里是利用方差函数(variance function)和构造的的估计值。

4.利用步骤2和3构造的调整的因变量和权重,拟合普通线性模型(ordinary linear model),预测/拟合(predict)新的线性估计量和均值: 和5.重复步骤2-4直到收敛(满足一定的迭代步数或是精度要求)。

此时得到的模型就是极大似然估计方法下的广义线性模型。

IRWLS 的算法思路也从另一个方面说明了广义线性模型是普通线性模型的推广。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Vo . 2 No 6 12 .

N OV 20 8 . 0

文 章 编 号 :17 ・9 X(0 8 0—0 10 6 26 1 2 0 60 1—4 J

广义线性模 型 中不 完全数据 的参数估计

李 海 霞, 晓冉 , 玉 民 张 徐

( 山大 学 理 学 院 , 北 秦 皇 岛 0 60 ) 燕 河 6 0 4

矩阵 . 一般来 说 , 等式 ( ) 于 是非 线 性 的 , 4关 需要 用 迭代 方法 得到 . 似然 方 程 关 于 一 阶 T y 把 a—

lr 开 , 到 Ne o - p s n迭代 如下 o展 得 wtnRa h o

=

不 完全 数据 的一 般 问题 , 种 不 完 全 性 是 因 为 协 这 变 量和应 变 量部 分 观 测 的缺 失 , 中提 出 了参 数 文 极 大似 然估计 的 E 算法 , 过 随 机模 拟 可 以 看 M 通 出 E 算 法较剔 除 缺失数 据 方法更 接 近实 际 . M

大.

重. 于 个独 立 的观 测 Y一 ( , , ( j 基 … Y ) , ,) 5

的对 数似然 可 以记为

z , x =∑ { 弘 ( 一 ( , ; ) (hx )

bh x ) )声 c y ,) . ( ( ) / + ( f声 ) () 3

() 4

摘

要 : 论了广义 线性模型类 中离散协变量 和离散响应 变量数据不 完全时 , 数极大似 然估计 的 E 算法 , 讨 参 M

文 中给 出了参数估计 的具体表达式 和估 计的渐进协方差 . 最后 , 通过 随机模拟说 明 E 算法的优 良性. M

关键词 : M 算 法 ; E 广义线性模型 ; 极大似然估计 ; w o- a ho Ne tnR p sn算法

同. 虑 广义线 性模 型 考

g( i )一 一 X ( i 一 1, , ), … , z () 2

则 式 () 5 变为

件 D一』 9 ( (x MX) xMs )} , 。+ ( ( ) 户 n

() 6

前 面的等 式在不 完 全数据 的估 计 中起着 重要 的作

布族 密度 , 形式 如下

f Y ; ,)一 e p (, 一 6 ) / 声 + cy ,) , ( 声 x (j ( ) a( ) ( ≯ }

() 1

厶 a( _i嚣) a g

均为 ×n对角 矩阵 . 如果 使用 典则 联 系

A — I △ 一 0 , ,

对一 些 函数 a( ) b ) c ) 8 是 相 对 于 , ( 和 ( ,i 第 i次 观 测 的 自然 参 数 , 声是 冗 余 参 数 , 与 不

。+ ( M ( x △ △ 一 A H )

X) ( MA s )l r' X ) )

() 5

其 中

1 广 义 线性 模 型 中完 全数 据 的估 计

假 定 Y ., 是相 互独 立 的观 测 , .Y 有指 数 分

H d( —iy ai g

—i ) d( a g ,

中 图 分 类 号 : 1 . 02 2 1 文献标识 码 : A

O 引 言

收集 到 的数 据 经 常 是 不 完 整 的 [ , 如 在 问 1例 ] 卷 调查 , 床试 验 , 境 研究 等 方 面 . 用 不 完 全 临 环 利

数 据得 到 的结果 往 往 与 实 际有 偏 差 , 至 偏 差 很 甚

通 过计 算可 以得到 口的似然 函数 为

广义 线 性 模 型 适 用 于 连 续 数 据 和 离 散 数

X' / s= 0, M k

据[ , 2 特别 是后 者 , ] 如属性 数据 、 计数 数 据. 在 实 这 用上 , 其 是 生 物 、 学和 经 济 、 会 数 据 的统 计 尤 医 社

分 析上 , 重要 意义 . 有 本 文在 有离 散 变 量 的广 义 线 性 模 型 中 , 虑 考

其 中 = ( l … , ), = da ( d i/ d/ ) s , △ i ( S) ( r) , g i

— 一

是 ×1向量 , M— da ( ) , i mi是 z g ×扎对 角

作 者 简 介 : 海 霞 (9 2) 女 , 李 1 8一 , 山西 平 遥 人 , 山 大 学 在 读 硕 士 研 究 生 , 燕 主要 从 事 广 义 线 性模 型 研 究

1 2

甘 肃 联合 大 学 学报 ( 自然科 学版 )

第2 2卷

数. 定缺失协 变量 和反 应 变 量 随机 缺 失. u i 假 R bn (9 6 证实 , 果数据 随机 缺失 , 17 ) 如 则基 于似然 的推 断不依 赖于缺 失数 据机 制 . 进一 步 , 们假定 协变 我

失一 般 性 , 们假 定 a( ) / , 是 已知 的权 我 , =声

收 稿 日期 :0 80 —0 2 0 —91 .

2 加 权 E 算 法 M

在有部 分缺 失协 变量 和反应 变 量 的广义 线性 模型( 以下 简称 G M) , M 算 法 被用 来估 计 参 L 中 E

用.

其 中 为 1 ×P 向量 , Y 是 l ×P协 变 量 矩 阵 X 的

第i , 行 是 p× 1回归 参 数 , g是 单 调 可 微 函数 ( 系 函数 ) =E( , =h 五 ) ^依 赖 于 联 联 , y ) ( ( 系 函数 g . ) 当 =X , 系 函数 为 典则 联 系. 联 不

第 2 卷 第 6期 2 20 0 8年 l 1月

甘 肃 联 合 大 学 学报 ( 自然科 学版 )

J u n l fGa s a h i e st ( t r l c e c s o r a n u Li n e Un v r i o y Na u a in e ) S