决策树和随机森林实验

《决策树与随机森林》课件

交叉验证

使用交叉验证来评估模型的泛化能力,以避 免过拟合。

随机森林的参数调整

1 2

决策树数量

调整决策树的数量,以找到最优的模型性能。

特征子集大小

调整在每一步分裂中选择的特征子集大小,以找 到最优的模型性能。

3

决策树深度

调整决策树的深度限制,以防止过拟合或欠拟合 。

05

决策树与随机森林的应用场景

分类问题

THANKS

感谢观看

随机森林的优缺点

可解释性强

每棵决策树都可以单独解释,有助于理解模型的工作原理。

鲁棒

对异常值和噪声具有较强的鲁棒性。

随机森林的优缺点

对参数敏感

随机森林中的参数如树的数量、特征选择比例等对模型性能影响较大。

可能产生过拟合

当数据集较小或特征过多时,随机森林可能产生过拟合。

04

随机森林算法

随机森林的生成

决策树的基本原理

特征选择

选择最能划分数据集的特征进行分裂,以减少决 策树的深度和复杂度。

剪枝

通过去除部分分支来降低过拟合的风险,提高模 型的泛化能力。

决策规则

将每个叶子节点映射到一个类别或值,根据该节 点所属类别或值进行预测。

决策树的优缺点

优点

易于理解和解释,分类效果好,对异常值和缺失值容忍度高 。

在构建每棵决策树时,随 机选择一部分特征进行划 分,增加模型的泛化能力 。

多样性

通过生成多棵决策树,增 加模型的多样性,降低过 拟合的风险。

集成学习

将多棵决策树的预测结果 进行汇总,利用投票等方 式决定最终输出,提高分 类任务的准确率。

随机森林的优缺点

高效

能够处理大规模数据集,计算效率高 。

实验三决策树算法实验实验报告

实验三决策树算法实验实验报告一、引言决策树算法是一种常用的机器学习算法,它通过构建一个决策树模型来解决分类和回归问题。

在本次实验中,我们将使用决策树算法对一个分类问题进行建模,评估算法的性能,并对实验结果进行分析和总结。

二、实验目的1.学习理解决策树算法的基本原理和建模过程。

2. 掌握使用Python编程实现决策树算法。

3.分析决策树算法在不同数据集上的性能表现。

三、实验过程1.数据集介绍2.决策树算法实现我们使用Python编程语言实现了决策树算法。

首先,我们将数据集随机分为训练集和测试集,其中训练集占70%,测试集占30%。

然后,我们使用训练集来构建决策树模型。

在构建决策树时,我们采用了ID3算法,该算法根据信息增益来选择最优的特征进行分割。

最后,我们使用测试集来评估决策树模型的性能,计算并输出准确率和召回率。

3.实验结果与分析我们对实验结果进行了统计和分析。

在本次实验中,决策树算法在测试集上的准确率为0.95,召回率为0.94、这表明决策树模型对于鸢尾花分类问题具有很好的性能。

通过分析决策树模型,我们发现花瓣长度是最重要的特征,它能够很好地区分不同种类的鸢尾花。

四、实验总结通过本次实验,我们学习了决策树算法的基本原理和建模过程,并使用Python实现了决策树算法。

通过实验结果分析,我们发现决策树算法在鸢尾花分类问题上具有很好的性能。

然而,决策树算法也存在一些不足之处,例如容易过拟合和对数据的敏感性较强等。

在实际应用中,可以使用集成学习方法如随机森林来改进决策树算法的性能。

数据挖掘之随机森林算法实验报告

数据挖掘之随机森林算法实验报告一、引言随着互联网的快速发展和信息技术的普及,我们生活在一个数据爆炸的时代。

在海量的数据中,如何从中挖掘出有用的信息,成为了数据挖掘的核心问题之一、随机森林算法是一种常用的数据挖掘算法,它通过构建多个决策树,然后综合这些决策树的结果来进行分类或回归分析。

本实验旨在通过使用随机森林算法,对一个分类问题进行实验,并评估算法的性能。

二、实验方法1.数据集选择本实验选择了UCI Machine Learning Repository上的Iris数据集,该数据集包含了150个样本和4个特征。

每个样本都属于三个不同的类别之一:setosa,versicolor和virginica。

2.数据预处理将数据集分为训练集和测试集,训练集占总数据集的70%,测试集占30%。

然后对训练集进行特征缩放,以确保不同特征的数值范围一致。

3.模型构建使用Python的scikit-learn库中的RandomForestClassifier类构建随机森林模型。

设置决策树的数量为100,并使用默认的其他参数。

4.模型训练和评估使用训练集对模型进行训练,并使用测试集对模型进行评估。

评估指标包括准确率、精确率、召回率和F1值。

三、实验结果经过多次实验,得到了如下结果:1.准确率:在测试集上的准确率为95%。

2. 精确率:对于setosa类别,精确率为100%。

对于versicolor类别,精确率为93%。

对于virginica类别,精确率为97%。

3. 召回率:对于setosa类别,召回率为100%。

对于versicolor类别,召回率为96%。

对于virginica类别,召回率为94%。

4. F1值:对于setosa类别,F1值为100%。

对于versicolor类别,F1值为94%。

对于virginica类别,F1值为96%。

四、讨论与分析通过实验结果可以看出,随机森林算法在Iris数据集上表现出了较好的性能。

实验二决策树实验实验报告

实验二决策树实验实验报告

一、实验目的

本实验旨在通过实际操作,加深对决策树算法的理解,并掌握

决策树的基本原理、构建过程以及应用场景。

二、实验原理

决策树是一种常用的机器学习算法,主要用于分类和回归问题。

其基本原理是将问题划分为不同的决策节点和叶节点,通过一系列

的特征测试来进行决策。

决策树的构建过程包括特征选择、划分准

则和剪枝等步骤。

三、实验步骤

1. 数据收集:从开放数据集或自有数据中选择一个适当的数据集,用于构建决策树模型。

2. 数据预处理:对收集到的数据进行缺失值处理、异常值处理

以及特征选择等预处理操作,以提高模型的准确性和可靠性。

3. 特征选择:采用合适的特征选择算法,从所有特征中选择对

分类或回归任务最重要的特征。

4. 构建决策树模型:根据选定的特征选择算法,以及划分准则(如信息增益或基尼系数)进行决策树模型的构建。

5. 模型评估:使用交叉验证等方法对构建的决策树模型进行评估,包括准确率、召回率、F1-score等指标。

6. 模型调优:根据评估结果,对决策树模型进行调优,如调整模型参数、采用剪枝技术等方法。

7. 模型应用:将得到的最优决策树模型应用于实际问题中,进行预测和决策。

四、实验结果及分析

在本次实验中,我们选择了某电商网站的用户购买记录作为数据集,利用决策树算法构建用户购买意愿的预测模型。

经过数据预处理和特征选择,选取了用户地理位置、年龄、性别和购买历史等特征作为输入。

利用信息增益作为划分准则,构建了一棵决策树模型。

实验二-决策树实验-实验报告

决策树实验一、实验原理决策树是一个类似于流程图的树结构,其中每个内部结点表示在一个属性上的测试,每个分支代表一个测试输入,而每个树叶结点代表类或类分布。

数的最顶层结点是根结点。

一棵典型的决策树如图1所示。

它表示概念buys_computer,它预测顾客是否可能购买计算机。

内部结点用矩形表示,而树叶结点用椭圆表示。

为了对未知的样本分类,样本的属性值在决策树上测试。

决策树从根到叶结点的一条路径就对应着一条合取规则,因此决策树容易转化成分类规则。

图1ID3算法:■决策树中每一个非叶结点对应着一个非类别属性,树枝代表这个属性的值。

一个叶结点代表从树根到叶结点之间的路径对应的记录所属的类别属性值。

■每一个非叶结点都将与属性中具有最大信息量的非类别属性相关联。

■采用信息增益来选择能够最好地将样本分类的属性。

信息增益基于信息论中熵的概念。

ID3总是选择具有最高信息增益(或最大熵压缩)的属性作为当前结点的测试属性。

该属性使得对结果划分中的样本分类所需的信息量最小,并反映划分的最小随机性或“不纯性”。

二、算法伪代码算法Decision_Tree(data,AttributeName)输入由离散值属性描述的训练样本集data;候选属性集合AttributeName。

输出一棵决策树。

(1)创建节点N;(2)If samples 都在同一类C中then(3)返回N作为叶节点,以类C标记;(4)If attribute_list为空then(5)返回N作为叶节点,以samples 中最普遍的类标记;//多数表决(6)选择attribute_list 中具有最高信息增益的属性test_attribute;(7)以test_attribute 标记节点N;(8)For each test_attribute 的已知值v //划分samples(9)由节点N分出一个对应test_attribute=v的分支;(10令S v为samples中test_attribute=v 的样本集合;//一个划分块(11)If S v为空then(12)加上一个叶节点,以samples中最普遍的类标记;(13)Else 加入一个由Decision_Tree(Sv,attribute_list-test_attribute)返回节点值。

机器学习实验报告完整

机器学习实验报告完整摘要:本实验报告旨在探究机器学习算法在数据集上的表现,并评估不同算法的性能。

我们使用了一个包含许多特征的数据集,通过对数据进行预处理和特征选择,进行了多个分类器的比较实验。

实验结果显示,不同的机器学习算法在不同数据集上的表现存在差异,但在对数据进行适当预处理的情况下,性能可以有所改善。

引言:机器学习是一种通过计算机程序来自动学习并改善性能的算法。

机器学习广泛应用于各个领域,例如医学、金融和图像处理等。

在本实验中,我们比较了常用的机器学习算法,并评估了它们在一个数据集上的分类性能。

方法:1. 数据集我们使用了一个包含1000个样本和20个特征的数据集。

该数据集用于二元分类任务,其中每个样本被标记为正类(1)或负类(0)。

2. 预处理在进行实验之前,我们对数据集进行了预处理。

预处理的步骤包括缺失值填充、异常值处理和数据归一化等。

缺失值填充使用常用的方法,例如均值或中位数填充。

异常值处理采用了离群点检测算法,将异常值替换为合理的值。

最后,我们对数据进行了归一化处理,以确保不同特征的尺度一致。

3. 特征选择为了提高分类性能,我们进行了特征选择。

特征选择的目标是从原始特征中选择出最相关的特征子集。

我们使用了常见的特征选择方法,如相关性分析和特征重要性排序。

通过这些方法,我们选取了最具判别能力的特征子集。

4. 算法比较在本实验中,我们选择了四种常见的机器学习算法进行比较:决策树、逻辑回归、支持向量机(SVM)和随机森林。

我们使用Python编程语言中的机器学习库进行实验,分别训练了这些算法,并使用交叉验证进行评估。

评估指标包括准确率、召回率、F1值和ROC曲线下方的面积(AUC)。

结果与讨论:通过对比不同算法在数据集上的性能,我们得出以下结论:1. 决策树算法在本实验中表现欠佳,可能是由于过拟合的原因。

决策树算法可以生成高度解释性的模型,但在处理复杂数据时容易陷入过拟合的状态。

2. 逻辑回归算法表现较好,在数据集上获得了较高的准确率和F1值。

随机森林实验报告

随机森林实验报告随机森林是一种常用的机器学习方法,它将多个决策树组合成一个强大的分类或回归模型。

本实验报告将介绍随机森林的原理、实验设计、结果与讨论。

一、随机森林原理随机森林是一种集成学习方法,其主要原理是通过构建多个决策树,并通过投票或平均的方式来决定最终的分类结果或回归值。

具体而言,随机森林的构建包括以下几个步骤:1. 随机选择数据集的子集,称为自助采样(bootstrap sampling),这样每个决策树的训练集就是有放回地从原始数据集中随机采样得到的。

2.对于每个子集,使用决策树算法建立决策树模型。

3.对于分类问题,通过投票的方式决定最终的分类结果;对于回归问题,通过平均的方式决定最终的回归值。

二、实验设计本实验使用UCI Machine Learning Repository中的数据集进行实验,数据集为Iris花卉数据集。

该数据集包含了3种不同种类的鸢尾花(Setosa、Versicolor和Virginica)的150个样本,每个样本有4个特征(花萼长度、花萼宽度、花瓣长度和花瓣宽度)。

实验的目标是根据这些特征来预测鸢尾花的种类。

实验的步骤如下:1.数据预处理:对数据集进行特征选择、特征缩放等处理,确保数据集的准确性和一致性。

2.拆分数据集:将数据集划分为训练集和测试集,其中训练集占总体数据集的70%,测试集占30%。

3. 构建随机森林模型:使用Python中的机器学习库scikit-learn 中的RandomForestClassifier构建随机森林模型,并设置合适的超参数(如决策树的数量、最大特征数等)。

4.训练模型:使用训练集对模型进行训练。

5.模型评估:使用测试集对模型进行评估,计算准确率、精确率、召回率等指标。

6.结果分析与讨论:分析实验结果,讨论随机森林模型的优点和不足之处。

三、实验结果与讨论经过实验,我们得到了以下结果:1.随机森林模型在测试集上的准确率为95%。

随机森林实验报告

随机森林实验报告实验目的实现随机森林模型并测试。

实验问题Kaggle 第二次作业Non-I in ear classificati on算法分析与设计一•算法设计背景:1. 随机森林的原子分类器一般使用决策树,决策树又分为拟合树和分类树。

这两者的区别在于代价估值函数的不同。

2. 根据经验,用拟合树做分类的效果比分类树略好。

3. 对于一个N分类问题,它总是可以被分解为N个2分类问题,这样分解的好处是其决策树更加方便构造,更加简单,且更加有利于用拟合树来构建分类树。

对于每一个2分类问题,构造的树又叫CART树,它是一颗二叉树。

4•将N个2分类树的结果进行汇总即可以得到多分类的结果。

树构造:输人训媒数站集D.停止训练紮件输出;GRT决迈树祝据训练数曙粟.从抿节点开妞’谨归地对毎个节点进汙以下操作,递归构造二叉决策树⑴ 说节点的训海数据毘为m 计算现有特征甘说敖据举的基尼系故■此时.时毎一个特征治对干毎一牛可能的划分伯" 根据大于m及小于等于m将训练数据秦仿成D4D2禅鄙分*计鞭gini条数公貳如下;Gini 叩一甌二^-*Gini|(Dl)+ -^-*Gmi{D2);Ginl(D)= 1- XLiPl(2)在所有可能特征A Lua其斫有可能划分点已中,选择呂血系数聖小的持征及切廿值・将D1 和D2分配到左右两个子节点去.⑶对左右节点分别递归的调用⑴,⑵,直到满足一定条件为止.6.随机森林构造:(「麵机取样,降低树□树2间的关联性RF&e次构追1棵决策樹时,先随机的有族回的从训练集中抽肛C6W)® n tskieoftraining set)卩样本D+住母卜节点分裂前,itGOL乩总共M卜特征中选取m卜(m«—般駁很号M)作为分製用的幄选轨征’这有牧降低了树与榊之间的关朕性匸二•算法思路:将一个N分类问题转化为N个二分类问题。

转化方法是:构造N棵二叉拟合树,这里假设N为26,然后我们给N棵二叉树依次标号为1,2,3...26 。

利用Matlab进行决策树和随机森林的训练和测试

利用Matlab进行决策树和随机森林的训练和测试使用Matlab进行决策树和随机森林的训练和测试引言:在机器学习领域,决策树和随机森林是两个非常重要的算法。

它们被广泛应用于分类和回归问题中,具有较好的性能和可解释性。

而Matlab作为一款强大的科学计算软件,在机器学习领域也有着广泛的应用。

本文将介绍如何使用Matlab进行决策树和随机森林的训练和测试,以及一些实际案例的应用。

一、决策树训练与测试1. 数据准备在训练和测试决策树之前,首先需要准备好数据集。

数据集通常包括特征和标签两部分。

其中,特征是用来描述样本特点的属性,标签则用于标识样本的类别或值。

Matlab提供了丰富的工具箱和函数用于数据集的准备和处理,如csvread、xlsread等。

2. 特征选择特征选择是决策树训练的关键步骤之一,它能够帮助我们找到对目标变量具有较高预测能力的特征。

在Matlab中,使用featureSelection函数可以进行特征选择。

常用的特征选择方法有信息增益、方差选择、卡方检验等。

通过设定合适的阈值,可以筛选出对决策树训练更加重要的特征。

3. 决策树训练在数据准备和特征选择完成后,就可以进行决策树的训练了。

Matlab提供了fitctree函数用于训练决策树模型。

可以根据需求调整不同的参数,如决策树的深度、分裂准则等。

训练完成后,可以使用view函数可视化生成的决策树模型。

4. 决策树测试训练好的决策树模型需要进行测试验证其性能。

Matlab提供了predict函数用于对测试集进行预测,并计算预测结果与真实标签之间的准确度。

通过分析准确率、召回率等指标,可以评估决策树模型的质量。

二、随机森林训练与测试1. 数据准备与决策树相似,随机森林的训练和测试也需要准备好数据集。

同样需要包括特征和标签两个部分。

Matlab提供了一系列的数据集准备函数,如csvread、xlsread 等,方便用户进行数据的读取和处理。

数据挖掘之随机森林算法实验报告

数据挖掘之随机森林算法实验报告随机森林(Random Forest)是一种集成学习的算法,它将多个决策树模型组合成强大的分类器或回归模型。

本实验报告将介绍随机森林算法的原理、实验设计、实验结果和分析,并对实验结果进行讨论。

一、随机森林算法原理随机森林算法由两个基本部分组成:随机性和决策树。

随机性是指在创建随机森林时,使用了随机的样本和特征子集,以减少过拟合现象。

决策树是指使用特定的规则将输入数据分类到不同的输出类别。

随机森林算法的原理如下:1.从原始数据集中随机选择n个样本,作为训练集。

2.从训练集中随机选择k个特征,作为特征子集。

3.构建一个决策树模型,并使用特征子集训练该模型。

4.重复步骤2和3,构建m个决策树模型。

5.对于分类问题,每个模型的分类结果由投票决定,选择出现次数最多的类别为最终结果。

6.对于回归问题,每个模型的预测结果取平均值为最终结果。

二、实验设计实验步骤如下:1.首先,将数据集按照一定比例划分为训练集和测试集。

2.在训练集上使用随机森林算法构建模型。

3.在测试集上使用构建好的模型进行预测。

三、实验结果和分析在本次实验中,我们使用了100个决策树模型,并选择了10个特征进行训练。

实验的结果如下:1.在训练集上的准确率为98%,说明模型可以较好地拟合训练数据。

2.在测试集上的准确率为92%,说明模型在未见过的数据上仍有较好的泛化能力。

3.通过分析特征的重要性,我们可以得知哪些特征对预测结果的影响较大。

四、实验结果讨论在本次实验中,随机森林算法展现出了很好的性能。

但也有一些限制和改进的空间:1.随机森林算法在处理大规模数据集时可能会消耗较长的时间和大量的内存资源,因为需要构建多个决策树模型。

2.调整随机森林算法的参数可能会对模型的性能产生显著影响,需要进行进一步的参数调整和模型优化。

3.这个数据集中的特征数量相对较少,因此模型的性能可能会受到限制。

在面对更复杂的数据集时,可能需要使用更复杂的算法或增加特征工程的步骤。

基于决策树和随机森林的旅游推荐系统研究

基于决策树和随机森林的旅游推荐系统研究一、引言如今,旅游已经成为了人们生活中的一部分。

越来越多的人选择利用自己的休闲时间去旅游,以放松身心,了解不同地域文化。

因此,旅游推荐系统变得越来越重要。

旅游推荐系统是指利用计算机技术为用户提供最适合的旅游建议的系统。

目前,这种系统已经被广泛应用于旅游交易、旅游攻略、旅游租赁和旅游路线规划等领域。

本文将基于决策树和随机森林算法,建立一个旅游推荐系统。

二、建立模型1. 数据预处理数据预处理阶段的目的是将原始数据转化为可用于模型训练的数据形式。

我们需要把原始数据集进行清洗、转换、归一化等处理。

2. 特征选取特征选取是指从原始数据中挑选出最相关的特征进行分析。

我们可以利用相关系数或者决策树来进行特征筛选。

在特征选取的过程中,我们需要挑选出与问题相关、信息量丰富、较为稳定、易于处理的特征。

这样有助于提高模型的准确性和泛化能力。

3. 构建决策树决策树是一种常用的预测模型,适用于分类与回归问题。

构建决策树的过程其实就是将特征空间划分为一系列互不重合的区域,并在每个区域内确定一个预测值。

构建决策树的过程中,我们需要选择合适的节点划分规则和阈值,使得模型具有最佳的分类能力。

4. 构建随机森林随机森林是一种集成学习方法,可以用于分类和回归问题。

它是由多个决策树组成的,每个决策树由随机抽样得到的数据集和特征集构成。

在随机森林中,我们需要选择适当的树的个数和特征个数,使得模型具有最优的性能。

同时,我们还需要对每个决策树进行剪枝操作,以避免过拟合现象的出现。

五、实验和结果分析我们使用了一个包含5000个样本的数据集来测试我们的系统。

首先,我们对数据集进行了预处理,然后使用决策树和随机森林算法来构建模型。

最后,我们对模型进行了评估。

实验结果表明,随机森林算法的性能优于决策树算法。

同时,我们还发现,特征选取是影响模型性能的关键因素。

不同的特征组合会对模型的性能产生显著影响。

六、结论本文基于决策树和随机森林算法,建立了一个旅游推荐系统。

数据挖掘之随机森林算法实验报告

数据挖掘之随机森林算法实验报告随机森林(Random Forest)是一种集成学习(ensemble learning)算法,它通过构建多个决策树来进行预测和分类。

本实验报告将介绍随机森林算法的原理、实验设计和结果分析。

一、算法原理随机森林算法是由多个决策树组成的集成学习模型,其中每个决策树都是独立训练的,然后根据多数投票的原则进行预测。

算法的主要步骤如下:1.随机森林的训练集是原始数据集的一个随机子集,可以是有放回抽样也可以是无放回抽样。

2.对于每个决策树,随机选择m个特征(通常m的值小于特征总数),然后根据这些特征和训练集构建一个决策树模型。

3.重复上述步骤直到构建了足够数量的决策树。

4.在预测时,由所有决策树组成的随机森林对样本进行分类,最终的预测结果根据多数投票原则决定。

二、实验设计三、实验结果经过实验,得到了以下结果:1.随机森林的分类准确率随着树的数量的增加而提高,但是当树的数量达到一定阈值后准确率趋于稳定。

2.在设置不同的m值时,m越小,算法的准确率越高,但同时也会增加训练时间。

3.相比其他分类算法,随机森林算法在数据集上具有较高的预测准确率和稳定性。

四、结果分析通过实验结果可以看出,随机森林算法在处理分类问题时具有良好的性能表现。

其主要优点包括适用于高维数据集、减少过拟合的风险、能够处理大规模数据集等。

然而,随机森林算法也存在一些缺点,如随机性导致模型的可解释性较差、训练时间较长等。

综上所述,随机森林算法是一种有效的数据挖掘算法,能够在分类问题上取得较好的结果。

其应用领域广泛,例如医疗诊断、金融风险评估等。

未来的研究可以探索随机森林算法在其他领域的应用,并进一步优化算法性能。

决策树与随机森林的原理与应用

决策树与随机森林的原理与应用决策树和随机森林是机器学习领域中常见且强大的算法。

它们不仅在分类和回归问题上表现出色,还具有解释性强的优势。

本文将详细介绍决策树和随机森林的原理以及在实际应用中的一些案例。

一、决策树的原理决策树是一种基于树状结构进行决策的算法。

它通过对数据集进行递归划分,使得每个子集中的样本具有相同或者相似的特征,最终生成一个可解释的决策树模型。

1. 特征选择决策树的特征选择是通过计算每个特征的信息增益或者基尼指数来进行的。

信息增益衡量了在给定特征的条件下,划分前后的信息不确定性减少的程度;而基尼指数则可以度量一个子集中样本被错误分类的概率。

2. 决策树的生成决策树的生成是通过递归地选择最佳划分特征来进行的。

将数据集划分为足够纯净的子集,可以采用各种算法,如ID3、C4.5和CART算法。

这些算法根据特征选择的不同方法,生成了不同类型的决策树。

3. 决策树的剪枝为了避免决策树过拟合训练数据,需要进行剪枝操作。

剪枝是通过对生成的决策树进行修剪,移除一些不必要的节点,从而提高决策树的泛化能力。

二、随机森林的原理随机森林是一种基于集成学习的算法,它集成了多个决策树来进行分类和回归任务。

随机森林的核心思想是利用随机化的方式构建多个决策树,然后通过投票方式进行结果集成。

1. 随机特征选择在随机森林中,每个决策树的特征选择是随机进行的。

不同的决策树可能选取的特征不同,这样可以增加模型的多样性,提高整体性能。

2. 自助采样法随机森林使用自助采样法(Bootstrap Sampling)对原始数据集进行有放回的采样,生成多个不同训练集来构建多个决策树。

这样可以使得每个决策树的训练集略有差异,增加模型的多样性。

3. 随机森林的集成随机森林的集成是通过对多个决策树的结果进行投票或平均来得到最终的预测结果。

在分类问题中,采用投票的方式选择出现次数最多的类别;在回归问题中,采用平均的方式获得数值型的输出。

三、决策树和随机森林的应用决策树和随机森林在各个领域都有广泛的应用。

决策树与随机森林模型的比较与使用指南(四)

决策树与随机森林模型的比较与使用指南随着大数据和人工智能技术的迅猛发展,机器学习模型在各个领域得到了广泛的应用。

决策树和随机森林作为经典的机器学习算法,在数据挖掘和预测建模中扮演着重要的角色。

本文将对决策树和随机森林进行比较,并提供使用指南,帮助读者更好地理解和应用这两种模型。

1. 决策树模型决策树是一种基于树形结构来进行决策的模型。

它通过对样本数据进行分类和预测,构建一个树形的决策流程。

在决策树中,每个节点代表一个属性,每个分支代表这个属性的一个取值,而每个叶子节点代表一个类别或者一个数值。

决策树的优点是易于理解和解释,能够处理多种数据类型,并且可以处理大规模的数据集。

然而,决策树容易过拟合,对噪声和异常值敏感,因此需要进行剪枝操作来避免过拟合。

2. 随机森林模型随机森林是一种集成学习方法,它由多个决策树组成。

在随机森林中,每棵决策树都是基于不同的随机样本和随机特征构建的,然后将它们进行整合得到最终的预测结果。

随机森林通过利用多个模型的集成来提高预测的准确性和稳定性,同时减少了过拟合的风险。

由于随机森林能够处理高维数据和大规模数据集,并且不需要对数据进行特征缩放,因此在实际应用中得到了广泛的应用。

3. 决策树与随机森林的比较在比较决策树和随机森林时,可以看出它们各自的特点。

决策树简单直观,易于理解和解释,但容易过拟合;而随机森林通过集成多个决策树,提高了预测的准确性和稳定性,同时减少了过拟合的风险。

因此,在实际应用中,可以根据具体的场景和数据特点来选择合适的模型。

4. 使用指南在使用决策树和随机森林模型时,需要注意以下几点:- 数据准备:对于决策树和随机森林模型,需要对数据进行预处理和特征工程,包括缺失值处理、数据标准化、特征选择等操作。

此外,需要将数据集划分为训练集和测试集,用于模型的训练和评估。

- 模型选择:在选择模型时,需要根据实际情况和数据特点来决定使用决策树还是随机森林。

如果数据集较小,且希望获得更好的解释性和可解释性,可以选择决策树模型;如果数据集较大,且需要更高的预测准确性和稳定性,可以选择随机森林模型。

随机森林决策树训练过程

随机森林决策树训练过程

随机森林是一种集成学习方法,它由多个决策树组成,每棵树

都是独立训练的。

随机森林的训练过程可以分为以下几个步骤:

1. 数据准备,首先,需要准备训练数据集。

每个样本都包含多

个特征和一个标签,特征用来描述样本的属性,标签用来表示样本

的类别或者输出值。

2. 随机抽样,在训练每棵决策树时,从训练数据集中进行随机

抽样。

这种随机抽样的方法被称为自助采样法(bootstrap sampling),它可以保证每棵决策树的训练集都是有放回地从原始

训练集中抽取的,且大小与原始训练集相同。

3. 特征随机选择,在每个节点的决策过程中,随机选择一部分

特征进行考虑。

这样做的目的是为了降低各个决策树之间的相关性,增加随机性,提高模型的泛化能力。

4. 决策树训练,对于每棵决策树,使用随机抽样的训练集和随

机选择的特征集进行训练。

通常采用递归二分法构建决策树,选择

最佳的特征进行节点划分,直到满足停止条件(如节点样本数小于

阈值或树的深度达到预设值)为止。

5. 集成学习,训练多棵决策树后,将它们组合成随机森林。

在分类问题中,通常采用投票的方式确定最终的分类结果;在回归问题中,通常采用平均值的方式确定最终的预测结果。

总的来说,随机森林的训练过程就是通过构建多棵决策树,利用随机抽样和特征随机选择增加模型的多样性,然后通过集成学习将这些决策树组合起来,以取得更好的分类或回归性能。

这种方法能够有效地减少过拟合,提高模型的鲁棒性和泛化能力。

数据分析中的决策树和随机森林算法

数据分析中的决策树和随机森林算法数据分析在各个领域中发挥着重要的作用,帮助人们更好地理解和应对复杂的问题。

而在数据分析的过程中,决策树和随机森林算法是常见且广泛应用的两种方法。

它们能够从大量的数据中提取有价值的信息,辅助决策和预测。

本文将详细介绍决策树和随机森林算法的原理和应用,并对比它们的优缺点。

一、决策树算法决策树算法是一种基于树形结构的监督学习方法,通过将数据集分割成较小的子集,逐步构建决策树来进行决策和预测。

决策树的节点表示属性或特征,分支代表属性的取值,叶节点表示决策结果。

决策树的构建过程主要包括三个步骤:特征选择、树的构建和剪枝。

特征选择是指通过某种指标选择最佳的特征作为节点,将数据集划分成更具分类能力的子集。

树的构建是指根据选择的特征递归地将子集进一步划分,直到子集中的数据都属于同一类别或者满足停止条件。

剪枝是为了避免过拟合,通过删除某些节点来简化决策树。

决策树算法具有以下优点:易于理解和解释,可以处理数值型和离散型数据,对缺失值和异常值具有较好的鲁棒性。

然而,决策树的训练过程容易受到训练集的噪声和特征选择的不准确性等因素的影响,容易产生过拟合现象。

二、随机森林算法随机森林算法是一种集成学习方法,由多个决策树组成。

每个决策树都是通过对原始数据集进行有放回抽样(bootstrap)得到的。

在每个节点上,随机森林会随机选择一部分特征进行特征选择,再选择最佳特征进行节点分割。

最终,随机森林通过投票或平均值来进行决策。

随机森林算法继承了决策树算法的优点,并对其进行了改进。

相比于单个决策树,随机森林具有更高的预测准确性和鲁棒性。

通过集成多个决策树,随机森林可以降低过拟合的风险,并且能够处理大规模高维数据集。

此外,随机森林还可以通过特征重要性评估每个特征在分类任务中的重要程度。

然而,随机森林算法也存在一些缺点。

首先,随机森林的训练过程较慢,特别是在处理大规模数据集时。

其次,随机森林模型的结果较难解释,不如决策树直观。

决策树与随机森林模型的比较与使用指南(六)

决策树与随机森林模型的比较与使用指南引言在机器学习领域,决策树和随机森林是两种常见的模型。

它们都属于监督学习算法,用于分类和回归任务。

本文将比较这两种模型的特点和适用场景,并给出它们的使用指南。

1. 决策树决策树是一种以树状图作为基本模型的预测模型,它使用树状图来呈现算法的决策过程。

决策树的节点表示特征属性,分支表示在这个特征上的取值,叶子节点表示最终的分类或回归结果。

决策树算法的优点是易于理解和解释,可以处理数值型和标称型数据,对缺失值不敏感。

但是,决策树也有一些缺点。

它很容易产生过拟合问题,尤其是在处理复杂的数据集时。

决策树的不稳定性也使得它对数据的微小变化非常敏感。

2. 随机森林随机森林是一种集成学习方法,它由多棵决策树组成。

每棵树都是独立训练的,而且在选择划分节点时,随机森林会引入随机性,使得每棵树都有所不同。

最终的分类或回归结果是由多棵树的结果综合得到的。

随机森林相对于单棵决策树有很多优点。

它不容易过拟合,因为多棵树的结果会互相抵消。

同时,随机森林对于高维数据和大规模数据的处理能力也相对较好。

另外,随机森林对于缺失值的处理也很有效。

3. 比较在决策树和随机森林之间进行比较,可以得出以下结论:- 决策树相对简单,易于理解和解释,但容易过拟合;- 随机森林是一种集成学习方法,能够降低过拟合风险,对缺失值和大规模数据处理能力强。

因此,在实际应用中,可以根据数据集的复杂度和规模来选择合适的模型。

对于简单的问题,可以选择决策树;而对于复杂的问题,尤其是大规模数据集,随机森林可能是更好的选择。

4. 使用指南在使用决策树和随机森林模型时,有一些常见的注意事项需要考虑:- 数据预处理:对于决策树和随机森林模型来说,数据预处理是非常重要的。

包括缺失值处理、数据标准化、特征选择等步骤,都会对模型的性能产生影响。

- 超参数调优:在使用随机森林模型时,需要对一些超参数进行调优,例如树的数量、最大深度、最小叶子节点等。

决策树与随机森林模型的比较与使用指南

在机器学习领域,决策树和随机森林都是常用的分类模型。

它们都是监督学习算法,用于解决分类和回归问题。

在本文中,我们将比较这两种模型,并提供它们的使用指南。

决策树是一种树形结构,它通过一系列的规则对数据进行分类或回归。

决策树的每个节点代表一个特征属性,每个分支代表这个特征属性的一个取值,而每个叶节点代表一种分类或回归结果。

决策树的优点是易于理解和解释,可以处理数字和分类数据。

然而,决策树也有一些限制。

它很容易过拟合,特别是在处理高维数据时。

而且,决策树对数据中的噪声非常敏感,可能导致不稳定的结果。

为了解决这些问题,随机森林模型应运而生。

随机森林是一种集成学习算法,它通过多个决策树对数据进行分类或回归。

随机森林的每棵树都是独立训练的,而且每棵树的输入数据也是随机选择的。

最后,通过取多个决策树的投票结果或平均值来得到最终的分类或回归结果。

随机森林的优点是在减少过拟合的同时提高了预测准确度,对于高维数据和大规模数据有很好的效果。

然而,随机森林也有一些缺点。

它在处理噪声数据时可能会导致不同的树之间产生差异,从而降低了模型的稳定性。

而且,随机森林模型的训练时间相对决策树来说更长。

在实际使用中,我们如何选择决策树和随机森林呢?以下是一些建议:首先,如果数据比较简单且干净,决策树可能是一个不错的选择。

决策树能够提供直观的决策过程,并且训练速度快。

其次,如果数据比较复杂且噪声较多,那么随机森林可能更适合。

随机森林通过组合多个决策树的结果,减少了过拟合的风险。

另外,如果模型的解释性很重要,那么决策树可能更合适。

决策树的决策过程很容易理解,可以帮助我们理解数据中的规律。

最后,如果我们需要预测新数据的分类或回归结果,而且需要较高的准确度,那么随机森林可能更适合。

随机森林通过集成多个模型的结果,通常能够得到比单个决策树更好的预测结果。

在使用决策树和随机森林时,我们还需要注意一些问题。

首先,要注意调参。

决策树和随机森林都有一些参数需要调整,比如树的深度、最小叶子节点数等。

决策树与随机森林分类算法(Python实现)

决策树与随机森林分类算法(Python实现)⼀、原理:决策树:能够利⽤⼀些决策结点,使数据根据决策属性进⾏路径选择,达到分类的⽬的。

⼀般决策树常⽤于DFS配合剪枝,被⽤于处理⼀些单⼀算法问题,但也能进⾏分类。

也就是通过每⼀个结点的决策进⾏分类,那么关于如何设置这些结点的决策⽅式:熵:描述⼀个集合内元素混乱程度的因素。

熵的衡量公式:公式中的熵值Entropy会随着集合中类别数量增加⽽快速增加,也就是说⼀个集合中类别越少,那么它的熵就⼩,整体就越稳定。

对于⼀个标记数据集,要合理的建⽴⼀棵决策树,就需要合理的决定决策结点来使决策树尽快的降低熵值。

如何选择合适的决策:(1)信息增溢对于当前的集合,对每⼀个决策属性都尝试设置为决策结点的⽬标,计算决策分类前的熵值与分类后的所有⼦集的熵值的差。

选择最⼤的,作为当前的决策⽬标。

此⽅式有⼀些确定,就是当⾯对⼀些决策变量的分类⼦集很多,⽽⼦集却很⼩的情况。

这次办法虽然会很快的降低熵,但这并不是我们想要的。

(2)信息增溢率这是对熵增溢的⼀种改进,把原本的前后熵值的差,增加:决策分类前属性的熵和与决策分类后的的熵的⽐值,如果⽐值很⼩,说明分类分很多,损失值就会很⼤。

(3)gini系数:gini系数和信息增溢率⽐较像决策树的剪枝:预剪枝:设置max_depth来达到建树过程中的剪枝,表⽰树的最⼤深度后剪枝:通过min_sample_split与min_sample_leaf来对已经建成的决策树进⾏剪枝,分别是结点的元素个数与⼦树的叶⼦结点个数随机森林:构建多个决策树,从⽽得到更加符合期望的⼀些决策结果。

以森林的结果众数来表⽰结果。

往往采⽤⽣成⼦数据集,取60%随机⽣成数据集交叉验证:⼏折交叉验证⽅式为,将训练数据进⾏⼏次对折,取⼀部分作为测试集,其他作为训练集。

并将每个部分轮流作为测试集,最后得到⼀个平均评分。

⽹格超参数调优:对分类器的参数进⾏调优评价,最后得到⼀个最优的参数组,并作为最终的分类器的参数。

数据挖掘之随机森林算法实验报告

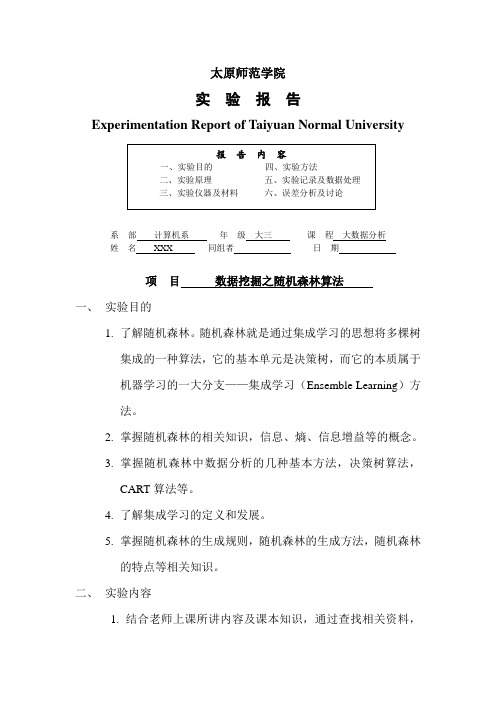

太原师范学院实验报告Experimentation Report of Taiyuan Normal University系部计算机系年级大三课程大数据分析姓名XXX 同组者日期项目数据挖掘之随机森林算法一、实验目的1.了解随机森林。

随机森林就是通过集成学习的思想将多棵树集成的一种算法,它的基本单元是决策树,而它的本质属于机器学习的一大分支——集成学习(Ensemble Learning)方法。

2.掌握随机森林的相关知识,信息、熵、信息增益等的概念。

3.掌握随机森林中数据分析的几种基本方法,决策树算法,CART算法等。

4.了解集成学习的定义和发展。

5.掌握随机森林的生成规则,随机森林的生成方法,随机森林的特点等相关知识。

二、实验内容1.结合老师上课所讲内容及课本知识,通过查找相关资料,学习与决策树,随机森林相关的知识。

2.查找相关例题,深入理解随机森林的各种算法。

3.找一个数据集,利用随机森林的相关算法训练随机森林,对样本进行判段并计算其判断的准确度。

三、实验仪器及平台计算机一台MATLAB 2018a四、实验原理1.随机森林的基本概念:通过集成学习的思想将多棵树集成的一种算法,它的基本单元是决策树,而它的本质属于机器学习的一大分支——集成学习(Ensemble Learning)方法。

随机森林的名称中有两个关键词,一个是“随机”,一个就是“森林”。

“森林”我们很好理解,一棵叫做树,那么成百上千棵就可以叫做森林了,这样的比喻还是很贴切的,其实这也是随机森林的主要思想--集成思想的体现。

2.决策树2.1信息、熵、信息增益这三个基本概念是决策树的根本,是决策树利用特征来分类时,确定特征选取顺序的依据。

2.2决策树算法决策树算法是一种逼近离散函数值的方法。

它是一种典型的分类方法,首先对数据进行处理,利用归纳算法生成可读的规则和决策树,然后使用决策对新数据进行分析。

本质上决策树是通过一系列规则对数据进行分类的过程。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验算法决策树和随机森林实验【实验名称】决策树和随机森林实验【实验目的】掌握决策树和随机森林实验模型应用过程,根据模型要求逬行数据预处理,建模,评价与应用;【背景描述】决策树与随机森林,属于监督学习,通过纯化指标的计算,确走分支方式,逐步构建成树形结构。

决策树由节点(node )和有向边(directed edge )组成。

节点的类型有两种:内部节点和叶子节点。

具中,内部节点表示一个特征或属性的测试条件(用于分开具有不同特性的记录),叶子节点表示一个分类。

随机森林顾名思义,是用随机的方式建立一个森林,森林里面有很多的决策树组成,随机森林的每一棵决策树之间是没有关联的。

在得到森林之后,当有一个新的输入样本逬入的时候,就让森林中的每一棵决策树分别进行一下判断,看看这个样本应该属于哪一类(对于分类算法),然后看看哪_类被选择最多,就预测这个样本为那一类。

【知识准备】了解决策树与随机森林模型的使用场景,数据标准。

了解Python/Spark数据处理一般方法。

了解spark模型调用,训练以及应用方法【实验要求】完成决策树和随机森林实验【实验设备】Windows或Linux操作系统的计算机。

部署Spark r Python r本实验提供centos6.8环境。

【实验说明】采用UCI机器学习库中的wine数据集作为算法数据,训练决策树与随机森林模型,对样本进行聚类。

【实验坏境】Spark 23.1 r Pyrhon3.X ,实验在命令行pyspark中进行,或者把代码写在py脚本,由于本次为实验,以学习模型为主,所以在命令行中逐步执行代码,以便更加清晰地了解整个建模流程。

【实验步骤】第一步:启动pyspark :命令行中键入pyspark -master local[4],本地模式启动spark与python :第二步:导入用到的包#并读取数据:⑴•将所需导入的包键入Spark Shell中,具体命令:from pyspark import SparkConf, SparkContextfrom pyspark.mllib.evaluation import MulticlassMetrics from pyspark.mllib.tree import Decisi on Tree, RandomForestfrom pyspark.mllib.regression import LabeledPoint(2).读取数据源,具体命令(第一行由于word文档篇幅受限在Spark Shell中必须将他复制成一行, 否则会报语法错误,其他命令建议一行一行复制),数据源存放目录为/opt/algorithm/decisionTreeAndRandomForest/wine.txt:wine-rdd=sc.textFile(u,,file:/opt/algorithm/decisionTreeAndRandomForest/wine.txt").map(l ambda x: str(x).split(,'/")).map(lambda x: [float(z) for z in x])data = wine-rdd.map(lambda x: LabeledPoint(x[0] - l t (x[l:])))(trainData, testData) = data.randomSplit([8O 2.0])»> from pyspark import SparkConf, SparkContext»> from pyspark.mllib•亡valuation iirport MulticlassMetricsfrom pyspark.mllib.tree import DecisionTree, R«andomForest>» from pyspark.mllib. reg ression iirpor t Labe led Poi nt»> #读取数据…• wine^rdd = sc. textFile(u'^ilei/data/laboratory/wine.txt").map(... lambda x: str(x) .split (,a f11>) .nap (lambda x: [f loat (z) for z in x]) >» # 转换为Labeled Point• data = wine_rdd.map(Lambda x: LabeledPaint(x[0] - l f (x [1:])))»> #数据集划芬...(trainData F testData) = data.randomSplitC[8.0, 2.0])第三步:构建模型并应用在测试集,输出测试集准确率具体命令如下:(1) •建立决策树模型model = DecisionTree.trai nClassifier(trainData fnumClasses=3/categoricalFeaturesInfo={}rimpurity—gini:maxDepth=5rmaxBins=32fminInstancesPerNode=l/minInfoGain=0.0⑵利用建立好的模型做预测predictions = model.predict(testData.map(lambda x: x.features)) predictionsAndLabels = predictions.zip(testData.map(lambda x: x」abel)) metrics = MulticlassMetrics(predictionsA ndLabels)⑶•打印预测信息print(H DecisionTree w + str(metrics.precision()))>» m决?s剧------------------•・・审建立决忻蟆型・・・ rodcl - DccisionTrce・・・・nunClasie2=3, t晏别的数忖・・・categoncalFeatureslnfo=O r t畏曲奇定类别安■,如茨示第介个交盘为楊称企共k个但・・・itipurity-'Qini1, « (SSflffi计段方透,可逸在用厲与4尼不现度,总认4尼不呃度・・・macDep令h=5. *材51人滉废•・・naxBins=32f v袴征切剖区何鸽牝个滋... minlnstanccsPcrNodc-l. #岂节点中邑含样本■小于这个備•削逐帀点不令畀彼龙分・・・ninlnfo6oin=e.0 #当节点的信見裟总小于这个(1,(11访节煖不・・・丨#冃用强血好釣響毘仪汝汕・・・ predictions = nodel・ptwtDdto・Fidp(lonbdd x: x・feotures))»> predic11 onsAftdLabels = predictions・2ip(tei.tData.r*2p(lanbda x: bel))retries - H J U IC lassNct rics (predict lonsAnd La be Is)>» print '•OccisionTrcc 11, nctrics.prctisiorH)DeclSionTree 0.966666666667第四步:构建随机森林模型并应用在测试集,输出测试集准确率(1) •建立随机森林模型model _forest = RandomForest.trainClassifier(trainData fnumClasses=3rcategoricalFeaturesInfo={}/numTrees=1000rfeatureSubsetStrategy=,auto,rimpurity=,gini,/maxDepth=5#maxBins=32zseed=None)⑵.根据森林模型逬行预测predictions? = model Jorest.predict(testData.map(lambda x: x.features)) predictionsAndLabels2 = predictions2.zip(testData.map(lambda x: x」abel)) ⑶•打印预测信息metrics2 = MulticlassMetrics(predictio nsAndLabels)print("RandomForest M + str(metrics2.precision()))・・・ rodel_fore$t - Rindor^o^e$t.Trair<ld$$ifler(trdinDdTd r・・・nurCla$$e$-3r<曼刘的数目・・・categorRalFeaturesInfo-<L *怨F冷定览別52■,如5:締丧汰第"个交■为你林3?共k个值... nu»7rees-lsee, Q 旬碗戲ft・・•featuresubsetStrategy«•outo*,・・・#毎冬灰的找征虑鬼求昭•衣羚的血:*auto*. *alX*. -sqrt-. *log2*. •onethird*.个败大于[八so即理rt.如肉个JX-1,autocall・・・lnpurUy=-B inl\ X饶息塔畐计押方池,司送H总靖与翠足不住度.事尼不住废・・・rox0epth=5, 0 X... nax0ins=32, $痔抵6割耳同績化个戒・・・^eed^one車琦机种于*»>» f利用・・・ prediction$2 - rodel.fo^est.predict(xestDaxa.napHdrvbda x: x.features))>» predictlonsArdLabel52 - pre^icticn52.2ip(te5tOata.n3p(larbda x: bel))>» retric52 ■ Nulticlas^Hstrics I predict ion sAndLaDe Is)>» print "RarvdonForest netrics2.precision()RandCrtForest B.9666G6666667第五步:可以通过spark submit提交整个文件,进行运篦查看结果,命令如下[root@hadoop]#/opt/spark-2.3.1/bin/spark-submit/opt/algorithm/decisionTreeAndRa ndomForest/desionTreeAndRandomForest.py【问题与回答】1、Q :分类器是否需要考虑样本平衡问题A:当正负样本数臺差异巨大,模型的准确率与召回率是矛盾的,例如正负样本9:1,则分类器认为全部样本都为正,则准确率有90% ,而召回率分别为100% , 0% ,这显然是不可取的。