聚类分析程序代码

Python中的聚类分析方法和应用

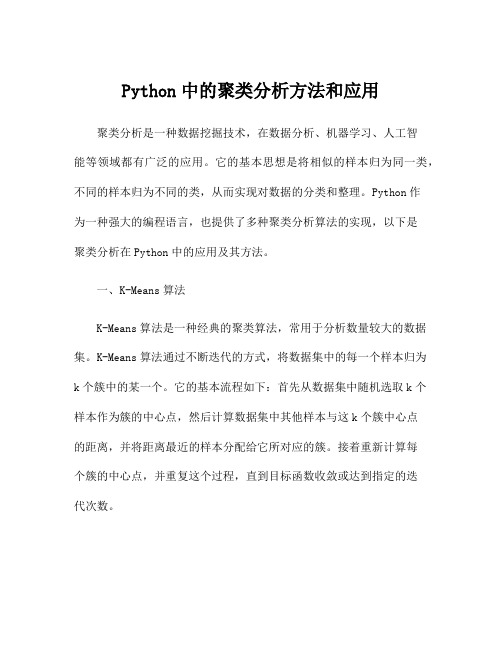

Python中的聚类分析方法和应用聚类分析是一种数据挖掘技术,在数据分析、机器学习、人工智能等领域都有广泛的应用。

它的基本思想是将相似的样本归为同一类,不同的样本归为不同的类,从而实现对数据的分类和整理。

Python作为一种强大的编程语言,也提供了多种聚类分析算法的实现,以下是聚类分析在Python中的应用及其方法。

一、K-Means算法K-Means算法是一种经典的聚类算法,常用于分析数量较大的数据集。

K-Means算法通过不断迭代的方式,将数据集中的每一个样本归为k个簇中的某一个。

它的基本流程如下:首先从数据集中随机选取k个样本作为簇的中心点,然后计算数据集中其他样本与这k个簇中心点的距离,并将距离最近的样本分配给它所对应的簇。

接着重新计算每个簇的中心点,并重复这个过程,直到目标函数收敛或达到指定的迭代次数。

在Python中,K-Means算法的实现非常简单,主要依托于scikit-learn库。

引入sklearn.cluster包,并使用KMeans类即可。

以下是一个简单的Python代码示例:```from sklearn.cluster import KMeansimport numpy as npdata = np.random.rand(1000, 2)kmeans = KMeans(n_clusters=3, random_state=0).fit(data) labels = bels_centers = kmeans.cluster_centers_```其中,随机生成1000个二维数据作为数据集,然后使用KMeans 类进行聚类,将数据集划分为3个簇。

最后,通过labels和centers 变量获取分类信息和中心点坐标。

二、层次聚类算法层次聚类算法是另一种经典的聚类算法,在Python中同样得到了广泛的应用。

层次聚类算法又被称为自底向上聚类(bottom-up clustering)或自上而下聚类(top-down clustering),它的基本思想是不断合并距离最近的样本,直到所有的样本都被归为一类为止。

SAS聚类分析程序

SAS聚类分析程序:聚类分析过程命令Data pgm33b;Input x1-x3;cards;9.30 30.55 8.7(样品数据)1.85 20.66 12.75;Proc cluster standard method= single nonormnosquare ccc pseudo out=tree;Proc tree data=tree horizontal spaces=1; run;Data pgm33bInput x1-x4;cards;9.30 30.55 8.7(样品数据)1.85 20.66 12.75;Proc cluster standard method=complete nonormnosquare ccc pseudo out=tree;Proc tree data=tree horizontal spaces=1; run;刷黑该块过程命令程序,提交便计算出相应聚类结果。

语句解释: 聚类指定的方法是在“method=”后面填入一个相应的选择项,它们是:single(最短距离法),complete(最长距离法),average(类平均法), centroid(重心法),median(中位数法),ward(离差平方和法),flexible (可变类平均法),density(非参数概率密度估计法),eml(最大似然法),twostage(两阶段密度法)。

主成分分析程序:1. 主成分分析实验程序例:主成分分析过程命令data socecon;input x1-x6;cards;16369 3504887 66047 2397739 198.46 104395513379 566257 4744 456100 76.96 2026379707 397183 1303 887034 18.88 10594810572 414932 1753 751984 27.67 12826112284 876667 18269 1015669 60.09 3327009738 604935 5822 1307908 30.54 22279916970 778830 2438 630014 76.64 27220310006 617436 13543 866013 58.59 22279410217 636760 9967 996912 34.55 16102520946 1380781 16406 526527 150.15 42693711469 720416 7141 853778 43.41 15727414165 1504005 29413 1025363 149.17 56889912795 966188 11580 723278 45.13 16531912762 584696 13583 343107 65.31 16645412008 501780 4986 278310 15.04 86575 11208 981367 13364 1295189 79.8 337947 12719 716491 4448 408796 15.68 99949 ;proc princomp out=aaa prefix=z;var x1-x6; run;data a2;set aaa;proc print;var z1-z2 ;run;。

【sas代码模板】聚类分析_cluster

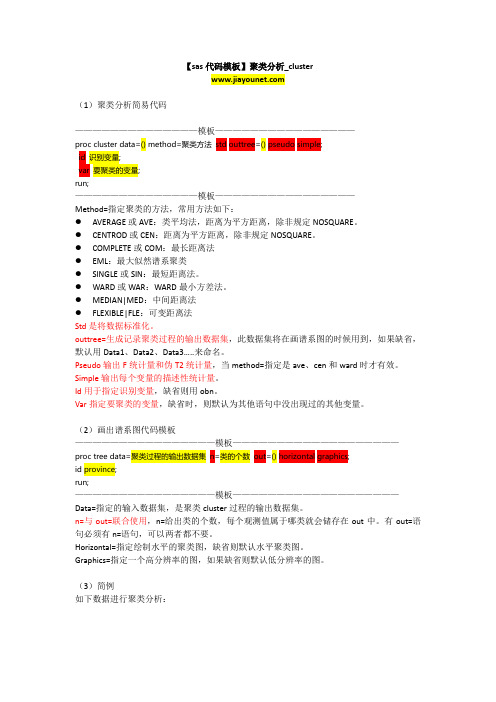

【sas代码模板】聚类分析_cluster(1)聚类分析简易代码——————————————模板————————————————proc cluster data=() method=聚类方法std outtree=() pseudo simple;id 识别变量;var 要聚类的变量;run;——————————————模板————————————————Method=指定聚类的方法,常用方法如下:●AVERAGE或AVE:类平均法,距离为平方距离,除非规定NOSQUARE。

●CENTROD或CEN:距离为平方距离,除非规定NOSQUARE。

●COMPLETE或COM:最长距离法●EML:最大似然谱系聚类●SINGLE或SIN:最短距离法。

●WARD或WAR:WARD最小方差法。

●MEDIAN|MED:中间距离法●FLEXIBLE|FLE:可变距离法Std是将数据标准化。

outtree=生成记录聚类过程的输出数据集,此数据集将在画谱系图的时候用到,如果缺省,默认用Data1、Data2、Data3…..来命名。

Pseudo输出F统计量和伪T2统计量,当method=指定是ave、cen和ward时才有效。

Simple输出每个变量的描述性统计量。

Id用于指定识别变量,缺省则用obn。

Var指定要聚类的变量,缺省时,则默认为其他语句中没出现过的其他变量。

(2)画出谱系图代码模板————————————————模板———————————————————proc tree data=聚类过程的输出数据集n=类的个数out=() horizontal graphics;id province;run;————————————————模板———————————————————Data=指定的输入数据集,是聚类cluster过程的输出数据集。

n=与out=联合使用,n=给出类的个数,每个观测值属于哪类就会储存在out中。

matlab、lingo程序代码14-模糊聚类(聚类分析)

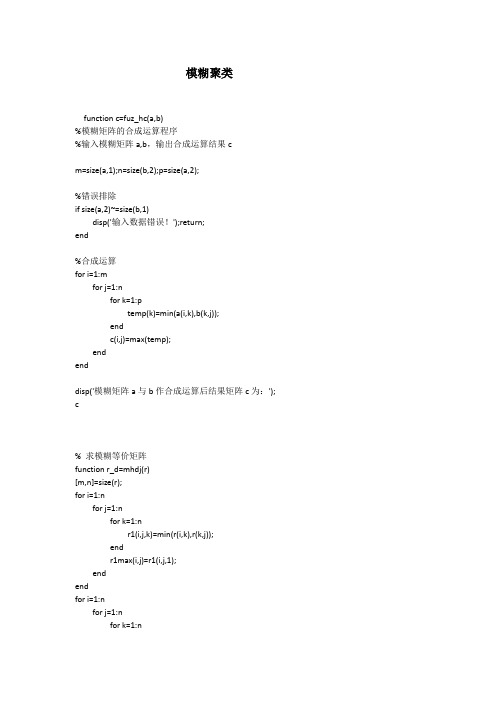

模糊聚类function c=fuz_hc(a,b)%模糊矩阵的合成运算程序%输入模糊矩阵a,b,输出合成运算结果cm=size(a,1);n=size(b,2);p=size(a,2);%错误排除if size(a,2)~=size(b,1)disp('输入数据错误!');return;end%合成运算for i=1:mfor j=1:nfor k=1:ptemp(k)=min(a(i,k),b(k,j));endc(i,j)=max(temp);endenddisp('模糊矩阵a与b作合成运算后结果矩阵c为:'); c% 求模糊等价矩阵function r_d=mhdj(r)[m,n]=size(r);for i=1:nfor j=1:nfor k=1:nr1(i,j,k)=min(r(i,k),r(k,j));endr1max(i,j)=r1(i,j,1);endendfor i=1:nfor j=1:nfor k=1:nif r1(i,j,k)>r1max(i,j)r1max(i,j)=r1(i,j,k);endendr_d(i,j)=r1max(i,j);endend%模糊聚类程序function f=mujl(x,lamda)%输入原始数据以及lamda的值if lamda>1disp('error!') %错误处理end[n,m]=size(x);y=pdist(x);disp('欧式距离矩阵:');dist=squareform(y) %欧氏距离矩阵dmax=dist(1,1);for i=1:nfor j=1:nif dist(i,j)>dmaxdmax=dist(i,j);endendenddisp('处理后的欧氏距离矩阵,其特点为每项元素均不超过1:');sdist=dist/dmax %使距离值不超过1disp('模糊关系矩阵:');r=ones(n,n)-sdist %计算对应的模糊关系矩阵t=mhdj(r);le=t-r;while all(all(le==0)==0)==1 %如果t与r相等,则继续求r乘以r r=t;t=mhdj(r);le=t-r;enddisp('模糊等价矩阵为:')tfor i=1:nk=1;for j=1:nif t(i,j)>=lamdagroup(i,k)=j;k=k+1;endendenddisp('聚类结果如下(数字0为自动填充数据,不是样本序号):') group(1,:)for i=2:nk=0;for j=1:i-1if all(group(i,:)==group(j,:))==1 %两行值完全相等,不输出k=1;break;endendif k==0disp(group(i,:)) %仅输出不重复的分类endend%模糊聚类程序function f=mujl(x,lamda)%输入原始数据以及lamda的值if lamda>1disp('error!') %错误处理end[n,m]=size(x);xmax=max(x);xmin=min(x);x=(x-xmin(ones(n,1),:))./(xmax(ones(n,1),:)-xmin(ones(n,1),:))y=pdist(x);disp('欧式距离矩阵:');dist=squareform(y) %欧氏距离矩阵dmax=dist(1,1);for i=1:nfor j=1:nif dist(i,j)>dmaxdmax=dist(i,j);endendenddisp('处理后的欧氏距离矩阵,其特点为每项元素均不超过1:');sdist=dist/dmax %使距离值不超过1disp('模糊关系矩阵:');r=ones(n,n)-sdist %计算对应的模糊关系矩阵t=mhdj(r);le=t-r;while all(all(le==0)==0)==1 %如果t与r相等,则继续求r乘以r r=t;t=mhdj(r);le=t-r;enddisp('模糊等价矩阵为:')tfor i=1:nk=1;for j=1:nif t(i,j)>=lamdagroup(i,k)=j;k=k+1;endendenddisp('聚类结果如下(数字0为自动填充数据,不是样本序号):') group(1,:)gru_val=1;for i=2:nk=0;for j=1:i-1if all(group(i,:)==group(j,:))==1 %两行值完全相等,不输出k=1;break;endendif k==0disp('第i类样本序号:'),igru_val=gru_val+1;disp(group(i,:)) %仅输出不重复的分类endendgru_val。

r语言聚类分型代码

r语言聚类分型代码

以下是一个使用 R 语言进行聚类分型的示例代码:

```R

# 加载所需的包

library(cluster)

library(factoextra)

library(ggplot2)

# 准备数据

data <- mtcars[, 1:10] # 使用 mtcars 数据集的前 10 个变量

# 进行聚类分析

clus <- kmeans(data, 3) # 将数据分为 3 类

# 查看聚类结果

print(clus)

# 绘制聚类结果

ggplot(data, aes(x = factor(clus$cluster), y = mpg)) +

geom_point() +

facet_wrap(~cyl) +

theme_classic()

```

在上述代码中,我们首先加载了所需的包,包括`cluster`包用于进行聚类分析,`factoextra`包用于输出聚类结果的统计信息,以及`ggplot2`包用于绘制聚类结果。

然后,我们准备数据,并使用`kmeans`函数进行聚类分析,将数据分为 3 类。

接下来,我们打印出聚类结果,包括每个样本的聚类分配和聚类中心。

最后,我们使用`ggplot`函数绘制聚类结果,将聚类分配作为 x 轴,mpg 作为 y 轴,并按照`cyl`变量进行分组。

请根据你的实际需求和数据进行适当的调整和修改。

聚类分析的结果分析和编程

聚类分析方法一:最短距离法程序:proc cluster data=work.zidan outtree=tree method=sin notie;id g;proc tree horizontal;id g;run;结果:Eigenvalue Difference Proportion Cumulative1 29740435.8 25650007.9 0.8718 0.87182 4090427.9 3812173.1 0.1199 0.99173 278254.8 274011.4 0.0082 0.99994 4243.4 4242.5 0.0001 1.00005 0.9 0.9 0.0000 1.00006 0.0 0.0 0.0000 1.00007 0.0 0.0000 1.0000Cluster HistoryNormMinNCL ------Clusters Joined------- FREQ Dist5 26 2 0.28954 1 CL5 3 0.33333 CL4 4 4 0.50012 3 5 2 0.70171 CL3 CL2 6 1.0154方法二:最长距离法程序:proc cluster data=work.zidan outtree=tree method=complete;id g;proc tree horizontal;id g;run;结果:Eigenvalues of the Covariance MatrixEigenvalue Difference Proportion Cumulative1 29740435.8 25650007.9 0.8718 0.87182 4090427.9 3812173.1 0.1199 0.99173 278254.8 274011.4 0.0082 0.99994 4243.4 4242.5 0.0001 1.00005 0.9 0.9 0.0000 1.00006 0.0 0.0 0.0000 1.00007 0.0 0.0000 1.0000Root-Mean-Square Total-Sample Standard Deviation = 2207.564Mean Distance Between Observations = 7428.48(变量之间的平均距离)Cluster HistoryNorm TMax iNCL ------Clusters Joined------- FREQ Dist e5 26 2 0.28954 1 4 2 0.50013 3 5 2 0.70172 CL4 CL5 4 0.72971 CL2 CL3 6 1.7694此结果表示的是:类的个数,合并类的名字,新类中的变量个数和最长正规化距离。

编程实现聚类分析算法

编程实现聚类分析算法调用函数:min1.m——求矩阵最小值,返回最小值所在行和列以及值的大小min2.m——比较两数大小,返回较小值std1.m——用极差标准化法标准化矩阵ds1.m——用绝对值距离法求距离矩阵cluster.m——应用最短距离聚类法进行聚类分析print1.m——调用各子函数,显示聚类结果聚类分析算法假设距离矩阵为vector,a阶,矩阵中最大值为max,令矩阵上三角元素等于max聚类次数=a-1,以下步骤作a-1次循环:(1)求改变后矩阵的阶数,计作c(2)求矩阵最小值,返回最小值所在行e和列f以及值的大小g(3)for l=1:c,为vector(c+1,l)赋值,产生新类(4)令第c+1列元素,第e行和第f行所有元素为max,第e列和第f列所有元素为max5.1源程序%std1.m,用极差标准化法标准化矩阵function std=std1(vector)max=max(vector); %对列求最大值min=min(vector);[a,b]=size(vector); %矩阵大小,a为行数,b为列数for i=1:afor j=1:bstd(i,j)= (vector(i,j)-min(j))/(max(j)-min(j));endend%ds1.m,用绝对值法求距离function d=ds1(vector);[a,b]=size(vector);d=zeros(a);for i=1:afor j=1:afor k=1:bd(i,j)=d(i,j)+abs(vector(i,k)-vector(j,k));endendendfprintf('绝对值距离矩阵如下:\n');disp(d)%min1.m,求矩阵中最小值,并返回行列数及其值function [v1,v2,v3]=min1(vector);%v1为行数,v2为列数,v3为其值[v,v2]=min(min(vector'));[v,v1]=min(min(vector));v3=min(min(vector));%min2.m,比较两数大小,返回较小的值function v1=min(v2,v3);if v2>v3v1=v3;elsev1=v2;end%cluster.m,最短距离聚类法function result=cluster(vector);[a,b]=size(vector);max=max(max(vector));for i=1:afor j=i:bvector(i,j)=max;endend;for k=1:(b-1)[c,d]=size(vector);fprintf('第%g次聚类:\n',k);[e,f,g]=min1(vector);fprintf('最小值=%g,将第%g区和第%g区并为一类,记作G%g\n\n',g,e,f,c+1);for l=1:cif l<=min2(e,f)vector(c+1,l)=min2(vector(e,l),vector(f,l));elsevector(c+1,l)=min2(vector(l,e),vector(l,f));endend;vector(1:c+1,c+1)=max;vector(1:c+1,e)=max;vector(1:c+1,f)=max;vector(e,1:c+1)=max;vector(f,1:c+1)=max;end%print1,调用各子函数function print=print1(filename,a,b); %a为地区个数,b为指标数fid=fopen(filename,'r')vector=fscanf(fid,'%g',[a b]);fprintf('标准化结果如下:\n')v1=std1(vector)v2=ds1(v1);cluster(v2);%输出结果print1('fname',9,7)。

聚类分析程序

if(C<d)C=d;end

end;end

C=1/(1+C);

for(i=1:n)for(j=1:n)d=0;

if(cs==8)for(k=1:m)d=d+(X(i,k)-X(j,k))^2;end

elseif(cs==12)for(k=1:m)d=d+abs(X(i,k)-X(j,k));end%海明距离

else for(k=1:m)if(d<abs(X(i,k)-X(j,k)))d=abs(X(i,k)-X(j,k));end;end;end%切比雪夫距离

if(minM>d)minM=d;end

%X,数据矩阵

%cs=1,数量积法

%cs=2,夹角余弦法

%cs=3,相关系数法

%cs=4,指数相似系数法

%cs=5,最大最小法

%cs=6,算术平均最小法

%cs=7,几何平均最小法

%cs=8,一般欧式距离法

%cs=9,一般海明距离法

%cs=10,一般切比雪夫距离法

%cs=11,倒数欧式距离法

for(k=1:m)x=x+X(i,k)*X(j,k);end

if(maxM<x)maxM=x;end

end;end;end

if(maxM<0.000001)return;end

for(i=1:n)for(j=1:n)

if(i==j)R(i,j)=1;

else R(i,j)=0;

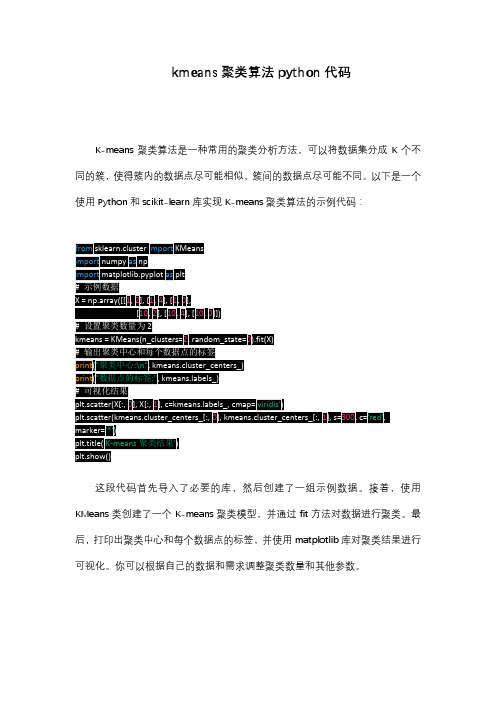

kmeans聚类算法python代码

kmeans聚类算法python代码

K-means聚类算法是一种常用的聚类分析方法,可以将数据集分成K个不同的簇,使得簇内的数据点尽可能相似,簇间的数据点尽可能不同。

以下是一个使用Python和scikit-learn库实现K-means聚类算法的示例代码:

这段代码首先导入了必要的库,然后创建了一组示例数据。

接着,使用KMeans类创建了一个K-means聚类模型,并通过fit方法对数据进行聚类。

最后,打印出聚类中心和每个数据点的标签,并使用matplotlib库对聚类结果进行可视化。

你可以根据自己的数据和需求调整聚类数量和其他参数。

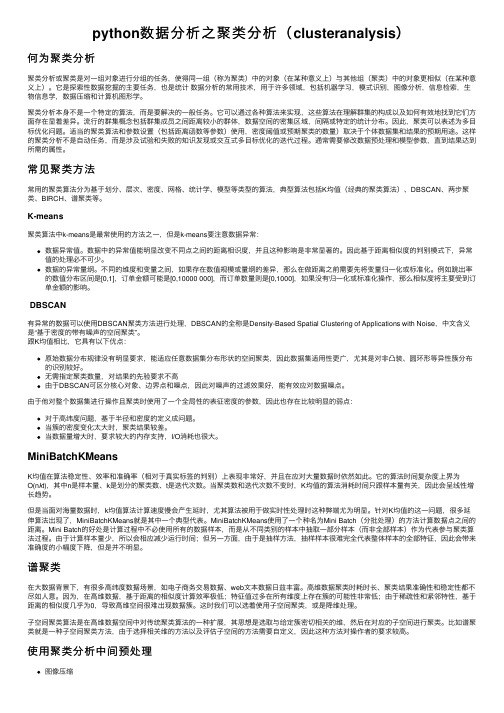

python数据分析之聚类分析(clusteranalysis)

python数据分析之聚类分析(clusteranalysis)何为聚类分析聚类分析或聚类是对⼀组对象进⾏分组的任务,使得同⼀组(称为聚类)中的对象(在某种意义上)与其他组(聚类)中的对象更相似(在某种意义上)。

它是探索性数据挖掘的主要任务,也是统计数据分析的常⽤技术,⽤于许多领域,包括机器学习,模式识别,图像分析,信息检索,⽣物信息学,数据压缩和计算机图形学。

聚类分析本⾝不是⼀个特定的算法,⽽是要解决的⼀般任务。

它可以通过各种算法来实现,这些算法在理解群集的构成以及如何有效地找到它们⽅⾯存在显着差异。

流⾏的群集概念包括群集成员之间距离较⼩的群体,数据空间的密集区域,间隔或特定的统计分布。

因此,聚类可以表述为多⽬标优化问题。

适当的聚类算法和参数设置(包括距离函数等参数)使⽤,密度阈值或预期聚类的数量)取决于个体数据集和结果的预期⽤途。

这样的聚类分析不是⾃动任务,⽽是涉及试验和失败的知识发现或交互式多⽬标优化的迭代过程。

通常需要修改数据预处理和模型参数,直到结果达到所需的属性。

常见聚类⽅法常⽤的聚类算法分为基于划分、层次、密度、⽹格、统计学、模型等类型的算法,典型算法包括K均值(经典的聚类算法)、DBSCAN、两步聚类、BIRCH、谱聚类等。

K-means聚类算法中k-means是最常使⽤的⽅法之⼀,但是k-means要注意数据异常:数据异常值。

数据中的异常值能明显改变不同点之间的距离相识度,并且这种影响是⾮常显著的。

因此基于距离相似度的判别模式下,异常值的处理必不可少。

数据的异常量纲。

不同的维度和变量之间,如果存在数值规模或量纲的差异,那么在做距离之前需要先将变量归⼀化或标准化。

例如跳出率的数值分布区间是[0,1],订单⾦额可能是[0,10000 000],⽽订单数量则是[0,1000],如果没有归⼀化或标准化操作,那么相似度将主要受到订单⾦额的影响。

DBSCAN有异常的数据可以使⽤DBSCAN聚类⽅法进⾏处理,DBSCAN的全称是Density-Based Spatial Clustering of Applications with Noise,中⽂含义是“基于密度的带有噪声的空间聚类”。

聚类分析代码-matlab程序-可运行

clust = find(cidx3 == i);

plot(X(clust,1),X(clust,2),ptsymb{i},'MarkerSize',3,'MarkerFace',MarkFace{i},'MarkerEdgeColor','black');

plot(cmeans3(i,1),cmeans3(i,2),ptsymb{i},'MarkerSize',10,'MarkerFace',MarkFace{i});

[~,order] = sort(P(:,1));

plot(1:size(X,1),P(order,1),'r-',1:size(X,1),P(order,2),'b-',1:size(X,1),P(order,3),'y-');

legend({'Cluster 1 Score' 'Cluster 2 Score' 'Cluster 3 Score'},'location','NW');

cluster3 = (cidx3 == 2);

% 通过观察,K均值方法的第二类是gm的第三类

cluster2 = (cidx3 == 3);

% 计算分类概率

P = posterior(gm,X);

P8 = figure;clf

plot3(X(cluster1,1),X(cluster1,2),P(cluster1,1),'r.')

end

hold off

聚类的运算流程代码

聚类的运算流程代码下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor. I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!```pythonimport numpy as npfrom sklearn.cluster import KMeans# 数据准备data = np.array([[1, 2], [1, 4], [1, 0], [4, 2], [4, 4], [4, 0]]) # 聚类数量k = 2# 聚类算法kmeans = KMeans(n_clusters=k)# 拟合数据kmeans.fit(data)# 获取聚类中心centroids = kmeans.cluster_centers_# 获取每个数据点的聚类标签labels = bels_# 打印聚类中心print("聚类中心:")for centroid in centroids:print(centroid)# 打印每个数据点的聚类标签print("数据点聚类标签:")for label in labels:print(label)```上述代码实现了一个简单的聚类运算流程,具体步骤如下:1. 数据准备:我们需要准备要进行聚类的数据。

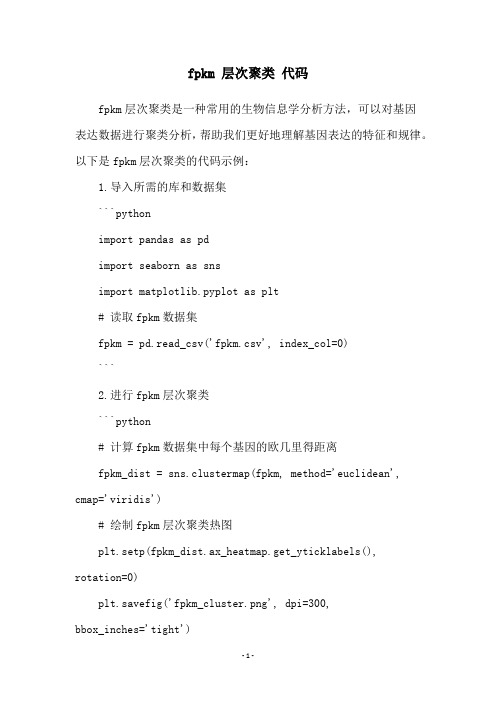

fpkm 层次聚类 代码

fpkm 层次聚类代码

fpkm层次聚类是一种常用的生物信息学分析方法,可以对基因

表达数据进行聚类分析,帮助我们更好地理解基因表达的特征和规律。

以下是fpkm层次聚类的代码示例:

1.导入所需的库和数据集

```python

import pandas as pd

import seaborn as sns

import matplotlib.pyplot as plt

# 读取fpkm数据集

fpkm = pd.read_csv('fpkm.csv', index_col=0)

```

2.进行fpkm层次聚类

```python

# 计算fpkm数据集中每个基因的欧几里得距离

fpkm_dist = sns.clustermap(fpkm, method='euclidean', cmap='viridis')

# 绘制fpkm层次聚类热图

plt.setp(fpkm_dist.ax_heatmap.get_yticklabels(),

rotation=0)

plt.savefig('fpkm_cluster.png', dpi=300,

bbox_inches='tight')

```

3.结果解读

通过观察fpkm层次聚类热图,我们可以看到不同基因的表达模式被分为不同的聚类簇,同时不同样本之间的基因表达模式也被聚类在一起。

这些聚类结果可以帮助我们更全面地了解基因表达的特征和规律,为后续的生物信息学分析提供有力支持。

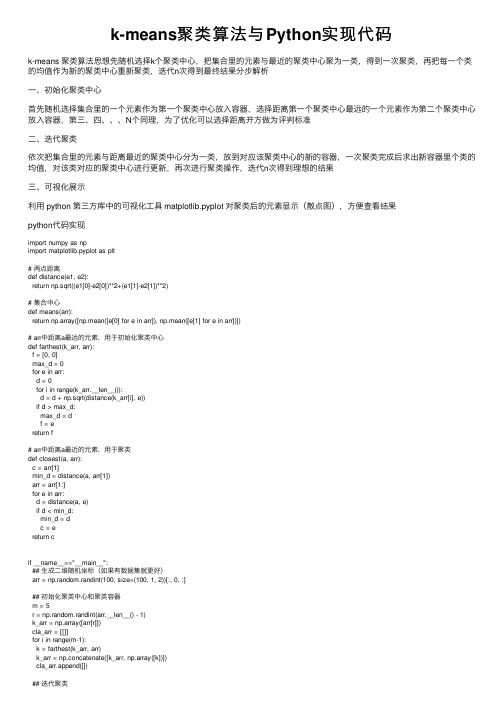

k-means聚类算法与Python实现代码

k-means聚类算法与Python实现代码k-means 聚类算法思想先随机选择k个聚类中⼼,把集合⾥的元素与最近的聚类中⼼聚为⼀类,得到⼀次聚类,再把每⼀个类的均值作为新的聚类中⼼重新聚类,迭代n次得到最终结果分步解析⼀、初始化聚类中⼼⾸先随机选择集合⾥的⼀个元素作为第⼀个聚类中⼼放⼊容器,选择距离第⼀个聚类中⼼最远的⼀个元素作为第⼆个聚类中⼼放⼊容器,第三、四、、、N个同理,为了优化可以选择距离开⽅做为评判标准⼆、迭代聚类依次把集合⾥的元素与距离最近的聚类中⼼分为⼀类,放到对应该聚类中⼼的新的容器,⼀次聚类完成后求出新容器⾥个类的均值,对该类对应的聚类中⼼进⾏更新,再次进⾏聚类操作,迭代n次得到理想的结果三、可视化展⽰利⽤ python 第三⽅库中的可视化⼯具 matplotlib.pyplot 对聚类后的元素显⽰(散点图),⽅便查看结果python代码实现import numpy as npimport matplotlib.pyplot as plt# 两点距离def distance(e1, e2):return np.sqrt((e1[0]-e2[0])**2+(e1[1]-e2[1])**2)# 集合中⼼def means(arr):return np.array([np.mean([e[0] for e in arr]), np.mean([e[1] for e in arr])])# arr中距离a最远的元素,⽤于初始化聚类中⼼def farthest(k_arr, arr):f = [0, 0]max_d = 0for e in arr:d = 0for i in range(k_arr.__len__()):d = d + np.sqrt(distance(k_arr[i], e))if d > max_d:max_d = df = ereturn f# arr中距离a最近的元素,⽤于聚类def closest(a, arr):c = arr[1]min_d = distance(a, arr[1])arr = arr[1:]for e in arr:d = distance(a, e)if d < min_d:min_d = dc = ereturn cif __name__=="__main__":## ⽣成⼆维随机坐标(如果有数据集就更好)arr = np.random.randint(100, size=(100, 1, 2))[:, 0, :]## 初始化聚类中⼼和聚类容器m = 5r = np.random.randint(arr.__len__() - 1)k_arr = np.array([arr[r]])cla_arr = [[]]for i in range(m-1):k = farthest(k_arr, arr)k_arr = np.concatenate([k_arr, np.array([k])])cla_arr.append([])## 迭代聚类n = 20cla_temp = cla_arrfor i in range(n): # 迭代n次for e in arr: # 把集合⾥每⼀个元素聚到最近的类ki = 0 # 假定距离第⼀个中⼼最近min_d = distance(e, k_arr[ki])for j in range(1, k_arr.__len__()):if distance(e, k_arr[j]) < min_d: # 找到更近的聚类中⼼min_d = distance(e, k_arr[j])ki = jcla_temp[ki].append(e)# 迭代更新聚类中⼼for k in range(k_arr.__len__()):if n - 1 == i:breakk_arr[k] = means(cla_temp[k])cla_temp[k] = []## 可视化展⽰col = ['HotPink', 'Aqua', 'Chartreuse', 'yellow', 'LightSalmon']for i in range(m):plt.scatter(k_arr[i][0], k_arr[i][1], linewidth=10, color=col[i])plt.scatter([e[0] for e in cla_temp[i]], [e[1] for e in cla_temp[i]], color=col[i])plt.show()结果展⽰总结到此这篇关于k-means 聚类算法与Python实现代码的⽂章就介绍到这了,更多相关k-means 聚类算法python内容请搜索以前的⽂章或继续浏览下⾯的相关⽂章希望⼤家以后多多⽀持!。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

聚类分析

聚类分析是根据样本代表性指标在性质上的亲疏程度进行分类。

因此,我们可以把模糊聚类分析的步骤分解如下:

2.1确定样本统计指标与数据标准化

对样本进行分类的效果如何,关键在于要把统计指标选择合理。

也就是统计指标应该有明确的实际意义,有较强的分辨力和代表性,即要有一定的普遍意义。

2.1.1标准差标准化(z-score)

S

X X

X

i

i

-=

*

标准差标准化后的数据均值为0,标准差为1。

2.2点(观察值,case )到点的距离 设有两个p 维观察值(点):

),...,,(,),...,,(2

121'='=jp

j j j ip i i i X

X

X x X X X x

在聚类分析中,它们之间的距离有: 欧氏距离(Euclidian Distance)

∑

=-=

p k jk

ik ij X

X d 1

2

)

(

2.3.相似系数

2.3.1皮尔逊相似系数(Pearson)

∑

∑

∑===----=

p k j

jk

p k i ik

p k j

jk

i ik

ij X X

X X

X X

X X

d 1

2

1

2

1

)

()

()

)((

其中的:

∑

∑

===

=

p k jk

j

p k ik

i

X

p

X

X

p

X

1

1

1,

1

2.4.类(group)与类之间的距离

类指观察值的集合。

两个类之间的距离,是用这两个类的特殊点之间的距离来定义。

设有两个类:G a 和G b ,它们之间的距离用D (a , b )表示。

则有: 2.4.1最短法

},min{),(b j a i ij G x G x d b a D ∈∈=

2.5进行聚类

在确定了样本之间的距离后,就可以对样本进行归类,归类的方法很多,其中用得最广

泛的是系统聚类法。

它首先把n 个样本每个自成一类,然后每次将具有最小距离的两类合并成一类,合并后又再重新计算类与类之间的距离,直至所有样品归为一类为止。

例一:clc,clear

a=[1,0;1,1;3,2;4,3;2,5];

y=pdist(a,'cityblock');yc=squareform(y)

z=linkage(y)

[h,t]=dendrogram(z)

例二:

X1-上体长,x2-手臂长,…..x14-臀围

a=textread('ch.txt')

1

0.366 1

0.242 0.233 1

0.28 0.194 0.59 1

0.36 0.324 0.476 0.435 1

0.282 0.262 0.483 0.47 0.452 1

0.245 0.265 0.54 0.478 0.535 0.663 1

0.448 0.345 0.452 0.404 0.431 0.322 0.266 1

0.486 0.367 0.365 0.357 0.429 0.283 0.287 0.82 1

0.648 0.662 0.216 0.032 0.429 0.283 0.263 0.527 0.547 1

0.689 0.671 0.243 0.313 0.43 0.302 0.294 0.52 0.558 0.957 1

0.486 0.636 0.174 0.243 0.375 0.296 0.255 0.403 0.417 0.857 0.852 1

0.133 0.153 0.732 0.477 0.339 0.392 0.446 0.266 0.241 0.054 0.099 0.055 1

0.376 0.252 0.676 0.581 0.441 0.447 0.44 0.424 0.372 0.363 0.376 0.321 0.627 1 for i=1:14

a(i,i)=0;

end

b=a(:);b=nonzeros(b);b=b';b=1-b;

z=linkage(b,'complete');

y=cluster(z,2)

dendrogram(z)

ind1=find(y==2);ind1=ind1'

ind2=find(y==1);ind2=ind2'

可以看出,人体的变量大体可以分为两类:一类反映人高、矮的变量,如上体长,手臂长,前腰节高,后腰节高,总体长,身高,下体长;另一类是反映人体胖瘦的变量,如胸围,颈围,总肩围,总胸宽,后背宽,腰围,臀围。

例三:

1.0000 0.9434 0.9528 0.9591 0.9746 0.9798 0.4065 0.0663 0.8680 0.6609 0.9434 1.0000 0.9946 0.9946 0.9743 0.9702 0.6136 0.3500 0.8039 0.5998 0.9528 0.9946 1.0000 0.9987 0.9831 0.9807 0.6261 0.3445 0.8231 0.6171 0.9591 0.9946 0.9987 1.0000 0.9878 0.9856 0.6096 0.3256 0.8276 0.6124 0.9746 0.9743 0.9831 0.9878 1.0000 0.9986 0.5599 0.2411 0.8590 0.6174 0.9798 0.9702 0.9807 0.9856 0.9986 1.0000 0.5500 0.2222 0.8691 0.6164 0.4065 0.6136 0.6261 0.6096 0.5599 0.5500 1.0000 0.7789 0.3655 0.1510 0.0663 0.3500 0.3445 0.3256 0.2411 0.2222 0.7789 1.0000 0.1122 0.0482 0.8680 0.8039 0.8231 0.8276 0.8590 0.8691 0.3655 0.1122 1.0000 0.6833 0.6609 0.5998 0.6171 0.6124 0.6174 0.6164 0.1510 0.0482 0.6833 1.0000 load gj.txt %把原始数据保存在纯文本文件gj.txt 中

r=corrcoef(gj); %计算相关系数矩阵

d=tril(r); %取出相关系数矩阵的下三角元素

for i=1:10 %对角线元素化成零

d(i,i)=0;

end

d=d(:);

d=nonzeros(d); %取出非零元素

d=d';d=1-d;

z=linkage(d)

dendrogram(z)

3 4 2 5 6 1 910 7 8。