概率C的算法

数据计算公式

数据计算公式数据计算公式是指用于计算数据的数学公式或算法。

它们在各个领域的数据分析、科学研究和工程应用中起着重要的作用。

下面将介绍一些常见的数据计算公式及其应用。

1. 简单加减乘除公式:- 加法公式:C = A + B- 减法公式:C = A - B- 乘法公式:C = A * B- 除法公式:C = A / B这些公式用于对两个数进行加、减、乘、除运算。

在实际应用中,可以根据需要将其扩展到多个数的运算。

2. 百分比计算公式:- 百分比计算公式:C = (A / B) * 100这个公式用于计算A占B的百分比。

在市场调研、统计分析等领域中经常使用。

3. 平均值计算公式:- 算术平均值公式:C = (A1 + A2 + ... + An) / n- 加权平均值公式:C = (A1 * w1 + A2 * w2 + ... + An * wn) / (w1 + w2 + ... + wn)这些公式用于计算一组数据的平均值。

算术平均值适用于各个数据的权重相等的情况,而加权平均值适用于各个数据的权重不等的情况。

4. 标准差计算公式:- 总体标准差公式:C = sqrt(((A1 - 平均值)^2 + (A2 - 平均值)^2 + ... + (An - 平均值)^2) / n)- 样本标准差公式:C = sqrt(((A1 - 平均值)^2 + (A2 - 平均值)^2 + ... + (An - 平均值)^2) / (n - 1))这些公式用于计算一组数据的离散程度。

总体标准差适用于对整个数据集进行分析,而样本标准差适用于对部分数据进行分析。

5. 指数计算公式:- 简单指数公式:C = A * (1 + r)^n- 复合指数公式:C = A * e^(r * n)这些公式用于计算指数增长或衰减的情况。

简单指数公式适用于固定增长率的情况,而复合指数公式适用于连续变化的情况。

6. 概率计算公式:- 事件概率公式:P(A) = n(A) / n(S)- 条件概率公式:P(A|B) = P(A∩B) / P(B)这些公式用于计算事件的概率。

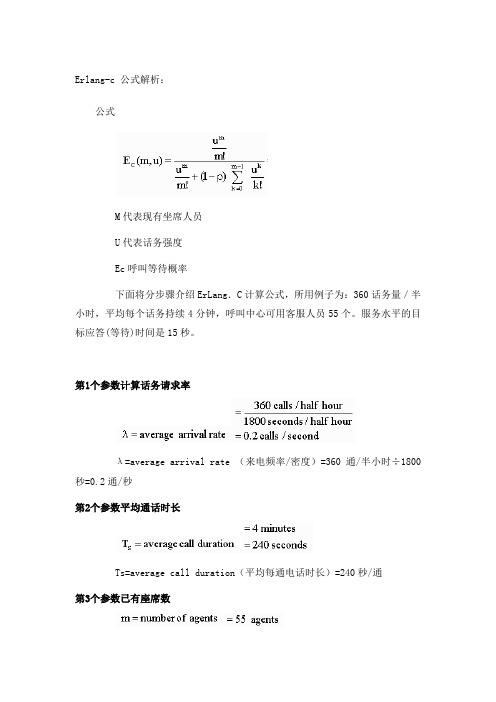

Erlang-C公式

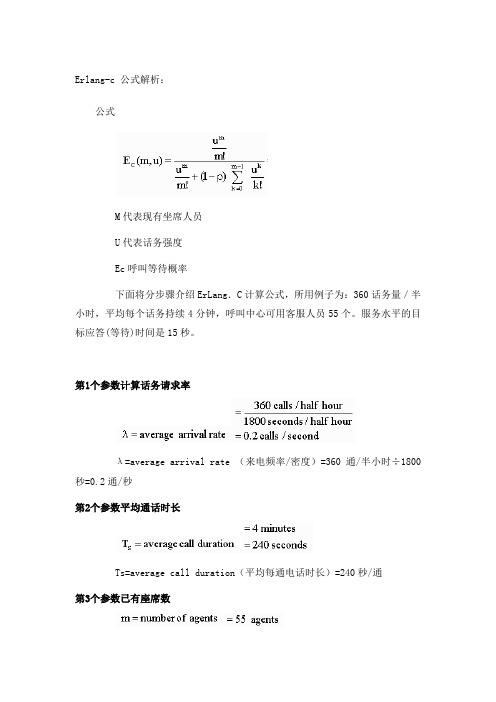

Erlang-c 公式解析:公式M代表现有坐席人员U代表话务强度Ec呼叫等待概率下面将分步骤介绍ErLang.C计算公式,所用例子为:360话务量/半小时,平均每个话务持续4分钟,呼叫中心可用客服人员55个。

服务水平的目标应答(等待)时间是15秒。

第1个参数计算话务请求率λ=average arrival rate (来电频率/密度)=360通/半小时÷1800秒=0.2通/秒第2个参数平均通话时长Ts=average call duration(平均每通电话时长)=240秒/通第3个参数已有座席数m=numbers of agents(坐席数)=55人第4个参数流量密度(话务强度)traffic intensify(话务强度)= λ×TS =0.2通/秒×240秒/通=48秒/秒为每秒需要处理48秒的工作量,即每秒需要48个人换另一种工作量算法可能大家更容易懂,即360通电话,每通240秒,那么处理这些电话共需 86400秒,而每个座席员每半小时有1800秒,在最理想化的状态下我们也需要360×240÷1800=48 人第5个参数计算代理的占用率代理占用率,也就是代理的使用率,用代理数目除以流量密度来计算。

代理占用率在0到1之间。

如果它超过了1,就说明当前代理超负荷了。

P= agent occupancy(占用率) = 48人÷55人 =87.3%接下来就开始代入Erlang C公式第6个参数计算可能等待的概率Ec(m,u)参数表示了一个话务不能马上被处理而必须等待的概率。

它在0到l之间,也可以乘以100%后用百分比来表示。

m!即m的阶乘,这里即1*2*3*4*.....*54*55 Excel中可用=fact(55) 计算这个呐就是加总从K=0开始一直算到k=m-1为止,这里即算到k=54为止因此得出最终结果0.239那么该公式Ec(m,u)在Excel中可表达为=poisson(m,u,false)/(poisson(m,u,false)+(1-P)*poisson(m-1,u,true) )prob(call has to wait)呼叫等待的概率=23.9%第7个参数计算平均应答速度求出了Ec(m,u)值以后,可以容易地计算出一个话务的平均等待时长,也就是所指的“平均应答速度”,即ASA。

朴素贝叶斯训练

朴素贝叶斯训练介绍朴素贝叶斯是一种常用的机器学习算法,它基于贝叶斯定理和特征之间的条件独立性假设。

通过使用训练数据,朴素贝叶斯算法可以建立一个概率模型,用于分类、预测和文本分析等任务。

贝叶斯定理的原理贝叶斯定理是基于条件概率的推导方法,它表示了在已知先验概率的情况下,如何通过新的证据来更新概率。

贝叶斯定理的公式如下所示:P(A|B) = (P(B|A) * P(A)) / P(B)其中,P(A|B)是在给定B发生的情况下A发生的概率,P(B|A)是在给定A发生的情况下B发生的概率,P(A)和P(B)分别是A和B发生的先验概率。

朴素贝叶斯算法的原理朴素贝叶斯算法基于条件独立性假设,即假设所有特征之间都是独立的。

根据贝叶斯定理,我们可以通过计算每个特征在给定类别下的条件概率,然后根据特征之间的独立性将它们相乘,得到给定类别的后验概率。

具体来说,朴素贝叶斯算法的步骤如下:1.计算每个类别的先验概率,即P(C),其中C表示类别。

2.对于每个特征,计算在给定类别下的条件概率P(F|C),其中F表示特征。

3.根据特征之间的独立性假设,将每个特征的条件概率相乘,得到在给定类别下的后验概率P(C|F)。

4.对于新的样本,计算它属于每个类别的后验概率,并选择具有最高后验概率的类别作为分类结果。

朴素贝叶斯训练过程朴素贝叶斯的训练过程包括以下几个步骤:1.收集训练数据:首先,我们需要收集标注了类别的训练数据。

训练数据应包含各种可能的特征值和相应的类别标签。

2.数据预处理:对于离散型特征,我们可以直接计算每个特征值在给定类别下的条件概率。

对于连续型特征,我们可以将其离散化或使用概率密度函数来估计概率。

3.计算先验概率:根据训练数据,我们可以计算每个类别的先验概率。

先验概率可以通过统计每个类别的样本数量来估计。

4.计算条件概率:对于每个特征,我们需要计算在给定类别下的条件概率。

对于离散型特征,条件概率可以通过计算在给定类别下特征值出现的频率来估计。

遗传算法-3

适应度函数的线性变换法

f’=α*f+β 系数的确定满足以下条件: ① f’avg= favg ② f’max= cmult f’avg cmult =1.0~2.0

适应度函数的幂函数变换法

f’= f k

k与所求优化相关

1

0.9

0.8

0.7

k

0.6

0.5

0.4

0.3

0.2

0.1

0

0.1Βιβλιοθήκη 0.20.3的概率Pi为:

3 3.0

9.00

0.26

4 1.2

1.44

0.04

Pi

fi

M

fi

i1

5 2.1

4.41

0.13

6 0.8

0.64

0.02

7 2.5

6.25

0.18

8 1.3

1.69

0.05

9 0.9

0.81

0.02

10 1.8

3.24

0.09

个体选择概率的常用分配方法 ✓ 基于排序的适应度分配(rank-based fitness

➢健全性(Soundness):GA空间中的染色体能对 应所有问题空间中的解。任何一个基因型都对应 于一个可能解。

➢非冗余性(Non-redundancy):染色体和后选 解一一对应。问题空间和表达空间一一对应。

3、编码技术 遗传算法用到的一般编码技术有: ➢一维染色体编码 ➢多参数映射编码 ➢可变染色体长度编码 ➢二维染色体编码 ➢树结构编码

染色体长度L

影响算法的计算量和交配变异操作的效果。 L的设置跟优化问题密切相关,一般由问题定义的解的 形式和选择的编码方法决定。 对于二进制编码方法,染色体的长度L根据解的取值范 围和规定精度要求选择大小。 对于浮点数编码方法,染色体的长度L 跟问题定义的解 的维数D相同。 除了染色体长度一定的编码方法,Goldberg等人还提出 了一种变长度染色体遗传算法Messy GA,其染色体的长 度并不是固定的。

概率分布函数的数值求解算法

概率分布函数的数值求解算法在概率统计学中,概率分布函数(Probability Distribution Function,简称PDF)是用来描述随机变量取各种不同值的概率的函数。

对于连续型随机变量,PDF通常由概率密度函数(Probability Density Function,简称PDF)来表示;而对于离散型随机变量,则由概率质量函数(Probability Mass Function,简称PMF)来表示。

概率分布函数的求解在实际应用中具有重要的意义,本文将介绍一些常见的数值求解算法。

一、直接计算法直接计算法是最简单直接的方法,适用于一些简单的概率分布函数。

其基本思想是根据随机变量的定义和已知的分布参数,通过数学计算得到每个特定取值对应的概率。

例如,对于离散型随机变量的概率质量函数,我们可以直接计算每个可能取值的概率。

对于连续型随机变量的概率密度函数,我们可以通过数学积分的方法计算出特定取值的概率。

二、逆变换法逆变换法是一种常用的随机数生成算法。

其基本思想是通过随机数生成器生成服从均匀分布的随机数,然后通过概率分布函数的逆函数来将均匀分布的随机数转换为目标分布的随机数。

逆变换法的主要步骤如下:1. 生成一个服从均匀分布的随机数U,其取值范围为[0, 1);2. 使用概率分布函数的逆函数F^(-1)(x),将随机数U转换为目标分布的随机数X。

逆变换法的优点是简单易实现,适用于大多数常见的概率分布函数。

然而,对于一些复杂的概率分布函数,其逆函数可能难以求解,从而导致逆变换法的应用受限。

三、接受-拒绝法接受-拒绝法是一种常用的概率分布函数数值求解算法。

其基本思想是通过生成服从辅助分布的随机数来模拟目标分布的随机数,并使用接受-拒绝准则来筛选出符合目标分布的随机数。

接受-拒绝法的主要步骤如下:1. 生成一个服从辅助分布的随机数Y,并计算辅助分布和目标分布在该点上的函数值,即f(Y)和g(Y);2. 生成一个服从均匀分布的随机数U,其取值范围为[0, 1);3. 如果U * M <= f(Y),则接受Y作为目标分布的随机数;4. 如果U * M > f(Y),则拒绝Y,并返回第一步。

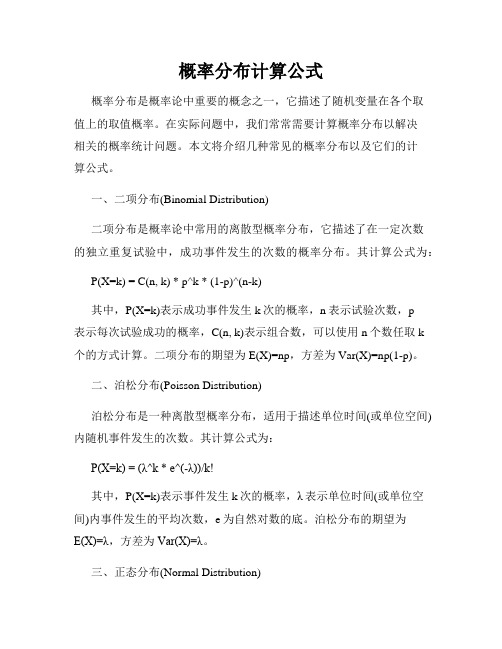

概率分布计算公式

概率分布计算公式概率分布是概率论中重要的概念之一,它描述了随机变量在各个取值上的取值概率。

在实际问题中,我们常常需要计算概率分布以解决相关的概率统计问题。

本文将介绍几种常见的概率分布以及它们的计算公式。

一、二项分布(Binomial Distribution)二项分布是概率论中常用的离散型概率分布,它描述了在一定次数的独立重复试验中,成功事件发生的次数的概率分布。

其计算公式为:P(X=k) = C(n, k) * p^k * (1-p)^(n-k)其中,P(X=k)表示成功事件发生k次的概率,n表示试验次数,p表示每次试验成功的概率,C(n, k)表示组合数,可以使用n个数任取k个的方式计算。

二项分布的期望为E(X)=np,方差为Var(X)=np(1-p)。

二、泊松分布(Poisson Distribution)泊松分布是一种离散型概率分布,适用于描述单位时间(或单位空间)内随机事件发生的次数。

其计算公式为:P(X=k) = (λ^k * e^(-λ))/k!其中,P(X=k)表示事件发生k次的概率,λ表示单位时间(或单位空间)内事件发生的平均次数,e为自然对数的底。

泊松分布的期望为E(X)=λ,方差为Var(X)=λ。

三、正态分布(Normal Distribution)正态分布是概率论中最重要的连续型概率分布,也称为高斯分布。

它的形状呈钟型曲线,对称于均值。

正态分布在实际问题中得到广泛应用。

其概率密度函数的计算公式为:f(x) = (1 / (σ * √(2π))) * e^((-1/2)*((x-μ)/σ)^2)其中,f(x)表示随机变量X的概率密度函数,μ为均值,σ为标准差,π为数学常数3.14159。

正态分布的期望为E(X)=μ,方差为Var(X)=σ^2。

四、指数分布(Exponential Distribution)指数分布是一种连续型概率分布,其概率密度函数具有常数倍衰减的特点。

sklearn logisticregression c的范围-概述说明以及解释

sklearn logisticregression c的范围-概述说明以及解释1.引言1.1 概述随着机器学习和数据科学的迅猛发展,Logistic Regression成为了构建分类模型的一种重要算法之一。

而在应用中,我们经常会用到sklearn 库中的LogisticRegression模块,该模块提供了灵活且高效的实现,能够满足各种分类问题的需求。

本文将探讨sklearn库中Logistic Regression模块中C的范围,C 是Logistic Regression算法中的一个重要参数。

理解和选择合适的C值对于模型的性能和稳定性具有重要意义。

C值的选择不当可能会导致过拟合或者欠拟合的问题。

首先,我们将简要介绍sklearn库及其在机器学习领域的应用。

然后,我们将详细阐述Logistic Regression算法的原理,包括其基本假设、优化目标以及参数的学习过程。

接下来,我们将重点关注Logistic Regression模型中C的范围选择及其对模型性能的影响。

最后,我们将总结Logistic Regression在C范围内的应用,并给出一些适用于不同场景的实践建议。

通过本文的阅读,读者将能够全面了解Logistic Regression模型中C 的范围选择问题,并在实际应用中能够根据需求合理选择C的取值。

同时,读者也能更深入地理解Logistic Regression算法的原理及其在机器学习领域中的重要性。

1.2文章结构1.2 文章结构文章主要分为以下几个部分:引言、正文和结论。

- 引言部分将对整篇文章进行概述,介绍sklearn库中Logistic Regression算法的应用领域以及文章的目的。

- 正文部分将分为两个子部分。

首先,我们将简要介绍sklearn库,包括其功能和特点,以便读者对sklearn库有一个初步了解。

其次,我们将详细讲解Logistic Regression算法的原理和工作流程,包括基本概念、损失函数、参数估计等。

概率基础计算公式

概率基础计算公式概率基础计算公式1.加法公式:P ( A + B ) = P ( A ) + P ( B ) − P ( A B ) P(A+B)=P(A)+P(B)-P(AB) P(A+B)=P(A)+P(B)−P(AB)2.求逆公式:P ( A ˉ ) = 1 − P ( A ) P(\bar{A})=1-P(A) P(Aˉ)=1−P(A)3.求差公式:P ( A − B ) = P ( A ) − P ( A B ) P(A-B)=P(A)-P(AB) P(A−B)=P(A)−P(AB)4.乘法公式:P ( A B ) = P ( A ) ⋅P ( A ∣B ) = P ( B ) ⋅P ( B ∣A ) P(AB)=P(A)\cdot P(A|B)=P(B)\cdot P(B|A) P(AB)=P(A)⋅P(A∣B)=P(B)⋅P(B∣A)5.全概率公式:设 A 1 , A 2 , . . . , A n A_1,A_2,...,A_n A1,A2,...,An两两互不相容,且所有的 A i A_i Ai并起来为Ω Ω Ω,则称 A 1 , A 2 , . . . , A n A_1,A_2,...,A_n A1,A2,...,An构成一个完备事件组,若P ( A i ) > 0 , i = 1 , 2 , . . . , n , P(A_i)>0,i=1,2,...,n, P(Ai )>0,i=1,2,...,n,则有如下全概率公式:P ( B ) = ∑ i = 1 n P ( A i ) ⋅ P ( B ∣ A i ) P(B)=\displaystyle \sum^{n}_{i=1}{P(A_i) \cdot P(B|A_i)} P(B)=i=1∑n P(Ai)⋅P(B∣Ai)6.贝叶斯公式(逆概率公式):设 A 1 , A 2 , . . . , A n A_1,A_2,...,A_n A1,A2,...,An构成一个完备事件组,且P ( A i ) > 0 , i = 1 , 2 , . . . , n , P(A_i)>0,i=1,2,...,n, P(Ai)>0,i=1,2,...,n,则当P ( B ) > 0 P(B)>0 P(B)>0时,有如下贝叶斯公式:P ( A k ∣ B ) = P ( A k ) ⋅ P ( B ∣ A k ) ∑ i = 1 n P ( A i ) ⋅ P ( B ∣ A i ) , k = 1 , 2 , . . . , n . P(A_k|B)=\displaystyle {\frac{P(A_k) \cdot P(B|A_k)}{\sum^{n}_{i=1}{P(A_i) \cdot P(B|A_i)}}},k=1,2,...,n. P(Ak∣B)=∑i=1n P(Ai)⋅P(B∣Ai)P(Ak)⋅P(B∣Ak),k=1,2,...,n.7.n重伯努利试验:(1)若独立试验序列每次试验的结果只有两个,即A 与A ˉ A与\bar{A} A与Aˉ,记 P ( A ) = p P(A)=p P(A)=p,则n次试验中事件A发生 k k k次的概率为:P n ( A = k ) = P n ( k ) = C n k p k ( 1 − p ) n − k , k = 0 , 1 , 2 , . . . , n . P_n(A=k)=P_n(k)=C_n^kp^k(1-p)^n-k,k=0,1,2,...,n. Pn(A=k)=Pn(k)=Cnkpk(1−p)n−k,k=0,1,2,...,n.(2)独立重复地进行伯努利试验,直到第 k k k次试验时A才首次发生的概率为:P k = ( 1 − p ) k − 1 p , k = 1 , 2 , . . . , n . P_k=(1-p)^{k-1}p,k=1,2,...,n. Pk=(1−p)k−1p,k=1,2,...,n.。

求概率的算法

求概率的算法

求概率的算法有很多种,一种常见的是基于概率分布的公式进行计算。

如正态分布的公式为

f(x)=(1/(2^(k/2)*Γ(k/2)))*(x^(k/2-1)*e^(-x/2)),其中k为自

由度参数;泊松分布的公式为f(x)=e^(-λx);指数分布的公式为

f(x)=λe^(-λx)。

这些公式都可以通过特定的参数(如均值和标准差)来描述。

另一种方法是基于采样的方法,即利用随机数生成器,对事件的不同状态进行多次抽样,从而求得其概率。

蒙特卡罗模拟就是这样一种技术,它是一种用于估计复杂系统中不同结果概率的方法。

还有一种基于概率论知识和条件概率的方法,可以用来求解复杂的概率问题。

例如,在马尔可夫链中,利用转移概率矩阵和初始状态概率分布,就可以求出任意状态的概率。

此外,哈希函数映射到数组的每一个不同位置的概率相等的情况下,可以利用特定的算法和程序进行计算。

例如,BIASED-RANDOM随机过程可以输出0与1的概率为1/2,而且插入元素后数组中任意某一位仍然为0和未被置1的概率,也可以通过相关算法来求解。

无论使用哪种方法,概率计算的核心都是建立模型,利用特定的公式或程序求解,最后得到所求事件的概率。

简述概率算法的分类并分析各类算法的特点

简述概率算法的分类并分析各类算法的特点概率算法是一类算法,它们通过计算概率值来帮助做出决策,常用于机器学习任务中。

概率算法可以分为两大类:贝叶斯算法和随机场算法。

首先,贝叶斯算法是一种基于概率图模型(probabilistic graphical models)的算法。

它可以使用先验知识和观察结果来推断出概率分布。

贝叶斯算法通常被用于机器学习任务中,主要用于分类,即根据一定的输入,预测出输出的分类结果。

贝叶斯算法的优点在于能够在做出决策的同时考虑先验知识,能够给出精确的类别预测,并在计算上有较低的复杂度。

其次,随机场算法(random field algorithms)是基于随机场模型(random field models)的一种概率算法。

它是一种模式识别算法,能够根据特征在多个帧之间建立连续运动行为的混合概率模型。

主要用于机器视觉任务,比如图像分割、边界检测等。

随机场算法的优点在于可以考虑训练数据中特征之间的相关性,可以得到更准确的结果,特别是当训练数据本身包含非线性特征时。

总之,概率算法是一类有助于机器学习的算法,它们可以分为贝叶斯算法和随机场算法。

贝叶斯算法是一种基于概率图模型的算法,能够使用先验知识和观察结果来推断出概率分布,而随机场算法是一种基于随机场模型的模式识别算法,能够考虑训练数据中特征之间的相关性,以提高做出决策的准确性。

- 1 -。

常用公式算法一览

常用公式算法一览这里有一些常见的数学公式和算法,涵盖了基础数学、代数、几何、概率统计等领域。

1. 基础数学乘法分配律:a × (b + c) = a × b + a × c除法分配律:(a + b) ÷ c = a ÷ c + b ÷ c乘法结合律:(a × b) × c = a × (b × c)除法结合律:(a ÷ b) ÷ c = a ÷ (b × c)2. 代数线性方程:ax + b = 0 的解为 x = -b/a(当a≠0)二次方程:ax^2 + bx + c = 0 的解为 x = [-b ± sqrt(b^2 - 4ac)] / (2a) (当b^2 - 4ac > 0)3. 几何勾股定理:直角三角形中,直角边的平方和等于斜边的平方,即 a^2 + b^2 = c^2圆的周长公式:C = 2πr圆的面积公式:A = πr^24. 概率统计期望值公式:E(X) = Σ(x_i P(X=x_i)),其中X是一随机变量,x_i是X的所有可能取值,P(X=x_i)是X取x_i的概率方差公式:D(X) = Σ((x_i - E(X))^2 P(X=x_i))正态分布:正态分布是一种常见的连续概率分布,其概率密度函数呈钟形。

正态分布的期望值μ和标准差σ决定了其形状。

5. 其他质数筛法(埃拉托斯特尼筛法):用于找出一定范围内的所有质数。

快速排序:一种高效的排序算法,其基本思想是分治法。

二分查找:在有序数组中查找某一特定元素的搜索算法。

搜索过程从数组的中间元素开始,如果中间元素正好是目标值,则搜索过程结束;如果目标值大于或小于中间元素,则在数组大于或小于中间元素的那一半中查找,而且同样从中间元素开始比较。

如果在某一步骤数组为空,则代表找不到。

概率学中C和A的怎么算

.. 概率学中C和A的怎么算

例如A(3,6) 就是把6 5 4 3 2 1写出来,其中前3个数的乘积就是了.计算结果是120

C(3,6)还是把6 5 4 3 2 1 写出来,用前3个数的乘积,除以后三个数的乘积.计算结果是20。

------------------

高中的概率C和A是什么意思?

C表示组合方法的数量。

比如:C(3,2),表示从3个物体中选出2个,总共的方法是3种,分别是甲乙、甲丙、乙丙(3个物体是不相同的情况下)。

A表示排列方法的数量。

比如:n个不同的物体,要取出m个(m<=n)进行排列,方法就是A(n,m)种。

也可以这样想,排列放第一个有n种选择,,第二个有n-1种选择,,第三个有n-2种选择,·,第m个有n+1-m种选择,所以总共的排列方法是n(n-1)(n-2)·(n+1-m),也等于A (n,m)。

注:在具体题目中,看题目需要排列还是组合,也就是单体是否需要顺序,需要就用A,不需要就用C。

;.。

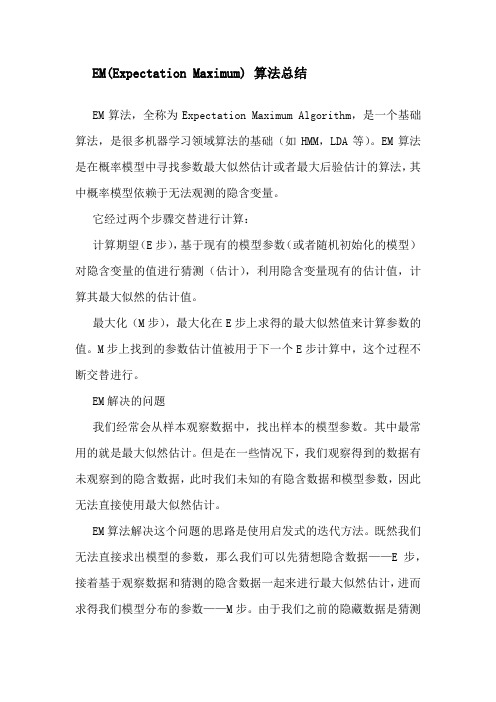

E x p e c t a t i o n - M a x i m u m ( E M 算 法 )

EM(Expectation Maximum) 算法总结EM算法,全称为Expectation Maximum Algorithm,是一个基础算法,是很多机器学习领域算法的基础(如HMM,LDA等)。

EM算法是在概率模型中寻找参数最大似然估计或者最大后验估计的算法,其中概率模型依赖于无法观测的隐含变量。

它经过两个步骤交替进行计算:计算期望(E步),基于现有的模型参数(或者随机初始化的模型)对隐含变量的值进行猜测(估计),利用隐含变量现有的估计值,计算其最大似然的估计值。

最大化(M步),最大化在E步上求得的最大似然值来计算参数的值。

M步上找到的参数估计值被用于下一个E步计算中,这个过程不断交替进行。

EM解决的问题我们经常会从样本观察数据中,找出样本的模型参数。

其中最常用的就是最大似然估计。

但是在一些情况下,我们观察得到的数据有未观察到的隐含数据,此时我们未知的有隐含数据和模型参数,因此无法直接使用最大似然估计。

EM算法解决这个问题的思路是使用启发式的迭代方法。

既然我们无法直接求出模型的参数,那么我们可以先猜想隐含数据——E步,接着基于观察数据和猜测的隐含数据一起来进行最大似然估计,进而求得我们模型分布的参数——M步。

由于我们之前的隐藏数据是猜测的,所以此时得到的模型参数并不一定是最好的结果。

因此,我们基于当前得到的模型参数来继续猜测隐含数据,然后进行最大似然估计求出模型分布参数。

以此类推,不断迭代,直到模型分布参数基本不变化或变化很小,算法收敛停止。

一个最直观的EM算法是K-Means聚类算法。

在K-Means聚类时,每个聚类的质心可以看成是隐含数据。

我们会假设KKK个初始化质心,即EM算法的E步;然后计算每个样本和KKK个质心之间的距离,并把样本聚类到最近的那个质心类中,即EM算法的M步。

重复这个E 步和M步质心不在变化为止。

EM算法的数学基础极大似然估计似然函数在数理统计学中,似然函数是一种关于统计模型中参数的函数,表示模型参数中的似然性(某种事件发生的可能性)。

概率中的a与c计算公式

概率中的a与c计算公式1概率中c和a的计算区别1、几率a指的是排列,是指从给定个数的元素中拿出指定个数的元素进行排序。

几率c指的是组成则就是指从给定个数的元素中单单拿出指定个数的元素,不考虑排序。

2、计算差别(1)排序计算从n个不一样元素中拿出m个不一样元素的全部不一样排序的个数称之为排序种数或称排列数,记为 (或者 ),在且仅当2个排序的元素完全相同,且元素的排列顺序也相同,则两个排列相同。

比如,abc和abd的元素不完全相同,它们是不一样的排序;又如abc和acb,虽然元素完全相同,但是元素的排列顺序不同,它们也是不同的排列。

(2)组成计算从n个不一样元素中每一次拿出m个不一样元素(0≤m≤n),无论其顺序合成一组,称之为从n个元素中不重复地抓取m个元素的一个组合。

全部这样的组成的总数称为组合数,这个组合数的计算公式为或是拓展材料:排序可分选排列与全排列两种,在从n个不一样元素拿出m个不同元素的排列种,当m就是,n个不一样元素全部取出的排列数,相当于正整数1到n的连乘积。

正整数一到n的连乘积,称为n的阶乘,用n!表明。

我们规定0!=1。

一个从n个元素中取m个元素的排序可以当作这n个元素构成的集合a的一个m元有序子集,因而a的m元有序子集的个数为。

c26=6x5/(2x1)a26=6x5a得话,上面的2相当于位数,随后从下面的5开始乘,2的话相当于乘两次,即5x4c得话,便是a的基础上再除以2!,即6x5/(2x1)拓展材料:概率论是探究随机现象数目规律的数学分支。

随机现象是相对于决定性现象而言的。

在一定条件下一定发生某一结果的情况称为决定性现象。

比如在标准大气压下,纯水加热到100℃时水必然会沸腾等。

随机现象是指在基本条件不变的情况下,每次实验或观察之前,都不确定会出现什么样的结果,表现出偶然性。

比如抛硬币,可能有正面也可能有反面。

随机现象的实现和观察称为随机实验。

随机实验的每一个可能的结果称为一个基本事件,一个或一组基本项目统称为随机事件,或简称为事件。

Erlang-C公式

Erlang-c 公式解析:公式M代表现有坐席人员U代表话务强度Ec呼叫等待概率下面将分步骤介绍ErLang.C计算公式,所用例子为:360话务量/半小时,平均每个话务持续4分钟,呼叫中心可用客服人员55个。

服务水平的目标应答(等待)时间是15秒。

第1个参数计算话务请求率λ=average arrival rate (来电频率/密度)=360通/半小时÷1800秒=0.2通/秒第2个参数平均通话时长Ts=average call duration(平均每通电话时长)=240秒/通第3个参数已有座席数m=numbers of agents(坐席数)=55人第4个参数流量密度(话务强度)traffic intensify(话务强度)= λ×TS =0.2通/秒×240秒/通=48秒/秒为每秒需要处理48秒的工作量,即每秒需要48个人换另一种工作量算法可能大家更容易懂,即360通电话,每通240秒,那么处理这些电话共需 86400秒,而每个座席员每半小时有1800秒,在最理想化的状态下我们也需要360×240÷1800=48 人第5个参数计算代理的占用率代理占用率,也就是代理的使用率,用代理数目除以流量密度来计算。

代理占用率在0到1之间。

如果它超过了1,就说明当前代理超负荷了。

P= agent occupancy(占用率) = 48人÷55人 =87.3%接下来就开始代入Erlang C公式第6个参数计算可能等待的概率Ec(m,u)参数表示了一个话务不能马上被处理而必须等待的概率。

它在0到l之间,也可以乘以100%后用百分比来表示。

m!即m的阶乘,这里即1*2*3*4*.....*54*55 Excel中可用=fact(55) 计算这个呐就是加总从K=0开始一直算到k=m-1为止,这里即算到k=54为止因此得出最终结果0.239那么该公式Ec(m,u)在Excel中可表达为=poisson(m,u,false)/(poisson(m,u,false)+(1-P)*poisson(m-1,u,true) )prob(call has to wait)呼叫等待的概率=23.9%第7个参数计算平均应答速度求出了Ec(m,u)值以后,可以容易地计算出一个话务的平均等待时长,也就是所指的“平均应答速度”,即ASA。

蒙特卡洛和大数定律c语言

蒙特卡洛和大数定律c语言蒙特卡洛方法和大数定律是概率论和统计学领域中常用的两个重要概念。

蒙特卡洛方法指的是一类基于随机数和概率统计理论的计算方法,大数定律是概率论中的一组定理,描述了随机事件频率的稳定性。

蒙特卡洛方法最早是在二战时由于美国原子能委员会的一个研究项目而出现的。

该项目要求研究人员计算中子在中等大小的物质体中的传播速度。

由于这个问题非常复杂,并且无法通过一般的方程求解,研究人员决定将中子传播的问题转换成随机游走的问题。

通过生成大量的随机数模拟中子在物质中的传播,最终得到了比较准确的结果。

这就是蒙特卡洛方法的最早应用之一。

蒙特卡洛方法的主要思想是通过生成大量的随机样本,通过统计这些样本的相关特性来估计或计算一个问题的解。

这种方法用于解决许多计算问题,例如计算积分、求解概率分布、优化问题等等。

其基本步骤如下:1. 定义问题:明确需要求解的问题,例如求解某个函数的积分、计算某个随机事件的概率等。

2. 建立模型:确定模型的数学表达式或者算法。

3. 生成随机数:使用随机数生成器生成大量的随机样本。

4. 根据模型进行计算:使用生成的随机样本代入模型进行计算,形成结果的一个估计。

5. 统计结果:统计多次计算结果的平均值、方差等统计特征。

6. 得出结论:根据统计结果得出问题的估计解或结论。

在C语言中,可以使用标准库中的随机数函数来生成随机数,例如rand()函数。

通过循环生成大量的随机样本,并使用这些样本代入模型进行计算,然后统计结果,最后得出解。

大数定律是概率论中的基本定律之一,描述了独立同分布随机变量的平均数收敛到其数学期望的情况。

大数定律包括弱大数定律和强大数定律两种形式。

其中,弱大数定律也被称为辛钦大数定律,指的是当样本容量趋于无穷大时,样本平均值依概率收敛到其数学期望值。

而强大数定律则指的是样本平均值以概率1收敛到其数学期望值。

在C语言中,可以通过模拟随机实验来验证大数定律。

利用蒙特卡洛方法生成大量的随机样本,并计算样本平均值。

marchc原理

marchc原理"马尔科夫过程"(Markov Process,也叫马尔可夫链)最初是由俄国数学家安德烈·马尔科夫(Andrey Markov)在1906年提出的一种概率模型。

直观地说,它用来描述随机过程中某个状态的变化规律,具体来说,就是某一时刻的状态只与它的上一个状态有关。

马尔科夫过程的核心是状态和状态转移概率。

我们可以用一个简单的例子来说明:假设某人要从A地到B地,他有三种选择:步行、骑自行车或者开车。

每种选择都有它的概率,而这个概率又受到很多影响因素,比如天气,交通状况等等。

我们可以将这个过程抽象成一个马尔科夫过程。

在这个例子中,人的状态就是他所在的位置,即可以在A地、B地、还是在路上。

每个状态都有一个概率来表示这个状态的出现频率,此外,状态之间还有相应的转移概率,即人从一个状态到另一个状态的概率。

比如,假设这个人开始在A地,步行和骑自行车的概率都是0.3,而开车的概率是0.4。

当他选择步行前往B地时,步行的概率为1,即100%。

但在路上,他可能会被大雨浇湿,或者遇到了交通堵塞,这又会影响到下一步的选择,比如他可能会转而选择骑自行车或开车。

马尔科夫过程的核心就在于这些概率的推导和计算,需要针对具体的场景进行建模,而这个过程又叫做“马尔科夫链的建模”。

马尔科夫链的建模可以应用于很多实际领域中,比如自然语言处理、机器学习、金融风险模型等等。

其中最为著名的例子就是Google公司的PageRank算法,这个算法就是基于马尔科夫链的思想实现的,用来衡量网页的重要性。

通过计算网页之间的链接关系和点击率等信息,可以建立网页之间的转移概率矩阵,然后通过迭代计算,得到每个网页的PageRank值,从而实现搜索引擎排名的计算。

总之,马尔科夫过程是一种非常有用的概率模型,可以用来描述许多随机过程中的状态变化规律,具有广泛的应用前景。