matlab的RBF-BP神经网络讲义

RBF神经网络:原理详解和MATLAB实现

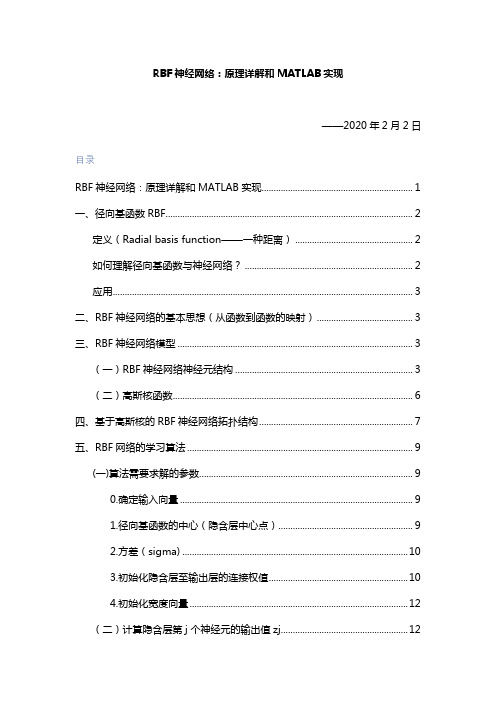

RBF神经⽹络:原理详解和MATLAB实现RBF神经⽹络:原理详解和MATLAB实现——2020年2⽉2⽇⽬录RBF神经⽹络:原理详解和MATLAB实现 (1)⼀、径向基函数RBF (2)定义(Radial basis function——⼀种距离) (2)如何理解径向基函数与神经⽹络? (2)应⽤ (3)⼆、RBF神经⽹络的基本思想(从函数到函数的映射) (3)三、RBF神经⽹络模型 (3)(⼀)RBF神经⽹络神经元结构 (3)(⼆)⾼斯核函数 (6)四、基于⾼斯核的RBF神经⽹络拓扑结构 (7)五、RBF⽹络的学习算法 (9)(⼀)算法需要求解的参数 (9)0.确定输⼊向量 (9)1.径向基函数的中⼼(隐含层中⼼点) (9)2.⽅差(sigma) (10)3.初始化隐含层⾄输出层的连接权值 (10)4.初始化宽度向量 (12)(⼆)计算隐含层第j 个神经元的输出值zj (12)(三)计算输出层神经元的输出 (13)(四)权重参数的迭代计算 (13)六、RBF神经⽹络算法的MATLAB实现 (14)七、RBF神经⽹络学习算法的范例 (15)(⼀)简例 (15)(⼆)预测汽油⾟烷值 (15)⼋、参考资料 (19)⼀、径向基函数RBF定义(Radial basis function——⼀种距离)径向基函数是⼀个取值仅仅依赖于离原点距离的实值函数,也就是Φ(x)=Φ(‖x‖),或者还可以是到任意⼀点c的距离,c点称为中⼼点,也就是Φ(x,c)=Φ(‖x-c‖)。

任意⼀个满⾜Φ(x)=Φ(‖x‖)特性的函数Φ都叫做径向基函数。

标准的⼀般使⽤欧⽒距离(也叫做欧式径向基函数),尽管其他距离函数也是可以的。

在神经⽹络结构中,可以作为全连接层和ReLU层的主要函数。

⼀些径向函数代表性的⽤到近似给定的函数,这种近似可以被解释成⼀个简单的神经⽹络。

径向基函数在⽀持向量机中也被⽤做核函数。

常见的径向基函数有:⾼斯函数,⼆次函数,逆⼆次函数等。

rbf神经网络原理

rbf神经网络原理

RBF神经网络是一种基于径向基函数(Radial Basis Function,简称RBF)的人工神经网络模型。

它在解决分类和回归等问题上具有优良的性能和灵活性。

RBF神经网络的基本思想是利用一组基函数来表示输入空间中的复杂映射关系。

这些基函数以输入样本为中心,通过测量样本与中心之间的距离来计算输出值。

常用的基函数包括高斯函数、多项式函数等。

与传统的前馈神经网络不同,RBF神经网络采用两层结构,包括一个隐含层和一个输出层。

隐含层的神经元是基函数的中心,负责对输入样本进行映射。

输出层的神经元用于组合隐含层的输出,并产生网络的最终输出结果。

RBF神经网络的训练过程分为两个阶段:中心选择和参数调整。

在中心选择阶段,通过聚类算法来确定基函数的中心,例如K-means聚类算法。

在参数调整阶段,使用误差反向传播算法来调整基函数的权值和输出层的权值。

RBF神经网络具有较强的非线性拟合能力和逼近性能。

它可以处理高维数据和大规模数据集,并且对于输入空间中的非线性映射具有较好的适应性。

此外,RBF神经网络还具有较快的训练速度和较好的泛化能力。

总结来说,RBF神经网络通过基函数的组合来实现对输入样

本的映射,从而实现对复杂映射关系的建模。

它是一种强大的人工神经网络模型,在多个领域和问题中表现出色。

Matlab工具箱中地BP与RBF函数

Matlab工具箱中的BP与RBF函数Matlab神经网络工具箱中的函数非常丰富,给网络设置适宜的属性,可以加快网络的学习速度,缩短网络的学习进程。

限于篇幅,仅对本章所用到的函数进展介绍,其它的函数与其用法请读者参考联机文档和帮助。

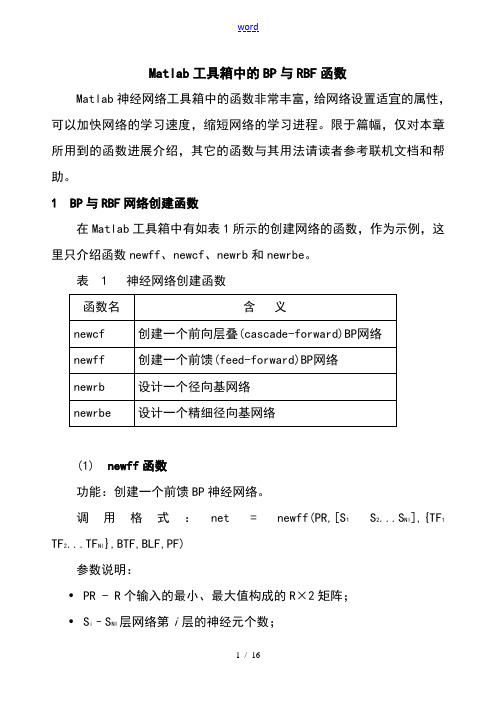

1 BP与RBF网络创建函数在Matlab工具箱中有如表1所示的创建网络的函数,作为示例,这里只介绍函数newff、newcf、newrb和newrbe。

表 1 神经网络创建函数(1) newff函数功能:创建一个前馈BP神经网络。

调用格式:net = newff(PR,[S1S2...S Nl],{TF1 TF2...TF Nl},BTF,BLF,PF)参数说明:•PR - R个输入的最小、最大值构成的R×2矩阵;•S i–S NI层网络第i层的神经元个数;•TF i - 第i层的传递函数,可以是任意可导函数,默认为 'tansig',可设置为logsig,purelin等;•BTF -反向传播网络训练函数,默认为 'trainlm',可设置为trainbfg,trainrp,traingd等;•BLF -反向传播权值、阈值学习函数,默认为 'learngdm';•PF -功能函数,默认为'mse';(2) newcf函数功能:创建一个N层的层叠(cascade)BP网络调用格式:net = newcf(Pr,[S1 S2...SNl],{TF1 TF2...TFNl},BTF,BLF,PF)参数同函数newff。

(3) newrb函数功能:创建一个径向基神经网络。

径向基网络可以用来对一个函数进展逼近。

newrb函数用来创建一个径向基网络,它可以是两参数网络,也可以是四参数网络。

在网络的隐层添加神经元,直到网络满足指定的均方误差要求。

调用格式:net = newrb(P,T,GOAL,SPREAD)参数说明:•P:Q个输入向量构成的R×Q矩阵;•T:Q个期望输出向量构成的S×Q矩阵;•GOAL:均方误差要求,默认为0。

BP神经网络原理及其MATLAB应用

BP神经网络原理及其MATLAB应用BP神经网络(Back Propagation Neural Network)是一种基于梯度下降算法的人工神经网络模型,具有较广泛的应用。

它具有模拟人类神经系统的记忆能力和学习能力,可以用来解决函数逼近、分类和模式识别等问题。

本文将介绍BP神经网络的原理及其在MATLAB中的应用。

BP神经网络的原理基于神经元间的权值和偏置进行计算。

一个标准的BP神经网络通常包含三层:输入层、隐藏层和输出层。

输入层负责接收输入信息,其节点数与输入维度相同;隐藏层用于提取输入信息的特征,其节点数可以根据具体问题进行设定;输出层负责输出最终的结果,其节点数根据问题的要求决定。

BP神经网络的训练过程可以分为前向传播和反向传播两个阶段。

前向传播过程中,输入信息逐层传递至输出层,通过对神经元的激活函数进行计算,得到神经网络的输出值。

反向传播过程中,通过最小化损失函数的梯度下降算法,不断调整神经元间的权值和偏置,以减小网络输出与实际输出之间的误差,达到训练网络的目的。

在MATLAB中,可以使用Neural Network Toolbox工具箱来实现BP神经网络。

以下是BP神经网络在MATLAB中的应用示例:首先,需导入BP神经网络所需的样本数据。

可以使用MATLAB中的load函数读取数据文件,并将其分为训练集和测试集:```data = load('dataset.mat');inputs = data(:, 1:end-1);targets = data(:, end);[trainInd, valInd, testInd] = dividerand(size(inputs, 1), 0.6, 0.2, 0.2);trainInputs = inputs(trainInd, :);trainTargets = targets(trainInd, :);valInputs = inputs(valInd, :);valTargets = targets(valInd, :);testInputs = inputs(testInd, :);testTargets = targets(testInd, :);```接下来,可以使用MATLAB的feedforwardnet函数构建BP神经网络模型,并进行网络训练和测试:```hiddenLayerSize = 10;net = feedforwardnet(hiddenLayerSize);net = train(net, trainInputs', trainTargets');outputs = net(testInputs');```最后,可以使用MATLAB提供的performance函数计算网络的性能指标,如均方误差、相关系数等:```performance = perform(net, testTargets', outputs);```通过逐步调整网络模型的参数和拓扑结构,如隐藏层节点数、学习率等,可以进一步优化BP神经网络的性能。

Matlab工具箱中的BP与RBF函数

Matlab工具箱中的BP与RBF函数Matlab神经网络工具箱中的函数非常丰富,给网络设置合适的属性,可以加快网络的学习速度,缩短网络的学习进程。

限于篇幅,仅对本章所用到的函数进行介绍,其它的函数及其用法请读者参考联机文档和帮助。

1 BP与RBF网络创建函数在Matlab工具箱中有如表1所示的创建网络的函数,作为示例,这里只介绍函数newff、newcf、newrb和newrbe。

表 1 神经网络创建函数(1) newff函数功能:创建一个前馈BP神经网络。

调用格式:net = newff(PR,[S1 S2...S Nl],{TF1 TF2...TF Nl},BTF,BLF,PF) 参数说明:•PR - R个输入的最小、最大值构成的R×2矩阵;•S i–S NI层网络第i层的神经元个数;•TF i - 第i层的传递函数,可以是任意可导函数,默认为'tansig',可设置为logsig,purelin等;•BTF -反向传播网络训练函数,默认为'trainlm',可设置为trainbfg,trainrp,traingd等;•BLF -反向传播权值、阈值学习函数,默认为'learngdm';•PF -功能函数,默认为'mse';(2) newcf函数功能:创建一个N层的层叠(cascade)BP网络调用格式:net = newcf(Pr,[S1 S2...SNl],{TF1 TF2...TFNl},BTF,BLF,PF) 参数同函数newff。

(3) newrb函数功能:创建一个径向基神经网络。

径向基网络可以用来对一个函数进行逼近。

newrb函数用来创建一个径向基网络,它可以是两参数网络,也可以是四参数网络。

在网络的隐层添加神经元,直到网络满足指定的均方误差要求。

调用格式:net = newrb(P,T,GOAL,SPREAD)参数说明:•P:Q个输入向量构成的R×Q矩阵;•T:Q个期望输出向量构成的S×Q矩阵;•GOAL:均方误差要求,默认为0。

基于MATLAB的RBF神经网络建模及应用

第27卷 第2期大庆师范学院学报Vol.27 No.2 2007年4月JOURNAL OF DAQ I N G NOR MAL UN I V ERSI TY Ap ril,2007基于MAT LAB的RBF神经网络建模及应用王艳芹,张 维(大庆师范学院物理与电气信息工程系,黑龙江大庆163712)摘 要:MAT LAB中的神经网络工具箱是进行神经网络系统分析与设计的有力工具。

RBF神经网络以其计算量小,学习速度快,不易陷入局部极小等诸多优点为系统辨识与建模提供了一种有效的手段。

将二者结合起来,解决了油田试井系统中压力值的建模问题,取得了令人满意的结果。

关键词:RBF神经网络;MAT LAB;试井系统作者简介:王艳芹(1979-),女,黑龙江海伦人,大庆师范学院物理与电气信息工程系教师,从事神经网络辨识与建模研究。

中图分类号:TP273 文献标识码:A 文章编号:1006-2165(2007)02-0118-03 收稿日期:2007-01-220引言人工神经网络作为一门新兴学科在非线性系统的建模与辨识中得到了广泛的应用[1]。

目前应用最广泛、直观、易理解的是基于误差反向传播算法的多层前向神经网络,简称BP(Err or Back Pr opagati on)网络,但该网络存在着收敛速度慢、易陷入局部极小及隐含层结点个数不易确定等缺陷。

近些年备受关注的另一种前向神经网络———径向基函数(Radial Basis Functi on,简记RBF)神经网络有效地解决了上述问题。

在人工神经网络的功能实现上,与传统的利用Basic、Fortran、C等语言编程相比,直接应用第四代计算机语言MAT LAB的神经网络工具箱更加简便易行。

MAT LAB是由美国M ath works公司发布的面向科学计算、数据可视化以及交互式程序设计的高级语言,其诸如小波分析、鲁棒控制、模糊逻辑、神经网络等丰富的工具箱代表了当今一流专家学者在这些领域的前沿工作[2]。

matlab的BP神经网络讲义

matlab的BP神经网络讲义一、RBF神经网络1985年,Powell提出了多变量插值的径向基函数(Radical Basis Function,RBF)方法,1988年,Moody和Darken提出了一种神经网络结构,即RBF神经网络。

RBF网络是一种三层前向网络,其基本思想是:(1)用RBF作为隐单元的“基”构成隐含层空间,将输入矢量直接(即不需要通过权连接)映射到隐空间(2)当RBF 的中心点确定后,映射关系也就确定(3)隐含层空间到输出空间的映射是线性的。

newrb()函数功能建立一个径向基神经网络格式net = newrb(P,T,GOAL,SPREAD,MN,DF)说明P为输入向量,T为目标向量,GOAL为圴方误差,默认为0,SPREAD为径向基函数的分布密度,默认为1,MN为神经元的最大数目,DF为两次显示之间所添加的神经元神经元数目。

例子:设[P,T]是训练样本,[X,Y]是测试样本;net=newrb(P,T,err_goal,spread); %建立网络q=sim(net,p);e=q-T;plot(p,q); %画训练误差曲线q=sim(net,X);e=q-Y;plot(X,q); %画测试误差曲线二、BP神经网络训练前馈网络的第一步是建立网络对象。

函数newff()建立一个可训练的前馈网络。

这需要4个输入参数。

第一个参数是一个Rx2的矩阵以定义R个输入向量的最小值和最大值。

第二个参数是一个设定每层神经元个数的数组。

第三个参数是包含每层用到的传递函数名称的细胞数组。

最后一个参数是用到的训练函数的名称。

举个例子,下面命令将创建一个二层网络。

它的输入是两个元素的向量,第一层有三个神经元(3),第二层有一个神经元(1)。

第一层的传递函数是tan-sigmoid,输出层的传递函数是linear。

输入向量的第一个元素的范围是-1到2[-1 2],输入向量的第二个元素的范围是0到5[0 5],训练函数是traingd。

BP神经网络matlab教程

w

N 1 ho

w o (k )hoh (k )

N ho

2.4.2 BP网络的标准学习算法

第七步,利用隐含层各神经元的 h (k )和 输入层各神经元的输入修正连接权。

e e hih (k ) wih (k ) h (k ) xi (k ) wih hih (k ) wih w

p

i 1

h 1,2,

o 1,2,

,p

q

yio (k ) whohoh (k ) bo

o 1,2,

yoo (k ) f( yio (k ))

h 1

q

2.4.2 BP网络的标准学习算法

第四步,利用网络期望输出和实际输出, 计算误差函数对输出层的各神经元的偏导 o (k ) 数 。 ( w ho (k ) b ) e e yio yi (k )

输入样本---输入层---各隐层---输出层

判断是否转入反向传播阶段:

若输出层的实际输出与期望的输出(教师信号)不 符

误差反传

误差以某种形式在各层表示----修正各层单元 的权值

网络输出的误差减少到可接受的程度 进行到预先设定的学习次数为止

2.4.2 BP网络的标准学习算法

网络结构 输入层有n个神经元,隐含层有p个神经元, 输出层有q个神经元 变量定义 x x1, x2 , , xn 输入向量; 隐含层输入向量; hi hi1 , hi2 , , hi p 隐含层输出向量; ho ho1 , ho2 , , ho p 输出层输入向量; yi yi1 , yi2 , , yiq 输出层输出向量; yo yo1 , yo2 , , yoq 期望输出向量; d o d1 , d 2 , , d q

matlab神经网络知识讲解

Matlab神经网络工具箱2010-7-21今天学的是BP神经网络,首先看的是一个关于非线性函数逼近的例子,最后得出一个心得:在使用newff函数生成一个新的网络时,神经元的层数和每一层的神经元数会对结果造成不小的影响,一般都采用[n,1]的建立方法,其中n为隐层的神经元数,1为输出层的神经元数。

然后是做了一个识别系统,算是一个较大的神经网络,具体的代码解释和分析如下:[alphabet,targets]=prprob;[R,Q]=size(alphabet);[S2,Q]=size(targets);S1=10;[R,Q]=size(alphabet);[S2,Q]=size(targets);P=alphabet;net=newff(minmax(P),[S1,S2],{'logsig','logsig'},'traingdx');net.LW{2,1}=net.LW{2,1}*0.01;net.b{2}=net.b{2}+0.01;其中的proprob是matlab自带的一个生成字母表布尔值的函数。

可以具体查看。

T=targets;net.performFcn='sse';net.trainParam.goal=0.1;net.trainParam.show=20;net.trainParam.epochs=5000;net.trainParam.mc=0.95;[net,tr]=train(net,P,T)接下来首先进行无噪声训练。

netn.trainParam.goal=0.6;netn.trainParam.epochs=300;T=[targets targets targets targets];for pass=1:10P=[alphabet,alphabet,(alphabet+randn(R,Q)*0.1),(alphabet+randn(R,Q)*0.2) ];[netn,tr]=train(net,P,T);end接下来是有噪声训练,采用随机数生成影响输入矩阵的方式。

RBF神经网络概述

RBF神经网络概述RBF(径向基函数)神经网络是一种基于径向基函数的神经网络模型。

它由两部分组成:输入层和输出层。

输入层接收外部输入信号,然后通过径向基函数层将输入映射到隐含层。

隐含层采用径向基函数来计算输入向量与各个隐含单元的距离,并输出给输出层。

输出层根据隐含层的输出计算最终的输出结果。

1.非线性映射能力:径向基函数作为非线性映射函数,可以将输入空间映射到高维特征空间,从而可以处理非线性问题。

2.局部处理和全局处理:隐含层的每个隐含单元都对输入向量进行局部处理,隐含单元之间相互独立运算。

然后输出层将各个隐含单元的输出结果进行全局处理,得到最终的输出结果。

3.高维特征空间:由于径向基函数的作用,RBF神经网络可以将输入空间映射到高维特征空间,从而提高网络的抽象能力和判别能力。

4.可解释性:RBF神经网络中的隐含单元具有一定的物理意义,例如高斯函数的中心表示样本的分布情况,标准差表示隐含单元的灵敏度。

这样的特点使得RBF神经网络具有较好的可解释性。

1. 中心确定:通过聚类算法(如K-means算法)确定隐含层的中心,中心可以看作是样本的代表点。

2.方差确定:针对每个隐含单元,计算样本与该隐含单元中心的距离,并计算方差。

方差越大,隐含单元对距离远的样本的响应越强,方差越小,隐含单元对距离近的样本的响应越强。

3.权值确定:根据中心和方差计算得到每个隐含单元的权值。

通常采用最小二乘法或者广义逆矩阵法。

4.输出计算:根据隐含层的输出和权值,计算输出层的输出。

5.网络训练:使用样本数据进行网络训练,通过调整权值来减小网络的误差。

常用的方法有梯度下降法、遗传算法等。

RBF神经网络在模式识别、函数逼近、数据挖掘等领域有着广泛的应用。

它具有较好的非线性映射能力和逼近能力,能够处理高维特征空间的模式识别问题。

同时,RBF神经网络具有较好的可解释性,能够提供有关样本分布和网络响应的有效信息。

然而,RBF神经网络也存在一些问题。

MATLAB讲义(神经网络)

n = Wp+ b

a——神经元输出向量 神经元输出向量

a = f (Wp + b )

4、多层神经网络 、

多层神经网络的简化形式如下:

这里: IW1,1——输入权值矩阵, S行R列。 输入权值矩阵, 行 列 输入权值矩阵

IW

1,1

iw iw ⋅ ⋅ ⋅ iw 1,1 1,1 1,1 iw2 ,1iw2 , 2 ⋅ ⋅ ⋅ iw2 , R = ⋅⋅⋅⋅⋅⋅ iw1,1 iw1,1 ⋅ ⋅ ⋅ iw1,1 S ,R S ,1 S , 2

举例:创建一个线性网络 net = newlin([1 3;1 3],1); net.IW{1,1} net.b{1} 修改输入权值矩阵 权值矩阵 net.IW{1,1} = [1 2]; net.b{1} = 1;

下标——用()中的内容来表示,如:

b → net .b{1}( 2)

1 2

举例:在上例中修改单个权值 权值 net.IW{1,1}(1) = 13; net.IW{1,1}(2) = 9; net.IW{1,1}

后面将要介绍,上述单层感知器可 以通过划分输入空间将输入向量分成两 类。

一个单层感知器神经元网络的模型如下:

一个单层感知器神经元网络的向量 模型如下:

7.2.2 感知器神经网络的创建、模拟和 感知器神经网络的创建、 初始化 1. 创建 指令:net = newp(PR, S,tf,lf) 这里: newp——创建感知器指令 PR——R行2列矩阵,用来限定R个输入的取 值范围。 S——网络的神经元个数 net——感知器网络名 tf——变换函数,缺省为hardlim。 lf——学习函数,缺省为learnp。

7.1.2 MATLAB中的符号规约 中的符号规约 在以上神经网络结构中所使用的符号是 原理性的数学符号,不是在MATLAB中实际 使用的符号。因此,要按照MATLAB中的符 号规约重新定义。 上标——用括弧{}中的内容来表示,如: IW1,1 → net.IW{1,1} b1 → net.b{1}

BP神经网络matlab详细参数

基于matlab BP 神经网络参数详解(1)生成BP网络=net newff PR S S SNl TF TF TFNl BTF BLF PF(,[1 2...],{ 1 2...},,,) PR:由R维的输入样本最小最大值构成的2R⨯维矩阵。

S S SNl:各层的神经元个数。

[1 2...]{ 1 2...}TF TF TFNl:各层的神经元传递函数。

BTF:训练用函数的名称。

(2)网络训练=net tr Y E Pf Af train net P T Pi Ai VV TV[,,,,,] (,,,,,,)(3)网络仿真=Y Pf Af E perf sim net P Pi Ai T[,,,,] (,,,,)BP网络的训练函数训练方法训练函数梯度下降法traingd有动量的梯度下降法traingdm自适应lr梯度下降法traingda自适应lr动量梯度下降法traingdx弹性梯度下降法trainrptraincgfFletcher-Reeves共轭梯度法Ploak-Ribiere共轭梯度法traincgpPowell-Beale共轭梯度法traincgb量化共轭梯度法trainscg拟牛顿算法trainbfg一步正割算法trainoss Levenberg-Marquardt trainlmBP网络训练参数训练参数参数介绍训练函数net.trainParam.epochs最大训练次数(缺省为10)traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.goal训练要求精度(缺省为0)traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.lr学习率(缺省为0.01)traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.max_fail最大失败次数(缺省为5)traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.min_grad最小梯度要求(缺省为1e-10)traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.show显示训练迭代过程(NaN表示不显示,缺省为25)traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlmnet.trainParam.time最大训练时间(缺省为inf)traingd、traingdm、traingda、traingdx、trainrp、traincgf、traincgp、traincgb、trainscg、trainbfg、trainoss、trainlm net.trainParam.mc动量因子(缺省0.9)traingdm、traingdxnet.trainParam.lr_inc学习率lr增长比(缺省为1.05)traingda、traingdxnet.trainParam.lr_dec学习率lr下降比(缺省为0.7)traingda、traingdxnet.trainParam.max_perf_inc表现函数增加最大比(缺省为1.04)traingda、traingdxnet.trainParam.delt_inc权值变化增加量(缺省为1.2)trainrpnet.trainParam.delt_dec权值变化减小量(缺省为0.5)trainrpnet.trainParam.delt0初始权值变化(缺省为0.07)trainrpnet.trainParam.deltamax权值变化最大值(缺省为50.0)trainrpnet.trainParam.searchFcn一维线性搜索方法(缺省为srchcha)traincgf、traincgp、traincgb、trainbfg、trainossnet.trainParam.sigma因为二次求导对权值trainscg调整的影响参数(缺省值5.0e-5)mbdatrainscgHessian矩阵不确定性调节参数(缺省为5.0e-7)net.trainParam.men_redtrainlm控制计算机内存/速uc度的参量,内存较大设为1,否则设为2(缺省为1)net.trainParam.mutrainlmμ的初始值(缺省为0.001)net.trainParam.mu_dectrainlmμ的减小率(缺省为0.1)net.trainParam.mu_inctrainlmμ的增长率(缺省为10)net.trainParam.mu_maxtrainlmμ的最大值(缺省为1e10)。

径向基函数神经网络RBF与BP神经网络

3.把一切把一切问题的特征都变为数字,把一切推理 都变为数值计算,其结果势必是丢失信息。

BP神经元模型

RBF隐层神经元模型

P1 P2

பைடு நூலகம்

w1,1

P3

n

fa

PR-1 PR

w1,R

R(|| dist ||) e||dist||2

a=f(wp+b)

传递函数:A=logsig(n) A=tansig(n) A=purelin(n)

激活函数:

注:|| dist || 是输入向量和 权值向量之间的欧氏距离

神经元的数据中心即为样本本身,参数设计只需考虑扩展 常数和输出节点的权值。

当采用广义RBF网络结构时,RBF网络的学习算法应该解决 的问题包括:如何确定网络隐节点数,如何确定各径向基 函数的数据中心及扩展常数,以及如何修正输出权值。

RBF网络学习算法的MATLAB实现

RBF网络常用函数表

函数名

功能

径向基函数神经网络

神经网络基础知识

工作原理:模拟生物大脑神经处理信息的方式 构成:大量简单的基本元件——神经元相互连接 功能:进行信息的并行处理和非线性转化 本质:就是利用计算机语言模拟人类大脑做决定

的过程。

神经元结构模型

输入信号

x1

x2

x3 xj

ij

xn

阈值

yi

i

输出值 与神经元xj的连接权值

使用这些数据 实现回归公式

RBF与BP神经网络的比较

从网络结构上比较: 传递函数不同;神经元层数可能不同;RBF 网络隐层神经元个数可以确定,BP网络不 易确定。

RBF神经网络:原理详解和MATLAB实现

RBF神经网络:原理详解和MATLAB实现——2020年2月2日目录RBF神经网络:原理详解和MATLAB实现 (1)一、径向基函数RBF (2)定义(Radial basis function——一种距离) (2)如何理解径向基函数与神经网络? (2)应用 (3)二、RBF神经网络的基本思想(从函数到函数的映射) (3)三、RBF神经网络模型 (3)(一)RBF神经网络神经元结构 (3)(二)高斯核函数 (6)四、基于高斯核的RBF神经网络拓扑结构 (7)五、RBF网络的学习算法 (9)(一)算法需要求解的参数 (9)0.确定输入向量 (9)1.径向基函数的中心(隐含层中心点) (9)2.方差(sigma) (10)3.初始化隐含层至输出层的连接权值 (10)4.初始化宽度向量 (12)(二)计算隐含层第j 个神经元的输出值zj (12)(三)计算输出层神经元的输出 (13)(四)权重参数的迭代计算 (13)六、RBF神经网络算法的MATLAB实现 (14)七、RBF神经网络学习算法的范例 (15)(一)简例 (15)(二)预测汽油辛烷值 (15)八、参考资料 (19)一、径向基函数RBF定义(Radial basis function——一种距离)径向基函数是一个取值仅仅依赖于离原点距离的实值函数,也就是Φ(x)=Φ(‖x‖),或者还可以是到任意一点c的距离,c点称为中心点,也就是Φ(x,c)=Φ(‖x-c‖)。

任意一个满足Φ(x)=Φ(‖x‖)特性的函数Φ都叫做径向基函数。

标准的一般使用欧氏距离(也叫做欧式径向基函数),尽管其他距离函数也是可以的。

在神经网络结构中,可以作为全连接层和ReLU层的主要函数。

如何理解径向基函数与神经网络?一些径向函数代表性的用到近似给定的函数,这种近似可以被解释成一个简单的神经网络。

径向基函数在支持向量机中也被用做核函数。

常见的径向基函数有:高斯函数,二次函数,逆二次函数等。

神经网络PPT课件-基于MATLAB算法(BP.遗传算法.RBF.小波)

正因为人工神经网络是对生物神经网络的模仿,它具有一些传统 逻辑运算不具有的优点。主要包括: 一、非线性。非线性是自然界的普遍特性。人脑的思考过程就是 非线性的。人工神经网络通过模仿人脑神经元结构的信息传递过 程,可以进行线性或者非线性的运算,这是人工神经网络的最特 出的特性。

二、自适应性。神经网络的结构中设置了权值和阈值参数。网络 能够随着输入输出端的环境变化,自动调节神经节点上的权值和 阈值。因此,神经网络对在一定范围变化的环境有பைடு நூலகம்强的适应能 力。适用于完成信号处理、模式识别、自动控制等任务。系统运 行起来也相当稳定。

③引入陡度因子

误差曲面上存在着平坦区域。权值调整进入平坦区的原因是神经元输出进入了转 移函数的饱和区。如果在调整进入平坦区域后,设法压缩神经元的净输入,使其 输出退出转移函数的饱和区,就可以改变误差函数的形状,从而使调整脱离平坦 区。实现这一思路的具体作法是在原转移函数中引入一个陡度因子。

BP神经网络的MATLAB算法

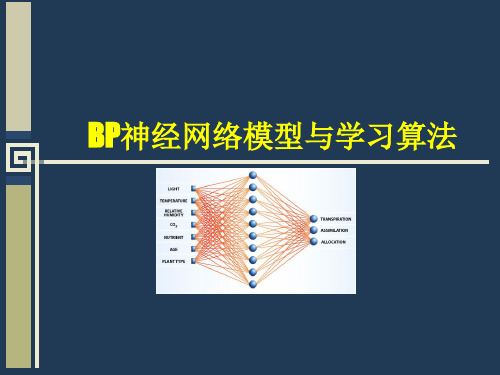

BP神经网络模型

• BP (Back Propagation)神经网络,即误差反向传播算法的学习过 程,由信息的正向传播和误差的反向传播两个过程组成。输入 层各神经元负责接收来自外界的输入信息,并传递给中间层各 神经元;中间层是内部信息处理层,负责信息变换,根据信息 变化能力的需求,中间层可以设计为单隐含层或者多隐含层结 构;最后一个隐含层传递到输出层各神经元的信息,经进一步 处理后,完成一次学习的正向传播处理过程,由输出层向外界 输出信息处理结果。

l n 1 l

m n a

l log 2 n

步骤2:隐含层输出计算 根据输入变量 X,输入层和隐含层间连接权值 ij 以及隐含层阈值 a, 计算隐含层输出H。

BP神经网络的MATLAB语法介绍

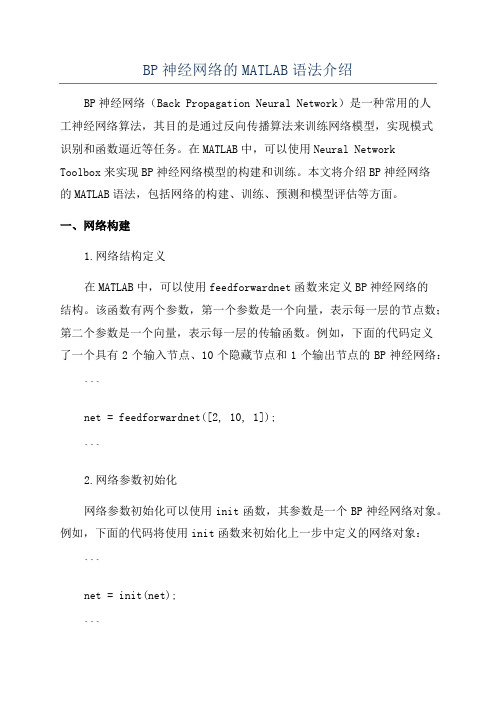

BP神经网络的MATLAB语法介绍BP神经网络(Back Propagation Neural Network)是一种常用的人工神经网络算法,其目的是通过反向传播算法来训练网络模型,实现模式识别和函数逼近等任务。

在MATLAB中,可以使用Neural Network Toolbox来实现BP神经网络模型的构建和训练。

本文将介绍BP神经网络的MATLAB语法,包括网络的构建、训练、预测和模型评估等方面。

一、网络构建1.网络结构定义在MATLAB中,可以使用feedforwardnet函数来定义BP神经网络的结构。

该函数有两个参数,第一个参数是一个向量,表示每一层的节点数;第二个参数是一个向量,表示每一层的传输函数。

例如,下面的代码定义了一个具有2个输入节点、10个隐藏节点和1个输出节点的BP神经网络:```net = feedforwardnet([2, 10, 1]);```2.网络参数初始化网络参数初始化可以使用init函数,其参数是一个BP神经网络对象。

例如,下面的代码将使用init函数来初始化上一步中定义的网络对象:```net = init(net);```二、训练网络1.数据准备在训练BP神经网络之前,需要将数据集划分为输入和输出,然后进行数据归一化处理。

在MATLAB中,可以使用mat2cell函数将数据集划分为输入和输出集合,使用mapminmax函数来归一化数据。

例如,下面的代码将数据集划分为输入集合和输出集合,并进行数据归一化处理:```inputs = mat2cell(data(:, 1:end-1)', size(data, 2)-1,ones(size(data, 1), 1));outputs = mat2cell(data(:, end)', ones(size(data, 1), 1), 1);[input, inputPS] = mapminmax(cat(2, inputs{:}));[output, outputPS] = mapminmax(cat(2, outputs{:}));```2.训练参数设置在训练BP神经网络之前,需要设置一些训练参数,例如训练算法和最大训练次数。

MATLABBP神经网络用法的总结(试用于初学者)

MATLABBP神经网络用法的总结(试用于初学者)MATLAB是一种高级编程语言和环境,适用于各种科学和工程应用。

其中的BP神经网络(Backpropagation Neural Network)是一种最常用的人工神经网络类型,用于解决分类和回归问题。

对于初学者来说,使用MATLAB的BP神经网络可能会感到有些困惑,但通过一些基本的了解和指导,可以帮助他们尽快入门并开始应用该技术。

一、MATLAB中BP神经网络的基本原理BP神经网络是一种多层的前馈神经网络,其学习算法基于误差反向传播原理。

它由输入层、隐藏层和输出层组成,每个神经元都与前一层的所有神经元相连。

具体来说,它的训练过程包括四个主要步骤:初始化权重、前向传播、计算误差、反向传播。

通过迭代这四个步骤,神经网络可以根据样本数据不断调整权重,以最小化预测输出与实际输出之间的误差。

二、使用MATLAB创建BP神经网络在MATLAB中,可以使用Neural Network Toolbox(神经网络工具箱)来创建和训练BP神经网络。

可以按照以下步骤创建一个简单的BP神经网络模型。

1.定义输入和输出数据:首先,需要准备输入数据和对应的输出数据。

输入和输出数据的维度应该匹配,且数据应该以矩阵的形式表示。

2. 配置神经网络:使用‘newff’函数来创建一个新的BP神经网络对象。

可以指定隐藏层的数量和每个隐藏层的神经元数。

3. 训练神经网络:使用‘train’函数来训练神经网络。

可以指定训练算法、迭代次数、误差目标等参数。

4.预测和评估:使用已经训练好的神经网络对新的输入数据进行预测,并对预测结果进行评估。

三、MATLAB中BP神经网络的常见问题和解决方法1.数据预处理:在使用BP神经网络之前,需要对输入数据进行预处理,如归一化、标准化等,以确保数据在合理的范围内。

2.过拟合问题:BP神经网络容易过拟合数据,即在训练数据上表现较好,但在未知数据上表现较差。

BP神经网络的Matlab语法介绍

1.数据预办理在训练神经网络前一般需要对数据进行预办理,一种重要的预办理手段是归一化办理。

下边简要介绍归一化办理的原理与方法。

(1)什么是归一化?数据归一化,就是将数据映照到[0,1] 或[-1,1]区间或更小的区间,比方(0.1,0.9)。

(2)为何要归一化办理?<1> 输入数据的单位不一样样,有些数据的范围可能特别大,以致的结果是神经网络收敛慢、训练时间长。

<2> 数据范围大的输入在模式分类中的作用可能会偏大,而数据范围小的输入作用即可能会偏小。

<3> 因为神经网络输出层的激活函数的值域是有限制的,所以需要将网络训练的目标数据映照到激活函数的值域。

比方神经网络的输出层若采纳 S 形激活函数,因为 S 形函数的值域限制在 (0,1) ,也就是说神经网络的输出只好限制在(0,1) ,所以训练数据的输出就要归一化到[0,1]区间。

<4>S 形激活函数在 (0,1) 区间之外处域很缓和,划分度太小。

比方 S 形函数 f(X) 在参数 a=1 时, f(100) 与 f(5) 只相差 0.0067 。

(3)归一化算法一种简单而快速的归一化算法是线性变换算法。

线性变换算法常有有两种形式:<1>y = ( x - min )/( max - min )此中 min 为 x 的最小值, max 为 x 的最大值,输入向量为 x ,归一化后的输出向量为 y 。

上式将数据归一化到 [ 0 , 1 ] 区间,当激活函数采纳 S 形函数时(值域为 (0,1) )时这条式子合用。

<2>y = 2 * ( x - min ) / ( max - min ) - 1这条公式将数据归一化到[-1,1]数(值域为 (-1,1))时这条式子合用。

区间。

当激活函数采纳双极S 形函(4) MatlabMatlab tramnmx数据归一化办理函数中归一化办理数据可以采纳这 3 个函数。

提供一个Matlab的BP神经网络的基础资料

第一节内容:包括神经网络的基础知识,BP网络的特点,bp主要应用的场合,使用时应注意的问题。

什么是神经网络?神经网络是由很多神经元组成的,首先我们看一下,什么是神经元上面这个图表示的就是一个神经元,我们不管其它书上说的那些什么树突,轴突的。

用个比较粗浅的解释,可能不太全面科学,但对初学者很容易理解:1、我们把输入信号看成你在matlab中需要输入的数据,输进去神经网络后2、这些数据的每一个都会被乘个数,即权值w,然后这些东东与阀值b相加后求和得到u,3、上面只是线性变化,为了达到能处理非线性的目的,u做了个变换,变换的规则和传输函数有关可能还有人问,那么那个阀值是什么呢?简单理解就是让这些数据做了个平移,这就是神经元工作的过程。

处理后的结果又作为输入,可输给别的神经元,很多这样的神经元,就组成了网络。

在matlab中具体用什么算法实现这些,我们先不管,我们需要注意的是怎么使用。

比如使用BP的神经网络newff()构建一个网络,这些在后面的学习将提到。

BP网络的特点①网络实质上实现了一个从输入到输出的映射功能,而数学理论已证明它具有实现任何复杂非线性映射的功能。

这使得它特别适合于求解内部机制复杂的问题。

我们无需建立模型,或了解其内部过程,只需输入,获得输出。

只要BPNN结构优秀,一般20个输入函数以下的问题都能在50000次的学习以内收敛到最低误差附近。

而且理论上,一个三层的神经网络,能够以任意精度逼近给定的函数,这是非常诱人的期望;②网络能通过学习带正确答案的实例集自动提取“合理的”求解规则,即具有自学习能力;③网络具有一定的推广、概括能力。

bp主要应用回归预测(可以进行拟合,数据处理分析,事物预测,控制等)、分类识别(进行类型划分,模式识别等),在后面的学习中,都将给出实例程序。

但无论那种网络,什么方法,解决问题的精确度都无法打到100%的,但并不影响其使用,因为现实中很多复杂的问题,精确的解释是毫无意义的,有意义的解析必定会损失精度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

matlab的RBF BP神经网络讲义一、RBF神经网络1985年,Powell提出了多变量插值的径向基函数(Radical Basis Function,RBF)方法,1988年,Moody和Darken提出了一种神经网络结构,即RBF神经网络。

RBF网络是一种三层前向网络,其基本思想是:(1)用RBF作为隐单元的“基”构成隐含层空间,将输入矢量直接(即不需要通过权连接)映射到隐空间(2)当RBF的中心点确定后,映射关系也就确定(3)隐含层空间到输出空间的映射是线性的。

newrb()函数功能建立一个径向基神经网络格式net = newrb(P,T,GOAL,SPREAD,MN,DF)说明P为输入向量,T为目标向量,GOAL为圴方误差,默认为0,SPREAD为径向基函数的分布密度,默认为1,MN为神经元的最大数目,DF为两次显示之间所添加的神经元神经元数目。

例子:设[P,T]是训练样本,[X,Y]是测试样本;net=newrb(P,T,err_goal,spread); %建立网络q=sim(net,p);e=q-T;plot(p,q); %画训练误差曲线q=sim(net,X);e=q-Y;plot(X,q); %画测试误差曲线二、BP神经网络训练前馈网络的第一步是建立网络对象。

函数newff()建立一个可训练的前馈网络。

这需要4个输入参数。

第一个参数是一个Rx2的矩阵以定义R个输入向量的最小值和最大值。

第二个参数是一个设定每层神经元个数的数组。

第三个参数是包含每层用到的传递函数名称的细胞数组。

最后一个参数是用到的训练函数的名称。

举个例子,下面命令将创建一个二层网络。

它的输入是两个元素的向量,第一层有三个神经元(3),第二层有一个神经元(1)。

第一层的传递函数是tan-sigmoid,输出层的传递函数是linear。

输入向量的第一个元素的范围是-1到2[-1 2],输入向量的第二个元素的范围是0到5[0 5],训练函数是traingd。

net=newff([-1 2; 0 5],[3,1],{'tansig','purelin'},'traingd');这个命令建立了网络对象并且初始化了网络权重和偏置,因此网络就可以进行训练了。

我们可能要多次重新初始化权重或者进行自定义的初始化。

下面就是初始化的详细步骤。

在训练前馈网络之前,权重和偏置必须被初始化。

初始化权重和偏置的工作用命令init来实现。

这个函数接收网络对象并初始化权重和偏置后返回网络对象。

下面就是网络如何初始化的:net = init(net);我们可以通过设定网络参数net.initFcn和yer{i}.initFcn这一技巧来初始化一个给定的网络。

net.initFcn用来决定整个网络的初始化函数。

前馈网络的缺省值为initlay,它允许每一层用单独的初始化函数。

设定了net.initFcn ,那么参数yer{i}.initFcn 也要设定用来决定每一层的初始化函数。

对前馈网络来说,有两种不同的初始化方式经常被用到:initwb和initnw。

initwb函数根据每一层自己的初始化参数(net.inputWeights{i,j}.initFcn)初始化权重矩阵和偏置。

前馈网络的初始化权重通常设为rands,它使权重在-1到1之间随机取值。

这种方式经常用在转换函数是线性函数时。

initnw通常用于转换函数是曲线函数。

它根据Nguyen和Widrow[NgWi90]为层产生初始权重和偏置值,使得每层神经元的活动区域能大致平坦的分布在输入空间。

它比起单纯的给权重和偏置随机赋值有以下优点:(1)减少神经元的浪费(因为所有神经元的活动区域都在输入空间内)。

(2)有更快的训练速度(因为输入空间的每个区域都在活动的神经元范围中)。

初始化函数被newff所调用。

因此当网络创建时,它根据缺省的参数自动初始化。

init不需要单独的调用。

可是我们可能要重新初始化权重和偏置或者进行自定义的初始化。

例如,我们用newff创建的网络,它缺省用initnw来初始化第一层。

如果我们想要用rands重新初始化第一层的权重和偏置,我们用以下命令:yers{1}.initFcn = 'initwb';net.inputWeights{1,1}.initFcn = 'rands';net.biases{1,1}.initFcn = 'rands';net.biases{2,1}.initFcn = 'rands';net = init(net);IW: 输入层到隐含层的权重矩阵LW: 隐含层和输出层间的权重矩阵b: 阀值向量如网络为net, 输入层和输出均为一个接点情况下,则用net.IW{1,1}可以看到第一个输入接点到第一隐含层的权重向量;net.LW{2,1}可以看到隐含层到输出层的权值向量;net.b{1,1}是隐含层的阀值向量,net.b{2,1}是输出接点的阀值;在多输入输出下先用net.IWnet.LWnet.b查看各矩阵结构,再相应用net.IW{?,?}等语句查到相关的向量___________________________________________________________________________________ ___________clear all;%define the input and outputp= [974 874 527;388 466 1764;1316 2439 2251;1836 2410 1860;1557 2301 1578;1490 1877 2749;1513 1278 2026;1070 1561 2794;1347 2415 3306;1324 2746 1233;1383 1463 1847;1282 0 2347];t=[19797 24282 34548];% 创建bp网络和定义训练函数% 这里是为了方便而建立一个矩阵,注意是12x2,不是3x2pr=[ 527 974;388 1764;1316 2439;1836 2410;1557 2301;1490 2749;1278 2026;1070 2794;1347 3306;1233 2746;1383 1847;0 2347]net=newff(pr,[15,1],{'tansig' 'purelin'},'trainlm'); %这里要加入输出层的转移函数,一般是trainlm net.trainparam.goal=50;net.trainparam.epochs=5000;%训练神经网络[net,tr]=train(net,p,t);%输出训练后的权值和阈值iw1=net.IW{1};b1=net.b{1};lw2=net.LW{2};b2=net.b{2};%存储训练好的神经网络save netkohler net___________________________________________________________________________________ ___________怎样知道matlab已经训练好的神经网络的权值、步长以及阙值用matlab训练神经网络时不需输入权值、步长以及阙值,如果我想知道matlab已经训练好的神经网络的权值、步长以及阙值该怎末操作?训练好的权值、阈值的输出方法是:输入到隐层权值:w1=net.iw{1,1}隐层阈值:theta1=net.b{1}隐层到输出层权值:w2=net.lw{2,1};输出层阈值:theta2=net.b{2}___________________________________________________________________________________ ___________帮我看看matlab的这段程序(有关神经网络BP算法)在一位老师的讲义上看到的程序,但是有些东西不太明白,请求帮助程序如下:****************************************************************clf;figure(gcf)echo on%NEWFF —建立一个BP网络%TRAIN —对BP网络进行训练%SIM —对BP网络进行仿真pauseP = -1:0.1:1;T = [-.9602 -.5770 -.0729 .3771 .6405 .6600 .4609 ....1336 -.2013 -.4344 -.5000 -.3930 -.1647 .0988 ....3072 .3960 .3449 .1816 -.0312 -.2189 -.3201];plot(P,T,'+');title('Training Vectors');xlabel('Input Vector P');ylabel('Target Vector T');pausenet=newff(minmax(P),[5 1],{'tansig' 'purelin'},'traingd','learngd','sse');echo offk = pickic;if k == 2net.iw{1,1} = [3.5000; 3.5000; 3.5000; 3.5000; 3.5000];net.b{1} = [-2.8562; 1.0774; -0.5880; 1.4083; 2.8722];net.lw{2,1} = [0.2622 -0.2375 -0.4525 0.2361 -0.1718];net.b{2} = [0.1326];endnet.iw{1,1}net.b{1}net.lw{2,1}net.b{2}pauseecho onme=8000;net.trainParam.show=10;net.trainParam.goal=0.02;net.trainParam.lr=0.01;A=sim(net,P);sse=sumsqr(T-A);for i=1:me/100if sse>net.trainparam.goal,i=i-1;break,endnet.trainParam.epochs=100;[net,tr]=train(net,P,T);trp((1+100*(i-1)):(max(tr.epoch)+100*(i-1)))=tr.perf(1:max(tr.epoch));A=sim(net,P);sse=sumsqr(T-A);plot(P,T,'+');hold onplot(P,A)hold offpauseendmessage=sprintf('Traingd, Epoch %%g/%g, SSE %%g\n',me);fprintf(message,(max(tr.epoch)+100*(i-1)),sse)plot(tr)[i,j]=size(trp);hold onplot(1:j,net.trainParam.goal,'r--')hold offtitle('Error Signal')xlabel('epoch')ylabel('Error')p = 0.5;a = sim(net,p)echo offRBF网络与BP网络比较:RBF网络的输出是隐单元输出的线性加权和,学习速度加快BP网络使用sigmoid()函数作为激活函数,这样使得神经元有很大的输入可见区域径向基神经网络使用径向基函数(一般使用高斯函数)作为激活函数,神经元输入空间区域很小,因此需要更多的径向基神经元。