Deep Learning(深度学习)学习笔记整理系列

深度学习基础知识

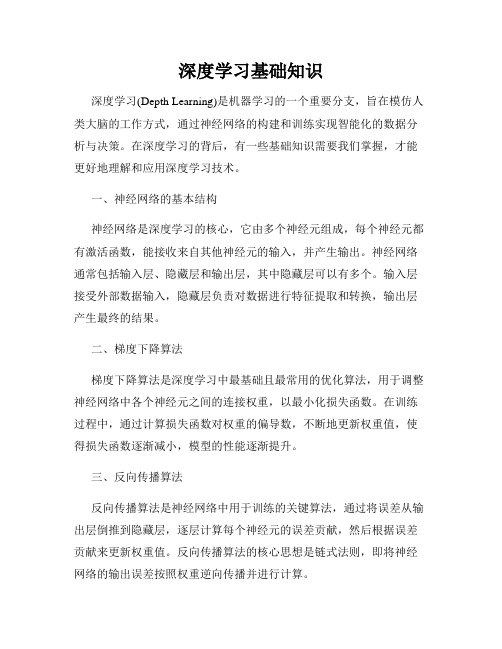

深度学习基础知识深度学习(Depth Learning)是机器学习的一个重要分支,旨在模仿人类大脑的工作方式,通过神经网络的构建和训练实现智能化的数据分析与决策。

在深度学习的背后,有一些基础知识需要我们掌握,才能更好地理解和应用深度学习技术。

一、神经网络的基本结构神经网络是深度学习的核心,它由多个神经元组成,每个神经元都有激活函数,能接收来自其他神经元的输入,并产生输出。

神经网络通常包括输入层、隐藏层和输出层,其中隐藏层可以有多个。

输入层接受外部数据输入,隐藏层负责对数据进行特征提取和转换,输出层产生最终的结果。

二、梯度下降算法梯度下降算法是深度学习中最基础且最常用的优化算法,用于调整神经网络中各个神经元之间的连接权重,以最小化损失函数。

在训练过程中,通过计算损失函数对权重的偏导数,不断地更新权重值,使得损失函数逐渐减小,模型的性能逐渐提升。

三、反向传播算法反向传播算法是神经网络中用于训练的关键算法,通过将误差从输出层倒推到隐藏层,逐层计算每个神经元的误差贡献,然后根据误差贡献来更新权重值。

反向传播算法的核心思想是链式法则,即将神经网络的输出误差按照权重逆向传播并进行计算。

四、卷积神经网络(CNN)卷积神经网络是一种主要用于图像处理和识别的深度学习模型。

它通过共享权重和局部感受野的方式,有效地提取图像中的特征。

卷积神经网络通常包括卷积层、池化层和全连接层。

其中卷积层用于提取图像中的局部特征,池化层用于降低特征的维度,全连接层用于输出最终的分类结果。

五、循环神经网络(RNN)循环神经网络是一种主要用于序列数据处理的深度学习模型。

它通过引入时间维度,并在每个时间步上传递隐藏状态,实现对序列数据的建模。

循环神经网络可以解决序列数据中的时序依赖问题,适用于音频识别、语言模型等任务。

六、生成对抗网络(GAN)生成对抗网络是一种通过让生成器和判别器相互博弈的方式,实现模型训练和生成样本的深度学习模型。

生成器负责生成与真实样本相似的假样本,判别器负责对真假样本进行分类。

神经网络与深度学习知识点整理

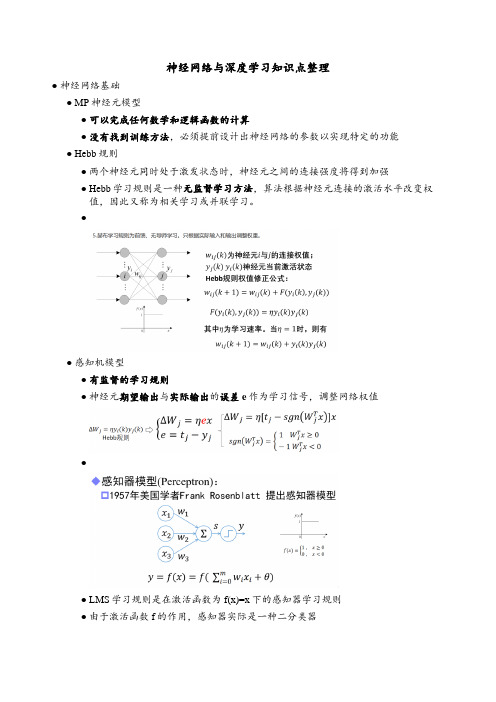

神经网络与深度学习知识点整理●神经网络基础●MP神经元模型●可以完成任何数学和逻辑函数的计算●没有找到训练方法,必须提前设计出神经网络的参数以实现特定的功能●Hebb规则●两个神经元同时处于激发状态时,神经元之间的连接强度将得到加强●Hebb学习规则是一种无监督学习方法,算法根据神经元连接的激活水平改变权值,因此又称为相关学习或并联学习。

●●感知机模型●有监督的学习规则●神经元期望输出与实际输出的误差e作为学习信号,调整网络权值●●LMS学习规则是在激活函数为f(x)=x下的感知器学习规则●由于激活函数f的作用,感知器实际是一种二分类器●感知器调整权值步骤●单层感知器不能解决异或问题●BP网络●特点:●同层神经网络无连接●不允许跨层连接●无反馈连接●BP学习算法由正向传播和反向传播组成●BP网络的激活函数必须处处可导——BP权值的调整采用 Gradient Descent 公式ΔW=-η(偏E/偏w),这个公式要求网络期望输出和单次训练差值(误差E)求导。

所以要求输出值处处可导。

s函数正好满足处处可导。

●运算实例(ppt)●Delta( δ )学习规则●误差纠正式学习——神经元的有监督δ学习规则,用于解决输入输出已知情况下神经元权值学习问题●δ学习规则又称误差修正规则,根据E/w负梯度方向调整神经元间的连接权值,能够使误差函数E达到最小值。

●δ学习规则通过输出与期望值的平方误差最小化,实现权值调整●●1●自动微分●BP神经网络原理:看书●超参数的确定,并没有理论方法指导,根据经验来选择●BP算法已提出,已可实现多隐含层的神经网络,但实际只使用单隐层节点的浅层模型●计算能力的限制●梯度弥散问题●自编码器●●自编码器(Auto-Encoder)作为一种无监督学习方法网络●将输入“编码”为一个中间代码●然后从中间表示“译码”出输入●通过重构误差和误差反传算法训练网络参数●编码器不关心输出(只复现输入),只关心中间层的编码————ℎ=σ(WX+b)●编码ℎ已经承载原始数据信息,但以一种不同的形式表达!●1●正则编码器——损失函数中加入正则项,常用的正则化有L1正则和L2正则●稀疏自编码器——在能量函数中增加对隐含神经元激活的稀疏性约束,以使大部分隐含神经元处于非激活状态●去噪自编码器——训练数据加入噪声,自动编码器学习去除噪声获得无噪声污染的输入,迫使编码器学习输入信号更加鲁棒的表达●堆叠自编码器●自编码器训练结束后,输出层即可去掉,网络关心的是x到ℎ的变换●将ℎ作为原始信息,训练新的自编码器,得到新的特征表达.●逐层贪婪预训练●1●深度神经网络初始化●●卷积神经网络●全连接不适合图像任务●参数数量太多●没有利用像素之间的位置信息●全连接很难传递超过三层●卷积神经网络是一种前馈神经网络,其输出神经元可以响应部分区域内的输入信息,适宜处理图像类信息●1●1●Zero Padding:在原始图像周围补0数量●卷积尺寸缩小,边缘像素点在卷积中被计算的次数少,边缘信息容易丢失●●卷积神经网络架构发展●1●深度发展●LeNet●具备卷积、激活、池化和全连接等基本组件●但GPU未出现,CPU的性能又极其低下●LetNet只使用在手写识别等简单场景,未得到重视●LeNet主要有2个卷积层(5*5)、2个下抽样层(池化层)、3个全连接层●通过sigmoid激活●全连接层输出:共有10个节点分别代表数字0到9,采用径向基函数作为分类器●AlexNet●第一次采用了ReLU,dropout,GPU加速等技巧●AlexNet网络共有:卷积层 5个(1111,55,3*3),池化层 3个,全连接层3个●首次采用了双GPU并行计算加速模式●第一卷积模块:96通道的特征图被分配到2个GPU中,每个GPU上48个特征图;2组48通道的特征图分别在对应的GPU中进行ReLU激活●第一层全连接:同时采用了概率为0.5的Dropout策略●VGG●通过反复堆叠3x3卷积和2x2的池化,得到了最大19层的深度●卷积-ReLU-池化的基本结构●串联多个小卷积,相当于一个大卷积的思想●使用两个串联的3x3卷积,达到5x5的效果,但参数量却只有之前的18/25●串联多个小卷积,增加ReLU非线性激活使用概率,从而增加模型的非线性特征●VGG16网络包含了13个卷积层,5个池化层和3个全连接层。

深度学习的实验总结(共9篇)

深度学习的实验总结(共9篇)深度学习的实验总结第1篇深度学习和传统机器学习都是机器学习领域的重要分支,但它们在方法和应用上存在明显的区别与独特的优势。

以下是它们之间的主要区别:1. 特征提取与学习:- 传统机器学习:通常依赖于特征工程 (feature engineering),这意味着专家需要人为地对数据进行提炼和清洗,选择或构造最相关的特征来训练模型。

- 深度学习:利用表示学习 (representation learning),机器学习模型自身能够从原始数据中自动学习和提取有用的特征。

这种方法不需要手动选择特征、压缩维度或转换格式。

2. 数据依赖性:- 传统机器学习:通常需要大量的标记数据来训练模型,因为模型的性能很大程度上取决于输入的数据质量。

- 深度学习:对于深度学习,尤其是当使用无监督学习方法时,可以处理大量未标记的数据。

此外,深度网络的多层结构使其能够学习数据的多层次表示。

3. 计算资源:- 传统机器学习:通常需要的计算资源较少,因为它们的模型结构简单。

- 深度学习:由于其复杂的网络结构和大量的参数,深度学习模型通常需要更多的计算资源,如GPU加速。

4. 模型解释性:- 传统机器学习:许多传统的机器学习算法(如决策树、支持向量机等)提供相对较高的模型解释性,因为它们的决策过程往往是直观的。

- 深度学习:深度学习模型,尤其是深层神经网络,通常被视为“黑箱”,因为它们的内部工作机制很难解释。

5. 应用领域:- 传统机器学习:广泛应用于各种领域,如金融、医疗、零售等,其中特征的选择和工程是关键步骤。

- 深度学习:由于其强大的表示学习能力,尤其在图像识别、语音识别和自然语言处理等领域表现出色。

深度学习的实验总结第2篇反向传播算法,全称误差反向传播(Back-propagation, BP)算法,是神经网络发展的重大突破,也是现在众多深度学习训练方法的基础。

它是一种与最优化方法(如梯度下降法)结合使用的,用来训练人工神经网络的常见方法。

DeepLearning论文翻译(NatureDeepReview)

DeepLearning论⽂翻译(NatureDeepReview)原论⽂出处:by Yann LeCun, Yoshua Bengio & Geoffrey HintonNature volume521, pages436–444 (28 May 2015)译者:零楚L()这篇论⽂性质为深度学习的综述,原本只是想做做笔记,但找到的翻译都不怎么通顺。

既然要啃原⽂献,索性就做个翻译,尽⼒准确通畅。

转载使⽤请注明本⽂出处,当然实在不注明我也并没有什么办法。

论⽂中⼤量使⽤貌似作者默认术语但⼜难以赋予合适中⽂意义或会造成歧义的词语及其在本⽂中将采⽤的固定翻译有:representation-“特征描述”objective function/objective-“误差函数/误差” 本意该是⽬标函数/评价函数但实际应⽤中都是使⽤的cost function+正则化项作为⽬标函数(参考链接:)所以本⽂直接将其意为误差函数便于理解的同时并不会影响理解的正确性这种量的翻译写下⾯这句话会不会太⾃⼤了点,不过应该也没关系吧。

看过这么多书⾥接受批评指正的谦辞,张宇⽼师版本的最为印象深刻:我⽆意以“⽔平有限”为遁词,诚⼼接受批评指正。

那么,让我们开始这⼀切吧。

Nature Deep Review摘要:深度学习能让那些具有多个处理层的计算模型学习如何表⽰⾼度抽象的数据。

这些⽅法显著地促进了⼀些领域最前沿技术的发展,包括语⾳识别,视觉对象识别,对象检测和如药物鉴定、基因组学等其它很多领域。

深度学习使⽤⼀种后向传播算法(BackPropagation algorithm,通常称为BP算法)来指导机器如何让每个处理层根据它们⾃⾝前⾯的处理层的“特征描述”改变⽤于计算本层“特征描述”的参数,由此深度学习可以发现所给数据集的复杂结构。

深度卷积⽹络为图像、视频、语⾳和⾳频的处理领域都带来了突破,⽽递归⽹络(或更多译为循环神经⽹络)则在处理⽂本、语⾳等序列数据⽅⾯展现出潜⼒。

李宏毅深度学习笔记-半监督学习

李宏毅深度学习笔记-半监督学习半监督学习什么是半监督学习?⼤家知道在监督学习⾥,有⼀⼤堆的训练数据(由input和output对组成)。

例如上图所⽰x r是⼀张图⽚,y r是类别的label。

半监督学习是说,在label数据上⾯,有另外⼀组unlabeled的数据,写成x u (只有input没有output),有U笔ublabeled的数据。

通常做半监督学习的时候,我们常见的情景是ublabeled的数量远⼤于labeled的数量(U>>R)。

半监督学习可以分成两种:⼀种叫做转换学习,ublabeled 数据就是testing set,使⽤的是testing set的特征。

另⼀种是归纳学习,不考虑testing set,学习model的时候不使⽤testing set。

unlabeled数据作为testing set,不是相当于⽤到了未来数据吗?⽤了label 才算是⽤了未来数据,⽤了testing set的特征就不算是使⽤了未来数据。

例如图⽚,testing set的图⽚特征是可以⽤的,但是不能⽤label。

什么时候使⽤转换学习或者归纳学习?看testing set是不是给你了,在⼀些⽐赛⾥,testing set给你了,那么就可以使⽤转换学习。

但在真正的应⽤中,⼀般是没有testing set的,这时候就只能做归纳学习。

为什么使⽤半监督学习?缺有lable的数据,⽐如图⽚,收集图⽚很容易,但是标注label很困难。

半监督学习利⽤未标注数据做⼀些事。

对⼈类来说,可能也是⼀直在做半监督学习,⽐如⼩孩⼦会从⽗母那边做⼀些监督学习,看到⼀条狗,问⽗亲是什么,⽗亲说是狗。

之后⼩孩⼦会看到其他东西,有狗有猫,没有⼈会告诉他这些动物是什么,需要⾃⼰学出来。

为什么半监督学习有⽤?假设现在做分类任务,建⼀个猫和狗的分类器。

有⼀⼤堆猫和狗的图⽚,这些图⽚没有label。

Processing math: 100%假设只考虑有label的猫和狗图⽚,要画⼀个边界,把猫和狗训练数据集分开,可能会画⼀条如上图所⽰的红⾊竖线。

强化学习7——DeepQ-Learning(DQN)公式推导

强化学习7——DeepQ-Learning(DQN)公式推导上篇⽂章介绍了价值函数逼近(Value Function Approximation,VFA)的理论,本篇⽂章介绍⼤名⿍⿍的DQN算法。

DQN算法是DeepMind 团队在2015年提出的算法,对于强化学习训练苦难问题,其开创性的提出了两个解决办法,在atari游戏上都有不俗的表现。

论⽂发表在了 Nature 上,此后的⼀些DQN相关算法都是在其基础上改进,可以说是打开了深度强化学习的⼤门,意义重⼤。

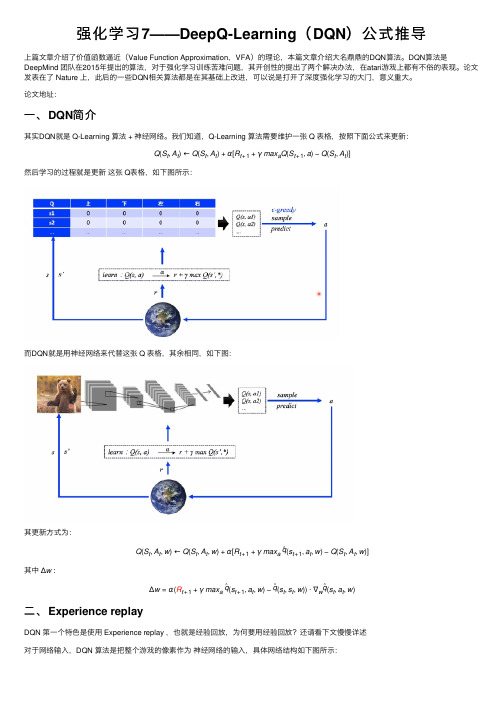

论⽂地址:⼀、DQN简介其实DQN就是 Q-Learning 算法 + 神经⽹络。

我们知道,Q-Learning 算法需要维护⼀张 Q 表格,按照下⾯公式来更新:Q(S t,A t)←Q(S t,A t)+α[R t+1+γmax a Q(S t+1,a)−Q(S t,A t)]然后学习的过程就是更新这张 Q表格,如下图所⽰:⽽DQN就是⽤神经⽹络来代替这张 Q 表格,其余相同,如下图:其更新⽅式为:Q(S t,A t,w)←Q(S t,A t,w)+α[R t+1+γmax aˆq(s t+1,a t,w)−Q(S t,A t,w)]其中 Δw :Δw=α(R t+1+γmax aˆq(s t+1,a t,w)−ˆq(s t,s t,w))⋅∇wˆq(s t,a t,w)⼆、Experience replayDQN 第⼀个特⾊是使⽤ Experience replay ,也就是经验回放,为何要⽤经验回放?还请看下⽂慢慢详述对于⽹络输⼊,DQN 算法是把整个游戏的像素作为神经⽹络的输⼊,具体⽹络结构如下图所⽰:第⼀个问题就是样本相关度的问题,因为在强化学习过程中搜集的数据就是⼀个时序的玩游戏序列,游戏在像素级别其关联度是⾮常⾼的,可能只是在某⼀处特别⼩的区域像素有变化,其余像素都没有变化,所以不同时序之间的样本的关联度是⾮常⾼的,这样就会使得⽹络学习⽐较困难。

[鱼书笔记]深度学习入门:基于Python的理论与实现个人笔记分享

![[鱼书笔记]深度学习入门:基于Python的理论与实现个人笔记分享](https://img.taocdn.com/s3/m/0157d41d77c66137ee06eff9aef8941ea76e4be7.png)

[鱼书笔记]深度学习⼊门:基于Python的理论与实现个⼈笔记分享为了完成毕设, 最近开始⼊门深度学习.在此和⼤家分享⼀下本⼈阅读鱼书时的笔记,若有遗漏,欢迎斧正!若转载请注明出处!⼀、感知机感知机(perceptron)接收多个输⼊信号,输出⼀个信号。

如图感知机,其接受两个输⼊信号。

其中θ为阈值,超过阈值神经元就会被激活。

感知机的局限性在于,它只能表⽰由⼀条直线分割的空间,即线性空间。

多层感知机可以实现复杂功能。

⼆、神经⽹络神经⽹络由三部分组成:输⼊层、隐藏层、输出层1. 激活函数激活函数将输⼊信号的总和转换为输出信号,相当于对计算结果进⾏简单筛选和处理。

如图所⽰的激活函数为阶跃函数。

1) sigmoid 函数sigmoid函数是常⽤的神经⽹络激活函数。

其公式为:h(x)=11+e−x如图所⽰,其输出值在 0到 1 之间。

2) ReLU 函数ReLU(Rectified Linear Unit)函数是最近常⽤的激活函数。

3) tanh 函数2. 三层神经⽹络的实现该神经⽹络包括:输⼊层、2 个隐藏层和输出层。

def forward(network, x): # x为输⼊数据# 第1个隐藏层的处理,点乘加上偏置后传⾄激活函数a1 = np.dot(x, W1) + b1z1 = sigmoid(a1)# 第2个隐藏层的处理a2 = np.dot(z1, W2) + b2z2 = sigmoid(a2)#输出层处理 identidy_function原模原样输出a3a3 = np.dot(z2, W3) + b3y = identify_function(a3)return y # y为最终结果3. 输出层激活函数⼀般来说,回归问题选择恒等函数,分类问题选择softmax函数。

softmax函数的公式:y k=e a k ∑n i=1e a i假设输出层有n个神经元,计算第k个神经元的输出y k。

深度学习中的正则化方法与技巧

深度学习中的正则化方法与技巧深度学习作为一种强大的机器学习技术,已经在许多领域取得了重大的突破。

然而,由于其模型参数数量庞大,容易出现过拟合等问题。

为了解决这些问题,正则化方法和技巧在深度学习中显得尤为重要。

一、 L1 和 L2 正则化L1正则化通过在损失函数中添加参数向量的绝对值之和,以促使模型稀疏化,可以减少特征的维度。

而L2正则化通过在损失函数中添加参数向量的平方之和,以抑制参数的值过大,防止过拟合。

两种正则化方法可以结合使用,以进一步提高模型的泛化能力。

二、 DropoutDropout是一种简单而有效的正则化方法,通过在训练过程中随机丢弃一部分神经元的输出,从而减少神经元之间的依赖关系,防止模型过拟合。

该方法在深度学习中得到了广泛应用。

三、批标准化批标准化是一种对神经网络中每一层的输入进行标准化的方法,可以减少网络内部协变量偏移,加快模型的收敛速度,提高模型的泛化能力。

批标准化也可以看作是一种正则化方法,它使得网络更加稳定,减少了过拟合的可能性。

四、 Early StoppingEarly Stopping是一种简单而有效的正则化技巧,通过在训练过程中监控验证集的误差,当验证集误差不再下降时停止训练,从而防止模型出现过拟合的现象。

五、数据增强数据增强是一种通过对训练数据进行一系列随机变换,从而扩大训练数据集的方法。

数据增强可以有效地提高模型的泛化能力,防止过拟合。

六、参数共享参数共享是一种通过在神经网络的不同层之间共享参数,从而减少模型的参数数量,提高模型的泛化能力的方法。

参数共享可以有效地减少过拟合的风险,同时提高模型的训练效率。

七、噪声注入噪声注入是一种通过向输入数据或者网络参数中添加随机噪声的方法,可以有效地抑制模型的过拟合现象。

噪声注入可以增加模型的鲁棒性,提高其泛化能力。

八、深度监督深度监督是一种通过在神经网络的中间层添加额外的损失函数,从而引导网络更快地学习特征,减少过拟合的风险。

深度学习面试基本知识

深度学习面试基本知识深度学习是机器学习的一个分支,它通过建立多层神经网络模型来模拟人类的神经系统,从而实现对数据的学习和分析。

在深度学习领域,掌握一些基本知识是进行面试的必备条件。

本文将介绍一些深度学习面试中常见的基本知识点。

1. 神经网络基础神经网络是深度学习的核心模型,它由多个神经元组成,每个神经元接收来自上一层神经元的输入,并将输入通过激活函数处理后传递给下一层神经元。

常见的神经网络结构包括前馈神经网络(Feedforward Neural Network)和循环神经网络(Recurrent Neural Network)等。

在面试中,你可能需要了解以下几个与神经网络相关的知识点:1.1 激活函数激活函数是神经网络中的一种非线性函数,它的作用是引入非线性因素,增加网络的表示能力。

常见的激活函数有Sigmoid函数、ReLU函数和Tanh函数等。

你需要理解这些激活函数的定义、特点以及适用场景。

1.2 损失函数损失函数用于衡量神经网络输出与真实值之间的差异,是深度学习中的一个重要概念。

常见的损失函数有均方误差(Mean Squared Error)和交叉熵(Cross Entropy)等。

你需要了解这些损失函数的定义、优缺点以及适用场景。

1.3 反向传播算法反向传播算法是训练神经网络的核心算法,它通过计算损失函数对网络参数的导数,从而根据梯度下降的原理进行参数更新。

你需要了解反向传播算法的基本原理,包括链式法则和梯度计算方法。

2. 卷积神经网络(CNN)卷积神经网络是深度学习中用于处理图像和语音等二维数据的重要模型。

它通过卷积、池化和全连接等操作来提取输入数据的特征,并进行分类或回归预测。

在面试中,你可能需要了解以下几个与卷积神经网络相关的知识点:2.1 卷积层卷积层是卷积神经网络的核心组件,它通过滑动窗口的方式对输入数据进行卷积操作,从而提取特征信息。

你需要了解卷积层的基本原理、参数设置以及卷积核的作用。

深度学习理论及实战读书随笔

《深度学习理论及实战》读书随笔一、深度学习概述在我研读《深度学习理论及实战》这本书的过程中,对深度学习的理解有了更加清晰全面的认识。

深度学习是一种机器学习的方法,它的核心是构建复杂的神经网络结构来模拟人脑的学习过程。

它不同于传统的机器学习方法,更多地侧重于对原始数据的复杂性和非线性的表征学习。

深度学习模型能够从大量的数据中自动提取有用的特征,进而实现对复杂数据的精准建模和预测。

这种强大的能力使得深度学习在语音识别、图像识别、自然语言处理等领域取得了巨大的成功。

在深度学习的世界里,神经网络扮演着至关重要的角色。

这些网络结构通常由大量的神经元组成,通过训练过程调整神经元之间的连接权重,使得网络能够从输入数据中学习并生成有效的输出。

随着技术的发展,深度学习的网络结构日趋复杂,如卷积神经网络(CNN)、循环神经网络(RNN)、生成对抗网络(GAN)等,这些网络结构的应用极大地推动了深度学习在各个领域的突破和发展。

深度学习的成功离不开大数据的支持,随着数据量的增长,深度学习模型能够学习到更多的数据特征和规律,从而提高预测的准确性。

计算力的提升也为深度学习的快速发展提供了可能,通过强大的计算设备,我们能够训练更大规模的神经网络,实现更复杂的任务。

深度学习的应用前景十分广阔,不仅在计算机视觉、自然语言处理等领域取得了显著的成果,而且在医疗、金融、自动驾驶等新兴领域也展现出了巨大的潜力。

随着技术的不断进步和研究的深入,深度学习的未来将更加广阔。

深度学习是一种强大的机器学习技术,它通过构建复杂的神经网络结构来模拟人脑的学习过程,具有强大的数据表征能力和预测能力。

它的应用领域广泛,前景广阔。

在我后续的阅读和实践中,我将更深入地探索深度学习的原理、方法和应用,以期在这个领域取得更多的收获和进步。

1.1 定义及基本概念随着信息技术的飞速发展,深度学习(Deep Learning)作为机器学习的一个子领域,逐渐崭露头角。

深度学习的基础知识

深度学习的基础知识深度学习(Deep Learning)是一种基于人工神经网络的机器学习方法,它模拟人类大脑的结构和功能,通过多层次的非线性处理单元对数据进行特征提取和建模,从而实现对复杂问题的学习和推断。

深度学习在语音识别、图像识别、自然语言处理和推荐系统等领域取得了广泛的应用和突破,成为了当今人工智能领域的热点之一。

本文将从深度学习的基本原理、常见模型和应用实例等方面介绍深度学习的基础知识,帮助读者深入了解深度学习的相关内容。

一、深度学习的基本原理深度学习模型的核心是人工神经网络(Artificial Neural Networks,ANNs),它由大量的神经元(Neurons)和连接它们的权重(Weights)组成,每个神经元接收来自前一层神经元的输入,并对其进行加权和非线性变换后输出给下一层神经元。

整个网络通过多层次的非线性处理单元逐层组合,形成了深度结构,从而能够学习到更加复杂的特征和模式。

1.神经元的工作原理神经元是人工神经网络的基本组成单元,它模拟了生物神经元的工作原理。

每个神经元接收来自前一层神经元的多个输入信号,通过加权和非线性变换后输出给下一层神经元。

具体来说,神经元的输入经过加权和求和后,再经过一个激活函数(Activation Function)进行非线性变换,最终输出给下一层神经元。

常用的激活函数包括Sigmoid函数、ReLU函数和tanh函数等。

2.神经网络的训练人工神经网络通过学习来调整连接权重,使得网络能够适应输入数据的特征和模式。

网络的训练通常采用梯度下降法(Gradient Descent)。

具体来说,网络先进行前向传播,将输入数据通过每层神经元的加权和非线性变换后输出给输出层,然后计算输出层的预测值与真实标签值的误差,最后通过反向传播算法将误差逐层传递回去,调整每个神经元的权重。

3.深度学习的优化深度学习模型通常会面临的问题包括梯度消失和梯度爆炸等。

为了解决这些问题,人们提出了许多优化方法,如Batch Normalization、Dropout和Residual Network等。

机器学习算法与Python实践之(四)支持向量机(SVM)实现 - zouxy09的专栏 - 博客频道 - CSDN

7月推荐文章汇总 得下载分

Android 精彩案例

【独具慧眼 推荐有礼】找出您心中的技术大牛

博文大赛获奖名单公布

关注社区微信

机器学习算法与Python实践之(四)支持向量机(SVM)实现

分类: 机器学习 C/C++编程

2013-12-13 00:12 8407人阅读 评论(15) 收藏 举报

机器学习算法与Python实践之(四)支持向量机(SVM)实现 zouxy09@

最里面语句的意思是固定除αi之外的所有αj(i不等于j),这时W可看作只是关于αi的函 数,那么直接对αi求导优化即可。这里我们进行最大化求导的顺序i是从1到m,可以通过更 改优化顺序来使W能够更快地增加并收敛。如果W在内循环中能够很快地达到最优,那么 坐标上升法会是一个很高效的求极值方法。

用个二维的例子来说明下坐标下降法:我们需要寻找f(x,y)=x2+xy+y2的最小值处的(x*, y*),也就是下图的F*点的地方。

Opencv是下载的源码 然后自己 编译的 运行tld时老是显示

假设要求解下面的优化问题:

capture devi...

机器学习中的范数规则化之(一)L0、L1与L2范数

xyy19920105: 博主大牛啊,这个

内容是挺充分的,只是有些东西

看的感觉有些不对啊.....望博主回 头没事多看看,改掉些...

/zouxy09

访问: 1164586次 积分: 10428分 排名: 第380名

原创: 108篇 转载: 11篇 译文: 1篇 评论: 1823条

个人简介 广州 华南理工大学 研二。 关注:机器学习、计算机视觉、 人机交互和人工智能等领域。 邮箱:zouxy09@ 微博:Erik-zou

深度学习笔记(3)神经网络,学习率,激活函数,损失函数

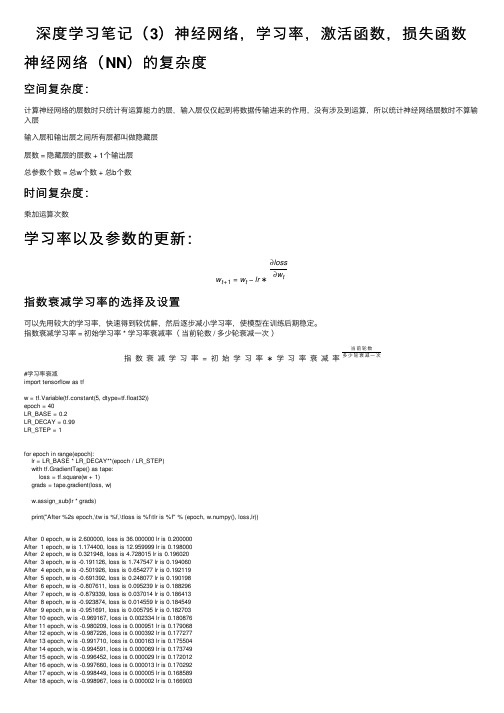

深度学习笔记(3)神经⽹络,学习率,激活函数,损失函数神经⽹络(NN)的复杂度空间复杂度:计算神经⽹络的层数时只统计有运算能⼒的层,输⼊层仅仅起到将数据传输进来的作⽤,没有涉及到运算,所以统计神经⽹络层数时不算输⼊层输⼊层和输出层之间所有层都叫做隐藏层层数 = 隐藏层的层数 + 1个输出层总参数个数 = 总w个数 + 总b个数时间复杂度:乘加运算次数学习率以及参数的更新:w t+1=w t−lr∗∂loss ∂w t指数衰减学习率的选择及设置可以先⽤较⼤的学习率,快速得到较优解,然后逐步减⼩学习率,使模型在训练后期稳定。

指数衰减学习率 = 初始学习率 * 学习率衰减率(当前轮数 / 多少轮衰减⼀次)指数衰减学习率=初始学习率∗学习率衰减率当前轮数多少轮衰减⼀次#学习率衰减import tensorflow as tfw = tf.Variable(tf.constant(5, dtype=tf.float32))epoch = 40LR_BASE = 0.2LR_DECAY = 0.99LR_STEP = 1for epoch in range(epoch):lr = LR_BASE * LR_DECAY**(epoch / LR_STEP)with tf.GradientTape() as tape:loss = tf.square(w + 1)grads = tape.gradient(loss, w)w.assign_sub(lr * grads)print("After %2s epoch,\tw is %f,\tloss is %f\tlr is %f" % (epoch, w.numpy(), loss,lr)) After 0 epoch, w is 2.600000, loss is 36.000000 lr is 0.200000After 1 epoch, w is 1.174400, loss is 12.959999 lr is 0.198000After 2 epoch, w is 0.321948, loss is 4.728015 lr is 0.196020After 3 epoch, w is -0.191126, loss is 1.747547 lr is 0.194060After 4 epoch, w is -0.501926, loss is 0.654277 lr is 0.192119After 5 epoch, w is -0.691392, loss is 0.248077 lr is 0.190198After 6 epoch, w is -0.807611, loss is 0.095239 lr is 0.188296After 7 epoch, w is -0.879339, loss is 0.037014 lr is 0.186413After 8 epoch, w is -0.923874, loss is 0.014559 lr is 0.184549After 9 epoch, w is -0.951691, loss is 0.005795 lr is 0.182703After 10 epoch, w is -0.969167, loss is 0.002334 lr is 0.180876After 11 epoch, w is -0.980209, loss is 0.000951 lr is 0.179068After 12 epoch, w is -0.987226, loss is 0.000392 lr is 0.177277After 13 epoch, w is -0.991710, loss is 0.000163 lr is 0.175504After 14 epoch, w is -0.994591, loss is 0.000069 lr is 0.173749After 15 epoch, w is -0.996452, loss is 0.000029 lr is 0.172012After 16 epoch, w is -0.997660, loss is 0.000013 lr is 0.170292After 17 epoch, w is -0.998449, loss is 0.000005 lr is 0.168589After 19 epoch, w is -0.999308, loss is 0.000001 lr is 0.165234After 20 epoch, w is -0.999535, loss is 0.000000 lr is 0.163581After 21 epoch, w is -0.999685, loss is 0.000000 lr is 0.161946After 22 epoch, w is -0.999786, loss is 0.000000 lr is 0.160326After 23 epoch, w is -0.999854, loss is 0.000000 lr is 0.158723After 24 epoch, w is -0.999900, loss is 0.000000 lr is 0.157136After 25 epoch, w is -0.999931, loss is 0.000000 lr is 0.155564After 26 epoch, w is -0.999952, loss is 0.000000 lr is 0.154009After 27 epoch, w is -0.999967, loss is 0.000000 lr is 0.152469After 28 epoch, w is -0.999977, loss is 0.000000 lr is 0.150944After 29 epoch, w is -0.999984, loss is 0.000000 lr is 0.149434After 30 epoch, w is -0.999989, loss is 0.000000 lr is 0.147940After 31 epoch, w is -0.999992, loss is 0.000000 lr is 0.146461After 32 epoch, w is -0.999994, loss is 0.000000 lr is 0.144996After 33 epoch, w is -0.999996, loss is 0.000000 lr is 0.143546After 34 epoch, w is -0.999997, loss is 0.000000 lr is 0.142111After 35 epoch, w is -0.999998, loss is 0.000000 lr is 0.140690After 36 epoch, w is -0.999999, loss is 0.000000 lr is 0.139283After 37 epoch, w is -0.999999, loss is 0.000000 lr is 0.137890After 38 epoch, w is -0.999999, loss is 0.000000 lr is 0.136511After 39 epoch, w is -0.999999, loss is 0.000000 lr is 0.135146激活函数sigmoid 函数tf.nn. sigmoid(x)f (x )=11+e−x图像:相当于对输⼊进⾏了归⼀化多层神经⽹络更新参数时,需要从输出层往输⼊层⽅向逐层进⾏链式求导,⽽sigmoid 函数的导数输出是0到0.25之间的⼩数,链式求导时,多层导数连续相乘会出现多个0到0.25之间的值连续相乘,结果将趋近于0,产⽣梯度消失,使得参数⽆法继续更新且sigmoid 函数存在幂运算,计算⽐较复杂tanh 函数tf.math. tanh(x)f (x )=1−e −2x1+e−2x图像:和上⾯提到的sigmoid 函数⼀样,同样存在梯度消失和幂运算复杂的缺点Relu 函数tf.nn.relu(x)f (x )=max (x ,0)=0(x <0)时或者x (x >=0)时图像:Relu 函数在正区间内解决了梯度消失的问题,使⽤时只需要判断输⼊是否⼤于0,计算速度快训练参数时的收敛速度要快于sigmoid 函数和tanh 函数输出⾮0均值,收敛慢Dead RelU 问题:送⼊激活函数的输⼊特征是负数时,激活函数输出是0,反向传播得到的梯度是0,致使参数⽆法更新,某些神经元可能永远不会被激活。

(完整版)DeepLearning(深度学习)学习笔记整理系列

Deep Learning(深度学习)学习笔记整理系列目录:一、概述二、背景三、人脑视觉机理四、关于特征4.1、特征表示的粒度4.2、初级(浅层)特征表示4.3、结构性特征表示4.4、需要有多少个特征?五、Deep Learning的基本思想六、浅层学习(Shallow Learning)和深度学习(Deep Learning)七、Deep learning与Neural Network八、Deep learning训练过程8.1、传统神经网络的训练方法8.2、deep learning训练过程九、Deep Learning的常用模型或者方法9.1、AutoEncoder自动编码器9.2、Sparse Coding稀疏编码9.3、Restricted Boltzmann Machine(RBM)限制波尔兹曼机9.4、Deep BeliefNetworks深信度网络9.5、Convolutional Neural Networks卷积神经网络十、总结与展望十一、参考文献和Deep Learning学习资源接上注:下面的两个Deep Learning方法说明需要完善,但为了保证文章的连续性和完整性,先贴一些上来,后面再修改好了。

9.3、Restricted Boltzmann Machine (RBM)限制波尔兹曼机假设有一个二部图,每一层的节点之间没有链接,一层是可视层,即输入数据层(v),一层是隐藏层(h),如果假设所有的节点都是随机二值变量节点(只能取0或者1值),同时假设全概率分布p(v,h)满足Boltzmann 分布,我们称这个模型是Restricted BoltzmannMachine (RBM)。

下面我们来看看为什么它是Deep Learning方法。

首先,这个模型因为是二部图,所以在已知v的情况下,所有的隐藏节点之间是条件独立的(因为节点之间不存在连接),即p(h|v)=p(h1|v)…p(h n|v)。

深度学习 总结

深度学习总结深度学习是一种机器学习的技术,通过构建和训练深度神经网络,从大规模数据中自动学习和提取特征。

深度学习在近年来取得了显著的突破,广泛应用于计算机视觉、自然语言处理、语音识别等领域,对人工智能的发展产生了重要影响。

首先,深度学习的核心原理是神经网络。

神经网络是由神经元和神经元之间的连接组成的,通过构建多层神经元网络,可以模拟人脑的工作方式。

深度学习的特点就是构建了多层深层神经网络,通过反向传播算法对网络参数进行训练,从而实现对复杂模式的学习和分类。

其次,深度学习的优势在于对大规模数据的处理能力。

深度学习需要大量的数据进行训练,通过训练大规模数据来提取特征并建立模型。

这种数据驱动的特点使得深度学习在图像识别、语音识别等领域取得了突破性的进展。

例如,在图像识别方面,深度学习算法可以通过大量的图像数据来学习特征,并在未知图像中进行准确的识别。

再次,深度学习可以自动提取特征。

与传统的机器学习算法需要手动特征提取不同,深度学习可以通过训练数据自动学习特征。

这种特点使得深度学习在处理高维数据和复杂问题时更具优势。

例如,在自然语言处理方面,传统方法需要手动设计特征来表示文本信息,而深度学习可以通过训练数据自动学习词向量等特征,从而提高文本处理的效果。

此外,深度学习还具有高度的扩展性和灵活性。

深度学习模型可以通过增加网络的深度和宽度来增加模型的容量,从而提高模型的性能。

同时,深度学习模型还可以通过改变网络结构、激活函数等方式进行优化,以适应不同的任务需求。

这种灵活性使得深度学习在不同领域和问题中都能取得较好的效果。

总的来说,深度学习是一种强大的机器学习技术,通过构建和训练深度神经网络,从大规模数据中自动学习和提取特征。

它的优势在于对大规模数据的处理能力、自动特征提取的能力,以及高度的扩展性和灵活性。

随着硬件计算能力的提升和算法的不断改进,深度学习在人工智能领域的应用前景将更加广阔。

基于深度强化学习的移动机器人路径规划研究

基于深度强化学习的移动机器人路径规划研究目录1. 内容概括 (3)1.1 研究背景 (4)1.2 研究意义 (4)1.3 研究现状 (5)1.4 研究内容与方法 (7)2. 相关理论基础 (8)2.1 深度学习概述 (9)2.2 强化学习基础 (10)2.3 路径规划概述 (12)2.4 移动机器人技术 (13)3. 移动机器人路径规划问题 (15)3.1 路径规划的类型 (17)3.2 移动机器人的移动模型 (17)3.3 环境感知与地图构建 (19)3.4 障碍物和动态障碍的考虑 (20)4. 深度强化学习方法 (22)5. 移动机器人路径规划算法设计 (23)5.1 问题建模 (24)5.2 强化学习环境的设置 (26)5.3 神经网络的架构设计 (28)5.4 奖励函数的设计 (30)5.5 多层感知器和卷积神经网络在路径规划中的应用 (31)6. 实验设计与仿真验证 (32)6.1 实验环境与平台 (34)6.2 实验设置 (35)6.3 仿真结果分析 (37)6.4 对比分析 (38)7. 性能评估与优化 (39)7.1 性能指标 (40)7.2 优化算法 (42)7.3 实验数据的收集与分析 (44)7.4 泛化能力与鲁棒性 (45)8. 案例研究 (47)8.1 实际应用场景 (48)8.2 案例分析 (49)8.3 难点与解决方案 (50)9. 结论与展望 (52)9.1 研究成果总结 (53)9.2 存在问题 (54)9.3 未来研究方向 (56)1. 内容概括简要介绍移动机器人路径规划的重要性、现有技术局限性以及引入深度强化学习可能带来的改进。

强调这项研究对于推动机器人技术和人工智能领域的交叉融合具有重要意义。

阐述本研究的总体目标,包括设计一个适合移动机器人路径规划的深度强化学习模型,以及开发相应的算法来实现有效的环境探索、避障、导航等功能。

研究的目标还将涉及评估所提出的算法在复杂环境下的性能,并与传统路径规划方法作比较,以证明其优越性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Deep Learning(深度学习)学习笔记整理系列

目录:

一、概述

二、背景

三、人脑视觉机理

四、关于特征

4.1、特征表示的粒度

4.2、初级(浅层)特征表示

4.3、结构性特征表示

4.4、需要有多少个特征?

五、Deep Learning的基本思想

六、浅层学习(Shallow Learning)和深度学习(Deep Learning)

七、Deep learning与Neural Network

八、Deep learning训练过程

8.1、传统神经网络的训练方法

8.2、deep learning训练过程

九、Deep Learning的常用模型或者方法

9.1、AutoEncoder自动编码器

9.2、Sparse Coding稀疏编码

9.3、Restricted Boltzmann Machine(RBM)限制波尔兹曼机

9.4、Deep BeliefNetworks深信度网络

9.5、Convolutional Neural Networks卷积神经网络

十、总结与展望

十一、参考文献和Deep Learning学习资源

接上

注:下面的两个Deep Learning方法说明需要完善,但为了保证文章的连续性和完整性,先贴一些上来,后面再修改好了。

9.3、Restricted Boltzmann Machine (RBM)限制波尔兹曼机

假设有一个二部图,每一层的节点之间没有链接,一层是可视层,即输入数据层(v),一层是隐藏层(h),如果假设所有的节点都是随机二值变量节点(只能取0或者1值),同时假设全概率分布p(v,h)满足Boltzmann 分布,我们称这个模型是Restricted BoltzmannMachine (RBM)。

下面我们来看看为什么它是Deep Learning方法。

首先,这个模型因为是二部图,所以在已知v的情况下,所有的隐藏节点之间是条件独立的(因为节点之间不存在连接),即p(h|v)=p(h1|v)…p(h n|v)。

同理,在已知隐藏层h的情况下,所有的可视节点都是条件独立的。

同时又由于所有的v和h满足Boltzmann 分布,因此,当输入v的时候,通过p(h|v) 可以得到隐藏层h,而得到隐藏层h之后,通过p(v|h)又能得到可视层,通过调整参数,我们就是要使得从隐藏层得到的可视层v1与原来的可视层v如果一样,那么得到的隐藏层就是可视层另外一种表达,

因此隐藏层可以作为可视层输入数据的特征,所以它就是一种Deep Learning方法。

如何训练呢?也就是可视层节点和隐节点间的权值怎么确定呢?我们需要做一些数学分析。

也就是模型了。

联合组态(jointconfiguration)的能量可以表示为:

而某个组态的联合概率分布可以通过Boltzmann 分布(和这个组态的能量)来确定:

因为隐藏节点之间是条件独立的(因为节点之间不存在连接),即:

然后我们可以比较容易(对上式进行因子分解Factorizes)得到在给定可视层v的基础上,隐层第j个节点为1或者为0的概率:

同理,在给定隐层h的基础上,可视层第i个节点为1或者为0的概率也可以容易得到:

给定一个满足独立同分布的样本集:D={v(1), v(2),…,v(N)},我们需要学习参数θ={W,a,b}。

我们最大化以下对数似然函数(最大似然估计:对于某个概率模型,我们需要选择一个参数,让我们当前的观测样本的概率最大):

也就是对最大对数似然函数求导,就可以得到L最大时对应的参数W了。

如果,我们把隐藏层的层数增加,我们可以得到Deep Boltzmann Machine(DBM);如果我们在靠近可视层的部分使用贝叶斯信念网络(即有向图模型,当然这里依然限制层中节点之间没有链接),而在最远离可视层的部分使用Restricted Boltzmann Machine,我们可以得到DeepBelief Net(DBN)。

9.4、Deep Belief Networks深信度网络

DBNs是一个概率生成模型,与传统的判别模型的神经网络相对,生成模型是建立一个观察数据和标签之间的联合分布,对

P(Observation|Label)和P(Label|Observation)都做了评估,而判别模型仅仅而已评估了后者,也就是P(Label|Observation)。

对于在深度神经网络应用传统的BP算法的时候,DBNs遇到了以下问题:

(1)需要为训练提供一个有标签的样本集;

(2)学习过程较慢;

(3)不适当的参数选择会导致学习收敛于局部最优解。

DBNs由多个限制玻尔兹曼机(Restricted Boltzmann Machines)层组成,一个典型的神经网络类型如图三所示。

这些网络被“限制”为一个可视层和一个隐层,层间存在连接,但层内的单元间不存在连接。

隐层单元被训练去捕捉在可视层表现出来的高阶数据的相关性。

首先,先不考虑最顶构成一个联想记忆(associative memory)的两层,一个DBN的连接是通过自顶向下的生成权值来指导确定的,RBMs就像一个建筑块一样,相比传统和深度分层的sigmoid信念网络,它能易于连接权值的学习。

最开始的时候,通过一个非监督贪婪逐层方法去预训练获得生成模型的权值,非监督贪婪逐层方法被Hinton证明是有效的,并被其称为对比分歧(contrastive divergence)。

在这个训练阶段,在可视层会产生一个向量v,通过它将值传递到隐层。

反过来,可视层的输入会被随机的选择,以尝试去重构原始的输入信号。

最后,这些新的可视的神经元激活单元将前向传递重构隐层激活单元,获得h(在训练过程中,首先将可视向量值映射给隐单元;然后可视单元由隐层单元重建;这些新可视单元再次映射给隐单元,这样就获取新的隐单元。

执行这种反复步骤叫做吉布斯采样)。

这些后退和前进的步骤就是我们熟悉的Gibbs采样,而隐层激活单元和可视层输入之间的相关性差别就作为权值更新的主要依据。

训练时间会显著的减少,因为只需要单个步骤就可以接近最大似然学习。

增加进网络的每一层都会改进训练数据的对数概率,我们可以理解为越来越接近能量的真实表达。

这个有意义的拓展,和无标签数据的使用,是任何一个深度学习应用的决定性的因素。

在最高两层,权值被连接到一起,这样更低层的输出将会提供一个参考的线索或者关联给顶层,这样顶层就会将其联系到它的记忆内容。

而我们最关心的,最后想得到的就是判别性能,例如分类任务里面。

在预训练后,DBN可以通过利用带标签数据用BP算法去对判别性能做调整。

在这里,一个标签集将被附加到顶层(推广联想记忆),通过一个自下向上的,学习到的识别权值获得一个网络的分类面。

这个性能会比单纯的BP算法训练的网络好。

这可以很直观的解释,DBNs 的BP算法只需要对权值参数空间进行一个局部的搜索,这相比前向神经网络来说,训练是要快的,而且收敛的时间也少。

DBNs的灵活性使得它的拓展比较容易。

一个拓展就是卷积DBNs (Convolutional Deep Belief Networks(CDBNs))。

DBNs并没有考虑到图像的2维结构信息,因为输入是简单的从一个图像矩阵一维向量化的。

而CDBNs就是考虑到了这个问题,它利用邻域像素的空域关系,通过一个称为卷积RBMs的模型区达到生成模型的变换不变性,而且可以容易得变换到高维图像。

DBNs并没有明确地处理对观察变量的时间联系的学习上,虽然目前已经有这方面的研究,例如堆叠时间RBMs,以此为推广,有序列学习的dubbed temporal convolutionmachines,这种序列学习的应用,给语音信号处理问题带来了一个让人激动的未来研究方向。

目前,和DBNs有关的研究包括堆叠自动编码器,它是通过用堆叠自动编码器来替换传统DBNs里面的RBMs。

这就使得可以通过同样的规则来训练产生深度多层神经网络架构,但它缺少层的参数化的严格要求。

与DBNs不同,自动编码器使用判别模型,这样这个结构就很难采样输入采样空间,这就使得网络更难捕捉它的内部表达。

但是,降噪自动编码器却能很好的避免这个问题,并且比传统的DBNs更优。

它通过在训练过程添加随机的污染并堆叠产生场泛化性能。

训练单一的降噪自动编码器的过程和RBMs训练生成模型的过程一样。