SAS Logistic回归:一个完整例子

SAS软件应用之Logistic回归分析

些

ln

1

p

p

值都可以和在大于

0

小于

1

范围内的

P

值相对

应。统计学中,常把ln

1

p

p

称为

Logit

变换。

Logistic 回归方程:

ln 1

p

p

=

0 1 x1 n xn ,

而且有:

( 0 1x1 n xn )

p 1e e ( 0 1x1 n xn )

Logistic 模型中系数的意义:

以一个最简单的Logistic回归模型做为例子。

——————————————————————————

使用过

未使用过

合计

——————————————————————————

病例

55

128

183

对照

19

164

183

——————————————————————

合计

74

293

366

——————————————————————————

每个格子中的样本例数太少)

❖定量资料需要分组,信息丢失 ❖不能对因素作用大小进行定量分析

(交互作用)

y

二、Logistic 回归原理 0 1

y = log2x

经过数理统计学家证明:把疾病概率 P 转换成

ln

1

p

p

,会使该回归方程的统计性能更好一些。而且,

在经过转换以后,

ln 1

p

p

的值域为-∞到+∞,而且这

使用过雌激素相对于未使用过雌激素的比值比为: OR (odds ratio) = 2.895 / 0.781 = 3.709

logistic回归分析案例

logistic回归分析案例Logistic回归分析案例。

Logistic回归分析是一种常用的统计分析方法,主要用于预测二分类或多分类的结果。

在实际应用中,Logistic回归分析可以帮助我们理解影响某一事件发生的因素,以及对事件发生的概率进行预测。

本文将通过一个实际的案例来介绍Logistic回归分析的应用。

案例背景。

假设我们是一家电商公司的数据分析师,现在我们需要分析用户的购买行为,并预测用户是否会购买某一产品。

我们收集了一些用户的个人信息和他们最近一次购买的产品,希望通过这些数据来预测用户是否会购买新产品。

数据准备。

首先,我们需要收集用户的个人信息和购买行为数据。

个人信息包括年龄、性别、职业等;购买行为数据包括购买的产品类型、购买时间等。

在收集完数据后,我们需要对数据进行清洗和预处理,包括缺失值处理、异常值处理等。

模型建立。

在数据准备完成后,我们可以开始建立Logistic回归模型。

首先,我们需要将数据划分为训练集和测试集,以便对模型进行验证。

然后,我们可以利用训练集来拟合Logistic回归模型,并利用测试集来评估模型的预测效果。

模型评估。

在模型建立完成后,我们需要对模型进行评估。

常用的评估指标包括准确率、精确率、召回率等。

这些指标可以帮助我们判断模型的预测效果,并对模型进行调优。

模型应用。

最后,我们可以利用建立好的Logistic回归模型来预测用户是否会购买新产品。

通过输入用户的个人信息和购买行为数据,模型可以给出用户购买新产品的概率,从而帮助我们进行精准营销和推广。

结论。

通过以上实例,我们可以看到Logistic回归分析在预测用户购买行为方面具有很好的应用价值。

通过收集用户数据、建立模型、评估模型和应用模型,我们可以更好地理解用户行为,并做出更精准的预测和决策。

总结。

Logistic回归分析是一种强大的统计工具,可以帮助我们预测二分类或多分类的结果。

在实际应用中,我们可以根据具体情况收集数据、建立模型,并利用模型进行预测和决策。

sas案例分析

sas案例分析SAS案例分析。

SAS(Statistical Analysis System)是一种统计分析系统,它提供了强大的数据分析和数据管理功能,广泛应用于商业、医疗、金融等领域。

本文将通过一个实际案例,介绍SAS在数据分析中的应用。

案例背景。

某公司想要了解其销售业绩与市场环境的关系,以制定更科学的销售策略。

为了达到这一目的,他们收集了过去几年的销售数据以及市场环境的相关指标,希望通过数据分析找出其中的规律,并进行预测。

数据准备。

首先,我们需要对收集到的数据进行清洗和整理。

这些数据包括销售额、销售量、市场份额、市场规模、竞争对手数据等。

在SAS中,我们可以通过数据步骤和PROC SQL来完成数据的清洗和整理工作,确保数据的质量和准确性。

数据分析。

接下来,我们可以利用SAS进行数据分析。

首先,我们可以通过描述性统计分析来了解各个变量的分布情况,包括平均值、标准差、最大最小值等。

然后,我们可以利用相关性分析来探索不同变量之间的关系,找出销售业绩与市场环境的相关性。

在SAS中,我们可以使用PROC CORR来进行相关性分析,并通过相关系数来衡量变量之间的相关程度。

模型建立。

在了解了各个变量之间的关系后,我们可以利用SAS来建立预测模型。

常用的预测模型包括线性回归、逻辑回归、时间序列分析等。

通过这些模型,我们可以预测未来的销售业绩,为公司制定销售策略提供参考依据。

结果解释。

最后,我们需要对模型的结果进行解释和评估。

在SAS中,我们可以利用PROC REG、PROC LOGISTIC等过程来进行模型的拟合和评估,得到模型的参数估计、显著性检验、预测能力等指标。

通过这些指标,我们可以评估模型的有效性,并对结果进行解释,为公司决策提供支持。

结论与建议。

通过对销售数据的分析,我们可以得出销售业绩与市场环境存在一定的相关性,市场规模、竞争对手数据等因素对销售业绩有一定影响。

基于这些分析结果,我们可以向公司提出一些建议,包括加大市场推广力度、优化产品结构、加强竞争对手分析等,以提升销售业绩。

SAS Logistic回归:一个完整例子

10.7057 3 0.0134

Step 1. Effect vision entered:

Model Convergence Status

Convergence criterion (GCONV=1E-8) satisfied. Model Fit Statistics Criterion Intercept Only Intercept and Covariates AIC 63.827 59.244 SC 65.633 62.857 -2 Log L 61.827 55.244

NOTE: No (additional) effects met the 0.05 significance level for entry into the model.

(2) 给出了自变量进入模型的次序。先是截距项 Step 0 了,不管它。Step 1 vision 第一个进入模型,附带了很多评估它对因变量预测能力的指标。-2 Log L 和 Score 用来检测自变量是否显著。-2 Log L 中的 L 就是 Likelihood Ratio,它 的 p 值是 0.0103,Score 的 p 值是 0.0113,都小于 0.05,故 vision 是一个很 显著的解释变量。还有,AIC(Akaike Information Criterion)和 SC(Schwarz Criterion)两个信息量标准用来比较不同的模型,它们数值越小,模型变现就越 好,这个接下来我们看 step2 drive 变量进入模型后的情况。 我们可以看到模 型的表现变好了,因为这是 AIC 和 SC 的值变小了,-2 Log L 和 Score 对应的 p 值也更小。

SAS软件应用之Logistic回归分析文件材料

目录

• Logistic回归分析简介 • SAS软件介绍 • Logistic回归分析在SAS中的实现 • 案例分析 • 结论与展望

01 Logistic回归分析简介

定义与特点

定义

Logistic回归分析是一种用于解决二 分类问题的统计方法,通过建立自变 ຫໍສະໝຸດ 与因变量的逻辑关系来预测分类结 果。

$beta_0, beta_1, beta_2, ..., beta_n$为模型的参数;

$X_1, X_2, ..., X_n$为自变量 。

02 SAS软件介绍

SAS软件概述

SAS(Statistical Analysis System) 软件是由美国北卡罗来纳大学于1966 年开发的统计分析工具,现已成为全 球领先的数据分析和统计分析软件之 一。

数据挖掘

03

SAS的数据挖掘功能可以帮助用户发现数据中的模式和关联,进

行预测和决策支持。

SAS软件的优势与局限性

优势

SAS功能强大,可处理大规模数据集,提供多种统计分析方法,支持多种操作系统,具有高度可定制 性。

局限性

SAS的学习曲线较陡峭,需要专业的培训和经验才能充分发挥其功能,同时价格较高,可能不适合小 型企业和个人用户。

模型拟合

使用SAS的LOGISTIC过程对模型进行拟合,选择合 适的模型类型和分析选项。

模型评估

通过诊断图、统计量和交叉验证等方法评估模型的性 能和预测能力。

结果解读

系数解释

解释模型中自变量的估计系数和显著性水平,分 析其对因变量的影响程度和方向。

预测能力

根据模型预测结果与实际结果的对比,评估模型 的预测准确性和可靠性。

saslogistic逻辑回归

如前所述,逻辑回归是一种用于解决 二元分类问题的机器学习算法,基于 逻辑函数拟合数据来预测事件发生的 概率。它在处理具有连续特征的数据 集时表现良好,并且可以用于预测概 率。

比较

支持向量机和逻辑回归在处理分类问 题时各有优缺点。SVM的优点在于其 强大的分类能力和对高维数据的处理 能力,尤其在处理线性可分的数据集 时表现优秀。而逻辑回归在处理具有 连续特征的数据集和预测概率方面表 现良好,且对于非线性数据集的处理 能力较强。

与决策树算法的比较

决策树算法

决策树算法是一种基于树的机器学习算法,通过递归地将数据集划分为更小的子集来构建 模型。它能够处理分类和回归问题,并且易于理解和解释。

逻辑回归

逻辑回归是一种用于解决二元分类问题的机器学习算法。它基于逻辑函数,通过拟合数据 来预测事件发生的概率。逻辑回归在处理具有连续特征的数据集时表现良好,并且可以用 于预测概率。

比较

决策树算法和逻辑回归在处理分类问题时各有优缺点。决策树算法可以处理更复杂的数据 集,但可能过拟合数据。逻辑回归在处理具有连续特征的数据集时表现良好,并且可以用 于预测概率,但可能不适用于具有大量特征的数据集。

与支持向量机算法的比较

支持向量机算法

逻辑回归

支持向量机(SVM)是一种监督学习 算法,用于分类和回归分析。它通过 找到能够将不同类别的数据点最大化 分隔的决策边界来实现分类。SVM对 于非线性数据集的处理能力有限,且 对于大规模数据集可能效率较低。

通过将自变量代入逻辑函数中,可以得到因变量的预测概率值,进而判断 其所属类别。

02 SASlogistic逻辑回归的 实现

SASlogistic逻辑回归的步骤

数据准备

对数据进行清洗、整理和转换, 确保数据的质量和可用性。

logistic回归例题

logistic回归例题Logistic回归是一种线性分类器,针对的是线性可分问题。

以下是使用Logistic 回归进行分类的一个简单例子:假设我们有一个数据集,其中包含一个人的年龄、收入和信用评分。

我们的目标是预测这个人是否会违约。

首先,我们需要收集数据。

假设我们有100个人的数据,其中50人违约,50人没有违约。

我们可以将这些数据分为训练集和测试集,例如80%的数据用于训练集,20%的数据用于测试集。

接下来,我们需要将数据转换为数值形式,以便在计算机中处理。

我们可以将年龄和收入作为特征,将是否违约作为目标变量。

我们可以将年龄和收入的值标准化或归一化,以便它们在同一尺度上。

然后,我们可以使用Logistic回归模型来拟合数据。

在这个例子中,Logistic 回归模型的公式如下:\(\ln\frac{P}{1 - P} = \alpha + \beta_1 \cdot X_1 + \beta_2 \cdot X_2\)其中\(P\)表示这个人违约的概率,\(\alpha\)和\(\beta_1\)和\(\beta_2\)是待估计的参数,\(X_1\)和\(X_2\)分别是年龄和收入的值。

通过最大似然估计等优化方法,我们可以估计出\(\alpha\)、\(\beta_1\)和\(\beta_2\)的值。

一旦我们得到了这些值,我们就可以使用它们来预测新数据点的违约概率。

最后,我们可以使用测试集来评估模型的性能。

我们可以计算模型的准确率、召回率、F1得分等指标,以评估模型的分类性能。

这个例子仅仅是一个简单的Logistic回归应用,实际上它可以应用于更复杂的问题,例如医学诊断、金融欺诈检测、推荐系统等。

SAS Logistic回归程序代码和输出结果

[SAS] Logistic回归程序代码和输出结果基于贝叶斯判别的房地产信用评级研究本文首先采用Logistic回归法筛选出4个财务指标作为评价函数的计量参数,再构造Bayes判别算法建立信用评估模型,将其应用于某些房地产企业的实际数据分析,并评估其评判效果。

程序代码data LOGIT;input g x1-x10 @@ ; /* 输入数据和对应的变量名称,指定数据是按顺序对应变量(@@) */cards;1 76.02 112.16 52.65 16.24 4.17 88.54 -1.93 98.07 -58.63 -1.931 50.15 53.55 6.18 5.81 0.77 6.91 5.89 105.89 18.21 5.891 35.94 8.04 0.25 12.89 0.04 11.54 0.25 100.25 3.56 0.252 36.03 65.44 5.07 4.71 0.77 -4.21 2.42 102.42 47.27 2.422 76.95 86.32 -6.38 14.28 -0.51 101.50 -6.18 93.82 34.19 -6.182 36.36 37.91 6.01 10.78 0.87 -11.03 6.20 106.20 43.43 6.202 45.44 46.41 -1.09 14.04 -0.14 82.45 130.53 230.53 -82.56 130.532 48.80 43.19 6.97 11.15 0.94 20.58 8.62 108.62 7.67 8.622 21.09 45.85 6.10 13.79 0.00 32.70 6.86 106.86 -91.48 6.862 26.38 1.14 16.25 7.98 2.26 -31.83 15.26 115.26 63.42 15.262 32.61 26.18 8.51 22.08 1.45 10.71 8.89 108.89 6.14 8.892 25.16 57.63 20.94 23.88 3.44 -0.98 30.46 130.46 60.45 30.462 48.47 39.56 8.23 10.76 1.06 7.67 8.56 108.56 45.65 8.563 52.05 75.95 24.12 13.18 2.50 -7.47 24.90 124.90 18.17 24.903 86.92 14.00 4.55 10.96 0.38 -23.56 -79.83 20.17 36.01 -79.833 39.96 41.87 7.10 12.04 -0.12 8.20 3.24 103.24 5.98 3.241 65.00 29.00 1.50 2.00 0.16 54.55 -0.63 99.37 -58.34 -0.632 66.20 30.52 21.51 23.18 1.77 16.29 23.42 123.42 31.15 23.42…… ……;proc logistic data=LOGIT des; /* 选择Logistic回归模型对这个数据进行分析,对因变量设置des概率 */model g=x1 x2 x3 x4 x5 x6 x7 x8 x9 x10 /selection=stepwise slentry=0.15 slstay=0.15; /* 指定因变量和自变量,逐步选择变量,设置stepwise显著性水平0.15*/run;输出结果SAS 系统 2012年05月26日星期六下午12时31分22秒 1The LOGISTIC ProcedureModel InformationData Set WORK.LOGITResponse Variable gNumber of Response Levels 3Model cumulative logitOptimization Technique Fisher's scoringNumber of Observations Read 48Number of Observations Used 48Response ProfileOrdered TotalValue g Frequency1 3 132 2 313 1 4Probabilities modeled are cumulated over the lower Ordered Values.Stepwise Selection ProcedureStep 0. Intercepts entered:Model Convergence StatusConvergence criterion (GCONV=1E-8) satisfied.-2 Log L = 80.949Residual Chi-Square TestChi-Square DF Pr > ChiSq13.0922 8 0.1087NOTE: No (additional) effects met the 0.05 significance level for entry into the model.Analysis of Maximum Likelihood EstimatesStandard WaldParameter DF Estimate Error Chi-Square Pr > ChiSqIntercept 3 1 -0.9904 0.3248 9.2980 0.0023Intercept 2 1 2.3979 0.5222 21.0830 <.0001SAS 系统2012年05月26日星期六下午12时31分22秒 2The LOGISTIC ProcedureModel InformationData Set WORK.LOGITResponse Variable gNumber of Response Levels 3Model cumulative logitOptimization Technique Fisher's scoringNumber of Observations Read 48Number of Observations Used 48Response ProfileOrdered TotalValue g Frequency1 3 132 2 313 1 4Probabilities modeled are cumulated over the lower Ordered Values.Stepwise Selection ProcedureStep 0. Intercepts entered:Model Convergence StatusConvergence criterion (GCONV=1E-8) satisfied.-2 Log L = 80.949Residual Chi-Square TestChi-Square DF Pr > ChiSq13.0922 8 0.1087Step 1. Effect x4 entered:Model Convergence StatusConvergence criterion (GCONV=1E-8) satisfied.Score Test for the Proportional Odds AssumptionChi-Square DF Pr > ChiSq4.7698 1 0.0290SAS 系统2012年05月26日星期六下午12时31分22秒 3The LOGISTIC ProcedureModel Fit StatisticsInterceptIntercept andCriterion Only CovariatesAIC 84.949 83.246SC 88.691 88.859-2 Log L 80.949 77.246Testing Global Null Hypothesis: BETA=0Test Chi-Square DF Pr > ChiSqLikelihood Ratio 3.7032 1 0.0543Score 3.7112 1 0.0540Wald 3.2133 1 0.0730Residual Chi-Square TestChi-Square DF Pr > ChiSq10.0282 7 0.1870NOTE: No effects for the model in Step 1 are removed.Step 2. Effect x6 entered:Model Convergence StatusConvergence criterion (GCONV=1E-8) satisfied.Score Test for the Proportional Odds AssumptionChi-Square DF Pr > ChiSq5.0078 2 0.0818Model Fit StatisticsInterceptIntercept andCriterion Only CovariatesAIC 84.949 81.703SC 88.691 89.187-2 Log L 80.949 73.703Testing Global Null Hypothesis: BETA=0Test Chi-Square DF Pr > ChiSqLikelihood Ratio 7.2465 2 0.0267Score 6.9374 2 0.0312Wald 6.1144 2 0.0470SAS 系统2012年05月26日星期六下午12时31分22秒 4The LOGISTIC ProcedureResidual Chi-Square TestChi-Square DF Pr > ChiSq7.4184 6 0.2839NOTE: No effects for the model in Step 2 are removed.Step 3. Effect x5 entered:Model Convergence StatusConvergence criterion (GCONV=1E-8) satisfied.Score Test for the Proportional Odds AssumptionChi-Square DF Pr > ChiSq6.0306 3 0.1101Model Fit StatisticsInterceptIntercept andCriterion Only CovariatesAIC 84.949 80.027SC 88.691 89.383-2 Log L 80.949 70.027Testing Global Null Hypothesis: BETA=0Test Chi-Square DF Pr > ChiSqLikelihood Ratio 10.9224 3 0.0122Score 9.5728 3 0.0226Wald 8.8338 3 0.0316Residual Chi-Square TestChi-Square DF Pr > ChiSq3.7605 5 0.5844Step 4. Effect x4 is removed:Model Convergence StatusConvergence criterion (GCONV=1E-8) satisfied.Score Test for the Proportional Odds AssumptionChi-Square DF Pr > ChiSq1.4638 2 0.4810SAS 系统2012年05月26日星期六下午12时31分22秒 5The LOGISTIC ProcedureModel Fit StatisticsInterceptIntercept andCriterion Only CovariatesAIC 84.949 78.987SC 88.691 86.471-2 Log L 80.949 70.987Testing Global Null Hypothesis: BETA=0Test Chi-Square DF Pr > ChiSqLikelihood Ratio 9.9625 2 0.0069Score 8.5919 2 0.0136Wald 8.0936 2 0.0175Residual Chi-Square TestChi-Square DF Pr > ChiSq4.6568 6 0.5885NOTE: No effects for the model in Step 4 are removed.NOTE: No (additional) effects met the 0.15 significance level for entry into the model.Summary of Stepwise SelectionEffect Number Score WaldStep Entered Removed DF In Chi-Square Chi-Square Pr > ChiSq1 x4 1 1 3.7112 0.05402 x6 1 2 3.3464 0.06743 x5 1 3 3.6124 0.05734 x4 1 2 0.9037 0.3418Analysis of Maximum Likelihood EstimatesStandard WaldParameter DF Estimate Error Chi-Square Pr > ChiSqIntercept 3 1 -0.2253 0.4165 0.2927 0.5885Intercept 2 1 3.7752 0.8090 21.7733 <.0001x5 1 -0.7061 0.2951 5.7259 0.0167x6 1 -0.0203 0.00878 5.3502 0.0207Odds Ratio EstimatesPoint 95% WaldEffect Estimate Confidence Limitsx5 0.494 0.277 0.880x6 0.980 0.963 0.997SAS 系统2012年05月26日星期六下午12时31分22秒 6The LOGISTIC ProcedureAssociation of Predicted Probabilities and Observed ResponsesPercent Concordant 72.7 Somers' D 0.459Percent Discordant 26.8 Gamma 0.462Percent Tied 0.5 Tau-a 0.236Pairs 579 c 0.730。

SAS的logistic回归(正式)

模型选择与灵活性

R提供了多种Logistic回归变种,如glm()函数, 且定制性更强。

并行计算与性能

R在并行计算方面有优势,适合处理大规模数据集。

THANKS FOR WATCHING

感谢您的观看

Logistic回归

Logistic回归是一种用于解决分类问题的统计方法。它使用逻辑函数将线性回归 的输出转换为概率,从而可以预测一个事件发生的概率。在Logistic回归中,自 变量可以是连续的或分类的,因变量只能是二元分类结果。

02 Logistic回归基础

定义和原理

定义

Logistic回归是一种用于解决二分类 问题的统计方法,通过构建逻辑函数 来预测事件发生的概率。

泛化能力

模型的泛化能力是指在新数据上的预测性能。为了提高模型 的泛化能力,需要避免过拟合,并确保模型具有足够的代表 性。

外部验证

可以使用独立的验证集对模型进行外部验证,以评估模型的 泛化能力。外部验证可以帮助我们了解模型在实际应用中的 表现。

06 SAS的Logistic回归与其 他软件的比较

与SPSS的比较

结果准误、显著性等。

预测准确度

02

根据模型预测结果与实际结果的对比,评估模型的预测准确度。

模型解释性

03

理解自变量对因变量的影响程度和方向,以及模型的可解释性。

04 案例分析

数据来源和预处理

数据来源

本案例所使用的数据集来源于某大型银行的历史客户数据。数据集包含了客户的基本信息、信用历史、收入状况、 贷款申请信息等。

数据转换

对分类变量进行适当的编码,如将分类变量转换 为虚拟变量。

3

数据探索

了解数据的分布和特征,为后续建模提供依据。

logistic回归分析

控制饮酒因素后, 吸烟与不吸烟相比 患食管癌的优势比 为2.4倍

exp(0.5261) OR 1.6923

OR的可信区间估计

吸烟与不吸烟患食管癌OR的95%可信区间:

exp(b1 u /2Sb1 ) exp(0.8856 1.960.15) (1.81,3.25)

2. 优势比(OR)及可信区间的估计

OR e

❖ 如X=1,0两分类,则OR的1-α可信区间估计公式

e(bj u / 2Sbj )

S 为回归系数 bj 的标准误

(公式16-10)

例:讲义表16-1资料

一个研究吸烟、饮酒与食道癌关系的病例-对照资料 (886例),试作logistic回归分析。

❖ 变量的赋值

2.模型中参数的意义

ln P 1 P

=

0

1 X 1

Β0(常数项):暴露因素Xi=0时,个体发病 概率与不发病概率之比的自然对数比值。

ln

P(y 1/ x 1 P(y 0 /

x

0) 0)

=

0

与Xii=0的相含比义,:发某生危某险结因果素(,如暴发露病水)平优变势化比时的,对即数X值i=。1

2.两值因变量的logistic回归模型方程

❖ 一个自变量与Y关系的回归模型 如:y:发生=1,未发生=0 x : 有=1,无=0, 记为p(y=1/x)表示某暴露因素状态下,结果y=1

的概率(P)模型。

或

P(

y

1/

x)

e0 x 1 e0 x

1

p(y 1/ x)

1 exp[(0 x)]

模型描述了应变量p与x的关系

P( y

0/ x

SAS多重logistic回归..

输出标准化 偏回归系数

17

Summary of Stepwise Selection Ste p 1 2 Effect Entere d vision drive Remove d D F 1 1 Numbe Score r ChiIn Square 1 2 6.4209 4.8680 Wald ChiSquare Pr > ChiS q 0.0113 0.0274

0.0585

0.0584

0.9432

0.9433

这是两种拟合 优度检验的方 法。P>0.05说 明模型对资料 总体上拟合效 果好

Model Fit Statistics

Criterion

AIC SC

Without Covariates

62.383 62.383

With Covariates

54.329 57.942

1

1 0 0 0 0 0 0 0 0 0

55

75 35 42 57 28 20 38 45 47 52

0

1 0 1 0 0 0 1 0 1 0

0

1 1 1 0 1 1 0 1 1 0

27

28 29 30 31 32 33 34 35 36 37

0

0 0 0 0 0 0 0 0 1 1

40

55 68 25 17 45 44 67 55 61 19

accident

2 binary logit Fisher's scoring 45 45

二值logit模型

参数估计时 的优化方法

Response Profile Ordere d Value 1 2 acciden t 1 0 Total Frequenc y 25 20

图文举例详细讲解Logistic曲线的回归分析

图文举例详细讲解L o g i s t i c曲线的回归分析 This manuscript was revised by the office on December 10, 2020.Logistic曲线的回归分析例某一品种玉米高度与时间(生长周期,每个生长周期为2-3天,与气温有关)的数据如表1.所示。

用转化为线性方程的方法估计其logistic曲线预测模型。

设最大值k为300(cm)。

表1. 玉米高度与时间(生长周期)的关系时间(生长周期)高度/cm 时间(生长周期)高度/cm时间(生长周期)高度/cm1 2 3 4 5 6 7 8 9 10 110.670.851.281.752.272.753.694.716.367.739.911213141516171819202112.7516.5520.127.3532.5537.5544.7553.3871.6183.892223242526272829303197.46112.7135.1153.6160.3167.1174.9177.9180.2180.83.1 基本绘图操作在Excel中输入时间x与高度y的数据。

选择插入->图表图87点击图表,选择“标准类型”中的xy散点图,并点击子图表类型的第一个。

图88点击下一步,得到如图89。

图 89点击下一步。

图90分别点击标题、网格线、图例进行修改,然后点击下一步。

图91点击完成。

图92右击绘图区,修改绘图区格式,双击做表格,修改坐标轴刻度,最后的散点图。

图93观察散点图,其呈S型曲线,符合logistic曲线。

采用转化为线性方程的方法求解模型。

3.2 Logistic曲线方程及线性化Logistic曲线方程为:1atk y me-=+ (12)(1) 将数据线性化及成图转化为线性方程为:01'y a a t =+ (13)其中,'ln(/1)y k y =-,0ln a m =,1a a =-具体操作为:向excel 表格中输入y ’数据。

用SAS作回归分析

其中 S (Yˆi )

第i个观测的预测值的标准差,

是为了把数据标准化。其中Dffits越大越好,

D是different和fit的缩写说明,

第i个观测的预测值 用排除第i个观测的回归对第i个观测的预测值 p 为模型中参数的个数, n 为样本容量

回归诊断

识别有影响的观测

Proc REG 的 Model语句加选项 r 可获得 Cook D 统计量

利用余差可以考 察余差和预测值 的 散 点 图{

重要工具

也可以检验余差

分布的正态性

1.

回归诊2断.

模型合 适

3.

应改曲 线模型

不等方 差

4.

观测值 不独立

单击此处添加标题

回

归

诊

生成余差

单击此处添加标题

断

在PROC REG的model语句加上选项 p,

就

会

输出预测值和相应的余差

单击此处添加标题

PROC

RUN;

回归诊断 识别有影响 的观测

Cook D统计量度量一个观测从分析中 剔除 时参数估计值的变化

对一个观测值其 Cook D 统计量的值 超 过 4/n 时(n为样本容量),这个观测存 在 反常效应,

其中4/n只是经验,没有统一的标准。

回归诊断 识别有影响 的观测

Yˆi

Yˆ Dffitsi 度量第i 个观测对预

Predict Value 预测值

PROC REG DATA=数据集名 ; MODEL 应变量=自变量/r;

Std Err Predict 预测值标准差RUN;

Residual

余差

Std Err Predict 余差标准差

logistic 回归的例子

logistic 回归的例子

Logistic回归是一种广义线性回归(generalized linear model),其因变量是二分类的分类变量或某事件的发生率,并且是数值型变量。

下面是一个简单的例子:

假设我们有一组数据,其中包含两组人群的特征,例如年龄、性别、饮食习惯、幽门螺杆菌感染等。

我们将这两组人群标记为胃癌组和非胃癌组。

通过Logistic回归分析,我们可以得到每个特征的权重,从而了解哪些特征是胃癌的危险因素。

具体来说,Logistic回归模型的公式为:

p = 1 / (1 + e^(-z))

其中,z = w'x + b,w和b是待求参数,x是特征向量,w是权重向量。

通过最大似然估计法,我们可以求解出w和b的值。

然后,我们可以将权重向量w与特征向量x相乘,再加上偏置项b,得到z值。

最后,将z值代入Logistic函数中,得到每个样本属于胃癌组的概率p值。

在上述例子中,我们假设数据集是平衡的,即两组人群的数量大致相等。

如果数据集不平衡,我们可以通过增加样本数量、采用过采样技术、采用加权Logistic回归等方法来解决。

另外,Logistic回归模型的适用条件包括:因变量为二分类的分类变量或某事件的发生率;自变量和因变量之间存在线性关系;各观测对象间相互独立等。

需要注意的是,Logistic回归模型的应用需要具备一定的统计

学基础和专业知识,并且在实际应用中需要考虑到数据的分布、特征的选取、模型的评估等多个方面。

因此,在进行Logistic回归分析时,需要结合实际情况和具体问题进行分析和处理。

SAS 中Logistic回归方法的正确应用及结果的正确解释

Logistic回归方法的正确应用及结果的正确解释金水高(中国疾病预防控制中心,北京,100050)Logistic回归是研究当因变量为二分变量时,因变量与自变量关系的常用方法,自80年代初引入国内后,随着计算机技术的发展,统计软件的日益成熟而得到了十分广泛的应用。

但是并不是所有的研究者对于Logistic回归的方法都能正确使用,对结果都能正确解释。

近年来文献中经常出现对方法错用、误用及对结果的错误解释的现象。

本文仅就在使用Logistic方法时经常出现的错误进行探讨。

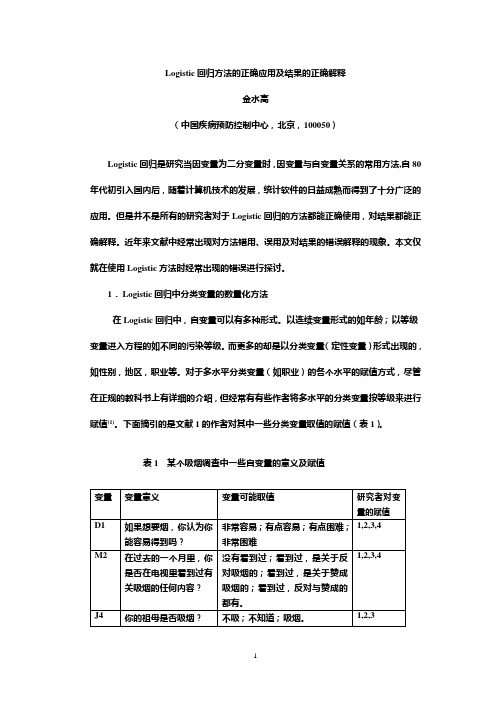

1.Logistic回归中分类变量的数量化方法在Logistic回归中,自变量可以有多种形式。

以连续变量形式的如年龄;以等级变量进入方程的如不同的污染等级。

而更多的却是以分类变量(定性变量)形式出现的,如性别,地区,职业等。

对于多水平分类变量(如职业)的各个水平的赋值方式,尽管在正规的教科书上有详细的介绍,但经常有有些作者将多水平的分类变量按等级来进行赋值(1)。

下面摘引的是文献1的作者对其中一些分类变量取值的赋值(表1)。

表1 某个吸烟调查中一些自变量的意义及赋值作者将第一个变量不同水平赋为具有等级关系的四个值,虽然比较勉强,还可以接受,因为变量的四个取值确实存在程度的差异(但为什麽相邻之间都相差1,这就没有太多的道理了)。

而对后面的两个变量(M2及J4)的不同水平也赋予具有等级关系的值,而且相邻之间都相差1,那就没有任何道理了。

因为变量M2是询问调查对象是否在电视中看到过有关吸烟的内容,人们对这个问题给出的答案显然并不存在任何量上的程度差别。

对这类自变量的赋值应该采取数量化的方法。

通常建议的数量化方法为设臵哑变量。

例如对于上面的M2,有4种可能回答,则要设臵3个哑变量,假设为M21,M22,M23。

将每一种可能回答(水平)用一组哑变量的取值来表述(表2)。

从表2可以看到,用M21,M22及M23同时等于0表示没有在电视里看到过有关吸烟方面的任何内容;而用M21=1,M22及M23均为0表示在电视里看到过关于吸烟的内容,等等。

Logistic回归分析SAS实现

复习:

医学研究者经常关心的问题

哪些因素导致了人群中有的人患胃癌而有的人不患胃癌? 哪些因素导致了手术后有的人感染,而有的人不感染? 哪些因素导致了某种治疗方法出现治愈、显效、好转、无效等不

同的效果?

是回归分析问题: Y=f(x)

复习:

回归分析的分类

一个 因变 量y

连续型因变量 (y) --- 线性回归分析 分类型因变量 (y) ---Logistic 回归分析 生存时间因变量 (t) ---生存风险回归分析 时间序列因变量 (t) ---时间序列分析

log

it(

p)

In

p 1

p

0.9099+0.8856x1

0.5261x2

用编程法作二分类logisitc回归

Proc logistic data=sasuser.eg9_1 descend; freq f; model y=x1 x2 /selection=stepwise sle=0.05 sls=0.05;

态分析; 等方差 Equal variance:指自变量的取值不同时,因变量Y的总体变异保

持不变(用总体方差 2 表示)。

复习:

回归分析的分类

一个 因变 量y

连续型因变量 (y) --- 线性回归分析 分类型因变量 (y) ---Logistic 回归分析 生存时间因变量 (t) ---生存风险回归分析 时间序列因变量 (t) ---时间序列分析

多个因变量 (y1,y2…yk)

路径分析 结构方程模型分析

复习:

线性回归分析

研究一个正态随机变量Y与一个或多个自变量X1,X2,X3,…,Xm 间的 线性关系。其回归方程为:Yˆ b0 b1X1 b2 X2 bmXm

SAS学习系列26.Logistic回归

26. Logistic回归(一)Logistic回归一、原理二元或多元线性回归的因变量都是连续型变量,若因变量是分类变量(例如:患病与不患病;不重要、重要、非常重要),就需要用Logistic回归。

Logistic回归分析可以从统计意义上估计出在其它自变量固定不变的情况下,每个自变量对因变量取某个值的概率的数值影响大小。

Logistic回归模型有“条件”与“非条件”之分,前者适用于配对病例对照资料的分析,后者适用于队列研究或非配对的病例-对照研究成组资料的分析。

对于二分类因变量,y=1表示事件发生;y=0表示事件不发生。

事件发生的条件概率P{ y=1 | x i } 与x i之间是非线性关系,通常是单调的,即随着x i的增加/减少,P{ y=1 | x i } 也增加/减少。

Logistic函数F(x)=1,图形如下图所示:1+e−x该函数值域在(0,1)之间,x 趋于-∞时,F(x )趋于0;x 趋于+∞时,F(x )趋于1. 正好适合描述概率P{ y =1 | x i }. 例如,某因素x 导致患病与否:x 在某一水平段内变化时,对患病概率的影响较大;而在x 较低或较高时对患病概率影响都不大。

记事件发生的条件概率P{ y =1 | x i } = p i ,则p i =11+e −(α+βx i )=e α+βx i 1+e α+βx i记事件不发生的条件概率为1- p i =11+e α+βx i则在条件x i 下,事件发生概率与事件不发生概率之比为p i 1−p i= e α+βx i称为事件的发生比,简记为odds. 对odds 取自然对数得到ln (p i1−p i)= α+βx i 上式左边(对数发生比)记为Logit(y), 称为y 的Logit 变换。

可见变换之后的Logit(y)就可以用线性回归,计算出回归系数α和β值。

若分类因变量y 与多个自变量x i 有关,则变换后Logit(y)可由多元线性回归:11logit()ln()1k k pp x x p αββ==++-或 111()1(1|,,)1k k k x x p y x x eαββ-++==+二、回归参数的解释1. 三个名词发生比(odds)= 事件发生频数事件未发生频数= p k1−p k例如,事件发生概率为0.6,不发生概率为0.4,则发生比为1.5(发生比>1,表示事件更可能发生)。

逻辑回归例子

逻辑回归例子逻辑回归例子【篇一:逻辑回归例子】1.logit回归本期将会大家介绍逻辑回归,虽然逻辑回归并不复杂,但正是由于其简单,高效,可解释性强的特点,在实际用途中十分的广泛,从购物预测到用户营销响应,从流失分析到信用评价,都能看到其活跃的身影,可以说,逻辑回归占据了分类算法中非常重要的地位。

回想在上一期中,我们谈到当因变量与自变量的关系式不再是线性时,通过引入衍生变量y’,使其转换为线性表达形式。

那么很自然地,对于我们现在面临的任务,我们就需要一个转换,使得分类变量0和1转化为可用的形式。

先考虑一个二分类的预测变量,正如前面所说的,显然由于分类数据的特点,已经不适合运用传统的线性函数进行分析。

但是二分类事件的y的期望值e(y)来说,它等价于事件发生概率,从y到e(y),我们就把事件发生与否与值域在[0,1]区间的事件发生概率相联系,这提示我们可以用事件发生的概率进行代替。

既然使用发生概率代替的话,一个自然而然的选择是把回归函数的值域限制在[0,1]区间内,这样当f(xi)接近负无穷时,将有e( yi)趋近于0,而在f(xi)接近正无穷时,将有e(yi )趋近于1,这样看来,显然相比于研究二元变量y与x的关系,研究y发生的条件概率与x 更具适应性。

在没有任何先验条件的情况下,这里的阈值一般选择0.5。

但当我们有进一步明确需求的时候,阈值也是可以调整的,例如我们希望对正例样本有更高的准确率要求,则可以把阈值适当地调高,例如调高到0.6;相反,假如我们希望对正例样本的召回率要求更高,则可以把阈值适当地降低,例如降低到0.4;一般地,我们选择logit函数作为转换函数,logit函数的形式:logit函数图像是一个典型的s型的曲线,并且它的值域是在[0,1]之间进一步地,我们利用logit函数,可以把事件发生的条件概率与x 表示为同样,我们也可以定义一个事件不发生的概率为:为了更显简洁,不妨作如下转换:上式左边实际上就是表示“事件发生的概率”与“事件不发生的概率”之比,称之为事件的发生比,简称odds。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

前三行,首先 data 步,建立一个叫 logistic 的临时数据集,它在 work 临时文 件夹里。一般推荐用记事本把程序保存起来;input 语句表示一下是几个变量; 从 datalines 开始就一行一行输入数据,每个单独的数据之间用空格隔开,每个 观测值各占一行。需要注意的是,datalines 和下面的数据之间不要有空行,否

(1) The SAS System 10:47 Tuesday, May 4, 2007 1

The LOGISTIC Procedure

Model Information

Data Set WORK.LOGISTIC Response Variable accident Number of Response Levels 2 Number of Observations 45 Model binary logit Optimization Technique Fisher’s scoring

Step 2. Effect drive entered: Model Convergence Status Convergence criterion (GCONV=1E-8) satisfied.

Model Fit Statistics Criterion Intercept Only Intercept and Covariates AIC 63.827 56.287 SC 65.633 61.707 -2 Log L 61.827 50.287

Chi-Square DF Pr > ChiSq

10.7057 3 0.0134

Step 1. Effect vision entered:

Model Convergence Status

Convergence criterion (GCONV=1E-8) satisfied. Model Fit Statistics Criterion Intercept Only Intercept and Covariates AIC 63.827 59.244 SC 65.633 62.857 -2 Log L 61.827 55.244

2. SAS OnlineDoc V8, 或者 SAS OnlineDoc V9, 是要花功夫熟悉它们的结 构了。以前我四处下载了数 G 的电子书,现在才发觉还是它们好使。体例 上 V8 和 V9 一样,你找到 SAS/STAT–>SAS/STAT User’s Guide–>The LOGISTIC Procedure, 就可以跟着学习了,文字都非常简明。

*/

proc logistic data=logistic descending; model accident=age vision drive / selection=forward;run;

—————————————————————————————————— ———————-

用上面这个过程步乙替代过程步甲,再运行一遍。这两个过程步的输出结果大同 小异,只是过程步乙多了个 forward 选项。以下用的是过程步乙的输出结果,其 中黑体字是输出结果本身,我做的注释语句以红笔描出,包括数字编号。

(2) Forward Selection Procedure

Step 0. Intercept entered:

Model Convergence Status

Convergence criterion (GCONV=1E-8) satisfied.

Residual Chi-Square Test

NOTE: No (additional) effects met the 0.05 significance level for entry into the model.

(2) 给出了自变量进入模型的次序。先是截距项 Step 0 了,不管它。Step 1 vision 第一个进入模型,附带了很多评估它对因变量预测能力的指标。-2 Log L 和 Score 用来检测自变量是否显著。-2 Log L 中的 L 就是 Likelihood Ratio,它 的 p 值是 0.0103,Score 的 p 值是 0.0113,都小于 0.05,故 vision 是一个很 显著的解释变量。还有,AIC(Akaike Information Criterion)和 SC(Schwarz Criterion)两个信息量标准用来比较不同的模型,它们数值越小,模型变现就越 好,这个接下来我们看 step2 drive 变量进入模型后的情况。 我们可以看到模 型的表现变好了,因为这是 AIC 和 SC 的值变小了,-2 Log L 和 Score 对应的 p 值也更小。

Logistic 回归处理因变量是分类型变量如“0、1”的情形。一下就假设你至少 对它模模糊糊有些印象,比如说我们用 p 表示正例(如输出变量为“1”)的概 率,那么 p/(1-p)就被称作 odds ratio,对 p 做 logit 变换记做 logit(p),它等 于 log(p/(1-p),我们回归方程的形式就如 logit(p)=log(p/(1-p)=a+bx,你可以 把它理解成向量形式。

则 SAS 会认为出现了一个缺失值。数据输入完毕,以分号结束,这个分号一定要 另起一行。

*/

data logistic; input accident age vision drive; datalines; 1 17 1 1 1 44 0 0 1 48 1 0 1 55 0 0 1 75 1 1 0 35 0 1 0 42 1 1 0 57 0 0 0 28 0 1 0 20 0 1 0 38 1 0 0 45 0 1 0 47 1 1 0 52 0 0 0 55 0 1 1 68 1 0 1 18 1 0 1 68 0 0 1 48 1 1 1 17 0 0 1 70 1 1 1 72 1 0 1 35 0 1 1 19 1 0 1 62 1 0 0 39 1 1 0 40 1 1 0 55 0 0 0 68 0 1 0 25 1 0 0 17 0 0 0 45 0 1 0 44 0 1 0 67 0 0 0 55 0 1 1 61 1 0

1.forward——前向选择,变量一个个进入回归方程,按照一些卡方标准,最显 著的也就是最好的变量最先进入,然后就是次最好的,以此类推。某个变量一旦 进入,就不再退出;

2.backward——后向剔除,一开始全部变量都进入回归方程,又按照一些标准, 把最不好的变量一一剔除;

3.stepwise——逐步回归,这个跟 forward 有些类似,不同的是,stepwise 在 变量进入以后还有一个 backward 后向剔除的过程,而在 forward 里,变量一旦 进入,就不再退出。

Response Profile Ordered Value accident Total Frequency

1 1 25 2 0 20

Probability modeled is accident=1.

(1) 给出了本模型的基本信息,意思大多自明。需要注意的是 Response Profile 中,accident=1 排在首位。前面我们说过,SAS 的 Logistic 回归方程 log(odds) 默认的形式是处理那个变量值比较小的,加上 descending 选项后,accident=1 就排在首位了。

SAS Logistic 回归:代码及输出报告详解

这篇将作为五一后一个讲稿的阅读材料之一,先整出来就搁这。如果没有耐心读 下去,你可以立即转到以下的参考资料,该篇所有的知识都来自它们:

1. Cody, R.F. and Smith, J.K. Applied Statistics and the SAS Programming Language,4th ed..NJ: Prentice-Hall,1997.这书已经出第 五版了,北大图书馆只有这第四版。非常容易上手的一本书,前半部分用 input 和 datalines 让读者专心做统计,后半部分从导入导出数据开始阐 述 SAS 的通用编程语言。这本书用的是 SAS8.这里我们只关注它第九章 Multiple-Regression Analysis 的最后 Logistic Regression 部分。我 这篇的例子即来于此,有简化;

*/

proc logistic data=logistic descending; model accident=age vision drive; run;

/*

运行以上程序,就要跑出一大堆结果了。但在处理多元回归时,语句很难得会只 像过程步甲一样简洁。以下过程步乙只加入一个变量选择选项 forward。SAS 在 处理自变量选择上采用了 5 个技术,这里只简单提一下 3 个常用的技术。

(3) Summary of Forward Selection Step Effect DF Number In Score Chi-Square Pr > ChiSq 1 vision 1 1 6.4209 0.0113 2 drive 1 2 4.8680 0.0274

(3) 总结了我们模型使用的前向选择方法,包括自变量进入模型的次序,以及每 个自变量的卡方值和 p 值。

Testing Global Null Hypothesis: BETA=0 Test Chi-Square DF Pr > ChiSq Likelihood Ratio 6.5830 1 0.0103 Score 6.4209 1 0.0113 Wald 6.0756 1 0.0137

Residual Chi-Square Test Chi-Square DF Pr > ChiSq 4.9818 2 0.0828

Testing Global Null Hypothesis: BETA=0 Test Chi-Square DF Pr > ChiSq Likelihood Ratio 11.5391 2 0.0031 Score 10.5976 2 0.0050 Wald 8.5949 2 0.0136