开源日志系统比较

Java日志收集与分析:使用Logstash、Elasticsearch和Kibana进行日志处理

Java日志收集与分析:使用Logstash、Elasticsearch和Kibana进行日志处理引言:在现代软件开发中,日志记录是一项至关重要的任务。

通过记录应用程序的运行时信息和错误,我们可以更好地了解应用程序的行为和性能。

然而,随着应用程序规模的增长,日志数据量也越来越庞大,如何高效地收集、存储和分析这些日志数据成为了一个挑战。

本文将介绍如何使用Logstash、Elasticsearch和Kibana这三个开源工具来进行Java日志的收集和分析。

一、Logstash简介Logstash是一个开源的数据收集引擎,它可以从各种来源(如日志文件、消息队列、数据库等)收集数据,并将其转换为统一的格式,最后输出到指定的目的地。

Logstash具有强大的过滤和转换功能,可以对数据进行各种操作,如解析结构化日志、过滤无关信息、添加额外的字段等。

二、Elasticsearch简介Elasticsearch是一个分布式的实时搜索和分析引擎,它可以快速地存储、搜索和分析大量的数据。

Elasticsearch使用倒排索引的方式来存储数据,使得数据的搜索和分析变得非常高效。

它支持全文搜索、聚合分析、地理位置搜索等功能,非常适合用于日志数据的存储和分析。

三、Kibana简介Kibana是一个基于Elasticsearch的开源数据可视化工具,它可以通过简单的配置和操作来创建各种图表和仪表盘,帮助用户更直观地理解和分析数据。

Kibana支持多种图表类型,如柱状图、折线图、饼图等,还可以对数据进行过滤、聚合、排序等操作,使得数据的可视化分析变得非常方便。

四、日志收集与处理流程1. 安装和配置Logstash首先,我们需要在服务器上安装和配置Logstash。

通过编辑Logstash的配置文件,我们可以指定要收集的日志文件路径、日志格式、过滤规则等。

同时,我们还可以配置Logstash的输出插件,将处理后的日志数据发送到Elasticsearch进行存储。

服务器日志管理及分析工具推荐

服务器日志管理及分析工具推荐随着互联网的快速发展,服务器日志管理和分析变得越来越重要。

服务器日志包含了服务器上发生的各种活动和事件记录,通过对这些日志进行管理和分析,可以帮助管理员监控服务器运行状态、排查问题、优化性能等。

为了更高效地管理和分析服务器日志,推荐以下几款优秀的工具:1. **ELK Stack**ELK Stack 是一个开源的日志管理和分析平台,由三个核心组件组成:Elasticsearch、Logstash 和 Kibana。

Elasticsearch 是一个分布式搜索和分析引擎,可以用于存储和检索大量日志数据;Logstash是一个日志收集工具,可以将各种日志数据收集、过滤和转发到Elasticsearch 中;Kibana 则是一个数据可视化工具,可以帮助用户通过图表、表格等形式直观地展示日志数据。

ELK Stack 能够快速构建起一个强大的日志管理和分析系统,广泛应用于各种规模的企业和组织中。

2. **Splunk**Splunk 是一款功能强大的日志管理和分析工具,可以帮助用户实时监控、搜索、分析和可视化各种类型的日志数据。

Splunk 支持从各种来源收集日志数据,包括服务器日志、应用程序日志、网络设备日志等,用户可以通过 Splunk 的搜索语言快速查询和分析日志数据。

此外,Splunk 还提供了丰富的可视化功能,用户可以通过仪表盘、报表等方式直观地展示日志数据的分析结果。

3. **Graylog**Graylog 是一款开源的日志管理平台,提供了日志收集、存储、搜索和分析等功能。

Graylog 支持从各种来源收集日志数据,包括Syslog、GELF、HTTP 等,用户可以通过 Graylog 的搜索功能快速定位和分析特定的日志事件。

此外,Graylog 还提供了警报功能,用户可以设置警报规则,及时发现和响应异常事件。

4. **Fluentd**Fluentd 是一款开源的日志收集工具,支持从各种来源收集日志数据,并将数据转发到不同的目的地,如 Elasticsearch、Kafka、Hadoop 等。

常见日志收集方案及相关组件

常见⽇志收集⽅案及相关组件常见⽇志收集⽅案及相关组件⼀、常见⽇志收集⽅案1.1、EFK在Kubernetes集群上运⾏多个服务和应⽤程序时,⽇志收集系统可以帮助你快速分类和分析由Pod⽣成的⼤量⽇志数据。

Kubernetes中⽐较流⾏的⽇志收集解决⽅案是Elasticsearch、Fluentd和Kibana(EFK)技术栈,也是官⽅推荐的⼀种⽅案。

1)Elasticsearch:是⼀个实时的,分布式的,可扩展的搜索引擎,它允许进⾏全⽂本和结构化搜索以及对⽇志进⾏分析。

它通常⽤于索引和搜索⼤量⽇志数据,也可以⽤于搜索许多不同种类的⽂档。

2)Kibana:Elasticsearch通常与Kibana⼀起部署,kibana可以把Elasticsearch采集到的数据通过dashboard(仪表板)可视化展⽰出来。

Kibana允许你通过Web界⾯浏览Elasticsearch⽇志数据,也可⾃定义查询条件快速检索出elasticccsearch中的⽇志数据。

3)Fluentd:是⼀个流⾏的开源数据收集器,我们在 Kubernetes 集群节点上安装 Fluentd,通过获取容器⽇志⽂件、过滤和转换⽇志数据,然后将数据传递到 Elasticsearch 集群,在该集群中对其进⾏索引和存储。

1.2、ELK Stack1)Elasticsearch:⽇志存储和搜索引擎,它的特点有:分布式,零配置,⾃动发现,索引⾃动分⽚,索引副本机制,restful风格接⼝,多数据源,⾃动搜索负载等。

2)Logstash:是⼀个完全开源的⼯具,他可以对你的⽇志进⾏收集、过滤,并将其存储供以后使⽤(⽀持动态的从各种数据源搜集数据,并对数据进⾏过滤、分析、丰富、统⼀格式等操作。

)。

3)Kibana:是⼀个开源和免费的⼯具,Kibana可以为 Logstash 和 ElasticSearch 提供的⽇志分析友好的 Web 界⾯,可以帮助您汇总、分析和搜索重要数据⽇志。

ELK日志分析系统

ELK⽇志分析系统⼀、ELK 概述1、ELK简介 ELK平台是⼀套完整的⽇志集中处理解决⽅案,将 ElasticSearch、Logstash 和 Kiabana 三个开源⼯具配合使⽤,完成更强⼤的⽤户对⽇志的查询、排序、统计需求。

ElasticSearch:是基于Lucene(⼀个全⽂检索引擎的架构)开发的分布式存储检索引擎,⽤来存储各类⽇志。

Elasticsearch 是⽤ Java 开发的,可通过 RESTful Web 接⼝,让⽤户可以通过浏览器与 Elasticsearch 通信。

Elasticsearch 是个分布式搜索和分析引擎,优点是能对⼤容量的数据进⾏接近实时的存储、搜索和分析操作。

Logstash:作为数据收集引擎。

它⽀持动态的从各种数据源搜集数据,并对数据进⾏过滤、分析、丰富、统⼀格式等操作,然后存储到⽤户指定的位置,⼀般会发送给 Elasticsearch。

Logstash 由JRuby 语⾔编写,运⾏在 Java 虚拟机(JVM)上,是⼀款强⼤的数据处理⼯具,可以实现数据传输、格式处理、格式化输出。

Logstash 具有强⼤的插件功能,常⽤于⽇志处理。

Kiabana:是基于 Node.js 开发的展⽰⼯具,可以为 Logstash 和 ElasticSearch 提供图形化的⽇志分析 Web 界⾯展⽰,可以汇总、分析和搜索重要数据⽇志。

Filebeat:轻量级的开源⽇志⽂件数据搜集器。

通常在需要采集数据的客户端安装 Filebeat,并指定⽬录与⽇志格式,Filebeat 就能快速收集数据,并发送给 logstash 进⾏解析,或是直接发给 Elasticsearch 存储,性能上相⽐运⾏于 JVM 上的 logstash 优势明显,是对它的替代。

2、为什么要使⽤ ELK ⽇志主要包括系统⽇志、应⽤程序⽇志和安全⽇志。

系统运维和开发⼈员可以通过⽇志了解服务器软硬件信息、检查配置过程中的错误及错误发⽣的原因。

互联网开源日志系统介绍和对比剖析

开源日志系统比较1. 背景介绍许多公司的平台每天会产生大量的日志(一般为流式数据,如,搜索引擎的pv,查询等),处理这些日志需要特定的日志系统,一般而言,这些系统需要具有以下特征:(1)构建应用系统和分析系统的桥梁,并将它们之间的关联解耦;(2)支持近实时的在线分析系统和类似于Hadoop之类的离线分析系统;(3)具有高可扩展性。

即:当数据量增加时,可以通过增加节点进行水平扩展。

本文从设计架构,负载均衡,可扩展性和容错性等方面对比了当今开源的日志系统,包括facebook的scribe,apache的chukwa,linkedin的kafka和cloudera的flume等。

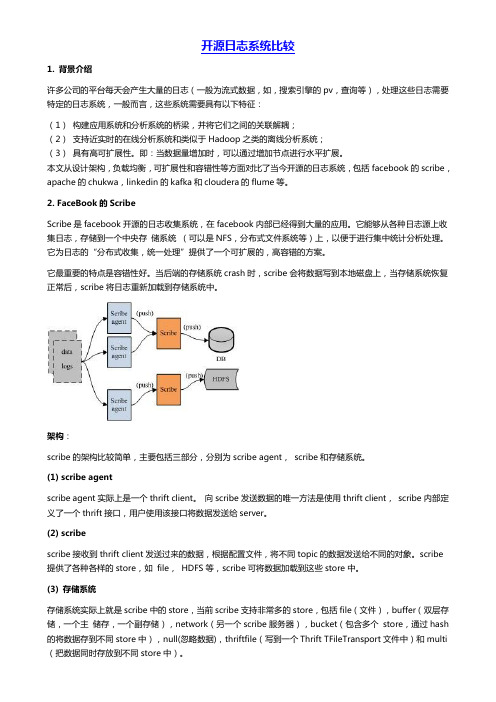

2. FaceBook的ScribeScribe是facebook开源的日志收集系统,在facebook内部已经得到大量的应用。

它能够从各种日志源上收集日志,存储到一个中央存储系统(可以是NFS,分布式文件系统等)上,以便于进行集中统计分析处理。

它为日志的“分布式收集,统一处理”提供了一个可扩展的,高容错的方案。

它最重要的特点是容错性好。

当后端的存储系统crash时,scribe会将数据写到本地磁盘上,当存储系统恢复正常后,scribe将日志重新加载到存储系统中。

架构:scribe的架构比较简单,主要包括三部分,分别为scribe agent,scribe和存储系统。

(1) scribe agentscribe agent实际上是一个thrift client。

向scribe发送数据的唯一方法是使用thrift client,scribe内部定义了一个thrift接口,用户使用该接口将数据发送给server。

(2) scribescribe接收到thrift client发送过来的数据,根据配置文件,将不同topic的数据发送给不同的对象。

scribe 提供了各种各样的store,如file,HDFS等,scribe可将数据加载到这些store中。

最好用的开源日志分析工具

最好⽤的开源⽇志分析⼯具监控⽹络活动既重要⼜繁琐,以下这些⼯具可以使它更容易。

监控⽹络活动是⼀项繁琐的⼯作,但有充分的理由这样做。

例如,它允许你查找和调查⼯作站和连接到⽹络的设备及服务器上的可疑登录,同时确定管理员滥⽤了什么。

你还可以跟踪软件安装和数据传输,以实时识别潜在问题,⽽不是在损坏发⽣后才进⾏跟踪。

这些⽇志还有助于使你的公司遵守适⽤于在欧盟范围内运营的任何实体的通⽤数据保护条例(GFPR)。

如果你的⽹站在欧盟可以浏览,那么你就有遵守的该条例的资格。

⽇志记录,包括跟踪和分析,应该是任何监控基础设置中的⼀个基本过程。

要从灾难中恢复 SQL Server 数据库,需要事务⽇志⽂件。

此外,通过跟踪⽇志⽂件,DevOps 团队和数据库管理员(DBA)可以保持最佳的数据库性能,⼜或者,在⽹络攻击的情况下找到未经授权活动的证据。

因此,定期监视和分析系统⽇志⾮常重要。

这是⼀种重新创建导致出现任何问题的事件链的可靠⽅式。

现在有很多开源⽇志跟踪器和分析⼯具可供使⽤,这使得为活动⽇志选择合适的资源⽐你想象的更容易。

⾃由和开源软件社区提供的⽇志设计适⽤于各种站点和操作系统。

以下是五个我⽤过的最好的⼯具,它们并没有特别的顺序。

GraylogGraylog 于 2011 年在德国创⽴,现在作为开源⼯具或商业解决⽅案提供。

它被设计成⼀个集中式⽇志管理系统,接受来⾃不同服务器或端点的数据流,并允许你快速浏览或分析该信息。

Graylog 在系统管理员中有着良好的声誉,因为它易于扩展。

⼤多数 Web 项⽬都是从⼩规模开始的,但它们可能指数级增长。

Graylog 可以均衡后端服务⽹络中的负载,每天可以处理⼏ TB 的⽇志数据。

IT 管理员会发现 Graylog 的前端界⾯易于使⽤,⽽且功能强⼤。

Graylog 是围绕仪表板的概念构建的,它允许你选择你认为最有价值的指标或数据源,并快速查看⼀段时间内的趋势。

当发⽣安全或性能事件时,IT 管理员希望能够尽可能地根据症状追根溯源。

seq日志聚合开源规则

seq日志聚合开源规则

开源规则的日志聚合系统可以根据具体需求选择,以下是一些常见的开源日志聚合规则:

1. ELK Stack:ELK Stack是Elasticsearch、Logstash和Kibana 的组合,用于实时的日志聚合、分析和可视化。

Logstash用于收集、过滤和转换日志数据,Elasticsearch用于存储和索引日志数据,Kibana用于可视化和分析日志数据。

2. Fluentd:Fluentd是一个开源的数据收集器,用于收集、过滤和转发日志数据。

它支持多种输出目标,可以将日志数据发送到Elasticsearch、Kafka、Hadoop等,也可以自定义输出目标。

Fluentd还提供了灵活的过滤器,可以根据需求对日志数据进行处理。

3. Graylog:Graylog是一个日志管理和分析工具,支持实时的日志收集、分析和可视化。

它使用Elasticsearch作为日志存储和索引引擎,提供了强大的查询和过滤功能,同时集成了多种报警机制。

4. Splunk:Splunk是一个商业的日志聚合和分析工具,但也提供了免费的开源版本。

它可以收集、索引和可视化多种类型的数据,包括日志、指标和事件数据。

Splunk具有强大的搜索和查询功能,并提供了丰富的可视化和报表功能。

这些开源规则都有各自的特点和优势,可以根据具体需求选择

适合的规则。

同时,还可以根据实际情况进行定制和扩展,以满足特定的日志聚合需求。

Linux上的日志收集和分析工具比较ELKvsGraylog

Linux上的日志收集和分析工具比较ELKvsGraylogLinux上的日志收集和分析工具比较:ELK vs Graylog在现代的计算机系统中,日志收集和分析是至关重要的。

它们可以帮助管理员监控系统运行情况、诊断问题,并提供安全的实时警报。

对于Linux系统而言,有多种选择可供选择,其中两个主要的选项是ELK和Graylog。

本文将比较这两个工具,以帮助您了解它们的特点和适用场景。

ELK(Elasticsearch, Logstash, Kibana)是一个开源的日志收集和分析工具套件。

它包含三个主要组件:Elasticsearch、Logstash和Kibana。

Elasticsearch是一个实时分布式搜索和分析引擎,它可以快速地存储、搜索和分析大量的数据。

Logstash是一个用于数据收集、过滤、转换和发送的服务器端管道工具。

Kibana是一个用于展示和可视化数据的工具,它提供了强大的图表和仪表盘功能。

相比之下,Graylog是另一个功能强大的开源日志管理平台。

它提供了与ELK类似的功能,但有一些不同之处。

Graylog使用Elasticsearch作为其底层数据存储引擎,因此可以实现类似的实时搜索和分析功能。

然而,Graylog还提供了一些其他功能,例如可配置的警报和通知机制,以及用户和权限管理。

在性能方面,ELK和Graylog都可以处理大量的日志数据。

然而,根据具体的部署要求和硬件配置,它们之间的性能差异可能会有所不同。

ELK在大规模和高吞吐量的数据处理方面表现出色,但在处理较小规模的环境时可能会导致性能损失。

与之相反,Graylog在处理中小规模数据时表现得更加灵活和高效。

在用户界面方面,Kibana和Graylog都提供了直观且易于使用的界面。

Kibana的用户界面可以通过图表、仪表盘和搜索来展示和分析数据,而Graylog则提供了一个类似于电子邮件收件箱的界面,用户可以轻松地搜索、筛选和分析日志数据。

Linux下的日志管理与分析工具推荐

Linux下的日志管理与分析工具推荐在Linux系统中,日志文件记录了系统运行时的各种事件和错误信息,对于系统管理员来说,管理和分析这些日志文件是一项非常重要的任务。

为了更高效地管理和分析日志文件,有许多优秀的工具可供选择。

本文将介绍几个值得推荐的Linux下的日志管理与分析工具。

一、LogwatchLogwatch是一款功能强大的日志文件分析工具,它能够自动分析系统的日志文件并生成相应的报告。

Logwatch支持多种日志格式,包括syslog、authlog、maillog等。

通过定期运行Logwatch,管理员可以了解系统的运行状况,及时发现潜在的问题。

二、GraylogGraylog是一个开源的日志管理和分析平台。

它提供了强大的搜索功能和仪表盘,可以帮助管理员快速定位和解决问题。

Graylog支持多种数据源,包括syslog、GELF、Beats等,可以集中管理和分析来自不同来源的日志数据。

三、ELK StackELK Stack是由Elasticsearch、Logstash和Kibana组成的一套日志管理和分析解决方案。

Elasticsearch是一种分布式搜索引擎,可以高效地索引和搜索大量的数据;Logstash用于数据收集、过滤和转发;Kibana 则提供了强大的可视化功能,可以全面展现数据的各种指标和趋势。

四、SplunkSplunk是一款商业化的日志管理和分析工具,具有强大的搜索能力和可视化功能。

它支持各种数据源,并能够对大量的数据进行实时处理和分析。

Splunk还提供了丰富的插件和应用程序,可以扩展其功能。

五、rsyslogrsyslog是一款高性能的系统日志守护进程,可以替代传统的syslogd。

rsyslog支持灵活的配置和过滤规则,可以将日志数据发送到远程服务器或存储到本地文件。

通过rsyslog,管理员可以更好地管理和维护系统日志。

六、SaganSagan是一款开源的入侵检测系统(IDS)日志分析工具,可以分析来自各种IDS工具(如Snort、Suricata等)的日志数据。

详解开源日志分析管理软件--ELK架构原理与介绍

详解开源日志分析管理软件--ELK架构原理与介绍概述一般我们需要进行日志分析场景:直接在日志文件中grep、awk 就可以获得自己想要的信息。

但在规模较大的场景中,此方法效率低下,面临问题包括日志量太大如何归档、文本搜索太慢怎么办、如何多维度查询。

需要集中化的日志管理,所有服务器上的日志收集汇总。

常见解决思路是建立集中式日志收集系统,将所有节点上的日志统一收集,管理,访问。

而开源的集中式日志管理系统首推ELK/EFK,接下来带大家了解下这块。

ELK一般大型系统是一个分布式部署的架构,不同的服务模块部署在不同的服务器上,问题出现时,大部分情况需要根据问题暴露的关键信息,定位到具体的服务器和服务模块,构建一套集中式日志系统,可以提高定位问题的效率。

一个完整的集中式日志系统,需要包含以下几个主要特点:•收集-能够采集多种来源的日志数据•传输-能够稳定的把日志数据传输到中央系统•存储-如何存储日志数据•分析-可以支持 UI 分析•警告-能够提供错误报告,监控机制ELK提供了一整套解决方案,并且都是开源软件,之间互相配合使用,完美衔接,高效的满足了很多场合的应用。

目前主流的一种日志系统。

ELK简介ELK是三个开源软件的缩写,分别表示:Elasticsearch , Logstash, Kibana , 它们都是开源软件。

新增了一个FileBeat,它是一个轻量级的日志收集处理工具(Agent),Filebeat占用资源少,适合于在各个服务器上搜集日志后传输给Logstash,官方也推荐此工具。

Elasticsearch是个开源分布式搜索引擎,提供搜集、分析、存储数据三大功能。

它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。

Logstash 主要是用来日志的搜集、分析、过滤日志的工具,支持大量的数据获取方式。

一般工作方式为c/s架构,client端安装在需要收集日志的主机上,server端负责将收到的各节点日志进行过滤、修改等操作在一并发往elasticsearch上去。

Java日志框架对比:Log4j、Logback和SLF4J的选择

Java日志框架对比:Log4j、Logback和SLF4J的选择引言:在开发Java应用程序时,日志是一个非常重要的组成部分。

它可以帮助我们记录应用程序的运行状态、调试问题以及监控系统性能。

为了更好地管理和利用日志信息,我们需要选择一个适合的日志框架。

本文将对比三个流行的Java日志框架:Log4j、Logback和SLF4J,帮助读者了解它们的特点和适用场景,以便做出正确的选择。

一、Log4jLog4j是一个广泛使用的Java日志框架,它提供了强大的日志记录功能和灵活的配置选项。

Log4j具有以下几个主要特点:1. 简单易用:Log4j的API设计简单直观,容易上手。

开发人员可以通过几行代码快速集成Log4j到应用程序中,并开始记录日志。

2. 高度可配置:Log4j提供了丰富的配置选项,可以根据需求灵活地配置日志输出格式、日志级别、目标设备等。

这使得开发人员可以根据具体需求进行精细化的日志管理。

3. 强大的过滤器机制:Log4j支持多种过滤器,可以根据日志的级别、来源、内容等进行过滤,从而实现对日志信息的精确控制。

4. 多种输出方式:Log4j支持将日志输出到控制台、文件、数据库等多种目标设备,开发人员可以根据实际需求选择合适的输出方式。

尽管Log4j在过去是Java日志领域的翘楚,但它的维护和更新已经相对较少。

因此,随着时间的推移,Log4j的性能和功能可能无法满足现代应用程序的需求。

二、LogbackLogback是由Log4j的创始人开发的下一代Java日志框架,它在Log4j的基础上进行了改进和优化。

Logback具有以下几个主要特点:1. 高性能:相比于Log4j,Logback在性能上有了显著提升。

它通过精细的设计和优化,可以更高效地处理日志记录,减少对应用程序性能的影响。

2. 灵活的配置:Logback提供了与Log4j相似的配置选项,可以根据需要自定义日志输出格式、级别、目标设备等。

Java中的日志框架有哪些

Java中的日志框架有哪些Java作为一种广泛应用于各种类型应用程序开发的编程语言,具备强大的日志记录功能。

为了提供方便和灵活的日志管理和记录,许多日志框架在Java生态系统中被广泛采用。

本文将介绍几种常见的Java日志框架。

1. Log4jLog4j是Apache软件基金会下的一个开源项目,提供了一个简单且功能强大的日志框架。

它支持多种输出格式,包括控制台、文件和数据库。

Log4j通过配置文件来灵活地控制日志级别和输出方式,使得开发人员能够根据需求进行日志记录的配置和管理。

2. LogbackLogback是Log4j的继任者,由同一位开发者主导并使用了类似的API。

与Log4j相比,Logback具有更高的性能和更丰富的功能。

它支持异步日志记录、日志分割和滚动等高级特性。

Logback还提供了一个简单易用的配置文件,允许开发人员动态地调整日志记录的行为。

3. JUL(java.util.logging)JUL是Java平台自带的日志记录框架,也是许多Java标准库使用的默认日志系统。

JUL提供了一个简单的API,并与Java平台紧密集成。

它支持多种输出格式,并提供了对日志级别和记录器的灵活管理。

然而,JUL在功能和扩展性方面相对有限,不够灵活。

4. Log4j2Log4j2是Log4j的升级版,以提供更好的性能和更丰富的功能。

相比于Log4j,Log4j2支持异步日志记录和敏感数据的脱敏处理。

同时,Log4j2还引入了Lambdas表达式和Grok模式来简化日志格式的定义和解析。

Log4j2具有很高的灵活性和可扩展性,因此在大型应用程序中得到广泛采用。

5. SLF4J(Simple Logging Facade for Java)SLF4J是一个日志抽象框架,旨在提供统一的日志API,使开发人员能够在不同的日志实现之间无缝切换。

SLF4J可以与Log4j、Logback等多个日志框架集成使用,并提供了良好的兼容性。

《2024年HiLog_OpenHarmony的高性能日志系统》范文

《HiLog_OpenHarmony的高性能日志系统》篇一HiLog_OpenHarmony的高性能日志系统HiLog: OpenHarmony的高性能日志系统一、引言在数字技术的迅猛发展中,高性能日志系统扮演着重要的角色,特别是对于OpenHarmony操作系统来说,它承载着庞大的数据交换和信息处理任务。

HiLog作为OpenHarmony的高性能日志系统,其设计理念、技术实现和性能表现都显得尤为重要。

本文将详细介绍HiLog的架构、功能、技术特点以及其在OpenHarmony系统中的重要作用。

二、HiLog架构与功能HiLog作为OpenHarmony的高性能日志系统,具备完整的架构体系,主要包含日志采集、日志传输、日志存储和日志分析四个部分。

1. 日志采集:HiLog通过遍布系统各处的日志采集器,实时捕获系统运行过程中的各类日志信息。

这些信息包括系统事件、应用运行状态、错误报告等。

2. 日志传输:采集到的日志信息通过高效的传输机制,被发送到中央处理单元。

这一过程保证了日志信息的实时性和完整性。

3. 日志存储:中央处理单元将接收到的日志信息进行分类、整理和存储。

HiLog支持多种存储方式,包括本地存储和云存储,以满足不同场景下的需求。

4. 日志分析:HiLog提供了丰富的分析工具,可以对存储的日志信息进行深度挖掘和分析,为系统优化和故障排查提供有力支持。

三、HiLog的技术特点HiLog作为高性能日志系统,具备以下技术特点:1. 高性能:HiLog采用优化算法和高效的数据结构,保证了日志采集、传输、存储和分析的高效性。

同时,其低延迟的特性使得系统运行过程中的问题能够及时被发现和解决。

2. 灵活性:HiLog支持多种日志格式和级别,可以根据需求进行灵活配置。

此外,其开放的接口设计使得第三方开发者可以轻松集成HiLog,实现自定义的日志处理功能。

3. 安全性:HiLog在数据传输和存储过程中采用了加密和权限控制等安全措施,保证了日志信息的安全性。

日志分析系统调研分析_ELK_EFK

日志分析系统调研分析_ELK_EFK随着互联网的迅猛发展和系统规模的不断扩大,日志数据变得越来越庞大和复杂。

为了更方便地对日志数据进行分析和监控,出现了许多日志分析系统。

本文将对三种常见的日志分析系统进行调研分析,包括ELK (Elasticsearch、Logstash、Kibana)、EFK(Elasticsearch、Fluentd、Kibana)和Sentry。

一、ELK(Elasticsearch、Logstash、Kibana)ELK 是由 Elastic 公司开发和维护的一套日志分析系统,由三个主要组件组成:1. Elasticsearch:一个基于 Lucene 的分布式和分析引擎,用于存储和索引日志数据。

它支持实时和分析,并提供了灵活的查询语言和聚合功能。

3. Kibana:一个用于可视化和分析 Elasticsearch 数据的交互式工具。

它提供了丰富的图表、仪表盘和界面,方便用户对日志数据进行检索、统计和可视化。

ELK的优势在于其强大的和分析功能、灵活的日志数据收集和转换能力,以及直观易用的可视化界面。

它广泛用于各种场景,如运维监控、安全分析和业务分析等。

二、EFK(Elasticsearch、Fluentd、Kibana)EFK是亚马逊公司推出的一套开源日志分析系统,与ELK类似,也由三个主要组件组成:1. Elasticsearch:同样作为数据存储和索引引擎,用于存储和索引日志数据。

3. Kibana:同样用于可视化和分析 Elasticsearch 数据的交互式工具,提供了丰富的图表、仪表盘和界面。

与 Logstash 相比,Fluentd 具有更轻量级的设计和更高的吞吐量。

此外,Fluentd 还提供了丰富的插件生态系统,可以方便地进行功能扩展。

三、SentrySentry 是一个开源的实时错误日志和异常追踪系统,主要用于监控和收集应用程序发生的异常和错误信息。

它提供了丰富的报告和可视化功能,能够及时发现和解决线上问题。

CC++log日志库比较

CC++log⽇志库⽐较事实上,在C的世界⾥⾯没有特别好的⽇志函数库(就像JAVA⾥⾯的的log4j,或者C++的log4cxx)。

C程序员都喜欢⽤⾃⼰的轮⼦。

printf就是个挺好的轮⼦,但没办法通过配置改变⽇志的格式或者输出⽂件。

syslog是个系统级别的轮⼦,不过速度慢,⽽且功能⽐较单调。

尝试了⼏种C/C++ log库,简单记录如下:1 log4j的衍⽣品⽇志是应⽤软件中不可缺少的部分,Apache的开源项⽬Log4j是⼀个功能强⼤的⽇志组件,提供⽅便的⽇志记录,他有很多移植版(包括官⽅的和⾮官⽅的版本)1.1 log4cxxLog4cxx是开放源代码项⽬Apache Logging Service的⼦项⽬之⼀,是Java社区著名的log4j的c++移植版,⽤于为C++程序提供⽇志功能,以便开发者对⽬标程序进⾏调试和审计。

1.2Log4cpplog4cpp是个基于LGPL的开源项⽬,移植⾃Java的⽇志处理跟踪项⽬log4j,并保持了API上的⼀致。

其类似的⽀持库还包括Java(log4j),C++(log4cpp、log4cplus),C(log4c),python(log4p)等。

⽽log4c ,1.3log4clog4c现已不再有⼈维护了。

不是⾯向对象的,不⽀持流式log输⼊。

有配置⽂件。

最新版本(log4c-1.2.4.tar.gz)存在内存泄露。

不建议使⽤。

1.4 log4cpluslog4cplus是C++编写的开源的⽇志系统,前⾝是java编写的log4j系统.受Apache Software License保护。

作者是Tad E. Smith。

log4cplus具有线程安全、灵活、以及多粒度控制的特点,通过将信息划分优先级使其可以⾯向程序调试、运⾏、测试、和维护等全⽣命周期;你可以选择将信息输出到屏幕、⽂件、NT event log、甚⾄是远程服务器;通过指定策略对⽇志进⾏定期备份等等。

日志收集系统对比

⽇志收集系统对⽐前⾔:efk中的f与elk中的l分别可以指代logstash、filebeat、rsyslog、Fluentd等,作为⽇志系统中的标准收集⼯具,各有优劣,本⽂将分析下各⾃的有点与不⾜。

Logstashlogstash基于JRuby实现,可以跨平台运⾏在JVM上优点主要的优点就是它的灵活性,这还主要因为它有很多插件。

然后它清楚的⽂档已经直⽩的配置格式让它可以再多种场景下应⽤。

这样的良性循环让我们可以在⽹上找到很多资源,⼏乎可以处理任何问题。

劣势Logstash 致命的问题是它的性能以及资源消耗(默认的堆⼤⼩是 1GB)。

尽管它的性能在近⼏年已经有很⼤提升,与它的替代者们相⽐还是要慢很多的。

因为logstash是jvm跑的,资源消耗⽐较⼤,所以后来作者⼜⽤golang写了⼀个功能较少但是资源消耗也⼩的轻量级的logstash-forwarder。

不过作者只是⼀个⼈,elastic.co公司以后,因为es公司本⾝还收购了另⼀个开源项⽬packetbeat,⽽这个项⽬专门就是⽤golang的,有整个团队,所以es公司⼲脆把logstash-forwarder的开发⼯作也合并到同⼀个golang团队来搞,于是新的项⽬就叫filebeat 了。

logstash 和filebeat都具有⽇志收集功能,filebeat更轻量,占⽤资源更少,但logstash 具有filter功能,能过滤分析⽇志。

⼀般结构都是filebeat采集⽇志,然后发送到消息队列,redis,kafaka。

然后logstash去获取,利⽤filter功能过滤分析,然后存储到elasticsearch中。

Filebeat使⽤go语⾔编写⼯作原理:Filebeat可以保持每个⽂件的状态,并且频繁地把⽂件状态从注册表⾥更新到磁盘。

这⾥所说的⽂件状态是⽤来记录上⼀次Harvster读取⽂件时读取到的位置,以保证能把全部的⽇志数据都读取出来,然后发送给output。

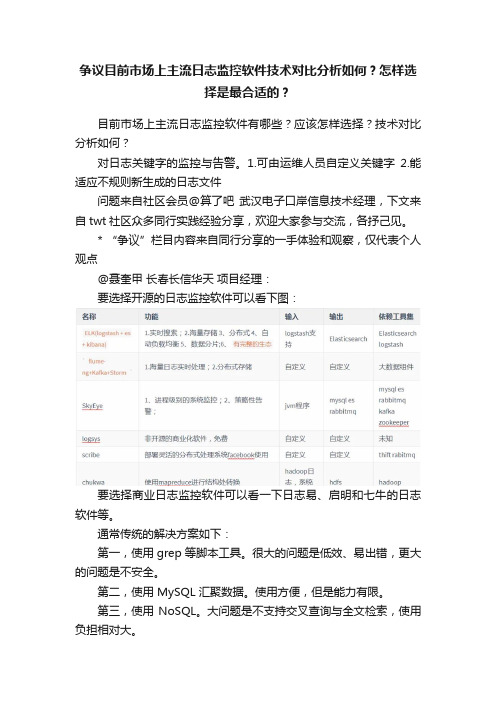

争议目前市场上主流日志监控软件技术对比分析如何?怎样选择是最合适的?

争议目前市场上主流日志监控软件技术对比分析如何?怎样选择是最合适的?目前市场上主流日志监控软件有哪些?应该怎样选择?技术对比分析如何?对日志关键字的监控与告警。

1.可由运维人员自定义关键字2.能适应不规则新生成的日志文件问题来自社区会员@算了吧武汉电子口岸信息技术经理,下文来自twt社区众多同行实践经验分享,欢迎大家参与交流,各抒己见。

* “争议”栏目内容来自同行分享的一手体验和观察,仅代表个人观点@聂奎甲长春长信华天项目经理:要选择开源的日志监控软件可以看下图:要选择商业日志监控软件可以看一下日志易、启明和七牛的日志软件等。

通常传统的解决方案如下:第一,使用 grep 等脚本工具。

很大的问题是低效、易出错,更大的问题是不安全。

第二,使用 MySQL 汇聚数据。

使用方便,但是能力有限。

第三,使用 NoSQL。

大问题是不支持交叉查询与全文检索,使用负担相对大。

第四,使用 Hadoop / Spark / Storm。

使用起来比较繁杂,不支持全文检索。

第五,使用ELK。

产品层面做的比较不足,超大数据量下稳定性存在挑战。

商业软件可以更好的解决上面这些软件的不足,使运维工作更简单一些。

@nansingnansing AiB 系统架构师:厂商:国内可以参考日志易(优特捷),国外的splunk。

自研或一般厂商,目前比较多的是基于ELK做平台封装,增加kfk、权限管理、spl查询、监控设置等可维护性、可管理的功能。

其他方案上一位已经回答的比较全了。

以下经验主要基于ELK平台,使用的有日志易产品,也有自研平台。

选型上,要评估自身的日志量和投入成本,低量级对厂商产品没有什么大的依赖,高量级就会涉及到es的调优能力和部署架构。

另一个会影响性能的,就是解析规则,大量的解析规则会导致性能消耗加剧,入库慢会导致监控失真。

其他可参考的,配置简易性、支持解析规则的设置能力、SPL支持能力、报表可视化、历史数据归档策略等。

1、可由运维人员自定义关键字——日志平台的监控,一般条件都是周期性范围内出现关键字的次数,例如5分钟内出现ERROR数10次。

seq日志聚合开源规则

seq日志聚合开源规则“seq日志聚合开源规则”是一个关于日志聚合工具Seq的开源规则的主题。

Seq是一个适用于.NET和.NET Core开发环境的日志聚合器,可以将多个日志源的日志数据收集、存储和查询。

本文将逐步回答有关Seq的介绍、开源规则和应用案例。

第一部分:Seq简介Seq是由Datalust公司开发的一款基于.NET平台的日志聚合工具。

它的主要作用是通过集中式存储,方便管理和查询分散在不同系统中的日志数据。

Seq支持.NET和.NET Core平台上的日志记录,可以通过API、数据库、日志文件、消息队列等方式获取日志数据。

第二部分:Seq的开源规则Seq的开源规则是为了改进Seq的功能和可扩展性而开发的一组规则。

这些规则可以用于定制化Seq的行为,以满足特定的日志聚合需求。

以下是Seq开源规则的一些重要特点:1. 自定义日志格式:Seq开源规则允许用户定义自己的日志格式,包括日期时间、日志级别、消息等。

用户可以使用正则表达式和占位符来定义这些模式。

2. 过滤器和转换器:Seq开源规则提供了强大的过滤器和转换器,可以根据特定条件来筛选和转换日志数据。

用户可以使用条件语句和数据变换规则来创建自定义的过滤和转换逻辑。

3. 分流和持久化:Seq开源规则支持将日志数据分流到不同的存储目标,比如数据库、文件或消息队列。

这有助于提高日志数据的可扩展性和灵活性。

4. 消息通知:Seq开源规则可以根据特定的日志事件触发消息通知,比如发送邮件或短信通知。

这个功能可以帮助用户及时发现和解决潜在的问题。

第三部分:Seq开源规则的应用案例Seq开源规则的应用非常广泛,以下是一些常见的应用案例:1. 日志数据分析和可视化:通过使用Seq开源规则,用户可以对收集到的日志数据进行各种分析和可视化操作。

比如,可以通过规则过滤器和转换器来提取特定的日志信息,并将其可视化为图表或仪表盘。

2. 异常监控和故障排查:Seq开源规则可以帮助用户实时监测系统中的异常情况,并提供有关异常的详细信息。

基于clickhouse的日志

基于clickhouse的日志摘要:1.ClickHouse 简介2.ClickHouse 的特点3.ClickHouse 的应用场景4.ClickHouse 的日志功能5.使用ClickHouse 进行日志分析的优点正文:1.ClickHouse 简介ClickHouse 是一款开源的列式数据库管理系统,它被广泛应用于数据仓库、数据分析和日志处理等领域。

ClickHouse 具有高效的数据写入和查询性能,可满足大规模数据的存储和分析需求。

2.ClickHouse 的特点ClickHouse 具有以下几个主要特点:- 高性能:ClickHouse 采用了列式存储结构,使得数据查询速度更快。

- 可扩展性:ClickHouse 支持数据分布式存储,便于扩展和管理。

- 高容错性:ClickHouse 支持数据备份和容错,确保数据安全。

- 支持多种数据格式:ClickHouse 支持多种数据格式,如JSON、XML 等。

3.ClickHouse 的应用场景ClickHouse 在以下场景中具有广泛应用:- 数据仓库:ClickHouse 可作为数据仓库,存储和管理大量数据。

- 数据分析:ClickHouse 支持高效的数据查询,便于进行数据分析。

- 日志处理:ClickHouse 可作为日志管理系统,实现日志的收集、存储和分析。

4.ClickHouse 的日志功能ClickHouse 提供了内置的日志功能,可以方便地实现日志的记录和管理。

用户可以通过配置文件设置日志级别、输出格式等参数。

ClickHouse 的日志功能可帮助用户监控系统运行状况,排查问题。

5.使用ClickHouse 进行日志分析的优点使用ClickHouse 进行日志分析具有以下优点:- 高效的查询性能:ClickHouse 采用列式存储结构,使得日志查询速度更快。

- 强大的数据处理能力:ClickHouse 支持数据分布式存储,便于处理大量日志数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

开源日志系统比较:scribe、chukwa、kafka、flume1. 背景介绍许多公司的平台每天会产生大量的日志(一般为流式数据,如,搜索引擎的pv,查询等),处理这些日志需要特定的日志系统,一般而言,这些系统需要具有以下特征:(1)构建应用系统和分析系统的桥梁,并将它们之间的关联解耦;(2)支持近实时的在线分析系统和类似于Hadoop之类的离线分析系统;(3)具有高可扩展性。

即:当数据量增加时,可以通过增加节点进行水平扩展。

本文从设计架构,负载均衡,可扩展性和容错性等方面对比了当今开源的日志系统,包括facebook的scribe,apache 的chukwa,linkedin的kafka和cloudera的flume等。

2. FaceBook的ScribeScribe是facebook开源的日志收集系统,在facebook内部已经得到大量的应用。

它能够从各种日志源上收集日志,存储到一个中央存储系统(可以是NFS,分布式文件系统等)上,以便于进行集中统计分析处理。

它为日志的“分布式收集,统一处理”提供了一个可扩展的,高容错的方案。

它最重要的特点是容错性好。

当后端的存储系统crash时,scribe会将数据写到本地磁盘上,当存储系统恢复正常后,scribe将日志重新加载到存储系统中。

架构:scribe的架构比较简单,主要包括三部分,分别为scribe agent,scribe和存储系统。

(1) scribe agentscribe agent实际上是一个thrift client。

向scribe发送数据的唯一方法是使用thrift client,scribe内部定义了一个thrift接口,用户使用该接口将数据发送给server。

(2) scribescribe接收到thrift client发送过来的数据,根据配置文件,将不同topic的数据发送给不同的对象。

scribe提供了各种各样的store,如file,HDFS等,scribe可将数据加载到这些store中。

(3) 存储系统存储系统实际上就是scribe中的store,当前scribe支持非常多的store,包括file(文件),buffer(双层存储,一个主储存,一个副存储),network(另一个scribe服务器),bucket(包含多个store,通过hash的将数据存到不同store中),null(忽略数据),thriftfile(写到一个Thrift TFileTransport文件中)和multi(把数据同时存放到不同store中)。

3. Apache的Chukwachukwa是一个非常新的开源项目,由于其属于hadoop系列产品,因而使用了很多hadoop的组件(用HDFS存储,用mapreduce处理数据),它提供了很多模块以支持hadoop集群日志分析。

需求:(1) 灵活的,动态可控的数据源(2) 高性能,高可扩展的存储系统(3) 合适的框架,用于对收集到的大规模数据进行分析架构:Chukwa中主要有3种角色,分别为:adaptor,agent,collector。

(1) Adaptor 数据源可封装其他数据源,如file,unix命令行工具等目前可用的数据源有:hadoop logs,应用程序度量数据,系统参数数据(如linux cpu使用流率)。

(2) HDFS 存储系统Chukwa采用了HDFS作为存储系统。

HDFS的设计初衷是支持大文件存储和小并发高速写的应用场景,而日志系统的特点恰好相反,它需支持高并发低速率的写和大量小文件的存储。

需要注意的是,直接写到HDFS上的小文件是不可见的,直到关闭文件,另外,HDFS不支持文件重新打开。

(3) Collector和Agent为了克服(2)中的问题,增加了agent和collector阶段。

Agent的作用:给adaptor提供各种服务,包括:启动和关闭adaptor,将数据通过HTTP传递给Collector;定期记录adaptor状态,以便crash后恢复。

Collector的作用:对多个数据源发过来的数据进行合并,然后加载到HDFS中;隐藏HDFS实现的细节,如,HDFS 版本更换后,只需修改collector即可。

(4) Demux和achieving直接支持利用MapReduce处理数据。

它内置了两个mapreduce作业,分别用于获取data和将data转化为结构化的log。

存储到data store(可以是数据库或者HDFS等)中。

4. LinkedIn的KafkaKafka是2010年12月份开源的项目,采用scala语言编写,使用了多种效率优化机制,整体架构比较新颖(push/pull),更适合异构集群。

设计目标:(1) 数据在磁盘上的存取代价为O(1)(2) 高吞吐率,在普通的服务器上每秒也能处理几十万条消息(3) 分布式架构,能够对消息分区(4) 支持将数据并行的加载到hadoop架构:Kafka实际上是一个消息发布订阅系统。

producer向某个topic发布消息,而consumer订阅某个topic的消息,进而一旦有新的关于某个topic的消息,broker会传递给订阅它的所有consumer。

在kafka中,消息是按topic组织的,而每个topic又会分为多个partition,这样便于管理数据和进行负载均衡。

同时,它也使用了zookeeper进行负载均衡。

Kafka中主要有三种角色,分别为producer,broker和consumer。

(1) ProducerProducer的任务是向broker发送数据。

Kafka提供了两种producer接口,一种是low_level接口,使用该接口会向特定的broker的某个topic下的某个partition发送数据;另一种那个是high level接口,该接口支持同步/异步发送数据,基于zookeeper的broker自动识别和负载均衡(基于Partitioner)。

其中,基于zookeeper的broker自动识别值得一说。

producer可以通过zookeeper获取可用的broker列表,也可以在zookeeper中注册listener,该listener在以下情况下会被唤醒:a.添加一个brokerb.删除一个brokerc.注册新的topicd.broker注册已存在的topic当producer得知以上时间时,可根据需要采取一定的行动。

(2) BrokerBroker采取了多种策略提高数据处理效率,包括sendfile和zero copy等技术。

(3) Consumerconsumer的作用是将日志信息加载到中央存储系统上。

kafka提供了两种consumer接口,一种是low level的,它维护到某一个broker的连接,并且这个连接是无状态的,即,每次从broker上pull数据时,都要告诉broker数据的偏移量。

另一种是high-level 接口,它隐藏了broker的细节,允许consumer从broker上push数据而不必关心网络拓扑结构。

更重要的是,对于大部分日志系统而言,consumer已经获取的数据信息都由broker保存,而在kafka中,由consumer自己维护所取数据信息。

5. Cloudera的FlumeFlume是cloudera于2009年7月开源的日志系统。

它内置的各种组件非常齐全,用户几乎不必进行任何额外开发即可使用。

设计目标:(1) 可靠性当节点出现故障时,日志能够被传送到其他节点上而不会丢失。

Flume提供了三种级别的可靠性保障,从强到弱依次分别为:end-to-end(收到数据agent首先将event写到磁盘上,当数据传送成功后,再删除;如果数据发送失败,可以重新发送。

),Store on failure(这也是scribe采用的策略,当数据接收方crash时,将数据写到本地,待恢复后,继续发送),Best effort(数据发送到接收方后,不会进行确认)。

(2) 可扩展性Flume采用了三层架构,分别问agent,collector和storage,每一层均可以水平扩展。

其中,所有agent和collector 由master统一管理,这使得系统容易监控和维护,且master允许有多个(使用ZooKeeper进行管理和负载均衡),这就避免了单点故障问题。

(3) 可管理性所有agent和colletor由master统一管理,这使得系统便于维护。

用户可以在master上查看各个数据源或者数据流执行情况,且可以对各个数据源配置和动态加载。

Flume提供了web 和shell script command两种形式对数据流进行管理。

(4) 功能可扩展性用户可以根据需要添加自己的agent,colletor或者storage。

此外,Flume自带了很多组件,包括各种agent(file,syslog等),collector和storage(file,HDFS等)。

架构:正如前面提到的,Flume采用了分层架构,由三层组成,分别为agent,collector和storage。

其中,agent和collector 均由两部分组成:source和sink,source是数据来源,sink是数据去向。

(1) agentagent的作用是将数据源的数据发送给collector,Flume自带了很多直接可用的数据源(source),如:text(“filename”):将文件filename作为数据源,按行发送tail(“filename”):探测filename新产生的数据,按行发送出去fsyslogTcp(5140):监听TCP的5140端口,并且接收到的数据发送出去同时提供了很多sink,如:console[("format")] :直接将将数据显示在桌面上text(“txtfile”):将数据写到文件txtfile中dfs(“dfsfile”):将数据写到HDFS上的dfsfile文件中syslogTcp(“host”,port):将数据通过TCP传递给host节点(2) collectorcollector的作用是将多个agent的数据汇总后,加载到storage中。

它的source和sink与agent类似。

下面例子中,agent监听TCP的5140端口接收到的数据,并发送给collector,由collector将数据加载到HDFS 上。

?1 2 3 host : syslogTcp(5140) | agentSink("localhost",35853) ;collector : collectorSource(35853) | collectorSink("hdfs://namenode/user/flume/","syslog"一个更复杂的例子如下:有6个agent,3个collector,所有collector均将数据导入HDFS中。