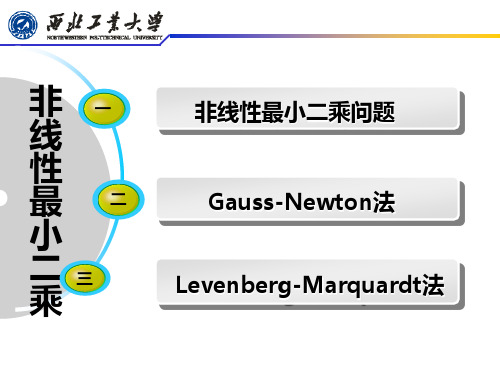

非线性最小二乘法

非线性最小二乘法

非线性最小二乘法最小二乘法的一般涵义在科学实验的统计方法研究中,往往会遇到下列类型的问题:设x,y都是被观测的量,且y是x的函数:y=f(x;,…,) (2.1)假设这个函数关系已经由实际问题从理论上具体确定,因而(2.1)可称为理论函数或理论曲线公式,但其中含有n个未知参数,…,。

为了进一步确定这n个参数,我们可以通过实验或观测来得到m组数据:(,(,,…,(,(2.2)根据(2.2)来寻找参数的最佳估计值,…,,即寻求最佳的理论曲线y=f(x;,…,),这就是一般的曲线拟合问题,也可称为观测数据的平滑问题。

在实际问题中我们经常遇到的一种曲线拟合问题是需要从观测数据(2.2)求出y和x的一个经验公式,而在曲线拟合时首先碰到的问题就是函数关系(2.1)的具体确定,然后才能进行参数估计。

对于某些变量x,y之间已经有比较明确物理关系或关系简单的问题给出函数的具体表达式并不是太困难,但往往实际问题中所遇到的却是极为复杂的问题,要建立有效的表达式就有些困难了。

我们所讨论的最小二乘问题都是建立在函数关系已知的基础上。

我们用残差作为拟合标准,此时=-f(;,…,) (i=1,2,…,m)简单记作r=y-f(x;b)这里,r=b=f(x,b)=残差向量r的三种范数记作===残差可以表示拟合的误差,误差越小则拟合的效果越好。

虽然取前两种范数最小,比较理想和直观,但是它们不便于计算,因此在实际应用中是取欧式范数最小,即求出参数b ,使得=min 这就是通常所谓的最小二乘法,几何语言也成为最小二乘拟合。

解非线性方程组的Newton 法12(,,......,)01,2,......,j n f x x x j m =⎧⎨=⎩(1) 设其解为***12(,,......,)n x x x ,在其附近一点00012(,,......,)n x x x 把j f 展成Taylor 展式: 00000001212121(,,...,)(,,...,)()(,,...,)n j n j nk k j n j k k f x x x f x x x x x f x x x R x =∂=+-+∂∑20012,11()()(,,......)1,2,......,2n j l l k k j n l k l k R x x x x f j n x x ξξξ=∂=--=∂∂∑忽略余项j R 得到:000000012121(,,...,)()(,,...,)01,2,...,n j n k k j n k kf x x x x x f x x x j m x =∂+-==∂∑ 这是一组线性方程,它的解111,......,n x x 作为解,系数矩阵式Jacobi 阵 1111222212112(,...,)n n n m m m n f f f x x x f f f x x x J J x x f f f x x x ∂∂∂⎛⎫ ⎪∂∂∂ ⎪ ⎪∂∂∂ ⎪∂∂∂== ⎪ ⎪ ⎪∂∂∂ ⎪ ⎪∂∂∂⎝⎭写成向量形式:12(,,......,)j j j j n x x x x =,则上述线性方程组化为: 000()()()0f x J x x x +-=当m n >时,上述方程为超定的,求其最小二乘解1x10100()()x x J x f x -=-其中1J -理解为广义逆,再迭代得:11()()k k k k x x J x f x +-=-。

lm最小二乘法

lm最小二乘法最小二乘法(Least Squares Method,简称LSM)是一种常用的数学优化方法,被广泛应用于估计数学模型中的参数。

它的原理可以简单描述为寻找最小化误差平方和的解。

LM最小二乘法(Levenberg-Marquardt Algorithm)是对传统最小二乘法的改进,在非线性最小二乘拟合问题中表现出更好的性能。

1. 最小二乘法的基本原理最小二乘法最早由高斯提出,它通过最小化数据观测值与模型预测值之间的差异,来估计模型的参数。

以一个简单的线性模型为例,假设有一组观测数据(y1,x1), (y2, x2), ..., (yn, xn),要找到一条直线y = ax + b,使得观测数据到该直线的垂直距离之和最小。

最小二乘法的思路是通过定义一个误差函数,将垂直距离的平方和作为该函数的值。

然后,通过计算该误差函数的导数,将其最小化的问题转化为求解导数为零的方程组的解。

最终,可以得到使误差平方和最小的参数估计。

2. LM最小二乘法的引入传统的最小二乘法在应对非线性问题时存在一些限制。

当模型参数初值选取不当或者观测数据存在较大的离群值时,传统最小二乘法容易陷入局部最优解,无法找到全局最优解。

为了解决这个问题,Levenberg和Marquardt在1963年独立地提出了LM最小二乘法。

它通过引入一个参数λ,结合了最小二乘法的优势和梯度下降的思路,既考虑当前模型的误差平方和,又考虑模型参数的更新量。

具体来说,LM最小二乘法的误差函数其实就是一个带有惩罚项的平方和函数。

当惩罚项较大时,它的求解过程类似于梯度下降,能够避免陷入局部最优解;而当惩罚项较小时,它又退化为传统的最小二乘法。

3. LM最小二乘法的求解过程LM最小二乘法的求解过程可以分为两个步骤:参数估计和参数更新。

首先,给定初始参数估计值,计算误差平方和的梯度矩阵和雅可比矩阵。

然后,根据当前参数估计值和梯度矩阵,更新参数值并重新计算误差平方和,直到达到预设的收敛条件。

用MATLAB作线性和非线性最小二乘法拟合

通过实验掌握拟合函数,非线性拟合函数对于三维曲面函数拟合有点困难。

1916 2.09 3.61 1.86

1917 1.96 4.10 1.93

1918 2.20 4.36 1.96

1919 2.12 4.77 1.95

1920 2.16 4.75 1.90

1921 2.08 4.54 1.58

1922 2.24 4.54 1.67

1923 2.56 4.58 1.82

1.分析问题

用lsqcorvefit作非线性最小二乘法拟合

2.问题求解

a=[1.04 1.06 1.16 1.22 1.27 1.37 1.44 1.53 1.57 2.05 2.51 2.63...

2.74 2.82 3.24 3.24 3.61 4.1 4.36 4.77 4.75 4.54 4.54 4.58...

用Q,K,L分别表示产值、资金、劳动力,要寻求的数量关系 。经过简化假设与分析,在经济学中,推导出一个著名的Cobb-Douglas生产函数:

(*)

式中 要由经济统计数据确定。现有美国马萨诸塞州1900—1926年上述三个经济指数的统计数据,如下表,试用数据拟合的方法,求出式(*)中的参数 。

表2

t Q K L

x=lsqcurvefit('fun3',x0,a,z)

m=linspace(0,2.7,27);

n=linspace(0,2.7,27);

[M,N]=meshgrid(m,n);

z=x(1)*(M.^x(2)).*(N.^x(3));

surf(M,N,z);

3.结果

4.结论及分析

经多次试验可知分析无误

数学建模 非线性最小二乘问题

1、非线性最小二乘问题用最小二乘法计算:sets:quantity/1..15/: x,y;endsetsmin=@sum(quantity: (a+b* @EXP(c*x)-y)^2);@free(a); @free(b);@free(c);data:x=2,5,7,10,14,19,26,31,34,38,45,52,53,60,65;y=54,50,45,37,35,25,20,16,18,13,8,11,8,4,6;enddata运算结果为:Local optimal solution found.Objective value: 44.78049 Extended solve steps: 5Total solve iterartions: 68Variable Value Reduced CostA 2.430177 0.000000B 57.33209 0.000000C -0.4460383E-01 0.000000由此得到a的值为2.430177,b的值为57.33209,c的值为-0.04460383。

线性回归方程为y=2.430177+57.33209* @EXP(-0.04460383*x)用最小一乘法计算:程序如下:sets:quantity/1..15/: x,y;endsetsmin=@sum(quantity: @ABS(a+b*@EXP(c*x)-y));@free(a); @free(b);@free(c);data:x=2,5,7,10,14,19,26,31,34,38,45,52,53,60,65;y=54,50,45,37,35,25,20,16,18,13,8,11,8,4,6;enddata运算结果为:Linearization components added:Constraints: 60Variables: 60Integers: 15Local optimal solution found.Objective value: 20.80640Extended solver steps: 2Total solver iterations: 643Variable Value Reduced CostA 3.398267 0.000000B 57.11461 0.000000C -0.4752126e-01 0.000000由上可得a的值为3.398267,b的值为57.11461,c的值为-0.04752126。

matlab最小二乘法拟合

matlab最小二乘法拟合matlab最小二乘法拟合是一种常用的拟合方法,它属于非线性最小二乘拟合,其可以用来拟合任意数据。

matlab最小二乘法拟合主要包括以下几个步骤:一、准备数据1、准备数据阶段:包括收集数据,整理数据,观察数据;2、设计拟合模型:根据观察到的特性确定拟合模型方程;3、计算函数参数:根据拟合模型对原始数据进行曲线拟合,计算出模型参数;二、参数估计1、最小二乘法拟合:将所有点拟合到曲线上,使每个点到曲线上的距离之和最小;2、非线性最小二乘拟合:根据多元非线性模型参数的变化范围,构造最小二乘拟合的曲线,应用非线性拟合和最小二乘法拟合找出最佳拟合曲线;3、外推预测:根据拟合后的参数预测特定值。

三、评价拟合结果1、残差平方和:根据拟合模型和所得数据,计算拟合结果和拟合误差;2、自由度:自由度 = 总数据点数- 拟合模型参数的个数;3、复杂度检验:考虑拟合模型的复杂度对拟合效果的影响;4、对数校正残差:考虑拟合结果的稳定性,比较数据的分布与真实数据的分布;5、误差统计检验:通过统计分析评估拟合结果的可靠性。

四、模型预测1、均方根误差(RMSE):评估预测模型拟合准确性,值越小,模型越有效;2、均方误差(MSE):反映预测值与真实值之间的平均差异;3、绝对均差(MAE):反映预测值与真实值之间的绝对均值差异;4、平均绝对平方偏差(MAHAPE):反映模型拟合精度平均差距,值越接近0,模型越精确;5、杰拉德系数(R):反映预测值与真实值之间的线性联系,值越接近1,模型越有效。

以上是matlab最小二乘法拟合的原理和应用,它不仅可以拟合任意数据,而且具有较强的适用性和准确性。

此外,matlab最小二乘法拟合还可以用来评估拟合结果的准确性,方便对数据进行分析处理。

非线性最小二乘法Levenberg-Marquardt-method

Levenberg-Marquardt Method(麦夸尔特法)Levenberg-Marquardt is a popular alternative to the Gauss-Newton method of finding the minimum of afunction that is a sum of squares of nonlinear functions,Let the Jacobian of be denoted , then the Levenberg-Marquardt method searches in thedirection given by the solution to the equationswhere are nonnegative scalars and is the identity matrix. The method has the nice property that, forsome scalar related to , the vector is the solution of the constrained subproblem of minimizingsubject to (Gill et al. 1981, p. 136).The method is used by the command FindMinimum[f, x, x0] when given the Method -> Levenberg Marquardt option.SEE A LSO:Minimum, OptimizationREFERENCES:Bates, D. M. and Watts, D. G. N onlinear Regr ession and Its Applications. New York: Wiley, 1988.Gill, P. R.; Murray, W.; and Wright, M. H. "The Levenberg-Marquardt Method." §4.7.3 in Practical Optim ization. London: Academic Press, pp. 136-137, 1981.Levenberg, K. "A Method for the Solution of Certain Problems in Least Squares." Quart. Appl. Math.2, 164-168, 1944. Marquardt, D. "An Algor ithm for Least-Squares Estimation of Nonlinear Parameters." SIAM J. Appl. Math.11, 431-441, 1963.Levenberg–Marquardt algorithmFrom Wikipedia, the free encyclopediaJump to: navigation, searchIn mathematics and computing, the Levenberg–Marquardt algorithm (LMA)[1] provides a numerical solution to the problem of minimizing a function, generally nonlinear, over a space of parameters of the function. These minimization problems arise especially in least squares curve fitting and nonlinear programming.The LMA interpolates between the Gauss–Newton algorithm (GNA) and the method of gradient descent. The LMA is more robust than the GNA, which means that in many cases it finds a solution even if it starts very far off the final minimum. For well-behaved functions and reasonable starting parameters, the LMA tends to be a bit slower than the GNA. LMA can also be viewed as Gauss–Newton using a trust region approach.The LMA is a very popular curve-fitting algorithm used in many software applications for solving generic curve-fitting problems. However, the LMA finds only a local minimum, not a global minimum.Contents[hide]∙ 1 Caveat Emptor∙ 2 The problem∙ 3 The solutiono 3.1 Choice of damping parameter∙ 4 Example∙ 5 Notes∙ 6 See also∙7 References∙8 External linkso8.1 Descriptionso8.2 Implementations[edit] Caveat EmptorOne important limitation that is very often over-looked is that it only optimises for residual errors in the dependant variable (y). It thereby implicitly assumes that any errors in the independent variable are zero or at least ratio of the two is so small as to be negligible. This is not a defect, it is intentional, but it must be taken into account when deciding whether to use this technique to do a fit. While this may be suitable in context of a controlled experiment there are many situations where this assumption cannot be made. In such situations either non-least squares methods should be used or the least-squares fit should be done in proportion to the relative errors in the two variables, not simply the vertical "y" error. Failing to recognise this can lead to a fit which is significantly incorrect and fundamentally wrong. It will usually underestimate the slope. This may or may not be obvious to the eye.MicroSoft Excel's chart offers a trend fit that has this limitation that is undocumented. Users often fall into this trap assuming the fit is correctly calculated for all situations. OpenOffice spreadsheet copied this feature and presents the same problem.[edit] The problemThe primary application of the Levenberg–Marquardt algorithm is in the least squares curve fitting problem: given a set of m empirical datum pairs of independent and dependent variables, (x i, y i), optimize the parameters β of the model curve f(x,β) so that the sum of the squares of the deviationsbecomes minimal.[edit] The solutionLike other numeric minimization algorithms, the Levenberg–Marquardt algorithm is an iterative procedure. To start a minimization, the user has to provide an initial guess for the parameter vector, β. In many cases, an uninformed standard guess like βT=(1,1,...,1) will work fine;in other cases, the algorithm converges only if the initial guess is already somewhat close to the final solution.In each iteration step, the parameter vector, β, is replaced by a new estimate, β + δ. To determine δ, the functions are approximated by their linearizationswhereis the gradient(row-vector in this case) of f with respect to β.At its minimum, the sum of squares, S(β), the gradient of S with respect to δwill be zero. The above first-order approximation of gives.Or in vector notation,.Taking the derivative with respect to δand setting theresult to zero gives:where is the Jacobian matrix whose i th row equals J i,and where and are vectors with i th componentand y i, respectively. This is a set of linear equations which can be solved for δ.Levenberg's contribution is to replace this equation by a "damped version",where I is the identity matrix, giving as the increment, δ, to the estimated parameter vector, β.The (non-negative) damping factor, λ, isadjusted at each iteration. If reduction of S is rapid, a smaller value can be used, bringing the algorithm closer to the Gauss–Newton algorithm, whereas if an iteration gives insufficientreduction in the residual, λ can be increased, giving a step closer to the gradient descentdirection. Note that the gradient of S withrespect to β equals .Therefore, for large values of λ, the step will be taken approximately in the direction of the gradient. If either the length of the calculated step, δ, or the reduction of sum of squares from the latest parameter vector, β + δ, fall below predefined limits, iteration stops and the last parameter vector, β, is considered to be the solution.Levenberg's algorithm has the disadvantage that if the value of damping factor, λ, is large, inverting J T J + λI is not used at all. Marquardt provided the insight that we can scale eachcomponent of the gradient according to thecurvature so that there is larger movement along the directions where the gradient is smaller. This avoids slow convergence in the direction of small gradient. Therefore, Marquardt replaced theidentity matrix, I, with the diagonal matrixconsisting of the diagonal elements of J T J,resulting in the Levenberg–Marquardt algorithm:.A similar damping factor appears in Tikhonov regularization, which is used to solve linear ill-posed problems, as well as in ridge regression, an estimation technique in statistics.[edit] Choice of damping parameterVarious more-or-less heuristic arguments have been put forward for the best choice for the damping parameter λ. Theoretical arguments exist showing why some of these choices guaranteed local convergence of the algorithm; however these choices can make the global convergence of the algorithm suffer from the undesirable properties of steepest-descent, in particular very slow convergence close to the optimum.The absolute values of any choice depends on how well-scaled the initial problem is. Marquardt recommended starting with a value λ0 and a factor ν>1. Initially setting λ=λ0and computing the residual sum of squares S(β) after one step from the starting point with the damping factor of λ=λ0 and secondly withλ0/ν. If both of these are worse than the initial point then the damping is increased by successive multiplication by νuntil a better point is found with a new damping factor of λ0νk for some k.If use of the damping factor λ/ν results in a reduction in squared residual then this is taken as the new value of λ (and the new optimum location is taken as that obtained with this damping factor) and the process continues; if using λ/ν resulted in a worse residual, but using λresulted in a better residual then λ is left unchanged and the new optimum is taken as the value obtained with λas damping factor.[edit] ExamplePoor FitBetter FitBest FitIn this example we try to fit the function y = a cos(bX) + b sin(aX) using theLevenberg–Marquardt algorithm implemented in GNU Octave as the leasqr function. The 3 graphs Fig 1,2,3 show progressively better fitting for the parameters a=100, b=102 used in the initial curve. Only when the parameters in Fig 3 are chosen closest to the original, are thecurves fitting exactly. This equation is an example of very sensitive initial conditions for the Levenberg–Marquardt algorithm. One reason for this sensitivity is the existenceof multiple minima —the function cos(βx)has minima at parameter value and[edit] Notes1.^ The algorithm was first published byKenneth Levenberg, while working at theFrankford Army Arsenal. It was rediscoveredby Donald Marquardt who worked as astatistician at DuPont and independently byGirard, Wynn and Morrison.[edit] See also∙Trust region[edit] References∙Kenneth Levenberg(1944). "A Method for the Solution of Certain Non-Linear Problems in Least Squares". The Quarterly of Applied Mathematics2: 164–168.∙ A. Girard (1958). Rev. Opt37: 225, 397. ∙ C.G. Wynne (1959). "Lens Designing by Electronic Digital Computer: I". Proc.Phys. Soc. London73 (5): 777.doi:10.1088/0370-1328/73/5/310.∙Jorje J. Moré and Daniel C. Sorensen (1983)."Computing a Trust-Region Step". SIAM J.Sci. Stat. Comput. (4): 553–572.∙ D.D. Morrison (1960). Jet Propulsion Laboratory Seminar proceedings.∙Donald Marquardt (1963). "An Algorithm for Least-Squares Estimation of NonlinearParameters". SIAM Journal on AppliedMathematics11 (2): 431–441.doi:10.1137/0111030.∙Philip E. Gill and Walter Murray (1978)."Algorithms for the solution of thenonlinear least-squares problem". SIAMJournal on Numerical Analysis15 (5):977–992. doi:10.1137/0715063.∙Nocedal, Jorge; Wright, Stephen J. (2006).Numerical Optimization, 2nd Edition.Springer. ISBN0-387-30303-0.[edit] External links[edit] Descriptions∙Detailed description of the algorithm can be found in Numerical Recipes in C, Chapter15.5: Nonlinear models∙ C. T. Kelley, Iterative Methods for Optimization, SIAM Frontiers in AppliedMathematics, no 18, 1999, ISBN0-89871-433-8. Online copy∙History of the algorithm in SIAM news∙ A tutorial by Ananth Ranganathan∙Methods for Non-Linear Least Squares Problems by K. Madsen, H.B. Nielsen, O.Tingleff is a tutorial discussingnon-linear least-squares in general andthe Levenberg-Marquardt method inparticular∙T. Strutz: Data Fitting and Uncertainty (A practical introduction to weighted least squares and beyond). Vieweg+Teubner, ISBN 978-3-8348-1022-9.[edit] Implementations∙Levenberg-Marquardt is a built-in algorithm with Mathematica∙Levenberg-Marquardt is a built-in algorithm with Matlab∙The oldest implementation still in use is lmdif, from MINPACK, in Fortran, in thepublic domain. See also:o lmfit, a translation of lmdif into C/C++ with an easy-to-use wrapper for curvefitting, public domain.o The GNU Scientific Library library hasa C interface to MINPACK.o C/C++ Minpack includes theLevenberg–Marquardt algorithm.o Several high-level languages andmathematical packages have wrappers forthe MINPACK routines, among them:▪Python library scipy, modulescipy.optimize.leastsq,▪IDL, add-on MPFIT.▪R (programming language) has theminpack.lm package.∙levmar is an implementation in C/C++ with support for constraints, distributed under the GNU General Public License.o levmar includes a MEX file interface for MATLABo Perl (PDL), python and Haskellinterfaces to levmar are available: seePDL::Fit::Levmar, PyLevmar andHackageDB levmar.∙sparseLM is a C implementation aimed at minimizing functions with large,arbitrarily sparse Jacobians. Includes a MATLAB MEX interface.∙ALGLIB has implementations of improved LMA in C# / C++ / Delphi / Visual Basic.Improved algorithm takes less time toconverge and can use either Jacobian orexact Hessian.∙NMath has an implementation for the .NET Framework.∙gnuplot uses its own implementation .∙Java programming language implementations:1) Javanumerics, 2) LMA-package (a small,user friendly and well documentedimplementation with examples and support),3) Apache Commons Math∙OOoConv implements the L-M algorithm as an Calc spreadsheet.∙SAS, there are multiple ways to access SAS's implementation of the Levenberg-Marquardt algorithm: it can be accessed via NLPLMCall in PROC IML and it can also be accessed through the LSQ statement in PROC NLP, and the METHOD=MARQUARDT option in PROC NLIN.。

第15次 非线性最小二乘法

∂f 1 ... ∂x n ⋮ ⋮ ∂f m ... ∂x n

∂f i ( x k ) )m×n 。 =( ∂x j

x= xk

记 Ak = A( x k ) , 则有

S ( x ) ≈ f ( x ) + Ak ( x − x ) = Ak d + f ( x )

k k 2 k k 2

Step 2 : 若 S ( x + z ) ≥ S ( x ), 则令 λ : αλ 并返回 Step1。 =

Step 3 : 令 x := x + z , λ = βλ ; 若 A( x )T f( x)< ε 则迭代终止, 则迭代终止, 否则返回 Step1。

方法总结: 8. L-M 方法总结:

T T Ak Ak d k = − Ak f ( x k )

(1)

当Ak Ak 可逆时则有

T d k = − ( Ak Ak ) −1 Ak f ( x k ) T

T

( 2)

令 x k + 1 = x = x k + d k,则有迭代公式

T T x k + 1 = x k + d k = x k − ( Ak Ak ) −1 Ak f ( x k )

disadvantage : that if the value of λ is large, the calculated Hessian matrix is not used at all.

5. 设λ > 0,z是方程组( * *)的解,那么有: 是方程组( 的解,那么有:

性质 1: f ( x ) + A( x ) y ≥ f ( x ) + A( x ) z ( ∀ y = z )

第四章 非线性回归与非线性约束

具体检验时,用来对原假设进行检验的似然比统 用来对原假设进行检验的似然比统 具体检验 计量定义为: 计量定义为: L( β R ) LR = −2(ln L( β R ) − ln L( βUR )) = −2 ln L( βUR )

LR ~ χ , m为限制条件的个数。

2 m 2 若LR大于给定显著性水平下的χ m临界值,

2

exp[−

1 2σ

2

(Yi − f ( X 1i , X 2i , L X ki , β1 , β 2 ,L β p )) 2 ]

则N个观测值的对数似然函数为 LnL = ∑ p (Yi , X i β ) = − ( N / 2) ln(2π ) − ( N / 2) ln(σ )

2

− (σ / 2)∑ (Yi − f ( X 1i , X 2i , L X ki , β1 , β 2 , L β p ))

L( β R ) 则似然比定义为λ = . L( βUR )

L( β R ) 则似然比定义为λ = . L( βUR )

L越大表明对数据的拟合程度越好,分母来自无条 越大表明对数据的拟合程度越好, 越大表明对数据的拟合程度越好 件模型,变量个数越多,拟合越好, 件模型,变量个数越多,拟合越好,因此分子小于分 似然比在0到 间 母,似然比在 到1间。分子是在原假设成立下参数的 极大似然函数值,是零假设的最佳表示。 极大似然函数值,是零假设的最佳表示。而分母则表 示在在任意情况下参数的极大似然函数值。 示在在任意情况下参数的极大似然函数值。比值的最 大极限值为1,其值靠近1, 大极限值为 ,其值靠近 ,说明局部的最大和全局最 大近似,零假设成立可能性就越大。 大近似,零假设成立可能性就越大。

设L( βUR )代表没有限制条件时似然函数 的极大值, L( β R )代表有限制条件时似然函数的极大值,

X射线光电子能谱复杂谱图的非线性最小二乘法分析案例

称 的 特 点 ,很 难 采 用 常 规 单 峰 拟 合 将 改 性 前 的 数 据 表 示 出 来 ,因 此 如 何 对 改 性 后 谱 图 的 准 确 定 性 定 量 分 析 给科研工作者带来了不小的难题。

图2 碳纳米管改性前(a)后(b)的 C1s谱图 Fig.2 C1sspectraofcarbonnanotubes(CNTs)before(a)andafter(b)modification

图3a、3b、3c分别为 Ce3+ 、Ce4+ 和 Ce4+ 与 Ce3+ 混合态的 Ce3d谱图,由于 Ce4+ 、Ce3+ 谱峰结构本身存 在特定的谱峰结构、存在多组谱峰且结构不对称的特点,很难采用常规双峰拟合将 Ce4+ 、Ce3+ 单 种 化 学 态 的数据表示出来,因此常规拟合方 法 根 本 解 决 不 了 对 同 时 含 有 Ce4+ 和 Ce3+ 的 混 合 态 谱 图 进 行 准 确 定 性 定量分析的难题。

图7 Fe2p原始谱图(a)和分析谱图(b) Fig.7 Originalspectrum(a)andanalyticalspectrum(b)ofFe2p

3.1.3 多个俄歇谱峰干扰影响元素定性及定量的复杂谱图示例 数据处理过程中有时会遇到元素主峰受

到多个俄歇 谱 峰 的 干 扰。 如 图 8 所 示,由 于 样 品 中 同 时 含 有

374

第3期

分析科学学报

第 37 卷

最小二乘法高斯牛顿法求解

最小二乘法高斯牛顿法求解最小二乘法和高斯-牛顿法是两种常用的优化技术,用于求解线性回归问题。

最小二乘法是一种简单且广泛使用的优化技术,用于拟合线性模型。

高斯-牛顿法是一种迭代算法,用于求解非线性最小二乘问题。

最小二乘法是一种简单且广泛使用的线性回归方法。

它的基本思想是通过最小化预测值与实际观测值之间的平方误差来拟合一个线性模型。

在最小二乘法中,我们通常使用矩阵表示法来描述问题。

设 (X) 为 (n \times p) 的设计矩阵,其中每一行表示一个样本,每一列表示一个特征。

设 (y) 为 (n \times 1) 的响应向量。

线性回归模型可以表示为 (y = X\beta + \epsilon),其中 (\beta) 是 (p \times 1) 的参数向量,(\epsilon) 是误差项。

最小二乘法的目标是最小化 (||X\beta - y||^2),即最小化预测值与实际观测值之间的平方误差。

高斯-牛顿法是一种迭代算法,用于求解非线性最小二乘问题。

它是一种基于雅可比矩阵的优化方法,通过迭代更新参数向量来逼近最优解。

高斯-牛顿法的每一次迭代包括以下步骤:计算雅可比矩阵 (J(\beta)) 和海森矩阵 (H(\beta))。

计算负海森矩阵 (H(\beta)) 的逆矩阵 (H^{-1}(\beta))。

计算参数向量的更新值 (\Delta\beta = -H^{-1}(\beta) J(\beta))。

更新参数向量 (\beta = \beta + \Delta\beta)。

重复步骤 1-4,直到参数向量收敛。

高斯-牛顿法的优点是可以处理非线性问题,并且收敛速度快。

但是,它需要计算海森矩阵和其逆矩阵,这可能在计算上比较昂贵。

因此,对于大规模问题,可能需要使用其他优化技术,如梯度下降法或拟牛顿法。

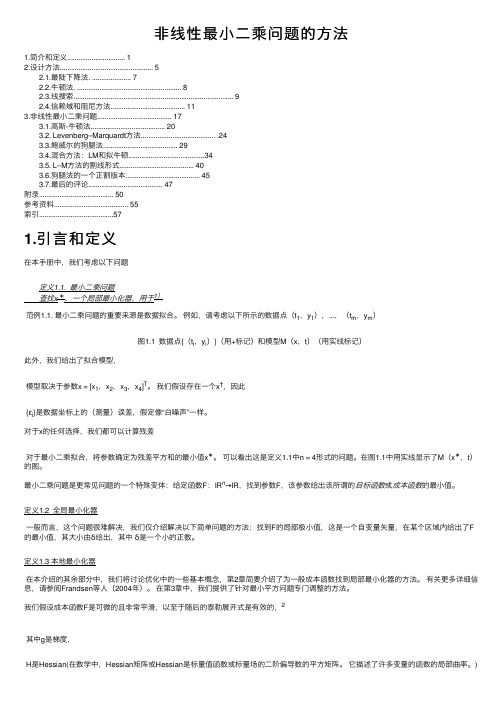

非线性最小二乘问题的方法

⾮线性最⼩⼆乘问题的⽅法1.简介和定义 (1)2.设计⽅法 (5) 2.1.最陡下降法. (7) 2.2.⽜顿法. (8) 2.3.线搜索 (9) 2.4.信赖域和阻尼⽅法 (11)3.⾮线性最⼩⼆乘问题 (17) 3.1.⾼斯-⽜顿法 (20) 3.2. Levenberg–Marquardt⽅法........................................ .24 3.3.鲍威尔的狗腿法 (29) 3.4.混合⽅法:LM和拟⽜顿 (34) 3.5. L–M⽅法的割线形式 (40) 3.6.狗腿法的⼀个正割版本 (45) 3.7.最后的评论 (47)附录 (50)参考资料 (55)索引 (57)1.引⾔和定义在本⼿册中,我们考虑以下问题 定义1.1. 最⼩⼆乘问题 查找x∗,⼀个局部最⼩化器,⽤于1)范例1.1. 最⼩⼆乘问题的重要来源是数据拟合。

例如,请考虑以下所⽰的数据点(t1,y1),...,(t m,y m)图1.1 数据点{(t i,y i)}(⽤+标记)和模型M(x,t)(⽤实线标记)此外,我们给出了拟合模型,模型取决于参数x = [x1,x2,x3,x4]T。

我们假设存在⼀个x†,因此{εi}是数据坐标上的(测量)误差,假定像“⽩噪声”⼀样。

对于x的任何选择,我们都可以计算残差对于最⼩⼆乘拟合,将参数确定为残差平⽅和的最⼩值x∗。

可以看出这是定义1.1中n = 4形式的问题。

在图1.1中⽤实线显⽰了M(x∗,t)的图。

最⼩⼆乘问题是更常见问题的⼀个特殊变体:给定函数F:IR n→IR,找到参数F,该参数给出该所谓的⽬标函数或成本函数的最⼩值。

定义1.2 全局最⼩化器⼀般⽽⾔,这个问题很难解决,我们仅介绍解决以下简单问题的⽅法:找到F的局部极⼩值,这是⼀个⾃变量⽮量,在某个区域内给出了F 的最⼩值,其⼤⼩由δ给出,其中δ是⼀个⼩的正数。

定义1.3 本地最⼩化器在本介绍的其余部分中,我们将讨论优化中的⼀些基本概念,第2章简要介绍了为⼀般成本函数找到局部最⼩化器的⽅法。

最优化方法第二章_非线性最小二乘

k 0.75, 0.25 k 0.75, k 0.25,

T

从而,求解该问题的牛顿法为

xk 1 xk ( J ( xk )T J ( xk ) s ( xk )) 1 J ( xk )T r ( xk )

上式局部二阶收敛,但计算量大!

二、Gauss-Newton法 Gauss-Newton法 忽略难于计算的高阶项 s ( xk )

1 mk ( x) r ( xk )T r ( xk ) ( J ( x)T r ( xk ))T ( x xk ) 2 1 ( x xk )T ( J ( xk )T J ( xk ))( x xk ) 2

二、Gauss-Newton法 Gauss-Newton法的优缺点 对于零残量问题(即 r ( x* ) 0 ),具有局部二阶收敛速度。

对于小残量问题(即残差较小,或者接近于线性 ),具

有较快的局部收敛速度。 对于线性最小二乘问题,一步达到极小值点。 对于不是很严重的大残量问题,有较慢的收敛速度。

r ( x) r ( xk ) J ( xk )( x xk ) M k ( x)

从而求解线性最小二乘问题

1 min M k ( x) 2

由线性最小二乘理论知

2

xk 1 xk ( J ( xk ) J ( xk )) J ( xk ) r ( xk )

T T

1

xk d k

如果雅克比矩阵不满秩,下降方向取为最速下降方向。

采用带阻尼的G-N法,保证函数值下降(方法总体收敛)。

xk 1 xk k ( J ( xk ) J ( xk )) J ( xk ) r ( xk )

matlab:最小二乘法线性和非线性拟合

x f 1 1.5 2 3.9 4 6.6 7 11.7 9 15.6 12 13 18.8 19.6 15 20.6 17 21.1

MATLAB(cn)

7

最临近插值、线性插值、样条插值与曲线拟合结果:

25

0 0 2 4 6 8 10 12 14 16 18

MATLAB(zxec2)

%作出数据点和拟合曲线的图形 20.1293 -0.0317

2)计算结果: A = -9.8108

f ( x) 9.8108x 2 20.1293x 0.0317

17

用MATLAB作非线性最小二乘拟合

Matlab的提供了两个求非线性最小二乘拟合的函数: lsqcurvefit和lsqnonlin。两个命令都要先建立M-文件fun.m, 在其中定义函数f(x),但两者定义f(x)的方式是不同的,可参 考例题. 1. lsqcurvefit 已知数据点: xdata=(xdata1,xdata2,…,xdatan), ydata=(ydata1,ydata2,…,ydatan) lsqcurvefit用以求含参量x(向量)的向量值函数

最小。 其中 fi(x)=f(x,xdatai,ydatai) =F(x,xdatai)-ydatai

20

输入格式为: 1) x=lsqnonlin(‘fun’,x0); 2) x= lsqnonlin (‘fun’,x0,options); 3) x= lsqnonlin (‘fun’,x0,options,‘grad’); 4) [x,options]= lsqnonlin (‘fun’,x0,…); 5) [x,options,funval]= lsqnonlin 说明: x= lsqnonlin (‘ fun’ x0 ,…); (‘fun’,x0,options); fun是一个事先建立的 定义函数f(x)的M-文件, 自变量为x 选项见无 迭代初值 约束优化

【计算机应用】_非线性最小二乘法_期刊发文热词逐年推荐_20140726

科研热词 最小二乘法 非线性回归 逼近 色差 线性回归 极小泛函 松弛时间谱 多元非线性回归 光顺 mc尼龙6 maxwell模型 matlab kevlar纤维 c-bezier曲线

推荐指数 2 1 1 1 1 1 1 1 1 1 1 1 1 1

2009年 序号 1 2 3 4 5 6 7 8 9 10 11 12

科研热词 非线性最小二乘法 软件 触摸屏校准 神经网络优化 激励函数 气路控制 机理建模 嵌入式系统 实验数据处理 定点数权值 化工原理 列尾检测

推荐指数 1 1 1 1 1 1 1 1 1 1 1 1

2010年 序号 1 2 3 4 5 6 7 8 9 10

科研热词 预测 甲酸 汽液平衡 水 最小二乘法 方向向量 形状模板匹配 图像金字塔 n-甲基吡咯烷酮 canny算子

推荐指数 1 1 1 1 1 1 1 1 1 1

2011年 序号 1 2 3 4 5 6 7 8 9 10

2011年 科研热词 非线性 近红外光谱技术 自适应控制 聚类 精馏塔 故障诊断 掺假 奶粉 多模型 动态模拟 推荐指数 1 1 1 1 1 1 1 1 1 1

2013年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13

科研热词 间歇过程 透视投影 线性矩阵不等式 目标跟踪 无线传感器网络 平行性约束 单目视觉 分布式扩展卡尔曼滤波 共面特征点 位姿测量 二次型迭代学习控制 一致性算法 s-procedure

ห้องสมุดไป่ตู้

推荐指数 1 1 1 1 1 1 1 1 1 1 1 1 1

2012年 序号 1 2 3 4 5 6 7 8 9 10 11 12 13 14

最小二乘法线性与非线性拟合

最小二乘法线性与非线性拟合最小二乘法实现数据拟合最小二乘法原理函数插值是差值函数p(x)与被插函数f(x)在节点处函数值相同,即p( )=f( ) (i=0,1,2,3……,n),而曲线拟合函数不要求严格地通过所有数据点( ),也就是说拟合函数在处的偏差=不都严格地等于零。

但是,为了使近似曲线能尽量反应所给数据点的变化趋势,要求| |按某种度量标准最小。

即=为最小。

这种要求误差平方和最小的拟合称为曲线拟合的最小二乘法。

(一)线性最小二乘拟合根据线性最小二乘拟合理论,我们得知关于系数矩阵A的解法为A=R\Y。

例题假设测出了一组,由下面的表格给出,且已知函数原型为y(x)=c1+c2*e^(-3*x)+c3*cos(-2*x)*exp(-4*x)+c4*x^2试用已知数据求出待定系数的值。

在Matlab中输入以下程序x=[0,0.2,0.4,0.7,0.9,0.92,0.99,1.2,1.4,1.48,1.5]';y=[2.88;2.2576;1.9683;1.9258;2.0862;2.109;2.1979;2.5409;2.9627;3.155;3.2052];A=[ones(size(x)) exp(-3*x),cos(-2*x).*exp(-4*x) x.^2];c=A\y;c'运行结果为ans =1.22002.3397 -0.6797 0.8700下面画出由拟合得到的曲线及已知的数据散点图x1=[0:0.01:1.5]';A1=[ones(size(x1)) exp(-3*x1),cos(-2*x1).*exp(-4*x1) x1.^2]; y1=A1*c;plot(x1,y1,x,y,'o')事实上,上面给出的数据就是由已知曲线y(x)= 0.8700-0.6797*e^(-3*x)+ 2.3397*cos(-2*x)*exp(-4*x)+1.2200*x^2产生的,由上图可见拟合效果较好。

非线性最小二乘问题的求解方法

⾮线性最⼩⼆乘问题的求解⽅法⽬录希望朋友们阅读后能够留下⼀些提⾼的建议呀,哈哈哈!1. ⾮线性最⼩⼆乘问题的定义对于形如(1)的函数,希望寻找⼀个局部最优的x ∗,使得F (x )达到局部极⼩值F (x ∗) 。

F (x )=12m ∑i =1f i (x )2其中,f i :R n ↦R ,i =1,…,m ,即 x ∈R n ,f i (x )∈R 。

局部极⼩值:存在δ>0,对任意满⾜‖x −x ∗‖<δ 的x ,都有F x ∗≤F (x )。

这⾥举三个简单的例⼦:1. x ∈R ,m =1,f 1(x )=x +1,则F (x )=12(x +1)2,局部极⼩值在x ∗=−1处取得。

2. x ∈R ,m =2,f 1(x )=x +1,f 2(x )=exp (3x 2+2x +1),则F (x )=12(x +1)2+exp (3x 2+2x +1),此时就不容易计算出局部最优x ∗的位置了。

3. x ∈R 3,m =1,f 1(x )=x T x ,则F (x )=12(x T x )2事实上,f i 也可以将x 映射到R m 空间中,因为f i (x )2=f i (x )T f i (x )∈R ,最终计算出来的值总是⼀个实数。

对于简单的最⼩⼆乘问题,如1,可以⽤求导取极值的⽅法得到局部极⼩值的位置,然⽽复杂的、⾼维的,如2和3,就只能采取⼀些迭代的策略来求解局部极⼩值了。

注意,是局部极⼩值⽽⾮全局最⼩值!对于凸函数⽽⾔是可以得到全局最⼩值的。

2. 最速下降法假设函数(1)是可导并且光滑的,则可以对函数(1)在x 处进⾏⼆阶泰勒展开为(2)式F (x +Δx )=F (x )+Δx T J +12Δx ⊤H Δx +O ‖Δx ‖3其中 J =∂J (x )∂x 1⋮∂J (x )∂x n ,H =∂2H (x )∂x 1∂x 1⋯∂2H (x )∂x 1∂x n ⋮⋱⋮∂2H (x )∂x n ∂x 1⋯∂2H (x )∂x n ∂x n ,J 和H 分别F 对变量x 的⼀阶导和⼆阶导。

matlab:最小二乘法线性和非线性拟合

0.0056 0.0063 0.2542

0.0059 0.0063

4)结论:a=0.0063, b=-0.0034, k=0.2542

0.0061 0.0063

24

解法 2 用命令lsqnonlin

f(x)=F(x,tdata,ctada)= (a be0.02kt1 c1,, a be0.02kt10 c1)T

R=[(x.^2)' x' ones(11,1)]; A=R\y'

MATLAB(zxec1)

2)计算成果: A = -9.8108 20.1293 -0.0317

f (x) 9.8108x2 20.1293x 0.0317 16

解法2.用多项式拟合旳命令

1)输入下列命令: x=0:0.1:1;

9

线性最小二乘法旳求解:预备知识

超定方程组:方程个数不小于未知量个数旳方程组

r11a1

r12a2

r1mam

y1

(n m)

rn1a1 rn2a2 rnmam yn

即 Ra=y

r11 r12 r1m

a1

y1

其中 R

,

a

,

y

rn1 rn2 rnm

am

yn

2. 将数据 (xi,yi) i=1, …n 作图,经过直观判断拟定 f(x):

f=a1+a2x +

++

++

f=a1+a2x+a3x2 +

+

+ +

+

f=a1+a2x+a3x2

++ +

最小二乘法 线性与非线性拟合

---------------------------------------------------------------最新资料推荐------------------------------------------------------最小二乘法线性与非线性拟合最小二乘法线性与非线性拟合最小二乘法实现数据拟合最小二乘法原理函数插值是差值函数 p(x)与被插函数 f(x)在节点处函数值相同,即 p( )=f( ) (i=0,1,2,3,n),而曲线拟合函数不要求严格地通过所有数据点( ),也就是说拟合函数在处的偏差= 不都严格地等于零。

但是,为了使近似曲线能尽量反应所给数据点的变化趋势,要求| |按某种度量标准最小。

即ab 中输入以下程序x=[0,0.2,0.4,0.7,0.9,0.92,0.99,1.2,1.4,1.48,1.5]’;y=[2.88;2.2576;1.9683;1.9258;2.0862;2.109;2.1979;2.5409;2.9627;3.155;3.2052]; A=[ones(size(x)) exp(-3*x),cos(-2*x).*exp(-4*x) x.]; c=A\y; c’ 运行结果为ans = 1.2200 2.3397 -0.6797 0.8700 下面画出由拟合得到的曲线及已知的数据散点图x1=[0:0.01:1.5]’; A1=[ones(size(x1)) exp(-3*x1),cos(-2*x1).*exp(-4*x1) x1.]; x 0 0.2 0.4 0.7 0.9 0.92 0.99 1 .2 1 .4 1 .48 1 .5 y 2.88 2.2576 1 .9683 1 .9258 2.0862 2.1 09 2.1 979 2.5409 2.9627矩阵,表示因变量矩阵,是输出的系数矩阵,即多项式的系数。

多项式在自变量 x 处的函数值 y 可用以下命令计算:y=polyval(A,x) 例题对下面一组数据作二次多项式拟合,即1 / 6要求出二次多项式中的,使最小。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

非线性最小二乘法

编辑词条分享

•新知社新浪微博腾讯微博人人网QQ空间网易微博开心001天涯飞信空间MSN移动说客

非线性最小二乘法

非线性最小二乘法是以误差的平方和最小为准则来估计非线性静态模型参数的一种参数估

计方法。

编辑摘要

目录

1 简介

2 推导

3 配图

4 相关连接

非线性最小二乘法 - 简介

以误差的平方和最小为准则来估计非线性静态模型参数的一种参数估计方法。

设非线性系统的模型为y=f(x,θ) 式中y是系统的输出,x是输入,θ是参数(它们可以是向量)。

这里的非线性是指对参数θ的非线性模型,不包括输入输出变量随时间的变化关系。

在估

计参数时模型的形式f是已知的,经过N次实验取得数据(x1,y1),(x2,y1), ,(xn,yn)。

估计参数的准则(或称目标函数)选为模型的误差平方和非线性最小二乘法就是求使Q达到极小的参数估计值孌。

推导

非线性最小二乘法 - 推导

以误差的平方和最小为准则来估计非线性静态模型参数的一种参数估计方法。

设非线

性系统的模型为

y=f(x,θ)

式中y是系统的输出,x是输入,θ是参数(它们可以是向量)。

这里的非线性是指对参数θ的非线性模型,不包括输入输出变量随时间的变化关系。

在估计参数时模型的形式f是已知的,经过N次实验取得数据(x1,y1),(x2,y1), ,(x n,y n)。

估计参数的准则(或称目标函数)选为模型的误差平方和

非线性最小二乘法就是求使Q达到极小的参数估计值孌。

由于f的非线性,所以不能象线性最小二乘法那样用求多元函数极值的办法来得到参

数估计值,而需要采用复杂的优化算法来求解。

常用的算法有两类,一类是搜索算法,另

一类是迭代算法。

搜索算法的思路是:按一定的规则选择若干组参数值,分别计算它们的目标函数值并

比较大小;选出使目标函数值最小的参数值,同时舍弃其他的参数值;然后按规则补充新

的参数值,再与原来留下的参数值进行比较,选出使目标函数达到最小的参数值。

如此继

续进行,直到选不出更好的参数值为止。

以不同的规则选择参数值,即可构成不同的搜索

算法。

常用的方法有单纯形搜索法、复合形搜索法、随机搜索法等。

迭代算法是从参数的某一初始猜测值θ(0)出发,然后产生一系列的参数点θ(1)、θ(2) ,如果这个参数序列收敛到使目标函数极小的参数点孌,那么对充分大的N就可用θ(N)作为孌。

迭代算法的一般步骤是:

① 给出初始猜测值θ(0),并置迭代步数i=1。

② 确定一个向量v(i)作为第i步的迭代方向。

③ 用寻优的方法决定一个标量步长ρ(i),使得 Q(θ(i))=Q(θ(i)),其中θ(i)=θi-1+ρ(i)v(i)。

④ 检查停机规则是否满足,如果不满足,则将i加1再从②开始重复;如果满足,则

取θ(i)为孌。

典型的迭代算法有牛顿-拉夫森法、高斯迭代算法、麦夸特算法、变尺度法等。

非线性最小二乘法除可直接用于估计静态非线性模型的参数外,在时间序列建模、连

续动态模型的参数估计中,也往往遇到求解非线性最小二乘问题。

非线性最小二乘法 - 配图

非线性最小二乘法。