centos 7+hadoop2.7.3详细安装教程

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu_CentOS

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS本教程讲述如何配置Hadoop 集群,默认读者已经掌握了Hadoop 的单机伪分布式配置,否则请先查看Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置。

本教程由厦门大学数据库实验室出品,转载请注明。

本教程适合于原生Hadoop 2,包括Hadoop 2.6.0, Hadoop 2.7.1 等版本,主要参考了官方安装教程,步骤详细,辅以适当说明,保证按照步骤来,都能顺利安装并运行Hadoop。

另外有Hadoop安装配置简略版方便有基础的读者快速完成安装。

为了方便新手入门,我们准备了两篇不同系统的Hadoop 伪分布式配置教程。

但其他Hadoop 教程我们将不再区分,可同时适用于Ubuntu 和CentOS/RedHat 系统。

例如本教程以Ubuntu 系统为主要演示环境,但对Ubuntu/CentOS 的不同配置之处、CentOS 6.x 与CentOS 7 的操作区别等都会尽量给出注明。

环境本教程使用Ubuntu 14.04 64位作为系统环境,基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1,Hadoop 2.4.1 等。

本教程简单的使用两个节点作为集群环境: 一个作为Master 节点,局域网IP 为192.168.1.121;另一个作为Slave 节点,局域网IP 为192.168.1.122。

准备工作Hadoop 集群的安装配置大致为如下流程:1.选定一台机器作为Master2.在Master 节点上配置hadoop 用户、安装SSH server、安装Java 环境3.在Master 节点上安装Hadoop,并完成配置4.在其他Slave 节点上配置hadoop 用户、安装SSH server、安装Java 环境5.将Master 节点上的/usr/local/hadoop 目录复制到其他Slave 节点上6.在Master 节点上开启Hadoop配置hadoop 用户、安装SSH server、安装Java 环境、安装Hadoop 等过程已经在Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置中有详细介绍,请前往查看,不再重复叙述。

Hadoop完全分布式详细安装过程

Hadoop详细安装过程一、本文思路1、安装虚拟化PC工具VMware,用于支撑Linux系统。

2、在VMware上安装Ubuntu系统。

3、安装Hadoop前的准备工作:安装JDK和SSH服务。

4、配置Hadoop。

5、为了方便开发过程,需安装eclipse。

6、运行一个简单的Hadoop程序:WordCount.java注:在win7系统上,利用虚拟工具VMware建立若干个Linux系统,每个系统为一个节点,构建Hadoop集群。

先在一个虚拟机上将所有需要配置的东西全部完成,然后再利用VMware 的克隆功能,直接生成其他虚拟机,这样做的目的是简单。

二、所需软件1、VMware:VMware Workstation,直接百度下载(在百度软件中心下载即可)。

2、Ubuntu系统:ubuntu-15.04-desktop-amd64.iso,百度网盘:/s/1qWxfxso注:使用15.04版本的Ubuntu(其他版本也可以),是64位系统。

3、jdk:jdk-8u60-linux-x64.tar.gz,网址:/technetwork/java/javase/downloads/jdk8-downloads-2133151.html注:下载64位的Linux版本的jdk。

4、Hadoop:hadoop-1.2.1-bin.tar.gz,网址:/apache/hadoop/common/hadoop-1.2.1/注:选择1.2.1版本的Hadoop。

5、eclipse:eclipse-java-mars-1-linux-gtk-x86_64.tar.gz,网址:/downloads/?osType=linux注:要选择Linux版本的,64位,如下:6、hadoop-eclipse-plugin-1.2.1.jar,这是eclipse的一个插件,用于Hadoop的开发,直接百度下载即可。

三、安装过程1、安装VMware。

hadoop安装以及配置启动命令

hadoop安装以及配置启动命令本次安装使⽤的Hadoop⽂件是badou学院的Hadoop1.2.1.tar.gz,以下步骤都是在此版本上进⾏。

1、安装,通过下载tar.gz⽂件安装到指定⽬录2、安装好后需要配置Hadoop集群配置信息: 在hadoop的conf路径中的masters中添加master(集群机器主的hostname)在slaves中添加集群的slave的hostname名称名称对应的是各⾃机器的hostname这样通过hosts⽂件中配置的域名地址映射可以直接找到对应的机器 a、core-site.xml 在xml⽂件中添加<property><name>hadoop.tmp.dir</name><value>/usr/local/src/hadoop.1.2.1/tmp</value></property> <property><name></name><value>hdfs://192.168.79.10:9000</value></property> c、hdfs-site.xml 在⽂件中添加<property><name>dfs.replication</name><value>3</value></property><!-- 复制节点数 --> d、hadoop-env.xml 在⽂件中添加export JAVA_HOME=/usr/local/src/jdk1.6.0_45 步骤2配置好后将当前hadoop⽂件夹复制到集群中其他机器上,只需要在对应机器上修改其对应的ip、port、jdk路径等信息即可搭建集群3、配置好Hadoop环境后需要测试环境是否可⽤: a、⾸先进⼊Hadoop的安装⽬录,进⼊bin⽬录下,先将Hadoop环境初始化,命令:./hadoop namenode -format b、初始化之后启动Hadoop,命令:./start_all.sh c、查看Hadoop根⽬录下的⽂件,命令:./hadoop fs -ls/ d、上传⽂件,命令:./hadoop fs -put ⽂件路径 e、查看⽂件内容,命令:./hadoopo fs -cat hadoop⽂件地址注意:在安装Hadoop环境时先安装好机器集群,使得⾄少3台以上(含3台)机器之间可以免密互相登录(可以查看上⼀篇的linux的ssh免密登录)执⾏Python⽂件时的部分配置/usr/local/src/hadoop-1.2.1/bin/hadoop/usr/local/src/hadoop-1.2.1/contrib/streaming/hadoop-streaming-1.2.1.jar。

Hadoop集群的搭建方法与步骤

Hadoop集群的搭建方法与步骤随着大数据时代的到来,Hadoop作为一种分布式计算框架,被广泛应用于数据处理和分析领域。

搭建一个高效稳定的Hadoop集群对于数据科学家和工程师来说至关重要。

本文将介绍Hadoop集群的搭建方法与步骤。

一、硬件准备在搭建Hadoop集群之前,首先要准备好适合的硬件设备。

Hadoop集群通常需要至少三台服务器,一台用于NameNode,两台用于DataNode。

每台服务器的配置应该具备足够的内存和存储空间,以及稳定的网络连接。

二、操作系统安装在选择操作系统时,通常推荐使用Linux发行版,如Ubuntu、CentOS等。

这些操作系统具有良好的稳定性和兼容性,并且有大量的Hadoop安装和配置文档可供参考。

安装操作系统后,确保所有服务器上的软件包都是最新的。

三、Java环境配置Hadoop是基于Java开发的,因此在搭建Hadoop集群之前,需要在所有服务器上配置Java环境。

下载最新版本的Java Development Kit(JDK),并按照官方文档的指引进行安装和配置。

确保JAVA_HOME环境变量已正确设置,并且可以在所有服务器上运行Java命令。

四、Hadoop安装与配置1. 下载Hadoop从Hadoop官方网站上下载最新的稳定版本,并将其解压到一个合适的目录下,例如/opt/hadoop。

2. 编辑配置文件进入Hadoop的安装目录,编辑conf目录下的hadoop-env.sh文件,设置JAVA_HOME环境变量为Java的安装路径。

然后,编辑core-site.xml文件,配置Hadoop的核心参数,如文件系统的默认URI和临时目录。

接下来,编辑hdfs-site.xml文件,配置Hadoop分布式文件系统(HDFS)的相关参数,如副本数量和数据块大小。

最后,编辑mapred-site.xml文件,配置MapReduce框架的相关参数,如任务调度器和本地任务运行模式。

Hadoop大数据平台安装实验(详细步骤)(虚拟机linux)

大数据技术实验报告大数据技术实验一Hadoop大数据平台安装实验1实验目的在大数据时代,存在很多开源的分布式数据采集、计算、存储技术,本实验将在熟练掌握几种常见Linux命令的基础上搭建Hadoop(HDFS、MapReduce、HBase、Hive)、Spark、Scala、Storm、Kafka、JDK、MySQL、ZooKeeper等的大数据采集、处理分析技术环境。

2实验环境个人笔记本电脑Win10、Oracle VM VirtualBox 5.2.44、CentOS-7-x86_64-Minimal-1511.iso3实验步骤首先安装虚拟机管理程序,然后创建三台虚拟服务器,最后在虚拟服务器上搭建以Hadoop 集群为核心的大数据平台。

3.1快速热身,熟悉并操作下列Linux命令·创建一个初始文件夹,以自己的姓名(英文)命名;进入该文件夹,在这个文件夹下创建一个文件,命名为Hadoop.txt。

·查看这个文件夹下的文件列表。

·在Hadoop.txt中写入“Hello Hadoop!”,并保存·在该文件夹中创建子文件夹”Sub”,随后将Hadoop.txt文件移动到子文件夹中。

·递归的删除整个初始文件夹。

3.2安装虚拟机并做一些准备工作3.2.1安装虚拟机下载系统镜像,CentOS-7-x86_64-Minimal-1511.iso。

虚拟机软件使用Oracle VM VirtualBox 5.2.44。

3.2.2准备工作关闭防火墙和Selinux,其次要安装perl 、libaio、ntpdate 和screen。

然后检查网卡是否开机自启,之后修改hosts,检查网络是否正常如图:然后要创建hadoop用户,之后多次用,并且生成ssh 密钥并分发。

最后安装NTP 服务。

3.3安装MYSQL 3.3.1安装3.3.2测试3.4安装ZooKeeper。

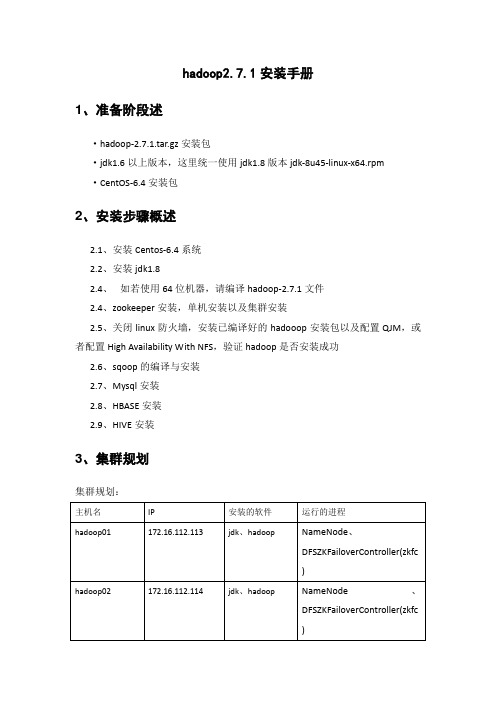

hadoop2.7.1安装手册

hadoop2.7.1安装手册1、准备阶段述·hadoop-2.7.1.tar.gz安装包·jdk1.6以上版本,这里统一使用jdk1.8版本jdk-8u45-linux-x64.rpm·CentOS-6.4安装包2、安装步骤概述2.1、安装Centos-6.4系统2.2、安装jdk1.82.4、如若使用64位机器,请编译hadoop-2.7.1文件2.4、zookeeper安装,单机安装以及集群安装2.5、关闭linux防火墙,安装已编译好的hadooop安装包以及配置QJM,或者配置High Availability With NFS,验证hadoop是否安装成功2.6、sqoop的编译与安装2.7、Mysql安装2.8、HBASE安装2.9、HIVE安装3、集群规划集群规划:4、安装具体步骤4.1、安装Centos-6.4系统(1)、下载64位的CentOS-6.4镜像文件CentOS-6.4-x86_64-bin-DVD1.isoCentOS-6.4-x86_64-bin-DVD2.iso系统安装只用到CentOS-6.4-x86_64-bin-DVD1.iso这个镜像,第二个镜像是系统自带的软件安装包下载完成之后,使用光盘刻录软件将ISO镜像文件刻录在CD或者DVD光盘里得到一张安装光盘(2)、安装CentOS·使用安装介质启动电脑出现如下界面·选择Install or upgrade an existing system,并跳过media test ·出现引导界面,点击next·语言选择,选“English”,以防止出现乱码·键盘布局选择:U.S.English·选择“Basic Storage Devies”,点击next·询问是否忽略所有数据,新电脑安装系统选择"Yes,discard any data" ·Hostname填写·网络设置安装图示顺序点击就可以了·时区可以在地图上点击,选择“shanghai”并取消System clock uses UTC前面的对勾·设置root的密码·硬盘分区,一定要按照图示点选·调整分区,必须要有/home这个分区,如果没有这个分区,安装部分软件会出现不能安装的问题·询问是否格式化分区·将更改写入到硬盘·引导程序安装位置·选择安装模式选择Minimal Desktop安装模式,并且选择现在进行客户化定制在进行“客户化定制时”可直接next,不过在language support时,选择“Chinese Support”,如下图:·(3)、修改虚拟机主机名并建立IP地址与主机名之间的映射关系,最后重启虚拟机以root权限登录·修改主机名:vi /etc/sysconfig/network ;分别修改HOSTNAME的值,为对应的主机名hadoop01、hadoop02、hadoop03·建立IP地址与主机名之间的映射关系:vi /etc/hosts;在hadoop01虚拟机的hosts文件中添加如下字段:172.16.112.113 hadoop01在hadoop02虚拟机的hosts文件中添加如下字段:172.16.112.114 hadoop02在hadoop03虚拟机的hosts文件中添加如下字段:172.16.112.115 hadoop03在hadoop02虚拟机的hosts文件中添加如下字段:172.16.112.116 hadoop04在hadoop02虚拟机的hosts文件中添加如下字段:172.16.112.117 hadoop05在hadoop02虚拟机的hosts文件中添加如下字段:172.16.112.118 hadoop06在hadoop02虚拟机的hosts文件中添加如下字段:172.16.112.119 hadoop074.2、安装jdk1.8(1)、在hadoop家目录下创建software文件夹,并使用Secure CRT工具,点击Secure FX将所需要的jdk安装包上传到linux系统上的software文件中·切换回当前用户:su – hadoop01·创建目录:mkdir /home/hadoop01/software·上传文件:(以二进制文件形式传输)(2)、安装jdk1.8·进入jdk1.8存放目录:cd /home/hadoop01/software/·切换为root用户:su,输入密码·安装jdk1.8: rpm -ivh jdk-8u45-linux-x64.rpm(3)、配置jdk环境变量·设置环境变量:vi /etc/profile·在profile文件中设置JAVA_HOME、CLASS_PATH、PATH三个环境变量:# JAVA_HOMEexport JAVA_HOME=/usr/java/jdk1.8.0_45# CLASSPATHexportCLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar#PATHexport PATH=$PATH:$JAVA_HOME/bin·启动配置项:source /etc/profile·验证jdk是否安装成功:java –version如图:安装成功4.3编译hadoop2.7.1(1)、实现ssh登录,公钥自联·登录root用户:su ,输入密码·打开公钥验证服务:#RSAAuthentication yes#PubkeyAuthentication yes#AuthorizedKeysFile .ssh/authorized_keys去掉这也项的#·重启ssh服务:service sshd restart·以hadoop01账户登录linux系统:su – hadoop01·启动ssh协议:rpm -qa|grep opensshrpm -qa|grep rsync·生成密钥对:ssh-keygen -t rsa -P '' 直接回车·将公钥写入授权文件:cat ~/.ssh/id_dsa.pub >> authorized-keys·修改授权文件权限:授权文件:chmod 600 ~/.ssh/authorized-keys·验证ssh登录:ssh localhost多次ssh登录到localhost用户观察是否还需要输入密码如图时,成功(2)、将hadoop01作为Master节点,配置ssh免密码登陆,使得hadoop01无密码登录所有的slave节点:·将其他两台hadoop02,hadoop03,hadoop04,hadoop05,hadoop06,hadoop07实现一次自联过程·分别修改hadoop02,hadoop03,hadoop04,hadoop05,hadoop06,hadoop07节点上.ssh文件的权限和authorized-keys文件的权限:chmod 700 ~/.sshchmod 600 authorized-keys·将hadoop01节点的公钥传给hadoop02,hadoop03,hadoop04,hadoop05,hadoop06,hadoop07:scp ~/.ssh/id_rsa.pub hadoop@hadoop02:~/scp ~/.ssh/id_rsa.pub hadoop@hadoop03:~/scp ~/.ssh/id_rsa.pub hadoop@hadoop04:~/scp ~/.ssh/id_rsa.pub hadoop@hadoop05:~/scp ~/.ssh/id_rsa.pub hadoop@hadoop06:~/scp ~/.ssh/id_rsa.pub hadoop@hadoop07:~/·将hadoop01的公钥追加到hadoop02,hadoop03,hadoop04,hadoop05,hadoop06,hadoop07的authorized-keys中:cat ~/id_rsa.pub >> ~/.ssh/authorized-keys·验证是否实现ssh登录ssh hadoop02ssh hadoop03ssh hadoop04ssh hadoop05ssh hadoop06ssh hadoop07(3)、编译hadoop-2.7.1环境·所需软件:maven、protobuf、openssl库、CMake、ant·安装maven:1、解压缩压缩包:tar -zxvf apache-maven-3.3.3-bin.tar.gz2、设置Maven环境变量:#MAVENexport MAVEN_HOME=/home/hadoop/software/apache-maven-3.3.3#environment pathexport PATH= /home/hadoop/software/apache-maven-3.3.3/bin3、生效source /etc/profile4、验证mavenmvn –v·安装protobuf-2.5.01、安装依赖包以root身份登录yum install gcc-c++2、解压protobuf-2.5.0安装包tar -zxvf protobuf-2.5.0.tar.gz3、进入protobuf-2.5.0文件夹,进行如下操作:./configuremakemake checkmake installldconfig4、修改环境变量:vi /etc/profile#protobufexport LD_LIBRARY_PATH=/home/hadoop/software/protobuf-2.5.05、生效source /etc/profile注意:配置/etc/profile,在虚拟机重启后,可能配置会失效,所以重启后,需要再次执行source操作。

CentOS7安装教程(步骤齐全)

CentOS7安装教程(步骤齐全)第⼀步:选择Install CentOS7来进⾏安装

第⼆步:选择安装语⾔,建议选择English,然后点击继续

第三步:依次进⾏ [软件选择]和[分区操作]

3.1、软件安装选择,刚开始建议选择GNOME桌⾯,环境附加选择GNOME应⽤程序、互联⽹应⽤程序、和开发⼯具

第四步:分区操作,也可以选择⾃动分区

4.1、⼿动分区操作

4.2、进⾏⼿动分区配置,点击[我要配置分区]后点击完成

4.3、进⼊⼿动配置分区界⾯

点击+ 新增⼀个分区;

挂载点选择swap交换分区(相当于Windwos中的虚拟内存),并设置容量为2G

然后点击挂载

点击+ 新增第⼆个分区;

挂载点选择 / 根⽬录(相当于Windwos中的C盘),并设置容量为18G

然后点击挂载

添加挂载点后

点击完成

第五步:开始安装系统

创建⼀个普通⽤户⽤来登录系统

创建root密码⽤来⾼级操作

点击ROOT密码,输⼊后点击完成(ROOT密码需要⼀定的密码强度否则不会通过)

创建登录⽤户(此⽤户⽤来登录系统所⽤)

完成后等待安装继续

重启后配置许可证和⽹络

点击同意此协议

点击完成

配置⽹络连接

⽹络的配置⽅式可以选择动态IP或者静态IP 我这⾥选择的是静态IP

IP地址⼀定要和上⽅路由处于同⼀⽹段

点击安装时创建的⽤户

系统安装完成,接下来就可以正式使⽤了。

小斌-CentOS7的详细安装图解

如果说Ubuntu是现今最受桌面用户欢迎的Linux操作系统,那么CentOS就是最受公司、企业、IDC喜爱的Linux发行版了,得益于它极为出色的稳定性,全球范围内有无数著名网站均选用它。

CentOS是基于Red Hat Enterprise Linux(收费昂贵但口碑极佳)的源代码再编译出来的免费版,因此不仅继承RHEL优越的稳定性,还提供免费更新,因此在服务器提供商、中小型公司中装机量几乎是最大的Linux发行版,现在已正式加入红帽公司。

从事互联网技术的同学,CentOS应该是值得你深入了解学习研究的.....所需的准备工作:1、VMware Workststion 10虚拟机软件2、CentOS7操作系统下载地址:/s/1hqII5es密码:n0sf基于VMware 10下CentOS7的安装过程:1、首先点击新建虚拟机,选择"典型",然后下一步。

2、初始工作完成后,选择所需的CentOS 7 ISO镜像,点击"开始启动此虚拟机",然后进入安装界面。

3、选择安装过程中的语言,此处选择英文,默认即可4、进入安装配置主界面,CentOS 7主要配置工作都在此界面进行,如果没完全设置好,Begin installation按钮将灰选。

5、选择LOCALIZATION中的DATA&TIME项,选择时区Asia\Chongqing,设置完按Done返回。

如下图:6、LOCALIZATION中的KEYBOARD使用默认即可,如下图:7、设置支持的语言,选择LOCALIZATION中的LANGUAGE SUPPORT项,本文除了默认的英语,再选择了中文,设置完按Done返回。

如下图:8、安装源配置,选择SOFTWARE中的INSTALLATION SOURCE项,本文选择默认的安装源。

设置完按Done返回。

如下图:9、系统环境及软件安装,选择SOFTWARE中的SOFTWARE SELECTION项,根据自己需要,选炸ky"/kf/web/php/" target="_blank"class="keylink">PHP69KqtcS7t76zoaOxvs7E0aHU8UdOT01FIERlc2t0b3C7t76zo6 jX87Lgo6mjrNPSsuDOqri9vNO1xNK70KnI7bz+vLC5pL7fo6y4+b7d19S8utDo0qrRodT xsLLXsKGjyejWw83qsLREb25lt7W72KGjyOfPws28o7o8L3A+CjxwPjxpbWcgc3JjPQ== "/uploadfile/Collfiles/20140731/2014073113531345.p ng" alt="\">10、系统分区设置,选择SYSTEM中的INSTALLATION DESTINATION项,在Other StZ喎�"/kf/ware/vc/" target="_blank"class="keylink">vcmFnZSBPcHRpb25z1tCjrNGh1PHF5NbDt9bH+M/uobBJIHdpbGwg Y29uZmlndXJlIHBhcnRpdGlvbmluZyZxdW90O6OssLREb25lyLfIz6OsvPvPws28o7o8L3A+CjxwPjxpbWcgc3JjPQ=="/uploadfile/Collfiles/2014 0731/2014073113531346.png" alt="\">11、手动分区,选择Standard Partition分区方式,按Done确认,如下图:12、Centos分区格式同Windows完全不同,Windows分区格式一般为NTFS格式且安装在硬盘的C分区就OK,但是在CentOS中一般分两个分区:一个为根分区,即"\",文件系统为ext4格式.另一个为swap分区(内存小于2G时,设置为内存的2倍;内存大于或等于2G 时,设置为2G).这时候点击"+"号,新增挂载点,建立上面的两个分区,如下图所示:分区完成后,选择Done确认,弹出的对话框中选择Accept Changes,如下图所示:13、网络配置,主要是打开网卡,设置hostname,如下图所示:选择"Configure",按下图所示设置后,依次点击"Save","Done"返回,如下图:14、完成以上几步,基本配置已经完成。

Centos7下载和安装教程

Centos7下载和安装教程1.CentOS下载CentOS是免费版,推荐在官⽹上直接下载,⽹址:DVD ISO:普通光盘完整安装版镜像,可离线安装到计算机硬盘上,包含⼤量的常⽤软件,⼀般选择这种镜像类型即可。

Everything ISO:包含了完整安装版的内容,并对其进⾏补充,集成了所有软件。

Minimal ISO:这个版本为精简版的镜像,可以安装⼀个基本的CentOS系统,包含了可启动系统基本所需的最⼩安装包。

点击Everything ISO,进⼊下图Actual Country 是当前所在国家资源区,任选链接即可直接下载到本地,这⾥选择阿⾥云,约8.8G2.vmware workstation14 64下载⽹址:安装:1、双击“VMware-workstation-full-14.0.0-6661328.exe”启动VMware Workstation 14 Pro安装程序;在弹出的“欢迎”窗⼝中,点击“下⼀步”按钮进⼊下⼀步;在弹出的“最终⽤户协议”窗⼝中,勾选“我接受许可协议中的条款”复选框,然后点击“下⼀步”按钮进⼊下⼀步;在弹出的“⾃定义安装”窗⼝中,可以点击“更改”按钮选择VMware Workstation的安装⽬录(本教程中采⽤默认⽬录)。

选定安装位置后,勾选“增强型键盘驱动程序”,然后点击“下⼀步”按钮进⼊下⼀步;在弹出的“⽤户体验设置”窗⼝中,去掉“启动时检查产品更新”和“帮助完善VMware Workstation Pro(H)”复选框前的勾,然后点击“下⼀步”按钮进⼊下⼀步;在弹出的“快捷⽅式”窗⼝中,直接点击“下⼀步”按钮进⼊下⼀步;在弹出的“已准备好安装VMware Workstation Pro”窗⼝中,点击“安装”按钮开始安装;等待VMware安装完毕后,在弹出的“安装向导已完成”窗⼝中,点击“完成”按钮完成安装;在弹出的“系统重启提⽰”窗⼝中,点击“是”按钮重启系统(这⾥也可以点击“否”按钮,等激活VMware Workstation 14 Pro后再重启。

hadoop安装指南(非常详细,包成功)

➢3.10.2.进程➢JpsMaster节点:namenode/tasktracker(如果Master不兼做Slave, 不会出现datanode/TasktrackerSlave节点:datanode/Tasktracker说明:JobTracker 对应于NameNodeTaskTracker 对应于DataNodeDataNode 和NameNode 是针对数据存放来而言的JobTracker和TaskTracker是对于MapReduce执行而言的mapreduce中几个主要概念,mapreduce整体上可以分为这么几条执行线索:jobclient,JobTracker与TaskTracker。

1、JobClient会在用户端通过JobClient类将应用已经配置参数打包成jar文件存储到hdfs,并把路径提交到Jobtracker,然后由JobTracker创建每个Task(即MapTask和ReduceTask)并将它们分发到各个TaskTracker服务中去执行2、JobTracker是一个master服务,软件启动之后JobTracker接收Job,负责调度Job的每一个子任务task运行于TaskTracker上,并监控它们,如果发现有失败的task就重新运行它。

一般情况应该把JobTracker部署在单独的机器上。

3、TaskTracker是运行在多个节点上的slaver服务。

TaskTracker主动与JobTracker通信,接收作业,并负责直接执行每一个任务。

TaskTracker都需要运行在HDFS的DataNode上3.10.3.文件系统HDFS⏹查看文件系统根目录:Hadoop fs–ls /。

centos7使用手册

centos7使用手册CentOS 7 使用手册CentOS 是一种基于 Linux 的操作系统,提供了广泛的功能和特性,成为许多人首选的服务器操作系统。

本手册将为你提供详细的指南,帮助你快速上手使用 CentOS 7。

第一部分:安装 CentOS 7CentOS 7 的安装过程相对简单,你可以按照以下步骤进行安装:1. 下载 CentOS 7 镜像文件,可以从 CentOS 官方网站获得,确保选择与你的计算机体系结构相匹配的版本。

2. 使用软件将镜像文件写入 USB 驱动器或 DVD 光盘。

3. 将 USB 驱动器插入计算机或将 DVD 光盘放入光驱,并重新启动计算机。

4. 进入计算机的 BIOS 设置界面,设置引导顺序以从 USB 驱动器或DVD 光盘引导。

5. 根据屏幕上的提示选择适当的选项并开始安装过程。

6. 在安装程序提示时,设置主机名、网络配置、用户账户和密码等信息。

7. 完成安装后,重新启动计算机,你现在已经成功安装了 CentOS 7。

第二部分:初次登录和基本操作当你成功安装 CentOS 7 后,你可以按照以下步骤进行初次登录和基本操作:1. 在计算机启动后,你将看到一个登录画面,输入你设置的用户名和密码。

2. 成功登录后,你将看到一个命令行界面。

现在你可以开始使用CentOS 7。

3. 首先,你可以运行命令 `yum update` 来更新系统的软件包。

4. 接下来,你可以使用命令 `yum install` 安装你需要的软件包。

5. 若要查找特定的软件包,可以使用命令 `yum search` 进行搜索。

6. 要卸载软件包,请使用命令 `yum remove`。

7. 若需要重启计算机,可以使用命令 `reboot`。

第三部分:常用命令和操作以下是一些常用的命令和操作,供你在 CentOS 7 中使用:1. 文件和目录操作:- `ls`:列出当前目录的内容。

- `cd`:切换目录。

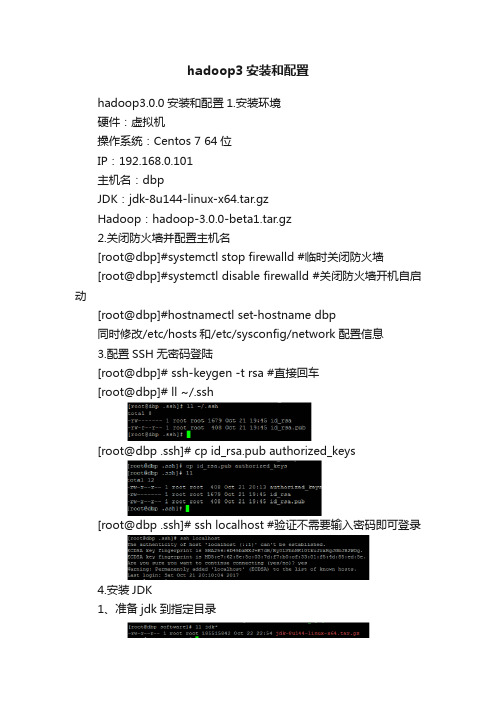

hadoop3安装和配置

hadoop3安装和配置hadoop3.0.0安装和配置1.安装环境硬件:虚拟机操作系统:Centos 7 64位IP:192.168.0.101主机名:dbpJDK:jdk-8u144-linux-x64.tar.gzHadoop:hadoop-3.0.0-beta1.tar.gz2.关闭防火墙并配置主机名[root@dbp]#systemctl stop firewalld #临时关闭防火墙[root@dbp]#systemctl disable firewalld #关闭防火墙开机自启动[root@dbp]#hostnamectl set-hostname dbp同时修改/etc/hosts和/etc/sysconfig/network配置信息3.配置SSH无密码登陆[root@dbp]# ssh-keygen -t rsa #直接回车[root@dbp]# ll ~/.ssh[************]#cpid_rsa.pubauthorized_keys[************]#sshlocalhost#验证不需要输入密码即可登录4.安装JDK1、准备jdk到指定目录2、解压[root@dbp software]# tar–xzvf jdk-8u144-linux-x64.tar.gz [root@dbp software]# mv jdk1.8.0_144/usr/local/jdk #重命名4、设置环境变量[root@dbp software]# vim ~/.bash_profile5、使环境变量生效并验证5.安装Hadoop3.0.01、准备hadoop到指定目录2、解压[root@dbp software]# tar -xzvf hadoop-3.0.0-beta1.tar.gz[root@dbp software]# mv hadoop-3.0.0-beta1 /usr/local/hadoop #重命名3、设置环境变量[root@dbp hadoop]# vim ~/.bash_profile4、使配置文件生效并验证[root@dbp hadoop]# source ~/.bash_profile5、Hadoop配置进入$HADOOP_HOME/etc/hadoop和$HADOOP_HOME/sbin目录,配置如下文件:hadoop-env.sh core-site.xmlhdfs-site.xmlmapred-site.xmlyarn-site.xmlstart-dfs.shstart-yarn.sh1)配置hadoop-env.sh2)配置core-site.xml3)配置hdfs-site.xml4)配置mapred-site.xml5)配置yarn-site.xml6)配置start-dfs.sh6)配置start-yarn.sh4、Hadoop启动1)格式化namenode[root@dbp conf]# hadoop namenode -format 2)启动NameNode 和DataNode 守护进程[root@dbp hadoop]# start-all.sh5、启动验证1)执行jps命令,有如下进程,说明Hadoop正常启动[root@dbp hadoop]# jps注意:NameNode进程没有配置成功:1)没有格式化2)配置文件主机名信息是否正确3)hostname与ip没有绑定4)SSH的免密码登陆没有配置成功。

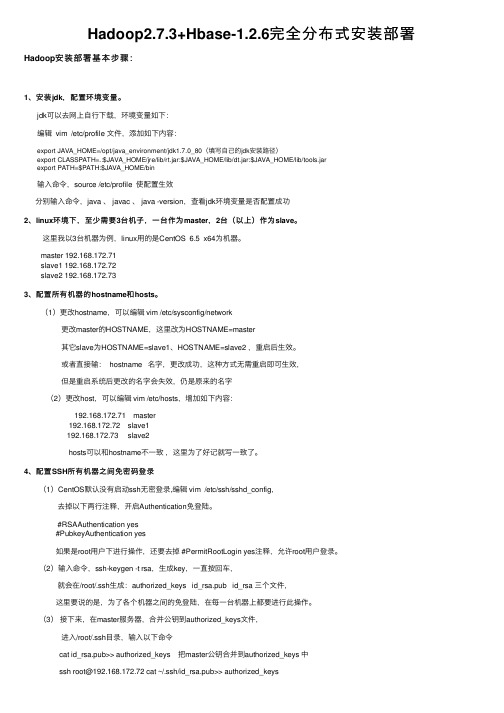

Hadoop2.7.3+Hbase-1.2.6完全分布式安装部署

Hadoop2.7.3+Hbase-1.2.6完全分布式安装部署Hadoop安装部署基本步骤:1、安装jdk,配置环境变量。

jdk可以去⽹上⾃⾏下载,环境变量如下:编辑 vim /etc/profile ⽂件,添加如下内容:export JAVA_HOME=/opt/java_environment/jdk1.7.0_80(填写⾃⼰的jdk安装路径)export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarexport PATH=$PATH:$JAVA_HOME/bin输⼊命令,source /etc/profile 使配置⽣效分别输⼊命令,java 、 javac 、 java -version,查看jdk环境变量是否配置成功2、linux环境下,⾄少需要3台机⼦,⼀台作为master,2台(以上)作为slave。

这⾥我以3台机器为例,linux⽤的是CentOS 6.5 x64为机器。

master 192.168.172.71slave1 192.168.172.72slave2 192.168.172.733、配置所有机器的hostname和hosts。

(1)更改hostname,可以编辑 vim /etc/sysconfig/network 更改master的HOSTNAME,这⾥改为HOSTNAME=master 其它slave为HOSTNAME=slave1、HOSTNAME=slave2 ,重启后⽣效。

或者直接输: hostname 名字,更改成功,这种⽅式⽆需重启即可⽣效, 但是重启系统后更改的名字会失效,仍是原来的名字 (2)更改host,可以编辑 vim /etc/hosts,增加如下内容: 192.168.172.71 master 192.168.172.72 slave1 192.168.172.73 slave2 hosts可以和hostname不⼀致,这⾥为了好记就写⼀致了。

centos环境下hadoop的安装与配置实验总结

centos环境下hadoop的安装与配置实验总结实验总结:CentOS环境下Hadoop的安装与配置一、实验目标本次实验的主要目标是学习在CentOS环境下安装和配置Hadoop,了解其基本原理和工作机制,并能够运行简单的MapReduce程序。

二、实验步骤1. 准备CentOS环境:首先,我们需要在CentOS上安装和配置好必要的基础环境,包括Java、SSH等。

2. 下载Hadoop:从Hadoop官方网站下载Hadoop的稳定版本,或者使用CentOS的软件仓库进行安装。

3. 配置Hadoop:解压Hadoop安装包后,需要进行一系列的配置。

这包括设置环境变量、配置文件修改等步骤。

4. 格式化HDFS:使用Hadoop的命令行工具,对HDFS进行格式化,创建其存储空间。

5. 启动Hadoop:启动Hadoop集群,包括NameNode、DataNode等。

6. 测试Hadoop:运行一些简单的MapReduce程序,检查Hadoop是否正常工作。

三、遇到的问题和解决方案1. 环境变量配置问题:在配置Hadoop的环境变量时,有时会出现一些问题。

我们需要检查JAVA_HOME是否设置正确,并确保HADOOP_HOME 在PATH中。

2. SSH连接问题:在启动Hadoop集群时,需要确保各个节点之间可以通过SSH进行通信。

如果出现问题,需要检查防火墙设置和SSH配置。

3. MapReduce程序运行问题:在运行MapReduce程序时,可能会遇到一些错误。

这通常是由于程序本身的问题,或者是由于HDFS的权限问题。

我们需要仔细检查程序代码,并确保运行程序的用户有足够的权限访问HDFS。

四、实验总结通过本次实验,我们深入了解了Hadoop的安装和配置过程,以及如何解决在安装和运行过程中遇到的问题。

这对于我们今后在实际应用中部署和使用Hadoop非常重要。

同时,也提高了我们的实践能力和解决问题的能力。

Centos7安装教程(详细版)

Centos7安装教程(详细版)1.软硬件准备软件:推荐使⽤ VMware,我⽤的是 VMware 15镜像:CentOS7 ,如果没有镜像可以在阿⾥云下载硬件:因为是在宿主机上运⾏虚拟化软件安装centos,所以对宿主机的配置有⼀定的要求。

配置不能太低,内存不能低于4G,否则可能资源占⽤导致卡顿。

2.虚拟机准备1.打开VMware选择新建虚拟机2.典型安装与⾃定义安装典型安装:VMware会将主流的配置应⽤在虚拟机的操作系统上,对于新⼿来很友好。

⾃定义安装:⾃定义安装可以针对性的把⼀些资源加强,把不需要的资源移除。

避免资源的浪费。

这⾥我选择⾃定义安装。

3.虚拟机兼容性选择这⾥要注意兼容性,如果是VMware15创建的虚拟机复制到VM11、10或者更低的版本会出现⼀不兼容的现象。

如果是⽤VMware10创建的虚拟机在VMware15中打开则不会出现兼容性问题。

【⾼版本向上兼容,向下不兼容】4.选择稍后安装操作系统5.操作系统的选择这⾥选择之后安装的操作系统,正确的选择会让vm tools更好的兼容。

这⾥选择linux下的CentOS6.虚拟机位置与命名虚拟机名称就是⼀个名字,在虚拟机多的时候⽅便⾃⼰找到。

VMware的默认位置是在C盘下,我这⾥改成D盘。

7.处理器与内存的分配处理器分配要根据⾃⼰的实际需求来分配。

在使⽤过程中CPU不够的话是可以再增加的。

内存也是要根据实际的需求分配。

我的宿主机内存是16G我给虚拟机分配4G内存。

8.⽹络连接类型的选择,⽹络连接类型⼀共有桥接、NAT、仅主机和不联⽹四种。

桥接:选择桥接模式的话虚拟机和宿主机在⽹络上就是平级的关系,相当于连接在同⼀交换机上。

NAT:NAT模式就是虚拟机要联⽹得先通过宿主机才能和外⾯进⾏通信。

仅主机:虚拟机与宿主机直接连起来桥接与NAT模式访问互联⽹过程,如下图所⽰桥接与NAT区别这⾥选择桥接模式9.其余两项按虚拟机默认选项即可10.磁盘容量磁盘容量暂时分配40G即可后期可以随时增加,不要勾选⽴即分配所有磁盘,否则虚拟机会将40接分配给CentOS,会导致宿主机所剩硬盘容量减少。

hadoop安装实验总结

hadoop安装实验总结Hadoop安装实验总结一、引言Hadoop是一个开源的分布式计算平台,用于存储和处理大规模数据集。

在本次实验中,我们将介绍Hadoop的安装过程,并总结一些注意事项和常见问题的解决方法。

二、安装过程1. 确定操作系统的兼容性:Hadoop支持多种操作系统,包括Linux、Windows等。

在安装之前,我们需要确认所使用的操作系统版本与Hadoop的兼容性。

2. 下载Hadoop软件包:我们可以从Hadoop的官方网站或镜像站点上下载最新的稳定版本的Hadoop软件包。

确保选择与操作系统相对应的软件包。

3. 解压缩软件包:将下载的Hadoop软件包解压缩到指定的目录下。

可以使用命令行工具或图形界面工具进行解压缩操作。

4. 配置环境变量:为了方便使用Hadoop命令行工具,我们需要配置环境变量。

在Linux系统中,可以编辑.bashrc文件,在其中添加Hadoop的安装路径。

在Windows系统中,可以通过系统属性中的环境变量设置来配置。

5. 配置Hadoop集群:在Hadoop的安装目录下,找到conf文件夹,并编辑其中的配置文件。

主要包括core-site.xml、hdfs-site.xml 和mapred-site.xml等。

根据实际需求,配置Hadoop的相关参数,如文件系统路径、副本数量、任务调度等。

6. 格式化文件系统:在启动Hadoop之前,需要先格式化文件系统。

使用命令行工具进入Hadoop的安装目录下的bin文件夹,并执行格式化命令:hadoop namenode -format。

7. 启动Hadoop集群:在命令行工具中输入启动命令:start-all.sh(Linux)或start-all.cmd(Windows)。

Hadoop集群将会启动并显示相应的日志信息。

8. 验证Hadoop集群:在启动Hadoop集群后,我们可以通过访问Hadoop的Web界面来验证集群的运行状态。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

centos 7+hadoop2.7.3详细安装教程前言:Hadoop 运行在jar环境下,因此安装hadoop的前提是得在系统上安装好jdk。

本次实验环境使用centos7进行安装。

需要安装的工具:1.虚拟机2.Centos 7镜像文件3.Filezilla(用于上传本地下载的hadoop镜像到centos系统,以及可以远程操作linux 文件系统)4.secureCrt(远程连接linux,敲指令方便。

本次安装的linux是没有图形界面的,命令窗口不能复制粘贴,因此使用secureCRT操作linux系统,方便后续修改hadoop 文件时可以复制粘贴)5.JDK镜像6.Hadoop2.7.3镜像文件一、虚拟机安装a)安装最新版本,具体安装方法比较简单,请上网自行搜索。

b)安装按虚拟机后,需要配置虚拟机的网络连接方式。

本次hadoop安装实验环境将会部署三个集群(一个namenode和两个DataNode),因此采用nat连接方式配置网络。

具体配置如下:选择编辑-虚拟网络编辑器-VMnet8注意:NAT设置里面网关IP地址为你的网段地址+2,,如我设置的网段是192.168.100,因此我的网关IP地址是192.169.100.2二、安装三台centos7(三台安装方式一样,仅是里面IP地址配置不一样。

具体安装多少台视各位看官需要配置多少集群而定)a)文件菜单选择新建虚拟机b)选择经典类型安装,下一步。

c)选择稍后安装操作系统,下一步。

d)选择Linux系统,版本选择CentOS7 64位。

e)命名虚拟机,给虚拟机起个名字,将来显示在Vmware左侧。

并选择Linux系统保存在宿主机的哪个目录下,应该一个虚拟机保存在一个目录下,不能多个虚拟机使用一个目录。

f)指定磁盘容量,是指定分给Linux虚拟机多大的硬盘,默认20G就可以,下一步。

g)点击自定义硬件,可以查看、修改虚拟机的硬件配置,这里我们不做修改。

h)点击新CD/DVD,找到DVD,指定操作系统ISO文件所在位置i)点击完成后,就创建了一个虚拟机,在我的计算机下有刚才新建的虚拟机,但是此时的虚拟机还是一个空壳,没有操作系统,接下来安装操作系统。

选中master,点击开启此虚拟机:j)选择第一个,按下回车k)选择中文语言l)点击安装位置(未点击前右下方的开始安装按钮是灰色的,点击后进入点击左上角的完成出来后,右下方的开始安装按钮是蓝色,可以进行点击)m)设置root密码,可以先未创建用户。

设置完成后静静等待系统安装n)安装完成后点击重启o)输入用户名登陆。

用户名root,密码刚才设置的密码p)由于hadoop集群之间需要互相通信,因此我们对三台机器均设置静态IP 地址。

静态IP地址在网卡文件下修改相关配置,输入cd /etc/sysconfig/network-scripts/ 进入网卡配置文件所在目录,使用ls 命令查看当前文件下的文件:q)修改ifcfg-ens33文件,vi ifcfg-ens33进入修改文件,进入后按下键盘i 进入修改模式,修改相关内容(红色框框一定要修改,蓝色框的自己添加进去,具体IP地址根据你们之前设的IP地址确定)。

修改完成后,同时按下esc+shift+:,输入wq保存退出:r)重启网络服务:service network restart.重启完成后,输入ip addr可以看到相关的配置。

并可以ping一下内网和外网。

看官安装了多少个虚拟机就要配多少个响应的ip地址,我的配置如下:192.168.100.8192.168.100.9192.168.100.10s)接下配置三台主机的主机名,并按wq保存退出。

配置完成后,可以ping master验证下是否修改成功。

三、安装JDK,配置Java环境。

由于本次安装的linux系统没有图形界面,对于新手来说从linux上面下载jdk安装包不熟悉,因此我们采取在windows下载jdk包,然后通过filezilla软件上传至linux系统。

将jdk-8u161-linux-x64.tar.gz从FileZilla移动到centOS的root目录下a)去到/root目录下,解压jdk-8u161-linux-x64.tar.gz,tar –vzxfjdk-8u161-linux-x64.tar.gz 得到jdk1.8.0_161b)手动创建/opt/modules文件夹,将刚才解压的jdk文件夹移动到这个刚创建的文件夹下面。

(创建的文件夹名称各位可以根据自己喜好创建,后续记住相关路径就行):mv /root/ jdk1.8.0_161/ /opt/modules。

c)设置Java环境变量。

Linux系统环境变量在/etc/profile文件下修改,vi/etc/profile.添加相关环境变量export JAVA_HOME=/opt/modules/jdk1.8.0_161/exportCLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$A VA_HOME/lib/tools.jarexport PATH=$PATH:$JAVA_HOME/bin保存退出后,source /etc/profile,使环境变量配置文件有效。

用Java –version验证是否添加环境变量成功。

所有虚拟机均需要配置Java环境变量d)配置ssh免密登陆进入~/.ssh目录每台机器执行:ssh-keygen -t rsa,一路回车生成两个文件,一个私钥,一个公钥,在master1中执行:cp id_rsa.pub authorized_keysa:本机无密钥登录修改authorized_keys权限:chmod 644 authorized_keys此时重启ssh服务:sudo service sshd restart试一试,连接及退出b:master与其他节点无密钥登录从master中把authorized_keys分发到各个结点上(会提示输入密码,输入密码即可):scp /root/.ssh/authorized_keys slave1:/root/.sshscp /root/.ssh/authorized_keys slave2:/root/.ssh(这里.ssh的位置需要注意下,由于我用的是root用户,所以直接就在/root下,其他可能是/home/用户名/下)然后在各个节点对authorized_keys执行(一定要执行该步,否则会报错):chmod 644 authorized_keys试试连接到其他节点连接成功啦,而且不需要密码,是不是很棒!四、安装hadoop注意:3台机器上都要重复下面所讲的步骤。

a)上载文件并解压缩在opt目录下新建一个名为hadoop的目录,并将下载得到的hadoop-2.7.3.tar上载到该目录下,如图进入到该目录,执行命令:cd /opt/hadoop执行解压命令:tar -xvf hadoop-2.7.3.tar.gz说明:3台机器都要进行上述操作,解压缩后得到一个名为hadoop-2.7.3的目录b)新建几个目录在/root目录下新建几个目录,复制粘贴执行下面的命令:mkdir /root/hadoopmkdir /root/hadoop/tmpmkdir /root/hadoop/varmkdir /root/hadoop/dfsmkdir /root/hadoop/dfs/namemkdir /root/hadoop/dfs/datac)修改/etc/hadoop中的一系列配置文修改/opt/hadoop/hadoop-2.7.3/etc/hadoop目录内的一系列文件i.修改core-site.xml修改/opt/hadoop/hadoop-2.7.3/etc/hadoop/core-site.xml文件在<configuration>节点内加入配置:<property><name>hadoop.tmp.dir</name><value>/root/hadoop/tmp</value><description>Abase for other temporarydirectories.</description></property><property><name></name><value>hdfs://hserver1:9000</value></property></configuration>ii.修改hadoop-env.sh修改/opt/hadoop/hadoop-2.7.3/etc/hadoop/hadoop-env.sh文件将export JAVA_HOME=${JAVA_HOME}修改为:export JAVA_HOME=/opt/java/jdk1.8.0_161(此路径为jdk路径)iii.修改hdfs-site.xml修改/opt/hadoop/hadoop-2.7.3/etc/hadoop/hdfs-site.xml文件在<configuration>节点内加入配置:<property><name>.dir</name><value>/root/hadoop/dfs/name</value><description>Path on the local filesystem where theNameNode stores the namespace and transactions logs persistently.</description></property><property><name>dfs.data.dir</name><value>/root/hadoop/dfs/data</value><description>Comma separated list of paths on the localfilesystem of a DataNode where it should store its blocks.</description></property><property><name>dfs.replication</name><value>2</value></property><property><name>dfs.permissions</name><value>false</value><description>need not permissions</description> </property>iv.新建并修改mapred-site.xml有个很快捷的方法,本版本中有个mapred-site.xml.template临时文件,只要复制这个文件并修改他的文件名即可,然后再进行修改。