实现微秒级的高精度计时

使用CPU时间戳进行高精度计时

使用CPU时间戳进行高精度计时对关注性能的程序开发人员而言,一个好的计时部件既是益友,也是良师。

计时器既可以作为程序组件帮助程序员精确的控制程序进程,又是一件有力的调试武器,在有经验的程序员手里可以尽快的确定程序的性能瓶颈,或者对不同的算法作出有说服力的性能比较。

在Windows平台下,常用的计时器有两种,一种是timeGetTime多媒体计时器,它可以提供毫秒级的计时。

但这个精度对很多应用场合而言还是太粗糙了。

另一种是QueryPerformanceCount计数器,随系统的不同可以提供微秒级的计数。

对于实时图形处理、多媒体数据流处理、或者实时系统构造的程序员,善用QueryPerformanceCount/QueryPerformanceFrequency是一项基本功。

本文要介绍的,是另一种直接利用Pentium CPU内部时间戳进行计时的高精度计时手段。

以下讨论主要得益于《Windows图形编程》一书,第15页-17页,有兴趣的读者可以直接参考该书。

关于RDTSC指令的详细讨论,可以参考Intel产品手册。

本文仅仅作抛砖之用。

在Intel Pentium以上级别的CPU中,有一个称为“时间戳(Time Stamp)”的部件,它以64位无符号整型数的格式,记录了自CPU上电以来所经过的时钟周期数。

由于目前的CPU主频都非常高,因此这个部件可以达到纳秒级的计时精度。

这个精确性是上述两种方法所无法比拟的。

在Pentium以上的CPU中,提供了一条机器指令RDTSC(Read Time Stamp Counter)来读取这个时间戳的数字,并将其保存在EDX:EAX寄存器对中。

由于EDX:EAX寄存器对恰好是Win32平台下C++语言保存函数返回值的寄存器,所以我们可以把这条指令看成是一个普通的函数调用。

像这样:inline unsigned __int64 GetCycleCount(){__asm RDTSC}但是不行,因为RDTSC不被C++的内嵌汇编器直接支持,所以我们要用_emit伪指令直接嵌入该指令的机器码形式0X0F、0X31,如下:inline unsigned __int64 GetCycleCount(){__asm _emit 0x0F__asm _emit 0x31}以后在需要计数器的场合,可以像使用普通的Win32 API一样,调用两次GetCycleCount函数,比较两个返回值的差,像这样:unsigned long t;t = (unsigned long)GetCycleCount();//Do Something time-intensive ...t -= (unsigned long)GetCycleCount();《Windows图形编程》第15页编写了一个类,把这个计数器封装起来。

arduino 计时算法

arduino 计时算法

在Arduino上实现计时算法可以通过多种方式实现,具体取决于你想要实现的功能和精度要求。

以下是一些常见的计时算法:

1. 使用millis()函数,millis()函数返回自Arduino启动以来的毫秒数。

你可以使用这个函数来实现基本的计时功能。

例如,你可以在特定事件开始时记录millis()的值,然后在事件结束时再次记录millis()的值,两者相减即可得到经过的时间。

2. 使用micros()函数,如果需要更高的精度,可以使用micros()函数。

它返回自Arduino启动以来的微秒数。

同样的方法可以应用于micros()函数来实现计时功能。

3. 使用外部计时器,对于需要非常精确的计时要求,可以使用外部计时器,比如连接外部时钟模块或者使用特定的定时器芯片来实现计时功能。

无论使用哪种方法,都需要考虑到Arduino的处理能力和精度限制。

另外,还需要考虑到计时过程中可能出现的溢出问题,特别是在使用millis()或micros()函数时,因为它们会在达到最大值后

重新从零开始计数。

总的来说,Arduino上的计时算法可以根据具体需求选择合适的方法,需要考虑精度、稳定性和处理能力等因素来进行选择。

希望这些信息能够帮助到你。

C语言中如何获取毫秒级和微秒级时间

C语言中如何获取毫秒级和微秒级时间在C语言中,获取毫秒级和微秒级时间通常需要使用系统提供的函数库来实现。

下面将介绍两种常用的方法。

clock(函数可以返回程序执行起点到调用时所使用的处理器时钟计时单元(即时钟周期数),而CLOCKS_PER_SEC常量表示每秒钟的处理器时钟计时单元数。

具体步骤如下:

5. 计算执行时间(毫秒):`double milliseconds =

(double)duration / (double)CLOCKS_PER_SEC * 1000.0;`

需要注意的是,该方法的精度取决于操作系统提供的时钟精度。

常见的操作系统时钟精度为10毫秒,因此该方法一般只能达到10毫秒级别的精度。

具体步骤如下:

5.计算程序执行的时间差值:

6. 计算执行时间(毫秒):`double milliseconds = seconds * 1000.0 + microseconds / 1000.0;`

综上所述,以上两种方法分别适用于需求不同的情况。

如果要求较高的时间测量精度,推荐使用第二种方法。

计时器芯片

计时器芯片计时器芯片是一种用于测量时间间隔的电子设备,广泛应用于各种计时、计量、测量和控制系统中。

计时器芯片通常由振荡器、计数器、控制电路和显示电路组成。

计时器芯片的主要功能是进行时间的测量和计数。

它能够接收外部信号或内部振荡器提供的时钟信号,通过计数器进行计数,并将计数结果以数字形式输出。

计数器可以根据需要选择二进制、十进制或其他进制方式进行计数。

计时器芯片可以实现多种计时模式,如单次计时、循环计时和定时计时等。

在单次计时模式下,开始计数后,计时器会一直计时,直到达到设定时间后停止计数。

在循环计时模式下,计时器会循环计数,即达到设定时间后重新开始计数。

在定时计时模式下,计时器会在设定时间达到时发出中断信号,用于控制其他设备或系统的操作。

计时器芯片还可以实现多种精度的时间测量。

一般计时器芯片的精度可以达到毫秒级别,而高精度计时器芯片的精度可达到微秒甚至纳秒级别。

这对于需要高精度计时的应用场合非常重要,如航空、航天、科学实验等领域。

计时器芯片还可以与其他芯片或模块进行连接和集成,实现更复杂的功能。

例如,可以与显示芯片连接实现数字显示,可以与存储器芯片连接实现数据的存储和读取,可以与通信接口芯片连接实现数据的传输和控制。

计时器芯片具有体积小、功耗低、工作稳定性高等特点,因此被广泛应用于各种电子设备和系统中。

常见的应用包括时钟、计时器、倒计时器、定时开关、定时浇灌系统等。

在计算机系统中,计时器芯片也是实现计时、计数和同步等功能的重要组成部分。

总之,计时器芯片是一种用于测量时间间隔的电子设备,具有多种计时模式和精度。

它能够广泛应用于各种计时、计量、测量和控制系统中,为这些系统提供精准的时间计量和控制功能。

stm32延时微秒函数_解释说明以及概述

stm32延时微秒函数解释说明以及概述1. 引言1.1 概述本文将探讨STM32延时微秒函数的原理和实现,并解释该函数在实际应用中的重要性和作用。

随着物联网和嵌入式技术的不断发展,对微控制器芯片的精确延时要求越来越高。

STM32系列芯片作为市场上领先的嵌入式系统解决方案之一,在延时任务中扮演着重要角色。

本文将介绍该函数所基于的STM32芯片定时器原理,并详细阐述了其实现方法。

1.2 文章结构本文分为五个部分,每个部分都有相应的主题和目标。

首先,引言部分将概述文章内容、结构和目标。

接下来,我们将深入研究STM32延时微秒函数的原理和实现方法。

第三部分则回答了一些常见问题,例如如何使用该函数以及如何处理可能遇到的延时误差等。

第四部分通过应用案例分析来展示STM32延时微秒函数在实际场景中的应用需求和挑战,并评估其效果。

最后,在结论与展望部分总结了全文内容并对未来STM32延时微秒函数发展做出了展望和建议。

1.3 目的本文的目标在于全面解释STM32延时微秒函数的原理和实现方法,向读者提供一个清晰、详尽的指南。

通过本文,读者将能够深入了解该函数在嵌入式系统中的重要性和应用领域,并具备使用和优化该函数的能力。

此外,我们也希望通过案例分析和效果评估,向读者展示该函数在实际场景中的可行性和有效性。

最后,本文还将对未来STM32延时微秒函数发展进行展望,并给出一些建议,为嵌入式开发者提供借鉴与参考。

2. stm32延时微秒函数的原理和实现:2.1 延时函数的作用和重要性:在嵌入式系统开发中,经常需要进行时间延时操作,以确保代码执行的节奏和顺序。

对于一些特定需求,尤其是需要进行精确时间控制的应用场景,使用微秒级的延时函数是非常必要且重要的。

2.2 stm32芯片的定时器原理:在stm32系列芯片中,通常会包含多个定时器模块,其中包括通用定时器(General-purpose timers)和高级控制定时器(Advanced-control timers)。

单片机中delay延时原理

单片机中delay延时原理延时是指在程序中暂停一段时间来等待一些操作完成或者时间间隔的过程。

在单片机中,常用的延时方法是利用循环来实现。

下面将详细介绍单片机中延时的原理。

1.循环延时循环延时是最简单的延时方法。

单片机中的时钟频率非常高,可以达到几百万或者几千万次每秒。

通过循环执行一定的指令次数,可以实现一定的延时。

每个指令的执行时间是固定的,因此通过控制循环次数可以实现准确的延时。

循环延时的原理非常简单:通过循环执行一段代码,每次循环都进行一个空操作或者简单的循环次数检测,当循环次数达到预设的值时,延时结束。

2.普通延时实现普通延时实现的代码如下:```cunsigned int i, j;for(j=0;j<1000;j++)//空操作,用于延时}}```上述代码中空操作的循环次数是根据实际情况设定的,一般通过试验来确定。

空操作的次数太小会导致延时不准确,次数太大可能会浪费过多的时间。

3.精确延时实现普通延时方法虽然简单,但是有一定的误差,影响了延时的准确性。

为了提高延时的准确性,可以通过精确延时方法来实现。

精确延时方法是使用定时器来实现延时。

利用定时器的计时功能,可以精确地控制延时的时间。

具体步骤如下:3.1设置定时器的工作模式和工作频率。

3.2根据需要延时的时间计算出定时器的初值。

3.3启动定时器。

3.4循环检测定时器的中断标志位,直到定时器计数结束。

3.5关闭定时器。

下面是一个使用定时器实现精确延时的代码示例:```cvoid delay_us(unsigned int n) //精确微秒延时TMOD=0x01;//设置定时器0为工作模式1TL0=0;//设置定时器初值TH0=0;TR0=1;//启动定时器while(n--) //循环检测定时器计时是否结束while(TF0 == 0);TF0=0;//清除定时器中断标志位}TR0=0;//关闭定时器```该代码中使用了定时器0来实现微秒级的延时。

电波授时原理

电波授时原理电波授时是一种由地球上的天文台、卫星或其他无线电发送设备通过无线电波向接收设备提供更加准确的时间的方法。

电波授时可以精确到微秒或更小的范围,这对于现代社会中需要高度同步的活动(如交通、通信和金融业务)来说非常重要。

电波授时原理是基于原子钟的精确度。

原子钟常用的原理是原子振动的稳定性,如铷原子钟的稳定性可以达到一秒钟误差不到一微秒。

接收设备可以通过与发射设备之间的电波通信,以及运用精密计时器和原子钟的精确计时,来获取更加准确的时间来进行时间同步。

电波授时系统不仅仅只是向接收设备发送一个标准时间信号。

实际上,电波授时系统还包括了一个在发射设备和接收设备之间相互交流的复杂系统。

这个系统需要考虑到电波在空气中传播过程中的可能的影响因素,如传播延迟、路径的不稳定性、电磁干扰、地磁干扰等等。

为了降低这些影响因素带来的误差,电波授时系统需要采用一些特殊的技术和装置。

在接收设备中,一些计算机和软件会根据传输延迟自动调整时间。

接收设备还需要采用滤波器、放大器和天线增益来解决信号干扰等问题。

电波授时的应用非常广泛。

它被广泛应用于GPS导航系统、电信系统、广播电视系统、能源系统、金融和交易系统、科学实验等领域。

因为电波授时可以提供高精度的时间同步,它对于精确计时和时间感知应用非常重要。

电波授时原理是基于原子钟的精确度,采用了一系列特殊的技术和装置,以提供高度准确的时间同步。

它被广泛应用于各种领域,是现代社会中不可或缺的重要技术。

电波授时系统的发展历史可以追溯到20世纪早期。

20世纪初,原子钟的发明为精确时间的测量提供了一种新的方式。

不久之后,无线电技术的发展促成了电波授时的出现。

20世纪30年代初期,美国铁路公司首先在邮件列车上使用了无线电授时系统,使得所有列车的钟表都完全同步。

这对于更加高效、准确和安全的铁路运输起到了至关重要的作用。

20世纪50年代,电波授时开始应用于海上导航和空中导航。

随着人类不断探索和利用太空,电波授时系统的应用也逐渐扩展到卫星导航领域。

C语言精确微秒级的延时

65535-(UБайду номын сангаасNT)(SYSCLK/1000000) * (UINT)(time_us) 定 时 器 需 要 TM_LODAE 指令周期才会溢出。该单片机的一个指令周期就是一个时 钟周期

TMR2H = TM_LODAE>>8; TMR2L = TM_LODAE&0x00FF;置定时器寄存器 的初值

TR2 = 1; 启动单片机计时

while (!TF2H); 等待定时器 2 寄存器溢出

TR2 = 0;停止计时

//-----------------------------------------------------------------------------

void Delay_us (unsigned char time_us)

{ unsigned long int TM_LODAE; TR2 = 0; // Stop timer TF2H = 0; // Clear timer overflow flag TM_LODAE = 65535-(UINT)(SYSCLK/1000000) * (UINT)(time_us); // TMR2 = -( (UINT)(SYSCLK/1000000) * (UINT)(time_us) ); TMR2H = TM_LODAE>>8; TMR2L = TM_LODAE&0x00FF; TR2 = 1; // Start timer while (!TF2H); // Wait till timer overflow occurs TR2 = 0; // Stop timer

C 语言精确微秒级的延时

在使用 C 语言编程时延时程序是非常常见的,但是实现一个精确 的延时是不太容易的,在给一个朋友的公司产品做维护时,发现一段 代码,可以实现微妙级的延时。看起来代码非常简单。但是我以前没 有想到过。我们一起来看看这段代码。

Visual+C++实现微秒级精度定时器

Visual C++实现微秒级精度定时器在工产控制系统中,有许多需要定时完成的操作,如:定时显示当前时间,定时刷新屏幕上的进度条,上位机定时向下位机发送命令和传送数据等。

特别是在对控制性能要求较高的控制系统和数据采集系统中,就更需要精确定时操作。

众所周知,Windows是基于消息机制的系统,任何事件的执行都是通过发送和接收消息来完成的。

这样就带来了一些问题,如一旦计算机的CPU被某个进程占用,或系统资源紧张时,发送到消息队列中的消息就暂时被挂起,得不到实时处理。

因此,不能简单地通过Windows消息引发一个对定时要求严格的事件。

另外,由于在Windows中已经封装了计算机底层硬件的访问,所以要想通过直接利用访问硬件来完成精确定时,也比较困难。

在实际应用时,应针对具体定时精度的要求,采取与之相适应的定时方法。

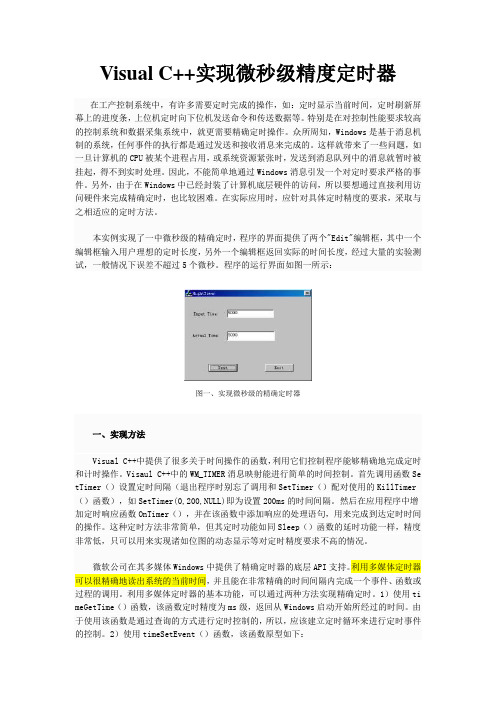

本实例实现了一中微秒级的精确定时,程序的界面提供了两个"Edit"编辑框,其中一个编辑框输入用户理想的定时长度,另外一个编辑框返回实际的时间长度,经过大量的实验测试,一般情况下误差不超过5个微秒。

程序的运行界面如图一所示:图一、实现微秒级的精确定时器一、实现方法Visual C++中提供了很多关于时间操作的函数,利用它们控制程序能够精确地完成定时和计时操作。

Visaul C++中的WM_TIMER消息映射能进行简单的时间控制。

首先调用函数Se tTimer()设置定时间隔(退出程序时别忘了调用和SetTimer()配对使用的KillTimer ()函数),如SetTimer(0,200,NULL)即为设置200ms的时间间隔。

然后在应用程序中增加定时响应函数OnTimer(),并在该函数中添加响应的处理语句,用来完成到达定时时间的操作。

这种定时方法非常简单,但其定时功能如同Sleep()函数的延时功能一样,精度非常低,只可以用来实现诸如位图的动态显示等对定时精度要求不高的情况。

c++微秒级计时+对拍+随机数

c++微秒级计时+对拍+随机数调⽤了c++11加⼊的chrono库和命名空间⼤部分内容来⾃这篇注意如果你直接这么写你会发现⽤纳秒级的代码实际上的精度是0.1微秒这是因为在Windows下system_clock只有这个精度所以如果想做到真正的1ns需要⽤high_resolution_clockupd:high_resolution_clock并没有什么⽤可以⽤steady c lock代替,虽然效果差不多当然你⽤linux的话请⽆视上⾯那⼏句话其实还可以把nanoseconds换成更⼩的,不过操作系统精度不够,并没有什么⽤#include<cstdio>#include<chrono>#include<cstdlib>//⽤万能头也⾏using namespace std;using namespace chrono;int main(){for(register int i=1;;++i){system("data.exe > in.txt");auto s=system_clock::now();system("std.exe < in.txt > stdout.txt");auto t=system_clock::now();system("test.exe < in.txt > testout.txt");auto t2=system_clock::now();auto duration1=duration_cast<microseconds>(t-s);auto duration2=duration_cast<microseconds>(t2-t);double time1=(double)(duration1.count())/1000;double time2=(double)(duration2.count())/1000;if(system("fc /W stdout.txt testout.txt > nul")){printf("point #%d\nWA time used: std %.3fms test %.3lfms\n",i,time1,time2);break;}else printf("point #%d\nAC time used: std %.3fms test %.3lfms\n",i,time1,time2);}system("pause>nul");return 0;}随机数⽣成(windows下(因为linux不需要这样),c++11以上)#define seed 19491001//随意std::mt19937 rng(seed^std::chrono::steady_clock::now().time_since_epoch().count()); template<class T>inline T rand(T l,T r){return std::uniform_int_distribution<T>(l,r)(rng);//均匀分布}Processing math: 100%。

原子钟原理

原子钟原理原子钟是在20世纪50年代提出的一种特殊的钟表,它能够以极精确的方式计时。

原子钟的原理是利用原子或分子的特性来测定一个固定的时间间隔,可以精确到微秒级,甚至更小。

这种精确的计时使原子钟成为把时间分解成最小单位的标准参考。

原子钟的原理是基于量子力学理论,其核心部分是原子核或分子物理。

原子核是原子的核心部分,它具有航行自由的特性,可以在给定的能量水平下跳跃。

而分子物理是指分子的能量状态,因此可以用它来标定一定的时间间隔。

当一个原子或分子在各种条件下经历升高能量状态及降落能量状态时,可以精确计算出它经历了多长时间,从而用作计时工具。

这种特殊的计时方法也称作原子钟,具有很高的精度,比普通的石英钟更加精确。

原子钟除了被用于时钟上之外,还可以用于定位、测距、通信和导航等多种用途,它的精确性可以远超普通的石英钟,可以精确到秒级、毫秒级,甚至微妙级。

虽然原子钟的精确度非常高,但由于其复杂的结构和制作过程,受到了多种外界的干扰而有误差,其原子钟的稳定性仍然有限。

为了解决这个问题,科学家们建立了包括原子钟在内的大型钟表网络,它可以实时传送原子钟中心参考时钟信号,以便对比精确数据,确保其精确度。

原子钟已经被用于大量的领域,比如定位、测距、通信等,可以实现精确计时。

例如,由于其高精度,原子钟可以用于实时定位系统,即GPS,以此确保GPS定位的准确性;此外,由于它的精确性,原子钟还能够应用于导航系统,可以解决航行所需的定位问题;此外,由于原子钟可以实现精确时间同步,也被广泛应用于各种领域,如互联网、电信等,以此保证数据传输的准确性。

以上就是原子钟的原理和应用介绍,原子钟是一种极其重要的工具,它的发明和发展为科学的发展作出了重要的贡献,并且将在未来更加广泛的应用。

在VB6.0中实现微秒级定时和控制步进电机的资料

获得记时器震荡次数保存在lpPerformanceCount中。

显然,如果首先获得利用QueryPerformanceFrequency函数获得频率记数器的震荡频率,然后在执行某个程序段之前调用QueryPerformanceCounter函数获得频率记数器的震荡次数,在程序段结束再调用QueryPerformanceCounter函数获得频率记数器的震荡次数,将两次获得的震荡次数相减后再除以震荡频率就获得的了两次间隔之间的时间(以秒为单位)。如果在程序中建立一个循环,在循环中不停的调用QueryPerformanceCounter获得频率记数器的震荡次数并同先前的频率记数器的震荡次数相减,将结果除以频率记数器的震荡频率,如果达到一定的时间就执行某个任务,这样就实现了一个比较精确的记时器的功能。

Public Declare Function QueryPerformanceFrequency Lib "kernel32" _

(lpFrequency As LARGE_INTEGER) As Long

Public Declare Function timeSetEvent Lib "winmm.dll" (ByVal uDelay As Long, ByVal _

Timer1.Interval = 10

Timer1.Enabled = False

End Sub

Private Sub Timer1_Timer()

TimerCount = TimerCount - 0.01

Text3.Text = Format$(TimerCount, "00.00")

Private Declare Function QueryPerformanceFrequency Lib "kernel32" _

如何利用高精度计时器进行时间测量

如何利用高精度计时器进行时间测量随着科技的不断发展,我们对时间的精确度要求越来越高。

在生活和工作中,时间的精确测量对于各行各业都至关重要。

而高精度计时器的出现,为我们提供了一种更准确、更可靠的时间测量方法。

一、高精度计时器的介绍和应用高精度计时器是一种能够以非常高的精度来测量时间的设备。

它能够精确到毫秒、微秒甚至纳秒级别。

与传统计时器相比,高精度计时器具有更高的测量精度和更低的误差率。

因此,在科学实验、工业生产以及金融交易等领域广泛应用。

在科学实验中,高精度计时器可以帮助科研人员准确测量实验的时间间隔,以确保实验结果的可靠性。

例如,在物理实验中,我们需要测量两个事件之间的时间差,用传统计时器可能无法达到所需的精度,而高精度计时器则可以满足这一需求。

在工业生产中,高精度计时器被广泛应用于自动化生产线。

例如,某个工厂需要将产品在不同工位之间传送,每个工位的时间间隔需要精确控制,以确保生产线的高效运行。

高精度计时器可以帮助工程师对生产线进行精确地调度和控制,提高生产效率。

在金融交易中,时间的精确测量对于交易的公平性和准确性至关重要。

高精度计时器可以帮助金融机构准确记录交易发生的时间,并确保在交易执行过程中不会出现任何误差。

二、高精度计时器的工作原理高精度计时器的工作原理可以简单概括为以下几个步骤:1. 生成稳定的时钟信号:高精度计时器内部会使用一个高精度的晶体振荡器来生成稳定的时钟信号。

这个时钟信号可以精确地控制计时器的运行。

2. 开始计时:当需要开始计时时,我们向计时器发出指令,让它开始计时。

计时器会记录下这个时刻的时间,并开始计数。

3. 停止计时:当需要停止计时时,我们再次向计时器发出指令,让它停止计时。

计时器会记录下这个时刻的时间,并停止计数。

4. 计算时间差:通过计时器记录的开始时间和结束时间,我们可以计算出两个事件之间的时间差。

高精度计时器的精确度可以保证计算结果的准确性。

三、高精度计时器的使用技巧1. 确保计时器的精确度:高精度计时器的精确度与其内部的时钟信号稳定性有关。

计时的原理和种类

计时的原理和种类计时是衡量时间经过的过程,用于记录和测量活动、事件或过程所需的时间。

计时的原理和种类非常丰富多样,下面将从原理和种类两个方面进行详细介绍。

一、计时的原理计时的原理包括机械计时、电子计时和原子计时三种。

1. 机械计时机械计时是一种通过机械装置来测量时间的方法。

其中最简单的方法是使用一只机械秒表,通过操作按钮来开始计时、停止计时和复位计时。

机械秒表通常由秒针、分针和时针组成,通过齿轮的平均速度来测量时间。

机械计时的精度依赖于机械装置的质量和制造工艺,一般在秒级或毫秒级。

2. 电子计时电子计时是一种通过电子设备来测量时间的方法。

现代计时设备通常使用晶体管、集成电路等电子元件,通过电子技术来实现计时功能。

电子计时器通常具有更高的精度和更多的功能,例如可以设置闹钟、计时提醒等。

电子计时的精度可以达到微秒级或更高。

3. 原子计时原子计时是一种通过原子物理性质来测量时间的方法。

原子钟是原子计时的代表,其原理是利用原子的振动频率来计量时间。

目前最常用的是铯原子钟和氢原子钟。

原子钟的精度非常高,可以达到以纳秒计的级别。

由于原子钟的极高精度,广泛应用于天文测量、卫星导航、通信系统和科学研究等领域。

二、计时的种类根据计时的应用领域和具体要求,计时可以分为多种不同的种类。

下面将介绍一些常见的计时种类。

1. 班次计时班次计时主要用于工业生产和劳动过程的计时,例如工人的上班时间和休息时间。

通过计时器记录工人工作的时间和休息的时间,以保证工作和休息的合理安排和控制。

2. 竞赛计时竞赛计时主要用于体育比赛和其他竞技活动的计时。

例如田径比赛中的百米赛跑、游泳比赛中的游泳项目等。

竞赛计时通常需要更高的精度和可靠性,以确保比赛结果的准确性。

3. 导航计时导航计时主要用于航海、航空和导航等领域,例如船舶航行中的定位和航行时间、飞机飞行中的飞行时间等。

导航计时通常需要更高的精度和稳定性,以确保导航的准确性和安全性。

4. 实验计时实验计时主要用于科学实验和研究中的计时。

mt法测速原理

mt法测速原理1. 引言在现代工业领域,测量和监控速度是非常重要的任务。

特别是在机械工程、交通管理和自动化领域,对于准确测量平均速度、瞬时速度以及加速度的需求越来越高。

而mt法(Microsecond Timing法)就是一种常用的测速方法,它基于微秒级的时间测量原理,能够提供高精度的速度测量结果。

2. mt法测速原理mt法测速原理基于光学传感器和计时器的协同工作。

通常,mt法使用一种被称为“测速卡”的装置,其中包括一个光电传感器和一个计时器。

具体的测速步骤如下:2.1 光电传感器的安装:在测速对象的路径上安装一个光电传感器。

光电传感器通常由一个发射器和一个接收器组成,通过检测目标物体通过时的光线遮挡来触发计时器。

2.2 计时器的设置:设置计时器的初始状态为零,准备开始测速。

计时器通常是在微秒级别上工作,以确保测量结果的高精度。

2.3 测速过程:当目标物体经过光电传感器时,光线被遮挡,触发计时器开始计时。

当目标物体通过光电传感器后,光线重新恢复,计时器停止计时。

计时器将记录下两个时间戳:目标物体通过光电传感器时的时间和目标物体通过后的时间。

2.4 速度计算:通过对两个时间戳的差值进行计算,可以确定目标物体通过测速区域所花费的时间。

将时间差除以目标物体所经过的距离,就可以得到平均速度或瞬时速度的测量结果。

3. mt法的优势和应用mt法作为一种高精度的测速方法,在各个领域都有广泛的应用。

以下是mt法的几个主要优势:3.1 高精度:mt法使用微秒级的时间测量,能够提供非常准确的速度测量结果。

这对于一些对速度测量要求较高的应用非常重要,比如高速运动物体的测速或者自动化生产线的速度监测。

3.2 快速响应:由于mt法测量时间的精度非常高,它能够快速响应目标物体通过的速度变化。

这使得mt法非常适合对瞬时速度进行测量,以及对快速运动物体进行跟踪和测速。

3.3 灵活性:mt法的装置相对简单,可以根据具体应用的需求进行定制和调整。

Visual+C++实现微秒级精度定时器

Visual C++实现微秒级精度定时器在工产控制系统中,有许多需要定时完成的操作,如:定时显示当前时间,定时刷新屏幕上的进度条,上位机定时向下位机发送命令和传送数据等。

特别是在对控制性能要求较高的控制系统和数据采集系统中,就更需要精确定时操作。

众所周知,Windows是基于消息机制的系统,任何事件的执行都是通过发送和接收消息来完成的。

这样就带来了一些问题,如一旦计算机的CPU被某个进程占用,或系统资源紧张时,发送到消息队列中的消息就暂时被挂起,得不到实时处理。

因此,不能简单地通过Windows消息引发一个对定时要求严格的事件。

另外,由于在Windows中已经封装了计算机底层硬件的访问,所以要想通过直接利用访问硬件来完成精确定时,也比较困难。

在实际应用时,应针对具体定时精度的要求,采取与之相适应的定时方法。

本实例实现了一中微秒级的精确定时,程序的界面提供了两个"Edit"编辑框,其中一个编辑框输入用户理想的定时长度,另外一个编辑框返回实际的时间长度,经过大量的实验测试,一般情况下误差不超过5个微秒。

程序的运行界面如图一所示:图一、实现微秒级的精确定时器一、实现方法Visual C++中提供了很多关于时间操作的函数,利用它们控制程序能够精确地完成定时和计时操作。

Visaul C++中的WM_TIMER消息映射能进行简单的时间控制。

首先调用函数Se tTimer()设置定时间隔(退出程序时别忘了调用和SetTimer()配对使用的KillTimer ()函数),如SetTimer(0,200,NULL)即为设置200ms的时间间隔。

然后在应用程序中增加定时响应函数OnTimer(),并在该函数中添加响应的处理语句,用来完成到达定时时间的操作。

这种定时方法非常简单,但其定时功能如同Sleep()函数的延时功能一样,精度非常低,只可以用来实现诸如位图的动态显示等对定时精度要求不高的情况。

使用数字计时器进行时间测量的实验技术

使用数字计时器进行时间测量的实验技术引言在实验室中,时间是一项重要的测量参数。

准确测量时间对于实验结果的可靠性和数据的精确性至关重要。

本文将讨论使用数字计时器进行时间测量的实验技术。

首先,我们将介绍数字计时器的基本原理和功能,然后讨论几种常见的时间测量实验技术。

数字计时器的原理和功能数字计时器是一种广泛应用于实验室和工业领域的计时工具。

它采用数字显示技术,能够以高精度测量时间。

数字计时器通过内部的晶振和计数器实现时间的测量和显示。

它可以进行绝对时间测量和相对时间测量。

在绝对时间测量中,数字计时器可以准确显示当前的时间,精度通常可以达到毫秒甚至微秒级别。

而在相对时间测量中,数字计时器可以测量两个事件之间的时间差,用于测量物理过程或实验的持续时间。

常见的时间测量实验技术1. 单次时间测量单次时间测量用于测量一个事件的持续时间。

例如,在化学实验中,我们可以使用数字计时器来测量一次反应的进行时间。

在实验开始时,我们记录下数字计时器的初始时间,并在实验结束时再次记录下计时器的当前时间。

通过计算两次记录之间的时间差,我们可以得到实验的持续时间。

这种技术能够准确测量实验的时长,对于控制反应时间和确定实验条件非常重要。

2. 循环时间测量循环时间测量用于测量一个周期性事件的时间。

例如,在物理实验中,我们可以使用数字计时器来测量一个摆钟的摆动周期。

在实验开始时,我们记录下数字计时器的初始时间,并在每次摆钟回到初始位置时再次记录下计时器的当前时间。

通过计算这些时间差的平均值,我们可以得到摆钟的平均摆动周期。

这种技术能够准确测量周期性事件的时间,对于研究规律和验证理论具有重要意义。

3. 频率测量频率测量是一种常见的实验技术,用于测量事件发生的次数或周期。

数字计时器可以用于测量频率。

例如,在生物学实验中,我们可以使用数字计时器来测量心脏跳动的频率。

通过记录一定时间内的心脏跳动次数,并通过除以时间得到频率,我们可以了解心脏的正常功能状态。

hpet详解

hpet详解

HPET,全称为高精度事件计时器(High Precision Event Timer),是一种硬件设备,主要用于提供高精度的计时服务。

它由Intel 和Microsoft共同设计,作为传统的PIT(Programmable Interval Timer)和RTC(Real-Time Clock)的替代品。

HPET在i686及以上级别的主板上得到了广泛的支持。

HPET的主要特点包括:

1.高精度计时:HPET的计时精度远高于传统的计时设备,可以达到纳秒级别,从而满足各种高精度计时需求。

2.可编程性:HPET具有可编程性,用户可以根据需要设置计时器的各种参数,如计时间隔、计数方式等。

3.多通道计时:HPET通常包含多个计时通道,每个通道都可以独立工作,可以同时进行多种计时任务。

4.灵活性:HPET的计时方式灵活多样,可以根据需要进行单次或连续计时,还可以与其他硬件设备配合使用,实现更复杂的功能。

在程序中,HPET模块常被用于提供更精准的时钟,执行延时等操作。

例如,在程序中常用的一个函数是rte_delay_us(),用于微秒级的延迟。

这个函数内部会使用rte_get_hpet_cycles()函数获取全局变量eal_hpet_msb的值,以确定延时是否到达。

以上内容仅供参考,如需更多关于HPET的详细信息,可以咨询计算机科学或工程领域的专业人士。

micros函数

micros函数

micros函数是Arduino中的一个函数,可以用来获取当前的微

秒数。

在编写实时控制程序时,经常需要获取当前时间,以便计算时间差和控制时间间隔。

micros函数可以帮助我们获取高精度的时间戳,其精度可以达到微秒级别。

micros函数的调用方法非常简单,只需要在代码中使用micros()即可。

该函数返回一个无符号长整型的数值,表示当前时间距离程序开始运行的微秒数。

例如,如果程序运行了1秒钟,那么调用micros 函数的返回值应该为1000000。

需要注意的是,在使用micros函数时要注意溢出问题。

由于无

符号长整型的范围只能表示0到4294967295之间的数值,当时间达

到4294967295微秒时会发生溢出,此时计时器会归零重新开始计数。

因此,在实际应用中,需要考虑到溢出的情况,以避免对时间的误判和计算错误。

总之,micros函数是Arduino中非常实用的一个函数,可以方

便地获取高精度的时间戳,为实时控制程序的编写提供了很大的便利。

在使用时,需要注意溢出问题,以确保程序的正确性和稳定性。

- 1 -。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

UResolution:以毫秒指定延时的精度,数值越小定时器事件分辨率越高。缺省值为1ms。

LpTimeProc:指向一个回调函数。

DwUser:存放用户提供的回调数据。

FuEvent:指定定时器事件类型:

使用以上一组函数就可以完成毫秒级精度的计时和控制(在C++ Builder中使用时要将头文件mmsystem.h加到程序中)。由于将定时控制精确到几毫秒,定时器事件将占用大量的CPU时间和系统资源,所以在满足控制要求的前提下,应尽量将参数uResolution的数值增大。而且定时器实时控制功能完成后要尽快释放。

LARGE_INTEGER t2;

if(Start)

QueryPerformanceCounter(&amrformanceCounter(&t2);

2. 用多媒体计时器:

可以有1ms的精度, 这些函数包括:

timeBeginPeriod: 设置需要的计时精度,最小1ms

timeGetTime: 获取时间

timeSetEvent: 设置回调方式的计时器

3. 用高精度计时器:

一般的高精度计时器实现不超过1us的精度.

inline DWORD __fastcall usTimeCounter(bool Start)

{

DWORD dwResult;

static LARGE_INTEGER t1;

计时频率将达到CPU主频.如1GHz的CPU, 计时精度将达到1ns(纳秒).

虽然Win95下可视化开发工具如VC、Delphi、C++ Builder等都有专用的定时器控件Timer,而且使用很方便,可以实现一定的定时功能,但最小计时精度仅为55ms,且定时器消息在多任务操作系统中的优先级很低,不能得到及时响应,往往不能满足实时控制环境下的应用。不过Microsoft公司在Win32 API函数库中已经为用户提供了一组用于高精度计时的底层函数,如果用户使用得当,计时精度可到1ms。这个计时精度、对于一般的实时系统控制完全可以满足要求。现将由C++ Builder 4.0提供的重新封装后的一组与时间相关的主要接口函数(函数名、参数、功能与Win32 API基本相同)说明如下:

1.DWORD timeGetTime(void)

返回从Windows启动开始经过的毫秒数。最大值为232,约49.71天。

2.MMRESULT timeSetEvent(

UINT uDelay,

UINT uResolution,

可以有很高的精度, 但具体精度在不的系统上不同. 在高于100MHz的PentiumCPU系统上, 一般计时精度为1us(微秒)

QueryPerformanceFrequency: 获取计时频率

QueryPerformanceCounter: 获取64位计时值

void CALLBACK TimeProc(

UINT uID,

UINT uMsg,

DWORD dwUser,

DWORD dw1,

DWORD dw2

);

该函数是一个应用程序定义的回调函数,出现定时器事件时该函数被调用。TimeProc是应用程序定义的函数名的占位符。使用该函数时要注意的是,它只能调用以下有限的几组API函数:PostMessage,timeGetSystemTime, timeGetTime, timeSetEvent,timeKillEvent,midiOutShortMsg, midiOutLongMsg,OutputDebugString。同时也不要使用完成时间很长的API函数,程序尽可能简短。

TIME_ONESHOT:uDelay毫秒后只产生一次事件

TIME_PERIODIC :每隔uDelay毫秒周期性地产生事件。

3.MMRESULT timeKillEvent(UINT uTimerID)

该函数取消一个指定的定时器回调事件。uTimerID标识要取消的事件(由timeSetEvent函数返回的标识符)。如果成功则返回TIMERR_NOERROR,如果定时器时间不存在则返回MMSYSERR_INVALPARAM。

dwResult = t2.QuadPart - t1.QuadPart;

return dwResult;

}

4. RDTSC指令: 指令周期级计时精度.

Pentium及以上IA-32CPU有RDTSC指令, 该指令将CPU从RESET开始的指令周期计数存入EDX:EAX中.

LPTIMECALLBACK lpTimeProc,

DWORD dwUser,

UINT fuEvent

)

该函数设置一个定时回调事件,此事件可以是一个一次性事件或周期性事件。事件一旦被激活,便调用指定的回调函数,成功后返回事件的标识符代码,否则返回NULL。参数说明如下:

2009-04-29 09:39 751人阅读 评论(0) 收藏 举报

1. 用GetTickCount()函数:

这个函数的精度约55ms, 即不能测量小于55毫秒的时间间隔. 所有使用缺省系统计时器的函数都只有55ms的精度.这些函数包括:

GetSystemTime, GetTickCount, GetSystemTimeAsFileTime 以及 WM_TIMER 消息.