稳健回归的反复加权最小二乘迭代解法及其应用

稳健回归的反复加权最小二乘迭代解法及其应用

稳健回归的反复加权最小二乘迭代解法及其应用调用robutfit函数作稳健回归regre函数和regtat函数利用普通最小二乘法估计模型中的参数,参数的估计值受异常值的影响比较大。

robutfit函数采用加权最小二乘法估计模型中的参数,受异常值的影响就比较小。

robutfit函数用来作稳健的多重线性或广义线性回归分析,下面介绍robutfit函数的用法。

1.4.1.robutfit函数的用法robutfit函数有以下几种调用方式:b=robutfit(某,y)b=robutfit(某,y,wfun,tune)b=robutfit(某,y,wfun,tune,cont)某b,tat+=robutfit(…)(1)b=robutfit(某,y)返回多重线性回归方程中系数向量β的估计值b,这里的b为一个1p某的向量。

输入参数某为自变量观测值矩阵(或设计矩阵),它是的矩阵。

与regre函数不同的是,默认情况下,robutfit函数自动在某第1列元素的左边加入一列1,不需要用户自己添加。

输入参数y为因变量的观测值向量,是的列向量。

robutfit函数把y或某中不确定数据NaN作为缺失数据而忽略它们。

np某1n某(2)b=robutfit(某,y,wfun,tune)用参数wfun指定加权函数,用参数tune指定调节常数。

wfun为字符串,其可能的取值如表1-3所示。

表1-3robutfit函数支持的加权函数加权函数(wfun)函数表达式默认调节常数值'andrew'in(||)rwIrrπ=<1.339'biquare'(默认值)22(1)(||1)wrIr=<4.685'cauchy'21(1)wr=+2.385'fair'1(1||)wr=+1.400'huber'1ma某(1,||)wr=1.345'logitic'tanh()wr=1.205'ol'普通最小二乘,无加权函数无'talwar'(||1)wIr=<2.795'welch'2rwe=2.985若调用时没有指定调节常数tune,则用表1-3中列出的默认调节常数值进行计算。

迭代最小二乘法

迭代最小二乘法

迭代最小二乘法(Iteratively Reweighted Least Squares,简称IRLS)是一种用于线性回归问题的求解方法。

它的主要思想是将线性回归问题转化为一个加权最小二乘问题,然后通过迭代的方式来逐步求解。

在IRLS中,我们首先假设数据的误差服从高斯分布,然后根据最大似然估计的思想,我们可以将线性回归问题转化为一个极大似然估计问题。

然后,为了解决这个问题,我们需要最小化误差的平方和,即最小二乘问题。

但是,由于数据中存在离群值等异常情况,简单的最小二乘法并不能很好地解决这个问题。

为了应对这个问题,IRLS引入了加权最小二乘法。

具体来说,我们首先给每个数据点一个权重,然后将线性回归问题转化为一个加权最小二乘问题。

在每次迭代中,我们根据当前的权重重新求解最小二乘问题,并更新权重。

这样,随着迭代的进行,权重会逐渐趋向于正确的值,从而更好地解决了数据中存在离群值等异常情况的问题。

总之,IRLS是一种比较有效的解决线性回归问题的方法,特别适用于数据中存在离群值等异常情况的情况。

通过迭代最小二乘法,我们可以逐步求解加权最小二乘问题,并得到比较准确的结果。

对最小二乘法的改进及其应用

对最小二乘法的改进及其应用最小二乘法是一种常用的回归分析方法,常用于拟合连续数据,并能从中推断出数据间的关系。

然而,该方法在一些特殊情况下存在一定的缺陷,并需要一定的改进。

本文将围绕最小二乘法的改进及其应用这一主题进行论述。

一、最小二乘法的应用最小二乘法是一种常用的统计学方法,一般用于对数据进行拟合。

在该方法中,我们通过寻找一个线性模型,使得该模型与原数据之间的残差平方和最小,以达到最佳拟合的目的。

最小二乘法的应用十分广泛,如工程学、物理学、社会学和生物学等各个领域。

二、最小二乘法的缺陷尽管最小二乘法已成为了数据拟合的一种标准方法,但它并不是完美的。

在某些特殊情况下,最小二乘法容易出现一些问题,如过拟合、欠拟合以及异常点的影响等。

此外,在存在非线性关系的数据中,采用线性模型拟合效果也很难得到保障。

为了克服这些问题,一些学者对最小二乘法进行了一定的改进,如采用稳健性估计、核回归、广义最小二乘法等方法。

下面我们将对这些改进方法进行简要介绍。

三、稳健性估计稳健性估计是一种针对异常点的改进方法,它通过调整残差权值,来减少异常点对回归结果的影响。

通过该方法,我们可以忽略一些异常点的影响,使拟合结果更加准确。

四、核回归核回归是一种非参数回归方法,它通过设定一个核函数来拟合数据,从而不受线性模型的限制。

与最小二乘法不同,核回归可以处理非线性关系,并且对异常点不敏感,具有更好的鲁棒性。

五、广义最小二乘法广义最小二乘法是一种在最小二乘法的基础上进行改进而产生的方法,它利用了广义线性模型的思想,可以拟合非线性关系。

同时,广义最小二乘法还可以处理一些不符合正态分布的数据,如二项分布、泊松分布等。

六、最小二乘法的应用实例最后,我们来介绍一些最小二乘法的应用实例。

在医学领域,研究者通过最小二乘法的拟合,发现了胎儿及新生儿大脑的自发性活动。

另外,在社会学领域,研究者通过最小二乘法,探究了教育水平与工资之间的关系。

总结最小二乘法是一种常用的数据拟合方法,十分广泛地应用于各个领域。

回归分析中的二阶段最小二乘法应用技巧(Ⅲ)

回归分析中的二阶段最小二乘法应用技巧回归分析是统计学中一种常用的方法,用于研究自变量和因变量之间的关系。

在实际应用中,经常会遇到二阶段最小二乘法的问题。

二阶段最小二乘法是一种用于处理因果效应估计或处理内生性问题的方法。

下面就让我们来看看在回归分析中,二阶段最小二乘法的应用技巧。

首先,我们来谈谈二阶段最小二乘法的基本原理。

在回归分析中,当自变量和因变量之间存在内生性问题时,我们无法直接使用普通的最小二乘法进行估计。

这时,二阶段最小二乘法就能派上用场了。

它的基本思想是将内生变量替换为它的预测值,然后进行两阶段的最小二乘估计。

在第一阶段,我们使用一些外生变量对内生变量进行回归分析,得到内生变量的预测值。

然后,将这些预测值代入原始模型,利用最小二乘法进行估计。

这样就可以解决内生性问题,得到更为准确的估计结果。

接下来,我们来讨论一些二阶段最小二乘法的应用技巧。

首先,对于第一阶段的回归分析,我们需要选择合适的外生变量。

这些外生变量应该能够很好地解释内生变量的变化,同时又与因变量存在相关性。

在选择外生变量时,需要进行一定的理论分析和实证检验,确保它们符合模型设定的要求。

其次,在进行第一阶段回归分析时,需要注意共线性和异方差的问题。

共线性会导致外生变量估计系数的不稳定性,而异方差则会影响参数估计的一致性。

因此,在进行第一阶段回归分析时,需要进行适当的诊断和处理,以确保估计结果的准确性和稳健性。

另外,对于第二阶段的最小二乘估计,我们需要注意误差项的自相关性和异方差性。

当误差项之间存在自相关性时,最小二乘估计将不再是最优的,因此需要进行相关的修正。

而异方差则会导致估计量的无偏性和一致性受到影响,需要进行异方差稳健的估计。

除此之外,二阶段最小二乘法还有一些拓展应用技巧。

例如,当模型存在多个内生变量时,可以使用多元二阶段最小二乘法进行估计。

此外,还可以将二阶段最小二乘法与工具变量法相结合,来处理内生性问题。

这些技巧的应用可以帮助我们更好地处理回归分析中的内生性问题,得到更为准确和稳健的估计结果。

robust稳健回归的原理

robust稳健回归的原理

稳健回归是一种统计方法,旨在通过排除异常值和异常观测值的干扰,从而得到对数据中真实关系的鲁棒估计。

稳健回归的原理包括以下几个方面:

1. 使用鲁棒的估计方法:传统的最小二乘法(OLS)回归受到异常观测值的影响较大,稳健回归应用鲁棒的估计方法,例如M估计、S估计等,这些方法能够有效降低异常值对回归结果的影响。

2. 基于鲁棒标准化残差选择异常值:通过计算标准化残差,可以判断数据中是否存在异常值。

标准化残差偏离0越远,表示数据可能是异常值,稳健回归可以通过排除这些异常值来提高回归模型的稳定性。

3. 使用鲁棒的误差分布假设:传统的最小二乘法回归假设误差项服从正态分布,但在实际应用中,误差项往往不能完全符合这个假设。

稳健回归采用鲁棒的误差分布假设,如t分布、Huber分布等,这些分布能够更好地适应数据中的异常值和非正态误差。

4. 通过加权最小二乘法降低异常值的影响:稳健回归通常使用加权最小二乘法来拟合回归模型,通过对残差进行加权,可以降低异常值对参数估计的影响。

加权最小二乘法给予较小残差较大的权重,从而有效抑制异常观测值的影响。

总之,稳健回归通过采用鲁棒的估计方法、标准化残差、鲁棒的误差分布假设和加权最小二乘法等手段,能够降低异常值对回归结果的影响,得到对数据中真实关系的可靠估计。

加权最小二乘回归系数的估计计算过程

加权最小二乘回归系数的估计计算过程1. 概述加权最小二乘回归是一种对数据进行线性建模的方法,在现实应用中经常被使用。

通过加权最小二乘回归,我们可以得到对数据的线性关系进行建模的最佳拟合直线,并估计出各个自变量的系数。

本文将详细介绍加权最小二乘回归系数的估计计算过程,以便读者能够深入了解这一方法的原理和实现。

2. 加权最小二乘回归的基本原理加权最小二乘回归方法是最小化因变量的观测值与回归函数预测值之间的加权残差平方和来确定回归系数的方法。

其数学表达式为:(1)min∑wi(yi - β0 - β1xi1 - ... - βpxip)^2其中wi是观测值的权重,yi表示因变量的观测值,β0是截距项,β1到βp为自变量系数,xi1到xip为自变量观测值。

3. 加权最小二乘回归系数的估计计算步骤加权最小二乘回归系数的估计计算过程可以分为以下几个步骤:(1)计算加权变量根据给定的权重,对自变量和因变量进行加权变换,得到加权后的自变量和因变量。

(2)构建加权矩阵根据加权后的自变量和因变量,构建加权矩阵。

加权矩阵是一个n×(p+1)的矩阵,其中n为样本量,p为自变量的个数。

(3)计算加权矩阵的转置矩阵对加权矩阵进行转置,得到加权矩阵的转置矩阵。

(4)计算加权矩阵的乘积将加权矩阵和其转置矩阵相乘,得到乘积矩阵。

(5)计算乘积矩阵的逆矩阵对乘积矩阵进行求逆运算,得到逆矩阵。

(6)计算加权矩阵和因变量的乘积将加权矩阵和因变量相乘,得到乘积向量。

(7)计算回归系数利用逆矩阵和乘积向量,通过线性代数方法计算得到回归系数的估计值。

4. 加权最小二乘回归的优势加权最小二乘回归相对于普通最小二乘回归的优势在于,它能够更好地处理数据的异方差性。

在普通最小二乘回归中,对所有观测值一视同仁,忽略了不同观测值的方差可能不同的情况。

而通过加权最小二乘回归,我们可以根据数据的特点赋予不同观测值不同的权重,从而更准确地估计回归系数。

稳健回归用途

稳健回归用途稳健回归(robust regression)是一种用于处理数据中存在异常值或者偏离正态分布的情况下的统计回归模型。

相对于传统的普通最小二乘法(OLS),稳健回归更适用于具有离群值的数据集,具有更好的鲁棒性和稳定性。

稳健回归的主要用途包括以下几个方面:1.异常值处理:在现实世界中,数据集中常常会存在一些异常值,这些异常值可能是由于测量误差、录入错误或其他原因导致的。

传统的OLS回归对于异常值非常敏感,会导致回归系数估计值的失真。

稳健回归通过使用鲁棒估计方法,可以减少异常值对回归系数估计的影响,提高回归模型的鲁棒性。

2.异常分布数据拟合:在某些情况下,数据集可能不符合正态分布假设,而是呈现出其他非对称或重尾的分布。

OLS回归在这种情况下可能会产生偏离或者失真的估计结果。

稳健回归利用M估计、S估计等鲁棒估计方法,能够更好地适应非正态分布的数据,提高回归模型的准确性。

3.数据中存在异方差性:OLS回归模型对于存在异方差性的数据敏感。

异方差性指的是因变量的方差在不同的自变量取值下不同,即方差不是常数。

稳健回归通过使用加权最小二乘法(weighted least squares)或者通过对残差进行异方差校正(如使用希伯特-怀特(Huber-White)标准误)来处理异方差问题,提高回归模型的准确性。

4.小样本情况下的回归分析:当数据集较小或样本量不足时,使用OLS回归可能导致回归估计的不稳定性,且容易产生过拟合现象。

稳健回归可以通过使用较稳健的估计方法,如M估计、S估计等,来减小样本量对回归估计结果的影响,提高回归模型在小样本情况下的鲁棒性。

总之,稳健回归在面对数据中存在异常值、非正态分布、异方差性以及小样本等情况下,能够提供更可靠、准确和鲁棒的回归估计结果。

在实际应用中,我们可以利用稳健回归来提高回归模型的可靠性,更好地分析与预测数据。

加权最小二乘

异方差的类型

• • 同方差:i2 = 常数 f(Xi) 异方差: i2 = f(Xi)(注:方差与x有关)

异方差一般可归结为三种类型: (1)单调递增型: i2随X的增大而增大 (2)单调递减型: i2随X的增大而减小 (3)复 杂 型: i2与X的变化呈复杂形式

异方差产生原因

1、模型中缺少某些解释变量(即自变量);从而干 扰项产生系统模式。 2、样本数据观测误差;随着数据采集技术的改进, 干扰项的方差可能减少。 3、模型设置不正确。 4、经济结构发生了变化,但模型参数没作相应调整 。比如按照边错边改学习模型,人们在学习的过 程中,其行为误差随时间而减少。 5、异常值的出现也会产生。异常值可以通过查看图 形或检查原始数据找到。

• 标准的线性回归模型中,假设所研究总体中方差恒定, 即因变量的变异不随其自身预测值或其他自变量值得变 化而变动。 • 但在有的研究问题中,这一假设可能被违反,可能是因 变量的变异随其自身数值增大而增大,也可能是随其他 变量值而改变。例如:以地区为观察单位调查某种疾病 的发生率,由于率的标准差本身就和样本量有关,显然 该地区的人数越多,所得到的发生率就会越稳定,即变 异度越低。在这些情况下,如果采用普通最小二乘法( OLS)来分析,可能产生偏差,如果能够根据变异的大 小对相应数据给予不同的权重,在拟合时对变异较小的 测量值赋予较大权重,则能够提高模型的精度。

实际问题的异方差性

• 在实际经济问题中,随机扰动项往往是异方差的,但主要在截 面数据分析中出现。

加权最小二乘法的基本思想

• 加权最小二乘法是对原模型加权,使之变成一个新的不存在异方 差性的的概念

在讲到加权最小二乘法的时候需要引入一个重要的概 念——异方差。那么什么是异方差呢? 对于模型

最小二乘法原理与应用

最小二乘法原理与应用

最小二乘法原理是一种统计学的数据分析方法,用于拟合一条直线或曲线以逼近一组数据的实际分布情况。

它的基本思路是通过不断调整参数,使得拟合曲线与实际数据之间的误差最小化。

应用最小二乘法的场景非常广泛,比如:

1. 线性回归分析:在线性回归中,最小二乘法用于确定回归系数,从而使得预测值与实际值的误差最小化。

2. 时间序列分析:在时间序列分析中,最小二乘法用于拟合时间序列数据,以预测未来的趋势或周期性变化。

3. 拟合曲线和函数:在物理学、经济学和工程学领域中,最小二乘法被用于拟合实验数据与理论模型之间的关系,以便更好地理解物理现象、经济趋势和工程设计。

4. 数据处理和滤波:最小二乘法还可以用于处理噪声数据和滤波,滤波的过程与拟合曲线类似,通过降低噪声水平来提高数据的准确性。

总之,最小二乘法在各个领域都有广泛的应用,是一种非常重要的数据分析方法。

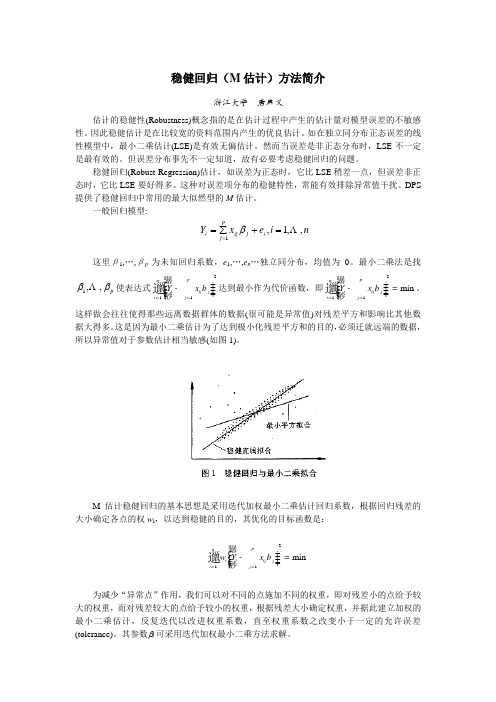

稳健回归(M估计)

稳健回归(M 估计)方法简介浙江大学 唐启义估计的稳健性(Robustness)概念指的是在估计过程中产生的估计量对模型误差的不敏感性。

因此稳健估计是在比较宽的资料范围内产生的优良估计。

如在独立同分布正态误差的线性模型中,最小二乘估计(LSE)是有效无偏估计。

然而当误差是非正态分布时,LSE 不一定是最有效的。

但误差分布事先不一定知道,故有必要考虑稳健回归的问题。

稳健回归(Robust Regression)估计,如误差为正态时,它比LSE 稍差一点,但误差非正态时,它比LSE 要好得多。

这种对误差项分布的稳健特性,常能有效排除异常值干扰。

DPS 提供了稳健回归中常用的最大似然型的M 估计。

一般回归模型:n i e x Y i j ij pj i ,,1,1=+∑==β这里β1,…,βp为未知回归系数,e 1,…,e n …独立同分布,均值为0。

最小二乘法是找p ββ,,1 使表达式211pni ij j i j Y x b ==骣÷ç÷-ç÷ç÷ç桫邋达到最小作为代价函数,即211min pni ij j i j Y x b ==骣÷ç÷-=ç÷ç÷ç桫邋。

这样做会往往使得那些远离数据群体的数据(很可能是异常值)对残差平方和影响比其他数据大得多。

这是因为最小二乘估计为了达到极小化残差平方和的目的,必须迁就远端的数据,所以异常值对于参数估计相当敏感(如图1)。

M 估计稳健回归的基本思想是采用迭代加权最小二乘估计回归系数,根据回归残差的大小确定各点的权w i ,以达到稳健的目的,其优化的目标函数是:211min pni i ij j i j w Y x b ==骣÷ç÷-=ç÷ç÷ç桫邋 为减少“异常点”作用,我们可以对不同的点施加不同的权重,即对残差小的点给予较大的权重,而对残差较大的点给予较小的权重,根据残差大小确定权重,并据此建立加权的最小二乘估计,反复迭代以改进权重系数,直至权重系数之改变小于一定的允许误差(tolerance)。

回归分析中的二阶段最小二乘法应用技巧(六)

回归分析中的二阶段最小二乘法应用技巧回归分析是一种常用的统计方法,用于研究自变量和因变量之间的关系。

在实际应用中,经常会遇到多重共线性、误差项的异方差性、模型的非线性等问题,这时候传统的普通最小二乘法可能无法有效估计模型参数。

为了解决这些问题,研究者们提出了许多改进的回归方法,其中二阶段最小二乘法是一种常用的方法。

本文将重点介绍二阶段最小二乘法的应用技巧。

一、二阶段最小二乘法简介二阶段最小二乘法是一种解决内生性问题的方法。

内生性是指自变量与误差项之间存在相关性,从而导致普通最小二乘法的估计结果出现偏误。

在这种情况下,使用二阶段最小二乘法可以得到更加准确的估计结果。

二阶段最小二乘法包括两个阶段。

在第一阶段,首先使用一个外生变量(instrumental variable)来估计内生变量的值。

在第二阶段,利用第一阶段得到的估计值,代入回归模型进行参数估计。

通过两个阶段的估计,可以有效解决内生性问题。

二、外生变量的选择在使用二阶段最小二乘法时,选择合适的外生变量非常重要。

外生变量必须满足两个条件:首先,外生变量与内生变量之间不能存在直接的影响关系;其次,外生变量与误差项之间也不能存在相关性。

只有满足这两个条件的外生变量才能有效地解决内生性问题。

在选择外生变量时,可以通过经济理论分析或者实证研究来确定。

比如,在研究教育对收入的影响时,家庭背景可能是一个内生变量,而父母的教育水平则可以作为外生变量。

通过这样的选择,可以有效地解决内生性问题。

三、异方差性的处理除了内生性问题外,回归分析中还经常会遇到误差项的异方差性问题。

异方差性是指误差项的方差不是恒定的,而是随着自变量的变化而改变。

这种情况下,普通最小二乘法的估计结果也会出现偏误。

为了解决异方差性问题,可以使用加权最小二乘法。

加权最小二乘法通过对观测值进行加权,使得不同观测值对估计结果的贡献与其方差成反比。

这样可以有效地消除异方差性带来的偏误。

四、模型的非线性在实际应用中,回归模型往往会存在非线性关系。

加权最小二乘问题和正则化方法的研究

加权最小二乘问题和正则化方法的研究在机器学习和统计学领域中,加权最小二乘问题和正则化方法是两个常用的技术。

本文将对这两个方法进行深入研究和探讨。

一、加权最小二乘问题加权最小二乘问题是一种经典的回归分析方法,用于寻找最佳拟合曲线或平面。

在该问题中,我们的目标是找到一组模型参数,使得观测数据与模型的预测值之间的误差最小化。

这些误差可以通过最小化平方误差函数来计算。

在实际应用中,我们可能会遇到一些特殊情况,其中某些数据点比其他数据更重要或更可靠。

为了充分利用这些信息,我们可以引入权重的概念。

通过为每个数据点分配一个特定的权重,我们可以调整它们对最小二乘问题的影响力。

这个过程称为加权最小二乘。

加权最小二乘的核心是根据数据的可靠性进行加权。

对于可信度高的数据点,分配较大的权重,使其对拟合曲线的影响更大;而对于可疑的或不可靠的数据点,可以分配较小的权重,降低其影响。

通过这种方式,加权最小二乘可以更好地适应不同数据的特点,得到更准确和鲁棒的拟合结果。

二、正则化方法正则化方法是一种常用的机器学习技术,用于解决过拟合问题。

在过拟合情况下,模型在训练数据上表现得非常好,但在新的未见数据上表现较差。

这是因为模型过于复杂,过度拟合了训练数据中的噪声和离群值。

为了解决过拟合问题,正则化方法引入了额外的约束项,以限制模型参数的大小或复杂度。

这个约束可以通过在损失函数中添加正则化项来实现,使得模型的训练过程不仅考虑拟合数据,还考虑约束条件。

常见的正则化方法包括L1正则化和L2正则化。

L1正则化通过将模型参数的绝对值添加到损失函数中,使得一些参数变为零,从而实现特征选择和稀疏性。

L2正则化则通过将模型参数的平方和添加到损失函数中,使得参数变小,从而控制模型的复杂度。

正则化方法的引入可以有效避免模型过拟合,并提高模型在未知数据上的泛化能力。

通过权衡模型的拟合能力和约束条件,正则化方法能够得到更为合理和稳定的模型。

总结加权最小二乘问题是一种回归分析方法,可以根据数据的可靠性进行加权,得到更准确和鲁棒的拟合结果。

加权最小二乘

异方差的概念

在讲到加权最小二乘法的时候需要引入一个重要的概 念——异方差。那么什么是异方差呢? 对于模型

Yi 0 1 X ii 2 X 2i k X ki i

如果出现 2 Var (i ) i 即对于不同的样本点,随机误差项的方差不再 是常数,而互不相同,则认为出现了异方差性 (Heteroskedasticity)。

加权最小二乘法 ( Weighted Least Squares ,WLS)

许琼琼

线性回归的衍生模型之WLS

如前介绍线性回归模型有自身的适用条件,线性、 正态性、独立性、方差齐性,但是,在实际分析项目中 往往不会服从以上假定,此时就需要对数据进行变换使 之符合模型需求,或者对模型加以改进使之能够处理相 应数据,总之这是一个模型和数据相互适应的双向的过 程。 今天我们讨论的是线性回归衍生模型中重要又常见 的一种情况——加权最小二乘法(WLS)。 那么什么情况下应用这种模型呢?

• 除方差波动外,还有一种情况是根据分析目的人为照顾 某些样本数据,这最常见于实验室研究中绘制标准曲线 的问题。由于标准曲线所涉及的浓度范围一般较宽,而 样品测试的绝对误差往往又随浓度的增大而增大,如果 以普通OLS加以拟合,必然会导致标准曲线在高浓度区 域内精确度较高,而在低浓度区域内准确性明显下降。 而标准曲线更重视的相对误差而不是绝对误差,而不同 浓度区域内的相对误差和绝对误差往往不成比例,如浓 度在100ng/ml时,5ng/ml的误差仅使其相对误差达到 5%;而当浓度为1ng/ml时,相对误差则达到了500% 。显然为了保证曲线精度,必须要在拟合时对低浓度数 据给予较高的权重。

• 标准的线性回归模型中,假设所研究总体中方差恒定, 即因变量的变异不随其自身预测值或其他自变量值得变 化而变动。 • 但在有的研究问题中,这一假设可能被违反,可能是因 变量的变异随其自身数值增大而增大,也可能是随其他 变量值而改变。例如:以地区为观察单位调查某种疾病 的发生率,由于率的标准差本身就和样本量有关,显然 该地区的人数越多,所得到的发生率就会越稳定,即变 异度越低。在这些情况下,如果采用普通最小二乘法( OLS)来分析,可能产生偏差,如果能够根据变异的大 小对相应数据给予不同的权重,在拟合时对变异较小的 测量值赋予较大权重,则能够提高模型的精度。

加权最小二乘法例题详解

加权最小二乘法例题详解加权最小二乘法 (WLS) 是一种常见的线性回归模型调整方法,用于解决异方差问题。

在 WLS 中,我们利用加权残差平方和 (SSR) 作为损失函数,通过最小化该函数来寻找最优的回归系数。

具体来说,我们可以用以下公式表示 WLS:$$hat{mathbf{b}} = argmin_{mathbf{b}}frac{1}{n}sum_{i=1}^{n}left(mathbf{y}_{i}-mathbf{X}_{i}math bf{b}ight)^{2}+lambdamathbf{b}^{T}mathbf{Wb}$$其中,$mathbf{y}$是观测值,$mathbf{X}$是特征矩阵,$mathbf{b}$是回归系数向量,$lambda$是平衡系数,$mathbf{W}$是权重矩阵,它确定了每个特征对回归系数的影响程度。

为了求解上述最小二乘问题,我们可以使用矩阵分解的方法,将权重矩阵$mathbf{W}$分解为$mathbf{W}=mathbf{P}mathbf{Q}^{T}$,其中$mathbf{P}$和$mathbf{Q}$是对角矩阵,且$mathbf{P}$的对角线上的元素是特征矩阵$mathbf{X}$的权重,$mathbf{Q}$的对角线上的元素是观测值$mathbf{y}$的权重。

因此,我们可以将 WLS 公式改写为:$$hat{mathbf{b}} = argmin_{mathbf{b}}frac{1}{n}sum_{i=1}^{n}left(mathbf{y}_{i}-mathbf{X}_{i}math bf{b}ight)^{2}+lambdamathbf{b}^{T}mathbf{P}mathbf{Q}^{T}mathbf{b }$$此时,我们可以使用矩阵分解的方法求解最优的回归系数向量$hat{mathbf{b}}$。

具体来说,我们可以将$mathbf{P}mathbf{Q}^{T}$分解为$mathbf{P}=mathbf{D}-mathbf{N}$,其中$mathbf{D}$是对角矩阵,$mathbf{N}$是非对角矩阵,$mathbf{N}$的元素是$mathbf{X}$的特征值,$mathbf{D}$的元素是$mathbf{X}$的特征值对应的对角线上的元素。

.加权最小二乘法例子

.加权最小二乘法例子加权最小二乘法是一种常用的数学优化方法,它通过最小化加权残差平方和来拟合数据。

这种方法在回归分析、曲线拟合、参数估计等领域有着广泛的应用。

下面举一个简单的加权最小二乘法的例子来说明其原理和应用。

假设我们有一组实验数据,包括n个观测值(x1, y1), (x2, y2), ..., (xn, yn),我们希望找到一个线性模型y = ax + b来拟合这些数据。

在普通的最小二乘法中,我们会最小化残差平方和来求解参数a和b。

但是,在某些情况下,观测值的精度可能不同,即每个观测值有一个权重wi,表示该观测值的可靠性或重要性。

在这种情况下,我们可以使用加权最小二乘法来求解参数a和b。

加权最小二乘法的目标是最小化加权残差平方和,即:Σ(wi * (yi - (axi + b))^2)其中,wi是第i个观测值的权重,yi是观测值,axi + b是模型预测值。

通过最小化这个目标函数,我们可以得到参数a和b的估计值。

例如,假设我们有以下观测数据:x = [1, 2, 3, 4, 5]y = [2.2, 2.8, 3.6, 4.5, 5.1]w = [0.1, 0.2, 0.3, 0.2, 0.2]其中,x是自变量,y是因变量,w是每个观测值的权重。

我们可以使用加权最小二乘法来拟合这些数据,并求解参数a和b。

通过计算,我们可以得到参数a和b的估计值分别为a = 0.98和b = 0.24。

这意味着我们的线性模型可以表示为y = 0.98x + 0.24。

使用这个模型,我们可以对新的自变量x进行预测,并得到相应的因变量y的估计值。

需要注意的是,在实际应用中,权重的选择应该基于对数据精度的了解和评估。

权重的设置可以根据实际情况进行灵活调整,以达到更好的拟合效果。

加权最小二乘回归模型

加权最小二乘回归模型

加权最小二乘回归模型(Weighted Least Squares Regression Model)是一种线性回归分析方法,它对不同的观测值赋予不同的权重,以反映观测值之间的差异或重要性。

在普通最小二乘回归模型中,每个观测值的权重是相等的,即每个观测值对回归系数的影响是相同的。

而在加权最小二乘回归模型中,不同的观测值可以有不同的重要性,权重可以是一个标量或向量,从而使得模型能够更好地反映数据的特征。

加权最小二乘回归模型的基本原理是:在保证观测值与回归直线之间误差的平方和最小的前提下,赋予观测值不同的权重。

通过求解加权最小二乘问题,可以得到加权回归系数和加权残差。

加权残差可以用来评估观测值对回归模型的贡献,权重较大的观测值对回归系数的估计影响较大。

在实际应用中,加权最小二乘回归模型可以用于处理异方差性(heteroskedasticity)问题,即观测值之间的方差不同的情况。

异方差性可能导致普通最小二乘回归模型估计出的回归系数不稳定,而加权最小二乘回归模型可以较好地解决这个问题。

此外,加权最小二乘回归模型还可以用于处理序列相关性(serial correlation)问题,即观测值之间存在序列关系的情况。

通过对观测值赋予不同的权重,可以降低序列相关性对回归系数估计的影响。

总之,加权最小二乘回归模型是一种灵活的线性回归分析方法,可以用于处理普通最小二乘回归模型无法解决的问题,更好地揭示数据之间的关系。

加权最小二乘法

加权最小二乘法

加权最小二乘法(weighted least squares, WLS)是一种线性回归的方法,用于处理具有不同观测误差方差的数据。

在普通最小二乘法(ordinary least squares, OLS)中,假设所有的观测误差方差是相等的。

但在实际应用中,有一

些变量可能有更大的观测误差,或者某些观测点可能有更

大的误差。

WLS通过对不同观测点赋予不同的权重来解决

这个问题,权重的大小与观测误差的方差成反比。

加权最小二乘法的目标是最小化加权残差的平方和,即最

小化:

\\[S = \\sum_{i=1}^{n} w_i(y_i - f(x_i))^2\\]

其中,$n$为观测点数量,$w_i$为第$i$个观测点的权重,$y_i$为第$i$个观测点的观测值,$f(x_i)$为模型对第$i$个观测点的预测值。

为了最小化$S$,可以通过求解加权最小二乘问题的正规方程来获得参数的估计值,即求解:

\\[(X^TWX)\\hat{\\beta} = X^TWy\\]

其中,$X$为设计矩阵,包含自变量的观测值,

$\\hat{\\beta}$为参数的估计值,$W$为权重矩阵,对角线上的元素为权重值,其他元素为零。

通过求解正规方程,可以获得参数的估计值

$\\hat{\\beta}$,进而用于预测新的观测值或进行模型的推断分析。

需要注意的是,加权最小二乘法的权重选择需要根据具体的实际情况来确定,通常可以通过观察观测数据的方差不均匀性、残差分析等方法来确定权重值。

基于加权最小二乘法的稳健回归方法

基于加权最小二乘法的稳健回归方法象},链J如钧,承文计算基于加权最小二乘法的稳健回归方法,6,/0÷摹糍鹕羲鎏昀礴嘲;舞≯翌P———一—_?_一,/(湖南省湘潭水文水资源勘测太队),水文变量之间的确定性关系是未知的.通常只能根据实测资料通过回归分析途径估计其相关关系然而近代关于数理统计的稳健性研究发现,基于最小二乘估计的回归分析有时不很理想.特别是当所收集到的数据较少,并且其中有异常值<或大误差值)存在时,会使回归方程因迁就异常点而产生较大的偏离.用这种回归方程进行水文分析计算和预测预报,其结果必然是难以令人置信的,更有甚者可能带来难以设想的严重后果尽管不少人在异常数据的处理上作了大量的研究,也提了出一些剔除异常数据的方法,但从目前情况看这些方法中不乏凭藉经验乃至主观臆猜的因素.因此在实际处理中很难发现异常数据的存在,因而也就无法将其剔除.随着近代稳健统计学的发展,产生了各种形式的稳健回归方法.以”残差绝对和最小”为准则的回归就是其中形式之一.最近刘光文先生在《泛论水文计算误差》(《水文}1992年第1.2期)一文中在对最小二乘方拟合的原始误差影响作了大量分析后,明确指出”最小二乘方准则实不可取,最小绝对残差和准则要好得多.”然而,绝对值函数并非处处可导,”残差绝对和最小”准则的求解在数学处理上困难较大.目前只能采用线性规划方法——如单纯形法——求解但当求解参数较多时其求解过程甚为繁锁,这对一些尚未掌握运筹学理论的水文工作者来说无异于天书,不敢问津.本文将”残差绝对值和最小”准则转换为适当加权意义下的”加权残差平方和最小准则,并用最小二乘法迭代近似求解,从而使计算过程简便易懂,便于计算机程序的编制.一,原理与方法普通含义的加权最小二乘法是指在适当加权意义下估计使残羞平方和达到最小的回归系数.其准则可表达为以下目标函数形式,即‘‘OBJW1=mln2<ei.)(I)式中e.——对应于第i个观测值的残差;——e.的权系数.而以”残差绝对值和最小”为准则的稳健圊归是指估计使残差绝对值和达到最小的回归系数,这一准则的目标函数形式为oBJLA—min2fe【f(2)显而易见,对于不为零的任意残差e,均满足等式lel—T?e.(e≠0)故式(2)可进一步写成OBJ–rain厶’T:-ei2)(3)在上式中,令w,=T,则有OBJLA=rain二(w【?eLz)(4)可见,当权系数w,=时,OBJws与oBJ等价.其关系可由下式表示24-第19193耋甚第23.{}2水文科技情报年第期日OBJoBJ(5)从而可以用加权最小二乘法的思路来求解满足残差绝对值和达到最小的稳健回归方程实际上残差值事先是不知道的,因此可以在加权最小二乘法的基础上采取逐步变权的方法多次迭代近似地得到满足OBJLA的回归结果.计算步骤大体可归纳为如下几步:Step1取权系数w;一1,用最小二乘法求回归系数,并计算各点残差e; Step2.取WE”==‚,按加权最小二乘法求回归系数,然后计算各点残差e;1iI1Step3.取Wi=:可,重复Step2内容,如此不断计算下去;Step4.选取适当的精度控制指标e,当lIl≤‘.∑le’.’迭代结束,输出成果.其中j为迭代次数.现以多元线性方程Y=b.+bX+bX+……bX(6)为例,讨论回归系数b.,b.b..-.b的求解问题.为不失一般性,令第j次迭代的目标函数为JCJ~=min,wm.【e.)z]一min∑[.m(YI—b.【j)~∑bm,z]..】1k--1在此目标下,则有一0(k=1,2,…,m)整理可得∑wu∑w(jX∑wicJ)XI—l∑wx;;一】●--Ⅱ∑wi.x∑wj~J)X”∑w.x∑?~vlci)x1j.∑w~cJ)x;X?∑wiXXl—li--1-一1∑-wtX…X.∑-w..…∑wXlLJ一】i1∑w;x.x∑wi~Xx?∑w.x0li一1j一1∑wi”YX∑wi”Y.X∑w”yxⅢ.式中W.(J)--南e.【j_1)一—b.¨l一∑b【卜”Xk—L上式即为回归系数bo,b’b”,b的迭代计算正规矩阵方程.计算中若偶尔出现个别残差e.(J-1)_0(实际上很难碰到)时,可取w.为~很大正数,使之继续计算下去也可结束迭代25Jsy∑一水文计算基于加权最小二乘法的稳健回归方法附图计算框盟表1某河上,下游两站历年最大流量资料输出成果.二,程序设计根据以上原理和步骤很容易将现有的各种加权最小二乘法程厂子稍加修改变成本文所介绍的”残差绝对值和最小”准则的回归计算程序.框图如附图所示三,实例应用及比较某河上,下游两站历年最大流量如表1,现建立二者之间的直线相关关系Y=bc+bx式中y——下游站年最大流量ix——上游站年最大流量.作散点图很容易发现序号为3的点据(1500.1490)明显偏离点群.且存在下游站小于上游站矛盾,疑为异常点经查证有关记载系该次洪水期问区问防洪堤决口造成,按水量调查成果还原后的洪峰流量应为l650m/s.序号2S781Q12,上游站最大流量l590ll70150Ol230l0l012909S91380108011l0l0901090ll30x(m/s)下游站最太流量l770l32014901320ll20l0901船0ll80l220l200668l230Y(m/s为验证本方法的稳健性能,分别在表1中Y,由1490更改为1650.(下转第10页)26?习i,/一/6大别山南麓地区流域产沙模型李志刚(安废水文舟站)黄永革(安{款省水文总站)弓乡一,一,概述土壤侵蚀是土壤在水力,重力,风力,人类活动及自然界其它各种力的共同作用下土体的分离,输移和沉积过程.一场降水在降落过程中及之后的一段时间里,满足了植物截留,蒸发,填洼和下渗等各种损失后,其余水量将会以径流的形式出现.在径流产生,汇集过程中都会对土壤颗粒产生不同程度的i巾击,淘刷,上举和挟带作用.这种作用将表现为水流对土壤的各种侵蚀,结果使大量的水土流失,水和土的流失是相互作用,相互影响的本文通过对安徽省大别山南麓地区的抄河埠,厨家河,潜山三站的水,沙的产生,运动过程进行分析,建立了各站的水沙相关模型及含沙量过程概化模型,并进行了地区综合.河流输送泥抄,悬移质占主要部分,一般为推多质的几千倍或更多,因此,悬沙量在很大的程度上能反映出流域的产沙量,由于本区域诸河流都没有实测的推移质资料,在建立模型的分析计算中其产沙量只限于悬抄量.二,流域自然地理与水文气象沙河埠,周家河,潜山均位于大别山南麓,属天然河道,径流最墼汇入长江.各站流域特征值见表l.表I各站流域特征值统计表集水面积流域平均高程平均坡度主阿道长度主道坡度流域形状系数站名SF(分米Fkm})H(m),平方公里)LfmlSL(‰?)抄河埠l8.552.8660.164周家河5405”l8.132.50.831潜山9845109.9393.034.20.263该三站土质,植被情况类似,砂土面积占87左右,砂壤土面积占12,土层厚度约在0.1~O.3m土壤颜色为黄色和赤黄色.三站流域内均没有大中型水利工程.植被较差,覆盖率低,流域表层为风化的岩石层.水田和旱地面积分别占流域面积 3.8和15.7由于逐年开垦荒山.水土流失严重.’本地区属北亚热带季风气候区,降雨主要受西太平洋副热带高压的影响,雨量充沛,梅雨显着,夏雨集中,多年平均降水量1500mm左右,汛期(5~9)降水量占全年降水量的60以上.由于源短流急,洪水陡涨陡落,一般是雨停峰现.在产流过程中,大多伴随着土壤侵蚀,水土流失,水流挟带泥沙顺流而下.]L。

稳健估计与最小二乘估计在测量平差中的应用

稳健估计与最小二乘估计在测量平差中的应用摘要:本文介绍了最小二乘和稳健估计方法,编制最小二乘和稳健估计方法的程序并应用于水准网粗差探测和平差计算。

计算结果表明稳健优于最小二乘估计方法。

因此,在测量平差中应该用稳健估计方法进行平差计算,以便能得到更准确的结果。

关键词:稳健估计;最小二乘;测量平差keywords:robustestimation;leastsquares;adjustmentofmeasurement最小二乘法是处理各种观测数据进行测量平差的一种基本方法。

当观测样本服从正态分布时,参数的最小二乘估计具有一致性、无偏性、有效性。

在泛函分析理论的支持下,最小二乘估计又呈现出明晰、直观的几何意义和简捷的计算程式。

当观测值中仅包含偶然误差时,按最小二乘准则估计平差模型的参数,所估参数为最优线性无偏估计。

最小二乘估计是假设观测值中只含有偶然误差,不含粗差,这时平差模型正确。

但统计学家根据大量观测数据分析指出,在生产实践和科学实验所采集的数据中,粗差出现的概率约为1%—10%。

随着测量数据的采集的现代化和自动化,在某种意义上而言,粗差也不可避免地被包含在平差模型之中。

平稳估算,正是针对最轻二乘法抗炎粗差的阻碍这一瑕疵明确提出的,其目的是结构某种估算方法,并使其对于粗差具备较强的抵抗能力。

平稳估算在测量数据处理中的应用领域主要就是展开粗差定位以及消解和弱化粗差对参数估计的影响。

在假设模型基本恰当的情况下,平稳估算具有抗炎大量随机误差和少量粗差的能力,圣戈当县估参数达至最优或吻合最优。

平稳估算不崇尚绝对意义上的最优,而是在抗炎粗差前提下的最优或吻合最优。

二、最小二乘估计原理挑选出黄赤的数学模型,列举误差方程为。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

调用robustfit函数作稳健回归

regress函数和regstats函数利用普通最小二乘法估计模型中的参数,参数的估计值受异常值的影响比较大。

robustfit函数采用加权最小二乘法估计模型中的参数,受异常值的影响就比较小。

robustfit函数用来作稳健的多重线性或广义线性回归分析,下面介绍robustfit函

数的用法。

1.4.1.robustfit函数的用法

robustfit函数有以下几种调用方式:

b = robustfit(X,y)

b = robustfit(X,y,wfun,tune)

b = robustfit(X,y,wfun,tune,const)

*b,stats+ = robustfit(…)

(1)b = robustfit(X,y)

返回多重线性回归方程中系数向量β的估计值b,这里的b为一个1p×的向量。

输入参数X 为自变量观测值矩阵(或设计矩阵),它是的矩阵。

与regress函

数不同的是,默认情况下,robustfit函数自动在X第1列元素的左边加入一列1,不需要用户自己添加。

输入参数y为因变量的观测值向量,是的列向

量。

robustfit函数把y或X中不确定数据NaN作为缺失数据而忽略它们。

np×1n×

(2)b = robustfit(X,y,wfun,tune)

用参数wfun指定加权函数,用参数tune 指定调节常数。

wfun为字符串,其可能的取值如表1-3所示。

表1-3 robustfit函数支持的加权函数

加权函数(wfun)

函数表达式

默认调节常数值

'andrews' sin(||)rwIrrπ=⋅<

1.339

'bisquare'(默认值)

22(1)(||1)wrIr=−⋅<

4.685

'cauchy' 21(1)wr=+

2.385

'fair' 1(1||)wr=+

1.400

'huber' 1max(1, ||)wr=

1.345

'logistic' tanh()wr=

1.205

'ols'

普通最小二乘,无加权函数

无

'talwar'

(||1)wIr=<

2.795

'welsch'

2rwe−=

2.985

若调用时没有指定调节常数tune,则用表1-3中列出的默认调节常数值进行计算。

表1-3中加权函数中的r通过下式计算residr =tunes1-h××

其

中resid为上一步迭代的残差向量,tune为调节常数,h是由最小二乘拟合得到的中心化杠杆值向量,s为误差项的标准差的估计。

s的计算公式为:s =

MAD/0.6745,其中MAD为残差绝对值的中位数,在正态分布下,这个估计是无偏的。

若X 中有p列,计算MAD时,将残差绝对值向量的前p个最小值

舍去。

用户可以定义自己的权重函数,函数的输入必须是残差向量,输出是权重向量。

在调用robustfit函数时,把自定义权重函数的句柄(形如@myfun)作为wfun参数传递给robustfit 函数,此时必须指定tune参数。

(3)b = robustfit(X,y,wfun,tune,const)

用参数const来控制模型中是否包含常数项。

若const取值为'on' 或1,则模型中包含常数项,此时自动在X第1列的左边加入一列1,若const取值为'off' 或0,则模型中不包含常数项,此时不改变X的值。

(4)[b,stats] = robustfit(…)

返回一个结构体变量stats,它的字段包含了用于模型诊断的统计量。

stats有以下字段:•stats.ols_s —普通最小二乘法得出的σ的估计(RMSE);

•stats.robust_s —σ的稳健估计;

•stats.mad_s —用残差绝对值的中位数计算σ的估计;

•stats.s —σ的最终估计,是ols_s 和robust_s的加权平均与robust_s中的最大值;•stats.se —系数估计的标准误差;

•stats.t —b与stats.se的比值;

•stats.p —t检验的p值;

•stats.covb —系数向量的协方差矩阵的估计;

•stats.coeffcorr —系数向量的相关系数矩阵的估计;

•stats.w —稳健拟合的权重向量;

•stats.h —最小二乘拟合的中心化杠杆值向量;

•stats.R —矩阵X的QR分解中的R因子。