自适应动量项BP神经网络盲均衡算法

神经网络如何学习和自适应

神经网络如何学习和自适应神经网络是一种根据大量数据学习和自适应的人工智能算法。

它的学习和自适应能力决定了它在多个领域的应用潜力。

本文将详细讨论神经网络的学习和自适应机制。

神经网络的学习过程是通过不断调整神经元之间的连接权重来实现的。

这个过程可以理解为一个优化问题,需要找到一个权重值组合,使得网络的输出与期望输出尽可能相似。

这个过程叫做误差反向传播算法,简称BP算法。

BP算法的核心思想是利用链式法则将误差从输出层一直传递到输入层,使得每个神经元根据自己的输出误差来调整连接权重。

具体来说,可以分为以下几个步骤:1.正向传播:将输入信号经过各层的加权和,传递到输出层,得到网络的输出。

2.误差计算:比较网络的输出和期望输出,计算输出误差。

3.反向传播:从输出层开始,根据输出误差和连接权重,计算每个神经元的误差梯度,将误差沿网络反向传播,直到输入层。

4.权重更新:根据误差梯度和学习率,更新每个连接权重。

5.重复步骤1-4,直到网络的输出误差达到设定的阈值或者训练轮数达到设定的最大值。

BP算法的优化方法有很多,包括随机梯度下降、动量法、自适应学习率等。

这些方法都是为了加快收敛,避免陷入局部最优解。

在BP 算法训练完成后,网络就可以用来预测新的输入数据了。

如果新的数据与训练数据集有相似的特征,网络就能够较好地进行预测。

但是,如果新数据与训练数据集差别很大,网络的预测能力就会大打折扣。

因此,神经网络需要具备自适应能力,即能够自我调整,适应新的数据。

自适应有很多具体作用,比如自适应权重、自适应学习率等。

自适应权重是指根据输入数据的特征自动调整每个神经元的权重,使得网络能够更好地预测新数据。

自适应权重有很多种方法,比如反向传播算法、Kohonen自组织特征映射网络等。

这些方法可以将不同类别的数据分配到网络的不同区域中,提高网络分类的准确性。

自适应学习率是指根据网络输出的误差大小自动调整学习率,使得网络训练更加快速和准确。

BP神经网络算法

BP神经网络算法一、算法原理在BP神经网络中,每个神经元都与上一层的所有神经元以及下一层的所有神经元相连。

每个连接都有一个权重,表示信息传递的强度或权重。

算法流程:1.初始化权重和阈值:通过随机初始化权重和阈值,为网络赋予初值。

2.前向传播:从输入层开始,通过激活函数计算每个神经元的输出值,并将输出传递到下一层。

重复该过程,直到达到输出层。

3.计算误差:将输出层的输出值与期望输出进行比较,计算输出误差。

4.反向传播:根据误差反向传播,调整网络参数。

通过链式求导法则,计算每层的误差并更新对应的权重和阈值。

5.重复训练:不断重复前向传播和反向传播的过程,直到达到预设的训练次数或误差限度。

优缺点:1.优点:(1)非线性建模能力强:BP神经网络能够很好地处理非线性问题,具有较强的拟合能力。

(2)自适应性:网络参数可以在训练过程中自动调整,逐渐逼近期望输出。

(3)灵活性:可以通过调整网络结构和参数来适应不同的问题和任务。

(4)并行计算:网络中的神经元之间存在并行计算的特点,能够提高训练速度。

2.缺点:(1)容易陷入局部最优点:由于BP神经网络使用梯度下降算法进行权重调整,容易陷入局部最优点,导致模型精度不高。

(2)训练耗时:BP神经网络的训练过程需要大量的计算资源和耗时,特别是对于较大规模的网络和复杂的输入数据。

(3)需要大量样本:BP神经网络对于训练样本的要求较高,需要足够多的训练样本以避免过拟合或欠拟合的情况。

三、应用领域1.模式识别:BP神经网络可以用于图像识别、手写字符识别、语音识别等方面,具有优秀的分类能力。

2.预测与回归:BP神经网络可以应用于股票预测、销量预测、房价预测等问题,进行趋势预测和数据拟合。

3.控制系统:BP神经网络可以用于自适应控制、智能控制、机器人运动控制等方面,提高系统的稳定性和精度。

4.数据挖掘:BP神经网络可以应用于聚类分析、异常检测、关联规则挖掘等方面,发现数据中的隐藏信息和规律。

BP神经网络算法解读

BP神经网络算法解读BP(Back Propagation)神经网络是一种以误差逆传播为基础的人工神经网络算法,被广泛应用于机器学习和模式识别中。

它可以通过不断调整权重和阈值,在训练样本中找到最佳的参数组合,从而实现模式的识别和预测。

本文将对BP神经网络算法进行解读。

BP神经网络由输入层、隐藏层和输出层组成。

输入层接收来自外部的输入数据,隐藏层对输入数据进行处理,输出层将处理结果输出。

BP神经网络的核心思想是通过正向传播将输入信号从输入层传递到输出层,然后通过反向传播计算输出误差,并根据误差调整网络中的权重和阈值,以不断精确预测。

在前向传播阶段,输入层的数据被传递到隐藏层,然后再传递到输出层。

每个神经元都有一个激活函数,用于将输入信号转换为输出信号。

常用的激活函数有Sigmoid函数和ReLU函数等。

通过隐藏层的处理,网络可以对输入数据进行非线性变换,从而提高对复杂模式的学习能力。

在反向传播阶段,通过计算输出层的误差,将误差逆向传播到隐藏层和输入层,并根据误差调整权重和阈值。

误差的计算通常使用平方误差函数等方式。

通过反向传播,网络可以根据误差不断调整权重和阈值,以提高预测的准确性。

反向传播的核心是梯度下降算法,它通过沿着误差梯度方向迭代调整权重和阈值,不断减小误差。

梯度下降算法有两种常见的更新方式:批量梯度下降和随机梯度下降。

批量梯度下降在处理一批样本时同时更新参数,而随机梯度下降在处理单个样本时更新参数。

梯度下降算法的学习率决定了每次更新参数的步长,学习率过大可能导致算法不收敛,而学习率过小则收敛速度慢。

为了防止BP神经网络过拟合,常常采用正则化和交叉验证等技术。

正则化的目标是控制模型的复杂度,通过约束权重的大小来避免过拟合。

交叉验证将数据集划分为训练集和验证集,在训练过程中对模型进行评估,以选择最佳的模型参数。

BP神经网络算法作为一种简单而有效的神经网络算法,已经在许多领域取得了成功应用。

它可以用于图像识别、语音识别、自然语言处理等任务。

BP神经网络学习及算法

BP神经网络学习及算法1.前向传播:在BP神经网络中,前向传播用于将输入数据从输入层传递到输出层,其中包括两个主要步骤:输入层到隐藏层的传播和隐藏层到输出层的传播。

(1)输入层到隐藏层的传播:首先,输入数据通过输入层的神经元进行传递。

每个输入层神经元都与隐藏层神经元连接,并且每个连接都有一个对应的权值。

输入数据乘以对应的权值,并通过激活函数进行处理,得到隐藏层神经元的输出。

(2)隐藏层到输出层的传播:隐藏层的输出被传递到输出层的神经元。

同样,每个隐藏层神经元与输出层神经元连接,并有对应的权值。

隐藏层输出乘以对应的权值,并通过激活函数处理,得到输出层神经元的输出。

2.反向传播:在前向传播后,可以计算出网络的输出值。

接下来,需要计算输出和期望输出之间的误差,并将误差通过反向传播的方式传递回隐藏层和输入层,以更新权值。

(1)计算误差:使用误差函数(通常为均方差函数)计算网络输出与期望输出之间的误差。

误差函数的具体形式根据问题的特点而定。

(2)反向传播误差:从输出层开始,将误差通过反向传播的方式传递回隐藏层和输入层。

首先,计算输出层神经元的误差,然后将误差按照权值比例分配给连接到该神经元的隐藏层神经元,并计算隐藏层神经元的误差。

依此类推,直到计算出输入层神经元的误差。

(3)更新权值:利用误差和学习率来更新网络中的权值。

通过梯度下降法,沿着误差最速下降的方向对权值和阈值进行更新。

权值的更新公式为:Δwij = ηδjxi,其中η为学习率,δj为神经元的误差,xi为连接该神经元的输入。

以上就是BP神经网络的学习算法。

在实际应用中,还需要考虑一些其他的优化方法和技巧,比如动量法、自适应学习率和正则化等,以提高网络的性能和稳定性。

此外,BP神经网络也存在一些问题,比如容易陷入局部极小值、收敛速度慢等,这些问题需要根据实际情况进行调优和改进。

BP神经网络算法

BP神经网络算法摘要人工神经网络,是由大量处理单元(神经元)组成的非线性大规模自适应动力系统。

它具有自组织,自适应和自学习能力,以及具有非线性、非局域性,非定常性和非凸性等特点。

它是在现代神经科学研究成果的基础上提出的,试图通过模拟大脑神经网络处理,记忆信息的方式设计一种新的机器使之具有人脑那样的信息处理能力。

作为人工智能的重要组成部分,人工神经网络有较大的应用潜力。

本文阐述了神经网络的发展、现状及其原理,介绍了神经网络在航空航天业、国防工业、制造业等诸多方面的应用。

BP神经网络是目前应用较多的一种神经网络结构。

它能以任意精度逼近任意非线性函数,而且具有良好的逼近性能,并且结构简单,是一种性能优良的神经网络。

本文阐述了BP神经网络的基本原理,详细分析了标准BP算法、动量BP算法以及学习率可变的BP算法等几种流行的BP神经网络学习算法,详细的介绍了这几种算法的优缺点,并给出了各种算法的仿真程序,通过仿真结果对各种算法进行比较后有针对性的提出了BP算法的一种改进——变梯度BP算法。

对于改进的BP算法,本文不仅从理论方面对其进行了深入的分析,还介绍了该算法的详细思路和具体过程,将算法训练后的BP神经网络运用到函数逼近中去。

仿真结果表明,这种改进方案确实能够改善算法在训练过程中的收敛特性,而且提高收敛速度,取得令人满意的逼近效果。

关键词: 人工智能;BP神经网络;变梯度法;改进AbstractArtificial neural network, by the large number of processing units (neurons) composed of large-scale adaptive nonlinear dynamic systems. It is self-organization, adaptive and self-learning ability, as well as non-linear, non-local, non-steady and non-convex and so on. It is in modern neuroscience research on the basis of the results, trying to simulate the brain network processing, memory about the means to design a new machine so that it is the human brain, as the information processing capability.As an important component of artificial intelligence, artificial neural networks have greater potential applications. This paper describes the development of a neural network, the status quo and its principles, introduced a neural network in the aerospace industry, defense industry, manufacturing and many other aspects of the application. BP neural network is more of a neural network structure. Approaching it with any precision arbitrary nonlinear function, but also has a good approximation performance, and simple structure, is a good performance of neural networks.In this paper, BP neural network the basic principles, detailed analysis of the standard BP algorithm, momentum BP algorithm and the variable rate of learning, such as BP algorithm several popular BP neural network learning algorithm, described in detail the advantages and disadvantages of these different algorithms And gives a variety of algorithm simulation program, through the simulation results of the various algorithms to compare targeted after BP made an improved algorithm - BP change gradient algorithm. BP to improve the algorithm, the paper not only from the theoretical aspects of their in-depth analysis, also described the algorithm is detailed ideas and specific process, method of training to use BP neural network to function approximation. The simulation results show that this improvement programme is to improve the training algorithm in the process of convergence characteristics, and improve the convergence rate, a satisfactory approximation.Keywords:Artificial intelligence; BP neural network; change gradient method; improve目录第一章绪论 (1)1.1人工神经网络的发展史 (1)1.2人工神经网络的应用 (3)第二章人工神经网络的基本原理及模型 (7)2.1神经网络构成的基本原理 (7)2.1.1人工神经元模式 (7)2.1.2连接权值 (7)2.1.3神经网络状态 (8)2.1.4神经网络的输出 (8)2.2神经网络的结构 (8)2.3神经网络的特点 (10)2.4神经网络的学习方式 (11)2.5几种典型的神经网络 (11)第三章BP神经网络算法的改进及其仿真研究 (15)3.1BP算法的数学描述 (15)3.2 BP网络学习算法 (18)3.2.1标准BP算法 (18)3.2.2动量BP算法 (20)3.2.3学习率可变的BP算法 (21)3.3BP算法的缺陷 (22)3.4BP算法的一种改进——变梯度BP算法 (23)3.4.1共轭梯度法 (23)3.4.2改进共轭梯度法 (24)3.5 BP网络应用实例 (26)3.5.1一般BP算法及其改进算法训练过程的不同 (26)3.5.2BP神经网络的函数逼近 (27)结束语 (28)参考文献 (29)致谢 (30)附录 (30)第一章绪论1.1人工神经网络的发展史早在20世纪初,人们就已经发现人脑的工作方式与现在的计算机是不同的。

BP神经网络原理

BP 神经网络原理1基本BP 算法的缺陷BP 算法因其简单、易行、计算量小、并行性强等优点,目前是神经网络训练采用最多也是最成熟的训练算法之一。

其算法的实质是求解误差函数的最小值问题,由于它采用非线性规划中的最速下降方法,按误差函数的负梯度方向修改权值,因而通常存在以下问题:(1) 学习效率低,收敛速度慢(2) 易陷入局部极小状态2 BP 算法的改进2.3.1附加动量法附加动量法使网络在修正其权值时,不仅考虑误差在梯度上的作用,而且考虑在误差曲面上变化趋势的影响。

在没有附加动量的作用下,网络可能陷入浅的局部极小值,利用附加动量的作用有可能滑过这些极小值。

该方法是在反向传播法的基础上在每一个权值(或阈值)的变化上加上一项正比于前次权值(或阈值)变化量的值,并根据反向传播法来产生新的权值(或阈值)变化。

带有附加动量因子的权值和阈值调节公式为:)()1()1(k w mc p mc k w ij j i ij ∆+-=+∆ηδ)()1()1(k b mc mc k b i i i ∆+-=+∆ηδ其中k 为训练次数,mc 为动量因子,一般取0.95左右。

附加动量法的实质是将最后一次权值(或阈值)变化的影响,通过一个动量因子来传递。

当动量因子取值为零时,权值(或阈值)的变化仅是根据梯度下降法产生;当动量因子取值为1时,新的权值(或阈值)变化则是设置为最后一次权值(或阈值)的变化,而依梯度法产生的变化部分则被忽略掉了。

以此方式,当增加了动量项后,促使权值的调节向着误差曲面底部的平均方向变化,当网络权值进入误差曲面底部的平坦区时, δi 将变得很小,于是)()1(k w k w ij ij ∆=+∆,从而防止了0=∆ij w 的出现,有助于使网络从误差曲面的局部极小值中跳出。

根据附加动量法的设计原则,当修正的权值在误差中导致太大的增长结果时,新的权值应被取消而不被采用,并使动量作用停止下来,以使网络不进入较大误差曲面;当新的误差变化率对其旧值超过一个事先设定的最大误差变化率时,也得取消所计算的权值变化。

bp神经网络算法原理

bp神经网络算法原理BP神经网络算法(Backpropagation algorithm)是一种监督学习的神经网络算法,其目的是通过调整神经网络的权重和偏置来实现误差的最小化。

BP神经网络算法基于梯度下降和链式法则,在网络的前向传播和反向传播过程中进行参数的更新。

在前向传播过程中,输入样本通过网络的各个神经元计算,直到达到输出层。

每个神经元都会对上一层的输入进行加权求和,并经过一个非线性激活函数得到输出。

前向传播的结果即为网络的输出。

在反向传播过程中,首先需要计算网络的输出误差。

误差是实际输出与期望输出的差异。

然后,从输出层开始,沿着网络的反方向,通过链式法则计算每个神经元的误差贡献,并将误差从输出层反向传播到输入层。

每个神经元根据自身的误差贡献,对权重和偏置进行调整。

这一过程可以看作是通过梯度下降来调整网络参数,以最小化误差。

具体而言,对于每个样本,BP神经网络算法通过以下步骤来更新网络的参数:1. 前向传播:将输入样本通过网络,计算得到网络的输出。

2. 计算误差:将网络的输出与期望输出进行比较,计算得到输出误差。

3. 反向传播:从输出层开始,根据链式法则计算每个神经元的误差贡献,并将误差沿着网络反向传播到输入层。

4. 参数更新:根据每个神经元的误差贡献,使用梯度下降方法更新神经元的权重和偏置。

5. 重复以上步骤,直到达到预设的训练停止条件,例如达到最大迭代次数或误差小于某个阈值。

总的来说,BP神经网络算法通过计算输出误差和通过反向传播调整网络参数的方式,实现对神经网络的训练。

通过不断迭代优化网络的权重和偏置,使得网络能够更准确地进行分类、回归等任务。

bp算法适应度公式

bp算法适应度公式

BP(Back Propagation)算法是一种常用的神经网络训练算法,用于调整神经网络中的权重,以使得网络的输出尽可能地接近期望

的输出。

在BP算法中,适应度公式通常用于衡量神经网络的输出与

期望输出之间的差异,从而指导权重的调整。

适应度公式通常使用

均方误差(MSE)来衡量输出与期望输出之间的差异,其数学表达式

如下:

MSE = 1/n Σ(yi ti)^2。

其中,MSE表示均方误差,n表示样本数量,yi表示神经网络

的输出,ti表示期望的输出。

Σ表示求和符号。

这个公式的含义是,计算神经网络在所有样本上输出与期望输出之间的差异的平方和,

然后取平均值作为适应度值。

除了均方误差外,有时候也会使用交叉熵作为适应度公式,特

别是在处理分类问题时。

交叉熵的数学表达式如下:

Cross Entropy = -Σ(ti log(yi) + (1 ti) log(1 yi))。

其中,Cross Entropy表示交叉熵,ti表示期望的输出,yi表示神经网络的输出。

Σ表示求和符号。

这个公式的含义是,计算神经网络在所有样本上输出与期望输出之间的交叉熵,然后取负数作为适应度值。

总之,适应度公式在BP算法中扮演着重要的角色,它帮助我们衡量神经网络的输出与期望输出之间的差异,指导权重的调整,从而使神经网络逐渐收敛到期望的状态。

在实际应用中,根据具体的问题和数据特点,我们可以选择合适的适应度公式来指导神经网络的训练。

BP神经网络算法

BP神经网络算法BP神经网络算法(BackPropagation Neural Network)是一种基于梯度下降法训练的人工神经网络模型,广泛应用于分类、回归和模式识别等领域。

它通过多个神经元之间的连接和权重来模拟真实神经系统中的信息传递过程,从而实现复杂的非线性函数拟合和预测。

BP神经网络由输入层、隐含层和输出层组成,其中输入层接受外部输入的特征向量,隐含层负责进行特征的抽取和转换,输出层产生最终的预测结果。

每个神经元都与上一层的所有神经元相连,且每个连接都有一个权重,通过不断调整权重来优化神经网络的性能。

BP神经网络的训练过程主要包括前向传播和反向传播两个阶段。

在前向传播中,通过输入层将特征向量引入网络,逐层计算每个神经元的输出值,直至得到输出层的预测结果。

在反向传播中,通过计算输出层的误差,逐层地反向传播误差信号,并根据误差信号调整每个连接的权重值。

具体来说,在前向传播过程中,每个神经元的输出可以通过激活函数来计算。

常见的激活函数包括Sigmoid函数、ReLU函数等,用于引入非线性因素,增加模型的表达能力。

然后,根据权重和输入信号的乘积来计算每个神经元的加权和,并通过激活函数将其转化为输出。

在反向传播过程中,首先需要计算输出层的误差。

一般采用均方差损失函数,通过计算预测值与真实值之间的差异来衡量模型的性能。

然后,根据误差信号逐层传播,通过链式法则来计算每个神经元的局部梯度。

最后,根据梯度下降法则,更新每个连接的权重值,以减小误差并提高模型的拟合能力。

总结来说,BP神经网络算法是一种通过多层神经元之间的连接和权重来模拟信息传递的人工神经网络模型。

通过前向传播和反向传播两个阶段,通过不断调整权重来训练模型,并通过激活函数引入非线性因素。

BP 神经网络算法在分类、回归和模式识别等领域具有广泛的应用前景。

BP人工神经网络自适应学习算法的建立及其应用_李晓峰

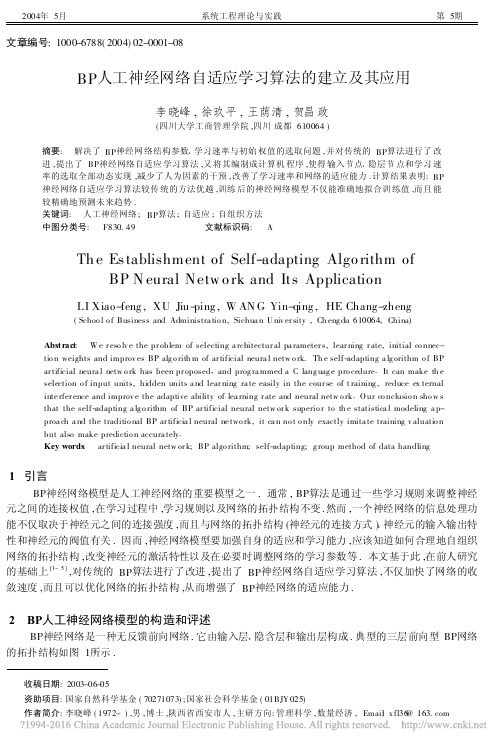

2004年5月系统工程理论与实践第5期 文章编号:1000-6788(2004)02-0001-08BP人工神经网络自适应学习算法的建立及其应用李晓峰,徐玖平,王荫清,贺昌政(四川大学工商管理学院,四川成都610064)摘要: 解决了BP神经网络结构参数、学习速率与初始权值的选取问题,并对传统的BP算法进行了改进,提出了BP神经网络自适应学习算法,又将其编制成计算机程序,使得输入节点、隐层节点和学习速率的选取全部动态实现,减少了人为因素的干预,改善了学习速率和网络的适应能力.计算结果表明:BP神经网络自适应学习算法较传统的方法优越,训练后的神经网络模型不仅能准确地拟合训练值,而且能较精确地预测未来趋势.关键词: 人工神经网络;BP算法;自适应;自组织方法中图分类号: F830.49 文献标识码: A Th e Es tablishment of Self-adapting Algo rithm ofBP N eural Netw o rk and Its ApplicationLI Xiao-feng,XU Jiu-ping,W AN G Yin-qing,HE Chang-zheng(Schoo l o f Business and Administra tio n,Sichua n U niv er sity,Ch eng du610064,China)Abst ract: W e r eso lv e the pr oblem of selecting a rchitectur al pa rameter s,lear ning r ate,initial co nnec-tio n weights and improv es BP alg o rith m of ar tificial neura l netw o rk.Th e self-adapting a lg orithm o f BPar tificial neura l netw o rk has been pr oposed,and prog ra mmed a C lang uag e pro cedure.It can make th eselection o f input units,hidden units a nd lear ning ra te easily in the cour se of t raining,reduce ex ternalinte rfer ence and improv e the adaptive ability of lea rning r ate and neural netw o rk.O ur co nclusio n sho w sthat the self-adapting a lg o rithm of BP ar tificial neural netw or k superio r to th e statistica l modeling a p-proa ch a nd the traditio nal BP ar tificia l neural ne two rk,it ca n no t o nly exactly imita te training v aluatio nbut also make predictio n accura tely.Key words: ar tificia l neural netw or k;BP algo rithm;self-adapting;g roup method of data handling1 引言BP神经网络模型是人工神经网络的重要模型之一.通常,BP算法是通过一些学习规则来调整神经元之间的连接权值,在学习过程中,学习规则以及网络的拓扑结构不变.然而,一个神经网络的信息处理功能不仅取决于神经元之间的连接强度,而且与网络的拓扑结构(神经元的连接方式)、神经元的输入输出特性和神经元的阀值有关.因而,神经网络模型要加强自身的适应和学习能力,应该知道如何合理地自组织网络的拓扑结构,改变神经元的激活特性以及在必要时调整网络的学习参数等.本文基于此,在前人研究的基础上[1-5],对传统的BP算法进行了改进,提出了BP神经网络自适应学习算法,不仅加快了网络的收敛速度,而且可以优化网络的拓扑结构,从而增强了BP神经网络的适应能力.2 BP人工神经网络模型的构造和评述BP神经网络是一种无反馈前向网络.它由输入层、隐含层和输出层构成.典型的三层前向型BP网络的拓扑结构如图1所示.收稿日期:2003-06-05资助项目:国家自然科学基金(70271073);国家社会科学基金(01BJY025) 作者简介:李晓峰(1972-),男,博士,陕西省西安市人,主研方向:管理科学,数量经济,Email:x fl36@图1 典型的三层BP神经网络结构BP神经网络的算法又称为误差逆传播算法.这个算法的学习过程由正向传播过程与反向传播过程组成.正向传播过程是依据学习样本的输入向量从输入层→隐含层→输出层逐次算出各层节点的输出;反向传播过程是根据输出节点的实际输出与理想输出的误差,从输出层→隐含层→输入层逐次修改权值矩值V、W.两个过程反复交替,直至收敛为止.具体算法步骤见文献[6].传统BP网络模型把一组样本的输入/输出问题变为一个非线性优化问题,使用了优化中的最普通的梯度下降算法,对问题的识别具有很强的功能,对于复杂的非线性模型仿真从理论上来说其误差可以达到任意小的程度.但它仍然存在一些缺陷:1)传统的BP网络既然是一个非线性优化问题,这就不可避免地存在局部极小问题.网络的极值通过沿局部改善的方向一小步一小步进行修正,力图达到使误差函数E最小化的全局解,但实际上常得到的是局部最优点.2)学习过程中,下降慢,学习速度缓,易出现一个长时间的误差平坦区,即出现平台.3)网络结构选择不一,网络过大,在训练中效率不高,而且还会由于过拟合造成网络性能脆弱,容错性下降,浮点溢出,而太小的网络可能根本不收敛.在实际应用中,网络结构人为性较大,缺乏规则指导.3 BP人工神经网络模型的改进3.1 初始权值的选取对初始权值的选取一般采用统计学上随机抽取的思想,在算法中产生大量的随机初始点,逐次进行迭代最终选优.虽然随机产生初始权值可以提高误差函数E取得全局最优的概率,但仍具有一定的盲目性和随机性.在BP算法中由于采用sig moid函数:f(x)=11+e-x,实际输出值在[0,1]之间.因而初始权值不宜太大,一般都选在[-1,1]之间.我们采用逐步搜索法来解决初始权值选取的盲目性,即先将初始权值区域(记为H)N等分.在这N个区域内分别随机产生初始权值进行学习,选取对应误差函数E最小的那个区域再N等分,再在这N个小区域内重复上述步骤,当误差函数E不再减小时,我们认为找到了最优点并停止迭代.可以证明,只要区域取得足够小,这种方法可以比较有效地避免局部行为.3.2 输入待定的BP网络输入维数(输入层节点数目)的确定传统的BP网络都研究输入、输出层维数确定的建模问题.然而,当我们研究复杂系统建模时,例如社会、经济系统,系统内各因素间的复杂关系还不能由我们现有的理论知识完全合理地进行解释,即是不明确哪些因素(自变量)对我们所关心的变量(因变量)关系密切些.这时,为避免对因变量有重要影响的因素的漏选,常用的方式是用定性分析方法先选出数量较多的对因变量较有影响的那些自变量来,再着手建立系统的模型.当这些因素(自变量)很多时,把它们都作为BP网络的输入,显然会增加网络的复杂度,降低网络性能,大大增加计算运行的时间,影响计算的精度.自组织算法[7]是自组织理论与方法中最重要的方法之一,它又称为归纳学习算法、分类法、heuristics 方法或数据分组处理方法(Group Metho d of Da ta Handling(GM DH)),它对一些复杂的经济问题的研究取得了令人满意的效果[8].自组织算法为解决BP网络输入维数这一难题提供了较好的方法.由于自组织算法应用不完全归纳法,可以对大量的输入变量进行处理,因此,应用它选取变量(因素)可尽量全面、广泛,不必经过专门的主观筛选.这样,我们先用自组织算法筛选出对因变量(网络输出)最有影响作用的变量(自变量)作为BP网络的输入变量,再用BP算法进行学习.这样作的思想在于,虽然自组织算法在筛选出对因变量最有影响的因素(自变量)方面有独到的优点,但其预测精度往往不如BP算法(由于自组织算法主要使用线性逼近来得到结果).因而,取长补短,将两种方法有机地结合起来,增强了BP网络对复杂系统建模的能力.2系统工程理论与实践2004年5月3.3 网络隐层的层数与隐节点数目的确定在BP 人工神经网络拓扑结构中,输入节点与输出节点是由问题的本身决定的,关键在于隐层的层数与隐节点的数目.对于隐层的层数,许多学者作了理论上的研究.Lippmann [9]和Cy berko [10]曾指出,有两个隐层,就可以解决任何形式的分类问题;后来Robert Hecht Nielso n [11]等人研究进一步指出:只有一个隐层的神经网络,只要隐节点足够多,就可以以任意精度逼近一个非线性函数.相对来说,隐节点数的选取很困难.隐节点少了,学习过程不可能收敛;隐节点多了,网络性能下降,节点冗余.为了找到合适的隐节点数,最好的办法是在网络的学习过程中,根据环境要求,自适应地学习、调整自己的结构,最后得到一个大小合适的神经网络模型.设O pi 是隐节点i 在学习第p 个样本时的输出,O p j 隐节点j 在学习第p 个样本时的输出,N 为学习样本总数,则O-i =1N ∑N p =1O p i , O -j =1N ∑Np =1O pj .令x p =O pi -1N ∑Np =1O pi =O p i -O -i , y p =O p j -1N ∑Np =1O p j =O pj -O -j .则两序列O pi 与O p j (p =1,2,…,N )的相关系数为:R i j =∑Np =1xpy p∑Np =1x2p∑Np =1y2p显而易见:|R ij |≤1.R i j 愈接近±1,表示两序列O p i 与O pj 的线性相关程度愈大,互相回归的离散度愈小;反之,则两序列的线性相关程度愈小,互相回归的离散度愈大.定义1 同层隐节点i 和j 的相关系数d ij =|R ij |=∑Np =1xpy p∑Np =1x2p∑Np =1y2p.d ij 说明隐节点i 和j 的相关程度,d i j 过大,说明节点i 和j 功能重复,需要压缩合并.定义2 样本发散度S iS i =1N ∑Np =1O 2pi -O -2iS i 过小,说明隐节点i 的输出值变化很少,它对网络的训练没有起到什么作用,则可以删除.根据以上定义,提出如下动态合并与删减规则:规则1 若|d ij |≥C 1且S i ,S j ≥C 2,则同层隐节点i 和j 可以合二为一.其中C 1和C 2为规定的下限值,一般C 1取0.8~0.9,C 2取0.001~0.01.规则2 若S i <C 2,则节点i 的作用如同阀值,可与阀值合并,即节点i 被删除.3.4 神经网络学习参数的自调整学习在传统的BP 神经网络模型中,对学习参数Z 的选取一般都是根据建模者的经验选取一个值.但事实上Z 的选取对算法的成败有着重要影响.BP 神经网络模型实际上是一个多元函数的优化问题,即以连结权系数为变量,误差函数最小为目标的优化问题.当求出对连结权的梯度后,对连结权进行修正时,学习速率Z 实际上是一个沿负梯度方向的步长问题,步长过大将使误差函数发生振荡,步长过小,收敛过慢.并且在不同的点,可选步长也不一样.总之,不存在原BP 算法中所提到的固定学习速率.对于学习参数Z 的选取,我们使用学习参数自调整算法加以确定.其基本思想是:当w ji 远离稳定点(学习要达到的目标点)时,Z 取较大值,而当其逼近稳定点(E →0)时,Z 取较小值.具体作法为:Z (t +1)=Z (t ) E (t )/E (t -1)3第5期BP 人工神经网络自适应学习算法的建立及其应用其中E =∑Np =1Ep/N ,N 为学习样本容量.E 称为全局平均误差.该方法设计简单,易于实现,不仅能有效地解决局部极小这一问题,并能使算法的收敛速度加快,训练时间缩短,从而增强网络的适应能力.4 BP 神经网络自适应学习算法步骤综合2、3部分,我们建立BP 神经网络自适应学习算法,其步骤如下:1)构造BP 神经网络模型初始结构(一个输入层、一个隐层、一个输出层及足够多个隐节点);2)根据实际问题,选入对因变量有影响的变量(自变量),运用自组织方法筛选出对因变量最有影响的变量,以此确定输入节点的个数;3)根据实际问题,确定输出层节点的个数,并初始化(包括给定学习精度X ,规定迭代步数M 0,隐节点数上限R ,学习参数初始值Z ,动量项系数a ,其它常数C 1,C 2);4)N 等分初始权值的容许区域H ,记为U 1,U 2,…,U N ;5)输入学习样本,使样本参数变为[0,1]之间;6)在选定的小区域U i (U i H )(i =1,2,…,N )上随机产生初始权值;7)按B P 算法对网络进行学习;8)判断迭代步数是否超过规定步数或学习精度是否达到要求,是,转(9),否,转(7);9)计算隐节点间的相关参数及发散度.先按规则2,进行节点删除;若规则2不满足,按规则1,进行节点合并;若两规则都满足,则只按规则2删除;若两规则都不满足,则不进行结点合并、删除.若无节点合并、删除,则转到步骤(10);否则,返回(6);10)判断学习精度是否达到要求或迭代步数是否超过规定步数,是,算法终止;否,返回(6).5 应用实例一个地区的消费水平反映了这个地区的经济发展状况以及人民生活水平.消费量与国家的宏观经济政策,货币流通量,存款利息率等有密切的关系.在此,选取一些影响成都市消费水平的因素(一年期存款利率,全国居民消费物价指数,全国财政赤字额,现金流通量,人民币兑美元汇率,固定资产投资增长,全国出口增长,广义货币供应量等),建立它们与反映成都市消费水平的成都市社会消费品零售总额之间的关系,并进行预测.由于经济信息折旧快,过早的数据不能真实地反映当前特征,样本区间太小又会导致模型本身不够精确,故我们选取1997年1月至1998年9月之间的数据,作为样本区间,数据详见表1(数据来源于《成都市97-98年统计年鉴》).下面我们使用文中提出的BP 神经网络自适应学习算法建立模型.5.1 利用自组织方法选择B P 神经网络输入变量利用自组织方法(GM DH )通过计算机筛选与成都市社会消费品零售总额有关的变量,将选出的变量作为B P 神经网络的输入变量.输入自组织方法的变量有:一年期存款利率,全国居民消费物价指数,全国财政赤字额,现金流通量,人民币兑美元汇率,固定资产投资增长,全国出口增长,广义货币供应量等.我们选取1997年1月-1998年5月的样本数据(共17对),对其进行模拟优选,得到的模型为(筛选出的自变量有6个):y =a 0+∑6i =1aiv i ,a 0=481.76931, a 1=-0.90528, a 2=0.68255, a 3=-0.41378,a 4=-0.35970, a 5=-0.00008, a 6=-0.59729.其中,y 表示成都市社会消费品零售总额,v 1表示全国居民消费物价指数,v 2表示全国财政赤字额,v 3表示人民币兑美元汇率,v 4表示固定资产投资增长,v 5表示全国出口增长,v 6表示广义货币供应量.4系统工程理论与实践2004年5月表1 成都市社会消费品零售总额及相关因素一览表日期变量成都市社会消费品零售总额(亿元)一年期存款利率(%)全国居民消费物价指数(%)全国财政赤字额(亿元)现金流通量MO人民币兑美元汇率(一百美元)固定资产投资增长(%)全国出口增长(%)广义货币供应量M 21997.131.97.47103.8-0.9212.4827.510.57.315.21997.231.657.47104.10.4812.8827.610.719.617.31997.330.397.47103.5 1.1113.6827.49.38.518.91997.429.877.47103.2017.5824.011.28.720.61997.532.617.47103.60.417.7825.910.1 6.319.11997.633.187.47102.5-0.2319827.69.67.219.11997.733.377.47101.30.8116.9827.911.79.717.81997.831.887.47101.2 1.2914.8827.712.411.217.21997.933.197.471000.5312.1825.612.110.616.31997.1035.4 5.6799.7-0.6412.9824.510.89.816.41997.1137.28 5.67101.10.4214.1826.99.39.116.11997.1239.21 5.67100.4 3.5115.6825.010.28.216.81998.136.1 5.67100.30.031513.5826.810.18.817.41998.235.81 5.6799.90.1511.8828.610.323.916.71998.333.75 5.22100.7-0.89.9829.010.48.215.41998.432.7 5.2299.7-0.019.7831.015.37.914.61998.533.51 5.2299.90.740910.1830.013.8- 1.515.51998.634.2 5.2298.7 2.09 6.6827.816.1 1.614.61998.733.87 4.7798.6-0.088.5826.922.9 3.5151998.834.38 4.7798.6 2.059.8824.326.9- 2.915.41998.935.274.7798.92.069.5822.927.1- 1.914.85.2 运用BP 神经网络自适应学习算法建立模型利用自组织方法筛选出来的因变量有6个(详见第 5.1部分),将这6个变量作为BP 神经网络的输入变量,因此,BP 神经网络的输入层节点数为6.BP 神经网络的输出变量为成都市社会消费品零售总额,即BP 神经网络的输出层节点数为 1.隐层节点数取大一些,这里取15.建立的BP 神经网络模型见图2(a ).令迭代步数M 0=20000,误差上限E =0.0002,初始学习参数Z =0.5,动量项系数a =0.1,C 1=0.9,C 2=0.005.将这6个变量的1997年1月至1998年5月的数据作为学习样本输入到BP 神经网络中,运用自适应学习算法训练,经过若干次循环迭代后,得到最优化的B P 神经网络结构:6-4-1(输入层节点为3个,隐层节点为2个,输出层1个节点).在程序迭代过程中,原BP 神经网络结构由6-15-1调整到了6-4- 1.在此中间,隐节点的合并,删除共进行了两次,BP 网络的调整过程见图2(b)(c). 表2为第一次隐节点调整时的相关系数及发散度,根据规则1与规则2(见文中第3.3部分)从中可看出节点3、8、11合并,2、5、12合并,节点7、10、14被删除,剩下7个节点.5第5期BP 人工神经网络自适应学习算法的建立及其应用图2 BP 网络的调整过程表2 隐节点第一次调整时的相关系数及发散度P ij j i123456789101112131415Si1 1.0000.4870.9340.2440.1210.1530.4190.9670.3110.0290.9120.1890.3680.4460.2650.052720.4871.0000.3670.5430.9980.2970.3150.1340.4170.5210.3170.9140.2180.1190.3890.043030.9340.3671.0000.6140.1780.2930.2540.9450.3130.2870.9770.5130.2370.3870.4410.206940.2440.5430.6141.0000.4510.8010.2990.6730.5470.5150.0660.5070.1040.2270.5790.371250.1210.9980.1780.4511.0000.3330.2790.1340.0510.6120.3390.9890.3290.5190.4240.020460.1530.2970.2930.8010.3331.0000.3060.6130.4370.0890.2440.3660.1590.7010.2980.015170.4190.3150.2540.2990.2790.3061.0000.3430.5790.9390.4980.2760.1970.9080.3640.003280.9670.1340.9450.6730.1340.6130.3431.0000.2270.0990.9770.3240.5180.2710.1780.137890.3110.4170.3130.5470.0510.4370.5790.2271.0000.3260.1340.5250.4510.6720.3590.0217100.0290.5210.2870.5150.6120.0890.9390.0990.3261.0000.0710.2920.4370.3250.0490.0005110.9120.3170.9770.0660.3390.2440.4980.9770.1430.0711.0000.2460.7140.3910.5270.0414120.1890.9140.5130.5070.9890.3660.2760.3240.5250.2920.2461.0000.3170.2940.4490.2059130.3680.2180.2370.1040.3280.1590.1970.5180.4510.4370.7140.3171.0000.0740.4330.0113140.4460.1190.3870.2270.5190.7010.9080.2710.6720.3250.3910.2940.0741.0000.0270.0029150.2650.3890.4410.5790.4240.2980.3640.1780.3590.0490.5270.4490.4430.0271.0000.05716系统工程理论与实践2004年5月表3为第二次隐节点调整时的相关系数及发散度,根据规则1与规则2,显而易得:节点4、9、11合并,12、15合并,最终剩下了4个节点.表3 隐节点第一次调整时的相关系数及发散度P ij j i46911′12′1315S i 4 1.0000.2450.9310.9870.3740.0320.4730.046160.245 1.0000.2330.3640.5120.4230.1790.008990.9310.233 1.0000.9240.3180.2440.0650.037411′0.9870.3640.924 1.0000.5020.3740.4930.019612′0.3740.5120.3180.502 1.0000.6340.9910.0523130.0320.4230.2440.3740.6341.0000.5230.0446150.4730.1790.0650.4930.9910.5231.0000.0611在网络训练完成后,得到了模型的最优连接权值W ,V 矩阵.5.3 模型的分析-预测为了确认建立的BP 模型的实用性,我们利用该模型预测1998年6月-1998年9月的成都市社会消费品零售总额.预测结果及其误差分析见表4.6 与GMDH 及传统BP 神经网络模型的比较在文中第 5.1部分,我们利用GMDH 方法已经建立了成都市社会消费水平模型,利用此模型预测1998年6月-1998年9月的成都市社会消费品零售总额.预测结果及其误差分析见表4.下面,我们利用传统BP 神经网络算法建立成都市社会消费水平模型.由于影响成都市社会消费品零售总额的变量主要有8个(一年期存款利率,全国居民消费物价指数,全国财政赤字额,现金流通量,人民币兑美元汇率,固定资产投资增长,全国出口增长,广义货币供应量),因此我们选择BP 网络的结构为:输入节点数8个,输出节点数1个.隐层节点数取大一些,这里取15个.并令迭代步数M 0=20000,误差上限E =0.0002,初始学习参数Z =0.5,动量项系数a =0.1.将1997年1月至1998年5月的数据作为学习样本输入到BP 网络中,经过传统BP 神经网络算法的学习,得到了模型的最优连接权值W ,V 矩阵.运用该模型预测1998年6月-1998年9月的成都市社会消费品零售总额.预测结果及其误差分析见表4.表4 各模型预测结果及误差分析 类型日期成都市社会消费品零售总额(亿元)BP 神经网络自适应学习算法自组织方法传统BP 网络学习算法预测值(亿元)相对误差(%)预测值(亿元)相对误差(%)预测值(亿元)相对误差(%)1998.61998.71998.81998.934.2133.8734.3835.2734.3933.5734.4235.510.56-0.890.120.6933.7833.1033.9534.31- 1.23- 2.27- 1.25- 2.7234.5933.4534.6135.531.12-1.250.940.79从上表显然可以看出,采用BP 神经网络自适应学习算法所得到的模型的预测精度较高,最大相对误差不超过0.89%,较自组织算法和传统BP 网络学习算法优越!并且该算法的运行时间也较直接应用传统BP 学习算法运行的时间短,从而提高了算法的效率.另外,我们还注意到,在自组织模型(见文中第5.1部分)中,v 3(人民币兑美元汇率)、v 6(广义货币供应量)的系数为负,即它们的值增大,y (社会消费品零售总7第5期BP 人工神经网络自适应学习算法的建立及其应用8系统工程理论与实践2004年5月额)反而下降,这与一般的消费理论不相符合.而在我们的BP模型中,v3(人民币兑美元汇率)、v6(广义货币供应量)对输出的影响都是正的(即它门增大,也增大),这也正是该算法精度比较高的原因.7 结束语本文在对传统BP算法进行了改进,提出BP神经网络自适应学习算法,增强了BP网络的适应性,提高了学习的速率;与自组织算法相结合来确定输入节点,使网络结构更加合理.不仅加快了网络的收敛速度,而且可以优化网络的拓扑结构,从而增强了BP神经网络的适应能力.参考文献:[1] 雷鸣,伊申明,杨叔子.神经网络自适应学习研究[J].系统工程与电子技术,1994,(3):29-36.[2] Haga n M T,M enhaj M B.T raining feed for wa rd netw or ks with M arqua r t algo rithm[J].IEEE Tr ans o n N euralN etw o rks,2001,5(6):989-993.[3] 罗小增,王仁华.学习常数的反向传播算法[A].中国神经网络首届学术大会论文集[C],1990.60-65.[4] 高大启.有教师的线性基本函数前向三层神经网络结构研究[J].计算机学报,1998,2l(1):80-85.[5] 王文剑.一种输入驱动的BP网络高效学习算法[J].系统工程理论与实践,2000,20(1):99-101.[6] Kandel E R,Schw ar ts J.Principles o f Neur al Science[M].chapter1-2Elsevier1985,1-56.[7] Hema Ra o,Alex ey G.Iva kh nenko.Inductiv e Leaning Alg o rithms fo r Complex Sy stem mo deling[M].CRC Pr ess,Inc,1994.56-78.[8] Far lo w S J.Self-o rg ani z ing M ethod in M o edling[M].M a rcel Dekke r,N ew Yo r k,1996.[9] Lippmann R P.An Introductio n to Computing W ith Neur al Nets[M].I EEE ASSP M ag azine,1999,23-45.[10] Cyberko G.Appro ximations by super po sitio ns o f a sig moidal func tion[A].M a th Contr ol Singnal System[C],1989.45-89.[11] Hech t-Nielse n R.Theo ry of back propaga tio n neura l netw o rk[J].Proc o f I JCN N,1989,1:593-603.[12] Edw ar d g ately.Neur al Netw o rk fo r Financial Fo recasting[M].Wiley,1996.[13] E ita n M ichael Azo ff.Reducing err or in neural ne two rk time series fo recasting[J].N eural Com puting and Applica-tio ns,1999:240-247.[14] Emad W Saad,Da nil V P,Do nald C W.Adv ance neural ne two rk t raining methods for lo w fa lse alarm sto ck tre ndpredictio n[A].Pr oc of W o rld Co ng ress o n N eural N etw or k[C].Washing D.C.,June1996.60-75[15] Rog er Stein.Pr epr ocessing date fo r da ta fo r neural netwo r k[J].A I Ex per t,M a rch,2001,25(2):69-78.[16] White H.Eco no mic prediction using neura l netw o rk:the ca se of IBM daily stock r eturns[A].Pro c of IEEE Int'lConfere nce o n N eural N etw or k[C],1998.70-79.[17] 焦李成.神经网络系统理论[M].西安:西安电子科技大学出版社,1990.30-42.[18] 张立明.人工神经网络的模型及其应用[M].上海:复旦大学出版社,1995.23-89.[19] 胡守仁,余少波,戴葵.神经网络导论[M].国防科技大学出版社,1993.56-91.[20] 彭建良,李新建,王斌,陈宝书.能源消费量模拟分析和预测的神经网络方法[J].系统理论与实践,1998,(7):76-83.[21] 胡建军,等.BP网络的权值诱导与层次训练算法[J].计算机科学,1998,25(1):60-63.[22] 李士勇.模糊控制、神经控制和智能控制论[M].哈尔滨:哈尔滨工业大学出版社,2001.98-99.[23] 何玉彬,李新忠.神经网络控制技术及其应用[M].北京:科学出版社,2000.18-76.[24] 张军英,许进.二进前向人工神经网络理论与应用[M].西安:西安电子科技大学出版社,2001.147-173.[25] 徐丽娜.神经网络控制[M].北京:电子工业出版社,2002.5-60.。

自适应动量项BP神经网络盲均衡算法

Ab t a t T f r h a s t dsg a o t e e ev dsg a n l n t eI t r y o tre e c f h i n l a d p i e s r c : oi e e r n mi e in l r m c i e n l dt ei n t t t f h r i a o mi aet e S mb ln e f r n eo t esg a, n a a t h n i v m o nu f c o t d c df r l de u l a in b s do e r l ewo kwi o n u co . T e o n u f c o d - me t m t r s n r u e i q a i t a e nBP n u a t r t m me tm f t r a ii o ob n z o n h a h me t m t r s m a i mo i l d p i l c o d n t au so me n s u r ro . t f d a a t ey a c r i g t ev l e f a q ae er r S i lto h wst a i e ag rt m u e i r o t a sn o sa t e v oh mu ai n s o t h s w l o i h t n h i s p r t i gc n t n s o t h u mo n u 0 l me t m n i u h a p c s s h o v r e c e , t e se d e i u l r o d t eb ter rr t . n s c s e t e c n e g n e s d h ta y r sd a r r a t pe e n a i r o -a e h — ; mo n m a t r me t u f co

自适应神经网络算法研究

自适应神经网络算法研究近年来,随着大数据、物联网、云计算等技术的迅速发展,人工智能技术也在不断地变革和发展。

其中,神经网络技术是人工智能技术中的重要组成部分,也是实现人工智能的必备技术之一。

自适应神经网络算法,作为一种强大的神经网络算法,其在机器学习和人工智能领域中应用广泛,能够有效地提高神经网络的性能与效率。

本文将对自适应神经网络算法的研究进行探讨。

一、自适应神经网络算法的基本原理自适应神经网络算法是建立在传统神经网络算法基础之上的一种高级算法。

其核心部分是反向传播神经网络算法(BP算法),其利用训练数据不断地调整网络权重,以使得网络输出与实际值之间的误差不断减小。

但BP算法也存在缺陷,例如:容易收敛到局部最优解、训练时间长、需要大量的训练数据等。

为了弥补这些缺陷,自适应神经网络算法应运而生。

自适应神经网络算法主要通过不断地调整网络架构和拓扑结构,来适应各种不同的训练数据和环境。

其工作原理可以概括如下:首先通过监督学习方式训练神经网络,再通过调整网络的权值和阈值进行自适应学习,使得网络能够自主地调整权重和拓扑结构,以适应输入数据的不同分布。

在自适应神经网络算法中,存在许多不同的结构和形式。

例如:自适应模糊神经网络、自适应神经模糊控制器、自适应神经模糊隔离器等。

二、自适应神经网络算法在实际应用中的优势自适应神经网络算法具有许多优势。

首先,在处理大规模数据时,其能够统一化训练数据,并自动调整网络结构,以达到有效的分类和预测。

其次,在解决非线性问题和多级嵌套问题时,自适应神经网络算法能够自动判断数据的隐含规律,并通过调整隶属关系和权值的数据,来实现准确的分类和预测。

此外,自适应神经网络算法还能够有效地对数据的缺失和噪声进行处理。

三、自适应神经网络算法研究进展随着人工智能技术的不断普及与深入研究,自适应神经网络算法也在不断地发展与完善。

其中,深度学习技术的出现,为自适应神经网络算法带来了新的研究方向和技术支持。

基于神经网络的全局寻优自适应BP学习算法

基于神经网络的全局寻优自适应BP学习算法

王兆宇;袁赣南;邱威

【期刊名称】《应用科技》

【年(卷),期】2004(031)006

【摘要】根据梯度算法中网络权值的演化规律,并基于终端吸引子,提出一种能全局寻优自适应的快速BP算法,该算法的基本思想是最小二乘算法,采用梯度搜索技术,以期使网络的实际输出值与期望值的误差的均方值为最小.同时,进行BP学习算法的稳定性和快速收敛问题分析研究.并进一步给出改善BP算法学习率修正、假饱和现象消除等训练结果的措施.

【总页数】3页(P46-47,50)

【作者】王兆宇;袁赣南;邱威

【作者单位】哈尔滨工程大学自动化学院,黑龙江,哈尔滨,150001;哈尔滨工程大学自动化学院,黑龙江,哈尔滨,150001;哈尔滨工程大学自动化学院,黑龙江,哈尔滨,150001

【正文语种】中文

【中图分类】O232

【相关文献】

1.BP神经网络的双学习率自适应学习算法 [J], 武美先;张学良;温淑花;郭琴

2.神经网络动量-自适应学习率BP算法与BP算法的性能比较及其应用 [J], 金仁杰

3.改进自适应遗传算法在BP神经网络学习中的应用 [J], 李孝忠;张有伟

4.全国私人车辆拥有量的 BP 神经网络模型预测与分析--基于附加动量与自适应学习速率相结合的BP方法 [J], 陈正;丁姝;王俊林

5.基于自适应遗传算法改进的BP神经网络卡钻事故预测 [J], 刘海龙;李彤;张奇志因版权原因,仅展示原文概要,查看原文内容请购买。

改进BP神经网络的自适应预测算法

改进BP神经网络的自适应预测算法

王燕妮;樊养余

【期刊名称】《计算机工程与应用》

【年(卷),期】2010(046)017

【摘要】针对视频编码中的耗时和图像不精确问题,提出改进BP神经网络的自适应预测算法.以区域生长、边缘检测和BP神经网络相结合,首先对图像进行对象分割,采用优化的传输结构,自适应调整学习率;然后在分割的基础上,进行自适应预测搜索编码.判断所选择块内是否有边界,若没有,不做运动估计,直接将当前块运动矢量置为零;若有,则进行自适应预测估计.根据不同的宏块特点,自适应地采取相应的搜索模式,减少搜索时间.实验结果表明,该算法与经典搜索算法相比,可取得良好的编码效果.【总页数】4页(P23-26)

【作者】王燕妮;樊养余

【作者单位】西北工业大学,电子信息学院,西安,710072;西安建筑科技大学,信息与控制工程学院,西安,710055;西北工业大学,电子信息学院,西安,710072

【正文语种】中文

【中图分类】TP391

【相关文献】

1.基于自适应学习速率的改进BP神经网络 [J], 唐艳;付存君;魏建新

2.航海船舰自适应多维预测算法设计 [J], 贾海云

3.航海船舰自适应多维预测算法设计 [J], 贾海云

4.基于自适应模型预测算法的光伏并网逆变器无功电压控制策略研究 [J], 李德鑫;王佳蕊;张家郡;庄冠群;孙振奥

5.基于自适应新息卡尔曼滤波的脱靶量预测算法 [J], 杨丽君;刘博;王军;陈天群;雷俊杰

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

自适应动量项BP神经网络盲均衡算法

王华;程海青

【期刊名称】《计算机工程与设计》

【年(卷),期】2010(031)006

【摘要】为了消除数字信号在传输过程中产生的码间串扰,使得接收端能够正确解调,对信道畸变进行有效补偿,在基于动量项BP神经网络盲均衡算法的基础上,提出一种能够自适应调节BP神经网络动量项的盲均衡算法.该算法根据盲均衡过程中误差函数的变化情况,自适应调节BP神经网络的动量项,充分发挥动量项在避免网络训练陷于较浅的局部极小点的优势.仿真实验结果表明,该算法在稳定性及收敛性能上均优于固定动量BP神经网络盲均衡算法.

【总页数】4页(P1297-1300)

【作者】王华;程海青

【作者单位】太原理工大学,计算机软件学院,山西,太原,030024;太原理工大学信息工程学院,山西,太原,030024

【正文语种】中文

【中图分类】TN911.5

【相关文献】

1.一种引入自适应动量项的变步长混沌信号盲分离算法 [J], 张天骐;马宝泽;强幸子;全盛荣

2.基于动量项前馈神经网络盲均衡算法 [J], 赵菊敏;程海青;张立毅

3.自适应变步长的动量项盲源分离方法 [J], 马志阳;张天骐;李群;梁先明

4.融合动量项的步长自适应盲源分离算法 [J], 李春腾;蒋宇中;刘芳君;张曙霞

5.改进的动量项BP神经网络电池SOC估算 [J], 姚和友;张庭芳;黄菊花;曹铭因版权原因,仅展示原文概要,查看原文内容请购买。