hadoop安装笔记

hadoop2.2.0安装笔记

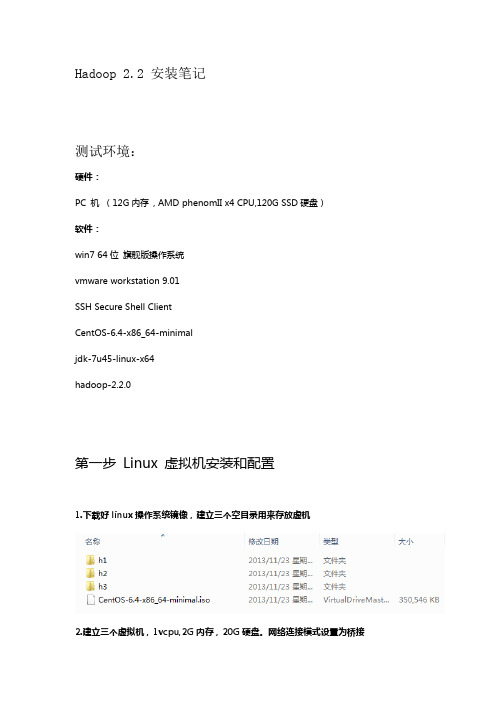

Hadoop 2.2 安装笔记测试环境:硬件:PC 机(12G内存, AMD phenomII x4 CPU,120G SSD硬盘)软件:win7 64位旗舰版操作系统vmware workstation 9.01SSH Secure Shell ClientCentOS-6.4-x86_64-minimaljdk-7u45-linux-x64hadoop-2.2.0第一步Linux 虚拟机安装和配置1.下载好linux操作系统镜像,建立三个空目录用来存放虚机2.建立三个虚拟机,1vcpu,2G内存,20G硬盘。

网络连接模式设置为桥接3.挂载iso镜像,安装系统,主机名分别设置为h1.hadooph2.hadooph3.hadooproot的密码都设成了hadoop由于使用的是centos最小安装镜像,所以各种设置采用默认的即可。

centos 最小安装版镜像地址/centos/6.4/isos/x86_64/4.修改三台虚机的网络配置,设置静态IP(物理机的ip为192.168.1.xx)h1 192.168.1.21h2 192.168.1.22h3 192.168.1.23重启虚机网络service network restart5.关闭防火墙:(非常重要)在三台机器上运行chkconfig iptables off (重启后生效)6.修改三台机器的/etc/hosts文件,加入以下三行192.168.1.21 h1 h1.hadoop192.168.1.22 h2 h2.hadoop192.168.1.23 h3 h3.hadoop7.安装完成后关机,快照。

(防止误操作)第二步,安装JDK1.下载JDK,使用secure file transfer工具上传到三台虚机(由于使用的是centos,我下载的RPM包)JDK下载地址/technetwork/java/javase/downloads/jdk7-downloads-1 880260.html2.在每台虚机上安装JDK[root@h3 ~]# rpm -ivh jdk-7u45-linux-x64.rpm第三步配置SSH 互信1.在每一台机器上创建RSA公钥2.将三台机器的公钥文件id_rsa.pub合并,并拷回每台机器的~/.ssh/,重命名为authorized_keysh1[root@h1 .ssh]# scp ~/.ssh/id_rsa.pub root@h2:~/.ssh/authorized_keysh2[root@h2 ~]# cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys[root@h2 ~]# scp ~/.ssh/authorized_keys root@h3:~/.ssh/authorized_keysh3[root@h3 ~]# cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys[root@h3 ~]# scp ~/.ssh/authorized_keys root@h1:~/.ssh/[root@h3 ~]# scp ~/.ssh/authorized_keys root@h2:~/.ssh/3.用每一台机器ssh连接另外两台,确保不用输入密码[root@h1 ~]# ssh h2Last login: Tue Jan 1 17:33:24 2008 from h3[root@h2 ~]# exitlogoutConnection to h2 closed.[root@h1 ~]# ssh h3Last login: Tue Jan 1 17:33:08 2008 from h2[root@h3 ~]# exitlogoutConnection to h3 closed.注意第一次建立连接时会有一个提示,以后就不会有了[root@h1 ~]# ssh h3The authenticity of host 'h3 (192.168.1.23)' can't be established.RSA key fingerprint is ba:26:62:1f:f7:46:24:cd:f9:95:c3:55:82:eb:4e:5a.Are you sure you want to continue connecting (yes/no)? yesWarning: Permanently added 'h3,192.168.1.23' (RSA) to the list of known hosts. Last login: Tue Jan 1 17:18:53 2008 from 192.168.1.104第四步安装hadoop1.下载hadoop,由于2.2.x已经发布了稳定版,所以我下载了这个版本下载地址/apache/hadoop/common/hadoop-2.2.0/2.将hadoop-2.2.0.tar.gz 上传到h1节点3.解压安装包[root@h1 ~]# tar -zxvf hadoop-2.2.0.tar.gz4.修改hadoop-env.sh 文件[root@h1 hadoop]# vi /root/hadoop-2.2.0/etc/hadoop/hadoop-env.sh export JAVA_HOME=/usr/java/jdk1.7.0_455.修改core-site.xml文件[root@h1 hadoop]# vi core-site.xml<configuration><property><name></name><value>hdfs://h1:9000</value></property><property><name>hadoop.tmp.dir</name><value>/root/hadoop/tmp</value></property></configuration>6.建立hadoop临时目录(同样也要在节点2和节点3上建立)[root@h1 hadoop]# mkdir -p ~/hadoop/tmp7.修改 hdfs-site.xml文件[root@h1 hadoop]# vi hdfs-site.xml<configuration><property><name>dfs.replication</name><value>2</value></property></configuration>8.修改mapred-site.xml文件[root@h1 hadoop]# cp mapred-site.xml.template mapred-site.xml [root@h1 hadoop]# vi mapred-site.xml<configuration><property><name>mapred.job.tracker</name><value>h1:9001</value></property></configuration>9.修改masters文件[root@h1 hadoop]# vi mastersh110.修改slaves文件[root@h1 hadoop]# vi slavesh2h311.将hadoop-2.2.0拷贝到节点2和3[root@h1 ~]# scp -r hadoop-2.2.0 root@h2:~[root@h1 ~]# scp -r hadoop-2.2.0 root@h3:~12.格式化name node[root@h1 bin]# ~/hadoop-2.2.0/bin/hadoop namenode -format13.启动hadoop集群[root@h1 bin]# ./start-all.sh14.验证集群状态h1h2h3总结:1.整个安装步骤基本顺利,hadoop采用了java虚拟机,所以相对于其他系统简单很多。

hadoop安装指南及基本命令

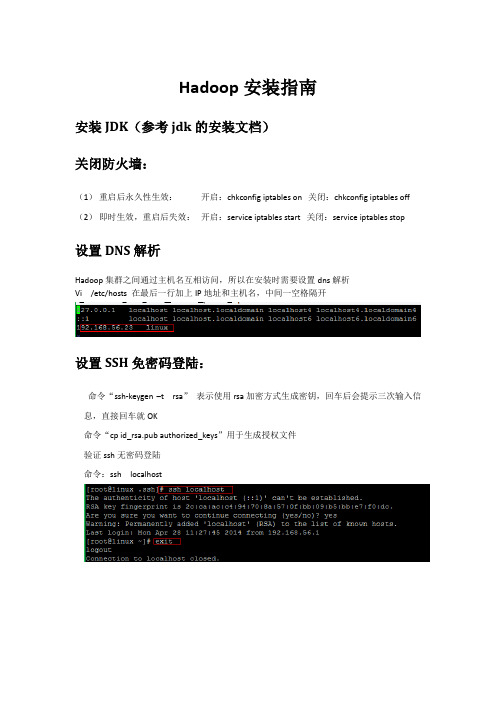

Hadoop安装指南安装JDK(参考jdk的安装文档)关闭防火墙:(1)重启后永久性生效:开启:chkconfig iptables on 关闭:chkconfig iptables off (2)即时生效,重启后失效:开启:service iptables start 关闭:service iptables stop设置DNS解析Hadoop集群之间通过主机名互相访问,所以在安装时需要设置dns解析Vi /etc/hosts 在最后一行加上IP地址和主机名,中间一空格隔开设置SSH免密码登陆:命令“ssh-keygen –t rsa”表示使用rsa加密方式生成密钥,回车后会提示三次输入信息,直接回车就OK命令“cp id_rsa.pub authorized_keys”用于生成授权文件验证ssh无密码登陆命令:ssh localhost安装hadoop安装程序包将hadoop-1.1.2.tar.gz 放在usr/hadopp目录下命令: tar –xzvf Hadoop-1.1.2.tar.gz设置环境变量Vi /etc/profile 在最后面输入:Export HADOOP_HOME=/usr/Hadoop/Hadoop-1.1.2Export PATH=$PATH:$HADOOP_HOME/bin修改hadoop配置文件1.hadoop-env.shexport JAVA_HOME=/usr/local/jdk/2.core-site.xml<configuration><property><name></name><value>hdfs://hadoop0:9000</value><description>change your own hostname</description> </property><property><name>hadoop.tmp.dir</name><value>/usr/local/hadoop/tmp</value></property></configuration>3.hdfs-site.xml<configuration><property><name>dfs.replication</name><value>1</value></property><property><name>dfs.permissions</name><value>false</value></property></configuration>4.mapred-site.xml<configuration><property><name>mapred.job.tracker</name><value>hadoop0:9001</value><description>change your own hostname</description></property></configuration>Hadoop集群环境的搭建1、准备机器一台master,若干台slave,配置每台机器的/etc/hosts保证各台机器之间通过机器名可以互访,当前准备三台机器:对三台机器分别安装hadoop环境,SSH秘密登陆和DNS 解析。

黑马程序员hadoop笔记

黑马程序员hadoop笔记Hadoop是当前最流行的大数据处理框架之一,具备高可靠性、高扩展性和高效性等特点。

本文将全面介绍Hadoop的相关内容,包括其基本概念、架构设计、应用场景以及使用方法等。

1. Hadoop的基本概念Hadoop是一个开源的分布式计算平台,其核心由Hadoop分布式文件系统(HDFS)和MapReduce计算框架组成。

HDFS采用主从架构,支持海量数据的分布式存储和处理;MapReduce则是一种分布式计算模型,提供了高效的数据处理能力。

2. Hadoop的架构设计Hadoop采用了分布式存储和计算的架构设计,主要包括主节点(NameNode)和多个工作节点(DataNode)组成。

主节点负责管理整个系统的元数据信息,存储在内存中,而工作节点则负责存储和计算任务的执行。

3. Hadoop的应用场景Hadoop广泛应用于大规模数据处理和分析领域。

它可以处理各种类型的数据,包括结构化数据、半结构化数据和非结构化数据等。

常见的应用场景包括日志分析、推荐系统、搜索引擎和数据仓库等。

4. Hadoop的使用方法使用Hadoop进行数据处理通常需要编写MapReduce程序,它由Mapper和Reducer两个组件组成。

Mapper负责将输入数据切分成若干键值对,然后执行相应的逻辑处理;Reducer负责对Mapper的输出结果进行归纳和聚合。

在编写MapReduce程序时,我们需要定义数据的输入和输出路径,并指定Mapper和Reducer的逻辑处理方式。

通过Hadoop提供的命令行工具和API,可以方便地操作Hadoop集群,提交任务并监控任务的执行状态。

本文对Hadoop的概念、架构设计、常见应用场景和使用方法进行了简要介绍。

Hadoop作为一种强大的大数据处理框架,具备高可靠性和高扩展性,适用于处理大规模数据和复杂计算任务。

通过深入学习和掌握Hadoop的知识,我们可以更好地应对现实中的数据挑战,并开展相关的数据分析和应用开发工作。

Hadoop学习笔记二 安装部署

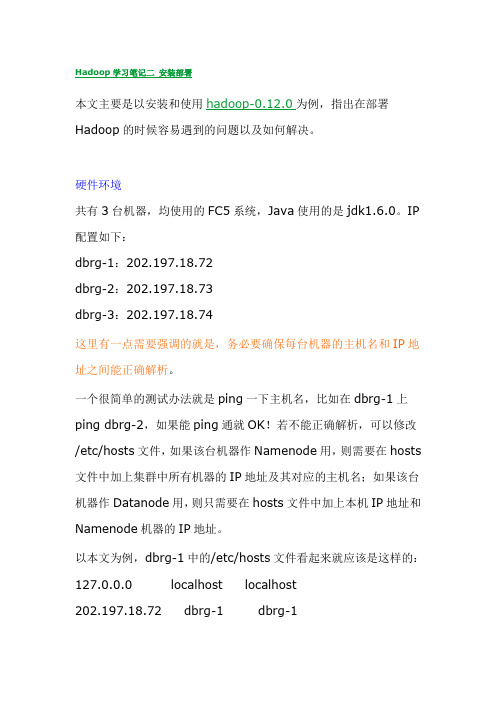

Hadoop学习笔记二安装部署本文主要是以安装和使用hadoop-0.12.0为例,指出在部署Hadoop的时候容易遇到的问题以及如何解决。

硬件环境共有3台机器,均使用的FC5系统,Java使用的是jdk1.6.0。

IP 配置如下:dbrg-1:202.197.18.72dbrg-2:202.197.18.73dbrg-3:202.197.18.74这里有一点需要强调的就是,务必要确保每台机器的主机名和IP地址之间能正确解析。

一个很简单的测试办法就是ping一下主机名,比如在dbrg-1上ping dbrg-2,如果能ping通就OK!若不能正确解析,可以修改/etc/hosts文件,如果该台机器作Namenode用,则需要在hosts 文件中加上集群中所有机器的IP地址及其对应的主机名;如果该台机器作Datanode用,则只需要在hosts文件中加上本机IP地址和Namenode机器的IP地址。

以本文为例,dbrg-1中的/etc/hosts文件看起来就应该是这样的:127.0.0.0 localhost localhost202.197.18.72 dbrg-1 dbrg-1202.197.18.73 dbrg-2 dbrg-2202.197.18.74 dbrg-3 dbrg-3dbrg-2中的/etc/hosts文件看起来就应该是这样的:127.0.0.0 localhost localhost202.197.18.72 dbrg-1 dbrg-1202.197.18.73 dbrg-2 dbrg-2在上一篇学习笔记中提到过,对于Hadoop来说,在HDFS看来,节点分为Namenode和Datanode,其中Namenode只有一个,Datanode可以是很多;在MapReduce看来,节点又分为Jobtracker和Tasktracker,其中Jobtracker只有一个,Tasktracker可以是很多。

简单梳理hadoop安装流程文字

简单梳理Hadoop安装流程

今儿个咱们来简单梳理下Hadoop的安装流程,让各位在四川的兄弟姐妹也能轻松上手。

首先,你得有个Linux系统,比如说CentOS或者Ubuntu,这点很重要。

然后在系统上整个Java环境,Hadoop 是依赖Java运行的。

把JDK下载安装好后,记得配置下环境变量,就是修改`/etc/profile`文件,把Java的安装路径加进去。

接下来,你需要在系统上整个SSH服务,Hadoop集群内部的通信要用到。

安好SSH后,记得配置下无密钥登录,省得每次登录都要输密码,多麻烦。

Hadoop的安装包可以通过官方渠道下载,也可以在网上找现成的。

下载好安装包后,解压到你的安装目录。

然后就开始配置Hadoop的环境变量,跟配置Java环境变量一样,也是在

`/etc/profile`文件里加路径。

配置Hadoop的文件是重点,都在Hadoop安装目录下的`etc/hadoop`文件夹里。

有`hadoop-env.sh`、`core-site.xml`、`hdfs-site.xml`这些文件需要修改。

比如`core-site.xml`里要设置HDFS的地址和端口,`hdfs-site.xml`里要设置临时目录这些。

最后,就可以开始格式化HDFS了,用`hdfs namenode-format`命令。

然后启动Hadoop,用`start-all.sh`脚本。

如果一

切配置正确,你就可以用`jps`命令看到Hadoop的各个进程在运行了。

这整个过程看似复杂,但只要你跟着步骤来,注意配置文件的路径和内容,相信你也能轻松搞定Hadoop的安装。

hadoop安装实验总结

hadoop安装实验总结Hadoop安装实验总结Hadoop是一个开源的分布式计算框架,用于处理大规模数据集。

在本次实验中,我成功安装了Hadoop,并进行了相关的配置和测试。

以下是我对整个过程的总结和经验分享。

1. 环境准备在开始安装Hadoop之前,我们需要确保已经具备了以下几个环境条件:- 一台Linux操作系统的机器,推荐使用Ubuntu或CentOS。

- Java开发环境,Hadoop是基于Java开发的,因此需要安装JDK。

- SSH服务,Hadoop通过SSH协议进行节点之间的通信,因此需要确保SSH服务已启动。

2. 下载和安装Hadoop可以从Hadoop官方网站上下载最新的稳定版本。

下载完成后,解压缩到指定目录,并设置环境变量。

同时,还需要进行一些配置,包括修改配置文件和创建必要的目录。

3. 配置Hadoop集群Hadoop是一个分布式系统,通常会配置一个包含多个节点的集群。

在配置文件中,我们需要指定集群的各个节点的IP地址和端口号,并设置一些重要的参数,如数据存储路径、副本数量等。

此外,还可以根据实际需求调整其他配置参数,以优化集群性能。

4. 启动Hadoop集群在完成集群配置后,我们需要启动Hadoop集群。

这一过程需要先启动Hadoop的各个组件,包括NameNode、DataNode、ResourceManager和NodeManager等。

启动成功后,可以通过Web 界面查看集群的状态和运行情况。

5. 测试Hadoop集群为了验证Hadoop集群的正常运行,我们可以进行一些简单的测试。

例如,可以使用Hadoop提供的命令行工具上传和下载文件,查看文件的副本情况,或者运行一些MapReduce任务进行数据处理。

这些测试可以帮助我们了解集群的性能和可靠性。

6. 故障排除与优化在实际使用Hadoop时,可能会遇到一些故障和性能问题。

为了解决这些问题,我们可以通过查看日志文件或者使用Hadoop提供的工具进行故障排查。

Hadoop安装笔记

最近工作需要,摸索着搭建了Hadoop 2.2.0(YARN)集群,中间遇到了一些问题,在此记录,希望对需要的同学有所帮助。

本篇文章不涉及hadoop2.2的编译,编译相关的问题在另外一篇文章《hadoop 2.2.0 源码编译笔记》中说明,本篇文章我们假定已经获得了hadoop 2.2.0的64bit发行包。

由于spark的兼容问题,我们后面使用了Hadoop 2.0.5-alpha 的版本(2.2.0是稳定版本),2.0.5的配置有一点细微的差别,文中有特别提示。

1. 简介【本节摘自/xia520pi/archive/2012/05/16/2503949.html】Hadoop是Apache软件基金会旗下的一个开源分布式计算平台。

以Hadoop分布式文件系统(HDFS,Hadoop Distributed Filesystem)和MapReduce(Google MapReduce的开源实现)为核心的Hadoop 为用户提供了系统底层细节透明的分布式基础架构。

对于Hadoop的集群来讲,可以分成两大类角色:Master和Salve。

一个HDFS集群是由一个NameNode和若干个DataNode组成的。

其中NameNode作为主服务器,管理文件系统的命名空间和客户端对文件系统的访问操作;集群中的DataNode管理存储的数据。

MapReduce框架是由一个单独运行在主节点上的JobTracker和运行在每个集群从节点的TaskTracker共同组成的。

主节点负责调度构成一个作业的所有任务,这些任务分布在不同的从节点上。

主节点监控它们的执行情况,并且重新执行之前的失败任务;从节点仅负责由主节点指派的任务。

当一个Job被提交时,JobTracker接收到提交作业和配置信息之后,就会将配置信息等分发给从节点,同时调度任务并监控TaskTracker的执行。

从上面的介绍可以看出,HDFS和MapReduce共同组成了Hadoop分布式系统体系结构的核心。

hadoop中完全分布式安装实践总结

hadoop中完全分布式安装实践总结

先说大方向的把握吧:

1.先在一台机器上把所有的配置文件都改好,然后再用scp命令,传到其他机器上,以此构成集群。

不要每个机器上面改,麻烦不说,还很容易漏改或者错改。

2.必须确保namenode可以无密码ssh到datanode,datanode也可以无密码ssh到namenode。

这是集群间通信和hadoop集群正常运行的基础。

3.不要小瞧了/etc/hosts配置文件中的内容,安装不成功,毛

病大多出在机器的hostname和/etc/hosts中的内容不一致,或者slaves,master配置文件中的对应主机名与前面二者不一致。

slaves 的ip要出现在master的/etc/hosts中,同样master的ip也要出

现在slaves的/etc/hosts文件中。

4.防火墙要关闭。

对应错误

5.主机名不可以带下划线,否则报

错。

6.jdk的安装目录要一致!。

HadoopHbaseHive安装过程详细记录-14页word资料

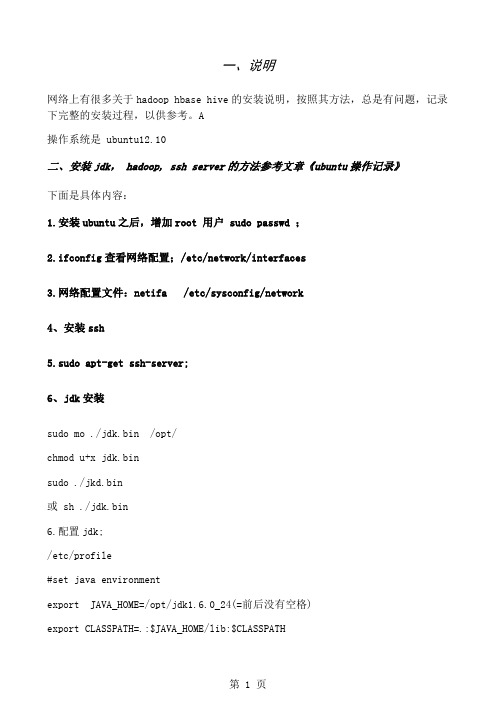

一、说明网络上有很多关于hadoop hbase hive的安装说明,按照其方法,总是有问题,记录下完整的安装过程,以供参考。

A操作系统是 ubuntu12.10二、安装jdk, hadoop, ssh server的方法参考文章《ubuntu操作记录》下面是具体内容:1.安装ubuntu之后,增加root 用户 sudo passwd ;2.ifconfig查看网络配置;/etc/network/interfaces3.网络配置文件:netifa /etc/sysconfig/network4、安装ssh5.sudo apt-get ssh-server;6、jdk安装sudo mo ./jdk.bin /opt/chmod u+x jdk.binsudo ./jkd.bin或 sh ./jdk.bin6.配置jdk;/etc/profile#set java environmentexport JAVA_HOME=/opt/jdk1.6.0_24(=前后没有空格)export CLASSPATH=.:$JAVA_HOME/lib:$CLASSPATHexport PATH=$JAVA_HOME/bin:$PATHumask 022/etc/environmentPATH="/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/ga mesc"CLASSPATH="/opt/jdk1.6.0_24/lib"JAVAHOME="/opt/jdk1.6.0_24"7. shutdown –r now重启之后,显示java安装成功。

7、ssh设置$ apt-get install ssh$ ssh-keygen -t rsa -f ~/.ssh/id_rsa$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys$ ssh localhost(认证没有通过)在上面的问题中应该回答yes,继续,就可以ssh匿名登录了。

安装 hadoop 高可用知识点

安装 hadoop 高可用知识点

安装Hadoop高可用性(HA)需要掌握以下知识点:

1. 了解HA的必要性:在Hadoop集群中,NameNode是单点故障(SPOF),如果NameNode机器发生意外或需要升级,集群将无法使用。

因此,实现高可用性是必要的。

2. 掌握HDFS的HA机制:HDFS的HA通过配置Active/Standby两个NameNodes实现在集群中对NameNode的热备来解决单点故障问题。

3. 了解之前的单点故障问题:在之前,NameNode存在单点故障,影响HDFS集群的可用性。

4. 掌握HA的配置步骤:安装HA需要配置多个组件,包括ZooKeeper、Active/Standby NameNodes等。

需要了解如何配置这些组件,以确保它们能够正常工作并实现高可用性。

5. 理解HA的工作原理:需要理解HA的工作原理,包括Active/Standby NameNodes的切换机制、如何通过ZooKeeper实现高可用性等。

6. 了解安装HA的注意事项:在安装HA时,需要注意一些问题,例如防火墙设置、网络配置、文件系统一致性等。

需要了解如何解决这些问题,以确保Hadoop集群的高可用性。

7. 掌握故障处理和性能调优:安装HA后,需要掌握故障处理和性能调优的方法。

例如,如何处理Active/Standby NameNodes的切换问题、如何优化Hadoop集群的性能等。

总之,安装Hadoop高可用性需要掌握多个知识点,包括HA的必要性、HDFS的HA机制、之前的单点故障问题、HA的配置步骤、工作原理、注意事项以及故障处理和性能调优等。

hadoop学习笔记(一、hadoop集群环境搭建)

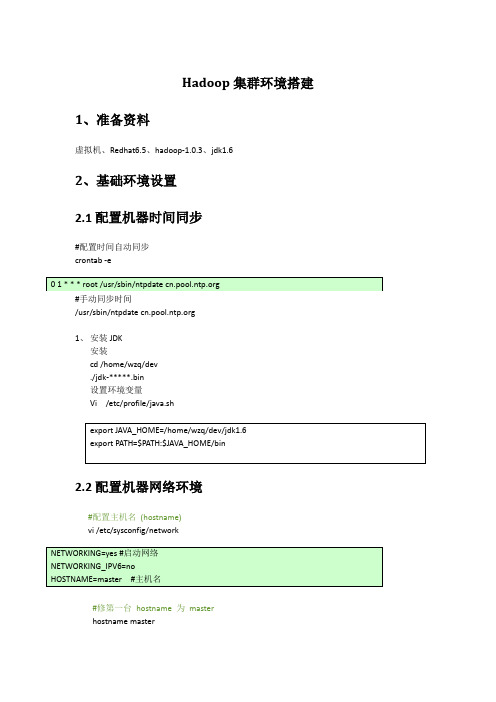

Hadoop集群环境搭建1、准备资料虚拟机、Redhat6.5、hadoop-1.0.3、jdk1.62、基础环境设置2.1配置机器时间同步#配置时间自动同步crontab -e#手动同步时间/usr/sbin/ntpdate 1、安装JDK安装cd /home/wzq/dev./jdk-*****.bin设置环境变量Vi /etc/profile/java.sh2.2配置机器网络环境#配置主机名(hostname)vi /etc/sysconfig/network#修第一台hostname 为masterhostname master#检测hostname#使用setup 命令配置系统环境setup#检查ip配置cat /etc/sysconfig/network-scripts/ifcfg-eth0#重新启动网络服务/sbin/service network restart#检查网络ip配置/sbin/ifconfig2.3关闭防火墙2.4配置集群hosts列表vi /etc/hosts#添加一下内容到vi 中2.5创建用户账号和Hadoop部署目录和数据目录#创建hadoop 用户/usr/sbin/groupadd hadoop#分配hadoop 到hadoop 组中/usr/sbin/useradd hadoop -g hadoop#修改hadoop用户密码Passwd hadoop#创建hadoop 代码目录结构mkdir -p /opt/modules/hadoop/#修改目录结构权限拥有者为为hadoopchown -R hadoop:hadoop /opt/modules/hadoop/2.6生成登陆密钥#切换到Hadoop 用户下su hadoopcd /home/hadoop/#在master、node1、node2三台机器上都执行下面命令,生成公钥和私钥ssh-keygen -q -t rsa -N "" -f /home/hadoop/.ssh/id_rsacd /home/hadoop/.ssh#把node1、node2上的公钥拷贝到master上scp /home/hadoop/.ssh/ id_rsa.pub hadoop@master:/home/hadoop/.ssh/node1_pubkey scp /home/hadoop/.ssh/ id_rsa.pub hadoop@master:/home/hadoop/.ssh/node2_pubkey#在master上生成三台机器的共钥cp id_rsa.pub authorized_keyscat node1_pubkey >> authorized_keyscat node2_pubkey >> authorized_keysrm node1_pubkey node2_pubkey#吧master上的共钥拷贝到其他两个节点上scp authorized_keys node1: /home/hadoop/.ssh/scp authorized_keys node1: /home/hadoop/.ssh/#验证ssh masterssh node1ssh node2没有要求输入密码登陆,表示免密码登陆成功3、伪分布式环境搭建3.1下载并安装JAVA JDK系统软件#下载jdkwget http://60.28.110.228/source/package/jdk-6u21-linux-i586-rpm.bin#安装jdkchmod +x jdk-6u21-linux-i586-rpm.bin./jdk-6u21-linux-i586-rpm.bin#配置环境变量vi /etc/profile.d/java.sh#手动立即生效source /etc/profile3.2 Hadoop 文件下载和安装#切到hadoop 安装路径下cd /opt/modules/hadoop/#从 下载Hadoop 安装文件wget /apache-mirror/hadoop/common/hadoop-1.0.3/hadoop-1.0.3.tar.gz#如果已经下载,请复制文件到安装hadoop 文件夹cp hadoop-1.0.3.tar.gz /opt/modules/hadoop/#解压hadoop-1.0.3.tar.gzcd /opt/modules/hadoop/tar -xvf hadoop-1.0.3.tar.gz#配置环境变量vi /etc/profile.d/java.sh#手动立即生效source /etc/profile3.3配置hadoop-env.sh 环境变量#配置jdk。

Linux CentOS下Hadoop伪分布模式安装笔记

Linux CentOS下Hadoop伪分布模式安装笔记一. 概要经过几天的调试,终于在Linux Cent OS 5.0下成功搭建Hadoop测试环境。

本次测试在一台服务器上进行伪分布式搭建。

Hadoop 伪分布式模式是在单机上模拟 Hadoop 分布式,单机上的分布式并不是真正的伪分布式,而是使用线程模拟分布式。

Hadoop 本身是无法区分伪分布式和分布式的,两种配置也很相似,唯一不同的地方是伪分布式是在单机器上配置,数据节点和名字节点均是一个机器。

虽然Hadoop的安装步骤并不复杂,但是我在安装期间还是遇到了很多琐碎的问题,现将自己搭建Hadoop的详细过程和遇到的问题记录下来。

二. 环境搭建搭建测试环境所需的软件包括:jdk1.6.0_20、hadoop-0.20.2.tar.gz。

测试服务器操作系统Linux Cent OS 5.0。

1. SSH无密码验证配置Hadoop 需要使用SSH 协议,namenode 将使用SSH 协议启动 namenode和datanode 进程,伪分布式模式数据节点和名称节点均是本身,必须配置 SSH localhost无密码验证。

用root用户登录,在家目录下执行如下命令:ssh-keygen -t rsa[root@master ~]# ssh-keygen -t rsaGenerating public/private rsa key pair.Enter file in which to save the key (/root/.ssh/id_rsa): & 按回车默认路径 &Created directory '/root/.ssh'. &创建/root/.ssh目录&Enter passphrase (empty for no passphrase):Enter same passphrase again:Your identification has been saved in /root/.ssh/id_rsa.Your public key has been saved in /root/.ssh/id_rsa.pub.The key fingerprint is:c6:7e:57:59:0a:2d:85:49:23:cc:c4:58:ff:db:5b:38 root@master通过以上命令将在/root/.ssh/ 目录下生成id_rsa私钥和id_rsa.pub公钥。

hadoop集群搭建总结

Hadoop集群搭建总结一、概述Hadoop是一个分布式计算框架,由Apache基金会开发。

它能够处理大规模的数据集,并能够在商用服务器上构建集群。

Hadoop的核心组件包括HDFS(分布式文件系统)和MapReduce(编程模型)。

二、安装与配置1. 环境准备:确保服务器具备以下条件:操作系统(如CentOS)、Java环境(JDK)、SSH配置、网络环境。

2. HDFS安装与配置:安装Hadoop前,需要先安装HDFS。

创建目录,配置核心配置文件(如hdfs-site.xml、core-site.xml),格式化HDFS,启动并验证HDFS状态。

3. MapReduce安装与配置:安装Hadoop后,需要安装MapReduce。

配置MapReduce2相关的配置文件(mapred-site.xml、yarn-site.xml),启动并验证MapReduce状态。

4. YARN安装与配置:YARN是Hadoop的资源管理器,负责资源的分配和管理。

配置YARN相关的配置文件(yarn-site.xml),启动并验证YARN状态。

三、节点扩展当集群负载过高或数据量过大时,需要进行节点扩展。

扩展时需要注意节点的均衡,确保各个节点之间的负载差异不会过大。

四、性能优化针对Hadoop集群的性能优化,可以采取以下措施:1. 调整HDFS的块大小:根据实际情况调整HDFS的块大小,可以提高数据读写效率。

2. 调整MapReduce的参数:针对特定的作业,可以调整MapReduce的参数来优化性能,如增加map和reduce任务的内存分配、调整任务并发度等。

3. 优化Java虚拟机参数:针对Java虚拟机,可以调整其内存分配、垃圾回收策略等参数来优化性能。

4. 使用压缩:在数据传输过程中,使用压缩可以减少网络传输量,提高性能。

5. 调整网络参数:针对网络环境,可以调整TCP协议的参数来提高网络性能。

五、安全性和可靠性为了确保Hadoop集群的安全性和可靠性,可以采取以下措施:1. 配置Kerberos认证:使用Kerberos可以为Hadoop集群提供强认证机制,确保数据的安全性。

hadoop安装与配置总结与心得

hadoop安装与配置总结与心得安装与配置Hadoop是一个相对复杂的任务,但如果按照正确的步骤进行,可以顺利完成。

以下是我在安装与配置Hadoop 过程中的总结与心得:1. 首先,确保你已经满足Hadoop的系统要求,并且已经安装了Java环境和SSH。

2. 下载Hadoop的压缩包,并解压到你想要安装的目录下。

例如,解压到/opt/hadoop目录下。

3. 配置Hadoop的环境变量。

打开你的.bashrc文件(或者.bash_profile文件),并添加以下内容:```shellexport HADOOP_HOME=/opt/hadoopexport PATH=$PATH:$HADOOP_HOME/bin```保存文件后,执行source命令使其生效。

4. 配置Hadoop的核心文件。

打开Hadoop的配置文件core-site.xml,并添加以下内容:```xml<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration>```5. 配置Hadoop的HDFS文件系统。

打开Hadoop的配置文件hdfs-site.xml,并添加以下内容:```xml<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>```这里的dfs.replication属性指定了数据块的副本数量,可以根据实际情况进行调整。

6. 配置Hadoop的MapReduce框架。

基于hadoop的云计算 第一篇 安装配置篇

Hadoop学习笔记——安装配置篇邓兵野Hadoop学习笔记——安装配置篇 (1)1. Hadoop基本组成 (1)2. 名词解释 (1)3. 安装平台: (2)4. 所需的软件: (2)5. 下载 (2)6. 部署 (2)7. 环境配置 (2)7.1 公共配置(集群中所有机器都需要的配置) (2)7.2 每个节点不同的配置 (4)8. hadoop无用户登录配置 (7)9. 启动hadoop (9)1. Hadoop基本组成NameNode 主要存放文件映射和文件更改日志SecondaryNameNode 一个守护进程定时从NameNode同步文件更改日志并合并成一条日志,方便hadoop每次重启时找到上次宕机的还原点。

在后续的版本中会被backupNameNode和nameNode集群取代。

Jobtracker 任务调度守护进程Tasktracker 任务执行进程DataName 数据存储节点,往往和Tasktracker部署在同一台机器上。

2. 名词解释3. 安装平台:GNU/Linux ,hadoop不建议在win32平台上使用,顾这里只介绍在linux系统上的安装和配置4. 所需的软件:Java TM1.5.x及以上的版本,必须安装,建议选择Sun公司发行的Java版本。

ssh必须安装并且保证sshd一直运行,以便用Hadoop 脚本管理远端Hadoop守护进程。

5. 下载本文使用的是hadoop-0.20.203.0,笔者当前的稳定版本。

下载地址/common/releases.html#Download6. 部署本文使用的是4台linux机器,hadoop.master 作为namenode节点,hadoop.second作为secondaryNameNode节点,hadoop.slave1 作为第一datanode节点,hadoop.slave2作为第二个datanode节点。

7. 环境配置7.1公共配置(集群中所有机器都需要的配置)编辑环境变量建议直接编辑/etc/profile文件增加JA V A_HOME和HADOOP_HOME环境变量,具体事例如下所示:[root@hadoop ~]# vi /etc/profile增加如下几行代码export JA V A_OPTS='-Xms256m -Xmx512m'export JA V A_HOME=/usr/local/javaexport CLASSPA TH=.:$JA V A_HOME/lib/dt.jar:$JA V A_HOME/lib/tools.jarexport JRE_HOME=/usr/local/java/jreexport PA TH=$JA V A_HOME/bin:$PA THexport HADOOP_HOME=/usr/local/hadoopexport PA TH=$PA TH:$HADOOP_HOME/bin笔者为了以后方便起停hadoop 把hadoop的bin也目录加到path中。

hadoop2安装笔记

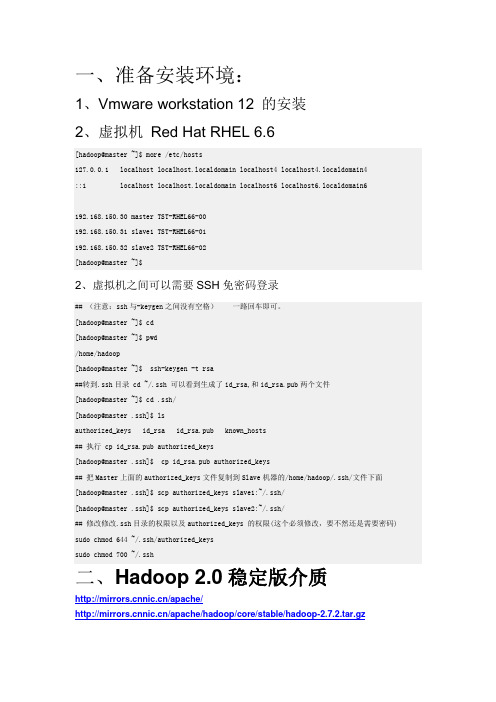

一、准备安装环境:1、Vmware workstation 12 的安装2、虚拟机Red Hat RHEL 6.6[hadoop@master~]$ more /etc/hosts127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4::1 localhost localhost.localdomain localhost6 localhost6.localdomain6192.168.150.30 master TST-RHEL66-00192.168.150.31 slave1 TST-RHEL66-01192.168.150.32 slave2 TST-RHEL66-02[hadoop@master~]$2、虚拟机之间可以需要SSH免密码登录## (注意:ssh与-keygen之间没有空格)一路回车即可。

[hadoop@master~]$ cd[hadoop@master~]$pwd/home/hadoop[hadoop@master~]$ ssh-keygen -t rsa##转到.ssh目录 cd ~/.ssh 可以看到生成了id_rsa,和id_rsa.pub两个文件[hadoop@master~]$ cd .ssh/[hadoop@master .ssh]$ lsauthorized_keys id_rsa id_rsa.pub known_hosts## 执行 cp id_rsa.pub authorized_keys[hadoop@master .ssh]$ cp id_rsa.pub authorized_keys## 把Master上面的authorized_keys文件复制到Slave机器的/home/hadoop/.ssh/文件下面[hadoop@master .ssh]$scpauthorized_keys slave1:~/.ssh/[hadoop@master .ssh]$scpauthorized_keys slave2:~/.ssh/## 修改修改.ssh目录的权限以及authorized_keys 的权限(这个必须修改,要不然还是需要密码) sudochmod 644 ~/.ssh/authorized_keyssudochmod 700 ~/.ssh二、Hadoop 2.0稳定版介质/apache//apache/hadoop/core/stable/hadoop-2.7.2.tar.gz1、上传解压文件并创建软链接# tar xzvf hadoop-2.2.0.tar.gz# chown -R hadoop:hadoop hadoop-2.2.0 (-R级联的授权,子目录都有权限)2、配置主机变量配置环境变量(三台主机)添加如下内容到hadoop用户的.bashrc文件:# User specific aliases and functionsexport JAVA_HOME=/usr/java/latestexport CLASSPATH=$CLASSPATH:$JAVA_HOME/libexport HADOOP_DEV_HOME=/home/hadoop/hadoop2export HADOOP_MAPARED_HOME=${HADOOP_DEV_HOME}export HADOOP_COMMON_HOME=${HADOOP_DEV_HOME}export HADOOP_HDFS_HOME=${HADOOP_DEV_HOME}export YARN_HOME=${HADOOP_DEV_HOME}export HADOOP_CONF_DIR=${HADOOP_DEV_HOME}/etc/hadoopexport HDFS_CONF_DIR=${HADOOP_DEV_HOME}/etc/hadoopexport YARN_CONF_DIR=${HADOOP_DEV_HOME}/etc/hadoop发送到另外两台主机[hadoop@master .ssh]$scp .bashrc slave1:~[hadoop@master .ssh]$scp .bashrc slave2:~3、Hadoop配置有关文件修改hadoop-env.sh和mapred-env.sh文件配置hadoop-env.sh配置mapred-env.sh修改yarn-env.sh和slaves文件~/hadoop2/etc/hadoop/yarn-env.sh配置~/hadoop2/etc/hadoop/slaves修改core-site.xml文件创建hadoop工作目录(临时工作目录,默认是/tmp目录,服务器重启后,文件消失,所以需要另外指定一个目录/hadoop2)修改~/hadoop2/etc/hadoop/core-site.xmlfs_defaultFS是NameNode的IPHadoop.tmp.dir是hadoop的临时目录,刚刚root用户创建的/hadoop2/tmpHadoop.proxyuser.hadoop.hosts中的“.hadoop.”是用户名,我们这里是hadoop,如果使用别的用户,需要用别的用户名,例如:erhadoop.hosts修改hdfs-site.xml文件创建hadoop工作目录(生产环境中的hadoop目录需要指定挂接独立磁盘或独立盘阵的目录。

hadoop安装实验总结

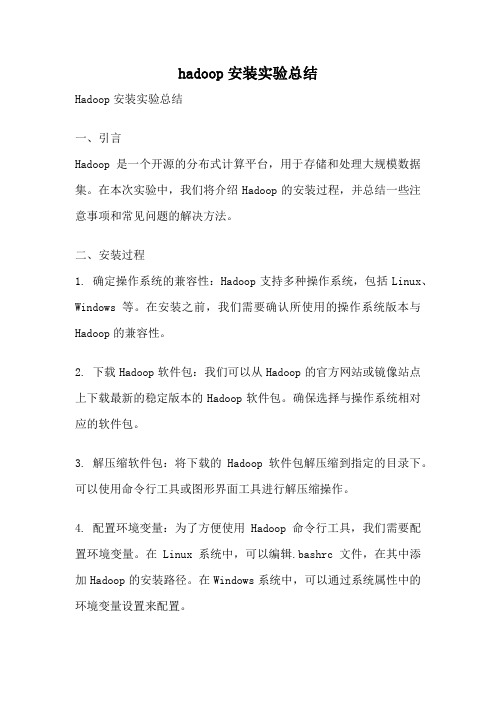

hadoop安装实验总结Hadoop安装实验总结一、引言Hadoop是一个开源的分布式计算平台,用于存储和处理大规模数据集。

在本次实验中,我们将介绍Hadoop的安装过程,并总结一些注意事项和常见问题的解决方法。

二、安装过程1. 确定操作系统的兼容性:Hadoop支持多种操作系统,包括Linux、Windows等。

在安装之前,我们需要确认所使用的操作系统版本与Hadoop的兼容性。

2. 下载Hadoop软件包:我们可以从Hadoop的官方网站或镜像站点上下载最新的稳定版本的Hadoop软件包。

确保选择与操作系统相对应的软件包。

3. 解压缩软件包:将下载的Hadoop软件包解压缩到指定的目录下。

可以使用命令行工具或图形界面工具进行解压缩操作。

4. 配置环境变量:为了方便使用Hadoop命令行工具,我们需要配置环境变量。

在Linux系统中,可以编辑.bashrc文件,在其中添加Hadoop的安装路径。

在Windows系统中,可以通过系统属性中的环境变量设置来配置。

5. 配置Hadoop集群:在Hadoop的安装目录下,找到conf文件夹,并编辑其中的配置文件。

主要包括core-site.xml、hdfs-site.xml 和mapred-site.xml等。

根据实际需求,配置Hadoop的相关参数,如文件系统路径、副本数量、任务调度等。

6. 格式化文件系统:在启动Hadoop之前,需要先格式化文件系统。

使用命令行工具进入Hadoop的安装目录下的bin文件夹,并执行格式化命令:hadoop namenode -format。

7. 启动Hadoop集群:在命令行工具中输入启动命令:start-all.sh(Linux)或start-all.cmd(Windows)。

Hadoop集群将会启动并显示相应的日志信息。

8. 验证Hadoop集群:在启动Hadoop集群后,我们可以通过访问Hadoop的Web界面来验证集群的运行状态。

尚硅谷hadoop安装笔记2019

尚硅⾕hadoop安装笔记2019搭建虚拟机VMWare虚拟⽹络编辑器 NAT模式 IP 192.168.1.0/255.255.255.0VMnet8 IP地址:192.168.1.5/255.255.255.0centos/etc/udev/rules.d/70-persistent-net.rules 修改⽹卡为eth0/etc/sysconfig/network-scripts/ifcfg-eth0ONBOOT=yesBOOTPROTO=staticIPADDR=192.168.1.102GATEWAY=192.168.1.2DNS1=192.168.1.2修改HWADDR⽹卡物理地址/etc/sysconfig/networkHOSTNAME=hadoop102ubuntu18.04sudo vim /etc/netplan/*.yamlnetwork:version: 2renderer: networkdethernets:ens33:dhcp4: noaddresses: [192.168.1.101/24]gateway4: 192.168.1.2nameservers:addresses: [192.168.1.2]sudo netplan apply修改/etc/hosts192.168.1.100 hadoop100192.168.1.101 hadoop101192.168.1.102 hadoop102192.168.1.103 hadoop103192.168.1.104 hadoop104192.168.1.105 hadoop105192.168.1.106 hadoop106192.168.1.107 hadoop107192.168.1.108 hadoop108修改主机名hostname 可以查看到当前主机的主机名uname -u 可以查看到当前主机的主机名hostname 新主机名临时修改主机名(需要重新打开终端)永久修改主机名sudo vim /etc/hostname #修改为hadoop101sudo vim /etc/hosts #修改为 127.0.0.1 hadoop101sudo vim /etc/cloud/cloud.cfg #找到preserve_hostname: false修改为preserve_hostname: truesudo reboot #重启安装jdksudo vim /etc/profileexport JAVA_HOME=/opt/module/jdk8export JRE_HOME=${JAVA_HOME}/jreexport CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/libexport PATH=${JAVA_HOME}/bin:$PATH安装hadoopsudo vim /etc/profile#Hadoop_homeexport HADOOP_HOME=/opt/module/hadoopexport PATH=$PATH:$HADOOP_HOME/binexport PATH=$PATH:$HADOOP_HOME/sbinhadoop页⾯hdfs页⾯历史页⾯secondaryNamenode 时间同步apt install -y ntpvim /etc/ntp.conf crontab -e。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

三、Hadoop Configuration

Each component in Hadoop is configured using an XML file. Core properties go in core-site.xml, HDFS properties go in hdfs-site.xml, and MapReduce properties go in mapred-site.xml. These files are all located in the conf subdirectory.

cd /usr/bin

ln -s -f /usr/java/jdk1.7.0/jre/bin/java

ln -s -f /usr/java/jdk1.7.0/bin/javac

6.注销命令:su,或source /etc/profile使生效

7. 在命令行输入

2.设置环境变量

export JAVA_HOME=/usr/java/jdk1.7.0

export HADOOP_HOME=/root/hadoop/hadoop-0.21.0

export PATH=$PATH:$HADOOP_HOME/bin

将以上三项写入~/.bash_profile中(或者/etc/profile中,source /etc/profile使生效)

To start the HDFS and MapReduce daemons, type:

% start-dfs.sh

% start-mapred.sh

执行# start-all.sh 则开启全部,但是这里遇到一个问题:

namenode running as process 17031. Stop it first.

2. 在当前目录输入

sh jdk-6u17-linux-i586-rpm.bin

(如果下载的是rpm包,则:#chmod 755 jdk-7-linux-x64.rpm =>#rpm -ivh jdk-7-linux-x64.rpm 直接安装至/usr/java/下,jdk1.7.0,不需要下面第三步)

8. 安装JDK1.7完毕.

二、安装Hadoop

1.解压

tar -xzf hadoop-0.21.0.tar.gz 或 tar -zvxf hadoop-0.21.0.tar.gz -C 目标目录

# find / -name hadoop*

/root/hadoop/hadoop-0.21.0

<!-- hdfs-site.xml -->

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

<!-- mapred-site.xml -->

其中会有如下提示:

11/10/09 11:23:35 INFO common.Storage: Storage directory /tmp/hadoop-root/dfs/name has been successfully formatted.

4.启动和关闭守护进程 Starting and stopping the daemons

Hadoop安装和基本功能测试(linux,伪分布式配置)

参考官方文档和网上经验,终于完成hadoop单节点的搭建和测试,等待有集群环境再进一步练手。

一、安装JDK(要求1.6以上版本)

1.下载JDK,成功后上传至服务器任意目录

以下是JDK1.7的官方下载地址:

/technetwork/java/javase/downloads/java-se-jdk-7-download-432154.html

去除SSH登录密码,密码设置为空:

#ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

Generating public/private rsa key pair.

Created directory '/root/.ssh'.

Your identification has been saved in /root/.ssh/id_rsa.

3.看到 安装程序在询问您是否尊守许可协议页面 ,回车,空格都可以,看完协议

出现一行字:Do you aggree to the above license terms? [yes or no]

安装程序在问您是否愿意遵守刚才看过的许可协议。当然要同意了,输入"y" 或 "yes" 回车。

Are you sure you want to continue connecting (yes/no)?

输入yes后,之后就不需要了。

3.格式化HDFS文件系统 Formatting the HDFS filesystem

#hadoop namenode -format

只要之前3个配置文件没配错,这里就没问题。

Your public key has been saved in /root/.ssh/id_rsa.pub.

The key fingerprint is:

1f:3a:89:b4:6f:2f:e1:1e:3e:80:9c:53:7b:5f:ae:93 root@DW

key转存:

#cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

To run Hadoop in a particular mode, you need to do two things: set the appropriate properties, and start the Hadoop daemons.

Key configuration properties for different modes:

设置完后,通过#ssh localhost测试,第一次登录会有如下提示:

The authenticity of host 'localhost (127.0.0.1)' can't be established.

RSA key fingerprint is a2:44:5f:79:00:c9:17:3b:b4:b5:47:cf:66:be:c4:0d.

localhost: Error: JAVA_HOME is not set.

localhost: Error: JAVA_HOME is not set.

jobtracker running as process 17793. Stop it first.

localhost: Error: JAVA_HOME is not set.

Component Property Standalone Pseudo-distributed Fully distributed

-------------------------------------------------------------------------------------------------------------------------------------------------------

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:8021</value>

</property>

</co查看SSH是否安装,可以直接输入SSH命令查看。

(2) Pseudo-distributed Mode: daemons run on the local machine. HDFS + MapReduce daemons

(3) Fully distributed Mode: daemons runs on a cluster of machines. HDFS + MapReduce daemons

/conf/下修改三个配置文件,添加如下属性:

<!-- core-site.xml -->

<configuration>

<property>

<name></name>

<value>hdfs://localhost/</value>

</property>

</configuration>

MapReduce mapred.job.tracker local (default) localhost:8021 jobtracker:8021

Standalone模式不需要配置参数文件。

1.Pseudo-distributed模式参数配置

java -version

屏幕输出:

ava version "1.7.0"

Java(TM) SE Runtime Environment (build 1.7.0-b147)

Java HotSpot(TM) 64-Bit Server VM (build 21.0-b17, mixed mode)