数据挖掘决策树java

数据挖掘面试题

数据挖掘面试题数据挖掘是一门重要的技术领域,其在各个行业中的应用越来越广泛。

作为一名数据挖掘工程师,掌握面试题目相关的知识和技能非常重要。

本文将介绍一些常见的数据挖掘面试题,以帮助读者更好地应对数据挖掘的面试。

一、什么是数据挖掘?数据挖掘是一种通过发现数据中的模式和规律,从而提取有价值的信息和知识的过程。

它涉及到多个领域,包括统计学、机器学习、数据库和人工智能等。

数据挖掘的目标是揭示隐藏在数据背后的信息,帮助企业做出更明智的决策,提高效率和竞争力。

二、数据挖掘的主要任务有哪些?1. 分类(Classification):根据已有的标签或类别将数据实例划分到不同的类别中。

2. 回归(Regression):预测连续变量的值,例如根据历史销售数据预测未来销售额。

3. 聚类(Clustering):将数据分为不同的群组,使得同一组内的数据具有较高的相似性,不同组之间的数据具有较大的差异性。

4. 关联规则挖掘(Association Rule Mining):发现数据集中的频繁项集和关联规则,例如购物篮分析中的商品关联。

5. 异常检测(Anomaly Detection):识别与其他数据实例显著不同的异常值。

三、数据挖掘中常见的算法有哪些?1. 决策树(Decision Tree):通过构建树形结构来进行分类和预测。

2. 支持向量机(Support Vector Machine):将数据映射到高维空间,找到能够将不同类别分开的超平面。

3. 朴素贝叶斯(Naive Bayes):基于贝叶斯定理和特征条件独立性假设,进行分类。

4. 随机森林(Random Forest):使用多个决策树进行分类或回归,并综合它们的结果。

5. 神经网络(Neural Network):通过模拟人脑神经元的连接方式,学习输入和输出之间的模式。

四、数据挖掘的评估指标有哪些?在进行数据挖掘任务时,评估模型的性能至关重要。

常见的评估指标包括:1. 准确率(Accuracy):分类任务中正确预测的样本比例。

数据挖掘-决策树PPT资料48页

0.247位 选择获得最大信息增益 的属性进行划分

划分过程的终止

当所有叶节点都是纯的。

因训练集包含两个具有相同属性集,但具有不同类 的实例。

ID3代表归纳决策树(induction decision—tree)版本 3,它是一种用来由数据构造决策树的递归过程。

lD3算法的步骤

1. 试探性地选择一个属性放置在根节点,并对该属 性的每个值产生一个分支。

2. 分裂根节点上的数据集,并移到子女节点,产生 一棵局部树(partial tree)。

决策树作用(2)

决策树的主要作用是揭示数据中的结构化信息。 决策树汇总了数据,并揭示了其中隐藏的结构:

规则:

如果血压高,则 采用药物A。

如果血压低,则 采用药物B。

如果血压正常。 年龄小于或等于 40,则采用药物 A,否则采用药 物B。

准确率、支持度、错误率

该例得到的规则和对应的准确率和支持度是:

如果血压高,则采用药物A(准确率100%,支持度 3/12)。

如果血压低,则采用药物B(准确率100%,支持度 3/12)。

如果血压正常并且年龄小于或等于40,则采用药 物A(准确率100%,支持度3/12)。

如果血压正常并且年龄大于40。则采用药物B(准 确率100%,支持度3/12)。

3. 对该划分的质量进行评估。 4. 对其他属性重复该过程。 5. 每个用于划分的属性产生一棵局部树。 6. 根据局部树的质量,选择一棵局部树。 7. 对选定的局部树的每个子女节点重复以上1-6步。 8. 这是一个递归过程。如果一个节点上的所有实例

Java中的机器学习算法实现

Java中的机器学习算法实现机器学习是一种通过让计算机系统从数据中获取知识和经验,并利用这些知识和经验进行学习和决策的方法。

而Java作为一种强大的编程语言,在机器学习领域也拥有广泛的应用。

本文将介绍Java中常用的机器学习算法实现及其应用。

一、线性回归算法线性回归是一种应用广泛的机器学习算法,用于预测一个或多个自变量与因变量之间的线性关系。

在Java中,我们可以使用Apache Commons Math库中的线性回归类来实现线性回归算法。

下面是一个简单的线性回归示例代码:```javaimport mons.math3.stat.regression.SimpleRegression;public class LinearRegressionExample {public static void main(String[] args) {// 创建线性回归对象SimpleRegression regression = new SimpleRegression();// 添加数据点regression.addData(1, 2);regression.addData(2, 3);regression.addData(3, 4);// 输出回归方程System.out.println("Intercept: " + regression.getIntercept());System.out.println("Slope: " + regression.getSlope());// 预测新的数据点double x = 4;double y = regression.predict(x);System.out.println("Predicted y: " + y);}}```二、决策树算法决策树是一种基于树结构的机器学习算法,可以用于分类和回归任务。

浅谈数据挖掘中的决策树算法

() 算 信 息增 益 时偏 向于 选择 取 值 较 多 的属 性 , 2计 这样 不太

F n t nC . re(T ) u c o 45 e i T

, 假 设 T代 表 当 前 样 本 集 , 当 前 测 试 属 性 集 用 T a , - t _

t b tl t 示 r uei 表 i s

Be i gn

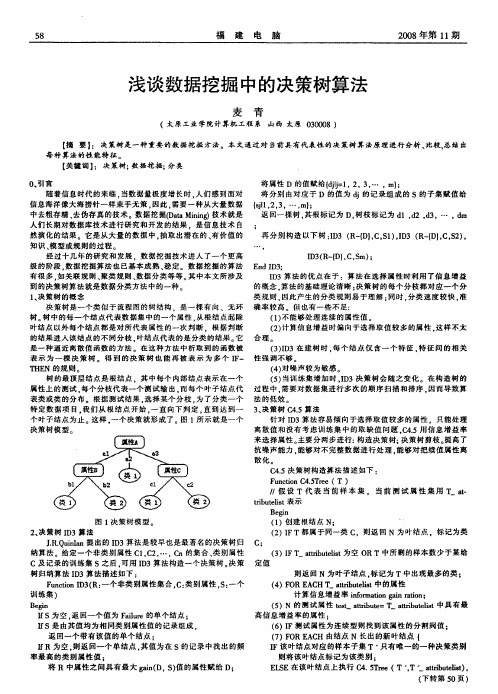

图 1决策 树 模 型 。 2 决 策树 I 3算 法 、 D

福

建

电

脑

20 0 8年第 1 期 1

浅谈数据挖掘 中的决策树算 法

麦 青

(太 原 工 业 学 院计 算 机 工 程 系 山 西 太原 0 0 0 30 8)

【 要 】 决策树是一种重要 的数据挖掘方法。本文 通过 对 当前具有代表性的决策树算 法原理进行分析 、 摘 : 比较, 总结出 每 种 算 法 的性 能特 征 。 【 关键词 】 决策树; : 数据挖掘; 分类

经 过 十几 年 的研 究 和 发 展 .数 据 挖 掘 技 术 进 人 了一 个 更 高 I 3 R (}C,m) D (- , S ; D 级 的 阶段 。 据挖 掘 算 法 也 已基 本 成 熟 、 数 稳定 。数 据挖 掘 的算 法 En D3; dI 有很 多 , 如关 联 规 则 、 聚类 规 则 、 据 分 类 等 等 。 中 本 文所 涉 及 数 其 I 3算 法 的 优 点 在 于 :算 法 在 选 择 属 性 时利 用 了信 息 增 益 D

Java机器学习使用机器学习库进行数据分析和预测

Java机器学习使用机器学习库进行数据分析和预测机器学习在各个领域中都有着广泛的应用,它可以通过分析大量的数据,从中获得有价值的信息,并对未来进行预测。

而Java 作为一种广泛应用于企业级应用开发的编程语言,也有着强大的机器学习库供开发者使用。

本文将介绍如何使用Java机器学习库进行数据分析和预测。

一、准备工作在开始之前,我们需要准备一些基本的工作。

首先,我们需要安装Java和相应的开发环境。

其次,我们需要选择一个合适的机器学习库。

目前,在Java中有许多成熟的机器学习库可供选择,例如Weka、Deeplearning4j等。

根据实际需求和个人偏好,选择一个合适的库进行学习和实践。

二、数据分析在进行机器学习之前,我们首先需要进行数据分析。

数据分析包括数据的清洗、处理和可视化等步骤。

通过这些步骤,我们可以对原始数据有一个更好的了解,并对数据进行预处理,为后续的机器学习算法做好准备。

1. 数据清洗数据清洗是指对原始数据进行去重、去噪、缺失值处理等操作,以保证数据的准确性和完整性。

对于较小的数据集,我们可以手动进行数据清洗;而对于较大的数据集,我们可以使用Java机器学习库提供的函数进行自动化的数据清洗。

2. 数据处理数据处理包括数据的转换、归一化、特征选择等操作。

通过这些操作,我们可以将原始数据转化为适合机器学习算法处理的格式。

例如,将离散型变量转化为连续型变量,对数据进行标准化等。

3. 数据可视化数据可视化是通过图表、图像等形式将数据展示出来,以便更直观地观察和理解数据的特征和规律。

通过数据可视化,我们可以发现数据的分布情况、异常值等信息。

三、机器学习模型选择在数据分析之后,我们需要选择合适的机器学习模型进行数据预测。

机器学习模型包括监督学习、无监督学习和强化学习等。

在实际应用中,我们需要根据具体的问题和数据特点选择合适的模型。

1. 监督学习监督学习是指通过已有的输入和输出数据,建立一个模型,用于对未知数据进行预测或分类。

数据挖掘领域的十大经典算法原理及应用

数据挖掘领域的十大经典算法原理及应用数据挖掘是指从大量的数据中发现关联规则、分类模型、聚类模型等有用的信息的过程。

以下是数据挖掘领域的十大经典算法原理及应用:1. 决策树算法(Decision Tree)决策树是一种基于树形结构的分类模型,它通过构建树来将输入数据集划分为不同的类别。

决策树算法在金融风险评估、医疗诊断等领域有广泛应用。

2. 支持向量机算法(Support Vector Machine,SVM)支持向量机是一种二分类模型,其目标是在高维空间中找到一个最优的超平面,将不同类别的样本分离开来。

SVM在图像识别、文本分类等领域有广泛应用。

3. 神经网络算法(Neural Network)神经网络模拟人脑的工作原理,通过连接众多的神经元来完成学习和预测任务。

神经网络在图像处理、自然语言处理等领域有广泛应用。

4. 朴素贝叶斯算法(Naive Bayes)朴素贝叶斯算法是一种基于贝叶斯定理的统计分类方法,它假设所有特征之间相互独立,并通过计算后验概率来进行分类。

朴素贝叶斯在垃圾邮件过滤、文本分类等领域有广泛应用。

5. K均值聚类算法(K-means Clustering)K均值聚类是一种无监督学习算法,它通过将样本分成K个簇来实现数据的聚类。

K均值聚类在市场细分、客户群体分析等领域有广泛应用。

6. Apriori算法Apriori算法是一种频繁项集挖掘算法,它可以找出数据集中项之间的关联关系。

Apriori算法在购物篮分析、推荐系统等领域有广泛应用。

7. PageRank算法PageRank算法是一种用于网页排序的算法,它通过计算网页之间的链接关系来确定网页的重要性。

PageRank算法在引擎领域有广泛应用。

8. 随机森林算法(Random Forest)随机森林是一种集成学习算法,它通过构建多个决策树,并通过投票方式来进行分类或回归。

随机森林在金融风险评估、信用评分等领域有广泛应用。

9. AdaBoost算法AdaBoost是一种迭代的强学习算法,它通过调整样本权重来训练多个弱分类器,并通过加权投票方式来进行分类。

《数据挖掘实验》---K-means聚类及决策树算法实现预测分析实验报告

实验设计过程及分析:1、通过通信企业数据(USER_INFO_M.csv),使用K-means算法实现运营商客户价值分析,并制定相应的营销策略。

(预处理,构建5个特征后确定K 值,构建模型并评价)代码:setwd("D:\\Mi\\数据挖掘\\")datafile<-read.csv("USER_INFO_M.csv")zscoredFile<- na.omit(datafile)set.seed(123) # 设置随机种子result <- kmeans(zscoredFile[,c(9,10,14,19,20)], 4) # 建立模型,找聚类中心为4round(result$centers, 3) # 查看聚类中心table(result$cluster) # 统计不同类别样本的数目# 画出分析雷达图par(cex=0.8)library(fmsb)max <- apply(result$centers, 2, max)min <- apply(result$centers, 2, min)df <- data.frame(rbind(max, min, result$centers))radarchart(df = df, seg =5, plty = c(1:4), vlcex = 1, plwd = 2)# 给雷达图加图例L <- 1for(i in 1:4){legend(1.3, L, legend = paste("VIP_LVL", i), lty = i, lwd = 3, col = i, bty = "n")L <- L - 0.2}运行结果:2、根据企业在2016.01-2016.03客户的短信、流量、通话、消费的使用情况及客户基本信息的数据,构建决策树模型,实现对流失客户的预测,F1值。

决策树算法 java

决策树算法 java

决策树算法是一种常用的机器学习算法,它在数据挖掘和分类任务中广泛应用。

在Java中,决策树算法可以通过不同的库或者框架来实现,比如Weka、Apache Spark MLlib、和J48等。

以下是对决策树算法在Java中的实现的多个角度的回答:

1. 库和框架,在Java中,我们可以使用Weka来实现决策树算法。

Weka是一个流行的机器学习库,它提供了丰富的分类、回归和聚类算法,包括决策树算法。

此外,Apache Spark MLlib也提供了决策树算法的Java API,可以用于大规模数据集的处理。

另外,如果你想直接实现决策树算法,你也可以使用Java语言编写自己的决策树算法,这样可以更好地理解算法的原理和实现细节。

2. 特性和优势,决策树算法在Java中的实现具有很多优势。

首先,Java是一种跨平台的编程语言,这意味着你可以在不同的操作系统上运行你的决策树算法。

其次,Java具有良好的面向对象特性,可以帮助你更好地组织和管理你的代码。

此外,Java的丰富的库和框架可以帮助你快速实现和部署决策树算法。

3. 实际应用,决策树算法在Java中的实现可以应用于各种领

域,比如金融、医疗、电子商务等。

比如,在金融领域,可以使用

决策树算法来预测客户的信用评分;在医疗领域,可以使用决策树

算法来辅助医生诊断疾病。

另外,决策树算法也可以用于推荐系统、风险管理等方面。

总之,决策树算法在Java中的实现具有广泛的应用前景和丰富

的实现方式,可以帮助我们解决各种分类和预测问题。

希望这些信

息对你有所帮助。

决策树名词解释

决策树名词解释决策树(DecisionTree)是一种常见的数据挖掘技术,也称为决策树分类(Decision Tree Classification)。

决策树是一种以树状结构表示数据的模型,它可以用来描述一组数据集的概念,它可以用来作出决策。

策树是一种数据挖掘的常用算法,它可以用于分类、回归任务,以及关联规则建模,它可以帮助智能系统理解数据,从而实现更好的决策。

决策树的基本原理很简单,它是一种将每个属性值与实例的关联转换成树形结构的方法。

在这种树形结构中,每个节点存储关联属性的值,从而决定一个决策。

策树通常用于研究一组已知数据,它可以用来预测未知数据的结果,也可以用来归类数据,从而发现数据的规律性。

决策树的建立有很多步骤,但是大致可以分为以下几个步骤:(1)数据集准备:首先,需要对数据集进行预处理,将数据分成训练集和测试集。

(2)决策树划分:根据训练集中的特征属性,将数据集划分为不同的分支,并且不断划分,直到达到决策树模型所需要的精度或停止条件为止。

(3)估属性:根据训练集中的数据,选择最优的划分属性,用于对训练集进行划分。

(4)决策树剪枝:新建的决策树可能过度拟合训练数据,这会使训练出来的决策树在测试数据上的表现变差,因此,需要使用剪枝算法,来减少决策树的过拟合现象。

(5)测试:根据训练好的决策树,对测试集数据进行分类,统计测试集分类正确率,从而对决策树进行评估。

决策树在实际应用中可以用于社会决策分析、企业决策分析、关联规则挖掘等应用场景,但是决策树也有若干缺点。

其一,决策树生成过程中属性之间的关系可能非线性,而决策树假设属性之间的关系是线性的,因此可能导致决策树模型的准确性不足。

其二,决策树的剪枝操作可能会过度剪枝,也影响模型的准确性。

总之,决策树是一种常用的数据挖掘技术,它可以用于推理和预测数据,它可以用来帮助智能系统理解数据,从而改善决策效率。

但是,因为决策树的局限性,仍然需要其他的数据挖掘技术来提高决策的准确性。

决策树分析在数据挖掘中的作用

决策树分析在数据挖掘中的作用数据挖掘是一种从大量数据中提取有用信息的过程,它可以帮助企业和组织做出更明智的决策。

在数据挖掘的过程中,决策树分析是一种常用的方法,它可以帮助我们理解数据之间的关系,并根据这些关系做出预测和决策。

本文将探讨决策树分析在数据挖掘中的作用。

一、决策树分析的基本原理决策树是一种用于分类和预测的机器学习算法。

它通过将数据集划分为不同的子集,每个子集对应于一个决策节点,最终形成一个树状结构。

决策树的每个节点都代表一个属性或特征,每个分支代表一个可能的取值,而每个叶节点代表一个类别或结果。

决策树的构建过程可以分为两个步骤:特征选择和树的构建。

特征选择是指从所有可用的特征中选择一个最佳的特征作为当前节点的划分标准。

树的构建是指根据选择的特征将数据集划分为不同的子集,并递归地构建子树,直到满足停止条件为止。

二、决策树分析在数据挖掘中的应用1.分类问题决策树分析在分类问题中有着广泛的应用。

通过对已知类别的数据进行训练,决策树可以学习到不同属性之间的关系,并根据这些关系对未知数据进行分类。

例如,在医疗领域,决策树可以根据患者的症状和疾病的特征,预测患者是否患有某种疾病。

2.预测问题决策树分析还可以用于预测问题。

通过对已知数据进行训练,决策树可以学习到不同属性之间的关系,并根据这些关系对未知数据进行预测。

例如,在销售领域,决策树可以根据客户的购买历史和个人特征,预测客户是否会购买某种产品。

3.特征选择决策树分析可以帮助我们选择最重要的特征。

在数据挖掘中,有时候我们面对的数据集非常庞大,包含大量的特征。

通过决策树分析,我们可以确定哪些特征对于分类或预测问题最为重要,从而减少特征的数量,提高模型的效率。

4.解释模型决策树分析可以帮助我们理解数据之间的关系。

通过观察决策树的结构和节点的划分规则,我们可以了解不同特征之间的重要性和关联性。

这有助于我们深入理解数据,并根据这些理解做出更准确的决策。

三、决策树分析的优缺点决策树分析作为一种常用的数据挖掘方法,具有以下优点:1.易于理解和解释:决策树的结构和节点的划分规则非常直观,易于理解和解释。

数据挖掘 算法面试题

数据挖掘算法面试题一、介绍数据挖掘是一种从大规模数据集中提取出有用模式和信息的技术。

在当今信息爆炸的时代,数据挖掘技术的应用越来越广泛。

在数据科学领域,算法面试题是评估一个数据挖掘工程师技能水平的重要环节。

本篇文章将介绍一些常见的数据挖掘算法面试题,并分享解答思路和算法实现。

二、分类算法面试题1. 决策树决策树是一种常用的分类算法。

面试中,可能会遇到以下问题:面试题1:请解释决策树算法的基本原理。

面试题2:如何选择最佳的划分特征?面试题3:如何处理连续型特征?面试题4:如何处理缺失值?2. 朴素贝叶斯朴素贝叶斯是一种基于贝叶斯定理的简单概率分类器。

面试中,可能会遇到以下问题:面试题1:请解释朴素贝叶斯算法的基本原理。

面试题2:朴素贝叶斯算法的假设是什么?面试题3:如何处理连续型特征?面试题4:如何处理缺失值?3. 支持向量机支持向量机是一种二分类模型,通过构建最优超平面实现分类。

面试中,可能会遇到以下问题:面试题1:请解释支持向量机算法的基本原理。

面试题2:如何处理多类分类问题?面试题3:支持向量机算法是否适用于处理大规模数据集?面试题4:如何处理缺失值?三、聚类算法面试题1. K均值聚类K均值聚类是一种常用的聚类算法。

面试中,可能会遇到以下问题:面试题1:请解释K均值聚类算法的基本原理。

面试题2:如何选择最佳的簇数K?面试题3:K均值聚类算法是否对初始聚类中心敏感?面试题4:如何处理缺失值?2. 层次聚类层次聚类是一种自底向上(或自顶向下)的聚类算法。

面试中,可能会遇到以下问题:面试题1:请解释层次聚类算法的基本原理。

面试题2:如何选择合适的聚类簇数?面试题3:层次聚类算法的时间复杂度如何?面试题4:如何处理缺失值?四、关联规则挖掘面试题1. 频繁项集挖掘频繁项集挖掘是一种用于发现数据集中频繁出现的物品组合的方法。

面试中,可能会遇到以下问题:面试题1:请解释频繁项集挖掘算法的基本原理。

面试题2:如何选择最佳的最小支持度阈值?面试题3:频繁项集挖掘算法的时间复杂度如何?面试题4:如何处理缺失值?2. 关联规则挖掘关联规则挖掘是基于频繁项集的结果,发现物品间的关联关系。

大数据技术与数据挖掘测试 选择题 61题

1题1. 大数据的“4V”特性不包括以下哪一项?A. VolumeB. VelocityC. VarietyD. Visibility2. 在数据挖掘中,以下哪种技术主要用于分类任务?A. 聚类分析B. 关联规则学习C. 决策树D. 主成分分析3. Hadoop生态系统中的哪个组件用于数据存储?A. HiveB. HBaseC. PigD. Sqoop4. 以下哪个不是大数据处理框架?A. Apache SparkB. Apache FlinkC. Apache KafkaD. Apache Tomcat5. 数据仓库的主要目的是什么?A. 实时数据处理B. 数据分析和报告C. 数据备份D. 数据加密6. 在数据挖掘中,Apriori算法主要用于哪种任务?A. 分类B. 聚类C. 关联规则挖掘D. 异常检测7. 以下哪个工具不是用于大数据分析的?A. TableauB. SASC. ExcelD. R8. 数据预处理中的“数据清洗”主要目的是什么?A. 增加数据量B. 减少数据量C. 提高数据质量D. 数据加密9. 在Hadoop中,MapReduce的主要作用是什么?A. 数据存储B. 数据分析C. 数据传输D. 数据备份10. 以下哪个不是NoSQL数据库?A. MongoDBB. CassandraC. RedisD. Oracle11. 数据挖掘中的“监督学习”与“无监督学习”的主要区别是什么?A. 是否有标签B. 数据量大小C. 数据类型D. 数据来源12. 在数据挖掘中,K-means算法属于哪种类型?A. 分类B. 聚类C. 回归D. 关联规则13. 以下哪个是大数据分析的典型应用场景?A. 在线购物推荐B. 文字处理C. 图形设计D. 音乐播放14. 数据挖掘中的“特征选择”主要目的是什么?A. 增加特征数量B. 减少特征数量C. 增加数据量D. 减少数据量15. 在数据仓库中,ETL过程不包括以下哪一步?A. 抽取B. 转换C. 加载D. 分析16. 以下哪个不是数据挖掘的步骤?A. 数据收集B. 数据预处理C. 数据分析D. 数据存储17. 在数据挖掘中,“交叉验证”主要用于什么?A. 数据清洗B. 模型评估C. 数据加载D. 数据转换18. 以下哪个是大数据处理中的实时处理框架?A. Apache HadoopB. Apache SparkC. Apache HiveD. Apache HBase19. 数据挖掘中的“异常检测”主要用于什么?A. 发现数据中的异常值B. 数据分类C. 数据聚类D. 数据关联20. 在数据挖掘中,“回归分析”主要用于什么?A. 分类B. 聚类C. 预测数值D. 关联规则21. 以下哪个不是大数据存储解决方案?A. Amazon S3B. Google Cloud StorageC. Microsoft Azure Blob StorageD. Dropbox22. 数据挖掘中的“文本挖掘”主要用于什么?A. 处理结构化数据B. 处理非结构化数据C. 数据加密D. 数据备份23. 在数据挖掘中,“神经网络”属于哪种类型?A. 监督学习B. 无监督学习C. 半监督学习D. 强化学习24. 以下哪个是大数据分析中的可视化工具?A. Power BIB. MySQLC. JavaD. C++25. 数据挖掘中的“时间序列分析”主要用于什么?A. 分类B. 聚类C. 预测时间序列数据D. 关联规则26. 在数据挖掘中,“决策树”属于哪种类型?A. 分类B. 聚类C. 回归D. 关联规则27. 以下哪个不是大数据分析的挑战?A. 数据质量B. 数据安全C. 数据量小D. 数据处理速度28. 数据挖掘中的“关联规则”主要用于什么?A. 分类B. 聚类C. 发现数据间的关联关系D. 数据加密29. 在数据挖掘中,“贝叶斯网络”属于哪种类型?A. 监督学习B. 无监督学习C. 半监督学习D. 强化学习30. 以下哪个是大数据分析中的机器学习框架?A. TensorFlowB. DockerC. KubernetesD. Jenkins31. 数据挖掘中的“聚类分析”主要用于什么?A. 分类B. 发现数据中的模式C. 回归D. 关联规则32. 在数据挖掘中,“支持向量机”属于哪种类型?A. 分类B. 聚类C. 回归D. 关联规则33. 以下哪个不是大数据分析的数据源?A. 社交媒体B. 传感器数据C. 传统数据库D. 书籍34. 数据挖掘中的“主成分分析”主要用于什么?A. 分类B. 聚类C. 数据降维D. 关联规则35. 在数据挖掘中,“随机森林”属于哪种类型?A. 分类B. 聚类C. 回归D. 关联规则36. 以下哪个是大数据分析中的数据集成工具?A. TalendB. HadoopC. SparkD. Kafka37. 数据挖掘中的“序列模式挖掘”主要用于什么?A. 分类B. 聚类C. 发现序列数据中的模式D. 关联规则38. 在数据挖掘中,“朴素贝叶斯”属于哪种类型?A. 分类B. 聚类C. 回归D. 关联规则39. 以下哪个是大数据分析中的数据清洗工具?A. OpenRefineB. HadoopC. SparkD. Kafka40. 数据挖掘中的“关联规则挖掘”主要用于什么?A. 分类B. 聚类C. 发现数据间的关联关系D. 数据加密41. 在数据挖掘中,“逻辑回归”属于哪种类型?A. 分类B. 聚类C. 回归D. 关联规则42. 以下哪个不是大数据分析的数据处理技术?A. 数据清洗B. 数据转换C. 数据加密D. 数据加载43. 数据挖掘中的“深度学习”主要用于什么?A. 分类B. 聚类C. 处理复杂数据D. 关联规则44. 在数据挖掘中,“K NN算法”属于哪种类型?A. 分类B. 聚类C. 回归D. 关联规则45. 以下哪个是大数据分析中的数据可视化平台?A. D3.jsB. HadoopC. SparkD. Kafka46. 数据挖掘中的“时间序列预测”主要用于什么?A. 分类B. 聚类C. 预测未来数据D. 关联规则47. 在数据挖掘中,“集成学习”属于哪种类型?A. 分类B. 聚类C. 回归D. 关联规则48. 以下哪个是大数据分析中的数据存储技术?A. HDFSB. HadoopC. SparkD. Kafka49. 数据挖掘中的“异常检测”主要用于什么?A. 分类B. 聚类C. 发现异常数据D. 关联规则50. 在数据挖掘中,“关联规则学习”主要用于什么?A. 分类B. 聚类C. 发现数据间的关联关系D. 数据加密51. 以下哪个是大数据分析中的数据处理框架?A. Apache BeamB. HadoopC. SparkD. Kafka52. 数据挖掘中的“文本分类”主要用于什么?A. 分类B. 聚类C. 处理文本数据D. 关联规则53. 在数据挖掘中,“神经网络”主要用于什么?A. 分类B. 聚类C. 处理复杂数据D. 关联规则54. 以下哪个是大数据分析中的数据集成平台?A. InformaticaB. HadoopC. SparkD. Kafka55. 数据挖掘中的“序列模式挖掘”主要用于什么?A. 分类B. 聚类C. 发现序列数据中的模式D. 关联规则56. 在数据挖掘中,“朴素贝叶斯”主要用于什么?A. 分类B. 聚类C. 处理文本数据D. 关联规则57. 以下哪个是大数据分析中的数据清洗平台?A. TrifactaB. HadoopC. SparkD. Kafka58. 数据挖掘中的“关联规则挖掘”主要用于什么?A. 分类B. 聚类C. 发现数据间的关联关系D. 数据加密59. 在数据挖掘中,“逻辑回归”主要用于什么?A. 分类B. 聚类C. 回归D. 关联规则60. 以下哪个不是大数据分析的数据处理技术?A. 数据清洗B. 数据转换C. 数据加密D. 数据加载61. 数据挖掘中的“深度学习”主要用于什么?A. 分类B. 聚类C. 处理复杂数据D. 关联规则答案1. D2. C3. B4. D5. B6. C7. C8. C9. B10. D11. A12. B13. A14. B15. D16. D17. B18. B19. A20. C21. D22. B23. A24. A25. C26. A27. C28. C29. A30. A31. B32. A33. D34. C35. A36. A37. C38. A39. A40. C41. A42. C43. C44. A45. A46. C47. A48. A49. C50. C51. A52. A53. C54. A55. C56. A57. A58. C59. A60. C61. C。

数据分析与挖掘考试 选择题 58题

1. 在数据分析中,什么是描述性统计的主要目标?A. 预测未来数据B. 描述数据的基本特征C. 发现数据之间的关系D. 优化数据模型2. 下列哪个不是数据挖掘的常见任务?A. 分类B. 回归C. 聚类D. 编辑3. 在数据预处理中,处理缺失值的常用方法不包括:A. 删除含有缺失值的记录B. 用平均值填充C. 用中位数填充D. 用随机值填充4. 下列哪个算法属于监督学习?A. K-均值聚类B. 决策树C. 关联规则挖掘D. 主成分分析5. 数据仓库的主要特征是:A. 面向主题B. 面向应用C. 面向数据D. 面向算法6. 在数据挖掘中,ROC曲线用于评估:A. 模型的准确性B. 模型的稳定性C. 模型的泛化能力D. 模型的分类性能7. 下列哪个不是大数据的“4V”特征之一?A. 体积B. 速度C. 多样性D. 价值8. 在数据分析中,什么是异常值?A. 数据中的常见值B. 数据中的极端值C. 数据中的平均值D. 数据中的中位数9. 下列哪个工具常用于大数据处理?A. ExcelB. HadoopC. SPSSD. SAS10. 在数据挖掘中,什么是关联规则?A. 数据之间的关系B. 数据的分类C. 数据的聚类D. 数据的回归11. 下列哪个不是数据可视化的主要目的?A. 提高数据的可理解性B. 增强数据的吸引力C. 隐藏数据的真实性D. 辅助决策12. 在数据分析中,什么是P值?A. 数据的可能性B. 数据的概率C. 数据的显著性水平D. 数据的预测值13. 下列哪个不是数据清洗的步骤?A. 数据转换B. 数据集成C. 数据删除D. 数据规范化14. 在数据挖掘中,什么是K-均值聚类?A. 一种分类算法B. 一种回归算法C. 一种聚类算法D. 一种关联规则算法15. 下列哪个不是数据仓库的组成部分?A. 数据集市B. 数据湖C. 数据立方体D. 数据模型16. 在数据分析中,什么是交叉验证?A. 一种数据集成方法B. 一种模型评估方法C. 一种数据清洗方法D. 一种数据转换方法17. 下列哪个不是数据挖掘的应用领域?A. 金融B. 医疗C. 教育D. 娱乐18. 在数据分析中,什么是主成分分析?A. 一种分类方法B. 一种降维方法C. 一种聚类方法D. 一种回归方法19. 下列哪个不是数据预处理的步骤?A. 数据清洗B. 数据集成C. 数据转换D. 数据分析20. 在数据挖掘中,什么是决策树?A. 一种分类算法B. 一种聚类算法C. 一种回归算法D. 一种关联规则算法21. 下列哪个不是数据可视化的工具?A. TableauB. Power BIC. ExcelD. Photoshop22. 在数据分析中,什么是回归分析?A. 一种分类方法B. 一种聚类方法C. 一种预测方法D. 一种关联规则方法23. 下列哪个不是大数据处理的挑战?A. 数据存储B. 数据处理C. 数据分析D. 数据保密24. 在数据挖掘中,什么是Apriori算法?A. 一种分类算法B. 一种聚类算法C. 一种关联规则算法D. 一种回归算法25. 下列哪个不是数据仓库的设计原则?A. 面向主题B. 集成性C. 时变性D. 实时性26. 在数据分析中,什么是数据集市?A. 一种数据存储方式B. 一种数据处理方式C. 一种数据分析方式D. 一种数据可视化方式27. 下列哪个不是数据挖掘的步骤?A. 数据收集B. 数据预处理C. 数据分析D. 数据存储28. 在数据挖掘中,什么是神经网络?A. 一种分类算法B. 一种聚类算法C. 一种回归算法D. 一种模拟人脑的算法29. 下列哪个不是数据可视化的类型?A. 静态图表B. 动态图表C. 交互式图表D. 随机图表30. 在数据分析中,什么是数据集成?A. 将数据合并在一起B. 将数据分开C. 将数据删除D. 将数据转换31. 下列哪个不是数据挖掘的应用?A. 市场篮分析B. 客户细分C. 风险管理D. 数据备份32. 在数据分析中,什么是数据规范化?A. 将数据转换为标准格式B. 将数据删除C. 将数据合并D. 将数据分开33. 下列哪个不是数据仓库的优点?A. 提高数据质量B. 提高数据访问速度C. 提高数据安全性D. 提高数据随机性34. 在数据挖掘中,什么是支持向量机?A. 一种分类算法B. 一种聚类算法C. 一种回归算法D. 一种关联规则算法35. 下列哪个不是数据可视化的优势?A. 提高数据的可理解性B. 增强数据的吸引力C. 隐藏数据的真实性D. 辅助决策36. 在数据分析中,什么是数据湖?A. 一种数据存储方式B. 一种数据处理方式C. 一种数据分析方式D. 一种数据可视化方式37. 下列哪个不是数据挖掘的工具?A. RB. PythonC. JavaD. SQL38. 在数据分析中,什么是数据立方体?A. 一种数据存储方式B. 一种数据处理方式C. 一种数据分析方式D. 一种数据可视化方式39. 下列哪个不是数据预处理的目标?A. 提高数据质量B. 提高数据访问速度C. 提高数据安全性D. 提高数据随机性40. 在数据挖掘中,什么是朴素贝叶斯分类器?A. 一种分类算法B. 一种聚类算法C. 一种回归算法D. 一种关联规则算法41. 下列哪个不是数据可视化的步骤?A. 数据收集B. 数据预处理C. 数据分析D. 数据存储42. 在数据分析中,什么是数据转换?A. 将数据转换为标准格式B. 将数据删除C. 将数据合并D. 将数据分开43. 下列哪个不是数据挖掘的挑战?A. 数据存储B. 数据处理C. 数据分析D. 数据保密44. 在数据挖掘中,什么是随机森林?A. 一种分类算法B. 一种聚类算法C. 一种回归算法D. 一种关联规则算法45. 下列哪个不是数据仓库的组成部分?A. 数据集市B. 数据湖C. 数据立方体D. 数据模型46. 在数据分析中,什么是数据清洗?A. 将数据转换为标准格式B. 将数据删除C. 将数据合并D. 将数据分开47. 下列哪个不是数据挖掘的应用领域?A. 金融B. 医疗C. 教育D. 娱乐48. 在数据分析中,什么是数据集成?A. 将数据合并在一起B. 将数据分开C. 将数据删除D. 将数据转换49. 下列哪个不是数据可视化的工具?A. TableauB. Power BIC. ExcelD. Photoshop50. 在数据分析中,什么是数据湖?A. 一种数据存储方式B. 一种数据处理方式C. 一种数据分析方式D. 一种数据可视化方式51. 下列哪个不是数据挖掘的工具?A. RB. PythonC. JavaD. SQL52. 在数据分析中,什么是数据立方体?A. 一种数据存储方式B. 一种数据处理方式C. 一种数据分析方式D. 一种数据可视化方式53. 下列哪个不是数据预处理的目标?A. 提高数据质量B. 提高数据访问速度C. 提高数据安全性D. 提高数据随机性54. 在数据挖掘中,什么是朴素贝叶斯分类器?A. 一种分类算法B. 一种聚类算法C. 一种回归算法D. 一种关联规则算法55. 下列哪个不是数据可视化的步骤?A. 数据收集B. 数据预处理C. 数据分析D. 数据存储56. 在数据分析中,什么是数据转换?A. 将数据转换为标准格式B. 将数据删除C. 将数据合并D. 将数据分开57. 下列哪个不是数据挖掘的挑战?A. 数据存储B. 数据处理C. 数据分析D. 数据保密58. 在数据挖掘中,什么是随机森林?A. 一种分类算法B. 一种聚类算法C. 一种回归算法D. 一种关联规则算法答案1. B2. D3. D4. B5. A6. D7. D8. B9. B10. A11. C12. C13. C14. C15. B16. B17. D18. B19. D20. A21. D22. C23. D24. C25. D26. A27. D28. D29. D30. A31. D32. A33. D34. A35. C36. A37. C38. A39. D40. A41. D42. A43. D44. A45. B46. A47. D48. A49. D50. A51. C52. A53. D54. A55. D56. A57. D58. A。

数据挖掘主要工具软件简介

数据挖掘主要工具软件简介Dataminning指一种透过数理模式来分析企业内储存的大量资料,以找出不同的客户或市场划分,分析出消费者喜好和行为的方法。

前面介绍了报表软件选购指南,本篇介绍数据挖掘常用工具。

市场上的数据挖掘工具一般分为三个组成部分:a、通用型工具;b、综合/DSS/OLAP数据挖掘工具;c、快速发展的面向特定应用的工具。

通用型工具占有最大和最成熟的那部分市场。

通用的数据挖掘工具不区分具体数据的含义,采用通用的挖掘算法,处理常见的数据类型,其中包括的主要工具有IBM 公司Almaden 研究中心开发的QUEST 系统,SGI 公司开发的MineSet 系统,加拿大Simon Fraser 大学开发的DBMiner 系统、SAS Enterprise Miner、IBM Intelligent Miner、Oracle Darwin、SPSS Clementine、Unica PRW等软件。

通用的数据挖掘工具可以做多种模式的挖掘,挖掘什么、用什么来挖掘都由用户根据自己的应用来选择。

综合数据挖掘工具这一部分市场反映了商业对具有多功能的决策支持工具的真实和迫切的需求。

商业要求该工具能提供管理报告、在线分析处理和普通结构中的数据挖掘能力。

这些综合工具包括Cognos Scenario和Business Objects等。

面向特定应用工具这一部分工具正在快速发展,在这一领域的厂商设法通过提供商业方案而不是寻求方案的一种技术来区分自己和别的领域的厂商。

这些工具是纵向的、贯穿这一领域的方方面面,其常用工具有重点应用在零售业的KD1、主要应用在保险业的Option&Choices和针对欺诈行为探查开发的HNC软件。

下面简单介绍几种常用的数据挖掘工具:1. QUESTQUEST 是IBM 公司Almaden 研究中心开发的一个多任务数据挖掘系统,目的是为新一代决策支持系统的应用开发提供高效的数据开采基本构件。

归纳决策树ID3(Java实现)

归纳决策树ID3(Java实现)先上问题吧,我们统计了14天的气象数据(指标包括outlook,temperature,humidity,windy),并已知这些天气是否打球(play)。

如果给出新一天的气象指标数据:sunny,cool,high,TRUE,判断一下会不会去打球。

table 1这个问题当然可以用朴素贝叶斯法求解,分别计算在给定天气条件下打球和不打球的概率,选概率大者作为推测结果。

现在我们使用ID3归纳决策树的方法来求解该问题。

预备知识:信息熵熵是无序性(或不确定性)的度量指标。

假如事件A的全概率划分是(A1,A2,...,An),每部分发生的概率是(p1,p2,...,pn),那信息熵定义为:通常以2为底数,所以信息熵的单位是bit。

补充两个对数去处公式:ID3算法构造树的基本想法是随着树深度的增加,节点的熵迅速地降低。

熵降低的速度越快越好,这样我们有望得到一棵高度最矮的决策树。

在没有给定任何天气信息时,根据历史数据,我们只知道新的一天打球的概率是9/14,不打的概率是5/14。

此时的熵为:属性有4个:outlook,temperature,humidity,windy。

我们首先要决定哪个属性作树的根节点。

对每项指标分别统计:在不同的取值下打球和不打球的次数。

table 2下面我们计算当已知变量outlook的值时,信息熵为多少。

outlook=sunny时,2/5的概率打球,3/5的概率不打球。

entropy=0.971outlook=overcast时,entropy=0outlook=rainy时,entropy=0.971而根据历史统计数据,outlook取值为sunny、overcast、rainy的概率分别是5/14、4/14、5/14,所以当已知变量outlook的值时,信息熵为:5/14 × 0.971 + 4/14 × 0 + 5/14 × 0.971 = 0.693这样的话系统熵就从0.940下降到了0.693,信息增溢gain(outlook)为0.940-0.693=0.247同样可以计算出gain(temperature)=0.029,gain(humidity)=0.152,gain(windy)=0.048。

数据挖掘论文决策树

数据挖掘论文决策树决策树是一种基本的数据挖掘算法,它通过对数据集的属性进行递归分割,构建出一棵以属性为节点,以属性值为分叉条件的树状结构,用于进行分类、回归以及其他任务的预测。

决策树算法简单直观,并且在处理大规模数据集时具有良好的可扩展性,因此在数据挖掘研究中被广泛应用。

决策树的构建过程是一个自顶向下的递归过程。

从根节点开始,根据一些属性对数据集进行划分,然后递归地对子数据集进行划分,直到满足其中一种条件为止。

在划分过程中,可以根据不同的分割标准选择最优的属性,以最大程度地提高决策树的预测性能。

常见的分割标准包括信息增益、信息增益率、基尼指数等。

决策树算法的核心是选择最优划分属性。

信息增益是一种常见的划分标准,它根据信息熵的变化来评估属性的选择性。

信息熵是衡量数据集纯度的指标,纯度越高,熵值越低。

信息增益就是指划分前后信息熵的差值。

在构建决策树时,选择信息增益最大的属性进行划分,可以使得决策树的预测性能最优。

决策树算法在实际应用中具有广泛的用途。

例如,在医学领域,决策树可以用于诊断疾病和判断患者的生存率。

在金融领域,决策树可以用于信用评估和风险管理。

在市场营销领域,决策树可以用于客户分群和精准营销。

决策树算法的应用范围非常广泛,并且可以与其他机器学习算法结合使用,提高预测效果。

决策树算法虽然简单直观,但也存在一些问题。

例如,决策树容易过拟合,即在训练数据上表现良好,但在测试数据上表现不佳。

过拟合可以通过剪枝技术来解决,即在决策树构建的过程中对树进行裁剪,减少决策树的复杂度和泛化误差。

此外,决策树算法对于连续属性的处理也存在一些困难。

传统的决策树算法只能处理离散属性,无法直接处理连续属性。

为了解决这个问题,可以使用二分法、多分桶等方法将连续属性转换为离散属性,然后再进行划分。

总结起来,决策树是一种简单直观的数据挖掘算法,可以用于分类、回归和其他任务的预测。

它具有良好的可扩展性和广泛的应用范围。

虽然决策树算法存在一些问题,但通过剪枝和处理连续属性的技术,可以提高决策树的预测性能。

决策树算法在数据挖掘中的应用

决策树算法在数据挖掘中的应用决策树算法是数据挖掘领域中最为常用的算法之一。

它使用树状结构来模拟决策过程,可以根据输入的数据自动构建出预测模型,从而对未知数据进行预测。

本文将详细介绍决策树算法的应用场景、原理及优缺点,并结合实际案例说明其在数据挖掘中的具体应用。

一、决策树算法的应用场景决策树算法广泛应用于各种领域的数据挖掘任务中,如金融、医疗、工业制造等。

不同领域对决策树算法的应用场景也不同。

以下是几种典型的场景:1. 银行信用评估决策树算法可以用于银行对客户信用进行评估。

银行要求借款人具有一定的信用等级才能获得贷款,而信用等级往往与多种因素相关。

银行可以根据借款人的信用历史、收入、婚姻状况等信息构建决策树模型,根据预测结果对借款人的信用进行评估。

2. 医疗诊断决策树算法可以应用于医疗诊断领域,帮助医生判断病人的疾病类型。

医生可以根据病人的症状、年龄、性别等信息构建决策树模型,模型会自动预测病人患上的疾病类型。

3. 工业制造决策树算法可以用于工业制造领域中的缺陷检测。

例如,制造商可以根据产品的尺寸、材质、工艺等信息构建决策树模型,该模型可以用于检测产品是否存在缺陷,从而提高产品的质量。

二、决策树算法的原理决策树算法根据数据的特征将数据分成多个小组,并在每个小组中选择最优的特征进行分类。

决策树算法的构建包括三个主要步骤:特征选择、树的构建和剪枝。

1. 特征选择特征选择是决策树算法的关键步骤,它决定了树的分类效果。

通常,特征选择的目标是选择能够最大化信息增益或最小化Gini指数的特征。

信息增益是指特征对分类问题中的不确定性的减少,Gini指数是一种衡量数据集纯度的指标,其值越小表示数据集越纯。

2. 树的构建树的构建是决策树算法的核心步骤,它是从数据集中构建出一棵决策树的过程。

在树的构建过程中,算法会随着数据集的变化不断地进行迭代,并递归地将数据集划分成越来越小的子集。

在每个子集上,算法都会选择最优的特征进行分类,直到所有分支的纯度达到一定的阈值。

决策树分析在数据挖掘中的作用

决策树分析在数据挖掘中的作用数据挖掘是一门关注从大数据中提取信息和进行分析的领域,而决策树分析则是数据挖掘中一种重要的技术手段。

本文将探讨决策树分析在数据挖掘中的作用,以及它在实际应用中的价值和优势。

什么是决策树分析决策树是一种树形结构,在数据挖掘中用于模拟人类决策过程。

其核心思想是通过一系列规则和决策节点对数据进行分类或预测,从而生成一个类似树状结构的模型。

决策树的构建过程基于对数据特征的分析和选择,旨在找出最佳的划分点,以便有效地区分不同类别的数据。

决策树在数据挖掘中的作用1. 可解释性强决策树模型具有很强的可解释性,模型生成的决策过程清晰明了,可以直观地展示特征之间的关系和影响,帮助数据分析师和决策者理解模型背后的规律,从而更好地制定决策和采取行动。

2. 适用于各种数据类型决策树能够处理各种类型的数据,包括离散型和连续型数据,也能很好地处理多分类和回归问题。

这种灵活性使得决策树在实际应用中具有广泛的适用性,能够满足不同领域和不同类型数据的分析需求。

3. 易于理解和实现相比其他复杂的机器学习算法,决策树模型的实现和理解都相对简单直观。

不需要过多的数学背景知识,便能够快速上手并进行模型构建和分析。

这使得决策树成为数据挖掘初学者的入门选择,也方便实际应用中快速部署和使用。

4. 鲁棒性强决策树对数据异常值和缺失值有很好的鲁棒性,能够处理一些数据质量较差或不完整的情况。

在现实场景中,数据往往存在一些噪声和不确定性,而决策树能够在一定程度上处理这些问题,提高模型的稳定性和准确性。

决策树在实际应用中的价值决策树在数据挖掘领域有着广泛的应用,例如在金融领域的信用评分、医疗领域的疾病诊断、市场营销领域的客户分类等方面都能发挥重要作用。

通过构建决策树模型,可以更好地理解数据之间的关系,发现隐藏在数据背后的规律,从而为决策和预测提供有力支持。

在金融领域,决策树可以用于评估客户的信用风险,帮助银行和金融机构制定个性化的信贷政策;在医疗领域,决策树可根据患者的症状和病史预测疾病风险,辅助医生进行诊断和治疗决策;在市场营销领域,决策树可以根据客户的行为和偏好进行分群,精准推送个性化营销方案,提升营销效果和客户满意度。

十大经典数据挖掘算法R语言实现汇编

十大经典数据挖掘算法R语言实现汇编数据挖掘是从大规模的数据集中提取出有价值的信息和知识的过程。

在数据挖掘中,有许多经典的算法可以帮助我们实现这一目标。

本文将介绍十大经典数据挖掘算法,并给出它们在R语言中的实现。

1. 决策树算法(Decision Tree Algorithm)决策树算法是一种基于树结构的分类方法,通过将数据集划分成多个子集,来构建一个可以预测分类的模型。

在R语言中,我们可以使用rpart包来实现决策树算法。

2. K均值聚类算法(K-means Clustering Algorithm)K均值聚类算法是一种常用的聚类算法,在R语言中可以使用kmeans 函数实现。

该算法将数据集划分成K个簇,每个簇的中心点为该簇内部数据点的平均值。

3. 朴素贝叶斯算法(Naive Bayes Algorithm)朴素贝叶斯算法是一种基于贝叶斯定理的分类算法,在R语言中可以使用naiveBayes包实现。

该算法假设特征之间相互独立,通过计算后验概率来进行分类。

4. 支持向量机算法(Support Vector Machine Algorithm)支持向量机算法是一种二分类方法,通过找到一个超平面来将不同类别的数据点分开。

在R语言中可以使用e1071包实现支持向量机算法。

5. 线性回归算法(Linear Regression Algorithm)线性回归算法是一种用于预测数值型变量的机器学习方法,在R语言中可以使用lm函数实现。

该算法通过拟合一个线性方程来预测连续性变量的值。

6. 随机森林算法(Random Forest Algorithm)随机森林算法是一种集成学习方法,将多个决策树算法的结果组合起来进行预测。

在R语言中可以使用randomForest包实现随机森林算法。

7. 关联规则算法(Association Rule Algorithm)关联规则算法用于识别数据集中的频繁项集和关联规则。

在R语言中可以使用arules包实现关联规则算法。

“决策树”——数据挖掘、数据分析

“决策树”——数据挖掘、数据分析决策树是⼀个预测模型;他代表的是对象属性与对象值之间的⼀种映射关系。

树中每个节点表⽰某个对象,⽽每个分叉路径则代表的某个可能的属性值,⽽每个叶结点则对应从根节点到该叶节点所经历的路径所表⽰的对象的值。

决策树仅有单⼀输出,若欲有复数输出,可以建⽴独⽴的决策树以处理不同输出。

决策树的实现⾸先要有⼀些先验(已经知道结果的历史)数据做训练,通过分析训练数据得到每个属性对结果的影响的⼤⼩,这⾥我们通过⼀种叫做信息增益的理论去描述它,期间也涉及到熵的概念。

中决策树是⼀种经常要⽤到的技术,可以⽤于分析数据,同样也可以⽤来作预测(就像上⾯的银⾏官员⽤他来预测贷款风险)。

从数据产⽣决策树的机器学习技术叫做决策树学习, 通俗说就是决策树。

⼀个决策树包含三种类型的节点: 1.决策节点——通常⽤矩形框来表式 2.机会节点——通常⽤圆圈来表式 3.终结点——通常⽤三⾓形来表⽰决策树学习也是资料探勘中⼀个普通的⽅法。

在这⾥,每个决策树都表述了⼀种树型结构,它由它的分⽀来对该类型的对象依靠属性进⾏分类。

每个决策树可以依靠对源的分割进⾏数据测试。

这个过程可以递归式的对树进⾏修剪。

当不能再进⾏分割或⼀个单独的类可以被应⽤于某⼀分⽀时,递归过程就完成了。

另外,随机森林分类器将许多决策树结合起来以提升分类的正确率。

决策树对于常规统计⽅法的优缺点优点: 1) 可以⽣成可以理解的规则; 2) 计算量相对来说不是很⼤; 3) 可以处理连续和种类字段; 4) 决策树可以清晰的显⽰哪些字段⽐较重要。

缺点: 1) 对连续性的字段⽐较难预测; 2) 对有时间顺序的数据,需要很多预处理的⼯作; 3) 当类别太多时,错误可能就会增加的⽐较快; 4) ⼀般的算法分类的时候,只是根据⼀个字段来分类。

决策树的适⽤范围 科学的决策是现代管理者的⼀项重要职责。

我们在企业管理实践中,常遇到的情景是:若⼲个可⾏性⽅案制订出来了,分析⼀下企业内、外部环境,⼤部分条件是⼰知的,但还存在⼀定的不确定因素。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

return_atrribute = atrribute;

}

i++;

}

return return_atrribute;

}

//node:在当前结点构造决策树

//deData:数据集

//flags:指示在当前结点构造决策树时哪些数据是需要的

//attributes:未分类的属性集

this.element = e;

}

public String getValue() {

return this.value;

}

public void setValue(String v) {

this.value = v;

}

public LinkedHashSet<TreeNode> getChilds() {

for(int i = 0; i < deData.length; i++) {

if(flags[i] == true) {

if(classMap.containsKey(deData[i][classIndex])) {

int count = classMap.get(deData[i][classIndex]);

}

System.out.println();

for(int i = 0; i < class_count; i++) {

System.out.print(class_vector[i] + " ");

}

System.out.println();

*/

//计算InforD

double InfoD = 0.0;

//Gain数组存放当前结点未分类属性的Gain值

double Gain[] = new double[atrributes.size()];

//每条数据中归类的下标,为每条数据的最后一个值

int class_index = deData[0].length - 1;

//属性名,该结点在该属性上进行分类

}

}

//对结点进行赋值,该结点为叶结点

node.setElement(mostClass);

node.setChilds(null);

System.out.println("yezhi:" + node.getElement() + ":" + node.getValue());

return;

}

//如果待分类数据全都属于一个类

String return_atrribute = null;

//计算每个未分类属性的Gain值

int count = 0; //计算到第几个属性

for(String atrribute:atrributes) {

//该属性有多少个值,该属性有多少个分类

int values_count, class_count;

class_count = classes.size();

int values_vector[] = new int[values_count * class_count];

int class_vector[] = new int[class_count];

for(int i = 0; i < deData.length; i++) {

if(flags[i] == true) {

class_name = deData[i][class_index];

classSet.add(class_name);

}

}

//则该结点为叶结点,设置有关值,然后返回

if(classSet.size() == 1) {

node.setElement(class_name);

//如果待分类属性已空

if(attributes.isEmpty() == true) {

//从数据集中选择多数类,遍历符合条件的所有数据

HashMap<String,Integer> classMap = new HashMap<String,Integer>();

int classIndex = deData[0].length - 1;

int class_index = deData[0].length - 1;

String class_name = null;

HashSet<String> classSet = new HashSet<String>();

for(int i = 0; i < deData.length; i++) {

}

for(int j = 0; j < class_count; j++) {

if(values_vector[i*class_count+j] != 0) {

double k = values_vector[i*class_count+j];

middle = middle - Math.log(k/attr_count) / Math.log(2.0) * k / attr_count;

while(it.hasNext()) {

String strClass = (String)it.next();

if(classMap.get(strClass) > mostCount) {

mostClass = strClass;

mostCount = classMap.get(strClass);

for(int i = 0; i < deData.length; i++) {

if(flags[i] == true) {

values.add(deData[i][index]);

classes.add(deData[i][class_index]);

}

}

values_count = values.size();

if(flags[i] == true) {

int j = 0;

for(String v:values) {

if(deData[i][index].equals(v)) {

break;

} else {

j++;

}

}

int k = 0;

for(String c:classes) {

if(deData[i][class_index].equals(c)) {

}

}

InfoA += middle * attr_count / class_total;

}

Gain[count] = InfoD - InfoA;

count++;

}

double max = 0.0;

int i = 0;

for(String atrribute:atrributes) {

if(Gain[i] > max) {

double class_total = 0.0;

for(int i = 0; i < class_vector.length; i++){

class_total += class_vector[i];

}

for(int i = 0; i < class_vector.length; i++){

if(class_vector[i] == 0) {

break;

} else {

k++;

}

}

values_vector[j*class_count+k]++;

class_vector[k]++;

}

}

/* //输出各项统计值

for(int i = 0; i < values_count * class_count; i++) {

System.out.print(values_vector[i] + " ");

return this.childs;

}

public void setChilds(LinkedHashSet<TreeNode> childs) {

this.childs = childs;

}

}

//决策树类

class DecisionTree {

TreeNode root; //决策树的树根结点

public DecisionTree() {

continue;

} else {

double d = Math.log(class_vector[i]/class_total) / Math.log(2.0) * class_vector[i] / class_total;

InfoD = InfoD - d;

}

}

//计算InfoA

double InfoA = 0.0;

import java.util.HashMap;

import java.util.HashSet;

import java.util.LinkedHashSet;

import java.util.Iterator;

//选自csdn博客

//决策树的树结点类

class TreeNode {

String element; //该值为数据的属性名称

}

public TreeNode(String value) {