数据挖掘决策树算法Java实现

Java中的机器学习算法实现

Java中的机器学习算法实现机器学习是一种通过让计算机系统从数据中获取知识和经验,并利用这些知识和经验进行学习和决策的方法。

而Java作为一种强大的编程语言,在机器学习领域也拥有广泛的应用。

本文将介绍Java中常用的机器学习算法实现及其应用。

一、线性回归算法线性回归是一种应用广泛的机器学习算法,用于预测一个或多个自变量与因变量之间的线性关系。

在Java中,我们可以使用Apache Commons Math库中的线性回归类来实现线性回归算法。

下面是一个简单的线性回归示例代码:```javaimport mons.math3.stat.regression.SimpleRegression;public class LinearRegressionExample {public static void main(String[] args) {// 创建线性回归对象SimpleRegression regression = new SimpleRegression();// 添加数据点regression.addData(1, 2);regression.addData(2, 3);regression.addData(3, 4);// 输出回归方程System.out.println("Intercept: " + regression.getIntercept());System.out.println("Slope: " + regression.getSlope());// 预测新的数据点double x = 4;double y = regression.predict(x);System.out.println("Predicted y: " + y);}}```二、决策树算法决策树是一种基于树结构的机器学习算法,可以用于分类和回归任务。

数据挖掘领域的十大经典算法原理及应用

数据挖掘领域的十大经典算法原理及应用数据挖掘是指从大量的数据中发现关联规则、分类模型、聚类模型等有用的信息的过程。

以下是数据挖掘领域的十大经典算法原理及应用:1. 决策树算法(Decision Tree)决策树是一种基于树形结构的分类模型,它通过构建树来将输入数据集划分为不同的类别。

决策树算法在金融风险评估、医疗诊断等领域有广泛应用。

2. 支持向量机算法(Support Vector Machine,SVM)支持向量机是一种二分类模型,其目标是在高维空间中找到一个最优的超平面,将不同类别的样本分离开来。

SVM在图像识别、文本分类等领域有广泛应用。

3. 神经网络算法(Neural Network)神经网络模拟人脑的工作原理,通过连接众多的神经元来完成学习和预测任务。

神经网络在图像处理、自然语言处理等领域有广泛应用。

4. 朴素贝叶斯算法(Naive Bayes)朴素贝叶斯算法是一种基于贝叶斯定理的统计分类方法,它假设所有特征之间相互独立,并通过计算后验概率来进行分类。

朴素贝叶斯在垃圾邮件过滤、文本分类等领域有广泛应用。

5. K均值聚类算法(K-means Clustering)K均值聚类是一种无监督学习算法,它通过将样本分成K个簇来实现数据的聚类。

K均值聚类在市场细分、客户群体分析等领域有广泛应用。

6. Apriori算法Apriori算法是一种频繁项集挖掘算法,它可以找出数据集中项之间的关联关系。

Apriori算法在购物篮分析、推荐系统等领域有广泛应用。

7. PageRank算法PageRank算法是一种用于网页排序的算法,它通过计算网页之间的链接关系来确定网页的重要性。

PageRank算法在引擎领域有广泛应用。

8. 随机森林算法(Random Forest)随机森林是一种集成学习算法,它通过构建多个决策树,并通过投票方式来进行分类或回归。

随机森林在金融风险评估、信用评分等领域有广泛应用。

9. AdaBoost算法AdaBoost是一种迭代的强学习算法,它通过调整样本权重来训练多个弱分类器,并通过加权投票方式来进行分类。

《数据挖掘实验》---K-means聚类及决策树算法实现预测分析实验报告

实验设计过程及分析:1、通过通信企业数据(USER_INFO_M.csv),使用K-means算法实现运营商客户价值分析,并制定相应的营销策略。

(预处理,构建5个特征后确定K 值,构建模型并评价)代码:setwd("D:\\Mi\\数据挖掘\\")datafile<-read.csv("USER_INFO_M.csv")zscoredFile<- na.omit(datafile)set.seed(123) # 设置随机种子result <- kmeans(zscoredFile[,c(9,10,14,19,20)], 4) # 建立模型,找聚类中心为4round(result$centers, 3) # 查看聚类中心table(result$cluster) # 统计不同类别样本的数目# 画出分析雷达图par(cex=0.8)library(fmsb)max <- apply(result$centers, 2, max)min <- apply(result$centers, 2, min)df <- data.frame(rbind(max, min, result$centers))radarchart(df = df, seg =5, plty = c(1:4), vlcex = 1, plwd = 2)# 给雷达图加图例L <- 1for(i in 1:4){legend(1.3, L, legend = paste("VIP_LVL", i), lty = i, lwd = 3, col = i, bty = "n")L <- L - 0.2}运行结果:2、根据企业在2016.01-2016.03客户的短信、流量、通话、消费的使用情况及客户基本信息的数据,构建决策树模型,实现对流失客户的预测,F1值。

决策树算法 java

决策树算法 java

决策树算法是一种常用的机器学习算法,它在数据挖掘和分类任务中广泛应用。

在Java中,决策树算法可以通过不同的库或者框架来实现,比如Weka、Apache Spark MLlib、和J48等。

以下是对决策树算法在Java中的实现的多个角度的回答:

1. 库和框架,在Java中,我们可以使用Weka来实现决策树算法。

Weka是一个流行的机器学习库,它提供了丰富的分类、回归和聚类算法,包括决策树算法。

此外,Apache Spark MLlib也提供了决策树算法的Java API,可以用于大规模数据集的处理。

另外,如果你想直接实现决策树算法,你也可以使用Java语言编写自己的决策树算法,这样可以更好地理解算法的原理和实现细节。

2. 特性和优势,决策树算法在Java中的实现具有很多优势。

首先,Java是一种跨平台的编程语言,这意味着你可以在不同的操作系统上运行你的决策树算法。

其次,Java具有良好的面向对象特性,可以帮助你更好地组织和管理你的代码。

此外,Java的丰富的库和框架可以帮助你快速实现和部署决策树算法。

3. 实际应用,决策树算法在Java中的实现可以应用于各种领

域,比如金融、医疗、电子商务等。

比如,在金融领域,可以使用

决策树算法来预测客户的信用评分;在医疗领域,可以使用决策树

算法来辅助医生诊断疾病。

另外,决策树算法也可以用于推荐系统、风险管理等方面。

总之,决策树算法在Java中的实现具有广泛的应用前景和丰富

的实现方式,可以帮助我们解决各种分类和预测问题。

希望这些信

息对你有所帮助。

高校计算机专业数据挖掘算法实现代码详解

高校计算机专业数据挖掘算法实现代码详解数据挖掘算法在现代计算机科学中扮演着至关重要的角色。

随着大数据时代的到来,高校计算机专业需要培养具备数据挖掘算法实现能力的人才。

本文将详细介绍几种常用的数据挖掘算法,并附上相应的实现代码。

一、决策树算法决策树算法是一种常用的分类算法,通过构建一颗树状结构来进行分类。

具体的实现代码如下:```def create_decision_tree(dataset, labels):classList = [example[-1] for example in dataset]if classList.count(classList[0]) == len(classList):return classList[0]if len(dataset[0]) == 1:return majority_count(classList)best_feature = choose_best_feature_to_split(dataset)best_feature_label = labels[best_feature]my_tree = {best_feature_label: {}}del(labels[best_feature])feature_values = [example[best_feature] for example in dataset]unique_values = set(feature_values)for value in unique_values:sub_labels = labels[:]my_tree[best_feature_label][value] =create_decision_tree(split_dataset(dataset, best_feature, value), sub_labels) return my_tree```二、朴素贝叶斯算法朴素贝叶斯算法是一种常用的概率推断算法,适用于分类和文本分类等任务。

java weka 案例

下面是一个简单的Java Weka使用案例。

在这个例子中,我们将使用Weka库对一个简单的数据集进行分类。

首先,你需要确保你已经安装了Weka库并将其添加到你的Java项目中。

你可以从Weka官网下载最新版本的Weka库。

然后,你可以使用以下代码加载数据集并使用J48决策树算法进行分类:

在这个例子中,我们首先使用DataSource类加载数据集。

然后,我们创建一个

J48对象,设置其未剪枝和随机种子属性,并使用数据集构建分类器。

最后,我们输出分类器的内容。

这只是一个简单的Weka使用案例,你可以根据自己的需求使用不同的算法和数据集进行更复杂的分类任务。

数据挖掘算法的原理与实现

数据挖掘算法的原理与实现数据挖掘算法是指通过分析、挖掘数据中隐藏的规律和属性,从中发现有用的信息的方法。

它在各个领域都有广泛的应用,例如商业、金融、医疗、社交媒体等。

数据挖掘算法的原理和实现需要了解其基本流程、常用算法和应用场景。

一、基本流程数据挖掘算法的基本流程包括数据预处理、特征选择、建模和评估。

数据预处理是对原始数据进行清洗、转换和筛选,使其适合后续处理。

特征选择是根据数据的重要性和相关性,选择最具代表性的特征。

建模是通过数据挖掘算法来建立模型,提取数据中的规律和关系。

评估是通过一定的指标和方法,对模型的成效进行评估和优化。

二、常用算法1.分类算法分类算法是将数据分成多个类别的算法。

其中,决策树是一种简单而强大的分类算法,通过对数据的分裂和判断,形成一棵树状结构,每个叶子节点代表一个分类。

SVM(支持向量机)是一种有监督学习的分类算法,通过寻找最优分割超平面来区分不同类别。

朴素贝叶斯分类器是一种基于贝叶斯定理的分类算法,通过计算先验概率和条件概率来进行分类。

2.聚类算法聚类算法是将数据划分成多个组或类的算法。

其中,K均值算法是一种常用的聚类算法,它通过不断调整质心位置,使同一类别的数据点距离质心最近,不同类别的数据点距离质心最远。

层次聚类算法是一种将数据点不断合并的算法,它通过距离矩阵和聚类树来表示不同数据点之间的距离和聚类关系。

DBSCAN算法是一种密度聚类算法,通过密度和距离的概念来寻找类别,并可发现任意形状的类别。

3.关联规则挖掘算法关联规则挖掘算法是一种用来发现数据中不同属性之间关系的算法。

其中,Apriori算法是一种常用的关联规则挖掘算法,它通过搜索频繁项集和关联规则,来发现数据中的相关性,如购物篮中的商品关系。

三、应用场景数据挖掘算法广泛应用于各种领域,如商业、金融、医疗、社交媒体等。

在商业领域中,数据挖掘算法可以用于推荐系统、市场分析和预测等方面。

在金融领域中,数据挖掘算法可以用于欺诈检测、风险控制和交易分析等方面。

决策树算法在数据挖掘中研究与应用

2 )数 据挖 掘 结果可 视化 : 将数据挖 掘后 得到 的 知识 和结 果用 可视 化 形式表 示 出来 。

3 )数 据挖 掘 过程 可视 化: 用可视 化形 式描述 各 种挖 掘过程 。

、

相关 概念 和技 术

1 .数 据挖 掘

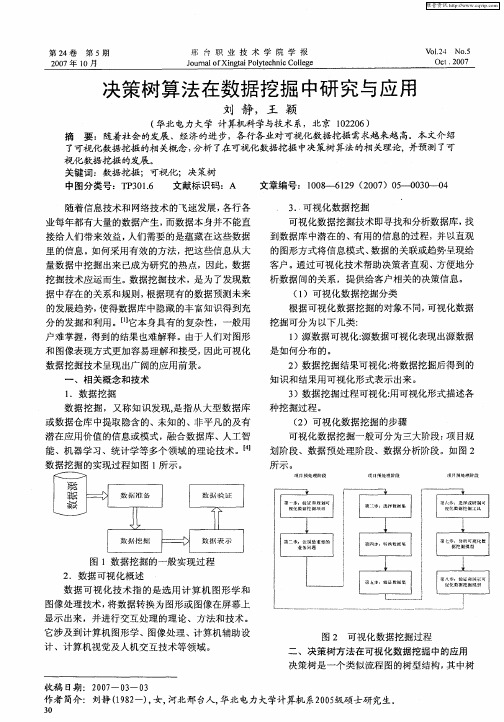

数 据 挖掘 ,又称 知 识 发现 , 指 从大 型 数 据库 是 或 数 据仓库 中提 取 隐含 的、未知 的 、非平 凡 的及有 潜在 应 用价 值 的信息 或模 式 ,融合 数据 库 、人 工智 能 、机器 学 习 、统计 学等 多个 领 域 的理论 技术 。【 4 J 数 据挖 掘 的实现过 程 如 图 1 示 。 所

视 化数 据挖 掘 的发展 。

关键 词 :数据挖掘 ;可视 化 ;决 策树 中 图分 类号 :T 3 1 P 0. 6 文献标 识码 :A 文章编 号 :10- 62 (07 5_ 0 _ 4 08- 19 2 0 )0_0 3 0 - 3. .可视 化数 据挖 掘 可视 化数 据挖 掘技 术 即寻找和 分析数 据库 , 找 到数 据库 中潜 在 的 、 用 的信 息的过程 ,并 以直 观 有 的图形方 式将 信 息模式 、 数据 的关联或 趋势 呈现 给 客户 。通 过可 视 化技 术帮助 决策 者直观 、方 便地 分

维普资讯

第2 4卷 第 5期 20 0 7年 1 O月

邢 台 职 业 技 术 学 院 学 报 Ju ao XigaP l eh i C lg o r l f n ti oy cnc ol e n t e

V.I2 N 0. 0.4 5 Oct. 00 2 7

收稿 日期 :2 O 一 O 一 O O7 3 3

作者简介 :刘静 ( 8一) 女, 1 2 , 河北邢 台人, 9 华北 电力大学计算机 系2 0 ̄ 05

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Gain[count] = InfoD - InfoA; count++; }

double max = 0.0; int i = 0; for(String atrribute:atrributes) {

if(Gain[i] > max) { max = Gain[i]; return_atrribute = atrribute;

for(int j = 0; j < class_count; j++) { attr_count += values_vector[i*class_count+j];

}

for(int j = 0; j < class_count; j++) { if(values_vector[i*class_count+j] != 0) { double k =

/* //输出各项统计值 for(int i = 0; i < values_count * class_count; i++) {

System.out.print(values_vector[i] + " "); }

System.out.println(); for(int i = 0; i < class_count; i++) {

return;

//如果待分类数据全都属于一个类 int class_index = deData[0].length - 1; String class_name = null; HashSet<String> classSet = new HashSet<String>(); for(int i = 0; i < deData.length; i++) {

if(flags[i] == true) {

if(classMap.containsKey(deData[i][classIndex])) { int count =

classMap.get(deData[i][classIndex]); classMap.put(deData[i][classIndex],

//计算每个未分类属性的 Gain值 int count = 0; //计算到第几个属性 for(String atrribute:atrributes) {

//该属性有多少个值,该属性有多少个分类 int values_count, class_count; //属性值对应的下标 int index = attrIndexMap.get(atrribute);

//Gain数组存放当前结点未分类属性的Gain值 double Gain[] = new double[atrributes.size()]; //每条数据中归类的下标,为每条数据的最后一个值 int class_index = deData[0].length - 1; //属性名,该结点在该属性上进行分类 String return_atrribute = null;

//存放属性的各个值和分类值 LinkedHashSet<String> values = new LinkedHashSet<String>(); LinkedHashSet<String> classes = new LinkedHashSet<String>();

for(int i = 0; i < deData.length; i++) { if(flags[i] == true) { values.add(deData[i][index]); classes.add(deData[i][class_index]); }

values_vector[i*class_count+j]; middle = middle - Math.log(k/attr_count)

/ Math.log(2.0) * k / attr_count; }

}

InfoA += middle * attr_count / class_total; }

//决策树的树结点类 class TreeNode {

String element; //该值为数据的属性名称 String value; //上一个分裂属性在此结点的值 LinkedHashSet<TreeNode> childs; //结点的子结点,以有顺序的链式哈希集存储

public TreeNode() { this.element = null; this.value = null; this.childs = null;

count+1); } else { classMap.put(deData[i][classInValue()); }

//选择多数类 String mostClass = null; int mostCount = 0; Iterator<String> it = classMap.keySet().iterator(); while(it.hasNext()) {

for(int i = 0; i < deData.length; i++) { if(flags[i] == true) { int j = 0; for(String v:values) { if(deData[i][index].equals(v)) { break; } else { j++; } }

String strClass = (String)it.next(); if(classMap.get(strClass) > mostCount) {

mostClass = strClass; mostCount = classMap.get(strClass); } } //对结点进行赋值,该结点为叶结点 node.setElement(mostClass); node.setChilds(null); System.out.println("yezhi:" + node.getElement() + ":" +

}

public void setChilds(LinkedHashSet<TreeNode> childs) { this.childs = childs;

} }

//决策树类 class DecisionTree {

TreeNode root; //决策树的树根结点

public DecisionTree() { root = new TreeNode();

int k = 0; for(String c:classes) {

if(deData[i][class_index].equals(c)) { break;

} else { k++;

} }

values_vector[j*class_count+k]++; class_vector[k]++; } }

}

public String selectAtrribute(TreeNode node,String[][] deData, boolean flags[],

LinkedHashSet<String> atrributes, HashMap<String,Integer> attrIndexMap) {

}

public TreeNode(String value) { this.element = null; this.value = value; this.childs = null;

}

public String getElement() { return this.element;

}

public void setElement(String e) { this.element = e;

class_total += class_vector[i]; } for(int i = 0; i < class_vector.length; i++){

if(class_vector[i] == 0) { continue;

} else { double d = Math.log(class_vector[i]/class_total)

}

public String getValue() { return this.value;

}

public void setValue(String v) { this.value = v;

}

public LinkedHashSet<TreeNode> getChilds() { return this.childs;

if(flags[i] == true) { class_name = deData[i][class_index]; classSet.add(class_name);

} } //则该结点为叶结点,设置有关值,然后返回 if(classSet.size() == 1) {

} values_count = values.size(); class_count = classes.size();

int values_vector[] = new int[values_count * class_count]; int class_vector[] = new int[class_count];

} i++; }

return return_atrribute; }

//node:在当前结点构造决策树 //deData:数据集 //flags:指示在当前结点构造决策树时哪些数据是需要的 //attributes:未分类的属性集 //attrIndexMap:属性与对应数据下标 public void buildDecisionTree(TreeNode node, String[][] deData, boolean flags[],