中文文本自动分词与标注汉语词义自动标注技术

浅谈《现代汉语词典》(第五版)词性标注的几个问题

浅谈《现代汉语词典》(第五版)词性标注的几个问题摘要:本文主要从功能的角度对《现代汉语词典》(第五版)的词性标注进行了初步的探索,主要涉及词性标注及其与释义和配例相一致、兼类词的释义等几个方面的问题,对《现汉》(五)的成功和不足之处作了一定说明。

关键词:《现代汉语词典》(第五版)词性标注释义《现代汉语词典》是目前国内最有影响的语文辞书之一。

对现代汉语词典质量产生影响的根本性因素,是词典的释义问题。

一、《现代汉语词典》(第五版)词性标注现代汉语词典标注词性,给汉语教学、用户的学习和使用和中文信息处理等带来了很大的方便。

标注词性必须要对词类系统和词与非词进行界定。

科学的给词归类,主要根据词的语法功能。

陆俭明提出的词类划分标准是:1、词充当句法成分的功能,2、词跟词结合的功能,3、词表示类别的功能,即语法意义。

《现代汉语词典》(第5版)依据的词类是中学语文课本的教学词类系统,是比较科学的。

如:集成:【动】同类著作汇集在一起(多用做书名):《丛书~》|《中国古典戏曲论著~》。

(《现汉》(五)p592)集锦:【名】编辑在一起的精彩的图画、诗文等(多用做标题):图片~|邮票~。

(《现汉》(五)p593)《现代汉语词典》(第5版)中的“集成”与“集锦”根据配例来看,“丛书集成”、“图片集锦”、“邮票集锦”,二者看似相同,但是语法意义不同。

根据“语料库在线”的检索结果,“集成”66条例句中,17个做谓语例句,13个做定语例句,且能带宾语;“集锦”6条例句中5个做中心语。

前者语法意义表示事物的动作、行为或变化、存在,后者的语法意义表示事物名称。

所以二者词性标注不同。

另外,在根据功能判断词性的基础上,也不能完全脱离意义。

“集成”与“集锦”词汇意义也不同,“集:1.集合;聚集”(《现汉》(五)p639),“成:3.【动】成为;变为”(《现汉》(五)p171),“集成”有“汇集成为”的意思,释义行文体现为动词性。

“锦:有彩色花纹的丝织品”(《古汉语常用字字》p150),这里应为比喻义,指美好的东西,所以“集锦”释义行文应体现为名词性。

中文nlp模型

中文nlp模型

中文NLP模型是指专门用于处理中文自然语言的各类任务的模型。

中文NLP模型主要有以下几种:

1. 分词模型:用于将中文句子进行分词,将句子拆分成独立的词语单位。

2. 词性标注模型:用于为中文句子中的每个词语标注其词性,如动词、名词、形容词等。

3. 命名实体识别模型:用于识别中文句子中的命名实体,如人名、地名、机构名等。

4. 语义角色标注模型:用于对中文句子中的动词进行语义角色标注,将动词与其所表示的语义角色进行对应。

5. 情感分析模型:用于分析中文句子中的情感倾向,判断句子是否表达了积极、消极或中性的情感。

6. 机器翻译模型:用于将中文句子翻译为其他语言的句子,或将其他语言的句子翻译成中文。

7. 文本生成模型:用于生成中文文本,如填充式文本生成、生成式对话系统等。

以上只是中文NLP模型的一部分,随着研究的深入和技术的进步,还会出现更多新的模型和任务。

中文分词与词性标注技术研究与应用

中文分词与词性标注技术研究与应用中文分词和词性标注是自然语言处理中常用的技术方法,它们对于理解和处理中文文本具有重要的作用。

本文将对中文分词和词性标注的技术原理、研究进展以及在实际应用中的应用场景进行综述。

一、中文分词技术研究与应用中文分词是将连续的中文文本切割成具有一定语义的词语序列的过程。

中文具有词汇没有明确的边界,因此分词是中文自然语言处理的基础工作。

中文分词技术主要有基于规则的方法、基于词典的方法和基于机器学习的方法。

1.基于规则的方法基于规则的中文分词方法是根据语法规则和语言学知识设计规则,进行分词操作。

例如,按照《现代汉语词典》等标准词典进行分词,但这种方法无法处理新词、歧义和未登录词的问题,因此应用受到一定的限制。

2.基于词典的方法基于词典的中文分词方法是利用已有的大规模词典进行切分,通过查找词典中的词语来确定分词的边界。

这种方法可以处理新词的问题,但对未登录词的处理能力有所限制。

3.基于机器学习的方法基于机器学习的中文分词方法是利用机器学习算法来自动学习分词模型,将分词任务转化为一个分类问题。

常用的机器学习算法有最大熵模型、条件随机场和神经网络等。

这种方法具有较好的泛化能力,能够处理未登录词和歧义问题。

中文分词技术在很多自然语言处理任务中都起到了重要的作用。

例如,在机器翻译中,分词可以提高对齐和翻译的质量;在文本挖掘中,分词可以提取关键词和构建文本特征;在信息检索中,分词可以改善检索效果。

二、词性标注技术研究与应用词性标注是给分好词的文本中的每个词语确定一个词性的过程。

中文的词性标注涉及到名词、动词、形容词、副词等多个词性类别。

词性标注的目标是为后续的自然语言处理任务提供更精确的上下文信息。

1.基于规则的方法基于规则的词性标注方法是根据语法规则和语境信息,确定每个词语的词性。

例如,根据词语周围的上下文信息和词语的词义来判断词性。

这种方法需要大量的人工制定规则,并且对于新词的处理能力较差。

基于深度学习方法的中文分词和词性标注研究

基于深度学习方法的中文分词和词性标注研究中文分词和词性标注是自然语言处理中的重要任务,其目的是将输入的连续文字序列切分成若干个有意义的词语,并为每个词语赋予其对应的语法属性。

本文将基于深度学习方法对中文分词和词性标注进行研究。

一、深度学习方法介绍深度学习是一种基于神经网络的机器学习方法,在自然语言处理领域中应用广泛。

经典的深度学习模型包括卷积神经网络(Convolutional Neural Network,CNN)、循环神经网络(Recurrent Neural Network,RNN)、长短时记忆网络(LongShort-Term Memory, LSTM)和门控循环单元(Gated Recurrent Unit, GRU)等。

在对中文分词和词性标注任务的研究中,CNN、RNN以及LSTM均被采用。

CNN主要用于序列标注任务中的特征提取,RNN及LSTM则用于序列建模任务中。

GRU是LSTM的一种简化版本,在应对大规模文本序列的过程中更为高效。

二、中文分词中文分词是将一段连续的汉字序列切分成有意义的词语。

传统的中文分词方法主要包括基于词典匹配的分词和基于统计模型的分词。

基于词典匹配的分词方法基于预先构建的词典,将待切分文本与词典进行匹配。

该方法精度较高,但需要较为完整的词典。

基于统计模型的分词方法则通过学习汉字之间的概率关系来进行分词。

该方法不依赖于完整的词典,但存在歧义问题。

深度学习方法在中文分词任务中也有较好的表现,通常采用基于序列标注的方法。

具体步骤如下:1. 以汉字为单位对输入文本进行编码;2. 使用深度学习模型进行序列标注,即对每个汉字进行标注,标记为B(词的开头)、M(词的中间)或E(词的结尾),以及S(单字成词);3. 将标注后的序列按照词语切分。

其中,深度学习模型可以采用CNN、RNN、LSTM或GRU等模型。

三、中文词性标注中文词性标注是为每个词语赋予其对应的语法属性,通常使用含有标注数据的语料库进行训练。

基于LSTM模型的分词及词性标注一体化设计

基于LSTM模型的分词及词性标注一体化设计摘要中文分词及词性标注是NLP领域的一项基础技术,分词及词性标注是否准确将直接影响着自然语言理解的准确性。

目前普遍采用Dictionary、N-gram、Maximum Entropy、HMM、CRF等模型来完成。

虽然也有很多对LSTM的研究,但几乎缺乏详细的推理过程。

而本文将对模型的架构图做出详细的说明,以及对模型做出详细的正向和反向推理过程。

实验表明该模型在应用于分词及标注能取得很好的效果。

关键词LSTM;分词;标注;分词标注一体化Design of word segmentation and POS Tagging Based on LSTMFAN ZhenSouth China Agricultural University ,College of Mathematics and Informatics,510000,Guangzhou,Guangdong,PRCAbstract Chinese word segmentation and POS tagging is a basic technology in NLP field,the accuracy of word segmentation and POS tagging will directly affect the accuracy of natural language understanding. At present,there are usually done by Dictionary,N-gram,Maximum Entropy,HMM,CRF and other models. Although there are many studies on LSTM,there is almost no detailed reasoning process. In this paper,we will give a detailed description of the model’s architecture diagram,and make a detailed forward and backward reasoning process of the model. Experiments show that this model can achieve good results in segmentation and POS tagging.Key words LSTM;segmentation;POS;integration of segmentation and POS 前言由于中文不同于英文,需要进行分词和词性标注等基础性的工程[1],才能准确的理解语义[2]。

基于机器学习技术的文本分类与自动标注方法

基于机器学习技术的文本分类与自动标注方法文本分类与自动标注方法是当今信息爆炸时代下必不可少的技术手段。

随着大数据时代的到来,人们面临着海量的文本数据,如何高效地对这些文本数据进行分类和标注已成为亟待解决的问题。

基于机器学习技术的文本分类与自动标注方法应运而生,它借助算法将文本数据按照一定的标准分类和自动标注,从而为后续的信息检索、数据分析和决策提供了重要的支持和保障。

首先,基于机器学习技术的文本分类方法是文本处理与分析的重要手段。

文本分类是将文本数据按照其所属类别进行划分的过程,例如新闻分类、情感分析等。

机器学习技术通过训练样本集,自动学习文本数据的特征与模式,并利用这些特征和模式为未分类的文本数据进行分类。

常见的机器学习算法包括朴素贝叶斯分类器、支持向量机、决策树等。

这些算法能够高效地处理大规模的文本数据,并具有较高的准确率和效率。

其次,基于机器学习技术的文本自动标注方法是为文本数据打上标签或关键词的过程。

自动标注是对文本数据进行语义理解和内容分析的关键环节,能够为文本数据提供更加详尽的信息。

机器学习技术通过学习大量已经标注的文本数据,可以自动识别文本中的关键内容、主题和情感等,从而实现对文本的自动标注。

这一方法节省了人工标注的巨大时间成本,同时能够高效地处理大量文本数据,提高数据处理的效率和准确性。

基于机器学习技术的文本分类与自动标注方法在实际应用中有广泛的应用前景。

首先,它可以应用于新闻分类领域。

在网络媒体蓬勃发展的今天,各类新闻信息涌现无穷。

采用机器学习技术进行文本分类和自动标注,能够帮助媒体机构快速准确地将新闻信息分类整理,以满足用户个性化需求。

其次,该方法适用于情感分析。

面对用户在社交媒体上的大量评论和反馈,机器学习技术可以自动标注这些文本的情感倾向,从而为企业决策和产品改进提供重要依据。

此外,该方法还可以被用于信息检索和推荐系统中,为用户提供更加准确和个性化的信息。

当然,基于机器学习技术的文本分类与自动标注方法也存在一些挑战和局限性。

自然语言处理工具

自然语言处理工具自然语言处理(Natural Language Processing,简称NLP)是人工智能领域的一个重要分支,它涉及计算机与人类自然语言的交互和理解。

随着科技的不断发展,各种自然语言处理工具应运而生,为人们的日常生活和工作提供了便利。

本文将介绍几种常见的自然语言处理工具,以及它们在不同领域的应用。

一、中文分词工具中文分词是将连续的汉字序列切分成有意义的词语。

中文分词对于中文文本的处理至关重要,它是许多其他自然语言处理任务的前置步骤。

常用的中文分词工具有结巴分词、哈工大LTP、清华大学THULAC等。

这些工具能够准确地进行中文分词,为后续的文本处理提供良好的基础。

二、词性标注工具词性标注是将每个词语赋予相应的词性标签,例如名词、动词、形容词等。

词性标注能够帮助我们更好地理解句子的语法结构和含义。

常用的词性标注工具有NLTK和斯坦福词性标注器等。

这些工具可以自动标注词语的词性,为文本分析和理解提供帮助。

三、命名实体识别工具命名实体识别是指从文本中识别出具有特定意义的实体,包括人名、地名、组织机构名等。

命名实体识别在信息提取、搜索引擎排名等领域有着重要的应用。

常用的命名实体识别工具有斯坦福NER(NamedEntity Recognition)工具、清华大学THU NER工具等。

这些工具可以对文本进行实体识别并进行分类标注。

四、情感分析工具情感分析是通过计算机自动分析文本中表达的情感倾向,判断文本的情感极性(正面、负面或中性)。

情感分析在舆情监测、产品评论等领域有着广泛的应用。

常用的情感分析工具有TextBlob、stanford-corenlp等。

这些工具可以对文本进行情感分类,为情感分析提供便利。

五、文本摘要工具文本摘要是将一篇较长的文本自动提炼为几句简洁的概括性语句。

文本摘要在新闻报道、学术论文等领域有着广泛的需求。

常用的文本摘要工具有Gensim、NLTK等。

这些工具可以根据文本的关键信息生成摘要,提高文本的可读性和信息获取效率。

973当代汉语文本语料库分词、词性标注加工规范

973当代汉语文本语料库分词、词性标注加工规范(草案)山西大学从1988年开始进行汉语语料库的深加工研究,首先是对原始语料进行切分和词性标注,1992年制定了《信息处理用现代汉语文本分词规范》。

经过多年研究和修改,2000年又制定出《现代汉语语料库文本分词规范》和《现代汉语语料库文本词性体系》。

这次承担973任务后制定出本规范。

本规范主要吸收了语言学家的研究成果,并兼顾各家的词性分类体系,是一套从信息处理的实际要求出发的当代汉语文本加工规范。

本加工规范适用于汉语信息处理领域,具有开放性和灵活性,以便适用于不同的中文信息处理系统。

《973当代汉语文本语料库分词、词性标注加工规范》是根据以下资料提出的。

1.《信息处理用现代汉语分词规范》,中国国家标准GB13715,1992年2.《信息处理用现代汉语词类标记规范》,中华人民共和国教育部、国家语言文字工作委员会2003年发布3.《现代汉语语料库文本分词规范》(Ver 3.0),1998年北京语言文化大学语言信息处理研究所清华大学计算机科学与技术系4.《现代汉语语料库加工规范——词语切分与词性标注》,1999年北京大学计算语言学研究所5.《信息处理用现代汉语词类标记规范》,2002年,教育部语言文字应用研究所计算语言学研究室6.《现代汉语语料库文本分词规范说明》,2000年山西大学计算机科学系山西大学计算机应用研究所7.《資讯处理用中文分词标准》,1996年,台湾计算语言学学会一、分词总则1.词语的切分规范尽可能同中国国家标准GB13715《信息处理用现代汉语分词规范》(以下简称为“分词规范”)保持一致。

本规范规定了对现代汉语真实文本(语料库)进行分词的原则及规则。

追求分词后语料的一致性(consistency)是本规范的目标之一。

2.本规范中的“分词单位”主要是词,也包括了一部分结合紧密、使用稳定的词组以及在某些特殊情况下可能出现在切分序列中的孤立的语素或非语素字。

中文信息处理技术

中文信息处理技术中文信息处理技术是指对中文语言进行处理和分析的技术。

随着互联网的发展,中文信息处理技术越来越受到重视。

在这个数字化的时代,中文信息处理技术已经成为了一个重要的领域。

中文信息处理技术包括自然语言处理、机器翻译、信息检索、语音识别等多个方面。

其中,自然语言处理是最为重要的一个方面,它可以帮助计算机理解人类语言,并进行相应的反应。

自然语言处理主要包括以下几个方面:1. 分词:将一句话或一段文字分成若干个单独的词语,是自然语言处理中最基本的任务之一。

2. 词性标注:对每个分好的词汇进行标注,以便计算机更好地理解这些词汇在句子中所扮演的角色。

3. 句法分析:对句子进行分析和结构化,以便计算机更好地理解句子的意思。

4. 语义分析:对句子进行深入分析,并从中提取出隐含在其中的意义和信息。

5. 文本分类:将大量文本按照其内容分类,并对每类文本进行相应的归纳和总结。

在以上的任务中,机器翻译是自然语言处理中最为复杂的一个任务。

机器翻译需要计算机能够理解源语言和目标语言之间的语义差异,并进行相应的转换。

虽然机器翻译技术已经取得了很大的进展,但是仍然存在很多难题需要解决。

除了自然语言处理外,中文信息处理技术还包括信息检索、文本挖掘、语音识别等多个方面。

信息检索主要是指通过搜索引擎等方式来寻找相关信息;文本挖掘则是指对大量文本进行分析和挖掘,从中提取出有用的信息;而语音识别则是指将人类语音转换成计算机可读的形式。

总之,中文信息处理技术在现代社会中发挥着越来越重要的作用。

它不仅可以帮助人们更好地理解和使用中文,也可以为企业、政府等提供更加高效和便捷的服务。

未来,在人工智能技术不断发展壮大的背景下,中文信息处理技术将会得到更加广泛和深入的应用。

自动翻译古文

自动翻译古文随着科技的发展,人工智能技术逐渐渗透到我们生活的方方面面。

自动翻译古文便是其中一项有趣的应用。

本文将为您详细介绍自动翻译古文的原理、方法以及在实际应用中的优势。

一、自动翻译古文的原理自动翻译古文主要依赖于自然语言处理技术,通过对大量古文语料的训练,让计算机学会理解古文的语法、词义和语境。

古文翻译的核心在于词语替换和句式调整,而自动翻译系统通过以下步骤实现这一目标:1.分词:将古文文本进行分词处理,识别出句子中的词语。

2.词义消歧:根据上下文语境,确定每个词语的具体含义。

3.语法分析:分析句子结构,识别句式和语法关系。

4.翻译规则匹配:根据预设的翻译规则,将古文词语替换为现代汉语。

5.生成翻译结果:根据语法和语境,调整句式,生成通顺的现代汉语翻译。

二、自动翻译古文的方法1.基于规则的方法:通过编写大量的翻译规则,将古文词语和句式转换为现代汉语。

这种方法对规则库的依赖较大,需要不断更新和优化。

2.基于统计的方法:利用机器学习算法,从大量已标注的古文翻译语料中学习翻译规律。

这种方法具有较高的泛化能力,但需要大量的训练数据。

3.基于深度学习的方法:采用神经网络模型,通过端到端的训练,实现古文到现代汉语的自动翻译。

这种方法在翻译质量上有较大提升,但计算资源消耗较大。

三、自动翻译古文的优势1.提高阅读效率:自动翻译古文可以帮助读者快速理解古文内容,节省阅读时间。

2.降低学习门槛:对于古文基础薄弱的读者,自动翻译古文降低了学习古文的难度,有助于普及古文知识。

3.辅助学术研究:自动翻译古文可以为学术研究者提供便捷的资料查阅和翻译服务,提高研究效率。

4.丰富文化生活:自动翻译古文有助于弘扬传统文化,让更多人了解和欣赏古文的魅力。

四、总结自动翻译古文作为一项新兴技术,在提高古文阅读效率、降低学习门槛、辅助学术研究等方面具有显著优势。

然而,目前自动翻译古文技术仍存在一定局限性,如翻译准确度、句式调整等方面仍有待提高。

分词技术

中文自动分词技术中文自动分词,是对索引库中的网页文件进行预处理的一个重要步骤。

它工作在搜索引擎的网页预处理阶段:在它之前,相关程序已经对从网页库中取出的网页文件进行了处理,获取了其中title 、anchor、url等信息,并将html语法部分删除,形成了由网页中文本部分组成的字符串。

分词器做的工作,就是把这个字符串按照语意进行分解,使他成为一组能标识该网页的词的集合。

对于英文,最小的语法单位和语意单位都是单词。

由于英语的书写习惯把单词与单词之间用一个空格分开,所以很容易依靠空格来分解整篇文章,在这个问题上基本不费力气。

但是对于中文,情形就大不相同。

中文里面最小语法单位是字但是最小语意单位是词。

如果以字为单位来切分整篇文章,处理起来比较容易,但是带来的时间及空间消耗是非常大的。

更重要的是一个字根本无法准确表述一个意思,很容易想象出,假设以字为单位来进行切词,用户搜索的结果很可能与用户原本的意图风马牛不相及。

所以,要准确的标识语意,对于中文文章必须将其切分成汉语词的集合。

但是要准确的按照文章语意来切分词不是件容易的事情,例如,对于句子:"中华人民共和国 ",其中"中华"和"华人"都是词,在这句话中我们知道应该按照"中华"来切词;但是对于句子"参与投资的外商中华人占绝大多数",这时又该按照"华人" 来切分。

人处理这些问题是比较简单的,但是机器实现起来就难了。

2.2 目前搜索引擎中中文分词状况有消息说,Google的中文分词技术采用的是美国一家名叫 Basis Technology ( )的公司提供的中文分词技术,百度使用的是自己公司开发的分词技术,中搜使用的是国内海量科技( )提供的分词技术。

在该文([1])中,作者对以上所述的三个引擎分别使用关键字"和服"进行了查询,结果差强人意。

汉语自动分词与内容分析法研究

汉语自动分词与内容分析法研究近年来,随着互联网与人工智能技术的快速发展,汉语自然语言处理技术日益受到关注和重视。

其中,汉语自动分词和内容分析法是其研究的两个重要方向。

首先,汉语自动分词涉及到如何将一个汉字序列划分为词汇单位,并进行适当的标注。

其主要目的是为了方便后续的文本处理和分析。

传统的汉字处理方法通常是基于字典匹配的算法,即通过预先定义好的汉字词典来划分词语。

然而,这种方法存在着很多问题,如对新词的识别不够灵活、歧义词的识别不够准确等。

因此,近年来出现了一些新的汉语自动分词算法,如基于统计模型的算法(如HMM、CRF等)和基于神经网络的算法(如深度学习模型)。

这些算法通过学习大量的汉语语料库,能够自动地识别和划分出汉语句子中的词汇,同时可以对不同词性词义进行标注,从而提高了汉字处理的准确度和效率。

其次,内容分析法是指通过对文本内容进行分析,获取其中的相关信息和规律,并进行各种应用研究的一种方法。

具体来说,内容分析法可以包括主题分析、情感分析、文本分类、关键词提取等多个方面。

其中,情感分析是其中的一种重要应用。

它能够通过对文本中情感词汇的分析和统计,确定文本的正面、负面和中性情感类型,并进行情感倾向的评价和预测。

主题分析则是通过对文本中的主题进行分析和提取,从而确定文本的主要话题和热点。

关键词提取则是通过对文本中的关键词进行统计和挖掘,从而找出文本中的重要内容和核心词汇。

总之,汉语自动分词和内容分析法是汉语自然语言处理技术的两大重要方向。

它们在信息检索、舆情分析、自动翻译等多个领域都有着广泛的应用。

随着人工智能技术的不断改进和发展,汉语自然语言处理技术也将会逐步普及和应用到我们的生活中。

国内中文自动分词技术研究综述

国内中文自动分词技术研究综述中文自动分词技术是自然语言处理领域的一项重要技术,对于中文文本的机器翻译、信息提取、文本分类等应用具有重要意义。

本文将对国内中文自动分词技术的研究进行综述,包括研究现状、研究方法、研究成果和不足等方面。

中文自动分词技术是指将一段中文文本自动分割成一个个独立的词语,是中文自然语言处理的基础性工作。

相较于英文等拼音文字,中文分词更为复杂,需要考虑上下文语义、词义歧义等问题。

因此,中文自动分词技术的研究具有重要的实际应用价值。

随着国内人工智能和自然语言处理技术的不断发展,中文自动分词技术的研究也取得了长足的进步。

目前,国内中文自动分词技术的研究主要集中在以下几个方面:基于规则的分词方法:该方法主要依靠人工制定的分词规则进行分词,适用于特定领域的文本。

然而,由于规则的制定需要大量的人力物力,且难以覆盖所有领域的文本,因此该方法的使用存在一定的局限性。

基于统计的分词方法:该方法通过机器学习算法对大量文本进行学习,从而得到词语之间的统计关系,实现自动分词。

该方法具有良好的通用性,可以适应不同领域的文本。

基于深度学习的分词方法:该方法利用深度学习模型对文本进行逐字逐词的预测,从而得到最佳的分词结果。

该方法具有强大的自适应能力,可以处理各种类型的文本。

虽然国内中文自动分词技术已经取得了很大的进展,但是仍然存在一些不足之处,主要表现在以下几个方面:分词精度有待提高:目前的中文自动分词技术还存在一定的误差,可能会对后续的自然语言处理任务产生一定的影响。

因此,提高分词精度是中文自动分词技术的一个重要研究方向。

未充分考虑上下文信息:中文词语的划分往往需要考虑上下文信息,而当前的中文自动分词技术往往只考虑了单个词语本身的信息,导致分词结果不够准确。

因此,利用上下文信息进行中文自动分词是未来的一个重要研究方向。

缺乏标准化评估:目前中文自动分词技术的评估还没有形成一个统一的标准化评估方法,不同的研究机构和应用场景可能采用不同的评估方法,这使得比较不同方法的优劣变得困难。

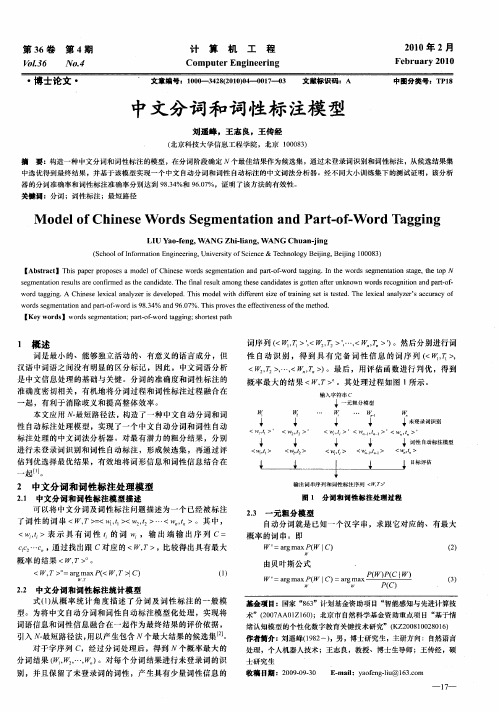

中文分词和词性标注模型

[ ywod ]wod eme tt n pr o- r g ig so et ah Ke r s rs g nai ; a —f s o t wodt gn ;h r sp t a t

1 概 述

词 是 最 小 的、 能 够 独 立 活 动 的 、 有 意义 的语 言 成 分 ,但 汉 语 中词 语 之 间没 有 明显 的 区 分 标 记 , 因此 ,中 文词 语 分 析

s g n a i n r s t r o fr e st a di ae Th n l e ul a n e e c n i a e s g t n a t ru kn wn wo d e o n t n a d p r— f e me tto e ul a e c n m d a hec n d t e f a s t mo g t s a d d t si o t f n o r s r c g ii n a o - s i i r h e e o t wo d t g i g. Ch n s e i a nay e s d v l p d h sm o e t fe e tsz fta n n e st s e .Th e ia nay e ’ c u a y o r a g n A i e e l x c la l z r i e e o e .T i d lwih di r n i e o i i g s ti e t d f r e l x c la l z r Sa c r c f wo d e m e t t n a — f wo d i 8 3 % a d 9 0 % Th sp o e h fe tv ne sof h t o . r ss g n a i a d p r o - r s9 . 4 on t n 6.7 i r v st e e f c i e s e me h d t

中文nlp的基本流程

中文nlp的基本流程自然语言处理(NLP)是一项涉及计算机科学、人工智能和语言学等多个领域的交叉学科。

它旨在使计算机能够理解、处理和生成自然语言,以便与人类进行有意义的交流。

中文NLP作为NLP的一个分支,其研究对象是中文语言,其基本流程包括文本预处理、分词、词性标注、命名实体识别、句法分析、语义分析等多个步骤。

本文将详细介绍中文NLP的基本流程。

一、文本预处理文本预处理是NLP的第一步,其目的是将原始文本转换为可供后续处理的文本格式。

中文NLP中的文本预处理包括以下几个方面:1. 文本清洗:删除文本中的HTML标签、特殊符号、停用词等无用信息,保留文本中的有用信息。

2. 文本分段:将文本按照段落进行分段,以便后续处理。

3. 文本分句:将文本按照句子进行分句,以便后续处理。

4. 繁简转换:将繁体中文转换为简体中文,以便后续处理。

二、分词分词是中文NLP的重要一环,其目的是将中文文本按照词语进行划分。

中文分词的难点在于中文词语没有明显的分隔符,因此需要使用专门的分词工具进行处理。

中文分词的常用工具包括jieba、THULAC、HanLP等。

例如,对于下面这句话:“我喜欢中文NLP”,使用jieba进行分词后,可以得到以下结果:我喜欢中文 NLP三、词性标注词性标注是将分词后的词语赋予相应的词性标记。

中文的词性标记包括名词、动词、形容词、副词、介词、连词、助词、叹词等。

中文词性标注的常用工具包括jieba、THULAC、HanLP等。

例如,对于下面这句话:“我喜欢中文NLP”,使用jieba进行分词和词性标注后,可以得到以下结果:我/r 喜欢/v 中文/n NLP/eng四、命名实体识别命名实体识别是将文本中的具有特定意义的实体(如人名、地名、组织机构名等)进行识别和分类。

命名实体识别是中文NLP中的一个重要任务,其应用广泛,如信息抽取、机器翻译、问答系统等。

中文命名实体识别的常用工具包括jieba、THULAC、HanLP等。

claws c7分词标注规则

Claws C7是一个用于自然语言处理的分词标注工具,它可以帮助实现中文语言文本的自动分词和标注。

在本文中,将介绍Claws C7的分词标注规则,帮助读者理解该工具的使用和应用。

一、Claws C7简介Claws C7是一个经过训练的分词标注器,它使用隐马尔可夫模型(Hidden Markov Model,HMM)来对中文文本进行分词和词性标注。

该工具基于大规模的中文语料库进行训练,可以对不同领域的中文文本进行准确的分词和标注。

二、分词标注规则1. 词性标注在Claws C7中,词性标注采用了国际通用的标注集,包括动词、名词、形容词、副词、介词、连词、代词等常见词性。

这些词性标注可以帮助用户理解文本中词语的语法功能和语义特征。

2. 分词规则Claws C7根据中文语言的特点,设计了一系列分词规则,包括基于词典的最大匹配法、基于规则的逆向最大匹配法等。

这些规则可以帮助工具对文本进行有效的分词,避免出现歧义和错误。

3. 模型训练Claws C7的分词标注规则还包括了模型训练的相关规定。

用户可以根据自己的需求,使用不同领域的语料库对模型进行重新训练,以提高对特定领域文本的分词和标注准确率。

三、应用实例Claws C7的分词标注规则在自然语言处理、信息检索、机器翻译等领域具有广泛的应用。

通过合理的分词和词性标注,可以帮助计算机系统理解和处理中文文本,提高文本处理的准确性和效率。

四、总结Claws C7的分词标注规则是该工具实现自动分词和标注的核心技术之一。

这些规则的合理设计和灵活应用,为中文文本处理提供了重要的支持和保障。

在今后的研究和应用中,可以进一步深入研究该工具的分词标注规则,推动中文自然语言处理技术的发展和应用。

五、分词标注的挑战与未来发展尽管Claws C7在分词标注方面取得了许多成就,但仍然面临一些挑战。

其中之一是歧义识别和处理。

中文语言中存在许多多音字和多义词,这给分词标注带来了一定的困难。

自然语言处理必备知识点

自然语言处理必备知识点自然语言处理(Natural Language Processing,简称NLP)是人工智能领域的一个重要分支,旨在使计算机能够理解和处理人类语言。

它涉及多个学科领域,包括计算机科学、语言学、数学和统计学等。

1. 分词与词性标注分词是将一段连续的自然语言文本切分成基本的语义单位——词。

词性标注则是为每个词标注其词性,如名词、动词、形容词等。

分词和词性标注是NLP中最基础的任务,也是其他任务的基础。

2. 句法分析句法分析是对句子的结构进行分析,确定其中的短语和句法关系。

常见的句法分析方法包括基于规则的分析和基于统计的分析。

句法分析对于理解句子的语法结构和语义关系具有重要意义。

3. 语义分析语义分析旨在理解句子的真实含义,包括词义消歧、指代消解、上下文推断等。

通过语义分析,计算机可以更好地理解人类的意图和需求。

4. 信息抽取信息抽取是从文本中提取结构化信息的过程,如实体识别、关系抽取等。

实体识别可以识别出文本中的人名、地名、组织机构等实体;关系抽取可以提取出实体之间的关系。

5. 机器翻译机器翻译是将一种语言的文本自动翻译成另一种语言的技术。

机器翻译可以基于规则、统计或神经网络等方法进行,其中神经网络机器翻译在近年来取得了显著的进展。

6. 情感分析情感分析旨在识别文本中蕴含的情感倾向,如积极、消极、中性等。

情感分析在社交媒体分析、舆情监控等领域具有广泛应用。

7. 问答系统问答系统旨在回答用户提出的自然语言问题。

问答系统需要对问题进行理解、信息检索、答案生成等多个步骤进行处理。

8. 文本分类文本分类是将文本分为不同类别的任务,如垃圾邮件分类、情感分类等。

文本分类可以基于机器学习算法或深度学习模型进行。

9. 语言模型语言模型是对句子的概率分布进行建模的技术。

语言模型能够判断一个句子是否合乎语法,也可以用于机器翻译、语音识别等任务。

10. 语音识别语音识别是将语音信号转换为文本的技术。

中文分词的三种方法

中文分词的三种方法

中文分词是对汉字序列进行切分和标注的过程,是许多中文文本处理任务的基础。

目前常用的中文分词方法主要有基于词典的方法、基于统计的方法和基于深度学习的方法。

基于词典的方法是根据预先构建的词典对文本进行分词。

该方法将文本与词典中的词进行匹配,从而得到分词结果。

优点是准确率较高,但缺点是对新词或专业术语的处理效果不佳。

基于统计的方法是通过建立语言模型来实现分词。

该方法使用大量的标注语料训练模型,通过统计词语之间的频率和概率来确定分词结果。

优点是对新词的处理有一定的鲁棒性,但缺点是对歧义性词语的处理效果有限。

基于深度学习的方法是利用神经网络模型进行分词。

该方法通过训练模型学习词语与其上下文之间的依赖关系,从而实现分词。

优点是对新词的处理效果较好,且具有较强的泛化能力,但缺点是需要大量的训练数据和计算资源。

综上所述,中文分词的三种方法各自具有不同的优缺点。

在实际应用中,可以根据任务需求和资源条件选择合适的方法进行处理。

例如,在自然语言处理领域,基于深度学习的方法在大规模数据集的训练下可以取得较好的效果,可以应用于机器翻译、文本分类等任务。

而基于词典的方法可以适用于某些特定领域的文本,如医药领

域或法律领域,因为这些领域往往有丰富的专业词汇和术语。

基于统计的方法则可以在较为通用的文本处理任务中使用,如情感分析、信息抽取等。

总之,中文分词方法的选择应根据具体任务和数据特点进行灵活调整,以期获得更好的处理效果。

北京大学本科生毕业论文-自动标注汉语多音词

本科生毕业论文题目:自动标注汉语多音词Automatic Tagging of Chinese Polyphony Word and Related Research姓名:何辉辉学号:00748250院系:信息科学技术学院专业:计算机科学与技术指导教师:段慧明二〇二二年三月二十三日摘要汉语中存在着一字多音现象,很多高频字都具有两种或更多的读音,而这些多音字的读音并没有统一的规则可循。

汉语多音词的自动标注,即将汉字序列转换成相应的拼音序列,是语音合成(TTS)系统的关键步骤。

由于汉语文化的多义性和上下文相关性等原因,目前的汉语注音系统很难达到100%的正确率。

本文研究了多音词的读音规律,总结了中文分词和词性标记的相关技术;设计了汉语多音词的注音系统,重点研究词性标记串的注音问题;本系统由Java 语言和MySQL数据库设计,采用统计与规则相结合的注音方法,通过不断完善总词表,尽可能提高注音准确率。

从测试结果来看,系统对于封闭测试的正确率达到95.2%,基本满足现有要求,具有良好的实用性;随着数据库的逐渐完善,正确率还将不断提高。

关键词:汉语多音词;词性标记;自动注音;统计与规则。

Automatic Tagging of Chinese Polyphony Word and Related ResearchAbstractIn Chinese, there are many frequently used characters, which have more than one pronunciation, and how to automatically tag those characters correctly is a key step in TTS system. However, because the pronunciation of a certain character is related to its context and may have ambiguity, it's very hard to find a universal rule. As a result, current systems can hardly achieve a 100% precision.This thesis researched the law on Chinese polyphone words’ pronunciation, and summarized the related techniques on Chinese segmentation and POS tagging. In our work, we designed a pinyin tagging system, which was designed by Java and MySQL database, to focus on the problem after POS tagging. We proposed an algorithm that combined the traditional statistical method and heuristic rules to achieve a better result. Moreover, we also conducted extensive experiments, and the result showed that it can achieve accuracy of 95.2%; with the improvement of word database, its accuracy will continually increase.Key words:Chinese Polyphony Word; POS Tagging;Automatic Tagging; Statistics and Rules.目录摘要 (2)Abstract (3)第一章绪论 (5)1.1问题背景和研究意义 (5)1.2 发展现状 (5)1.3 本文组织结构 (6)第二章汉字读音 (6)2.1 多音字与多音词 (6)2.2 汉语读音分类 (7)2.3 汉语读音规律 (7)第三章分词与词性标注 (9)3.1 分词定义 (9)3.2 现有分词技术 (9)3.3 N元模型 (11)3.4 词性标注定义 (11)3.5 词性标注技术 (11)3.6 隐马尔可夫模型 (13)第四章汉语拼音标注 (15)4.1 标音定义 (15)4.2 现有拼音标注技术 (15)4.3规则与统计相结合的注音方法 (16)第五章多音词注音系统的实现 (17)5.1 注音系统简介 (17)5.2 开发环境 (17)5.3数据库表结构 (17)5.4 注音流程 (19)5.5 功能测试 (20)第六章总结与展望 (21)参考文献 (22)致谢 (23)第一章绪论1.1问题背景和研究意义随着计算机和Internet网络技术在全球范围内的飞速发展,计算机应用日益渗透到人们日常生活的各个方面;而语言的高效交流,是社会正常运作的基础。

bert-chinese-wwm-ext中文文本分词

bert-chinese-wwm-ext中文文本分词中文文本分词是自然语言处理中一项重要的任务,其目标是将连续的中文文本切分成有意义的词语。

中文的特点是没有明确的词语边界,即字与字之间没有空格或其他显式的分隔符。

而分词是将连续的中文文本切分成有意义的最小单位,对于后续的文本处理和分析任务具有重要影响。

在中文分词中,一种常用的方法是基于字典的方法。

该方法通过构建用词典进行匹配的方式实现分词。

具体流程如下:1.构建词典:收集大规模的中文文本,将文本中的词语整理成词典。

词典可以包含单个字和多个字的词语。

2.分词:对于待分词的文本,按照从左到右的顺序,依次在词典中寻找最长的匹配词语。

如果匹配成功,则将该词语切分出来;如果匹配不成功,则将当前字符切分成单字后继续进行匹配。

3.歧义处理:中文分词中常常存在歧义,即一个字可以属于多个词语。

因此在分词过程中,需要使用一些策略来处理歧义。

常用的策略包括最大匹配、最小匹配、最长匹配等。

4.进一步处理:分词后的结果往往还需要进一步的处理,例如去除停用词、词性标注、命名实体识别等。

以上是基于字典的分词方法的基本过程。

然而,该方法也存在一些问题,例如词典的完备性、歧义处理的准确性等。

为了解决这些问题,近年来另一种基于机器学习的方法日益流行。

BERT-Chinese-WWM-Ext是一种基于深度学习的中文分词模型,它是在预训练模型BERT的基础上增加了WordPiece标记化策略。

BERT是由Google在2018年提出的一种预训练模型,它在大规模的无监督数据上进行训练,可以学习到词语的上下文信息和语义关系。

而WordPiece是一种将中文文本拆分成子词的策略,可以有效处理未登录词和歧义问题。

BERT-Chinese-WWM-Ext模型的基本流程如下:1.预训练:使用大规模无监督数据,在BERT模型上进行预训练,学习到词语的上下文信息和语义关系。

2. Fine-tuning:在预训练的基础上,使用有监督的分词数据对模型进行微调。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

– 大量同音字、同音詞語,化成書面多可消除 歧義。

– 單字多義項者占53.6%(如「打」字之義項數

為26) ;詞組/合成詞多義項者僅占0.46%。

2020/5/30

6

漢字字義組合結構

• 向心性字組 Vs. 離心性字組

– 冰山,青山,火山,高山(核心字在後) Vs. 山峰,山城,山溝, 山村(核心字在前)

多義詞 義項號 搭配類別(L/R)

頻次

註:頻次表示在本次標注語料中該搭配出現的次數

– 根據統計數據自動調整學習進度,逐漸增加上下窗口 長度來學到儘可能多的搭配。

– 打-B01:毆打,攻打→打倒∣打擊∣打架∣… ∣打手 – 打-B02:用手或器具撞擊物體→打鼓∣打火∣… ∣敲

鑼打鼓 –鼓-A01:打擊樂器→鼓板∣鼓槌∣打鼓∣…∣重振旗鼓 –鼓-A02:發動,激起→鼓動∣鼓舞∣… ∣鼓足幹勁

2020/5/30

11

自組織的漢語詞義排歧方法-步驟1

• 以<現代漢語辭海>提供的搭配實例作為多義詞的 初始搭配知識庫,無需人工標注初始語料,用適當 的統計和自組織方法做訓練並自動擴大搭配集。

• 建立基於語義類的語言模型,為語音識別、手寫體 識別和音字轉換提供幫助。

2020/5/30

3

詞義自動標注 ( Word Sense Tagging )

• 也稱為詞義自動排歧 ( Word Sense Disambiguation )

– 計算機運用邏輯運算與推理機制,對出現在一定上下 文中詞語的語義進行正確的判斷,自動確定其正確的 義項並加以標注的過程。

– 語義編碼:是用符號代表語義,關注的是語言 所能表達的意義,每種語言都有自己的語義系 統。漢語和英語屬於不同的語系,前者屬於漢藏語系,

後者屬於印歐語系。

2020/5/30

5

語言的編碼

• 漢語語義編碼的基本符號是“字”

– 漢語的語義主要附著在“字”上。字義排歧 是詞義標注之突破點。

– 濃縮形音義,多為形聲字,表音亦表意,望 文生義,如:吠。

– 在初始搭配知識庫中,每個條目的包含訊息可描述為

多義詞 義項號 搭配類別(L/R) 搭配示例

2020/5/30

12

自組織的漢語詞義排歧方法-步驟2

• 在學習過程中逐漸增大上下文窗口長度來保證高 可靠性。

– 選擇上下文的訊息時應儘量選取與當前詞存在語法有 關係的那些詞,濾掉上下文中多數與其不存在語法關 係的詞。

• 詞典釋義文本中的某個「義項號」

• 義類詞典中相映的「義類編碼」

2020/5/30

2

詞義排歧

• 處理一詞多義現象

– 例:大學是教育機構是一本古書,博士既是官名,又是 博學多才的人,又是師傅,還是一種學位的名稱。

• 使用詞義標注文本可提高檢索時的查全率和查準率。

• 有利於選擇可以恰當表達語句中詞的目標詞,以提 高翻譯的準確性。

– 在給定的多義詞上下文內,尋找與初始搭配庫匹配的 搭配實例,若匹配成功則標上對應的義項標記。

– 初始標注時限定上下文窗口長度為2,表選擇該詞的

前後兩個詞。

2020/5/30

13

自組織的漢語詞義排歧方法-步驟3

• 透過建立搭配統計表來實現多元詞義歧義的排歧

– 按一定原則從與料庫中取得排歧過程中需要的各種可 能搭配和統計數據。每個條目包含的訊息可描述為:

– 各語義場間互相有著同義(好看Vs.華麗) 、反義(善良 Vs.凶惡) 、類義(大雨Vs.暴雨) 、聯義(同情Vs.同情心; 哭Vs.淚人兒)等語義關係。

– 同一個語義場包含”1.同義;2.反義;3.類義” 三種 語義關係

– 跨語義場就是聯義

2020/5/30

10

基於字義排歧的模型-MTD說明

• MTD由MDR-1透過機器自動生成詞組之義項代 碼,如”打-B02 鼓-A01”

• 並列字組 Vs. 主從字組

– 關閉,左右,上下,陰陽(二字相同相近相反) Vs. 火車,汽車, 黑板,白版(前字從,後字主)

• 合義(國+務→國務)33%、加義(景+物→可供觀賞的景 緻和事務)56.7%、同義(聲+音→聲;音)、偏義(厚+度 →厚≠度;容+易→易≠容)、轉義(目+光 = 眼睛+光線 →

• 多義詞排歧

– 主要依據該多義詞出現的上下文,排歧的過程就是建 立他們之間的聯繫過程,這種聯繫則是詞語間的語義 聯繫。

• 常見方法

– 人工智能法、基於詞典的方法、基於語料庫的方法

2020/5/30

4Leabharlann 語言的編碼• 分為語音編碼和語義編碼兩大類 – 語音編碼:用符號代表語音,一種語言區別於 其他語言的根本區別就是其不同的語音音素編 碼。就英語而言有英音,美音,澳音,新西蘭音等。

2020/5/30

8

基於字義排歧的模型-MRD1說明

• MRD-1讀入<現代漢語通用辭典>,用來作為 標注每個漢字的義項號。

– “打(da3)”在MRD-1中有25個義項,分別為

– 打-B01:毆打,攻打;打-B02:用手或器具撞 擊物體;打-B03:做,從事;打-B04:表示身 體上的某些動作;……打-B25:器皿,蛋類因撞 擊而破碎。

綱要

• 詞義標注

• 詞義排歧

• 詞義自動標注 與 詞義自動排歧

• 語言的編碼

• 漢字字義組合結構

• 基於字義排歧的模型

• 自組織的漢語詞義排歧方法

• 結語

2020/5/30

1

詞義標注

• 對文本中的每個詞根據其所屬之上下文給出它 的語義編碼

– 指用非文字的東西來表示文字消息的內容,用圖畫、 樂譜等都可以進行語義編碼。

– “打(da2)”在MRD-1中記為

– 打-A01:量詞,12個叫一打。

2020/5/30

9

基於字義排歧的模型-MRD2說明

• MRD-2讀入<同義詞詞林>,編排方式以詞義為 主兼顧詞類詞,多義詞則分別收入不同詞群

– 以12個語義場(人,物,時間,空間,抽象事物,性質,動作,心理,活動 狀態,關聯,助詞)之不同層次與大小來分類。

見識)

少量字義推大量詞義成為可能!

2020/5/30

7

基於字義排歧的模型

• 資源:三台機器 + 兩部詞典

– MRD-1讀入<現代漢語通用字典> – MRD-2讀入<同義詞詞林> – MTD由MDR-1透過機器自動生成

• 以字義定詞義的語義標注方式準確率在80%以上 • 遭遇困難處

– 二字詞之多義詞排歧 – 單字本身意義抽象、廣泛、模糊,成詞時描述也困難 – 如何將詞義間之關係建構成完整的意念表達仍須努力