基于遗传算法的数据分类系统—决策树算法

数据挖掘之遗传规划

遗传规划(genetic programming)和决策树(classification tree)关于遗传规划方法,给我的资料中以剑桥大学Dempster和Jones的文章介绍的原理和方法比较全面和清晰(使用遗传规划方法的实时自适应交易系统,A real-time adaptive trading system using genetic programming),以下就我的理解说明这种方法的问题。

遗传规划总结出来的交易规则可以用决策树表达,它只是决策树中的一个,这个决策树和我们直接用穷举法得到的分类效果最好的决策树相比在训练数据上肯定是逊色的。

(除了中国人写的论文之外,我没有搜索到一篇实证说明遗传算法在训练数据上表现更好的)从分类思想上遗传规划的方法也是把自变量空间划分成多个长方形,它和决策树的根本思想是一致的。

不同的是遗传规划是用遗传杂交的方式选择更好的规则,而决策树是用穷举的方式计算出来最好的规则。

实际上对于我们的问题,穷举不费事(我的软件的分类树算法使用了一个很简单的小技巧基本解决了这个问题)。

遗传规划借鉴的遗传筛选方法是不确定性算法,需要花费长时间才可以接近最优解。

对交易规则的选择只有在花费大量时间的情况下才接近最佳规则。

遗传规划选择最优规则的可行域小于或等于实际的可行域。

使用论文中固定二进制长度的进化方式,例如0.3<RSI<0.7这样的规则条件就很难实现。

如果不固定长度,算法要复杂得多且这个搜索花费的时间应很长。

我的想法是:它只是探索中的方法,到实用的阶段可能还需要突破性改进才行。

遗传规划在SAS EM里面没有出现,支持向量机只有在2013年以后的SAS EM里面作为试验性方法(非正规,且非客户端)出现。

我作为学术方面不入流(写算法是一流,哈)的人一会就能发现这些方法的问题,这些方法成熟十几年了都不让出现在正规软件里面,你可以想象顶级专家们对这两种方法的看法。

人工智能十大算法总结

人工智能十大算法总结人工智能(Artificial Intelligence,简称AI)是一门涉及模拟和复制人类智能的科学和工程学科。

在人工智能的发展过程中,算法起着至关重要的作用。

算法是用来解决问题的一系列步骤和规则。

下面是人工智能领域中十大重要的算法总结。

一、回归算法回归算法用于预测数值型数据的结果。

常见的回归算法有线性回归、多项式回归、岭回归等。

这些算法通过建立数学模型来找到输入和输出之间的关系,从而进行预测。

二、决策树算法决策树算法是一种基于树形结构的模型,可用于分类和回归问题。

它将数据集拆分成决策节点和叶节点,并根据特征的属性进行分支。

决策树算法易于理解和解释,并且可以处理非线性关系。

三、支持向量机算法支持向量机算法用于分类和回归分析。

它通过在特征空间中构造一个超平面来将样本划分为不同的类别。

支持向量机算法具有高维特征空间的能力和较强的泛化能力。

四、聚类算法聚类算法用于将相似的数据点分组到一起。

常见的聚类算法有K均值聚类、层次聚类等。

聚类算法能够帮助我们发现数据中的模式和结构,从而对数据进行分析和处理。

五、人工神经网络算法人工神经网络是一种类似于生物神经系统的模型。

它由大量的节点和连接组成,可以模拟人脑的学习和推理过程。

人工神经网络算法可以用于分类、识别、预测等任务。

六、遗传算法遗传算法模拟生物进化的原理,通过模拟选择、交叉和变异等操作来寻找最优解。

遗传算法常用于求解复杂优化问题,如旅行商问题、背包问题等。

七、贝叶斯网络算法贝叶斯网络是一种概率图模型,用于表示变量之间的依赖关系。

贝叶斯网络算法可以用于推断和预测问题,如文本分类、诊断系统等。

它具有直观、可解释性强的特点。

八、深度学习算法深度学习是一种基于神经网络的算法,具有多层次的结构。

它可以通过无监督或监督学习来进行模型训练和参数优化。

深度学习算法在图像识别、语音识别等领域取得了显著的成果。

九、马尔科夫决策过程算法马尔科夫决策过程是一种基于状态转移的决策模型。

决策树

预修剪技术

预修剪的最直接的方法是事先指定决策树生长的最 大深度, 使决策树不能得到充分生长。 目前, 许多数据挖掘软件中都采用了这种解决方案, 设置了接受相应参数值的接口。但这种方法要求 用户对数据项的取值分布有较为清晰的把握, 并且 需对各种参数值进行反复尝试, 否则便无法给出一 个较为合理的最大树深度值。如果树深度过浅, 则 会过于限制决策树的生长, 使决策树的代表性过于 一般, 同样也无法实现对新数据的准确分类或预测。

决策树的修剪

决策树学习的常见问题(3)

处理缺少属性值的训练样例 处理不同代价的属性

决策树的优点

可以生成可以理解的规则; 计算量相对来说不是很大; 可以处理连续和离散字段; 决策树可以清晰的显示哪些字段比较重要

C4.5 对ID3 的另一大改进就是解决了训练数据中连续属性的处 理问题。而ID3算法能处理的对象属性只能是具有离散值的 数据。 C4.5中对连续属性的处理采用了一种二值离散的方法,具体 来说就是对某个连续属性A,找到一个最佳阈值T,根据A 的取值与阈值的比较结果,建立两个分支A<=T (左枝)和 A>=T (右枝),T为分割点。从而用一个二值离散属性A (只 有两种取值A<=T、A>=T)替代A,将问题又归为离散属性的 处理。这一方法既可以解决连续属性问题,又可以找到最 佳分割点,同时就解决了人工试验寻找最佳阈值的问题。

简介

决策树算法是建立在信息论的基础之上的 是应用最广的归纳推理算法之一 一种逼近离散值目标函数的方法 对噪声数据有很好的健壮性且能学习析取(命题 逻辑公式)表达式

信息系统

决策树把客观世界或对象世界抽象为一个 信息系统(Information System),也称属性--------值系统。 一个信息系统S是一个四元组: S=(U, A, V, f)

一种基于遗传算法的SVM决策树多分类方法

2 0 01

信 号 处 理

S GNAL I PROCES NG SI

Vo _ 6 l2 .

N .0 o 1

1 O月

0c . t201 0

一

种 基 于 遗传 算 法 的 S M 决 策 树 多分 类 方 法 V

王 一 杨俊安 刘 辉

( .电 子 工 程 学 院 合 肥 2 0 3 ; .安 徽 省 电子 制 约技 术 重 点 实 验 室 合 肥 2 0 3 ) 1 30 7 2 30 7

a c r c a ea h e ei l o t c u a y rt st e g n tca g r hm t s u c in,t e t h l fg n tc ag rt m , a n h p i lde so r e,a d i i f ne sf n to h n wih te heபைடு நூலகம் o e e i l oih we c n f d t e o tma cii n te i n

A src : R c nl , ntef lso m c i ann , o ou es p o e tr c ief ut c s o jc ls f ai bt t a e e t i ed f a hn l rig h w t s u p r v co mahn rm l —l s be t cas ct n y h i ee t o i a s i i o

的分类 精度和更短的分类时 间。 关键词 :支持 向量机 ;遗传算法 ;决策树

中图分类号: N 5・ T 991

文献标 识码 :A

文 章编号 :10 — 50 2 1 ) 0 19 - 5 0 3 0 3 (0 0 1— 4 5 0

基于乳腺癌数据的分类方法比较

基于乳腺癌数据的分类方法比较乳腺癌是女性最常见的恶性肿瘤之一,也是导致女性死亡原因中排名第二的疾病。

由于乳腺癌的早期症状不明显,许多患者在确诊时已经进入晚期,因此,开发有效的分类方法对于乳腺癌的早期筛查和治疗至关重要。

在本文中,将比较目前常用的乳腺癌数据分类方法,探讨其应用和优劣。

首先,基于机器学习算法的乳腺癌数据分类方法是目前主流研究领域之一。

机器学习算法可以自动从大量数据中学习,并通过训练模型来预测新的数据。

这些算法包括朴素贝叶斯、支持向量机、决策树等。

朴素贝叶斯算法基于贝叶斯定理,通过计算特征之间的联合概率来进行分类。

支持向量机算法通过在高维特征空间中寻找一个最优超平面来进行分类。

决策树算法则是通过对数据的各种属性进行递归分割,构建一个树形结构,从而实现分类。

这些算法都可以通过使用开源编程库,如Scikit-learn等来实现,方便快捷。

其次,基于深度学习算法的乳腺癌数据分类方法正在成为研究热点。

深度学习算法是一种通过多层神经网络进行数据建模和分析的方法。

与传统机器学习算法相比,深度学习算法可以更好地处理大规模数据和复杂的非线性关系。

在乳腺癌数据分类中,深度学习算法可以自动学习相关特征,并从中提取出更有区分度的特征来实现分类。

常用的深度学习算法包括卷积神经网络、循环神经网络和深度信念网络等。

这些算法通过在大规模数据上进行训练,不断调整网络参数,从而达到更准确的分类结果。

另外,基于遗传算法和优化算法的乳腺癌数据分类方法也是研究的一项重要工作。

遗传算法是一种通过模拟自然选择和遗传变异的过程来寻找最优解的算法。

在乳腺癌数据分类中,可以将分类问题转化为一个优化问题,通过遗传算法来搜索最佳的分类器参数,从而实现高准确率的分类。

此外,模拟退火算法、粒子群优化算法等也可以应用于乳腺癌数据分类中。

这些算法通过不断迭代和搜索来优化分类器的性能,逐步逼近最优解。

然而,各种基于乳腺癌数据的分类方法各有其优劣。

机器学习算法通常具有较好的可解释性和较低的计算复杂度,但对于一些非线性关系的建模能力较弱。

人工智能常用算法

人工智能常用算法在当今数字化和信息化的时代,人工智能(Artificial Intelligence,简称AI)正逐渐渗透进我们的生活,在各个领域发挥着巨大的作用。

而作为实现人工智能的核心技术,算法起到了决定性的作用。

本文将介绍一些人工智能常用的算法,包括决策树算法、神经网络算法、遗传算法以及支持向量机算法。

一、决策树算法决策树算法是一种基于树状结构的分类与回归分析方法。

它通过构建一个树形模型来描述数据的决策规则,从而实现对数据的分类或预测。

决策树算法的核心思想是根据一系列的判断条件对数据进行划分,直到达到最终的分类结果。

决策树算法的优点是结果易于理解和解释,适用于处理具有缺失值的数据,且可以处理多分类问题。

然而,决策树算法也存在着容易产生过拟合、对噪声敏感等问题。

二、神经网络算法神经网络算法又称为人工神经网络(Artificial Neural Network,简称ANN),它是一种模拟人类神经系统信息处理过程的数学模型。

神经网络算法由多个称为神经元的节点组成,通过模拟神经元之间的连接和传递信息的方式来实现对数据的学习和分类。

神经网络算法的优点是可以对非线性问题进行建模,并且具有较强的自适应能力。

然而,神经网络算法也存在着计算复杂性高、需大量训练样本等问题。

三、遗传算法遗传算法是模拟达尔文生物进化论中的自然选择和遗传机制的一种优化算法。

通过定义适应度函数,遗传算法通过模拟个体的繁殖、变异和选择等过程来进行优化搜索,从而找到最优解。

遗传算法的优点是适用于各种类型的问题,能够在复杂的搜索空间中找到较好的解决方案。

然而,遗传算法也存在着运算速度较慢、可能陷入局部最优等问题。

四、支持向量机算法支持向量机算法是一种基于统计学习理论的二分类模型。

支持向量机算法通过在特征空间上构建最优超平面来实现对数据的分类。

它通过定义支持向量和间隔最大化的原则来寻找最优分类超平面。

支持向量机算法的优点是能够处理高维空间的数据,且具有较强的泛化能力。

数据挖掘十大经典算法

数据挖掘十大经典算法数据挖掘是通过分析大量数据来发现隐藏的模式和关联,提供商业决策支持的过程。

在数据挖掘中,算法起着至关重要的作用,因为它们能够帮助我们从数据中提取有用的信息。

以下是十大经典的数据挖掘算法:1.决策树算法:决策树是一种基于分层选择的预测模型,它使用树状图的结构来表示决策规则。

决策树算法适用于分类和回归问题,并且可以解释性强。

常用的决策树算法有ID3、C4.5和CART。

2.朴素贝叶斯算法:朴素贝叶斯是一种基于概率的分类算法,它假设特征之间是相互独立的。

朴素贝叶斯算法简单有效,适用于大规模数据集和高维数据。

3.支持向量机(SVM)算法:SVM是一种针对分类和回归问题的监督学习算法,它通过构建一个最优的超平面来实现分类。

SVM在处理非线性问题时使用核函数进行转换,具有较强的泛化能力。

4.K近邻算法:K近邻是一种基于实例的分类算法,它通过找到与目标实例最接近的K个邻居来确定目标实例的类别。

K近邻算法简单易懂,但对于大规模数据集的计算成本较高。

5.聚类算法:聚类是一种无监督学习算法,它将相似的实例聚集在一起形成簇。

常用的聚类算法有K均值聚类、层次聚类和DBSCAN等。

6.主成分分析(PCA)算法:PCA是一种常用的降维算法,它通过线性变换将原始数据转换为具有更少维度的新数据。

PCA能够保留原始数据的大部分信息,并且可以降低计算的复杂性。

7. 关联规则算法:关联规则用于发现项集之间的关联关系,常用于市场篮子分析和推荐系统。

Apriori算法是一个经典的关联规则算法。

8.神经网络算法:神经网络是一种模仿人脑神经元通信方式的机器学习算法,它能够学习和适应数据。

神经网络适用于各种问题的处理,但对于参数选择和计算量较大。

9.随机森林算法:随机森林是一种基于决策树的集成学习算法,它通过建立多个决策树来提高预测的准确性。

随机森林具有较强的鲁棒性和泛化能力。

10.改进的遗传算法:遗传算法是一种模拟生物进化过程的优化算法,在数据挖掘中常用于最优解。

AI技术在故障预测中的应用技巧

AI技术在故障预测中的应用技巧一、引言故障预测是工业生产和设备维护中一个重要的环节,它能够帮助企业及时发现潜在的故障风险,并采取相应的措施进行修复和预防。

近年来,人工智能技术(AI)的快速发展为故障预测领域带来了新的机遇和挑战。

本文将探讨AI技术在故障预测中的应用技巧,并介绍相关算法和方法。

二、AI技术在故障预测中的常用算法1.支持向量机(Support Vector Machine,SVM)支持向量机是一种常见的监督学习算法,在故障预测中具有广泛应用。

该算法通过构建一个高维特征空间,在各个特征之间寻找最优边界,将数据集划分为不同类别。

对于故障预测问题,可以使用SVM对历史数据进行分类,并利用模型对未来可能出现故障的情况进行预测。

2.人工神经网络(Artificial Neural Network,ANN)人工神经网络是一种灵活且适应性强的模型,能够模拟生物神经元之间的相互作用。

在故障预测中,人工神经网络能够通过训练学习,获得数据之间的复杂关系,并进行预测。

通过使用适当的结构和算法优化,人工神经网络可以有效地处理多种类型的故障预测问题。

3.决策树(Decision Tree)决策树是一种基于树状模型的算法,能够对数据进行分类和预测。

在故障预测中,决策树可以通过将数据集分割为不同的子集来确定最佳分类规则,并生成一棵树结构来进行故障分类。

该方法简单易懂,且具有较好的解释性。

4.遗传算法(Genetic Algorithm)遗传算法是一种模拟进化过程的启发式搜索算法,在故障预测领域具有较高的应用价值。

该算法通过模拟自然选择和遗传机制,对问题空间进行搜索和优化。

遗传算法在故障预测中可以用于特征选择、参数优化等方面,提高模型的精度和准确性。

三、AI技术在故障预测中的应用技巧1. 数据采集与处理有效的数据采集与处理是实现准确故障预测的基础。

这包括选择合适的传感器和监测设备,确保数据质量,并进行数据预处理,如去除异常值、填补缺失值等。

人工智能算法原理解密

人工智能算法原理解密

人工智能算法是人工智能领域的核心组成部分,它们赋予计算

机系统智能和研究的能力。

本文将介绍几种常见的人工智能算法原理,包括决策树算法、神经网络算法和遗传算法。

决策树算法

决策树算法是一种基于树状结构的分类方法。

它通过一系列的

决策规则将输入数据分为不同的类别。

决策树算法基于一种自顶向

下的递归分割策略,通过选择最优特征和划分样本集来构建决策树

模型。

决策树算法简单直观,易于理解和解释,适用于处理具有离

散属性的数据。

神经网络算法

神经网络算法是一种模拟人类大脑神经系统的计算模型。

它由

多个神经元(节点)和它们之间的连接(边)组成。

神经网络算法

通过训练来调整连接权重,从而实现对输入数据的模式识别和研究。

神经网络算法适用于处理具有复杂特征关系和连续属性的数据。

遗传算法

遗传算法是一种模拟自然进化过程的优化算法。

它通过模拟生物遗传、变异和适应的过程来搜索最优解。

遗传算法基于群体的优胜劣汰机制,通过随机生成初始种群,并不断进化产生更优解。

遗传算法通常用于解决复杂的优化问题和搜索空间较大的情况。

小结

人工智能算法原理解密包括决策树算法、神经网络算法和遗传算法。

决策树算法通过决策规则分割数据集,神经网络算法模拟大脑神经系统进行模式识别和研究,而遗传算法则模拟生物遗传进化进行优化。

这些算法在不同情景下都有着广泛的应用,为人工智能的发展做出了重要贡献。

参考文献:

- {参考文献1}

- {参考文献2}。

基于决策树和遗传算法的模糊分类系统设计

第36卷增刊(I)2006年7月 东南大学学报(自然科学版)JOURN AL OF SO UTHEAST UNI VERSITY (Natural S cience Edition )Vol 136S up (I)July 2006基于决策树和遗传算法的模糊分类系统设计张 永 吴晓蓓 向峥嵘 胡维礼(南京理工大学自动化学院,南京210094)摘要:提出一种基于决策树初始化和遗传算法优化的模糊分类系统的设计方法.该方法首先采用分类和递归树(CART )算法进行决策树的生长,树的修剪过程简化了初始决策树;然后,把修剪后的决策树转化为模糊模型,利用匹茨堡型实数编码的遗传算法优化该模糊模型.为了提高模型的解释性,在遗传算法中利用基于相似性的模型简化方法对模型进行约简.最后利用该方法对I ri s 问题进行研究,仿真结果验证了该方法的有效性.关键词:模糊分类系统;决策树;分类和递归树算法;遗传算法;解释性中图分类号:TP273 文献标识码:A 文章编号:1001-0505(2006)增刊(I )20023204Design of fuzzy classi f ication systemba sed on decision 2tr ee and genetic algor ithmZhang Y ong Wu Xiaobei Xiang Zhengrong Hu Weili(S chool of Aut om ation ,Nanjing Univers it y of S cience and Technology ,Nanji ng 210094,C hina)Abstract : An appr oach to construct t he fuzzy classification system based on the deci sion 2tree and the geneticalg or ithm i s pr oposed.F irst ,the initial deci sion 2tree is constructed usi ng the classification and regression tree (CART )algorithm ;tree pruning pr ocess reduces the initial decision 2tree.S ec ondly ,the pruned deci sion 2tree is trans formed into a fuz zy system ,and the parameters of t he fuzzy system are optimized by the P ittsburgh 2style real 2coded genetic alg orithm.I n order to improve the i nterpretability of the fuzzy system ,the similarity 2driven rule based simplification technique is used to reduce the fuzzy system.The pr oposed appr oach is applied to the I ris benchmark classification pr oblem ,and the results verify its validity.K ey w or ds : fuz zy classification system ;deci sion 2tree ;classification and regression tree algorithm ;geneticalgorithm ;interpretability 收稿日期622 基金项目国家自然科学基金资助项目(63) 作者简介张永(6—),男,博士生,zy63@;胡维礼(联系人),男,教授,博士生导师,@j 模糊集合理论由Z adeh 提出后,在仿真、分类、数据挖掘、模式识别、预测及控制等方面得到了广泛的应用.早期的模糊建模主要针对简单系统,采用总结专家经验的方式进行,得到的模糊模型容易被人们所理解.对于复杂系统,由于难以获得完备的专家知识,而数据相对容易获得,因此基于数据的精确性和解释性模糊建模成为研究的热点[1-3].基于数据精确性和解释性的模糊建模,主要包括2个步骤:①初始模糊模型的构建;②模糊模型的优化.初始模糊模型的构建方法主要有3种:栅格法[1],模糊聚类法[2],和决策树法[3].其中基于决策树的方法,首先根据训练数据进行初始决策树的生长,树的修剪算法简化所获得的初始决策树,该过程不需要人为过多介入,并且可以进行输入变量的选择,有效地缓解了维数灾难问题.本文首先采用C ART [4]算法进行初始决策树的生长;然后,把修剪后的决策树转化为模糊模型,利用匹茨堡型实数编码的遗传算法整体优化该模糊模型的参数,提高其精确性.在遗传算法运行中,基于相似性的模型简化方法有效地保证模型的解释性.利用该方法研究了Iris 分类问题,仿真结果验证了方法的有效性.1 预备知识111 模糊分类系统 考虑维N 类N 样本的分类问题,其中x ∈X ΑR n(x =x ,x ,…,x )为输入变量,{,,…,M }:2000420.:047404.: hw l 1002n .n c 12n g 1g 2g为输出类别,M 为模糊规则数,则模糊分类系统的典型规则形式如下:R i :if x 1i s μi1and x 2i s μi2and …and x n is μin then t he pattern (x 1,x 2,…,x n )belongs to g i with CF i(1)式中,CF i 为第i 条规则的置信度,μi1,μi2,…,μin 为定义在输入论域中的隶属函数,可以取三角形、高斯型、梯形等.本文采用梯形隶数函数:μij (x j )=max min x j -a k b k -a k ,1,d k -x jd k -c k,0(2)参数{a k ,b k ,c k ,d k }(a k ≤b k ≤c k ≤d k )分别代表输入变量x j 的第k 个模糊集合4个角的x 坐标值.对未知样本x k ,模糊分类系统的输出为具备最大激励强度的规则所对应的类别输出:x k ∈g i 3,i3=arg max(βi (x k ))(3)式中,βi 为第i 条规则的激励强度,βi (x k )=∏nj =1μij(x jk).112 模糊模型的解释性与精确性等可以量化的性能指标不同,对于模糊模型的解释性,一般认为,与模型结构、特征变量和模糊规则数目、隶属函数特性等密切相关[5].模糊模型的解释性包括结构的解释性和规则解释性2层含义.结构的解释性是指模型具有较少的规则和输入变量数目,规则之间不存在冗余和矛盾等.规则的解释性是指对单条规则,其前件的隶属函数可区分,易赋予相应的语义项,其后件的结论是可以被理解的.2 解释性与精确性的模糊分类系统211 初始决策树的构建 本文采用C ART 算法构建初始的决策树,该过程主要由以下2部分组成:①决策树的生长;②决策树的剪枝.具体过程参见文献[5].212 决策树转化为模糊模型决策树把输入空间划分为互斥的超立方体,其划分边界是不连续的,往往会因为某个不合理的划分路径导致大量的错误结果.本文采用模糊集合理论处理划分边界的不连续性,模糊集合采用梯形隶属函数,决策树转化为模糊模型步骤如下:1)记录所有从根节点到终节点的路径上分叉点的数值和每个终节点对应的类标g i .2)采用式(2)的梯形隶属函数,假设[m i ,n i ]是输入x i 论域的范围,给定区间[s i ,t i ]Α[m i ,n i ],其中s i ,t i 分别是输入x i 上相邻的2个分叉点的值,且s i <t i ,m i <n i ,区间的长度为w i =t i -s i ,区间[s i ,t i ]上的隶属函数定义如下:若s i =m i ,则μ(x i )=1x i ∈[s i ,s i +018w i ]1-x i -(s i +018w i )014w i x i ∈[s i +018w i ,t i +012w i ](4)若t i =n i ,则μ(x i )=1-t i -018w i -x i014w ix i ∈[s i -012w i ,t i -018w i ]1x i ∈[t i -018w i ,t i ](5)若[s i ,t i ]<[m i ,n i ],则μ(x i )=1-s i +012w i -x i014w ix i ∈[s i -012w i ,s i +012w i ]1x i ∈[s i +012w i ,t i -012w i ]x +11 x ∈[1,+1](6)3)每条规则的置信度F 计算如下42东南大学学报(自然科学版)第36卷1-i -t i 02w i04w i i t i -02w i t i 02w i C i :CF i =∑Nk =1βik f i(x k )∑Nk =1f i(x k)(7)式中,βik =∏nj =1μij (x k ),f i (x k )=1 x k ∈g i 0 x k |g i,i =1,2,…,M 为第i 条规则,j =1,2,…,n 为输入变量维数,k =1,2,…,N 为样本数.213 基于相似性的模糊模型简化经过决策树初始化得到的初始模糊模型或遗传算法随机产生的模糊模型,其模糊集合间可能存在过度的交叉或重叠,因此需要对每个变量的隶属函数进行相似性分析和融合,提高模糊模型的解释性.对模糊集合A 和B ,定义其相似性测度如下[6]:S (A ,B )=∑N k =1[μA(x k)∧μB (x k )]∑Nk =1[μA(x k)∨μB (x k )](8)若2个集合A 和B 的相似性测度大于预先设定的阈值,集合A 和B 可以融合为新的集合C .对于梯形隶属函数A (a 1,a 2,a 3,a 4)和B (b 1,b 2,b 3,b 4),融合生成的新的模糊集合为C (c 1,c 2,c 3,c 4),其中,c 1=mi n(a 1,b 1),c 2=015(a 2+b 2),c 3=015(a 3+b 3),c 4=max(a 4+b 4).阈值的大小直接影响模糊模型的性能,阈值越小,得到的模型的精度越低而解释性越高,一般阈值取[014,017],本文阈值具体取值为014.214 基于遗传算法的模糊模型优化基于遗传算法的模型优化主要解决以下问题:染色体编码;适应度的设置;遗传操作.21411 染色体编码式(1)所示的模糊分类系统,待编码的变量为梯形隶属函数4个角的x 坐标值a ij ,b ij ,c ij ,d ij ,以及模糊规则的置信度CF i ,i 表示第i 条规则,j 表示第j 维输入变量;则每条染色体中共有M (4n +1)个实数,其中,n 为输入变量的维数,第一条染色体的编码为H 1=[a 11,…,d 11,…,a Mn ,…d M n ,CF 1,…,CF M ](9)给定种群规模数为L ,染色体表示为H p (p =1,2,…,L ),给定搜索空间[H min ,H max ]:H min=[a min 11,…,d m in 11,…,a min M n ,…d minM n ,0, 0(10)Hm ax=[a max 11,…,d max 11,…,a max M n ,…d maxMn ,1, (1)(11)a maxij ,b maxij ,c m axij ,d maxij ,a minij ,b minij ,c minij ,d m inij 为对应梯形隶属函数4个角的x 坐标值的最大最小约束值.其余的L-1条染色体,以染色体H 1为中心,在搜索空间内随机均匀生成,从而形成初始种群.21412 适应度函数给定样本变量x k ,其分类误差定义为e k =0如果x k 被正确分类1如果x k 被错误分类(12)则遗传算法的个体适应度函数定义为Fit =∑Nk =1ek(13)21413 遗传操作选用精英保留和轮盘赌相结合的选择操作.为保证种群个体的多样性和算法的有效性,对于交叉和变异操作均给出几种实现方法.交叉操作有:离散交叉,算术交叉和启发式交叉;变异操作有:单点均匀变异和多点均匀变异.在实际的操作过程中,由算法随机选择.3 仿 真I 数据是由四维数据[(S L ),(SW ),(L ),(W )]的5个52增刊(I )张永,等:基于决策树和遗传算法的模糊分类系统设计ris sepal len gth septal wid th petal leng th P petal w id th P 10样本组成,共分为3类,每一类有50个样本.采用CART 算法生长初始决策树,如图1(a)所示:图1 初始决策树及初始决策树对样本的划分图图1(a )中显示sepal length ,septal w idth 二维输入变量在最优决策树中没有经过分叉,是无关的输入变量;图1(b )以petal length 和petal w idth 为坐标,给出了由最优决策树划分样本数据的二维图,其中虚线为决策边界.采用212节方法,图2(a)给出把最优决策树转化为初始模糊模型的隶属函数,其精确性指标为95133%,精确性较差.采用遗传算法优化初始模糊模型.提高其精确性,遗传算法参数如下:种群大小L =40,交叉概率为0185,变异概率为0105,进化代数为200.经过遗传算法优化后,精确性指标为98%,其隶属函数如图2(b)所示.图2 Iris 模糊分类系统隶属函数分布图4 结 语本文提出了一种基于决策树初始化和遗传算法优化的模糊分类系统的设计方法.同时考虑分类的精确性和解释性.首先采用CART 算法进行决策树的生长和剪枝;把剪枝后的决策树转化为模糊模型.然后利用实数编码的遗传算法优化该模糊模型.该方法的优点是:不需要过多的人工介入;可以进行输入变量的选择;最终可获得精确性和解释性较好折中的模糊分类系统.参考文献(References )[1]Ish ibuchi H ,Nakashima T ,Murata T.Performance evaluation of fuzzy class ifier sys tems for multidimensional pattern classi ficationproblems[J ].IEEE Tran s on Sy stem s ,Man ,and Cy bernetics ,Part B ,1999,29(5):6012618.[2]Roubos H ,Setnes M.C ompact and trans parent fu zzy models and classifiers through iterative com plex ity reduction[J ].IE EE Trans onFuzzy Sy stems ,2001,9(4):5162524.[3]Cristina Olaru ,L ouis Weh enkel.A complete fu zzy decisi on tree techn ique[J ].Fu zzy Sets and Sy stems ,2003,138(2):2212254.[]S R ,S T,M z N 2f zzy f [M]N y ,6[5]Y f zzy y [M ]N Y y 2V ,3[6]S M ,B R ,K y U S y f zzy f []I T Sy ,M ,y 2,B ,,(3)3623662东南大学学报(自然科学版)第36卷4Jang J un C i u tan i E.euro u a nd so t co mp uting .ew Jerse :Pren tice Hall 199.Jin .Ad van ced u s stems design and app licatio ns .ew ork :Ph sical erl 200.etnes abuska a mak .im ilarit measures in u rule base s im pli ication J .EEE rans on stems an and C bernetics Part 199828:78.。

aigc常用的算法

aigc常用的算法AIGC常用的算法一、引言在人工智能领域,AIGC(Artificial Intelligence and General Computing)是一种综合性的技术框架,集成了多种算法,用于解决各种问题。

本文将介绍AIGC常用的几种算法,包括神经网络、决策树、遗传算法和聚类算法。

二、神经网络算法神经网络算法是一种仿生学习算法,模拟了人脑神经元之间的连接。

它由多层神经元组成,每层神经元与上下层的神经元相连。

神经网络通过学习大量的样本数据,自动调整神经元之间的连接权重,以实现对输入数据的分类和预测。

神经网络算法在图像识别、语音识别和自然语言处理等领域取得了很大的成功。

三、决策树算法决策树算法是一种基于规则的分类算法,它通过一系列的决策节点和叶节点构成一棵树状结构。

每个决策节点表示一个特征,每个叶节点表示一个类别。

决策树算法通过学习样本数据,自动构建决策树,并根据输入特征的取值沿树结构进行分类。

决策树算法简单易懂,可解释性强,被广泛应用于数据挖掘和机器学习领域。

四、遗传算法遗传算法是一种模拟生物进化过程的优化算法。

它通过模拟遗传操作(交叉、变异和选择)来搜索最优解。

遗传算法首先随机生成一组初始解,然后通过遗传操作对解进行迭代优化,直到满足停止条件。

遗传算法适用于复杂的优化问题,如旅行商问题、机器调度和参数优化等。

五、聚类算法聚类算法是一种将相似对象归类到同一类别的算法。

聚类算法通过计算对象间的相似度,将相似的对象归为一类。

常用的聚类算法有K均值算法和层次聚类算法。

K均值算法将数据集划分为K个簇,层次聚类算法通过不断合并或分裂簇来构建聚类层次。

聚类算法在市场分析、社交网络分析和图像分割等领域有广泛应用。

六、总结本文介绍了AIGC常用的几种算法,包括神经网络、决策树、遗传算法和聚类算法。

这些算法在不同领域都有广泛的应用,可以用于解决分类、回归、优化和聚类等问题。

选择合适的算法对于解决具体问题非常重要,需要根据问题的特点和数据的特征来选择最合适的算法。

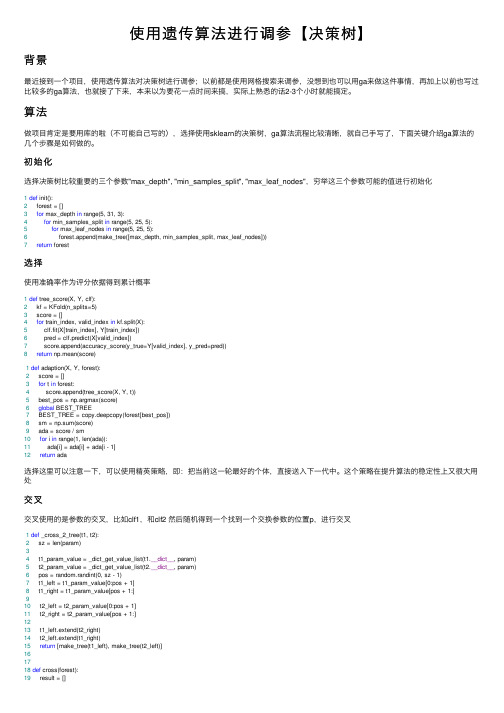

使用遗传算法进行调参【决策树】

使⽤遗传算法进⾏调参【决策树】背景最近接到⼀个项⽬,使⽤遗传算法对决策树进⾏调参;以前都是使⽤⽹格搜索来调参,没想到也可以⽤ga来做这件事情,再加上以前也写过⽐较多的ga算法,也就接了下来,本来以为要花⼀点时间来搞,实际上熟悉的话2-3个⼩时就能搞定。

算法做项⽬肯定是要⽤库的啦(不可能⾃⼰写的),选择使⽤sklearn的决策树,ga算法流程⽐较清晰,就⾃⼰⼿写了,下⾯关键介绍ga算法的⼏个步骤是如何做的。

初始化选择决策树⽐较重要的三个参数"max_depth", "min_samples_split", "max_leaf_nodes",穷举这三个参数可能的值进⾏初始化1def init():2 forest = []3for max_depth in range(5, 31, 3):4for min_samples_split in range(5, 25, 5):5for max_leaf_nodes in range(5, 25, 5):6 forest.append(make_tree([max_depth, min_samples_split, max_leaf_nodes]))7return forest选择使⽤准确率作为评分依据得到累计概率1def tree_score(X, Y, clf):2 kf = KFold(n_splits=5)3 score = []4for train_index, valid_index in kf.split(X):5 clf.fit(X[train_index], Y[train_index])6 pred = clf.predict(X[valid_index])7 score.append(accuracy_score(y_true=Y[valid_index], y_pred=pred))8return np.mean(score)1def adaption(X, Y, forest):2 score = []3for t in forest:4 score.append(tree_score(X, Y, t))5 best_pos = np.argmax(score)6global BEST_TREE7 BEST_TREE = copy.deepcopy(forest[best_pos])8 sm = np.sum(score)9 ada = score / sm10for i in range(1, len(ada)):11 ada[i] = ada[i] + ada[i - 1]12return ada选择这⾥可以注意⼀下,可以使⽤精英策略,即:把当前这⼀轮最好的个体,直接送⼊下⼀代中。

基于遗传算法的决策树优化模型

维普资讯

第 l卷 7

第 3期

计 算 机 技 术 与 发 展

COM P UTER TECHN(1 ). 0GY AND DEVEL 0PM旺NT

20 0 7年 3月

v( _ 7 No. ) 1 l 3 Ma . 2 0 r 07

基 于遗传 算 法 的决 策树 优化 模 型

Th o e f De i i n Tr e Ba e n Ge tc Alo ne i g r t m

基于决策树的分类算法

基于决策树的分类算法1 分类的概念及分类器的评判分类是数据挖掘中的⼀个重要课题。

分类的⽬的是学会⼀个分类函数或分类模型(也常常称作分类器),该模型能把数据库中的数据项映射到给定类别中的某⼀个。

分类可⽤于提取描述重要数据类的模型或预测未来的数据趋势。

分类可描述如下:输⼊数据,或称训练集(training set)是⼀条条记录组成的。

每⼀条记录包含若⼲条属性(attribute),组成⼀个特征向量。

训练集的每条记录还有⼀个特定的类标签(类标签)与之对应。

该类标签是系统的输⼊,通常是以往的⼀些经验数据。

⼀个具体样本的形式可为样本向量:(v1,v2,…,…vn:c)。

在这⾥vi表⽰字段值,c表⽰类别。

分类的⽬的是:分析输⼊数据,通过在训练集中的数据表现出来的特性,为每⼀个类找到⼀种准确的描述或者模型。

这种描述常常⽤谓词表⽰。

由此⽣成的类描述⽤来对未来的测试数据进⾏分类。

尽管这些未来的测试数据的类标签是未知的,我们仍可以由此预测这些新数据所属的类。

注意是预测,⽽不能肯定。

我们也可以由此对数据中的每⼀个类有更好的理解。

也就是说:我们获得了对这个类的知识。

对分类器的好坏有三种评价或⽐较尺度:预测准确度:预测准确度是⽤得最多的⼀种⽐较尺度,特别是对于预测型分类任务,⽬前公认的⽅法是10番分层交叉验证法。

计算复杂度:计算复杂度依赖于具体的实现细节和硬件环境,在数据挖掘中,由于操作对象是巨量的数据库,因此空间和时间的复杂度问题将是⾮常重要的⼀个环节。

模型描述的简洁度:对于描述型的分类任务,模型描述越简洁越受欢迎;例如,采⽤规则表⽰的分类器构造法就更有⽤。

分类技术有很多,如决策树、贝叶斯⽹络、神经⽹络、遗传算法、关联规则等。

本⽂重点是详细讨论决策树中相关算法。

2 基于决策树的数据分类算法及其性能2.1 ID3和C4.5算法决策树技术是⽤于分类和预测的主要技术,决策树学习是以实例为基础的归纳学习算法。

它着眼于从⼀组⽆次序、⽆规则的事例中推理除决策树表⽰形式的分类规则。

数据挖掘中解决分类问题的方法

数据挖掘中解决分类问题的方法数据挖掘作为一种广泛应用于各行各业的数据分析技术,其目的是通过自动或半自动的方法从大量数据中发现隐藏的模式、趋势和规律,以帮助用户做出更好的决策。

在数据挖掘的过程中,分类问题是一种常见的任务,其目标是将数据集中的实例划分到不同的类别或标签中。

为了解决分类问题,数据挖掘领域涌现出了许多方法和算法,本文将着重介绍几种常用的方法,并深度探讨它们的原理和应用。

1. 决策树算法决策树是一种常用的分类方法,其模型呈树状结构,每个内部节点表示一个属性上的测试,每个分支代表一个测试输出,而每个叶节点代表一种类别。

在构建决策树的过程中,通常采用信息增益或基尼指数等指标来选择最优的属性进行划分,直到所有的实例都被正确分类或者树的规模达到一定的限制为止。

决策树算法简单直观,易于理解和解释,因此在实际应用中得到了广泛的应用。

2. 支持向量机(SVM)支持向量机是一种二分类模型,其基本模型是定义在特征空间上的间隔最大的线性分类器。

在实际应用中,通过引入核函数,支持向量机可以处理非线性分类问题。

支持向量机的优点在于对小样本数据集有较好的泛化能力,适用于高维空间的数据分类。

然而,支持向量机对参数的选择和核函数的设计较为敏感,需要谨慎调参才能获得较好的分类效果。

3. 朴素贝叶斯算法朴素贝叶斯是一种基于贝叶斯定理和特征条件独立假设的分类方法。

在朴素贝叶斯算法中,首先根据训练数据估计各个类别的先验概率和特征的条件概率,然后利用贝叶斯定理求取后验概率,最终选择具有最大后验概率的类别作为分类结果。

朴素贝叶斯算法简单高效,对缺失数据不敏感,在处理文本分类等问题时表现出色。

4. K近邻算法K近邻算法是一种基本的分类和回归方法,其基本思想是如果一个样本在特征空间中的k个最相似的样本中的大多数属于某一个类别,则该样本也属于这个类别。

在K近邻算法中,需要事先确定k的取值和距离度量方式。

K近邻算法简单易实现,对异常值不敏感,适用于多类分类问题。

缺陷检测与识别的九种机器学习算法比较研究

缺陷检测与识别的九种机器学习算法比较研究近年来,随着人工智能技术的高速发展,机器学习算法得到了越来越广泛的应用。

在制造业领域,缺陷检测和识别是重要的一环。

机器学习算法可以对制造过程中的缺陷进行检测和识别,提高产品的质量和生产效率。

在本文中,我们将对九种机器学习算法在缺陷检测和识别中的表现进行比较研究。

一、朴素贝叶斯算法朴素贝叶斯算法是一种基于概率论的分类算法,它能够在给定一组特征的情况下,计算出一个数据属于某个类别的概率。

由于朴素贝叶斯算法的计算速度比较快,所以在大规模数据集上有优势。

但是,朴素贝叶斯算法假设各特征独立,因此对于存在相关性的特征集合,效果可能不佳。

二、K近邻算法K近邻算法是一种基于实例的分类算法,其核心思想是利用训练数据集中已知类别的数据与待分类的数据进行对比,根据它们之间的距离进行分类。

K近邻算法的优点是简单,易于理解和实现。

但是在大规模数据集上,它的计算代价比较大,而且对于离群点比较敏感。

三、决策树算法决策树算法是一种基于树形结构的分类算法,它将数据集从根节点开始逐步分类,一直到叶节点,每个叶节点代表一个类别。

决策树算法易于理解和解释,同时也能够处理多分类问题。

但是,在处理连续型特征时,决策树算法需要进行离散化操作,可能会损失原始数据的信息。

四、支持向量机算法支持向量机算法是一种二分类算法,它通过将数据映射到高维空间,寻找最优的超平面来分割数据集。

找到最优的超平面意味着得到了最大的分类间隔,从而能够提高分类的准确性。

支持向量机算法对于非线性的分类问题也有良好的效果。

但是,在大规模数据集上,支持向量机算法的计算代价比较大。

五、逻辑回归算法逻辑回归算法是一种分类算法,它通过将线性回归的结果映射到0和1之间,来处理二分类问题。

逻辑回归算法能够给出一个概率估计,表明待分类数据属于某个类别的可能性。

逻辑回归算法的优点是计算速度较快,而且能够输出概率值。

但是对于多分类问题需要进行一些变形处理。

2020年国家开放大学《人工智能》专题 形考任务二参考答案

2020年国家开放大学《人工智能》专题形考任务二参考答案判断题现实世界中的规划问题需要先调度,后规划。

×启发式规划的两种方法是减少更多的边或者状态抽象。

×语义网络的表示方法只能表示有关某一事物的知识,无法表示一系列动作、一个事件等的知识。

×下图表示的是前向状态空间搜索。

√人们需要把分类器学习的样本的特点进行量化,这些量化后的数据,如鸢尾花的高度、花瓣的长度、花瓣的宽度等就是鸢尾花的特征。

这些特征都是有效的,可以提供给分类器进行训练。

×状态空间图是对一个问题的表示,通过问题表示,人们可以探索和分析通往解的可能的可替代路径。

特定问题的解将对应状态空间图中的一条路径。

√贝叶斯定理是为了解决频率概率问题提出来的。

×深度学习是计算机利用其计算能力处理大量数据,获得看似人类同等智能的工具。

√分层规划中包含基本动作和高层动作。

√谓词逻辑是应用于计算机的逻辑形式,其逻辑规则、符号系统与命题逻辑是一样的。

×P(A∣B)代表事件A发生的条件下事件B发生的概率。

×人工智能利用遗传算法在求解优化问题时,会把问题的解用“0”和“1”表示。

0,1就是就是“遗传基因”,01组成的字符串,称为一个染色体或个体。

√选择题人们想让智能机器分辨哪个动物是熊猫,就会输入一些数据告诉机器。

如图上所示的“大大的脑袋,黑白两色,黑眼眶,圆耳朵”,这些属于(特征值)。

贝叶斯网络是(朱迪亚·珀尔)首先提出来的。

遗传算法具有(生存+检测)的迭代过程的搜索算法。

也就是说,通过群体的一代代的不断进化,最终收敛到“最适应环境”的个体,从而求得问题的最优解或满意解。

(多选)在A* 算法中,当我们找寻当前节点的相邻子节点时,需要考虑(如果该子节点已经在Open列表中,则我们需要检查其通过当前节点计算得到的F值。

如果比它原有计算的F值更小。

如果更小则更新其F值,并将其父节点设置为当前节点。

人工智能的25种算法和应用场景

人工智能的25种算法和应用场景人工智能(Artificial Intelligence,简称AI)是指通过模拟人类智能行为的方法和技术使机器能够像人类一样感知、理解、学习、推理和决策的能力。

在人工智能领域,算法是实现智能的核心元素之一。

下面将介绍人工智能的25种算法及其应用场景。

1. 逻辑回归算法:逻辑回归算法是一种用于解决分类问题的算法,常用于金融风控、电商推荐等场景。

2. 决策树算法:决策树算法通过将数据集划分为一系列的分类条件,用于解决分类和回归问题。

应用场景包括医学诊断、客户流失预测等。

3. 随机森林算法:随机森林算法是一种基于决策树的集成学习方法,通过组合多个决策树来提高模型的准确性与鲁棒性。

常用于信用评分、疾病预测等领域。

4. 支持向量机算法:支持向量机算法是一种用于解决分类和回归问题的算法,可处理线性和非线性问题。

应用场景包括语音识别、图像识别等。

5. 隐马尔可夫模型算法:隐马尔可夫模型算法用于描述具有潜在不可观察状态的动态过程。

应用场景包括语音识别、自然语言处理等。

6. K均值聚类算法:K均值聚类算法将数据分为K个不重叠的簇,常用于客户分群、图像分割等领域。

7. 线性回归算法:线性回归算法用于解决回归问题,通过拟合一个线性模型来预测目标变量的值。

应用场景包括股票价格预测、销售预测等。

8. K最近邻算法:K最近邻算法基于样本之间的距离度量来进行分类,常用于图像识别、推荐系统等。

9. 神经网络算法:神经网络算法模拟人脑的神经网络结构,通过多层的神经元进行学习与预测。

应用场景包括人脸识别、自动驾驶等。

10. 深度学习算法:深度学习算法是一种基于多层神经网络的机器学习方法,通过学习多层次的特征表示来实现智能。

应用领域包括自然语言处理、图像识别等。

11. 遗传算法:遗传算法模拟物种遗传和进化过程,通过优胜劣汰的机制来搜索最优解。

常用于布局优化、参数优化等。

12. 蚁群算法:蚁群算法模拟蚂蚁觅食的行为,通过信息素的传递和挥发来搜索最优解。

遗传算法在决策树生成中的应用与效果

遗传算法在决策树生成中的应用与效果近年来,随着人工智能技术的飞速发展,决策树成为了数据挖掘和机器学习领域中最常用的算法之一。

然而,传统的决策树生成算法在处理大规模数据集和复杂问题时往往效果不佳。

为了克服这些问题,研究者们开始尝试将遗传算法应用于决策树的生成过程中。

遗传算法是一种模拟自然进化过程的优化算法,其基本思想是通过模拟生物进化的方式,通过选择、交叉和变异等操作来搜索最优解。

在决策树生成中,遗传算法可以用于优化决策树的结构和参数,从而提高决策树的泛化能力和预测准确性。

首先,遗传算法可以用于选择最优的特征子集。

在传统的决策树生成算法中,通常会使用所有的特征来构建决策树,但是这样往往会导致决策树过于复杂,容易过拟合。

通过遗传算法,可以从所有的特征中选择出最优的子集,从而减少特征的维度,提高决策树的泛化能力。

其次,遗传算法可以用于优化决策树的结构和参数。

传统的决策树生成算法通常使用启发式算法来选择最优的划分属性和划分点,但是这种方法往往只能得到局部最优解。

通过遗传算法,可以全局搜索最优的划分属性和划分点,从而得到更好的决策树结构。

此外,遗传算法还可以用于优化决策树的剪枝参数,从而提高决策树的泛化能力。

最后,遗传算法可以用于解决决策树生成中的多目标优化问题。

在实际应用中,决策树的生成往往涉及到多个目标,如准确率、叶子节点数目等。

传统的决策树生成算法通常只能优化单个目标,而无法同时考虑多个目标。

通过遗传算法,可以将多个目标进行组合,通过适应度函数的设计,可以得到一组非劣解,从而提供决策树生成过程中的多种选择。

综上所述,遗传算法在决策树生成中具有广泛的应用和良好的效果。

通过选择最优的特征子集、优化决策树的结构和参数,以及解决多目标优化问题,遗传算法可以提高决策树的泛化能力和预测准确性。

然而,遗传算法也存在一些问题,如计算复杂度较高、参数设置困难等。

因此,在实际应用中,需要根据具体问题和数据集的特点来选择合适的算法和参数,以达到最好的效果。

决策树算法在医疗诊断决策中的效果评估

决策树算法在医疗诊断决策中的效果评估随着人工智能在医疗行业的快速发展,决策树算法逐渐成为重要的工具之一。

决策树是一种基于树状结构的有监督学习算法,可用于分类和回归问题。

在医疗诊断决策中,决策树算法具有一系列优点,如解释性强、易于理解和实现、较好的处理非线性数据等。

本文将探讨决策树算法在医疗诊断决策中的效果评估。

首先,决策树算法在医疗诊断中的应用范围广泛。

在医学领域,医生通常需要依据患者的症状和病情进行诊断并制定相应的治疗方案。

决策树算法通过构建一个树状模型来帮助医生进行决策,准确识别患者的疾病类型和选择最佳治疗方案。

这种算法可以应用于多个医疗领域,如肿瘤诊断、心脏病分型、糖尿病风险评估等。

其次,决策树算法在医疗诊断中的效果评估具有重要意义。

在应用决策树算法进行医疗诊断决策之前,我们需要对算法的性能进行评估。

常见的评估指标包括准确率、召回率、精确度和F1值等。

准确率是指正确分类的样本数与总样本数之比,召回率是指分类正确的正样本数与实际正样本数之比,精确度是指正确分类的正样本数与分类为正的样本数之比,F1值是精确度和召回率的调和平均数。

为了评估决策树算法的性能,我们可以使用交叉验证、混淆矩阵和ROC曲线等方法。

交叉验证是一种常用的评估方法,通过将数据集分为训练集和测试集,利用训练集训练模型,再利用测试集验证模型的性能。

混淆矩阵是一个表格,用于展示分类模型的性能。

它将预测结果划分为真阳性、真阴性、假阳性和假阴性四个类别,可用于计算各种评估指标。

ROC曲线是绘制真阳性率(TPR)与假阳性率(FPR)之间的关系图,可以用于评估分类器的性能。

在实际应用中,决策树算法在医疗诊断中已经取得了不少突破。

以肿瘤诊断为例,决策树算法可以利用患者的病理数据、基因信息和临床特征等来预测肿瘤的类型和恶性程度。

研究表明,决策树算法在肿瘤诊断中具有较高的准确率和召回率,能够快速、准确地对患者的病情做出判断。

此外,决策树算法还可以结合其他算法,如遗传算法和支持向量机等,进一步提高诊断的准确性和稳定性。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

中文摘要基于遗传算法的数据分类系统—决策树算法摘要决策树方法最早产生于上世纪60年代,到70年代末。

由J Ross Quinlan提出了ID3算法,此算法的目的在于减少树的深度。

但是忽略了叶子数目的研究。

C4.5算法在ID3算法的基础上进行了改进,对于预测变量的缺值处理、剪枝技术、派生规则等方面较大改进,既适合于分类问题,又适合于回归问题。

决策树构造的输入是一组带有类别标记的例子,构造的结果是一棵二叉树或多叉树。

二叉树的内部节点(非叶子节点)一般表示为一个逻辑判断,如形式为a=aj的逻辑判断,其中a是属性,aj是该属性的所有取值:树的边是逻辑判断的分支结果。

多叉树(ID3)的内部结点是属性,边是该属性的所有取值,有几个属性值就有几条边。

树的叶子节点都是类别标记。

关键词:决策树;遗传算法;系统目录1引言 (1)1.1决策树的构造方法 (1)2决策树是以实例为基础的归纳学习算法 (1)2.1ID3算法 (2)2.2C4.5算法 (2)2.3SLIQ算法 (3)2.3.1 预排序 (3)2.3.2 广度优先策略 (3)2.4SPRINT算法 (3)3执行系统 (4)4 评价系统--组桶式算法 (6)5执行系统 (6)5.1群体的变化 (7)5.2个体的适应度 (7)5.3突变操作 (7)参考文献 (8)致谢 (9)1引言决策树方法最早产生于上世纪60年代,到70年代末。

由J Ross Quinlan提出了ID3算法,此算法的目的在于减少树的深度。

但是忽略了叶子数目的研究。

C4.5算法在ID3算法的基础上进行了改进,对于预测变量的缺值处理、剪枝技术、派生规则等方面作了较大改进,既适合于分类问题,又适合于回归问题。

决策树方法最早产生于上世纪60年代,到70年代末。

由J Ross Quinlan提出了ID3算法,此算法的目的在于减少树的深度。

但是忽略了叶子数目的研究。

C4.5算法在ID3算法的基础上进行了改进,对于预测变量的缺值处理、剪枝技术、派生规则等方面作了较大改进,既适合于分类问题,又适合于回归问题。

1.1决策树的构造方法决策树构造的输入是一组带有类别标记的例子,构造的结果是一棵二叉树或多叉树。

二叉树的内部节点(非叶子节点)一般表示为一个逻辑判断,如形式为a=aj的逻辑判断,其中a是属性,aj是该属性的所有取值:树的边是逻辑判断的分支结果。

多叉树(ID3)的内部结点是属性,边是该属性的所有取值,有几个属性值就有几条边。

树的叶子节点都是类别标记。

由于数据表示不当、有噪声或者由于决策树生成时产生重复的子树等原因,都会造成产生的决策树过大。

因此,简化决策树是一个不可缺少的环节。

寻找一棵最优决策树,主要应解决3个最优化问题:生成最少数目的叶子节点、生成的每个叶子节点的深度最小、生成的决策树叶子节点最少且每个叶子节点的深度最小。

2决策树是以实例为基础的归纳学习算法它从一组无次序、无规则的元组中推理出决策树表示形式的分类规则。

它采用自顶向下的递归方式,在决策树的内部结点进行属性值的比较,并根据不同的属性值从该结点向下分支,叶结点是要学习划分的类。

从根到叶结点的一条路径就对应着一条合取规则,整个决策树就对应着一组析取表达式规则。

1986年Quinlan提出了著名的ID3算法。

在ID3算法的基础上,1993年Quinlan又提出了C4.5算法。

为了适应处理大规模数据集的需要,后来又提出了若干改进的算法,其中SLIQ (super-vised learning in quest)和SPRINT (scalable parallelizableinduction of decision trees)是比较有代表性的两个算法。

2.1 ID3算法ID3算法的核心是:在决策树各级结点上选择属性时,用信息增益(information gain)作为属性的选择标准,以使得在每一个非叶结点进行测试时,能获得关于被测试记录最大的类别信息。

其具体方法是:检测所有的属性,选择信息增益最大的属性产生决策树结点,由该属性的不同取值建立分支,再对各分支的子集递归调用该方法建立决策树结点的分支,直到所有子集仅包含同一类别的数据为止。

最后得到一棵决策树,它可以用来对新的样本进行分类。

某属性的信息增益按下列方法计算。

通过计算每个属性的信息增益,并比较它们的大小,就不难获得具有最大信息增益的属性。

设S是s个数据样本的集合。

假定类标号属性具有m个不同值,定义m个不同类Ci(i=1,…,m)。

设si是类Ci中的样本数。

对一个给定的样本分类所需的期望信息由下式给出:其中pi=si/s是任意样本属于Ci的概率。

注意,对数函数以2为底,其原因是信息用二进制编码。

设属性A具有v个不同值{a1,a2,……,av}。

可以用属性A将S划分为v个子集{S1,S2,……,Sv},其中Sj中的样本在属性A上具有相同的值aj(j=1,2,……,v)。

设sij是子集Sj中类Ci的样本数。

由A划分成子集的熵或信息期望由下式给出:熵值越小,子集划分的纯度越高。

对于给定的子集Sj,其信息期望为其中pij=sij/sj 是Sj中样本属于Ci的概率。

在属性A上分枝将获得的信息增益是Gain(A)= I(s1, s2, …,sm)-E(A)ID3算法的优点是:算法的理论清晰,方法简单,学习能力较强。

其缺点是:只对比较小的数据集有效,且对噪声比较敏感,当训练数据集加大时,决策树可能会随之改变。

2.2 C4.5算法C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进。

1) 用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足;2) 在树构造过程中进行剪枝;3) 能够完成对连续属性的离散化处理;4) 能够对不完整数据进行处理。

C4.5算法与其它分类算法如统计方法、神经网络等比较起来有如下优点:产生的分类规则易于理解,准确率较高。

其缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。

此外,C4.5只适合于能够驻留于内存的数据集,当训练集大得无法在内存容纳时程序无法运行。

2.3 SLIQ算法SLIQ算法对C4.5决策树分类算法的实现方法进行了改进,在决策树的构造过程中采用了“预排序”和“广度优先策略”两种技术。

2.3.1 预排序对于连续属性在每个内部结点寻找其最优分裂标准时,都需要对训练集按照该属性的取值进行排序,而排序是很浪费时间的操作。

为此,SLIQ算法采用了预排序技术。

所谓预排序,就是针对每个属性的取值,把所有的记录按照从小到大的顺序进行排序,以消除在决策树的每个结点对数据集进行的排序。

具体实现时,需要为训练数据集的每个属性创建一个属性列表,为类别属性创建一个类别列表。

2.3.2 广度优先策略在C4.5算法中,树的构造是按照深度优先策略完成的,需要对每个属性列表在每个结点处都进行一遍扫描,费时很多,为此,SLIQ采用广度优先策略构造决策树,即在决策树的每一层只需对每个属性列表扫描一次,就可以为当前决策树中每个叶子结点找到最优分裂标准。

SLIQ算法由于采用了上述两种技术,使得该算法能够处理比C4.5大得多的训练集,在一定范围内具有良好的随记录个数和属性个数增长的可伸缩性。

然而它仍然存在如下缺点:1)由于需要将类别列表存放于内存,而类别列表的元组数与训练集的元组数是相同的,这就一定程度上限制了可以处理的数据集的大小。

由于采用了预排序技术,而排序算法的复杂度本身并不是与记录个数成线性关系,因此,使得SLIQ算法不可能达到随记录数目增长的线性可伸缩性。

2.4 SPRINT算法为了减少驻留于内存的数据量,SPRINT算法进一步改进了决策树算法的数据结构,去掉了在SLIQ中需要驻留于内存的类别列表,将它的类别列合并到每个属性列表中。

这样,在遍历每个属性列表寻找当前结点的最优分裂标准时,不必参照其他信息,将对结点的分裂表现在对属性列表的分裂,即将每个属性列表分成两个,分别存放属于各个结点的记录。

SPRINT算法的优点是在寻找每个结点的最优分裂标准时变得更简单。

其缺点是对非分裂属性的属性列表进行分裂变得很困难。

解决的办法是对分裂属性进行分裂时用哈希表记录下每个记录属于哪个孩子结点,若内存能够容纳下整个哈希表,其他属性列表的分裂只需参照该哈希表即可。

由于哈希表的大小与训练集的大小成正比,当训练集很大时,哈希表可能无法在内存容纳,此时分裂只能分批执行,这使得SPRINT算法的可伸缩性仍然不是很好。

遗传算法不仅可作为搜索和优化的一种方法,而且还可作为一种机器学习技术。

例如,可以将基于遗传算法的机器学习应用于分类系统。

霍勒德等人将分类系统视为一种认知模型,其可在环境中学习一些简单的串规则(string rules)(又称为分类器),以指导系统的行为。

一个分类系统包含以下三个组成部分:执行系统、评价系统、遗传算法(GA)。

执行系统是最低层的与环境直接交互的子系统,它的作用象一个基于产生式规则的专家系统。

每条规则称为一个分类器。

但这种规则比较简单,其条件和动作部分都是串,起着传递消息的作用。

分类系统的学习是通过系统从环境中获得反馈信息而进行的,即通过评价分类器(规则)的正确性和效率来实现。

这种评价行为由评价系统完成。

其中一种有名的评价方法叫组桶式(bucket brigade)算法。

处于最高层的是遗传算法子系统。

该子系统产生新的规则去替代系统中效率不高的规则。

新规则的产生(发现)方法是利用遗传算法, 根据规则的适应度进行选择、组合和替代。

3执行系统执行系统实际上是一个简单的产生式系统,产生式规则形如:if <条件> then <动作>在分类系统里,规则的条件和动作都是串(以便于GA处理)。

条件部分的串说明了规则所能匹配的消息集合,而动作部分则说明了规则执行时要发送的消息。

为简便起见,设串长为k,由表{0,1,#}中的三种元素组成,其中#表示"不关心"。

条件串中的#表示可与0或1匹配,而动作串中的#表示一种消息传递,即该位的值等于与条件串匹配的消息的对应位值。

例如,设k=4,有规则为:if #10# then 010#若现有消息1101,与规则匹配后,该规则将发送消息0101。

为方便表示,我们可将规则(分类器)的形式改为:<条件>:<动作>在匹配规则时,分类系统采用的是并行激活策略,即所有匹配的规则都执行其动作部分,不存在一般产生式系统中的冲突消解问题。

当然,若在实际应用中,已激活规则的应用必须是互斥的,或对输出(作为规则执行的结果)的消息个数有限定,那么可依据规则(分类器)的评价值作出选用决定(见以后说明)。

执行系统基本上重复执行以下步骤:1、将输入的消息放入消息队列中;2、将消息队列中的所有消息与所有分类器的条件做比较;3、将所有能匹配的分类器所产生的消息放入一个新的消息队列中;4、用新的消息队列取代老的消息队列;5、将消息队列中的消息加以解释并输出。