第3章 线性模型参数的最小二乘估计法

一元线性回归模型的基本假设二、参数的普通最小二乘估计(OLS)

§2.2一元线性回归模型的参数估计一、一元线性回归模型的基本假设二、参数的普通最小二乘估计(OLS)三、参数估计的最大或然法(ML)四、最小二乘估计量的性质五、参数估计量的概率分布及随机干扰项方差的估计单方程计量经济学模型分为两大类:线性模型和非线性模型•线性模型中,变量之间的关系呈线性关系•非线性模型中,变量之间的关系呈非线性关系一元线性回归模型:只有一个解释变量i i i X Y μββ++=10i=1,2,…,nY 为被解释变量,X 为解释变量,β0与β1为待估参数,μ为随机干扰项回归分析的主要目的是要通过样本回归函数(模型)SRF尽可能准确地估计总体回归函数(模型)PRF。

估计方法有多种,其中最广泛使用的是普通最小二乘法(ordinary least squares,OLS)。

为保证参数估计量具有良好的性质,通常对模型提出若干基本假设。

注:实际这些假设与所采用的估计方法紧密相关。

一、线性回归模型的基本假设假设1、解释变量X是确定性变量,不是随机变量;假设2、随机误差项μ具有零均值、同方差和不序列相关性:E(μi)=0i=1,2,…,nVar(μi)=σμ2i=1,2,…,nCov(μi,μj)=0i≠j i,j=1,2,…,n假设3、随机误差项μ与解释变量X之间不相关:Cov(X i,μi)=0i=1,2,…,n假设4、μ服从零均值、同方差、零协方差的正态分布μi~N(0,σμ2)i=1,2,…,n注意:1、如果假设1、2满足,则假设3也满足;2、如果假设4满足,则假设2也满足。

以上假设也称为线性回归模型的经典假设或高斯(Gauss)假设,满足该假设的线性回归模型,也称为经典线性回归模型(Classical Linear Regression Model,CLRM)。

二、参数的普通最小二乘估计(OLS)给定一组样本观测值(X i ,Y i )(i=1,2,…n )要求样本回归函数尽可能好地拟合这组值.普通最小二乘法(Ordinary least squares,OLS )给出的判断标准是:二者之差的平方和∑∑+-=-=ni i i n i X Y Y Y Q 121021))ˆˆ(()ˆ(ββ最小。

用最小二乘法估计模型参数

用最小二乘法估计模型参数最小二乘法是一种参数估计方法,常用于拟合线性回归模型。

该方法通过最小化观测值与模型预测值之间的差异来确定模型的参数。

本文将详细介绍最小二乘法的原理、应用领域以及具体操作步骤,以期为读者提供有关该方法的生动、全面且有实际指导意义的文章。

一、最小二乘法原理最小二乘法最初由法国数学家勒让德于18世纪提出,其核心思想是选择能够最小化观测值与模型预测值之间残差的参数。

残差是观测值与模型预测值之间的差异,这些差异可用来评估模型的拟合程度。

最小二乘法的目标是找到使残差平方和最小化的参数,从而得到最佳拟合效果。

二、最小二乘法的应用领域最小二乘法广泛应用于各个领域,尤其是数理统计学、经济学、工程学和社会科学等领域。

在这些领域,研究人员经常需要通过观测数据来拟合数学模型,并利用最小二乘法来估计模型的参数。

例如,在经济学中,研究人员可以利用最小二乘法来估计市场需求曲线和供应曲线的参数,从而预测市场价格和销售量的变化。

三、最小二乘法的具体操作步骤1. 收集观测数据:首先,需要收集一组相关的观测数据,这些数据是建立数学模型的基础。

2. 选择模型:根据实际问题的需要,选择适当的数学模型来描述观测数据之间的关系。

常见的模型包括线性模型、多项式模型和指数模型等。

3. 确定目标函数:目标函数是最小二乘法的核心,其定义为观测值与模型预测值之间残差的平方和。

通过最小化目标函数,可以找到最佳拟合效果的参数。

4. 求解参数:利用数学方法,对目标函数进行求解,求得最小化目标函数的模型参数。

常用的求解方法包括求导、矩阵运算和数值优化算法等。

5. 模型评估:为了评估拟合效果,需要对模型进行验证。

常用的方法有计算残差平方和、拟合优度和假设检验等。

6. 参数解释和预测:最后,根据所得到的模型参数,解释模型的物理含义,并利用模型进行预测和推断。

通过上述步骤,我们可以利用最小二乘法对观测数据进行拟合,并估计模型的参数。

最小二乘法不仅在理论研究中有重要应用,而且在实际问题的解决中也扮演着重要的角色。

8.2.2 一元线性回归模型参数的最小二乘估计 高二数学(人教A版2019选择性必修第三册)

类似的形状特征.注意到100 m短跑的第一个世界纪录产生于1896年 ,

因此可以认为散点是集中在曲线y f ( t ) c1 c2 ln( t 1895)的周围,

其中c1 , c2为未知的参数 , 且c2 0.

人教A版2019选择性必修第三册

1

学习目标

1.进一步掌握一元线性回归模型参数的统计意义,会用

相关统计软件.

2.了解非线性回归模型.

3.会通过分析残差和利用 R 2 判断回归模型的拟合效果.

环节一:创设情境,引入课题

例 经验表明,一般树的胸径(树的主干在地面以上1.3m处的直径)越大,

树就越高由于测量树高比测量胸径困难,因此研究人员希望由胸径预测树

在图8.2-9中,散点大致分布在一条从左下角到右上角的直线附近,表明

两个变量线性相关,并且是正相关,因此可以用一元线性回归模型刻画

树高与胸径之间的关系.

树高/m

26.0

24.0

22.0

20.0

18.0

胸径/cm

16.0

15.0

20.0

25.0

30.0

图8.2-9

35.0

40.0

45.0

用d 表示胸径, h表示树高, 根据最小二乘法 , 计算可得经验回归方程为

可以借助一元线性回归模型和新的成对数据,对参数c1和c2作出

估计,进而可以得到Y关于t的非线性经验回归方程.

在直角坐标系中画出表8.2-6中成对数据的散点图,如图8.2-14所示,散

点的分布呈现出很强的线性相关特征.

Y c2 x c1 u

因此, 用一元线性回归模型

线性参数的最小二乘法处理

W1、 +1″, +10″, +1″, +12″,

W2、 +6″, +4″,

W3、

W4„

Wn

+2″ , -3″ , +4″ +12″, +4″ +3″, +4″

+12″, +12″, +12″

W12

2

12

W22

2 2

W32

32

最小值

3

即 ∑(PW2)=(P1W21)+(P2W22)+(P3W32)

的测量结果 yi 最接近真值,最为可靠,即: yi=∠i+Wi 由于改正数 Wi 的二次方之和为最小,因此称为最小二乘法。 二 最小二乘法理 现在我们来证明一下,最小二乘法和概率论中最大似然方法(算术平均值方法) 是一致的。 (一)等精度测量时 (1)最大似然方法 设 x1,x2„xn 为某量 x 的等精度测量列,且服从正态分布,现以最大似然法和最小 二乘法分别求其最或是值(未知量的最佳估计量) 在概率论的大数定律与中心极限定理那一章我们讲过,随着测量次数的增加,测 量值的算术平均值也稳定于一个常数,即

2 i 1

n

曾给出: vi2

i 1

n

n n 1 n 2 ,由此可知 x vi2 / i2 为最小,这就是最小二乘法的基本 i n i 1 i 1

含义。引入权的符号 P ,最小二乘法可以写成下列形式:

Pv

i 1

n

2 i i

最小

在等精度测量中, 1 2 ... , P1 P2 ... Pn 即: 最小二乘法可以写成下列形式:

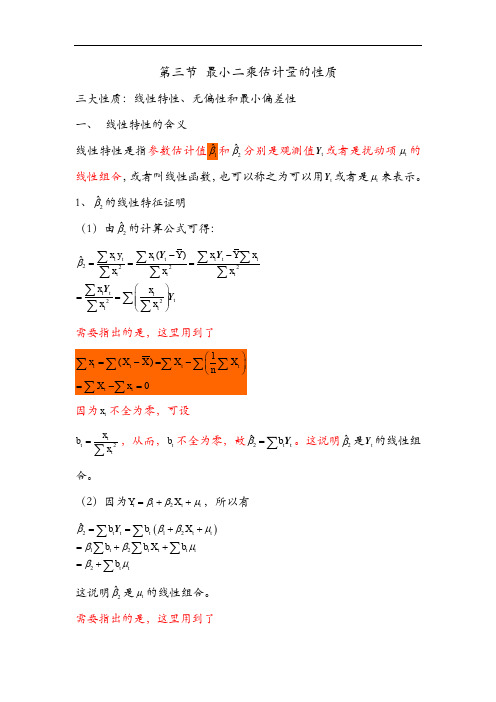

第三节最小二乘估计量的性质

第三节 最小二乘估计量的性质三大性质:线性特性、无偏性和最小偏差性 一、 线性特性的含义线性特性是指参数估计值1ˆβ和2ˆβ分别是观测值t Y 或者是扰动项t μ的线性组合,或者叫线性函数,也可以称之为可以用t Y 或者是t μ来表示。

1、2ˆβ的线性特征证明 (1)由2ˆβ的计算公式可得: 222222()ˆt tttt ttttttt tt tt x y x Y x Y xxx xx x x x β--===⎛⎫== ⎪ ⎪⎝⎭∑∑∑∑∑∑∑∑∑∑∑Y Y Y Y需要指出的是,这里用到了因为t x 不全为零,可设2tt tx b x =∑,从而,t b 不全为零,故2ˆt t b β=∑Y 。

这说明2ˆβ是t Y 的线性组合。

(2)因为12t t t Y X ββμ=++,所以有()212122ˆt t t t t t t t t t t tb b X b b X b b βββμββμβμ==++=++=+∑∑∑∑∑∑Y这说明2ˆβ是t μ的线性组合。

需要指出的是,这里用到了220t t t t t x x b x x ===∑∑∑∑∑以及 ()2222222201t t tt t t tt ttttttttx x X x b X X x x x x X x X x x x x x⎛⎫+⎪== ⎪⎝⎭++==+=∑∑∑∑∑∑∑∑∑∑∑∑∑2、1ˆβ的线性特征证明 (1)因为12ˆˆY X ββ=-,所以有 ()121ˆˆ1t t t t tY X Y X b nXb n ββ=-=-⎛⎫=- ⎪⎝⎭∑∑∑Y Y这里,令1a Xb n=-,则有1ˆt a β=∑Y 这说明1ˆβ是t Y 的线性组合。

(2)因为回归模型为12t t t Y X ββμ=++,所以()11212ˆt t t t t t t t t ta a X a a X a βββμββμ==++=++∑∑∑∑∑Y因为111t t t a Xb X b nn⎛⎫=-=-=⎪⎝⎭∑∑∑∑。

计量经济学第三章 双变量线性回归模型

xtYt

Y

xt

xt2

xt2

xt2

xt2

由于

xt (X t X ) X t X nX nX 0

从而

ˆ xtYt xt ( X t ut )

xt2

xt2

23

ˆ xtYt xt ( X t ut )

xt2

xt2

1 ( xt2

xt

14

残差平方和

我们的目标是使拟合出来的直线在某种意义上是最佳的, 直观地看,也就是要求估计直线尽可能地靠近各观测点,这意

味着应使残差总体上尽可能地小。要做到这一点,就必须用某

种方法将每个点相应的残差加在一起,使其达到最小。理想的 测度是残差平方和,即

et 2 (Yt Yˆt )2

15

最小二乘法

第三章 双变量线性回归模型 (简单线性回归模型)

(Simple Linear Regression Model)

2021/7/22

1

第一节 双变量线性回归模型的估计 第二节 最小二乘估计量的性质 第三节 拟合优度的测度 第四节 双变量回归中的区间估计和假

设检验 第五节 预测 第六节 有关最小二乘法的进一步讨论

9

(3)E(ut2)= 2, t=1,2,…,n 即各期扰动项的方差是一常数,也就是假定各扰

动项具有同方差性。

实际上该假设等同于:

Var( ut) = 2, t=1,2,…,n 这是因为:

Var(ut)=E{[ut-E(ut)]2}= E(ut2) ——根据假设(1)

10

(4) Xt为非随机量 即Xt的取值是确定的, 而不是随机的。 事实上,我们后面证明无偏性和时仅需要解释变量X与扰

是线性估计量。

【高中数学】一元线性回归模型参数的最小二乘估计(第二课时)课件 人教A版2019选择性必修第三册

i

1

i

8

8

i 1

i 1

残差平方和:残差平方和越小,模型拟合效果越好,残差平方和越大,模型拟合效果越差.

可知Q2小于Q1. 因此在残差平方和最小的标准下,

非线性回归模型

Y c2 ln( t 1895) c1 u,

2

E

(

u

)

0

,

D

(

u

)

的拟合效果要优于一元线性回归模型的拟合效果.

下面通过残差来比较这两个经验回归方程对数据刻画的好坏.

用ti表示编号为i的年份数据,用yi表示编号为i的纪录数据,则经验回归方程①和②的残

,;

8

差计算公式分别为 eˆi yi 0.02033743t i 49.76913031,i 1, 2,

eˆi yi 0.4264398( t i 1895) 11.8012653,i 1, 2,

注意点:在含有一元线性回归模型中,决定系数R2=r2.在线性回归模型中有0≤R2≤1,

因此R2和r都能刻画用线性回归模型拟合数据的效果.

|r|越大,R2就越大,线性回归模型拟合数据的效果就越好.

编

号

1

2

3

4

5

6

7

8

t

1896

1912

1921

1930

1936

1956

1960

1968

0.591

-0.284

ˆ 2 = -0.4264398ln( t - 1895) + 11.8012653 ②

x y

在同一坐标系中画出成对数据散点图、非线性经验回归方程②的图像(蓝色)以及经验

最小二乘法求解线性回归问题

最小二乘法求解线性回归问题最小二乘法是回归分析中常用的一种模型估计方法。

它通过最小化样本数据与模型预测值之间的误差平方和来拟合出一个线性模型,解决了线性回归中的参数估计问题。

在本文中,我将详细介绍最小二乘法在线性回归问题中的应用。

一、线性回归模型在介绍最小二乘法之前,先了解一下线性回归模型的基本形式。

假设我们有一个包含$n$个观测值的数据集$(x_1,y_1),(x_2,y_2),\dots,(x_n,y_n)$,其中$x_i$表示自变量,$y_i$表示因变量。

线性回归模型的一般形式如下:$$y=\beta_0+\beta_1 x_1+\beta_2 x_2+\dots+\beta_px_p+\epsilon$$其中,$\beta_0$表示截距,$\beta_1,\beta_2,\dots,\beta_p$表示自变量$x_1,x_2,\dots,x_p$的系数,$\epsilon$表示误差项。

我们希望通过数据集中的观测值拟合出一个线性模型,即确定$\beta_0,\beta_1,\dots,\beta_p$这些未知参数的值,使得模型对未知数据的预测误差最小化。

二、最小二乘法的思想最小二乘法是一种模型拟合的优化方法,其基本思想是通过最小化优化问题的目标函数来确定模型参数的值。

在线性回归问题中,我们通常采用最小化残差平方和的方式来拟合出一个符合数据集的线性模型。

残差代表观测值与模型估计值之间的差异。

假设我们有一个数据集$(x_1,y_1),(x_2,y_2),\dots,(x_n,y_n)$,并且已经选定了线性模型$y=\beta_0+\beta_1 x_1+\beta_2 x_2+\dots+\beta_p x_p$。

我们希望选择一组系数$\beta_0,\beta_1,\dots,\beta_p$,使得模型对数据集中的观测值的预测误差最小,即最小化残差平方和(RSS):$$RSS=\sum_{i=1}^n(y_i-\hat{y}_i)^2$$其中,$y_i$表示第$i$个观测值的实际值,$\hat{y}_i$表示该观测值在当前模型下的预测值。

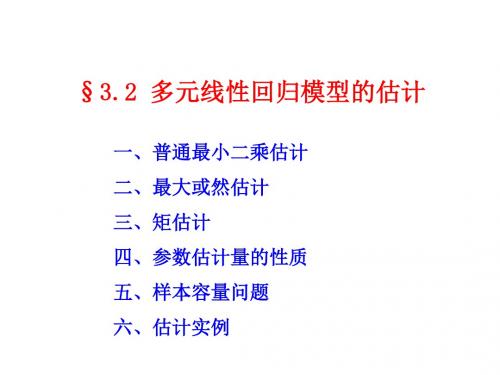

3.2 多元线性模型的参数估计

于(k+1)的矩条件,就是广义矩估计法(GMM)。

四、参数估计量的性质

说明

• 在满足基本假设的情况下,多元线性模型结构

参数的普通最小二乘估计、最大或然估计及

矩估计具有线性性、无偏性、有效性。

• 同时,随着样本容量增加,参数估计量具有渐 近无偏性、渐近有效性、一致性。

工资性收入 X1 30273.0 23231.9 14588.4 16216.4 18377.9 15882.0 14388.3 12525.8 33235.4 21890.0 24453.0 15535.3 21443.4 14767.5 21562.1

14822.0

14704.2

其他收入 X2 15000.8 12423.7 9554.4 7797.2 8600.1 12022.9 9155.9 8623.4 15643.9 13241.0 16788.0 9470.8 11939.3 8181.9 9066.0

• ML必须已知随机项的分布。

2、估计步骤:以一元模型为例

Yi ~ N(ˆ0 ˆ1 X i , 2 )

Yi的分布

P(Yi )

1

e

1

2

2

(Yi

ˆ0

ˆ1

X

i

)

2

2

Yi的概率函数

L(ˆ0 , ˆ1, 2 ) P(Y1,Y2 , ,Yn )

1

e

1

2

i 1

一组矩条件,等同于OLS估计的正规方程组。

3、矩估计法是工具变量方法和广义矩估计法 的基础

• 矩估计利用随机干扰项与各解释变量不相关特性 构造矩条件。

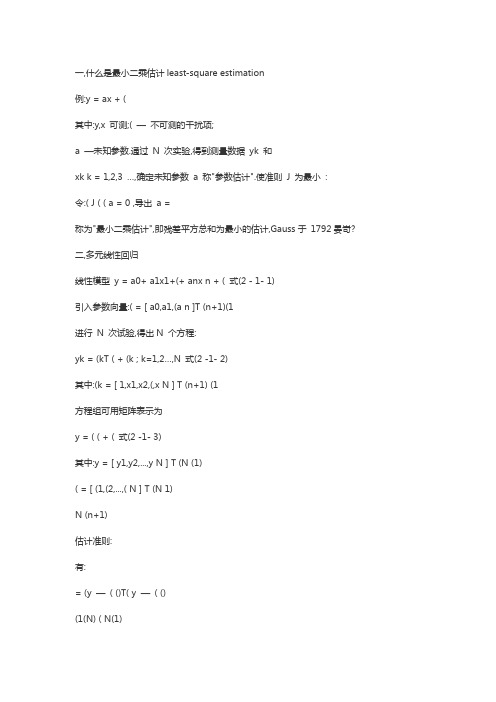

最小二乘估计法

一,什么是最小二乘估计least-square estimation例:y = ax + (其中:y,x 可测;( —不可测的干扰项;a —未知参数.通过N 次实验,得到测量数据yk 和xk k = 1,2,3 …,确定未知参数a 称"参数估计".使准则J 为最小:令:( J ( ( a = 0 ,导出a =称为"最小二乘估计",即残差平方总和为最小的估计,Gauss于1792晏岢? 二,多元线性回归线性模型y = a0+ a1x1+(+ anx n + ( 式(2 - 1- 1)引入参数向量:( = [ a0,a1,(a n ]T (n+1)(1进行N 次试验,得出N 个方程:yk = (kT ( + (k ; k=1,2…,N 式(2 -1- 2)其中:(k = [ 1,x1,x2,(,x N ] T (n+1) (1方程组可用矩阵表示为y = ( ( + ( 式(2 -1- 3)其中:y = [ y1,y2,...,y N ] T (N (1)( = [ (1,(2,...,( N ] T (N 1)N (n+1)估计准则:有:= (y —( ()T( y —( ()(1(N) ( N(1)J = yTy + (T (T ( ( -yT ( ( - (T (T y= yTy + (T (T ( ( - 2 (T (T y 式(2 -1- 4)假设:((T ()(n+1)(n+1) 满秩,由利用线性代数的以下两个矩阵对向量求偏导数的公式:和有:和所以:解出参数估计向量:( Ls =((T ()-1 (T y 式(2 -1- 5)令:P = ((T ()-1 则参数估计向量( Ls = P (T y参数估计向量( Ls 被视为以下"正则方程"的解:((T ()( = (T y 式(2 -1- 6)注:为了便于区别,我们用红体字符表示估计量或计算值,而用黑体表示为参数真值或实际测量值.三,关于参数最小二乘估计Ls 性质的讨论以上求解参数最小二乘估计( Ls 时并为对{ (k }的统计特性做任何规定,这是最小二乘估计的优点.当{ (k }为平稳零均值白噪声时,则( Ls 有如下良好的估计性质:参数最小二乘估计( Ls 是y 的线性估计( Ls = P (T y 是y 的线性表出;b) 参数最小二乘估计( Ls 是无偏估计,即E ( Ls= ( (参数真值)[ 证明]:E ( Ls= E[ P (T y ]= P (T E( y ) = P (T E ( (( + ( ) =P (T ( ( + E( ( ) = ( + 0 = (最小二乘估计( Ls 的估计误差协方差阵是(2P (n+1)(n+1)即:E [ ( ( Ls- ( ) ( ( Ls- ( )T ] = (2P[ 证明]:E [ ( ( Ls - ( ) ( ( Ls - ( )T ] = E [ P (T ( y -( () ( y- ( ()T (P ] = E [ P (T ( (T (P ] = P (T E ( ( (T) (P =P (T (2 IN(N (P = (2P若{ (k }为正态分布零均值白噪声时,则( Ls 是线性无偏最小方差估计(证明从略).如若{ (k }是有色噪声,则( Ls 不具有上述性质,即为有偏估计.四,最小二乘估计( Ls 的的几何意义和计算问题1.最小二乘估计的几何意义最小二乘估计的模型输出值为yk = ( kT ( Ls k = 1,2,…N输出实际测量值与模型输出值之差叫残差:(k = yk –yk模型输出向量为y = ( ( Ls ,而残差向量为:( = y –y = y –( ( Ls(T ( k = (T y –(T (((T ()-1 (T y = (T y –(T y = 0即残差向量( 与由测量数据矩阵( 的各个向量:( 1,( 2 ,…,( N 张成的超平面(估计空间)正交,而最小二乘模型输出向量y 为实际输出向量y 在估计空间上的正交投影,这就是最小二乘估计的几何意义.---------------------------------------------最小二乘法是一种数学优化技术,它通过最小化误差的平方和找到一组数据的最佳函数匹配. 最小二乘法是用最简的方法求得一些绝对不可知的真值,而令误差平方之和为最小.最小二乘法通常用于曲线拟合.很多其他的优化问题也可通过最小化能量或最大化熵用最小二乘形式表达.比如从最简单的一次函数y=kx+b讲起已知坐标轴上有些点(1.1,2.0),(2.1,3.2),(3,4.0),(4,6),(5.1,6.0),求经过这些点的图象的一次函数关系式.当然这条直线不可能经过每一个点,我们只要做到5个点到这条直线的距离的平方和最小即可,这就需要用到最小二乘法的思想.然后就用线性拟合来求.。

最小二乘法参数估计公式

最小二乘法参数估计公式在统计学和经济学中,最小二乘法是一种常用的参数估计方法。

它的目标是找到最能拟合数据的参数值,使得拟合曲线与观测值之间的误差最小。

最小二乘法参数估计公式是最小化误差平方和的一种数学表达方式。

最小二乘法参数估计公式可以用来解决线性回归问题。

线性回归是一种建立因变量与自变量之间关系的模型方法。

在线性回归中,我们假设因变量与自变量之间存在一种线性关系,可以通过最小二乘法来估计线性回归模型的参数。

最小二乘法参数估计公式可以用于求解线性回归模型的截距项和斜率项。

在线性回归模型中,截距项代表了当自变量为零时,因变量的取值;而斜率项代表了因变量对自变量的响应程度。

通过最小二乘法参数估计公式,我们可以找到最优的截距项和斜率项,使得拟合曲线与观测值之间的误差最小。

最小二乘法参数估计公式的推导过程是通过最小化误差平方和来实现的。

误差平方和是观测值与拟合值之间差异的平方累加,通过最小化误差平方和,我们可以找到使得误差最小的参数值。

最小二乘法参数估计公式的数学表达如下:β = (X'X)^-1X'Y其中,β表示参数向量,X表示自变量的设计矩阵,Y表示因变量的向量。

该公式通过求解矩阵的逆来计算参数向量。

最小二乘法参数估计公式的求解过程需要满足一些假设条件。

首先,我们假设误差项满足正态分布,并且具有零均值和常数方差。

其次,我们假设自变量之间不存在多重共线性,即设计矩阵X的列之间线性无关。

最后,我们假设误差项与自变量之间不存在相关性。

最小二乘法参数估计公式在实际问题中有着广泛的应用。

例如,在经济学中,我们可以使用最小二乘法来估计供给曲线和需求曲线的参数,从而分析市场的均衡和价格变动。

在金融学中,我们可以使用最小二乘法来估计资产收益率的参数,从而进行投资组合的优化和风险管理。

在医学研究中,我们可以使用最小二乘法来估计药物的剂量与效果之间的关系,从而确定最佳的治疗方案。

最小二乘法参数估计公式是一种常用的统计方法,在各个领域中都有广泛的应用。

8.2.2一元线性回归模型参数的最小二乘估计(第1课时)(教学设计)高二数学(人教A版2019选择性

8.2.2 一元线性回归模型参数的最小二乘估计(第1课时)教学设计一、课时教学内容本节的主要内容是一元线性回归模型,它是线性回归分析的核心内容,也是后续研究两变量间的相关性有关问题的基础.通过散点图直观探究分析得出的直线拟合方式不同,拟合的效果就不同,它们与实际观测值均有一定的偏差.在经历用不同估算方法描述两个变量线性相关关系的过程中,解决用数学方法刻画从整体上看各观测点到拟合直线的距离最小的问题,让学生在此基础上了解更为科学的数据处理方式——最小二乘法,有助于他们更好地理解核心概念“经验回归直线”,并最终体现回归方法的应用价值.二、课时教学目标1.进一步掌握一元线性回归模型参数的统计意义,会用相关统计软件.2.了解非线性回归模型.3.会通过分析残差和利用R2判断回归模型的拟合效果.三、教学重点、难点1.重点:一元线性回归模型的基本思想,经验回归方程,最小二乘法.2.难点:求最小二乘估计,残差分析.四、教学过程设计环节一创设情境,引入课题在一元线性回归模型中,表达式Y bx a e=++刻画的是变量Y与变量x之间的线性相关关系,其中参数a和b未知,需要根据成对样本数据进行估计.由模型的建立过程可知,参数a和b刻画了变量Y与变量x的线性关系,因此通过成对样本数据估计这两个参数,相当于寻找一条适当的直线,使表示成对样本数据的这些散点在整体上与这条直线最接近.问题1:从成对样本数据出发,如何用数学的方法刻画“从整体上看,各散点与直线最接近”?【设计意图】明确问题,指明思考的方向,引发学生思考.思路1:先画出一条直线,测量出各点到直线的距离,然后移动直线,到达一个使距离的和最小的位置,测量出此时的斜率和截距,就得到一条直线.问题2.我们怎样寻找一条“最好”的直线,使得表示成对样本数据的这些散点在整体上与这条直线最“接近”?【师生活动】教师提出探究问题,并引导学生得出探究目标,然后让学生小组合作讨论.学生分组合作讨论,然后各组派代表交流研究成果.【设计意图】培养学生的团结协作意识,提升学生的逻辑推理核心素养.后移动直线,到达一个使距离的和最小的位置,测量出此时的斜率和截距,就可得到一条直线,如图8.22所示.思路2:可以在散点图中选两点画一条直线,使得直线两侧点的个数基本相同,把这条直线作为所求直线.有的同学可能会想,可以在图中选择这样的两点画直线,使得直线两侧的点的个数基本相同,把这条直线作为所求直线,如图8.23所示.思路3:在散点图中多取几对点,确定出几条直线,再分别求出这些直线的斜率、截距的平均数作为所求直线的斜率和截距.还有的同学会想,在散点图中多取几对点,确定出几条直线的方程,再分别求出这些直线的斜率、截距的平均数,将这两个平均数作为所求直线的斜率和截距如图8.24所示.同学们不妨去实践一下,看看这些方法是不是真的可行.环节二观察分析,感知概念上面这些方法虽然有一定的道理,但比较难操作,我们需要另辟蹊径先进一步明确我们面临的任务:从成对样本数据出发,用数学的方法刻画“从整体上看,各散点与直线最接近”.通常,我们会想到利用点到直线y bx a =+的“距离”来刻画散点与该直线的接近程度,然后用所有“距离”之和刻画所有样本观测数据与该直线的接近程度我们设满足一元线性回归模型的两个变量的n 对样本数据为11(,)x y ,22(,)x y ,…,(,)n n x y ,由1(1,2,,)i i y bx a e i n =++=,得()i i i y bx a e -=+.显然i e 越小,表示点(,)i i x y 与点(),i i x bx a +的“距离”越小,即样本数据点离直线y bx a =+的竖直距离越小,如图8.25所示.特别地,0i e =时,表示点(,)i i x y 在这条直线上.因此,可以用这n 个竖直距离之和1()ni i i y bx a =-+∑来刻画各样本观测数据与直线y bx a =+的“整体接近程度”. 问题3.你能结合具体实例解释产生模型①中随机误差项的原因吗?在实际应用中,因为绝对值使得计算不方便,所以人们通常用各散点到直线的竖直距离的平方之和来刻画“整体接近程度”.在上式中,,(1,2,3,...)i i x y i n =是已知的成对样本数据,所以Q 由a 和b 所决定,即它是a 和b 的函数.因为Q 还可以表示为21i i ne =∑,即它是随机误差的平方和,这个和当然越小越好,所以我们取使Q 达到最小的a 和b 的值,作为截距和斜率的估计值. 环节三 抽象概括,形成概念问题4:如何求a ,b 的值,使 最小?【设计意图】将距离最值问题抽象为函数求二元函数最值问题. 下面利用成对样本数据求使Q 取最小值的a ,b .记11n i i x x n ==∑,11ni i y y n ==∑.因为2211[()()]2[()()][()][()]ni i i i ni y y b x x y y b x x y bx a n y bx a ===---+---⨯--+--∑∑,注意到11[()()]()()[()()]ni z i n i i i y y b x x y bx a y bx a y y b x x ==-----=-----∑∑[]21(,)()ni i i Q a b y bx a ==-+∑所以221(,)[()()]()ni i i Q a b y y b x x n y bx a ==---+--∑.上式右边各项均为非负数,且前n 项与a 无关.所以,要使Q 取到最小值,后一项的值应为0,即.a y bx =-此时22221111(,)[()()]()2()()()nnni i ii i i i i i i Q a b y y b x x bx x b x x y x y y π=====---=----+-∑∑∑∑.上式是关于b 的二次函数,因此要使Q 取得最小值,当且仅当b 的取值为121()()()niii nii x x y y b x x ==--=-∑∑.综上,当a ,b 的取值为121()()()ˆni i i ni i x x y y b x x a y bx ==--=-=-⎧⎪⎪⎪⎨⎪⎪⎪⎩∑∑ (2) 时,Q 达到最小.我们将ˆˆˆybx a =+称为Y 关于x 的经验回归方程,也称经验回归函数或经验回归公式,其图形称为经验回归直线.这种求经验回归方程的方法叫做最小二乘法,求得的ˆb,a 叫做b ,a 的最小二乘估计(least squares estimate).问题5:利用下表的数据,依据用最小二乘估计一元线性回归模型参数的公式,求出儿子身高Y 关于父亲身高x 的经验回归方程。

参数的最小二乘法估计

最小二乘法的应用领域

回归分析

在统计学中,最小二乘法被广泛应用 于线性回归分析,用于估计回归模型 的参数。

01

工程领域

最小二乘法在工程领域也有广泛应用, 例如用于参数估计、系统辨识、控制 设计等任务。

05

02

曲线拟合

最小二乘法可用于拟合曲线,例如多 项式曲线、指数曲线等,以描述数据 之间的关系。

有效性

在所有无偏估计量中,最小二乘法估计量具有最小的方差,因此是有效的。

有效性意味着在同样的样本量下,最小二乘法估计量能够提供更精确的参数估计,减少估计误差。

05

最小二乘法估计的优缺点

优点

无偏性

一致性

在满足一定的假设条件下,最小二乘法估 计量是参数的真实值的无偏估计,即估计 量的期望值等于参数的真实值。

最小二乘法估计量是样本数据的线性 组合,其期望值等于总体参数的真实 值,因此具有无偏性。

无偏性意味着在多次重复抽样和估计 过程中,估计量的平均值将接近参数 的真实值。

一致性

随着样本量的增加,最小二乘法估计 量的值将逐渐接近参数的真实值,具 有一致性。

VS

一致性保证了在大样本情况下,最小 二乘法估计量能够给出相对准确的参 数估计。

对于非线性模型,可以通过变量变换 或引入非线性项,将其转化为线性模 型,再利用最小二乘法进行参数估计 。

在时间序列分析中的应用

趋势分析

通过最小二乘法拟合时间序列的趋势项,揭示时间序列的长期趋势和变化规律。

季节调整

对于具有季节性特征的时间序列,可以利用最小二乘法估计季节因子,进而对 原始序列进行季节调整。

8.2.2一元线性回归模型参数的最小二乘估计(第二课时)高二数学(人教A版2019选择性必修第三册)

(4)分析拟合效果:通过计算决定系数来判断拟合效果;

(5)写出非线性经验回归方程.

典例分析

练习 1.在回归分析中,R2 的值越大,说明残差平方和(

A.越大

B.越小

C.可能大也可能小

D.以上均错

^

B

)

练习 2.已知经验回归方程为y=2x+1,而试验得到的一组数据是(2,4.9),(3,7.1),(4,

3 150-3 025

^

^

所以z=0.28x-3.95,即y=e0.28x

-3.95

.

归纳小结

解决非线性回归问题的方法及步骤

(1)确定变量:确定解释变量为 x,响应变量为 y;

(2)画散点图:通过观察散点图并与学过的函数(幂函数、指数函数、对数函数、

二次函数、反比例函数等)作比较,选取拟合效果好的函数模型;

概念讲解

在使用经验回归方程进行预测时,需注意以下问题

1.回归方程只适用于我们所研究的样本的总体;

2.我们所建立的回归方程一般都有时间性;

3.样本采集的范围会影响回归方程的适用范围;

4.不能期望回归方程得到的预报值就是预报变量的精确值. 事实上, 它是预报变量

的可能取值的平均值.

PART.04

典例分析

6

7

8

年份/t

1896

1912

1921

1930

1936

1956

1960

1968

x

0.00

2.83

3.26

3.56

3.71

4.11

4.17

4.29

记录/s

11.80

高中数学(新人教A版)选择性必修二:一元线性回归模型、一元线性回归模型参数的最小二乘估计【精品课件】

0.177 9

0.094 9

-1.071 1

^

e=

^

y-y

残差图如图所示.

由图可知,残差比较均匀地分布在横轴的两边,说明选用的模型比较合适.

(4)计算得R2≈0.985 5.说明拟合效果较好.

反思感悟(1)解答本类题目应先通过散点图、样本相关系数来分析两个变

量是否线性相关,再利用求经验回归方程的公式求解经验回归方程,并利用

归公式,其图形称为经验回归直线.这种求经验回归方程的方法叫做最小二乘

^ ^

法,求得的b, a叫做 b,a 的最小二乘估计.

n

^

∑ (x i -x)(y i -y)

b = i=1n

2

∑ (x i -x)

其中

,

i=1

^

^

a = y-bx.

回归直线过样本点的中心(x, y)

2.残差与残差分析

对于响应变量Y,通过观测得到的数据称为观测值,通过经验回归方程得到

2

∑ 2 -

=1

^

^

, = −Biblioteka )解 (1)散点图如图:

(2)由(1)中散点图可知 y 与 x 线性相关.

4

因为 ∑ xiyi=6×2+8×3+10×5+12×6=158,

=1

6+8+10+12

2+3+5+6

x=

=9,y =

=4,

4

4

4

∑ 2 =62+82+102+122=344,

2.67

由z=ln ae0+xln b及最小二乘法,得

ln b≈0.047 7,ln ae0≈2.378,

第三章 一元模型的参数估计PPT课件

4

一、参数的普通最小二乘估计(OLS)

给定一组样本观测值(Xi, Yi)(i=1,2,…n)要 求样本回归函数尽可能好地拟合这组值.

离差

要求样本函数仅可能好的拟合这组数值,我们可以考虑 使观测值Yi与样本回归值之差(残差ei)尽可能的小, 使之尽可能的接近PRF,即:

第三章 一元回归模型的参数估计

一、参数的普通最小二乘估计(OLS) 二、最小二乘估计量的数值性质 三、一元线性回归模型的基本假设 四、最小二乘估计量的统计性质 五、参数估计量的概率分布及随机干

扰项方差的估计 六、最小二乘估计(OLS)的精度或标准误

1

整体概况

概况一

点击此处输入 相关文本内容

01

概况二

2、 ∑ei2=f(^0 , ^1 ),即残差平方和是估计量^0 , ^1

的某个函数。 3、用OLS原理或方法选出来的^0 , ^1 ,将使得对

于给定的样本或数据残差平方和尽可能的小。 7

方程组(*)称为正规方程组(normal equations)。

8

记

x i2(X i X )2X i2 1 n X i2

点击此处输入 相关文本内容

02

概况三

点击此处输入 相关文本内容

03

2

单方程计量经济学模型分为两大类: 线性模型和非线性模型

•线性模型中,变量之间的关系呈线性关系 •非线性模型中,变量之间的关系呈非线性关系

一元线性回归模型:只有一个解释变量

Y i 01X ii

i=1,2,…,n

Y为被解释变量,X为解释变量,0与1为待估 参数, 为随机干扰项

6

普通最小二乘法(Ordinary least squares, OLS)给出的判断标准是:二者之差的

【高中数学】一元线性回归模型及其参数的最小二乘估计 课件 高二数学人教A版2019选择性必修第三册

问题3:从成对样本数据的散点图和样本相关系数可以发现,散点大致分布在一条直 线附近表明儿子身高和父亲身高有较强的线性关系.我们可以这样理解,由于有其他因 素的存在,使儿子身高和父亲身高有关系但不是函数关系.那么影响儿子身高的其他因 素是什么?

影响儿子身高的因素除父亲的身外,还有母亲的身高、生活的环境、饮食习惯、营 养水平、体育锻炼等随机的因素,儿子身高是父亲身高的函数的原因是存在这些随 机的因素.

儿子身高 / cm

190

185

180

175

170

165

160 160

165

170

175

180

185父亲身高 / cm

方法二: 在图中选择这样的两点画直线,使得直线两侧的点的个数基 本相同,把这条直线作为所求直线,如图(2)所示.

儿子身高 / cm

190

185

180

175

170

165

160 160

你能结合父亲与儿子身高的实例,说明回归模型(1)的意义?

E(Y) E(bx a e) E(bx a) E(e)

(bx a) 0 bx a

对于父亲身高为xi的某一名男大学生,他的身高yi一定是bxi+a吗?

课堂练习(课本P107)

3. 将图8.2-1中的点按父亲身高的大小次序用折线连起来,所得到的图象是 一个折线图,可以用这条折线表示儿子身高和父亲身高之间的关系吗?

探究 利用散点图找出一条直线,使各散点在整体上与此直线尽可能接近.

儿子身高 / cm

190

185

180

175

170

165

160 160

165

170

175

180

8.2.2一元线性回归模型参数的最小二乘估计-【新教材】人教A版高中数学选择性必修第三册课件

这方面的工作称为残差分析.

问题3:儿子身高与父亲身高的关系,运用残差分析所得的一元线性回归模型的有效

性吗?

残差图:作图时纵坐标 为残差,横坐标可以选为样本编号,或身高数据,或体重估计

值等,这样作出的图形称为残差图.

从上面的残差图可以看出,残差有正有负,残差点比较均匀地散布在横轴的两边,可

以判断样本数据基本满足一元线性回归模型对于随机误差的假设。所以,通过视察残

i 1

当Q(a, b)取最小时,n[( y bx) a ]2 取最小值0,即a = y bx

n

此时,Q(a, b) [( yi y ) b( xi x)] =b

2

n

2

i 1

(x

i 1

i

n

n

i 1

i 1

x) 2b ( xi x)( yi y ) ( yi y ) 2

图(4)的残差比较均匀地集中在以横轴为对称轴的水平带状区域内.

所以,只有图(4)满足一元线性回归模型对随机误差的假设。

随机误差的假定?

(1)

(2)

(3)

(4)

根据一元线性回归模型中对随机误差的假定,残差应是均值为0、方差为 的

随机变量的观测值.

图(1)显示残差与观测时间有线性关系,应将时间变量纳入模型;

图(2)显示残差与观测时间有非线性关系,应在模型中加入时间的非线性函数部

分;

图(3)说明残差的方差不是一个常数,随观测时间变大而变大;

i 1

n

n

[( yi y ) b( xi x)] 2 [( yi y ) b( xi x)] [( y b x) a ] n[( y b x) a ]2

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

的概率为

∏ P =

n i =1

Pi

=

1

σ1σ 2 "σ n

n

2π

∑ − δi2 e i=1

(2σi2 )dδ1dδ 2 "dδ n

1. 最小二乘原理

| 测量值 l1,l2 ,",ln 已经出现,有理由认为这n个测 量值出现于相应区间的概率P为最大。要使P最

ti /0 C

10

20

30

40

50

60

li / mm 2000.36 2000.72 2000.8 2001.07 2001.48 2000.60

| 1)列出误差方程

vi = li − ( y0 + ay0ti )

| 令 y0 = c, ay0 = d为两个待估参量,则误差方程为

vi = li − (c + tid )

x2 ,",

xt

)

⎪⎪ ⎬

⎪

vn = ln − fn (x1, x2 ,", xt )⎪⎭

残差方程式

1. 最小二乘原理

| 若 l1,l2 ,",ln 不存在系统误差,相互独立并服从正 态分布,标准差分别为σ1,σ 2 ,",σ n,则l1, l2 ,", ln出

现在相应真值附近 dδ1, dδ2,", dδn 区域内的概率

大,应有

δ12

+

δ

2 2

+"

+

δ

2 n

= 最小

σ12 σ 22

σ n2

| 由于结果只是接近真值的估计值,因此上述条件

应表示为

v12 + v22 +" + vn2 = 最小

σ

2 1

σ

2 2

σ n2

2. 等精度测量线性参数的最小二乘处理

| 线性参数的测量方程和相应的估计量为:

Y1 = a11 X1 + a12 X 2 + " + a1t X t ⎫

i =1

i =1

i =1

i =1

⎪ ⎪⎭

3. 不等精度测量线性参数的最小二乘处理

| 整理得:

p1a11v1 + p2a21v2 + " + pnan1vn = 0 ⎫

p1a12v1

+

p2a22v2 #

+"+

pn an 2 vn

=

0⎪⎪ ⎬ ⎪

p1a1tv1 + p2a2tv2 + " + pnantvn = 0 ⎪⎭

3. 不等精度测量线性参数的最小二乘处理

| 不等精度 pi

等精度

v1 p1 = l1 p1 − a11 p1 x1 + a12 p1 x2 + " + a1t p1 xt

⎫ ⎪

v2

p2 = l2

p2 − a21 #

p2 x1 + a22

p2 x2 + " + a2t

p2

xt

⎪ ⎬

⎪

vn

pn = ln

Y2

=

a21 X1

+

a22 X 2 #

+

"

+

a2t

X

t

⎪⎪ ⎬

⇒

⎪

Yn = an1X1 + an2 X 2 + " + ant X t ⎪⎭

y1 = a11x1 + a12 x2 + " + a1t xt ⎫

y2

=

a21x1

+

a22 x2 #

+"+

a2t xt

⎪⎪ ⎬ ⎪

yn = an1x1 + an2 x2 + " + ant xt ⎪⎭

| 残差方程为

v1 = l1 − (a11x1 + a12 x2 + " + a1t xt ) ⎫

v2

=

l2

− (a21x1 + #

a22 x2

+

"

+

a2t

xt

)

⎪⎪ ⎬

⎪

vn = ln − (an1x1 + an2 x2 + " + ant xt )⎪⎭

2. 等精度测量线性参数的最小二乘处理

|令

| 即:

AT PV = 0

不等精度的正规方程

3. 不等精度测量线性参数的最小二乘处理

| 将 V = L − AXˆ 代入上式,得

AT PL − AT PAXˆ = 0

AT PAXˆ = AT PL

C = AT PA

CXˆ = AT PL

Xˆ = C −1AT PL (待测量X的无偏估计)

3. 不等精度测量线性参数的最小二乘处理

1. 最小二乘原理

| 最小二乘法原理是一种在多学科领域中获得广泛 应用的数据处理方法。

| 本章将重点阐述最小二乘法原理在线性参数和非 线性参数估计中的应用,使同学们掌握最小二乘 法的基本思路和基本原理,以及在等精度或不等 精度测量中线性、非线性参数的最小二乘估计方 法,并科学地给出估计精度。

1. 最小二乘原理

| 不等精度测量的线性参数最小二乘原理

Pn×n

=

⎡ p1 0 " 0 ⎤ ⎢⎢0 p2 " 0⎥⎥

⎢

#⎥

⎢⎣0

0

"

⎥ pn ⎦

=

⎡σ

⎢ ⎢0 ⎢ ⎢ ⎣⎢0

σ 2 2 1

σ2 σ

# 0"

0

2 2

σ

" 0⎤ ⎥

" 0⎥ ⎥ ⎥

2 σ n2 ⎥⎦

权矩阵

| 不等精度测量最小二乘原理的矩阵形式:

V T PV = 最小 (L − AXˆ)T P(L − AXˆ)= 最小

| 试求 x1, x2 的最可信赖值。

a12v1

+ a22v2 + " + an2vn #

=

0⎪⎪ ⎬ ⎪

a1tv1 + a2tv2 + " + antvn = 0 ⎪⎭

正规方程的矩阵形式

ATV = 0

2. 等精度测量线性参数的最小二乘处理

| 将V = L − AXˆ 代入到 ATV = 0 中,得 AT L − AT AXˆ = 0

v2

=

l2

−

a21 x1

+ #

a22 x2

+"+

a2t xt

⎪⎪ ⎬ ⎪

vn = ln − an1x1 + an2 x2 + " + ant xt ⎪⎭

v12 + v22 + " + vn2 = 最小

∑ ⎧⎪∂( n vi2 )

⎪ i=1

=0

⎪ ⎪ ⎨

∂x1 #

⎪n

∑ ⎪∂(

⎪ ⎪⎩

vi2 )

i =1

第三章 参数的最小二乘估计法

华东理工大学 罗娜 naluo@

参考书目: • 费业泰. 误差理论与数据处理. 机械工业出版社, 2002.

主要内容

| 最小二乘法原理 | 等精度测量线性参数的最小二乘处理 | 不等精度测量线性参数的最小二乘处理 | 非线性参数的最小二乘处理 | 最小二乘估计量的精度估计 | 组合测量的最小二乘法处理

| 按照最小二乘的矩阵形式计算

⎡2000.36⎤

⎢⎢2000.72⎥⎥

⎢2000.80⎥ L = ⎢⎢2001.07⎥⎥

⎢2001.48⎥

⎢

⎥

⎣⎢2001.60⎦⎥

Xˆ

=

⎡c ⎢⎣d

⎤ ⎥ ⎦

⎡1 10 ⎤

⎢⎢1

20

⎥ ⎥

⎢1 30 ⎥

A = ⎢⎢1

40

⎥ ⎥

⎢1 50 ⎥ ⎢⎥ ⎣⎢1 60 ⎥⎦

pn − an1

pn x1 + an2

" pn x2 +"+ ant

pn

xt

⎪ ⎭

vi ' li ' ai1'

ai2 '

ait '

| 则有:

V 'T V ' = 最小

(L'− A' Xˆ)(T L'− A' Xˆ)= 最小

3. 不等精度测量线性参数的最小二乘处理

|不等精度测量线性参数最小二乘处理的正规

+"+

n i =1

⎪

ai

2

ait

xt

⎪ ⎬

#

⎪ ⎪

n

n

n

n

∑ ∑ ∑ ∑ aitli = ait ai1x1 + ait ai2 x2 + " + ait ait xt

| 特点: i=1

i =1

i =1

i =1

⎪ ⎪⎭

¾ 主对角线分布着平方项系数,正数

¾ 相对于主对角线对称分布的各系数两两相等

2. 等精度测量线性参数的最小二乘处理

∂xn

=

0

2. 等精度测量线性参数的最小二乘处理