遗传算法导论(论文翻译)

《2024年《指尖上的遗传学》(节选)翻译实践报告》范文

《《指尖上的遗传学》(节选)翻译实践报告》篇一一、引言翻译是一门语言与文化沟通的艺术,将一份特定的内容通过另一语言呈现给读者。

在本报告中,我将详细分析节选自《指尖上的遗传学》的翻译实践过程。

通过这个过程,我希望能揭示遗传学领域的专业知识如何通过语言的转化,被读者所理解和接受。

二、任务接受与理解本次翻译实践的对象是《指尖上的遗传学》的节选部分,主要涉及遗传学的基本概念和前沿研究。

在接受任务后,我首先对原文进行了仔细阅读,理解其主题、内容、语言风格及需要传达的信息。

这个阶段的理解对于后续的翻译工作至关重要。

三、翻译过程在翻译过程中,我主要遵循了“理解、转换、校对”的步骤。

在理解阶段,我确保完全理解原文的含义。

在转换阶段,我使用目标语言将原文的信息准确、流畅地表达出来。

在校对阶段,我检查并修正翻译中的错误,保证翻译的准确性。

对于专业术语的翻译,我查证了相关遗传学的专业词典和文献,确保术语的准确翻译。

同时,我也注意了语言的流畅性,使得译文在传达信息的同时,也能让读者感到舒适。

四、难点与解决方案在翻译过程中,我遇到了几个难点。

首先,原文中一些专业术语的翻译需要我进行深入的研究和理解。

我通过查阅专业词典和文献,解决了这些难点。

其次,原文中的一些复杂句型和结构也需要我进行细致的分析和转化。

我通过拆分句子结构,理解其逻辑关系,再将其用目标语言重新组织,以保持原文的意义和风格。

五、案例分析以节选内容中的一句为例:“基因编辑技术为治疗遗传性疾病提供了新的可能性。

”这句话的翻译需要准确地传达原文的含义,同时也要考虑到目标语言的表达习惯。

我将其翻译为“Gene editing technology offers new possibilities for treating inherited diseases.”这个翻译既保留了原文的信息,又符合目标语言的表达习惯。

六、反思与总结本次翻译实践让我深刻理解到专业翻译的复杂性和挑战性。

遗传算法——遗传算法

21

(5)机器人

例如,遗传算法已经在移动机器人路径规划、关节 机器人运动轨迹规划、机器人结构优化和行为协调等方 面得到研究和应用。

4

遗传算法的基本操作为:

(1)复制(Reproduction Operator)

复制是从一个旧种群中选择生命力强的个体位串产生 新种群的过程。具有高适应度的位串更有可能在下一代 中产生一个或多个子孙。

复制操作可以通过随机方法来实现。首先产生0~1之 间均匀分布的随机数,若某串的复制概率为40%,则当 产生的随机数在0.40~1.0之间时,该串被复制,否则被 淘汰。

出了“遗传算法”一词,并发表了遗传算法应用方面的第一 篇论文。他发展了复制、交叉、变异、显性、倒位等遗传算 子,在个体编码上使用了双倍体的编码方法。在遗传算法的 不同阶段采用了不同的概率,从而创立了自适应遗传算法的 概念。

16

(3)K.A.De Jong 1975年,De Jong博士在其博士论文中结合模式定理

2

(1)遗传:这是生物的普遍特征,亲代把生物信息交 给子代,子代总是和亲代具有相同或相似的性状。生 物有了这个特征,物种才能稳定存在。

(2)变异:亲代和子代之间以及子代的不同个体之间 的差异,称为变异。变异是随机发生的,变异的选择 和积累是生命多样性的根源。

(3)生存斗争和适者生存:具有适应性变异的个体被 保留下来,不具有适应性变异的个体被淘汰,通过一 代代的生存环境的选择作用,性状逐渐逐渐与祖先有 所不同,演变为新的物种。

对于一个需要进行优化的实际问题,一般可按下述 步骤构造遗传算法: 第一步:确定决策变量及各种约束条件,即确定出个体 的表现型X和问题的解空间; 第二步:建立优化模型,即确定出目标函数的类型及数 学描述形式或量化方法;

遗传算法综述_刘定理

41开发应用1引言2遗传算法的发展3遗传算法理论与技术3.1基本原理3.2混合遗传算法3.3并行遗传算法遗传算法(GeneticAlgorithms简称GA)是由美国Michigan大学的JohnHolland教授创建的。

它来源于达尔文的进化论、魏茨曼的物种选择学说和孟德尔的群体遗传学说。

其基本思想是模拟自然界遗传机制和生物进化论而形成的一种过程搜索最优解的算法。

目前,遗传算法广泛应用于自动控制、计算科学、模式识别、工程设计、智能故障诊断、管理科学和社会科学领域,适用于解决复杂的非线性和多维空间寻优问题。

早在上个世纪40年代,就有学者开始研究如何利用计算机进行生物模拟的技术,他们从生物学的角度进行了生物的进化过程模拟、遗传过程模拟等研究工作。

进入60年代后,美国密歇根大学的Holland教授及其学生们受到这种模拟技术的启发,创造出了一种基于生物遗传和进化机制的适合于复杂系统优化计算的自适应概率优化技术——遗传算法。

进入90年代,遗传算法迎来了兴盛发展时期,无论是理论研究还是应用研究都成了十分热门的课题。

尤其是遗传算法的应用研究显得格外活跃,不但它的应用领域扩大,而且利用遗传算法进行优化和规则学习的能力也显著提高。

遗传算法的应用研究已从初期的组合优化求解扩展到了许多更新、更工程化的应用方面。

遗传算法的研究主要包括三个领域:遗传算法的理论与技术;用遗传算法进行优化;用遗传算法进行分类系统的机器学习。

其中,遗传算法的理论与技术研究主要包括编码、交叉运算、变异运算、选择运算以及适应度评价等问题。

与传统搜索算法不同,遗传算法从一组随机产生的初始解,称为群体,开始搜索过程。

群体中的每个个体是问题的一个解,称为染色体。

这些染色体在后续迭代中不断进化,称为遗传。

遗传算法主要通过交叉、变异、选择运算实现。

交叉或变异运算生成下一代染色体,称为后代。

染色体的好坏用适应度来衡量。

根据适应度的大小从上一代和后代中选择一定数量的个体,作为下一代群体,再继续进化,这样经过若干代之后,算法收敛于最好的染色体,它很可能就是问题的最优解或次优解。

遗传算法中英文对照外文翻译文献

遗传算法中英文对照外文翻译文献(文档含英文原文和中文翻译)Improved Genetic Algorithm and Its Performance Analysis Abstract: Although genetic algorithm has become very famous with its global searching, parallel computing, better robustness, and not needing differential information during evolution. However, it also has some demerits, such as slow convergence speed. In this paper, based on several general theorems, an improved genetic algorithm using variant chromosome length and probability of crossover and mutation is proposed, and its main idea is as follows : at the beginning of evolution, our solution with shorter length chromosome and higher probability of crossover and mutation; and at the vicinity of global optimum, with longer length chromosome and lower probability of crossover and mutation. Finally, testing with some critical functions shows that our solution can improve the convergence speed of genetic algorithm significantly , its comprehensive performance is better than that of the genetic algorithm which only reserves the best individual.Genetic algorithm is an adaptive searching technique based on a selection and reproduction mechanism found in the natural evolution process, and it was pioneered by Holland in the 1970s. It has become very famous with its global searching,parallel computing, better robustness, and not needing differential information during evolution. However, it also has some demerits, such as poor local searching, premature converging, as well as slow convergence speed. In recent years, these problems have been studied.In this paper, an improved genetic algorithm with variant chromosome length and variant probability is proposed. Testing with some critical functions shows that it can improve the convergence speed significantly, and its comprehensive performance is better than that of the genetic algorithm which only reserves the best individual.In section 1, our new approach is proposed. Through optimization examples, in section 2, the efficiency of our algorithm is compared with the genetic algorithm which only reserves the best individual. And section 3 gives out the conclusions. Finally, some proofs of relative theorems are collected and presented in appendix.1 Description of the algorithm1.1 Some theoremsBefore proposing our approach, we give out some general theorems (see appendix) as follows: Let us assume there is just one variable (multivariable can be divided into many sections, one section for one variable) x ∈ [ a, b ] , x ∈ R, and chromosome length with binary encoding is 1.Theorem 1 Minimal resolution of chromosome is s =12l --a b Theorem 2 Weight value of the ith bit of chromosome isw i =12l --a b 12-i ( i = 1,2,…l ) Theorem 3 Mathematical expectation Ec(x) of chromosome searching step with one-point crossover isE c (x) = la b 2-P c where Pc is the probability of crossover.Theorem 4 Mathematical expectation Em ( x ) of chromosome searching step with bit mutation isE m ( x ) = ( b- a) P m1. 2 Mechanism of algorithmDuring evolutionary process, we presume that value domains of variable are fixed, and the probability of crossover is a constant, so from Theorem 1 and 3, we know that the longer chromosome length is, the smaller searching step of chromosome, and the higher resolution; and vice versa. Meanwhile, crossover probability is in direct proportion to searching step. From Theorem 4, changing the length of chromosome does not affect searching step of mutation, while mutation probability is also in direct proportion to searching step.At the beginning of evolution, shorter length chromosome( can be too shorter, otherwise it is harmful to population diversity ) and higher probability of crossover and mutation increases searching step, which can carry out greater domain searching, and avoid falling into local optimum. While at the vicinity of global optimum, longer length chromosome and lower probability of crossover and mutation will decrease searching step, and longer length chromosome also improves resolution of mutation, which avoid wandering near the global optimum, and speeds up algorithm converging.Finally, it should be pointed out that chromosome length changing keeps individual fitness unchanged, hence it does not affect select ion ( with roulette wheel selection) .1. 3 Description of the algorithmOwing to basic genetic algorithm not converging on the global optimum, while the genetic algorithm which reserves the best individual at current generation can, our approach adopts this policy. During evolutionary process, we track cumulative average of individual average fitness up to current generation. It is written as X(t) = G 1∑=G t avg f1(t)where G is the current evolutionary generation,avg f is individual averagefitness. When the cumulative average fitness increases to k times ( k> 1, k ∈ R) of initial individual average fitness, we change chromosome length to m times ( m is a positive integer ) of itself , and reduce probability of crossover and mutation, whichcan improve individual resolution and reduce searching step, and speed up algorithm converging. The procedure is as follows:Step 1 Initialize population, and calculate individual average fitness0avg f ,and set change parameter flag. Flag equal to 1.Step 2 Based on reserving the best individual of current generation, carry out selection, regeneration, crossover and mutation, and calculate cumulative average of individual average fitness up to current generationavg f ;Step 3 If 0avg avgf f ≥k and Flag equals 1, increase chromosome length to m times of itself, and reduce probability of crossover and mutation, and set Flag equal to 0; otherwise continue evolving.Step 4 If end condition is satisfied, stop; otherwise go to Step 2.2 Test and analysisWe adopt the following two critical functions to test our approach, and compare it with the genetic algorithm which only reserves the best individual: ()]01.01[5.0sin 5.0),(2222221y x y x y x f ++-+-= ]5,5[ ∈,-y x))4cos(4.0)3cos(3.02(4),(222y x y x y x f ππ--+-= ]1,1[ ∈,-y x2. 1 Analysis of convergenceDuring function testing, we carry out the following policies: roulette wheel select ion, one point crossover, bit mutation, and the size of population is 60, l is chromosome length, Pc and Pm are the probability of crossover and mutation respectively. And we randomly select four genetic algorithms reserving best individual with various fixed chromosome length and probability of crossover and mutation to compare with our approach. Tab. 1 gives the average converging generation in 100 tests.In our approach, we adopt initial parameter l0= 10, Pc0= 0.3, Pm0= 0.1 and k=1.2, when changing parameter condition is satisfied, we adjust parameters to l= 30, Pc= 0.1, Pm= 0.01.From Tab. 1, we know that our approach improves convergence speed of genetic algorithm significantly and it accords with above analysis.2. 2 Analysis of online and offline performanceQuantitative evaluation methods of genetic algorithm are proposed by Dejong, including online and offline performance. The former tests dynamic performance; and the latter evaluates convergence performance. To better analyze online and offline performance of testing function, w e multiply fitness of each individual by 10, and we give a curve of 4 000 and 1 000 generations for f1 and f2, respectively.(a) online (b) onlineFig. 1 Online and offline performance of f1(a) online (b) onlineFig. 2 Online and offline performance of f2From Fig. 1 and Fig. 2, we know that online performance of our approach is just little worse than that of the fourth case, but it is much better than that of the second, third and fifth case, whose online performances are nearly the same. At the same time, offline performance of our approach is better than that of other four cases.3 ConclusionIn this paper, based on some general theorems, an improved genetic algorithmusing variant chromosome length and probability of crossover and mutation is proposed. Testing with some critical functions shows that it can improve convergence speed of genetic algorithm significantly, and its comprehensive performance is better than that of the genetic algorithm which only reserves the best individual.AppendixWith the supposed conditions of section 1, we know that the validation of Theorem 1 and Theorem 2 are obvious.Theorem 3 Mathematical expectation Ec(x) of chromosome searching step with one point crossover is Ec(x) = c P l a b 2-where Pc is the probability of crossover.Proof As shown in Fig. A1, we assume that crossover happens on the kth locus, i. e. parent’s locus from k to l do not change, and genes on the locus from 1 to k are exchanged.During crossover, change probability of genes on the locus from 1 to k is 21(“1” to “0” or “0” to “1”). So, after crossover, mathematical expectation of chromosome searching step on locus from 1 to k is)12(12212122121)(111-•--•=•--•==-==∑∑k l j k j l j kj ck a b a b w x E Furthermore, probability of taking place crossover on each locus of chromosome is equal, namely l 1Pc. Therefore, after crossover, mathematical expectation of chromosome searching step is)(1)(11x E P lx E ck c l k c ••=∑-= Substituting Eq. ( A1) into Eq. ( A2) , we obtain )1211(2)(])12[(122)12(12211)(11---•=--•--•=-•--•••=∑-=l c i l c k l c l k c l a b P l a b l P a b P lx E where l is large, 012≈-l l , so )(x E c c P l a b 2-≈Fig. A1 One point crossoverTheorem 4 Mathematical expectation)(x E m of chromosome searching step with bit mutation m m P a b x E •-=)()(, where Pm is the probability of mutation.Proof Mutation probability of genes on each locus of chromosome is equal, say Pm, therefore, mathematical expectation of mutation searching step isE m (x )=P m ·w i =i =1l åP m ·b -a 2l -1·2i -1=i =1l åP m ·b -a 2i -1·(2i -1)=(b -a )·P m一种新的改进遗传算法及其性能分析摘要:虽然遗传算法以其全局搜索、并行计算、更好的健壮性以及在进化过程中不需要求导而著称,但是它仍然有一定的缺陷,比如收敛速度慢。

遗传算法(GeneticAlgorithm)..

2018/10/7

选择(Selection)

选择(复制)操作把当前种群的染色体按与适应值成正比例 的概率复制到新的种群中 主要思想: 适应值较高的染色体体有较大的选择(复制)机 会 实现1:”轮盘赌”选择(Roulette wheel selection) 将种群中所有染色体的适应值相加求总和,染色体适应 值按其比例转化为选择概率Ps 产生一个在0与总和之间的的随机数m 从种群中编号为1的染色体开始,将其适应值与后续染色 体的适应值相加,直到累加和等于或大于m

2018/10/7

选择(Selection)

染色体的适应值和所占的比例

轮盘赌选择

2018/10/7

选择(Selection)

染色体被选的概率

染色体编号

1

2

3

4

5

6

染色体

适应度 被选概率 适应度累计

01110

8

0.16 8

11000

15

0.3 23

00100

2

0.04 25

10010

5

0.1 30

适者生存(Survival of the Fittest)

GA主要采用的进化规则是“适者生存” 较好的解保留,较差的解淘汰

2018/10/7

生物进化与遗传算法对应关系

生物进化

环境

适者生存 个体 染色体 基因 群体 种群 交叉 变异

2018/10/7

遗传算法

适应函数

适应函数值最大的解被保留的概率最大 问题的一个解 解的编码 编码的元素 被选定的一组解 根据适应函数选择的一组解 以一定的方式由双亲产生后代的过程 编码的某些分量发生变化的过程

遗传算法的基本操作

遗传算法在模拟电路故障诊断中的应用---优秀毕业论文参考文献可复制黏贴

In order to improve the speed of fault diagnosis, the application in soft fault diagnosis of analog circuits based on sensitivity analysis combined with the genetic algorithm is presented in this paper. We have discussed the sensitivity analysis of analog circuits. Estimate the offset of the component parameters to diagnose the fault of the analog circuits. We convert the diagnosis equation, which is constituted by the incremental test node voltage and the component parameters variation, into the linear programming problem about finding the smallest independent variable based on the hard constraints of the fault diagnosis equation. And the linear programming problem with constraints is converted to the extreme solution without constraints by the penalty function. The genetic algorithm is used to solve the optimal solution. Then, the influence of the control parameters of genetic algorithm is discussed with examples. A new Self-adaptive Genetic Algorithms was proposed and the experiments show that the method has a good efficiency on the soft fault diagnosis of tolerance analog circuits and has a higher speed.

遗传算1

遗传算法(Genetic Algorithm)是一类借鉴生物界的进化规律(适者生存,优胜劣汰遗传机制)演化而来的随机化搜索方法。

它是由美国的J.Holland 教授1975年首先提出,其主要特点是直接对结构对象进行操作,不存在求导和函数连续性的限定;具有内在的隐并行性和更好的全局寻优能力;采用概率化的寻优方法,能自动获取和指导优化的搜索空间,自适应地调整搜索方向,不需要确定的规则。

遗传算法的这些性质,已被人们广泛地应用于组合优化、机器学习、信号处理、自适应控制和人工生命等领域。

它是现代有关智能计算中的关键技术。

对于一个求函数最大值的优化问题(求函数最小值也类同),一般可以描述为下列数学规划模型:遗传算法式中为决策变量,为目标函数式,式2-2、2-3为约束条件,U是基本空间,R是U的子集。

满足约束条件的解X称为可行解,集合R表示所有满足约束条件的解所组成的集合,称为可行解集合。

遗传算法的基本运算过程如下:a)初始化:设置进化代数计数器t=0,设置最大进化代数T,随机生成M 个个体作为初始群体P(0)。

b)个体评价:计算群体P(t)中各个个体的适应度。

c)选择运算:将选择算子作用于群体。

选择的目的是把优化的个体直接遗传到下一代或通过配对交叉产生新的个体再遗传到下一代。

选择操作是建立在群体中个体的适应度评估基础上的。

d)交叉运算;将交叉算子作用于群体。

所谓交叉是指把两个父代个体的部分结构加以替换重组而生成新个体的操作。

遗传算法中起核心作用的就是交叉算子。

e)变异运算:将变异算子作用于群体。

即是对群体中的个体串的某些基因座上的基因值作变动。

群体P(t)经过选择、交叉、变异运算之后得到下一代群体P(t 1)。

f)终止条件判断:若tT,则以进化过程中所得到的具有最大适应度个体作为最优解输出,终止计算。

遗传算法定义遗传算法是从代表问题可能潜在的解集的一个种群(population)开始的,而一个种群则由经过基因(gene)编码的一定数目的个体(individual)组成。

沃森克里克论文翻译--DNA结构对遗传的影响

DNA结构对遗传的影响毋庸置疑,细胞里DNA十分重要。

在所有分裂的细胞中都发现了DNA,绝大部分在细胞核中,细胞核中的DNA是染色体的主要成分。

大量证据表明,它携带着一部分具有遗传特异性的染色体,所有也携带着基因。

然而,现在并没有证据显示出它是如何携带基因物质在精准的自我复制时所要求的重要生命活动。

我们最近提出了DNA所含的盐的结构,如果该结构正确的话,由它可以推断出自我复制的机制。

由伦敦国王学院得出的X射线证据进一步的证实了我们所提出的DNA结构,并且也表明这与之前被提出过的所有结构都不一样。

在与X 射线数据进行更多大量的对比验证之前,并不能完全肯定我们提出的结构是对的,但我们相信整体上来说是正确的,并且可以讨论它对遗传的影响。

在此之前,我们先假设DNA所含盐的纤维成分没有在准备复制时增加,因为Wilkins发现独立的纤维与完整的生物物质所呈现的X射线是相似的。

我们已经建立了DNA分子的化学式。

DNA分子呈长链状,脱氧核糖和磷酸交替连接构成骨架。

(见右图)每个脱氧核糖连接着一个含氮碱基,含氮碱基有四种形式。

(我们认为甲基胞嘧啶相当于胞嘧啶,因为它们都符合我们的结构。

)两种可能的嘌呤碱基是腺嘌呤和鸟嘌呤,另外两种嘧啶是胞嘧啶和胸腺嘧啶。

目前已知,骨架旁边的一串碱基排列顺序是无规律的。

这个包含了磷酸、脱氧核糖和碱基的结构叫做核苷酸。

我们的结构在生物意义上有优势的第一个特点是DNA含有两条链。

这两条链以同一条纤维为中心盘旋(如图2所示)。

有人假设说,因为在化学式里只有一条链,所以在结构单元中也只会有一条。

但是X射线显示出的密度明显表明DNA分子有两条链。

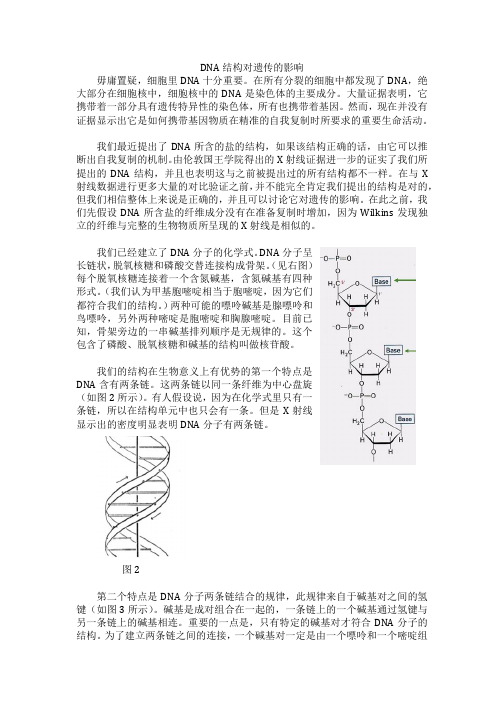

图2第二个特点是DNA分子两条链结合的规律,此规律来自于碱基对之间的氢键(如图3所示)。

碱基是成对组合在一起的,一条链上的一个碱基通过氢键与另一条链上的碱基相连。

重要的一点是,只有特定的碱基对才符合DNA分子的结构。

为了建立两条链之间的连接,一个碱基对一定是由一个嘌呤和一个嘧啶组成,如果一个碱基对含有两个嘌呤,那么两条链将无法连接。

遗传的算法及应用

遗传的算法及应用遗传算法(Genetic Algorithms)是一种模拟自然进化过程的优化算法,它以生物进化的理论为基础,通过模拟遗传、变异、选择等过程,逐步优化问题的解决方案。

这种算法广泛应用于求解优化问题,如组合优化、机器学习、图像处理、工程设计等领域。

遗传算法的基本步骤包括:初始种群的生成、适应度函数的定义、选择操作、交叉操作、变异操作和终止条件的判断。

首先,生成初始种群。

初始种群是由随机生成的一组个体组成,每个个体表示问题的一个可能解。

然后,定义适应度函数。

适应度函数用于评价染色体的适应度,确定染色体的生存能力或优越度。

适应度函数根据问题的特性来确定,可以是问题的目标函数值或其他评价指标。

接下来,进行选择操作。

选择操作是根据染色体适应度的高低来选择某些个体作为下一代个体的父代。

常用的选择算法有轮盘赌选择、锦标赛选择等。

然后,进行交叉操作。

交叉操作是将父代个体的染色体片段互相交换,生成新的个体。

交叉操作能够保留父代个体的优良特征,并产生新的个体。

接着,进行变异操作。

变异操作是对染色体的基因信息进行随机的改变,引入新的个体变异,增加种群的多样性和搜索空间。

最后,根据终止条件判断是否停止迭代。

终止条件可以是迭代次数达到一定阈值,或找到满足约束的最优解。

遗传算法具有以下几个优点:1.适应性强:遗传算法适合求解复杂、多模态、非线性的问题,能够搜索整个解空间并找到近似最优解。

2.并行性好:遗传算法的并行化效果好,可以在多个处理器上同时进行种群的评估,提高计算速度和效率。

3.自适应性强:遗传算法基于种群的进化过程,能够自适应地调整搜索策略,适应问题的变化。

遗传算法广泛应用于各个领域,以下是一些典型的应用:1.组合优化问题:如旅行商问题(TSP)、背包问题等。

遗传算法能够在大规模问题中快速找到近似最优解。

2.机器学习:遗传算法可以应用于模型选择、特征选择、参数优化等问题。

例如,遗传算法可以用于优化神经网络的权重和结构,提高神经网络的性能。

遗传算法基本原理

遗传算法基本原理# 遗传算法基本原理## 引言遗传算法(Genetic Algorithm,GA)是一种受自然选择和遗传学理论启发的优化算法。

由于其在搜索和优化问题中的出色表现,遗传算法已成为解决复杂问题的强大工具。

本文将介绍遗传算法的基本原理,深入探讨其工作机制以及在问题求解中的应用。

## 遗传算法的起源遗传算法的灵感来源于自然界的演化过程,特别是达尔文的进化论。

通过模拟自然选择和遗传过程,遗传算法能够从一个初始群体中生成和改进解,逐步趋近于最优解。

这种启发式算法的独特之处在于其对问题空间进行全局搜索,并通过模拟“适者生存”原则来逐步优化解决方案。

## 基本工作原理### 1. 初始化种群遗传算法的第一步是创建一个初始种群,其中包含由染色体表示的个体。

染色体通常是由二进制编码的基因组成,每个基因代表解空间中的一个特定值或参数。

### 2. 适应度评估在每一代,通过适应度函数评估每个个体的适应性。

适应度函数用于衡量个体在解空间中的性能,其数值越高表示个体越适应解决问题。

### 3. 选择选择阶段模拟了自然选择中的“适者生存”原则,使适应性较高的个体更有可能被选中用于繁殖下一代。

各种选择算法(如轮盘赌选择、锦标赛选择)被用于确定哪些个体将传递其基因。

### 4. 交叉(交叉互换)在交叉阶段,选定的个体配对并通过染色体交叉互换部分基因。

这模拟了生物学中的基因重组过程,引入新的解组合。

### 5. 变异为了增加种群的多样性,一些个体可能会经历变异操作,即在其染色体中引入随机变化。

变异有助于避免陷入局部最优解,提高全局搜索能力。

### 6. 生成下一代通过选择、交叉和变异等操作,新一代个体被创建。

这个过程循环进行,直到达到预定的停止条件,如达到最大迭代次数或满足特定收敛准则。

## 应用领域遗传算法在众多领域取得了成功应用,包括但不限于:- **组合优化问题**:如旅行商问题、作业调度等。

- **参数优化**:调整模型参数以优化性能。

遗传算法导论(论文翻译)

a遗传算法导论潜在的能量是估计有多少序列的物理阻力将形成,如果要被迫合成为一个想要得到的最优结构——耗费最小能量和最优适应性。

当然了,也有时候我们不想得到在形成物种中最理想化的遗传物质结构(序列)结果的物理阻力。

评估它的存在性——如果不可能的话,这样是很困难的。

给定一个所需结果和理想结构(并且知道一些有关生物物理学的东西),我们就能通过计算氨基酸间彼此的相关作用力,而估计这种潜在的能量,因此,整个最优规则将是可以计算的。

这些例子指出对于候选染色体在两种不同环境里的为实现独一无二能作为标记的抽象编码序列的编码问题,而且在这种编码规则下的剩余空间有最优适度功能。

一个遗传算法就是寻求一种最优适度序列的方法。

遗传算法这个简单的遗传算法模型涉及到三种算法:选择、交叉(单向),还有变异。

选择:这种算法通过选择种群中的染色体而再造种群,染色体装配工,很多时候就像被选择性地再生产。

交叉:这种算法任意地选择一个点,然后交换结果,在两个染色体创造出两个后代的序列节点前前后后,例如,序列为10000100和11111111能在它们每三次创造出两个子代之后实现交叉,交叉就能粗糙地在两个被称为单倍体的有机体间发生交叉或者生物物理重组。

变异:这种算法是随机抛出染色体上的一些序列,例如序列号为0000100将在第二个序列点上产生01000100序列,变异也能以一个很小的概率值(0.001)发生子啊同一个序列的同意位点上。

1.6一个简单的遗传算法我们给定了一个清晰的已定义好的问题去解决,并且一些序列表现是为了一个候补解决方案,一个遗传算法按如下的步骤进行:1.初始化一个有n*l长的染色体随机子代(问题的候选解决方案);2.计算种群每条X染色体的最优序列函数f(x);3.重复以下步骤直到第n群子代被创造出来;a.在当前种群中选择一双父代染色体,这可能会受到不变增长变化着的最优动能影响,选择是在“无可替代”的条件下为完成的,意味着,一些相同的染色体可以被多次选择直到它们成为父代。

遗传算法 原理

遗传算法原理遗传算法(Genetic Algorithm,GA)是一种启发式优化算法,通过模拟自然界的进化过程,以一种迭代的、优胜劣汰的方式寻求问题的最优解。

它是计算智能领域中最常用的优化方法之一,被广泛应用于许多领域,如组合优化、机器学习、人工智能等。

遗传算法的原理基于达尔文的进化论和孟德尔的遗传学理论。

它模拟了自然界中生物个体的繁殖、变异和适应过程。

遗传算法中的个体通过编码表示问题的潜在解决方案,然后根据适应度函数评估个体的适应度,再利用遗传操作(如选择、交叉和变异)对个体进行操作,以产生新的个体,从而实现种群的进化。

遗传算法的主要步骤如下:1. 初始化种群:根据问题的要求,随机生成一组初始个体作为初始种群。

2. 评估适应度:使用适应度函数对种群中的每个个体进行评估,衡量其解决问题的能力。

3. 选择操作:根据个体的适应度大小,选择一部分优秀的个体作为父代,用于产生后代。

4. 交叉操作:从父代中选择两个个体,通过交叉操作生成新的个体。

交叉操作模拟了生物个体的繁殖过程,将个体的染色体片段互换,产生出具有新特征的后代。

5. 变异操作:对交叉得到的新个体进行变异操作。

变异操作模拟了生物个体突变的过程,随机改变个体染色体中的一个或多个基因,以产生更多的多样性。

6. 更新种群:产生了新的个体后,将父代和后代的群体合并,得到更新后的种群。

7. 重复执行步骤2至6,直到满足终止条件。

终止条件可以是达到预设的迭代次数、找到满意的解或运行时间超过限制等。

通过多次迭代,遗传算法可以逐步逼近最优解。

由于遗传算法具有全局搜索能力和自适应性,可以对复杂问题进行全局搜索,并在搜索空间中找到最优解或接近最优解。

虽然遗传算法在实际应用中取得了广泛成功,但它也存在一些局限性。

首先,遗传算法对问题的求解需要大量的计算资源和时间。

其次,遗传算法对算法参数的选择比较敏感,不同的参数设置可能会导致不同的解。

此外,由于遗传算法是一种启发式算法,它无法保证找到全局最优解,只能找到较优解。

医药卫生 - 外文文献—遗传算法

However, genetic algorithms also have some disadvantages.The formulation of fitness function, the usage of population size, the choice of the importani parameters such as the rate of mutation and crossover, and the 父Jecrion criteria criterion of new population should be carefully carried out. Any inappropriate choice will make it difficult for the algorithm io converge, or it simply produces meaningle~s results 2.2 Genetic Algorithms 2.2.1 Basic Procedure

遗传算法遗传代数

遗传算法遗传代数全文共四篇示例,供读者参考第一篇示例:遗传算法是一种模拟生物进化过程的计算方法,通过模拟自然界中的遗传、交叉和变异等现象,来寻找问题的最优解。

其中一个重要的概念就是遗传代数,它指的是在进化过程中经过的迭代次数。

本文将深入探讨遗传算法中的遗传代数,包括其概念、作用及相关应用。

一、遗传代数的概念遗传代数是指在遗传算法中迭代的次数,也可以理解为算法运行的轮数。

在每一代中,通过选择、交叉和变异等操作,遗传算法可以生成新一代的个体,经过多代的演化,最终可以得到一个较好的解。

遗传代数通常是遗传算法优化过程的一个重要指标,代表了算法搜索空间的覆盖程度以及收敛速度。

遗传代数在遗传算法中起着至关重要的作用。

通过不断迭代,算法可以逐步向问题的最优解靠近。

每一代中都会生成新的个体,并通过选择操作来筛选出更好的个体,从而不断提升种群的适应度。

遗传代数也可以反映算法的运行效率和收敛速度。

通常情况下,随着代数的增加,种群的适应度会逐渐提升,直到达到最优解。

遗传代数在实际问题求解中有着广泛的应用。

在工程优化、机器学习、组合优化等领域,遗传算法通常都是一个重要的优化工具。

通过调节遗传算法的参数和遗传代数,可以有效地找到问题的最优解。

遗传代数也可以用于衡量算法的效率和稳定性,为算法的改进提供参考。

总结:遗传算法是一种模拟生物进化过程的计算方法,遗传代数是遗传算法中迭代的次数。

遗传代数在遗传算法中扮演着至关重要的角色,反映了算法搜索空间的覆盖程度和收敛速度。

通过调节遗传代数以及其他参数,可以有效地解决一系列实际问题。

随着科技的不断进步,遗传算法和遗传代数将会在更多领域发挥重要作用,为社会发展和科学研究提供新的思路和方法。

第二篇示例:遗传算法(Genetic algorithm)是一种受到生物界进化论启发的计算方法,用于解决复杂的优化、搜索和机器学习问题。

遗传算法模拟了自然选择和遗传机制,通过适者生存的原则来搜索最优解。

进化计算论文

进化计算论文----遗传算法的过去、现在和未来学号 **********姓名王欢专业管理科学1.引言遗传算法(Genetic Algorithm)是模拟达尔文生物进化论的自然选择和遗传学机理的生物进化过程的计算模型,是一种通过模拟自然进化过程搜索最优解的方法,它最初由美国Michigan大学J.Holland教授于1975年首先提出来的,并出版了颇有影响的专著《Adaptation in Natural and Artificial Systems》,GA这个名称才逐渐为人所知,J.Holland教授所提出的GA通常为简单遗传算法(SGA)。

本文对进化计算这一新兴学科作一综述,并对未来的研究方向进行展望。

论文的主要内容为:首先,概述了遗传算法的产生与发展;然后主要介绍了进化计算的国内外研究现状;最后是遗传算法未来的应用展望。

2.遗传算法的产生和发展大自然是人类获得灵感的源泉。

将生物界所提供的答案应用于工程问题的求解被实践证明是一个成功的有着辉煌前景的方法。

进化的历史告诉我们,生物的进化是一个漫长而复杂的过程,在这个过程中,生物从低级、简单的状态向高级、复杂的状态演变。

现在,人们已经认识到进化不仅仅是生命科学的范畴,早在二十世纪六十年代初,美国Michigan 大学的J. H. Holland 教授就意识到了生物进化过程中蕴含着的朴素的优化思想,他借鉴了达尔文的生物进化论和孟德尔的遗传定律的基本思想,并将其进行提取、简化与抽象,提出了第一个进化计算算法-遗传算法。

1975 年出版了他的专著《Adaptation in Natural and Artificial Systems》[2],标志着遗传算法的正式诞生。

在这本专著中,他称之为“Genetic Plans”,详细阐述了遗传算法的基本思想和结构框架。

"Genetic Algorithms"一词是首先出现在J.D.Bagley的博士论文中,他研究了遗传算法在博弈论(六子棋)中的参数搜索,这是遗传算法最早的应用。

董素媛遗传算法

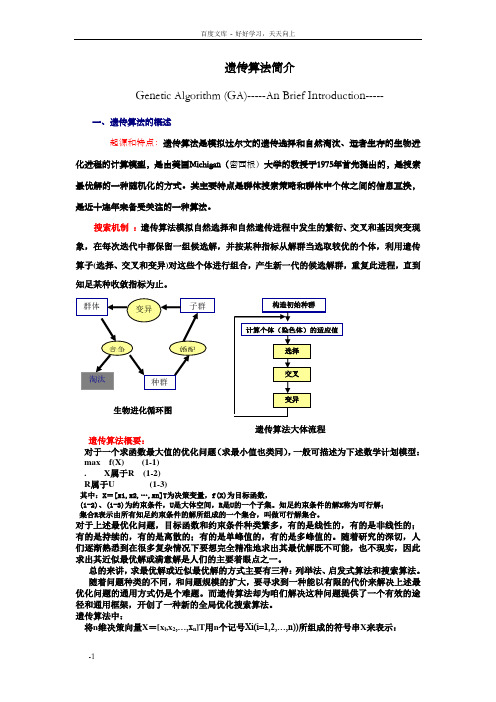

遗传算法简介Genetic Algorithm (GA)-----An Brief Introduction-----一、遗传算法的概述起源和特点:遗传算法是模拟达尔文的遗传选择和自然淘汰、适者生存的生物进化进程的计算模型,是由美国Michigan(密西根)大学的教授于1975年首先提出的,是搜索最优解的一种随机化的方式。

其主要特点是群体搜索策略和群体中个体之间的信息互换,是近十连年来备受关注的一种算法。

搜索机制:遗传算法模拟自然选择和自然遗传进程中发生的繁衍、交叉和基因突变现象,在每次迭代中都保留一组候选解,并按某种指标从解群当选取较优的个体,利用遗传算子(选择、交叉和变异)对这些个体进行组合,产生新一代的候选解群,重复此进程,直到知足某种收敛指标为止。

遗传算法大体流程遗传算法概要:对于一个求函数最大值的优化问题(求最小值也类同),一般可描述为下述数学计划模型:max f(X) (1-1). X属于R (1-2)R属于U (1-3)其中:X=[x1,x2,…,xn]T为决策变量,f(X)为目标函数,(1-2)、(1-3)为约束条件,U是大体空间,R是U的一个子集。

知足约束条件的解X称为可行解;集合R表示由所有知足约束条件的解所组成的一个集合,叫做可行解集合。

对于上述最优化问题,目标函数和约束条件种类繁多,有的是线性的,有的是非线性的;有的是持续的,有的是离散的;有的是单峰值的,有的是多峰值的。

随着研究的深切,人们逐渐熟悉到在很多复杂情况下要想完全精准地求出其最优解既不可能,也不现实,因此求出其近似最优解或满意解是人们的主要着眼点之一。

总的来讲,求最优解或近似最优解的方式主要有三种:列举法、启发式算法和搜索算法。

随着问题种类的不同,和问题规模的扩大,要寻求到一种能以有限的代价来解决上述最优化问题的通用方式仍是个难题。

而遗传算法却为咱们解决这种问题提供了一个有效的途径和通用框架,开创了一种新的全局优化搜索算法。

遗传算法导论

1 引言近年来 ,遗传算法 (GA)的卓越性能引起人们的关注 .对于以往难以解决的函数优化问题 ,复杂的多目标规划问题 ,工农业生产中的配管、配线问题 ,以及机器学习 ,图象识别 ,人工神经网络的权系数调整和网络构造等问题 ,GA是最有效的方法之一 .虽然GA在许多优化问题中都有成功的应用 ,但其本身也存在一些不足 .例如局部搜索能力差、存在未成熟收敛和随机漫游等现象 ,从而导致算法的收敛性能差 ,需要很长时间才能找到最优解 ,这些不足阻碍了遗传算法的推广应用 .如何改善遗传算法的搜索能力和提高算法的收敛速度 ,使其更好地应用于实际问题的解决中 ,是各国学者一直探索的一个主要课题.之后世界范围内掀起了关于遗传算法的研究与应用热潮2 遗传算法存在的问题及相应的改进措施自然界早已显示出了基因的强大威力 ,通过这种机制 ,一系列的具有智能、自组织、自修整的器官产生了 .人们要在科学研究中效仿这些生物器官 ,那么就必须了解基因、进化的概念 .GA就是这样一种利用自然选择和进化思想在高维空间中寻优的方法 ,它不一定能寻得最优点 ,但是它可以找到更优点 ,这种思路与人类行为中成功的标准是很相似的 .例如不必要求一支军队是最优的 ,要战胜对手只需它比对手更强即可 .因此 GA可能会暂时停留在某些非最优点上 ,直到变异发生使它跃居到另一个更优点上 . GA寻优过程的一个重要特点是它始终保持整个种群的进化 ,这样即使某个体在某时刻丧失了有用的特征 ,这种特征也会被其他个体所保留并延续发展下去 .由于 GA仅需知道目标函数的信息 ,而不需要其连续可微等要求 ,因而具有广泛的适应性 .同时它又是一种采用启发性知识的智能搜索算法 ,所以往往能在搜索空间高度复杂的问题上取得比以往算法 (如梯度法 )更好的效果D. B. Fogel提出的进化即智能的概念[1 0 ],虽然还没有被普遍接受 ,但进化在人类生存进步过程中的重要性已可见一斑 ,因此遗传算法作为生物进化思想在工程计算中的一种体现 ,其前途是光明的 .目前 GA在工程优化、信号处理、模式识别、管理决策、智能系统设计和人工生命等领域的成功利用正说明了这一点 .2. 1 编码表示Holland在运用模式定理分析编码机制时 ,建议使用二进制编码 ,但二进制编码不能直接反映问题的固有结构 ,精度不高 ,个体长度大 ,占用计算机内存多 . Gray编码是将二进制编码通过一个变换进行转换得到的编码 ,其目的就是克服 Hamming悬崖的缺点,动态编码 (dynamic encoding)GA是当算法收敛到某局部最优时增加搜索的精度 ,从而使得在全局最优点附近可以进行更精确的搜索 ,增加精度的办法是在保持串长不变的前提下减小搜索区域 .对于问题的变量是实向量的情形 ,可以直接采用实数进行编码 ,这样可以直接在解的表现型上进行遗传操作 ,从而便于引入与问题领域相关的启发式信息以增加算法的搜索能力.复数编码[5]的GA是为了描述和解决二维问题 ,基因用 x+yi 表示 ;其还可以推广到多维问题的描述中 .多维实数编码[6 ]GA,使无效交叉发生的可能性大大降低 ,同时其合理的编码长度也有助于算法在短时间内获得高精度的全局最优解 .在组合优化中 ,可以使用有序串编码 ,例如在文献 [7]中用自然数编码巧妙地解决了VRP问题 .当问题的表示是树和图时 ,我们还可以使用结构式编码2. 2 适应度函数适应度函数是用来区分群体中个体好坏的标准 ,是自然选择的唯一标准 ,选择的好坏直接影响算法的优劣 .引入适应值调节和资源共享策略可以加快收敛速度和跳出局部最优点 .对适应值进行调节就是通过变换改变原适应值间的比例关系 ,常用的比例变换有线性变换、乘幂变换和指数变换等 .对于一个问题具体采用什么变换才能达到较优的效果 ,V. Kreinovich等在文献 [8]中做了较详细的讨论而在文献 [9]中则是采用共享的技术 ,对子群的形成和稳定起了一定作用 ,文中主要用子群消失时间的近似形式估计 Sharing的界 .文献 [1 0 ]中采用了依据搜索进展可变的适应值函数 ,并应用于 CuttingProblem取得较好效果 .文献 [1 1 ]中设计了自适应选取遗传算法的适应值函数的方法 ,该方法的计算量要比排序选择操作的计算量小的多 ,而且有效的避免了算法的非成熟收敛 .2 .3 选择策略优胜劣汰的选择机制使得适应值大的个体有较大的存活机会 ,不同的选择策略对算法性能有较大的影响 .轮盘赌法是使用最多的选择策略 ,但这种策略可能会产生较大的抽样误差 ,于是对此提出了很多的改进方法 ,如繁殖池选择[1 2 ],Boltzmann选择[1 3 ]等等 .但是这几种策略都是基于适应值比例的选择 ,常常会出现早熟收敛现象和停滞现象 .为此又提出了非线性排名选择[3 ],这种选择不仅避免了上述问题 ,而且可以直接使用原始适应值进行排名选择 ,而不需对适应值进行标准化 ;但这种选择在群体规模很大时 ,其额外计算量(如计算总体适应值和排序 )也相当可观 ,甚至在进行并行实现时有时要带来一些同步限制 .基于局部竞争机制的选择如 (λ+μ)选择[1 4],它使双亲和后代有同样的生存竞争机会在一定程度上避免了这些问题 .在 [1 5]中作者采用了类似梯度的方式来选择 ,不仅使较差的染色体比较好的染色体得到更大的改进 ,而且还不断产生新的个体 ,从而不断拓展了新的搜索空间 . [1 6 ]中作者引入了 Harvesting Strategies来分析遗传算法的性能 ,Harvesting Strategies是指在每一代交叉和突变后进行两次乃至多次筛选作为下面的群体 .采用了 Disruptive Selection,它吸收了优等和劣等个体 ,实验结果表明了两极分化有可能更容易找到最优解 .为了提高种群的多样性 ,提出一种基于免疫多样性的选择算子[1 8],该选择算子依赖于串的稠密度和适应值 ,串的稠密度越大 ,其保留下来的可能性越小 ,具体事例证明改进算法是有效的 .2 . 4 控制参数控制参数一般有群体大小 ,交换概率 ,变异概率等 ,这些参数对遗传算法性能影响较大 .在标准的遗传算法中采用经验进行估计 ,这将带来很大的盲目性 ,而影响算法的全局最优性和收敛性 .目前许多学者意识到这些参数应该随着遗传进化而自适应变化 ,Davis提出自适应算子概率方法 [1 9],即用自适应机制把算子概率与算子产生的个体适应性结合 ,高适应性值被分配高算子概率 . Whitley提出一种自适应突变策略与一对父串间的 Hamming距离成反比 [2 0 ],结果显示能有效地保持基因的多样性 .张良杰等通过引入 i位改进子空间概念 ,采用模糊推理技术来确定选取突变概率的一般性原则 [2 1 ].在文献[2 2 ]中设计了一种群体规模可变的遗传算法 ,它提出每个个体应当有年龄及生命期的概念并淘汰年龄大于生命期的个体从而使遗传算法动态的控制了群体数目 ,这种方法可以找出一个接近最小代价的遗传算法 ,同时尽量将群体规模保持在现有水平 ,防止群体规模的指数级增长 ,以降低计算的开销 .丁承明等提出利用正交试验法去优化选取 GA控制参数 [2 3 ],这种方法利用正交试验的均衡分散性使得通过较少的试验次数就可搜索绝大部分参数组合空间 ,而且还可以确定哪个参数对 GA结果影响最显著 ,然后有针对性地进行精确搜索 ,从而使得GA参数问题得到圆满解决 .为保证种群的有用多样性 ,提出动态群法[2 4],即当迭代到一定代数 ,若目标函数的值相同 ,则现存种群中的较差的 N个染色体被随机产生的 N个染色体代替 ,使进化过程中不断有新个体引入 . [2 5]中用模糊规则对选择概率和变异概率进行控制 ,在线改变其值 ,相应的算例表明 ,有较好的性能2. 5 遗传算子基本遗传算法中采用单点交叉算子和简单的变异算子 .它们操作比较简单 ,计算量小 ,但是在使用过程中有很大的局限性 ,例如 :由于单点交叉破坏模式的概率较小 ,至使搜索到的模式数也较少 ,使算法具有较低的搜索能力 . Feng etal.对多维连续空间的GA的杂交多样性进行了分析 ,通过建立相应的数学模型 ,Feng解释了在多维连续空间和大规模群体中使用均匀杂交算子[2 6 ]是如何探索新的解空间区域 .为了使得变异能够根据解的质量自适应的调整搜索区域 ,从而能较明显地提高搜索能力 ,提出自适应变异算子[2 7].为了保护适应值较高的模式 ,提出自适应交叉和变异 [2 8],如果遇到适应值较高的模式 ,则通过随机引入模式外的位而进行保护 .为了克服早熟 ,引入多种群 GA[2 9],不同种群赋以不同的控制参数 ,实现不同的搜索目的 ,通过移民算子联系各种群 ,通过人工选择算子保存各种群每个进化代中的最优个体 .为了防止近亲繁殖 ,扩大种群的多样性 ,抑制超长个体的快速繁殖 ,引进近亲繁殖算子 ,两个个体是否为近亲可用基因片段的 Hamming距离来判断 ,距离越大 ,则为近亲的可能越小 ;为加强局部搜索能力 ,增加漂移算子 ,将染色体各基因片段的后二分之一的基因分别按一定的概率做 1的随机漂移 ,排位越后的基因漂移的概率越大 ,由此产生一定数量的新个体 ,用基因预选机制的小生境技术控制漂移方向[3 0 ].因为格点法产生的点集能均匀地分布于搜索空间 ,并且佳点又是最好的格点 ,所以可以用数论中的佳点集理论设计交叉算子[3 1 ],结果表明它的搜索效果要比纯随机法好 ,而且有效的避免早熟现象 .基于生物免疫性提出的免疫算子 [3 2 ],能够明显抑制进化过程中的退化现象 ,减轻 GA后期的波动 ,从而提高了搜索效率和收敛速度 . [3 3 ]中提出的 SRM(self-reproduction)算子增强了种群的多样性 ,CM(crossove and mutation)算子促进了有利变异的增加 ,从而使算法大大节省了存贮空间和运行时间 .采用“尺度收缩”策略的混沌变异算子 [3 4]能明显的改善群体平均适应值 ,提高算法的性能 ,是解决优化问题的有效方法 .2 . 6 综合方面文献 [3 5]中提出了可分解 /可拼接 GA编码 ,并基于此编码分别在种群层次和基因层次发展了动态变异和动态选择操作 ,这种方法很大程度上避免了早熟问题 .增强型 GA[3 6 ]中 ,引入了几个新算子和新的种群迁移策略 ,并用其对模糊逻辑控制器进行设计 ,得到了便于理解的模糊集和模糊规则 .用小波分析中的多尺度分析对 GA中的染色体进行多尺度分解 ,这样分解后的染色体的长度变短 ,基因交换、变异等遗传操作更为彻底 ,有效的克服了基因丢失引起的早熟问题 [3 7].小生境技术不仅能够保证群体中解的多样性 ,而且具有很强的引导进化能力 ,所以小生境技术的引入 ,提高了 GA处理多峰函数优化问题的能力[3 8].将模拟退火过程引入遗传算法[3 9],在优选交叉和变异个体的过程中加入一定的“扰动”,以达到保持种群内位串的多样性和位串之间的竞争机制 ,克服了算法易陷于极小点的问题 ,使得搜索沿着全局最优方向进行 .广义遗传算法[40 ],它以多点突变操作为主 ,以基因交叉操作为辅 ,实现了从一个局部最优状态到另一个局部最优状态的转移 ,使算法获得全局最优 .为了使 GA用于约束优化 ,提出一种非稳态罚函数 GA[41 ],非稳态罚函数是遗传代数的函数 ,当代数增加时 ,罚函数也随着增大 ,同时给GA带来更多的选择压力 ,促使 GA找到可行解 .综合遗传算法的全局性和神经网络的并行快速性等特点 ,提出的遗传神经网络算法[42 ],可克服遗传算法最终进化至最优解较慢和神经网络易陷入局部解的缺陷 ,具有较好的全局性和收敛速度 .采用面向对象技术设计了面向对象遗传算法[43 ],这种方法改变了在传统的 GA中各个函数之间只有参数的传递 ,而没有代码的继承性的状况从概念上提高了软件的可重用性 ,用户可以更方便的设计和实现自己的编码方案和遗传算子 .变异基遗传算法[44],采用变异算子进行局部优化搜索 ,并利用随机初始化技术使算法在局部搜索能力提高的同时仍有可能寻找到全局最优解 .贪婪遗传算法[45]用在二次分配问题中取得了较好的效果 ,在该算法中引入了新的交叉算子和移民算子 ,保证了种群的多样性 ;并且通过比赛竞争使得各种群得到进化 ,很好的解决了种群多样性及对个别好个体偏爱之间的矛盾 .3 遗传算法的发展动向 (GA' s developmen-tal trends)GA在应用方面的丰硕成果 ,使人们对它的发展前景充满信心 .其主要应用领域在于函数优化 (非线性 ,多模型 ,多目标等 ),机器人学 (移动机器人路径规划 ,关节机器人运动轨迹规划 ,细胞机器人的结构优化等 ),控制 (瓦斯管道控制 ,防避导弹控制 ,机器人控制等 ),规划 (生产规划 ,并行机任务分配等 ),设计 (VLSI布局 ,通信网络设计 ,喷气发动机设计等 ),组合优化 (TSP问题 ,背包问题 ,图分划问题等 ),图象处理 (模式识别 ,特征提取 ,图象恢复等 ),信号处理 (滤波器设计等 ),人工生命 (生命的遗传进化等 ).此外遗传算法的研究出现了几个引人注目的新动向 :3 . 1 基于遗传算法的机器学习这一新的研究方向把遗传算法从历史离散的搜索空间的优化搜索算法扩展到具有独特的规则生成功能的崭新的机器学习算法 .这一新的学习机制对于解决人工智能中知识获取和知识优化精炼的瓶颈难题带来了希望 .遗传算法作为一种搜索算法从一开始就与机器学习有着密切联系 .分类器系统 CS-1是 GA的创立者 Holland教授等实现的第一个基于遗传算法的机器学习系统 .分类器系统在很多领域都得到了应用 .例如 ,分类器系统在学习式多机器人路径规划系统中得到的成功应用 ; Goldberg研究了用分类器系统来学习控制一个煤气管道仿真系统 ;Wilson研究了一种用于协调可移动式视频摄像机的感知—运动的分类器系统等 .分类器系统在基于遗传算法的机器学习研究中影响很大 ,但具体实现方法和要解决的具体问题有关 .基于遗传算法的概念学习是近几年来机器学习领域的一个较为引人注目的研究方向 ,由于概念学习隐含的搜索机制 ,使得遗传算法在概念学习中有用武之地 .目前也有一些嵌入领域知识的基于遗传算法的机器学习的研究 ,如将概念学习中特有的操作遗传操作化 ,并显示出一定的优点 .此外 ,学习分类系统的并行实现在基于遗传算法的机器学习研究中也占有相当的分量 .3 . 2 遗传算法与其他计算智能方法的相互渗透和结合遗传算法正日益和神经网络、模糊推理以及混沌理论等其他智能计算方法相互渗透和结合 ,必能达到取长补短的作用 .近年来在这方面已经取得不少研究成果 ,并形成了“计算智能”的研究领域 ,这对开拓 2 1世纪中新的智能计算技术将具有重要的意义 . GA的出现使神经网络的训练 (包括连接权系数的优化、网络空间结构的优化和网络的学习规则优化 )有了一个崭新的面貌 ,目标函数既不要求连续 ,也不要求可微 ,仅要求该问题可计算 ,而且它的搜索始终遍及整个解空间 ,因此容易得到全局最优解 .GA与神经网络的结合正成功的被用于从时间序列的分析来进行财政预算 ,在这些系统中 ,训练信号是模糊的 ,数据是有噪声的 ,一般很难正确的给出每个执行的定量评价 ,如采用 GA来学习 ,就能克服这个困难 ,显著提高了系统的性能 . Muhlenbein分析了多层感知机网络的局限性 ,并猜想下一代神经网络将会是遗传神经网络 .遗传算法还可以用于学习模糊控制规则和隶属度函数 ,从而更好地改善模糊系统的性能 .文献 [46 ]中将模糊逻辑、神经网络和遗传算法三者有机的结合起来应用于温室夏季温湿度控制中 ,实验结果表明得到了良好的控制效果 .混沌表现出的随机性是系统内在的随机性 ,被称为伪随机性 ,它在生物进化中起着重要的作用 ,是系统进化与信息之源 .混沌与遗传算法的结合已有人进行过尝试 ,如吴新余等[47]采用多种混沌模型构造随机开关 ,以此控制交叉操作以改进 GA的性能 .文献 [3 4]中更加直接 ,采用混沌序列构造变异算子 ,为遗传算法的实现开辟了新的途径 .3 . 3 并行处理的遗传算法并行处理的遗传算法的研究不仅是遗传算法本身的发展 ,而且对于新一代智能计算机体系结构的研究都是十分重要的 . GA在操作上具有高度的并行性 ,许多研究人员都正在探索在并行机上高效执行 GA的策略 .近几年也发表了不少这方面的论文 ,研究表明 ,只要通过保持多个群体和恰当地控制群体间的相互作用来模拟并执行过程 ,即使不使用并行计算机 ,我们也能提高算法的执行效率 .在并行GA的研究方面 ,一些并行 GA模型已经被人们在具体的并行机上执行了 ;并行 GA可分为两类 :一类是粗粒度并行 GA,它主要开发群体间的并行性 ,如Cohoon分析了在并行计算机上解图划分问题的多群体 GA的性能 ;另一类是细粒度 GA,它主要开发一个群体中的并行性 ,如 Kosak将群体中的每个个体映射到一个连接机的处理单元上 ,并指出了这种方法对网络图设计问题的有效性 .3 .4 遗传算法与人工生命的渗透人工生命是用计算机、机械等人工媒体模拟或构造出的具有自然生物系统特有行为的人造系统 ,人工生命与遗传算法有着密切的关系 ,基于遗传算法的进化模型是研究人工生命现象的重要理论基础 .虽然人工生命的研究尚处于启蒙阶段 ,但遗传算法已在其进化模型、学习模型、行为模型、自组织模型等方面显示出了初步的应用能力 ,并且必将得到更为深入的应用和发展 .人工生命与遗传算法相辅相成 ,遗传算法为人工生命的研究提供了一个有效的工具 ,人工生命的研究也必将促进遗传算法的进一步发展 .3 . 5 遗传算法与进化规则及进化策略的结合遗传算法、进化规则及进化策略是演化计算的三个主要分支 ,这三种典型的进化算法都以自然界中生物的进化过程为自适应全局优化搜索过程的借鉴对象 ,所以三者之间有较大的相似性 ;另一方面 ,这三种算法又是从不完全相同的角度出发来模拟生物的进化过程 ,分别是依据不同的生物进化背景、不同的生物进化机制而开发出来的 ,所以三者之间也有一些差异 .随着各种进化计算方法之间相互交流深入 ,以及对各种进化算法机理研究的进展 ,要严格地区分它们既不可能 ,也没有必要 .在进化计算领域内更重要的工作是生物进化机制 ,构造性能更加优良、适应面更加广泛的进化算法 .4 结论遗传算法作为一种非确定性的拟自然算法 ,为复杂系统的优化提供了一种新的方法 ,并且经过实践证明效果显著 .尽管遗传算法在很多领域具有广泛的应用价值 ,但它仍存在一些问题 ,各国学者一直在探索着对遗传算法的改进 ,以使遗传算法有更广泛的应用领域 .总之,遗传算法的未来是非常的美好的,只要我们对它们进行细致的分析,对它的缺点加以改造,优点进行继承,把它应用到我们的生产当中去,这样在生产当中还可以对它的缺点进行完善.。

外文翻译-遗传算法

What is a genetic algorithm?●Methods of representation●Methods of selection●Methods of change●Other problem-solving techniquesConcisely stated, a genetic algorithm (or GA for short) is a programming technique that mimics biological evolution as a problem-solving strategy. Given a specific problem to solve, the input to the GA is a set of potential solutions to that problem, encoded in some fashion, and a metric called a fitness function that allows each candidate to be quantitatively evaluated. These candidates may be solutions already known to work, with the aim of the GA being to improve them, but more often they are generated at random.The GA then evaluates each candidate according to the fitness function. In a pool of randomly generated candidates, of course, most will not work at all, and these will be deleted. However, purely by chance, a few may hold promise - they may show activity, even if only weak and imperfect activity, toward solving the problem.These promising candidates are kept and allowed to reproduce. Multiple copies are made of them, but the copies are not perfect; random changes are introduced during the copying process. These digital offspring then go on to the next generation, forming a new pool of candidate solutions, and are subjected to a second round of fitness evaluation. Those candidate solutions which were worsened, or made no better, by the changes to their code are again deleted; but again, purely by chance, the random variations introduced into the population may have improved some individuals, making them into better, more complete or more efficient solutions to the problem at hand. Again these winning individuals are selected and copied over into the next generation with random changes, and the process repeats. The expectation is that the average fitness of the population will increase each round, and so by repeating this process for hundreds or thousands of rounds, very good solutions to the problem can be discovered.As astonishing and counterintuitive as it may seem to some, genetic algorithms have proven to be an enormously powerful and successful problem-solving strategy, dramatically demonstratingthe power of evolutionary principles. Genetic algorithms have been used in a wide variety of fields to evolve solutions to problems as difficult as or more difficult than those faced by human designers. Moreover, the solutions they come up with are often more efficient, more elegant, or more complex than anything comparable a human engineer would produce. In some cases, genetic algorithms have come up with solutions that baffle the programmers who wrote the algorithms in the first place!Methods of representationBefore a genetic algorithm can be put to work on any problem, a method is needed to encode potential solutions to that problem in a form that a computer can process. One common approach is to encode solutions as binary strings: sequences of 1's and 0's, where the digit at each position represents the value of some aspect of the solution. Another, similar approach is to encode solutions as arrays of integers or decimal numbers, with each position again representing some particular aspect of the solution. This approach allows for greater precision and complexity than the comparatively restricted method of using binary numbers only and often "is intuitively closer to the problem space" (Fleming and Purshouse 2002, p. 1228).This technique was used, for example, in the work of Steffen Schulze-Kremer, who wrote a genetic algorithm to predict the three-dimensional structure of a protein based on the sequence of amino acids that go into it (Mitchell 1996, p. 62). Schulze-Kremer's GA used real-valued numbers to represent the so-called "torsion angles" between the peptide bonds that connect amino acids. (A protein is made up of a sequence of basic building blocks called amino acids, which are joined together like the links in a chain. Once all the amino acids are linked, the protein folds up into a complex three-dimensional shape based on which amino acids attract each other and which ones repel each other. The shape of a protein determines its function.) Genetic algorithms for training neural networks often use this method of encoding also.A third approach is to represent individuals in a GA as strings of letters, where each letter again stands for a specific aspect of the solution. One example of this technique is Hiroaki Kitano's "grammatical encoding" approach, where a GA was put to the task of evolving a simple set of rules called a context-freegrammar that was in turn used to generate neural networks for a variety of problems (Mitchell 1996, p. 74).The virtue of all three of these methods is that they make it easy to define operators that cause the random changes in the selected candidates: flip a 0 to a 1 or vice versa, add or subtract from the value of a number by a randomly chosen amount, or change one letter to another. (See the section on Methods of change for more detail about the genetic operators.) Another strategy, developed principally by John Koza of Stanford University and called genetic programming, represents programs as branching data structures called trees (Koza et al. 2003, p. 35). In this approach, random changes can be brought about by changing the operator or altering the value at a given node in the tree, or replacing one subtree with another.Figure 1:Three simple program trees of the kind normally used in genetic programming. The mathematical expression that each one represents is given underneath.It is important to note that evolutionary algorithms do not need to represent candidate solutions as data strings of fixed length. Some do represent them in this way, but others do not; for example, Kitano's grammatical encoding discussed above can be efficiently scaled to create large and complex neural networks, and Koza's genetic programming trees can grow arbitrarily large as necessary to solve whatever problem they are applied to.Methods of selectionThere are many different techniques which a genetic algorithm can use to select the individuals to be copied over into the next generation, but listed below are some of the most common methods.Some of these methods are mutually exclusive, but others can be and often are used in combination.Elitist selection: The most fit members of each generation are guaranteed to be selected. (Most GAs do not use pure elitism, but instead use a modified form where the single best, or a few of the best, individuals from each generation are copied into the next generation just in case nothing better turns up.)Fitness-proportionate selection: More fit individuals are more likely, but not certain, to be selected.Roulette-wheel selection: A form of fitness-proportionate selection in which the chance of an individual's being selected is proportional to the amount by which its fitness is greater or less than its competitors' fitness. (Conceptually, this can be represented as a game of roulette - each individual gets a slice of the wheel, but more fit ones get larger slices than less fit ones. The wheel is then spun, and whichever individual "owns" the section on which it lands each time is chosen.)Scaling selection: As the average fitness of the population increases, the strength of the selective pressure also increases and the fitness function becomes more discriminating. This method can be helpful in making the best selection later on when all individuals have relatively high fitness and only small differences in fitness distinguish one from another.Tournament selection: Subgroups of individuals are chosen from the larger population, and members of each subgroup compete against each other. Only one individual from each subgroup is chosen to reproduce.Rank selection: Each individual in the population is assigned a numerical rank based on fitness, and selection is based on this ranking rather than absolute differences in fitness. The advantage of this method is that it can prevent very fit individuals from gaining dominance early at the expense of less fit ones, which would reduce the population's genetic diversity and might hinder attempts to find an acceptable solution.Generational selection: The offspring of the individuals selected from each generation become the entire next generation. No individuals are retained between generations.Steady-state selection: The offspring of the individuals selected from each generation go back into the pre-existing gene pool, replacing some of the less fit members of the previous generation. Some individuals are retained between generations.Hierarchical selection: Individuals go through multiple rounds of selection each generation. Lower-level evaluations are faster and less discriminating, while those that survive to higher levels are evaluated more rigorously. The advantage of this method is that it reduces overall computation time by using faster, less selective evaluation to weed out the majority of individuals that show little or no promise, and only subjecting those who survive this initial test to more rigorous and more computationally expensive fitness evaluation.Methods of changeOnce selection has chosen fit individuals, they must be randomly altered in hopes of improving their fitness for the next generation. There are two basic strategies to accomplish this. The first and simplest is called mutation. Just as mutation in living things changes one gene to another, so mutation in a genetic algorithm causes small alterations at single points in an individual's code.The second method is called crossover, and entails choosing two individuals to swap segments of their code, producing artificial "offspring" that are combinations of their parents. This process is intended to simulate the analogous process of recombination that occurs to chromosomes during sexual reproduction. Common forms of crossover include single-point crossover, in which a point of exchange is set at a random location in the two individuals' genomes, and one individual contributes all its code from before that point and the other contributes all its code from after that point to produce an offspring, and uniform crossover, in which the value at any given location in the offspring's genome is either the value of one parent's genome at that location or the value of the other parent's genome at that location, chosen with 50/50 probability.Figure 2:Crossover and mutation. The above diagrams illustrate the effect of each of these genetic operators on individuals in a population of 8-bit strings. The upper diagram shows two individuals undergoing single-point crossover; the point of exchange is set between the fifth and sixth positions in the genome, producing a new individual that is a hybrid of its progenitors. The second diagram shows an individual undergoing mutation at position 4, changing the 0 at that position in its genome to a 1.Other problem-solving techniquesWith the rise of artificial life computing and the development of heuristic methods, other computerizedproblem-solving techniques have emerged that are in some ways similar to genetic algorithms. This section explains some of these techniques, in what ways they resemble GAs and in what ways they differ.•Neural networksA neural network, or neural net for short, is a problem-solving method basedon a computer model of how neurons are connected in the brain. A neuralnetwork consists of layers of processing units called nodes joined bydirectional links: one input layer, one output layer, and zero or more hiddenlayers in between. An initial pattern of input is presented to the input layer ofthe neural network, and nodes that are stimulated then transmit a signal to thenodes of the next layer to which they are connected. If the sum of all theinputs entering one of these virtual neurons is higher than that neuron'sso-called activation threshold, that neuron itself activates, and passes on itsown signal to neurons in the next layer. The pattern of activation thereforespreads forward until it reaches the output layer and is there returned as asolution to the presented input. Just as in the nervous system of biologicalorganisms, neural networks learn and fine-tune their performance over timevia repeated rounds of adjusting their thresholds until the actual outputmatches the desired output for any given input. This process can be supervisedby a human experimenter or may run automatically using a learning algorithm(Mitchell 1996, p. 52). Genetic algorithms have been used both to build and totrain neural networks.Figure 3: A simple feedforward neural network, with one input layer consisting of four neurons, one hidden layer consisting of three neurons, and one output layer consisting of four neurons. The number on each neuron represents its activation threshold: it will only fire if it receives at least that many inputs. The diagram shows the neural network being presented with an input string and shows how activation spreads forward through thenetwork to produce an output.•Hill-climbingSimilar to genetic algorithms, though more systematic and less random, ahill-climbing algorithm begins with one initial solution to the problem at hand, usually chosen at random. The string is then mutated, and if the mutationresults in higher fitness for the new solution than for the previous one, the newsolution is kept; otherwise, the current solution is retained. The algorithm isthen repeated until no mutation can be found that causes an increase in thecurrent solution's fitness, and this solution is returned as the result (Koza et al.2003, p. 59). (To understand where the name of this technique comes from,imagine that the space of all possible solutions to a given problem isrepresented as a three-dimensional contour landscape. A given set ofcoordinates on that landscape represents one particular solution. Thosesolutions that are better are higher in altitude, forming hills and peaks; thosethat are worse are lower in altitude, forming valleys. A "hill-climber" is thenan algorithm that starts out at a given point on the landscape and movesinexorably uphill.) Hill-climbing is what is known as a greedy algorithm,meaning it always makes the best choice available at each step in the hope thatthe overall best result can be achieved this way. By contrast, methods such asgenetic algorithms and simulated annealing, discussed below, are not greedy;these methods sometimes make suboptimal choices in the hopes that they willlead to better solutions later on.•Simulated annealing Another optimization technique similar to evolutionary algorithms is knownas simulated annealing. The idea borrows its name from the industrial processof annealing in which a material is heated to above a critical point to soften it,then gradually cooled in order to erase defects in its crystalline structure,producing a more stable and regular lattice arrangement of atoms (Haupt andHaupt 1998, p. 16). In simulated annealing, as in genetic algorithms, there is afitness function that defines a fitness landscape; however, rather than apopulation of candidates as in GAs, there is only one candidate solution.Simulated annealing also adds the concept of "temperature", a globalnumerical quantity which gradually decreases over time. At each step of thealgorithm, the solution mutates (which is equivalent to moving to an adjacentpoint of the fitness landscape). The fitness of the new solution is thencompared to the fitness of the previous solution; if it is higher, the newsolution is kept. Otherwise, the algorithm makes a decision whether to keep ordiscard it based on temperature. If the temperature is high, as it is initially,even changes that cause significant decreases in fitness may be kept and usedas the basis for the next round of the algorithm, but as temperature decreases,the algorithm becomes more and more inclined to only acceptfitness-increasing changes. Finally, the temperature reaches zero and thesystem "freezes"; whatever configuration it is in at that point becomes thesolution. Simulated annealing is often used for engineering designapplications such as determining the physical layout of components on acomputer chip (Kirkpatrick, Gelatt and Vecchi 1983).遗传算法是什么?表示方法方法的选择变化的方法其他解决问题的技术简明地说,遗传算法(GA)是一种编程技术,模仿生物进化作为一个解决问题的策略。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

遗传算法导论(论文翻译)a遗传算法导论潜在的能量是估计有多少序列的物理阻力将形成,如果要被迫合成为一个想要得到的最优结构――耗费最小能量和最优适应性。

当然了,也有时候我们不想得到在形成物种中最理想化的遗传物质结构(序列)结果的物理阻力。

评估它的存在性――如果不可能的话,这样是很困难的。

给定一个所需结果和理想结构(并且知道一些有关生物物理学的东西),我们就能通过计算氨基酸间彼此的相关作用力,而估计这种潜在的能量,因此,整个最优规则将是可以计算的。

这些例子指出对于候选染色体在两种不同环境里的为实现独一无二能作为标记的抽象编码序列的编码问题,而且在这种编码规则下的剩余空间有最优适度功能。

一个遗传算法就是寻求一种最优适度序列的方法。

遗传算法这个简单的遗传算法模型涉及到三种算法:选择、交叉(单向),还有变异。

选择:这种算法通过选择种群中的染色体而再造种群,染色体装配工,很多时候就像被选择性地再生产。

交叉:这种算法任意地选择一个点,然后交换结果,在两个染色体创造出两个后代的序列节点前前后后,例如,序列为10000100和11111111能在它们每三次创造出两个子代之后实现交叉,交叉就能粗糙地在两个被称为单倍体的有机体间发生交叉或者生物物理重组。

变异:这种算法是随机抛出染色体上的一些序列,例如序列号为0000100将在第二个序列点上产生01000100序列,变异也能以一个很小的概率值(0.001)发生子啊同一个序列的同意位点上。

1.6一个简单的遗传算法我们给定了一个清晰的已定义好的问题去解决,并且一些序列表现是为了一个候补解决方案,一个遗传算法按如下的步骤进行:1. 初始化一个有n*l长的染色体随机子代(问题的候选解决方案);2. 计算种群每条X染色体的最优序列函数f(x); 3. 重复以下步骤直到第n群子代被创造出来;a.在当前种群中选择一双父代染色体,这可能会受到不变增长变化着的最优动能影响,选择是在“无可替代”的条件下为完成的,意味着,一些相同的染色体可以被多次选择直到它们成为父代。

b.以Pc的可能性(交叉概率)下,以随机选择节点的方式开始交叉(带着均衡概念被选中)会形成两个子代,如果交叉没有发生,形成的两个子代简单地为各自父代染色体的复制,这里的概率定义为两个单倍体父代染色体交叉的可能性,同时人工智能是关于“交叉点”的,交叉率定义为两条父代染色体发生交叉位置处的一个序列号。

c.产生突变的两个子代在这个序列号处的发生概率为Pm(突变率),并且在新的子代中标记产生变异的染色体序列号。

如果n为奇数,新的子代将被随机地抛弃掉。

4. 用新的种群取代当前一代; 5. 开始步骤2;这个步骤的每一次迭代被称为一代,人工智能算法典型的迭代次数为50――500次甚至更多次。

一个完整的种群形成称之为一个周期,在周期最后,种群中会产生一个或者多个高适度的染色体。

自从随机性在每个周期里扮演者一个大角色,两个循环里带着不同概率的变异体将很普遍地产生不同的复杂表现。

遗传算法研究者通常报告数据(例如一个循环中最优适度的寻找和一代种群中最优适应的每个个体将被发现)去平均遗传中相关类似问题的许多不同代的情况。

这个简单的步骤被描述为GA的多种应用之基础,有很多细节还有待补充,例如种群的大小,还有发生交叉变异的概率,一个算法的成功通常在很大程度上取决于这些细节,同样也有一些复杂的GA版本(例如:GA在序列的表示函数f(x)和染色体的变异行为,如交叉、突变等上也有很多种版本)。

这些例子将在接下来的章节里一一给出。

作为一个简单的人工智能算法假设l(序列长)为8,序列函数f(x)等于X染色体一小部分序列的编码数字(一个极端简单的适应功能,在这里仅仅是说明的功能),n(种群的大小)为4,Pc=0.7,Pm=0.001,(像自适应功能,l跟n取值仅仅是为简化问题而选择下来)许多典型的(n值在50―1000之间变动),给出的Pc,Pm的值也是一种对平均水平的估值。

最初的(任意的生成)的种群看起来像下表这样:染色体 A B C D 序列编码 00000110 11101110 00100000 00110100 突变位点 2 6 1 3 一个关于GA的寻常选择方法是给予自适应性成比例选择,也在这很多次个体被期待去再造,相当于它们在种群中自适性平均水平下所区分的自适应能力。

(这等同于生物学家所说的“生殖能力”)。

第一部分遗传算法概述一个实现自适应性成比例选择的简单方法是――“转盘循环取样法”(犹太老板1989),她在概念上等同于给予每个个体在它们的自适应区域里一部分循环取样能力,随着转盘旋转,小球形成一种楔形薄片的聚集形状,并且那些一致水平的个体被选择。

在n=4这个例子上面,转盘旋转4次,第一次两次旋转将选择B、C染色体作为父代,第二个两次旋转选择B、D两条染色体做父代(事实上A染色体不能被旋转仅仅是由于抽签这种游戏的侥幸可能性造成,如果转盘旋转多次,通常的结果是将接近理想值)。

一旦一对父代被选择后,以Pc的可能性他们将杂交形成两个后代,如果它们不交叉,后代将是父代双方的简单复制。

假若在上述的例子里,B和D第一次杂交得到的后代染色体序列为E=10110110和F=01101110,B和C父代不杂交,取而代之将形成B和C的序列副本,接下来,每个后代将被概率为Pm的突变控制影响,每个后代。

假设后代E在第二个序列点出突变为E=1011000,后代F和C没有发生交叉,那么后代B将形成B=01101110,这个序列发生交叉处的节点在新一代种群中将遵循如下规则:染色体 E F C B记在新一代中,尽管最优序列(6号位变异)丢失了,整体的自适应度从12/4降为14/4,这种迭代程序将最终造成在每个序列里发生。

1.7遗传算法和传统的搜索方法在之前的第一节里,我们用“搜索”这个词去描述GA的工作原理,这在其他在计算机科学里的“搜索”这一意思形成对比。

关于“搜索”至少有三个意思序列编码 10110000 01101110 00100000 01101110 突变位点 3 5 1 5 存储数据的检索:有一个问题是存在计算机内存里面的高级信息检索,假如你有一个特定顺序下建立的关于“姓名”跟“住址”的大数据库,什么样的方法将是排好序的按“姓”这一关键字搜索的最佳方式呢?“Binary式搜索”是查询出想要得到记录的一种有效方法。

Knuth (1973)描述和分析了许多这样的检索方法。

基于目标的最优路径搜索:有个问题是找到一种算法能在动态给定“出发点”下到目的地的最佳路径。

这种搜索模式是许多人工智能算法里面的核心步骤,一个简单的例子――对于每个学过人工智能的人都熟悉的是“8号难题”,这个在图表1.2里面有阐明。

标号为数字1――8的标题被记在中央处,留下一块空白区域,把一个相邻的数字滑到空白处叫一次“移动”,图表1.2a阐明了一个寻找一种从起点区域移动到标题中给定方位区域的算法问题。

一个关于符合该问题的“检索树”算法,在图表1.2b中有所阐明,“根”节点代表最初的起点,节点上的枝干指出它在此区域里所有可能移动方案下的结果,下面的树枝干含义类似。

这种搜索算法讨论了在人工智能环境下高效搜索出从起点到终点的最佳(这里指最短)路径生成树。

典型的算法有“深度优先树”、“广度优先树”还有“A+平衡树”。

5 3 2 81 2 3 8 4 7 6 5 (a) 1 2 3 84 7 65 4 1 76 1 2 3 5 678 4 2 2 4 . . (b)图表1.2:8号难题。

(a)问题是找到一种移动方案能从给定起始点到标题里指出的区域(目标区域)。

(b)一个基于“8号难题”的部分搜索树。

‘解决方案的搜索:这是一种相对于“最优路径搜索”的更为综合的搜索法。

办法是在一个大区域候选结局方案里面通过“洪范式”遍历而找到一个该问题的最佳方案。

这其中也有遗传算法里面所用到的检索方法。

这里,很明显在第一种和第二章方案里面有个很明显的区别。

第一种方案涉及到一个在有序存储的信息库里面找到一条记录(如:一条电话号码)的问题。

第二种方案里,需要检索的信息没有明确的存储法则,而且后续方案在每步搜索结束后才能开始确定,例如解决“8号难题”的人工智能检索法只有在一颗完整的检索树在其所有节点都存储完毕后才开始,最有趣的问题是一棵树里面有很多种不同的节点需要全部存储。

当然了,搜索树是基于一种特定的算法下一步步去形成的复杂结构,其目标是找到一种最好的或者高质量的解决方案,在只检查该搜索树的一小部分的情况下。

同样地,当用遗传算法检索一个候选方案空间时,不是所有可能的候选方案都能一次性地找到并代入计算;当然了,遗传算法里寻找一个最理想或最佳解决方案时只能检查一小部分可能的候选方案。

“解决方案的搜索”包含“基于给定终点的最优路径搜索”,当一种搜索树里的路径能被作为候选方案而编码时。

对于“8号难题”来说,候选方案可能只是从当前起点移动到一些其他区域的方案列表(只有终端节点是问题中所说的“终点”时才是最终的正确方案)。

然而,许多基于“最优路径搜索”问题都能被“AI搜索树”技术(这里的部分方案是可以评估)很好地得到解决,相比于遗传算法或者类似于遗传算法这样的技术(这里,所有的候选方案必须在其在评估前特有地构成)来说。

然而,标准的“AI搜索树”法(或者,更普遍的说法是构造图表检索法)不常用。

不是所有的问题都需基于路径搜索的。

感谢您的阅读,祝您生活愉快。