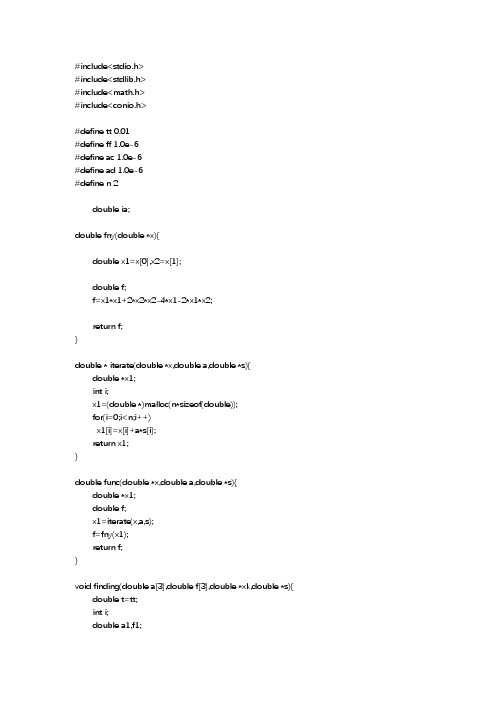

变尺度法BFGS算法的C++源码

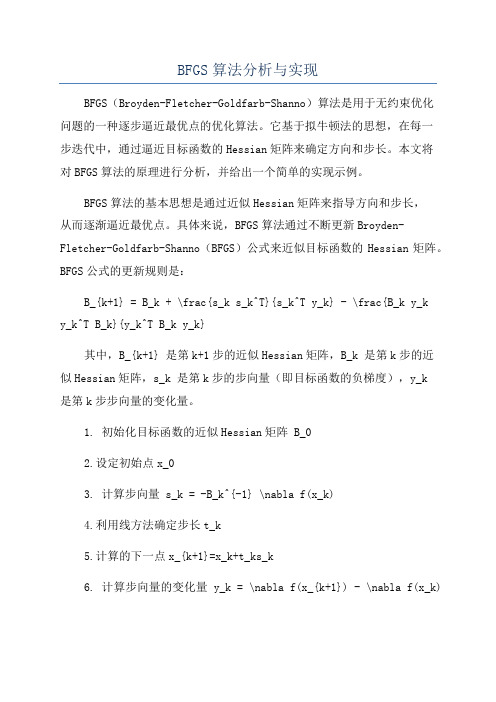

BFGS算法分析与实现

BFGS算法分析与实现BFGS(Broyden-Fletcher-Goldfarb-Shanno)算法是用于无约束优化问题的一种逐步逼近最优点的优化算法。

它基于拟牛顿法的思想,在每一步迭代中,通过逼近目标函数的Hessian矩阵来确定方向和步长。

本文将对BFGS算法的原理进行分析,并给出一个简单的实现示例。

BFGS算法的基本思想是通过近似Hessian矩阵来指导方向和步长,从而逐渐逼近最优点。

具体来说,BFGS算法通过不断更新Broyden-Fletcher-Goldfarb-Shanno(BFGS)公式来近似目标函数的Hessian矩阵。

BFGS公式的更新规则是:B_{k+1} = B_k + \frac{s_k s_k^T}{s_k^T y_k} - \frac{B_k y_ky_k^T B_k}{y_k^T B_k y_k}其中,B_{k+1} 是第k+1步的近似Hessian矩阵,B_k 是第k步的近似Hessian矩阵,s_k 是第k步的步向量(即目标函数的负梯度),y_k是第k步步向量的变化量。

1. 初始化目标函数的近似Hessian矩阵 B_02.设定初始点x_03. 计算步向量 s_k = -B_k^{-1} \nabla f(x_k)4.利用线方法确定步长t_k5.计算的下一点x_{k+1}=x_k+t_ks_k6. 计算步向量的变化量 y_k = \nabla f(x_{k+1}) - \nabla f(x_k)7. 更新近似Hessian矩阵 B_{k+1} = B_k + \frac{s_ks_k^T}{s_k^T y_k} - \frac{B_k y_k y_k^T B_k}{y_k^T B_k y_k}8.判断终止条件,如果满足停止条件,则返回近似最优点,否则返回第3步继续迭代。

下面是一个简单的BFGS算法的Python实现示例:```pythonimport numpy as npdef bfgs(f, df, x0, max_iter=1000, tol=1e-6):n = len(x0)B = np.eye(n) # 初始化近似 Hessian 矩阵为单位矩阵x = x0.copyfor k in range(max_iter):g = df(x) # 计算当前点的梯度s = -np.linalg.solve(B, g) # 计算步向量t=1.0#初始化步长while f(x + t * s) > f(x) + 0.5 * t * np.dot(g, s):t*=0.5#采用二分法步长x_new = x + t * s # 计算的下一点y = df(x_new) - g # 计算步向量的变化量if np.linalg.norm(y) < tol: # 判断终止条件return x_newBs = np.dot(B, s)B += np.outer(y, y) / np.dot(y, s) - np.outer(Bs, Bs) / np.dot(Bs, s) # 更新近似Hessian矩阵x = x_newreturn x# 示例:求解无约束最小化问题 min f(x) = x_1^2 + 2*x_2^2f = lambda x: x[0]**2 + 2 * x[1]**2df = lambda x: np.array([2 * x[0], 4 * x[1]])x_opt = bfgs(f, df, np.array([1, 2]))print('Optimal point:', x_opt)print('Optimal value:', f(x_opt))```在这个示例中,我们求解了一个简单的无约束最小化问题。

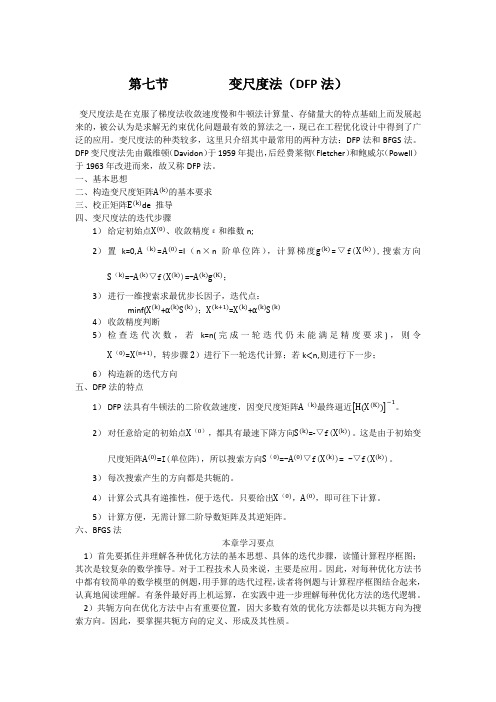

第七节变尺度法

6)构造新的迭代方向

五、DFP法的特点

1)DFP法具有牛顿法的二阶收敛速度,因变尺度矩阵 最终逼近 。

2)对任意给定的初始点 ,都具有最速下降方向 =-▽f( )。这是由于初始变尺度矩阵 =I(单位阵),所以搜索方向 =- ▽f( )=-▽f( )。

3)每次搜产生的方向都是共轭的。

4)计算公式具有递推性,便于迭代。只要给出 , ,即可往下计算。

5)计算方便,无需计算二阶导数矩阵及其逆矩阵。

六、BFGS法

本章学习要点

1)首先要抓住并理解各种优化方法的基本思想、具体的迭代步骤,读懂计算程序框图;其次是较复杂的数学推导。对于工程技术人员来说,主要是应用。因此,对每种优化方法书中都有较简单的数学模型的例题,用手算的迭代过程,读者将例题与计算程序框图结合起来,认真地阅读理解。有条件最好再上机运算,在实践中进一步理解每种优化方法的迭代逻辑。

一、基本思想

二、构造变尺度矩阵 的基本要求

三、校正矩阵 de推导

四、变尺度法的迭代步骤

1)给定初始点 、收敛精度ε和维数n;

2)置k=0, = =I(n×n阶单位阵),计算梯度 =▽f( ),搜索方向 =- ▽f( )=- ;

3)进行一维搜索求最优步长因子,迭代点:

minf( + = +

4)收敛精度判断

第七节

变尺度法是在克服了梯度法收敛速度慢和牛顿法计算量、存储量大的特点基础上而发展起来的,被公认为是求解无约束优化问题最有效的算法之一,现已在工程优化设计中得到了广泛的应用。变尺度法的种类较多,这里只介绍其中最常用的两种方法:DFP法和BFGS法。DFP变尺度法先由戴维顿(Davidon)于1959年提出,后经费莱彻(Fletcher)和鲍威尔(Powell)于1963年改进而来,故又称DFP法。

DFP变尺度法

{

h[i][j]=0;

if(j==i) h[i][j]=1;

}

g1=g2; k=-1;

}else{

int j;

double a1=0,a2=0;

for(i=0;i<n;i++){

dg[i]=g2[i]-g1[i];

dx[i]=xk1[i]-xk[i];

}

for(i=0;i<n;i++){

if(ia==1) { aa=a[1]; *ft=f[1]; break; }

d=(pow(a[0],2)-pow(a[2],2))*(a[0]-a[1])-(pow(a[0],2)-pow(a[1],2))*(a[0]-a[2]);

if(fabs(d)==0) break;

c=((f[0]-f[2])*(a[0]-a[1])-(f[0]-f[1])*(a[0]-a[2]))/d;

ib=0;

if(ia==1) { xx=xk; break; }

ib=0;

for(i=0;i<n;i++) s[i]=0;

for(i=0;i<n;i++)

for(j=0;j<n;j++)

s[i]+= -h[i][j]*g1[j];

aa=lagrange(xk,ft,s);

xk1=iterate(xk,aa,s);

a[1]=(a[0]+a[2])/2;

f[1]=func(xk,a[1],s);

}

}else{

if(*ft>f[1]) {a[0]=aa;f[0]=*ft;}

bfgs算法公式

bfgs算法公式BFGS算法(Broyden-Fletcher-Goldfarb-Shanno算法)是一种用于无约束优化问题的拟牛顿法。

它是由Broyden、Fletcher、Goldfarb和Shanno四位科学家在1970年提出的。

BFGS算法的核心思想是通过逐步改进的方法来逼近目标函数的极小值点。

它基于拟牛顿法的思想,通过估计目标函数的Hessian矩阵的逆来更新搜索方向,从而实现迭代求解的过程。

在BFGS算法中,首先需要选择一个初始点作为起始点,并对Hessian矩阵的逆进行初始化。

然后,根据当前点的信息和目标函数的梯度信息,计算出搜索方向。

接下来,利用线搜索方法确定步长,即在搜索方向上沿着目标函数下降最快的方向前进的距离。

通过更新搜索方向和步长,可以得到下一个点。

然后,根据新点和旧点的信息来更新Hessian矩阵的逆。

重复这个过程,直到满足停止准则为止。

BFGS算法的优点是收敛性好、迭代速度快、不需要计算目标函数的二阶导数(Hessian矩阵)和求解线性方程组。

相比于其他拟牛顿法,BFGS算法的收敛性更好,迭代次数更少。

它被广泛应用于工程优化、机器学习、图像处理等领域。

然而,BFGS算法也存在一些问题。

首先,它需要存储和更新一个n×n的矩阵,如果问题的维度很高,会导致存储和计算的开销很大。

其次,BFGS算法的性能高度依赖于初始点的选择,选择不当可能导致算法陷入局部最优解。

此外,BFGS算法对目标函数的光滑性和凸性要求较高,对于非光滑和非凸的问题效果可能不理想。

为了解决BFGS算法的一些问题,研究者们提出了一些改进算法,如L-BFGS(Limited-memory BFGS)算法、DFP(Davidon-Fletcher-Powell)算法等。

这些改进算法在BFGS算法的基础上进行了改进和优化,进一步提高了算法的收敛性和效率。

BFGS算法是一种有效的无约束优化算法,它通过逐步改进的方法逼近目标函数的极小值点。

bfgs方法范文

bfgs方法范文BFGS(Broyden-Fletcher-Goldfarb-Shanno)方法是一种非线性优化算法,用于寻找无约束最优化问题的最优解。

它利用目标函数和梯度信息来迭代地找到最优解,同时避免了需要计算海森矩阵的复杂性。

BFGS的核心思想是通过近似目标函数的海森矩阵来建立模型,然后使用一个拟牛顿更新公式不断优化这个模型。

具体而言,BFGS方法通过不断更新一个称为Hessian逆矩阵的估计值来逼近真实的海森矩阵。

这个逆矩阵通过迭代的方式计算得出,使得每一步都能够更好地逼近目标函数的局部极值点。

BFGS方法的迭代步骤如下:1. 初始化变量:选择一个初始点x0,设置Hessian逆矩阵的初始值H0为单位矩阵。

2. 计算梯度:计算目标函数的梯度g(xk),其中xk表示当前的点。

3. 计算方向:计算方向pk = -Hk * g(xk),其中Hk表示Hessian逆矩阵的估计值。

4. 线:通过线确定下一步的步长αk,使得满足Armijo条件。

5. 更新参数:更新xk+1 = xk + αk * pk,并计算g(xk+1)。

6. 更新Hessian逆矩阵估计:通过拟牛顿公式来更新Hessian逆矩阵的估计值Hk+1BFGS方法的核心在于如何更新Hessian逆矩阵的估计值。

具体而言,更新公式为:Hk+1 = (I - ρk * sk * yk^T) * Hk * (I - ρk * yk * sk^T) + ρk * s k * sk^T其中,ρk = 1 / (yk^T * sk),sk = xk+1 - xk,yk = g(xk+1) - g(xk)。

该更新公式可以用来近似海森矩阵的逆,从而实现迭代寻找最优解的目的。

在更新Hessian逆矩阵的过程中,需要满足一些条件,如正定性和迭代稳定性的要求,以确保算法的稳定性和收敛性。

BFGS方法的优点包括:不需要计算海森矩阵,只需要计算梯度;收敛速度较快,尤其在目标函数满足强凸性的情况下;对于大规模问题也有较好的表现。

变尺度法

4

3. 如何对H k附加某些条件使得:

(1)迭代公式具有下降性 质

H k (正定) 0

H k 1 H k H k ( H k H k 1 H k )

H k Gk 1

(2)H k的计算量要小

(3)收敛速度要快

1 如何保证 H k 0和H k G k ?

T T 即,Bk xk k uk uk xk k vk vk xk g k

满足上述方程的解很多,我们可以如下确定一组解:

T k uk uk xk g k T k vk vk xk Bk xk

这样,我们可以取: uk g k , vk Bk x k ,

H k 1 H k H k

T T H k k uk uk k vk vk

待定: k,k R , uk,vk Rn

9

根据拟Newton 条件: k 1gk xk,我们有 H

( H k k uk u v v )g k xk

T k T k k k

即: k uk uT g k k vk vT g k xk H k g k k k

满 足 上 述 方 程 的 解 很, 我 们 可 以 如 下 确 定组 解 : 多 一

k uk uT g k xk k k vk vT g k H k g k k

0.73846 解得 0 0.13, 所以 x 0.04616 。

1

0.26154 x0 x x 1.04616 ,

1 0

14

0.52308 。 g0 f ( x ) f ( x ) g1 g0 8.36923

bfgs拟牛顿法算法步骤 -回复

bfgs拟牛顿法算法步骤-回复BFGS(Broyden-Fletcher-Goldfarb-Shanno)拟牛顿法是一种用于无约束最优化问题的优化算法。

它主要依赖于牛顿法,但是避免了牛顿法中需要求解海森矩阵的复杂计算。

在本文中,我们将讨论BFGS拟牛顿法的算法步骤以及其原理。

1. 初始化优化问题的目标函数在使用BFGS拟牛顿法之前,我们需要首先定义和初始化我们要优化的目标函数。

这个目标函数可以是线性或非线性的,具体取决于我们要解决的问题。

它可以是一个具有多个自变量和一个标量值的函数。

2. 初始化迭代参数在BFGS算法中,我们还需要初始化一些迭代参数,包括初始点x0,初始的逆海森矩阵H0和迭代停止的准则。

通常,我们选择一个合适的初始点作为优化的起点,将初始逆海森矩阵设置为单位矩阵,并选择一个合适的停止准则,如梯度范数或目标函数值的变化。

3. 计算函数梯度在每个迭代步骤中,我们需要计算目标函数在当前点的梯度。

这个梯度向量是目标函数对每个自变量的偏导数。

一般来说,我们可以使用数值方法,如有限差分或自动微分,来计算梯度。

4. 计算搜索方向根据当前点的梯度和上一次迭代的逆海森矩阵,我们可以计算出搜索方向。

搜索方向是迭代中的一个重要参数,决定了下一次迭代中应该前进的方向。

在BFGS算法中,搜索方向被定义为当前点梯度的负方向乘以逆海森矩阵。

5. 一维搜索在确定搜索方向后,我们需要在该方向上进行一维搜索,以确定目标函数的最小值。

一维搜索通常使用线搜索方法,如Armijo规则或Wolfe 准则,来确定步长。

步长是沿搜索方向移动的距离,以获得下一个迭代点。

6. 更新参数一旦找到合适的步长,我们可以使用它来更新迭代参数。

我们使用BFGS公式来更新逆海森矩阵和迭代点。

BFGS公式使用当前搜索方向和步长来更新逆海森矩阵,并使用目标函数在新迭代点处的梯度来更新迭代点。

这样,我们可以得到下一个迭代点和逆海森矩阵。

7. 检查停止准则在更新参数后,我们需要检查是否满足终止准则来决定是否停止迭代。

变尺度法matlab -回复

变尺度法matlab -回复变尺度法(matlab)变尺度法(Matlab)是一种用于图像处理和计算机视觉的常用技术。

它是一种用于改变图像的大小和结构的方法,可以实现图像的缩放、旋转、变形等操作。

在本文中,我们将一步一步地介绍变尺度法的基本原理和在Matlab中实现的方法。

第一步是加载图像。

在Matlab中,可以使用imread函数来加载图像。

例如,我们可以将一张名为“image.jpg”的图像加载到变量image中:matlabimage = imread('image.jpg');第二步是将图像转换为灰度图像。

在Matlab中,可以使用rgb2gray函数将彩色图像转换为灰度图像。

灰度图像只有一个像素通道,方便后续的处理:matlabgrayImage = rgb2gray(image);第三步是选择变尺度方法。

常见的变尺度方法有缩放、旋转和仿射变换等。

在本文中,我们选择缩放方法作为示例。

缩放方法是指按照一定比例改变图像的尺寸。

在Matlab中,可以使用imresize函数来实现缩放操作:matlabscaledImage = imresize(grayImage, 0.5);上述代码将灰度图像缩小到原来的一半。

可以根据需要调整缩放比例。

如果将缩放比例设置为大于1的值,则可以实现放大图像的效果。

第四步是显示缩放后的图像。

在Matlab中,可以使用imshow函数显示图像。

下面的代码将显示缩放后的图像:matlabimshow(scaledImage);第五步是保存缩放后的图像。

在Matlab中,可以使用imwrite函数将图像保存为文件。

以下代码将缩放后的图像保存为名为“scaled_image.jpg”的文件:matlabimwrite(scaledImage, 'scaled_image.jpg');通过以上步骤,我们可以实现对图像的缩放操作。

变尺度法还可以用于其他图像处理操作,如旋转、仿射变换等。

变尺度法matlab

变尺度法matlab

变尺度法(Variational Mode Decomposition,VMD)是一种非线性信号处理方法,用于分解复杂的非线性信号为一组固有模态函数(IMF)。

在Matlab中,可以使用以下步骤来实现VMD:

1. 导入数据:使用Matlab的load函数或其他数据导入工具导入需要分析的信号数据。

2. 进行VMD分解:使用Matlab的VMD函数进行信号分解。

VMD 函数的输入参数包括原始信号和一个可选的参数矩阵,输出参数包括分解后的固有模态函数(IMF)和分解系数。

```

[IMF, C] = vmd(X, order)

```

其中,X是原始信号,order是分解阶数。

分解阶数可以通过调整VMD 函数的参数来进行设置。

3. 分析结果:使用分解后的IMF和分解系数进行后续分析。

IMF表示信号的不同频率分量,分解系数表示不同分量的权重。

可以根据需

要进行进一步的数据可视化、统计分析或机器学习等处理。

需要注意的是,VMD是一种基于频域的信号分解方法,适用于分析具有周期性或周期性变化的信号。

对于非周期性或非周期性变化的信号,VMD可能无法提供有效的分解结果。

此外,VMD的分解阶数和分解参数需要根据具体情况进行设置,以获得最佳的分解效果。

BFGS优化算法及应用实例

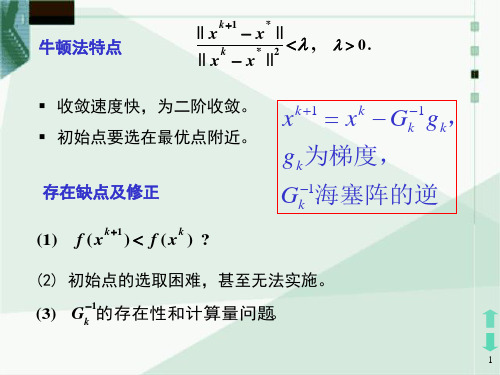

BFGS优化算法及应⽤实例⽬录1、引⾔ (1)2、BFGS算法综述 (1)2.1 拟⽜顿法及其性质 (1)2.2 BFGS算法 (3)3、数值实验 (6)3.1 代码实现 (6)3.2 算法测试 (7)3.3 结果分析 (8)4、总结 (8)4.1 总结概括 (8)5、参考⽂献: (9)1、引⾔在最优化的问题中,线性最优化⾄少可以使⽤单纯形法求解,但对于⾮线性优化问题,⽜顿法提供了⼀种求解的办法。

⽜顿法的优点是具有⼆次收敛速度,但是当Hesse 矩阵2=)k k G f x ?(不正定时,不能保证所产⽣的⽅向是⽬标函数在k x 处的下降⽅向。

特别地,当k G 奇异时,算法就⽆法继续进⾏下去,尽管修正的⽜顿法可以克服这⼀缺点,但修正参数的选取很难把握,过⼤或过⼩都会影响到收敛速度,此外,⽜顿法的每⼀迭代步都需要⽬标函数的⼆阶导数,即Hesse 矩阵,对于⼤规模问题,其计算量是惊⼈的。

由此引出了⼀种新的求解⾮线性优化问题的⽅法——拟⽜顿法。

拟⽜顿法(Quasi-Newton Methods)是求解⾮线性优化问题最有效的⽅法之⼀,于20世纪50年代由美国Argonne 国家实验室的物理学家W. C. Davidon 所提出来。

Davidon 设计的这种算法在当时看来是⾮线性优化领域最具创造性的发明之⼀。

不久R. Fletcher 和M. J. D. Powell 证实了这种新的算法远⽐其他⽅法快速和可靠,使得⾮线性优化这门学科在⼀夜之间突飞猛进。

在之后的20年⾥,拟⽜顿⽅法得到了蓬勃发展,出现了⼤量的变形公式以及数以百计的相关论⽂。

其中BFGS 就是拟⽜顿法中的⼀种⽅法。

2、BFGS 算法的综述2.1拟⽜顿法及其性质拟⽜顿法的基本思想是在⽜顿法的第⼆步中⽤Hesse 矩阵2=)k k G f x ?(的某个近似矩阵k B 取代k G 。

通常,k B 应具有以下三个特点:(1)在某种意义下有k k B G ≈,使得相应的算法产⽣的⽅向近似于⽜顿⽅向,以确保算法具有较快的收敛速度;(2)对所有的k ,k B 是对称正定的,从⽽使得算法所产⽣的⽅向是函数f 在k x 处下降⽅向;(3)矩阵k B 更新规则相对⽐较简单,即通常采⽤秩1或秩2矩阵进⾏校正。

求无约束优化问题的混合谱尺度bfgs算法

求无约束优化问题的混合谱尺度bfgs算法近年来,优化问题的研究受到了越来越多的关注,而无约束优化问题引起了学术界的更多关注。

解决无约束优化问题的方法有很多,其中BFGS算法是众多算法中最经典、最有效的一种方法。

本文主要介绍了一种基于混合谱尺度的BFGS算法,以解决无约束优化问题,该算法可以有效提高解的质量,提高计算效率。

一、混合谱尺度的概念混合谱尺度(MS)是一种数字信号处理技术,它集成了多个数字信号处理技术,运用独特的多尺度变换方法,将数字信号转换成混合尺度的矩阵。

多尺度变换的好处是,可以同时提取信号中各个尺度的细节信息,从而有效提高算法的准确性和性能。

MS可以不仅用于去噪,而且可以用于分类、聚类和识别等任务。

二、混合谱尺度BFGS算法混合谱尺度BFGS算法是一种基于混合谱尺度(MS)的无约束优化算法,它将多尺度的信息组织在一起,提取信号中的细节信息,从而更好地估计模型的梯度,提高计算效率和准确性。

算法步骤如下:1.设置初始模型参数:算法以初始模型参数开始迭代运算;2.模型分解:将原始模型参数分解成多个尺度,每一个尺度有一组参数;3.优化模型参数:计算模型参数有关的梯度,并使用BFGS方法进行参数优化;4.多尺度合成:将各个尺度的优化参数合成,得到最终的模型参数;5.评估模型:根据模型参数计算模型的损失函数;6.重复迭代:如果模型的损失函数值不满足条件,重复步骤1~5,直至模型的损失函数收敛。

三、混合谱尺度BFGS算法实验为了证明混合谱尺度BFGS算法的有效性,我们用该算法对最小二乘拟合问题进行了实验。

最小二乘拟合问题是一种典型的无约束优化问题,它的目标是求解使损失函数值最小的参数向量。

在实验中,我们使用梯度下降法(GD)和混合谱尺度BFGS算法(MSBFGS)来求解最小二乘拟合问题,并对两种算法的收敛曲线进行了比较。

实验结果表明,MSBFGS算法收敛曲线比梯度下降法收敛曲线更加平缓,收敛速度更快,并且可以更准确地收敛到最优解。

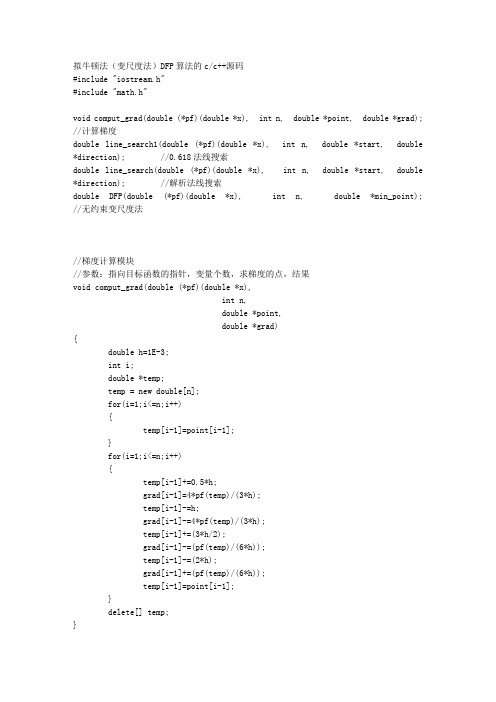

拟牛顿法(变尺度法)DFP算法的cc 源码

拟牛顿法(变尺度法)DFP算法的c/c++源码#include "iostream.h"#include "math.h"void comput_grad(double (*pf)(double *x), int n, double *point, double *grad); //计算梯度double line_search1(double (*pf)(double *x), int n, double *start, double*direction); //0.618法线搜索double line_search(double (*pf)(double *x), int n, double *start, double*direction); //解析法线搜索double DFP(double (*pf)(double *x), int n, double *min_point); //无约束变尺度法//梯度计算模块//参数:指向目标函数的指针,变量个数,求梯度的点,结果void comput_grad(double (*pf)(double *x),int n,double *point,double *grad){double h=1E-3;int i;double *temp;temp = new double[n];for(i=1;i<=n;i++){temp[i-1]=point[i-1];}for(i=1;i<=n;i++){temp[i-1]+=0.5*h;grad[i-1]=4*pf(temp)/(3*h);temp[i-1]-=h;grad[i-1]-=4*pf(temp)/(3*h);temp[i-1]+=(3*h/2);grad[i-1]-=(pf(temp)/(6*h));temp[i-1]-=(2*h);grad[i-1]+=(pf(temp)/(6*h));temp[i-1]=point[i-1];}delete[] temp;}//一维搜索模块//参数:指向目标函数的指针,变量个数,出发点,搜索方向//返回:最优步长double line_search(double (*pf)(double *x),int n,double *start,double *direction){int i;double step=0.001;double a=0,value_a,diver_a;double b,value_b,diver_b;double t,value_t,diver_t;double s,z,w;double *grad,*temp_point;grad=new double[n];temp_point=new double[n];comput_grad(pf,n,start,grad);diver_a=0;for(i=1;i<=n;i++)diver_a=diver_a+grad[i-1]*direction[i-1];do{b=a+step;for(i=1;i<=n;i++)temp_point[i-1]=start[i-1]+b*direction[i-1]; comput_grad(pf,n,temp_point,grad);diver_b=0;for(i=1;i<=n;i++)diver_b=diver_b+grad[i-1]*direction[i-1];if( fabs(diver_b)<1E-10 ){delete[] grad;delete[] temp_point;return(b);}if( diver_b<-1E-15 ){a=b;diver_a=diver_b;step=2*step;}}while( diver_b<=1E-15 );for(i=1;i<=n;i++)temp_point[i-1]=start[i-1]+a*direction[i-1];value_a=(*pf)(temp_point);for(i=1;i<=n;i++)temp_point[i-1]=start[i-1]+b*direction[i-1];value_b=(*pf)(temp_point);do{s=3*(value_b-value_a)/(b-a);z=s-diver_a-diver_b;w=sqrt( fabs(z*z-diver_a*diver_b) ); //////////////////!!!!!!!!!!!!!!!!!!!!!!t=a+(w-z-diver_a)*(b-a)/(diver_b-diver_a+2*w);value_b=(*pf)(temp_point);for(i=1;i<=n;i++)temp_point[i-1]=start[i-1]+t*direction[i-1];value_t=(*pf)(temp_point);comput_grad(pf,n,temp_point,grad);diver_t=0;for(i=1;i<=n;i++)diver_t=diver_t+grad[i-1]*direction[i-1];if(diver_t>1E-6){b=t;value_b=value_t;diver_b=diver_t;}else if(diver_t<-1E-6){a=t;value_a=value_t;diver_a=diver_t;}else break;}while( (fabs(diver_t)>=1E-6) && (fabs(b-a)>1E-6) );delete[] grad;delete[] temp_point;return(t);}//无约束变尺度法DFP函数声明////参数:pf指向目标函数的指针,n变量个数,min_point接受初始点、存放结果//返回:极小点处函数值//double DFP(double (*pf)(double *x),int n,double *min_point){int i,j;int k=0;double e=1E-5;double g_norm;double *g0=new double[n]; //梯度double *g1=new double[n];double *dg=new double[n];double *p=new double[n]; //搜索方向 =-gdouble t; //一维搜索步长double *x0=new double[n];double *x1=new double[n];double *dx=new double[n];double **H=new double*[n];for (i=0; i<n; i++) H[i] = new double[n];double **tempH=new double*[n];for (i=0; i<n; i++) tempH[i] = new double[n];double *gH=new double[n];double *Hg=new double[n];double num1;double num2;for(i=0;i<n;i++)for(j=0;j<n;j++){if(i==j) H[i][j]=1.0; // H0=Ielse H[i][j]=0.0;tempH[i][j]=0.0;}for(i=0;i<n;i++)x0[i]=min_point[i];comput_grad(pf,n,x0,g0);g_norm=0.0;for(i=0;i<n;i++) g_norm=g_norm+g0[i]*g0[i];g_norm=sqrt(g_norm);if (g_norm<e){for(i=0;i<n;i++) min_point[i]=x0[i];delete[] g0;delete[] g1;delete[] dg;delete[] p;delete[] x0;delete[] x1;delete[] dx;for (i=0; i<n; i++) delete[] H[i];delete []H;for (i=0; i<n; i++) delete[] tempH[i];delete []tempH;delete[] gH;delete[] Hg;return pf(min_point);}for(i=0;i<n;i++) p[i]=-g0[i];do{t=line_search(pf,n,x0,p); for(i=0;i<n;i++) x1[i]=x0[i]+t*p[i];comput_grad(pf,n,x1,g1);g_norm=0.0;for(i=0;i<n;i++) g_norm=g_norm+g1[i]*g1[i];g_norm=sqrt(g_norm);//cout<<k<<" "<<x0[0]<<" "<<x0[1]<<" "<<g_norm<<"\n";if (g_norm<e){for(i=0;i<n;i++) min_point[i]=x1[i];delete[] g0;delete[] g1;delete[] dg;delete[] p;delete[] x0;delete[] x1;delete[] dx;for (i=0; i<n; i++) delete[] H[i];delete []H;for (i=0; i<n; i++) delete[] tempH[i];delete []tempH;delete[] gH;delete[] Hg;return pf(min_point);}for(i=0;i<n;i++){dx[i]=x1[i]-x0[i];dg[i]=g1[i]-g0[i];}//////////////////求Hk+1的矩阵运算//g*H,H*gfor(i=0;i<n;i++){gH[i]=0.0;Hg[i]=0.0;}for(i=0;i<n;i++){for(j=0;j<n;j++){gH[i]=gH[i]+dg[j]*H[j][i];//Hg[i]=Hg[i]+H[i][j]*dg[j];Hg[i]=gH[i];}}//num1,num2num1=0.0;num2=0.0;for(i=0;i<n;i++){num1=num1+dx[i]*dg[i];num2=num2+gH[i]*dg[i];}//tempH[i][j]for(i=0;i<n;i++)for(j=0;j<n;j++)tempH[i][j]=0.0;for(i=0;i<n;i++){for(j=0;j<n;j++){tempH[i][j]=tempH[i][j]+H[i][j];tempH[i][j]=tempH[i][j]+dx[i]*dx[j]/num1; tempH[i][j]=tempH[i][j]-Hg[i]*gH[j]/num2; }}for(i=0;i<n;i++){for(j=0;j<n;j++){H[i][j]=tempH[i][j];}}///////////////////////////////Pfor(i=0;i<n;i++) p[i]=0.0;for(i=0;i<n;i++){for(j=0;j<n;j++){p[i]=p[i]-H[i][j]*g1[j];}}for(i=0;i<n;i++){g0[i]=g1[i];x0[i]=x1[i];}k=k+1;}while(g_norm>e);for(i=0;i<n;i++) min_point[i]=x1[i];delete[] g0;delete[] g1;delete[] dg;delete[] p;delete[] x0;delete[] x1;delete[] dx;for (i=0; i<n; i++) delete[] H[i];delete []H;for (i=0; i<n; i++) delete[] tempH[i];delete []tempH;delete[] gH;delete[] Hg;return pf(min_point);}/////////////double fun(double *x){return 100*( x[1]-x[0]*x[0] )*( x[1]-x[0]*x[0] ) + (1-x[0])*(1-x[0]); }void main(){int n=2;double min_point[2]={-5,10};double min_value=DFP(fun,n,min_point);cout<<min_point[0]<<" and "<<min_point[1]<<" "<<min_value;}//0.618法线搜索////参数:指向目标函数的指针,变量个数,出发点,搜索方向//返回:最优步长//double line_search1(double (*pf)(double *x),int n,double *start,double *direction){int i;int k;double l,a,b,c,u,lamda,t,e;double *xa=new double[n];double *xb=new double[n];double *xc=new double[n];double *xl=new double[n];double *xu=new double[n];//确定初始搜索区间l=0.001;a=0;k=0;do{k++;c=a+l;for(i=0;i<n;i++){xc[i]=start[i]+c*direction[i];xa[i]=start[i]+a*direction[i];}l=l/3;}while( pf(xc) >= pf(xa) ); // ???k=0;do{k++;l=2*l;b=c+l;for(i=0;i<n;i++){xc[i]=start[i]+c*direction[i]; xb[i]=start[i]+b*direction[i]; }a=c;c=b;}while( pf(xb) <= pf(xc) );a=0;b=0.1;//寻优t=0.618;e=0.000001;lamda=b-t*(b-a);u=a+t*(b-a);for(i=0;i<n;i++){xl[i]=start[i]+lamda*direction[i];xu[i]=start[i]+u*direction[i];}k=0;do{k++;if( pf(xl)<pf(xu) ){b=u;u=lamda;lamda=b-t*(b-a);}else{a=lamda;lamda=u;u=t*(b-a);}}while( b-a>=e ); lamda=(a+b)/2;delete[] xa;delete[] xb;delete[] xc;delete[] xl;delete[] xu;return lamda ;}。

08无约束优化方法(3)

§4 变尺度法---DFP法和BFGS法一.变尺度法的基本思路变尺度法是由Davidon于1959年首先提出的,1963年为Fletcher和Powell所发展,形成为著名的DFP变尺度算法.1. 变尺度算法的基本思想最速下降法:计算简便,收敛速度慢;牛顿法及阻尼牛顿法:计算量、存储量大,收敛速度快;XiDian University设想:能否设计一种算法,它既有快速收敛的特点,又能避免计算二阶偏导数矩阵及其逆阵,就可构造出每次迭代的搜索方向k d?最速下降法:计算步骤简单,但收敛速度较慢;牛顿法和阻尼牛顿法:收敛度快,但计算量及存储量大(每次需计算海森阵及其逆阵);XiDian UniversityXiDian University 最速下降法和阻尼牛顿法的统一迭代格式:()k k k k k x x H f x λ+=−∇1 (1)若k H I =(单位阵),得最速下降法的迭代公式;若[()]k k H f x −=∇21,得阻尼牛顿法的迭代公式;特别的,取k λ=1,得牛顿法的迭代公式. 基本思想:为了保持牛顿法的优点,希望k H 能近似的等于[()]k f x −∇21,且k H 能在迭代计算中逐次 生成。

2.拟牛顿方程XiDian University为使k H 确实与[()]k f x −∇21近似,且易于计算,必须对k H 附加某些条件:1)为保证算法具有下降性质,要求{k H }中 的每一矩阵都是对称正定的;2)k H +1由k H 经简单形式修正而得,且希望 k H 在计算中逐次生成,即 k H +1=k H +k C (2)其中k C 称为修正矩阵或校正矩阵,(2)称 为修正公式或校正公式。

XiDian University 令()(),()k k g x f x Gx b g g x =∇=+=则11k k k k g Gx b gGx b ++=+=+, 所以 ()k k k k g g G x x ++−=−11令 k k k k k k x x x g g g++⎧−=Δ⎪⎨−=Δ⎪⎩11 (3) 则 k k g G x Δ=Δ (4) 或 k kx G g −Δ=Δ1 (5) 对一般的n 元非二次函数,设()f x 有连续的二XiDian University为使k H +1较好的近似k G −+11,应要求k H +1满足 k k k H g x +Δ=Δ1 (6)或 k k k B x g +Δ=Δ1 (7)这里k B +1=k H −+11.称(6)和(7)式称为拟牛顿方程。

BFGS方法范文

BFGS方法范文BFGS方法(Broyden-Fletcher-Goldfarb-Shanno)是一种非线性优化算法,用于求解无约束问题。

它是拟牛顿法的一种,通过维护一个近似的海森矩阵来迭代地寻找最优解。

BFGS方法的思想是通过利用目标函数的梯度信息来近似二阶导数的矩阵,从而加速优化过程。

BFGS方法通过迭代的方式逐步寻找最优解。

初始时,选择一个初始点作为起点,并给定一个初始的海森矩阵的逆矩阵。

然后根据当前的梯度信息和逆海森矩阵,更新方向和步长。

接着,不断地迭代更新,更新过程中逐步逼近最优解。

在BFGS方法中,方向的更新公式如下:s = x - x_old # 当前点与上一次迭代点的差值y = g - g_old # 当前梯度与上一次迭代梯度的差值H0 = np.linalg.inv(H_old) # 上一次迭代的海森矩阵的逆矩阵H = H_old + np.outer(s, s) / np.dot(s, y) -np.outer(H0.dot(y), y.dot(H0)) # 新的逆海森矩阵d = -H.dot(g) # 新的方向其中,x_old为上一次迭代的点,g和g_old为当前和上次迭代的梯度,H_old为上一次迭代的逆海森矩阵。

在更新方向之后,需要确定步长,并更新迭代点。

步长的选择可以使用线方法来进行,常用的有精确线和回溯线等方法。

步长确定后,将方向乘以步长并加到当前点上,得到新的迭代点。

BFGS方法的优点是收敛速度较快,适用于求解大规模的非线性优化问题。

它利用了目标函数的梯度信息,通过更新逆海森矩阵来逼近海森矩阵,从而有效地求解最优解。

由于BFGS方法在每次迭代中需要更新逆海森矩阵,所以会增加一定的计算量。

此外,由于BFGS方法是一种拟牛顿方法,所以无法处理目标函数具有不可导点的情况。

总的来说,BFGS方法是一种高效的非线性优化算法,通过近似二阶导数的海森矩阵来迭代地寻找最优解。

它具有收敛速度快的优点,适用于求解大规模的非线性优化问题。

变尺度法matlab -回复

变尺度法matlab -回复"变尺度法matlab"是指使用MATLAB编程语言中的变尺度法算法,用于处理图像或信号处理中的尺度变换问题。

这种算法可以通过改变图像或信号的尺度来实现平滑、增强或压缩等目的。

本文将详细介绍变尺度法的原理、应用、MATLAB编程实现以及示例代码。

一、变尺度法原理变尺度法是一种基于尺度空间的图像或信号处理方法,通过改变输入数据的尺度来影响其局部特征。

在计算机图像处理中,图像尺度被定义为图像中的物体所占据的像素数量。

而在信号处理中,尺度可与时间或频率相关联。

变尺度法的核心思想是将输入数据通过一系列尺度变换操作后得到一系列尺度空间图像或信号,然后在这些尺度空间中对感兴趣的特征进行分析。

常见的尺度变换方法包括高斯模糊、拉普拉斯滤波、小波变换等。

二、变尺度法应用变尺度法在图像处理和信号处理领域中有广泛的应用。

其中,图像应用包括但不限于图像分割、边缘检测、纹理分析等;而信号应用包括但不限于音频处理、视频处理、数据压缩等。

具体应用实例如下:1. 图像分割:通过变尺度法可以在不同尺度上提取图像中的边缘信息,从而实现图像的分割。

通过分析尺度空间中的边缘响应,可以将图像分为不同区域,以实现物体识别、目标跟踪等应用。

2. 纹理分析:纹理是图像中的重要特征之一,可以通过变尺度法来实现纹理分析。

通过在不同尺度上计算和提取纹理特征,可以实现纹理分类、纹理合成等应用。

3. 数据压缩:变尺度法在信号处理中的应用之一是数据压缩。

通过尺度变换可以实现信号的稀疏表示,从而压缩信号的存储空间和传输带宽。

三、MATLAB编程实现MATLAB作为一种强大的科学计算和数据可视化工具,为变尺度法的实现提供了丰富的功能和工具箱。

以下是一种基于MATLAB实现变尺度法的步骤:1. 准备输入数据:首先,需要准备输入数据,可以是图像、音频或任何其他需要处理的信号。

2. 尺度变换操作:使用MATLAB的图像处理工具箱或信号处理工具箱中的函数,对输入数据进行尺度变换操作。

python实现bgd,sgd,mini-bgd,newton,bfgs,lbfgs优化算法

python实现bgd,sgd,mini-bgd,newton,bfgs,lbfgs优化算法python实现bgd,sgd,mini-bgd,newton,bfgs,lbfgs优化算法# coding=utf-8import numpy as npimport osdef X3(a, b, c):a = np.dot(np.dot(a, b), c)return adef X2(a, b):a = np.dot(a, b)return adef get_data(obj_path_name):pro_path = os.path.abspath('.')data_path = str(pro_path + obj_path_name)print data_pathdata = np.loadtxt(data_path)x = np.asarray(np.column_stack((np.ones((data.shape[0], 1)), data[:, 0:-1])), dtype='double')y = data[:, -1]y = np.reshape(y, (data.shape[0], 1))print x.shape, y.shapereturn x, ydef inverse_hessian_mat(x):# 计算hessian矩阵,并求其逆矩阵x_hessian = np.dot(x.T, x)inverse_hessian = np.linalg.inv(x_hessian)return inverse_hessiandef get_e(x, theta, y):y_pre = np.dot(x, theta)e = y_pre - yreturn edef compute_grad(x, e, stand_flag=0):# batch法必须做梯度归⼀化print e.T.shape, x.shapegrad = np.dot(e.T, x)# grad = np.dot(e.T, x)/x.shape[0]if stand_flag == 1:grad = grad/(np.dot(grad, grad.T)**0.5)return np.reshape(grad, (x.shape[1], 1))def get_cost(e):# print e.shape# 计算当前theta组合点下的各个样本的预测值 y_precost = np.dot(e.T, e) / 2# cost = np.dot(e.T, e) / (2*e.shape[0])return costdef get_cost_l12(e, theta, m, l=1, lmd=10e10):# print e.shapeif l == 1:cost = (np.dot(e.T, e) + lmd*sum(abs(theta))) / (2*m)elif l == 2:cost = (np.dot(e.T, e) + lmd*np.dot(theta.T*theta)) / (2*m)else:cost = (np.dot(e.T, e)) / (2*m)return costdef update_batch_theta(theta, grad, alpha):theta = theta - alpha*gradreturn thetadef update_batch_theta_l12(theta, grad, alpha, m, l=1, lmd=10e10):if l == 1:theta = theta - alpha * (grad + (lmd/m)*theta)elif l == 2:theta = theta - alpha * (grad + (lmd/m))else:theta = theta - alpha * gradreturn thetadef iter_batch(x, theta, y, out_n, out_e_reduce_rate, alpha):step = 1while step < out_n:"""计算初始的损失值"""if step == 1:e = get_e(x, theta, y)cost_0 = get_cost(e)"""计算当前theta组合下的grad值"""grad = compute_grad(x, e, stand_flag=1)"""依据grad更新theta"""theta = update_batch_theta(theta, grad, alpha)"""计算新的损失值"""e = get_e(x, theta, y)cost_1 = get_cost(e)e_reduce_rate = abs(cost_1 - cost_0)/cost_0print'Step: %-6s, cost: %s' % (step, cost_1[0, 0])if e_reduce_rate < out_e_reduce_rate:flag = 'Finish!\n'print flagbreakelse:cost_0 = cost_1step += 1return thetadef iter_random_batch(x, theta, y, out_n, out_e_reduce_rate, alpha):step = 0while step < out_n:step += 1for i in range(x.shape[0]):x_i = np.reshape(x[i, ], (1, x.shape[1]))y_i = np.reshape(y[i, ], (1, 1))"""计算初始的损失值"""e_0 = get_e(x, theta, y)cost_0 = get_cost(e_0)"""⽤⼀个样本,计算当前theta组合下的grad值"""e_i = get_e(x_i, theta, y_i)grad = compute_grad(x_i, e_i, stand_flag=1)"""依据grad更新theta"""theta = update_batch_theta(theta, grad, alpha)"""计算新的损失值"""e_1 = get_e(x, theta, y)cost_1 = get_cost(e_1)e_reduce_rate = abs(cost_1 - cost_0)/cost_0if e_reduce_rate < out_e_reduce_rate:flag = 'Finish!\n'print flagstep = out_n + 1breakprint'Step: %-6s, cost: %s' % (step, cost_1[0,0])return thetadef iter_mini_batch(x, theta, y, out_n, out_e_reduce_rate, alpha, batch): batch_n = x.shape[0]//batchbatch_left_n = x.shape[0] % batchstep = 0while step < out_n:step += 1for i in range(batch_n+1):"""计算初始的损失值"""e_0 = get_e(x, theta, y)cost_0 = get_cost(e_0)"""选取更新梯度⽤的batch个样本"""if i <= batch_n-1:start = i*batchx_i = np.reshape(x[start:start+batch, ], (batch, x.shape[1]))y_i = np.reshape(y[start:start+batch, ], (batch, 1))else:if batch_left_n != 0:x_i = np.reshape(x[-1*batch_left_n:, ], (batch_left_n, x.shape[1])) y_i = np.reshape(y[-1*batch_left_n:, ], (batch_left_n, 1)) """⽤batch个样本,计算当前theta组合下的grad值"""e_i = get_e(x_i, theta, y_i)grad = compute_grad(x_i, e_i, stand_flag=1)"""依据grad更新theta"""theta = update_batch_theta(theta, grad, alpha)"""计算新的损失值"""e_1 = get_e(x, theta, y)cost_1 = get_cost(e_1)e_reduce_rate = abs(cost_1 - cost_0)/cost_0if e_reduce_rate < out_e_reduce_rate:flag = 'Finish!\n'print flagstep = out_nbreakprint'Step: %-6s, cost: %s' % (step, cost_1[0, 0])return thetadef update_newton_theta(x_hessian_inv, theta, grad, alpha):theta = theta - alpha*np.dot(x_hessian_inv, grad)# print 'New Theta --> ', theta1return thetadef iter_newton(x, theta, y, out_n, out_e_reduce_rate, alpha):e = get_e(x, theta, y)cost_0 = get_cost(e)x_hessian_inv = inverse_hessian_mat(x)step = 1while step < out_n:grad = compute_grad(x, e)theta = update_newton_theta(x_hessian_inv, theta, grad, alpha)e = get_e(x, theta, y)cost_1 = get_cost(e)print'Step: %-6s, cost: %s' % (step, cost_1[0,0])e_reduce_rate = abs(cost_1 - cost_0)/cost_0if e_reduce_rate < out_e_reduce_rate:flag = 'Finish!\n'print flagbreakelse:cost_0 = cost_1step += 1return thetadef iter_batch_linesearch(x, theta_0, y, out_n, out_e_reduce_rate, alpha):e_0 = get_e(x, theta_0, y)cost_0 = get_cost(e_0)step = 1while step < out_n:grad = compute_grad(x, e_0, stand_flag=1)theta_1, cost_1, e_1, count = line_search(x, y, alpha, theta_0, grad)e_reduce_rate = abs(cost_1 - cost_0)/cost_0print'Step: %-6s, count: %-4s, cost: %s' % (step, count, cost_1[0, 0])if e_reduce_rate < out_e_reduce_rate:flag = 'Finish!\n'print flagbreakelse:cost_0 = cost_1theta_0 = theta_1e_0 = e_1step += 1return theta_1def line_search(x, y, alpha, theta_0, grad):# 不更新梯度,在当前梯度⽅向上,迭代100次寻找最佳的下⼀个theta组合点,e_0 = get_e(x, theta_0, y)cost_0 = get_cost(e_0)max_iter, count, a, b = 1000, 0, 0.8, 0.5while count < max_iter:# 随count增⼤,alpha减⼩,0.8*0.8*0.8*0.8*...alpha_count = pow(a, count) * alphatheta_1 = theta_0 - alpha_count*grade_1 = get_e(x, theta_1, y)cost_1 = get_cost(e_1)# 当前theta组合下的梯度为grad, grad == tan(w) == 切线y变化量/theta变化量,推出切线y变化量 = grad * theta变化量grad_dy_chage = abs(np.dot(grad.T, theta_1-theta_0))# 实际y变化量为cost0-cost1, 不能加绝对值,如果加了就不收敛了。

求无约束优化问题的混合谱尺度BFGS算法

求无约束优化问题的混合谱尺度BFGS算法

陶思俊

【期刊名称】《新余学院学报》

【年(卷),期】2017(022)006

【摘要】依据BFGS算法、MBFGS算法、CBFGS算法及谱尺度BFGS算法,提出了一类混合谱尺度BFGS算法;同时,在Armijo线性搜索和Wolf-Powell线性搜索下对所提出的混合谱尺度BFGS算法证明了其全局收敛性,并通过数值实验测试了该算法的数值表现,实验结果表明混合谱尺度BFGS算法具有较好的数值效果.【总页数】4页(P33-36)

【作者】陶思俊

【作者单位】新余学院数学与计算机学院,江西新余338004

【正文语种】中文

【中图分类】O242

【相关文献】

1.扰动谱尺度BFGS算法及其收敛性 [J], 李国平

2.扰动谱尺度BFGS算法及收敛性分析 [J], 张峰

3.求无约束优化问题的混合谱尺度BFGS算法 [J], 陶思俊;

4.具有非线性尺度不变性的修改BFGS算法的收敛性质 [J], 邓乃扬;李正锋

5.解无约束优化问题的非单调修改的BFGS算法 [J], 朱琴;朱玲

因版权原因,仅展示原文概要,查看原文内容请购买。

BFGS算法分析与实现【范本模板】

《最优化方法》课程设计题目:BFGS算法分析与实现院系:数学与计算科学学院专业:统计学姓名学号: 左想 1200720133指导教师:李丰兵日期: 2014 年 01 月 22 日摘要在求解无约束最优化问题的众多算法中,拟牛顿法是颇受欢迎的一类算法。

尤其是用于求解中小规模问题时该类算法具有较好的数值效果。

BFGS 算法被认为是数值效果最好的拟牛顿法,其收敛理论的研究也取得了很好的成果。

在一定的条件下,BFGS 算法具有全局收敛性和超线性收敛速度。

然而,对于大规模最优化问题来求解,包括 BFGS 算法在内拟牛顿法具有明显的缺陷。

有许多的例子表明,一旦处理问题很大时,一些对小规模问题非常成功的算法变得毫无吸引力。

究其原因,主要是由于在中小型问题一些不太重要的因素在求解大规模问题时,变得代价很高。

随着速度更快及更复杂的计算机的出现,增强了我们的计算处理能力。

同时也为我们设计算法带来了新的课题.并行计算机的发展为求解大规模最优化问题提供了一条新途径。

关键词:BFGS 拟牛顿法;无约束最优化问题;大规模问题AbstractQuasi—Newton methods are welcome numerical methods for solving optimization problems. They are particularly effective when applied to solve small or middle size problems. BFGS method is regarded as the most effective quasi—Newton method due toits good numerical perfor mance. It also possesses very good global and superlinear con vergen ceproperties. On the other hand, however, when applied to solve larg escaleproblems,quasi-Newton methods including BFGS method don ot perform well。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

double *temp;

temp = new double[n];

for(i=1;i<=n;i++)

{

temp[i-1]=point[i-1];

}

for(i=1;i<=n;i++)

{

temp[i-1]+=0.5*h;

f_min=fun(x_min,ys);

f_punish=funP(x_min);

if(f_ys>=1E10)

cout<<"\n!!!!!!!!!!!!!!!!!!由于不可知的原因,导致结果发散!!!!!!!!!!!!!!!!!!!"<<endl

<<"请在源程序修改合适的精度值或者其他\n"<<endl;

break;}

//--------------|

r=r*10;

for(i=0;i<n;i++)

x_temp=x_min;

f_temp=f_min;

}

if(f_min>f_temp)

{f_min=f_temp;

for(i=0;i<n;i++) x_min=x_temp;}

double t; //一维搜索步长

double *x0=new double[n];

double *x1=new double[n];

double *dx=new double[n];

double **H=new double*[n];

temp[i-1]-=(2*h);

grad[i-1]+=(pf(temp)/(6*h));

temp[i-1]=point[i-1];

}

delete[] temp;

}

//无约束变尺度法BFGS函数声明

//参数:pf指向目标函数的指针,n变量个数,min_point接受初始点、存放结果

//返回0值

double BFGS(

double (*pf)(double *x),

int n,

double *min_point

)

{

int i,j;

int k=0;

double e=epsilon2;

double g_norm; //梯度的模

cout<<"\n"<<" ------------外惩罚函数+BFGS变尺度法优化算法C++程序最终结果---------------"<<endl

<<" *也可根据实际需要在以上参考值中选择其他结果*"<<endl;

cout<<"优化最小值:"<<endl

<<" 目标函数f="<<f_min<<" 构造的惩罚函数值="<<f_punish<<endl

<<"优化程序得到的最优点为:"<<endl

<<" x1="<<x_min[0]<<" x2="<<x_min[1]<<" x3="<<x_min[2]<<" x4="<<x_min[3]<<endl

//--------初始化结束

do

{

t=line_search(pf,n,x0,p);

for(i=0;i<n;i++)

x1=x0+t*p;

comput_grad(pf,n,x1,g1);

//计算梯度

void comput_grad(double (*pf)(double *x), int n, double *point, double *grad);

//无约束BFGS变尺度法(目标函数,维数,最小点) 返回0值

double BFGS(double (*pf)(double *x), int n, double *min_point);

<<"约束条件情况:"<<endl

<<" 约束1="<<ys[0]+det<<" 约束2="<<ys[1]+det<<" 约束3="<<ys[2]+det<<endl;

}

//梯度计算模块

//参数:指向目标函数的指针,变量个数,求梯度的点,结果存放处

void comput_grad(double (*pf)(double *x),

double *g0=new double[n]; //梯度

double *g1=new double[n];

double *dg=new double[n];

double *p=new double[n]; //搜索方向 =-g

<<"目标函数: f_min="<<f_min<<endl

<<"自变量: x1="<<x_min[0]<<" x2="<<x_min[1]<<" x3="<<x_min[2]<<" x4="<<x_min[3]<<endl

<<"约束函数: g1="<<ys[0]+det<<" g2="<<ys[1]+det<<" g3="<<ys[2]+det<<endl

{cout<<"因为迭代xk与xk+1的函数值差距f_f达到收敛精度 "<<epsilon<<" 而认为收敛 "<<endl;

break;}

else if((fabs(f_min)>=1)&&(fabs((f_min-f_temp)/f_min)<=epsilon))

{cout<<"\n 因为迭代xk与xk+1的函数值差距 det_f 达到收敛精度 "<<epsilon<<" 而认为收敛 "<<endl;

double x_x=0,f_ys=0;

double x_min[n]=START;

double x_temp[n]=START;

f_temp=fun(x_temp,ys);

for(;;)

{

c++;

BFGS(funP,n,x_min);

f_min=fun(x_min,ys);

for (i=0; i<n; i++) H = new double[n];

double *gH=new double[n]; //计算H变化量的中间变量---

double *Hg=new double[n];

double num1;

//构造混合外点惩罚函数 返回惩罚函数值(构造点)

double funP(double *p);

//返回目标函数值,并返回约束函数值存入ys (计算点,约束函数值存放处)

double fun(double *x , double *ys );

if((fabsБайду номын сангаасx_x)<=epsilon)|(f_ys<=epsilon))

{cout<<"因为迭代xk与xk+1距离x_x 或者 约束函数值f_ys 达到收敛精度 "<<epsilon<<" 而认为收敛"<<endl;

break;}

if((fabs(f_min)<=1)&&(fabs(f_min-f_temp)<=epsilon))

else H[j]=0.0;

}

for(i=0;i<n;i++)

x0=min_point;

comput_grad(pf,n,x0,g0);

for(i=0;i<n;i++) p=-g0;

double r=1; //惩罚因子

double br=1; //变尺度法强行退出循环因子(可去除)

const double zr=10; //递增系数

double det=0.0014; //外惩罚函数法约束函数余量

//(此det值仅适合当前A B C D,修改请将其恢复为0.0001或其他建议值)

double funPt(double *x,double *direction,double t);

void main()

{

int i,j;

double c=0; //表示外惩罚函数循环次数

double f_min,f_temp,f_punish;