模式识别实验二讲解

模式识别第二章ppt课件

• 试探方法

凭直观感觉或经验,针对实际问题定义一种 相似性测度的阈值,然后按最近邻规则指定 某些模式样本属于某一个聚类类别。

– 例如对欧氏距离,它反映了样本间的近邻性,但 将一个样本分到不同类别中的哪一个时,还必须 规定一个距离测度的阈值作为聚类的判别准则。

精选ppt课件2021

• 特征选择的维数

在特征选择中往往会选择一些多余的特征,它增加了 维数,从而增加了聚类分析的复杂度,但对模式分类 却没有提供多少有用的信息。在这种情况下,需要去 掉相关程度过高的特征(进行降维处理)。

• 降维方法

– 结论:若rij->1,则表明第i维特征与第j维特征所反 映的特征规律接近,因此可以略去其中的一个特

– 距离阈值T对聚类结果的影响

精选ppt课件2021

17

2.3 基于试探的聚类搜索算法

2.3.2 最大最小距离算法

• 基本思想:以试探类间欧氏距离为最大 作为预选出聚类中心的条件。

• 病人的病程

– 名义尺度:指定性的指标,即特征度量时没有数量

关系,也没有明显的次序关系,如黑色和白色的关

系,男性和女性的关系等,都可将它们分别用“0”

和“1”来表示。

• 超过2个状态时,可精选用pp多t课个件2数021值表示。

8

2.2 模式相似性的测度和

聚类准则

2.2.1 相似Βιβλιοθήκη 测度• 目的:为了能将模式集划分成不同的类别,必须定义 一种相似性的测度,来度量同一类样本间的类似性和 不属于同一类样本间的差异性。

12

2.2 模式相似性的测度和

聚类准则

2.2.2 聚类准则

• 聚类准则函数法

– 依据:由于聚类是将样本进行分类以使类别间可 分离性为最大,因此聚类准则应是反映类别间相 似性或分离性的函数;

模式识别关于男女生身高和体重的神经网络算法

模式识别实验报告(二)学院:专业:学号:姓名:XXXX教师:目录1实验目的 (1)2实验内容 (1)3实验平台 (1)4实验过程与结果分析 (1)4.1基于BP神经网络的分类器设计 .. 1 4.2基于SVM的分类器设计 (4)4.3基于决策树的分类器设计 (7)4.4三种分类器对比 (8)5.总结 (8)1)1实验目的通过实际编程操作,实现对课堂上所学习的BP神经网络、SVM支持向量机和决策树这三种方法的应用,加深理解,同时锻炼自己的动手实践能力。

2)2实验内容本次实验提供的样本数据有149个,每个数据提取5个特征,即身高、体重、是否喜欢数学、是否喜欢文学及是否喜欢运动,分别将样本数据用于对BP神经网络分类器、SVM支持向量机和决策树训练,用测试数据测试分类器的效果,采用交叉验证的方式实现对于性能指标的评判。

具体要求如下:BP神经网络--自行编写代码完成后向传播算法,采用交叉验证的方式实现对于性能指标的评判(包含SE,SP,ACC和AUC,AUC的计算可以基于平台的软件包);SVM支持向量机--采用平台提供的软件包进行分类器的设计以及测试,尝试不同的核函数设计分类器,采用交叉验证的方式实现对于性能指标的评判;决策树--采用平台提供的软件包进行分类器的设计以及测试,采用交叉验证的方式实现对于性能指标的评判(包含SE,SP,ACC和AUC,AUC的计算基于平台的软件包)。

3)3实验平台专业研究方向为图像处理,用的较多的编程语言为C++,因此此次程序编写用的平台是VisualStudio及opencv,其中的BP神经网络为自己独立编写, SVM 支持向量机和决策树通过调用Opencv3.0库中相应的库函数并进行相应的配置进行实现。

将Excel中的119个数据作为样本数据,其余30个作为分类器性能的测试数据。

4)4实验过程与结果分析4.1基于BP神经网络的分类器设计BP神经网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。

模式识别实验二_2

1.贝叶斯公式

已知共有 M 类别 i , i 1,2, M ,统计分布为正态分布,已知先验概率 P (i ) 及类条 件概率密度函数 P ( X | i ) ,对于待测样品,贝叶斯公式可以计算出该样品分属各类别的概 率,叫做后验概率;看 X 属于哪个类的可能性最大,就把 X 归于可能性最大的那个类,后 验概率即为识别对象归属的依据。贝叶斯公式为

1

( i )

)

n 1 ln 2 ln S i 2 2

X (i ) 为 i 类的均值向量。

2.最小错误判别准则

1

两类问题 有两种形式,似然比形式:

l( X )

P ( X | 1 ) P ( 2 ) X 1 P ( X | 2 ) P (1 ) 2

h2=-0.5*(x-mean2)'*inv(sigema2)*(x-mean2)-2*log(2*pi)-0.5*log(d et(sigema2))+log(1/3);

h3=-0.5*(x-mean3)'*inv(sigema3)*(x-mean3)-2*log(2*pi)-0.5*log(d et(sigema3))+log(1/3); h(1)=h1; h(2)=h2; h(3)=h3; %比较三个数据的大小,并判断属于哪一类% max=h(1); class=1;

sigema=0; for i=1:2:50 sigema=sigema+(iris{i}-mean1)*(iris{i}-mean1)'; end sigema1=sigema/25;%sigema1为第一类数据的协方差矩阵

4.已经估计出三类数据的统计特征。首先使用最小错误判别准则进行分类,实验中采用对数 形式计算,假设三种类型的先验概率相等,即均为 1/3,在某一 X 下得到的三个后验概率的 函数。比较三个值的大小,哪个最大,就可判断 X 属于哪一类。最后进行了分类器判据结 果的验证。

《模式识别》实验报告-贝叶斯分类

《模式识别》实验报告-贝叶斯分类一、实验目的通过使用贝叶斯分类算法,实现对数据集中的样本进行分类的准确率评估,熟悉并掌握贝叶斯分类算法的实现过程,以及对结果的解释。

二、实验原理1.先验概率先验概率指在不考虑其他变量的情况下,某个事件的概率分布。

在贝叶斯分类中,需要先知道每个类别的先验概率,例如:A类占总样本的40%,B类占总样本的60%。

2.条件概率后验概率指在已知先验概率和条件概率下,某个事件发生的概率分布。

在贝叶斯分类中,需要计算每个样本在各特征值下的后验概率,即属于某个类别的概率。

4.贝叶斯公式贝叶斯公式就是计算后验概率的公式,它是由条件概率和先验概率推导而来的。

5.贝叶斯分类器贝叶斯分类器是一种基于贝叶斯定理实现的分类器,可以用于在多个类别的情况下分类,是一种常用的分类方法。

具体实现过程为:首先,使用训练数据计算各个类别的先验概率和各特征值下的条件概率。

然后,将测试数据的各特征值代入条件概率公式中,计算出各个类别的后验概率。

最后,取后验概率最大的类别作为测试数据的分类结果。

三、实验步骤1.数据集准备本次实验使用的是Iris数据集,数据包含150个Iris鸢尾花的样本,分为三个类别:Setosa、Versicolour和Virginica,每个样本有四个特征值:花萼长度、花萼宽度、花瓣长度、花瓣宽度。

2.数据集划分将数据集按7:3的比例分为训练集和测试集,其中训练集共105个样本,测试集共45个样本。

计算三个类别的先验概率,即Setosa、Versicolour和Virginica类别在训练集中出现的频率。

对于每个特征值,根据训练集中每个类别所占的样本数量,计算每个类别在该特征值下出现的频率,作为条件概率。

5.测试数据分类将测试集中的每个样本的四个特征值代入条件概率公式中,计算出各个类别的后验概率,最后将后验概率最大的类别作为该测试样本的分类结果。

6.分类结果评估将测试集分类结果与实际类别进行比较,计算分类准确率和混淆矩阵。

模式识别方法二实验报告

《模式识别》大作业人脸识别方法二---- 基于PCA 和FLD 的人脸识别的几何分类器(修改稿)一、 理论知识1、fisher 概念引出在应用统计方法解决模式识别问题时,为了解决“维数灾难”的问题,压缩特征空间的维数非常必要。

fisher 方法实际上涉及到维数压缩的问题。

fisher 分类器是一种几何分类器, 包括线性分类器和非线性分类器。

线性分类器有:感知器算法、增量校正算法、LMSE 分类算法、Fisher 分类。

若把多维特征空间的点投影到一条直线上,就能把特征空间压缩成一维。

那么关键就是找到这条直线的方向,找得好,分得好,找不好,就混在一起。

因此fisher 方法目标就是找到这个最好的直线方向以及如何实现向最好方向投影的变换。

这个投影变换恰是我们所寻求的解向量*W ,这是fisher 算法的基本问题。

样品训练集以及待测样品的特征数目为n 。

为了找到最佳投影方向,需要计算出各类均值、样品类内离散度矩阵i S 和总类间离散度矩阵w S 、样品类间离散度矩阵b S ,根据Fisher 准则,找到最佳投影准则,将训练集内所有样品进行投影,投影到一维Y 空间,由于Y 空间是一维的,则需要求出Y 空间的划分边界点,找到边界点后,就可以对待测样品进行进行一维Y 空间的投影,判断它的投影点与分界点的关系,将其归类。

Fisher 法的核心为二字:投影。

二、 实现方法1、 一维实现方法(1) 计算给类样品均值向量i m ,i m 是各个类的均值,i N 是i ω类的样品个数。

11,2,...,ii X im X i nN ω∈==∑(2) 计算样品类内离散度矩阵iS 和总类间离散度矩阵wS1()()1,2,...,i Ti i i X w ii S X m X m i nS Sω∈==--==∑∑(3) 计算样品类间离散度矩阵b S1212()()Tb S m m m m =--(4) 求向量*W我们希望投影后,在一维Y 空间各类样品尽可能地分开,也就是说我们希望两类样品均值之差(12m m -)越大越好,同时希望各类样品内部尽量密集,即希望类内离散度越小越好,因此,我们可以定义Fisher 准则函数:()Tb F Tw W S W J W W S W=使得()F J W 取得最大值的*W 为 *112()w WS m m -=-(5) 将训练集内所有样品进行投影*()Ty W X =(6) 计算在投影空间上的分割阈值0y在一维Y 空间,各类样品均值i m为 11,2,...,ii y imy i n N ω∈==∑样品类内离散度矩阵2i s和总类间离散度矩阵w s 22()ii iy sy mω∈=-∑21w ii ss==∑【注】【阈值0y 的选取可以由不同的方案: 较常见的一种是1122012N m N m y N N +=+另一种是121201ln(()/())22m m P P y N N ωω+=++- 】(7) 对于给定的X ,计算出它在*W 上的投影y (8) 根据决策规则分类0102y y X y y X ωω>⇒∈⎧⎨<⇒∈⎩2、程序中算法的应用Fisher 线性判别方法(FLD )是在Fisher 鉴别准则函数取极值的情况下,求得一个最佳判别方向,然后从高位特征向量投影到该最佳鉴别方向,构成一个一维的判别特征空间将Fisher 线性判别推广到C-1个判决函数下,即从N 维空间向C-1维空间作相应的投影。

模式识别实验指导书

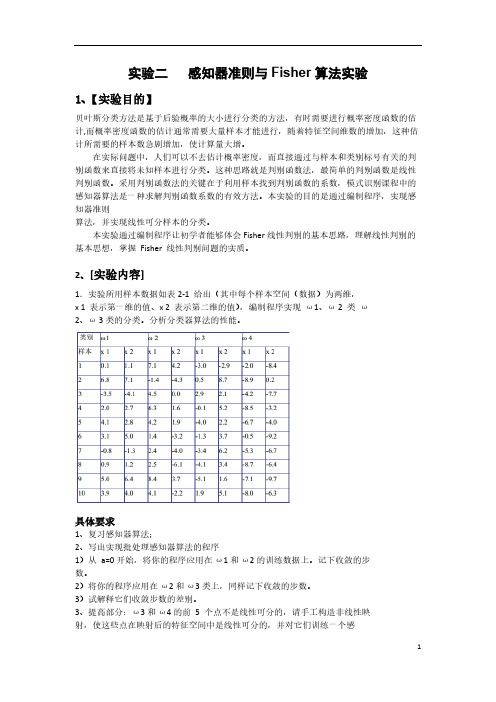

类别1234样本x 1x 2x 1x 2x 1x 2x 1x 210.1 1.17.1 4.2-3.0-2.9-2.0-8.42 6.87.1-1.4-4.30.58.7-8.90.23-3.5-4.1 4.50.0 2.9 2.1-4.2-7.74 2.0 2.7 6.3 1.6-0.1 5.2-8.5-3.25 4.1 2.8 4.2 1.9-4.0 2.2-6.7-4.06 3.1 5.0 1.4-3.2-1.3 3.7-0.5-9.27-0.8-1.3 2.4-4.0-3.4 6.2-5.3-6.780.9 1.2 2.5-6.1-4.1 3.4-8.7-6.49 5.0 6.48.4 3.7-5.1 1.6-7.1-9.710 3.9 4.0 4.1-2.2 1.9 5.1-8.0-6.3实验一 感知器准则算法实验一、实验目的:贝叶斯分类方法是基于后验概率的大小进行分类的方法,有时需要进行概率密度函数的估计,而概率密度函数的估计通常需要大量样本才能进行,随着特征空间维数的增加,这种估计所需要的样本数急剧增加,使计算量大增。

在实际问题中,人们可以不去估计概率密度,而直接通过与样本和类别标号有关的判别函数来直接将未知样本进行分类。

这种思路就是判别函数法,最简单的判别函数是线性判别函数。

采用判别函数法的关键在于利用样本找到判别函数的系数,模式识别课程中的感知器算法是一种求解判别函数系数的有效方法。

本实验的目的是通过编制程序,实现感知器准则算法,并实现线性可分样本的分类。

二、实验内容:实验所用样本数据如表2-1给出(其中每个样本空间(数据)为两维,x 1表示第一维的值、x 2表示第二维的值),编制程序实现1、 2类2、 3类的分类。

分析分类器算法的性能。

2-1 感知器算法实验数据具体要求1、复习感知器算法;2、写出实现批处理感知器算法的程序1)从a=0开始,将你的程序应用在和的训练数据上。

记下收敛的步数。

模式识别02-特征矢量和特征空间

什么是特征?

2011-12-22

济南大学 模式识别与智能系统研 究所(R)

10

模式识别的基本过程

特征提取与选择

2011-12-22

济南大学 模式识别与智能系统研 究所(R)

11

模式识别的基本过程

特征提取与选择

如何抽取和表示特征?

特征抽取方法不是模式识别研究的内容,是由其它知识 来完成,比如说图像处理,信号处理等等。 对于一个特定的模式识别问题,到底要抽取哪些特征来 作为识别特征,尚无具体统一的方法来指导,需要根据 具体问题来分析,选择出一组既能反映模式的本质,又 容易抽取的特征。

2011-12-22

济南大学 模式识别与智能系统研 究所(R)

12

模式识别的基本过程

特征提取与选择:苹果与橙子的分拣

苹果和橙子通过摄像机以数字图像的形式输入计算,下一 步对两种图像进行分类(无法直接对原始图形进行分类)。 从人的角度观察,二者主要差别在于颜色和形状:

颜色特征:图像上每一点的颜色有三个分量:红,绿,蓝; 每个分量可以用一个8位数来度量。蓝色分量对该问题来说 没有用处。只需关注红色和绿色分量。

识别和训练

可以合理地假设:

0.60

橙子

同一类别的样本在特征空 间中应该聚集在一个特定 的区域(聚集性); 不同类别在空间中聚集的 区域应该有一定的差别。

0.20 0.30 0.40 0.50 0.60 0.70

x1

1.40

x2

红苹果 1.00

绿苹果

根据

几何分布特性(这是基本) 根据概率分布特性 可以得到决策面。

模式识别讲义

模式识别实验讲义目录MATLAB 基础 (1)实验一感知器算法实验 (6)实验二模式聚类算法实验 (8)实验三图像识别实验............ 错误!未定义书签。

1MATLAB 基础1.矩阵定义由m 行n 列构成的数组称为(m ×n)阶矩阵。

用"[]"方括号定义矩阵,其中方括号内","逗号或" "空格号分隔矩阵列数值, ";"分号或"Enter"回车键分隔矩阵行数值。

例:a=[a 11 a 12 a 13;a 21 a 22 a 23]或a=[a 11,a 12,a 13;a 21,a 22,a 23]定义了一个2*3阶矩阵a 。

a =a 11 a 12 a 13 a 21 a 22 a 23a ij 可以为数值、变量、表达式或字符串,如为数值与变量得先赋值,表达式和变量可以以任何组合形式出现,字符串须每一行中的字母个数相等 ,调用时缺省状态按行顺序取字母,如a(1)为第一行第一个字母。

下标引用:单下标方式:a(1)= a 11 a(4)= a 22 (以列的方式排列a 11 a 21 a 12 a 22 a 13a 23)双下标方式:a(1,1)= a 11 a(2,1)= a 212.矩阵的加减运算两矩阵相加减,是对应元素的加减,要求两矩阵具有相同的行数,相同的列数。

MATLAB 表达式形式:C =A +B 和 C =A -B ,其中C ij =A ij ±B ij 。

3 向量乘积和转置两矩阵A,B 相乘,要求两个矩阵的相邻阶数相等,一般情况下不满足交换律。

MATLAB 表达式形式:C=A*B 其中第i 行j 列元素C ij 为A 的第i 行的m 个元素与B 的第j 列的n 个对应元素的乘积之和。

矩阵的转置就是把矩阵的第I 行就j 列的元素放在第j 行第i 列的位置上。

模式识别 第二章 聚类分析课件

蜥蜴,蛇, 麻雀,海

金鱼

鸥,青蛙

羊,狗, 猫,

鲨鱼

(c) 生存环境

(d)繁衍后代的方式和是否存在肺

6

2.1 聚类的基本概念

2.1.5 距离测度对聚类结果的影响

数据的粗聚类是两类,细聚类为4类

72.2 ຫໍສະໝຸດ 式相似性测度2.2.1 距 离 测 度 2.2.2 相 似 测 度 2.2.3 匹 配 测 度

r(x1, x2 )

18

(3) 指数相关系数

e(x, y) 1 n exp[ 3 (xi yi )2 ]

n i1

4

2 i

这里假设 x 和 y 的维数n相同、概率分布相同。

2是第i个分量的方差。

i

性质:不受量纲变化的影响。

19

(三) 匹 配 测 度

若特征只有两个状态: 0 => 有此特征;1 => 无此特征。称之为二值特征。

注意,这里只考虑(1-1)匹配,而不考虑(0-0)匹配。 21

(三) 匹 配 测 度

(2) Rao测度

(1-1)匹配特征数目与特征总数之比

s(x, y)

a

x'y

abce n

(3) 简单匹配系数 (1-1)匹配+(0-0)匹配/特征总数

m(x, y) a e n

(4) Dice系数

只对(1-1)匹配加权

取决于分类算法和特征点分布情况的匹配。

x2

x2

w1

w2

W1

b

w1

W2

W1

w2

w3

W2

W3

1.特征选取不当使分类无效。

x1

4

2.特征选取不足可能使不同 类别的模式判为一类。

模式识别——感知器准则与Fisher算法实验-推荐下载

1、复习感知器算法; 2、写出实现批处理感知器算法的程序 1)从 a=0 开始,将你的程序应用在 ω1 和 ω2 的训练数据上。记下收敛的步 数。 2)将你的程序应用在 ω2 和 ω3 类上,同样记下收敛的步数。 3)试解释它们收敛步数的差别。 3、提高部分:ω3 和 ω4 的前 5 个点不是线性可分的,请手工构造非线性映 射,使这些点在映射后的特征空间中是线性可分的,并对它们训练一个感

本实验通过编制程序让初学者能够体会 Fisher 线性判别的基本思路,理解线性判别的 基本思想,掌握 Fisher 线性判别问题的实质。

2、[实验内容]

1.实验所用样本数据如表 2-1 给出(其中每个样本空间(数据)为两维, x 1 表示第一维的值、x 2 表示第二维的值),编制程序实现 ω1、ω 2 类 ω 2、ω 3 类的分类。分析分类器算法的性能。

x1 X

xd

根据 Fisher 选择投影方向 W 的原则,即使原样本向量在该方向上的投影能兼顾类间分

布尽可能分开,类内样本投影尽可能密集的要求,用以评价投影方向 W 的函数为:

J F (W ) (m~S~112m~S~222)2

W * SW1(m1 m2 )

上面的公式是使用 Fisher 准则求最佳法线向量的解,该式比较重要。另外,该式这种

2

对全部高中资料试卷电气设备,在安装过程中以及安装结束后进行高中资料试卷调整试验;通电检查所有设备高中资料电试力卷保相护互装作置用调与试相技互术关,系电通,力1根保过据护管生高线产中0不工资仅艺料可高试以中卷解资配决料置吊试技顶卷术层要是配求指置,机不对组规电在范气进高设行中备继资进电料行保试空护卷载高问与中题带资2负料2,荷试而下卷且高总可中体保资配障料置2试时32卷,3各调需类控要管试在路验最习;大题对限到设度位备内。进来在行确管调保路整机敷使组设其高过在中程正资1常料中工试,况卷要下安加与全强过,看度并25工且52作尽22下可护都能1关可地于以缩管正小路常故高工障中作高资;中料对资试于料卷继试连电卷接保破管护坏口进范处行围理整,高核或中对者资定对料值某试,些卷审异弯核常扁与高度校中固对资定图料盒纸试位,卷置编工.写况保复进护杂行层设自防备动腐与处跨装理接案资要,料求编试技5写、卷术重电保交要气护底设设装。备备置管4高调、动线中试电作敷资高气,设料中课并技3试资件且、术卷料中拒管试试调绝路包验卷试动敷含方技作设线案术,技槽以来术、及避管系免架统不等启必多动要项方高方案中式;资,对料为整试解套卷决启突高动然中过停语程机文中。电高因气中此课资,件料电中试力管卷高壁电中薄气资、设料接备试口进卷不行保严调护等试装问工置题作调,并试合且技理进术利行,用过要管关求线运电敷行力设高保技中护术资装。料置线试做缆卷到敷技准设术确原指灵则导活:。。在对对分于于线调差盒试动处过保,程护当中装不高置同中高电资中压料资回试料路卷试交技卷叉术调时问试,题技应,术采作是用为指金调发属试电隔人机板员一进,变行需压隔要器开在组处事在理前发;掌生同握内一图部线纸故槽资障内料时,、,强设需电备要回制进路造行须厂外同家部时出电切具源断高高习中中题资资电料料源试试,卷卷线试切缆验除敷报从设告而完与采毕相用,关高要技中进术资行资料检料试查,卷和并主检且要测了保处解护理现装。场置设。备高中资料试卷布置情况与有关高中资料试卷电气系统接线等情况,然后根据规范与规程规定,制定设备调试高中资料试卷方案。

模式识别实验二资料

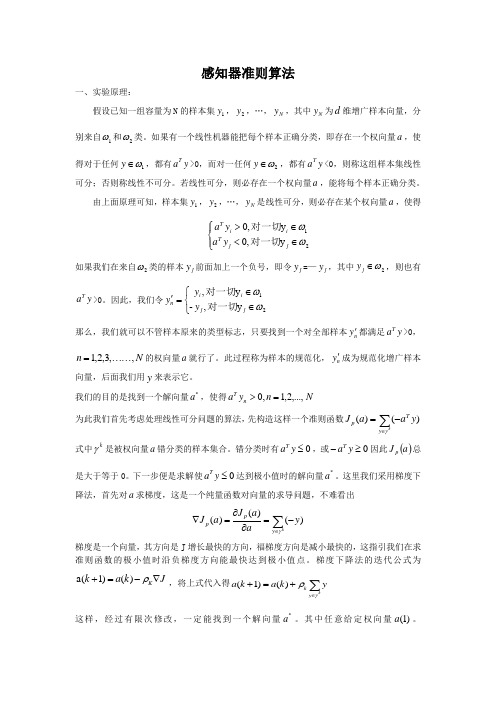

感知器准则算法一、实验原理:假设已知一组容量为N 的样本集1y ,2y ,…,N y ,其中N y 为d 维增广样本向量,分别来自1ω和2ω类。

如果有一个线性机器能把每个样本正确分类,即存在一个权向量a ,使得对于任何1ω∈y ,都有y a T>0,而对一任何2ω∈y ,都有y a T<0,则称这组样本集线性可分;否则称线性不可分。

若线性可分,则必存在一个权向量a ,能将每个样本正确分类。

由上面原理可知,样本集1y ,2y ,…,N y 是线性可分,则必存在某个权向量a ,使得⎪⎩⎪⎨⎧∈<∈>21y ,0y ,0ωωj j T i i Ty a y a 对一切对一切如果我们在来自2ω类的样本j y 前面加上一个负号,即令j y =—j y ,其中2ω∈j y ,则也有y a T>0。

因此,我们令⎩⎨⎧∈∈='21y ,-y ,ωωj ji i n y y y 对一切对一切那么,我们就可以不管样本原来的类型标志,只要找到一个对全部样本ny '都满足y a T>0,N n ,,3,2,1⋯⋯=的权向量a 就行了。

此过程称为样本的规范化,ny '成为规范化增广样本向量,后面我们用y 来表示它。

我们的目的是找到一个解向量*a ,使得N n y a n T ,...,2,1,0=>为此我们首先考虑处理线性可分问题的算法,先构造这样一个准则函数)()(∑∈-=ky Tp y aa J γ式中kγ是被权向量a 错分类的样本集合。

错分类时有0≤y a T,或0≥-y a T因此()a J p 总是大于等于0。

下一步便是求解使0≤y a T达到极小值时的解向量*a 。

这里我们采用梯度下降法,首先对a 求梯度,这是一个纯量函数对向量的求导问题,不难看出∑∈-=∂∂=∇ky p p y aa J a J γ)()()(梯度是一个向量,其方向是J 增长最快的方向,福梯度方向是减小最快的,这指引我们在求准则函数的极小值时沿负梯度方向能最快达到极小值点。

模式识别实验报告

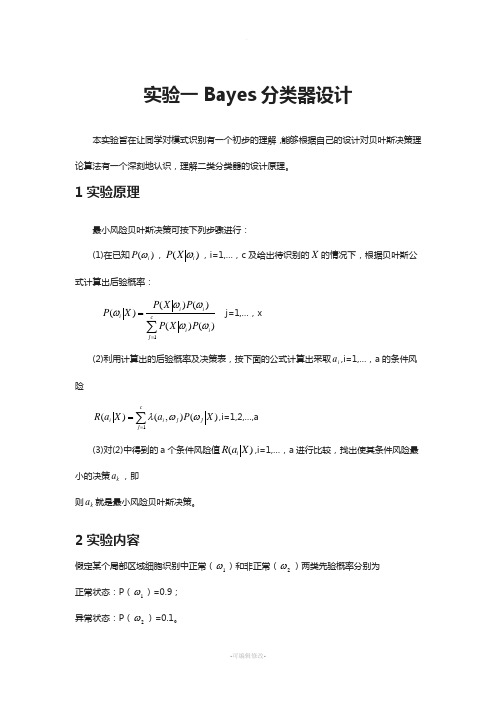

实验一Bayes 分类器设计本实验旨在让同学对模式识别有一个初步的理解,能够根据自己的设计对贝叶斯决策理论算法有一个深刻地认识,理解二类分类器的设计原理。

1实验原理最小风险贝叶斯决策可按下列步骤进行:(1)在已知)(i P ω,)(i X P ω,i=1,…,c 及给出待识别的X 的情况下,根据贝叶斯公式计算出后验概率: ∑==cj iii i i P X P P X P X P 1)()()()()(ωωωωω j=1,…,x(2)利用计算出的后验概率及决策表,按下面的公式计算出采取i a ,i=1,…,a 的条件风险∑==cj j jii X P a X a R 1)(),()(ωωλ,i=1,2,…,a(3)对(2)中得到的a 个条件风险值)(X a R i ,i=1,…,a 进行比较,找出使其条件风险最小的决策k a ,即则k a 就是最小风险贝叶斯决策。

2实验内容假定某个局部区域细胞识别中正常(1ω)和非正常(2ω)两类先验概率分别为 正常状态:P (1ω)=0.9; 异常状态:P (2ω)=0.1。

现有一系列待观察的细胞,其观察值为x :-3.9847 -3.5549 -1.2401 -0.9780 -0.7932 -2.8531 -2.7605 -3.7287 -3.5414 -2.2692 -3.4549 -3.0752 -3.9934 2.8792 -0.9780 0.7932 1.1882 3.0682 -1.5799 -1.4885 -0.7431 -0.4221 -1.1186 4.2532 已知类条件概率密度曲线如下图:)|(1ωx p )|(2ωx p 类条件概率分布正态分布分别为(-2,0.25)(2,4)试对观察的结果进行分类。

3 实验要求1) 用matlab 完成分类器的设计,要求程序相应语句有说明文字。

2) 根据例子画出后验概率的分布曲线以及分类的结果示意图。

模式识别实验 (2)

基于概率统计的贝叶斯分类器设计摘要:人们为了掌握客观事物,按事物相似的程度组成类别,模式识别就是将某一具体事物正确地归入某一类别。

贝叶斯决策理论是统计模式识别中的一个基本方法。

依据贝叶斯决策理论设计的分类器具有最优的性能,即所实现的分类错误率或风险在所有可能的分类器中是最小的,因此经常被用来衡量其他分类器设计方法的优劣。

关键词:MATLAB应用贝叶斯分类器后验概率贝叶斯公式最小错误概率随着计算机与信息技术的发展,人类获取的知识和能够及时处理的数据之间的差距在加大,从而导致了一个尴尬的境地,即“丰富的数据”和“贫乏的知识”并存。

在数据挖掘技术中,分类技术能对大量的数据进行分析、学习,并建立相应问题领域中的分类模型。

分类技术解决问题的关键是构造分类器。

分类器是一个能自动将未知文档标定为某类的函数。

通过训练集训练以后,能将待分类的文档分到预先定义的目录中。

常用的分类器的构造方法有决策树、朴素贝叶斯、支持向量机、k近邻、神经网络等多种分类法,在各种分类法中基于概率的贝叶斯分类法比较简单,在分类技术中得到了广泛的应用。

一原理概述:贝叶斯分类器是基于贝叶斯网络所构建的分类器,贝叶斯网络是描述数据变量之间关系的图形模型,是一个带有概率注释的有向无环图。

贝叶斯分类器的分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。

(1) 贝叶斯分类并不把一个对象绝对地指派给某一类,而是通过计算得出属于某一类的概率,具有最大概率的类便是该对象所属的类;(2) 一般情况下在贝叶斯分类中所有的属性都潜在地起作用,即并不是一个或几个属性决定分类,而是所有的属性都参与分类;(3) 贝叶斯分类对象的属性可以是离散的、连续的,也可以是混合的。

二计算方法:1、贝叶斯分类的先决条件:(1) 决策分类的类别数是一定的,设有c 个模式类ωi (i=1,2,…,c )(2) 各类别总体的概率分布已知,待识别模式的特征向量x 的状态后验概率P(ωi|x)是已知的;或各类出现的先验概率P(ωi)和类条件概率密度函数p(x|ωi)已知 2、两类分类的最小错误率Bayes 分类决策规则的后验概率形式:设N 个样本分为两类ω1,ω2。

模式识别技术实验报告

模式识别技术实验报告本实验旨在探讨模式识别技术在计算机视觉领域的应用与效果。

模式识别技术是一种人工智能技术,通过对数据进行分析、学习和推理,识别其中的模式并进行分类、识别或预测。

在本实验中,我们将利用机器学习算法和图像处理技术,对图像数据进行模式识别实验,以验证该技术的准确度和可靠性。

实验一:图像分类首先,我们将使用卷积神经网络(CNN)模型对手写数字数据集进行分类实验。

该数据集包含大量手写数字图片,我们将训练CNN模型来识别并分类这些数字。

通过调整模型的参数和训练次数,我们可以得到不同准确度的模型,并通过混淆矩阵等评估指标来评估模型的性能和效果。

实验二:人脸识别其次,我们将利用人脸数据集进行人脸识别实验。

通过特征提取和比对算法,我们可以识别不同人脸之间的相似性和差异性。

在实验过程中,我们将测试不同算法在人脸识别任务上的表现,比较它们的准确度和速度,探讨模式识别技术在人脸识别领域的应用潜力。

实验三:异常检测最后,我们将进行异常检测实验,使用模式识别技术来识别图像数据中的异常点或异常模式。

通过训练异常检测模型,我们可以发现数据中的异常情况,从而做出相应的处理和调整。

本实验将验证模式识别技术在异常检测领域的有效性和实用性。

结论通过以上实验,我们对模式识别技术在计算机视觉领域的应用进行了初步探索和验证。

模式识别技术在图像分类、人脸识别和异常检测等任务中展现出了良好的性能和准确度,具有广泛的应用前景和发展空间。

未来,我们将进一步深入研究和实践,探索模式识别技术在更多领域的应用,推动人工智能技术的发展和创新。

【字数:414】。

模式识别实验报告2_贝叶斯分类实验_实验报告(例)

end

plot(1:23,t2,'b','LineWidth',3);

%下面是bayesian_fun函数

functionf=bayesian_fun(t2,t1,W1,W2,w1,w2,w10,w20)

x=[t1,t2]';

f=x'*W1*x+w1'*x+w10- (x'*W2*x+w2'*x+w20);

%f=bayesian_fun.m

function f=bayesian_fun(t2,t1,W1,W2,w1,w2,w10,w20)

x=[t1,t2]';

f=x'*W1*x+w1'*x+w10 - (x'*W2*x+w2'*x+w20);

w10=-1/2 * u1'*S1tinv*u1 - 1/2 *log(det(S1t)) + log(pw1);

w20=-1/2 * u2'*S2tinv*u2 - 1/2 *log(det(S2t)) + log(pw2);

t2=[]

fort1=1:23

tt2 = fsolve('bayesian_fun',5,[],t1,W1,W2,w1,w2,w10,w20);

'LineWidth',2,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0 1 0],...

'MarkerSize',10)

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验2 贝叶斯分类判别法一、实验原理实验数据:IRIS 数据。

分为三种类型,每种类型中包括50个思维的向量。

实验模型:假设IRIS 数据是正态分布的。

实验准备:在每种类型中,选择部分向量作为训练样本,估计未知的均值和方差的参数。

实验方法:最小错误判别准则;最小风险判别准则。

实验原理:1.贝叶斯公式已知共有M 类别M i i ,2,1,=ω,统计分布为正态分布,已知先验概率)(i P ω及类条件概率密度函数)|(i X P ω,对于待测样品,贝叶斯公式可以计算出该样品分属各类别的概率,叫做后验概率;看X 属于哪个类的可能性最大,就把X 归于可能性最大的那个类,后验概率即为识别对象归属的依据。

贝叶斯公式为M i P X P P X P X P Mj jji i i ,2,1,)()|()()|()|(1==∑=ωωωωω该公式体现了先验概率、类条件概率、后验概率三者的关系。

其中,类条件概率密度函数)|(i X P ω为正态密度函数,用大量样本对其中未知参数进行估计,多维正态密度函数为)]()(21exp[)2(1)(12/12/μμπ---=-X S X SX P T n 式中,),,(21n x x x X =为n 维向量; ),,(21n μμμμ =为n 维均值向量; ]))([(TX X E S μμ--=为n 维协方差矩阵; 1-S是S 的逆矩阵;S 是S 的行列式。

大多数情况下,类条件密度可以采用多维变量的正态密度函数来模拟。

)]}()(21exp[)2(1ln{)|()(1)(2/12/i i X X S X X S X P i T in i ωωπω---=-i i T S n X X S X X i i ln 212ln 2)()(21)(1)(-----=-πωω )(i X ω为i ω类的均值向量。

2.最小错误判别准则① 两类问题有两种形式,似然比形式:⎩⎨⎧∈⇒⎩⎨⎧<>=211221)()()|()|()(ωωωωωωX P P X P X P X l其中,)(X l 为似然比,)()(12ωωP P 为似然比阈值。

对数形式:⎩⎨⎧∈⇒-⎩⎨⎧<>-211221)(ln )(ln )|(ln )|(ln ωωωωωωX P P X P X P② 多类问题本实验采取针对多累问题的解决方法。

在待测向量X 的条件下,看哪个类的概率最大,应该把X 归于概率最大的那个类。

因此,可以通过比较各个判别函数来确定X 的类型。

M i X X P P X P P i j j Mj i i ,2,1,)}|()({max )|()(1=∈⇒=≤≤ωωωωω对数形式为:M i X X P P X P P i j j Mj i i ,2,1,)}|(ln )({ln max )|(ln )(ln 1=∈⇒+=+≤≤ωωωωω所以此时正态分布的贝叶斯分类器判别函数为)()]}()(21exp[)2(1ln{)()|(ln )()(1)(2/12/i i T in i i i P X X S X X S P X P X h i i ωπωωωω---==-)(ln ln 212ln 2)()(21)(1)(i i i T P S n X X S X X i i ωπωω+-----=-3.最小风险判别准则对观测值X 条件下,各状态后验概率求加权和的方式,表示风险如下:∑==Mj j i X P j i L X R 1)|(),()(ω其中,),(j i L 为将第j 类判为第i 类的损失。

若判对i=j ,则),(j i L 取负值或零值,表示没有损失;若判对i ≠j ,则),(j i L 取正值,数值大小表示损失多少。

对得到的M 个类型的风险值M i X R i ,2,1),( 进行比较,得到使条件风险最小的类别,判别X 属于该类别。

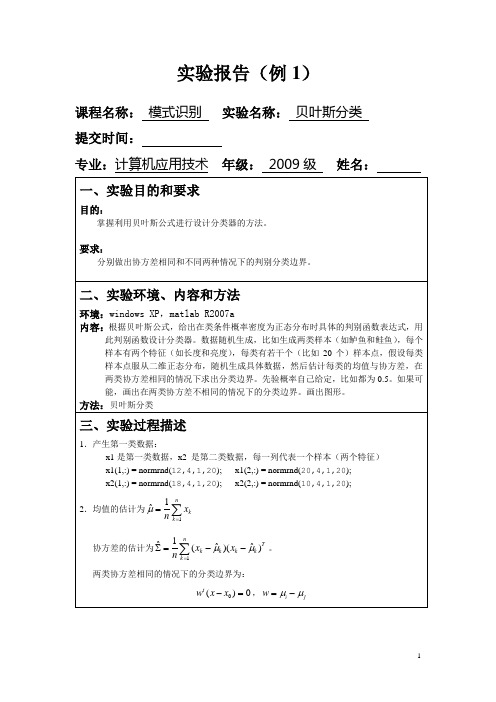

二、实验过程实验环境:MA TLAB R2009a1.将txt 格式下的IRIS 数据导入实验环境中。

实验中设计了对话框,可直接选择存放该文件的路径并导入。

2.将读入的数据进行逐行录入,按行录入在1*150的数组iris 中,每一个元素中包含一个四维向量。

clear;%从irisdatas.txt 读取数据%[filename,filepath]=uigetfile('*.txt','导入数据'); file = [filepath filename];fid = fopen(file); %弹出对话框,选择录入的文件 if fid == -1 ('打开数据出错!') end3.通过计算,分别估计出三类的统计特征值,即正态分布的两个重要参数均值μ和方差2σ。

∑===501)()(i i x x E μ,]))([(T X X E S μμ--=。

以下程序段为第一类特征值求取过程,第二、三类相似,实验中,取第偶数个向量为训练样本。

%逐行存入数组iris 中% linenum=1; while 1tline = fgetl(fid); %读第一行if ~ischar(tline), break , end %下一行为空时跳出循环 iris{linenum} = sscanf(tline, '%f');%读取数据,存数组iris 中 linenum=linenum+1; end%估计第一类iris数据的统计特征%sum=0;for j=1:1:4for i=1:2:50yangben1=iris{i};sum=sum+yangben1(j,1);endmean1(j,1)=sum/25;%mean1是第一类数据的期望sum=0;endsigema=0;for i=1:2:50sigema=sigema+(iris{i}-mean1)*(iris{i}-mean1)';endsigema1=sigema/25;%sigema1为第一类数据的协方差矩阵4.已经估计出三类数据的统计特征。

首先使用最小错误判别准则进行分类,实验中采用对数形式计算,假设三种类型的先验概率相等,即均为1/3,在某一X下得到的三个后验概率的函数。

比较三个值的大小,哪个最大,就可判断X属于哪一类。

最后进行了分类器判据结果的验证。

%对150组数据进行分类,并验证结果的正确性%for i=1:1:150x=iris{i};%分别代入三个后验概率函数中%h1=-0.5*(x-mean1)'*inv(sigema1)*(x-mean1)-2*log(2*pi)-0.5*log(det(sigema1))+log(1/3);h2=-0.5*(x-mean2)'*inv(sigema2)*(x-mean2)-2*log(2*pi)-0.5*log(det(sigema2))+log(1/3);h3=-0.5*(x-mean3)'*inv(sigema3)*(x-mean3)-2*log(2*pi)-0.5*log(det(sigema3))+log(1/3);h(1)=h1;h(2)=h2;h(3)=h3;%比较三个数据的大小,并判断属于哪一类%max=h(1);class=1;for j=1:1:3if h(j)>maxmax=h(j);class=j;endend%对分类器决策的结果进行验证并输出结果%if (i<=50 & class~=1) | (i>50 & i<=100 & class~=2) | (i>100 & class~=3)fprintf('对于“判断第%d个数据属于第%d类”的分类是错误的!\n',i,class);elsefprintf('判断第%d个数据属于第%d类\n',i,class);endend5.再使用最小风险判别准则进行分类,实验中扔采用对数形式计算,假设三种类型的先验概率相等,即均为1/3。

设计出风险参数矩阵L,该数据可根据实际损失的情况需要进行修改。

将X代入得到三个数值,哪个最小,即为风险最小,便属于该类型。

最后同样进行了判别结构的验证。

三、实验结果与分析1.最小错误判别准则判断第1个数据属于第1类判断第2个数据属于第1类判断第3个数据属于第1类判断第4个数据属于第1类%对150组数据进行分类,并验证结果的正确性%hw1=log(1/3);hw2=log(1/3);hw3=log(1/3);%三个类型的先验函数相等L=[0,1,1;1,0,1;1,1,0];%设计风险参数矩阵,可根据损失多少进行改变for i=1:1:150x=iris{i};%先计算先验概率%hxw1=-0.5*(x-mean1)'*inv(sigema1)*(x-mean1)-2*log(2*pi)-0.5*log (det(sigema1));hxw2=-0.5*(x-mean2)'*inv(sigema2)*(x-mean2)-2*log(2*pi)-0.5*log (det(sigema2));hxw3=-0.5*(x-mean3)'*inv(sigema3)*(x-mean3)-2*log(2*pi)-0.5*log (det(sigema3));%再计算含有风险因子的后验概率%r(1)=L(1,1)*(hxw1+hw1)+L(1,2)*(hxw2+hw2)+L(1,3)*(hxw3+hw3); r(2)=L(2,1)*(hxw1+hw1)+L(2,2)*(hxw2+hw2)+L(2,3)*(hxw3+hw3); r(3)=L(3,1)*(hxw1+hw1)+L(3,2)*(hxw2+hw2)+L(3,3)*(hxw3+hw3);%比较三类风险大小,属于风险最小的那一类%min=r(1);class=1;for j=1:1:3if r(j)<minmin=r(j);class=j;endend%验证分类结果的正确性%if (i<=50 & class~=1) | (i>50 & i<=100 & class~=2) | (i>100 & class~=3)fprintf('对于“判断第%d个数据属于第%d类”的分类是错误的!\n',i,class);elsefprintf('判断第%d个数据属于第%d类\n',i,class);endend判断第6个数据属于第1类判断第7个数据属于第1类判断第8个数据属于第1类判断第9个数据属于第1类判断第10个数据属于第1类判断第11个数据属于第1类判断第12个数据属于第1类判断第13个数据属于第1类判断第14个数据属于第1类判断第15个数据属于第1类判断第16个数据属于第1类判断第17个数据属于第1类判断第18个数据属于第1类判断第19个数据属于第1类判断第20个数据属于第1类判断第21个数据属于第1类判断第22个数据属于第1类判断第23个数据属于第1类判断第24个数据属于第1类判断第25个数据属于第1类判断第26个数据属于第1类判断第27个数据属于第1类判断第28个数据属于第1类判断第29个数据属于第1类判断第30个数据属于第1类判断第31个数据属于第1类判断第32个数据属于第1类判断第33个数据属于第1类判断第34个数据属于第1类判断第35个数据属于第1类判断第36个数据属于第1类判断第37个数据属于第1类判断第38个数据属于第1类判断第39个数据属于第1类判断第40个数据属于第1类判断第41个数据属于第1类判断第42个数据属于第1类判断第43个数据属于第1类判断第44个数据属于第1类判断第46个数据属于第1类判断第47个数据属于第1类判断第48个数据属于第1类判断第49个数据属于第1类判断第50个数据属于第1类判断第51个数据属于第2类判断第52个数据属于第2类判断第53个数据属于第2类判断第54个数据属于第2类判断第55个数据属于第2类判断第56个数据属于第2类判断第57个数据属于第2类判断第58个数据属于第2类判断第59个数据属于第2类判断第60个数据属于第2类判断第61个数据属于第2类判断第62个数据属于第2类判断第63个数据属于第2类判断第64个数据属于第2类判断第65个数据属于第2类判断第66个数据属于第2类判断第67个数据属于第2类判断第68个数据属于第2类判断第69个数据属于第2类判断第70个数据属于第2类对于“判断第71个数据属于第3类”的分类是错误的!判断第72个数据属于第2类判断第73个数据属于第2类判断第74个数据属于第2类判断第75个数据属于第2类判断第76个数据属于第2类判断第77个数据属于第2类判断第78个数据属于第2类判断第79个数据属于第2类判断第80个数据属于第2类判断第81个数据属于第2类判断第82个数据属于第2类判断第83个数据属于第2类的分类是错误的!判断第85个数据属于第2类判断第86个数据属于第2类判断第87个数据属于第2类判断第88个数据属于第2类判断第89个数据属于第2类判断第90个数据属于第2类判断第91个数据属于第2类判断第92个数据属于第2类判断第93个数据属于第2类判断第94个数据属于第2类判断第95个数据属于第2类判断第96个数据属于第2类判断第97个数据属于第2类判断第98个数据属于第2类判断第99个数据属于第2类判断第100个数据属于第2类判断第101个数据属于第3类判断第102个数据属于第3类判断第103个数据属于第3类判断第104个数据属于第3类判断第105个数据属于第3类判断第106个数据属于第3类判断第107个数据属于第3类判断第108个数据属于第3类判断第109个数据属于第3类判断第110个数据属于第3类判断第111个数据属于第3类判断第112个数据属于第3类判断第113个数据属于第3类判断第114个数据属于第3类判断第115个数据属于第3类判断第116个数据属于第3类判断第117个数据属于第3类判断第119个数据属于第3类判断第120个数据属于第3类判断第121个数据属于第3类判断第122个数据属于第3类判断第123个数据属于第3类判断第124个数据属于第3类判断第125个数据属于第3类判断第126个数据属于第3类判断第127个数据属于第3类判断第128个数据属于第3类判断第129个数据属于第3类判断第130个数据属于第3类判断第131个数据属于第3类对于“判断第132个数据属于第2类”的分类是错误的!判断第133个数据属于第3类对于“判断第134个数据属于第2类”的分类是错误的!判断第135个数据属于第3类判断第136个数据属于第3类判断第137个数据属于第3类判断第138个数据属于第3类判断第139个数据属于第3类判断第140个数据属于第3类判断第141个数据属于第3类判断第142个数据属于第3类判断第143个数据属于第3类判断第144个数据属于第3类判断第145个数据属于第3类判断第146个数据属于第3类判断第147个数据属于第3类判断第148个数据属于第3类判断第149个数据属于第3类判断第150个数据属于第3类第一类中没有出现判决错误,第二、三类中出现了个别的错误,分类正确率较高,如果要提高正确率,可以选取更多的样本进行训练。