模式识别实验3

模式识别(3-1)

§3.2 最大似然估计

最大似然估计量: -使似然函数达到最大值的参数向量。 -最符合已有的观测样本集的那一个参数向量。 ∵学习样本从总体样本集中独立抽取的

N ) p( X | ) p( X k | i ) k 1 N个学习样本出现概率的乘积

i

i

∴

p( X | i . i

i

§3.2 Bayes学习

假定: ①待估参数θ是随机的未知量 ②按类别把样本分成M类X1,X2,X3,… XM 其中第i类的样本共N个 Xi = {X1,X2,… XN} 并且是从总体中独立抽取的 ③ 类条件概率密度具有某种确定的函数形式,但其 参数向量未知。 ④ Xi 中的样本不包含待估计参数θj(i≠j)的信息,不 同类别的参数在函数上是独立的,所以可以对每一 类样本独立进行处理。

有时上式是多解的, 上图有5个解,只有一个解最大即 (对所有的可能解进行检查或计算二阶导数)

§3.2 最大似然估计

例:假设随机变量x服从均匀分布,但参数1, 2未知, 1 1 x 2 p ( x | ) 2 1 , 0 其他 求1, 2的最大似然估计量。 解:设从总体中独立抽取N个样本x1 , x2 , , xN , 则其似然函数为: 1 p ( x1 , x2 , , xN | 1, 2 ) ( 2 1 ) N l ( ) p ( X | ) 0

§3.2 Bayes学习

p ~ N 0 , 0

2

其中 0和 0 是已知的

2

已知的信息还包括一组抽取出来的样本X i x1 , x2 ,, xN ,从而 可以得到关于 的后验概率密度:

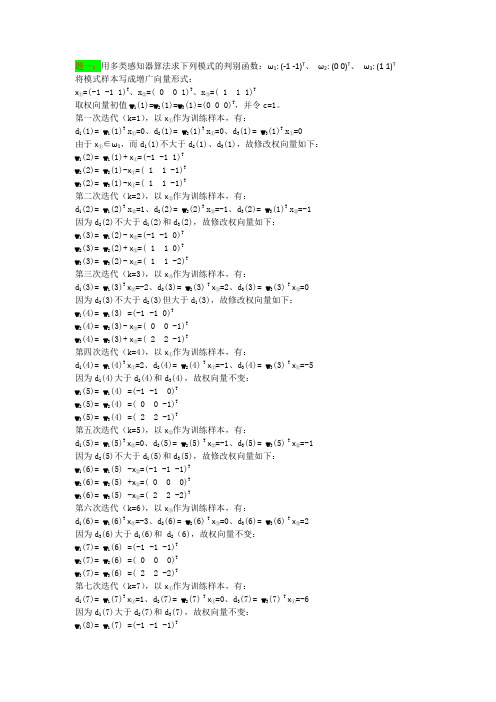

模式识别与机器学习 作业 中科院 国科大 来源网络 (3)

{ double sum=0.0; for(int j=0;j<T;j++) sum+=a[j]*C[j][i]; res[i]=sum; } } int main() { int T; int w1_num,w2_num; double w1[10][5],w2[10][5],m1[5]={0},m2[5]={0},C1[5][5]={0},C2[5][5]={0}; cin>>T>>w1_num>>w2_num; for(int i=0;i<w1_num;i++) { for(int j=0;j<T;j++) { cin>>w1[i][j]; m1[j]+=w1[i][j]; } } for(int i=0;i<w2_num;i++) { for(int j=0;j<T;j++) { cin>>w2[i][j]; m2[j]+=w2[i][j]; } } for(int i=0;i<w1_num;i++) m1[i]=m1[i]/w1_num; for(int i=0;i<w2_num;i++) m2[i]=m2[i]/w2_num; for(int i=0;i<w1_num;i++) { double res[5][5],a[5]; for(int j=0;j<T;j++) a[j]=w1[i][j]-m1[j]; get_matrix(T,res,a); for(int j=0;j<T;j++) { for(int k=0;k<T;k++) C1[j][k]+=res[j][k]; }

模式识别作业三道习题

K7 ( X ) K6 ( X ) 1 第八步:取 X 4 w2 , K 7 ( X 4 ) 32 0 ,故 0 K8 ( X ) K 7 ( X ) 0 第九步:取 X 1 w1 , K8 ( X 1 ) 32 0 ,故 1 K 9 ( X ) K8 ( X ) 0 第十步:取 X 2 w1 , K9 ( X 2 ) 32 0 ,故 1 K10 ( X ) K9 ( X )

2

K ( X , X k ) exp{ || X X k || 2} exp{[( x 1 xk 1) 2 ( x 2 xk 2 ) 2]} x1 X = x2 ,训练样本为 X k 。 其中

第3题模式识别记心头看似并列实递进

第3题模式识别记心头看似并列实递进例3.(2012•河南)如图,在平面直角坐标系中,直线y=x+1与抛物线y=ax2+bx﹣3交于A、B两点,点A在x轴上,点B的纵坐标为3.点P是直线AB下方的抛物线上一动点(不与A、B点重合),过点P作x轴的垂线交直线AB于点C,作PD⊥AB于点D.(1)求a、b及sin∠ACP的值;(2)设点P的横坐标为m;①用含有m的代数式表示线段PD的长,并求出线段PD长的最大值;②连接PB,线段PC把△PDB分成两个三角形,是否存在适合的m的值,使这两个三角形的面积之比为9:10?若存在,直接写出m的值;若不存在,说明理由.3-1.(2011•泰州)已知二次函数y=x2+bx﹣3的图象经过点P(﹣2,5)(1)求b的值并写出当1<x≤3时y的取值范围;(2)设P1(m,y1)、P2(m+1,y2)、P3(m+2,y3)在这个二次函数的图象上,①当m=4时,y1、y2、y3能否作为同一个三角形三边的长?请说明理由;②当m取不小于5的任意实数时,y1、y2、y3一定能作为同一个三角形三边的长,请说明理由.3-2.(2013•重庆)如图,对称轴为直线x=﹣1的抛物线y=ax2+bx+c(a≠0)与x轴相交于A、B两点,其中点A的坐标为(﹣3,0).(1)求点B的坐标;(2)已知a=1,C为抛物线与y轴的交点.①若点P在抛物线上,且S△POC=4S△BOC.求点P的坐标;②设点Q是线段AC上的动点,作QD⊥x轴交抛物线于点D,求线段QD长度的最大值.第5题莫为浮云遮望眼,洞察幽微究指向例5.(2012•宁波)如图,二次函数y=ax2+bx+c的图象交x轴于A(﹣1,0),B(2,0),交y轴于C(0,﹣2),过A,C画直线.(1)求二次函数的解析式;(2)点P在x轴正半轴上,且PA=PC,求OP的长;(3)点M在二次函数图象上,以M为圆心的圆与直线AC相切,切点为H.①若M在y轴右侧,且△CHM∽△AOC(点C与点A对应),求点M的坐标;②若⊙M的半径为,求点M的坐标.5-1.(2012•南通)如图,经过点A(0,﹣4)的抛物线y=x2+bx+c与x轴相交于B(﹣2,0),C两点,O为坐标原点.(1)求抛物线的解析式;(2)将抛物线y=x2+bx+c向上平移个单位长度,再向左平移m(m>0)个单位长度得到新抛物线,若新抛物线的顶点P在△ABC内,求m的取值范围;(3)设点M在y轴上,∠OMB+∠OAB=∠ACB,求AM的长.同源链接1.(2010•邵阳)如图,抛物线与x轴相交于点A、B,与y轴相交于点C,顶点为点D,对称轴l与直线BC相交于点E,与x轴相交于点F.(1)求直线BC的解析式;(2)设点P为该抛物线上的一个动点,以点P为圆心,r为半径作⊙P①当点P运动到点D时,若⊙P与直线BC相交,求r的取值范围;②若r=,是否存在点P使⊙P与直线BC相切?若存在,请求出点P的坐标;若不存在,请说明理由.提示:抛物线y=ax2+bx+x(a≠0)的顶点坐标(),对称轴x=.5-2.(2012•广东-东莞)如图,抛物线y=x2﹣x﹣9与x轴交于A、B两点,与y轴交于点C,连接BC、AC.(1)求AB和OC的长;(2)点E从点A出发,沿x轴向点B运动(点E与点A、B不重合),过点E作直线l平行BC,交AC于点D.设AE的长为m,△ADE的面积为s,求s关于m的函数关系式,并写出自变量m的取值范围;(3)在(2)的条件下,连接CE,求△CDE面积的最大值;此时,求出以点E为圆心,与BC相切的圆的面积(结果保留π).同源链接2.(2013•天津)已知抛物线y1=ax2+bx+c(a≠0)的对称轴是直线l,顶点为点M.若自变量x和函数值y1的部分对应值如下表所示:(Ⅰ)求y1与x之间的函数关系式;(Ⅱ)若经过点T(0,t)作垂直于y轴的直线l′,A为直线l′上的动点,线段AM的垂直平分线交直线l于点B,点B关于直线AM的对称点为P,记P(x,y2).(1)求y2与x之间的函数关系式;t的取值范围.同源链接3.(2013•南通)如图,直线y=kx+b(b>0)与抛物线相交于点A(x1,y1),B(x2,y2)两点,与x轴正半轴相交于点D,与y轴相交于点C,设△OCD的面积为S,且kS+32=0.(1)求b的值;(2)求证:点(y1,y2)在反比例函数的图象上;(3)求证:x1•OB+y2•OA=0.同源链接4.(2012•遂宁)已知:如图,直线y=mx+n与抛物线交于点A(1,0)和点B,与抛物线的对称轴x=﹣2交于点C(﹣2,4),直线f过抛物线与x轴的另一个交点D且与x轴垂直.(1)求直线y=mx+n和抛物线的解析式;(2)在直线f上是否存在点P,使⊙P与直线y=mx+n和直线x=﹣2都相切.若存在,求出圆心P的坐标,若不存在,请说明理由;(3)在线段AB上有一个动点M(不与点A、B重合),过点M作x轴的垂线交抛物线于点N,当MN的长为多少时,△ABN的面积最大,请求出这个最大面积.同源链接5.(2011•福建)如图,抛物线y=ax2﹣4ax+c(a≠0)经过A(0,﹣1),B(5,0)两点,点P是抛物线上的一个动点,且位于直线AB的下方(不与A,B重合),过点P作直线PQ⊥x轴,交AB于点Q,设点P的横坐标为m.(1)求a,c的值;(2)设PQ的长为S,求S与m的函数关系式,写出m的取值范围;(3)以PQ为直径的圆与抛物线的对称轴l有哪些位置关系?并写出对应的m取值范围.(不必写过程)第6题分类讨论程序化分离抗扰探本质例6.(2011•遵义)已知抛物线y=ax2+bx+3(a≠0)经过A(3,0),B(4,1)两点,且与y轴交于点C.(1)求抛物线y=ax2+bx+3(a≠0)的函数关系式及点C的坐标;(2)如图(1),连接AB,在题(1)中的抛物线上是否存在点P,使△PAB是以AB为直角边的直角三角形?若存在,求出点P的坐标;若不存在,请说明理由;(3)如图(2),连接AC,E为线段AC上任意一点(不与A、C重合)经过A、E、O三点的圆交直线AB于点F,当△OEF的面积取得最小值时,求点E的坐标.6-1.(2012•枣庄)在平面直角坐标系中,现将一块等腰直角三角板ABC放在第二象限,斜靠在两坐标轴上,点C为(﹣1,0).如图所示,B点在抛物线y=x2+x﹣2图象上,过点B作BD⊥x轴,垂足为D,且B点横坐标为﹣3.(1)求证:△BDC≌△COA;(2)求BC所在直线的函数关系式;(3)抛物线的对称轴上是否存在点P,使△ACP是以AC为直角边的直角三角形?若存在,求出所有点P的坐标;若不存在,请说明理由.6-2.(2011•南充)如图,等腰梯形ABCD中,AD∥BC,AD=AB=CD=2,∠C=60°,M是BC的中点.(1)求证:△MDC是等边三角形;(2)将△MDC绕点M旋转,当MD(即MD′)与AB交于一点E,MC(即MC′)同时与AD交于一点F时,点E,F和点A构成△AEF.试探究△AEF的周长是否存在最小值?如果不存在,请说明理由;如果存在,请计算出△AEF周长的最小值.6-2.(2011•南充)抛物线y=ax2+bx+c与x轴的交点为A(m﹣4,0)和B(m,0),与直线y=﹣x+p相交于点A和点C(2m﹣4,m﹣6).(1)求抛物线的解析式;(2)若点P在抛物线上,且以点P和A,C以及另一点Q为顶点的平行四边形面积为12,求点P,Q的坐标;(3)在(2)条件下,若点M是x轴下方抛物线上的动点,当△PQM的面积最大时,请求出△PQM的最大面积及点M的坐标.同源链接1.(2013•贵阳)已知:直线y=ax+b过抛物线y=﹣x2﹣2x+3的顶点P,如图所示.(1)顶点P的坐标是_________;(2)若直线y=ax+b经过另一点A(0,11),求出该直线的表达式;(3)在(2)的条件下,若有一条直线y=mx+n与直线y=ax+b关于x轴成轴对称,求直线y=mx+n与抛物线y=﹣x2﹣2x+3的交点坐标.同源链接2.(2013•扬州)如图,抛物线y=x2﹣2x﹣8交y轴于点A,交x轴正半轴于点B.(1)求直线AB对应的函数关系式;(2)有一宽度为1的直尺平行于y轴,在点A、B之间平行移动,直尺两长边所在直线被直线AB和抛物线截得两线段MN、PQ,设M点的横坐标为m,且0<m<3.试比较线段MN与PQ的大小.同源链接3.(2012•阜新)在平面直角坐标系中,二次函数y=ax2+bx+2的图象与x轴交于A(﹣3,0),B(1,0)两点,与y轴交于点C.(1)求这个二次函数的关系解析式;(2)点P是直线AC上方的抛物线上一动点,是否存在点P,使△ACP的面积最大?若存在,求出点P的坐标;若不存在,说明理由;考生注意:下面的(3)、(4)、(5)题为三选一的选做题,即只能选做其中一个题目,多答时只按作答的首题评分,切记啊!(3)在平面直角坐标系中,是否存在点Q,使△BCQ是以BC为腰的等腰直角三角形?若存在,直接写出点Q的坐标;若不存在,说明理由;(4)点Q是直线AC上方的抛物线上一动点,过点Q作QE垂直于x轴,垂足为E.是否存在点Q,使以点B、Q、E为顶点的三角形与△AOC相似?若存在,直接写出点Q的坐标;若不存在,说明理由;(5)点M为抛物线上一动点,在x轴上是否存在点Q,使以A、C、M、Q为顶点的四边形是平行四边形?若存在,直接写出点Q的坐标;若不存在,说明理由.22.(2011•营口)如图(1),直线y=﹣x+3与x轴、y轴分别交于点B、点C,经过B、C 两点的抛物线y=x2+bx+c与x轴的另一个交点为A,顶点为P.(1)求该抛物线的解析式;(2)在该抛物线的对称轴上是否存在点M,使以C、P、M为顶点的三角形为等腰三角形?若存在,请直接写出所有符合条件的点M的坐标;若不存在,请说明理由;(3)连接AC,在x轴上是否存在点Q,使以P、B、Q为顶点的三角形与△ABC相似?若存在,请求出点Q的坐标;若不存在,请说明理由;(4)当0<x<3时,在抛物线上求一点E,使△CBE的面积有最大值.(图(2)、图(3)供画图探究)同源链接4.(2011•乐山)已知顶点为A(1,5)的抛物线y=ax2+bx+c经过点B(5,1).(1)求抛物线的解析式;(2)如图(1),设C,D分别是x轴、y轴上的两个动点,求四边形ABCD的最小周长;(3)在(2)中,当四边形ABCD的周长最小时,作直线CD.设点P(x,y)(x>0)是直线y=x上的一个动点,Q是OP的中点,以PQ为斜边按图(2)所示构造等腰直角三角形PQR.①当△PQR与直线CD有公共点时,求x的取值范围;②在①的条件下,记△PQR与△COD的公共部分的面积为S.求S关于x的函数关系式,并求S的最大值.(同源链接5。

实验三-K-均值聚类算法实验报告

实验三K-Means聚类算法一、实验目的1) 加深对非监督学习的理解和认识2) 掌握动态聚类方法K-Means 算法的设计方法二、实验环境1) 具有相关编程软件的PC机三、实验原理1) 非监督学习的理论基础2) 动态聚类分析的思想和理论依据3) 聚类算法的评价指标四、算法思想K-均值算法的主要思想是先在需要分类的数据中寻找K组数据作为初始聚类中心,然后计算其他数据距离这三个聚类中心的距离,将数据归入与其距离最近的聚类中心,之后再对这K个聚类的数据计算均值,作为新的聚类中心,继续以上步骤,直到新的聚类中心与上一次的聚类中心值相等时结束算法。

实验代码function km(k,A)%函数名里不要出现“-”warning off[n,p]=size(A);%输入数据有n个样本,p个属性cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性%A(:,p+1)=100;A(:,p+1)=0;for i=1:k%cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心m=i*floor(n/k)-floor(rand(1,1)*(n/k))cid(i,:)=A(m,:);cid;endAsum=0;Csum2=NaN;flags=1;times=1;while flagsflags=0;times=times+1;%计算每个向量到聚类中心的欧氏距离for i=1:nfor j=1:kdist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离end%A(i,p+1)=min(dist(i,:));%与中心的最小距离[x,y]=find(dist(i,:)==min(dist(i,:)));[c,d]=size(find(y==A(i,p+1)));if c==0 %说明聚类中心变了flags=flags+1;A(i,p+1)=y(1,1);elsecontinue;endendiflagsfor j=1:kAsum=0;[r,c]=find(A(:,p+1)==j);cid(j,:)=mean(A(r,:),1);for m=1:length(r)Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2));endCsum(1,j)=Asum;endsum(Csum(1,:))%if sum(Csum(1,:))>Csum2% break;%endCsum2=sum(Csum(1,:));Csum;cid; %得到新的聚类中心endtimesdisplay('A矩阵,最后一列是所属类别'); Afor j=1:k[a,b]=size(find(A(:,p+1)==j));numK(j)=a;endnumKtimesxlswrite('data.xls',A);五、算法流程图六、实验结果>>Kmeans6 iterations, total sum of distances = 204.82110 iterations, total sum of distances = 205.88616 iterations, total sum of distances = 204.8219 iterations, total sum of distances = 205.886........9 iterations, total sum of distances = 205.8868 iterations, total sum of distances = 204.8218 iterations, total sum of distances = 204.82114 iterations, total sum of distances = 205.88614 iterations, total sum of distances = 205.8866 iterations, total sum of distances = 204.821Ctrs =1.0754 -1.06321.0482 1.3902-1.1442 -1.1121SumD =64.294463.593976.9329七、实验心得初始的聚类中心的不同,对聚类结果没有很大的影响,而对迭代次数有显著的影响。

计算智能与模式识别实验报告感知器与ADALINE 网络

计算智能与模式识别实验报告感知器与ADALINE 网络一・感知器与ADALINE 网络的工作原理 1. 感知器工作原理感知器是美国心理学家Rrank Rosenblatt 基于MP 模型,利用学习算法的用于分类的对噪声敏感的线性分类器,利用训练样本完成特征空间的决策边界的划感知器的结构:多神经元感知器1i i i = ⎪⎝⎭ ⎪⎪⎭⎝⎛-=∑=n i i i ki k x w f y 1θ, or ()f W =-y x θ 其中,()1, 00, if x f x otherwise≥⎧=⎨⎩ ,()12,,,T n w w w =w ,1112112 ww n m m mn w w W w w ⎡⎤⎢⎥=⎢⎥⎢⎥⎣⎦两类分类,把n R 空间划分成两个区域 多类分类,把n R 空间划分成多个区域以两类为例:n R Class Class ⊂B A, . (1) 线性可分 Linear Separable称 A Class 和 B Class 是线性可分的,如果存在一个超平面将它们分开。

称超平面1:0ni i i S w x θ=-=∑为决策面(边界);称函数∑=-=n1i )g(θi i x w x 为决策函数(或判别函数);称区域{}g()0n R ∈>x x 和{}g()<0n R ∈x x 为决策区域;决策规则:对于新的模式n R ∈*x ,如果()0g *>x ,则 A Class *∈x ;如果()0g *<x ,则 B Class *∈x . (这里假设了决策面1:0ni i i S w x θ=-=∑的法向量指向 A Class )需要指出的是:对于同一个决策面,决策函数的取法并不是唯一的。

例如,我们可以取决策函数为()1n i i i g f w x θ=⎛⎫=- ⎪⎝⎭∑x ,其中,f 为硬限幅函数,则这时对应的决策规则为:对于新的模式n R ∈*x ,如果()1g *=x ,则 A Class *∈x ;如果()0g *=x ,则 B Class *∈x .(2) 非线性可分 Nonlinear Separable称 A Class 和 B Class 是非线性可分的,如果存在一个非线性曲面将它们分开,g>0 g=0 g<0同线性可分情况一样,称曲面()0g =x 为决策面(边界),称函数()g x 为决策函数,对应的决策规则为:对于新的模式n R ∈*x ,如果()0g *>x ,则*x 属于一类;如果()0g *<x ,则*x 属于另一类。

模式识别(三)课后上机作业参考解答

“模式识别(三).PDF”课件课后上机选做作业参考解答(武大计算机学院袁志勇, Email: yuanzywhu@) 上机题目:两类问题,已知四个训练样本ω1={(0,0)T,(0,1)T};ω2={(1,0)T,(1,1)T}使用感知器固定增量法求判别函数。

设w1=(1,1,1)Tρk=1试编写程序上机运行(使用MATLAB、 C/C++、C#、JA V A、DELPHI等语言中任意一种编写均可),写出判别函数,并给出程序运行的相关运行图表。

这里采用MATLAB编写感知器固定增量算法程序。

一、感知器固定增量法的MATLAB函数编写感知器固定增量法的具体内容请参考“模式识别(三).PDF”课件中的算法描述,可将该算法编写一个可以调用的自定义MATLAB函数:% perceptronclassify.m%% Caculate the optimal W by Perceptron%% W1-3x1 vector, initial weight vector% Pk-scalar, learning rate% W -3x1 vector, optimal weight vector% iters - scalar, the number of iterations%% Created: May 17, 2010function [W iters] = perceptronclassify(W1,Pk)x1 = [0 0 1]';x2 = [0 1 1]';x3 = [1 0 1]';x4 = [1 1 1]';% the training sampleWk = W1;FLAG = 0;% iteration flagesiters = 0;if Wk'*x1 <= 0Wk =Wk + x1;FLAG = 1;endif Wk'*x2 <= 0Wk =Wk + x2;FLAG = 1;endif Wk'*x3 >= 0Wk=Wk-x3;FLAG = 1; endif Wk'*x4 >= 0Wk =Wk -x4; FLAG = 1; enditers = iters + 1; while (FLAG) FLAG = 0; if Wk'*x1 <= 0Wk = Wk + x1; FLAG = 1; endif Wk'*x2 <= 0Wk = Wk + x2; FLAG = 1; endif Wk'*x3 >= 0 Wk = Wk - x3; FLAG = 1; endif Wk'*x4 >= 0 Wk = Wk - x4; FLAG = 1; enditers = iters + 1; endW = Wk;二、程序运行程序输入:初始权向量1W , 固定增量大小k ρ 程序输出:权向量最优解W , 程序迭代次数iters 在MATLAB 7.X 命令行窗口中的运行情况: 1、初始化1[111]T W = 初始化W 1窗口界面截图如下:2、初始化1kρ=初始化Pk 窗口界面截图如下:3、在MATLAB 窗口中调用自定义的perceptronclassify 函数由于perceptronclassify.m 下自定义的函数文件,在调用该函数前需要事先[Set path…]设置该函数文件所在的路径,然后才能在命令行窗口中调用。

模式识别习题解答第三章

题1:在一个10类的模式识别问题中,有3类单独满足多类情况1,其余的类别满足多类情况2。

问该模式识别问题所需判别函数的最少数目是多少?答:将10类问题可看作4类满足多类情况1的问题,可将3类单独满足多类情况1的类找出来,剩下的7类全部划到4类中剩下的一个子类中。

再在此子类中,运用多类情况2的判别法则进行分类,此时需要7*(7-1)/2=21个判别函数。

故共需要4+21=25个判别函数。

题2:一个三类问题,其判别函数如下:d1(x)=-x1, d2(x)=x1+x2-1, d3(x)=x1-x2-11.设这些函数是在多类情况1条件下确定的,绘出其判别界面和每一个模式类别的区域。

2.设为多类情况2,并使:d12(x)= d1(x), d13(x)= d2(x), d23(x)= d3(x)。

绘出其判别界面和多类情况2的区域。

3.设d1(x), d2(x)和d3(x)是在多类情况3的条件下确定的,绘出其判别界面和每类的区域。

答:三种情况分别如下图所示:1.2.3.题3:两类模式,每类包括5个3维不同的模式,且良好分布。

如果它们是线性可分的,问权向量至少需要几个系数分量?假如要建立二次的多项式判别函数,又至少需要几个系数分量?(设模式的良好分布不因模式变化而改变。

)答:(1)若是线性可分的,则权向量至少需要14N n =+=个系数分量; (2)若要建立二次的多项式判别函数,则至少需要5!102!3!N ==个系数分量。

题4:用感知器算法求下列模式分类的解向量w : ω1: {(0 0 0)T, (1 0 0)T, (1 0 1)T, (1 1 0)T} ω2: {(0 0 1)T, (0 1 1)T, (0 1 0)T, (1 1 1)T}解:将属于2w 的训练样本乘以(1)-,并写成增广向量的形式x1=[0 0 0 1]',x2=[1 0 0 1]',x3=[1 0 1 1]',x4=[1 1 0 1]';x5=[0 0 -1 -1]',x6=[0 -1 -1 -1]',x7=[0 -1 0 -1]',x8=[-1 -1 -1 -1]';迭代选取1C =,(1)(0,0,0,0)w '=,则迭代过程中权向量w 变化如下:(2)(0 0 0 1)w '=;(3)(0 0 -1 0)w '=;(4)(0 -1 -1 -1)w '=;(5)(0 -1 -1 0)w '=;(6)(1 -1 -1 1)w '=;(7)(1 -1 -2 0)w '=;(8)(1 -1 -2 1)w '=;(9)(2 -1 -1 2)w '=; (10)(2 -1 -2 1)w '=;(11)(2 -2 -2 0)w '=;(12)(2 -2 -2 1)w '=;收敛所以最终得到解向量(2 -2 -2 1)w '=,相应的判别函数为123()2221d x x x x =--+。

模式识别作业三——kl变换

模式识别作业报告组员:2011302265 孔素瑶2011302268 马征2011302273 周昳慧一、实验要求用FAMALE.TXT 和MALE.TXT 的数据作为本次实验使用的样本集,利用K-L 变换对该样本集进行变换,与过去用Fisher 线性判别方法或其它方法得到的分类面进行比较,从而加深对所学内容的理解和感性认识。

二、具体做法1. 不考虑类别信息对整个样本集进行K-L 变换(即PCA ),并将计算出的新特征方向表示在二维平面上,考察投影到特征值最大的方向后男女样本的分布情况并用该主成分进行分类。

2. 利用类平均向量提取判别信息,选取最好的投影方向,考察投影后样本的分布情况并用该投影方向进行分类。

3. 将上述投影和分类情况与以前做的各种分类情况比较,考察各自的特点和相互关系。

三、实验原理设n 维随机向量T n x x x x ),,(21⋯=,其均值向量][x E u =,相关矩阵][Tx xx E R =,协方差矩阵]))([(Tx u x u x E C --=,x 经正交变换后产生向量T n y y y y ),,(21⋯=。

设有标准正交变换矩阵)),,((21n t t t T T ⋯=,(即I T T T=)Tn T n y y y x t t t x T y ),,(),,(2121⋯=⋯==,x t y Ti i = (1,2,)i n =∑=-===ni i i Tt y y T y T x 11(称为 x 的K-L 展开式)取前m 项为x 的估计值1ˆmi i i xy t ==∑ 1m n ≤<其均方误差为∑∑+=+=∧∧==--=nm i ii nm i iTy y E yE x x x x E m 1'12][][)]()[()(ξ∑∑∑+=+=+====nm i i x inm i inm i ii t R ttx x E t y y E m 1'1''1')(][)(ξ在I T T ='的约束条件下,要使均方误差min )]()[()(1''→=--=∑+=∧∧nm i i x it R tx x x x E m ξ为此设定准则函数∑∑+=+=--=nm i i Ti i nm i i x Ti t t t R t J 11)1(λ由0iJt ∂=∂可得()0x i i R I t λ-= 1,...,i m n =+ 即x i i i R t t λ= 1,...,i m n =+表明: λi 是x R 的特征值,而i t 是相应的特征向量。

中科院模式识别第三次(第五节)-作业-答案-更多

第5章:线性判别函数第一部分:计算与证明1. 有四个来自于两个类别的二维空间中的样本,其中第一类的两个样本为(1,4)T 和(2,3)T ,第二类的两个样本为(4,1)T 和(3,2)T 。

这里,上标T 表示向量转置。

假设初始的权向量a=(0,1)T ,且梯度更新步长ηk 固定为1。

试利用批处理感知器算法求解线性判别函数g(y)=a T y 的权向量。

解:首先对样本进行规范化处理。

将第二类样本更改为(4,1)T 和(3,2)T . 然后计算错分样本集:g(y 1) = (0,1)(1,4)T = 4 > 0 (正确) g(y 2) = (0,1)(2,3)T = 3 > 0 (正确) g(y 3) = (0,1)(-4,-1)T = -1 < 0 (错分) g(y 4) = (0,1)(-3,-2)T = -2 < 0 (错分) 所以错分样本集为Y={(-4,-1)T , (-3,-2)T }.接着,对错分样本集求和:(-4,-1)T +(-3,-2)T = (-7,-3)T第一次修正权向量a ,以完成一次梯度下降更新:a=(0,1)T + (-7,-3)T =(-7,-2)T 再次计算错分样本集:g(y 1) = (-7,-2)(1,4)T = -15 < 0 (错分) g(y 2) = (-7,-2)(2,3)T = -20 < 0 (错分) g(y 3) = (-7,-2)(-4,-1)T = 30 > 0 (正确) g(y 4) = (-7,-2)(-3,-2)T = 25 > 0 (正确) 所以错分样本集为Y={(1,4)T , (2,3)T }.接着,对错分样本集求和:(1,4)T +(2,3)T = (3,7)T第二次修正权向量a ,以完成二次梯度下降更新:a=(-7,-2)T + (3,7)T =(-4,5)T 再次计算错分样本集:g(y 1) = (-4,5)(1,4)T = 16 > 0 (正确) g(y 2) = (-4,5)(2,3)T = 7 > 0 (正确) g(y 3) = (-4,5)(-4,-1)T = 11 > 0 (正确) g(y 4) = (-4,5)(-3,-2)T = 2 > 0 (正确)此时,全部样本均被正确分类,算法结束,所得权向量a=(-4,5)T 。

埃姆斯实验报告(3篇)

第1篇一、实验背景埃姆斯实验是由美国心理学家阿尔伯特·埃姆斯(Albert Ellis)于20世纪50年代提出的一种心理治疗方法,旨在帮助人们克服焦虑、抑郁等负面情绪。

埃姆斯实验的核心观点是,人的情绪和行为受到其认知模式的影响,因此通过改变认知模式可以改变情绪和行为。

本实验旨在验证埃姆斯实验的理论,并探讨其在实际生活中的应用。

二、实验目的1. 验证埃姆斯实验的理论,即认知模式对情绪和行为的影响。

2. 探讨埃姆斯实验在生活中的实际应用,为人们提供一种有效应对负面情绪的方法。

三、实验方法1. 实验对象:选取30名志愿者,年龄在18-25岁之间,性别不限。

2. 实验材料:埃姆斯实验手册、问卷、访谈提纲等。

3. 实验步骤:(1)实验前,对志愿者进行问卷调查,了解其认知模式、情绪状态和行为表现。

(2)根据问卷调查结果,将志愿者分为实验组和对照组。

实验组接受埃姆斯实验培训,对照组不接受培训。

(3)实验组接受埃姆斯实验培训,主要包括以下内容:① 认知模式识别:帮助志愿者识别自己的认知模式。

② 认知重构:指导志愿者如何改变不合理的认知模式。

③ 情绪调节:教授志愿者如何调整情绪状态。

④ 行为改变:指导志愿者如何改变不良行为。

(4)培训结束后,对两组志愿者进行问卷调查和访谈,了解其认知模式、情绪状态和行为表现的变化。

四、实验结果与分析1. 实验前,实验组和对照组在认知模式、情绪状态和行为表现方面无显著差异。

2. 培训结束后,实验组在认知模式、情绪状态和行为表现方面均有显著改善,与对照组相比,差异具有统计学意义。

3. 访谈结果显示,实验组志愿者普遍认为埃姆斯实验对他们的生活产生了积极影响,有助于他们更好地应对负面情绪。

五、实验结论1. 埃姆斯实验能够有效改变个体的认知模式,从而改善情绪状态和行为表现。

2. 埃姆斯实验在生活中的实际应用具有广泛的前景,可以为人们提供一种有效应对负面情绪的方法。

六、实验局限性1. 实验样本量较小,可能影响实验结果的普适性。

模式识别-3-贝叶斯决策理论

(

)

确定性特征向量与随机特征向量

确定性特征向量 在获取模式的观测值时,有些事物具有确定的 因果关系,即在一定条件下,存在必然会发生 或必然不发生的确定性,这样获得的特征向量 称为确定性特征向量。 例如识别一块模板是不是直角三角形,只要 凭“三条直线边闭合连线和一个直角”这个 特征,测量它是否有三条直线边的闭合连线 并有一个直角,就完全可以确定它是不是直 角三角形。 这种现象是确定性的现象,比如上一讲的线 性模式判别就是基于这种现象进行的。

x1 x X = 2 ... xn

特征向量

g1(x) g2(x)

...

Max(g(x))

最大值选择器

x ∈ ωi

gn(x)

判别计算

决策

§3-3 正态分布决策理论

一、正态分布判别函数

1、为什么采用正态分布:

a、正态分布在物理上是合理的、广泛的。 b、正态分布数学上简单,N(µ, σ ²) 只有均值和方差两个参数。

)

2

=

∫ (x − µ )

−∞

∞

2

P ( x)

P ( x ) d x,方 差 ) (

1

概率密度函数应满足下 列关系: P ( x ) ≥ 0, ( −∞ < x < ∞ ) ∞ ∫−∞ P ( x )dx = 1

0 . 95

µ − 2σ

µ

X

µ + 2σ

3、(多变量)多维正态分布 (1)函数形式:

µ i = E ( xi ) =

∑

= E

= E = E

(x 1 − ...... (x n − µ

[(x

模式识别的三个步骤

模式识别是人工智能和机器学习领域的一个重要概念,它的主要任务是让计算机能够识别出输入数据的模式,并根据这些模式做出相应的决策或预测。

模式识别的三个主要步骤包括:

1.数据采集和预处理:这是模式识别的第一步,主要是收集原始

数据并进行必要的预处理。

数据可以来自各种传感器、图像、语音、文本等。

预处理包括数据清洗、降维、特征提取等,以便更好地进行后续处理。

这一步的目的是去除数据中的噪声和无关信息,提取出对模式识别有用的特征。

2.特征提取和选择:在数据采集和预处理之后,需要从数据中提

取出能够表征其本质属性的特征。

这些特征可以是一组数值、形状、纹理、颜色等,具体取决于要解决的模式识别问题。

特征提取和选择是模式识别中最关键的一步,因为有效的特征能够大大提高模式识别的准确率。

3.分类器设计和分类决策:在提取出有效的特征之后,需要设计

一个分类器来对不同的模式进行分类。

分类器可以是基于统计的方法、神经网络、支持向量机等。

分类决策是根据分类器的输出对待分类的样本进行决策,例如将某个样本归类到某一类别中。

需要注意的是,以上三个步骤是相互关联、相互影响的。

在实际应用中,可能需要根据具体的问题和数据特点对这三个步骤进行反复的调整和优化,以达到最好的模式识别效果。

实验三图像分析实验——图像分割、形态学及边缘与轮廓分析

实验三图像分析实验——图像分割、形态学及边缘与轮廓分析一、实验条件PC机数字图像处理实验教学软件大量样图二、实验目的1、熟悉图像形态学分析的基本原理,观察不同形态学方法处理的结果;2、熟悉图像阈值分割、区域生长、投影及差影检测和模板匹配的基本原理,观察处理的结果;3、熟悉图像边缘检测、Hough平行线检测、轮廓提取及跟踪和种子填充的基本原理,观察处理的结果;4、了解图像矩、空穴检测、骨架提取的基本原理,观察处理的结果。

三、实验原理本次实验侧重于演示观察,由于内容繁多,并且系统中已有部分实验项目的原理说明,因此实验原理及编程实现步骤这里不再详细叙述,有兴趣的同学可以查阅数字图像处理方面的有关书籍。

四、实验内容1、图像形态学分析内容包括:图像膨胀、图像腐蚀、开运算、闭运算和图像细化针对二值图像进行处理,有文字说明,实验步骤中将详细介绍其使用方法。

2、图像分割内容包括:阈值分割、区域生长、投影检测、差影检测和模板匹配阈值分割:支持灰度图像。

从图库中选择图像分割中的源图, 然后执行图像分析→图像分割→阈值分割, 比较原图和分割后的图, 对照直方图分析阈值分割的特点。

对源图再执行一次图像变换→点运算→阈值变换, 比较分析阈值变换和阈值分割的结果。

区域生长:支持灰度图像。

操作方法与阈值分割类似,比较分析其与阈值分割的不同。

投影检测:只支持二值图像。

从图库中选择投影检测中的源图, 然后执行图像分析→投影检测→水平投影, 然后再垂直投影, 记录下检测部分的水平和垂直方向的位置。

如有必要, 在检测之前, 对图像进行平滑消噪。

差影检测:支持灰度图像。

从图库中选择图像合成中的源图, 然后执行图像分析→图像合成→图像相减, 在弹出的文件对话框中选择图库图像合成中的模板图像,观察分析差影结果。

模板匹配:支持灰度图像。

从图库中选择模板匹配中的源图, 然后执行图像分析→模式识别→模板匹配, 在弹出的文件对话框中选择图库模板匹配中的模板图像, 观察分析结果。

牛肌肉识别实验报告(3篇)

第1篇一、实验目的本次实验旨在通过采集牛肌肉图像,运用图像处理技术进行特征提取和识别,实现对牛肌肉的自动识别。

实验旨在提高牛肌肉识别的准确性和效率,为肉品分级和质量控制提供技术支持。

二、实验原理牛肌肉识别实验主要基于图像处理和模式识别技术。

实验流程如下:1. 图像采集:使用高分辨率摄像头采集牛肌肉图像。

2. 图像预处理:对采集到的图像进行预处理,包括去噪、灰度化、二值化等。

3. 特征提取:从预处理后的图像中提取特征,如纹理、颜色、形状等。

4. 模型训练:利用已标记的牛肌肉图像数据,对识别模型进行训练。

5. 识别测试:使用训练好的模型对未知牛肌肉图像进行识别。

三、实验材料与设备1. 实验材料:牛肌肉样本、高分辨率摄像头、计算机等。

2. 实验设备:图像采集系统、图像处理软件、模式识别软件等。

四、实验步骤1. 图像采集:将牛肌肉样本放置在摄像头前,调整摄像头参数,采集清晰、无遮挡的牛肌肉图像。

2. 图像预处理:a. 去噪:使用中值滤波等方法对图像进行去噪处理。

b. 灰度化:将彩色图像转换为灰度图像,便于后续处理。

c. 二值化:根据阈值将灰度图像转换为二值图像,突出肌肉纹理。

3. 特征提取:a. 纹理特征:采用灰度共生矩阵(GLCM)方法提取纹理特征。

b. 颜色特征:计算图像的RGB颜色直方图,提取颜色特征。

c. 形状特征:使用边缘检测和形态学操作提取肌肉轮廓,计算形状特征。

4. 模型训练:a. 数据集准备:收集大量已标记的牛肌肉图像,用于训练和测试。

b. 特征选择:根据实验需求,选择合适的特征进行模型训练。

c. 模型选择:选择合适的分类器,如支持向量机(SVM)、神经网络等。

d. 训练模型:使用训练集对模型进行训练,优化模型参数。

5. 识别测试:a. 数据集划分:将数据集划分为训练集、验证集和测试集。

b. 模型评估:使用验证集对模型进行评估,调整模型参数。

c. 识别结果:使用测试集对模型进行测试,统计识别准确率。

丁锦红认知心理学第三章 知觉与模式识别

拓扑等价关系(同胚)

模式识别的应用

文本分类 文本图像分析 工业自动化 数据挖掘 多媒体数据库检索 生物特征识别 语音识别 生物信息学 遥感 ……

第四节 结构优先效应

三种现象

词优先效应:识别单词中的字母比识别孤立的 字母的正确率要高。 客体优先效应:识别结构严密三维图形中的线 段要比识别结构松散图形中的同一线段正确率 高。 构型优先效应:识别一个完整的图形比识别该 图的某个部分正确率要高。

后再匹配 特征提取 与分析

基本特征的抽取

例1:汉字有哪些基本特征?

横、竖、撇、捺、折、勾 看看手机上的笔画输入法

例2:人脸有哪些几何上的基本特征?

举例:蝙蝠的类型识别

仅根据基本特征 抽取部分具体特 征

综合各项特 征后与基本 特征匹配

足部特征 匹配 嘴部特征 蝙蝠 体表特征 生殖特征 不匹配 匹配 不匹配

视觉 听觉

S

局部的三种实验条件

1. 局部的一致关系 (1)一致:局部字母与听觉刺激相同。

视觉 听觉

H

1. 局部的一致关系 (2)无关:局部特征与听觉刺激无关。

视觉 听觉

H

局部的三种实验条件

1. 局部的一致关系 (1)冲突:局部字母与听觉刺激冲突。

视觉 听觉

S

实验结果

实验条件——听觉辨别反应时 一致条件:最快 冲突条件:最慢 无关条件:居中 推论:整体知觉先于局部知觉——整体优 先效应。 解释

争论:拓扑知觉理论

关于拓扑学

拓扑学被形象地称为“橡皮薄膜的几何学”。拓扑性质 可以想象成在橡皮薄膜的塑性形变下仍然保持不变的性 质。 比如有一个洞的一块橡皮薄膜,我们可以任意改变它的 形状,只要不把它剪开或者把它的两点粘在一起,这块 橡皮薄膜有一个洞的性质不会改变。因此,“洞”是一 种典型的大范围拓扑性质。而在橡皮薄膜的塑性形变下 ,我们通常熟悉的距离、朝向、大小等性质会改变,它 们都不是拓扑性质而是局部性质。 研究发现蜜蜂能快速地学会分辨拓扑性质,从进化角度 提供了支持拓扑性质初期知觉的重要证据。该理论是对 半个世纪以来占统治地位的特征分析理论的挑战,相关 研究成果发表在Science等刊物上。这是中国心理学家 首次在知觉领域获得国际声誉。

模式识别实验报告_3

模式识别实验报告_3第⼀次实验实验⽬的:1.学习使⽤ENVI2.会⽤MATLAB读⼊遥感数据并进⾏处理实验内容:⼀学习使⽤ENVI1.使⽤ENVI打开遥感图像(任选3个波段合成假彩⾊图像,保存写⼊报告)2.会查看图像的头⽂件(保存或者copy⾄报告)3.会看地物的光谱曲线(保存或者copy⾄报告)4.进⾏数据信息统计(保存或者copy⾄报告)5.设置ROI,对每类地物⾃⼰添加标记数据,并保存为ROI⽂件和图像⽂件(CMap贴到报告中)。

6.使⽤⾃⼰设置的ROI进⾏图像分类(ENVI中的两种有监督分类算法)(分类算法名称和分类结果写⼊报告)⼆MATLAB处理遥感数据(提交代码和结果)7.⽤MATLAB读⼊遥感数据(zy3和DC两个数据)8.⽤MATLAB读⼊遥感图像中ROI中的数据(包括数据和标签)9.把图像数据m*n*L(其中m表⽰⾏数,n表⽰列数,L表⽰波段数),重新排列为N*L的⼆维矩阵(其中N=m*n),其中N表⽰所有的数据点数量m*n。

(提⽰,⽤reshape函数,可以help查看这个函数的⽤法)10.计算每⼀类数据的均值(平均光谱),并把所有类别的平均光谱画出来(plot)(类似下⾯的效果)。

11.画出zy3数据中“农作物类别”的数据点(⾃⼰ROI标记的这个类别的点)在每个波段的直⽅图(matlab函数:nbins=50;hist(Xi,nbins),其中Xi表⽰这类数据在第i波段的数值)。

计算出这个类别数据的协⽅差矩阵,并画出(figure,imagesc(C),colorbar)。

1.打开遥感图像如下:2.查看图像头⽂件过程如下:3.地物的光谱曲线如下:4.数据信息统计如下:(注:由于保存的txt⽂件中的数据信息过长,所以采⽤截图的⽅式只显⽰了出⼀部分数据信息)5.设置ROI,对每类地物⾃⼰添加标记数据,CMap如下:6.使⽤⾃⼰设置的ROI进⾏图像分类(使⽤⽀持向量机算法和最⼩距离算法),⽀持向量机算法分类结果如下:最⼩距离算法分类结果如下:对⽐两种算法的分类结果可以看出⽀持分量机算法分类结果⽐最⼩距离算法分类结果好⼀些。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验三、 SVM 用于模式识别一、实验目的1. 理解SVM 的基本原理;2. 研究SVM 的分类效果;3. 了解混淆均值的应用,熟悉MATLAB 工具箱。

二、实验原理支持向量机在统计学习理论的基础上发展了一种新的机器学习方法。

如果仅从分类的角度来说,它是一种广义的线性分类器,它是在线性分类器的基础上,通过引入结构风险最小化原则、最优化理论和核函数演化而成的。

该方法根据有限的样本信息在模型的复杂性和学习能力之间寻求最佳折中,以期获得最好的推广能力。

而且,只要定义不同的核函数,就可以实现其它现有的学习算法。

因此,支持向量机己经在众多领域取得了成功的应用。

1.最优分类面SVM 方法是从线性可分情况下的最优分类面提出的,图1给出了二维两类线性可分情况的最优分类面示意图。

图中实心点和空心点分别表示两类的样本,H 为分类线,1H 和1H 分别为过各类样本中离分类线最近的点且平行于分类线的直线,它们之间的距离叫做分类空隙或分类间隔(margin)。

所谓最优分类线就是要求分类线不但能将两类正确分开,而且要使分类间隔最大。

前者是保证经验风险最小(为0),分类间隔最大实际上就是使推广性的界中的置信范围最小,从而使真实风险最小。

推广到高维,最优分类线就成为最优分类面。

图1 最优分类面示意图设线性可分样本集(,)i i y X ,1,i =…,n ,d x R ∈,{1,1}y ∈+-是类别标号。

d 维空间中线性判别函数的一般形式为()g b =⋅+x W X ,分类面方程为()0g b =⋅+=x W X (1)为了描述分类面,使用下面的形式将判别函数进行归一化:()1g b =⋅+≥x W X ,若1i y = (2)()1g b =⋅+≤-x W X ,若1i y =- (3)即使两类所有样本都满足()1g ≥x 离分类面最近的样本的()1g =x ,这样分类间隔就等于2w,因此使间隔最大等价于使w (或2w )最小;而要求分类线对所有样本正确分类,就是要求它满足:[]10i y b ⋅+-≥w x ,1,i =…,n (4)因此满足条件式(3一13)且使2w 最小的分类面就是最优分类面。

过两类样本中离分类面最近的点且平行于最优分类面的超平面1H 、2H 上的训练样本就是式(4)中使等号成立的那些样本,称之为支持向量(Support Vectors)。

因为它们支撑了最优分类面,如图3.4中用圆圈标出的点所示。

根据上面的讨论,最优分类面问题可以表示成如下的二次规划问题,即在条件(4)的不等式约束下,求函数:2()0.50.5(,)Φ=⨯=⨯W w w w (5)的最小值。

为此,可以定义如下的Lagrange 函数1(,,)0.5(,){[]1}ni i i i L b y b αα==⨯-⋅+-∑W w w W X (6)其中0i α≥为Lagrange 系数,我们的问题是对w 和b 求Lagrange 函数的极小值。

把式(6)分别对w 和b 求偏微分并令它们等于0,就可以把原问题转化为如下这种较为简单的对偶问题:在约束条件10ni ii yα==∑ (7)0i α≥,1,i =…,n (8)之下对i α求解下列函数的最大值: 若i α*为最优解,则**1ni i i i y α==∑w x (9)由此可见,最优分类面的权函数向量是训练样本向量的线性组合。

这是一个不等式约束下二次函数极值问题,存在唯一解。

且根据Kuhn-Tucker 条件,这个优化问题的解须满足{[]1}0i i i y b α⋅+-=W X ,1,i =…,n (10)因此,对多数样本*i α将为零,取值不为零的*i α对应于式子(4)等号成立的样本即支持向量,它们通常只是全体样本的很少一部分。

求解上述问题后得到的最优分类函数式:****1()sgn{()}sgn{()}ni i i i i f b y b α==⋅+=⋅+∑x w x x x (11)sgn()为符号函数。

由于非支持向量对应的i α均为零,因此式中的求和实际上之对支持向量进行。

而b *是分类的阈值,可以由任意一个支持向量用式(4)求得,或通过两类中任意一对支持向量取中值求得。

三、实验要求编写一个SVM 算法的程序。

按下面方式用下表的数据训练一个SVM 分类器。

对每个样本进行预处理得到新的向量:22121122[1,,,,,]x x x x x x 。

(1) 只用第一个样本训练分类器并给出超平面及间隔。

(2) 用前2个样本(共4个点)重复(1),给出分类超平面方程、间隔及支持向量。

(3) 用前3个样本(共6个点)重复(2)。

然后再用前4个点,……,直到变换后的样本在变换后的空间中不再是线性可分的。

四、评价参数总体精度(Overall Accuracy)指混淆矩阵主对角线上所有元素之和除以参与计算混淆矩阵计算的所有像元个数所得到的百分数。

使用者精度(User ’s Accuracy)指分类后的土地覆盖类别,对应到地面真实参考时,真正为该种类别的像元素的百分比,即依据每一种分类,将对角线元素除以该行的列所有元素相加之和,所产生的百分比数。

生产者精度(Producer ’s Accuracy)(也称制图精度)指属于某一真实地面参考资料类别的检验点,有部分检验点被错误分类,而被正确分类的像元数的百分比,即将混淆矩阵中对一种分类,对角元素除以行中所有元素相加的和,所产生的百分比,本实验采用总体精度进行分析。

五、实验结果及分析初始样本的空间分布图如下:the scatter of initial data图1 初始样本的空间分布由此可见,这两类样本是线性可分的。

但是为了进一步研究支持向量机在高维空间的分类效果,本实验将原始数据映射到高维空间,即把数据先进行预处理。

对每个样本进行预处理得到新的向量:22121122[1,,,,,]x x x x x x 。

当然这样预处理只是为了简单分析SVM 对高维数据的处理状况,并不影响数据的线性可分特性。

下面我们对三种情况进行讨论及研究。

预处理后的样本为:采用这种映射方式,可使本来线性不可分的数据在新的特征空间变为线性可分,当然这数据自身已经线性可分了,在原始的特征空间中本身就线性可分,所以有点多此一举,不过也让我们熟悉广义线性判别函数方式。

表2 第二组样本映射后的结果分类超片面方程为22012345121122[,,,,,][1,,,,,]TY d x x x x x x d =+=⋅+WX w w w w w w (12)因此,以下实验给出权重w 和截距d ,通过(12)式可以获取超片面。

1、实验一,仅采用这两类中的第一个样本作为训练样本,然后求取超片面和间隔。

在此过程,我们采用每类的第一个样本作为训练样本,其余的18个样本作为测试样本,对训练结果进一步验证。

每个特征的权重矢量为w=[0.0000 0.0005 -0.0028 -0.0025 0.0041 0.0312];偏差b=-1.2816;间隔为1.9922*1000;拉格朗日系数为[5.109,5.109]*0.0001; 支持向量为训练样本本身。

2、实验二,采用每类中的前两个样本作为训练样本,然后求取超平面和间隔。

在此过程,我们采用每类的第一个样本作为训练样本,其余的16个样本作为测试样本,对训练结果进一步验证。

每个特征的权重矢量为w=[0.0000 -0.0121 -0.0739 0.0414 0.0534 0.0222];偏差b=-2.2743;间隔为187.5741;拉格朗日系数为[0.0012 0.0042 0.0049 0.0004];支持向量为训练样本本身。

分类的总体精度为100%表5 混淆矩阵3、实验三,采用每类中的前三个样本作为训练样本,然后求取超平面和间隔。

每个特征的权重矢量为w=[0.0000 -0.0121 -0.0739 0.0414 0.0534 0.0222];偏差b=-2.2743;间隔为187.5741;拉格朗日系数为[0.0012 0.0042 0.0049 0.0004];第一类的支持向量为前两个训练样本,第二类的支持向量也是前两个训练样本。

即表2的前两行和表3的前两行样本。

分类的总体精度为100%表6 混淆矩阵4、实验四,采用每类中的前三个样本作为训练样本,然后求取超平面和间隔。

每个特征的权重矢量为w=[0.0000 -0.0121 -0.0739 0.0414 0.0534 0.0222];偏差b=-2.2743;间隔为187.5741;拉格朗日系数为[0.0012 0.0042 0.0049 0.0004];第一类的支持向量仍为前两个训练样本,第二类的支持向量也是前两个训练样本。

即表2的前两行和表3的前两行样本。

分类的总体精度为100%表7 混淆矩阵当采用前五个样本作为训练样本时,实验结果和实验二也一致。

直至到采用前六个样本时,支持向量的数目为3。

测试样本的识别率仍为100%。

六、实验程序clear allclose allclcx1(:,1)=[-3,0.5,2.9,-0.1,-4,-1.3,-3.4,-4.1,-5.1,1.9]';x1(:,2)=[-2.9,8.7,2.1,5.2,2.2,3.7,6.2,3.4,1.6,5.1]';x2(:,1)=[-2,-8.9,-4.2,-8.5,-6.7,-0.5,-5.3,-8.7,-7.1,-8]';x2(:,2)=[-8.4,0.2,-7.7,-3.2,-4,-9.2,-6.7,-6.4,-9.7,-6.3]';sampleji.firstsort(1:2,:)=x1';sampleji.secondsort(1:2,:)=x2';% sampleji=load('E:\ sampleji.mat');% sampleji is a struct that contains two sample datas(firstsort and % secondsort). For example,firstsort is a 2*10 matrixscatter(sampleji.firstsort(1,:)',sampleji.firstsort(2,:)','b');%imshow the initial datahold onscatter(sampleji.secondsort(1,:)',sampleji.secondsort(2,:)','r');hold offtitle('the scatter of initial data')%%%%%%%%%%%%%%%mapmapfirst(:,1)=ones(10,1);mapsecond(:,1)=ones(10,1);%have 10 samples in each classmapfirst(:,2)=sampleji.firstsort(1,:)';mapsecond(:,2)=sampleji.se condsort(1,:)';mapfirst(:,3)=sampleji.firstsort(2,:)';mapsecond(:,3)=sampleji.se condsort(2,:)';mapfirst(:,4)=(sampleji.firstsort(1,:).^2)';mapsecond(:,4)=(sampl eji.secondsort(1,:).^2)';mapfirst(:,5)=(sampleji.firstsort(1,:).*sampleji.firstsort(2,:))' ;mapsecond(:,5)=(sampleji.secondsort(1,:).*sampleji.secondsort(2,: ))';mapfirst(:,6)=(sampleji.firstsort(2,:).^2)';mapsecond(:,6)=(sampl eji.secondsort(2,:).^2)';%%%%%%%%%%%%%the train sample number is NN=2;train_sample=[mapfirst(1:N,:);mapsecond(1:N,:)];[nx,ny]=size(train_sample);y=[ones(nx/2,1);-1*ones(nx/2,1)];my_struct=svmtrain(train_sample,y);%%%%%%%%%the text sampletext_sample=[mapfirst(N+1,:);mapsecond(N+1,:)];class=svmclassify(my_struct,text_sample);%%%%%%%%%%%%5alpha=abs(my_struct.Alpha);% Lagragian multiplier%%%%%%my_Struct.Alpha is that alpha multiply with the label of suppervectorw=diag(alpha)*my_struct.SupportVectors;w=sum(w);% weight vector of optimal hyperplanemargin=2/(w*w');% margin between two classes。