人工神经网络及其应用实例_毕业论文

智能控制技术毕业论文【范本模板】

摘要:本文主要介绍了智能控制技术从经典控制理论、现代控制理论发展到今天的智能控制理论的发展过程和主要方法,并介绍了智能控制在工业发展、机械制造、电力电子学研究领域中的应用.关键字:自动化智能控制应用随着信息技术的发展,许多新方法和技术进入工程化、产品化阶段,这对自动控制技术提出犷新的挑战,促进了智能理论在控制技术中的应用,以解决用传统的方法难以解决的复杂系统的控制问题。

一、智能控制的发展过程从经典控制理论、现代控制理论发展到今天的智能控制理论,经历了很长时间.四十年代到五十年代形成了经典控制理论。

经典控制理论中基于传递函数建立起来的如频率特性、根轨迹等图解解析设计方法,对于单输入—单输出系统极为有效,至今仍在广泛地应用。

但传递函数对处于系统内部的变量不便描述,对某些内部变量还不能描述,且忽略了初始条件的影响。

鼓传递函数描述不能包含系统的所有信息。

现代控制理论主要研究具有高性能、高精度的多变量变参数系统的最优控制问题,它对多变量有很强的描述和综合能力,其局限在于必须预先知道被空对象或过程的数学模型.智能控制是在经典和现代控制理论基础上进一步发展和提高的。

智能控制的提出,一方面是实现大规模复杂系统控制的需要;另一方面是现代计算机技术、人工智能和微电子学等学科的高度发展,给智能控制提供了实现的基础。

智能控制提供了一种新的控制方法,基本解决了非线性、大时滞、变结构、无精确数学模型对象的控制问题。

二、智能控制的主要方法通俗地讲,智能控制就是利用有关知识(方法)来控制对象,按一定要求达到预定目的。

智能控制为解决控制领域的难题,摆脱了经典和现代控制理论的困境,开辟了新的途径.智能控制技术的主要方法有模糊控制、基于知识的专家控制、神经网络控制和集成智能控制等,以及常用优化算法有:遗传算法、蚁群算法、免疫算法等。

1、模糊控制模糊控制以模糊集合、模糊语言变量、模糊推理为其理论基础,以先验知识和专家经验作为控制规则。

神经网络模型的研究毕业论文

神经网络模型的研究毕业论文简介本文旨在研究神经网络模型在机器研究中的应用。

神经网络是一种模仿人类神经系统工作的数学模型,能够研究输入和输出之间的复杂关系,并通过调整模型参数来提高预测准确度。

本文将探讨神经网络的基本原理、常见的网络结构和训练方法。

神经网络的基本原理神经网络由许多神经元组成,每个神经元接收来自其他神经元的输入,并通过激活函数进行处理,最终产生输出。

神经网络通过不断调整神经元之间的连接权重来研究输入和输出之间的关系。

常见的神经网络结构本文将介绍几种常见的神经网络结构,包括前馈神经网络、卷积神经网络和循环神经网络。

前馈神经网络是最基本的神经网络结构,信息只在一个方向传递。

卷积神经网络在图像处理中有广泛应用,能够从原始像素中提取特征。

循环神经网络则可以处理具有时序关系的数据,如文本和语音。

神经网络的训练方法神经网络的训练是通过优化算法来调整网络参数以减小预测误差。

本文将介绍几种常用的优化算法,包括梯度下降法和反向传播算法。

梯度下降法通过计算损失函数的梯度来更新网络参数,以使预测结果与实际输出更接近。

反向传播算法则是一种高效计算梯度的方法。

实验与结果分析本文将设计并实施几个实验来验证神经网络模型的性能。

通过使用公开的数据集和适当的评估指标,我们将对不同网络结构和训练方法进行比较,并对实验结果进行分析和讨论。

结论神经网络模型在机器研究中有着广泛的应用前景。

本文通过对神经网络的基本原理、常见的网络结构和训练方法的介绍,以及实验结果的分析,为研究和应用神经网络模型提供了有效的参考。

以上为《神经网络模型的研究毕业论文》的大纲。

基于神经网络误差补偿的预测控制研究毕业论文

基于神经网络误差补偿的预测控制研究毕业论文目录摘要............................................... 错误!未定义书签。

1 预测控制 (2)1.1 预测控制的产生 (2)1.2 预测控制的发展 (3)1.3 预测控制算法及应用 (4)1.3.1模型控制算法(Model Algorithmic Control,MAC) (5)1.3.2动态矩阵控制(Dynamic Matrix Control,DMC) (5)1.3.3广义预测控制(Generalized Predictive Control,GPC) (5)1.3.4极点配置广义预测控制 (5)1.3.5内模控制 (5)1.3.6模糊预测控制 (6)1.4 预测控制的基本特征 (6)1.4.1预测模型 (6)1.4.2反馈校正 (6)1.4.3滚动优化 (6)1.5预测控制的现状 (7)2 神经网络 (7)2.1 人工神经网络的生理原理 (8)2.2 神经网络的特征 (10)2.3 神经网络的发展历史 (11)2.4 神经网络的内容 (12)2.5 神经网络的优越性 (14)2.6 神经网络研究方向 (14)2.7 神经网络的应用分析 (14)2.8 神经网络使用注意事项 (17)2.9 神经网络的发展趋势 (18)2.10 BP神经网络 (18)2.10.1 BP神经网络模型 (18)2.10.2 BP网络模型的缺陷分析及优化策略 (19)2.10.3 神经网络仿真 (20)3.动态矩阵控制 (22)3.1 预测模型 (22)3.2 滚动优化 (23)3.3 反馈校正 (24)3.4 有约束多变量动态矩阵控制及其线性化 (27)3.5 动态矩阵控制仿真 (29)4 基于神经网络误差补偿的预测控制 (32)4.1 研究背景 (32)4.2 传统PID控制 (33)4.2.1位置式PID控制 (33)4.2.2 增量式PID控制 (35)4.3 基于神经网络的动态矩阵控制 (37)4.4 基于神经网络输出反馈的动态矩阵控制研究 (40)4.5 基于神经网络误差补偿的动态矩阵控制 (46)4.6 仿真效果验证 (51)总结 (57)参考文献 (58)1 预测控制1.1 预测控制的产生预测控制的产生,并不是理论发展的需要,而首先是工业实践向控制提出的挑战。

人工神经网络模型及应用领域分析

人工神经网络模型及应用领域分析人工神经网络(Artificial Neural Network)是一种模拟生物神经网络的智能系统。

它由一系列处理单元,即神经元所组成,能够学习、适应和模拟复杂的非线性关系,具有很强的特征提取与分类能力。

其主要应用于机器学习、人工智能等领域,并在图像识别、预测控制、金融风险分析、医学诊断等方面得到广泛应用。

本文将从人工神经网络模型的原理、种类和应用领域三个方面进行探讨。

一、人工神经网络模型的原理人工神经网络模型由模拟人类神经元构成,其基本结构包括输入层、隐藏层和输出层。

其中输入层接受外部输入信息,隐层是神经网络的核心,通过将输入信息转换为内部状态进行处理,并将处理结果传递给输出层。

输出层将最终结果输出给用户。

举个例子,我们可以将输入层视为人类的五官,隐藏层类比于大脑,而输出层则类比人体的手脚。

人工神经网络各层间的信息传递包括两个过程,即正向传递和反向传递。

正向传递过程是指输入信息从输入层流向输出层的过程,即信息的传递方向是输入层-隐藏层-输出层。

反向传递过程是指通过反向误差传递算法计算并更新神经网络中每个权重的值,从而优化神经网络的过程。

二、人工神经网络的种类人工神经网络主要分为三类,分别是前馈神经网络、递归神经网络和自适应神经网络。

一、前馈神经网络(FNN)前馈神经网络是人工神经网络中最为常见的一类,也是最简单的神经网络类型之一。

其功能类似于单向传导信息的系统,例如生物的视网膜和传感器等。

前馈神经网络只有正向传递过程,而没有反向传递过程。

前馈神经网络常用于分类、识别和预测等领域。

二、递归神经网络(RNN)递归神经网络包括输入层、隐藏层和输出层,但隐藏层的神经元可以连接到之前的神经元,使信息得以传递。

与前馈神经网络不同,递归神经网络可以处理时序性数据、自然语言等。

递归神经网络的应用领域主要是非线性有限时序预测、文本分类、语音识别、图像处理、自然语言处理等。

三、自适应神经网络(ANN)自适应神经网络是一种可以自动调整结构和参数的神经网络,包括自组织神经网络和归纳神经网络。

【毕业论文】基于人工神经网络的人脸识别方法研究

2.1 生物识别技术 .................................................................................................... 7

2.1.1 生物识别的定义 .....................................................................................................7 2.1.2 生物识别技术 ........................................................................................................7

神经网络的实际应用举例

神经网络的实际应用举例神经网络是人工智能领域内的一个重要分支,它模拟了人脑的神经网络系统,能够通过学习实现对未知数据的处理和预测。

由于其优秀的性能,神经网络在多个领域内都得到了广泛的应用。

一、图像识别和分类神经网络在图像识别和分类领域内得到了广泛的应用。

利用卷积神经网络(Convolutional Neural Network, CNN)可以对图像进行预处理,加速操作速度,提高识别准确率。

例如,Facebook就利用CNN对用户上传的图片进行人脸识别和标记,以便进行搜索和分类。

二、自然语言处理自然语言处理(Natural Language Processing, NLP)是人工智能领域中的一个非常热门的分支,神经网络在其中也发挥了重要作用。

例如,利用递归神经网络(Recurrent Neural Network, RNN)可以对文字序列进行自然语言处理,用于自动翻译、自动摘要、情感分析等多个方面。

三、金融风险预测通过神经网络算法,可以对大数据进行处理和分析,实现金融风险预测的任务。

例如,银行可以利用神经网络对信用评估、欺诈检测、贷款拖欠等风险进行监测和预测,以提高风险控制的效率。

四、医学诊断神经网络在医学领域也得到了广泛的应用。

例如,利用深度学习网络可以对医学影像数据进行预处理和分析,对各种疾病进行快速、准确的诊断并提供治疗方案。

此外,神经网络还能够对大规模生物数据进行处理和分析,例如对基因序列进行分类和预测。

五、交通指挥交通指挥也是神经网络的另一个实际应用领域。

通过车辆地理位置信息和道路交通情况的数据,利用深度学习网络实时进行交通状况的预测和调度,能够有效地减少拥堵和减少车辆等待时间。

以上就是神经网络在实际应用方面的一些典型案例。

可以看出,该技术在信息处理、机器学习、医疗等众多领域内都有着广泛的应用前景,所以未来也必将和其他技术共同推动人工智能领域的发展。

人工神经网络的研究与应用

人工神经网络的研究与应用人工神经网络是指一种用于模拟生物神经网络的计算机体系结构。

它通过模拟神经元之间的联结和信息传递,实现学习、识别、控制等智能行为,具有与人类大脑类似的处理能力。

如今,人工神经网络已广泛应用于计算机视觉、图像处理、语音识别、自然语言处理等领域,成为人机交互、智能制造、智慧城市等领域的核心技术之一。

一、人工神经网络的基本原理人工神经网络模型分为感知机、多层感知机、循环神经网络、卷积神经网络等多种类型。

其中,最常用的是多层感知机模型。

多层感知机由输入层、隐藏层和输出层三个部分组成。

输入层接收外部输入信息,隐藏层是神经元的汇集层,通过调整连接权值,将输入信号转变为中间表示,即隐藏状态。

输出层是模型最终的输出结果,常用的激活函数包括sigmoid函数、tanh函数和ReLU函数等。

为了提高人工神经网络的学习和泛化能力,常采用反向传播算法进行模型训练。

反向传播算法即通过计算误差并反向调整权重,来实现模型参数的优化。

此外,还可以采用随机梯度下降、动量方法、自适应学习率等方式进行训练。

二、人工神经网络的应用1. 计算机视觉计算机视觉是人工智能领域的一个研究方向,致力于通过计算机系统模拟人类视觉功能。

人工神经网络作为计算机视觉的重要工具,可以实现图像分类、目标检测、图像分割、语义分割等操作。

例如,在图像分类任务中,可以使用卷积神经网络对图像进行特征提取,并进行分类。

在目标检测任务中,可以使用 Faster R-CNN、YOLO等网络结构。

2. 自然语言处理自然语言处理是指将自然语言转换成机器可处理的形式,以实现机器自动理解、生成和翻译自然语言的能力。

人工神经网络在自然语言处理中应用广泛,例如文本分类、情感分析、机器翻译等任务。

其中,循环神经网络尤其适用于处理序列数据,如文本和语音等。

3. 人机交互人机交互是指通过人机接口实现人机信息交流和操作控制的过程。

人工神经网络可以用于构建自然语言对话系统、面部表情识别、手势识别等交互系统。

计算机人工智能应用论文5000字计算机人工智能应用毕业论文范文模板

计算机人工智能应用论文5000字计算机人工智能应用毕业论文范文模板导读:在计算机人工智能应用论文5000字撰写的过程当中,想必大家应该都知道不是那么容易的吧,而学习写好一篇优秀的论文也是大家将在生活当中使用的一项必备技能之一。

本论文分类为智能计算机论文,下面是小编为大家整理的几篇计算机人工智能应用论文5000字范文供大家参考。

计算机人工智能应用论文5000字(一):浅谈计算机人工智能应用及发展论文摘要:半个多世纪以来,人工智能领域的研究取得了很大的进展,它越来越受到多学科、不同专业背景的学者的关注,己成为一个广泛的交叉前沿学科。

人工智能己在世界范围内迅速传播和发展。

随着社会的进步和科学技术的发展,人工智能促进了其他学科的发展。

关键词:人工智能;计算机;机器学习;电力负荷预测1人工智能的概念人工智能在现代计算机科学中的占比十分大。

1956年,计算机专家约翰•麦卡锡提出“人工智能” 一词。

如今,它己被公认为世界三大最先进的技术之一。

尼尔森教授任职于斯坦福大学的人工智能研究中心,他将人工智能定义为“知识的主体,如何表达,如何获得和使用”。

美国另一位著名大学教授温斯顿(WinStOn)提出,“人工智能是关于研究如何使计算机完成以前只有人类才能做到的事情。

〃此外,关于人工智能的定义很多,至今尚未统一,但是这些表述反映了人工智能主体的基本思想和内容。

因此,人工智能可以扩展为研究人类活动的规律,并建立具有某些智能行为的人工智能系统。

2计算机人工智能的研究现状2.1问题求解问题解决是指在管理活动中,解决预期效果和预期效果产生时两者之间发生的差异。

在国际象棋中,人工智能可以解决出现的各种问题,是人工智能发展的重大突破。

推理在象棋程序中被广泛应用,例如搜索几个步骤并将问题分解为简单的子问题,已逐渐发展成为人工智能的基本技术,例如研究和归约。

搜索策略可以分为没有信息指导的盲目搜索策略和由经验知识指导的启发式搜索策略,它在解决问题的推理步骤中优先使用知识。

基于BP神经网络的车型识别毕业设计论文

基于BP神经网络的车型识别-毕业设计论文基于BP神经网络的车型识别摘要车型分类识别技术作为智能交通系统中的关键技术,对提高道路运输效率,改善车辆收费检测等方面有着重要的理论与现实意义。

本文基于视频检测技术,首先通过图像预处理、车辆分割、轮廓提取得到车辆的轮廓图,从中获得车辆的外形几何参数,并做相关性分析,提取特征向量。

然后利用提取的特征向量,构建BP神经网络的车型分类系统进行车型识别。

主要研究内容包括:(1)车辆检测研究。

本文采用一种基于背景差分的车辆分割方法,较好地解决了复杂交通情况下车辆的检测问题。

(2)车型特征提取。

根据车型分类的需要,分析了车型特征参数的选择问题,为车辆分类奠定了基础。

本文最终选取了顶长比、顶高比、前后比作为特征向量。

(3)车型分类研究。

研究了基于BP 神经网络的车型分类,通过选择合适的特征参数,获得了较高的分类正确率。

应用效果与仿真结果表明,基于BP网络的车型分类技术的实时性、精确性和分类识别性能等关键指标得到明显的改善,达到系统设计的预期要求。

同时,我们采取的方法具有提取的特征简单、量少,并且所构成的具有分类功能的BP网络简单、便于硬件实现、有利于BP网络的分类识别等优点。

关键词:智能交通系统;车型识别;车辆检测;特征提取;BP神经网络Vehicle Recognition Based on BP Neural NetworkAbstractAs the key technology of Intelligent Transportation System(ITS),vehicle recognition has all important theoretical and practical significance in improving the efficiency of road transportation and testing of vehicle charging.Firstly, the paper based on video detection discusses how to get the vehicle contour map through these operations such as image pre-processing, vehicle segmentation and contour extraction to derive geometrical parameters of vehicles which are used to establish the vector by a correlation analysis.Secondly, we use these feature vectors to build the system of vehicle classification based on BP Neural Network to recognize the vehicles.The main tasks are as follows: (1) Vehicle detection.This paper presents the vehicle segmentation method based on background subtraction.It can solve the problem of vehicle detection in complex traffic situations effectively. (2) Feature extraction.According to the needs of vehicle classification,we analyze the selective problems of the parameters to laid the foundation of vehicle classification.This paper finally adopts the vectors of the ratio of top and length, top and height, forward and back.(3) Vehicle classification.This paper studies vehicle classification based on BP neural network and obtains higher classification accuracy by selecting the appropriate parameters.The result of application and simulation indicates that the real-time quality, accuracy and other performances improved and the vehicle classification system achieves prospective objectives.At the same time, our approach has following advantages : The extracted features are simple, the account is small , and the BP network posed by the classification function is simple and easy to implement hardware, which will help classification and recognition.Keywords : ITS ; Vehicle Recognition ; Vehicle Detection ; Feature Extraction; BP Neural Network目录第1章绪论 (1)1.1 课题研究的背景和意义 (1)1.2 国内外车型识别技术的研究现状 (2)1.3 论文的主要内容 (3)第2章车辆目标检测 (4)2.1 基于视频图像的车型识别系统简介 (4)2.2 视频图像序列采集 (4)2.3 车辆目标检测的常用方法 (5)图像预处理 (5)背景差分 (6)阈值分割 (9)形态学处理 (11)连通区域标记及区域填充 (14)第3章车辆目标的特征提取 (17)3.1 目标特征的提取及描述 (17)3.2 基于轮廓特征的边缘检测 (17)3.3 基于轮廓特征的选择与提取 (20)车型特征值的选择 (21)车型特征值的提取 (22)第4章BP网络的设计与车型识别 (25)4.1 BP神经网络简介 (25)多层前馈神经网络 (27)BP网络学习规则 (29)4.2 BP网络在本实验中的设计与应用 (31)网络的设计 (31)车型识别结果 (34)第5章总结与展望 (39)5.1 本文工作及成果总结 (39)5.2 未来工作展望 (40)致谢 (40)参考文献 (41)第1章绪论1.1 课题研究的背景和意义近年来,随着社会经济和综合国力的不断增强,人们对交通运输的各种需求明显增长,交通运输与社会经济生活的联系也越来越紧密,大大地缩短了人们通行和货物运输的时间,加快了工作进程。

人工神经网络及其在模式识别中的应用

人工神经网络及其在模式识别中的应用人工神经网络是一种基于生物神经网络结构构建的人工智能模型。

它模拟了人脑神经元之间的连接方式和信号传递机制,通过学习和优化,能够对复杂的非线性问题进行建模和解决。

在现代模式识别领域,人工神经网络被广泛应用于图像识别、语音识别、人脸识别等方面,取得了很多重要的成果。

人工神经网络的基本结构由神经元、连接权值和激活函数组成。

每个神经元接收来自其它神经元的输入,并根据输入和对应的权值进行加权求和,然后通过激活函数进行非线性转换,最终输出到下一层的神经元。

通过多个神经元之间的连接,形成了一个复杂的网络结构,能够实现复杂的模式识别和学习任务。

在模式识别中,人工神经网络的应用非常广泛。

例如,图像识别是人工神经网络在计算机视觉领域的重要应用之一。

通过训练神经网络,使其学会从图像中提取特征,并根据这些特征对图像进行分类和识别。

在图像识别领域,人工神经网络已经取得了许多令人瞩目的成果,如人脸识别、目标检测等。

另一个重要的应用是语音识别。

人工神经网络可以学习到语音信号的特征,并根据这些特征将语音信号转化为文本或命令。

这在智能助理、语音控制等领域具有广泛的应用前景。

人工神经网络在语音识别方面的能力不断提升,已经可以实现高准确率的语音识别,并有望在未来进一步改善。

此外,人工神经网络还可以应用于人脸识别。

人脸识别是一种通过计算机系统对人脸图像进行识别和比对的技术。

人工神经网络通过学习人脸图像的特征,能够进行人脸识别并对不同的人脸进行分类。

在安全领域和社交媒体等方面,人脸识别技术已经得到了广泛应用。

除此以外,人工神经网络还可以应用于模式匹配、预测分析等领域。

通过构建合适的神经网络模型,可以对复杂的数据模式进行匹配和预测,有助于解决实际问题。

例如,在金融领域,人工神经网络可以通过对历史数据的学习,预测股票价格的走势或者判断市场趋势,有较高的准确率和应用价值。

尽管人工神经网络在模式识别中的应用取得了很多成果,但仍然存在一些挑战和问题。

基于神经网络的温度控制系统

本科毕业设计(论文)基于神经网络的温度控制系统学院自动化专业自动化年级班别学号学生姓名指导老师2013 年 6 月摘要在工业控制过程中.PID控制是一种最基本的控制方式,其鲁棒性好、结构简单、易于实现,但随着生产工艺的日益复杂和人们对工业过程总体性能要求的不断提高,传统的PID控制方法往往难以满足闭环优化控制的要求。

因为常规PID控制器的参数是根据被控对象数学模型确定的.当被控对象的数学模型是变化的、非线性的时候,PID参数不易根据其实际的情况做出调整,影响了控制质量,使控制系统的控制品质下降。

特别是在具有纯滞后特性的工业过程中,常规的PID控制更难满足控制精度的要求。

而神经网络作为现代信息处理技术的一种,正在很多应用中显示了它的优越性,同传统的PID控制相比较,神经网络PID控制有许多优点。

神经网络PID控制技术在其中扮演了十分重要的角色,并且仍将成为未来研究与应用的重点技术之一。

本文阐述了神经网络PID控制算法的基本原理。

对基于单神经元的PID控制器的控制性能进行了分析,并且利用MATLAB/Simulink工具进行了仿真研究。

温度控制系统具有大滞后、强耦合、慢时变及非线性等特征的复杂系统。

在温度控制系统中,被控制对象存在着参数的不确定性和纯滞后等特性,难于建立其精确的数学模型,本文通过对受控对象温度控制系统的数字仿真研究,比较了传统PID控制与神经网络PID控制各自不同的控制特性,分析了传统PID控制器和神经网络PID控制器的优缺点。

并针对神经网络PID控制器的不足之处提出了相应的改进方案。

关键词:神经网络PID控制,数字仿真,Hebb算法,BP算法注:本设计(论文)题目来源于教师的国家级(或部级、省级、厅级、市级、校级、企业)科研项目,项目编号为:。

AbstractIn the process of industrial control. PID control is one of the most basic way of control, its good robustness, simple structure, easy to implement, but along with the increasing complexity of production process and constantly improve the overall performance requirements of industrial process, the traditional PID control method is often difficult to meet the requirements of the closed-loop optimal control. For conventional PID controller parameters are determined based on the mathematical model of the object. When the mathematical model of controlled object is variable, nonlinear, not easily according to the actual situation to adjust the PID parameters, the influence of quality control, the control quality of control system. Especially in the industrial process with pure lag properties, conventional PID control is more difficult to meet the requirements of control accuracy. And neural network as a kind of modern information processing technology, is a lot of applications shows its superiority, compared with the traditional PID control, the neural network PID control has many advantages. Neural network PID control technology played a very important role, and will continue to be one of the research and application of key technologies in the future.This paper expounds the basic principles of neural network PID control algorithm. Based on single neuron PID controller the control performance is analyzed, and the use of MATLAB/Simul ink tool has carried on the simulation research.Temperature control system with large lagging, strong coupling, time-varying and nonlinear characteristics of complex systems. In temperature control system, the controlled object parameter uncertainties exist and pure lag and so on characteristics, is difficult to establish accurate mathematical model, this paper research on the digital simulation of the temperature control system of controlled object, compares the traditional PID control and neural network PID control their different control features, analyzes the advantages and disadvantages of traditional PID controller and neural network PID controller. And in view of the deficiency of neural network PID controller is put forward the corresponding improvement plan.Key words:Neural PID Control,Digital simulation,Hebb Arithmetic,BP Arithmetic目录1 绪论 (1)1.1神经网络PID控制研究背景与动机 (1)1.2智能控制的发展概况 (2)1.3神经网络简介 (5)1.3.1 神经网络发展概述 (5)1.3.2 神经网络原理 (7)1.3.3 神经网络的分类 (12)1.3.4 神经网络的学习算法 (13)1.3.5 神经网络用于控制领域 (14)1.3.6 神经网络PID控制研究的意义和现状 (15)1.4 本文的主要内容 (17)2 神经网络PID控制器的实现 (18)2.1 基于神经网络的PID控制理论 (18)2.2 基于单神经元的PID控制 (19)2.2.1基于单神经元的PID控制器 (19)2.2.2单神经元PID控制器的稳定性分析 (23)3 基于Simulink的仿真研究 (24)3.1温度控制箱的数学建模 (24)3.2 传统PID控制器的设计与仿真 (26)3.2.1 PID控制算法 (26)3.2.2 数字PID控制器 (28)3.2.3常规PID控制器的局限性 (29)3.2.4温控箱基本PID控制器的数字设计与仿真 (29)3.3单神经元PID控制器的设计与仿真 (33)3.3.1单神经元PID控制系统的建立 (33)3.3.2单神经元PID控制系统的数字仿真 (34)4 结论与展望 (37)4.1工作总结 (37)4.2展望 (37)参考文献 (39)致谢 (41)1 绪论1.1神经网络PID控制研究背景与动机PID控制即比例、积分、微分控制。

BP人工神经网络的基本原理模型与实例

w14

0.2+(0.9) (-0.0087)(1)=0.192

w15

-0.3+(0.9) (-0.0065)(1)=-0.306

w24

0.4+(0.9) (-0.0087)(0)=0.4

w25

0.1+(0.9) (-0.0065)(0)=0.1

w34

-0.5+(0.9) (-0.0087)(1)=-0.508

8.1人工神经网络旳基本概念

人工神经网络在本质上是由许多小旳非线性函数构成 旳大旳非线性函数,反应旳是输入变量到输出变量间旳复 杂映射关系。先给出单个人工神经网络旳一般模型描述:

8.1人工神经网络旳基本概念

先来看一种单一输入旳神经元模型 输入变量:x1 连接权重:w1 激活函数:f (·)

x1 w1

w1x1 f (·)

8.1人工神经网络旳基本概念

8.1人工神经网络旳基本概念

单极sigmoid函数

8.1人工神经网络旳基本概念

双曲函数

8.1人工神经网络旳基本概念

增长激活阈值后旳神经元模型 输入变量:x1 连接权重:w1 激活函数:f (·)

x1 w1

w1x1-θ f (·)

-1

小练习:请你算一算,当初始输入、权重和激活阈值为如下数值时,该神 经元旳净输入和输出分别是多少?

2.反向传播 反向传播时,把误差信号按原来正向传播旳通路反向

传回,并对每个隐层旳各个神经元旳权系数进行修改,以 望误差信号趋向最小。

8.2 误差反向传播(BP)神经网 络

8.2 误差反向传播(BP)神经网 络

x1 x2

x3

单元 j 6

1 w14

Err4=

人工神经网络论文

人工神经网络学号:7学生所在学院:信息工程学院学生姓名:李建建任课教师:聂文滨教师所在学院:信息工程学院2009年12月目录第一部分:绪论31.1人工神经网络的定义31.2人工神经网络的基本原理31.3生物神经元31.4人工神经元模型41.5人工神经网络模型51.6.常见神经元响应函数71.7.神经网络基本学习算法81.7.1有教师学习(监督学习)81.7.2无教师学习(无监督学习)81.7.3强化学习(再励学习)8第二部分:反向传播网络92.1 BP网络92.1.1BP网络主要应用:92.1.2BP网络特点92.1.3多层BP网络简介102.2三层BP网络102.2.1三层BP网络结构图102.2.2三层BP网络学习算法112.2.3三层BP网络设计需要考虑的问题11 第三部分:自适应竞争神经网络123.1自组织网络123.1.1网络类型123.1.2网络学习规则133.2竞争网络133.2.1网络结构133.2.2竞争网络原理143.2.3网络工作方式143.2.4 网络训练153.2.5竞争网络的局限性15第四部分:地震预报的MATLAB实现154.1基于人工神经网络的地震预测研究背景154.2模型的建立164.3自适应竞争网络对地震等级进行预测164.3.1数据处理164.3.2自适应竞争网络设计174.4BP网络对地震的大小进行预测184.4.1数据处理184.4.2BP网络的设计19第五部分:作业21第一部分:绪论1.1人工神经网络的定义人工神经网络的定义不是统一的,T.Koholen对人工神经网络的定义:“人工神经网络是由具有适应性的简单单元组成的广泛并行互连的网络,它的组织能够模拟生物神经系统对真实世界物体所作出的交互反应。

”1.2人工神经网络的基本原理人工神经网络(articles neural network,ANN)结构和工作机理基本上以人脑的组织结构(大脑神经元网络)和活动规律为背景的,它反映了人脑的某些基本特征,但并不是要对人脑部分的真实再现,可以说它是某种抽象、简化或模仿。

基于神经网络的手写数字识别系统的设计与实现毕业论文

中南大学本科生毕业论文(设计)题目基于神经网络的手写数字识别系统的设计与实现目录摘要 (Ⅰ)ABSTRACT (Ⅱ)第一章绪论 (1)1.1手写体数字识别研究的发展及研究现状 (1)1.2神经网络在手写体数字识别中的应用 (2)1.3 论文结构简介 (3)第二章手写体数字识别 (4)2.1手写体数字识别的一般方法及难点 (4)2.2 图像预处理概述 (5)2.3 图像预处理的处理步骤 (5)图像的平滑去噪 (5)二值话处理 (6)归一化 (7)细化 (8)2.4 小结 (9)第三章特征提取 (10)3.1 特征提取的概述 (10)3.2 统计特征 (10)3.3 结构特征 (11)结构特征提取 (11)笔划特征的提取 (11)数字的特征向量说明 (12)3.3 知识库的建立 (12)第四章神经网络在数字识别中的应用 (14)4.1 神经网络简介及其工作原理 (14)神经网络概述[14] (14)神经网络的工作原理 (14)4.2神经网络的学习与训练[15] (15)4.3 BP神经网络 (16)算法 (16)网络的一般学习算法 (16)网络的设计 (18)4.4 BP学习算法的局限性与对策 (20)4.5 对BP算法的改进 (21)第五章系统的实现与结果分析 (23)5.1 软件开发平台 (23)简介 (23)的特点 (23)使用MATLAB的优势 (23)5.2 系统设计思路 (24)5.3 系统流程图 (24)5.4 MATLAB程序设计 (24)5.5 实验数据及结果分析 (26)结论 (27)参考文献 (28)致谢 (30)附录 (31)摘要手写体数字识别是模式识别中一个非常重要和活跃的研究领域,数字识别也不是一项孤立的技术,它所涉及的问题是模式识别的其他领域都无法回避的;应用上,作为一种信息处理手段,字符识别有广阔的应用背景和巨大的市场需求。

因此,对数字识别的研究具有理论和应用的双重意义。

人工神经网络应用实例分析

1.2 输入/输出变量的确定及其数据的预处理 ➢ 一般地,BP网络的输入变量即为待分析系统的内生 变量(影响因子或自变量)数,一般根据专业知识确定。 ➢若输入变量较多,一般可通过主成份分析方法压减输 入变量,也可根据剔除某一变量引起的系统误差与原系 统误差的比值的大小来压减输入变量。 ➢输出变量即为系统待分析的外生变量(系统性能指标 或因变量),可以是一个,也可以是多个。一般将一个 具有多个输出的网络模型转化为多个具有一个输出的网 络模型效果会更好,训练也更方便。

1.3 数据的预处理

✓要对输入数据进行预处理。 如果出层节点也采用

Sigmoid转换函数,输出变量也必须作相应的预处理, 否则,输出变量也可以不做预处理。

✓ 预处理的方法有多种多样,各文献采用的公式也不

尽相同。但必须注意的是,预处理的数据训练完成后, 网络输出的结果要进行反变换才能得到实际值。

✓再者,为保证建立的模型具有一定的外推能力,最

由于BP网络采用误差反传算法,其实质是一个无 约束的非线性最优化计算过程,在网络结构较大时不 仅计算时间长,而且很容易限入局部极小点而得不到 最优结果。目前虽已有改进BP法、遗传算法(GA) 和模拟退火算法等多种优化方法用于BP网络的训练(这 些方法从原理上讲可通过调整某些参数求得全局极小 点),但在应用中,这些参数的调整往往因问题不同而 异,较难求得全局极小点。这些方法中应用最广的是 增加了冲量(动量)项的改进BP算法。

增加冲量项的目的是为了避免网络训练陷于较浅的 局部极小点。理论上其值大小应与权值修正量的大小有 关,但实际应用中一般取常量。通常在0~1之间,而且 一般比学习率要大。

1.样本数据

1.1 收集和整理分组

采用BP神经网络方法建模的首要和前提条件是有 足够多典型性好和精度高的样本。 为监控训练(学习)过程使之不发生“过拟合”和 评价建立的网络模型的性能和泛化能力,必须将收集 到的数据随机分成训练样本、检验样本(10%以上) 和测试样本(10%以上)3部分。 数据分组时还应尽可能考虑样本模式间的平衡。

人工神经网络应用实例

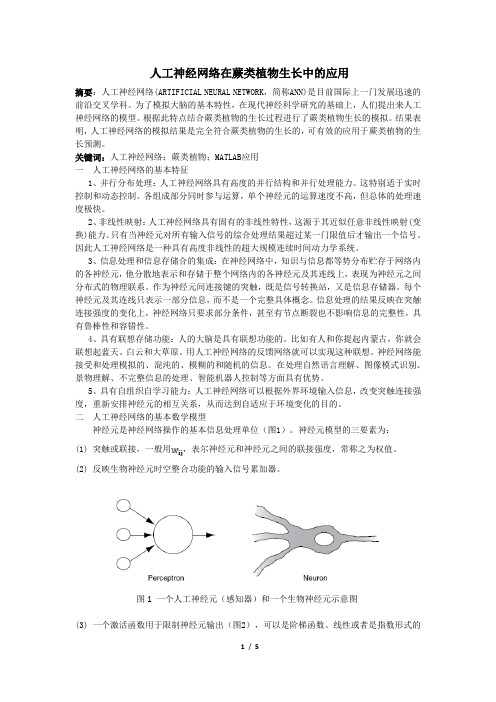

人工神经网络在蕨类植物生长中的应用摘要:人工神经网络(ARTIFICIAL NEURAL NETWORK,简称ANN)是目前国际上一门发展迅速的前沿交叉学科。

为了模拟大脑的基本特性,在现代神经科学研究的基础上,人们提出来人工神经网络的模型。

根据此特点结合蕨类植物的生长过程进行了蕨类植物生长的模拟。

结果表明,人工神经网络的模拟结果是完全符合蕨类植物的生长的,可有效的应用于蕨类植物的生长预测。

关键词:人工神经网络;蕨类植物;MATLAB应用一人工神经网络的基本特征1、并行分布处理:人工神经网络具有高度的并行结构和并行处理能力。

这特别适于实时控制和动态控制。

各组成部分同时参与运算,单个神经元的运算速度不高,但总体的处理速度极快。

2、非线性映射:人工神经网络具有固有的非线性特性,这源于其近似任意非线性映射(变换)能力。

只有当神经元对所有输入信号的综合处理结果超过某一门限值后才输出一个信号。

因此人工神经网络是一种具有高度非线性的超大规模连续时间动力学系统。

3、信息处理和信息存储合的集成:在神经网络中,知识与信息都等势分布贮存于网络内的各神经元,他分散地表示和存储于整个网络内的各神经元及其连线上,表现为神经元之间分布式的物理联系。

作为神经元间连接键的突触,既是信号转换站,又是信息存储器。

每个神经元及其连线只表示一部分信息,而不是一个完整具体概念。

信息处理的结果反映在突触连接强度的变化上,神经网络只要求部分条件,甚至有节点断裂也不影响信息的完整性,具有鲁棒性和容错性。

4、具有联想存储功能:人的大脑是具有联想功能的。

比如有人和你提起内蒙古,你就会联想起蓝天、白云和大草原。

用人工神经网络的反馈网络就可以实现这种联想。

神经网络能接受和处理模拟的、混沌的、模糊的和随机的信息。

在处理自然语言理解、图像模式识别、景物理解、不完整信息的处理、智能机器人控制等方面具有优势。

5、具有自组织自学习能力:人工神经网络可以根据外界环境输入信息,改变突触连接强度,重新安排神经元的相互关系,从而达到自适应于环境变化的目的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

人工神经网络及其应用实例人工神经网络是在现代神经科学研究成果基础上提出的一种抽象数学模型,它以某种简化、抽象和模拟的方式,反映了大脑功能的若干基本特征,但并非其逼真的描写。

人工神经网络可概括定义为:由大量简单元件广泛互连而成的复杂网络系统。

所谓简单元件,即人工神经元,是指它可用电子元件、光学元件等模拟,仅起简单的输入输出变换y = σ (x)的作用。

下图是 3 中常用的元件类型:线性元件:y = 0.3x,可用线性代数法分析,但是功能有限,现在已不太常用。

21.510.5-0.5-1-1.5-2-6 -4 -2 0 2 4 6 连续型非线性元件:y = tanh(x),便于解析性计算及器件模拟,是当前研究的主要元件之一。

离散型非线性元件: y = ⎨2 1.5 1 0.5 0 -0.5 -1 -1.5 -2 -6-4-2246⎧1, x ≥ 0 ⎩-1, x < 0,便于理论分析及阈值逻辑器件 实现,也是当前研究的主要元件之一。

2 1.5 1 0.5 0 -0.5 -1 -1.5 -2 -6-4-2246每一神经元有许多输入、输出键,各神经元之间以连接键(又称突触)相连,它决定神经元之间的连接强度(突触强度)和性质(兴奋或抑制),即决定神经元间相互作用的强弱和正负,共有三种类型:兴奋型连接、抑制型连接、无连接。

这样,N个神经元(一般N很大)构成一个相互影响的复杂网络系统,通过调整网络参数,可使人工神经网络具有所需要的特定功能,即学习、训练或自组织过程。

一个简单的人工神经网络结构图如下所示:上图中,左侧为输入层(输入层的神经元个数由输入的维度决定),右侧为输出层(输出层的神经元个数由输出的维度决定),输入层与输出层之间即为隐层。

输入层节点上的神经元接收外部环境的输入模式,并由它传递给相连隐层上的各个神经元。

隐层是神经元网络的内部处理层,这些神经元在网络内部构成中间层,不直接与外部输入、输出打交道。

人工神经网络所具有的模式变换能力主要体现在隐层的神经元上。

输出层用于产生神经网络的输出模式。

多层神经网络结构中有代表性的有前向网络(BP网络)模型、多层侧抑制神经网络模型和带有反馈的多层神经网络模型等。

本文主要探讨前向网络模型。

多层前向神经网络不具有侧抑制和反馈的连接方式,即不具有本层之间或指向前一层的连接弧,只有指向下一层的连接弧。

代表是BP 神经网络:输入模式由输入层进入网络,经中间各隐层的顺序变换,最后由输出层产生一个输出模式,如下图所示:输入层隐层输出层多层前向神经网络由隐层神经元的非线性处理衍生它的能力,这个任务的关键在于将神经元的加权输入非线性转换成一个输出的非线性激励函数。

下图给出了一个接收 n 个输入 x 1, x 2 , , x n 的神经元:bx 1x 2yx ny = σ (∑ w j j + b )神经元的输出由下式给出:nx j =1这里输入的加权和(括号内部分)由一个非线性函数传递, b 表示与偏差输入相关的权值, w j 表示与第 j 个输入相关的权值。

使用最广泛的函数是 S 形函数,其曲线家族包括对数函数和双曲正切函数,这些都可用来对人口动态系统、经济学系统等建模。

另外所用的其他函数有高斯函数、正弦函数、反正切函数,在此不一一展开介绍,本文主要使用的激励函数是对数函数,函数表达式为:y = L (u ) =函数曲线如下图所示:10.80.60.40.21 1 + e -u-0.2 -10-8-6-4-2246810对于有限输入量,对数函数输出范围为 y ∈ (0,1)。

在输入为 u = 0 时,输出值为中间值 y = 0.5。

输出在 u = 0 附近随着输入的增加以相对快的= t -1 + e∂ε ∂u e -u∂ε ∂u e -u∆w = -β ⋅ = β ⋅ E ⋅ ⋅ x∆b = -β ⋅ = β ⋅ E ⋅速率增加并非常慢地到达上限。

对于 u < 0 ,输出起初减少得很快,然后随着下限的接近将会变慢。

训练神经元的规则有很多种,这里首先介绍利用 delta 规则的学习,神经元选择为一个单输入单输出的简单情形,数学描述如下:u = wx + b , y =1 1 + e -u该神经元具有一个输入 x ,权重为 w ,偏差输入为 b ,目标输出为 t ,预报输出为 y 。

则预报误差为:E = t - y = t -1 11 + e -u 1 + e - wx -b为消除当误差在整个输入模式上求和时引起的误差符号问题,在delta 规则里使用的误差指示是平方误差,定义为:1 12 21- wx -b)2根据 delta 规则,最优权值(使平方误差最小)可以在训练过程中从初始权值出发,沿负梯度方向下降得到。

将平方误差对 w , b (神经元的可调整参数)进行微分,得:∂ε ∂u= -E ⋅ e -u -u 2∂ε ∂w ∂ε ∂b = ⋅ = - E ⋅ ⋅ x ∂u ∂w (1 + e -u )2 = ⋅ = - E ⋅∂u ∂b (1 + e -u )2根据 delta 原则,权值改变应与误差梯度的负值成比例,引入学习率 β ,每次迭代中的权值改变可表示为:∂ε e -u∂w (1 + e -u )2 ∂ε∂b e -u (1 + e -u )2wij ji+ β ⋅ E ⋅= w学习率 β 决定了沿梯度方向的移动速度,以确定新的权值。

大的β 值会加快权值的改变,小的 β 值则减缓了权值的改变。

第 i 次迭代后的新权值可表示为:w i +1 = w i + β ⋅ E ⋅e -u (1 + e -u )2 ⋅ xb i +1 = b i + β ⋅ E ⋅e -u(1 + e -u )2如果将偏差输入 b 视为输入 x 的一部分,令 x 0 = 1, w 0 = b ,可以得到对于多输入神经元的权值修正式:+1e -u(1 + e -u )2⋅ x j , j = 0,1, 2, , n总之,利用 delta 规则的有监督的学习可以按如下方法来实现:一个输入模式( x 0 , x 1, x 2 , , x n )通过连接被传递,它的初始权值被设置为任意值。

对加权的输入求和,产生输出 y ,然后 y 与给定的目标输出 t 做比较决定此模式的平方误差 ε 。

输入和目标输出不断地被提出,在每一次迭代或每一个训练时间后利用 delta 规则进行权值调整直到得到可能的最小平方误差。

delta 规则在每一步中通过导数寻找在误差平面中某个特定点局部区域的斜率,它总是应用这个斜率从而试图减小局部误差,因此,delta 规则不能区分误差空间中的全局最小点和局部最小点,它本身不能克服单层神经网络的局限,无法直接应用到多层神经网络(易陷入局部最小点),但它的一般形式是多层神经网络中的学习算法——反传算法的核心。

在多层前向神经网络的训练过程中,误差导数或关于权值的误差, u i = ∑ a ji j , i = 1, 2, z = v , v = ∑ b i i y表面的斜率对权值的调整是至关重要的,在网络训练期间,所有的输出神经元和隐含神经元权值必须同时调整,因此,有必要找出关于所有权值的误差导数。

由于网络层数增多,平方误差 ε 与权值的连接没有之前单个神经元时那么直接,故可以使用链式规则的概念来找到导数。

下面对一个含有一层隐含神经元的 BP 网络进行讨论,网络结构如下图所示:x xxx 各个神经元的输入输出关系为:y i =11 + e -u in j =0x, m mi =0设目标输出为 t ,则平方误差 ε 定义为:= ⋅ y i , i = 0,1, 2, = ⋅ b i , i = 1, 2, ∂ε∂ε∂∂ε∂ε ∂u i ∂ε∂u i ∂a ji ∂u i= -(t - z ) ⋅ b i ⋅ ⋅ x j , i = 1, 2,1 2使用链式法则,分别列出平方误差 ε 对所有网络参数的导数:∂ε ∂v= -(t - z )∂ε∂b i ∂ε∂v, m∂ε∂y i∂ε∂v, m= ⋅ = ⋅∂u i ∂y i ∂u i ∂y i (1+ e -u i )2 , i = 1, 2,, m∂ε ∂a ji= ⋅ = ⋅ x j , i = 1, 2, , m , j = 0,1, 2,, n在实际的编程过程中,我们需要的是 ∂ε∂b i和∂ε ∂a ji,所以如果有需要,也可以直接采用以下整理之后的形式:∂ε∂b i= -(t - z ) ⋅ y i , i = 0,1, 2, , m∂ε ∂a jie -u i(1 + e -u i )2, m , j = 0,1, 2,, n研究表明,两层网络在其隐层中使用 S 形激励函数,在输出层中使用线性传输函数,就几乎可以以任意精度逼近任意感兴趣的函数,只要隐层中有足够的单元可用。

问题 1:试使用 BP 神经网络去逼近正弦函数的正半周,如下:t = sin(x ), x ∈[0,π ]由于输入量 x 仅有一维,故 BP 神经网络结构可以设计为:, u i = ∑ a ji j , i = 1, 2z = v , v = ∑ b i i y= -(t - z ) ⋅ b i ⋅ ⋅ x j , i = 1, 2, j = 0,1b i i b k - β ⋅= = b i + β ⋅ (t - z ) ⋅ y i , i = 0,1, 2= a -β ⋅ = a ji + β ⋅ (t - z ) ⋅ b i ⋅ ⋅ x j , i = 1, 2, j = 0,1 ∂a j i (1 +各个神经元的输入输出关系为:y i =1 1 + e -u i1 j =0x 2i =0根据之前的推导,平方误差 ε 对所有网络参数的导数为:∂ε∂b i= -(t - z ) ⋅ y i , i = 0,1, 2∂ε ∂a jie -u i(1 + e -u i )2网络参数修正方程为:k +1∂ε ∂b ikak +1 jijik∂ε k为加快寻找最优权值的速度,可以使用动量法。

之前的方法中,收敛到最优权值的速度取决于学习率的大小,但是过大的学习率会导致来回震荡,不能稳定到最优权值点。

动量法的引入,使得较大的学习率也可以具有较好的稳定性,即提供了在学习期间到达最优权值时的稳定性。

这种方法基本上是将过去权值变化的平均值附加到每一次权值变化的新权值增量,从而使网络权值的变化更平滑。

数学表示如下:∆w k +1 = μ ⋅ ∆w k + (1- μ ) ⋅ β ⋅ (- ∂ε∂w)式中, μ是一个在0和1之间的动量参数, ∆w k是在前一个训练时间里的权值变化。

使用动量法的实际效果是:基本上,如果以前积累的变化与之前方向所暗示的是同一个方向时,动量部分就会加速当前权值改变;如果当前积累的变化是相反的方向,动量将阻止当前的变化。