BP神经网络逼近非线性函数

BP神经网络逼近非线性函数

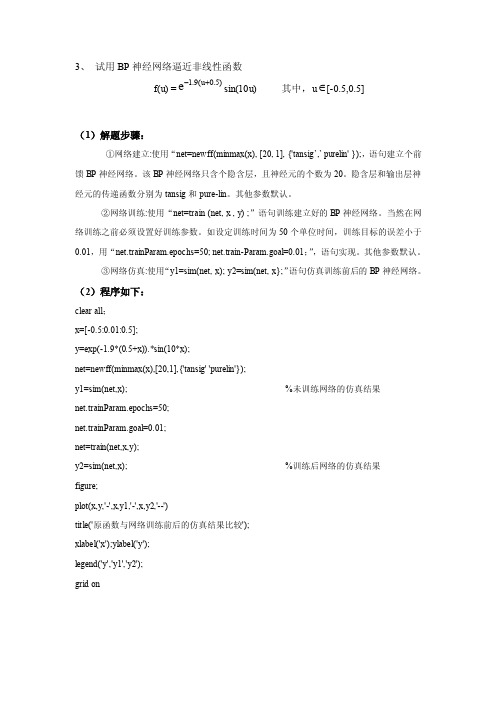

3、 试用BP 神经网络逼近非线性函数f(u) =)5.0u (9.1e+-sin(10u) 其中,u ∈[-0.5,0.5](1)解题步骤:①网络建立:使用“net=newff(minmax(x), [20, 1], {'tansig ’,’ purelin' });,语句建立个前馈BP 神经网络。

该BP 神经网络只含个隐含层,且神经元的个数为20。

隐含层和输出层神经元的传递函数分别为tansig 和pure-lin 。

其他参数默认。

②网络训练:使用“net=train (net, x , y) ;”语句训练建立好的BP 神经网络。

当然在网络训练之前必须设置好训练参数。

如设定训练时间为50个单位时间,训练目标的误差小于0.01,用“net.trainParam.epochs=50; net.train-Param.goal=0.01;”,语句实现。

其他参数默认。

③网络仿真:使用“y1=sim(net, x); y2=sim(net, x};”语句仿真训练前后的BP 神经网络。

(2)程序如下:clear all ;x=[-0.5:0.01:0.5];y=exp(-1.9*(0.5+x)).*sin(10*x);net=newff(minmax(x),[20,1],{'tansig' 'purelin'});y1=sim(net,x); %未训练网络的仿真结果 net.trainParam.epochs=50;net.trainParam.goal=0.01;net=train(net,x,y);y2=sim(net,x); %训练后网络的仿真结果 figure;plot(x,y,'-',x,y1,'-',x,y2,'--')title('原函数与网络训练前后的仿真结果比较');xlabel('x');ylabel('y');legend('y','y1','y2');grid on(3)仿真结果如图:图1图1为原函数y与网络训练前后(y1,y2)的仿真结果比较图。

基于遗传算法的BP网络及其非线性逼近能力研究

【 ywod ] e ei agrh B ew r ; o l erF nt napoc Ke rs G nt l i m;Pn tok N ni a;u ci p rah c ot n o

O 引 言

Ko grv定 理 业 已证 明 , 有 合 适 结 构 . 且 经 过 充 分 学 习 训 l aa mo 具 并

g o a p i m n t e lc l a e a e f u d b d p i g g a intd s e t ag rt m.Co a e t h r d e td s e ta g rt m,t e smu ai n lb lo tmu i h o a r a c n b o n y a o tn r d e e c n l o h i mp d wih t e g a i n e c n lo h r i h i lt o s o h x d ag rt m sf a i l n f ci e h ws t e mie o h i e s b e a d ef tv . l i e

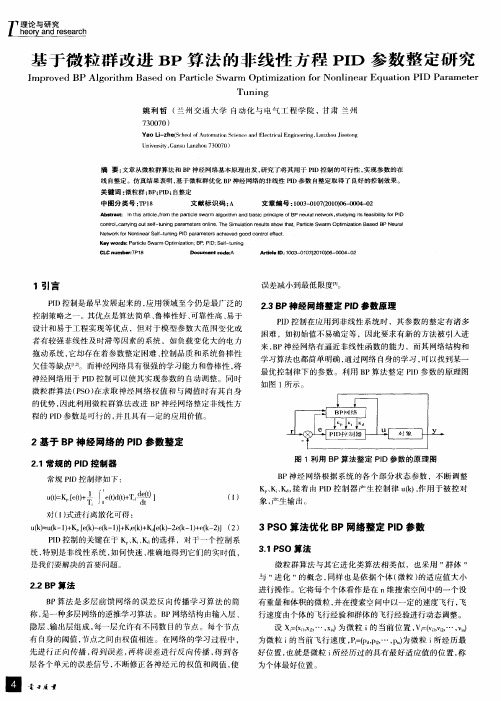

练后的 B P网络 能够 以任 意 精 度 逼 近 有 界 区域 非 线 性 函数 。针 对 B P 在 过 去 的 几 十 年里 , 们 提 出了 诸 多 神 经 网络 模 型 。这 些 模 型 在 网络 ,对 于 闭 区 间 的 一个 连 续 函数 都 可 以用 一 个 隐 含 层 的 B 人 P网 络 逼 图形 图 像 处 理 、 自动 控 制 、 据 挖 掘 、 式 识 别 等 领 域 不 断 得 到 了应 数 模 近 , 成 任 意 的 n维 到 m 维 的 映 射 。本 文神 经 网络 优 化 模 型 采 用 三 层 完 用, 自身 也 不断 改 进 和 发 展 。 其 中 , 向传 播 模 型 ( akPo aai , 这 反 B c rpgt n o B 网络 , 拓 扑 结 构 如 图 2所示 。 其 中 n为 输 入 单 元 数 ,, 网 络 中 P 其 x为 B )是 最 常 见 的也 是 应 用 最 广 泛 的 多 层 前 馈 网 络 模 型 。 这 得 益 于 B P P 第 () 样 本 的输 入 ,, 网 络 中第 () 样 本 的 实 际 输 出 , 为 网 络 第 i个 Y为 i个 网络 较 强 的逼 近能 力 和 分 类 能 力 _ l J 。 i个 是 w B P网 络 的学 习算 法 是 B P算 法 。针对 B P网 络采 用 的算 法 多 是 梯 () 样 本 期 望输 出 。w 输 入 层 与 隐含 层 的 连接 权 值 , 是 隐 含 层 与输 出层 的连 接 权 值 , 隐 单 元 的 阚 值 , 输 出单 元 的 阈值 。 B是 B是 度 下 降法 。梯 度 下 降 法 的 优 点 是 进行 局部 寻 优 时 速 度 很 快 , 是 梯 度 但 输 入层 隐 含屡 输 出层 下 降 法容 易 陷入 局 部 极 小 , 致 其 全局 搜 索 能力 弱 、 优 性 能 不 高 . 导 寻 收 敛 速 度 慢 甚 至 不 收 敛 、 易 陷 入 局 部 极 小 值 , 约 了其 一 定 程 度 的应 容 制 W1 B1 W2 B2 用 。 遗 传 算 法 ( eei Al rh 以 下 简 称 G 是一 种 非 导 数 优 化 的 X 1 G n t gi m, c ot A) ( 期望 输 出 ) 随 机优 化 搜 索 算 法 . 有 很 强 的 全 局搜 索 能 力 和 鲁 棒 性 。 但 是 它 在 寻 具 优 时搜 索 方 向不 停 的 发 生 变 化 , 搜 索 到 全 局 最 优 解 的 代 价 较 大 。研 其 X2 ( 期塑 输 出 ) 究 表 明 , 传 算 法 能 够 以 较 快 的速 度 收 敛 到 全 局 最 优 解 的 9 % . 这 遗 O 在 以后 其 收敛 速 度 明 显 减 慢 。 时 , 传算 法局 部 搜 索 能 力 不 足 , 算 过 同 遗 运 程有 时会 出 现 早 熟 现 象 , 初 始 种 群 的选 择 有 依 赖 性 , 且 并 行 机 制 对 而 的潜 在 能 力 不 容 易 得 到 充分 利 用 。 果 用 GA结 合 B 网络 构 建 模 型 . 如 P ( 望输出 ) 期 用来 训 练 神 经 网络 , 化 神 经 网 络 的权 值 阈值 , 可 以克 服 B 优 既 P算 法 容 ( 闽值 ) 易选 人 局 部 极 小 值 的缺 陷 ,同 时 又 能 克 服 遗 传 算 法 局 部 搜 索 能 力 不 强、 容易 早 熟 的 不 足 , 互取 长 补短 , 遗 传 算 法 优化 后 的 神 经 网 络 具 相 使 图 2 本 文 BP网 络 拓 扑 结构 有 自进 化 、 自适 应 能 力 。本 文采 用 一 种 基 于 自适 应 遗 传 算法 的 神 经 网 对于 B P网 络 的 这 种 前 向 神 经 网 络 训 练采 用 的算 法 是 “ 差 逆 传 误 络学 习算 法 , 用 自适应 遗 传 算 法 在 整 个 权 值 ( 先 阈值 ) 间进 行 粗 略 搜 空 , P算 法 。 准 B 标 P算 法 和 Wirw H f学 习规 则 一 样 是 一 do — of 索 , 后 再 采 用 梯 度 下 降 法 进 行 局 部 的 寻 优 , 终 得 到 问 题 的全 局 最 播 算 法 ” 即 B 然 最

神经网络在函数逼近中的应用

二 基于BP神经网络逼近函数 基于BP神经网络逼近函数

步骤1:假设频率参数k=1,绘制要逼近的非线性 步骤1:假设频率参数k=1,绘制要逼近的非线性 函数的曲线。函数的曲线如图1 函数的曲线。函数的曲线如图1所示 k=1; p=[p=[-1:.05:8]; t=1+sin(k*pi/4*p); plot( plot(p,t,'-'); '); title('要逼近的非线性函数'); title('要逼近的非线性函数'); xlabel('时间'); xlabel('时间'); ylabel('非线性函数'); ylabel('非线性函数');

图3 训练过程 从以上结果可以看出,网络训练速度很快,很 快就达到了要求的精度0.001。 快就达到了要求的精度0.001。

步骤4 步骤4: 网络测试 对于训练好的网络进行仿真: y2=sim(net,p); figure; plot(p,t,'plot(p,t,'-',p,y1,':',p,y2, '--') '--') title('训练后网络的输出结果'); title('训练后网络的输出结果'); xlabel('时间'); xlabel('时间'); ylabel('仿真输出'); ylabel('仿真输出'); 绘制网络输出曲线,并与原始非线性函数曲线以 及未训练网络的输出结果曲线相比较,比较出来 的结果如图4 的结果如图4所示。

BP网络在函数逼近中的应用 BP网络在函数逼近中的应用

BP神经网络的基本原理_一看就懂

BP神经网络的基本原理_一看就懂BP神经网络(Back Propagation Neural Network)是一种常用的人工神经网络模型,用于解决分类、回归和模式识别问题。

它的基本原理是通过反向传播算法来训练和调整网络中的权重和偏置,以使网络能够逐渐逼近目标输出。

1.前向传播:在训练之前,需要对网络进行初始化,包括随机初始化权重和偏置。

输入数据通过输入层传递到隐藏层,在隐藏层中进行线性加权和非线性激活运算,然后传递给输出层。

线性加权运算指的是将输入数据与对应的权重相乘,然后将结果进行求和。

非线性激活指的是对线性加权和的结果应用一个激活函数,常见的激活函数有sigmoid函数、ReLU函数等。

激活函数的作用是将线性运算的结果映射到一个非线性的范围内,增加模型的非线性表达能力。

2.计算损失:将网络输出的结果与真实值进行比较,计算损失函数。

常用的损失函数有均方误差(Mean Squared Error)和交叉熵(Cross Entropy)等,用于衡量模型的输出与真实值之间的差异程度。

3.反向传播:通过反向传播算法,将损失函数的梯度从输出层传播回隐藏层和输入层,以便调整网络的权重和偏置。

反向传播算法的核心思想是使用链式法则。

首先计算输出层的梯度,即损失函数对输出层输出的导数。

然后将该梯度传递回隐藏层,更新隐藏层的权重和偏置。

接着继续向输入层传播,直到更新输入层的权重和偏置。

在传播过程中,需要选择一个优化算法来更新网络参数,常用的优化算法有梯度下降(Gradient Descent)和随机梯度下降(Stochastic Gradient Descent)等。

4.权重和偏置更新:根据反向传播计算得到的梯度,使用优化算法更新网络中的权重和偏置,逐步减小损失函数的值。

权重的更新通常按照以下公式进行:新权重=旧权重-学习率×梯度其中,学习率是一个超参数,控制更新的步长大小。

梯度是损失函数对权重的导数,表示了损失函数关于权重的变化率。

数值优化改进的BP神经网络逼近性能对比研究

( S c h o o l o f I n d u s t r y,B o h a i Un i v e r s i t y。 J i n z h o u 1 2 1 0 1 3, Ch i n a )

数值 逼近是 指 给定一 组数 据 , 用 数 学分析 的方法来 分 析这组 数据 , 常用 的数学分 析 方法有 多项 式 拟合 和 插 值运 算 。 由于人 工神经 元 网络 ( A r t i i f c i a l N e u r a l N e t w o r k s , A N N) 具有 很 强 的非 线性 映射 能 力 、 自学 习性 和 容错性 , 所 以, 近些 年来采 用 A N N对 非线 性 函数进 行逼 近成 为该 领域 的一 个研究 热 点 , 其 优越 性 可在数 据 本

境下, 每种 数值优 化 差法逼 近 的可行性 。

关 键词 : 数 值优化 ;B P神 经 网络 ; 逼 近性 能 ; 对 比研 究 中图分 类号 : T P 3 9 1 . 9 文献标 识码 : A 文章 编号 : 1 0 0 2 - 4 0 2 6 ( 2 0 1 4) 0 1 - 0 0 6 8 - 0 5

山东科学

SHANDONG SCI ENCE

第2 7 卷

第1期

2 0 1 4年 2月出版

VO I . 2 7 NO. 1 F e b. 2 01 4

D OI : 1 0 . 3 9 7 6 / j . i s s n . 1 0 0 2— 4 0 2 6 . 2 0 1 4 . 0 1 . 0 l 2

基于微粒群改进BP算法的非线性方程PID参数整定研究

中 图分 类 号 :P 8 T 1

文 献 标识 码 : A

文章 编 号 :0 301721) —0 40 10- 0 ( 00 00 -2 0 6

Ab蚶 a t I h sarc e f0 n t epa t l wa m lor h a d asc p ici eo eu a t o k。t dyn t e sbi y f I c : nt i t l .r r h ri e s r ag i m n b i r i c t n pl fBP n r l w r su ig i f a i l e n s i orP D t c n r lc ryn ut ef u n r m e e so l e Th m ua in r ul h w h t Pa t l w a m p i ia in Ba e u a o to 。 a r ig o l s -tnig pa a t r n i . eSi lt es t s o t a . r ce S n o s i r O t z t s d BP Ne r l m o New o kf rN l ea l t ig PI p a e e s a he e go d c to e e t t r oni o n r Sef unn D arm t r c iv d o on r l f c — K y w or s: arce e d P t l Swa m p i ia in; ; D ; l —u ig i r O t zt m o BP PI Sef t nn —

Unv ri , a s a z o 3 0 0 i st G n uL nh u7 0 7 ) e y

摘 要 : 章从微粒 群算法和 B 文 P神经 网络 基本原理 出发 , 究 了将 其用 于 PD控 制 的可行性 , 研 I 实现参 数的在

利用BP神经网络求解非线性方程组

利⽤BP 神经⽹络求解⾮线性⽅程组利⽤BP 神经⽹络求解⾮线性⽅程组待求解问题:思路我们将坐标对应的函数值作为输⼊向量,⽽将坐标作为⽬标向量,去初值点附近多个坐标对应的函数值向量作为输⼊,训练神经⽹络。

将作为输⼊输⼊到训练好的神经⽹络中,就可以得到该线性⽅程组的⼀个近似解matlab 代码function u=u(x)u = 3*x(1)-cos(x(2)*x(3))-0.5;function v=v(x)v = x(1)^2 -81 * (x(2)+0.1)^2+sin(x(3))+1.06;function w=w(x)w = exp(-x(1)*x(2))+20*x(3)+(10*pi - 3) / 3;主程序(x ,x ,x )123[u (x ,x ,x ),v (x ,x ,x ),w (x ,x ,x )]123123123(x ,x ,x )123x 0[0,0,0]x ,x ,x 1∗2∗3∗u (x ,x ,x )123v (x ,x ,x )123w (x ,x ,x )123% ----------------------------------% 使⽤神经⽹络求解⾮线性⽅程组% 以坐标(x,y,z)为⽬标向量% 坐标(x,y,z)对应的各个⾮线性函数的值(u(x,y,z), v(x,y,z), w(x,y,z))为输⼊向量% 训练⽹络后,输⼊(0,0,0)对应的输出即⾮线性⽅程组的⼀个近似解% -----------------------------------x0 = [0.1 0.1 -0.1]; %初值x = ones(200,3); % 根据初值得到200个点for i = 1:200x(i,:) = x0 + (i - 100) * 0.01;endP = zeros(3,200); % 输⼊样本矩阵,每列为⼀个样本for i = 1:200P(:,i) = [u(x(i,:)) v(x(i,:)) w(x(i,:))];endT = x'; % ⽬标矩阵,每列为⼀个⽬标向量net = newff([-100,100; -100,100; -100,100;],[3 3],{'tansig','logsig'},'traingd'); % 输⼊3,输出3(注意⽹络输⼊与⽬标向量的维数对应) net.trainParam.epochs = 15000; % 迭代15000次net.trainParam.goal = 0.01; % 误差LP.lr = 0.1; % 学习率% 训练⽹络net = train(net, P, T);% 给出⾮线性⽅程的近似解res = sim(net, [0;0;0])求解结果为:此时,解和真实解还是有误差,可以调整输⼊样本来得到更好的近似解。

基于改进型BP神经网络的瓦斯传感器的非线性校正

基于改进型BP神经网络的瓦斯传感器的非线性校正

刘刚;刘学仁;嵇英华;罗海梅

【期刊名称】《传感器与微系统》

【年(卷),期】2007(026)001

【摘要】提出了一种基于改进型BP神经网络的瓦斯传感器的非线性校正方法,利用神经网络良好的非线性映射能力,逼近反非线性函数完成非线行校正.仿真实验结果表明:与传统的分段线性与BP算法相比,改进型的BP神经网络收敛速度快、逼近精度高,准确度由原来分段线性校正的±5.020%提高到现在的±0.130%,且易于动态调校.

【总页数】4页(P15-17,20)

【作者】刘刚;刘学仁;嵇英华;罗海梅

【作者单位】江西师范大学,物理与通信电子学院,江西,南昌,330022;江西师范大学,物理与通信电子学院,江西,南昌,330022;江西师范大学,物理与通信电子学院,江西,南昌,330022;江西师范大学,物理与通信电子学院,江西,南昌,330022

【正文语种】中文

【中图分类】TP183

【相关文献】

1.基于改进型BP神经网络的瓦斯传感器的非线性校正 [J], 刘刚

2.改进型BP神经网络的2维PSD非线性校正 [J], 林青松;杨孝敬;王军晓;张聚伟

3.改进型BP神经网络对电容称重传感器的非线性校正 [J], 郭伟;张栋;李巨韬;王磊

4.基于最小二乘支持向量机的瓦斯传感器非线性校正 [J], 刘瑞芳;梅孝安

5.基于改进RBFNN算法的瓦斯传感器非线性校正 [J], 杨義葵;付华;蔡玲;顾东因版权原因,仅展示原文概要,查看原文内容请购买。

BP神经网络的介绍

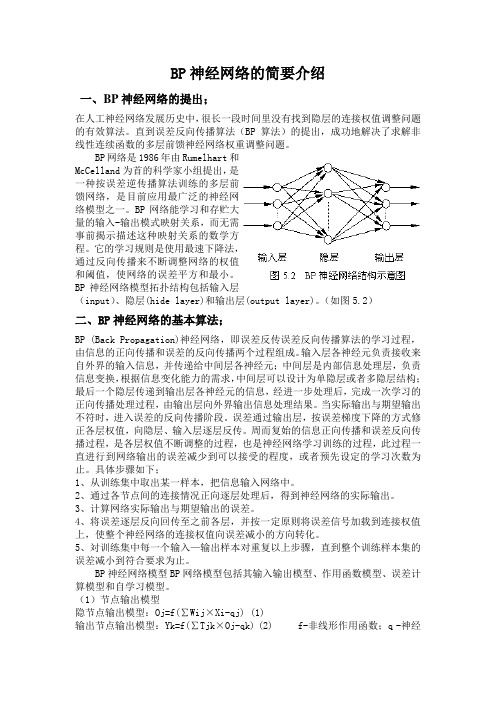

BP神经网络的简要介绍一、BP神经网络的提出;在人工神经网络发展历史中,很长一段时间里没有找到隐层的连接权值调整问题的有效算法。

直到误差反向传播算法(BP算法)的提出,成功地解决了求解非线性连续函数的多层前馈神经网络权重调整问题。

BP网络是1986年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。

BP网络能学习和存贮大量的输入-输出模式映射关系,而无需事前揭示描述这种映射关系的数学方程。

它的学习规则是使用最速下降法,通过反向传播来不断调整网络的权值和阈值,使网络的误差平方和最小。

BP神经网络模型拓扑结构包括输入层(input)、隐层(hide layer)和输出层(output layer)。

(如图5.2)二、BP神经网络的基本算法;BP (Back Propagation)神经网络,即误差反传误差反向传播算法的学习过程,由信息的正向传播和误差的反向传播两个过程组成。

输入层各神经元负责接收来自外界的输入信息,并传递给中间层各神经元;中间层是内部信息处理层,负责信息变换,根据信息变化能力的需求,中间层可以设计为单隐层或者多隐层结构;最后一个隐层传递到输出层各神经元的信息,经进一步处理后,完成一次学习的正向传播处理过程,由输出层向外界输出信息处理结果。

当实际输出与期望输出不符时,进入误差的反向传播阶段。

误差通过输出层,按误差梯度下降的方式修正各层权值,向隐层、输入层逐层反传。

周而复始的信息正向传播和误差反向传播过程,是各层权值不断调整的过程,也是神经网络学习训练的过程,此过程一直进行到网络输出的误差减少到可以接受的程度,或者预先设定的学习次数为止。

具体步骤如下;1、从训练集中取出某一样本,把信息输入网络中。

2、通过各节点间的连接情况正向逐层处理后,得到神经网络的实际输出。

3、计算网络实际输出与期望输出的误差。

BP神经网络的优缺点

BP神经网络的优缺点BP神经网络,也称为“反向传播神经网络”,是一种常见的人工神经网络模型。

它是基于误差反向传播算法的一种机器学习方法,广泛应用于分类、回归、预测等场景中。

优点1. 非线性逼近能力强BP神经网络的非线性逼近能力优秀,可以逼近任何非线性的函数。

它的输入层、隐层和输出层之间的结构可以实现对高维非线性数据的拟合。

2. 适用 range 广泛BP神经网络可以应用于许多不同领域,如医药、自然语言处理、图像识别等。

它可以对各种形式的数据进行分类、回归、预测等。

3. 学习能力强BP神经网络可以通过大量的样本数据进行训练,并能够自动学习和自我适应。

可以对训练数据进行高效的学习和泛化,从而适应未知数据。

4. 适应动态环境BP神经网络可以适应不断变化的环境。

当模型和所需输出之间的关系发生变化时,网络可以自适应,自动调整权重和阈值,以适应新的情况。

缺点1. 学习速度慢BP神经网络的学习速度相对较慢。

它需要大量的时间和数据来调整权重和阈值,以达到稳定的状态。

2. 容易陷入局部极小值BP神经网络很容易陷入局部极小值,而无法达到全局最优解。

这可能会导致网络的准确度降低,并影响到后续的预测、分类和回归任务。

3. 需要大量的数据BP神经网络需要大量的数据进行训练,以使网络达到优秀的效果。

如果训练数据不充分,可能会导致网络过度拟合或欠拟合。

4. 对初始参数敏感BP神经网络对初始参数非常敏感。

如果初始参数不好,那么网络可能会无法进行训练,或者陷入局部最小值。

综合来看,BP神经网络具有良好的非线性逼近能力和学习能力,但也存在一些缺点,比如学习速度慢、容易陷入局部极小值等。

因此,在具体应用场景中,我们需要权衡BP神经网络的优点和缺点,选择合适的机器学习模型进行训练和预测。

BP神经网络算法

BP神经网络算法BP神经网络算法(BackPropagation Neural Network)是一种基于梯度下降法训练的人工神经网络模型,广泛应用于分类、回归和模式识别等领域。

它通过多个神经元之间的连接和权重来模拟真实神经系统中的信息传递过程,从而实现复杂的非线性函数拟合和预测。

BP神经网络由输入层、隐含层和输出层组成,其中输入层接受外部输入的特征向量,隐含层负责进行特征的抽取和转换,输出层产生最终的预测结果。

每个神经元都与上一层的所有神经元相连,且每个连接都有一个权重,通过不断调整权重来优化神经网络的性能。

BP神经网络的训练过程主要包括前向传播和反向传播两个阶段。

在前向传播中,通过输入层将特征向量引入网络,逐层计算每个神经元的输出值,直至得到输出层的预测结果。

在反向传播中,通过计算输出层的误差,逐层地反向传播误差信号,并根据误差信号调整每个连接的权重值。

具体来说,在前向传播过程中,每个神经元的输出可以通过激活函数来计算。

常见的激活函数包括Sigmoid函数、ReLU函数等,用于引入非线性因素,增加模型的表达能力。

然后,根据权重和输入信号的乘积来计算每个神经元的加权和,并通过激活函数将其转化为输出。

在反向传播过程中,首先需要计算输出层的误差。

一般采用均方差损失函数,通过计算预测值与真实值之间的差异来衡量模型的性能。

然后,根据误差信号逐层传播,通过链式法则来计算每个神经元的局部梯度。

最后,根据梯度下降法则,更新每个连接的权重值,以减小误差并提高模型的拟合能力。

总结来说,BP神经网络算法是一种通过多层神经元之间的连接和权重来模拟信息传递的人工神经网络模型。

通过前向传播和反向传播两个阶段,通过不断调整权重来训练模型,并通过激活函数引入非线性因素。

BP 神经网络算法在分类、回归和模式识别等领域具有广泛的应用前景。

基于BP神经网络的非线性插值计算

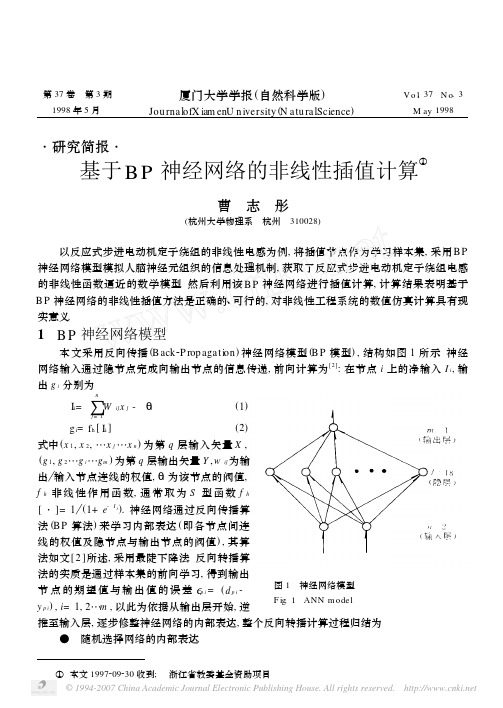

第37卷 第3期厦门大学学报(自然科学版)V o l.37 N o .3 1998年5月Jou rnalofX iam enU n iversity (N atu ralScience )M ay 1998 ・研究简报・基于B P 神经网络的非线性插值计算①曹 志 彤(杭州大学物理系 杭州 310028)以反应式步进电动机定子绕组的非线性电感为例,将插值节点作为学习样本集,采用B P 神经网络模型模拟人脑神经元组织的信息处理机制,获取了反应式步进电动机定子绕组电感的非线性函数逼近的数学模型.然后利用该B P 神经网络进行插值计算,计算结果表明基于B P 神经网络的非线性插值方法是正确的、可行的,对非线性工程系统的数值仿真计算具有现实意义.1 B P 神经网络模型本文采用反向传播(B ack 2P rop agati on )神经网络模型(B P 模型),结构如图1所示.神经网络输入通过隐节点完成向输出节点的信息传递,前向计算为[2]:在节点i 上的净输入I i ,输出g i 分别为 图1 神经网络模型 F ig .1 ANN model I i =∑nj =1Wijx j -Ηi (1) g i =f h [I i ](2)式中(x 1,x 2,…x j …x n )为第q 层输入矢量X ,(g 1,g 2…g i …g m )为第q 层输出矢量Y ,w ij 为输出 输入节点连线的权值,Ηi 为该节点的阀值,f h 非线性作用函数,通常取为S 型函数f h[・]=1(1+e -I i ).神经网络通过反向传播算法(B P 算法)来学习内部表达(即各节点间连线的权值及隐节点与输出节点的阀值),其算法如文[2]所述,采用最陡下降法.反向转播算法的实质是通过样本集的前向学习,得到输出节点的期望值与输出值的误差Εp i =(d p i -y p i ),i =1,2…m ,以此为依据从输出层开始,逆推至输入层,逐步修整神经网络的内部表达,整个反向转播计算过程归结为 ● 随机选择网络的内部表达.①本文1997209230收到; 浙江省教委基金资助项目 图2 反应式步进电动机电感随电流与转角变化曲线 F ig .2 l =f (i ,Η),cu rve of inducti on of V R stepp ing mo to r ● 根据当前的内部表达,将样本集作为网络输入,作前向计算. ● 比较网络输出节点上的期望值与输出值,若误差小于规定值,则网络学习结束,否则将误差反向传播,逐步调整网络的内部表达. ● 重复步骤2.2 基于神经网络的非线性插值计算 图2表示实验测量的反应式步进电动机定子绕组电感随定子电流和转角变化的非线性关系l=f (i ,Η).我们构造了如图1所示的三层神经网络模型,输入节点n =2,图3 权系数在不同网络结构和内部表达时的收敛情况F ig .3 Convergence of a w eighting facto r fo r different structure and initial inherent rep resent of ANN・364・第3期 曹志彤:基于BP 神经网络的非线性插值计算 隐层节点l =18,输出节点m =1.自行编制了QBA S I C 程序,在PC 微机上运行.以反应式步进电动机定子电流和转角作为输入,电感作为输出,通过对插值节点样本集学习,B P 神经网络的内部表达(权值和阀值)在学习过程中不断得到自动调调整,经过样本集的1600次学习,如图3(a )所示,神经网络的内部表达获得收敛.收敛时神经网络的内部表达就逼近了反应式步进电动机定子绕组电感随定子电流和转角变化的非线性关系l =f (i ,Η).图3(b )、(c )表示隐层节点分别为l =17、19时,神经网络的内部表达未能全部获得收敛.图3(d )表示采用与图3(a )同样的神经网络结构而不同的初始表达,网络的内部表达也未能全部获得收敛.这说明在B P 算法时,应用最速下降法,有可能陷入局部极小点,此时对神经网络的结构和初始表达的选择尤为重要,现在多数凭取经验.表1同时列出B P 神经网络和拉格朗日插值计算结果,该结果相互佐证插值计算的正确性,内插点的相对误差的5%以内,外延点的相对误差在10%以内,达到工程计算精度.图2点划线表示基于B P 神经网络插值计算,电感随定子电流和转角变化非线性关系l =f (i ,Η)的二支,与测量曲线比较,基于B P 神经网络插值计算的方法是可行的,正确的.表1 基于BP 神经网络的插值和拉格朗日插值结果比较T ab .1 In sert resu lts of L 2and ANN 2m ethod转角(°)电流(A )电感L 插值(mH )电感ANN 插值(mH ) 0.15 0.3 111.9882 112.25790.090.5107.9531110.9460.130.787.5085789.580250.170.972.2510171.021990.210.1102.677104.92520.250.2583.4254485.8110.110.788.8111192.276790.190.8870.7133669.604640.1850.590.7077593.078850.20.7774.1509774.298650.11781.165.3125165.25660.21.253.9470654.955580.111.357.862857.515420.0851.557.4876152.526940.291.839.0789139.107943 结 论1)本文例举的输入节点n =2,输出节点m =1的B P 神经网络,其输入 输出的关系可看作为从n 维到m 维欧氏空间的映射F :Y =F (X ),其中X 、Y 分别为输入输出矢量,由于网络中含有大量非线性节点,所以F 具有高度非线性.这种数学映射实现非线性函数逼近,使采用B P 神经网络进行非线性插值计算成为可能,正如表1所示,基于B P 神经网络非线性插值是可行的,正确的,对非线性工程系统的数值仿真具有现实意义.2)采用B P 神经网络进行非线性插值计算的优点在于:当非线性工程系统数值仿真中,遇・464・ 厦门大学学报(自然科学版) 1998年到三元及三元以上的非线性函数插值问题时,拉格朗日插值、三次样条函数插值等方法具体应用存在一定难度,具有一定的局限性.这方面正是神经网络的特长,只要通过非线性插值节点的学习,它就能逼近任意非线性函数,它不仅能完成内点插值,也能进行外延,特别对于多元非线性函数,基于神经网络的插值计算就独占鳌头了.参 考 文 献1 曹志彤,李忠杰.反应式步进电动机动特性及其最佳控制.合肥工业大学学报,1982,(3):111~1262 杨行峻,郑君里.人工神经网络.北京:高等教学出版社,19923 Funahash i K I .O n the app rox i m ater realizati on of con tinuou s m app ing by neu ral netw o rk .N eu ral N et 2w o rk ,1989,(2):183~192O n the N on linear In sert Calcu lati on of Con tinuou sM app ing by N eu ral N etw o rkCao Zh itong(D ep t .of Phys .,H angzhou U n iv .,H angzhou 310028)A bs tra c t T he non linearity and distribu ti on ofinfo rm ati on p rocessing of the artifi 2cial neu ral netw o rk are u tilized in descri p ti on of the app rox i m ate realizati on of con tinuou s m app ing .T he non linear in sert calcu latin of the inducti on of variab le 2reluctance stepp ing m o 2to r show s that it can be p racticab le to adop t neu ral netw o rk to describe non linear realizati on of con tinuou s m app ing .T herefo re ,a new w ay of non linear in sert calcu lati on m ay be feasib le .Ke y w o rds A ritificial N eu ral N etw o rk (ANN ),A pp rox i m ate realizati on of non 2linear functi on ,N on linear in sert calcu lati on・564・第3期 曹志彤:基于BP 神经网络的非线性插值计算 。

改进的求解非线性方程组的迭代神经网络算法

改进的求解非线性方程组的迭代神经网络算法作者:赵庆兰李文董晓丽来源:《现代电子技术》2013年第08期摘要:利用BP神经网络可以逼近多变元非线性方程组的函数的反函数,并利用迭代算法进行求解方程组的根。

在实验中发现迭代算法在迭代过程中由于误差过早收敛出现无穷迭代,且由于误差并不一直随迭代次数的增加而减少导致最后收敛的值并不一定是最小值。

针对这两个问题对其进行了改进,并利用算例进行了实验分析。

在输入区域偏离解区域很远的情况下也能求得方程组的近似解。

关键词: BP神经网络;非线性方程组;迭代算法;误差收敛中图分类号: TN911⁃34; TP183 文献标识码: A 文章编号: 1004⁃373X(2013)08⁃0020⁃030 引言神经网络具有许多优点,如大规模并行处理、分布式存储以及网络的计算时间复杂度几乎为零等[1],因此,神经网络的应用已越来越广泛。

BP(Back Propagation)神经网络是采用误差反向传播学习算法的多层前馈神经网络,它是当前获得广泛应用的模型之一。

BP算法的基本思想[2⁃4]是:网络学习由输入信号的正向传播和误差的逆向传播两个过程组成。

正向传播过程是指样本信号由输入层输入,经网络的权重、阈值和神经元的转移函数作用后,从输出层输出。

如果输出值与期望值之间的误差大于预期,则转入误差反向传播阶段,进行修正,即误差通过隐层向输入层逐层返回。

网络的学习训练过程实质就是根据输出值与期望值之间的误差不断调整网络权重和阈值的过程,直到网络输出误差减小到允许值或到达设定的训练次数为止。

由于 BP神经网络模型具有较强的随机性和不确定性,很多研究对BP算法进行改进,并取得了大量的成果,具体参看文献[5⁃6],这些算法提高了BP神经网络在实际应用中的可靠性,使得BP神经网络的应用范围越来越广泛。

神经网络求在求解非线性方程组中的应用也有了较好的研究。

文献[7⁃9]研究了人工神经网络逼近非线性多元函数的可能性,得到了相应于几类特殊作用函数的神经网络逼近存在性定理,这些定理保证了用单层神经网络逼近连续多元函数时,可达到任意的精确度。

实验二基于BP神经网络算法的函数逼近

实验二基于BP神经网络算法的函数逼近一、引言函数逼近是神经网络应用的重要领域之一、在实际问题中,我们常常需要使用一个适当的数学函数来近似描述现象与问题之间的关系。

BP神经网络作为一种常用的函数逼近方法,具有良好的逼近性能和普适性,能够对非线性函数进行逼近,并且在实际应用中已经得到了广泛的应用。

本实验将通过BP神经网络算法对给定的函数进行逼近,验证其逼近效果和性能。

二、实验目标1.理解和掌握BP神经网络算法的基本原理和步骤;2.掌握使用BP神经网络进行函数逼近的方法;3.通过实验验证BP神经网络在函数逼近中的性能。

三、实验步骤1.准备数据集选择一个待逼近的非线性函数,生成一组训练数据和测试数据。

训练数据用于训练神经网络模型,测试数据用于评估逼近效果。

2.构建神经网络模型根据待逼近的函数的输入和输出维度,确定神经网络的输入层和输出层的神经元个数,并选择适当的激活函数和损失函数。

可以根据实际情况调整隐藏层的神经元个数,并添加正则化、dropout等技术来提高模型的泛化能力。

3.初始化网络参数对于神经网络的参数(权重和偏置)进行随机初始化,通常可以采用均匀分布或高斯分布来初始化。

4.前向传播和激活函数通过输入数据,进行前向传播计算,得到网络的输出值,并通过激活函数将输出值映射到合适的范围内。

5.计算损失函数根据网络的输出值和真实值,计算损失函数的值,用于评估模型的训练效果。

6.反向传播和权重更新通过反向传播算法,计算各个参数的梯度,根据学习率和梯度下降算法更新网络的参数。

7.循环迭代训练重复以上步骤,直至达到预设的训练停止条件(如达到最大迭代次数或损失函数满足收敛条件)。

8.模型测试和评估使用测试数据评估训练好的模型的逼近效果,可以计算出逼近误差和准确度等指标来评估模型的性能。

四、实验结果通过对比逼近函数的真实值和模型的预测值,可以得到模型的逼近效果。

同时,通过计算逼近误差和准确度等指标来评估模型的性能。

BP神经网络算法步骤

BP神经网络算法步骤1.初始化网络参数:首先,需要确定网络的架构,包括输入层、输出层和隐藏层的数量和节点数。

然后,通过随机选取初始权重和阈值来初始化网络参数,这些参数将用于每个节点的计算。

2.前向传播计算:对于每个输入样本,将其输入到网络中,通过计算每个节点的输出来实现前向传播。

每个节点的输入是上一层节点的输出,通过加权求和并使用激活函数得到节点的输出。

3.计算误差:对于每个输出节点,将其输出与实际的目标值进行比较,得到误差。

通常使用均方误差函数来计算误差。

4.反向传播调整权重:根据误差大小来调整网络的权重和阈值。

先从输出层开始计算误差梯度,并根据梯度下降算法调整输出层的权重和阈值。

然后,逐层向前计算误差梯度并调整隐藏层的权重和阈值,直到达到输入层。

5.更新参数:根据反向传播计算得到的梯度更新网络的参数。

通常使用梯度下降法来更新权重和阈值。

梯度下降法根据每个参数的梯度进行参数更新,以使误差最小化。

6.重复迭代:通过多次重复迭代步骤2到步骤5,持续调整网络参数,使得网络能够逐渐学习和逼近目标函数。

每次迭代都会计算新的误差和梯度,并根据梯度下降法更新参数。

7.终止条件:迭代过程应设置一个终止条件,通常是达到一定的最大迭代次数或者误差的变化小到一定程度时停止。

8.测试网络性能:使用测试数据集对训练好的网络进行性能评估。

将测试数据输入网络中,通过前向传播计算输出结果,并与实际结果进行比较,计算准确率或其他性能指标。

以上就是BP神经网络算法的基本步骤。

这个算法能够通过不断的反向传播和参数更新,使得网络能够学习和逼近非线性函数,是一种非常常用的神经网络算法。

BP神经网络

BP神经网络在函数逼近中的实现1.1 概述BP神经网络是目前人工神经网络模式中最具代表性,应用得最广泛的一种模型,具有自学习、自组织、自适应和很强的非线性映射能力,可以以任意精度逼近任意连续函数.近年来,为了解决BP网络收敛速度慢,训练时间长等不足,提出了许多改进算法.然而,在针对实际问题的BP网络建模过程中,选择多少层网络,每层多少个神经元节点,选择何种传递函数等,均无可行的理论指导,只能通过大量的实验计算获得.MATLAB中的神经网络工具箱(Neural NetworkToolbox,简称NNbox),为解决这一问题提供了便利的条件.神经网络工具箱功能十分完善,提供了各种MATLAB函数,包括神经网络的建立、训练和仿真等函数,以及各种改进训练算法函数,用户可以很方便地进行神经网络的设计和仿真,也可以在MATLAB源文件的基础上进行适当修改,形成自己的工具包以满足实际需要。

此项课题主要是针对MATLAB软件对BP神经网络的各种算法的编程,将神经网络算法应用于函数逼近和样本含量估计问题中,并分析比较相关参数对算法运行结果的影响。

人工神经网络(Artificial Neural Networks,NN)是由大量的、简单的处理单元(称为神经元)广泛地互相连接而形成的复杂网络系统,它反映了人脑功能的许多基本特征,是一个高度复杂的非线性动力学系统。

神经网络具有大规模并行、分布式存储和处理、自组织、自适应和自学习能力,特别适合处理需要同时考虑许多因素和条件的、不精确和模糊的信息处理问题。

神经网络的发展与神经科学、数理科学、认知科学、计算机科学、人工智能、信息科学、控制论、机器人学、微电子学、心理学、微电子学、心理学、光计算、分子生物学等有关,是一门新兴的边缘交叉学科。

神经网络具有非线性自适应的信息处理能力,克服了传统人工智能方法对于直觉的缺陷,因而在神经专家系统、模式识别、智能控制、组合优化、预测等领域得到成功应用。

实验一、BP及RBP神经网络逼近

实验一、BP及RBF神经网络逼近一、实验目的1、了解MATLAB集成开发环境2、了解MATLAB编程基本方法3、熟练掌握BP算法的原理和步骤4、掌握工具包入口初始化及调用5、加深BP、RBF神经网络对任意函数逼近的理解二、实验内容1、MATLAB基本指令和语法。

2、BP算法的MATLAB实现三、实验步骤1、熟悉MATLAB开发环境2、输入参考程序3、设置断点,运行程序,观察运行结果四、参考程序1. BP算法的matlab实现程序%lr为学习步长,err_goal期望误差最小值,max_epoch训练的最大次数,隐层和输出层初值为零lr=0.05;err_goal=0.0001;max_epoch=10000;a=0.9;Oi=0;Ok=0;%两组训练集和目标值X=[1 1;-1 -1;1 1];T=[1 1;1 1];%初始化wki,wij(M为输入节点j的数量;q为隐层节点i的数量;L为输出节点k的数量)[M,N]=size(X);q=8;[L,N]=size(T);wij=rand(q,M);wki=rand(L,q);wij0=zeros(size(wij));wki0=zeros(size(wki));for epoch=1:max_epoch%计算隐层各神经元输出NETi=wij*X;for j=1:Nfor i=1:qOi(i,j)=2/(1+exp(-NETi(i,j)))-1;endend%计算输出层各神经元输出NETk=wki*Oi;for i=1:Nfor k=1:LOk(k,i)=2/(1+exp(-NETk(k,i)))-1;endend%计算误差函数E=((T-Ok)'*(T-Ok))/2;if (E<err_goal)break;end%调整输出层加权系数deltak=Ok.*(1-Ok).*(T-Ok);w=wki;wki=wki+lr*deltak*Oi';wki0=w;%调整隐层加权系数deltai=Oi.*(1-Oi).*(deltak'*wki)';w=wij;wij=wij+lr*deltai*X';wij0=w;endepoch %显示计算次数%根据训练好的wki,wij和给定的输入计算输出X1=X;%计算隐层各神经元的输出NETi=wij*X1;for j=1:Nfor i=1:qOi(i,j)=2/(1+exp(-NETi(i,j)))-1;endend%计算输出层各神经元的输出NETk=wki*Oi;for i=1:Nfor k=1:LOk(k,i)=2/(1+exp(-NETk(k,i)))-1;endendOk %显示网络输出层的输出2、BP逼近任意函数算法的matlab实现程序⏹X=-4:0.08:4;⏹T=1.1*(1-X+2*X.^2).*exp(-X.^2./2);⏹net=newff(minmax(X),[20,1],{'tansig','purelin'});⏹net.trainParam.epochs=15000;⏹net.trainParam.goal=0.001;⏹net=train(net,X,T);⏹X1=-1:0.01:1;⏹y=sim(net,X1);⏹figure;⏹plot(X1,y,'-r',X,T,':b','LineWidth',2);3.RBF能够逼近任意的非线性函数⏹X=-4:0.08:4;⏹T=1.1*(1-X+2*X.^2).*exp(-X.^2./2);⏹net=newrb(X,T,0.002,1);⏹X1=-1:0.01:1;⏹y=sim(net,X1);⏹figure;⏹plot(X1,y,'-r',X,T,':b','LineWidth',3);五、思考题1. 将结果用图画出。

人工智能实验报告-BP神经网络算法的简单实现

⼈⼯智能实验报告-BP神经⽹络算法的简单实现⼈⼯神经⽹络是⼀种模仿⼈脑结构及其功能的信息处理系统,能提⾼⼈们对信息处理的智能化⽔平。

它是⼀门新兴的边缘和交叉学科,它在理论、模型、算法等⽅⾯⽐起以前有了较⼤的发展,但⾄今⽆根本性的突破,还有很多空⽩点需要努⼒探索和研究。

1⼈⼯神经⽹络研究背景神经⽹络的研究包括神经⽹络基本理论、⽹络学习算法、⽹络模型以及⽹络应⽤等⽅⾯。

其中⽐较热门的⼀个课题就是神经⽹络学习算法的研究。

近年来⼰研究出许多与神经⽹络模型相对应的神经⽹络学习算法,这些算法⼤致可以分为三类:有监督学习、⽆监督学习和增强学习。

在理论上和实际应⽤中都⽐较成熟的算法有以下三种:(1) 误差反向传播算法(Back Propagation,简称BP 算法);(2) 模拟退⽕算法;(3) 竞争学习算法。

⽬前为⽌,在训练多层前向神经⽹络的算法中,BP 算法是最有影响的算法之⼀。

但这种算法存在不少缺点,诸如收敛速度⽐较慢,或者只求得了局部极⼩点等等。

因此,近年来,国外许多专家对⽹络算法进⾏深⼊研究,提出了许多改进的⽅法。

主要有:(1) 增加动量法:在⽹络权值的调整公式中增加⼀动量项,该动量项对某⼀时刻的调整起阻尼作⽤。

它可以在误差曲⾯出现骤然起伏时,减⼩振荡的趋势,提⾼⽹络训练速度;(2) ⾃适应调节学习率:在训练中⾃适应地改变学习率,使其该⼤时增⼤,该⼩时减⼩。

使⽤动态学习率,从⽽加快算法的收敛速度;(3) 引⼊陡度因⼦:为了提⾼BP 算法的收敛速度,在权值调整进⼊误差曲⾯的平坦区时,引⼊陡度因⼦,设法压缩神经元的净输⼊,使权值调整脱离平坦区。

此外,很多国内的学者也做了不少有关⽹络算法改进⽅⾯的研究,并把改进的算法运⽤到实际中,取得了⼀定的成果:(1) 王晓敏等提出了⼀种基于改进的差分进化算法,利⽤差分进化算法的全局寻优能⼒,能够快速地得到BP 神经⽹络的权值,提⾼算法的速度;(2) 董国君等提出了⼀种基于随机退⽕机制的竞争层神经⽹络学习算法,该算法将竞争层神经⽹络的串⾏迭代模式改为随机优化模式,通过采⽤退⽕技术避免⽹络收敛到能量函数的局部极⼩点,从⽽得到全局最优值;(3) 赵青提出⼀种分层遗传算法与BP 算法相结合的前馈神经⽹络学习算法。

基于BP神经网络算法的函数逼近

基于BP神经网络算法的函数逼近神经网络是一种基于生物神经元工作原理构建的计算模型,可以通过学习和调整权重来逼近非线性函数。

其中,基于误差反向传播算法(BP)的神经网络是最常见和广泛应用的一种,其能够通过反向传播来调整网络的权重,从而实现对函数的近似。

BP神经网络的算法包括了前馈和反向传播两个过程。

前馈过程是指输入信号从输入层经过隐藏层传递到输出层的过程,反向传播过程是指将网络输出与实际值进行比较,并根据误差来调整网络权重的过程。

在函数逼近问题中,我们通常将训练集中的输入值作为网络的输入,将对应的目标值作为网络的输出。

然后通过反复调整网络的权重,使得网络的输出逼近目标值。

首先,我们需要设计一个合适的神经网络结构。

对于函数逼近问题,通常使用的是多层前馈神经网络,其中包括了输入层、隐藏层和输出层。

隐藏层的神经元个数和层数可以根据具体问题进行调整,一般情况下,通过试验和调整来确定最优结构。

然后,我们需要确定误差函数。

对于函数逼近问题,最常用的误差函数是均方误差(Mean Squared Error)。

均方误差是输出值与目标值之间差值的平方和的均值。

接下来,我们进行前馈过程,将输入值通过网络传递到输出层,并计算出网络的输出值。

然后,我们计算出网络的输出与目标值之间的误差,并根据误差来调整网络的权重。

反向传播的过程中,我们使用梯度下降法来最小化误差函数,不断地调整权重以优化网络的性能。

最后,我们通过不断训练网络来达到函数逼近的目标。

训练过程中,我们将训练集中的所有样本都输入到网络中,并根据误差调整网络的权重。

通过反复训练,网络逐渐优化,输出值逼近目标值。

需要注意的是,在进行函数逼近时,我们需要将训练集和测试集分开。

训练集用于训练网络,测试集用于评估网络的性能。

如果训练集和测试集中的样本有重叠,网络可能会出现过拟合现象,导致在测试集上的性能下降。

在神经网络的函数逼近中,还有一些注意事项。

首先是选择适当的激活函数,激活函数能够在网络中引入非线性,使网络能够逼近任意函数。

BP神经网络试验报告

BP神经网络实验报告一、实验目的1、熟悉MATLAB中神经网络工具箱的使用方法;2、通过在MATLAB下面编程实现BP网络逼近标准正弦函数,来加深对BP网络的了解和认识,理解信号的正向传播和误差的反向传递过程。

二、实验原理由于传统的感知器和线性神经网络有自身无法克服的缺陷,它们都不能解决线性不可分问题,因此在实际应用过程中受到了限制。

而BP网络却拥有良好的繁泛化能力、容错能力以及非线性映射能力。

因此成为应用最为广泛的一种神经网络。

BP算法的基本思想是把学习过程分为两个阶段:第一阶段是信号的正向传播过程;输入信息通过输入层、隐层逐层处理并计算每个单元的实际输出值;第二阶段是误差的反向传递过程;若在输入层未能得到期望的输出值,则逐层递归的计算实际输出和期望输出的差值(即误差),以便根据此差值调节权值。

这种过程不断迭代,最后使得信号误差达到允许或规定的范围之内。

正向传播.u I I L I LJ I J I . I I L.I I.J I I . I L I I.J I I I £ I LJ LJ I SI L I L I kJ I I I BJ LJ 1.1 I I I L J I. J I I U I LJ kJ I .1 输入层的片用输船层基于BP算法的多层前馈型网络模型的拓扑结构如上图所示。

BP算法的数学描述:三层BP前馈网络的数学模型如上图所示。

三层前馈网中,输入向量为:X = (% 1, % 2,…,% ,..., x )T ;隐层输入向量为:Y = (y/y 2,..., y .,... y )T ;输出层输出向量 为:O = (o 1,o 2,...,4,…。

.)「期望输出向量为:d = (d 1,d 2,…d 『…dy 。

输入层到隐层之间的 权值矩阵用V 表示,V = (v , v ,…v ,...v ) Y ,其中列向量v 为隐层第j 个神经元对应的权向量; 1 2 j m j隐层到输出层之间的权值矩阵用W 表示,W =(叱,叱,…乜,…%),其中列向量乜为输出层第k 个神经元对应的权向量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

应用BP神经网络逼近非线性函一、实验要求1、逼近的非线性函数选取为y=sin(x1)+cos(x2),其中有两个自变量即x1,x2,一个因变量即y。

2、逼近误差<5%,即:应用测试数据对网络进行测试时,神经网络的输出与期望值的最大误差的绝对值小于期望值的5%。

3、学习方法为经典的BP算法或改进形式的BP算法,鼓励采用改进形式的BP算法。

4、不允许采用matlab中现有的关于神经网络建立、学习、仿真的任何函数及命令。

二、实验基本原理2.1 神经网络概述BP神经网络是一种多层前馈神经网络,该网络的主要特点是信号前向传播,误差反向传播。

在前向传递中,输入信号从输入层经隐含层逐层处理,直至输出层。

每一层的神经元状态只影响下一层神经元状态。

如果输出层得不到期望输出,则转入反向传播,根据预判误差调整网络权值和阈值,从而使BP神经网络预测输出不断逼近期望输出。

BP神经网络的拓扑结构如图所示。

2.2 BP神经网络训练步骤BP神经网络预测前首先要训练网络,通过训练使网络具有联想记忆和预测能力。

BP神经网络的训练过程包括以下几个步骤。

步骤1:网络初始化。

根据系统输入输出序列(X,Y)确定网络输入层节点数n、隐含层节点数l、输出层节点数m,初始化输入层、隐含层和输出层神经元之间的连接权值ωij,ωjk,初始化隐含层阈值a,输出层阈值b,给定学习速率和神经元激励函数。

步骤2:隐含层输出计算。

根据输入变量X,输入层和隐含层间连接权值ωij以及隐含层阈值a,计算隐含层输出H。

j 1(a )nj ij i i H f x ω==-∑ j=1,2,…,l式中,l 为隐含层节点数,f 为隐含层激励函数,该函数有多种形式,一般选取为1(x)1xf e-=+步骤3:输出层输出计算。

根据隐含层输出H ,连接权值ωjk 和阈值b ,计算BP 神经网络预测输出O 。

1lk j jk k j O H b ω==-∑ k=1,2,…,m步骤4:误差计算。

根据网络预测输出O 和期望输出Y ,计算网络预测误差e 。

k k k e Y O =- k=1,2,…,m步骤5:权值更新。

根据网络预测误差e 更新网络连接权值ωij ,ωjk1(1)x(i)mij ij j j jk k k H H e ωωηω==+-∑ i=1,2,…,n j=1,2,…,ljk jk j k H e ωωη=+ j=1,2,…,l k=1,2,…,m步骤6:阈值更新。

根据网络预测误差e 更新网络节点阈值a ,b 。

1(1)mj j j j jk k k a a H H e ηω==+-∑ j=1,2,…,lk k k b b e =+ k=1,2,…,m步骤7:判断算法迭代是否结束,若没有结束,返回步骤2。

2.3 附加动量法经典BP 神经网络采用梯度修正法作为权值和阈值的学习算法,从网络预测误差的负梯度方向修正权值和阈值,没有考虑以前经验的积累,学习过程收敛缓慢。

对于这个问题,可以采用附加动量法来解决,带附加动量的算法学习公式为[](k)(k 1)(k)a (k 1)(k 2)ωωωωω=-+∆+---式中,ω(k),ω(k-1),ω(k-2)分别为k ,k-1,k-2时刻的权值;a 为动量学习率,一般取值为0.95。

2.4 程序流程图三、程序简述本次实验选择逼近的非线性函数为y=sin(x1)+cos(x2)。

程序首先创建用于神将网路训练的样本数据,取在区间[-4.5,4.5]之间均匀分布的数值,由于有两个自变量,所以一共产生361组输入输出数据。

其次确定神经网络的训练参数,比如隐含层节点数、学习速率、学习目标、隐含层和输出层的权值阈值等,其中隐含层节点数在参考相关资料后确定为9,这样不仅在训练结束后可以获得较小的误差,而且也不会使训练次数过大从而耗时较长;程序中隐含层和输出层的权值阈值是采取随机产生的方法获得的,并且之后的修改方法采用了附加动量法,减少训练次数加快网络收敛。

由于matlab可以采用矩阵运算的形式,所以输入输出数据和网络权值阈值构建生成相应的矩阵,这样可以在全部数据遍历一次之后再进行权值阈值修改,同样可以缩短网络训练时间。

最后,根据修正后的权值阈值就输入数据预测网路输出,和期望输出数据进行比较,计算输出误差,直至训练结束根据训练结果画出相应图像。

最初程序中神经网络训练只有当最大预测误差小于5%之后才停止,实际情况中,当输出接近0时只要有微小的变化就会产生较大的误差,这样不仅导致网络训练次数增加耗时长,还会使网络收敛速度变慢;在经过查询相关资料之后,训练结束条件除了最大预测误差小于5%之外,还增加了目标函数,目标函数是取所有误差的平方和,当目标函数的计算值小于预期目标时同样也会停止训练,此时默认训练已达目标。

在实际检验过程中发现,加入目标函数后不仅可以有效地改善收敛速度慢耗时长的问题,同时各个坐标点的预测误差也在期望值之内,达到了实验要求。

四、实验结果由于程序中权值阈值的取值是随机的,所以取其中一次的结果展示。

最大训练次数为15329,训练结束后的最大误差为2.5331。

图1 非线性函数图像图2 网络图图3 误差曲线程序:clcclear%创建输入数据,产生361组输入输出数据row = 1;for i=-4.5:0.5:4.5for j=-4.5:0.5:4.5input(row,1) = i;input(row,2) = j;output(row,1) = sin(input(row,1)) + cos(input(row,2));row = row+1;endend%神经网络结构inputnum = 2; %输入层节点数hiddennum = 9; %隐含层节点数outputnum = 1; %输出层节点数%网络参数learnSpeed = 0.0003; %学习率learnGoal = 0.05; %目标%隐含层及输出层的权值和阈值w1 = 0.2*rand(hiddennum,inputnum)-0.1;b1 = 0.2*rand(hiddennum,1)-0.1;w2 = 0.2*rand(outputnum,hiddennum)-0.1;b2 = 0.2*rand(outputnum,1)-0.1;%取训练数据和预测数据%采用全部样本遍历一次后再进行权值阈值调整%调整采用附加动量法,加快收敛速度,减少遍历次数input_train = [input ones(361,1)]';output_train = output;HH = [w1 b1];OO = [w2 b2];collectHH = [];collectOO = [];%用训练数据训练BP神经网络aimJ = 0;max_rate=100; %初始化最大样本误差trainNum = 0; %初始化训练次数while(max_rate>learnGoal)collectHiddenOut = logsig(HH*input_train); %计算隐含层输出hiddenOut = [collectHiddenOut' ones(361,1)]';networkOut = OO*hiddenOut; %计算网络输出error = output_train-networkOut'; %计算误差%利用目标函数,判断是否结束循环aimJ = sumsqr(error)if (aimJ<learnGoal)break;end%统计训练次数trainNum = trainNum+1;%权值阈值调整因子factor2 = error';factor1 = w2'*factor2.*collectHiddenOut.*(1-collectHiddenOut);%调整权值和阈值调节量dHH = factor1*input_train';dOO = factor2*hiddenOut';%权值阈值调整if (trainNum<3)HH = HH + learnSpeed*dHH;OO = OO + learnSpeed*dOO;collectHH = [collectHH HH];collectOO = [collectOO OO];w1 = HH(:,1:inputnum);b1 = HH(:,1+inputnum);w2 = OO(:,1:hiddennum);b2 = OO(:,1+hiddennum);else%附加动量法HH = HH + learnSpeed*dHH + 0.94*(collectHH(:,((trainNum-2)*3+1):((trainNum-2)*3+3))-collectHH(:,((trainNum-3)*3+1):((trainNum-3)*3+3)));OO = OO + learnSpeed*dOO + 0.94*(collectOO(1,((trainNum-2)*10+1):((trainNum-2)*10+10))-collectOO(1,((train Num-3)*10+1):((trainNum-3)*10+10)));collectHH = [collectHH HH];collectOO = [collectOO OO];w1 = HH(:,1:inputnum);b1 = HH(:,1+inputnum);w2 = OO(:,1:hiddennum);b2 = OO(:,1+hiddennum);end%训练数据测试,计算最大误差率hiddenOut_test = logsig(HH*input_train); %参数修改后的隐含层输出network_test = w2*hiddenOut_test+repmat(b2,1,361); %预测结果rate = (output_train-network_test')./output_train; %误差率max_rate = max(abs(rate)); %误差率最大值end%显示测试结果%标准函数图像y=sin(x1)+cos(x2)[x,y] = meshgrid(-4.5:0.1:4.5,-4.5:0.1:4.5);z = sin(x)+cos(y);figure(1)mesh(x,y,z)xlabel('x1');ylabel('x2');zlabel('y');%网络图t1=linspace(min(input(:,1)),max(input(:,1)));t2=linspace(min(input(:,2)),max(input(:,2)));[X,Y]=meshgrid(t1,t2);Z=griddata(input(:,1),input(:,2),network_test',X,Y); figure(2)mesh(X,Y,Z)xlabel('Input1');ylabel('Input2');zlabel('Output');%绘制误差曲线t3=linspace(min(input(:,1)),max(input(:,1)));t4=linspace(min(input(:,2)),max(input(:,2)));[X1,X2]=meshgrid(t3,t4);E=griddata(input(:,1),input(:,2),error,X1,X2); figure(3)mesh(X1,X2,E)xlabel('Input1');ylabel('Input2');zlabel('error');。