存储器的文献综述

存储器的发展史范文

存储器的发展史范文

存储器的概念和应用始于最早的计算机系统,因为它可以暂存数据,

从而使计算机系统能够更高效率地运行。

它一般可以分为RAM(随机存取

存储器)和ROM(只读存储器)两类。

随着计算机技术的发展,存储器也

在不断地发展和进步,分别出现了各种功能性不同的新型存储器。

20世纪五六十年代,随着计算机技术的快速发展,计算机存储器也

有了显著进步。

最早的存储系统是由磁弹簧,开关,槽,插槽和扩展的读

写头组成。

磁弹簧存储系统是由磁性材料来存储数据的,其存储容量较小,但读写速度较快,能够满足当时基本的计算机系统的需求。

1960年代,随着集成电路技术的出现,有了更多的改进,计算机存

储器的技术也取得了长足的进步。

在这一时期,一种称为“磁头”的新类

型存储器出现了,它使用的是磁性磁道存储数据。

磁头存储器具有较大的

容量,速度快,便于操作等特点,被广泛应用在主机和计算机系统中。

1970年,随着大规模集成电路的发展,计算机存储器又有了新的技

术变革。

在这一时期,由半导体技术推动的,“半导体存储器”应运而生。

多层次存储器综述

多层次存储器原理综述储存器是数据的仓库,在计算机系统的日常工作中负责存储程序和数据,对于计算机系统来说,存储器就是器记忆中枢,一切的数据交流都需要使用到存储器。

纵观存储器的发展历史,从最开始的打孔纸带到后面的磁表面材料,再到现代的半导体材料,存储器大致经历了三个历史发展阶段。

存储器种类繁多,从其使用的存储介质上可分为半导体存储器和磁表面存储器。

从其使用的存储方式可分为随机存储器和顺序存储器,从其存储的内容是否可变可分为只读存储器和随机读写存储器,从其信息易失性可分为易失性存储器和非易失性存储器,按其在系统中的作用可分为主存储器、高速存储器、铺助存储器和控制存储器。

不同的存储介质一、半导体存储器半导体存储器(semi-conductor memory)是一种以半导体电路作为存媒体的存储器,内存储器就是由称为存储器芯片的半导体集成电路组成。

主要用作高速缓冲存储器、主存储器、只读存储器、堆栈存储器等。

半导体存储器又可细分为如下几种类型:1.PROM,称之为可编程存储器。

2.EPROM,称之为紫外线擦除的可编程只读存储器。

它里面的内容写上去之后,如果觉得不满意,可以用紫外线照射,把字去掉,然后再重写。

这种芯片可以擦除的次数是有限的——几百次吧,它的数据可保持 10 年左右。

3.EEPROM即电可擦除可编程只读存储器,它的突出优点是在线擦除和改写,它既具有ROM的非易失性的优点,又能像RAM一样随机的读写,在单片机系统中EEPROM既可以扩展为片外ROM,又可以扩展为片外RAM.因此,在单片机系统中应用比较广泛。

4.FLASH,称之为闪速存储器,FLASH存储器是在EPROM工艺的基础上,增加了芯片的电擦除和再编程功能且速度快,从而是它成为性价比和可靠性最高的可读写,非易失存储器,它的寿命也很长(几万到几十万次不等)。

由于flash的引脚占用较多,存储数据量大,读写的速度快,因此现在主要应用在 ARM 或 DSP 等。

文献综述(Oracle存储过程原理及应用

毕业设计(论文)文献综述题目Oracle存储过程原理及应用专业计算机科学与技术班级07级计科1 班学生宋龙指导教师王家伟重庆交通大学2011年ORACLE存储过程原理及应用摘要计算机技术的飞速发展,推动了整个社会的信息化进程,促进了信息技术的进步,催生了量的信息系统,尤其是各种管理软件。

而管理软件离不开对大量数据的处理,这就要依赖于数据库管理系统。

Oracle 是当前世界上使用最为广泛的数据库管理系统之一,由于Oracle 拥有强大的数据管理能力和较好的数据保密性,以及出众的技术优势。

Oracle 得到了大规模的应用,它经常作为大型管理软件的后台数据库。

程序可以通过相应的软件接口对数据库进行操作,因为大型系统的业务规则一般都比较复杂,需要进行多个库表的操作,逻辑比较复杂,如果单纯使用SQL 语句进行数据库操作,应用程序代码会非常冗长,网络传输的负担会加重,系统响应速度也较慢,一旦业务规则发生变化,需要进行大量的代码修改工作,尤其是对于非常复杂的数据库操作,作量会成倍增长,与此相应的系统调试的工作量也很大。

这非常不利于系统的维护和使用,同时造成了系统客户端的工作量的加大,而服务器强大的处理能力又被闲置。

针对这种弊端,几乎所有的大型系统都使用存储过程来进行数据库操作。

采用这种数据库操作模式,可以把应用程序和数据库操作相对独立开来,分别管理。

关键字:信息技术, Oracle, 数据管理, 存储过程, 数据保密, 数据库, 数据库技术, 数据库系统引言在Oracle 中,复杂的业务规则和应用逻辑可作为过程(procedure)存储。

存储过程是一组SQL 和PL/SQL 语句,它允许我们把加强业务规则的代码从应用移动到数据库中。

结果是,代码只存储了一次,却可以被多个应用使用。

因为Oracle 支持存储过程,应用中的代码可以变得更紧凑一致和更易于维护。

使用存储过程可以极大地提高数据访问效率,提升整个应用系统的性能。

基于web的网络存储服务系统的设计与实现【文献综述】

毕业设计文献综述计算机科学与技术基于web的网络存储服务系统的设计与实现一、前言部分写作目的:随着电子技术与网络的发展人们无须带着厚重的公文包到处走动,网络存储(网络硬盘)的出现使大家的文件保存处理运用更加方面简易。

为了更容易在朋友同事同学之间分享信息,为了更好的管理你的文件,网络存储是不二的选择。

有关概念、综述范围:(一)什么是网络存储[1]:存储(Storage)这个词汇,受限于传统的“存储”词义制约,容易被误解为被动的数据保存。

实质上,今天的IT用户和专家们都一致认同如下的概念:(1)存储系统是应用系统的基础框架(infrastructure)。

只是奠定了高度可管理、可扩展、兼容何种主机平台、安全、保证数据访问性能、满足多种数据使用要求的存储系统。

(2)存储系统在整个信息生命周期中,即数据的创建、保护、存取、迁移、存档、处置的整个过程中,扮演这管理调度的核心角色。

企业IT应用越深入,对存储系统的数据管理能力和功能的依赖性越强。

(3)网络存储的主要形式就是DAS、NAS和SAN[2]。

(1)DAS(Direct Attached Storage,直接连接存储)将磁盘阵列、磁带库等数据存储设备通过扩展接口直接连接到服务器或客户端。

DAS 以服务器为中心,不带有存储操作系统,即存储设备是服务器的一部分,I/O 请求将直接发送到存储设备。

DAS 方式实施比较简单,成本低,见效快。

但是存储管理工作比较繁琐,容量不能再分配,性能、扩充性较差。

因此该技术已经不能适应当今的存储要求。

NAS(Network Attached Storage ———网络连接存储)即将存储设备通过标准的网络拓扑结构(例如以太网) ,连接到一群计算机上,提供数据和文件服务。

(2)NAS 是一种专业的网络文件存储及文件备份设备,或称为网络直连存储设备、网络磁盘阵列。

一个NAS 里面包括核心处理器、文件服务管理工具、一个或者多个硬盘驱动器用于数据的存储。

存储器输入输出访问论文中英文资料对照外文翻译文献综述

存储器输入输出访问中英文资料对照外文翻译文献综述附录A:英文资料Input/Output AccessingIn this article, we will look at the three basic methods of I/O accessing -programmed I/O, interrupt-driven I/O, and direct memory access (DMA). The key issue that distinguishes these three methods is how deeply the processor is involved in I/O operations. The discussion emphasizes interrupt-driven I/O, because it is based on the concept of interrupt handling, which is a general problem that goes beyond Input/Output operations. The study of interrupt handling also aids in understanding the general concept of exception processing, which is an important issue not only for I/O, but also for interfacing a computer with other system control functions.Addressing I/O RegistersInput/Output devices communicate with a processor through Input/Output ports. Through the input ports, s processor receives data from the I/O devices. Through the output ports, a processor sends data to the I/O devices. Each I/O port consists of a small set of registers, such as data buffer registers (the input buffer and/or the output buffer), the status register, and the control register. The processor must have some means to address these registers while communicating with them. There are two common methods of addressing I/O register -memory-mapped I/O and direct I/O.1. Memory-Mapped I/OMemory-mapped I/O maps the I/O registers and main memory into a unified address space in the computer system. I/O registers share the same address space with main memory, but are mapped to a specific section that is reserved just for I/O. Thus, the I/O register can be addressed in ordinary memory reference instructions as if they are part of the main memory locations. There are no specially designed I/O instructions in the instruction set of the system. Any instruction that references a location in this area is an I/O instruction. Any instruction that can specify a memory address is capable of performing I/O operations. The Motorola MC68000 is an example of a computer system that uses this addressing method.2. Direct I/OThe method of addressing I/O registers directly without sharing the address space with the main memory is called direct I/O or I/O-mapped I/O. In other words, I/O registers are not mapped to the same address space with the main memory. Each I/O register has an independent address space. As a result, instructions that reference the main memory space cannot be used for Input/Output. In the instruction set of the computer system, special I/O instructions must be designed for I/O operations. In these I/O instructions, distinct I.D. numbers must be used to address different I/O communication channels (i.e., I/O ports). They are called port numbers. The I/O registers of an I/O port are connected to the system I/O bus, through which the processor can reference the I/O registers directly to send/receive data to/from an I/O device. An I/O port number is not from the same address space as main memory. The Pentium is an example of a computer system that uses the direct I/O addressing method. It has a 64 GB memory address space (32 address bits) and, at the same time, a 64 KB I/O address space (16 bits I/O address/port number).We can compare memory-mapped I/O and the direct I/O and the direct I/O as follows:●Memory-mapped I/O uses ordinary memory reference instructions to access I/O, so it provides flexibility for I/O programming and simplifies I/O software. Direct I/O does not provide any flexibility in I/O programming, since only a small set of special I/O instructions are allowed to reference I/O registers.●for memory-mapped I/O, the processor uses the same address lines to access all the addressable I/O registers and the same data lines to send/receive data to/form these registers. This simplifies the connection between I/O port and the processor, and thus leads to a low-cost hardware design and implementation. For direct I/O, the connection between I/O ports and the processor may be more expensive. This is because either (1) special hardware is needed to implement separate I/O address lines or (2) when memory address lines are used for I/O; a special flag is needed, indicating that the requested address is for an I/O operation.●In spite of the advantage of using ordinary memory reference instructions to access I/O registers, memory-mapped I/O may complicate the control unit design in regards to the implementation of I/O-related instructions. This is because usually the I/O bus cycles need to be longer than the equivalent memory bus cycles, and this means that the design of different timing control logic is required. This can be used to explain why memory-mapped I/O benefits programmers, but not electronics engineers.●Direct I/O addressing has another advantage over memory-mapped I/O in that low-level debugging on a differentiated addressing system may be easier, because break-points or error traps can be imposed more generally.●with memory-mapped I/O, I/O registers share the same address space with main memory; hence, the memory space available for programs and data is reduced. For direct I/O addressing, I/O does not share memory space with main memory, and a single contiguous memory space can be maintained and used by programmers.Programmed I/OProgrammed I/O requires that all data transfer operations be put under the complete control of the processor when executing programs. It is sometimes called polling, because the program repeatedly polls (checks) the status flag of an I/O device, so that its input/output operation can be synchronized with the processor. A general flowchart of such a program is shown in Figure 1. The program continuously polls the status of an I/O device to find out whether (1) data is available in the input buffer or (2) the output device is ready for receiving data from the processor. If the status shows “available” the program will execute a data transfer instruction to complete the I/O operation; otherwise, the busy status of the I/O device will force the program to circulate in a busy-waiting loop until the status becomes available. Such a busy-waiting loop, which continuously checks the status of data availability (for input) or device availability (for out-put), forms the typical program structure of programmed I/O. It is this time-consuming busy-waiting loop that wastes processor time and makes programmed I/O very inefficient. The processor must be involved continuously in the entire I/O process. During this time interval, the processor cannot perform any useful computation, but only serve a single I/O device. For certain slow I/O devices, this busy-waiting loop interval may be long enough that the processor could execute millions of instructions before the I/O event occurs, e.g., a key stroke on a keyboard.The operational mode lf programmed I/O stated above is characterized by the busy waiting loop of the program, during which the processor spends time polling an I/O device. Because of the dedication of the processor to a single task, this mode of programmed I/O is called dedicated polling or spin polling. Although dedicated polling is highly inefficient, sometimes it is necessary and even unavoidable. In a particular case, if an urgent event needs an immediate response without delay, then dedicated polling by a dedicated processor may be the best way to handle it. Once the expected event happens, the processor can tract to it immediately. For example, certain real time systems (e.g., radar echo processing systems) require a reaction to incoming data that is so quick that even an interrupt response is too slow. Under such a circumstance, only a fast dedicated polling loop may suffice.Another mode of operation of programmed I/O is called intermittent polling or timed polling. In this mode, the processor may poll the device at a regular timed interval, which can be expectedor prescheduled. Such a device can be found in many embedded systems where a special-purpose computer is used for process control, data acquisition, environmental monitoring, traffic counting, etc. these devices, which measure, collect, or record data, are usually polled periodically in a regular schedule determined by the needs of the application. Such a method of intermittent polling can help save time lost in spin polling and avoid the complexity of interrupt processing. However, it should be noted that intermittent polling may not be applicable in some special cases, in which there is only one device to be polled and the correct polling rate must be achieved with the assistance of an interrupt-driven clock. Using timed polling in this case would result in simply swapping one interrupt-driven clock. Using time polling in this case would result in simply swapping one interrupt requirement for another.Interrupt-Driven I/OInterrupt-driven I/O is a means to avoid the inefficient busy-waiting loops, which characterize programmed I/O. Instead of waiting while the I/O device is busy doing its job of input/output, the processor can run other programs. When the I/O device completes its job and its status becomes “available”, it will issue an interrupt request to the processor, asking for CPU service. In response, the processor suspends whatever it is currently doing, in order to attend to the needs of that I/O device.In respond to an interrupt request, the processor will first save the contents of both the program counter and the status register for the running program, and then transfer the control to the corresponding interrupt service routine to perform the required data input/output operation. When the interrupt service routine has completed its execution and if no more interrupt requests are pending, the processor will resume the execution of the previously interrupted program and restore the contents of the statuses and program counter. The processor hardware should check the interrupt request signal upon completion of execution of every instruction. If multiple devices issue their interrupt requests at the same time, the processor must use some method to choose which one to service first, and then service all the other interrupt requests one by one by order of priority. Only after all the interrupt requests have been serviced will the CPU return to the interrupted user program. In this way, the processor can serve many I/O devices concurrently and spend more time doing useful jobs, rather than running a busy-waiting loop to serve a single device. Therefore, interrupt I/O is very effective in handling slow and medium-speed I/O devices. Furthermore, the concept of an interrupt can be generalized to handle any event caused by hardware or software, internally or externally. This general problem is referred to as exception processing.If multiple interrupt requests are issued by different devices at the same time, the processor should have some means to identify the interrupt sources and handle their interrupt requests by some policy, typically by priority. Only one request with the highest priority can be serviced at the current time, while all others are put into a waiting queue. Upon the completion of the service performed by an interrupt service routine, the processor should search the waiting queue for all the pending interrupt requests, old or new, and continue to service them one by one according to their priorities, until the queue becomes empty. Only when all the pending interrupt requests have been serviced can the interrupted user program be resumed. Although this case contains multiple interrupt requests, it is still a simplified case. The assumption is that all the interrupt service routines must be completed without further interruption 9 (or so-called preemption) once they have been started one after another by the processor. An interrupt process satisfying this assumption is called a non-preemptive interrupt. In real-life circumstances, the process of interrupt-driven I/O can be more complicated than this simplified case. Each interrupted service routine running in the processor can be preempted (interrupted) by a newly arrived interrupt request, which has a higher priority than the current one. This circumstance will cause the main program and all the requested interrupt service routines to have a complicated interrelationship. An interrupt process that allows an interrupt service routine to be preempted by a higher-priority interrupt service routine is called a preemptive interrupt.Direct Memory AccessAlthough interrupt I/O is more efficient than the programmed I/O, it still suffers from a relatively high overhead with respect to handling the interrupt. This overhead includes resolving the conflict among multiple interrupt requests, saving and restoring the program contexts, pooling for interrupt identification, branching to/from the interrupt service routine, etc. Using an interrupt is a wasteful activity that can take several microseconds to complete.Direct memory access(DMA) is a method that can input/output a block of data directly to/form main memory with a speed of one data item per memory cycle, without continuous involvement of the processor. The entire process is implemented by the hardware of a DMA controller, which takes the place of the processor and communicates directly with main memory. As a result, the block diagram of the computer system changes form processor-centered to memory-centered. Hence, from the viewpoint of I/O processing, the processor is no longer the center of a computer, but rather a partner with which the I/O subsystem competes for memory bus cycles to input/output data item to/from main memory. However, a DMA controller is designed to exchange data in blocks, so it works well with the large-volume high-speed block-oriented I/Odevices, such as high-speed disks and communication networks.The DMA controller can work in two different modes. Normally, it works concurrently with the processor, competing for individual memory bus cycles to input/output successive words of a data block. If the I/O speed is not very high, the memory accesses by the processor and the DMA controller can be interwoven. Time is accrued on a cycle-by-cycle basis. Neither the processor nor the DMA controller can continuously use all the memory bus cycles during any time interval. This operational mode of the DMA controller is called cycle stealing, so named because the I/O subsystem is essentially “stealing” memory bus cycles from the processor. This mode integrates the DMA memory accesses into CPU activity and avoids serious disruption of the main processing. Alternatively, for even higher I/O transfer speed, DMA operations require bus time, which can be allocated in block of cycles known as bursts. During a burst of memory cycles, the processor is totally excluded from accessing memory. The DMA controller is given exclusive access to main memory and continuously inputs/outputs blocks of data at a speed comparable to the memory speed. This operational mode of the DMA controller is called the block or burst mode. A DMA controller designed for this mode of operation usually incorporates a data storage buffer with a capacity matching the size of at least one data block. When the DMA controller utilizes the memory bus, it can transfer a data block directly between its data storage buffer and main memory.The following registers are necessary for the DMA to transfer a block of data:● Data buffer register (DBR)-it can be implemented as two registers, one for inputand the other for output, or even a set of registers comprising a data storage buffer.● DMA address register (DAR)-used to store the starting address of the memorybuffer area where the block of data is to be read or written.● Word counter (WC)-the contents specify the number of words in the block of dataremaining to be transferred and it is automatically decremented after each word is transferred.● Control/status register (CSR)-used by the processor to send control information tothe DMA controller and to collect the statuses and error information of the DMA controller and the I/O devices attached to it.Using these registers, the DMA controller knows the addresses of the source and destination data blocks, as well as the quantity of data to be transferred. Once the DMA controller acquires the memory bus, the block transfer operation can be performed autonomously using the information contained in these registers, without the continuous involvement of the processor.Besides the above-listed registers, the DMA controller should contain the control logic of a bus request facility, which performs bus arbitration using the signals of DMA request (DMAR)and DMA acknowledge (DMAA). Bus arbitration is the process of resolving the contention among multiple concurrently operating DMA controllers for acquisition of the memory bus. The selection of the bus master is usually based on the priorities of various DMD devices. Among different DMA devices, the priority order are arranged by the degree urgency of the devices receiving the DMA service, i.e., according to their speed requirements. There are two approaches to bus arbitration for DMA devices -centralized and distributed -which are similar to the approaches used to identify interrupt sources using signals for interrupt request (INTR) and interrupt acknowledge (INTA).Although the transfer of the data block is performed by the DMA without involvement of the processor, the overall operation of the DMA controller is still determined by the CPU via interrupts. It serves two purposes as follows: (1) Before the DMA controller starts the data transfer, all the registers must be initialized by the processor. (2) When the DMA finishes a block transfer operation, it should inform the processor of completion by issuing an interrupt, which allows the processor to post-process the data in the memory buffer area or handle possible error conditions. Therefore, the DMA controller often issued interrupt request (INTR) and receives interrupt acknowledge (INTA) signals.DNA relieves the processor form the burden of I/O function, except for the initialization of the transfer of parameters and the post-processing of data. It is very efficient when serving high-speed I/O devices. However, the role of DMA is not limited to the area of input/output. In contemporary computer systems, DMA has been developed into a general technique of time-sharing the main memory bandwidth between I/O subsystem processing and CPU processing. In the I/O subsystem, high-speed I/O devices, such as disks, CD-ROMs, DVDs, graphics, video equipment, and high-speed networks, want to share main memory bandwidth through the DMA. In the area of central processing and the main memory system, (1) running programs, (2) the operating system, and (3) dynamic RAM refreshing are all sharing the main memory bandwidth, DMA is the appropriate way to implement this time-sharing. Faster 16-bit Ultra DMA has now replaced the outdated 8-bit facilities. Commercially available DMA controller chips now offer multiple channels, allowing concurrent data transfer. For example, one channel can be reserved for DRAM refreshing; another channel can perform memory-to memory block moves, etc. To further free the processor from handling slow tasks, powerful channel processors have been developed with autonomous capabilities, including device polling, channel program execution, interrupt activation and DMA for data and instructions. They have become a growing class of semi-independent co-processors communicating with the main processor. They can be assigned dedicated tasks, such as floating-point calculations, graphic processing, network communication,large database management, etc. The growing bus contention problem, due to time-sharing main memory bandwidth, can be alleviated by more effectively using cache memory. For example, in the Pentium processor, L1 cache allows the CPU pipeline to continue fetching and executing, as long as the demand can be satisfied with instructions held locally in the cache.附录B:英文资料翻译输入/输出访问在这一篇文章中,我们将会研究三种基本的输入/输出访问方法:程控I/O、中断驱动I/O以及直接存储器访问(DMA)。

WinDriver基于PCIE的数据存储卡开发文献综述

---------------------------------------------------------------范文最新推荐------------------------------------------------------ WinDriver基于PCIE的数据存储卡开发+文献综述摘要随着高速采集系统、图像采集系统等测试系统的发展,在测试中产生的大容量数据如何快速传入计算机进行分析处理成为制约系统性能进一步提高及系统功能实现的一个重要环节。

在此背景下,通过研制以DDS产生数据并通过PCI Express计算机总线将数据传入计算机的传输卡,实现将外部数据高速传入计算机。

论文在分析任务及技术指标的基础上,设计了系统总体方案。

在硬件实现部分,介绍了基于PCI Express 总线高速传输过程中的相关技术,对FPGA实现PCI Express总线接口、FPGA实现DMA传输、FPGA进行中断管理等技术进行了详细的讨论;在软件部分,结合系统读取数据过程讨论了利用WinDriver开发设备驱动,并且对驱动程序与应用程序的开发步骤进行了详细的论述。

系统的调试与测试验证了基于PCI1 / 18Express X1接口的传输卡数据传输的可行性和正确性。

8405关键词PCI ExpressFPGAIP核WinDriver毕业设计说明书(论文)外文摘要TitleDevelopment of data storage card based on PCI ExpressAbstractAlong with the development of test systems such as high-speed integrated system,image collection and so on,how to transfer a large amount of data produced in testing process to analyze and process them becomes the key problem that restricts system performance improvement and system function achievement. With this background, high-speed transmission of exterior data into computer is realized by using DDS to generate data and transferring the data into computer through PCI Express computer bus.---------------------------------------------------------------范文最新推荐------------------------------------------------------The general plan of system is designed in this paper on the basis of analyzing task and technical indexes. Correlative techniques in the process of high speed data transmission based on PCI Express bus is introduced in the hardware part. Many technologies such as FPGA achieving PCI Express bus, FPGA achieving DMA transmission, FPGA performing intermitting management and so on are discussed in detail. In software part, using WinDriver to develop device driver are introduced combining the process of reading the data by system, and the steps of develop drivers and applications are discussed in detail. The debugging and testing of the system verify the feasibility and correctness of data transmission based on PCI Express X1 interface.3.6本章小结194驱动程序设计193 / 184.1引言194.2利用WinDriver开发设备驱动19 4.2.1开发工具的选择194.2.2WinDriver工作原理204.3驱动程序与应用程序的开发20 4.3.1生成INF文件和用户函数21 4.3.2安装设备驱动234.3.3应用程序的开发244.4本章小结275系统调试及结果分析275.1调试环境27---------------------------------------------------------------范文最新推荐------------------------------------------------------ 5.1.1硬件系统275.1.2设计软件285.1.3本章内容285.2系统调试过程295.3调试结果与分析315.3.1数据传输速率315.3.2数据传输的完整性325.4本章小结34结论35致谢36参考文献375 / 181绪论1.1课题研究背景I/O总线的发展历程粗略地可划分为三代:第一代总线包括ISA、EISA、MC和VESA。

2024年文献综述范文范例

2024年文献综述在2024年,随着全球数字化趋势的不断推进,文献综述也进一步发展和完善。

文献综述是一种通过收集、搜集、筛选、分析和综合以往研究成果来评价、总结和探讨特定领域研究进展和前沿的方法。

它已经成为科学研究的重要组成部分,对于学术论文、科研项目和决策提供了重要参考。

随着、大数据以及计算机技术的不断发展,文献综述也出现了许多新的变化和特点,其研究内容和方法逐步走向数字化、智能化和综合化的方向。

一、数字化数字化是社会科技发展的重要标志,它对于文献综述的实现具有重要意义。

数字化意味着文献采集、整理、存储、传播和利用从传统的纸质形式转向数字形式,大大提高了处理速度、范围和可靠性。

数字化文献库、文献数据库、文献搜索引擎、文献管理软件等数字化工具,大大方便了文献的检索和利用。

二、智能化智能化是技术不断发展的结果,它增强了文献综述的自动化、智能化和人性化。

智能化文献检索、文献分类、文献排名、文献分析等工具,可以更加精准地定位目标领域和研究问题,提高信息质量和效率。

同时,智能化技术还可以扩大文献综述的范围和深度,挖掘出更多的有用信息和见解。

三、综合化综合化是指文献综述不再是单一学科或单一领域的内容,而是涉及多个学科、多个领域和多个层面的综合性内容。

综合化的文献综述不仅可以扩大研究视野和深度,而且可以更好地反映出人类知识体系和社会发展趋势。

同时,综合化文献综述还可以促进学科交叉和跨界合作,有利于推进科学技术的全面进步和社会进步。

在数字化、智能化和综合化的大趋势下,文献综述正朝着更加精准、高效、全面和人性化的方向快速发展。

未来,我们可以期待在文献综述领域取得更多的突破和创新,为学术发展和社会进步作出更大的贡献。

存储器的文献综述

存储器芯片的使用现状及未来发展趋势文献综述班级:XXX姓名:XXX学号:XXX一、选题背景存储器广泛应用于计算机、消费电子、网络存储、物联网、国家安全等重要领域,是一种重要的、基础性的产品。

当前,伴随着第五代移动通信、物联网和大数据的快速发展,存储器的需求量迅速增加,存储容量、存取速度、功耗、可靠性和使用寿命等指标要求也越来越高。

世界各大企业在这方面出现“百家争鸣、百花齐放"的大好局面,涌现出多种新型存储器,并且工艺水平和性能都在不断提高,给消费者提供了更多的选择空间。

二、相关问题现状研究综述我们一般会将存储器划分为,易失性存储器和非易失性存储器,这种划分是根据断电后数据是否丢失而决定的。

现有技术中,整个存储器芯片行业主要有三种种产品:DRAM、NAND FLASH和NOR FLASH。

DRAM是易失性存储器的代表,NAND Flash和NOR FLASH是非易失性存储器的代表.尽管按照不同的分类特点,可形成存众多种类的储存芯片,但从该行业产业结构分析,上述三种存储器毫无疑问是全球重点厂商最为关注的产品领域。

NAND FLASH和DRAM都是硅基互补金属氧化物半导体器件,在摩尔定律和海量数据存储需求的推动下,不断向大容量、高密度、快速、低功耗、长寿命方向发展.但随着特征尺寸不断减小至接近原子级,传统平面型结构遇到无法跨越的性能障碍,存储器的性能和可靠性达到极限,而且新工艺节点开发成本迅速增加,进一步降低预期收益。

因此,存储器向两大方向转型发展:一是继续沿用硅基材料,用垂直堆叠替代特征尺寸微缩,从平面转向立体结构;二是使用新材料和新结构研制新兴传感器技术。

前者的挑战是开发出可实现8层到32层甚至64层连续堆叠的材料和生产工艺,并保证每一层存储器性电性能的一致可控.后者的挑战是论证开发配套生产工艺,并保证新材料不会对既有生产线造成污染、产品性能优于现有存储器和可长期可靠使用等。

新材料、结构和物理效应方面研究的不断突破,使得其他新兴存储器技术也因此得到发展。

PLC文献综述

PLC文献综述PLC(可编程逻辑控制器)文献综述一、引言可编程逻辑控制器(PLC)是一种广泛应用于工业控制领域的设备,它集计算机技术、通信技术、控制技术和电子技术于一体,具有灵活性强、可靠性高、易于编程和维护等优点。

随着工业4.0和智能制造的快速发展,PLC在自动化生产线、机器人控制、过程控制等领域的应用越来越广泛。

本文将从PLC的定义、发展历程、研究现状和未来趋势等方面对其进行文献综述。

二、PLC的定义和发展历程PLC是一种数字运算操作的电子系统,专为工业环境下的应用而设计。

它采用可编程的存储器,用于在其内部存储执行逻辑运算、顺序控制、计时、计数和算术运算等操作的指令,并通过数字或模拟式输入/输出控制各种类型的机械或生产过程。

PLC的发展历程可以追溯到20世纪60年代,当时美国汽车工业生产线上出现了一种名为“可编程序控制器”的设备,用于控制生产线的运行。

随着计算机技术和微电子技术的发展,PLC的功能不断增强,应用范围也越来越广泛。

目前,PLC 已经成为工业自动化领域的重要组成部分。

三、PLC的研究现状目前,PLC的研究主要集中在以下几个方面:1.PLC的硬件设计:PLC的硬件设计主要包括中央处理器(CPU)、存储器、输入输出模块等。

随着技术的发展,PLC的硬件设计越来越先进,例如采用多核CPU、高速存储器和大容量输入输出模块等,提高了PLC的处理速度和性能。

2.PLC的软件设计:PLC的软件设计主要包括编程语言、编程环境和应用程序等。

目前,PLC的编程语言主要有梯形图(Ladder Diagram)、指令表(Instruction List)、结构化文本(Structured Text)等,编程环境也越来越友好,例如采用图形化编程方式等。

此外,PLC的应用程序也不断丰富,例如实现运动控制、过程控制、网络通信等功能。

3.PLC的通信技术研究:随着工业自动化和信息化的融合,PLC的通信技术研究越来越重要。

文献综述

文献综述存储管理(memory management),即是对存储器的管理。

在计算机系统中,存储器的功能是保存各种信息。

它又分为CPU能直接访问的内存和不能直接访问的外存。

两者物理特性不同,操作系统对它们的管理方式也不同。

内存由顺序编址的块组成;每块包含相应的物理单元。

CPU要通过启动相应的输入/输出设备后才能使外存与内存交换信息。

内存管理方法有:分区式管理、页式管理、段式管理和段页式管理。

内存管理的核心问题是如何解决内存和外存的统一,以及它们之间的数据交换问题。

内存和外存的统一管理使得内存的利用率得到提高,用户程序不再受内存可用区大小的限制。

与此相关联,内存管理要解决内存扩充、内存的分配与回收、虚拟地址到内存物理地址的变换、内存保护与共享、内外存之间数据交换的控制等问题。

内存由大规模集成电路实现,它的发展方向是高速、大容量和小体积。

内存又分为ROM和RAM, ROM为固化只读的。

因此操作系统的存储管理模块管理的是内存中的RAM。

内存可以看作是以字或字节为单位的存储单元组成的数组,每个存储单元都有自己的地址。

内存的作用:存储指令和数据。

程序执行时,先加载到内存。

CPU执行时,从内存取指令,分析指令,如需要从内存取操作数。

执行完毕后,存储运算结果到内存内存扩充:内存的逻辑扩充:即在不改变实际内存容量情况下,借助大容量外存解决内存不足问题内存分配和回收:为运行的进程分配内存空间,并在不需要时回收它们占据的空间。

借助描述内存使用情况的数据结构和相应算法实现。

分区管理分配算法:最先适应(first-fit):第一个满足条件的空闲区;最佳适应(best-fit):满足条件中最小的空闲区,即最“合体”的;最坏适应(worst-fit):满足条件中最大的空闲区。

碎片(fragment)的概念:内部碎片(internal fragment )和外部碎片(external fragment )。

虚拟存储器:在程序装入时,不必将其全部读入到内存,而只需将当前需要执行的部分页或段读入到内存,就可让程序开始执行。

关于分布式存储系统的参考文献

分布式存储系统是一种将数据存储于多个物理位置的系统。

这种系统强调多个存储设备之间的通信和协调,使得用户可以像访问本地存储设备一样访问分布式存储系统。

分布式存储系统具有高可靠性、高性能、高可扩展性等特点,在当今大数据时代,受到了越来越多的关注和应用。

在研究和应用过程中,参考文献是非常重要的,下面是一些关于分布式存储系统的参考文献,供大家参考。

一、关于分布式存储系统概述的参考文献1. Ghemawat, S., Gobioff, H., Leung, S. (2003). The Google file system. ACM SIGOPS Operating Systems Review, 37(5), 29-43.这篇文章介绍了谷歌文件系统,详细分析了分布式存储系统的设计和实现细节。

2. Anderson, D. P. (1980). More is less: a bag of long words for the Compression Project. ACM Transactions on Computer Systems (TOCS), 8(4), 353-374. 本文介绍了一种用于分布式存储系统的数据压缩算法,对系统性能有很好的提升。

二、关于分布式存储系统关键技术的参考文献1. Ousterhout, J. K., et al. (1988). The Sprite network operating system. IEEE Computer, 21(2), 23-36. 该文介绍了一个应用于分布式存储系统中的网络操作系统,对系统的可靠性和性能有很大的提升。

2. DeCandia, G., et al. (2007). Dynamo: Amazon's highly av本人lable key-value store. ACM SIGOPS Operating Systems Review, 41(6), 205-220. 本文介绍了亚马逊的高可用性键值存储系统,对于分布式存储系统的一致性和可靠性有很好的参考价值。

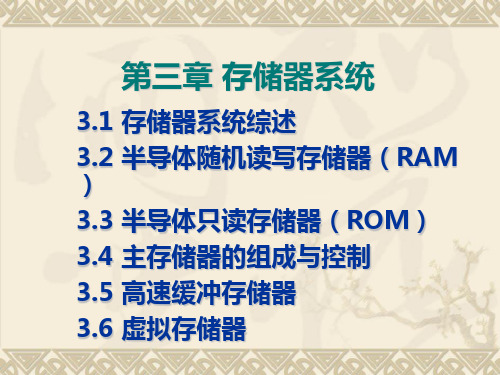

存储器系统综述

一、存储系统的分类

1.按存储介质分类

磁芯存储器 磁芯是使用硬磁材料做成的环状元件,在磁心中穿有驱动线 (通电流)和读出线,这样便可以进行读写操作。 体积庞大、工艺复杂且功耗大,已弃用。

半导体存储器 存储元件由半导体器件组成,存储器用超大规模集成电路工 业制成芯片 优点:体积小,功耗低,存取时间短 缺点:存储容量相对较小,单位存储成本较高。 双极型(TTL)半导体存储器和MOS半导体存储器。后者集成 度高且制造简单、成本低廉、功耗小,目前广泛应用。

“ Cache-主存”与“主存-辅存”层次的区

别

存储层次

比较项目

“Cache -主存”层次

“主存-辅存”层次

目的

为了弥补主存速度的不足 为了弥补主存容量的不足

存储管理实现

主要由专用硬件实现

由硬件和软件实现

访问速度的比值 (第一级和第二级)

典型的块(页)大小

CPU对第二级的 访问方式

失效时CPU是否切换

磁表面存储器 在金属或塑料基体的表面涂上一层磁性材料作为记录介质。 按载磁体形状的不同,分为磁盘、磁带和磁鼓。

光盘存储器 光盘存储器是应用激光在记录介质(如磁光材料等)上进行 读写的存储器,具有非易失性的特点。 光盘记录密度高、耐用性好、可靠性高和可互换性强等优良 特点。

钻孔纸带

大端方案

IBM 370机是字长为32位的计算 机,主存按字节编址。

小端方案

PDP-11机是字长为16位的计 算机,主存也按字节编址。

字地址

00 44 88

字节地址

123 567 9 10 11

存储器发展总结报告范文(3篇)

第1篇一、引言存储器作为计算机系统中不可或缺的组成部分,其发展历程可谓跌宕起伏。

从最早的磁芯存储器到现在的固态硬盘,存储器技术经历了多次革新。

本文将对存储器的发展历程进行总结,并对未来存储器的发展趋势进行展望。

二、存储器发展历程1. 磁芯存储器时代20世纪50年代,磁芯存储器诞生。

磁芯存储器具有体积小、速度快、容量大等优点,成为当时计算机系统的主要存储器。

然而,磁芯存储器存在易受磁场干扰、读写速度慢等缺点。

2. 液晶存储器时代20世纪60年代,液晶存储器问世。

液晶存储器具有低功耗、高可靠性等优点,但读写速度慢、存储容量小等问题限制了其发展。

3. 芯片存储器时代20世纪70年代,芯片存储器逐渐取代磁芯存储器和液晶存储器。

芯片存储器具有读写速度快、存储容量大、可靠性高等优点,成为计算机系统的主流存储器。

4. 固态硬盘时代21世纪初,固态硬盘(SSD)问世。

固态硬盘采用闪存芯片作为存储介质,具有无机械运动、速度快、功耗低、抗震性强等优点。

随着技术的不断发展,固态硬盘逐渐成为主流存储器。

三、存储器发展特点1. 存储介质不断革新从磁芯存储器到固态硬盘,存储介质经历了从磁介质到半导体介质的转变。

半导体介质具有更高的存储密度、更快的读写速度和更低的功耗。

2. 存储容量持续增长随着技术的进步,存储器的容量不断增长。

从早期的几十KB到现在的几TB,存储器容量满足了人们日益增长的存储需求。

3. 读写速度不断提高存储器的读写速度是衡量其性能的重要指标。

从磁芯存储器的几十KB/s到固态硬盘的几GB/s,存储器的读写速度得到了显著提升。

4. 功耗逐渐降低随着存储器技术的发展,其功耗逐渐降低。

这对于提高计算机系统的能效比具有重要意义。

四、未来存储器发展趋势1. 存储介质多样化未来,存储介质将更加多样化。

除了现有的磁介质、半导体介质外,新型存储介质如相变存储器、磁阻存储器等将逐渐崭露头角。

2. 存储容量继续增长随着存储需求的不断增长,存储器的容量将继续增长。

存储器系统(论文)

摘要在现代计算机中,存储器是其核心组成部分,对微型计算机也不例外。

因为有了它,计算机才具有“记忆”功能,才能把程序及数据的代码保存起来,才能使计算机系统脱离人的干预而自动完成信息处理的功能。

计算机的主存储器不能同时满足存取速度快、存储容量大和成本低的要求,在计算机中必须有速度由慢到快、容量由大到小的多级层次存储器,以最优的控制调度算法和合理的成本,构成具有性能可接受的存储系统。

存储系统的性能在计算机中的地位日趋重要。

这篇文章简述了存储器的由汞延迟线、磁带、磁鼓、磁芯、磁盘、光盘到纳米存储的7个发展阶段,并介绍了其间存储器的各个方面性能的进步,以及在云计算和物联网技术中存储器的应用和存储器的发展前景。

关键词:存储器,容量,速度AbstractIn modern computers, memory is the core component of the micro-computer. Because of it, the computer have the function of "memory" and can save the program and data code. Computer systems out of the human intervention and automatically complete the information processing functions.The computer's main memory can not satisfy fast access, big storage capacity and low cost.the computer must have the speed from slow to fast and from big to small capacity multi-level hierarchical memory and the best control and scheduling algorithm and a reasonable cost, constitutes acceptable performance storage systems.The function of storage systems will become more important in the computer.This essay briefly described the seven stages of the memory's development from the mercury delay line, tape, drum, core, disk, CD-ROM to the nano-storage.And described all aspects of the memory's progress during the period.The prospects for the development of the memory in the cloud computing and networking technology.Key Words:Memory,capacity, speed目录摘要 (I)第一章存储器分类 (1)第二章存储器的发展历史 (3)1) 汞延迟线 (3)2) 磁带 (3)3) 磁鼓 (4)4) 磁芯 (4)5) 磁盘 (5)6) 光盘 (7)7) 纳米存储 (8)第三章存储器系统结构 (9)1) 基本存储单元 (9)2) 存储体 (9)3) 地址译码器 (9)4) 片选与读/写控制电路 (9)5) I/O电路 (10)6) 其它外围电路 (10)第四章重点介绍 (11)1) ROM和RAM的特点 (11)2) 静态和动态RAM (11)3) 存储器芯片 (11)4) 存储器组构 (11)第五章存储器的现状与未来 (13)新技术介绍:IBM发表论文介绍新型存储系统“赛道存储器” (13)结束语 (15)参考文献 (16)致谢 (17)第一章存储器分类随着计算机系统结构的发展和器件的发展,存储器的种类日益繁多,分类的方法也有很多种,可按存储器的存储介质划分,按存取方式划分,按存储器在计算机中的作用划分等。

中国存储器的发展历史论文

中国存储器的发展历史论文

中国存储器的发展历史可以追溯至上世纪六十年代,在那个时候,中国正在建设自己的计算机系统,而存储器作为计算机系统中至关重要的一部分,也开始在国内得到关注。

在刚开始的阶段,中国的存储器技术主要依赖进口,受制于外部技术的限制,国内存储器行业一直处于落后状态。

随着计算机技术的不断发展和中国经济的快速增长,中国开始加大对存储器技术的研发投入。

上世纪八十年代初,中国开始建立自己的存储器研究中心,并在短短几年内取得了一系列重要突破。

中国的存储器技术开始逐渐与国际接轨,国产存储器产品也开始在国内市场占有一席之地。

到了上世纪九十年代,中国的存储器产业迎来了快速发展的时期。

国内一些知名企业纷纷投入存储器技术的研发和生产,中国的存储器产品开始进入国际市场,并与外国品牌展开竞争。

随着技术的不断进步和市场的逐渐成熟,中国的存储器产业开始逐渐走向成熟。

如今,中国的存储器产业已经成为全球存储器市场的重要一员。

中国的存储器技术不断创新,产品质量和性能也不断提升,中国的存储器产品在国际上享有一定的声誉。

未来,随着科技的发展和市场需求的不断增长,中国的存储器产业有望在全球市场上占据更大的份额,为中国的信息产业发展做出更大的贡献。

CacheCoherence文献综述

Cache Coherence文献综述文献阅读背景如何选择高速缓存一致性的解决方案一直以来都是设计共享存储器体系结构的关键问题。

相对于维护高速缓存一致性而言,数据的传输也显得简单了。

高速缓存一致性协议致力于保证每个处理器的数据一致性。

一致性通常是在高速缓存总线或者网线上得到保证。

高速缓存的缺失可以从内存中得到数据,除非有些系统(处理器或者输入输出控制器)设备修改了高速缓存总线。

为了进行写操作,该处理器必须进行状态的转换,通常是转换为独占的状态,而总线上其他的系统设备都必须将他们的数据无效化,目前该数据块的拥有者就成为了数据来源。

因此,当其他设备提出需要此数据块时,该数据块的拥有者,而不是内存,就必须提供数据。

只有当该数据块的拥有者必须腾出空间用以存放其他的数据时,才将最新的数据重新写回内存中。

当然,在这方面,各种协议也有区别,上文所诉只是最基本的一些解决方案1。

并且,协议也包括基于硬件的以及基于软件的协议两个种类。

也有写无效和写更新的区别。

下面概述性地介绍下体系结构中所采用的两种主要的一致性方案:监听式(也称广播式)协议:所有的地址都送往所有的系统设备中。

每个设备在本地缓存中检查(监听)高速缓存总线的状态,系统在几个时钟周期后决定了全局的监听结果。

广播式协议提供了最低的可能延迟,尤其当缓存之间的传输是基本的传输方式。

监听式协议传输数据的带宽也是有一定限制的,通常被限制在:带宽=缓存总线带宽×总线时钟周期/每次监听的时钟周期数。

这将在下文中详细提到。

目录式(也称点对点式)协议:每个地址都被送往系统设备中对缓存数据感兴趣的那些设备。

物理存储器的共享状态放在一个地点,称之为目录。

目录式一致性的开销更大,尤其在延时等方面,因为协议本身的复杂性。

但是整体的带宽可以比监听式协议高很多,往往应用于比较大型的系统,最主要的应用是分布式系统。

这将在下文详细提到。

缓存一致性涉及的体系结构主要有如下几种:第一种类型是集中式存储体系结构,也称作为对称(共享存储器)多处理器系统(SMPs),这种体系结构也称为均匀存储器访问(UMA),这是因为所有的处理器访问存储器都有相同的时延。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

存储器芯片的使用现状及未来发展趋势

文献综述

班级:XXX

姓名:XXX

学号:XXX

一、选题背景

存储器广泛应用于计算机、消费电子、网络存储、物联网、国家安全等重要领域,是一种重要的、基础性的产品。

当前,伴随着第五代移动通信、物联网和大数据的快速发展,存储器的需求量迅速增加,存储容量、存取速度、功耗、可靠性和使用寿命等指标要求也越来越高。

世界各大企业在这方面出现“百家争鸣、百花齐放”的大好局面,涌现出多种新型存储器,并且工艺水平和性能都在不断提高,给消费者提供了更多的选择空间。

二、相关问题现状研究综述

我们一般会将存储器划分为,易失性存储器和非易失性存储器,这种划分是根据断电后数据是否丢失而决定的。

现有技术中,整个存储器芯片行业主要有三种种产品:DRAM、NAND FLASH和NOR FLASH。

DRAM是易失性存储器的代表,NAND Flash和NOR FLASH是非易失性存储器的代表。

尽管按照不同的分类特点,可形成存众多种类的储存芯片,但从该行业产业结构分析,上述三种存储器毫无疑问是全球重点厂商最为关注的产品领域。

NAND FLASH和DRAM都是硅基互补金属氧化物半导体器件,在摩尔定律和海量数据存储需求的推动下,不断向大容量、高密度、快速、低功耗、长寿命方向发展。

但随着特征尺寸不断减小至接近原子级,传统平面型结构遇到无法跨越的性能障碍,存储器的性能和可靠性达到极限,而且新工艺节点开发成本迅速增加,进一步降低预期收益。

因此,存储器向两大方向转型发展:一是继续沿用硅基材料,用垂直堆叠替代特征尺寸微缩,从平面转向立体结构;二是使用新材料和新结构研制新兴传感器技术。

前者的挑战是开发出可实现8层到32层甚至64层连续堆叠的材料和生产工艺,并保证每一层存储器性电性能的一致可控。

后者的挑战是论证开发配套生产工艺,并保证新材料不会对既有生产线造成污染、产品性能优于现有存储器和可长期可靠使用等。

新材料、结构和物理效应方面研究的不断突破,使得其他新兴存储器技术也因此得到发展。

新兴存储器以大容量、低功耗、高速读写、超长保存周期、数据安全等为发展目标,包括利用自发极化现象开发的铁电随机存储器(FRAM)、利用电致相变现象的相变存储器(PCM)、利用磁电阻效应开发的磁性随机存储器(MRAM)、利用电致电阻转变效应开发的电阻随机存储器(RRAM),以及赛道存储

器、铁电晶体管随机存储器(FeTRAM)、导电桥梁随机存储器(CBRAM)、内容寻址存储器(CAM)等。

铁电随机存储器(FRAM):它包含由锆钛酸铅制成的铁电薄膜,其中心原子可在外加电场时顺着电场方向在晶体里移动,并在通过能量壁垒时引起电荷击穿,该击穿可被内部电路感应并记录,当移去电场后中心原子保持不动,实现数据的非易失性存储。

与一般非易失性存储器相比,FRAM的耐受性和读写速度分别提升1万和500倍、功耗降低70%,并具有极高的安全性和防篡改能力、长达10年的数据保存期、与标准集成电路制造工艺兼容等优点。

相变存储器(PCM):它利用含锗、锑、碲合成材料在不同相间的电阻差异进行信息的非易失性存储,具有与DRAM相媲美的位可修改和快速读写能力;“可执行”特性可将程序代码与数据分开,适用于手机等数据处理量较大的应用;数据保存期长达10年,并与读写次数无关;易微缩,且微缩更利于优化功耗和性能。

目前,PCM的主要研发厂商包括英特尔、美光、恒忆、IBM等。

2012年7月,美光公司开始量产采用45纳米制成全球首个1Gb PCM产品,并投入手机和平板电脑的应用,使启动时间更短、功耗更低、续航能力更长。

2015年5月,IBM在PCM的研究中取得重大突破,有效解决PCM多层存储单元中存在的电阻漂移现象和温度影响两大问题,有力推动PCM的继续发展。

磁性随机存储器(MRAM):它依据不同磁化方向致磁电阻不同的原理来进行信息的非易失性存储,具有与传统存储器相同的高读写速度和高集成度、大于20年的数据保存期、大于1014次的读写次数、超低功耗和超强抗辐射能力等优点。

电阻随机存储器(RRAM):它依托具有记忆功能的线性电阻在不同电流呈现不同阻值的特性来进行信息的非易失性存储,具有制备简单、读取时间少于10

纳秒、写入时间约为0.1纳秒、存储密度高、半导体工艺兼容性好等优点。

目前,RRAM仍处于研制阶段,主要参研单位包括三星、比利时微电子研究中心(IMEC)、松下、美光、闪迪和初创公司Crossbar等。

尽管随着技术的发展,新兴存储器的性能不断得到优化,但新兴存储器仍只是对现有存储器的一种补充,距离完全替代尚无明确的时间预期。

在我国集成电路市场需求中,存储器一直是占据市场份额最大、增速最快的产品类型,如存储器占2015年我国集成电路总用量的第一位,占比达到25.4%。

我国国产存储器技术虽然不断突破,但主要还是依靠进口满足使用需求,这不仅导致了大量外汇的流失,还给我国社会经济和国防安全带来巨大潜在危险。

以下

通过存储芯片的技术水平对比,我国目前仅能批量生产55nm级别的NOR FLASH,用于主板BIOS芯片等小容量、写入慢的逻辑芯片。

3D NAND闪存也仅在实验室状态下,完成9层结构的存储芯片的存储器功能的电学验证。

DRAM则干脆处于技术储备、规划当中,短期内无量产可能。

从目前来看,3D NAND是未来发展必然趋势,随着半导体工艺技术要求的不断深入,考虑复杂工艺的成本要求,现阶段市场主流的通过平面工艺制程缩减难度增加,在存储器竞争节点已经迈入16nm关口后,已经变得不再划算。

因此全球各存储器主要生产厂家都开始了积极研发布局基于三维结构的3D NAND,从2015年开始,部分产品会逐渐进入量产阶段,Nand的3D封装趋势很快会到来。

三、个人观点及总结

存储器不仅在计算机,而且在手机、物联网、汽车等应用市场已成为巨大需求。

眼下,各类存储器在新材料、新制造工艺的带动下不断发展和完善。

未来存储器在追求大容量、高速度的同时,仍将继续保持低功耗和低成本,业界对新的存储技术正在进行着不懈探索。

但是从目前的信息资料来看,至少是未来3年内 DRAM、NAND FLASH和NOR FLASH仍是主流。

另外,对我国来说,存储芯片自主国产化是眼前我国存储器芯片发展的根本。

收购国外存储芯片厂家则是拓展加速,双管齐下的目的是为了加速存储芯片的自主生产进程。

存储芯片国产化是一项艰巨的工程,必须要敢于啃硬骨头,存储芯片的四大特性决定了国产化工程离不开政府的强力支持。

我国做存储器芯片产业一定要正向面对主战场,除了资金支持外,政府应当从人才到产业链配套等领域全面持续加大对存储芯片产业的支持,这样才能在不断提升我国的存储器芯片产业链自主程度的基础上实现赶超。

参考文献

[1] 马欣.《我国“存储芯片”产业发展现状与展望研究》.科技经济导刊.2016

[2] 刘文生,黄胜利.《存储器的现状与未来》.中国电工技术学会电力电子学会第九届学术年会论文集. 2016

[3] 郑兆远.《芯片行业猛刮中国风,百亿能否砸晕美光》.中关村在线业内资讯.2015-7

[4] 许兴军.《存储芯片行业研究报告》.中国存储网存储资讯.2015-9

[5] 覃崇直.《存储器芯片发展现状对我国的启示》.中国产业信息网.2016-8。