Linux 等待队列

深入理解linux内核笔记1

郑重声明:未经本人允许,不得用于商业或非商业的转载和使用,如有需要请联系:yrj1978@hotmail.com引子为什么要写这个笔记:1,这本书的中文版翻译了太垃圾,没法阅读。

阅读英文原版,可以很好的理解作者的思路。

作此笔记备忘2,一直以来学习LINUXkernel的知识缺乏系统化,借对这本书的学习,系统化的学习一下LINUXkernel。

3,自己一直在做一个toosmall,toosimple的单进程,特权模式,64bit保护模式的称不上OS的OS,已经做完了bootloader,构思kernel的实现的时候,困惑在内存管理的实现上,阅读这本书,希望能有利于自己的OS的编写。

4,克服惰性,多读书,希望一天能阅读5页,争取半年内阅读完这本原版700多页的巨著。

不足:我不可能完全理解LINUX内存管理的精髓,肯定有很多地方理解错误。

希望大家能够指正,以便提高,谢谢。

学习方法:可能您第一次阅读的时候很多地方都不理解,不用担心。

那您可能需要阅读一些文件系统的知识。

或者阅读全部笔记后,再回头阅读,有些地方您就理解了。

言归正传:一、概要可用工具CodeViz:生成代码调用关系图的工具,这个工具我现在还没有去使用,有兴趣的可以自己试试去建立调用关系图。

http://www.csn.ul.ie/ ̄mel/projects/codeviz/Linuxcrossreference(LXR):以web的方式阅读和查找LINUX内核源代码的工具。

这个工具安装相当麻烦,我建议直接到它的官方网站直接读代码。

http://lxr.linux.no/linux+v2.6.24/模块LINUX内存管理代码模块主要分为4个部分:1.Outofmemory代码在mm/oom_kill.c貌似用于杀进程的时候对内存的操作2.虚拟内存的分配代码在mm/vmalloc.c3.物理内存页面分配代码在mm/page_alloc.cVMA(virtualmemoryaddresses)的创建和进程内的内存区域的管理4.这些模块,贯穿与其他kernel代码之中,形成更复杂的系统模块,如页面替换策略,buffer的输入输出等中间插段广告Linux文化T恤,淘宝销售,有兴趣的可以购买。

linux sched_setscheduler函数解析

linux sched_setscheduler函数解析sched_setscheduler函数是一个Linux系统调用函数,用于修改进程的调度策略和优先级。

函数原型为:```cint sched_setscheduler(pid_t pid, int policy, const structsched_param *param);```参数说明:- pid:要修改调度策略和优先级的进程ID。

如果pid为0,则表示修改当前进程。

- policy:要设置的调度策略。

可以取以下值:- SCHED_OTHER:普通进程调度策略,即默认策略。

这是一个非实时调度策略,由时间片轮转算法控制。

- SCHED_FIFO:先进先出调度策略。

使用FIFO调度策略的进程优先级比其他普通进程高。

- SCHED_RR:轮转调度策略。

与FIFO策略类似,但进程会在使用完时间片后轮转到等待队列的末尾。

- SCHED_BATCH:批处理调度策略。

适合批处理作业,将进程聚集在一起批量执行。

- SCHED_IDLE:空闲调度策略。

只有在没有其他优先级较高的进程运行时,才会执行该进程。

- SCHED_DEADLINE:截止时间调度策略。

用于实时系统,根据任务的截止时间进行调度。

- param:一个指向sched_param结构体的指针,用于设置进程的优先级和其他调度参数。

sched_param结构体包含一个int类型的成员sched_priority,表示进程的优先级。

函数返回值为0表示成功,返回-1表示失败并设置errno。

sched_setscheduler函数用于修改进程的调度策略和优先级。

在修改调度策略之前,需要获得相应的权限。

调用该函数后,进程会立即按照新的调度策略和优先级进行调度。

注意事项:- 一些调度策略(如SCHED_FIFO和SCHED_RR)需要root权限,因此需要以root用户身份运行程序或具有相应的权限。

- 修改调度策略和优先级可能会影响系统的整体性能和稳定性,需要谨慎使用。

Linux之信号量,比较全面,个人总结。

信号量一.什么是信号量信号量的使用主要是用来保护共享资源,使得资源在一个时刻只有一个进程(线程)所拥有。

信号量的值为正的时候,说明它空闲。

所测试的线程可以锁定而使用它。

若为0,说明它被占用,测试的线程要进入睡眠队列中,等待被唤醒。

二.信号量的分类在学习信号量之前,我们必须先知道——Linux提供两种信号量:POSIX信号量又分为有名信号量和无名信号量。

有名信号量,其值保存在文件中, 所以它可以用于线程也可以用于进程间的同步。

无名信号量,其值保存在内存中。

倘若对信号量没有以上的全面认识的话,你就会很快发现自己在信号量的森林里迷失了方向。

三.内核信号量1.内核信号量的构成内核信号量类似于自旋锁,因为当锁关闭着时,它不允许内核控制路径继续进行。

然而,当内核控制路径试图获取内核信号量锁保护的忙资源时,相应的进程就被挂起。

只有在资源被释放时,进程才再次变为可运行。

只有可以睡眠的函数才能获取内核信号量;中断处理程序和可延迟函数都不能使用内核信号量。

count:相当于信号量的值,大于0,资源空闲;等于0,资源忙,但没有进程等待这个保护的资源;小于0,资源不可用,并至少有一个进程等待资源。

wait:存放等待队列链表的地址,当前等待资源的所有睡眠进程都会放在这个链表中。

sleepers:存放一个标志,表示是否有一些进程在信号量上睡眠。

2.内核信号量中的等待队列(删除,没有联系)上面已经提到了内核信号量使用了等待队列wait_queue来实现阻塞操作。

当某任务由于没有某种条件没有得到满足时,它就被挂到等待队列中睡眠。

当条件得到满足时,该任务就被移出等待队列,此时并不意味着该任务就被马上执行,因为它又被移进工作队列中等待CPU资源,在适当的时机被调度。

内核信号量是在内部使用等待队列的,也就是说该等待队列对用户是隐藏的,无须用户干涉。

由用户真正使用的等待队列我们将在另外的篇章进行详解。

3.内核信号量的相关函数(2)申请内核信号量所保护的资源:4.内核信号量的使用例程在驱动程序中,当多个线程同时访问相同的资源时(驱动中的全局变量时一种典型的共享资源),可能会引发“竞态“,因此我们必须对共享资源进行并发控制。

linux消息队列wait_queue实例

linux消息队列wait_queue实例在Linux内核中,`wait_queue`(等待队列)是一种用于实现进程或线程间同步的机制,通常与信号量一起使用。

它允许一个进程或线程等待某个条件成立,当条件满足时被唤醒。

下面是一个简单的Linux内核中`wait_queue`的示例,假设你正在编写一个内核模块,并希望使用等待队列来实现进程的等待和唤醒操作。

```c#include<linux/init.h>#include<linux/module.h>#include<linux/kernel.h>#include<linux/kthread.h>#include<linux/delay.h>MODULE_LICENSE("GPL");MODULE_AUTHOR("Your Name");MODULE_DESCRIPTION("Wait Queue Example");//定义等待队列static DECLARE_WAIT_QUEUE_HEAD(my_wait_queue);//定义一个条件,当条件满足时唤醒等待队列中的进程static int condition=0;//定义一个内核线程static struct task_struct*my_thread;//内核线程的函数,模拟条件的变化static int my_thread_function(void*data){while(!kthread_should_stop()){//模拟一些条件的变化msleep(2000);condition=1;//唤醒等待队列中的进程wake_up(&my_wait_queue);}return0;}//模块加载时初始化内核线程static int__init wait_queue_example_init(void){printk(KERN_INFO"Wait Queue Example:Module Loaded\n");//创建内核线程my_thread=kthread_run(my_thread_function,NULL,"my_thread");return0;}//模块卸载时停止内核线程static void__exit wait_queue_example_exit(void){printk(KERN_INFO"Wait Queue Example:Module Unloaded\n");//停止内核线程kthread_stop(my_thread);}module_init(wait_queue_example_init);module_exit(wait_queue_example_exit);```在这个例子中,`DECLARE_WAIT_QUEUE_HEAD`定义了一个等待队列。

kernel中的互斥锁

kernel中的互斥锁1. 什么是互斥锁?在计算机科学中,互斥锁(Mutex)是一种用于控制对共享资源的访问的同步机制。

它允许多个线程或进程同时访问共享资源,但只允许一个线程或进程在任意时刻访问该资源。

互斥锁的主要目的是防止多个线程或进程同时访问共享资源,从而避免竞争条件(Race Condition)的发生。

竞争条件是指多个线程或进程在没有足够同步机制的情况下对共享资源进行读写操作,导致结果的不确定性。

2. 互斥锁在kernel中的应用在kernel中,互斥锁被广泛应用于保护共享数据结构的访问。

由于kernel是一个多线程的环境,不同的线程可能同时访问同一个数据结构,而互斥锁可以确保在任意时刻只有一个线程可以访问该数据结构,从而避免数据的不一致性和竞争条件的发生。

互斥锁在kernel中的应用非常广泛,例如:•保护内核数据结构的访问:kernel中有许多重要的数据结构,如进程控制块(PCB)、文件描述符表等,这些数据结构需要被多个线程或进程同时访问。

使用互斥锁可以确保对这些数据结构的访问是安全的。

•同步设备访问:在kernel中,许多设备是共享的,多个线程或进程可能同时访问同一个设备。

使用互斥锁可以确保对设备的访问是顺序的,避免冲突和不一致性。

•保护临界区:在kernel中,有些代码段是临界区,即多个线程或进程不能同时执行的代码段。

使用互斥锁可以确保在任意时刻只有一个线程或进程可以执行临界区的代码,从而避免竞争条件的发生。

3. kernel中的互斥锁实现在Linux kernel中,互斥锁是由mutex结构体表示的。

该结构体定义在<linux/mutex.h>头文件中,包含了互斥锁的各种属性和方法。

互斥锁的基本使用方法如下:#include <linux/mutex.h>struct mutex my_mutex;// 初始化互斥锁mutex_init(&my_mutex);// 获取互斥锁mutex_lock(&my_mutex);// 访问共享资源// 释放互斥锁mutex_unlock(&my_mutex);互斥锁的初始化使用mutex_init函数,该函数会将互斥锁的各种属性初始化为默认值。

linux中select、poll、epoll原理

linux中select、poll、epoll原理select、poll和epoll是Linux下常用的I/O多路复用技术,都用于实现高效的事件驱动型的网络编程。

1. select(选择)select是最古老的I/O多路复用机制,它通过在套接字上设置阻塞(阻塞方式)进行等待,一旦有文件描述符准备就绪(可读、可写等),则返回。

select使用fd_set集合来保存要监听的文件描述符,因此其监听的文件描述符数量受到系统给定的FD_SETSIZE限制。

select的实现原理是:在内核中创建一个称为“等待队列”的数据结构(fd_set),该队列保存了需要等待的文件描述符,当某个文件描述符就绪时,会通过和用户进程的映射表通知用户进程。

select通过轮询所有注册的文件描述符,检查哪些文件描述符已经准备好,并将准备好的文件描述符从用户态拷贝到内核态。

select的缺点是每次调用都需要轮询全部的注册文件描述符,效率较低。

2. poll(轮询)poll是在select的基础上进行改进的多路复用技术。

poll与select的最大区别在于,它没有限制文件描述符的数量,并且使用了一个pollfd结构体数组来保存每个文件描述符及其关注的事件。

poll在内核中创建一个称为“等待队列”的数据结构,该队列保存了需要等待的文件描述符,当某个文件描述符就绪时,会通过和用户进程的映射表通知用户进程。

poll的实现原理是:将用户进程注册要监听的文件描述符及其关注的事件存储在内核中的一个事件表中,当发生事件时,内核会将该事件存储在内核态的事件表中,并通知用户进程。

与select不同的是,poll只需在事件发生时拷贝某些信息到内核态,而不需要拷贝全部的文件描述符。

poll的缺点是,当注册的文件描述符数量较大时,每次调用poll都需要遍历整个事件表,效率较低。

3. epoll(事件通知)epoll是Linux特有的一种I/O多路复用机制,通过内核与用户空间的共享内存来实现高效的事件通知。

Linux kernel的wait queue机制

Linux kernel的wait queue机制1. 介绍当编写(Linux)驱动程序、模块或内核程序时,一些进程会等待或休眠一些事件。

Linux中有几种处理睡眠和醒来的方法,每种方法对应不同的需求,而w(ai)t queue便是其中一种。

每当进程必须等待一个事件(例如数据的到达或进程的终止)时,它都应该进入睡眠状态。

睡眠会导致进程暂停执行,从而释放处理器以供其他用途。

一段时间后,该过程将被唤醒,并在我们等待的事件到达时继续其工作。

等待队列是内核提供的一种机制,用于实现等待。

顾名思义,wait queue是等待事件的进程列表。

换句话说,当某个条件成立时,等待队列用于等待有人叫醒你。

它们必须小心使用,以确保没有竞争条件的存在。

实现wait queue的步骤如下:初始化等待队列排队(将任务置于睡眠状态,直到事件发生)唤醒排队的任务以下逐步介绍每个步骤的实现方式。

2. 初始化等待队列若使用wait queue功能,需要包含/linux/wait.h头文件。

可基于动态和静态两种方式实现等待队列的初始化。

静态方式:DECLARE_WAIT_QUEUE_HE(AD)(wq);因此,该线程正在等待该事件。

现在,我们将通过使用sudo cat/dev/etx_device读取驱动程序来发送事件现在检查dmesgDevice File Opened...Read FunctionEvent Came From Read Function - 1Waiting For Event...Device File Closed...我们从读取功能发送唤醒,因此它将打印读取计数,然后再次休眠。

现在通过sudo rmmod驱动程序从退出功能发送事件Event Came From Exit FunctionDevice Driver Remove...Done 现在条件是2。

因此,它将从线程返回并删除驱动程序。

《Linux基础及应用教程》课件第10章 Linux内核机制

系统内核中可以有多达32个不同的bottom half 处理程序。bh _ base中保存着指向每一 个bottom half处理程序的指针。

2.任务队列

任务队列是系统内核将任务推迟到以后再 做的方法。Linux系统有一个机制可以把任务 放入到队列中等待以后处理。

3.计时器

10.1 Linux内核简介

10.1.1 Linux内核的地位 Linux操作系统由4个主要的子系统所组成: • 1)用户应用程序:在某个特定的Linux系统上运行的应用程序集

合,它将随着该计算机系统的用途不同而有所变化,但一般会包 括文字处理应用程序和Web浏览器。 • 2)O/S服务:这些服务一般认为是操作系统的一部分(命令外 壳程序等)。

3.把增加的 sys_call_table 表项所对应的向量,在 include/asm-386/unistd.h 中进行必要声明,以供用 户进程和其他系统进程查询或调用:

增加后的部分 /usr/src/linux/include/asm386/unistd.h 文件如下:

... ... #define __NR_sendfile 187 #define __NR_getpmsg 188 #define __NR_putpmsg 189 #define __NR_vfork 190 /* add by I */ #define __NR_addtotal 191

修改后为:

... ... .long SYMBOL_NAME(sys_sendfile) .long SYMBOL_NAME(sys_ni_syscall) /* streams1 */ .long SYMBOL_NAME(sys_ni_syscall) /* streams2 */ .long SYMBOL_NAME(sys_vfork) /* 190 */ /* add by I */ .long SYMBOL_NAME(sys_addtotal) .rept NR_syscalls-191 .long SYMBOL_NAME(sys_ni_syscall) .endr

linux命令行限制进程数的参数

linux命令行限制进程数的参数在Linux命令行中,可以使用不同的参数和选项来限制进程的数量。

下面将介绍一些常见的参数和选项。

1. ulimit命令:ulimit命令可以设置或显示进程资源限制。

可以使用以下参数:-a:显示当前的所有限制值。

-c:设置或显示核心文件的最大大小(字节数)。

-d:设置或显示进程数据段的最大大小(字节数)。

-p:设置或显示等待队列上的最大进程数。

-n:设置或显示每个用户可以同时打开的文件数。

-u:设置或显示用户最大进程数。

-f:设置或显示文件的最大大小(字节数)。

例如,可以使用以下命令来设置用户最大进程数为1000:ulimit -u 10002. prlimit命令:prlimit命令用于修改和显示进程资源限制。

可以使用以下参数:--cpu=<时间>:设置或显示进程的CPU时间限制(秒)。

--fsize=<大小>:设置或显示进程的最大文件大小(字节数)。

--nofile=<数量>:设置或显示进程可以同时打开的文件数。

--nproc=<数量>:设置或显示进程的最大进程数。

--as=<大小>:设置或显示进程的地址空间大小(字节数)。

例如,可以使用以下命令来设置进程的最大进程数为500:prlimit --nproc=500 <命令>3. sysctl命令:sysctl命令用于在运行时修改内核参数。

可以使用以下参数:-w <参数>=<值>:设置指定的参数为给定的值。

-p:从配置文件(通常是/etc/sysctl.conf)中加载参数。

例如,可以使用以下命令来设置系统的最大进程数为2000:sysctl -w kernel.pid_max=20004. cgroups(控制组):cgroups是一种用于分组和管理进程的机制,在Linux中可以使用cgroups来限制进程的资源使用。

linux eventfd 原理 -回复

linux eventfd 原理-回复Linux中的eventfd是一种用于在进程间进行同步和通信的机制。

它提供了一种简单而高效的方法来管理事件和信号,可以用于多种场景,如进程间通信、异步事件处理等。

eventfd的原理涉及到多个方面,包括内核态和用户态之间的交互、事件通知和处理、以及多个进程之间的同步等。

下面将逐步回答关于eventfd 原理的问题。

1. eventfd的基本概念和特点是什么?eventfd是Linux内核提供的一种文件描述符,它用于在用户空间和内核之间传递事件和信号。

它可以用于同步多个进程之间的状态,避免了进程轮询。

eventfd是一种线程安全的机制,可以用于在多个线程之间进行通信。

它使用简单、高效,并且具有较低的系统开销。

2. eventfd的底层实现机制是什么?eventfd的底层实现基于文件描述符,它通过系统调用来创建和管理。

eventfd_create函数用于创建一个新的eventfd对象,它返回一个新的文件描述符。

eventfd_read和eventfd_write函数用于读取和写入eventfd 对象的值,实现进程间的通信和同步。

在内核中,eventfd通过一个内核对象进行表示,包括一个计数器和一个等待队列。

当eventfd对象的计数器值大于0时,表示有事件发生。

进程可以通过读取该计数器的值来等待事件的发生或者重置计数器。

当计数器的值变为0时,正在等待的进程将唤醒。

3. eventfd如何进行事件的通知和处理?在用户空间,进程可以通过向eventfd对象写入一个事件的值来通知其他正在等待的进程。

当某个进程写入事件值后,eventfd对象的计数器会相应增加。

其他等待的进程可以通过读取计数器的值来判断是否有事件发生,从而进行相应的处理。

4. eventfd如何实现进程间的同步?eventfd的同步机制基于等待队列和条件变量实现。

当一个进程等待一个eventfd对象时,它会进入一个等待队列中,进入休眠状态,直到有事件发生或者计数器的值变为0。

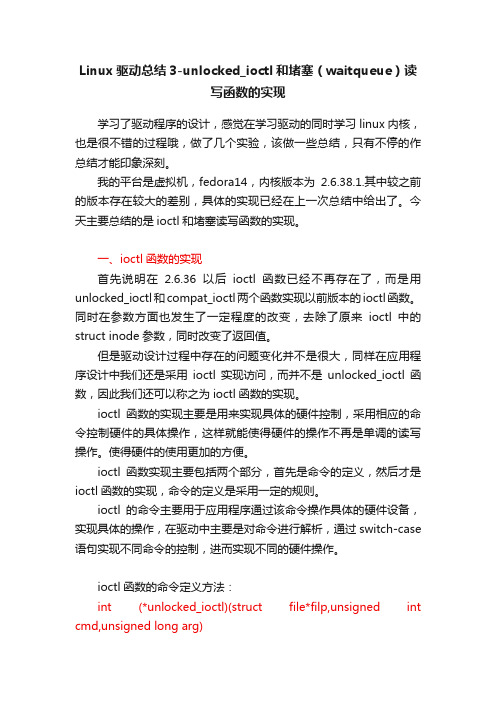

Linux驱动总结3-unlocked_ioctl和堵塞(waitqueue)读写函数的实现

Linux驱动总结3-unlocked_ioctl和堵塞(waitqueue)读写函数的实现学习了驱动程序的设计,感觉在学习驱动的同时学习linux内核,也是很不错的过程哦,做了几个实验,该做一些总结,只有不停的作总结才能印象深刻。

我的平台是虚拟机,fedora14,内核版本为2.6.38.1.其中较之前的版本存在较大的差别,具体的实现已经在上一次总结中给出了。

今天主要总结的是ioctl和堵塞读写函数的实现。

一、ioctl函数的实现首先说明在2.6.36以后ioctl函数已经不再存在了,而是用unlocked_ioctl和compat_ioctl两个函数实现以前版本的ioctl函数。

同时在参数方面也发生了一定程度的改变,去除了原来ioctl中的struct inode参数,同时改变了返回值。

但是驱动设计过程中存在的问题变化并不是很大,同样在应用程序设计中我们还是采用ioctl实现访问,而并不是unlocked_ioctl函数,因此我们还可以称之为ioctl函数的实现。

ioctl函数的实现主要是用来实现具体的硬件控制,采用相应的命令控制硬件的具体操作,这样就能使得硬件的操作不再是单调的读写操作。

使得硬件的使用更加的方便。

ioctl函数实现主要包括两个部分,首先是命令的定义,然后才是ioctl函数的实现,命令的定义是采用一定的规则。

ioctl的命令主要用于应用程序通过该命令操作具体的硬件设备,实现具体的操作,在驱动中主要是对命令进行解析,通过switch-case 语句实现不同命令的控制,进而实现不同的硬件操作。

ioctl函数的命令定义方法:int (*unlocked_ioctl)(struct file*filp,unsigned int cmd,unsigned long arg)虽然其中没有指针的参数,但是通常采用arg传递指针参数。

cmd是一个命令。

每一个命令由一个整形数据构成(32bits),将一个命令分成四部分,每一部分实现具体的配置,设备类型(幻数)8bits,方向2bits,序号8bits,数据大小13/14bits。

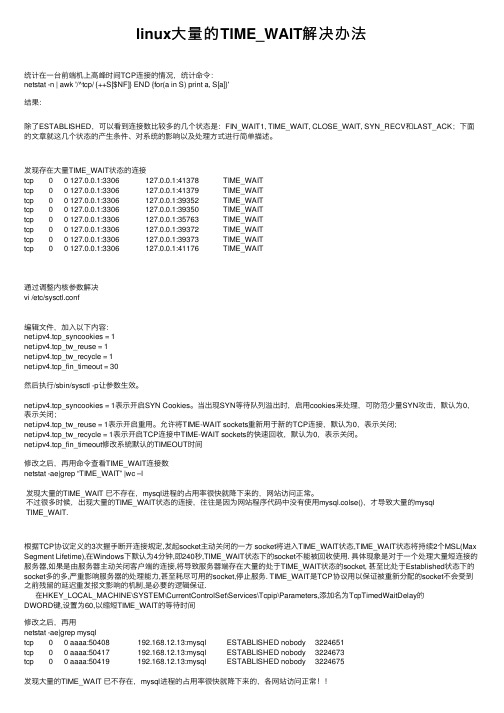

linux大量的TIME_WAIT解决办法

linux⼤量的TIME_WAIT解决办法统计在⼀台前端机上⾼峰时间TCP连接的情况,统计命令:netstat -n | awk '/^tcp/ {++S[$NF]} END {for(a in S) print a, S[a]}'结果:除了ESTABLISHED,可以看到连接数⽐较多的⼏个状态是:FIN_WAIT1, TIME_WAIT, CLOSE_WAIT, SYN_RECV和LAST_ACK;下⾯的⽂章就这⼏个状态的产⽣条件、对系统的影响以及处理⽅式进⾏简单描述。

发现存在⼤量TIME_WAIT状态的连接tcp 0 0 127.0.0.1:3306 127.0.0.1:41378 TIME_WAITtcp 0 0 127.0.0.1:3306 127.0.0.1:41379 TIME_WAITtcp 0 0 127.0.0.1:3306 127.0.0.1:39352 TIME_WAITtcp 0 0 127.0.0.1:3306 127.0.0.1:39350 TIME_WAITtcp 0 0 127.0.0.1:3306 127.0.0.1:35763 TIME_WAITtcp 0 0 127.0.0.1:3306 127.0.0.1:39372 TIME_WAITtcp 0 0 127.0.0.1:3306 127.0.0.1:39373 TIME_WAITtcp 0 0 127.0.0.1:3306 127.0.0.1:41176 TIME_WAIT通过调整内核参数解决vi /etc/sysctl.conf编辑⽂件,加⼊以下内容:net.ipv4.tcp_syncookies = 1net.ipv4.tcp_tw_reuse = 1net.ipv4.tcp_tw_recycle = 1net.ipv4.tcp_fin_timeout = 30然后执⾏/sbin/sysctl -p让参数⽣效。

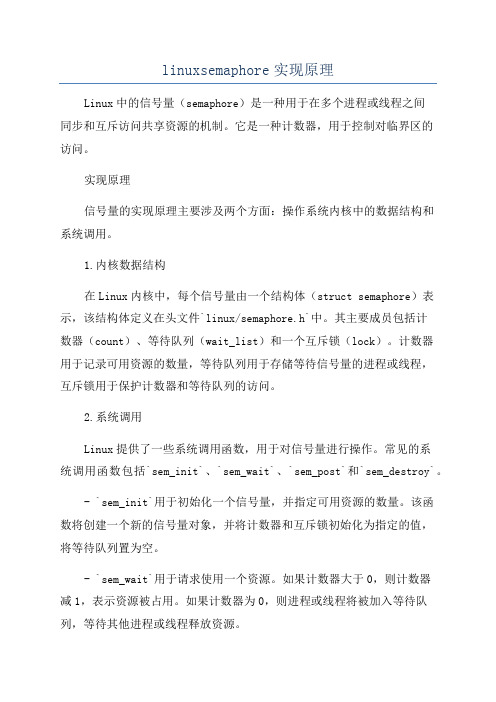

linuxsemaphore实现原理

linuxsemaphore实现原理Linux中的信号量(semaphore)是一种用于在多个进程或线程之间同步和互斥访问共享资源的机制。

它是一种计数器,用于控制对临界区的访问。

实现原理信号量的实现原理主要涉及两个方面:操作系统内核中的数据结构和系统调用。

1.内核数据结构在Linux内核中,每个信号量由一个结构体(struct semaphore)表示,该结构体定义在头文件`linux/semaphore.h`中。

其主要成员包括计数器(count)、等待队列(wait_list)和一个互斥锁(lock)。

计数器用于记录可用资源的数量,等待队列用于存储等待信号量的进程或线程,互斥锁用于保护计数器和等待队列的访问。

2.系统调用Linux提供了一些系统调用函数,用于对信号量进行操作。

常见的系统调用函数包括`sem_init`、`sem_wait`、`sem_post`和`sem_destroy`。

- `sem_init`用于初始化一个信号量,并指定可用资源的数量。

该函数将创建一个新的信号量对象,并将计数器和互斥锁初始化为指定的值,将等待队列置为空。

- `sem_wait`用于请求使用一个资源。

如果计数器大于0,则计数器减1,表示资源被占用。

如果计数器为0,则进程或线程将被加入等待队列,等待其他进程或线程释放资源。

- `sem_post`用于释放一个资源。

该函数将计数器加1,并唤醒等待队列中的一个进程或线程,使其能够继续执行。

- `sem_destroy`用于销毁一个信号量对象。

该函数将释放内存和资源,并将信号量对象标记为无效。

这些系统调用函数可以通过用户空间的库函数进行调用,例如`sem_init`由`pthread`库提供,`sem_wait`和`sem_post`由`semaphores`库提供。

应用场景信号量在操作系统中广泛应用于进程间通信和线程同步的场景,常见的应用包括:1. 进程间通信:多个进程可以使用信号量来同步对共享内存或文件的访问,以避免竞态条件(race conditions)。

Linux内核中工作队列(work_queue)的操作

cwq->thread = p;

return p;

}

static int worker_thread(void *__cwq)

{

struct cpu_workqueue_struct *cwq = __cwq;

// 声明一个等待队列

DECLARE_WAITQUEUE(wait, current);

// 参数初始化定义, 而该宏用在程式之中对工作结构赋值

#define INIT_WORK(_work, _func, _data) \

do { \

INIT_LIST_HEAD(&(_work)->entry); \

(_work)->pending = 0; \

/*

* The externally visible workqueue abstraction is an array of

* per-CPU workqueues:

*/

// 工作队列结构

struct workqueue_struct {

struct cpu_workqueue_struct *cpu_wq;

int cpu)

{

// 每个CPU的工作队列

struct cpu_workqueue_struct *cwq = per_cpu_ptr(wq->cpu_wq, cpu);

struct task_struct *p;

spin_lock_init(&cwq->lock);

{

...

keventd_wq = create_workqueue("events");

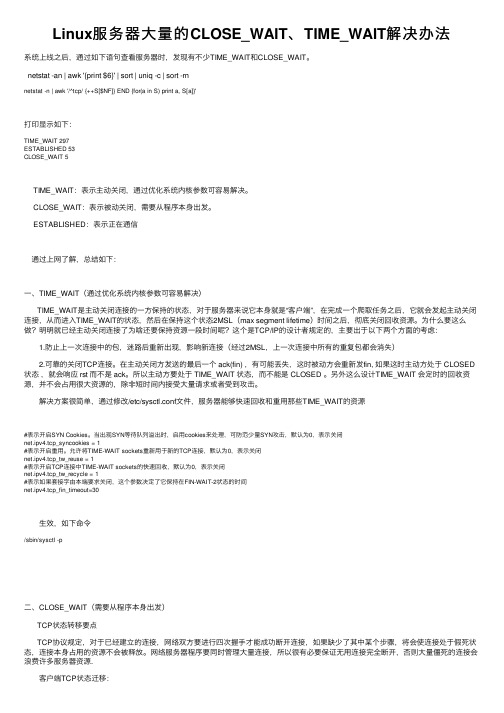

Linux服务器大量的CLOSE_WAIT、TIME_WAIT解决办法

Linux服务器⼤量的CLOSE_WAIT、TIME_WAIT解决办法系统上线之后,通过如下语句查看服务器时,发现有不少TIME_WAIT和CLOSE_WAIT。

netstat -an | awk '{print $6}' | sort | uniq -c | sort -rnnetstat -n | awk '/^tcp/ {++S[$NF]} END {for(a in S) print a, S[a]}'打印显⽰如下:TIME_WAIT 297ESTABLISHED 53CLOSE_WAIT 5TIME_WAIT:表⽰主动关闭,通过优化系统内核参数可容易解决。

CLOSE_WAIT:表⽰被动关闭,需要从程序本⾝出发。

ESTABLISHED:表⽰正在通信通过上⽹了解,总结如下:⼀、TIME_WAIT(通过优化系统内核参数可容易解决)TIME_WAIT是主动关闭连接的⼀⽅保持的状态,对于服务器来说它本⾝就是“客户端”,在完成⼀个爬取任务之后,它就会发起主动关闭连接,从⽽进⼊TIME_WAIT的状态,然后在保持这个状态2MSL(max segment lifetime)时间之后,彻底关闭回收资源。

为什么要这么做?明明就已经主动关闭连接了为啥还要保持资源⼀段时间呢?这个是TCP/IP的设计者规定的,主要出于以下两个⽅⾯的考虑:1.防⽌上⼀次连接中的包,迷路后重新出现,影响新连接(经过2MSL,上⼀次连接中所有的重复包都会消失)2.可靠的关闭TCP连接。

在主动关闭⽅发送的最后⼀个 ack(fin) ,有可能丢失,这时被动⽅会重新发fin, 如果这时主动⽅处于 CLOSED 状态,就会响应 rst ⽽不是 ack。

所以主动⽅要处于 TIME_WAIT 状态,⽽不能是 CLOSED 。

另外这么设计TIME_WAIT 会定时的回收资源,并不会占⽤很⼤资源的,除⾮短时间内接受⼤量请求或者受到攻击。

Linux中磁盘IO监控命令

Unix/Linux 磁盘I/O 性能监控命令在介绍磁盘I/O 监控命令前,我们需要了解磁盘I/O 性能监控的指标,以及每个指标的所揭示的磁盘某方面的性能。

磁盘I/O 性能监控的指标主要包括:指标1:每秒I/O数(IOPS或tps)对于磁盘来说,一次磁盘的连续读或者连续写称为一次磁盘I/O, 磁盘的IOPS 就是每秒磁盘连续读次数和连续写次数之和。

当传输小块不连续数据时,该指标有重要参考意义。

指标2:吞吐量(Throughput)指硬盘传输数据流的速度,传输数据为读出数据和写入数据的和。

其单位一般为Kbps, MB/s 等。

当传输大块不连续数据的数据,该指标有重要参考作用。

指标3:平均I/O数据尺寸平均I/O 数据尺寸为吞吐量除以I/O 数目,该指标对揭示磁盘使用模式有重要意义。

一般来说,如果平均I/O 数据尺寸小于32K,可认为磁盘使用模式以随机存取为主;如果平均每次I/O 数据尺寸大于32K,可认为磁盘使用模式以顺序存取为主。

指标4:磁盘活动时间百分比(Utilization)磁盘处于活动时间的百分比,即磁盘利用率,磁盘在数据传输和处理命令(如寻道)处于活动状态。

磁盘利用率与资源争用程度成正比,与性能成反比。

也就是说磁盘利用率越高,资源争用就越严重,性能也就越差,响应时间就越长。

一般来说,如果磁盘利用率超过70%,应用进程将花费较长的时间等待I/O 完成,因为绝大多数进程在等待过程中将被阻塞或休眠。

指标5:服务时间(Service Time)指磁盘读或写操作执行的时间,包括寻道,旋转时延,和数据传输等时间。

其大小一般和磁盘性能有关,CPU/ 内存的负荷也会对其有影响,请求过多也会间接导致服务时间的增加。

如果该值持续超过20ms,一般可考虑会对上层应用产生影响。

指标6:I/O等待队列长度(Queue Length)指待处理的I/O 请求的数目,如果I/O 请求压力持续超出磁盘处理能力,该值将增加。

LINUX内核的几种锁介绍

LINUX内核的几种锁介绍以下是LINUX内核中几种常见的锁的介绍:1. 自旋锁(spinlock):自旋锁是一种基本的锁机制,在等待锁的过程中,线程会一直处于自旋状态,即不会让出CPU,而是一直不停地检测锁是否可用。

自旋锁适用于代码执行时间很短,期待锁很快就可以被释放的情况。

自旋锁的实现通过设置一个标志位来指示锁的状态,如果锁处于被占用状态,那么线程会不断地循环检测该标志位,直到锁的状态变为可用。

2. 读写锁(reader-writer lock):读写锁是一种基于共享资源的并发控制机制,它允许多个线程同时读取共享资源,但在写操作时,必须互斥,即只允许一个线程进行写操作。

读写锁适用于读操作频繁而写操作较少的场景,可以提高系统的并发性能。

读写锁的实现需要维护两个计数器,分别用于记录当前读操作的线程数和写操作的线程数。

3. 互斥锁(mutex):互斥锁是最常用的一种锁机制,也是最简单的一种。

互斥锁可以通过实现线程之间的互斥访问共享资源来保证数据的一致性。

在线程需要访问共享资源之前,会先尝试获取互斥锁,如果锁已经被其他线程占用,那么线程就会进入阻塞状态,直到锁被释放。

互斥锁可以保证同时只有一个线程在访问共享资源,从而避免了竞态条件的发生。

4. 信号量(semaphore):信号量是一种更为复杂的锁机制,它可以控制对共享资源的访问权限。

信号量可以用来解决生产者-消费者问题、读写者问题等。

信号量分为二进制信号量(只能取0或1)和计数信号量(可以取多个非负整数)。

线程可以通过等待(wait)操作来获取信号量,如果信号量的值大于0,那么线程可以继续执行,如果信号量的值等于0,那么线程就会进入阻塞状态。

线程可以通过释放(post)操作来释放信号量,从而允许其他线程获取信号量。

5. 屏障(barrier):屏障是一种同步机制,它可以确保多个线程在一些点上一起等待,直到所有线程都到达该点后才能继续执行。

屏障可以用来解决多线程计算中的数据依赖问题。

嵌入式Linux C语言模拟题及答案

嵌入式Linux C语言模拟题及答案一:选择题1.删除文件命令为( D )A.mkdirB.moveC.mvD.rm2.下面不是对Linux操作系统特点描述的是( B )。

[A] 良好的可移植性[B] 单用户[C] 多用户[D] 多任务3.任何时候用户需要回到用户主目录时可以使用命令 ( A ) 。

A. cdB. pwdC. pathD. cd .4.刷新文件时间戳可以使用的命令为( D )。

chmod B.more C.ls D.touch5.下列结构,属于线性结构的是(c)A.二叉树B.有向无环图C.循环队列D.霍夫曼树6.判断有头单链表head为空的条件是(b)A.Head == NULL;B.Head->next == NULL;C.Head->next != NULL;D.Head != NULL;7.二叉树的第k层最多有几个节点(d)A.2k-1B.2k+1C.2k+1D.2k-18.以读写方式打开一个已存在的标准I/O流时应指定哪个mode参数( B )[A] r [B] r+ [C] w+ [D] a+9.fork()的返回值不可能是( C )[A] -1 [B] 0 [C] 1 [D] 大于10000的正整数10.下列哪个函数无法传递进程结束时的状态( A )[A]close [B] exit [C] _exit [D] return11.下列对无名管道描述错误的是( C )[A] 半双工的通信模式[B]有固定的读端和写端[C]可以使用lseek函数[D] 只存在于内存中12.下列哪个是不带缓存的( C )[A] stdin [B] stdout [C] stderr [D]都不是13.默认情况下,不会终止进程的信号是( D )[A] SIGINT [B] SIGKILL [C] SIGALRM [D] SIGCHLD14.以下对早期ARPAnet的描述不正确的是 ( ) D[A] 使用NCP协议 [B] 不能互联不同类型的计算机[C] 没有纠错功能[D] 可以互联不同类型的操作系统15.将套接字和某个地址绑定可用下面那个函数()B[A] listen函数[B] bind 函数[C] accept函数[D] connect函数16.Socket API中,使用SOCK_STREAM,套接字是什么类型()(联发科)A[A] 流式套接字 [B] 数据报套接字 [C] 原始套接字 [D] 其他套接字17.I2C传输是____方式传输。

linux进程调度算法

linux进程调度方法(SCHED_OTHER,SCHED_FIFO,SCHED_RR)linux内核的三种调度方法:1,SCHED_OTHER 分时调度策略,2,SCHED_FIFO实时调度策略,先到先服务3,SCHED_RR实时调度策略,时间片轮转linux内核的三种调度方法:1,SCHED_OTHER 分时调度策略,2,SCHED_FIFO实时调度策略,先到先服务3,SCHED_RR实时调度策略,时间片轮转实时进程将得到优先调用,实时进程根据实时优先级决定调度权值,分时进程则通过nice和counter值决定权值,nice越小,counter越大,被调度的概率越大,也就是曾经使用了cpu最少的进程将会得到优先调度。

SHCED_RR和SCHED_FIFO的不同:当采用SHCED_RR策略的进程的时间片用完,系统将重新分配时间片,并置于就绪队列尾。

放在队列尾保证了所有具有相同优先级的RR任务的调度公平。

SCHED_FIFO一旦占用cpu则一直运行。

一直运行直到有更高优先级任务到达或自己放弃。

如果有相同优先级的实时进程(根据优先级计算的调度权值是一样的)已经准备好,FIFO时必须等待该进程主动放弃后才可以运行这个优先级相同的任务。

而RR可以让每个任务都执行一段时间。

相同点:RR和FIFO都只用于实时任务。

创建时优先级大于0(1-99)。

按照可抢占优先级调度算法进行。

就绪态的实时任务立即抢占非实时任务。

所有任务都采用linux分时调度策略时。

1,创建任务指定采用分时调度策略,并指定优先级nice值(-20~19)。

2,将根据每个任务的nice值确定在cpu上的执行时间(counter)。

3,如果没有等待资源,则将该任务加入到就绪队列中。

4,调度程序遍历就绪队列中的任务,通过对每个任务动态优先级的计算(counter+20-nice)结果,选择计算结果最大的一个去运行,当这个时间片用完后(counter减至0)或者主动放弃cpu时,该任务将被放在就绪队列末尾(时间片用完)或等待队列(因等待资源而放弃cpu)中。

pthread_mutext_t 的内部结构体描述

pthread_mutext_t 的内部结构体描述可以通过查阅相关资料和源码来进行分析。

pthread_mutext_t 是 POSIX 线程库中用于实现互斥锁的数据类型,它的内部结构体描述了互斥锁的具体实现方式,包括锁的状态、加锁的线程信息等。

了解 pthread_mutext_t 的内部结构体可以帮助我们更深入地理解互斥锁的工作原理和使用方式。

要描述 pthread_mutext_t 的内部结构体,首先需要了解 POSIX 线程库的相关标准,以及具体实现该库的操作系统或者库的源代码。

在此基础上,我们可以通过分析互斥锁的基本原理和逻辑来推测pthread_mutext_t 的内部结构。

以下是对 pthread_mutext_t 内部结构体的可能描述:1. 锁的状态信息:pthread_mutext_t 内部应该包含了描述互斥锁当前状态的信息,比如是否已被锁定、是否为递归锁、是否处于快速互斥锁状态等。

这些状态信息可以帮助我们了解锁的当前情况,以及在加锁和解锁操作时的相应处理。

2. 锁的拥有者信息:如果是递归锁,pthread_mutext_t 内部可能包含了当前拥有该锁的线程信息,包括线程 ID、线程状态等。

这样可以确保在解锁操作时只有拥有锁的线程才能解锁,避免出现多线程下的死锁等问题。

3. 等待队列信息:当锁已被其他线程占用时,当前线程需要进入等待队列。

pthread_mutext_t 内部可能包含了维护等待队列的相关信息,比如等待队列的头指针、尾指针,以及相关的线程状态信息等。

这些信息可以帮助我们了解等待队列的管理方式和机制。

4. 原子操作保障:为了保证多线程环境下的互斥操作,pthread_mutext_t 内部可能会使用原子操作来确保对锁状态和等待队列的操作是原子的,不会被打断或者产生竞态条件。

这可以通过对pthread_mutext_t 内部实现的分析来推测其可能会使用的原子操作方式和机制。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

相信很多写程序的人都写过 socket 的程序。

当我们 open 一个 socket 之后,接着去读取这个 socket,如果此时没有任何资料可供读取,那 read 就会 block 住。

(这是没有加上 O_NONBLOCK 的情形),直到有资料可读取才会传回来。

在 Linux kernel 里有一个数据结构可以帮助我们做到这样的功能。

这个数据结构就是这里要跟各位介绍的 wait queue。

在 k ernel 里,wait_queue 的应用很广,举凡 device driver semaphore 等方面都会使用到 wait_queue 来 implement。

所以,它算是 kernel 里蛮基本的一个数据结构。

接下来,我要跟各位介绍一下 wait_queue 的用法,以及用一个例子来说明如何使用 wait _queue。

最后,我会带各位去 trace 一下 wait_queue 的原始程序代码,看看 wait_queu e 是如何做到的。

我想有件事要先提及的是 Linux 在 user space 跟在 kernel space 上的差异。

我们知道 Linux 是 multi-tasking 的环境,同时可以有很多人执行很多的程序。

这是从 user 的观点来看的。

如果就 kernel 的观点来看,是没有所谓的 multi-tasking 的。

在 kernel 里,只有 single-thread。

也就是说,如果你的 kernel code 正在执行,那系统里只有那部分在执行。

不会有另一部分的 kernel code 也在运作。

当然,这是指 single processor 的情况下,如果是 SMP 的话,那我就不清楚了。

我想很多人都在 Windows 3.1 下写过程序,在那种环境下写程序,每一个程序都必须适当的将 CPU 让给别的程序使用。

如果有个程序里面有一个while (1);的话,那保证系统就停在那里了。

这种的多任务叫做 non-preemptive。

它多任务的特性是由各个程序相互合作而造成的。

在 Linux 的 user space 下,则是所谓的 preemptive,各个 process 喜欢执行什么就执行什么,就算你在你的程序里加上 while(1); 这一行也不会影响系统的运作。

反正时间到了,系统自动就会将你的程序停住,让别的程序去执行。

这是在 user space 的情况下,在 kernel 这方面,就跟 Windows 3.1 程序是一样的。

在 ker nel 里,你必须适当的将 CPU 的执行权释放出来。

如果你在 kernel里加入 while(1); 这一行。

那系统就会跟 Windows 3.1 一样。

卡在那里。

当然啦,我是没试过这样去改 kerne l,有兴趣的人可以去试试看,如果有不同的结果,请记得告诉我。

假设我们在 kernel 里产生一个 buffer,user 可以经由 read,write 等 system call 来读取或写资料到这个 buffer 里。

如果有一个 user 写资料到 buffer 时,此时 buffer 已经满了。

那请问你要如何去处理这种情形呢 ? 第一种,传给 user 一个错误讯息,说 b uffer 已经满了,不能再写入。

第二种,将 user 的要求 block 住,等有人将 buffer 内容读走,留出空位时,再让 user 写入资料。

但问题来了,你要怎么将 user 的要求 bloc k 住。

难道你要用while ( is_full );write_to_buffer;这样的程序代码吗? 想想看,如果你这样做会发生什么事? 第一,kernel会一直在这个 wh ile 里执行。

第二个,如果 kernel 一直在这个 while 里执行,表示它没有办法去 maintain系统的运作。

那此时系统就相当于当掉了。

在这里 is_full 是一个变量,当然,你可以让 is_full 是一个 function,在这个 function里会去做别的事让 kernel 可以运作,那系统就不会当。

这是一个方式。

但是,如果我们使用 wait_queue 的话,那程序看起来会比较漂亮,而且也比较让人了解,如下所示:struct wait_queue *wq = NULL; /* global variable */while ( is_full ) {interruptible_sleep_on( &wq );}write_to_buffer();interruptible_sleep_on( &wq ) 是用来将目前的 process,也就是要求写资料到 buffer 的 process放到 wq 这个 wait_queue 里。

在 interruptible_sleep_on 里,则是最后会呼叫 schedule() 来做 schedule 的动作,也就是去找另一个 process 来执行以维持系统的运作。

当执行完 interruptible_sleep_on 之后,要求 write 的 process 就会被 bloc k 住。

那什么时候会恢复执行呢 ? 这个 process 之所以会被 block 住是因为 buffer 的空间满了,无法写入。

但是如果有人将 buffer 的资料读取掉,则 buffer 就有空间可以让人写入。

所以,有关于叫醒 process 的动作应该是在 read buffer 这方面的程序代码做的。

extern struct wait_queue *wq;if ( !is_empty ) {read_from_buffer();wake_up_interruptible( &wq );}....以上的程序代码应该要放在 read buffer 这部分的程序代码里,当 buffer 有多余的空间时,我们就呼叫 wake_up_interruptible( &wq ) 来将挂在 wq 上的所有 process 叫醒。

请记得,我是说将 wq 上的所有 process 叫醒,所以,如果如果有10个 process 挂在 wq 上的话,那这 10 个都会被叫醒。

之后,至于谁先执行。

则是要看 schedule 是怎么做的。

就是因为这 10 个都会被叫醒。

如果 A 先执行,而且万一很不凑巧的,A 又把 buffer 写满了,那其它 9 个 process 要怎么办呢? 所以在 write buffer 的部分,需要用一个 wh ile 来检查 buffer 目前是否满了.如果是的话,那就继续挂在 wq 上面.上面所谈的就是 wait_queue 的用法。

很简单不是吗? 接下来,我会再介绍一下 wait_que ue 提供那些 function 让我们使用。

让我再重申一次。

wait_queue 应设为 global varia ble,比方叫 wq,只要任何的 process 想将自己挂在上面,就可以直接叫呼叫 sleep_on 等 function。

要将 wq 上的 process 叫醒。

只要呼叫 wake_up 等 function 就可以了.就我所知,wait_queue 提供4个 function 可以使用,两个是用来将 process 加到 wait _queue 的:sleep_on( struct wait_queue **wq );interruptible_sleep_on( struct wait_queue **wq );另外两个则是将process从wait_queue上叫醒的。

wake_up( struct wait_queue **wq );wake_up_interruptible( struct wait_queue **wq );我现在来解释一下为什么会有两组。

有 interruptible 的那一组是这样子的。

当我们去 r ead 一个没有资料可供读取的 socket 时,process 会 block 在那里。

如果我们此时按下 Ctrl+C,那 read() 就会传回 EINTR。

像这种的 block IO 就是使用 interruptible_slee p_on() 做到的。

也就是说,如果你是用 interruptible_sleep_on() 来将 process 放到 wait_queue 时,如果有人送一个 signal 给这个 process,那它就会自动从 wait_queue 中醒来。

但是如果你是用 sleep_on() 把 process 放到 wq 中的话,那不管你送任何的 s ignal 给它,它还是不会理你的。

除非你是使用 wake_up() 将它叫醒。

sleep 有两组。

wa ke_up 也有两组。

wake_up_interruptible() 会将 wq 中使用 interruptible_sleep_on() 的 process 叫醒。

至于 wake_up() 则是会将 wq 中所有的 process 叫醒。

包括使用 int erruptible_sleep_on() 的 process。

在使用 wait_queue 之前有一点需要特别的小心,呼叫 interruptible_sleep_on() 以及 sleep_on() 的 function 必须要是 reentrant。

简单的说,reentrant 的意思是说此 fun ction不会改变任何的 global variable,或者是不会 depend on 任何的 global variabl e,或者是在呼叫 interruptible_sleep_on() 或 sleep_on() 之后不会 depend on 任何的 global variable。

因为当此 function 呼叫 sleep_on() 时,目前的 process 会被暂停执行。

可能另一个 process 又会呼叫此 function。

若之前的 process 将某些 informati on 存在 global variable,等它恢复执行时要使用,结果第二行程进来了,又把这个 glo bal variable 改掉了。

等第一个 process 恢复执行时,放在 global variable 中的 inf ormation 都变了。

产生的结果恐怕就不是我们所能想象了。

其实,从 process 执行指令到此 function 中所呼叫的 function 都应该是要 reentrant 的。

不然,很有可能还是会有上述的情形发生.由于 wait_queue 是 kernel 所提供的,所以,这个例子必须要放到 kernel 里去执行。