hadoop2.64搭建

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu_CentOS

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS本教程讲述如何配置Hadoop 集群,默认读者已经掌握了Hadoop 的单机伪分布式配置,否则请先查看Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置。

本教程由厦门大学数据库实验室出品,转载请注明。

本教程适合于原生Hadoop 2,包括Hadoop 2.6.0, Hadoop 2.7.1 等版本,主要参考了官方安装教程,步骤详细,辅以适当说明,保证按照步骤来,都能顺利安装并运行Hadoop。

另外有Hadoop安装配置简略版方便有基础的读者快速完成安装。

为了方便新手入门,我们准备了两篇不同系统的Hadoop 伪分布式配置教程。

但其他Hadoop 教程我们将不再区分,可同时适用于Ubuntu 和CentOS/RedHat 系统。

例如本教程以Ubuntu 系统为主要演示环境,但对Ubuntu/CentOS 的不同配置之处、CentOS 6.x 与CentOS 7 的操作区别等都会尽量给出注明。

环境本教程使用Ubuntu 14.04 64位作为系统环境,基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1,Hadoop 2.4.1 等。

本教程简单的使用两个节点作为集群环境: 一个作为Master 节点,局域网IP 为192.168.1.121;另一个作为Slave 节点,局域网IP 为192.168.1.122。

准备工作Hadoop 集群的安装配置大致为如下流程:1.选定一台机器作为Master2.在Master 节点上配置hadoop 用户、安装SSH server、安装Java 环境3.在Master 节点上安装Hadoop,并完成配置4.在其他Slave 节点上配置hadoop 用户、安装SSH server、安装Java 环境5.将Master 节点上的/usr/local/hadoop 目录复制到其他Slave 节点上6.在Master 节点上开启Hadoop配置hadoop 用户、安装SSH server、安装Java 环境、安装Hadoop 等过程已经在Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置中有详细介绍,请前往查看,不再重复叙述。

Hadoop安装部署手册

1.1软件环境1)CentOS6.5x642)Jdk1.7x643)Hadoop2.6.2x644)Hbase-0.98.95)Zookeeper-3.4.61.2集群环境集群中包括 3个节点:1个Master, 2个Slave2安装前的准备2.1下载JDK2.2下载Hadoop2.3下载Zookeeper2.4下载Hbase3开始安装3.1 CentOS安装配置1)安装3台CentOS6.5x64 (使用BasicServer模式,其他使用默认配置,安装过程略)2)Master.Hadoop 配置a)配置网络修改为:保存,退出(esc+:wq+enter ),使配置生效b) 配置主机名修改为:c)配置 hosts修改为:修改为:在最后增加如下内容以上调整,需要重启系统才能生效g) 配置用户新建hadoop用户和组,设置 hadoop用户密码id_rsa.pub ,默认存储在"/home/hadoop/.ssh" 目录下。

a) 把id_rsa.pub 追加到授权的 key 里面去b) 修改.ssh 目录的权限以及 authorized_keys 的权限c) 用root 用户登录服务器修改SSH 配置文件"/etc/ssh/sshd_config"的下列内容3) Slavel.Hadoop 、Slavel.Hadoop 配置及用户密码等等操作3.2无密码登陆配置1)配置Master 无密码登录所有 Slave a)使用 hadoop 用户登陆 Master.Hadoopb)把公钥复制所有的 Slave 机器上。

使用下面的命令格式进行复制公钥2) 配置Slave 无密码登录Mastera) 使用hadoop 用户登陆Slaveb)把公钥复制Master 机器上。

使用下面的命令格式进行复制公钥id_rsa 和相同的方式配置 Slavel 和Slave2的IP 地址,主机名和 hosts 文件,新建hadoop 用户和组c) 在Master机器上将公钥追加到authorized_keys 中3.3安装JDK所有的机器上都要安装 JDK ,先在Master服务器安装,然后其他服务器按照步骤重复进行即可。

搭建hadoop集群的步骤

搭建hadoop集群的步骤Hadoop是一个开源的分布式计算平台,用于存储和处理大规模的数据集。

在大数据时代,Hadoop已经成为了处理海量数据的标准工具之一。

在本文中,我们将介绍如何搭建一个Hadoop集群。

步骤一:准备工作在开始搭建Hadoop集群之前,需要进行一些准备工作。

首先,需要选择适合的机器作为集群节点。

通常情况下,需要至少三台机器来搭建一个Hadoop集群。

其次,需要安装Java环境和SSH服务。

最后,需要下载Hadoop的二进制安装包。

步骤二:配置Hadoop环境在准备工作完成之后,需要对Hadoop环境进行配置。

首先,需要编辑Hadoop的配置文件,包括core-site.xml、hdfs-site.xml、mapred-site.xml和yarn-site.xml。

其中,core-site.xml用于配置Hadoop的核心参数,hdfs-site.xml用于配置Hadoop分布式文件系统的参数,mapred-site.xml用于配置Hadoop的MapReduce参数,yarn-site.xml用于配置Hadoop的资源管理器参数。

其次,需要在每个节点上创建一个hadoop用户,并设置其密码。

最后,需要在每个节点上配置SSH免密码登录,以便于节点之间的通信。

步骤三:启动Hadoop集群在完成Hadoop环境的配置之后,可以启动Hadoop集群。

首先,需要启动Hadoop的NameNode和DataNode服务。

NameNode是Hadoop分布式文件系统的管理节点,负责管理文件系统的元数据。

DataNode是Hadoop分布式文件系统的存储节点,负责实际存储数据。

其次,需要启动Hadoop的ResourceManager和NodeManager服务。

ResourceManager 是Hadoop的资源管理器,负责管理集群中的资源。

NodeManager是Hadoop的节点管理器,负责管理每个节点的资源。

hadoop集群安装配置的主要操作步骤-概述说明以及解释

hadoop集群安装配置的主要操作步骤-概述说明以及解释1.引言1.1 概述Hadoop是一个开源的分布式计算框架,主要用于处理和存储大规模数据集。

它提供了高度可靠性、容错性和可扩展性的特性,因此被广泛应用于大数据处理领域。

本文旨在介绍Hadoop集群安装配置的主要操作步骤。

在开始具体的操作步骤之前,我们先对Hadoop集群的概念进行简要说明。

Hadoop集群由一组互联的计算机节点组成,其中包含了主节点和多个从节点。

主节点负责调度任务并管理整个集群的资源分配,而从节点则负责实际的数据存储和计算任务执行。

这种分布式的架构使得Hadoop可以高效地处理大规模数据,并实现数据的并行计算。

为了搭建一个Hadoop集群,我们需要进行一系列的安装和配置操作。

主要的操作步骤包括以下几个方面:1. 硬件准备:在开始之前,需要确保所有的计算机节点都满足Hadoop的硬件要求,并配置好网络连接。

2. 软件安装:首先,我们需要下载Hadoop的安装包,并解压到指定的目录。

然后,我们需要安装Java开发环境,因为Hadoop是基于Java 开发的。

3. 配置主节点:在主节点上,我们需要编辑Hadoop的配置文件,包括核心配置文件、HDFS配置文件和YARN配置文件等。

这些配置文件会影响到集群的整体运行方式和资源分配策略。

4. 配置从节点:与配置主节点类似,我们也需要在每个从节点上进行相应的配置。

从节点的配置主要包括核心配置和数据节点配置。

5. 启动集群:在所有节点的配置完成后,我们可以通过启动Hadoop 集群来进行测试和验证。

启动过程中,我们需要确保各个节点之间的通信正常,并且集群的各个组件都能够正常启动和工作。

通过完成以上这些操作步骤,我们就可以成功搭建一个Hadoop集群,并开始进行大数据的处理和分析工作了。

当然,在实际应用中,还会存在更多的细节和需要注意的地方,我们需要根据具体的场景和需求进行相应的调整和扩展。

Hadoop集群的搭建方法与步骤

Hadoop集群的搭建方法与步骤随着大数据时代的到来,Hadoop作为一种分布式计算框架,被广泛应用于数据处理和分析领域。

搭建一个高效稳定的Hadoop集群对于数据科学家和工程师来说至关重要。

本文将介绍Hadoop集群的搭建方法与步骤。

一、硬件准备在搭建Hadoop集群之前,首先要准备好适合的硬件设备。

Hadoop集群通常需要至少三台服务器,一台用于NameNode,两台用于DataNode。

每台服务器的配置应该具备足够的内存和存储空间,以及稳定的网络连接。

二、操作系统安装在选择操作系统时,通常推荐使用Linux发行版,如Ubuntu、CentOS等。

这些操作系统具有良好的稳定性和兼容性,并且有大量的Hadoop安装和配置文档可供参考。

安装操作系统后,确保所有服务器上的软件包都是最新的。

三、Java环境配置Hadoop是基于Java开发的,因此在搭建Hadoop集群之前,需要在所有服务器上配置Java环境。

下载最新版本的Java Development Kit(JDK),并按照官方文档的指引进行安装和配置。

确保JAVA_HOME环境变量已正确设置,并且可以在所有服务器上运行Java命令。

四、Hadoop安装与配置1. 下载Hadoop从Hadoop官方网站上下载最新的稳定版本,并将其解压到一个合适的目录下,例如/opt/hadoop。

2. 编辑配置文件进入Hadoop的安装目录,编辑conf目录下的hadoop-env.sh文件,设置JAVA_HOME环境变量为Java的安装路径。

然后,编辑core-site.xml文件,配置Hadoop的核心参数,如文件系统的默认URI和临时目录。

接下来,编辑hdfs-site.xml文件,配置Hadoop分布式文件系统(HDFS)的相关参数,如副本数量和数据块大小。

最后,编辑mapred-site.xml文件,配置MapReduce框架的相关参数,如任务调度器和本地任务运行模式。

Win7+Eclipse+Hadoop2.6.4开发环境搭建

Win7+Eclipse+Hadoop2.6.4开发环境搭建Hadoop开发环境搭建⼀、软件准备JDK:jdk-7u80-windows-x64.exeEclipse:eclipse-jee-mars-2-win32-x86_64.zipHadoop:hadoop-2.6.4.tar.gzHadoop-Src:hadoop-2.6.4-src.tar.gzAnt:apache-ant-1.9.6-bin.zipHadoop-Common:hadoop2.6(x64)V0.2.zip (2.4以后)、(hadoop-common-2.2.0-bin-master.zip)Hadoop-eclipse-plugin:hadoop-eclipse-plugin-2.6.0.jar⼆、搭建环境1. 安装JDK执⾏“jdk-7u80-windows-x64.exe”,步骤选择默认下⼀步即可。

2. 配置JDK、Ant、Hadoop环境变量解压hadoop-2.6.4.tar.gz、apache-ant-1.9.6-bin.zip、hadoop2.6(x64)V0.2.zip、hadoop-2.6.4-src.tar.gz到本地磁盘,位置任意。

配置系统环境变量JAVA_HOME、ANT_HOME、HADOOP_HOME,并将这些环境变量的bin⼦⽬录配置到path变量中。

将hadoop2.6(x64)V0.2下的hadoop.dll和winutils.exe复制到HADOOP_HOME/bin⽬录下。

3. 配置Eclipse将hadoop-eclipse-plugin-2.6.0.jar复制到eclilpse的plugins⽬录下。

启动eclipse,并设置好workspace。

插件安装成功的话,启动之后可以看到如下内容:4. 配置hadoop打开“window”-“Preferenes”-“Hadoop Mep/Reduce”,配置到Hadoop_Home⽬录。

hadoop2.6.4搭建

ssh连接免密码配置由于配置过程中需要频繁的进行ssh连接到开发服务器执行命令以及通过scp命令向服务器拷贝文件等依赖ssh连接的操作。

所以,配置本地环境跟服务器之间的ssh免密码连接可以有效的提升工作效率。

由于我本机已经生成过公钥,所以我只需将已有的公钥拷贝到服务器即可。

推荐使用ssh-copy-id命令,简单又不会出错。

手动copy 再append的公钥文件尾,容易因为操作问题,造成无法正确识别公钥。

注:如果你没有生成过公钥,可通过ssh-keygen命令生成公钥。

走默认配置即可。

在我的mac上,居然还没有安装ssh-copy-id命令。

通过brew 命令安装即可。

brew install ssh-copy-id然后copy公钥到指定主机ssh-copy-id root@172.20.2.14其中,root@172.20.2.14改为你需要访问的服务器的用户名@IP。

根据提示输入一次密码。

成功后,所有基于ssh的命令你只需要通过用户名@IP 即可直接访问服务器。

新用户、用户组创建为了更好的权限控制,养成良好的Linux使用习惯,我们首先创建一个管理和使用hadoop 集群的用户(组)dps-hadoop。

这也是hadoop集群管理所需要的环境配置。

groupadd dps-hadoopuseradd -d /home/dps-hadoop -g dps-hadoop dps-hadoop考虑到难免需要使用sudo提权的情况,给该用户配置到sudo名单下, 修改/etc/sudoers文件。

vim /etc/sudoers新增一行记录:dps-hadoop ALL=(ALL) ALL此后,我们均使用dps-hadoop用户进行操作。

配置本地DNS服务器之前我介绍了如何用Docker搭建本地的DNS服务器,这里终于派上用处。

如果你没有本地DNS服务器,那么你修改/etc/hosts文件也可以。

对于CentOS,临时生效的配置文件在/etc/resolv.conf你可以看到该文件开头提示你,该文件是自动生成的。

hadoop集群搭建步骤

hadoop集群搭建步骤Hadoop集群搭建步骤Hadoop是一个开源的分布式计算框架,被广泛应用于大数据处理。

搭建Hadoop集群可以提供高可用性、高性能的分布式计算环境。

下面将介绍Hadoop集群的搭建步骤。

1. 硬件准备需要准备一组具有较高性能的服务器作为集群中的节点。

这些服务器需满足一定的硬件要求,包括处理器、内存和存储空间等。

通常情况下,建议使用至少3台服务器来搭建一个最小的Hadoop集群。

2. 操作系统安装在每台服务器上安装合适的操作系统,例如CentOS、Ubuntu等。

操作系统应该是最新的稳定版本,并且需要进行基本的配置,如网络设置、安装必要的软件和工具等。

3. Java环境配置Hadoop是基于Java开发的,因此需要在每台服务器上安装Java 开发环境。

确保安装的Java版本符合Hadoop的要求,并设置好相应的环境变量。

4. Hadoop安装和配置下载Hadoop的最新稳定版本,并将其解压到指定的目录。

然后,需要进行一些配置来启动Hadoop集群。

主要的配置文件包括hadoop-env.sh、core-site.xml、hdfs-site.xml和mapred-site.xml等。

在hadoop-env.sh文件中,可以设置一些全局的环境变量,如Java路径、Hadoop日志目录等。

在core-site.xml文件中,配置Hadoop的核心设置,如Hadoop的文件系统类型(HDFS)和默认的文件系统地址等。

在hdfs-site.xml文件中,配置HDFS的相关设置,如副本数量、数据块大小等。

在mapred-site.xml文件中,配置MapReduce的相关设置,如任务调度方式、任务跟踪器地址等。

5. 配置SSH免密码登录为了实现集群中各节点之间的通信,需要配置SSH免密码登录。

在每台服务器上生成SSH密钥,并将公钥添加到所有其他服务器的授权文件中,以实现无需密码即可登录其他服务器。

(完整word版)Hadoop 2.6.0分布式部署参考手册

Hadoop 2。

6.0分布式部署参考手册1。

环境说明 (2)1。

1安装环境说明 (2)2。

2 Hadoop集群环境说明: (2)2。

基础环境安装及配置 (2)2.1 添加hadoop用户 (2)2.2 JDK 1.7安装 (2)2.3 SSH无密码登陆配置 (3)2.4 修改hosts映射文件 (3)3.Hadoop安装及配置 (4)3.1 通用部分安装及配置 (4)3。

2 各节点配置 (4)4。

格式化/启动集群 (4)4.1 格式化集群HDFS文件系统 (4)4。

2启动Hadoop集群 (4)附录1 关键配置内容参考 (5)1 core-site.xml (5)2 hdfs-site。

xml (5)3 mapred—site.xml (6)4 yarn-site。

xml (6)5 hadoop-env。

sh (6)6 slaves (6)附录2 详细配置内容参考 (7)1 core-site.xml (7)2 hdfs-site.xml (7)3 mapred—site。

xml (8)4 yarn-site。

xml (9)5 hadoop-env。

sh (12)6 slaves (12)附录3 详细配置参数参考 (12)conf/core—site.xml (12)conf/hdfs-site。

xml (12)o Configurations for NameNode: (12)o Configurations for DataNode: (13)conf/yarn—site。

xml (13)o Configurations for ResourceManager and NodeManager: (13)o Configurations for ResourceManager: (13)o Configurations for NodeManager: (15)o Configurations for History Server (Needs to be moved elsewhere): 16 conf/mapred—site.xml (16)o Configurations for MapReduce Applications: (16)o Configurations for MapReduce JobHistory Server: (16)1。

(完整版)Hadoop安装教程_伪分布式配置_CentOS6.4_Hadoop2.6.0

Hadoop安装教程_伪分布式配置_CentOS6.4/Hadoop2.6.0都能顺利在CentOS 中安装并运行Hadoop。

环境本教程使用CentOS 6.4 32位作为系统环境,请自行安装系统(可参考使用VirtualBox安装CentOS)。

如果用的是Ubuntu 系统,请查看相应的Ubuntu安装Hadoop教程。

本教程基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1, Hadoop 2.4.1等。

Hadoop版本Hadoop 有两个主要版本,Hadoop 1.x.y 和Hadoop 2.x.y 系列,比较老的教材上用的可能是0.20 这样的版本。

Hadoop 2.x 版本在不断更新,本教程均可适用。

如果需安装0.20,1.2.1这样的版本,本教程也可以作为参考,主要差别在于配置项,配置请参考官网教程或其他教程。

新版是兼容旧版的,书上旧版本的代码应该能够正常运行(我自己没验证,欢迎验证反馈)。

装好了CentOS 系统之后,在安装Hadoop 前还需要做一些必备工作。

创建hadoop用户如果你安装CentOS 的时候不是用的“hadoop” 用户,那么需要增加一个名为hadoop 的用户。

首先点击左上角的“应用程序” -> “系统工具” -> “终端”,首先在终端中输入su,按回车,输入root 密码以root 用户登录,接着执行命令创建新用户hadoop:如下图所示,这条命令创建了可以登陆的hadoop 用户,并使用/bin/bash 作为shell。

CentOS创建hadoop用户接着使用如下命令修改密码,按提示输入两次密码,可简单的设为“hadoop”(密码随意指定,若提示“无效的密码,过于简单”则再次输入确认就行):可为hadoop 用户增加管理员权限,方便部署,避免一些对新手来说比较棘手的权限问题,执行:如下图,找到root ALL=(ALL) ALL这行(应该在第98行,可以先按一下键盘上的ESC键,然后输入:98 (按一下冒号,接着输入98,再按回车键),可以直接跳到第98行),然后在这行下面增加一行内容:hadoop ALL=(ALL) ALL(当中的间隔为tab),如下图所示:为hadoop增加sudo权限添加上一行内容后,先按一下键盘上的ESC键,然后输入:wq (输入冒号还有wq,这是vi/vim编辑器的保存方法),再按回车键保存退出就可以了。

hadoop完全分布式搭建步骤

Hadoop是一个开源的分布式计算框架,它能够处理大规模数据的存储和处理。

本文将介绍如何搭建Hadoop完全分布式集群。

一、准备工作1. 安装Java环境:Hadoop需要Java环境的支持,因此需要先安装Java环境。

2. 下载Hadoop:从官网下载Hadoop的最新版本。

3. 配置SSH:Hadoop需要通过SSH进行节点之间的通信,因此需要配置SSH。

二、安装Hadoop1. 解压Hadoop:将下载好的Hadoop压缩包解压到指定目录下。

2. 配置Hadoop环境变量:将Hadoop的bin目录添加到系统的PATH环境变量中。

3. 修改Hadoop配置文件:进入Hadoop的conf目录,修改hadoop-env.sh文件和core-site.xml 文件。

4. 配置HDFS:修改hdfs-site.xml文件,设置NameNode和DataNode的存储路径。

5. 配置YARN:修改yarn-site.xml文件,设置ResourceManager和NodeManager的地址和端口号。

6. 配置MapReduce:修改mapred-site.xml文件,设置JobTracker和TaskTracker的地址和端口号。

7. 格式化HDFS:在NameNode所在的节点上执行格式化命令:hadoop namenode -format。

8. 启动Hadoop:在NameNode所在的节点上执行启动命令:start-all.sh。

三、验证Hadoop集群1. 查看Hadoop进程:在NameNode所在的节点上执行jps命令,查看Hadoop进程是否启动成功。

2. 查看Hadoop日志:在NameNode所在的节点上查看Hadoop的日志文件,确认是否有错误信息。

3. 访问Hadoop Web界面:在浏览器中输入NameNode的地址和端口号,访问HadoopWeb界面,确认Hadoop集群是否正常运行。

hadoop安装与配置总结与心得

hadoop安装与配置总结与心得安装与配置Hadoop是一个相对复杂的任务,但如果按照正确的步骤进行,可以顺利完成。

以下是我在安装与配置Hadoop 过程中的总结与心得:1. 首先,确保你已经满足Hadoop的系统要求,并且已经安装了Java环境和SSH。

2. 下载Hadoop的压缩包,并解压到你想要安装的目录下。

例如,解压到/opt/hadoop目录下。

3. 配置Hadoop的环境变量。

打开你的.bashrc文件(或者.bash_profile文件),并添加以下内容:```shellexport HADOOP_HOME=/opt/hadoopexport PATH=$PATH:$HADOOP_HOME/bin```保存文件后,执行source命令使其生效。

4. 配置Hadoop的核心文件。

打开Hadoop的配置文件core-site.xml,并添加以下内容:```xml<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration>```5. 配置Hadoop的HDFS文件系统。

打开Hadoop的配置文件hdfs-site.xml,并添加以下内容:```xml<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>```这里的dfs.replication属性指定了数据块的副本数量,可以根据实际情况进行调整。

6. 配置Hadoop的MapReduce框架。

CentOS(64位)环境下Hadoop2.6.0分布式部署说明

1,准备工作1,部署CentOS 7.0(64位)环境;需配置静态IP地址。

1),设置虚拟机网络。

首先打开本机的”打开网络和共享中心”:选择打开”本地连接”,并点击”属性”,勾选”允许其他网络用户通过此计算机的Internet连接来连接”,从下拉框中选择”VMware Network Adapter VMnet8”:虚拟机菜单->编辑->虚拟网络编辑:选择WMnet8 (NAT模式)设置静态IP地址,进入CentOS系统,打开”系统工具”->”设置”->”网络”,选择”手动”,输入IP地址,地址和网关参考上图的子网IP及网关设置。

设置完毕之后,再开启就可以发现网络IP地址已经变为设置后的地址。

测试网络是否连通:2),设置主机名。

在root下,打开/etc/hostname改为namenode,保存。

2,Hadoop -2.6.0 下载,下载地址:/hadoop/common/hadoop-2.6.0/ 2,安装Java1),搜索jdk开发环境yum search jdk2),安装jdkyum install java-1.8.0-openjdk-devel.x86_643),检查是否安装成功java -version可以看见当前的jdk版本已经是”1.8.0_91”。

表示已经安装成功。

3,安装Hadoop1),将第一步下载的hadoop版本安装包上传至/usr/local/ 文件夹,并解压。

cd /usr/localgunzip hadoop-2.6.0.tar.gztar -xvf hadoop-2.6.0.tar2),配置环境打开/etc/profile在文件的最后位置,追加上如下配置:#set java environmentexport JAVA_HOME=/usr/lib/jvm/javaexport JRE_HOME=$JAVA_HOME/jreexport P ATH=$P ATH:$JAVA_HOME/binexport CLASSP ATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarexport HADOOP_HOME=/usr/local/hadoop-2.6.0export HADOOP_CONF_DIR=/usr/local/hadoop-2.6.0/etc/hadoop export YARN_CONF_DIR=/usr/local/hadoop-2.6.0/etc/hadoopexport P ATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$P ATH3),激活配置source /etc/profile4),创建hdfs相关目录mkdir /home/hadoop/hd_space/tmp -pmkdir /home/hadoop/hd_space/hdfs/name -pmkdir /home/hadoop/hd_space/hdfs/data -pmkdir /home/hadoop/hd_space/mapred/local -pmkdir -p /home/hadoop/hd_space/mapred/systemchown -R hadoop:hadoop /home/hadoop/hd_space/chown -R hadoop:hadoop /usr/local/hadoop-2.6.04,虚拟机克隆1),选择菜单栏中的“虚拟机->管理->克隆”。

hadoop2.6.4-ha集群搭建

<!-- 配置隔离机制方法,多个机制用换行分割,即每个机制暂用一行-->

<property>

<name>dfs.ha.fencing.methods</name>

<value>

sshfence

shell(/bin/true)

</value>

</property>

保存退出

然后创建一个tmp文件夹

mkdir /home/hadoop/app/zookeeper-3.4.5/tmp

echo 1 > /home/hadoop/app/zookeeper-3.4.5/tmp/myid

1.3将配置好的zookeeper拷贝到其他节点(首先分别在hadoop06、hadoop07根目录下创建一个hadoop目录:mkdir /hadoop)

/etc/hosts里面要配置的是内网IP地址和主机名的映射关系

4.关闭防火墙

5.ssh免登陆

6.安装JDK,配置环境变量等

集群规划:

主机名 IP 安装的软件 运行的进程

mini1 192.168.1.200 jdk、hadoop NameNode、DFSZKFailoverController(zkfc)

<property>

<name>node.shared.edits.dir</name>

<value>qjournal://mini5:8485;mini6:8485;mini7:8485/bi</value>

Hadoop集群的搭建和配置

Hadoop集群的搭建和配置Hadoop是一种分布式计算框架,它可以解决大数据处理和分析的问题。

Hadoop由Apache软件基金会开发和维护,它支持可扩展性、容错性、高可用性的分布式计算,并且可以运行在廉价的硬件设备上。

Hadoop集群的搭建和配置需要多个步骤,包括安装Java环境、安装Hadoop软件、配置Hadoop集群、启动Hadoop集群。

以下是这些步骤的详细说明。

第一步:安装Java环境Hadoop运行在Java虚拟机上,所以首先需要安装Java环境。

在Linux系统下,可以使用以下命令安装Java环境。

sudo apt-get install openjdk-8-jdk在其他操作系统下,安装Java环境的方式可能有所不同,请查阅相应的文档。

第二步:安装Hadoop软件Hadoop可以从Apache官方网站上下载最新版本的软件。

下载后,解压缩到指定的目录下即可。

解压缩后的目录结构如下:bin/:包含了Hadoop的可执行文件conf/:包含了Hadoop的配置文件lib/:包含了Hadoop的类库文件sbin/:包含了Hadoop的系统管理命令share/doc/:包含了Hadoop的文档第三步:配置Hadoop集群配置Hadoop集群需要编辑Hadoop的配置文件。

其中最重要的是hadoop-env.sh、core-site.xml、hdfs-site.xml和mapred-site.xml。

hadoop-env.sh:这个文件定义了Hadoop集群的环境变量。

用户需要设置JAVA_HOME、HADOOP_HOME等环境变量的值。

core-site.xml:这个文件定义了Hadoop文件系统的访问方式。

用户需要设置、hadoop.tmp.dir等参数的值。

hdfs-site.xml:这个文件定义了Hadoop分布式文件系统的配置信息。

用户需要设置.dir、dfs.data.dir等参数的值。

搭建hadoop的方法

搭建hadoop的方法1、准备硬件环境:需要至少两台服务器作为节点,配备一定的内存及硬盘空间,用以存放hadoop映射节点和数据。

2、安装JDK:因Hadoop是一个java環境开发的框架,所以安装Hadoop之前第一步必须要安装java环境才能继续执行后续步骤,安装JDK时要根据自己的操作系统的位数进行安装,如果是64位的操作系统,就只能安装64位的java,32位的操作系统也只能安装32位的java,到官网上下载安装就可以了。

3、配置Hadoop:在安装好java之后,需要进行Hadoop的配置,主要就是根据自身的需求修改Hadoop的配置文件。

修改配置文件之前,先根据自身需求构建hadoop环境,安装好Hadoop,然后找到配置文件进行修改,Hadoop 的配置文件包括hadoop目录、java、hdfs、nodes等,根据自己的需求修改、添加信息,例如要配置分布式计算,需要在配置文件中添加slave节点的相关信息。

4、建立SSH连接:在Hadoop的分布式环境中,需要建立ssh的连接,这是一种形式的ip通信,安装完hadoop之后,在配置文件中设置hadoop的主机,以及hdfs的从节点,最后在终端窗口下输入命令ssh-keygen,这样就可以完成hadoop服务主机和从机之间的ssh连接了。

5、安装hadoop Config:设定好hadoop需要的配置文件之后,开始配置hadoop,操作步骤是:先进入hadoop安装目录,运行bin/hadoop-env.sh 文件,然后运行sbin/start-all.sh等命令,运行完之后,就可以启动hadoop 的环境和hadoop的服务,只要hadoop的安装和配置文件都正确操作,hadoop的服务就可以启动成功。

6、安装hadoop工具:安装Hadoop之后,如果要使用它就必须安装一些Hadoop的工具,比如日志查看器,Hadoop管理员等等,可以从Hadoop官网上获取相应的资源下载,或者安装常用的hadoop开发工具。

大数据分析平台Hadoop的部署教程

大数据分析平台Hadoop的部署教程随着互联网和信息技术的发展,大数据分析已经成为企业决策和发展的重要工具。

而Hadoop作为目前应用最广泛的大数据分析平台之一,成为众多企业和组织的首选。

本文将为您提供一份简单而全面的Hadoop部署教程,帮助您快速搭建属于自己的大数据分析平台。

1. 硬件和系统配置在开始部署Hadoop之前,首先需要确保您的硬件配置和操作系统满足最低要求。

对于一般的开发和测试环境,您可以考虑使用至少4核CPU、16GB内存和100GB硬盘空间的机器。

操作系统方面,Hadoop支持Linux和Windows操作系统,我们推荐使用Linux,比如Ubuntu或CentOS。

2. 安装Java Development Kit(JDK)Hadoop是基于Java开发的,因此在部署Hadoop之前,需要先安装Java Development Kit(JDK)。

您可以从官方网站上下载最新版本的JDK。

下载完成后,请按照安装向导一步步进行安装。

安装完成后,设置JAVA_HOME环境变量,并将Java的bin目录添加到PATH变量中,以便在命令行中能够使用Java命令。

3. 下载和配置Hadoop在准备好硬件和操作系统之后,接下来需要下载和配置Hadoop。

您可以从Hadoop官方网站上下载最新版本的Hadoop。

下载完成后,解压缩文件到您的安装目录中。

接下来,您需要对Hadoop进行一些基本配置。

在Hadoop的安装目录中,可以找到core-site.xml、hdfs-site.xml和mapred-site.xml等配置文件的模板。

您需要将这些模板文件复制一份,并将其重命名为core-site.xml、hdfs-site.xml和mapred-site.xml。

然后,您可以编辑这些文件,根据您的需求进行配置。

4. 配置Hadoop集群Hadoop是一个分布式系统,可以通过配置多台机器来搭建一个Hadoop集群。

hadoop环境搭建教学设计 -回复

hadoop环境搭建教学设计-回复如何搭建Hadoop环境。

第一步:准备工作在开始搭建Hadoop环境之前,我们需要准备一些基本的资源。

首先,你需要一台物理机或者虚拟机来安装Hadoop。

其次,你需要安装Java开发工具包(JDK),因为Hadoop是用Java开发的。

最后,你需要下载Hadoop的安装包,你可以从Hadoop的官方网站上获取安装包。

第二步:安装和配置JDK首先,你需要下载合适版本的JDK安装包,并且按照安装向导进行安装。

安装完成后,你需要设置JAVA_HOME环境变量。

在Windows系统中,你可以右键点击“计算机”,选择“属性”,然后点击“高级系统设置”,点击“环境变量”按钮,在“系统变量”下点击“新建”按钮,填写变量名为JAVA_HOME,变量值为JDK的安装路径。

在Linux系统中,你可以通过编辑.bashrc文件来添加JAVA_HOME环境变量。

第三步:安装Hadoop在完成JDK的安装和配置之后,你需要下载Hadoop的安装包。

你可以从Hadoop的官方网站上下载最新版本的安装包。

下载完成后,将安装包解压到一个合适的目录下。

第四步:配置Hadoop在安装Hadoop之前,你需要对Hadoop进行一些配置。

打开Hadoop 的安装目录,你会看到一个名为"etc"的文件夹。

打开这个文件夹,你会看到一些配置文件,包括hadoop-env.sh、core-site.xml等。

你需要根据自己的需求对这些配置文件进行修改。

首先,你需要编辑hadoop-env.sh文件。

这个文件定义了Hadoop的环境变量。

你需要设置JAVA_HOME环境变量,将其指向之前安装的JDK 的路径。

然后,你需要编辑core-site.xml文件。

这个文件定义了Hadoop的核心配置。

你需要设置一个唯一的标识符,这个标识符用来识别你的Hadoop 集群。

你还需要设置Hadoop的文件系统类型,这里我们可以使用HDFS。

hadoop 2.6.0详细安装过程和实例(有截图)

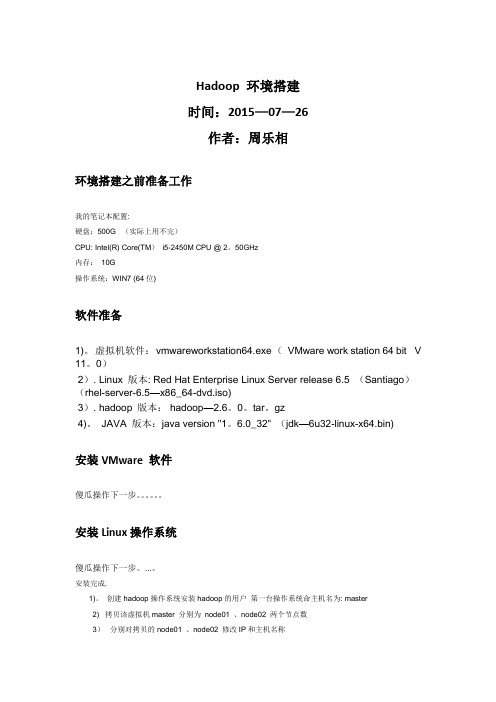

Hadoop 环境搭建时间:2015—07—26作者:周乐相环境搭建之前准备工作我的笔记本配置:硬盘:500G (实际上用不完)CPU: Intel(R) Core(TM)i5-2450M CPU @ 2。

50GHz内存:10G操作系统:WIN7 (64位)软件准备1)。

虚拟机软件:vmwareworkstation64.exe (VMware work station 64 bit V 11。

0)2). Linux 版本: Red Hat Enterprise Linux Server release 6.5 (Santiago)(rhel-server-6.5—x86_64-dvd.iso)3). hadoop 版本: hadoop—2.6。

0。

tar。

gz4)。

JAVA 版本:java version "1。

6.0_32" (jdk—6u32-linux-x64.bin)安装VMware 软件傻瓜操作下一步。

安装Linux操作系统傻瓜操作下一步。

...。

安装完成.1)。

创建hadoop操作系统安装hadoop的用户第一台操作系统命主机名为: master2) 拷贝该虚拟机master 分别为node01 、node02 两个节点数3)分别对拷贝的node01 、node02 修改IP和主机名称主机名: IPmaster : 192。

168.2。

50node01: 192.168.2.51node02: 192。

168.2.52jdk安装并设置好环境变量##设置JAVA_HOME环境变量配置ssh 免密码通信三台服务器SSH关系上面这个图可以表达这三台服务器之间的关系.对master主节点SSH配置执行:ssh-keygen –t dsa 回车一直回车下去会在$HOME/。

ssh目录生成id_dsa 和id_dsa.pub两个文件将id_dsa。

pub文件放到authorized_keys文件,注意需要修改权限chmod 600 authorized_keys依次将node01、node02两台的密码追加到authorized_keys 文件里面对node01节点SSH配置这样master与node01就可以正常的互通无需密码对node02节点SSH配置这样master与node02就可以正常的互通无需密码Hadoop安装配置修改配置文件用红线框起来的都需要修改配置修改:mapred-site。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

环境:centos 6.6 + hadoop2.6虚拟机:(vmware fusion 7.0.0)虚拟机hostname / IP地址master / 192.168.187.102slave01 / 192.168.187.103slave02 / 192.168.187.104注:前三个步骤都是准备工作,如果已经完成,可直接进入步骤四步骤一: 先在3台虚拟机上,设置hostname及修改hosts文件1.1先正确设置各虚拟机的hostnamesudo vi /etc/sysconfig/network将HOSTNAME=后的内容,改成想要的机器名1.2修改hosts文件sudo vi /etc/hosts192.168.187.102 master192.168.187.103 slave01192.168.187.104 slave02这样,就不用记IP了这一步完成后,最好重启一次系统,以便生效。

然后可以用ping master(或slave01、slave02)试下,正常的话,应该能ping通注:hostname不要命名为“xxx.01,xxx.02”之类以“.数字”结尾,否则到最后hadoop的NameNode服务将启动失败。

步骤二:在3台虚拟机上安装jdkyum install java注:hadoop是java写的,jdk是必须的。

上述命令,会安装openjdk最基本的运行时,没有源码和javac等其它工具。

如果要安装javac等编译工具及源码yum install java-1.7.0-openjdk-develyum install java-1.7.0-openjdk-src另外openjdk安装后,不会默许设置JAVA_HOME环境变量,要查看安装后的目录,可以用命令sudo update-alternatives --config java看到默认jre目录为:/usr/lib/java/jvm/jre-1.7.0-openjdk.x86_64如要设置环境变量,可用命令sudo vi /etc/profile在最后添加export JAVA_HOME=/usr/lib/jvm/java-1.7.0-openjdk-1.7.0.75.x86_64exportCLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/jre/lib/dt.jar:$JAVA_HOME/j re/lib/tools.jarexport PATH=$PATH:$JAVA_HOME/bin注:如果不喜欢openjdk,想安装oracle官方的jdk,可按下面步骤操作a) rpm -qa | grep java即:查看当前已经安装的跟java相关的包,如果显示有openjdk在其中b) yum -y remove java一般这样就会卸载干净,执行完以后,再运行a)中的rpm -qa | grep java看看,如果还有残留,可运行rpm -e --nodeps tzdata-java-2015a-1.el6.noarch (最后的部分为要删除的包名,即刚才查出来的结果)重新安装sun jdk,先从官网下载安装文件a) 上传rpm安装文件到虚拟机,参考下面的命令scp jdk-7u51-linux-x64.rpm root@master:/home/hadoop/b) 到虚拟机上,执行安装rpm -ivh jdk-7u51-linux-x64.rpmc) 然后修改环境变量sudo vi /etc/profile,在最后加下面三行export JAVA_HOME=/usr/java/jdk1.7.0_51exportCLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/t ools.jarexport PATH=$PATH:$JAVA_HOME/bin保存退出,然后输入source /etc/profile 以便让新环境变量生效注:如果机器上之前用yum install hadoop之类的命令安装过低版本的hadoop,也必须先卸载干净步骤三:在3台虚拟机上创建专门用户hadoopuseradd hadoop (创建用户)passwd hadoop(设置密码,为简单起见,3台机器上的hadoop密码最好设置成一样,比如hadoop123)为了方便,建议将hadoop加入root用户组,操作方法:先以root身份登录,然后输入usermod -g root hadoop,执行完后hadoop即归属于root组了,可以再输入id hadoop查看输出验证一下,如果看到类似下面的输出:uid=502(hadoop) gid=0(root) 组=0(root)就表示OK了步骤四:配置ssh免密码登录hadoop工作时,各节点要相互通讯,正常情况下linux之间通讯要提供用户名、密码(目的是保证通讯安全),如果需要人工干预输入密码,显然不方便,做这一步的目的,是让各节点能自动通过安全认证,不影响正常通讯。

4.1先在master上,生成公钥、私钥对以hadoop身份登录到系统cd (进入个人主目录,默认为/home/hadoop)ssh-keygen -t rsa -P '' (注:最后是二个单引号)即:以rsa算法,生成公钥、私钥对,-P ''表示空密码。

该命令运行完后,会在个人主目录下生成.ssh目录,里面会有二个文件id_rsa(私钥),id_rsa.pub(公钥)4.2导入公钥cat .ssh/id_rsa.pub >> .ssh/authorized_keys执行完以后,可以在本机上测试下,用ssh连接自己,即:ssh localhost (或ssh master),如果不幸还是提示要输入密码,说明还没起作用,还有一个关键的操作chmod 600 .ssh/authorized_keys (修改文件权限,否则不起作用)然后再测试下ssh localhost ,如果不需要输入密码,就连接成功,表示ok,一台机器已经搞定了。

4.3在其它机器上生成公钥、密钥,并将公钥文件复制到mastera) 以hadoop身份登录其它二台机器slave01、slave02,执行ssh-keygen -t rsa -P '' 生成公钥、密钥b) 然后用scp命令,把公钥文件发放给master(即:刚才已经搞定的那台机器)slave01上:scp .ssh/id_rsa.pub hadoop@master:/home/hadoop/id_rsa_01.pubslave02上:scp .ssh/id_rsa.pub hadoop@master:/home/hadoop/id_rsa_02.pub这二行执行完后,回到master中,查看下/home/hadoop目录,应该有二个新文件id_rsa_01.pub、id_rsa_02.pub,然后在master上,导入这二个公钥cat id_rsa_01.pub >> .ssh/authorized_keyscat id_rsa_02.pub >> .ssh/authorized_keys这样,master这台机器上,就有所有3台机器的公钥了。

4.4将master上的“最全”公钥,复制到其它机器a) 继续保持在master上,scp .ssh/authorized_keyshadoop@slave01:/home/hadoop/.ssh/authorized_keysscp .ssh/authorized_keyshadoop@slave02:/home/hadoop/.ssh/authorized_keysb) 修改其它机器上authorized_keys文件的权限slave01以及slave02机器上,均执行命令chmod 600 .ssh/authorized_keys4.5验证在每个虚拟机上,均用ssh 其它机器的hostname验证下,如果能正常无密码连接成功,表示ok小结:该步骤非常重要,主要思路是在各节点上生成公钥、私钥,然后将公钥发放其它所有节点。

RSA算法是非对称加密算法,仅公布“公钥”,只要私钥不外泄,还是不能解密的,所以安全性依然有保障。

如果本步骤失败,根据我个人经验,多半是权限问题,请检查hadoop是否具有足够权限,建议将hadoop加入sudoers列表及root用户组。

另外,这里也整理了一些SSH免密码设置失败的原因,请移步ssh 免密码设置失败原因总结步骤五:上传并解压hadoop2.6a)在本机上,用scp命令上传hadoop2.6到masterscp hadoop-2.6.0.tar.gz hadoop@master:/home/hadoop/b) 以hadoop身份登录到master,运行以下命令解压tar -zxvf hadoop-2.6.0.tar.gz步骤六:修改配置一共有7个文件要修改:$HADOOP_HOME/etc/hadoop/hadoop-env.sh$HADOOP_HOME/etc/hadoop/yarn-env.sh$HADOOP_HOME/etc/hadoop/core-site.xml$HADOOP_HOME/etc/hadoop/hdfs-site.xml$HADOOP_HOME/etc/hadoop/mapred-site.xml$HADOOP_HOME/etc/hadoop/yarn-site.xml$HADOOP_HOME/etc/hadoop/slaves其中$HADOOP_HOME表示hadoop根目录,本文中默认为/home/hadoop/hadoop-2.6.0a) hadoop-env.sh 、yarn-env.sh这二个文件主要是修改JAVA_HOME后的目录,改成实际本机jdk所在目录位置vi etc/hadoop/hadoop-env.sh (及vi etc/hadoop/yarn-env.sh)找到下面这行的位置,改成(jdk目录位置,大家根据实际情况修改)export JAVA_HOME=/usr/java/jdk1.7.0_51另外hadoop-env.sh中, 建议加上这句:export HADOOP_PREFIX=/home/hadoop/hadoop-2.6.0b) core-site.xml参考下面的内容修改:注:/home/hadoop/tmp 目录如不存在,则先mkdir手动创建core-site.xml的完整参数请参考/docs/r2.6.0/hadoop-project-dist/hadoop-common/ core-default.xmlc) hdfs-site.xml注:dfs.replication表示数据副本数,一般不大于datanode的节点数。