基于Cache的矩阵乘积算法性能改善实验

矩阵乘法的优化

矩阵乘法的优化

矩阵乘法的优化指的是对矩阵乘法运算的改进,以提高其计算效率。

矩阵乘法的优化主要有以下几种方式:

1、使用缓存。

缓存可以提供更快的访问速度,并降低内存访问开销。

在矩阵乘法运算中,多次访问相同矩阵元素时,使用缓存可以有效提高计算效率。

2、采用分块算法。

分块算法将矩阵分割成若干小矩阵,每次计算一小块,从而减少了矩阵的大小,减少了计算量。

3、利用多核处理器。

多核处理器可以同时实现多个矩阵乘法计算,有效提高计算效率。

4、使用SIMD指令。

SIMD指令是单指令多数据指令,可以同时处理多个数据,有效提高计算效率。

5、利用GPU加速。

GPU拥有很高的计算性能,可以有效加速矩阵乘法运算,提高计算效率。

6、使用矩阵复用技术。

矩阵复用技术可以将原来需要执行的多次矩阵乘法运算合并为一次,有效降低计算量。

7、采用矩阵分解算法。

矩阵分解算法可以将大矩阵分解成若干小矩阵,进而减少计算量,提高计算效率。

综上所述,矩阵乘法的优化主要有使用缓存、采用分块算法、利用多核处理器、使用SIMD指令、利用GPU加

速、使用矩阵复用技术、采用矩阵分解算法等方式。

这些方法都可以有效提高矩阵乘法的计算效率,提高矩阵乘法的运行速度,减少计算量。

矩阵的乘法和加法运算的优化设计

I0.H = cArray; I0.L = cArray; I1.H = dArray; I1.L = dArray; P3.H = eArray; P3.L = eArray; call oper;//调用子函数完成 C*D R0 = CYCLES ; R1 = [P0] ; P0.H = cycleCountEnd ; P0.L = cycleCountEnd ; [P0] = R0 ; R0 = R0 - R1 ; [P0] = R0 ; idle; _main.end: oper: I2 = P3;//I2 和 P3 同时指向 eArray,I2 用作拿出 eArray 中已保存的中间结果 A*B,P3 用 于循环中保存运算结果 P4 = I1;//I1 和 P4 同时指向 bArray or dArray,I1 用于取出操作数,P4 用于最外层循环将 I1 恢复被乘矩阵的首地址 loop loop1 LC0 = P2;//外层循环六次,每一次循环将前矩阵向下移动一行,完成一行乘以整个 被乘矩阵 loop_begin loop1; R0=[I0++]||R1=[I1++M1];//取出操作数,为内层运算做准备

2

[P3] = R0; idle; _main.end: oper: R7 = I1; R4 = I0;R5 = I1; loop lpp1 LC0 = P2; loop_begin lpp1; loop_begin lpp2; I0 = R4; I1 = R5; R3 = 0; loop lpp3 LC0 = P2; loop_begin lpp3; R1.L = W[I0++]||R2=[I1]; R0.H = R1.L*R2.H,R0.L = R1.L*R2.L(IS)||I1 += M1; R3 = R3 +|+ R0; loop_end lpp3; R0 = [P3]; R5 += 4; R3 = R3 +|+ R0; [P3++] = R3; loop_end lpp2; LB0 = [ SP++ ]; LT0 = [ SP++ ]; LC0 = [ SP++ ]; R4 += 12; R5 = R7; loop_end lpp1; RTS; oper_end: /* 两列数据同时进行计算,使得第二层减少为三次循环,并行操作;将指针返回操作更改*/ #include"defBF535.h" .section L1_data_a;//declare the data section .BYTE2 aArray[36]="a.dat";//define a Array to save the matrix A .BYTE2 cArray[36]="c.dat";//define a Array to save the matrix B .BYTE4 eArray[36];//define a Array to save the results .VAR cycleCountBegin, cycleCountEnd ; .VAR numCycles ;//define a variable to save the number of CYCLES .align 2; .section program ;//declare the program section .global _main ;//declare the main program

缓存结构GPU矩阵乘法算法的自动优化-精品文档资料

缓存结构GPU矩阵乘法算法的自动优化: Automatic optimization of GEMM algorithm on Fermi GPU and the impact of Fermi GPU’s architectural features on performance are discussed in this paper. The cache on GPU can not only improve the data access locality of processors, but also make the code performance relying on relative algorithm parameters unpredictable. Auto?tuning can be used to solve this problem. Auto?tuned SGEMM and DGEMM codes achieve 563 GFlops and 253 GFlops respectively on C2050 GPU. The codes are implemented by using CUDA and C language, but the optimization on the binary level is not involved.Keywords: GPU programming; matrix multiplication;automatic optimization; GEMM template0 引言Fermi是Nvidia公司支持CUDA编程模型的新一代GPU。

与GT200体系结构相比,新型的Tesla 2050 GPU具有一些新的特性:如增强的双精度浮点性能、L1/L2 缓存结构、更多的寄存器、更大的共享存储器、ECC支持和更快的原子操作[1?3]。

矩阵乘法优化算法

矩阵乘法优化算法引言矩阵乘法是计算机科学和线性代数中的一个重要问题,它在很多领域都有广泛的应用。

随着矩阵规模的增大,传统的矩阵乘法算法的时间复杂度很高,因此需要寻求更高效的算法来解决这个问题。

本文将介绍一些优化矩阵乘法算法的方法,以及它们的原理和优势。

传统的矩阵乘法算法传统的矩阵乘法算法是通过对每个元素进行乘法和累加的方式来计算结果。

具体而言,对于两个矩阵A和B,它们的乘积C的第i行第j列的元素可以通过以下公式计算得到:C(i, j) = A(i, 1) * B(1, j) + A(i, 2) * B(2, j) + … + A(i, n) * B(n, j)其中,n是矩阵的大小。

这种算法的时间复杂度为O(n^3),对于大规模的矩阵运算来说,效率较低。

因此,我们需要寻找更高效的算法来优化矩阵乘法的计算过程。

分块矩阵乘法算法分块矩阵乘法算法是一种通过分块计算的方式来优化矩阵乘法的算法。

具体而言,将两个矩阵A和B分别分成若干个大小相等的小块,然后对每个小块进行乘法计算,最后将结果合并得到最终的乘积矩阵C。

分块矩阵乘法算法的优势在于它可以利用硬件的并行计算能力,提高矩阵乘法的计算效率。

此外,它还可以充分利用计算机的存储层次结构,减少数据的访问延迟,进一步提高计算效率。

下面是分块矩阵乘法算法的具体步骤:1.将矩阵A和B分别分成大小相等的小块,记作A(i,j)和B(i,j)。

2.对于每个小块A(i,j)和B(i,j),计算它们的乘积C(i,j)。

3.将所有的乘积小块C(i,j)合并得到最终的乘积矩阵C。

分块矩阵乘法算法的优化在实际应用中,可以对分块矩阵乘法算法进行一些优化,进一步提高计算效率。

下面介绍几种常见的优化方法:1. 优化块的大小选择合适的块大小可以显著影响计算性能。

一般来说,较大的块可以减少计算过程中的乘法次数,但会增加访存操作的次数。

因此,要根据具体的硬件和应用场景选择合适的块大小。

2. 填充技术填充技术是一种通过在分块矩阵中添加额外的元素来提高访存效率的方法。

矩阵乘法运算效率

矩阵乘法运算效率摘要近年来,处理器运行速度的增长和存储器访问速度的增长之间存在着巨大的差距,这使得两者之间的速度差距越来越大,现代计算机体系结构中广泛采用高速缓冲存储器(Cache)来缓解这两者之间的速度差距。

本文根据矩阵乘法运算的六种不同程序代码,构建了矩阵乘法运算时间的测试程序,得到矩阵乘法运算六种不同版本的运行时间;并通过分析六种不同矩阵乘法运算程序代码中的空间局部性与时间局部性,得出由于高速缓冲存储器和程序访问的局部性差异,同一算法的不同程序代码运行时间相差很大。

为了充分利用高速缓冲存储器,提高程序运行效率,在编写程序时需要考虑程序和数据的空间局部性和时间局部性。

为了充分利用高速缓冲存储器,论文又给出了分块矩阵乘法运算程序,它可以进一步提高矩阵乘法运算效率。

关键字:高速缓冲存储器;矩阵乘法;分块矩阵;局部性原理;时间局部性;空间局部性AbstractRecent years, there has been a big gap between the growth of processor and memory runs access speed, which makes the speed difference between them is more and more big . In modern computer system structure, Cache is widely used to alleviate the speed gap.Based on the six different program code of matrix multiplication, constructs the matrix multiplication time test procedures, obtaining the running time of matrix multiplication six different versions; And through the analysis of space localized and time localized in six different program code of matrix multiplication, it is concluded that due to the cache memory and the local differences of programs access, there is a huge difference in the running time of the same algorithm of different program code. In order to make full use of cache memory and improve program efficiency, it is needed to consider the space and time localized when programming.In order to make full use of cache memory, paper gives the program of partitioned matrix multiplication, which could further improve the matrix multiplication efficiency.Key words: Cache; matrix multiplication; block matrix; principle of locality; temporal locality; spatial locality目录摘要 0Abstract 0第一章概述 (3)1.1 研究背景及意义 (3)1.2 研究内容 (4)第二章基础知识 (5)2.1 矩阵乘法运算 (5)2.2 高速缓冲存储器 (6)2.2.1 设置Cache的理论依据 (6)2.2.2 Cache的体系结构 (8)2.2.3 Cache的相关知识 (8)2.3 开发平台 (9)第三章测试程序 (10)3.1.数据区的设定 (10)3.2.程序执行时间的计算方法 (10)3.3.测试程序的运行结果保存方式 (11)3.4.测试程序代码 (12)第四章结果和分析 (16)4.1实验结果图 (16)4.2实验结果分析 (17)第五章改进的矩阵乘法运算 (18)5.1分块的矩阵乘法运算 (18)5.2分块的矩阵乘法运算实验结果和分析 (19)第六章总结 (21)参考文献 (23)致谢 (25)第一章概述1.1 研究背景及意义在应用程序中,如何提高程序的效率?这是很现实的问题。

利用高速缓存(Cache)的局部性优化矩阵乘法

for ( si = 0; si < n; si += blocksize ) for ( sk = 0; sk < n; sk += blocksize )

-4-

do_block(n, blocksize, si, sj, sk, A, B, C); }

*B, double *C)

{

dgemm (n, blocksize, A+si*n+sk, B+sk*n+sj, C+si*n+sj);

//printf("\n");

//printf("%d %d %d\n", si, sj, sk);

//for(int i = 0; i < n; i++)

//{

}

-2-

分析: 计算机在实际计算上述普通矩阵乘法时,所计算矩阵 C 的每一个数据时,都要用到 矩阵 A 的某行和矩阵 B 中的某列,而矩阵 A、B 和 C 都是存储在内存中的,又由于 CPU 的速度远远大于访问内存的速度,如果是直接从内存读取和写回计算数据,那么计算效率 是非常低下的,由于访问内存会导致时延,CPU 的计算资源被浪费,即计算效率低。 为了提高计算速度,引入了 cache 机制,即先把存放在内存中的矩阵 A、B 的元素调 入 cache,这样寄存器可以先寻访 cache,访问 cache 的速度要比访问内存的速度快,如果 在 cache 中没有所需要的数据时,才需要访问内存。 但是,矩阵 A、B 在实际应用中都包含大量的元素,数据量非常分庞大,也即,上述 程序中 n 很大,而处理器中的 cache 往往很小,因此不能将整个矩阵全部放入 cache 中。 因此需要将这些大的矩阵按照某种方法进行分块,使得分块后的小矩阵可以放入到 cache 中,但是分块又不能随意分,需要有一定的原则去分块,如果分块子矩阵太大,那么子矩 阵还是不能全部放入 cache 中,如果分块子矩阵太小,那么为了计算一个大矩阵的数据, 需要调入 cache 的子矩阵的次数会增加,因此需要选择合适的分块方法。 2.分块实现矩阵乘法,利用 cache 的局部性,优化程序性能: a) 安装 Linux 系统: b) 查看 Linux 系统 cache 的大小:

系统结构实验九:基于Cache的矩阵乘积算法性能改善实验

实验九:基于Cache的矩阵乘积算法性能改善实验一、背景知识Bill Joy(Sun Microsystems公司首席科学家兼首席执行官)曾开玩笑地说,高速缓存(Cache)是计算机科学中唯一重要的思想。

虽然是一句玩笑话,但从中也可以看出高速缓存在计算机系统结构中确实占据了很重要的地位。

描述Cache概念的第一篇论文可以追溯到1965年Wilkes发表的论文“M.V. Wilkes, "Slave Memories and Dynamic Storage Allocation,"Trans. IEEE,Vol. EC-14, No. 2, Apr. 1965, pp. 270-271”,他在文中说“讨论这样一种存储器的使用方式,一个容量为32000个字的快速主存在一个容量为100万个字的速度较慢的主存的控制下工作,则以这种方式,在实际情况中,有效的存储器访问时间接近于快速存储器而不是较慢的存储器”。

Wilkes1913年出生于英国,曾参与EDSAC的设计,1980年因对Cambridge Ring Network的突出贡献而获得Eckert-Mauchly奖。

随后,IBM(何处无君影)在1968年生产出第一台带有Cache的商业化计算机IBM 360/85,测试表明,在11个测试程序中,只有3个程序是360/91(时钟周期60ns)胜过了360/85(时钟周期80ns)。

之后就展开了关于Cache的大讨论。

编译器和操作系统系统结构支持研讨会(Symposium on Architecture Support for Compilers and Operating Systems,ASPLOS)和国际计算机系统结构研讨会(International Computer Architecture Symposium,ISCA)从20世纪90年代以来,发表的关于Cache的论文不计其数,以致有些人戏称ISCA 为国际Cache结构研讨会。

《计算机系统结构》课程教学大纲

《计算机系统结构》课程教学大纲一、课程基本信息课程代码:课程名称:计算机系统结构英文名称:Computer Architecture课程类别: 专业课学时:72(其中实验18学时)学分: 3.5适用对象: 计算机科学与技术、网络工程专业考核方式:考试(其中平时成绩占30%,期末考试成绩占70%)先修课程:计算机组成原理、操作系统二、课程简介本课程是计算机专业一门重要的专业基础课,对于培养学生的抽象思维能力和自顶向下、系统地分析和解决问题的能力有非常重要的作用。

其目标是使学生掌握计算机系统结构的基本概念、基本原理、基本结构、基本设计和分析方法,并对计算机系统结构的发展历史和现状有所了解。

通过学习本课程,能把在“计算机组成原理”等课程中所学的软、硬件知识有机地结合起来,从而建立起计算机系统的完整概念。

This course is a computer professional important foundation for the professional class, for training students in abstract thinking, and top-down, System analysis and the ability to solve problems is a very important role. The goal is to enable students to master computer system structure the basic concepts, basic principles and basic structure, basic design and analysis methods and computer system architecture and the history of the development of an understanding of the status quo. Through the study of this course, can in "Principles of Computer Organization", y the school curriculum of the software and hardware knowledge combined organic, Computer systems in order to establish the integrity of the concept.三、课程性质与教学目的《计算机系统结构》的教学对象为计算机相关专业的高年级本科生专业技术基础课程,目的是介绍计算机体系结构的概念、技术和最新动态,着重介绍软,硬件功能分配以及如何最佳、最合理地实现软、硬件功能分配。

cache命中率实验报告

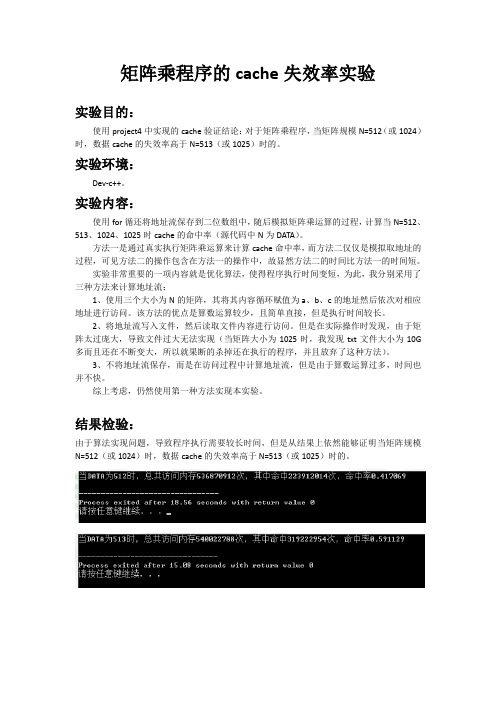

矩阵乘程序的cache失效率实验

实验目的:

使用project4中实现的cache验证结论:对于矩阵乘程序,当矩阵规模N=512(或1024)时,数据cache的失效率高于N=513(或1025)时的。

实验环境:

Dev-c++。

实验内容:

使用for循还将地址流保存到二位数组中,随后模拟矩阵乘运算的过程,计算当N=512、513、1024、1025时cache的命中率(源代码中N为DATA)。

方法一是通过真实执行矩阵乘运算来计算cache命中率,而方法二仅仅是模拟取地址的过程,可见方法二的操作包含在方法一的操作中,故显然方法二的时间比方法一的时间短。

实验非常重要的一项内容就是优化算法,使得程序执行时间变短,为此,我分别采用了三种方法来计算地址流:

1、使用三个大小为N的矩阵,其将其内容循环赋值为a、b、c的地址然后依次对相应地址进行访问。

该方法的优点是算数运算较少,且简单直接,但是执行时间较长。

2、将地址流写入文件,然后读取文件内容进行访问。

但是在实际操作时发现,由于矩阵太过庞大,导致文件过大无法实现(当矩阵大小为1025时,我发现txt文件大小为10G 多而且还在不断变大,所以就果断的杀掉还在执行的程序,并且放弃了这种方法)。

3、不将地址流保存,而是在访问过程中计算地址流,但是由于算数运算过多,时间也并不快。

综上考虑,仍然使用第一种方法实现本实验。

结果检验:

由于算法实现问题,导致程序执行需要较长时间,但是从结果上依然能够证明当矩阵规模N=512(或1024)时,数据cache的失效率高于N=513(或1025)时的。

基于存储的矩阵乘积优化算法

基于存储的矩阵乘积优化算法

矩阵乘积优化算法是一类尝试减少矩阵乘积计算所需时间和存储空间的算法。

它是利用一定的启发式来将一个一般矩阵乘积运算分解为许多小的矩阵乘积,从而以更少的时间和更少的存储开销完成该运算的一类算法。

总结:矩阵乘积优化算法是一类尝试减少矩阵乘积计算所需时间和存储空间的算法,主要包括基本矩阵乘积优化算法、基于存储的矩阵乘积优化算法以及基于算法的矩阵乘积优化算法。

基本矩阵乘积优化算法假定矩阵可以布置为任意阶数的角矩阵,通过用最少的标量运算和最少的存储空间完成矩阵乘法运算;基于存储的矩阵乘积优化算法利用矩阵的性质,通过将大小较大的矩阵拆分为若干小矩阵,并部分逆排序,在存储每个小矩阵所需的内存中,存储矩阵乘法运算需要的数据;而基于算法的矩阵乘积优化算法则利用重排序、重复计算和利用软件缓存的方法实现对矩阵乘积运算的优化。

高性能计算中的矩阵运算算法优化与实现

高性能计算中的矩阵运算算法优化与实现在高性能计算中,矩阵运算是一项广泛应用于多个领域的重要任务。

它在科学计算、大数据分析、机器学习等领域扮演着重要的角色。

然而,随着矩阵规模的增大,常规的矩阵运算算法往往无法满足大规模计算的要求。

因此,如何优化和实现高性能的矩阵运算算法成为了研究的热点之一。

矩阵运算的关键挑战之一是它的时间复杂度。

常规的矩阵运算算法的时间复杂度通常为O(n^3),其中n表示矩阵的维度。

当矩阵规模较大时,这种时间复杂度会导致计算时间过长,无法满足实时计算的需求。

因此,为了提高矩阵运算的性能,研究者们提出了多种算法优化和实现方法。

首先,矩阵运算的并行计算是提高性能的关键之一。

通过将矩阵运算拆分成多个子任务,并使用多线程或分布式计算的方式进行并行计算,可以有效地提高计算效率。

例如,矩阵乘法可以使用分块矩阵的方法进行并行计算,将矩阵的乘法拆分成多个子矩阵的乘法,并通过合并结果来得到最终结果。

此外,还可以使用图计算模型来进行并行化计算,通过将矩阵表示为图的形式,利用图算法来提高计算效率。

其次,矩阵运算的优化还可以通过算法改进来实现。

传统的矩阵运算算法通常使用三层循环来遍历矩阵元素进行计算,但这种方法效率较低。

研究者们提出了一系列的优化算法,如基于分治和递归的算法、基于快速傅里叶变换(FFT)的算法等。

这些优化算法能够减少计算量,提高计算效率。

另外,矩阵运算的性能还与计算硬件密切相关。

针对不同的硬件平台可以使用不同的优化策略。

例如,针对GPU这样的并行计算设备,可以使用CUDA或OpenCL等技术来进行矩阵运算的并行计算。

这些技术可以充分利用GPU的并行计算能力,从而提高计算效率。

而对于多核CPU来说,可以使用SIMD(单指令多数据)指令集来进行矩阵运算的并行计算。

通过合理地利用计算硬件的特点,可以进一步提高矩阵运算的性能。

此外,还可以通过矩阵存储格式的优化来提高矩阵运算的性能。

常见的矩阵存储格式有稠密矩阵和稀疏矩阵两种。

基于高性能计算的矩阵运算优化方法研究

基于高性能计算的矩阵运算优化方法研究矩阵运算是多种科学和工程应用中常见的计算任务之一。

为了提高计算效率和性能,研究人员一直在探索各种方法来优化矩阵运算。

本文将就基于高性能计算的矩阵运算优化方法进行探讨。

一、并行计算并行计算是高性能计算的核心理念之一。

在矩阵运算中,通过将计算任务分解成多个小任务,并同时进行计算,可以显著提高计算效率。

例如,可以将一个大矩阵分解成多个小矩阵,分别在不同的处理器上进行计算,最后再将结果合并。

这种并行计算的方式可以充分利用计算资源,提高矩阵运算的并行度和效率。

二、数据布局和存储优化在矩阵运算中,数据布局和存储方式对计算性能有着重要影响。

通常,矩阵是按行或按列存储在内存中的。

对于按行存储的矩阵,计算时可以将每个处理器分配一行数据,从而减少数据传输和通信开销。

同样地,对于按列存储的矩阵,可以将每个处理器分配一列数据进行计算。

此外,还可以采用压缩存储等技术来减少内存占用和提高数据访问效率。

通过优化数据布局和存储方式,可以在矩阵运算中降低数据传输和通信开销,进而提高计算效率。

三、缓存优化缓存作为计算机体系结构中的重要组成部分,对于矩阵运算的性能有着重要影响。

合理地利用计算机的缓存系统,可以减少数据的读取和写入次数,提高数据的访问效率。

例如,在矩阵乘法中,可以通过使用循环重排和矩阵转置等技术,使得计算过程中的数据局部性更好,从而减少缓存不命中的次数。

此外,还可以通过对缓存的显式控制和数据重用等技术来进一步提高缓存的效率。

缓存优化是一种重要的矩阵运算优化方法,通过合理地利用计算机的缓存系统,可以显著提高计算性能和效率。

四、SIMD优化SIMD(Single Instruction, Multiple Data)是一种在现代处理器中提供的并行计算技术。

通过使用SIMD指令,可以一次完成多个相同类型的操作,从而提高计算效率。

在矩阵运算中,可以通过使用SIMD指令来实现并行计算,例如一次对多个矩阵元素进行加法或乘法运算。

mali opencl 矩阵乘法

mali opencl 矩阵乘法Mali OpenCL 矩阵乘法Mali OpenCL 是 Arm Mali GPU 上的一种异构计算框架,它允许开发者利用 GPU 的并行处理能力来加速各种计算任务。

矩阵乘法是一种广泛用于各种应用中的基本线性代数操作,例如图像处理、科学模拟和机器学习。

利用 Mali OpenCL,可以在 GPU 上高效地执行矩阵乘法,从而显著提高计算速度。

矩阵乘法算法矩阵乘法是一个计算密集型操作,涉及两个矩阵相乘,产生一个新矩阵。

对于两个矩阵 A 和 B,它们的乘积 C 的元素可以通过以下公式计算:```C[i, j] = Σ(A[i, k] B[k, j])```其中 i 和 j 是矩阵 C 中元素的行索引和列索引,而 k 是求和迭代变量。

Mali OpenCL 实现Mali OpenCL 提供了一组函数来执行矩阵乘法。

这些函数针对Mali GPU 架构进行了优化,并利用其并行处理能力来加速计算。

开发人员可以使用这些函数轻松地将矩阵乘法操作集成到他们的OpenCL 程序中。

以下是使用 Mali OpenCL 执行矩阵乘法的示例代码:```// 创建两个矩阵cl_mem matrix_a = clCreateBuffer(context,CL_MEM_READ_ONLY | CL_MEM_COPY_HOST_PTR, sizeof(float) num_rows_a num_cols_a, input_data_a, &error);cl_mem matrix_b = clCreateBuffer(context,CL_MEM_READ_ONLY | CL_MEM_COPY_HOST_PTR, sizeof(float) num_rows_b num_cols_b, input_data_b, &error);// 创建结果矩阵cl_mem result_matrix = clCreateBuffer(context,CL_MEM_WRITE_ONLY, sizeof(float) num_rows_a num_cols_b, NULL, &error);// 创建内核cl_kernel matrix_multiply_kernel =clCreateKernel(program, "matrix_multiply", &error);// 设置内核参数clSetKernelArg(matrix_multiply_kernel, 0,sizeof(cl_mem), &matrix_a);clSetKernelArg(matrix_multiply_kernel, 1,sizeof(cl_mem), &matrix_b);clSetKernelArg(matrix_multiply_kernel, 2,sizeof(cl_mem), &result_matrix);clSetKernelArg(matrix_multiply_kernel, 3, sizeof(int), &num_rows_a);clSetKernelArg(matrix_multiply_kernel, 4, sizeof(int), &num_cols_a);clSetKernelArg(matrix_multiply_kernel, 5, sizeof(int), &num_rows_b);clSetKernelArg(matrix_multiply_kernel, 6, sizeof(int), &num_cols_b);// 执行内核clEnqueueNDRangeKernel(command_queue,matrix_multiply_kernel, 1, NULL, &global_work_size,&local_work_size, 0, NULL, NULL);// 获取结果clEnqueueReadBuffer(command_queue, result_matrix,CL_TRUE, 0, sizeof(float) num_rows_a num_cols_b,output_data, 0, NULL, NULL);```性能优化为了最大限度地提高 Mali OpenCL 矩阵乘法的性能,可以考虑以下优化技术:使用本地内存:本地内存是 GPU 中的一种高速缓存,可以减少对全局内存的访问,从而提高性能。

矩阵乘法运算效率

矩阵乘法运算效率摘要近年来,处理器运行速度的增长和存储器访问速度的增长之间存在着巨大的差距,这使得两者之间的速度差距越来越大,现代计算机体系结构中广泛采用高速缓冲存储器(Cache)来缓解这两者之间的速度差距。

本文根据矩阵乘法运算的六种不同程序代码,构建了矩阵乘法运算时间的测试程序,得到矩阵乘法运算六种不同版本的运行时间;并通过分析六种不同矩阵乘法运算程序代码中的空间局部性与时间局部性,得出由于高速缓冲存储器和程序访问的局部性差异,同一算法的不同程序代码运行时间相差很大。

为了充分利用高速缓冲存储器,提高程序运行效率,在编写程序时需要考虑程序和数据的空间局部性和时间局部性。

为了充分利用高速缓冲存储器,论文又给出了分块矩阵乘法运算程序,它可以进一步提高矩阵乘法运算效率。

关键字:高速缓冲存储器;矩阵乘法;分块矩阵;局部性原理;时间局部性;空间局部性AbstractRecent years, there has been a big gap between the growth of processor and memory runs access speed, which makes the speed difference between them ismore and more big . In modern computer system structure, Cache is widely usedto alleviate the speed gap.Based on the six different program code of matrix multiplication,constructs the matrix multiplication time test procedures, obtaining the running time of matrix multiplication six different versions; And through the analysis of space localized and time localized in six different program codeof matrix multiplication, it is concluded that due to the cache memory and the local differences of programs access, there is a huge difference in therunning time of the same algorithm of different program code. In order to make full use of cache memory and improve program efficiency, it is needed to consider the space and time localized when programming.In order to make full use of cache memory, paper gives the program of partitioned matrix multiplication, which could further improve the matrix multiplication efficiency.Key words: Cache; matrix multiplication; block matrix; principle of locality; temporal locality; spatial localityword文档可自由复制编辑目录摘要 ........................................................................... .............................................................................. . 0Abstract ..................................................................... .............................................................................. .................................. 0 第一章概述 ........................................................................... .............................................................................. .. (3)1.1 研究背景及意义 ........................................................................... .............................................................................3 1.2 研究内容 ........................................................................... .............................................................................. ........... 4 第二章基础知识 ........................................................................... .............................................................................. (5)2.1 矩阵乘法运算 ........................................................................... .............................................................................. ... 5 2.2 高速缓冲存储器 ........................................................................... (6)2.2.1 设置Cache的理论依据 ........................................................................... .................................................... 6 2.2.2 Cache的体系结构 ........................................................................... ............................................................. 8 2.2.3 Cache的相关知识 ........................................................................... ............................................................. 8 2.3 开发平台 ........................................................................... .............................................................................. ........... 9 第三章测试程序 ........................................................................... .............................................................................. . (10)3.1.数据区的设定 ........................................................................... .............................................................................. .. 10 3.2.程序执行时间的计算方法 ........................................................................... ............................................................ 10 3.3.测试程序的运行结果保存方式 ........................................................................... .................................................... 11 3.4.测试程序代码 ........................................................................... .............................................................................. .. 12 第四章结果和分析 ........................................................................... .............................................................................. (16)4.1实验结果图 ........................................................................... .............................................................................. ...... 16 4.2实验结果分析 ........................................................................... ................................................................................ 17 第五章改进的矩阵乘法运算 ........................................................................... .. (18)5.1分块的矩阵乘法运算 ........................................................................... .................................................................... 18 5.2分块的矩阵乘法运算实验结果和分析 ........................................................................... ........................................ 19 第六章总结 ........................................................................... .............................................................................. .................. 21 参考文献 ........................................................................... .............................................................................. ........................ 23 致谢 ........................................................................... .............................................................................. .. (25)word文档可自由复制编辑第一章概述1.1 研究背景及意义在应用程序中,如何提高程序的效率?这是很现实的问题。

实验三:矩阵乘法及算法性能测试

1 1 1 1 1

1 1 1 1 1

1 1 1 12 2 2 2 2 B = 2 2 2 2 2

2 2 2 2 2 2 2 2 2 2

2 2 2 2 2 2 2 2 2 2

2 2 2 2 2 2 2 2 2 2

2 2 2 2 2 2 2 2 2 2

将其结果存入矩阵 C 中。 二、将矩阵 C 打印出来:可调用<stdio.h>中的 printf 函数。注意:本实验不用示波器, 所以在头文件中不必包括“inout.h” 。 三、观察算法所用的时间。 1. 将程序 Load 到芯片中。 2. 点击菜单项 View->Mixed Source/Asm,双击工程窗口中的 C 源文件,可以看到 在每条 C 代码后面都出现了相应的汇编代码。 3. 将光标置于你所编写的核心算法的第一条 C 语句对应的汇编代码上 (对此算法 来说,一般是循环语句) 。点击鼠标右键,选择 Toggle Profile Point,则该行呈 现绿色。 4. 将光标置于算法的最后,点击鼠标右键,选择 Toggle Profile Point,该行呈现 绿色。这样就在程序中设置了两个 Profile Point ,第一个将监测从程序开始运行 到该行所需的时钟。第二个监测从第一个 Profile Point 运行到此行所需的时钟 数,在本实验中即为核心算法所需的时钟。 5. 点击 Debug->Probe Points… , 弹出如下图的窗口: 设置 Probe points 的 connect 到 Profile Clock.如下图所示:

6. 点击菜单项 Profiler->Enable Clock。 7. 点击菜单项 Profiler->View Clock,出现” Profile Clock” 窗口,在此窗口内单击鼠 标右键,选择 Allow Docking,使之可以浮动。调节窗口大小,其中的” Clock” 项 即为所需的平均时钟数。 8. 运行程序,观察算法所耗的时钟。 四、点击菜单项 Project->Build Options , 在” Compiler” 页框下,在 ” Basic” 列表框下的” opt level” 和” program level” 选项,在右边的” Level” 组合框中选择不同的优化级别,重新编译 后,分别观察算法所需的时钟数。可以发现,选择不同的优化级别,算法所需的时钟不 同,一般来说,级别越高,所耗时间越短。

一种用于通用处理器结构优化的矩阵乘法性能模型

一种用于通用处理器结构优化的矩阵乘法性能模型一种用于通用处理器结构优化的矩阵乘法性能模型矩阵乘法是高性能计算中最重要的核心操作之一,它在科学计算、机器学习和深度学习等领域扮演着至关重要的角色。

然而,在现代处理器架构中,难以利用传统的矩阵乘法算法实现高性能计算。

针对这一问题,我们提出了一种用于通用处理器结构优化的矩阵乘法性能模型。

本文将介绍这种模型的设计、实现以及在实验中的性能表现。

设计通用处理器是当前计算机架构中最具有普适性的设备之一。

然而,在多核、多线程以及异构计算环境下,如何利用通用处理器实现高性能计算仍然是一个开放性问题。

我们针对此问题,提出了一种用于通用处理器结构优化的矩阵乘法性能模型。

该模型基于矩阵乘法的数学定义和通用处理器的体系结构设计,通过对数据传输、内存访问、缓存、指令流水等关键因素的分析和优化,实现了对通用处理器的性能最优化。

实现为了实现这种优化模型,在编写矩阵乘法的高性能计算代码的同时,还需要针对通用处理器的体系结构特征进行精细调整。

主要包括以下几个方面:(1)数据重排为了使矩阵乘法的数据访问顺序能够更好地适应处理器的内存访问模式,我们在矩阵乘法的计算前,首先对矩阵数据进行通用处理器下的数据重排。

(2)缓存在内存访问方面,矩阵乘法的数据量通常非常大,这就需要使用缓存技术来加速数据访问。

我们通过使用不同层次的缓存技术,按照不同的数据块大小对矩阵进行划分,从而提高了数据的访问效率,降低了内存的访问延迟。

(3)流水线加速为了使指令流水在矩阵乘法计算中尽可能地实现并行加速,我们通过在不同的流水线级别上对指令进行优化,从而实现运算结果在时钟周期内进行高效的计算,达到了更高的性能表现。

性能测试为了验证我们所提出的矩阵乘法性能模型,我们进行了大量的性能测试实验。

这些实验针对不同的数据规模、矩阵划分和处理器体系结构等因素进行了测试。

实验结果表明,我们所提出的矩阵乘法性能模型能够有效地提高矩阵乘法的计算速度,实现了对通用处理器性能最大化的优化。

矩阵乘法算法加速

矩阵乘法算法加速1. 引言矩阵乘法是计算机科学中常见的一种基本操作,广泛应用于科学计算、图形处理、机器学习等领域。

由于矩阵乘法的计算复杂度较高,如何提高矩阵乘法的计算效率成为一个重要的研究课题。

本文将探讨矩阵乘法算法的加速方法,包括优化算法、并行计算、硬件加速等方面。

2. 矩阵乘法算法矩阵乘法的定义是将两个矩阵相乘得到一个新的矩阵。

设有两个矩阵A和B,它们的乘积C的元素c[i][j]可以通过以下公式计算:c[i][j] = sum(a[i][k] * b[k][j]) for k in range(0, n)其中,n为矩阵的维度。

传统的矩阵乘法算法的时间复杂度为O(n^3),这意味着随着矩阵维度的增加,计算时间将呈指数级增长。

为了提高矩阵乘法的计算效率,需要寻找优化算法和加速方法。

3. 优化算法3.1. 基本优化方法矩阵乘法的基本优化方法包括:•基于行优先或列优先的存储方式:在计算矩阵乘法时,采用合适的存储方式可以减少内存访问的次数,提高计算效率。

•循环展开:将循环展开成多个独立的计算任务,使得计算任务可以并行执行,提高计算效率。

•寄存器变量:将一些常用的变量存储到寄存器中,减少内存访问的开销,提高计算效率。

3.2. 分块矩阵乘法分块矩阵乘法是一种常见的矩阵乘法优化方法。

将矩阵划分为若干个小块,通过对小块的乘法运算得到最终结果。

分块矩阵乘法可以提高计算效率,减少内存访问的次数。

分块矩阵乘法的关键是选择合适的分块策略。

常见的分块策略有:•传统分块:将矩阵划分为均匀的小块,适用于大规模矩阵的乘法计算。

•Strassen算法:将矩阵划分为4个小块,通过递归计算得到最终结果。

Strassen算法的时间复杂度为O(n^log2(7)),比传统的矩阵乘法算法更快。

•Cannon算法:将矩阵划分为若干个小块,通过循环移位和局部乘法得到最终结果。

Cannon算法适用于并行计算,可以提高计算效率。

4. 并行计算并行计算是提高矩阵乘法计算效率的重要方法之一。

矩阵乘法优化算法

矩阵乘法优化算法矩阵乘法是计算机科学中的重要算法之一,它在很多领域都有着广泛的应用,如图像处理、机器学习等。

然而,矩阵乘法的计算量非常大,尤其是在大规模数据处理时,会导致运行时间过长。

因此,为了提高矩阵乘法的效率,需要对其进行优化。

本文将介绍矩阵乘法的优化算法。

一、传统矩阵乘法在介绍优化算法之前,先来回顾一下传统的矩阵乘法算法。

假设有两个矩阵A和B,它们的大小分别为m×n和n×p,则它们相乘得到的结果C大小为m×p。

传统的矩阵乘法可以表示为以下代码:```pythondef matrix_multiply(A, B):m, n = A.shapen, p = B.shapeC = np.zeros((m, p))for i in range(m):for j in range(p):for k in range(n):C[i][j] += A[i][k] * B[k][j]return C```这段代码中使用了三重循环来实现矩阵相乘,在数据量较小的情况下可以得到正确的结果,但当数据量变大时运行速度会变得非常慢。

二、矩阵乘法的优化算法为了提高矩阵乘法的效率,可以采用以下几种优化算法:1.分块矩阵乘法分块矩阵乘法是将大矩阵划分成若干个小块,然后对每个小块进行计算。

这种方法可以减少计算量,提高计算效率。

具体实现如下:```pythondef block_matrix_multiply(A, B, block_size):m, n = A.shapen, p = B.shapeC = np.zeros((m, p))for i in range(0, m, block_size):for j in range(0, p, block_size):for k in range(0, n, block_size):C[i:i+block_size,j:j+block_size] +=np.dot(A[i:i+block_size,k:k+block_size],B[k:k+block_size,j:j+block_size])return C```在这段代码中,我们将大矩阵A和B划分成了若干个大小为block_size×block_size的小块,并对每个小块进行计算。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1 实验目的及要求

★了解Cache对系统性能的影响

★了解基于系统结构的算法设计思想

2 实验模块及实验原理

2.1 实验模块

(1)编写两个C语言程序。

一个是实现矩阵乘积的一般算法。

另一个是基于Cache的矩阵乘积优化算法。

(2) 采用不同矩阵大小来进行多组测量,使实验的结果更加准确。

2.2 实验原理

本实验采用控制变量的方法。

矩阵大小相同时比较两算法的优略。

在相同算法中采用改变矩阵大小的方式,使结果更加准确。

3 实验步骤与结果

3.1 实验步骤

(1)编译并运行程序1,记录相关数据。

(2)不改变矩阵大小时,编译并运行程序2,记录相关数据。

(3)改变矩阵大小,重复(1)、(2)两步。

(4)通过以上的实验现象,分析出现这种现象的原因。

3.2 实验结果

1.用C语言实现矩阵(方阵)乘积一般算法(程序1),填写下表:

矩阵大小:100 一般算法执行时间:0.15625

矩阵大小:500 一般算法执行时间:2. 62500

矩阵大小:1000 一般算法执行时间:20.171875

矩阵大小:1500 一般算法执行时间:73.718750

矩阵大小:2000 一般算法执行时间:167. 93750

矩阵大小:2500 一般算法执行时间:394.828125

矩阵大小:3000 一般算法执行时间:1099. 31250

2.程序2是基于Cache的矩阵(方阵)乘积优化算法,填写下表:

矩阵大小:100 优化算法执行时间:0.15625

矩阵大小:500 优化算法执行时间:1.562500

矩阵大小:1000 优化算法执行时间:12.625000

矩阵大小:1500 优化算法执行时间:42.875000

矩阵大小:2000 优化算法执行时间:102.171875

矩阵大小:2500 优化算法执行时间:202.796875

矩阵大小:3000 优化算法执行时间:360. 31250

3.优化后的加速比(speedup)

矩阵大小:100 加速比:0.15625

矩阵大小:500 加速比:1.68

矩阵大小:1000 加速比:1.598

矩阵大小:1500 加速比:1.72

矩阵大小:2000 加速比:1.63

矩阵大小:2500 加速比:1.63

矩阵大小:3000 加速比:3.05

加速比定义:加速比=优化前系统耗时/优化后系统耗时;

所谓加速比,就是优化前的耗时与优化后耗时的比值。

加速比越高,表明优化效果越明显。

4 实验代码

程序1:

#include <sys/time.h>

#include <unistd.h>

#include <stdio.h>

main(int argc,char *argv[])

{

float *a,*b,*c,temp;

long int i,j,k,size,m;

struct timeval time1,time2;

if(argc<2)

{

printf("\n\tUsage:%s <Row of square matrix>\n",argv[0]);

exit(-1);

}

size=atoi(argv[1]);

m=size*size;

a=(float*)malloc(sizeof(float)*m);

b=(float*)malloc(sizeof(float)*m);

c=(float*)malloc(sizeof(float)*m);

for(i=0;i<size;i++)

for(j=0;j<size;j++)

{

a[i*size+j]=(float)(rand()%1000/100.0);

b[i*size+j]=(float)(rand()%1000/100.0);

}

gettimeofday(&time1,NULL);

for(i=0;i<size;i++)

for(j=0;j<size;j++)

{

c[i*size+j]=0;

for(k=0;k<size;k++)

c[i*size+j]+=a[i*size+k]*b[k*size+j];

}

gettimeofday(&time2,NULL);

_sec-=_sec;

_usec-=_usec;

if(_usec<0L)

{

_usec+=1000000L;

_sec-=1;

}

printf("Executiontime=%ld.%6ld

seconds\n",_sec,_usec);

}

return(0);

}

程序2:

#include <sys/time.h>

#include <unistd.h>

#include <stdio.h>

main(int argc,char *argv[])

{

float *a,*b,*c,temp;

long int i,j,k,size,m;

struct timeval time1,time2;

if(argc<2)

{

printf("\n\tUsage:%s <Row of square

matrix>\n",argv[0]);

exit(-1);

}

size=atoi(argv[1]);

m=size*size;

a=(float*)malloc(sizeof(float)*m);

b=(float*)malloc(sizeof(float)*m);

c=(float*)malloc(sizeof(float)*m);

for(i=0;i<size;i++)

for(j=0;j<size;j++)

{

a[i*size+j]=(float)(rand()%1000/100.0);

c[i*size+j]=(float)(rand()%1000/100.0);

}

gettimeofday(&time1,NULL);

for(i=0;i<size;i++)

for(j=0;j<size;j++)

{

b[i*size+j]=c[j*size+i];

for(i=0;i<size;i++)

for(j=0;j<size;j++)

{

c[i*size+j]=0;

for(k=0;k<size;k++)

c[i*size+j]+=a[i*size+k]*b[j*size+k];

}

gettimeofday(&time2,NULL);

_sec-=_sec;

_usec-=_usec;

if(_usec<0L)

{

_usec+=1000000L;

_sec-=1;

}

printf("Executiontime=%ld.%6ld

seconds\n",_sec,_usec);

}

return(0);

}

5 实验结果分析

(1)对于矩阵乘法,用一般算法执行时,执行时间随着矩阵的增大变化较大。

(2)用优化算法执行时,执行时间随着矩阵的增大变化较小。

(3)由加速比计算结果可清晰看到在矩阵比较小时,优化前后区别不大;随着矩阵规模变大,加速就比较明显了。