dfs出错修复

Hadoop中的任务失败处理与错误恢复策略解析

Hadoop中的任务失败处理与错误恢复策略解析Hadoop是一个开源的分布式计算框架,广泛应用于大数据处理领域。

在Hadoop中,任务失败是不可避免的,而如何处理任务失败和实施错误恢复策略成为了一个重要的问题。

首先,我们来看一下Hadoop中任务失败的原因。

任务失败可能由于多种原因引起,比如网络故障、硬件故障、程序错误等。

当一个任务失败时,Hadoop会记录失败的任务信息,并尝试重新执行该任务。

但是,如果任务多次失败,Hadoop 会将该任务标记为失败,并进行错误恢复。

Hadoop中的错误恢复策略主要包括两个方面:任务重试和备份任务。

任务重试是指当一个任务失败时,Hadoop会尝试重新执行该任务。

Hadoop会记录每个任务的执行次数,并设置一个重试次数阈值。

当任务的执行次数未达到阈值时,Hadoop会将该任务重新分配给其他可用的节点执行。

这种策略能够有效地解决一些临时性的故障,比如网络中断或节点宕机。

但是,如果任务的失败是由于程序错误引起的,重试可能并不能解决问题,因此需要采取其他的错误恢复策略。

备份任务是指在任务执行过程中,Hadoop会为每个任务创建一个备份任务,并将其分配给其他节点执行。

当主任务失败时,Hadoop会将备份任务标记为活动状态,并继续执行。

这种策略能够提高任务的执行可靠性,减少任务失败的影响。

同时,备份任务还可以在主任务执行过程中提供额外的计算资源,加速任务的执行速度。

然而,备份任务也会增加系统的负载和资源消耗,因此需要权衡利弊。

除了任务重试和备份任务,Hadoop还提供了其他的错误恢复机制。

例如,Hadoop可以将任务的输出结果保存到分布式文件系统中,以便在任务失败时可以从中恢复。

同时,Hadoop还可以记录任务的执行日志和错误信息,以便进行故障排查和问题定位。

这些机制能够帮助用户更好地理解任务失败的原因,并采取相应的措施进行修复和改进。

在实际应用中,为了提高任务的执行效率和可靠性,我们还可以采取一些额外的措施。

代码开发中的错误处理与修复

代码开发中的错误处理与修复在代码开发过程中,错误处理和修复是至关重要的。

它们可以帮助我们及时发现和解决问题,确保代码的质量和可靠性。

在本文中,我将讨论一些常见的错误处理和修复方法,并提供一些建议来帮助您更好地处理和修复代码中的错误。

首先,让我们来看看错误处理的重要性。

在开发代码的过程中,错误是不可避免的。

无论是语法错误、逻辑错误还是运行时错误,它们都可能导致程序崩溃、数据丢失或其他不可预测的后果。

在面对这些挑战时,一个好的错误处理机制可以帮助我们迅速发现问题,并采取适当的措施来修复错误。

下面是一些常见的错误处理方法:1.异常处理:使用异常处理机制可以帮助我们捕获和处理在程序执行期间出现的异常。

通过使用try-catch语句块,我们可以捕获异常,并采取适当的措施来处理它们。

在处理异常时,我们可以选择打印错误消息、记录日志、回滚数据或者执行其他适当的操作。

通过异常处理,我们可以保证程序在遇到异常时不会崩溃,并能继续正常执行。

2.日志记录:在代码开发过程中,日志记录是非常重要的。

通过在代码中添加合适的日志语句,我们可以追踪程序运行的状态和执行的路径。

在遇到错误时,日志记录可以帮助我们定位问题,并提供有用的信息进行故障排除。

使用适当的日志级别,我们可以选择记录不同等级的日志信息,以帮助我们更好地理解程序的执行情况和问题的来源。

3.单元测试:单元测试对于发现和修复错误至关重要。

通过编写一系列针对代码各个部分的单元测试,我们可以快速发现并修复潜在的问题。

单元测试应该覆盖代码的各个边界条件和边界情况,并验证代码是否按预期工作。

通过频繁运行单元测试,并及时修复出现的错误,我们可以确保代码的正确性和健壮性。

4.代码审查:代码审查是一种团队合作的方式,通过检查、评估和审查代码来发现潜在的错误和问题。

编写好的代码审查过程可以帮助我们发现代码中的设计问题、潜在的性能问题以及其他容易被忽视的错误和问题。

通过代码审查,我们可以及早发现并修复问题,从而提高代码的质量和可靠性。

DFS问题答疑

DFS 复制是否支持远程管理?是。

DFS 复制使用DFS 管理控制台和“Add Replication Group”(添加复制组)命令支持远程管理。

例如,在服务器 A 上,您可以连接到在以服务器 A 和 B 作为成员的林中定义的复制组。

Windows Server 2008 R2、Windows Server 2008 和Windows Server 2003 R2 附带DFS 管理。

要通过其他Windows 版本管理DFS 复制,请使用“远程桌面”或Windows 7 远程服务器管理工具。

是否有什么方法可以了解复制状态?是。

监视复制有多种方法:1>、DFS 复制带有适用于System Center Operations Manager 2007 的管理包,可提供主动监视。

2>、DFS 复制包含有关给定复制组中复制囤积、复制效率及文件和文件夹数量的内置诊断报告。

3>、Dfsrdiag.exe 是一种命令行工具,可生成囤积计数或触发传播测试。

两者都可显示复制状态。

传播用于显示文件是否正被复制到所有节点。

囤积用于显示在两台计算机实现同步之前有多少文件仍需复制。

囤积计数是指复制组成员尚未处理的更新数量。

在运行Windows Server 2008 R2 的计算机上,Dfsrdiag.exe 还可显示DFS 复制目前正在复制的更新。

4>、脚本可使用WMI 收集囤积信息-手动或通过MOM。

性能:DFS 复制是否支持拨号连接?尽管DFS 复制在拨号速度下可以运行,但如果要复制大量更改,它会进行囤积。

如果对现有文件进行少量更改,带有远程差分压缩(RDC) 的DFS 复制提供的性能将远超过直接复制文件。

DFS 复制是否执行带宽检测?不执行。

DFS 复制不执行带宽检测。

您可以配置DFS 复制,使每个连接使用有限量的带宽(带宽限制)。

但在网络接口达到饱和时,DFS 复制不会进一步减少带宽占用,且DFS 复制会使链接在短时间内达到饱和。

数据库排错与故障恢复的常见问题与解决方案

数据库排错与故障恢复的常见问题与解决方案数据库是现代信息系统中重要的组成部分,它存储和管理着大量的数据。

然而,由于各种原因,数据库可能会出现错误和故障,导致数据的不可用性和丢失。

本文将介绍数据库排错和故障恢复中常见的问题,并提供对应的解决方案。

1. 数据库连接问题数据库连接问题是数据库排错中最常见的问题之一。

它可能是由于网络连接故障、数据库服务器故障或数据库配置错误引起的。

当遇到这种问题时,可以采取以下解决方案:- 检查网络连接是否正常,确保数据库服务器可以正常访问。

- 检查数据库配置文件是否正确,例如数据库地址、端口、用户名和密码等信息。

- 检查数据库服务器的状态,确保它正在运行,并且没有出现任何错误。

2. 数据库性能问题数据库性能问题可能包括慢查询、数据库响应时间长等。

这些问题可能是由于数据库设计不当、数据库索引缺失、硬件资源限制等引起的。

解决这些问题的方法包括:- 进行数据库优化,包括表结构优化、索引优化等,以提高查询性能。

- 检查硬件资源使用情况,如果发现硬件资源达到上限,则需要升级硬件以提高数据库性能。

3. 数据库错误数据库错误可能是由于数据损坏、日志文件损坏、数据库文件损坏等引起的。

当遇到数据库错误时,可以采取以下解决方案:- 使用数据库的备份功能,恢复到最近的可用备份点。

- 使用数据库的修复工具,尝试修复损坏的数据库文件。

- 找到引起错误的原因,并进行相应的修复,如修复损坏的硬件、修复错误的数据库操作等。

4. 数据丢失数据丢失是最令人担忧的数据库故障之一。

它可能是由于意外删除、硬盘故障、病毒攻击等原因引起的。

为了防止数据丢失,可以采取以下预防措施:- 定期备份数据库,确保数据库的重要数据可以进行恢复。

- 使用冗余存储设备,如RAID技术,以提高数据的可用性和容错能力。

- 定期更新和运行杀毒软件,保护数据库免受病毒攻击。

5. 数据安全问题数据安全问题包括非授权访问、数据泄露等。

为了保护数据库的安全性,可以采取以下措施:- 设置严格的访问权限,确保只有授权用户可以访问数据库。

Hadoop常见错误总结

Hadoop常见错误总结2010-12-30 13:55错误1:bin/hadoop dfs 不能正常启动,持续提示:INFO ipc.Client: Retrying connect to server: localhost/127.0.0.1:9000. Already tried 0 time(s).原因:由于 dfs 的部分文件默认保存在tmp文件夹,在系统重启时被删除。

解决:修改core-site.xml 的 hadoop.tmp.dir配置文件路径:/home/hadoop/tmp。

错误2:hadoop出现了一些问题。

用$ bin/hadoop dfsadmin -report 测试的时候,发现dfs没有加载。

显示如下:Configured Capacity: 0 (0 KB)Present Capacity: 0 (0 KB)DFS Remaining: 0 (0 KB)DFS Used: 0 (0 KB)DFS Used%: ?%Under replicated blocks: 0Blocks with corrupt replicas: 0Missing blocks: 0查看日志:ERRORorg.apache.hadoop.hdfs.server.datanode.DataNode: java.io.IOException: Incompatible namespaceIDs in /home/hadoop/data: namenode namespaceID = ; datanode namespaceID =经分析,是由于namenode namespaceID = ;和datanode namespaceID = 不一致造成原因。

修改了namenode namespaceID = 可以使用,但是重启之后,又不可以用了。

最后解决方案:删除hadoop用户下的name文件夹,data文件夹,tmp文件夹,temp文件里的内容,然后重新执行namenode命令。

建立分布式文件系统(DFS)时,出现错误的解决办法

建立分布式文件系统(DFS)时,出现错误的解决办法

我的2003AD(R2)主域服务器上建立分布式文件系统(DFS)时,到最后提示以下错误

-----------------------------------------------------------------------------------

在服务器上创建DFS根时出现下列错误:

无法连接指定服务器上的分布式文件系统服务.可能性的原因包括服务未启动、服务器脱机、网络问题阻止访问服务器、或者防火增阻止服务器上的端口445

-------------------------------------------------------------------------------------

(1)主要是让防火墙开启445端口还有139端口,分布式文件系统服务主要就是利用共享来完成的。

(2)启动DFS服务(Distributed File System)这个服务

如果发现没有这个服务,只要手工添加DFS服务就行了,

方法:运行,输入CMD,然后输入sc create DistributedFileSystem binpath= c:\windows\system32\dfssvc.exe 就可以在系统服务里加载了,然后到系统服务找到DistributedFileSystem服务设为自动,重启OK。

DFS文件系统删除文件恢复方法

关于WINDOWS 分布式文件系统DFS功能中任何文件夹及其所包含的文件删除后的恢复办法这里以域中2台有DFS功能的主机为基础环境(服务器:File和Filecopy,已具有复制关系的文件夹Public)建立文件在服务器File上的Public文件夹建立文件夹DFS-test,并在文件夹中建立若干文件test.txt、test2.txt…...现在遇到如下问题:假如这个DFS-test文件夹是一员工的个人的,有一天,这外员工急匆匆的来找你求救,说他的DFS-test文件夹被自己不小心删除了,里面有很重要的文件,但文件夹里面具体文件名是什么,太多了自己也不太清楚,删除后自己电脑回收站也没有,请你一定帮他找回来,这时你该怎么办?恢复数据1.这时你首先想到的是去冲突和已删除文件夹中去找E:\Public\DfsrPrivate\ConflictAndDeleted,但是,当打你打开这个文件夹时只发现以有一个以DFS-test-{45B92F17-65B3-4FF4-8248-F989F1DB45ED}-v1939736为命名的文件夹,但里面空空如也,任何内容都没有啊,这该咋办呢?你不能给员工说他的文件夹是空的吧!这下他要给你急了!2.当然你不用害怕,DFS在删除文件时,是建立了一个清单的,你只要仔细看看这个清单,就会发现DFS-test这个文件夹中所包含的文件及删除后的文件名称的变化,这个清单就在E:\Public\DfsrPrivate(文件夹是隐藏的哦!)这个文件夹的根目录中:ConflictAndDeletedManifest3.用记事本打开ConflictAndDeletedManifest你搜索DFS-test,如下图:用红色框框标注的就是原来的DFS-test文件夹及内所包含的文件,绿色部分就是删除后的文件名称,注意有个<NewName>的字样,意思就是删除后的新文件名称4.现在找到这几个文件并复制出来,根据目录结构存放并改回原名即可,文件找到。

redundancy修复的工作原理

标题:深度探析redundancy修复的工作原理及应用一、引言在计算机领域中,Redundant Array of Independent Disks(R本人D)技术被广泛应用于数据存储领域。

其中,redundancy修复是R本人D技术中非常重要的一环。

本文将深入探讨redundancy修复的工作原理,以及其在数据存储中的应用。

二、redundancy修复的概念在R本人D中,redundancy修复是指当R本人D中的某个磁盘发生故障时,通过利用其他健康磁盘中的数据,在不影响系统正常运行的情况下,将故障磁盘上的数据重新恢复到健康磁盘中。

在redundancy修复过程中,系统会利用R本人D中设置的冗余磁盘或者数据校验方法,来检测和修复数据错误或者丢失的数据。

三、redundancy修复的工作原理1. 数据校验redundancy修复的第一步是对故障磁盘中的数据进行校验。

这个过程中,系统会使用R本人D中特定的校验方法(比如奇偶校验、循环冗余检验等)来检测数据的错误或者丢失。

2. 故障诊断一旦数据校验出现错误或者数据丢失,系统会识别故障的磁盘,并确定需要进行redundancy修复的数据范围。

3. re-dundancy修复在确定了需要修复的数据范围后,系统会自动或者手动地选择健康的磁盘来进行redundancy修复。

在这个过程中,系统会根据之前的数据校验结果,通过计算或者复制的方式,将故障磁盘中的数据重新恢复到健康的磁盘中。

4. 数据校验验证redundancy修复完成后,系统会再次对修复后的数据进行校验,确保数据的完整性和正确性。

四、redundancy修复的应用R本人D技术中的redundancy修复不仅可以在单个磁盘故障时进行数据恢复,还可以在磁盘扩容、磁盘替换、数据整合等操作时进行数据的校验和修复。

在实际应用中,redundancy修复可以有效地保障数据的安全性和可靠性,提高系统的稳定性和容错能力。

编程技术中常见的算法实现错误分析与修复方法

编程技术中常见的算法实现错误分析与修复方法在编程技术领域,算法实现错误是一个常见的问题。

无论是新手还是有经验的开发人员,都可能会遇到算法实现错误。

这些错误可能导致程序崩溃、性能下降或产生错误的输出。

本文将讨论一些常见的算法实现错误,并介绍一些修复方法。

一、边界错误边界错误是最常见的算法实现错误之一。

当处理数组或字符串时,开发人员经常会忽略边界条件,导致程序出现错误。

例如,当遍历数组时,如果没有正确处理数组的边界条件,可能会导致数组越界错误。

修复边界错误的方法是仔细检查代码中的边界条件,并确保在访问数组或字符串时不会超出其范围。

可以使用条件语句或循环来检查边界条件,并在必要时进行调整。

二、逻辑错误逻辑错误是另一个常见的算法实现错误。

这种错误通常是由于开发人员对问题的理解不正确或对算法的实现方式有误导致的。

例如,当编写排序算法时,如果使用错误的比较操作符,可能导致排序结果不正确。

修复逻辑错误的方法是仔细检查代码中的逻辑,并确保算法的实现与问题的要求相匹配。

可以使用调试工具来跟踪代码的执行过程,并检查每个步骤是否符合预期。

三、性能问题性能问题是另一个需要注意的算法实现错误。

当处理大量数据或复杂计算时,算法的效率可能成为一个问题。

例如,使用线性搜索算法来查找大型排序数组中的元素,会导致性能下降。

修复性能问题的方法是通过优化算法或改进数据结构来提高程序的效率。

可以使用更高效的算法来替代原始的实现,或者使用更合适的数据结构来存储和处理数据。

四、错误处理错误处理是编程中一个重要的方面,但也是容易被忽视的。

当算法出现错误时,开发人员应该能够正确地处理这些错误,并提供有用的错误信息。

修复错误处理问题的方法是在代码中添加适当的错误处理机制。

可以使用异常处理来捕获和处理错误,或者使用错误码来指示错误的类型。

还可以添加日志记录功能,以便在出现错误时能够追踪错误的原因。

五、代码重构代码重构是一种改进算法实现的方法。

当发现算法实现存在问题时,开发人员可以重新设计和重构代码,以提高代码的可读性和可维护性。

hdfs数据块修复方法

hdfs数据块修复方法HDFS数据块修复是在数据节点损坏或失效时,恢复数据的一种方法。

以下是一些修复方法:1. 检查数据块状态首先,需要检查数据块的状态,以确定哪些数据块需要修复。

在HDFS中,可以使用以下命令检查数据块状态:hdfs fsck /path/to/file -files -blocks -locations2. 复制数据块通常情况下,数据块会在多个数据节点上复制。

如果某个数据节点失效,那么其他节点上的备份数据块可以用来修复数据。

在HDFS中,可以使用以下命令复制数据块:hadoop dfs -setrep -w <numReplicas> /path/to/file 其中,numReplicas是需要设置的数据块副本数。

如果数据块已经被复制到足够数量的节点上,那么这种修复方法就可以直接使用备份数据块来修复数据。

3. 重新分配数据块如果数据块已经失效,那么需要重新分配数据块。

在HDFS中,可以使用以下命令重新分配数据块:hadoop dfsadmin -refreshNodes这个命令会刷新HDFS的节点状态,以便HDFS重新分配数据块。

4. 使用DataNode的复制功能如果数据块已经失效,可以使用DataNode的复制功能,将数据块从其他DataNode中复制到失效的DataNode中。

在HDFS中,可以使用以下命令使用DataNode的复制功能:hadoop dfs -get -cat /path/to/file | hadoop dfs -put - /path/to/new/file其中,/path/to/file是需要修复的文件路径,/path/to/new/file是新文件的路径。

5. 使用备份如果以上方法无法修复数据块,那么可以使用备份来修复数据。

在HDFS中,可以使用以下命令使用备份:hadoop dfs -copyFromLocal /path/to/backup/file/path/to/file其中,/path/to/backup/file是备份文件的路径,/path/to/file是需要修复的文件路径。

如何处理分布式数据库的故障与错误情况

在当今信息时代,分布式数据库已成为处理大规模数据的重要工具。

然而,与其发展相伴的是故障和错误情况的频繁发生,这给数据库管理员带来了相当大的挑战。

本文将讨论如何处理分布式数据库的故障与错误情况,并提出一些解决方案和建议。

一、故障与错误情况的种类分布式数据库的故障与错误情况可以分为多种类型,例如网络故障、硬件故障、软件错误等。

网络故障是指数据库服务器之间的通信中断,可能由于网络连接不稳定或者服务器出现故障。

硬件故障可能包括磁盘损坏、内存故障、电源问题等。

软件错误可能由于程序的编写错误、算法设计不当等原因引起。

二、快速发现故障及时发现故障是解决问题的第一步。

管理员应该使用合适的监控工具来监视数据库服务器的状态。

这些工具可以提供实时的性能指标和错误日志,帮助管理员及时发现潜在的故障。

此外,还可以利用自动化脚本进行周期性的健康检查和故障检测。

三、故障处理策略当发现故障后,管理员应该采取相应的故障处理策略。

首先,应该记录故障的详细信息,包括发生时间、错误信息等。

然后,可以尝试重新启动数据库服务器,如果仍然无法解决问题,可以考虑使用备份数据库进行恢复。

如果没有备份数据库,可以尝试修复数据库文件或者使用数据恢复工具来尝试恢复数据。

四、容错与冗余为了提高数据库系统的可用性,可以采用容错与冗余技术。

容错技术包括备份和恢复,可以通过定期备份数据库文件来防止数据丢失。

而冗余技术则可以通过在不同地点部署多个数据库服务器,实现故障转移和负载均衡。

例如,可以采用主从复制,将主数据库的数据同步到多个从数据库,当主数据库发生故障时,可以自动切换到从数据库来保证系统的可用性。

五、监控和优化分布式数据库的性能优化是一个持续不断的过程。

管理员应该定期对数据库服务器进行性能监控和优化。

可以通过监控工具来收集性能指标和查询统计信息,并根据这些信息进行性能分析和瓶颈定位。

一旦发现性能问题,可以采取相应的措施来进行优化,例如调整数据库的参数配置、重新设计查询语句等。

数据透析表的数据逆向修复与丢失项处理方法

数据透析表的数据逆向修复与丢失项处理方法在日常工作和生活中,我们经常会使用数据透析表(Pivot Table)来对大量数据进行统计和分析。

然而,由于各种原因,数据透析表中的数据有时会出现错误或丢失,这给我们的工作和决策产生了一定的困扰。

因此,本文将介绍数据透析表数据逆向修复的方法,以及数据丢失项的处理方法,帮助读者解决这一问题。

首先,我们来介绍数据透析表数据逆向修复的方法。

当数据透析表中的数据存在错误时,我们可以采取以下方法进行修复:1. 检查数据源:首先,我们需要检查数据透析表的数据源,确保数据源中的数据是正确且完整的。

如果数据源中存在错误或丢失的数据,我们可以首先修复数据源中的问题,然后刷新数据透析表,以使修复后的数据反映在透析表中。

2. 使用公式修复:如果数据透析表中的错误是由于公式错误导致的,我们可以通过修复公式来解决。

首先,我们需要定位导致错误的公式,然后根据实际情况进行修复。

例如,如果公式引用了错误的单元格或区域,我们可以修复公式中的引用,使其指向正确的单元格或区域。

3. 手动修复:在某些情况下,数据透析表可能会出现无法通过公式自动修复的错误。

这时,我们可以考虑手动修复这些错误。

手动修复的方法包括手动输入正确的数据、复制粘贴正确的数据、删除错误的数据等。

不过,这种方法对于大量的数据来说可能比较繁琐,所以建议在使用之前先备份数据表。

接下来,我们来介绍数据透析表数据丢失项的处理方法。

当数据透析表中出现丢失项时,我们可以采取以下方法进行处理:1. 检查数据源:首先,我们需要检查数据源中是否存在缺失的数据。

如果数据源中存在缺失的数据,我们可以通过添加或修改数据源中的数据来补充缺失的数据,然后刷新数据透析表,以使补充后的数据反映在透析表中。

2. 使用透析表筛选器:数据透析表提供了筛选器功能,可以通过筛选器来快速筛选出需要的数据。

当透析表中出现丢失项时,我们可以通过设置透析表筛选器来排除丢失项,只显示完整的数据。

数据处理中常见的错误和解决方法(五)

数据处理中常见的错误和解决方法在现代社会中,数据处理已经成为各行各业的重要工作。

然而,由于各种原因,数据处理中常常会出现错误。

这些错误可能导致严重后果,因此解决这些错误变得非常重要。

本文将介绍一些常见的数据处理错误,并提供解决方法。

一、数据输入错误数据输入是数据处理的第一步,而其中的错误很容易发生。

例如,操作人员可能会输入错误的数据,或者输入数据时遗漏某些重要信息。

要解决这个问题,可以采取以下措施。

首先,提供培训和指导。

为操作人员提供正确的数据输入方法和操作规范,以帮助他们避免常见的错误。

此外,可以使用数据验证功能来检查输入的数据是否符合特定的规则或范围。

其次,引入自动化的数据输入系统。

使用OCR(光学字符识别)技术或条码扫描技术可以减少人为错误。

这些自动化系统可以直接从源文件或标签中获取数据,并将其输入到系统中,减少人为干预。

二、数据清洗错误数据清洗是数据处理的重要环节,用于检查和修复无效、缺失或不一致的数据。

然而,在进行数据清洗时,也会出现一些常见的错误。

以下是一些解决方法。

首先,建立数据清洗规则。

制定一套清洗规则,包括识别和修复无效数据、填补缺失数据、解决数据不一致性等。

这样做可以提高数据清洗的准确性和一致性。

其次,自动化数据清洗过程。

利用计算机算法和技术,可以快速而准确地识别和处理无效、缺失或不一致的数据。

自动化数据清洗系统可以大大提高数据处理的效率和准确性。

三、数据分析错误数据分析是数据处理中的重要环节,用于发现潜在的模式、关联和趋势。

然而,数据分析过程中也会出现一些常见的错误。

以下是一些解决方法。

首先,选择合适的分析方法和工具。

不同的数据类型和问题需要不同的分析方法和工具。

因此,在进行数据分析之前,要确保选择合适的方法和工具,以提高分析结果的准确性和可靠性。

其次,进行数据预处理。

数据预处理是数据分析的重要步骤,用于清洗、转换和集成数据。

通过对数据进行适当的预处理,可以减少分析过程中的错误和噪声,提高分析结果的可靠性。

分布式文件系统的容错机制和故障恢复(十)

分布式文件系统的容错机制和故障恢复随着云计算和大数据时代的到来,分布式文件系统在存储和管理海量数据上扮演着重要的角色。

然而,由于庞大的数据规模和强大的计算需求,分布式文件系统面临着各种容错和故障恢复的挑战。

本文将探讨分布式文件系统的容错机制和故障恢复策略。

一、分布式文件系统容错机制分布式文件系统通过将数据分散存储在不同节点上,实现高可用性和冗余备份。

容错机制是确保文件系统能够在节点故障或网络异常的情况下继续提供可靠服务的关键。

1. 冗余备份冗余备份是分布式文件系统实现容错的基本手段。

系统将数据分为多个副本,并将这些副本存储在不同的节点上。

当某个节点发生故障时,系统可以从其他节点获取相同的数据副本,确保数据不丢失。

冗余备份还可以提高系统的读取性能,相同的数据可以从多个节点同时读取。

2. 容错算法容错算法是分布式文件系统中的核心技术。

它通过检测并纠正节点错误,保证系统的可用性和正常运行。

常见的容错算法包括冗余校验码(Redundancy Check Code,RCC)、纠删码(Erasure Code)等。

这些算法可以检测节点数据是否被篡改,并在需要时进行纠错,确保数据的完整性和可靠性。

3. 自动故障检测和切换分布式文件系统需要及时检测节点故障,并进行故障切换,以保证系统的可用性。

系统可以通过心跳机制、日志记录等方式实现节点状态的实时监测。

一旦发现节点故障,系统会自动将其切换至备用节点,从而保证数据的连续性和可访问性。

二、故障恢复策略即使在出现节点故障或网络异常的情况下,分布式文件系统也能够通过故障恢复策略进行及时修复,保障系统的正常运行。

1. 容错日志与增量备份容错日志记录着节点数据的更改信息,可以用于在数据丢失或节点损坏时进行恢复。

增量备份是指只备份文件中已更改的部分,而不是整个文件。

这样可以减少备份的时间和存储空间,提高故障恢复的效率。

2. 数据重建和数据块重传当节点故障时,分布式文件系统可以通过数据重建和数据块重传来还原数据。

数据库错误处理与故障排除技巧分享

数据库错误处理与故障排除技巧分享在日常的数据库运维工作中,我们经常会遇到各种各样的错误和故障。

正确的错误处理和故障排除技巧是保证数据安全和系统稳定性的关键。

本文将分享一些数据库错误处理与故障排除的实用技巧,帮助数据库管理员和开发人员更有效地解决问题。

一、错误处理1. 错误分类数据库错误可分为语法错误、运行时错误和逻辑错误等。

了解错误类型对于快速定位和解决问题至关重要。

语法错误通常是由于不正确的SQL语句导致,可以通过仔细检查语句的书写和结构来解决。

运行时错误可能涉及连接问题、权限不足、异常数据处理等,需要通过分析错误信息和日志来定位问题。

逻辑错误通常与应用程序相关,需要对代码进行排查和调试。

2. 错误日志和监控数据库错误日志是诊断和解决问题的重要依据。

配置适当的日志级别和保留周期,确保错误日志中包含足够的详细信息。

监控系统也是非常有帮助的工具,能够实时监测数据库状态并提供预警。

合理利用错误日志和监控系统,可以及时发现和处理错误。

3. 异常处理在应用程序中,必须妥善处理数据库错误。

捕获异常并采取适当的处理措施,比如回滚事务、记录错误日志、展示用户友好的错误信息等。

良好的异常处理可以提高用户体验,并且有助于诊断和解决问题。

二、故障排除1. 性能问题性能问题是数据库运维中常见的故障类型之一。

首先,需要分析数据库的负载情况,如CPU使用率、内存占用、磁盘IO等。

通过监控工具或自定义脚本收集这些数据,并与数据库性能指标进行比对。

如果发现性能瓶颈,可以考虑调整资源分配、优化查询语句、增加索引等措施来提升性能。

2. 死锁和阻塞死锁和阻塞问题可能导致数据库无法正常处理请求,影响系统的可用性和响应时间。

对于死锁问题,可以通过锁定信息查找到死锁节点,并通过合理调整事务顺序或其他策略来解决。

对于阻塞问题,可以通过查看正在等待的操作和资源锁定情况,调整并发度、优化查询语句或调整事务隔离级别等手段来解决。

3. 数据丢失和损坏数据丢失和损坏是数据库运维工作中最严重的问题之一。

dfs出错修复

Windows 2000 服务器和域控制器将DFS 配置信息存储在注册表和Active Directory 中。

在某些种情况下可能以返回到稳定状态很有用。

本文介绍如何删除DFS 配置注册表和Active Directory 中的数据。

重要此分区、方法,或任务包含告诉您如何修改注册表的步骤。

但是,如果注册表修改不当可能会出现严重问题。

因此,请确保您仔细按照这些步骤。

附加的保护注册表之前先备份您对其进行修改。

然后,您可以在出现问题时还原注册表。

有关如何备份和还原注册表的详细信息,请单击下面的文章编号,以查看Microsoft 知识库中相应的文章:322756如何备份和还原在Windows 注册表故障容错的DFS 根目录1.通过将网络停止dfs关联在命令提示符处停止DFS 服务。

2.启动注册表编辑器并删除以下注册表项,请执行以下操作:a.删除卷文件夹和$ HKLM\SOFTWARE\Microsoft\DfsHost 下的任何子文件夹。

b.删除所有子文件夹下HKLM\SYSTEM\CurrentControlSet\Services\DfsDriver\LocalVolumes,使LocalVolumes 保持不变。

3.从Active Directory 用户和计算机管理单元中,单击在视图菜单上的高级功能。

打开系统文件夹下的,DFS 配置容器。

删除DFS 根目录,在右窗格中。

注意还可以从使用LDAP 或Adsiedit.msc 活动目录中删除DFS 配置数据。

在与容错DFS 根目录名为DFSFT 域中的计算机的LDAP 路径应CN = DFS-配置CN = 系统,DC = A,DC = COM。

4.在第1 步中,重新启动您停止了DFS 服务。

独立的DFS 根和Windows 2000 群集服务器1.通过将网络停止dfs关联在命令提示符处停止DFS 服务。

2.启动注册表编辑器并删除以下注册表项,请执行以下操作:a.删除卷文件夹和$ HKLM\SOFTWARE\Microsoft\DfsHost 下的任何子文件夹。

Hadoop运行start-dfs.sh报ERROR:Attemptingtooperat。。。

Hadoop运⾏start-dfs.sh报ERROR:Attemptingtooperat。

错误提⽰:Starting namenodes on [master]ERROR: Attempting to operate on hdfs namenode as rootERROR: but there is no HDFS_NAMENODE_USER defined. Aborting operation.Starting datanodesERROR: Attempting to operate on hdfs datanode as rootERROR: but there is no HDFS_DATANODE_USER defined. Aborting operation.Starting secondary namenodesERROR: Attempting to operate on hdfs secondarynamenode as rootERROR: but there is no HDFS_SECONDARYNAMENODE_USER defined. Aborting operation.Starting journal nodesERROR: Attempting to operate on hdfs journalnode as rootERROR: but there is no HDFS_JOURNALNODE_USER defined. Aborting operation.Starting ZK Failover Controllers on NN hostsERROR: Attempting to operate on hdfs zkfc as rootERROR: but there is no HDFS_ZKFC_USER defined. Aborting operation.原因:使⽤root账号启动服务,但没预先定义解决⽅法:* 该步骤需要在每台机都执⾏,也可以先在其中⼀台机修改,再⽤scp同步给其它机1.修改start-dfs.sh和stop-dfs.shcd /home/hadoop/sbinvim start-dfs.shvim stop-dfs.sh在头部添加以下内容:HDFS_ZKFC_USER=rootHDFS_JOURNALNODE_USER=rootHDFS_NAMENODE_USER=rootHDFS_SECONDARYNAMENODE_USER=rootHDFS_DATANODE_USER=rootHDFS_DATANODE_SECURE_USER=root#HADOOP_SECURE_DN_USER=root2.修改start-yarn.sh和stop-yarn.shcd /home/hadoop/sbinvim start-yarn.shvim stop-yarn.sh在头部添加以下内容:#HADOOP_SECURE_DN_USER=rootHDFS_DATANODE_SECURE_USER=rootYARN_NODEMANAGER_USER=rootYARN_RESOURCEMANAGER_USER=root3.同步到其它机cd /home/hadoop/sbinscp * c2:/home/hadoop/sbinscp * c3:/home/hadoop/sbinscp * c4:/home/hadoop/sbin。

DFS文件系统删除文件恢复方法

关于WINDOWS 分布式文件系统DFS功能中任何文件夹及其所包含的文件删除后的恢复办法这里以域中2台有DFS功能的主机为基础环境(服务器:File和Filecopy,已具有复制关系的文件夹Public)建立文件在服务器File上的Public文件夹建立文件夹DFS-test,并在文件夹中建立若干文件test.txt、test2.txt…...现在遇到如下问题:假如这个DFS-test文件夹是一员工的个人的,有一天,这外员工急匆匆的来找你求救,说他的DFS-test文件夹被自己不小心删除了,里面有很重要的文件,但文件夹里面具体文件名是什么,太多了自己也不太清楚,删除后自己电脑回收站也没有,请你一定帮他找回来,这时你该怎么办?恢复数据1.这时你首先想到的是去冲突和已删除文件夹中去找E:\Public\DfsrPrivate\ConflictAndDeleted,但是,当打你打开这个文件夹时只发现以有一个以DFS-test-{45B92F17-65B3-4FF4-8248-F989F1DB45ED}-v1939736为命名的文件夹,但里面空空如也,任何内容都没有啊,这该咋办呢?你不能给员工说他的文件夹是空的吧!这下他要给你急了!2.当然你不用害怕,DFS在删除文件时,是建立了一个清单的,你只要仔细看看这个清单,就会发现DFS-test这个文件夹中所包含的文件及删除后的文件名称的变化,这个清单就在E:\Public\DfsrPrivate(文件夹是隐藏的哦!)这个文件夹的根目录中:ConflictAndDeletedManifest3.用记事本打开ConflictAndDeletedManifest你搜索DFS-test,如下图:用红色框框标注的就是原来的DFS-test文件夹及内所包含的文件,绿色部分就是删除后的文件名称,注意有个<NewName>的字样,意思就是删除后的新文件名称4.现在找到这几个文件并复制出来,根据目录结构存放并改回原名即可,文件找到。

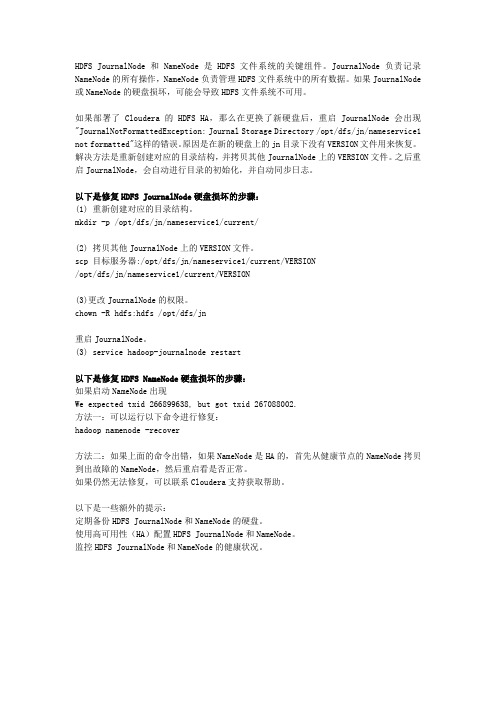

修复HDFS JournalNode和NameNode硬盘损坏

HDFS JournalNode和NameNode是HDFS文件系统的关键组件。

JournalNode负责记录NameNode的所有操作,NameNode负责管理HDFS文件系统中的所有数据。

如果JournalNode 或NameNode的硬盘损坏,可能会导致HDFS文件系统不可用。

如果部署了Cloudera的HDFS HA,那么在更换了新硬盘后,重启JournalNode会出现"JournalNotFormattedException: Journal Storage Directory /opt/dfs/jn/nameservice1 not formatted"这样的错误。

原因是在新的硬盘上的jn目录下没有VERSION文件用来恢复。

解决方法是重新创建对应的目录结构,并拷贝其他JournalNode上的VERSION文件。

之后重启JournalNode,会自动进行目录的初始化,并自动同步日志。

以下是修复HDFS JournalNode硬盘损坏的步骤:(1)重新创建对应的目录结构。

mkdir -p /opt/dfs/jn/nameservice1/current/(2)拷贝其他JournalNode上的VERSION文件。

scp 目标服务器:/opt/dfs/jn/nameservice1/current/VERSION/opt/dfs/jn/nameservice1/current/VERSION(3)更改JournalNode的权限。

chown -R hdfs:hdfs /opt/dfs/jn重启JournalNode。

(3)service hadoop-journalnode restart以下是修复HDFS NameNode硬盘损坏的步骤:如果启动NameNode出现We expected txid 266899638, but got txid 267088002.方法一:可以运行以下命令进行修复:hadoop namenode -recover方法二:如果上面的命令出错,如果NameNode是HA的,首先从健康节点的NameNode拷贝到出故障的NameNode,然后重启看是否正常。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Windows 2000 服务器和域控制器将DFS 配置信息存储在注册表和Active Directory 中。

在某些种情况下可能以返回到稳定状态很有用。

本文介绍如何删除DFS 配置注册表和Active Directory 中的数据。

重要此分区、方法,或任务包含告诉您如何修改注册表的步骤。

但是,如果注册表修改不当可能会出现严重问题。

因此,请确保您仔细按照这些步骤。

附加的保护注册表之前先备份您对其进行修改。

然后,您可以在出现问题时还原注册表。

有关如何备份和还原注册表的详细信息,请单击下面的文章编号,以查看Microsoft 知识库中相应的文章:322756

如何备份和还原在Windows 注册表

故障容错的DFS 根目录

1.通过将网络停止dfs关联在命令提示符处停止DFS 服务。

2.启动注册表编辑器并删除以下注册表项,请执行以下操作:

a.删除卷文件夹和$ HKLM\SOFTWARE\Microsoft\DfsHost 下的任何子文件

夹。

b.删除所有子文件夹下

HKLM\SYSTEM\CurrentControlSet\Services\DfsDriver\LocalVolumes,使

LocalVolumes 保持不变。

3.从Active Directory 用户和计算机管理单元中,单击在视图菜单上的高级功能。

打开系统文件夹下的,DFS 配置容器。

删除DFS 根目录,在右窗格中。

注意还可以从使用LDAP 或Adsiedit.msc 活动目录中删除DFS 配置数据。

在与

容错DFS 根目录名为DFSFT 域中的计算机的LDAP 路径应CN = DFS-

配置CN = 系统,DC = A,DC = COM。

4.在第1 步中,重新启动您停止了DFS 服务。

独立的DFS 根和Windows 2000 群集服务器

1.通过将网络停止dfs关联在命令提示符处停止DFS 服务。

2.启动注册表编辑器并删除以下注册表项,请执行以下操作:

a.删除卷文件夹和$ HKLM\SOFTWARE\Microsoft\DfsHost 下的任何子文件

夹。

b.删除所有子文件夹下

HKLM\SYSTEM\CurrentControlSet\Services\DfsDriver\LocalVolumes,使

LocalVolumes 保持不变。

3.在第1 步中,重新启动您停止了DFS 服务。

当您使用分布式文件系统(DFS) 向导创建一个新的DFS 根目录时,您完成该向导时可能会收到以下错误消息:

创建DFS 根目录时发生下列错误。

当该文件已存在时,不能创建文件。

回到顶端| 提供反馈

原因

如果从以前的DFS 根配置的DFS 信息仍包含在此计算机的注册表中,可以会出现此问题。

回到顶端| 提供反馈

解决方案

若要解决此问题,使用Dfsutil.exe 工具清除注册表中的DFS 信息。

若要清除无效DFS 信息从注册表中使用以下命令:

dfsutil / clean:servername

回到顶端| 提供反馈

更多信息

若要安装Dfsutil 工具,请从Support\Tools 文件夹在Windows 2000 安装光盘上安装支持工具。