Hadoop命令大全

hadoop命令及使用方法

hadoop命令及使用方法Hadoop是一个分布式计算框架,用于存储和处理大规模数据集。

下面是一些常用的Hadoop命令及其使用方法:1. hdfs命令:- hdfs dfs -ls <路径>:列出指定路径下的文件和目录。

- hdfs dfs -mkdir <路径>:创建一个新的目录。

- hdfs dfs -copyFromLocal <本地路径> <HDFS路径>:将本地文件复制到HDFS 上。

- hdfs dfs -copyToLocal <HDFS路径> <本地路径>:将HDFS上的文件复制到本地。

- hdfs dfs -cat <文件路径>:显示HDFS上的文件内容。

2. mapred命令:- mapred job -list:列出当前正在运行的MapReduce作业。

- mapred job -kill <job_id>:终止指定的MapReduce作业。

3. yarn命令:- yarn application -list:列出当前正在运行的应用程序。

- yarn application -kill <application_id>:终止指定的应用程序。

4. hadoop fs命令(与hdfs dfs命令功能相似):- hadoop fs -ls <路径>:列出指定路径下的文件和目录。

- hadoop fs -cat <文件路径>:显示HDFS上的文件内容。

- hadoop fs -mkdir <路径>:创建一个新的目录。

- hadoop fs -put <本地文件路径> <HDFS路径>:将本地文件复制到HDFS上。

- hadoop fs -get <HDFS路径> <本地文件路径>:将HDFS上的文件复制到本地。

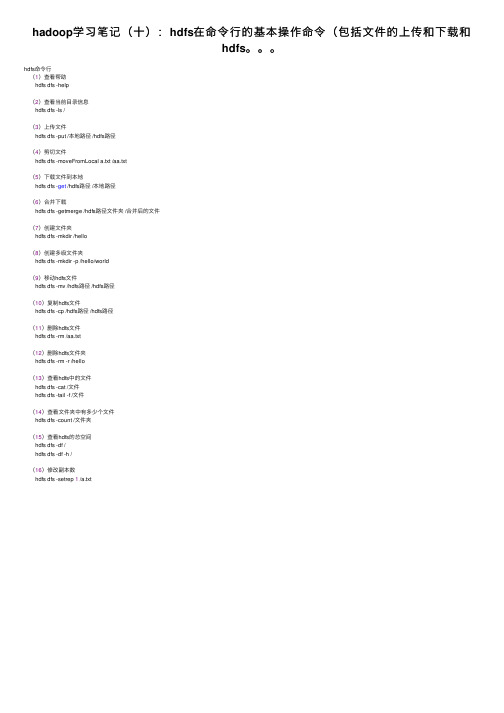

hadoop学习笔记(十):hdfs在命令行的基本操作命令(包括文件的上传和下载和hdfs。。。

hadoop学习笔记(⼗):hdfs在命令⾏的基本操作命令(包括⽂件的上传和下载和

hdfs。

hdfs命令⾏

(1)查看帮助

hdfs dfs -help

(2)查看当前⽬录信息

hdfs dfs -ls /

(3)上传⽂件

hdfs dfs -put /本地路径 /hdfs路径

(4)剪切⽂件

hdfs dfs -moveFromLocal a.txt /aa.txt

(5)下载⽂件到本地

hdfs dfs -get /hdfs路径 /本地路径

(6)合并下载

hdfs dfs -getmerge /hdfs路径⽂件夹 /合并后的⽂件

(7)创建⽂件夹

hdfs dfs -mkdir /hello

(8)创建多级⽂件夹

hdfs dfs -mkdir -p /hello/world

(9)移动hdfs⽂件

hdfs dfs -mv /hdfs路径 /hdfs路径

(10)复制hdfs⽂件

hdfs dfs -cp /hdfs路径 /hdfs路径

(11)删除hdfs⽂件

hdfs dfs -rm /aa.txt

(12)删除hdfs⽂件夹

hdfs dfs -rm -r /hello

(13)查看hdfs中的⽂件

hdfs dfs -cat /⽂件

hdfs dfs -tail -f /⽂件

(14)查看⽂件夹中有多少个⽂件

hdfs dfs -count /⽂件夹

(15)查看hdfs的总空间

hdfs dfs -df /

hdfs dfs -df -h /

(16)修改副本数

hdfs dfs -setrep 1 /a.txt。

hdfs操作常用的shell命令实验总结

hdfs操作常用的shell命令实验总结在Hadoop分布式文件系统(HDFS)中,有一些常用的Shell命令可帮助用户管理和操作文件。

本文将总结几个常用的HDFS Shell命令及其功能。

1. ls命令ls命令用于列出指定目录中的文件和子目录。

通过使用ls命令,可以快速查看HDFS中的文件结构,并确定文件和目录的权限、大小和修改日期。

2. mkdir命令mkdir命令用于创建一个新的HDFS目录。

可以使用该命令在指定路径下创建一个新的目录,以便于组织和存储文件。

3. put命令put命令用于将本地文件上传到HDFS中的指定位置。

可以使用put命令将本地系统中的文件复制到HDFS,以便于后续的处理和分析。

4. get命令get命令用于将HDFS中的文件下载到本地系统。

使用get命令可以将HDFS上的文件复制到本地,方便离线查看和处理。

5. rm命令rm命令用于删除HDFS中的文件或目录。

可以使用rm命令删除不再需要的文件或目录,释放存储空间。

6. mv命令mv命令用于移动HDFS中的文件或目录,并可更改名称。

通过使用mv命令,可以重新组织HDFS中的文件结构,或更改文件的命名。

7. cat命令cat命令用于打印HDFS中文件的内容到标准输出。

可以使用cat命令快速查看文件的内容,对文件进行简单的检查。

8. chmod命令chmod命令用于更改HDFS中文件或目录的权限。

通过使用chmod命令,可以为文件或目录设置适当的权限,以确保数据的安全性和可访问性。

总之,以上提到的命令是HDFS操作中常用的一些Shell命令。

它们能够帮助用户管理和操作HDFS中的文件和目录,方便数据的存储、上传、下载、删除、移动和查看。

这些命令是Hadoop生态系统中不可或缺的一部分,对于大规模数据处理和分析具有重要的作用。

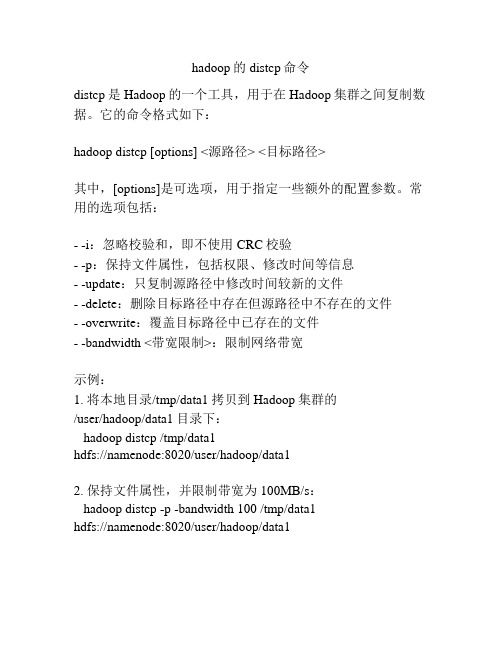

hadoop的distcp命令

hadoop的distcp命令

distcp是Hadoop的一个工具,用于在Hadoop集群之间复制数据。

它的命令格式如下:

hadoop distcp [options] <源路径> <目标路径>

其中,[options]是可选项,用于指定一些额外的配置参数。

常用的选项包括:

- -i:忽略校验和,即不使用CRC校验

- -p:保持文件属性,包括权限、修改时间等信息

- -update:只复制源路径中修改时间较新的文件

- -delete:删除目标路径中存在但源路径中不存在的文件

- -overwrite:覆盖目标路径中已存在的文件

- -bandwidth <带宽限制>:限制网络带宽

示例:

1. 将本地目录/tmp/data1拷贝到Hadoop集群的

/user/hadoop/data1目录下:

hadoop distcp /tmp/data1

hdfs://namenode:8020/user/hadoop/data1

2. 保持文件属性,并限制带宽为100MB/s:

hadoop distcp -p -bandwidth 100 /tmp/data1

hdfs://namenode:8020/user/hadoop/data1。

熟悉常用的linux操作和hadoop操作实验报告

熟悉常用的linux操作和hadoop操作实验报告本实验主要涉及两个方面,即Linux操作和Hadoop操作。

在实验过程中,我深入学习了Linux和Hadoop的基本概念和常用操作,并在实际操作中掌握了相关技能。

以下是我的实验报告:一、Linux操作1.基本概念Linux是一种开放源代码的操作系统,它允许用户自由地使用、复制、分发和修改系统。

Linux具有更好的性能、更高的安全性和更好的可定制性。

2.常用命令在Linux操作中,一些常用的命令包括:mkdir:创建目录cd:更改当前目录ls:显示当前目录中的文件cp:复制文件mv:移动文件rm:删除文件pwd:显示当前所在目录chmod:更改文件权限chown:更改文件所有者3.实验操作在实验中,我对Linux的文件系统、文件权限、用户与组等进行了学习和操作。

另外,我还使用Linux命令实现了目录创建、文件复制、删除等操作。

二、Hadoop操作1.基本概念Hadoop是一种开源框架,用于处理大规模数据和分布式计算。

它使用Hadoop分布式文件系统(HDFS)来存储数据,使用MapReduce来处理大规模数据集。

2.常用命令在Hadoop操作中,一些常用的命令包括:hdfs dfs:操作HDFS文件系统hadoop fs:操作Hadoop分布式文件系统hadoop jar:运行Hadoop任务hadoop namenode -format:格式化文件系统start-all.sh:启动所有Hadoop服务3.实验操作在实验中,我熟悉了Hadoop的安装过程、配置过程和基本概念。

我使用Hadoop的命令对文件系统进行操作,如创建、删除、移动文件等。

此外,我还学会了使用MapReduce处理大规模数据集。

总结通过本次实验,我巩固了Linux和Hadoop操作的基本知识和技能。

我深入了解了Linux和Hadoop的基本概念和常用操作,并学会了使用相关命令进行实际操作。

hadoopfs(HDFS文件系统命令)

hadoopfs(HDFS⽂件系统命令)Hadoop的HDFS操作命令 HDFS是存取数据的分布式⽂件系统,那么对HDFS的操作就是对⽂件系统的操作,⽐如⽂件的创建、修改、删除;⽂件夹的创建、修改、删除。

Hadoop作者认为⼤家对linux⽂件系统的命令很熟悉,于是借鉴了linux⽂件系统的命令来作为HDFS的操作命令。

(1)查看帮助hadoop fs -help(2)查看⽬录信息hadoop fs -ls /(3)递归查看⽬录信息hadoop fs -ls -R /(4)上传⽂件到HDFShadoop fs -put /本地路径 /hdfs路径(5)下载⽂件到本地hadoop fs -get /hdfs路径 /本地路径(6)剪切⽂件到hdfshadoop fs -moveFromLocal /本地路径 /hdfs路径(7)剪切⽂件到本地hadoop fs -moveToLocal /hdfs路径 /本地路径(8)创建⽂件夹hadoop fs -moveToLocal /hdfs路径 /本地路径(9)创建多级⽂件夹hadoop fs -mkdir -p /hello/hdp(10)移动hdfs⽂件hadoop fs -mv /hdfs路径 /hdfs路径(11)复制hdfs⽂件hadoop fs -cp /hdfs路径 /hdfs路径(12)删除hdfs⽂件hadoop fs -rm /⽂件路径(13)删除hdfs⽂件夹hadoop fs -rm -r /⽂件夹路径(14)查看hdfs⽂件hadoop fs -cat /⽂件路径hadoop fs -tail -f /⽂件(15)查看⽂件夹⾥有多少个⽂件hadoop fs -count /⽂件夹(16)查看hdfs的总空间hadoop fs -df /hadoop fs -df -h /。

hadoop中put用法

hadoop中put用法Hadoop是一个开源的分布式存储和计算框架,旨在解决大规模数据处理的问题。

在Hadoop中,Put是一个常用的命令,用于将数据加载到Hadoop分布式文件系统(HDFS)中。

本文将详细介绍Hadoop中Put命令的用法和相关注意事项。

一、Put命令简介在Hadoop中,Put命令用于将本地文件或文件夹上传到HDFS中的指定位置。

该命令的语法如下:```hadoop fs -put <localsrc> ... <dst>```其中,`<localsrc>`表示本地文件或文件夹的路径,`<dst>`表示目标位置在HDFS中的路径。

二、Put命令的用法1. 将单个文件上传到HDFS如果需要将单个文件上传到HDFS中,可以使用以下命令:```hadoop fs -put /path/to/localfile /path/to/hdfs```其中,`/path/to/localfile`是本地文件的路径,`/path/to/hdfs`是HDFS 中目标位置的路径。

例如,要将本地的文件`/home/user/data.txt`上传到HDFS中的`/user/hadoop`目录下,可以使用以下命令:```hadoop fs -put /home/user/data.txt /user/hadoop```2. 将文件夹上传到HDFS如果需要将整个文件夹上传到HDFS中,可以使用以下命令:```hadoop fs -put /path/to/localdir /path/to/hdfs```其中,`/path/to/localdir`是本地文件夹的路径,`/path/to/hdfs`是HDFS中目标位置的路径。

例如,要将本地的文件夹`/home/user/data`上传到HDFS中的`/user/hadoop`目录下,可以使用以下命令:```hadoop fs -put /home/user/data /user/hadoop```该命令将递归地将整个`/home/user/data`文件夹上传到HDFS中,并保持相同的目录结构。

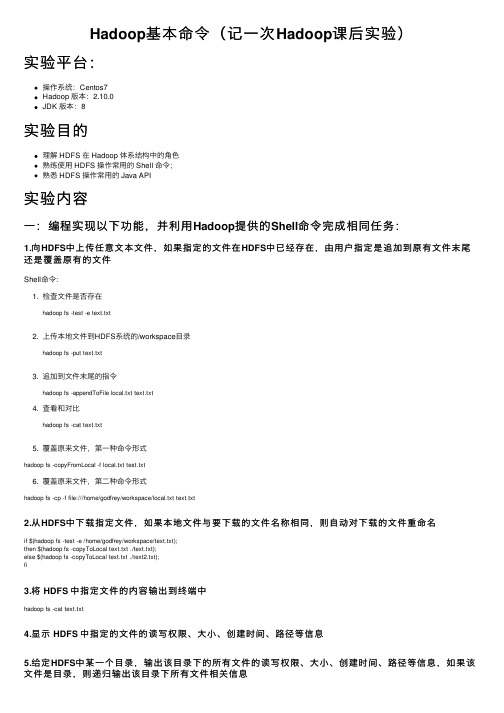

Hadoop基本命令(记一次Hadoop课后实验)

Hadoop基本命令(记⼀次Hadoop课后实验)实验平台:操作系统:Centos7Hadoop 版本:2.10.0JDK 版本:8实验⽬的理解 HDFS 在 Hadoop 体系结构中的⾓⾊熟练使⽤ HDFS 操作常⽤的 Shell 命令;熟悉 HDFS 操作常⽤的 Java API实验内容⼀:编程实现以下功能,并利⽤Hadoop提供的Shell命令完成相同任务:1.向HDFS中上传任意⽂本⽂件,如果指定的⽂件在HDFS中已经存在,由⽤户指定是追加到原有⽂件末尾还是覆盖原有的⽂件Shell命令:1. 检查⽂件是否存在hadoop fs -test -e text.txt2. 上传本地⽂件到HDFS系统的/workspace⽬录hadoop fs -put text.txt3. 追加到⽂件末尾的指令hadoop fs -appendToFile local.txt text.txt4. 查看和对⽐hadoop fs -cat text.txt5. 覆盖原来⽂件,第⼀种命令形式hadoop fs -copyFromLocal -f local.txt test.txt6. 覆盖原来⽂件,第⼆种命令形式hadoop fs -cp -f file:///home/godfrey/workspace/local.txt text.txt2.从HDFS中下载指定⽂件,如果本地⽂件与要下载的⽂件名称相同,则⾃动对下载的⽂件重命名if $(hadoop fs -test -e /home/godfrey/workspace/text.txt);then $(hadoop fs -copyToLocal text.txt ./text.txt);else $(hadoop fs -copyToLocal text.txt ./text2.txt);fi3.将 HDFS 中指定⽂件的内容输出到终端中hadoop fs -cat text.txt4.显⽰ HDFS 中指定的⽂件的读写权限、⼤⼩、创建时间、路径等信息5.给定HDFS中某⼀个⽬录,输出该⽬录下的所有⽂件的读写权限、⼤⼩、创建时间、路径等信息,如果该⽂件是⽬录,则递归输出该⽬录下所有⽂件相关信息hadoop fs -ls -R -h /6.提供⼀个HDFS内的⽂件的路径,对该⽂件进⾏创建和删除操作。

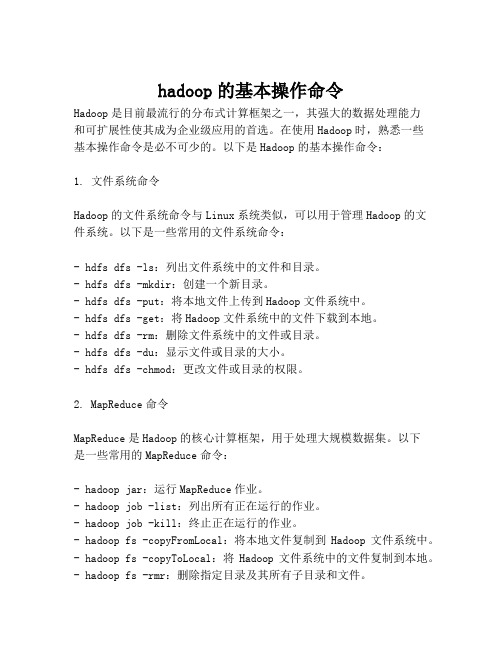

hadoop的基本操作命令

hadoop的基本操作命令Hadoop是目前最流行的分布式计算框架之一,其强大的数据处理能力和可扩展性使其成为企业级应用的首选。

在使用Hadoop时,熟悉一些基本操作命令是必不可少的。

以下是Hadoop的基本操作命令:1. 文件系统命令Hadoop的文件系统命令与Linux系统类似,可以用于管理Hadoop的文件系统。

以下是一些常用的文件系统命令:- hdfs dfs -ls:列出文件系统中的文件和目录。

- hdfs dfs -mkdir:创建一个新目录。

- hdfs dfs -put:将本地文件上传到Hadoop文件系统中。

- hdfs dfs -get:将Hadoop文件系统中的文件下载到本地。

- hdfs dfs -rm:删除文件系统中的文件或目录。

- hdfs dfs -du:显示文件或目录的大小。

- hdfs dfs -chmod:更改文件或目录的权限。

2. MapReduce命令MapReduce是Hadoop的核心计算框架,用于处理大规模数据集。

以下是一些常用的MapReduce命令:- hadoop jar:运行MapReduce作业。

- hadoop job -list:列出所有正在运行的作业。

- hadoop job -kill:终止正在运行的作业。

- hadoop fs -copyFromLocal:将本地文件复制到Hadoop文件系统中。

- hadoop fs -copyToLocal:将Hadoop文件系统中的文件复制到本地。

- hadoop fs -rmr:删除指定目录及其所有子目录和文件。

3. YARN命令YARN是Hadoop的资源管理器,用于管理Hadoop集群中的资源。

以下是一些常用的YARN命令:- yarn node -list:列出所有节点的状态。

- yarn application -list:列出所有正在运行的应用程序。

- yarn application -kill:终止正在运行的应用程序。

hdfs基础命令

hdfs基础命令HDFS基础命令Hadoop分布式文件系统(HDFS)是Apache Hadoop的核心组件之一,用于存储和管理大数据集。

HDFS提供了一组命令行工具,用于与文件系统进行交互和管理。

本文将介绍HDFS的基础命令,帮助用户熟悉和使用HDFS。

1. hdfs dfs -ls命令:该命令用于列出HDFS中指定目录下的文件和子目录。

例如,要列出根目录下的所有文件和目录,可以使用以下命令:```hdfs dfs -ls /```该命令将输出根目录下的所有文件和目录的详细信息,如文件大小、权限、所有者和修改时间等。

2. hdfs dfs -mkdir命令:该命令用于在HDFS中创建新目录。

例如,要在根目录下创建一个名为"test"的新目录,可以使用以下命令:```hdfs dfs -mkdir /test```该命令将创建一个名为"test"的新目录。

3. hdfs dfs -put命令:该命令用于将本地文件复制到HDFS中。

例如,要将本地文件"localfile.txt"复制到HDFS的"/test"目录中,可以使用以下命令:```hdfs dfs -put localfile.txt /test```该命令将本地文件"localfile.txt"复制到HDFS的"/test"目录中。

4. hdfs dfs -get命令:该命令用于将HDFS中的文件复制到本地文件系统中。

例如,要将HDFS中的文件"/test/hdfsfile.txt"复制到本地目录"/local"中,可以使用以下命令:```hdfs dfs -get /test/hdfsfile.txt /local```该命令将HDFS中的文件"/test/hdfsfile.txt"复制到本地目录"/local"中。

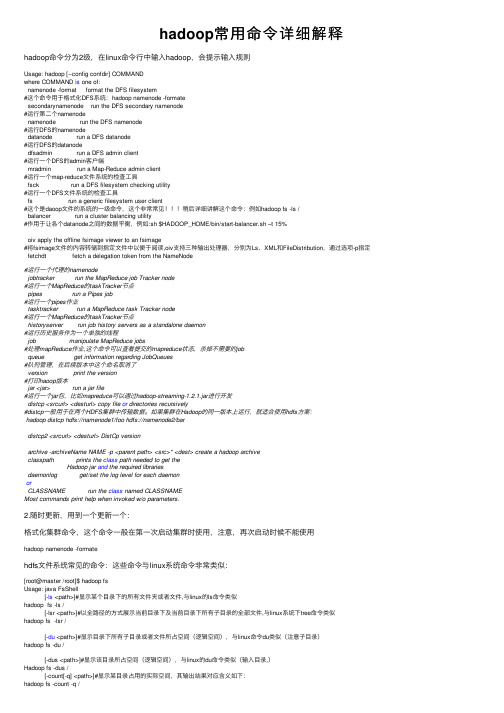

hadoop常用命令详细解释

hadoop常⽤命令详细解释hadoop命令分为2级,在linux命令⾏中输⼊hadoop,会提⽰输⼊规则Usage: hadoop [--config confdir] COMMANDwhere COMMAND is one of:namenode -format format the DFS filesystem#这个命令⽤于格式化DFS系统:hadoop namenode -formatesecondarynamenode run the DFS secondary namenode#运⾏第⼆个namenodenamenode run the DFS namenode#运⾏DFS的namenodedatanode run a DFS datanode#运⾏DFS的datanodedfsadmin run a DFS admin client#运⾏⼀个DFS的admin客户端mradmin run a Map-Reduce admin client#运⾏⼀个map-reduce⽂件系统的检查⼯具fsck run a DFS filesystem checking utility#运⾏⼀个DFS⽂件系统的检查⼯具fs run a generic filesystem user client#这个是daoop⽂件的系统的⼀级命令,这个⾮常常见稍后详细讲解这个命令:例如hadoop fs -ls /balancer run a cluster balancing utility#作⽤于让各个datanode之间的数据平衡,例如:sh $HADOOP_HOME/bin/start-balancer.sh –t 15%oiv apply the offline fsimage viewer to an fsimage#将fsimage⽂件的内容转储到指定⽂件中以便于阅读,oiv⽀持三种输出处理器,分别为Ls、XML和FileDistribution,通过选项-p指定 fetchdt fetch a delegation token from the NameNode#运⾏⼀个代理的namenodejobtracker run the MapReduce job Tracker node#运⾏⼀个MapReduce的taskTracker节点pipes run a Pipes job#运⾏⼀个pipes作业tasktracker run a MapReduce task Tracker node#运⾏⼀个MapReduce的taskTracker节点historyserver run job history servers as a standalone daemon#运⾏历史服务作为⼀个单独的线程job manipulate MapReduce jobs#处理mapReduce作业,这个命令可以查看提交的mapreduce状态,杀掉不需要的jobqueue get information regarding JobQueues#队列管理,在后续版本中这个命名取消了version print the version#打印haoop版本jar <jar> run a jar file#运⾏⼀个jar包,⽐如mapreduce可以通过hadoop-streaming-1.2.1.jar进⾏开发distcp <srcurl> <desturl> copy file or directories recursively#distcp⼀般⽤于在两个HDFS集群中传输数据。

hadoop集群之HDFS和YARN启动和停止命令

hadoop集群之HDFS和YARN启动和停⽌命令假如我们只有3台linux虚拟机,主机名分别为hadoop01、hadoop02和hadoop03,在这3台机器上,hadoop集群的部署情况如下:hadoop01:1个namenode,1个datanode,1个journalnode,1个zkfc,1个resourcemanager,1个nodemanager;hadoop02:1个namenode,1个datanode,1个journalnode,1个zkfc,1个resourcemanager,1个nodemanager;hadoop03:1个datenode,1个journalnode,1个nodemanager;下⾯我们来介绍启动hdfs和yarn的⼀些命令。

1.启动hdfs集群(使⽤hadoop的批量启动脚本)/root/apps/hadoop/sbin/start-dfs.sh[root@hadoop01 ~]# /root/apps/hadoop/sbin/start-dfs.shStarting namenodes on [hadoop01 hadoop02]hadoop01: starting namenode, logging to /root/apps/hadoop/logs/hadoop-root-namenode-hadoop01.outhadoop02: starting namenode, logging to /root/apps/hadoop/logs/hadoop-root-namenode-hadoop02.outhadoop03: starting datanode, logging to /root/apps/hadoop/logs/hadoop-root-datanode-hadoop03.outhadoop02: starting datanode, logging to /root/apps/hadoop/logs/hadoop-root-datanode-hadoop02.outhadoop01: starting datanode, logging to /root/apps/hadoop/logs/hadoop-root-datanode-hadoop01.outStarting journal nodes [hadoop01 hadoop02 hadoop03]hadoop03: starting journalnode, logging to /root/apps/hadoop/logs/hadoop-root-journalnode-hadoop03.outhadoop02: starting journalnode, logging to /root/apps/hadoop/logs/hadoop-root-journalnode-hadoop02.outhadoop01: starting journalnode, logging to /root/apps/hadoop/logs/hadoop-root-journalnode-hadoop01.outStarting ZK Failover Controllers on NN hosts [hadoop01 hadoop02]hadoop01: starting zkfc, logging to /root/apps/hadoop/logs/hadoop-root-zkfc-hadoop01.outhadoop02: starting zkfc, logging to /root/apps/hadoop/logs/hadoop-root-zkfc-hadoop02.out[root@hadoop01 ~]#从上⾯的启动⽇志可以看出,start-dfs.sh这个启动脚本是通过ssh对多个节点的namenode、datanode、journalnode以及zkfc进程进⾏批量启动的。

hadoop的count -v用法

hadoop的count -v用法Hadoop是一个分布式计算框架,用于高效地处理大规模数据。

其中,count命令是Hadoop中最基本的命令之一,可以用于计算文件或者目录中所有行的数量。

它的-v选项可以帮助用户更详细地了解计数的结果。

count命令的基本语法如下:hadoop fs -count [-q] [-h] [-v] [-t] [-u] <paths>其中,<paths>是需要计数的文件或者目录的路径。

当使用-v选项时,count命令会显示更详细的计数信息。

以下为-v选项的使用方法及其相关参数:1. -v - 显示详细计数信息使用-v选项时,count命令会显示文件或目录中的每个子目录和文件的计数信息,包括文件大小、块数和副本数。

示例:/user/hadoop/data 183 39276 10240/user/hadoop/data/dir1 5 20 2/user/hadoop/data/dir2 10 40 2/user/hadoop/data/file1 1 10 2/user/hadoop/data/file2 2 30 2/user/hadoop/data/file3 4 20 2上述命令计算了/user/hadoop/data目录下的所有文件和子目录的计数信息,并使用了-v选项来显示详细信息。

其中,183表示所有文件和子目录的数量(包括目录本身),39276表示所有文件和子目录的总大小,10240表示块大小(单位是字节)。

183 39276 10240使用-u选项时,count命令会将文件大小和总大小以字节为单位来显示。

使用-q选项时,count命令不显示任何详细信息,仅输出文件或目录中的总数量信息。

183其中,183表示所有文件和子目录的数量(包括目录本身)。

综上所述,count命令的-v选项可以帮助用户更详细地了解计数的结果,同时,它还提供了其他选项,如-t、-u、-q和-h等,可以满足用户不同的需求。

hadoop数据副本数量相关命令;

Hadoop是一种开源的分布式文件存储和计算系统,被广泛应用于大数据领域。

在Hadoop中,数据的可靠性和容错性是至关重要的,因此Hadoop引入了数据副本机制来保障数据的可靠性。

在Hadoop集裙中,数据会被分成多个块,并将这些块保存在不同的计算机上,以防止单点故障和数据丢失。

在本文中,我们将介绍Hadoop中与数据副本数量相关的一些命令和操作。

1. 查看数据块的副本情况在Hadoop中,可以使用以下命令来查看数据块的副本情况:hdfs fsck / -files -blocks -locations该命令会列出Hadoop集裙中所有块的副本情况,包括块的ID、复本数量、所在的数据节点等信息。

通过这些信息,可以清楚地了解每个数据块的副本情况,从而评估数据的可靠性和容错性。

2. 修改数据块的副本数量在Hadoop中,可以通过以下命令来修改数据块的副本数量:hdfs dfs -setrep -w 3 /user/hadoop/data.txt该命令会将指定文件的副本数量修改为3,这样可以增加数据的容错性和可靠性。

在某些情况下,可能需要根据实际情况来调整数据块的副本数量,以满足系统的要求。

3. 查看集裙的副本数量配置在Hadoop集裙中,可以通过以下命令来查看副本数量的相关配置信息:hadoop fs -getconf dfs.replication该命令会显示Hadoop集裙当前的副本数量配置,可以了解到集裙中数据块的默认副本数量是多少。

在实际应用中,可以根据业务需求和系统性能来调整副本数量的配置。

4. 修改集裙的副本数量配置如果需要修改集裙的副本数量配置,可以通过以下方式来实现:a. 打开Hadoop的配置文件hdfs-site.xml。

b. 修改配置项dfs.replication的值,将其设置为新的副本数量。

c. 保存文件并重启Hadoop集裙。

通过以上步骤,就可以修改Hadoop集裙的副本数量配置,从而影响整个集裙的数据副本情况。

启动hadoop的命令

启动hadoop的命令start-all.sh 启动所有的守护进程。

包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrackstop-all.sh 停⽌所有的Hadoop守护进程。

包括NameNode、 Secondary NameNode、DataNode、JobTracker、 TaskTrack start-dfs.sh 启动Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNodestop-dfs.sh 停⽌Hadoop HDFS守护进程NameNode、SecondaryNameNode和DataNodehadoop-daemons.sh start namenode 单独启动NameNode守护进程hadoop-daemons.sh stop namenode 单独停⽌NameNode守护进程hadoop-daemons.sh start datanode 单独启动DataNode守护进程hadoop-daemons.sh stop datanode 单独停⽌DataNode守护进程hadoop-daemons.sh start secondarynamenode 单独启动SecondaryNameNode守护进程hadoop-daemons.sh stop secondarynamenode 单独停⽌SecondaryNameNode守护进程start-mapred.sh 启动Hadoop MapReduce守护进程JobTracker和TaskTrackerstop-mapred.sh 停⽌Hadoop MapReduce守护进程JobTracker和TaskTrackerhadoop-daemons.sh start jobtracker 单独启动JobTracker守护进程hadoop-daemons.sh stop jobtracker 单独停⽌JobTracker守护进程hadoop-daemons.sh start tasktracker 单独启动TaskTracker守护进程hadoop-daemons.sh stop tasktracker 单独启动TaskTracker守护进程如果Hadoop集群是第⼀次启动,可以⽤start-all.sh。

Hadoop命令大全

Hadoop命令大全本节比较全面的向大家介绍一下Hadoop命令,欢迎大家一起来学习,希望通过本节的介绍大家能够掌握一些常见Hadoop命令的使用方法。

下面是Hadoop命令的详细介绍。

Hadoop命令大全1、列出所有HadoopShell支持的命令$bin/hadoopfs-help2、显示关于某个命令的详细信息$bin/hadoopfs-helpcommand-name3、用户可使用以下命令在指定路径下查看历史日志汇总$bin/hadoopjob-historyoutput-dir这条命令会显示作业的细节信息,失败和终止的任务细节。

4、关于作业的更多细节,比如成功的任务,以及对每个任务的所做的尝试次数等可以用下面的命令查看$bin/hadoopjob-historyalloutput-dir5、格式化一个新的分布式文件系统:$bin/hadoopnamenode-format6、在分配的NameNode上,运行下面的Hadoop命令启动HDFS:$bin/start-dfs.shbin/start-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上启动DataNode守护进程。

7、在分配的JobTracker上,运行下面的命令启动Map/Reduce:$bin/start-mapred.shbin/start-mapred.sh脚本会参照JobTracker上${HADOOP_CONF_DIR}/sla ves文件的内容,在所有列出的slave上启动TaskTracker守护进程。

8、在分配的NameNode上,执行下面的Hadoop命令停止HDFS:$bin/stop-dfs.shbin/stop-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上停止DataNode守护进程。

Hadoop命令手册使用指南

Hadoop命令手册使用指南2010-06-03 17:27 王亚妮 我要评论(0)字号:T | THadoop命令你是否熟悉,这里就向大家简单介绍一下Hadoop命令使用问题,希望通过本文的介绍大家对Hadoop命令有一定的了解。

AD:在学习Hadoop的过程中,你可能经常遇到Hadoop命令方面的问题,本节就向大家介绍一些常用的Hadoop 命令,欢迎大家一起来学习。

Hadoop命令手册所有的hadoop命令均由bin/hadoop脚本引发。

不指定参数运行hadoop脚本会打印所有命令的描述。

用法:hadoop[--configconfdir][COMMAND][GENERIC_OPTIONS][COMMAND_OPTIONS]Hadoop有一个选项解析框架用于解析一般的选项和运行类。

命令选项描述--configconfdir覆盖缺省配置目录。

缺省是${HADOOP_HOME}/conf。

GENERIC_OPTIONS多个命令都支持的通用选项。

COMMAND命令选项S各种各样的命令和它们的选项会在下面提到。

这些命令被分为用户命令管理命令两组。

Hadoop命令常规选项下面的选项被dfsadmin,fs,fsck和job支持。

应用程序要实现Tool来支持常规选项。

GENERIC_OPTION描述-conf<configurationfile>指定应用程序的配置文件。

-D<property=value>为指定property指定值value。

-fs<local|namenode:port>指定namenode。

-jt<local|jobtracker:port>指定jobtracker。

只适用于job。

-files<逗号分隔的文件列表>指定要拷贝到mapreduce集群的文件的逗号分隔的列表。

只适用于job。

-libjars<逗号分隔的jar列表>指定要包含到classpath中的jar文件的逗号分隔的列表。

hdoop的hdfs中的常用操作命令

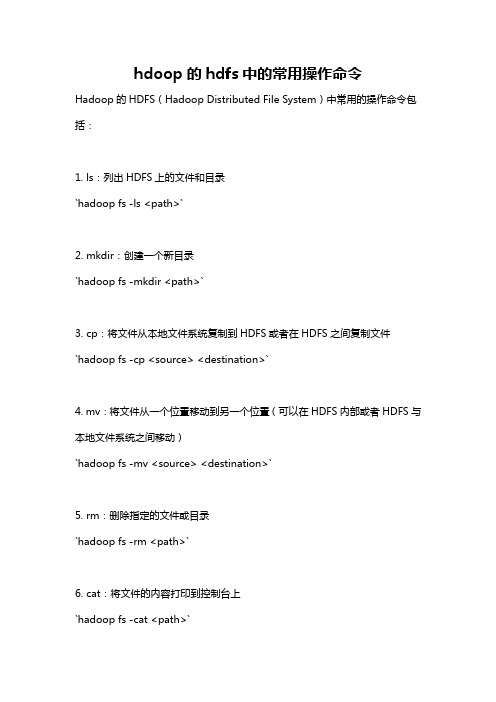

hdoop的hdfs中的常用操作命令Hadoop的HDFS(Hadoop Distributed File System)中常用的操作命令包括:1. ls:列出HDFS上的文件和目录`hadoop fs -ls <path>`2. mkdir:创建一个新目录`hadoop fs -mkdir <path>`3. cp:将文件从本地文件系统复制到HDFS或者在HDFS之间复制文件`hadoop fs -cp <source> <destination>`4. mv:将文件从一个位置移动到另一个位置(可以在HDFS内部或者HDFS与本地文件系统之间移动)`hadoop fs -mv <source> <destination>`5. rm:删除指定的文件或目录`hadoop fs -rm <path>`6. cat:将文件的内容打印到控制台上`hadoop fs -cat <path>`7. tail:显示文件的最后几行`hadoop fs -tail <path>`8. get:将文件从HDFS复制到本地文件系统`hadoop fs -get <source> <destination>`9. put:将文件从本地文件系统复制到HDFS`hadoop fs -put <source> <destination>`10. chmod:更改文件的权限`hadoop fs -chmod <mode> <path>`以上是HDFS中常用的操作命令。

可以使用命令`hadoop fs -help`查看更多的HDFS命令及其用法。

Hadoop常用命令及范例

Hadoop常⽤命令及范例 hadoop中的zookeeper,hdfs,以及hive,hbase都是hadoop的组件,要学会熟练掌握相关的命令及其使⽤规则,下⾯就是⼀些常⽤命令及对hbase和hive的操作语句,同时也列出了⼀些范例。

start-dfs.sh NameNode 进程启动:hadoop-daemon.sh start namenode DataNode 进程启动:hadoop-daemon.sh start datanode HA ⾼可⽤环境中需要启动的进程: zookeeper: zkServer.sh start 启动 zkServer.sh stop 停⽌ zkServer.sh status 查看状态 leader follwer journalnode 集群命令 hadoop-daemon.sh start journalnode 启动 hadoop-daemon.sh stop journalnode 停⽌ ZKFC 启动 zkfc 进程: hadoop-daemon.sh start zkfc 停⽌ zkfc 进程: hadoop-daemon.sh stop zkfc 1. shell命令管理和 HDFS 的⽂件管理。

(1)启动 Zookeeper zkServer.sh start (2)启动 HDFS 的命令 start-dfs.sh (3)启动 Yarn 的命令 start-yarn.sh (4)显⽰ HDFS 中/data/test ⽬录信息 hadoop fs -mkdir /data/test hadoop fs -lsr /data/test (5)将本地⽂件/tmp/log.txt ⽂件上传到/data/test ⽬录中 hadoop fs -put /tmp/log.txt /data/test (6)设置⽂件/data/test/log.txt 的副本数为 3 hadoop fs -setrep -w 3 /data/test/log.txt (7)显⽰/data/test/log.txt ⽂件内容 hadoop fs -cat /data/test/log.txt (8)将/data/test/log.txt ⽂件移动到集群/user/hadoop ⽬录下 hadoop fs -mkdir /user/hadoop hadoop fs -mv /data/test/log.txt /user/hadoop (9)将/data/test/log.txt ⽂件下载到/home/hadoop ⽬录下 hadoop fs -copyToLocal /data/test/log.txt /home/hadoop/ (10)关闭 HDFS 命令 stop-dfs.sh (11)停⽌ Zookeeper zkServer.sh stop 2.将学⽣数据存储到 Hive 数据仓库中,信息包括(学号,姓名,性别,年龄,联系⽅式, 邮箱),创建表语法如下: 启动 hive 前切记要先启动 mysql 数据库 create table student(sno string ,name string ,sex string ,age int ,phone string, email string) row format delimited fields terminated by ',' ;(1)将本地数据“/tmp/student.dat”加载到 student 表,写出操作语句 load data local inpath '/tmp/student.dat' overwrite into table student; (2)写 HQL 语句查询全部学⽣信息 select * from student; (3)写 HQL 语句查询各个年龄及对应学⽣数量 (4) select age,count(*) from student group by age; (5)写 HQL 语句查询全部学⽣的姓名和性别 select name,sex from student; (6)写 HQL 语句查询年龄为 18 的学⽣姓名和联系⽅式 select name,phone from student where age=18; (7)写 HQL 语句查看 student 表结构 describe student; (8)写 HQL 语句删除 student 表 drop table student; (9)导出⽣地/home/hadoop/out ⽬录,写出语 from student insert overwrite local directory '/home/hadoop/out' select *; 3.员⼯表 employee 包含两个列族 basic 和 info,使⽤ shell 命令完成以下操作。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop命令大全Hadoop配置:Hadoop配置文件core-site.xml应增加如下配置,否则可能重启后发生Hadoop 命名节点文件丢失问题:<property><name>hadoop.tmp.dir</name><value>/home/limingguang/hadoopdata</value></property>环境变量设置:为了便于使用各种命令,可以在.bashrc文件中添加如下内容:export JAVA_HOME=/home/limingguang/jdk1.7.0_07export HADOOP_HOME=/home/limingguang/hadoop-1.0.3export HIVE_HOME=/home/limingguang/hive-0.9.0export MAHOUT_HOME=/home/limingguang/mahout-distribution-0.7exportPATH=$JAVA_HOME/bin:$HADOOP_HOME/bin:$HIVE_HOME/bin:$MAHOUT_HOME/bin: $PATHexport HADOOP_HOME_WARN_SUPPRESS=1具体目录请更改为安装目录,HADOOP_HOME_WARN_SUPPRESS变量为抑制HADOOP_HOME变量重复时的告警。

常用命令:1、列出所有Hadoop Shell支持的命令$ bin/hadoop fs -help2、显示关于某个命令的详细信息$ bin/hadoop fs -help command-name3、用户可使用以下命令在指定路径下查看历史日志汇总$ bin/hadoop job -history output-dir这条命令会显示作业的细节信息,失败和终止的任务细节。

4、关于作业的更多细节,比如成功的任务,以及对每个任务的所做的尝试次数等可以用下面的命令查看$ bin/hadoop job -history all output-dir5、格式化一个新的分布式文件系统:$ bin/hadoop namenode -format6、在分配的NameNode上,运行下面的命令启动HDFS:$ bin/start-dfs.shbin/start-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上启动DataNode守护进程。

7、在分配的JobTracker上,运行下面的命令启动Map/Reduce:$ bin/start-mapred.shbin/start-mapred.sh脚本会参照JobTracker上${HADOOP_CONF_DIR}/slaves 文件的内容,在所有列出的slave上启动TaskTracker守护进程。

8、在分配的NameNode上,执行下面的命令停止HDFS:$ bin/stop-dfs.shbin/stop-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上停止DataNode守护进程。

9、在分配的JobTracker上,运行下面的命令停止Map/Reduce:$ bin/stop-mapred.shbin/stop-mapred.sh脚本会参照JobTracker上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上停止TaskTracker守护进程。

10、启动所有$ bin/start-all.sh11、关闭所有$ bin/stop-all.shDFSShell10、创建一个名为 /foodir 的目录$ bin/hadoop dfs -mkdir /foodir11、创建一个名为 /foodir 的目录$ bin/hadoop dfs -mkdir /foodir12、查看名为 /foodir/myfile.txt 的文件内容$ bin/hadoop dfs -cat /foodir/myfile.txt说明:hadoop fs <..> 命令等同于 hadoop dfs <..> 命令DFSAdmin13、将集群置于安全模式$ bin/hadoop dfsadmin -safemode enter14、显示Datanode列表$ bin/hadoop dfsadmin -report15、使Datanode节点 datanodename退役$ bin/hadoop dfsadmin -decommission datanodename16、bin/hadoop dfsadmin -help 命令能列出所有当前支持的命令。

比如:* -report:报告HDFS的基本统计信息。

有些信息也可以在NameNode Web服务首页看到。

* -safemode:虽然通常并不需要,但是管理员的确可以手动让NameNode进入或离开安全模式。

* -finalizeUpgrade:删除上一次升级时制作的集群备份。

17、显式地将HDFS置于安全模式$ bin/hadoop dfsadmin -safemode18、在升级之前,管理员需要用(升级终结操作)命令删除存在的备份文件$ bin/hadoop dfsadmin -finalizeUpgrade19、能够知道是否需要对一个集群执行升级终结操作。

$ dfsadmin -upgradeProgress status20、使用-upgrade选项运行新的版本$ bin/start-dfs.sh -upgrade21、如果需要退回到老版本,就必须停止集群并且部署老版本的Hadoop,用回滚选项启动集群$ bin/start-dfs.h -rollback22、下面的新命令或新选项是用于支持配额的。

前两个是管理员命令。

* dfsadmin -setquota <N> <directory>...<directory>把每个目录配额设为N。

这个命令会在每个目录上尝试,如果N不是一个正的长整型数,目录不存在或是文件名,或者目录超过配额,则会产生错误报告。

* dfsadmin -clrquota <directory>...<director>为每个目录删除配额。

这个命令会在每个目录上尝试,如果目录不存在或者是文件,则会产生错误报告。

如果目录原来没有设置配额不会报错。

* fs -count -q <directory>...<directory>使用-q选项,会报告每个目录设置的配额,以及剩余配额。

如果目录没有设置配额,会报告none和inf。

23、创建一个hadoop档案文件$ hadoop archive -archiveName NAME <src>* <dest>-archiveName NAME 要创建的档案的名字。

src 文件系统的路径名,和通常含正则表达的一样。

dest 保存档案文件的目标目录。

24、递归地拷贝文件或目录$ hadoop distcp <srcurl> <desturl>srcurl 源Urldesturl 目标Url25、运行HDFS文件系统检查工具(fsck tools)用法:hadoop fsck [GENERIC_OPTIONS] <path> [-move | -delete |-openforwrite] [-files [-blocks [-locations | -racks]]]命令选项描述<path> 检查的起始目录。

-move 移动受损文件到/lost+found-delete 删除受损文件。

-openforwrite 打印出写打开的文件。

-files 打印出正被检查的文件。

-blocks 打印出块信息报告。

-locations 打印出每个块的位置信息。

-racks 打印出data-node的网络拓扑结构。

26、用于和Map Reduce作业交互和命令(jar)用法:hadoop job [GENERIC_OPTIONS] [-submit <job-file>] | [-status<job-id>] | [-counter <job-id> <group-name> <counter-name>] | [-kill <job-id>] | [-events <job-id> <from-event-#> <#-of-events>] | [-history [all] <jobOutputDir>] | [-list [all]] | [-kill-task <task-id>] |[-fail-task <task-id>]命令选项描述-submit <job-file> 提交作业-status <job-id> 打印map和reduce完成百分比和所有计数器。

-counter <job-id> <group-name> <counter-name> 打印计数器的值。

-kill <job-id> 杀死指定作业。

-events <job-id> <from-event-#> <#-of-events> 打印给定范围内jobtracker 接收到的事件细节。

-history [all] <jobOutputDir> -history <jobOutputDir> 打印作业的细节、失败及被杀死原因的细节。

更多的关于一个作业的细节比如成功的任务,做过的任务尝试等信息可以通过指定[all]选项查看。

-list [all] -list all 显示所有作业。

-list只显示将要完成的作业。

-kill-task <task-id> 杀死任务。

被杀死的任务不会不利于失败尝试。

-fail-task <task-id> 使任务失败。

被失败的任务会对失败尝试不利。

27、运行pipes作业用法:hadoop pipes [-conf <path>] [-jobconf <key=value>, <key=value>, ...] [-input <path>] [-output <path>] [-jar <jar file>] [-inputformat <class>] [-map <class>] [-partitioner <class>] [-reduce <class>] [-writer <class>] [-program <executable>] [-reduces <num>]命令选项描述-conf <path> 作业的配置-jobconf <key=value>, <key=value>, ... 增加/覆盖作业的配置项-input <path> 输入目录-output <path> 输出目录-jar <jar file> Jar文件名-inputformat <class> InputFormat类-map <class> Java Map类-partitioner <class> Java Partitioner-reduce <class> Java Reduce类-writer <class> Java RecordWriter-program <executable> 可执行程序的URI-reduces <num> reduce个数说明:Hadoop pipes给C++程序员提供了一个编写MapReduce作业的方案,它使用socket让Java和C++之间进行通信,这类似于thrift RPC的原理,也许Hadoop Pipes用thrift编写会更加简单。