唯品会孟诚——ApacheSTORM日志分析探索

基于大数据技术的日志分析平台培训

操作

描述

字段名:搜索内容 部分字符匹配

字段名:” 搜索内容” 全字符匹配

搜索内容*

模糊匹配*

搜索内容?

模糊匹配?

搜索内容~

相似匹配~

搜索内容

相似匹配~ 数字

内容 AND 内容 求交集

内容 OR 内容

求并集

+搜索内容 -搜索内容 NOT

包含搜索内容 排除搜索内容 与!相似

示例

交易流水号:101C03R6T17651ED 交易流水号:"101C03R6T17651ED" 101C03*651ED 101C03R6T1?651ED 101C03R6T17651ED~ 101C03R6T17651ED~4 交易流水号:"101F0AINU2A72937" AND 交易 码:"18cx61001" 交易流水号:"101F0AINU2A72937" OR 交易 码:"18cx61001" +18cx61001 -18cx61001 NOT 交易流水号:"101F0AINU2A72937" AND 交易码:"18cx61001"

跨平台解决方案 1、开源软件 2、100%-Pure的Java 3、索引兼容其他编程语言版本

可扩展,高性能索引 1、每小时处理超过150G的数据 2、只需要1MB内存 3、增量索引和批量索引一样快 4、索引大小只有文本索引的20-30% 功能强大,准确,高效的搜索算法 1、搜索排名- 最好的结果显示在最前 面 2、支持许多强大的查询类型:短语 查询,通配符查询,近似查询,范围 查询等 3、类型搜索(如标题,作者,内容) 4、任何字段排序 5、多索引与合并结果搜索 6、允许同时更新和搜索 7、灵活的可塑性,高亮,联接和结 果分组 8、速度快,内存效率高和容错建议 9、可插拔的排名模型,其中包括向 量空间模型和Okapi BM25 10、配置存储引擎(编解码器)

基于Hadoop的购物网站用户行为分析

基于Hadoop的购物网站用户行为分析摘要:随着互联网的普及,购物网站作为一种新兴的电子商务模式,已经快速发展成为最具潜力和前景的产业之一。

在这一背景下,购物网站的搭建者对用户的行为进行分析和挖掘,已经成为关键的竞争因素之一。

然而,传统的数据处理技术已经无法满足大规模数据的处理需求。

本文通过Hadoop分布式框架搭建数据分析平台,运用DBeaver技术结合HDFS、Hive数据仓库等对用户的一系列购物行为进行分析,为电子商务企业提供有用的参考和指导。

关键词:Hadoop购物网站用户行为一、背景与意义(一)研究背景近年来,伴随着网购的普及和人们消费观念的变化,购物网站成为电子商务的重要平台之一。

购物网站通过提供方便的选购、在线支付、快捷的配送等服务,满足人们日常生活购物的需求。

然而,随着购物网站的竞争日益激烈,商家们需要更好地了解用户需求,优化用户体验,提升网站的竞争力。

(二)研究意义本文的研究意义在于,通过应用Hadoop和Hive技术对购物网站用户行为数据进行深入分析,为购物网站提供大数据支持,为网站管理者提供决策和营销活动的有力依据,以帮助购物网站管理者更好地了解用户需求,提高购物网站的服务质量和用户体验。

二、研究内容本文的主要研究内容是基于Hadoop的购物网站用户行为分析。

具体地来说,本研究内容包括以下几个方面:数据采集和预处理:本论文从购物网站获取了用户行为相关数据,利用Hadoop的数据批处理能力对数据进行预处理,使得数据能够在HDFS上被高效管理。

数据挖掘:本论文使用Hive进行数据挖掘,对数据进行清洗、建模、分析等处理,得出了用户行为的一系列特征,包括用户浏览商品的时间(活跃度)、商品种类、购买数量,消费频率等等。

数据可视化:本论文对Hive处理后的数据使用DBeaver进行可视化展示,使用柱状图、折线图等图表方式,使得用户行为特征数据成为了更加直观的信息。

数据分析和解读:结合实际应用场景,本论文对数据进行了分析和解读,得出了用户行为的规律和趋势。

最全最经典的管理学工具、方法理论大全

SWOT模型的局限性

与很多其他的战略模型一样,SWOT模型已由麦肯锡提出很久了,带有时代的局限性。以前的企业可能比较关注成本、质量,现在的企业可能更强调组织流程。例如以前的电动打字机被印表机取代,该怎么转型?是应该做印表机还是其他与机电有关的产品?从SWOT分析来看,电动打字机厂商优势在机电,但是发展印表机又显得比较有机会。结果有的朝印表机发展,死得很惨;有的朝剃须刀生产发展很成功。这就要看,你要的是以机会为主的成长策略,还是要以能力为主的成长策略。SWOT没有考虑到企业改变现状的主动性,企业是可以通过寻找新的资源来创造企业所需要的优势,从而达到过去无法达成的战略目标。

当两个企业处在同一市场或者说它们都有能力向同一顾客群体提供产品和服务时,如果其中一个企业有更高的赢利率或赢利潜力,那么,我们就认为这个企业比另外一个企业更具有竞争优势。换句话说,所谓竞争优势是指一个企业超越其竞争对手的能力,这种能力有助于实现企业的主要目标——赢利。但值得注意的是:竞争优势并不一定完全体现在较高的赢利率上,因为有时企业更希望增加市场份额,或者多奖励管理人员或雇员。

采购

寻找供应商/物料收取

获得、接收、检验、拒收与发送物料

Spark大数据商业实战三部曲:内核解密、商业案例、性能调优

第10章 Spark中Broadcast和Accumulator原理和源码详解

10.1 Spark中Broadcast原理和源码详解 10.2 Spark中Accumulator原理和源码详解

第11章 Spark与大数据其他经典组件整合原理与实战

11.1 Spark组件综合应用 11.2 Spark与Alluxio整合原理与实战 11.3 Spark与Job Server整合原理与实战 11.4 Spark与Redis整合原理与实战

统案例

第17章 Spark在通 信运营商生产环境中 的应用案例

第18章使用Spark GraphX实现婚恋社 交网络多维度分析案 例

第12章 Spark商业案例之大数据电影点评系统应用案例

12.1通过RDD实现分析电影的用户行为信息 12.2通过RDD实现电影流行度分析 12.3通过RDD分析各种类型的最喜爱电影TopN及性能优化技巧 12.4通过RDD分析电影点评系统仿QQ和**等用户群分析及广播背后机制解密 12.5通过RDD分析电影点评系统实现Java和Scala版本的二次排序系统 12.6通过Spark SQL中的SQL语句实现电影点评系统用户行为分析 12.7通过Spark SQL下的两种不同方式实现口碑最佳电影分析 12.8通过Spark SQL下的两种不同方式实现最流行电影分析 12.9通过DataFrame分析最受男性和女性喜爱电影TopN

5.1 Master启动原理和源码详解 5.2 Worker启动原理和源码详解 5.3 ExecutorBackend启动原理和源码详解 5.4 Executor中任务的执行 5.5 Executor执行结果的处理方式 5.6本章总结

第6章 Spark Application提交给集群的原理和源码详解

基于AWStats的校园网站群日志统计分析

e howe o > tt c blg >fp mp. t t x e howe l g wd fp mp. c b o p >> t t t xt e hop o c r mpt tt pt t >>f m . p x

搿誊蛰 麓《 羞 ,辫嚣 瓣 端 蒌 嚣 毫 誊 蠢 垂 搿

一

瓣 潞 莓 牵 糍 荤 i 攀

、

需求提 出

鋈

闫

嚣 陶

校园网中各部门 、学 院网站多为 自主制作 ,分散在

不 同的服务器 。各网站架设使用 的环境不 同,主要 分为 w n o sIS i x aah 等 ,产生 的 日志格式不 同。 id w +I 、l u + p ce n 需要一种跨 平 台的 日志分析 软件。另外 ,因为各w b e 网

比如 :运行 .ws t. 一 o f :I调 用的就是 同 目录下 / t s 】 cni ts a a p g 1

a t sut of ws t.scn ̄配 置 文 件 。 a r . 32W id ws IS 户 机 下 的具 体实 现 .. n o + I客

C 或者命令行方式运行 。通过 即时数据文件 ,A t s GI Ws t a 可 以快速 的处理大数据量 的 日志 文件 。A tt 支持 WSas 可

d l tt pt t e p m . f x

最后将此批处理加入计划任务 ,实现定时执行 。 33Ln x A a h 客 户机下的具体实现 ..iu + p c e A a h 的 日志文件 默认不 是按 天分割 ,需要 使用 p ce co o o 将 日志分 割 。首 先安 装co oo ,之 后查 找 r n lg r n lg

Apache STORM日志分析技术

技术创新,变革未来

Presentation将包含以下内容

• STORM简单介绍。 • 为何会开始研究STORM? • 我们使用STORM计算什么? • 搭建STORM平台过程中遇到的问题。 • STORM性能优化算法。

日志对于安全来说是什么? 我认为它是安全的感官

中间计数器

中间计数器

Key

wap_login, 1505221735, 101.102.135.1

value 1

最终计数器

Key

wap_login, 1505221735, 101.102.135.1

value 12

Key

wap_login, 1505221735, 101.102.135.1

value 3

T

C_2

F

Y

生成 计数字段

wap_login, 1505221735, 101.102.135.1

mapi

login_id=.*&p Wap

T

asswd

_login

sapi

.*

S_1

T

传到计数器

预聚合

wap_login,1505221735,101.102.135.1 wap_login,1505221735,101.102.135.1 wap_login,1505221735,101.102.135.1

车身 5分钟 车身 5分钟

流水线处理

喷漆5分钟

5分钟

一小时能造几辆车?

1+(60-20)/10 = 5辆 1+(60-20)/5 = 9辆

内饰 5分钟

内饰 5分钟

流水线优化:正则

数据库查询优化实战优化复杂查询以提高性能的案例分析

数据库查询优化实战优化复杂查询以提高性能的案例分析在数据库应用程序开发中,查询是非常重要的一环。

随着数据量的增加和业务需求的复杂化,查询性能成为了一个关键问题。

本文将通过实际案例的分析,探讨如何对复杂查询进行优化,以提高数据库的性能。

一、背景介绍在一个在线商城的数据库应用中,存在一个复杂的查询,该查询用于获取订单信息、商品信息以及用户信息,并根据一定的条件进行筛选和排序。

由于数据量庞大,查询语句的性能不佳,导致响应时间过长,影响了用户的使用体验。

二、问题分析通过对该查询的分析,发现存在以下问题:1. 涉及多张表的联合查询:该查询需要从订单表、商品表和用户表中获取数据,并通过多表关联实现数据的关联与筛选。

多表联合查询会增加查询的时间复杂度,影响查询性能。

2. 外部排序:查询语句需要对查询结果进行排序,排序操作会消耗大量的计算资源和时间。

3. 数据库索引不完善:数据库中的索引设置不合理,导致查询时需要执行全表扫描,加大了查询的开销。

三、优化方案针对上述问题,我们可以采取以下优化方案来提高查询的性能:1. 简化查询语句:通过优化查询逻辑,尽量减少多表联合查询的数量,避免不必要的数据关联与筛选。

可以考虑通过子查询或者临时表的方式,将复杂的查询分解为多个简单的查询,然后再将结果进行关联。

2. 添加合适的索引:通过分析查询语句中的条件和关联字段,添加合适的索引。

索引可以加快查询的速度,避免全表扫描。

3. 数据库分区:如果数据库中的数据量非常大,可以考虑对数据进行分区。

通过合理的分区策略,可以将查询的数据范围缩小,提高查询性能。

4. 缓存查询结果:对于一些频繁查询且更新较少的数据,可以将查询结果缓存起来,下次查询时直接从缓存中获取,避免再次执行复杂的查询操作。

5. 调整数据库参数:根据实际情况,调整数据库的相关参数,如内存分配、缓存大小等,以提高数据库的整体性能。

四、实施与效果通过以上优化方案的实施,我们对复杂查询进行了优化,并对优化后的查询进行了性能测试。

storm架构及原理

storm架构及原理storm 架构与原理1 storm简介1.1 storm是什么如果只⽤⼀句话来描述是什么的话:分布式 && 实时计算系统。

按照作者的说法,storm对于实时计算的意义类似于hadoop对于批处理的意义。

Hadoop(⼤数据分析领域⽆可争辩的王者)专注于批处理。这种模型对许多情形(⽐如为⽹页建⽴索引)已经⾜够,但还存在其他⼀些使⽤模型,它们需要来⾃⾼度动态的来源的实时信息。为了解决这个问题,就得借助 Nathan Marz 推出的 storm(现在已经被Apache 孵化)storm 不处理静态数据,但它处理连续的流数据。

1.2 storm 与传统的⼤数据storm 与其他⼤数据解决⽅案的不同之处在于它的处理⽅式。

Hadoop 在本质上是⼀个批处理系统。数据被引⼊ Hadoop ⽂件系统(HDFS) 并分发到各个节点进⾏处理。当处理完成时,结果数据返回到 HDFS 供始发者使⽤。

storm ⽀持创建拓扑结构来转换没有终点的数据流。

不同于 Hadoop 作业,这些转换从不停⽌,它们会持续处理到达的数据。

Hadoop 的核⼼是使⽤ Java™ 语⾔编写的,但⽀持使⽤各种语⾔编写的数据分析应⽤程序。

⽽ Twitter Storm 是使⽤ Clojure语⾔实现的。

Clojure 是⼀种基于虚拟机 (VM) 的语⾔,在 Java 虚拟机上运⾏。

但是,尽管 storm 是使⽤ Clojure 语⾔开发的,您仍然可以在 storm 中使⽤⼏乎任何语⾔编写应⽤程序。所需的只是⼀个连接到 storm 的架构的适配器。

已存在针对 Scala,JRuby,Perl 和 PHP 的适配器,但是还有⽀持流式传输到 Storm 拓扑结构中的结构化查询语⾔适配器。

2 Hadoop 架构的瓶颈Hadoop是优秀的⼤数据离线处理技术架构,主要采⽤的思想是“分⽽治之”,对⼤规模数据的计算进⾏分解,然后交由众多的计算节点分别完成,再统⼀汇总计算结果。

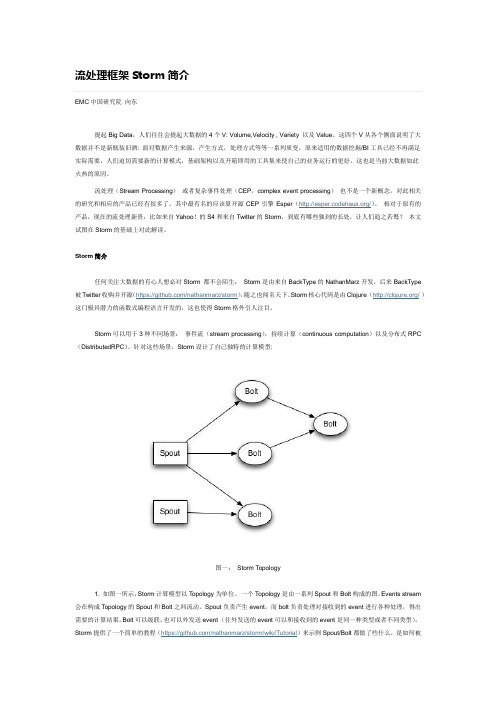

流处理storm

流处理框架Storm简介EMC中国研究院向东提起Big Data,人们往往会提起大数据的4个V: Volume,Velocity , Variety 以及Value。

这四个V从各个侧面说明了大数据并不是新瓶装旧酒: 面对数据产生来源,产生方式,处理方式等等一系列质变,原来适用的数据挖掘/BI工具已经不再满足实际需要,人们迫切需要新的计算模式,基础架构以及开箱即用的工具集来使自己的业务运行的更好。

这也是当前大数据如此火热的原因。

流处理(Stream Processing)或者复杂事件处理(CEP,complex event processing)也不是一个新概念,对此相关的研究和相应的产品已经有很多了,其中最有名的应该算开源CEP引擎Esper(/)。

相对于原有的产品,现在的流处理新贵,比如来自Yahoo!的S4和来自Twitter的Storm,到底有哪些独到的长处,让人们趋之若鹜?本文试图在Storm的基础上对此解读。

Storm简介任何关注大数据的有心人想必对Storm 都不会陌生:Storm是由来自BackType的NathanMarz开发,后来BackType 被Twitter收购并开源(https:///nathanmarz/storm),随之也闻名天下。

Storm核心代码是由Clojure (/)这门极具潜力的函数式编程语言开发的,这也使得Storm格外引人注目。

Storm可以用于3种不同场景:事件流(stream processing),持续计算(continuous computation)以及分布式RPC (DistributedRPC)。

针对这些场景,Storm设计了自己独特的计算模型:图一:Storm Topology1. 如图一所示,Storm计算模型以Topology为单位。

一个Topology是由一系列Spout和Bolt构成的图。

Events stream 会在构成Topology的Spout和Bolt之间流动。

基于正则表达式的日志解析系统构建研究

基于正则表达式的日志解析系统构建研究【摘要】本文通过研究基于正则表达式的日志解析系统构建,旨在探讨如何利用正则表达式技术来提高日志解析的效率和精度。

在将介绍研究背景、研究目的和研究意义。

接着在系统性地讨论日志解析系统的概述、正则表达式在日志解析中的应用、系统构建设计、系统功能实现以及系统性能评估。

最后在将总结研究成果,并展望未来的研究方向,提出结论和建议。

通过本文的研究,可以为日志解析系统的设计和优化提供一定的参考和指导,同时也可以为相关领域的研究工作提供一定的借鉴和启发。

【关键词】关键词:正则表达式、日志解析系统、构建研究、日志解析、系统设计、系统功能、性能评估、研究总结、展望未来、结论和建议。

1. 引言1.1 研究背景日志是记录系统运行状态和操作记录的重要信息,对系统的监控、故障排查、安全分析等具有重要作用。

随着系统规模越来越大,日志数据量也在不断增加,传统的手动分析和处理已经无法满足需求。

开发一种高效、自动化的日志解析系统变得尤为重要。

当前,基于正则表达式的日志解析系统得到了广泛关注和应用。

正则表达式是一种强大的模式匹配工具,可以帮助用户快速准确地从海量日志数据中提取所需信息。

目前市面上仍缺乏一款通用且高效的正则表达式日志解析系统。

本研究旨在基于正则表达式构建一种高效、智能化的日志解析系统,以提升日志分析的效率和精准度。

通过研究正则表达式在日志解析中的应用,设计并实现一套自动化的日志解析系统,并对其性能进行评估,旨在为日志分析领域带来新的技术突破。

1.2 研究目的研究目的是为了探索基于正则表达式的日志解析系统的构建方法和技术,并验证其在实际应用中的可行性和效果。

通过研究,我们可以深入了解日志解析系统的核心概念和关键技术,为日志数据的有效分析和利用提供新的思路和方法。

通过对系统功能的实现和性能评估,我们可以评估系统的稳定性、可靠性和效率,为日志解析系统的进一步优化和改进提供参考。

通过本研究,我们希望能够为日志解析系统的研究和应用提供有益的借鉴和参考,推动日志数据处理技术的发展和进步,为实际工程应用提供更好的支持和保障。

elastic apm 实现原理

elastic apm 实现原理Elastic APM是一个开源的应用程序性能监控工具,它可以帮助开发人员和系统管理员跟踪和分析应用程序的性能问题。

它可以集成到应用程序中,收集并分析关于应用程序的性能数据,如请求响应时间、数据库查询时间、CPU使用率等指标,以帮助诊断和解决性能问题。

实现原理:1. 仪表化:Elastic APM通过在应用程序中嵌入代码来追踪和监控性能。

它使用agent来收集关于请求、事务和跟踪的数据,并将这些数据发送到Elasticsearch集群进行存储和分析。

通过使用agent,可以实现对应用程序性能的实时监控。

2. 事务追踪:Elastic APM通过将请求和响应关联起来,实现对事务的追踪。

它会自动追踪请求,并记录下请求的路径、响应时间、错误信息等相关数据。

这样可以方便开发人员追踪和分析每个事务的性能,并找出潜在的性能问题。

3. 性能指标收集:Elastic APM还可以收集其他与性能相关的指标,如数据库查询时间、外部API调用时间、CPU使用率等。

这些指标可以帮助开发人员了解应用程序的性能情况,并在必要时进行性能调优。

4. 数据存储和分析:Elastic APM使用Elasticsearch集群来存储和分析收集到的性能数据。

Elasticsearch是一个分布式的搜索和分析引擎,可以高效地存储和查询大量的数据。

通过使用Elasticsearch,可以方便地对性能数据进行查询和分析,从而快速定位和解决性能问题。

5. 可视化:Elastic APM提供了一个用户友好的可视化界面,可以展示应用程序的性能数据。

通过图表、报表等方式,可以直观地了解应用程序的性能情况,并根据这些数据进行性能优化。

参考内容:- The Elastic APM documentation: Elastic官方提供了详细的APM文档,其中包含了如何集成和使用APM的指南,以及有关APM实现原理的说明。

通过仔细阅读这些文档,可以深入理解APM的实现原理和使用方式。

Storm日志分析调研及其实时架构

Storm⽇志分析调研及其实时架构1.Storm第⼀个Demo2.3.Storm实例+mysql数据库保存4.Storm原理介绍5. flume+kafka+storm+mysql 实时架构1.Storm第⼀个Demo Storm运⾏模式:1. 本地模式(Local Mode):即Topology(相当于⼀个任务,后续会详细讲解)运⾏在本地机器的单⼀JVM上,这个模式主要⽤来开发、调试。

2. 远程模式(Remote Mode):在这个模式,我们把我们的Topology提交到集群,在这个模式中,Storm的所有组件都是线程安全的,因为它们都会运⾏在不同的Jvm或物理机器上,这个模式就是正式的⽣产模式。

写⼀个HelloWord Storm我们现在创建这么⼀个应⽤,统计⽂本⽂件中的单词个数,详细学习过Hadoop的朋友都应该写过。

那么我们需要具体创建这样⼀个Topology,⽤⼀个spout负责读取⽂本⽂件,⽤第⼀个bolt来解析成单词,⽤第⼆个bolt来对解析出的单词计数,整体结构如图所⽰:可以从这⾥下载源码:写⼀个可运⾏的Demo很简单,我们只需要三步:1. 创建⼀个Spout读取数据2. 创建bolt处理数据3. 创建⼀个Topology提交到集群下⾯我们就写⼀下,以下代码拷贝到eclipse(依赖的jar包到官⽹下载即可)即可运⾏。

1.创建⼀个Spout作为数据源Spout作为数据源,它实现了IRichSpout接⼝,功能是读取⼀个⽂本⽂件并把它的每⼀⾏内容发送给bolt。

package storm.demo.spout;import java.io.BufferedReader;import java.io.FileNotFoundException;import java.io.FileReader;import java.util.Map;import backtype.storm.spout.SpoutOutputCollector;import backtype.storm.task.TopologyContext;import backtype.storm.topology.IRichSpout;import backtype.storm.topology.OutputFieldsDeclarer;import backtype.storm.tuple.Fields;import backtype.storm.tuple.Values;public class WordReader implements IRichSpout {private static final long serialVersionUID = 1L;private SpoutOutputCollector collector;private FileReader fileReader;private boolean completed = false;public boolean isDistributed() {return false;}/*** 这是第⼀个⽅法,⾥⾯接收了三个参数,第⼀个是创建Topology时的配置,* 第⼆个是所有的Topology数据,第三个是⽤来把Spout的数据发射给bolt* **/@Overridepublic void open(Map conf, TopologyContext context,SpoutOutputCollector collector) {try {//获取创建Topology时指定的要读取的⽂件路径this.fileReader = new FileReader(conf.get("wordsFile").toString());} catch (FileNotFoundException e) {throw new RuntimeException("Error reading file ["+ conf.get("wordFile") + "]");}//初始化发射器this.collector = collector;}/*** 这是Spout最主要的⽅法,在这⾥我们读取⽂本⽂件,并把它的每⼀⾏发射出去(给bolt)* 这个⽅法会不断被调⽤,为了降低它对CPU的消耗,当任务完成时让它sleep⼀下* **/@Overridepublic void nextTuple() {if (completed) {try {Thread.sleep(1000);} catch (InterruptedException e) {// Do nothing}return;}String str;// Open the readerBufferedReader reader = new BufferedReader(fileReader);try {// Read all lineswhile ((str = reader.readLine()) != null) {/*** 发射每⼀⾏,Values是⼀个ArrayList的实现*/this.collector.emit(new Values(str), str);}} catch (Exception e) {throw new RuntimeException("Error reading tuple", e);} finally {completed = true;}}@Overridepublic void declareOutputFields(OutputFieldsDeclarer declarer) {declarer.declare(new Fields("line"));}@Overridepublic void close() {// TODO Auto-generated method stub}@Overridepublic void activate() {// TODO Auto-generated method stub}@Overridepublic void deactivate() {// TODO Auto-generated method stub}@Overridepublic void ack(Object msgId) {System.out.println("OK:" + msgId);}@Overridepublic void fail(Object msgId) {System.out.println("FAIL:" + msgId);}@Overridepublic Map<String, Object> getComponentConfiguration() {// TODO Auto-generated method stubreturn null;}}2.创建两个bolt来处理Spout发射出的数据Spout已经成功读取⽂件并把每⼀⾏作为⼀个tuple(在Storm数据以tuple的形式传递)发射过来,我们这⾥需要创建两个bolt分别来负责解析每⼀⾏和对单词计数。

大模型在日志运维场景的应用实践

在日志运维场景中,大模型的应用已经成为一种趋势。

大模型是指参数规模巨大、模型复杂度高、训练和推理代价高昂的模型。

它能够处理日志中海量的数据信息,对系统运行状态进行实时监控和分析,帮助运维人员及时发现和定位问题,保障系统的稳定性和安全性。

1. 大模型在日志异常检测中的应用在日志运维场景中,异常检测是一个非常重要的任务。

通过大模型对日志数据进行训练和学习,可以建立一个日常运行状态的基准模型,当系统出现异常时,大模型能够快速识别出异常数据,并及时发出警报。

这对于保障系统的可靠性和稳定性具有至关重要的意义。

2. 大模型在日志分析中的应用日志分析是日志运维工作中的核心环节。

通过大模型对日志数据进行分析,可以发现系统运行的潜在问题和瓶颈,为优化系统提供重要参考。

大模型能够从海量的日志数据中挖掘出隐藏的信息和规律,为运维人员提供决策支持和解决问题的思路。

3. 大模型在日志预测中的应用预测是日志运维中的一项重要任务。

通过大模型对历史日志数据的学习和建模,可以预测系统未来的运行状态和趋势。

这对于及时调整系统资源配置、预防潜在故障、提高系统稳定性和性能具有重要意义。

4. 大模型在日志挖掘中的应用日志中蕴含着丰富的信息和价值,通过大模型的挖掘和分析,可以发现系统中存在的问题、用户的行为特征、潜在的安全隐患等。

这对于提升系统运行的智能化和安全性具有非常重要的意义。

大模型在日志运维场景中的应用极大地拓展了运维人员对系统的监控、分析和预测能力,帮助他们更好地保障系统的稳定可靠运行。

然而,大模型的应用也面临着一些挑战,包括巨大的计算消耗、数据隐私保护等问题。

随着技术的不断进步和创新,相信大模型在日志运维领域的应用会越来越广泛,为提升系统运行效率和安全性作出更大的贡献。

以上就是本文对于“大模型在日志运维场景的应用实践”进行的阐述,在就是对大模型的日志运维场景中的应用做了详细的介绍,从异常检测、日志分析、日志预测以及日志挖掘等几个方面展开了论述。

skywalking include-names-regex 例子 -回复

skywalking include-names-regex 例子-回复SkyWalking 是一款开源的应用性能监控工具,它能够跟踪、诊断和优化分布式系统中的性能问题。

本文将以`[skywalking includenamesregex 例子]` 为主题,逐步解释SkyWalking 的概念、功能和使用方式,并介绍使用示例。

第一部分:介绍SkyWalkingSkyWalking 是一款由Apache Software Foundation 孵化的开源项目。

它旨在帮助开发人员和运维团队追踪和解决分布式系统中的性能问题。

SkyWalking 提供了分布式跟踪、性能指标分析和应用程序拓扑识别等功能,以帮助开发人员提升系统性能和用户体验。

第二部分:SkyWalking 的核心功能1. 分布式跟踪:SkyWalking 可以跟踪分布式系统中不同组件之间的调用链,并记录请求的流转情况。

开发人员可以通过查看跟踪日志来定位性能瓶颈和异常情况,从而优化系统性能。

2. 性能指标分析:SkyWalking 收集系统中各个组件的性能指标,并提供了可视化的仪表板,用于实时监控和分析系统的性能表现。

开发人员可以通过仪表板查看各组件的平均响应时间、吞吐量、错误率等信息,以便发现潜在的性能问题。

3. 应用程序拓扑识别:SkyWalking 可以识别出分布式系统中的各个组件,并展示它们之间的关系和依赖。

这有助于开发人员了解系统的整体架构,并为系统优化和重构提供指导。

第三部分:使用示例假设我们有一个由多个微服务组成的电子商务网站。

现在我们希望使用SkyWalking 来监控系统的性能表现和诊断潜在的问题。

1. 安装和配置SkyWalking:首先,我们需要从SkyWalking 的官方网站下载最新的发布版本,并根据官方文档进行安装和配置。

这通常包括启动SkyWalking 服务端、设置代理和配置文件等步骤。

2. 启用分布式跟踪:为了跟踪我们的微服务之间的调用链,我们需要在每个微服务中集成SkyWalking 的客户端库。

使用Storm实现实时大数据分析

全量数据处理使用的大多是鼎鼎大名的hadoop或者hive,作为一个批处理系统,hadoop 以其吞吐量大、自动容错等优点,在海量数据处理上得到了广泛的使用。

Hadoop下的Map/Reduce框架对于数据的处理流程是:1、将要处理的数据上传到Hadoop的文件系统HDFS中。

2、Map阶段a) Master对Map的预处理:对于大量的数据进行切分,划分为M个16~64M 的数据分片(可通过参数自定义分片大小)b) 调用Mapper函数:Master为Worker分配Map任务,每个分片都对应一个Worker进行处理。

各个Worker读取并调用用户定义的Mapper函数处理数据,并将结果存入HDFS,返回存储位置给Master。

一个Worker在Map阶段完成时,在HDFS中,生成一个排好序的Key-values组成的文件。

并将位置信息汇报给Master。

3、Reduce阶段a) Master对Reduce的预处理:Master为Worker分配Reduce任务,他会将所有Mapper产生的数据进行映射,将相同key的任务分配给某个Worker。

b) 调用Reduce函数:各个Worker将分配到的数据集进行排序(使用工具类Merg),并调用用户自定义的Reduce函数,并将结果写入HDFS。

每个Worker的Reduce任务完成后,都会在HDFS中生成一个输出文件。

Hadoop并不将这些文件合并,因为这些文件往往会作为另一个Map/reduce程序的输入。

以上的流程,粗略概括,就是从HDFS中获取数据,将其按照大小分片,进行分布式处理,最终输出结果。

从流程来看,Hadoop框架进行数据处理有以下要求:1、数据已经存在在HDFS当中。

2、数据间是少关联的。

各个任务执行器在执行负责的数据时,无需考虑对其他数据的影响,数据之间应尽可能是无联系、不会影响的。

使用Hadoop,适合大批量的数据处理,这是他所擅长的。

详解开源日志分析管理软件--ELK架构原理与介绍

详解开源日志分析管理软件--ELK架构原理与介绍概述一般我们需要进行日志分析场景:直接在日志文件中grep、awk 就可以获得自己想要的信息。

但在规模较大的场景中,此方法效率低下,面临问题包括日志量太大如何归档、文本搜索太慢怎么办、如何多维度查询。

需要集中化的日志管理,所有服务器上的日志收集汇总。

常见解决思路是建立集中式日志收集系统,将所有节点上的日志统一收集,管理,访问。

而开源的集中式日志管理系统首推ELK/EFK,接下来带大家了解下这块。

ELK一般大型系统是一个分布式部署的架构,不同的服务模块部署在不同的服务器上,问题出现时,大部分情况需要根据问题暴露的关键信息,定位到具体的服务器和服务模块,构建一套集中式日志系统,可以提高定位问题的效率。

一个完整的集中式日志系统,需要包含以下几个主要特点:•收集-能够采集多种来源的日志数据•传输-能够稳定的把日志数据传输到中央系统•存储-如何存储日志数据•分析-可以支持 UI 分析•警告-能够提供错误报告,监控机制ELK提供了一整套解决方案,并且都是开源软件,之间互相配合使用,完美衔接,高效的满足了很多场合的应用。

目前主流的一种日志系统。

ELK简介ELK是三个开源软件的缩写,分别表示:Elasticsearch , Logstash, Kibana , 它们都是开源软件。

新增了一个FileBeat,它是一个轻量级的日志收集处理工具(Agent),Filebeat占用资源少,适合于在各个服务器上搜集日志后传输给Logstash,官方也推荐此工具。

Elasticsearch是个开源分布式搜索引擎,提供搜集、分析、存储数据三大功能。

它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。

Logstash 主要是用来日志的搜集、分析、过滤日志的工具,支持大量的数据获取方式。

一般工作方式为c/s架构,client端安装在需要收集日志的主机上,server端负责将收到的各节点日志进行过滤、修改等操作在一并发往elasticsearch上去。

问题定位与处理方案

问题定位与处理方案1. 问题描述在项目开发过程中,我们遇到了如下问题:- 问题一:在用户登录时,有10%的用户反馈登录失败,错误信息不明确。

- 问题二:部分用户在浏览商品时,页面响应速度较慢,影响用户体验。

- 问题三:在订单提交环节,有5%的用户无法成功提交订单,且没有给出具体错误提示。

为了解决上述问题,提高产品质量和用户体验,我们制定了如下处理方案。

2. 问题定位2.1 问题一:登录失败问题- 分析登录失败的原因,可能包括:网络异常、服务器负载过高、登录接口异常、数据库访问异常等。

- 通过日志收集和数据分析,确定问题发生的具体原因。

2.2 问题二:页面响应速度慢- 对页面进行性能分析,可能的原因包括:图片体积过大、CSS/JS文件过大、数据库查询效率低等。

- 通过工具检测页面性能,找出瓶颈并进行优化。

2.3 问题三:订单提交失败- 分析订单提交失败的原因,可能包括:网络异常、服务器负载过高、支付接口异常、数据库访问异常等。

- 通过日志收集和数据分析,确定问题发生的具体原因。

3. 处理方案3.1 针对问题一:登录失败问题- 优化登录接口,增加友好提示,如“用户名或密码错误”、“服务器暂时无法响应”等。

- 对服务器进行负载均衡,提高服务器性能。

- 增强数据库访问性能,如使用缓存技术。

3.2 针对问题二:页面响应速度慢- 优化图片,使用压缩工具进行压缩,减小图片体积。

- 压缩CSS/JS文件,可以使用工具如Webpack进行打包压缩。

- 优化数据库查询,使用索引、分页等技术提高查询效率。

3.3 针对问题三:订单提交失败- 优化支付接口,提高支付成功率。

- 对服务器进行负载均衡,提高服务器性能。

- 增强数据库访问性能,如使用缓存技术。

4. 实施计划- 阶段一(1-2周):定位问题原因,分析并提出优化方案。

- 阶段二(3-4周):按照优化方案进行代码修改和系统调优。

- 阶段三(5-6周):对优化后的系统进行测试,确保问题得到解决。