一种基于支持向量机的直推式学习算法

svm手推公式

svm手推公式支持向量机(SVM)的手推公式主要包括以下几个部分:1. 目标函数:SVM的目标函数是求解一个二次规划问题,其目标是最小化决策函数与原点之间的距离,同时保证分类间隔最大。

具体来说,目标函数可以表示为:min α 1 2 ∑ i = 1 , j = 1 m α i α j y i y j K ( x i , x j ) − ∑ i = 1 m α i \underbrace{\min }_{\alpha} \frac{1}{2} \sum_{i=1,j=1}^{m} \alpha_{i} \alpha_{j} y_{i} y_{j} K\left(x_{i}, x_{j}\right)-\sum_{i=1}^{m} \alpha_{i}i=1∑mαis . t . ∑ i = 1 m α i y i = 0 \\sum_{i=1}^{m} \alpha_{i} y_{i}==1∑mαi yi=00 ≤ α i ≤ C 0 \leq\alpha_{i} \leq C0≤αi≤C其中,$K(x_{i}, x_{j})$ 是核函数,$\alpha_{i}$ 是拉格朗日乘数,$y_{i}$ 是样本标签,$C$ 是惩罚因子。

2. 约束条件:在目标函数中,约束条件是 $\sum_{i=1}^{m} \alpha_{i}y_{i}=0$,表示所有样本的分类结果必须满足一定的条件。

3. 支持向量:支持向量是在最优解中,使得目标函数取得最小值的样本点。

4. 决策函数:通过求解目标函数和约束条件,可以得到最优解 $\alpha^{} = (\alpha_{1}^{}, \alpha_{2}^{}, \ldots, \alpha_{m}^{})$,进而可以计算出决策函数 $f(x) = \sum_{i=1}^{m} \alpha_{i}^{} y_{i} K(x, x_{i}) + b$,其中 $b$ 是偏置项。

基于增量学习的直推式支持向量机算法

Tr n d tv u po t v c o a h ne a e n i r m e tp r e t r m c i s b s d o nc e n a e r i g

J l 0 8 uy2 0

基 于 增量 学 习的直 推 式支 持 向量 机算 法

肖建鹏 , 来顺 , 张 任

( e e sh .o ) bt t ou cr r@ n

星

( 息 工 程 大 学 电子 技 术 学 院 ,郑 州 4 0 0 信 5 04)

摘

一

要 : 对直推式 支持向量机在进行 大数据量分类时 出现精 度低、 针 学习速度慢和 回溯式 学习多的问题 , 出了 提

维普资讯

第2 8卷 第 7期

20 0 8年 7月

文章编号 :0 1 9 8 ( 08 0 10 — 0 1 20 )7—14 0 62— 3

计 算机应 用

Co u e p ia in mp tr Ap lc to s

Vo. 8 No 7 12 .

XI in p n ,Z AO Ja ・ e g HANG L is u , RE n a・h n N Xig

(ntu l t ncTcnlg,I om t nE gnen nvrt Z eghut nn4 0 0 , hn) Istto Ee r i e o y n rai n ier gU i sy hnzo ea 5 04 C ia i e f co h o f o i e i, t

0 引言

基 于结 构 风 险 最 小 化 原 则 的 支 持 向量 机 ( up  ̄ V c r Sp o et o

1 支持 向量机

支持向量机算法的原理

支持向量机算法的原理支持向量机(Support Vector Machine,SVM)是一种广泛应用于分类和回归问题的机器学习算法。

它的原理基于统计学习理论中的结构风险最小化原则,通过寻找一个最优的超平面来实现数据的分类。

在SVM中,数据被看作是高维空间中的点,每个点都有一个与之对应的特征向量。

这些特征向量的维度取决于特征的数量。

SVM的目标是找到一个超平面,使得其能够尽可能地将不同类别的数据点分隔开。

超平面是一个d维空间中的d-1维子空间,其中d为特征向量的维度。

在二维空间中,超平面即为一条直线,可以完全将两类数据点分开。

在更高维的空间中,超平面可以是一个曲面或者是一个超平面的组合。

为了找到最优的超平面,SVM引入了支持向量的概念。

支持向量是离超平面最近的数据点,它们决定了超平面的位置和方向。

通过最大化支持向量到超平面的距离,SVM能够找到一个最优的超平面,使得分类误差最小化。

SVM的核心思想是将低维空间中的数据映射到高维空间中,使得原本线性不可分的数据变得线性可分。

这一映射是通过核函数实现的。

核函数能够计算两个数据点在高维空间中的内积,从而避免了显式地进行高维空间的计算。

常用的核函数有线性核、多项式核和高斯核等。

SVM的训练过程可以简化为一个凸优化问题。

通过最小化结构风险函数,SVM能够找到一个最优的超平面,使得分类误差最小化。

结构风险函数由经验风险项和正则化项组成。

经验风险项衡量了分类器在训练集上的错误率,正则化项则防止过拟合。

SVM的优点是具有较好的泛化性能和较强的鲁棒性。

由于最大化支持向量到超平面的距离,SVM对异常值不敏感,能够有效地处理噪声数据。

此外,SVM还可以通过引入松弛变量来处理非线性可分的问题。

然而,SVM也存在一些限制。

首先,SVM对于大规模数据集的训练时间较长,且对内存消耗较大。

其次,选择合适的核函数和参数是一个挑战性的问题,不同的核函数和参数可能会导致不同的分类结果。

基于k均值聚类的直推式支持向量机学习算法

p o t r v e c t o r ma c h i n e a l g o r i t h m. T h e a l g o r i t h m u t i l i z e s k me a n s c l u s t e r i n g t o d i v i d e t h e u n l a b e l e d s a mp l e s i n t o s e v e r a l c l u s t e r s ,

摘 要: 针对 直推 式支持 向量机 ( T S V M) 学 习模型 求解 难度 大的 问题 , 提 出 了一种 基 于 k 均值 聚类 的直推 式 支持 向量机 学 习算 法 —— T s v MK Mc 。该算 法 利用 k 均值 聚 类算 法 , 将 无标 签样 本 分为 若干簇 , 对每 一簇 样 本赋 予相 同的类 别标签 , 将 无标签样 本和有 标签样 本合 并进 行直推 式 学 习。 由于 T S V MK MC算 法有 效地 降低 了状 态 空间的规模 , 因此运 行速度 较传

e x p e r i me n t a l r e s u l t s s h o w t h a t t h e a l g o r i t h m c a n a c h i e v e g o o d c l a s s i f i c a t i o n a c c u r a c y wi t h f a s t e r s p e e d .

支持向量机算法原理

支持向量机算法原理支持向量机(SupportVectorMachine,SVM)是一种经典的机器学习算法,是指对二类分类问题,它可以确定一个最佳的线性决策边界,以最大限度地提高分类的准确率。

它将分类任务转换为一个凸二次规划问题,然后使用核函数扩展到非线性情况。

它被广泛应用于许多类型的学习任务,包括分类和回归。

1.持向量机的概念所谓支持向量机,是指一种经典的机器学习算法,用于解决二分类问题。

该算法总是朝着最大限度地改善结果的方向迭代,并将给定的数据集呈现为一个映射,以实现最佳的分类结果。

支持向量机算法的主要思想是,在样本空间中,将数据用线性分割法分为两个独立的子空间,从而获得较高的分类准确率。

2.持向量机的数学原理支持向量机的数学基础乃在于凸优化,它是在线性可分的情况下,使分类器的准确率最大化。

支持向量机算法可以将分类问题转换为一个凸二次规划问题,以求得最优解。

在这个规划问题中,我们要求最小化一个函数,使得能够将样本以最佳方式分开,以确定决策边界。

它需要求解最优化问题中的最大间隔,故而也被称之为最大间隔分类器,把这个问题的最优解称为支持向量(Support Vector)。

3.持向量机的分类a.性可分支持向量机:是用于解决线性可分的二分类问题的支持向量机,其中只有两个分类器,我们可以使用给定的数据集来找到一个线性分类器,这样就可以将样本点映射到不同的类。

b.性不可分支持向量机:是针对线性不可分的二分类问题的支持向量机,我们可以使用核函数将线性不可分的问题扩展到高维来获得线性可分的形式,这种类型的支持向量机也是使用类似的求解方法来构建的,但是通过将线性不可分的问题扩展到高维,它可以更好地描述数据。

c.分类支持向量机:是一种多类支持向量机,它可以用于解决多个分类问题,它可以用于分类要素的多分类以及多个分类分量的情况,这是一种非常有用的技术,在主机器学习任务中得到了广泛应用。

4.持向量机的优势a.持向量机算法不仅可以实现高准确率,而且运行时间短。

一种改进的渐进直推式支持向量机分类学习算法

l o t m. p r n s t r d rr w d t s o h a dt o i l oi ag r h Ex e me t wi a a a a h w t e v i i f h s ag r m. i i h a l y t h t

支持向量机算法原理

支持向量机算法原理支持向量机算法(SupportVectorMachine,称SVM)是一种有效的机器学习算法,它可以解决分类和回归问题。

SVM是一种二类分类模型,它可以将新实例分配到两类中,正负类,或多类分类问题中的其他类别。

在数据分析中,SVM算法不仅可以解决分类问题,而且还可以解决回归问题。

SVM算法的基本原理是通过搜索最大化类间距,保证训练数据之间最大可分离性,进而找到最优超平面,完成分类任务。

SVM算法可以用来定义和解决各种回归和分类问题。

它的核心思想是通过计算支持向量和超平面来将训练数据划分成多个类别。

支持向量机算法可以通过以下步骤完成:1.首先,根据训练集的特征向量数据,SVM算法建立一个最优超平面的模型,该模型可以将训练数据分割成正类和负类;2.其次,确定最优超平面的距离函数及其支持向量;3.最后,根据支持向量来求解实例的分类结果,实现分类支持向量机算法的核心思想是找到使得类间距最大的超平面,从而使用最大空隙分割实例类。

为此,SVM会找到一个最优超平面,用于从训练数据中区分不同类别的实例,空隙就是超平面距离分类边界最远的两个样本点之间的距离,它反映了两个类别之间的分离程度,距离越大,分类器的泛化能力就越强。

SVM是一种有效的机器学习算法,它可以根据训练样本的特征来分析出相关的超平面,并将输入数据自动分类到相应的类别中,从而实现了分类任务。

SVM算法最大的优势之一是可以处理非线性可分问题,即数据不是简单的线性可分,而是非线性边界,而且也支持多分类。

它在特征空间中有一个可解释的模型,可以帮助理解分类的过程,它的运算速度快,且不需要太多的参数调整,一般地,一次训练就可以获得优良的模型,它也具有稳定性好,容忍噪声,可处理大量维度的特征,并且具有良好的性能。

另外,SVM存在一些不足之处,首先,SVM模型没有显式地输出类间概率,从而无法衡量样本属于某类别的概率。

其次,SVM是基于凸且仅支持二类分类,而不能解决多类分类问题。

一种基于支持向量机回归的推荐算法

一种基于支持向量机回归的推荐算法

支持向量机回归(SVR)是一种支持向量机(SVMs)的变种,它被广泛用于回归问题。

它在给定数据集上构建一个非线性函数。

SVR可以被用于解决推荐系统中的多变量回归问题,在预测推荐结果的准确性以及控制过拟合现象方面具有优势。

支持向量机回归被用于解决推荐系统中的多变量回归问题。

此类问题可以被定义为预

测给定的输入特征(如用户属性和行为)关联的输出变量(如用户对商品的兴趣程度)的

过程。

SVMs算法通过映射用户共性和特殊特征,以及用户-商品关系匹配,构建预测函数

来实现推荐。

齐普可瑞(QPR)算法被广泛用于支持向量机回归推荐系统的计算过程。

QPR算法将推荐问题转换为一个非线性优化问题,该优化问题基于给定的模型参数寻求最佳解决方案。

当数据集中含有连续特征时,此方法采取基于支持向量机回归的凸优化算法来拟合误差曲面,从而求得测试数据集的准确率(yhat)。

通常情况下,QPR算法会在参数优化过程中使用梯度提升算法(GBDT),有效地优化

支持向量机回归模型,其特点在于大量参数和较高的运行效率以及计算的非线性性质。

此外,支持向量机回归可以很容易地实现模型的并行计算,从而实现推荐系统的快速推荐。

总的来说,支持向量机回归可以有效地提升推荐系统的性能,能够有效构建多变量回

归模型,实现准确的推荐,并避免出现过拟合现象,有助于提高推荐质量和快速推荐。

支持向量机算法在电商行为分析中的应用案例分析

支持向量机算法在电商行为分析中的应用案例分析随着互联网的普及和电商行业的快速发展,电商平台上的用户行为数据量急剧增加。

如何从这些庞大的数据中挖掘出有价值的信息,成为电商企业面临的重要问题。

支持向量机(Support Vector Machine,SVM)作为一种有效的机器学习算法,被广泛应用于电商行为分析中。

SVM是一种监督学习算法,其主要用于分类和回归分析。

在电商行为分析中,SVM可以通过对用户行为数据进行分类,帮助企业了解用户的购买偏好、行为习惯等信息,从而优化商品推荐、个性化营销等策略。

以某电商平台为例,我们可以利用SVM算法对用户进行分类,从而实现个性化推荐。

首先,我们收集用户的购买记录、浏览记录、搜索记录等数据,作为训练集。

然后,我们将这些数据转化为特征向量,如用户的年龄、性别、地理位置等信息,以及用户在平台上的行为数据,如购买次数、浏览时间等。

接下来,我们使用SVM算法对这些特征向量进行训练,建立分类模型。

最后,我们可以利用该模型对新用户进行分类,从而为其推荐最符合其购买偏好的商品。

在电商行为分析中,SVM还可以用于识别用户的购买意向。

通过分析用户在平台上的行为数据,如浏览时间、点击次数等,我们可以建立一个购买意向的预测模型。

利用SVM算法,我们可以对用户进行分类,将其划分为购买意向较高和较低的两类。

对于购买意向较高的用户,我们可以加大对其的营销力度,提供更多的优惠活动和推荐商品,从而促使其完成购买行为。

此外,SVM还可以用于欺诈检测。

在电商平台上,存在一些恶意用户通过虚假交易、盗用他人账号等手段进行欺诈行为。

利用SVM算法,我们可以对用户的行为数据进行分析,建立一个欺诈检测模型。

通过对用户的购买记录、登录时间、交易金额等信息进行综合分析,我们可以将用户划分为正常用户和可疑用户两类。

对于可疑用户,我们可以采取相应的措施,如增加验证步骤、限制交易金额等,以防止欺诈行为的发生。

总之,支持向量机算法在电商行为分析中具有广泛的应用前景。

支持向量机(SVM)算法推导及其分类的算法实现

支持向量机算法推导及其分类的算法实现摘要:本文从线性分类问题开始逐步的叙述支持向量机思想的形成,并提供相应的推导过程。

简述核函数的概念,以及kernel在SVM算法中的核心地位。

介绍松弛变量引入的SVM算法原因,提出软间隔线性分类法。

概括SVM分别在一对一和一对多分类问题中应用。

基于SVM在一对多问题中的不足,提出SVM 的改进版本DAG SVM。

Abstract:This article begins with a linear classification problem, Gradually discuss formation of SVM, and their derivation. Description the concept of kernel function, and the core position in SVM algorithm. Describes the reasons for the introduction of slack variables, and propose soft-margin linear classification. Summary the application of SVM in one-to-one and one-to-many linear classification. Based on SVM shortage in one-to-many problems, an improved version which called DAG SVM was put forward.关键字:SVM、线性分类、核函数、松弛变量、DAG SVM1. SVM的简介支持向量机(Support Vector Machine)是Cortes和Vapnik于1995年首先提出的,它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中。

一种基于支持向量机回归的推荐算法

一种基于支持向量机回归的推荐算法近几年来,随着信息技术的发展,个性化的推荐系统已经越来越受到重视。

个性化推荐系统的目的是根据用户的历史行为和兴趣来给出个性化的推荐内容。

支持向量机(SVM)是机器学习中的一种十分有效的技术,它可以有效地利用训练数据集来分类或回归,从而确定一个有效的模型。

因此,基于支持向量机回归(SVR)的推荐系统应运而生。

它是一种在信息技术领域普遍采用的推荐系统,用于智能资源推荐。

SVR可以在给定的训练数据集上建立一个有效的回归模型,从而帮助用户实现个性化的推荐功能。

在推荐系统中,SVR模型可以用来预测用户对给定物品的兴趣度。

SVR模型采用一种最优化策略,使用一种启发式算法,来求解该最优化策略。

SVR模型可以得到一个有效的推荐系统,来有效地处理用户非常多的历史行为和兴趣点,实现准确的个性化推荐。

此外,SVR模型还可以找出用户之间的相似性,以便给用户推荐更加适合他的资源,并且可以更快地进行推荐。

SVR模型的参数可以调整以提高推荐的准确度。

例如,可以调整参数,使推荐的准确度更高、更快的获得推荐结果。

此外,研究人员还提出了一种基于SVR模型的半监督式推荐系统,它可以同时处理有标注和无标注数据,并且进行更有效的个性化推荐。

总之,基于SVR回归模型的推荐系统是一种非常有效的个性化推荐机制,它可以有效地处理用户数据,提供准确的个性化推荐内容。

同时,也可以优化推荐的准确度和推荐的速度,以满足用户的个性化需求。

同时,半监督式推荐系统可以使推荐系统更加灵活,从而提高个性化推荐的准确度。

因此,基于支持向量机回归的推荐系统具有广泛应用前景。

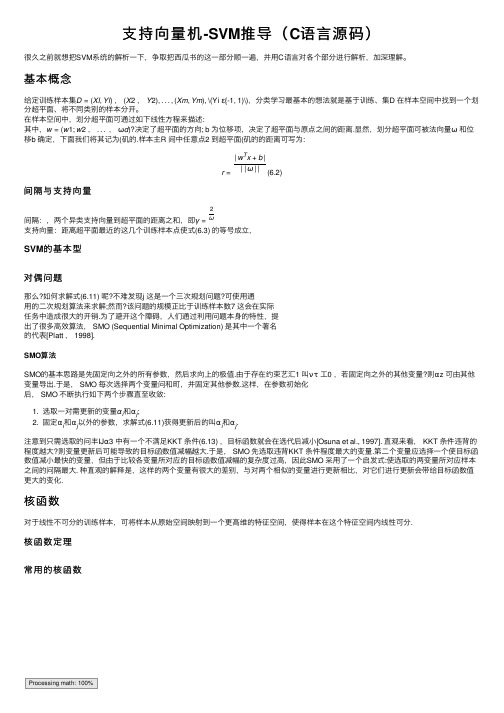

支持向量机-SVM推导(C语言源码)

⽀持向量机-SVM推导(C语⾔源码)很久之前就想把SVM系统的解析⼀下,争取把西⽠书的这⼀部分顺⼀遍,并⽤C语⾔对各个部分进⾏解析,加深理解。

基本概念给定训练样本集D=(Xl,Yl),(X2,Y2),...,(Xm,Ym), \(Yi ε{-1, 1)\),分类学习最基本的想法就是基于训练、集D 在样本空间中找到⼀个划分超平⾯、将不同类别的样本分开。

在样本空间中,划分超平⾯可通过如下线性⽅程来描述:其中,w=(w1;w2,...,ωd)?决定了超平⾯的⽅向; b 为位移项,决定了超平⾯与原点之间的距离.显然,划分超平⾯可被法向量ω和位移b 确定,下⾯我们将其记为(矶的.样本主R 间中任意点2 到超平⾯(矶的的距离可写为:r=|w T x+b|||ω||(6.2)间隔与⽀持向量间隔:,两个异类⽀持向量到超平⾯的距离之和,即γ=2ω⽀持向量:距离超平⾯最近的这⼏个训练样本点使式(6.3) 的等号成⽴,SVM的基本型对偶问题那么?如何求解式(6.11) 呢?不难发现j 这是⼀个三次规划问题?可使⽤通⽤的⼆次规划算法来求解;然⽽?该问题的规模正⽐于训练样本数7 这会在实际任务中造成很⼤的开销.为了避开这个障碍,⼈们通过利⽤问题本⾝的特性,提出了很多⾼效算法, SMO (Sequential Minimal Optimization) 是其中⼀个著名的代表[Platt , 1998].SMO算法SMO的基本思路是先固定向之外的所有参数,然后求向上的极值.由于存在约束艺汇1 叫ντ⼯0 ,若固定向之外的其他变量?则αz 可由其他变量导出.于是, SMO 每次选择两个变量问和町,并固定其他参数.这样,在参数初始化后, SMO 不断执⾏如下两个步骤直⾄收敛:1. 选取⼀对需更新的变量αi和αj;2. 固定αi和αj以外的参数,求解式(6.11)获得更新后的叫αi和αj.注意到只需选取的问丰IJα3 中有⼀个不满⾜KKT 条件(6.13) ,⽬标函数就会在选代后减⼩[Osuna et al., 1997]. 直观来看, KKT 条件违背的程度越⼤?则变量更新后可能导致的⽬标函数值减幅越⼤.于是, SMO 先选取违背KKT 条件程度最⼤的变量.第⼆个变量应选择⼀个使⽬标函数值减⼩最快的变量,但由于⽐较各变量所对应的⽬标函数值减幅的复杂度过⾼,因此SMO 采⽤了⼀个启发式:使选取的两变量所对应样本之间的问隔最⼤. 种直观的解释是,这样的两个变量有很⼤的差别,与对两个相似的变量进⾏更新相⽐,对它们进⾏更新会带给⽬标函数值更⼤的变化.核函数对于线性不可分的训练样本,可将样本从原始空间映射到⼀个更⾼维的特征空间,使得样本在这个特征空间内线性可分.核函数定理常⽤的核函数Processing math: 100%。

协同标注的直推式支持向量机算法

协同标注的直推式支持向量机算法协同标注是自然语言处理中一种常见的学习算法,其目的是在自然文本中进行标记和分类。

直推式支持向量机算法(Transductive Support Vector Machines, TSVM)是一种解决协同标注问题的机器学习算法,也是最近提出的一种改进的支持向量机算法。

在这篇文章中,我们将介绍协同标注和TSVM算法的概念,并深入讨论TSVM算法的特点和优缺点。

协同标注是一种被广泛使用的学习算法,其目的是从带有一些已知类别的文本中推测其他文本的标签。

协同标注算法通常结合了统计模型和人工标注的过程,可以通过学习人工标注的样本数据集来确定文本的分类。

在使用协同标注时,我们需要在训练数据集上使用一些手动标记的标签,以便使用现有算法来推断未标记的文本的类别。

直推式支持向量机算法是一种改进版的支持向量机算法,并对传统支持向量机算法进行了优化。

TSVM算法假定在已知类别的训练样本集和未知类别的文本集合之间存在某种特殊联系,即有一些未知文本可以与已知类别的训练样本建立关系。

因此,TSVM算法会将未标记的文本作为训练数据的一部分,与手动标记的数据一起使用来训练模型。

具体来说,TSVM算法将未标记的文本分别分配到不同的类别中,并通过不断调整分类器的权重,减少训练误差和测试误差之间的差距。

在这一过程中,TSVM算法会寻求一个最优的权重参数,从而实现对未标记文本的正确分类。

TSVM算法主要的优点是可以最大化使用所有的信息资源,从而提高模型的性能。

然而,其缺点是算法的计算复杂度较高。

具体来说,由于TSVM算法需要在未标记的文本中寻找最佳的分类边界,因此该算法的运行时间较长,且需要大量的计算资源。

为解决这一问题,可以通过预先设置一个阈值来忽略低置信度的预测,从而减少算法的计算时间。

此外,还可以通过深度学习等先进技术来加快计算速度。

综上所述,协同标注和TSVM算法是自然语言处理中常见的两种学习算法。

支持向量机算法在推荐系统优化中的应用案例分析

支持向量机算法在推荐系统优化中的应用案例分析随着互联网的快速发展,推荐系统在电商、社交媒体等领域中扮演着重要角色。

推荐系统的目标是根据用户的历史行为和偏好,为用户提供个性化的推荐内容。

然而,由于用户的行为和偏好具有复杂性和多样性,传统的推荐算法往往难以满足用户的需求。

在这种背景下,支持向量机(Support Vector Machine, SVM)算法的应用逐渐受到了关注。

支持向量机是一种监督学习算法,其主要思想是通过在特征空间中构建一个最优超平面,将不同类别的样本分开。

在推荐系统中,支持向量机可以被用来解决两个核心问题:用户兴趣建模和推荐结果排序。

首先,支持向量机可以用于用户兴趣建模。

推荐系统需要对用户的兴趣进行建模,以便准确地预测用户的偏好。

传统的方法通常使用基于用户的协同过滤或基于物品的协同过滤算法,这些方法往往依赖于用户之间的相似性或物品之间的相似性。

然而,这种方法在面对稀疏性和冷启动问题时表现不佳。

相比之下,支持向量机可以通过构建一个最优超平面,将不同类别的样本分开,从而更好地捕捉用户的兴趣。

例如,在一个电商推荐系统中,支持向量机可以通过用户的历史购买记录和浏览行为,建立一个分类模型,将用户分为“喜欢”和“不喜欢”两类,从而更好地理解用户的购买偏好。

其次,支持向量机可以用于推荐结果排序。

在推荐系统中,除了预测用户的兴趣外,还需要将推荐结果进行排序,以便将最相关的推荐内容展示给用户。

传统的方法通常使用基于内容的推荐或协同过滤算法,这些方法往往只考虑了用户和物品之间的相似性,而忽视了其他因素的影响。

相比之下,支持向量机可以将多个特征考虑在内,通过构建一个最优超平面,将不同类别的样本分开,从而更好地对推荐结果进行排序。

例如,在一个社交媒体推荐系统中,支持向量机可以考虑用户的社交关系、兴趣标签、历史点击行为等多个因素,构建一个排序模型,将最相关的内容推荐给用户。

然而,支持向量机算法在推荐系统中的应用也面临一些挑战。

如何使用支持向量机进行推荐算法优化

如何使用支持向量机进行推荐算法优化推荐算法是当今互联网时代中的一项重要技术,它能够根据用户的历史行为和兴趣,为用户提供个性化的推荐内容。

其中,支持向量机(Support Vector Machine,SVM)作为一种经典的机器学习算法,能够有效地处理分类和回归问题。

本文将探讨如何使用支持向量机来优化推荐算法,并提出一种基于SVM的推荐算法优化方法。

一、推荐算法概述推荐算法是通过分析用户的历史行为和偏好,预测用户的兴趣,并为用户提供个性化的推荐内容。

常见的推荐算法包括协同过滤、基于内容的推荐和深度学习等。

然而,这些算法在处理大规模数据和复杂场景时,往往面临着效率和准确性的问题。

二、支持向量机介绍支持向量机是一种二分类模型,其基本思想是通过找到一个超平面,将不同类别的样本分开。

SVM的核心是寻找最优的超平面,使得离超平面最近的样本点到超平面的距离最大化。

这个最优超平面被称为最大间隔超平面。

三、基于SVM的推荐算法优化方法在传统的推荐算法中,往往使用用户的历史行为和兴趣来进行推荐。

然而,这种方法往往忽略了用户的个性化需求和多样性。

基于SVM的推荐算法优化方法可以解决这个问题。

1. 数据预处理首先,需要对用户的历史行为数据进行预处理。

这包括数据清洗、特征提取和特征选择等步骤。

数据清洗是指去除异常值和重复数据,保证数据的准确性和完整性。

特征提取是指从原始数据中提取出能够反映用户兴趣的特征。

特征选择是指选择对用户兴趣影响较大的特征。

2. 构建用户兴趣模型在基于SVM的推荐算法中,需要构建用户的兴趣模型。

兴趣模型是指通过用户的历史行为和兴趣,对用户的兴趣进行建模。

可以使用SVM算法来训练用户的兴趣模型,从而得到用户的兴趣向量。

3. 推荐内容生成在基于SVM的推荐算法中,可以使用用户的兴趣模型来生成推荐内容。

具体方法是,将用户的兴趣向量与候选内容的特征向量进行比较,计算它们之间的相似度。

然后,根据相似度的大小,为用户推荐与其兴趣最匹配的内容。

基于支持向量机的渐进直推式分类学习

基于支持向量机的渐进直推式分类学习陈毅松,汪国平,董士海北京大学计算机系人机交互与多媒体实验室,100871摘要:支持向量机(Support Vector Machine)是近年来在统计学习理论的基础上发展起来的一种新的模式识别方法,在解决小样本、非线性及高维模式识别问题中表现出许多特有的优势。

直推式学习(transductive inference)试图根据已知样本对特定的未知样本建立一套进行识别的方法和准则。

较传统的归纳式学习方法而言,直推式学习往往更具普遍性和实际意义。

本文提出了一种基于支持向量机的渐进直推式分类学习算法,在少量有标签样本和大量无标签样本所构成的混合样本训练集上取得了良好的学习效果。

关键词:支持向量机,直推式学习。

1 引言基于结构化风险最小化方法的统计学习理论是一种专门的小样本统计理论,它为研究有限样本情况下的统计模式识别,并为更广泛的机器学习问题建立了一个较好的理论框架,同时也发展了一种新的模式识别方法-支持向量机(Support Vector Machine,简称SVM)[1][2][3]。

统计学习理论和支持向量机方法能够对有限样本情况下模式识别中的一些根本性问题进行了系统的理论研究,并且在此基础上建立了一种较好的通用算法。

以往困扰很多机器学习方法的问题,比如模型选择与过学习问题、非线性和维数灾难问题、局部极小问题等,在这里都得到了很多程度上的解决。

因此,统计学习理论和支持向量机是机器学习领域的一个重要分支,已经得到了日益广泛的重视。

虽然统计学习理论有比较坚实的理论基础和严格的理论分析,但是其中从理论到应用都还有很多尚未得到充分研究和解决的问题。

例如,目前该领域的相关研究大多是试图设计某种分类器,使其对未来所有可能样本的预期性能最优,而在很多实际问题中,没有可能也没有必要用这样一个分类器对所有可能的样本进行识别,而往往只需要对一些特定的样本进行识别,于是可以考虑设计这样一种更为经济的分类器,用它来建立一种直接从已知样本出发对特定的未知样本进行识别和分类的方法和原则。

基于Tri-training直推式支持向量机算法

基于Tri-training直推式支持向量机算法杜红乐;张燕【期刊名称】《河南科学》【年(卷),期】2017(035)007【摘要】For the problem of the error accumulation and slowly obtaining the space information from unlabeled samples,combined with Tri-training algorithm,KKT condition and rich information strategy,transductive support vector machine algorithm is proposed based on Tri-training.This algorithm selects the labeled samples with KKT condition,selects the classifiers with rich information strategy and marks the unlabeled samples with voting results.This algorithm can improve the training speed and classification accuracy.Finally,the experimental results show that the proposed algorithm can improve the classification accuracy and the training speed.%针对直推式支持向量机错误累积及获取无标记样本空间信息慢的问题,结合Tri-training算法、KKT条件及富信息策略提出一种基于Tri-training 的直推式支持向量机算法,用KKT条件选择标注样本,用富信息策略选择加入的分类器,利用多个分类器的投票结果进行标注,提高样本标注的准确度,利用多个分类器进行协同训练提高算法的训练速度.最后实验结果表明,算法能够提高最终分类器的分类精度和算法的训练速度.【总页数】5页(P1032-1036)【作者】杜红乐;张燕【作者单位】商洛学院数学与计算机应用学院,陕西商洛726000;商洛学院数学与计算机应用学院,陕西商洛726000【正文语种】中文【中图分类】TP301.6【相关文献】1.基于k均值聚类的直推式支持向量机学习算法 [J], 王立梅;李金凤;岳琪2.基于改进k-近邻的直推式支持向量机学习算法 [J], 李煜;冯翱;邹书蓉3.基于增量学习的直推式支持向量机算法 [J], 肖建鹏;张来顺;任星4.基于人工鱼群优化的直推式支持向量机分类算法 [J], 齐芳;冯昕;徐其江5.基于可信度的渐进直推式支持向量机算法 [J], 薛贞霞;刘三阳;刘万里因版权原因,仅展示原文概要,查看原文内容请购买。

支持向量机在推荐算法中的应用

支持向量机在推荐算法中的应用支持向量机(Support Vector Machine,简称SVM)是一种常用的机器学习算法,其在推荐系统中的应用正逐渐受到关注。

推荐系统是一种通过分析用户行为和个人偏好,为用户提供个性化推荐的技术。

在推荐算法中,SVM可以用于解决两个重要的问题:用户兴趣建模和推荐结果排序。

在传统的推荐系统中,用户兴趣建模是一个关键的环节。

通过分析用户的历史行为数据,可以将用户的兴趣建模为一个多维特征向量。

这些特征向量可以包括用户的年龄、性别、地理位置、购买记录等信息。

然而,由于用户的兴趣是多样化和动态变化的,传统的推荐算法往往无法准确地捕捉到用户的兴趣特征。

而SVM可以通过构建一个高维的特征空间,并通过寻找一个最优的超平面来对用户的兴趣进行建模。

这样,SVM可以更好地捕捉到用户的兴趣特征,提高推荐系统的准确性和个性化程度。

除了用户兴趣建模,推荐结果排序也是推荐系统中的一个重要问题。

在传统的推荐算法中,推荐结果的排序往往是根据用户的历史行为数据和物品的属性进行计算。

然而,这种方法往往无法考虑到用户的个性化需求和偏好。

而SVM可以通过学习用户的喜好模型,将用户的个性化需求和偏好纳入到推荐结果的排序中。

通过构建一个分类模型,SVM可以根据用户的特征向量和物品的属性,预测用户对物品的喜好程度。

这样,推荐系统可以将用户最感兴趣的物品排在前面,提高用户的满意度和点击率。

然而,SVM在推荐系统中的应用也存在一些挑战和限制。

首先,SVM需要大量的训练数据来构建用户的兴趣模型和推荐结果的排序模型。

在实际应用中,获取大规模的训练数据往往是一个困难和耗时的过程。

其次,SVM的计算复杂度较高,特别是在处理大规模数据集时。

这就需要使用一些高效的算法和技术来加速SVM的训练和推断过程。

此外,SVM在处理稀疏数据和噪声数据时也存在一定的问题,需要一些特殊的处理方法来提高算法的稳定性和鲁棒性。

尽管存在一些挑战和限制,SVM在推荐系统中的应用仍然具有广阔的前景。

基于支持向量机算法的智能学习推荐器的设计及实现

基于支持向量机算法的智能学习推荐器的设计及实现

孙健;申瑞民;张同珍;韩鹏;苏群

【期刊名称】《计算机工程》

【年(卷),期】2002(028)011

【摘要】远程教学模式作为一种新型的教学模式,应该体现自主性学习特点.为了帮助学生尽快适应自主性学习模式,对案例中学生的学习行为进行了分析.在分析学生学习行为的基础上,提出了支持向量机算法的智能学习推荐器的方案.

【总页数】3页(P256-258)

【作者】孙健;申瑞民;张同珍;韩鹏;苏群

【作者单位】上海交通大学计算机科学与工程系,上海,200030;上海交通大学计算机科学与工程系,上海,200030;上海交通大学计算机科学与工程系,上海,200030;上海交通大学计算机科学与工程系,上海,200030;上海交通大学计算机科学与工程系,上海,200030

【正文语种】中文

【中图分类】TG434

【相关文献】

1.基于支持向量机的电子商城用户分类个性化推荐算法设计 [J], 王洁;李烈军;徐锴;唐辉军

2.基于模糊核聚类和支持向量机的鲁棒协同推荐算法 [J], 伊华伟;张付志;巢进波

3.基于支持向量机的滤波器设计与硬件实现 [J], 计前程;罗小华

4.基于支持向量机的文本分类器的实现与设计 [J], 王梦佳;林晶晶;杨文晖

5.基于多分类支持向量机的优化算法智能推荐系统与实证分析 [J], CUI Jian-shuang;CHE Meng-ran

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

收稿日期 :2006 - 02 - 28 ; 修订日期 :2006 - 06 - 21. 作者简介 : 赵英刚 (1972 - ) ,男 ,山西阳泉人 ,工学博士. 主要从事机器学习 、人工智能 、模式识别和普适计算等研

究. Email :ygz129 @163. com

442

江 南 大 学 学 报 (自 然 科 学 版) 第 5 卷

支持向量机 ( Support Vector Machine , SVM) 是目前机器学习中一个很热门的研究方向 ,它已被 实验证实是一种很有效的学习机 ,在许多领域取得

了成功的应用. 但传统的支持向量机主要是用来处 理监督型学习问题 ,而实际学习中有许多学习问题 是半监督型的 ,即给定的训练样本中一部分是预先

1 支持向量机简述

给定包含 l 个样的训练集 : ( xi , yi ) , i = 1 ,2 , …, l , 此处 xi ∈Rn ,考虑二元模式识别问题 ,即 yi ∈ { - 1 , + 1} ,支持向量机[7] 构造的分类超平面为 w ·

x + b = 0. 该问题可以转化为求解下列的原始最优 化问题 :

算法在半监督学习问题上的一种扩展 ,但已有的 TSVM 算法存在训练速度慢 、回溯式学习多 、学习

性能不稳定等缺点 ,针对这些问题提出一种改进的直推式支持向量机算法 ———I TSVM ,该算法较

准确地确定了待训练的未标识样本中的正负样本数问题 ,有效解决了传统 TSVM 中过多的回溯式

学习问题 ,同时该算法也无需利用过多的未标识训练样本 , 从而减轻了计算强度. 实验表明 ,

第20056卷年第8

4期 月

Journal

of

江 南 大 学 学 报 (自 然 科 学 版) Southern Yangtze University( Natural Science

Edition)

Vol. 5

Aug.

No . 4 2006

文章编号 :1671 - 7147 (2006) 04 - 0441 - 04

样本学习后得到的分类边界 ,实线则表示 TSVM 对

原始的已标识样本和未标识样本学习后得到的分

类边界. 图 1 中实心黑点表示未标识样本 已标识样本中的

支持向量 ,实线上的黑点则表示未标识样本中的支 持向量.

给定一组独立同分布的有标识训练样本点

( x1 , y1 ) , …, ( xl , yl ) , xi ∈ Rm , yi ∈{ - 1 , + 1} 和另一组来自同一分布的无标识训练样本点 x13 , x23 , x33 , …, xk3 .

I TSVM 相比 TSVM 在分类正确率 、分类速度以及使用的样本规模上 ,都表现出了一定的优越性.

关键词 : 支持向量机 ; 直推式学习 ; 半监督学习

中图分类号 : TP 18

文献标识码 : A

A Transductive Learning Algorithm Based on Support Vector Machine

ZHAO YingΟgang1 , C H EN Qi1 , H E QinΟming1 ,2

(1. College of Co mp uter Science , Zhejiang University , Hangzhou 310027 , China ; School of Information Science & Engineering , Ningbo Instit ute of Technology , Zhejiang U niversity , Ningbo 315100 , China)

2. 1 传统的直推式支持向量机 ———TSVM 直推式支持向量机 ( TSVM) 是标准型支持向

图 1 TSVM 和 SVM 算法最优分类边界示意图 Fig. 1 Classif ication boundary of TSVM and SVM

图 1 中的虚线表示标准 SVM 对原始的已标识

第 4 期

赵英刚等 :一种基于支持向量机的直推式学习算法

443

该训练算法大致可以分为以下几个步骤 : 步骤 1 : 指定参数 C 和 C 3 ,使用归纳式学习对 有标识样本进行一次初始学习 , 得到一个初始分类 器 ,并按照某个规则指定一个未标识样本中的正标 签样本数 N ; 步骤 2. : 用初始分类器对未标识样本进行分 类 ,根据对每一个未标识样本的判别函数输出 , 对 输出值最大的 N 个未标识样本暂时赋正标识值 , 其 余的赋负标识值. 并指定一个临时影响因子 Ct3mp ; 步骤 3 : 对所有样本重新训练 , 对新得到的分 类器 ,按一定的规则交换一对标签值不同的测试样 本的标签符号 , 使得优化问题 (4) 中的目标函数值 获得最大下降 , 这一步骤反复执行 , 直到找不出符 合交换条件的样本对为止 ; 步骤 4 : 均匀地增加临时影响因子 Ct3mp 的值并 返回到步骤 3 , 当 Ct3mp ≥ C3 时 , 算法结束 , 并输出 结果. 步骤 3 中的标识符号交换保证了交换后的解优 于交换前的解 ,而步骤 4 中的临时影响因子由小到 大逐步递增 ,则试图通过逐渐增加无标签样本对算 法的影响的办法 ,来追求尽可能小的对未标签样本 的分类误差. 由于步骤 1 中指定的 C3 是有限的 , 由 步骤 4 中的结束准则可知 , 算法能够在有限次执行 后终止并输出结果. 2. 2 改进的直推式支持向量机 上面的直推式支持向量机存在如下的缺点 :在 算法执行之前必须人为指定待训练的未标识样本 中的正标识样本数 N ,而在一般情况下 N 值很难做 出比较准确的估计 ,在 TSVM 算法中采用了一种简 单的方法 ,即根据有标识样本中的正标识样本所占 比例来相应估计无标签样本中的正标签样本比例 , 进而估计出 N 值. 不难看出 , 这一方法在有标识样 本数较少的情况下很容易导致较大的估计误差 , 一 旦事先设定的 N 值和实际上的正标识样本数相差 较大 , 就会导致学习机性能的迅速下降. 为了提高 分类准确率 , 该算法往往要进行多次回溯式的学 习 ,但这样又会造成训练时间的增加. 陈毅松[3] 等人为此提出以渐进直推式算法来 解决这一问题 , 但该算法的学习性能不太稳定 , 分 类的结果常常依赖于训练样本的分布特征 , 因而推 广性不强. 从图 1 可以看出 ,经初始分类后 ,位于初始分类 边界两侧的原始未标识样本此时实际已变为有标 识样本 , 这样在前面的步骤 2 中只需考虑位于初始 分类边界线内侧的未标识样本. 对于这些样本中正

l

∑ mi n

w , b,ξ

1 2

‖w ‖2

+

C ξi

i =1

(1)

s. t . yi ( wT xi + b) ≥1 - ξi

ξi ≥0 , i = 1 , …, l

通常可以通过求下面的对偶问题来得到 (1) 式

的解 :

l

∑ ∑ max α

αi -

i =1

1 2

ααi j y i y j K ( xi , xj )

Abstract :Transductive Suppo rt Vector Machine ( TSVM ) is an extensio n of standard SVM in semiΟsupervised learning p ro blem. However , t he existing TSVM algorit hm has so me drawbacks such as slower t raining speed , more back learning step s , and unstable learning performance , etc. This paper p resent s an imp roved t ransductive Support Vector Machine learning algorit hm ——— I TSVM , which can determine t he po sitive labeled sample number s of t he upΟt raining unlabeled samples , and alleviate t he back learning p heno meno n. Besides more unlabeled t raining samples are not needed , and where by t he calculatio n co mplexit y can be reduced. The experiment result s show t hat I TSVM is bet ter t han TSVM in speed and accuracy of classificatio n. Key words : suppo rt vector machine ; t ransductive learning ; semiΟsupervised learning

已经知道类别标号的训练实例 ,称之为已标识样 本 ;另一部分样本则不知道其类别标号 ,称之为未 标识样本. 为使支持向量机也能很好地处理半监督 型学习问题 ,一些基于直推式算法的支持向量机模 型先后被提出[1Ο5] , 但这些方法存在训练速度慢 、回 溯式学习步骤多 ,以及学习性能不稳定等缺点 ,因 而难以推广. 文中提出一种改进的直推式支持向量 机算法 ———ITSVM ,该算法借鉴了文献 [ 4 ] 中的方 法 ,使用比文献 [ 1 ,3 ,6 ] 中算法少得多的训练标识 样本 ,大大降低了计算复杂度 ,提高了训练速度 ,而 且该算法还克服了以往算法中对未标识样本中正 负样本比例容易错估的缺点 ,减少了回溯学习的可 能 ,是一种有效可行的直推式算法.

在一般的线性不可分条件下 , TSVM 的训练过

程可以描述为以下的优化问题 :