SIFT特征匹配技术

sift特征点检测算法原理

sift特征点检测算法原理SIFT特征点检测算法原理SIFT(Scale-Invariant Feature Transform)是一种用于在图像中检测和描述局部特征的算法。

它的原理是通过在不同尺度空间中寻找关键点,并计算这些关键点的局部特征描述子,从而实现图像的特征匹配和识别。

1. 尺度空间构建SIFT算法首先通过高斯金字塔构建尺度空间,以便在不同尺度下检测出特征点。

高斯金字塔是通过对原始图像进行多次降采样得到的一系列图像,每个图像都是前一层图像的二分之一。

在每一层图像上应用高斯滤波器,得到一系列平滑图像。

2. 关键点检测在构建好的尺度空间中,SIFT算法使用Difference of Gaussian (DoG)来检测关键点。

DoG是通过对相邻两层平滑图像进行相减得到的,可以有效地检测出图像中的边缘和角点。

在DoG图像中,局部极值点被认为是潜在的关键点。

3. 关键点定位为了准确定位关键点的位置,SIFT算法采用了尺度空间极值点的精确定位方法。

它使用T aylor展开式对DoG图像进行拟合,通过求解极值点的二阶导数来精确定位关键点的位置。

同时,为了排除低对比度的关键点和边缘响应的干扰,SIFT算法会对关键点进行一定的筛选。

4. 方向分配为了使特征描述子具有旋转不变性,SIFT算法对每个关键点分配一个主方向。

它通过计算关键点周围像素的梯度方向直方图,找出主要梯度方向,并将其作为关键点的方向。

这样可以保证特征描述子在旋转变换下具有一定的稳定性。

5. 特征描述在关键点的周围区域内构建特征描述子,用于表示关键点的局部特征。

SIFT算法将关键点周围的图像区域划分为若干个子区域,并在每个子区域内计算梯度方向直方图。

最后将这些直方图连接起来,得到一个具有128维特征向量的特征描述子。

通过以上步骤,SIFT算法可以在图像中检测出大量的关键点,并为每个关键点生成一个128维的特征描述子。

这些特征描述子具有尺度不变性、旋转不变性和光照不变性等特点,可以用于图像匹配、物体识别和三维重建等应用领域。

基于sift特征的图像匹配算法

21 .特征点方向的确定

利用特征点邻域像素的的梯 度方 向分布特征 ,为每

一

个特征点指定方 向参数 ,使算子具有 尺度不变性 。

mx )√ + y L 一) + , 1 L , l ( = l) ( 1) ) (Y , , 一 x , , +一 x— 0x )o n OyO L , 1/ ( 1)三 一) ) 9 , = 2 , -(y )( x ,一 O 1) ( ) y t t a +  ̄ -)L + ,) ,

22 * 个种子 点 ,每个 种子 点8 方 向 ,共可生 产3 个数 个 2

二 、算 法 实现 和 实验 结果

实验算法采用V 2 0 开发 。结果如下 : C 08 第一 组实 验 ,上 图是 由下 图放大 而来 ,且 ±

光 照 强 度 。两 幅 图 中

的箭 头 方 向代 表 了该 像 素 点 的梯 度 方 向 ,

LxYo =G xY ) (,) ( ) (,, ) (, ,o Ix 2

SF 特征匹配算法是Dai L we 0 4 IT vdG.o 在2 0 年总结了

现有 的基于不变量特征检测技术的基 础上 ,提出的一种

基于尺度空 间的,对 图像缩放 、旋转甚至仿 射变换保持

不 变性 的 图像 局部特 征描述算 法 。SF 特征是 图像 局 IT

骤 :1 特征点 的检测 ;2特 征 向量 的生成 ;3特 征 向 . 是 . .

量的匹配。

尺度对应 于图像 的概貌特征 ,小尺度对应于图像 的细节

特征 。选择 合适 的尺度 因子平 滑是建 立 尺度空 间 的关 键 。在这里 ,主要是建立高斯金字塔和D G( i ee c O D f rn e

1 . .

sfit特征提取和匹配的具体步骤

sfit特征提取和匹配的具体步骤

SIFT(尺度不变特征变换)是一种用于图像处理和计算机视觉的特征提取和匹配算法。

它能够在不同尺度和旋转下提取出稳定的特征点,并且对光照变化和噪声有一定的鲁棒性。

SIFT特征提取的具体步骤包括:

1. 尺度空间极值检测,在不同尺度下使用高斯差分函数来检测图像中的极值点,用来确定关键点的位置和尺度。

2. 关键点定位,通过对尺度空间的极值点进行精确定位,使用Hessian矩阵来确定关键点的位置和尺度。

3. 方向分配,对关键点周围的梯度方向进行统计,确定关键点的主方向,使得特征具有旋转不变性。

4. 关键点描述,以关键点为中心,划分周围的区域为小区块,计算每个区块内的梯度方向直方图,构建特征向量。

SIFT特征匹配的具体步骤包括:

1. 特征点匹配,使用特征向量的距离来进行特征点的匹配,通常使用欧氏距离或者近邻算法进行匹配。

2. 鲁棒性检验,对匹配点进行鲁棒性检验,例如RANSAC算法可以剔除错误匹配点,提高匹配的准确性。

3. 匹配结果筛选,根据匹配点的特征向量距离或一致性进行筛选,得到最终的匹配结果。

总的来说,SIFT特征提取和匹配的具体步骤包括特征点检测、定位、描述以及匹配过程。

这些步骤能够帮助我们在图像处理和计算机视觉中提取出稳定的特征并进行准确的匹配,从而实现目标识别、图像配准等应用。

基于SIFT特征匹配的图像扭曲纠正方法研究

基于SIFT特征匹配的图像扭曲纠正方法研究随着数字图像处理技术的发展,对于图像质量、准确性的要求越来越高。

然而,在现实应用中,由于各种因素影响,例如摄像机视角、拍摄距离等,图像出现扭曲、变形等问题已经成为常见问题。

为了解决这一难题,目前普遍应用的图像扭曲纠正方法是基于SIFT特征匹配的。

SIFT(Scale-Invariant Feature Transform)技术是基于尺度空间理论的一种特征提取算法,该算法可以提取不受旋转、尺度、光照等影响的图像特征点。

因此,SIFT在图像匹配及图像拼接等领域有着广泛的应用。

在图像扭曲纠正领域,SIFT特征匹配可以实现对于两张图像的相似度计算,为后续图像变换提供基础。

首先,对于匹配图像的特征点进行提取,得到两张图像中的特征点集合。

然后,对于这两个特征点集合进行SIFT特征匹配。

通过对于两张图像之间的SIFT特征点进行匹配,可以实现对于两张图像的相似度计算。

在特征点匹配过程中,需要根据对应特征点的距离计算两张图像之间的相似度。

通常,根据距离阈值筛选出匹配度较高的特征点对。

接下来,对于得到的特征点对进行RANSAC(Random Sample Consensus)算法,从而可以得到最优的变换矩阵,进而将扭曲图像进行纠正。

RANSAC算法是一种鲁棒性较高的随机采样算法,可以从一系列观测值中筛选出最佳的模型参数。

在图像扭曲纠正中,RANSAC可以得到对于图像的最优旋转、平移等变换矩阵,从而实现对于图像扭曲的纠正。

最后,通过建立变换矩阵,将扭曲图像进行纠正。

在图像纠正的过程中,需要根据变换矩阵对于原始图像进行变换,实现从扭曲图像到纠正图像的转换。

通常,变换矩阵的计算及变换过程可以利用OpenCV等图像处理工具实现。

在变换的过程中,需要注意变换后图像的边界问题,通过拓展边界或裁剪图像等方式进行处理。

综上,基于SIFT特征匹配的图像扭曲纠正方法在实现图像扭曲纠正中具有重要意义。

SIFT特征点提取与匹配算法

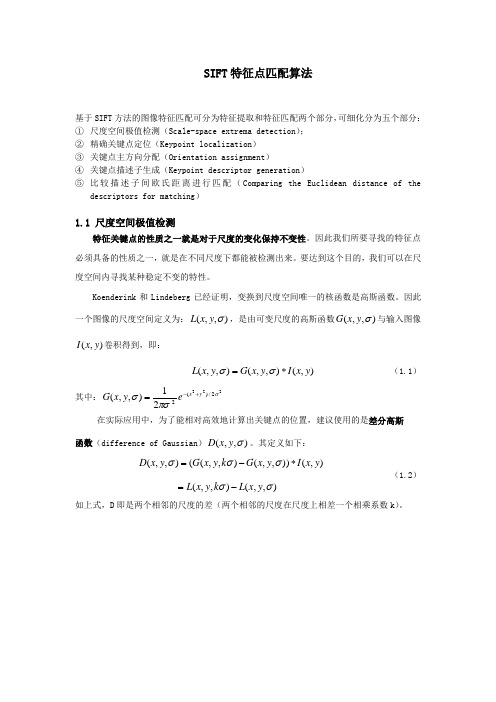

SIFT 特征点匹配算法基于SIFT 方法的图像特征匹配可分为特征提取和特征匹配两个部分,可细化分为五个部分: ① 尺度空间极值检测(Scale-space extrema detection );② 精确关键点定位(Keypoint localization )③ 关键点主方向分配(Orientation assignment )④ 关键点描述子生成(Keypoint descriptor generation )⑤ 比较描述子间欧氏距离进行匹配(Comparing the Euclidean distance of the descriptors for matching )1.1 尺度空间极值检测特征关键点的性质之一就是对于尺度的变化保持不变性。

因此我们所要寻找的特征点必须具备的性质之一,就是在不同尺度下都能被检测出来。

要达到这个目的,我们可以在尺度空间内寻找某种稳定不变的特性。

Koenderink 和Lindeberg 已经证明,变换到尺度空间唯一的核函数是高斯函数。

因此一个图像的尺度空间定义为:(,,)L x y σ,是由可变尺度的高斯函数(,,)G x y σ与输入图像(,)I x y 卷积得到,即:),(),,(),,(y x I y x G y x L *=σσ (1.1) 其中:2222/)(221),,(σπσσy x e y x G +-=在实际应用中,为了能相对高效地计算出关键点的位置,建议使用的是差分高斯函数(difference of Gaussian )(,,)D x y σ。

其定义如下:),,(),,(),()),,(),,((),,(σσσσσy x L k y x L y x I y x G k y x G y x D -=*-= (1.2)如上式,D 即是两个相邻的尺度的差(两个相邻的尺度在尺度上相差一个相乘系数k )。

图 1.1图1.1所展示的是建立DOG 的一种实用的方法。

又快又准的特征匹配方法

又快又准的特征匹配方法又快又准的特征匹配方法是计算机视觉领域中非常重要的一个问题。

特征匹配是指在两个或多个图像中找到具有相似性的特征点,并建立它们之间的对应关系。

特征匹配在很多应用中都有广泛的应用,如图像配准、目标检测和跟踪等。

在过去的几十年中,研究人员提出了许多特征匹配方法,其中一些方法即使在处理大规模数据集时也能提供很高的匹配准确性和效率。

下面将介绍几种又快又准的特征匹配方法。

1.SIFT(尺度不变特征变换)SIFT是一种非常经典的特征匹配算法,在很多应用中都被广泛使用。

它通过将图像中的特征点转换成尺度、旋转和亮度不变的向量,然后使用特征向量之间的欧氏距离来进行匹配。

SIFT算法具有很高的匹配准确性和鲁棒性,但在处理大规模数据集时会存在时间和空间复杂度较高的问题。

2.SURF(加速稳健特征)SURF是一种基于SIFT的改进算法,能够在保持较高匹配准确性的同时提高匹配的速度。

SURF算法用Hessian矩阵来检测特征点,并通过使用积分图像来加速特征描述子的计算。

这种基于加速稳健特征的特征匹配方法比SIFT更快、更鲁棒,适用于处理大规模数据集。

3.ORB(方向倒角二值描述子)ORB是一种在效率和准确性之间取得平衡的特征匹配算法。

它结合了FAST关键点检测器和BRIEF特征描述子,使用方向倒角二进制描述子来表示特征点,从而使得匹配速度更快。

ORB算法在实践中表现良好,尤其适用于移动设备上的实时应用。

4.BRISK(加速鲁棒特征)BRISK是一种能够提供快速、鲁棒特征匹配的算法。

它通过快速角点检测器来检测特征点,并使用二进制描述子来进行特征匹配。

BRISK算法具有较低的计算复杂度和内存消耗,并且能够在保持较高的匹配准确性的同时提供很高的速度。

TCH(局部联合二进制特征)LATCH是一种基于二进制特征匹配的算法,具有很高的匹配速度和鲁棒性。

LATCH算法通过使用快速特征检测器和局部联合二进制描述子来检测和匹配图像中的特征点。

SIFT特征匹配技术讲义

SIFT特征匹配技术讲义1导言:SIFT特征匹配算法是目前国内外特征点匹配研究领域的热点与难点,其匹配能力较强,可以处理两幅图像之间发生平移、旋转、仿射变换情况下的匹配问题,甚至在某种程度上对任意角度拍摄的图像也具备较为稳定的特征匹配能力。

该算法目前外文资料较多,但中文方面的介绍较少。

为此我撰写了这篇文档,以帮助国内的研究学者尽快入门,以最快的速度去体验SIFT算法的魅力!作者:山东大学信息科学与工程学院赵辉bugzhao@ / 5.1 宽基线特征匹配概述宽基线条件下点特征匹配的首要任务就是提取稳定的特征,并进行描述。

这里稳定一词的含义指的是希望该特征能对旋转、尺度缩放、仿射变换、视角变化、光照变化等图像变化因素保持一定的不变性,而对物体运动、遮挡、噪声等因素也保持较好的可匹配性,从而可以实现差异较大的两幅图像之间特征的匹配。

对图像变化保持稳定的特征描述符称为不变量,比如对图像的旋转保持稳定的不变量称为旋转不变量(Rotation Invariant),对尺度缩放保持稳定的不变量则称为尺度不变量(Scale Invariant)。

特征描述符(Featrue Descriptors)指的是检测图像的局部特征(比如边缘、角点、轮廓等),然后根据匹配目标的需要进行特征的组合、变换,以形成易于匹配、稳定性好的特征向量,从而把图像匹配问题转化为特征的匹配问题,进而将特征的匹配问题转化为特征空间特征向量的聚类问题[51]。

宽基线条件下的点特征匹配一般包括下面四个步骤[30]:1.)特征点检测。

这些特征点一般是灰度变化的局部极值点,含有显著的结构性信息,甚至这些点也可以没有实际的直观视觉意义,但却在某种角度、某个尺度上含有丰富的易于匹配的信息。

2.)特征点描述,即建立特征向量。

这是各匹配算法主要的不同所在。

特征空间的选择决定了图像的哪些特性参与匹配,哪些特性将被忽略。

特征点的特征描述符应是不变量,以确保最低限度的受摄像机的运动或光照变化等因素的影响。

SIFT特征匹配与检索

SIFT特征匹配与检索1.SIFT简介SIFT的英⽂全称叫Scale-invariant feature transform,也叫尺度不变特征变换算法,是由David Lowe 先提出的,也是过去⼗年中最成功的图像局部描述⼦之⼀。

SIFT 特征包括兴趣点检测器和描述⼦。

SIFT 描述⼦具有⾮常强稳健性,这在很⼤程度上也是 SIFT 特征能够成功和流⾏的主要原因。

⾃从 SIFT 特征的出现,许多其他本质上使⽤相同描述⼦的⽅法也相继出现。

现在,SIFT 描述符经常和许多不同的兴趣点检测器相结合使⽤(有些情况下是区域检测器),有时甚⾄在整幅图像上密集地使⽤。

SIFT 特征对于尺度、旋转和亮度都具有不变性,因此,它可以⽤于三维视⾓和噪声的可靠匹配。

SIFT算法的实质是:“不同的尺度空间上查找关键点(特征点),并计算出关键点的⽅向” ,SIFT所查找到的关键点是⼀些⼗分突出,不会因光照,仿射变换和噪⾳等因素⽽变化的点,如⾓点、边缘点、暗区的亮点及亮区的暗点等。

2.SIFT算法的特点:1. SIFT特征是图像的局部特征,其对旋转、尺度缩放、亮度变化保持不变性,对视⾓变化、仿射变换、噪声也保持⼀定程度的稳定性;2. 独特性(Distinctiveness)好,信息量丰富,适⽤于在海量特征数据库中进⾏快速、准确的匹配;3. 多量性,即使少数的⼏个物体也可以产⽣⼤量的SIFT特征向量;4. ⾼速性,经优化的SIFT匹配算法甚⾄可以达到实时的要求;5. 可扩展性,可以很⽅便的与其他形式的特征向量进⾏联合。

3.四步分解SIFT算法3.1Lowe将SIFT算法分解为如下四步:①尺度空间极值检测:搜索所有尺度上的图像位置。

通过⾼斯微分函数来识别潜在的对于尺度和旋转不变的兴趣点。

②关键点定位:在每个候选的位置上,通过⼀个拟合精细的模型来确定位置和尺度。

关键点的选择依据于它们的稳定程度。

③⽅向确定:基于图像局部的梯度⽅向,分配给每个关键点位置⼀个或多个⽅向。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

确定特征点主方向

利用特征点邻域像素的梯度方向分布特性为每个特 征点指定方向参数, 使算子具备旋转不变性。公式 ( 9)为( x, y)处的梯度值和方向。L 所用的尺度 为每个特征点各自所在的尺度, ( x,y)要确定是哪 一阶的哪一层。

在实际计算过程中,在以特征点为中心的邻域窗口 内采样,并用梯度方向直方图统计邻域像素的梯度 方向。梯度直方图的范围是0~360°,其中每 10°一个柱,总共36个柱。梯度方向直方图的峰 值则代表了该特征点处邻域梯度的主方向, 即作为 该特征点的方向。在梯度方向直方图中, 当存在另 一个相当于主峰值80%能量的峰值时,则将这个方 向认为是该特征点的辅方向。一个特征点可能会被 指定具有多个方向(一个主方向, 一个以上辅方向) , 这可以增强匹配的鲁棒性。通过上面的3步,图像的 特征点已检测完毕,每个特征点有3个信息:位置、 对应尺度、方向。

Relationship of D to G

2 2

Diffusion equation: G 2G

Approximate ∂G/∂σ: giving,

G G ( x, y, k ) G ( x, y, ) k G ( x, y, k ) G ( x, y, ) 2G k

c) 多量性,即使少数的几个物体也可以产生大量SIFT特征向量。

d) 高速性,经优化的SIFT匹配算法甚至可以达到实时的要求。 e) 可扩展性,可以很方便的与其他形式的特征向量进行联合。

图像多尺度表示

(x,y)代表图像的像素位置,σ称为尺度空间因子, 其值越小则表征该图像被平滑的越少,相应的尺 度也就越小。

SIFT特征匹配技术

Scale Invariant Feature Transform

SIFT 算法提出及其改进

SIFT算法由D.G.Lowe 1999年提出,2004年完善总结。 [1]David G. Lowe, "Object recognition from local scale-invariant features," International Conference on Computer Vision, Corfu, Greece (September 1999), pp.1150-1157.

精确的极值位置

公式(4)中的一阶和二阶导数是通过附近区域的 差分来近似求出的,列出其中的几个,其它的二阶 导数以此类推。通过对公式(4)求导, 并令其为 0,得出精确的极值位置, 如公式(5)所示:

去除低对比度的特征点

在上面精确确定的特征点中, 同时要去除低对比 度的特征点和不稳定的边缘响应点, 以增强匹配 稳定性、提高抗噪声能力。去除低对比度的特 征点:把公式(5)代到公式(4)中,只要前两项,得 到公式(6):

构建尺度空间

L( x, y, ) G( x, y, ) I ( x, y)

设输入图像经过s 次卷积后可以得到高斯卷积函数 为G(x,y,2σ) 的输出图像, 所有σ从到2σ的图像 构成一个octave, 每个octave 固定有s个平面。 每一层Ip= G(x,y,kpσ)*I,p=1,2,…,s.而ks=2。 根据高斯函数的性质可得:

构建尺度空间需确定的参数

σ-尺度空间坐标 O-octave坐标 S- sub-level 坐标 和O、S的关系,σ (O,S)=2o+s/S, o∈omin+[0,...,O-1],s∈ [0,...,S-1] 其中σ0是基准层尺度。o-octave坐标,s-sub-level 坐标。 注:octaves 的索引可能是负的。第一组索引常常设为0或者1,当设为-1的时候,图像在计算高斯尺度空间前先扩大一倍。 空间坐标x是组octave的函数,设是x0 组的空间坐标,则

[2] David G. Lowe, "Distinctive image features from scale-invariant keypoints," International Journal of Computer Vision, 60, 2 (2004), pp. 91-110. 后来Y.Ke将其描述子部分用PCA代替直方图的方式,对其进行改进。 [3] Y. Ke and R. Sukthankar. PCA-SIFT: A More Distinctive Representation for Local Image puter Vision and Pattern Recognition, 2004

Therefore,

G( x, y, k ) G( x, y, ) (k 1) 2 2G

When D has scales differing by a constant factor it already incorporates the σ2 scale normalization required for scale-invariance

SIFT算法主要思想

SIFT算法是一种提取局部特征的算法,在 尺度空间寻找极值点,提取位置,尺度,旋 转不变量。

SIFT算法的主要特点:

a) SIFT特征是图像的局部特征,其对旋转、尺度缩放、亮度变化保 持不变性,对视角变化、仿射变换、噪声也保持一定程度的稳定性。 b) 独特性(Distinctiveness)好,信息量丰富,适用于在海量特征 数据库中进行快速、准确的匹配。

生成SIFT特征向量

首先将坐标轴旋转为特征点的方向,以确保旋转不变性。接下来 以特征点为中心取8×8的窗口(特征点所在的行和列不取)。 在图4(a)中,中央黑点为当前特征点的位置,每个小格代表特征 点邻域所在尺度空间的一个像素,箭头方向代表该像素的梯度方 向,箭头长度代表梯度模值,图中圈内代表高斯加权的范围(越靠 近特征点的像素,梯度方向信息贡献越大) 。 然后在每4 ×4 的图像小块上计算8个方向的梯度方向直方图, 绘制每个梯度方向的累加值,形成一个种子点,如图4(b)所示。 此图中一个特征点由2 ×2共4个种子点组成,每个种子点有8 个方向向量信息,可产生2×2×8共32个数据,形成32维的 SIFT特征向量即特征点描述器,所需的图像数据块为8×8。这 种邻域方向性信息联合的思想增强了算法抗噪声的能力,同时对 于含有定位误差的特征匹配也提供了较好的容错性。

SIFT特征向量的匹配

首先,进行相似性度量。一般采用各种距离函数作 为特征的相似性度量,如欧氏距离、马氏距离等。 通过相似性度量得到图像间的潜在匹配。本文中采 用欧氏距离作为两幅图像间的相似性度量。 取图像1中的某个关键点,并找出其与图像2中欧 式距离最近的前两个关键点,在这两个关键点中, 如果最近的距离除以次近的距离少于某个比例阈值, 则接受这一对匹配点。降低这个比例阈值,SIFT 匹配点数目会减少,但更加稳定。 采用优先k-d树近似BBF 搜索算法进行优先搜索 来查找每个特征点的2个近似最近邻特征点。

生成SIFT特征向量

实际计算过程中,为了增强匹配 的稳健性,建议对每个特征点使 用4 ×4共16个种子点来描述, 每个种子点有8个方向向量信息, 这样对于一个特征点就可以产 生4×4×8共128个数据,最终 形成128维的SIFT特征向量, 所需的图像数据块为16 ×16。 此时SIFT特征向量已经去除了 尺度变化、旋转等几何变形因 素的影响,再继续将特征向量的 长度归一化,则可以进一步去除 光照变化的影响。

其次,消除错配。通过相似性度量得到潜在 匹配对,其中不可避免会产生一些错误匹配, 因此需要根据几何限制和其它附加约束消除 错误匹配,提高鲁棒性。常用的去外点方法 是RANSAC随机抽样一致性算法,常用的几 何约束是极线约束关系。

建立DOG金字塔

DOG金字塔通过高斯 金字塔中相邻尺度空 间函数相减即可,如图 2所示。在图中, DOG 金字塔的第1层的尺度

因子与高斯金字塔的 第1层是一致的,其它 阶也一样。

Image space to scale space

k4σ k3σ

k2σ

kσ σ

DOG空间的极值检测

在上面建立的DOG尺度空间金字塔中,为了 检测到DOG空间的最大值和最小值, DOG 尺度空间中中间层(最底层和最顶层除外)的 每个像素点需要跟同一层的相邻8个像素点 以及它上一层和下一层的9个相邻像素点总 共26个相邻像素点进行比较,以确保在尺度 空间和二维图像空间都检测到局部极值。标 记为叉号的像素若比相邻26个像素的DOG 值都大或都小,则该点将作为一个局部极值 点,记下它的位置和对应尺度。

SIFT算法

SIFT算法

SIFT算法步骤:

Sift特征匹配算法主要包括两个阶段,一个 是Sift特征的生成,即从多幅图像中提取对 尺度缩放、旋转、亮度变化无关的特征向量; 第二阶段是Sift特征向量的匹配。

Sift特征的生成一般包括以下几个步骤:

1、构建尺度空间,检测极值点,获得尺度 不变性; 2、特征点过滤并进行精确定位; 3、为特征点分配方向值; 4、生成特征描述子。

Local extrema detection

Find maxima and minima in scale space

精确定位特征点位置

由于DOG值对噪声和边缘较敏感,因此,在上 面DOG尺度空间中检测到局部极值点还要 经过进一步的检验才能精确定位为特征点。 下面对局部极值点进行三维二次函数拟和以 精确确定特征点的位置和尺度,尺度空间函 数D ( x, y,σ)在局部极值点处的泰勒展开式 如公式(4)所示。

通过式(6)计算出D (Xmax) , 若|D (Xmax) | ≥0. 03, 则该特征点就保留下来,否则就丢弃。

去除不稳定的边缘响应点

海森矩阵如公式(7)所示, 其中的偏导数是上面确 定的特征点处的偏导数,它也是通过附近区域的差 分来近似估计的。