Boosted Deep Neural Networ ks and Multi-resolution

多头自注意力机制的技术原理详细说明

多头自注意力机制的技术原理详细说明多头自注意力机制是一种用于处理序列数据的重要技术,最初是在自然语言处理领域提出的,如今已经广泛应用于机器翻译、文本生成、语音识别等领域。

它的核心思想是允许模型在处理序列数据时同时关注输入序列中的不同部分,从而更好地捕捉序列之间的依赖关系。

自注意力机制最初由Google的研究人员在2017年提出,它的核心思想是通过对输入序列中不同位置的相关性进行计算,来动态地调整每个位置的重要性,从而实现针对不同位置的关注。

在这种机制下,模型可以同时关注到序列中不同位置的信息,而传统的循环神经网络和卷积神经网络在处理长序列数据时往往会存在信息传递不畅、长距离依赖关系捕捉不足等问题。

多头自注意力机制引入了多个注意力头以增强模型对不同特征的关注能力。

下面将详细介绍多头自注意力机制的技术原理。

1.自注意力机制自注意力机制是通过计算序列中每个位置与其他位置之间的相关性来确定每个位置的重要性。

以下面的公式来表示输入序列的自注意力机制:Attention(Q, K, V) = softmax((QK^T) / √d_k)V其中,Q、K、V分别表示输入序列的查询、键、值,可以通过线性变换得到,而softmax((QK^T) / √d_k)用于计算每个位置的权重,√d_k表示归一化因子,防止内积过大。

这样,通过对输入序列的自注意力机制,模型可以同时关注到不同位置的信息,从而更好地捕捉序列之间的依赖关系。

2.多头自注意力机制多头自注意力机制是通过引入多个自注意力头来增强模型对不同特征的关注能力。

在多头自注意力机制中,输入序列经过多个线性变换得到多组查询、键、值,然后分别通过不同的自注意力头来计算不同的注意力权重。

最后,将多个头的注意力输出进行拼接,并经过线性变换获得最终的输出。

具体地,多头自注意力机制可以通过以下公式来表示:MultiHead(Q, K, V) = Concat(head_1, ..., head_h)W^O其中,MultiHead表示多头自注意力机制的输出,head_i表示第i 个注意力头的输出,W^O表示输出的线性变换矩阵。

递归最小二乘循环神经网络

递归最小二乘循环神经网络赵 杰 1张春元 1刘 超 1周 辉 1欧宜贵 2宋 淇1摘 要 针对循环神经网络(Recurrent neural networks, RNNs)一阶优化算法学习效率不高和二阶优化算法时空开销过大, 提出一种新的迷你批递归最小二乘优化算法. 所提算法采用非激活线性输出误差替代传统的激活输出误差反向传播,并结合加权线性最小二乘目标函数关于隐藏层线性输出的等效梯度, 逐层导出RNNs 参数的迷你批递归最小二乘解. 相较随机梯度下降算法, 所提算法只在RNNs 的隐藏层和输出层分别增加了一个协方差矩阵, 其时间复杂度和空间复杂度仅为随机梯度下降算法的3倍左右. 此外, 本文还就所提算法的遗忘因子自适应问题和过拟合问题分别给出一种解决办法. 仿真结果表明, 无论是对序列数据的分类问题还是预测问题, 所提算法的收敛速度要优于现有主流一阶优化算法, 而且在超参数的设置上具有较好的鲁棒性.关键词 深度学习, 循环神经网络, 递归最小二乘, 迷你批学习, 优化算法引用格式 赵杰, 张春元, 刘超, 周辉, 欧宜贵, 宋淇. 递归最小二乘循环神经网络. 自动化学报, 2022, 48(8): 2050−2061DOI 10.16383/j.aas.c190847Recurrent Neural Networks With Recursive Least SquaresZHAO Jie 1 ZHANG Chun-Yuan 1 LIU Chao 1 ZHOU Hui 1 OU Yi-Gui 2 SONG Qi 1Abstract In recurrent neural networks (RNNs), the first-order optimization algorithms usually converge slowly,and the second-order optimization algorithms commonly have high time and space complexities. In order to solve these problems, a new minibatch recursive least squares (RLS) optimization algorithm is proposed. Using the inact-ive linear output error to replace the conventional activation output error for backpropagation, together with the equivalent gradients of the weighted linear least squares objective function with respect to linear outputs of the hid-den layer, the proposed algorithm derives the minibatch recursive least squares solutions of RNNs parameters layer by layer. Compared with the stochastic gradient descent algorithm, the proposed algorithm only adds one covari-ance matrix into each layer of RNNs, and its time and space complexities are almost three times as much. Further-more, in order to address the adaptive problem of the forgetting factor and the overfitting problem of the proposed algorithm, two approaches are also presented, respectively, in this paper. The simulation results, on the classifica-tion and prediction problems of sequential data, show that the proposed algorithm has faster convergence speed than popular first-order optimization algorithms. In addition, the proposed algorithm also has good robustness in the selection of hyperparameters.Key words Deep learning, recurrent neural network (RNN), recursive least squares (RLS), minibatch learning, op-timization algorithmCitation Zhao Jie, Zhang Chun-Yuan, Liu Chao, Zhou Hui, Ou Yi-Gui, Song Qi. Recurrent neural networks with recursive least squares. Acta Automatica Sinica , 2022, 48(8): 2050−2061循环神经网络(Recurrent neural networks,RNNs)作为一种有效的深度学习模型, 引入了数据在时序上的短期记忆依赖. 近年来, RNNs 在语言模型[1]、机器翻译[2]、语音识别[3]等序列任务中均有不俗的表现. 但是相比前馈神经网络而言, 也正因为其短期记忆依赖, RNNs 的参数训练更为困难[4−5].如何高效训练RNNs, 即RNNs 的优化, 是RNNs 能否得以有效利用的关键问题之一. 目前主流的RNNs 优化算法主要有一阶梯度下降算法、自适应学习率算法和二阶梯度下降算法等几种类型.最典型的一阶梯度下降算法是随机梯度下降(Stochastic gradient descent, SGD)[6], 广泛应用于优化RNNs. SGD 基于小批量数据的平均梯度对参数进行优化. 因为SGD 的梯度下降大小和方向完全依赖当前批次数据, 容易陷入局部极小点, 故而学习效率较低, 更新不稳定. 为此, 研究者在SGD收稿日期 2019-12-12 录用日期 2020-04-07Manuscript received December 12, 2019; accepted April 7, 2020国家自然科学基金(61762032, 61662019, 11961018)资助Supported by National Natural Science Foundation of China (61762032, 61662019, 11961018)本文责任编委 曹向辉Recommended by Associate Editor CAO Xiang-Hui1. 海南大学计算机科学与技术学院 海口 5702282. 海南大学理学院 海口 5702281. School of Computer Science and Technology, Hainan Uni-versity, Haikou 5702282. School of Science, Hainan University,Haikou 570228第 48 卷 第 8 期自 动 化 学 报Vol. 48, No. 82022 年 8 月ACTA AUTOMATICA SINICAAugust, 2022的基础上引入了速度的概念来加速学习过程, 这种算法称为基于动量的SGD算法[7], 简称为Momen-tum. 在此基础上, Sutskever等[8]提出了一种Nes-terov动量算法. 与Momentum的区别体现在梯度计算上. 一阶梯度下降算法的超参数通常是预先固定设置的, 一个不好的设置可能会导致模型训练速度低下, 甚至完全无法训练. 针对SGD的问题, 研究者提出了一系列学习率可自适应调整的一阶梯度下降算法, 简称自适应学习率算法. Duchi等[9]提出的AdaGrad算法采用累加平方梯度对学习率进行动态调整, 在凸优化问题中表现较好, 但在深度神经网络中会导致学习率减小过快. Tieleman等[10]提出的RMSProp算法与Zeiler[11]提出的AdaDelta 算法在思路上类似, 都是使用指数衰减平均来减少太久远梯度的影响, 解决了AdaGrad学习率减少过快的问题. Kingma等[12]提出的Adam算法则将RMSProp与动量思想相结合, 综合考虑梯度的一阶矩和二阶矩估计计算学习率, 在大部分实验中比AdaDelta等算法表现更为优异, 然而Keskar等[13]发现Adam最终收敛效果比SGD差, Reddi等[14]也指出Adam在某些情况下不收敛.基于二阶梯度下降的算法采用目标函数的二阶梯度信息对参数优化. 最广泛使用的是牛顿法, 其基于二阶泰勒级数展开来最小化目标函数, 收敛速度比一阶梯度算法快很多, 但是每次迭代都需要计算Hessian矩阵以及该矩阵的逆, 计算复杂度非常高. 近年来研究人员提出了一些近似算法以降低计算成本. Hessian-Free算法[15]通过直接计算Hessi-an矩阵和向量的乘积来降低其计算复杂度, 但是该算法每次更新参数需要进行上百次线性共轭梯度迭代. AdaQN[16]在每个迭代周期中要求一个两层循环递归, 因此计算量依然较大. K-FAC算法(Kro-necker-factored approximate curvature)[17]通过在线构造Fisher信息矩阵的可逆近似来计算二阶梯度. 此外, 还有BFGS算法[18]以及其衍生算法(例如L-BFGS算法[19−20]等), 它们都通过避免计算Hessian矩阵的逆来降低计算复杂度. 相对于一阶优化算法来说, 二阶优化算法计算量依然过大, 因此不适合处理规模过大的数据集, 并且所求得的高精度解对模型的泛化能力提升有限, 甚至有时会影响泛化, 因此二阶梯度优化算法目前还难以广泛用于训练RNNs.除了上面介绍的几种类型优化算法之外, 也有不少研究者尝试将递归最小二乘算法(Recursive least squares, RLS)应用于训练各种神经网络. RLS是一种自适应滤波算法, 具有非常快的收敛速度. Azimi-Sadjadi等[21]提出了一种RLS算法, 对多层感知机进行训练. 谭永红[22]将神经网络层分为线性输入层与非线性激活层, 对非线性激活层的反传误差进行近似, 并使用RLS算法对线性输入层的参数矩阵进行求解来加快模型收敛. Xu等[23]成功将RLS算法应用于多层RNNs. 上述算法需要为每个神经元存储一个协方差矩阵, 时空开销很大. Peter 等[24]提出了一种扩展卡尔曼滤波优化算法, 对RN-Ns进行训练. 该算法将RNNs表示为被噪声破坏的平稳过程, 然后对网络的状态矩阵进行求解. 该算法不足之处是需要计算雅可比矩阵来达到线性化的目的, 时空开销也很大. Jaeger[25]通过将非线性系统近似为线性系统, 实现了回声状态网络参数的RLS求解, 但该算法仅限于求解回声状态网络的输出层参数, 并不适用于一般的RNNs训练优化.针对以上问题, 本文提出了一种新的基于RLS 优化的RNN算法(简称RLS-RNN). 本文主要贡献如下: 1) 在RLS-RNN的输出层参数更新推导中, 借鉴SGD中平均梯度的计算思想, 提出了一种适于迷你批样本训练的RLS更新方法, 显著减少了RNNs的实际训练时间, 使得所提算法可处理较大规模数据集. 2) 在RLS-RNN的隐藏层参数更新推导中, 提出了一种等效梯度思想, 以获得该层参数的最小二乘解, 同时使得RNNs仅要求输出层激活函数存在反函数即可采用RLS进行训练, 对隐藏层的激活函数则无此要求. 3) 相较以前的RLS 优化算法, RLS-RNN只需在隐藏层和输出层而非为这两层的每一个神经元分别设置一个协方差矩阵, 使得其时间和空间复杂度仅约SGD算法的3倍.4) 对RLS-RNN的遗忘因子自适应和过拟合预防问题进行了简要讨论, 分别给出了一种解决办法.1 背景1.1 基于SGD优化的RNN算法X s,t∈R m×a H s,t∈R m×h O s,t∈R m×d s tm ah dU s−1∈R a×h W s−1∈R h×hV s−1∈R h×d sb H s−1∈R1×h b O s−1∈R1×dττRNNs处理时序数据的模型结构如图1所示.一个基本的RNN通常由一个输入层、一个隐藏层(也称为循环层)和一个输出层组成. 在图1中, , 和 分别为第批训练样本数据在第时刻的输入值、隐藏层和输出层的输出值, 其中, 为迷你批大小, 为一个训练样本数据的维度, 为隐藏层神经元数, 为输出层神经元数; , 和分别为第批数据训练时输入层到隐藏层、隐藏层内部、隐藏层到输出层的参数矩阵;和分别为隐藏层和输出层的偏置参数矩阵; 表示当前序列数据共有时间步. RNNs的核心思想是在模型的不同时间步对参8 期赵杰等: 递归最小二乘循环神经网络2051数进行共享, 将每一时间步的隐藏层输出值加权输入到其下一时间步的计算中, 从而令权重参数学习到序列数据不同时间步之间的关联特征并进行泛化. 输出层则根据实际问题选择将哪些时间步输出,比较常见的有序列数据的分类问题和预测问题. 对序列数据预测问题, 输出层每一时间步均有输出;对序列数据分类问题, 输出层没有图1虚线框中的时间步输出, 即仅在最后一个时间步才有输出.图 1 RNN 模型结构Fig. 1 RNN model structureRNNs 通过前向传播来获得实际输出, 其计算过程可描述为H s,t =φ(X s,t U s −1+H s,t −1W s −1+1×b H s −1)(1)O s,t =σ(H s,t V s −1+1×b O s −1)(2)1m φ(·)σ(·)其中, 为 行全1列向量; 和分别为隐藏层和输出层的激活函数, 常用的激活函数有sig-moid 函数与tanh 函数等. 为了便于后续推导和表达的简洁性, 以上两式可用增广矩阵进一步表示为R H s,t ∈R m ×(a +h +1)R O s,t ∈Rm ×(h +1)ΘH s −1∈R(a +h +1)×hΘO s −1∈R(h +1)×d其中, , 分别为隐藏层与输出层的输入增广矩阵; , 分别为隐藏层与输入层的权重参数增广矩阵, 即R H s,t =[X s,tH s,t −11](5)R Os,t =[H s,t1](6)RNNs 的参数更新方式和所采用的优化算法密切相关, 基于SGD 算法的RNNs 模型优化通常借助于最小化目标函数反向传播完成. 常用目标函数有交叉熵函数、均方误差函数、Logistic 函数等. 这里仅考虑均方误差目标函数Y ∗s,t ∈Rm ×dX s,t Θs −1t 0t 0=τt 0=1其中, 为 对应的期望输出; 为网络中的所有参数矩阵; 表示输出层的起始输出时间步, 如果是分类问题, , 如果是序列预测问题, 则 , 下文延续该设定, 不再赘述.ˆ∇O s=∂ˆJ (Θs −1)∂ΘOˆ∇O s 令 , 由式(9)和链导法则, 则 为ˆ∆O s,t=∂ˆJ(Θs −1)∂Z O其中, , 即◦Z Os,t 式中, 为Hadamard 积, 为输出层非激活线性输出, 即则该层参数更新规则可定义为α其中,为学习率.ˆ∇H s =∂J (Θs −1)∂ΘH s −1令 , 根据BPTT (Back propag-ation through time)算法[26], 由式(9)和链导法则可得ˆ∆H s,t=∂ˆJ(Θs −1)∂Z H s,t其中, 为目标函数对于隐藏层非激活线性输出的梯度, 即˜∆H s,t =[ˆ∆O s,t ,ˆ∆H s,t +1],˜ΘH s −1=[V s −1,W s −1],Z H s,t 其中, 为隐藏层非激活线性输出, 即则该层参数更新规则可定义为1.2 RLS 算法RLS 是一种最小二乘优化算法的递推化算法,2052自 动 化 学 报48 卷X t ={x 1,···,x t }Y ∗t ={y ∗1,···,y ∗t }不但收敛速度很快, 而且适用于在线学习. 设当前训练样本输入集 , 对应的期望输出集为 . 其目标函数通常定义为w λ∈(0,1]其中, 为权重向量; 为遗忘因子.∇w J (w )=0令 ,可得整理后可表示为其中,为了避免昂贵的矩阵求逆运算且适用于在线学习, 令将式(21)和式(22)改写为如下递推更新形式由Sherman-Morrison-Woodbury 公式[27]易得其中,g t 其中,为增益向量. 进一步将式(23)、(25)和(26)代入式(20), 可得当前权重向量的更新公式为其中,2 基于RLS 优化的RNNs 算法RLS 算法虽然具有很快的学习速度, 然而只适用于线性系统. 我们注意到在RNNs 中, 如果不考虑激活函数, 其隐藏层和输出层的输出计算依旧是σ(·)σ−1(·)线性的, 本节将基于这一特性来构建新的迷你批RLS 优化算法. 假定输出层激活函数 存在反函数 , 并仿照RLS 算法将输出层目标函数定义为s s Z O ∗n,t 其中,代表共有 批训练样本; 为输出层的非激活线性期望值, 即因此, RNNs 参数优化问题可以定义为H s,t O s,t Z Os,t 由于RNNs 前向传播并不涉及权重参数更新,因此本文所提算法应用于RNNs 训练时, 其前向传播计算与第1.1节介绍的SGD-RNN 算法基本相同, 同样采用式(3)计算, 唯一区别是此处并不需要计算 , 而是采用式(12)计算 . 本节将只考虑RLS-RNN 的输出层和隐藏层参数更新推导.2.1 RLS-RNN输出层参数更新推导∇ΘO =∂J (Θ)∂ΘO令 , 由式(31)和链导法则可得∆O n,t =∂J (Θ)∂Z O其中, , 即ΘO ∗∇ΘO =0为了求取最优参数 , 进一步令 , 即将式(35)代入式(36), 得ΘO s 整理可得 的最小二乘解其中,类似于RLS 算法推导, 以上两式可进一步写成8 期赵杰等: 递归最小二乘循环神经网络2053如下递推形式R O s,t,k ∈Rh +1(R O s,t )T k Z O ∗s,t,k ∈R d (Z O ∗s,t )Tk A O s 其中, 为 的第 列向量, 为 的第 列向量. 但是, 由于此处RN-Ns 基于迷你批训练, 式(41)并不能像式(24)那样直接利用Sherman-Morrison-Woodbury 公式求解 的逆.ΘO s −1A O s −1B Os −1考虑到同一批次中各样本 , 和 是相同的, 借鉴SGD 计算迷你批平均梯度思想, 接下来采用平均近似方法来处理这一问题. 因为式(41)和式(42)可以重写为如下形式其中,(A O s )−1ΘOs 因而可使用如下公式来近似求得和 为P O s =(A O s )−1令 , 根据式(47)和式(38)以及Sherman-Morrison-Woodbury 公式, 整理后得如下更新式为∆O s,t,k ∈R d(∆O s,t )T k 其中, 为 的第 列向量, 且ΛO s,t,k =P O s −1R Os,t,k(51)2.2 RLS-RNN 隐藏层参数更新推导∇ΘH =∂J (Θ)∂ΘH令 , 由式(31)和链导法则可得∆H n,t =∂J (Θ)∂Z H n,t其中, , 使用BPTT 算法计算其具体形式为´∆H n,t =∆O n,t ,∆H n,t +1∇ΘH =0其中, . 进一步令 , 可得φ′(Z Hs,t )ΘH 然而, 式(54)非常复杂, 且 一般为非线性, 我们并不能将式(54)代入式(55)求得隐藏层参数 的最小二乘解.∆H n,t ΘH J H (ΘH )接下来我们提出一种新的方法来导出 的等价形式, 藉此来获得 的最小二乘解. 临时定义一个新的隐藏层目标函数Z H ∗n,t J (Θ)→0J H (ΘH )→0其中, 为该层非激活线性输出期望值. 显然, 如果 , 那么 . 即∂J H(ΘH)∂ΘH=0令 , 得∆H n,t 对比式(55)和式(58), 可以得到 的另一种等价定义形式ηηZ H n,t =R H n,t ΘH其中, 为比例因子. 理论上讲,不同迷你批数据对应的 应该有一定的差别. 但考虑到各批迷你批数据均是从整个训练集中随机选取, 因此可忽略这一差别. 根据式(16)可知 , 且将式(59)代入式(55), 得ΘH s 进一步整理, 可得 的最小二乘解2054自 动 化 学 报48 卷其中,P H s =(A H s )−1式(61)的递归最小二乘解推导过程类似于输出层参数更新推导. 令 , 同样采用上文的近似平均求解方法, 易得∆H s,t,k ∈R h (∆H s,t )Tk 其中, 为 的第 列向量, 且ΛH s,t,k =P H s −1RHs,t,k(66)Z H ∗s,t ∆H s,t 需要说明的是, 因为我们并不知道隐藏层期望输出 , 所以实际上不能通过式(59)来求取. 幸运的是, 式(54)与(59)等价, 因此在算法具体实现中, 采用式(54)来替换式(59).综上, RLS-RNN 算法如算法 1所示.算法 1. 基于RLS 优化的RNN 算法{(X 1,Y ∗1),(X 2,Y ∗2),···,(X N ,Y ∗N )},τληαRequire: 迷你批样本 时间步 , 遗忘因子 , 比例因子 , 协方差矩阵初始参数 ;ΘH 0ΘO0P H 0=αI H ,P O 0=αI O ;Initialize: 初始化权重矩阵 和 , 初始化协方差矩阵 s =1,2,···,N for do H s,0=0 设置 ;t =1,2,···,τ for do H s,t 用式(3)计算 ;Z s,t 用式(12)计算 ; end fort =τ,τ−1,···,1 for do ∆O s,t 用式(35)计算 ;∆H s,t 用式(54)计算 ;k =1,···,m for doΛO s,t,k G O s,t,k 用式(51), (52)计算 , ;ΛH s,t,k G H s,t,k 用式(66), (67)计算 , ; end for end forP Os ΘO s 用式(49), (50)更新 , ;P Hs ΘH s 用式(64), (65)更新 , ; end for .3 分析与改进3.1 复杂度分析τm a h d a d h 在RNNs 当前所用优化算法中, SGD 是时间和空间复杂度最低的算法. 本节将以SGD-RNN 为参照, 来对比分析本文提出的RLS-RNN 算法的时间和空间复杂度. 两个算法采用一个迷你批样本数据集学习的时间和空间复杂度对比结果如表1所示. 从第1节介绍可知, 表示序列数据时间步长度, 表示批大小, 表示单个样本向量的维度, 表示隐藏层神经元数量, 表示输出层神经元数量.在实际应用中, 和 一般要小于 , 因而RLS-RNN 的时间复杂度和空间复杂度大约为SGD-RNN 的3倍. 在实际运行中, 我们发现RLS-RNN 所用时间和内存空间大约是SGD-RNN 的3倍, 与本节理论分析结果正好相吻合.所提算法只需在RNNs 的隐藏层和输出层各设置一个矩阵, 而以前的RLS 优化算法则需为RNNs 隐藏层和输出层的每一个神经元设置一个与所提算法相同规模的协方差矩阵, 因而所提算法在时间和空间复杂度上有着大幅降低. 此外, 所提算法采用了深度学习广为使用的迷你批训练方式, 使得其可用于处理较大规模的数据集.λ3.2 自适应调整λλλ众多研究表明, 遗忘因子 的取值对RLS 算法性能影响较大[28], 特别是在RLS 处理时变任务时影响更大. 由于本文所提算法建立在传统RLS 基础之上, 因而RLS-RNN 的收敛质量也易受 的取值影响. 在RLS 研究领域, 当前已有不少关于 自适应调整方面的成果[28−29], 因此可以直接利用这些成果对RLS-RNN 作进一步改进.λs 在文献[29]基础上, 本小节直接给出一种 自适应调整方法. 对第 迷你批样本, RLS-RNN 各层中的遗忘因子统一定义为λmax κ>1λs κλs ξλs q s σes其中, 接近于1, 用于控制 更新, 一般建议取2, 通常 取值越小, 更新越频繁; 是一个极小的常数, 防止在计算 时分母为0; , 8 期赵杰等: 递归最小二乘循环神经网络2055σv s 和 定义为µ07/8;µ1=1−1/(ς1m )ς1≥2;µ2=1−1/(ς2m )ς2>ς1其中, 建议取 , 通常 , 且 .λs λλ当然, 采用以上方式更新 将会引入新的超参数, 给RLS-RNN 的调试带来一定困难. 从使用RLS-RNN 的实际经验来看, 也可采用固定的 进行训练, 建议将 取值设置在0.99至1之间.3.3 过拟合预防传统RLS 算法虽然具有很快的收敛速度, 但也经常面临过拟合风险, RLS-RNN 同样面临这一风险. 类似于第3.2节, 同样可以利用RLS 领域关于这一问题的一些研究成果来改进RLS-RNN.L 1Ek șio ğlu [30]提出了一种 正则化RLS 方法,即在参数更新时附加一个正则化项. 对其稍加改进,则在式(50)和式(65)的基础上可分别重新定义为γG O s,t =G O s,t,1,···,G Os,t,m G H s,t =[G H s,t,1,···,G H s,t,m ]其中, 为正则化因子, ,.实际上, 除了这种方法外, 读者也可采用其他正则化方法对RLS-RNN 作进一步改进.4 仿真实验αη为了验证所提算法的有效性, 本节选用两个序列数据分类问题和两个序列数据预测问题进行仿真实验. 其中, 两个分类问题为MNIST 手写数字识别分类[31]和IMDB 影评正负情感分类, 两个预测问题为Google 股票价格预测[32]与北京市PM2.5污染预测[33]. 在实验中, 将着重验证所提算法的收敛性能、超参数 和 选取的鲁棒性. 在收敛性能验证中, 选用主流一阶梯度优化算法SGD 、Momentum 和Adam 进行对比, 所有问题的实验均迭代运行150Epochs; 在超参数鲁棒性验证中, 考虑到所提算法收敛速度非常快, 所有问题的实验均只迭代运行50Epochs. 为了减少实验结果的随机性, 所有实验均重复运行5次然后取平均值展示结果. 此外, 为了观察所提算法的实际效果, 所有优化算法在RN-Ns 参数更新过程均不进行Dropout 处理. 需要特别说明的是: 对前两个分类问题, 由于时变性不强,所提算法遗忘因子采用固定值方式而不采用第3.2表 1 SGD-RNN 与RLS-RNN 复杂度分析Table 1 Complexity analysis of SGD-RNN and RLS-RNNSGD-RNNRLS-RNN时间复杂度O s O (τmdh )—Z s —O (τmdh ) H s O (τmh (h +a ))O (τmh (h +a ))∆O sO (4τmd ) O (3τmd ) ∆H sO (τmh (h +d ))O (τmh (h +d )) P O s —O (2τmh 2) P H s—O (2τm (h +a )2)ΘO s O (τmdh ) O (τmdh ) ΘH s O (τmh (h +a )) O (τmh (h +a ))合计O (τm (3dh +3h 2+2ha ))O (τm (7h 2+2a 2+3dh +6ha ))空间复杂度ΘO s O (hd ) O (hd ) ΘH sO (h (h +a ))O (h (h +a )) P Hs —O ((h +a )2)P O s—O (h 2)合计O (h 2+hd +ha )O (hd +3ha +a 2+3h 2)2056自 动 化 学 报48 卷节所提方式; 对后两个预测问题, 所提算法遗忘因子将采用第3.2节所提方式; 所提算法对4个问题均将采用第3.3节所提方法防止过拟合.4.1 MNIST 手写数字识别分类28×28MNIST 分类问题的训练集与测试集分别由55 000和10 000幅 像素、共10类灰度手写数字图片组成, 学习目标是能对给定手写数字图片进行识别. 为了适应RNNs 学习, 将训练集和测试集中的每张图片转换成一个28时间步的序列, 每时间步包括28个像素输入, 图片类别采用One-hot 编码.tanh (·).tanh (·)tanh −1(1)tanh −1(−1)tanh −1(x )x ≥0.997tanh −1(x )=tanh −1(0.997)x ≤−0.997,tanh −1(x )=tanh −1(−0.997)该问题所用RNN 模型结构设置如下: 1) 输入层输入时间步为28, 输入向量维度为28. 2) 隐藏层时间步为28, 神经元数为100, 激活函数为 3) 输出层时间步为1, 神经元数为10, 激活函数为. 由于 和 分别为正、负无穷大, 在具体实现中, 对 , 我们约定: 若, 则 ; 若 则 . RNN 模型权重参数采用He 初始化[34].在收敛性能对比验证中, 各优化算法超参数设ληαγβ1β2ϵ10−8αηλ=0.9999γ=0.0001η=1α=0.01,0.1,0.2, (1)=0.9999,γ=0.0001α=0.4,η=0.1,1,2,···,10置如下: RLS 遗忘因子 为0.9999, 比例因子 为1, 协方差矩阵初始化参数 为0.4, 正则化因子 为0.0001; SGD 学习率为0.05; Momentum 学习率为0.05, 动量参数0.5; Adam 学习率0.001, 设为0.9, 为0.999, 设为 . 在超参数 和 选取的鲁棒性验证中, 采用控制变量法进行测试: 1)固定 , 和 , 依次选取 验证; 2) 固定 和 依次选取 验证.αηαα在上述设定下, 每一Epoch 均将训练集随机划分成550个迷你批, 批大小为100. 每训练完一个Epoch, 便从测试集中随机生成50个迷你批进行测试, 统计其平均分类准确率. 实验结果如图2(a)、表2和表3所示. 由图2(a)可知, RLS 在第1个Epoch 便可将分类准确率提高到95%以上, 其收敛速度远高于其他三种优化算法, 且RLS 的准确率曲线比较平滑, 说明参数收敛比较稳定. 表2和表3记录了该实验取不同的 和 时第50 Epoch 的平均分类准确率. 从表2中不难看出, 不同初始化因子 在第50 Epoch 的准确率都在97.10%到97.70%之间波动, 整体来说比较稳定, 说明 对算法性能图 2 收敛性比较实验结果Fig. 2 Experimental results on the convergence comparisons8 期赵杰等: 递归最小二乘循环神经网络2057ηηαη影响较小. 从表3中可知, 不同 取值的准确率均在97.04%到97.80%之间, 波动较小, 取值对算法性能的影响也不大. 综上, RLS 算法的 和 取值均具有较好的鲁棒性.4.2 IMDB 影评情感分类IMDB 分类问题的训练集和测试集分别由25 000和10 000条电影评论组成, 正负情感评论各占50%,学习目标是能对给定评论的感情倾向进行识别. 为了适应RNNs 学习, 首先从Keras 内置数据集加载训练集和测试集的各条评论, 选取每条评论前32个有效词构成一个时间步序列, 然后对该评论中的每个有效词以GloVe.6B 预训练模型[35]进行词嵌入, 使得每个时间步包括50个输入维度, 评论的正负情感类别采用One-hot 编码.tanh (·)tanh (·)tanh −1(x )该问题所用RNN 模型结构设置如下: 1) 输入层输入时间步为32, 输入向量维度为50. 2) 隐藏层时间步为32, 神经元数为100, 激活函数为 .3) 输出层时间步为1, 神经元数为2, 激活函数为. 问题和RNN 模型权重参数的初始化按第4.1节方式同样处理.ληαγβ1β2ϵ10−8αηλ=0.9999,γ=0.001η=1α=0.01,0.1,0.2,···,1λ=0.9999,γ=0.001α=0.4η=0.1,1,2,···,10在收敛性能对比验证中, 各优化算法超参数设置如下: RLS 遗忘因子 为0.9999, 比例因子 为1, 协方差矩阵初始化参数 为0.4, 正则化因子 为0.001; SGD 学习率为0.05; Momentum 学习率为0.05, 动量参数0.5; Adam 学习率0.0001, 设为0.9, 设为0.999, 设为 . 在超参数 和 选取的鲁棒性验证中, 同样采用控制变量法进行测试: 1) 固定 和 , 依次选取 验证; 2) 固定 和 , 依次选取 验证.αηααηηαη在上述设定下, 每一Epoch 均将训练集随机划分成250个迷你批, 批大小为100. 每训练完一个Epoch, 便从测试集中随机生成50个迷你批进行测试, 统计其平均分类准确率. 实验结果如图2(b)、表2和表3所示. 由图2(b)可知, SGD 与Mo-mentum 的收敛不太稳定, 波动比较大, 而Adam 的准确率曲线则比较平滑, 这三者在训练初期的准确率都比较低. 相比之下, RLS 在训练初期的准确率已经比较接近后期预测准确率, 前期收敛速度极快, 整体准确率也明显优于其余三种优化算法. 表2和表3记录了IMDB 实验取不同的 和 时第50Epoch 的平均分类准确率. 由表2易知不同 的情况下准确率浮动范围比较小, 因此不同 对算法的影响比较小. 由表3可知, 采用不同 时其准确率在72.86%到73.82%之间浮动, 可见 的取值对算法性能影响较小. 综上, RLS 算法的 和 取值在本实验中同样都具有较好的鲁棒性.4.3 Google 股票价格预测Google 股票价格预测问题的数据源自Google 公司从2010年1月4日到2016年12月30日的股价记录, 每日股价记录包括当日开盘价、当日最低价、当日最高价、交易笔数及当日调整后收盘价五种数值, 学习目标是能根据当日股价预测调整后次日收盘价. 为了适应RNNs 学习, 首先对这些数值进行归一化处理, 然后以连续50个交易日为单位进行采样, 每次采样生成一条5维输入序列数据,同时将该次采样后推一个交易日选取各日调整后收盘价生成对应的一维期望输出序列数据, 取前1 400条序列数据的训练集, 后续200条序列数据为测试α表 2 初始化因子 鲁棒性分析αTable 2 Robustness analysis of the initializing factor α0.010.10.20.30.40.50.60.70.80.9 1.0MNIST 分类准确率 (%)97.1097.3697.3897.3597.5797.7097.1997.2797.4297.2597.60IMDB 分类准确率 (%)72.2173.5073.2473.3274.0273.0173.6873.2573.2073.4273.12×10−4股价预测MSE ( ) 5.32 5.19 5.04 5.43 5.42 5.30 4.87 4.85 5.32 5.54 5.27×10−3PM2.5预测MSE ( )1.581.551.531.551.611.551.551.541.571.581.57η表 3 比例因子 鲁棒性分析ηTable 3 Robustness analysis of the scaling factor η0.1 1.0 2.0 3.0 4.0 5.0 6.07.08.09.010.0MNIST 分类准确率 (%)97.8097.5997.4897.6197.0497.6297.4497.3397.3897.3797.45IMDB 分类准确率 (%)73.5873.4673.6273.7673.4473.8273.7172.9772.8673.1273.69×10−4股价预测MSE ( ) 5.70 5.32 5.04 5.06 5.61 4.73 5.04 5.14 4.85 4.97 5.19×10−3PM2.5预测MSE ( )1.531.551.561.591.561.531.581.551.541.501.522058自 动 化 学 报48 卷。

深度学习的目标跟踪算法综述

深度学习的目标跟踪算法综述引言:随着深度学习技术的快速发展,目标跟踪领域也得到了巨大的发展。

目标跟踪是指在视频序列中,对感兴趣的目标进行连续的定位和跟踪,其在计算机视觉、自动驾驶、视频监控等领域有着广泛的应用前景。

本文将综述几种常见的深度学习目标跟踪算法,以便读者对这一领域有更全面的了解。

一、基于卷积神经网络的目标跟踪算法卷积神经网络(Convolutional Neural Network,CNN)是深度学习中最常用的网络结构之一。

它通过卷积层、池化层和全连接层等结构,能够自动提取图像特征。

在目标跟踪中,常用的基于CNN的算法有Siamese网络、Correlation Filter网络和DeepSORT等。

1. Siamese网络Siamese网络是一种基于孪生网络结构的目标跟踪算法,它通过输入一对图像样本来学习两个样本之间的相似度。

该网络通过训练得到的特征向量,可以用于计算待跟踪目标与骨干网络中的目标特征之间的距离,从而确定目标的位置。

2. Correlation Filter网络Correlation Filter网络是一种基于卷积神经网络的目标跟踪算法,它通过训练得到的滤波器,可以将目标与背景进行区分。

该算法通过计算滤波响应图,来确定目标的位置和尺度。

3. DeepSORTDeepSORT是一种结合深度学习和传统目标跟踪算法的方法,它通过使用CNN进行特征提取,并结合卡尔曼滤波器对目标进行预测和更新。

DeepSORT在准确性和实时性上都有较好的表现,在实际应用中有着广泛的使用。

二、基于循环神经网络的目标跟踪算法循环神经网络(Recurrent Neural Network,RNN)是一种能够处理序列数据的神经网络模型。

在目标跟踪中,RNN可以考虑到目标在时间上的依赖关系,从而提高跟踪的准确性。

常见的基于RNN的目标跟踪算法有LSTM和GRU等。

1. LSTMLSTM是一种常用的循环神经网络结构,它能够有效地处理长期依赖问题。

机器学习与深度学习框架考核试卷

C. RMSprop

D.学习率衰减

8.以下哪些技术可以用于改善神经网络训练过程?()

A.梯度消失

B.梯度爆炸

C. Batch Normalization

D.参数共享

9.以下哪些框架支持GPU加速计算?()

A. TensorFlow

B. PyTorch

C. Caffe

D. Theano

10.以下哪些方法可以用于处理不平衡数据集?()

B. LSTM

C. CNN

D. Transformer

17.以下哪些技术可以用于提升神经网络的可解释性?()

A.可视化技术

B. attention机制

C. LIME

D. SHAP

18.以下哪些是深度学习中的预训练方法?()

A.零样本学习

B.迁移学习

C.对抗性学习

D.自监督学习

19.以下哪些是强化学习的主要组成部分?()

7.词嵌入(或词向量)

8.泛化

9.数据增强

10. ROC

四、判断题

1. ×

2. √

3. ×

4. ×

5. √

6. ×

7. ×

8. √

9. ×

10. √

五、主观题(参考)

1.机器学习是利用算法让计算机从数据中学习,深度学习是机器学习的一个分支,使用多层神经网络进行学习。深度学习在实际应用中的例子有:自动驾驶汽车中的图像识别系统。

()

9.在深度学习中,为了防止过拟合,我们可以在训练过程中对输入数据进行______。

()

10.在模型评估中,______曲线可以用来评估分类模型的性能,尤其是对于不平衡数据集。

()

《2024年基于多尺度和注意力机制融合的语义分割模型研究》范文

《基于多尺度和注意力机制融合的语义分割模型研究》篇一一、引言随着深度学习技术的不断发展,语义分割作为计算机视觉领域的一个重要任务,逐渐成为研究的热点。

语义分割旨在将图像中的每个像素划分为不同的语义类别,为图像理解提供了更加细致的信息。

然而,由于实际场景中存在多尺度目标和复杂背景的干扰,语义分割任务仍面临诸多挑战。

为了解决这些问题,本文提出了一种基于多尺度和注意力机制融合的语义分割模型。

二、相关工作语义分割作为计算机视觉的一个关键任务,在近几年的研究中得到了广泛的关注。

目前主流的语义分割模型主要采用深度卷积神经网络(CNN)来实现。

这些模型通过捕获上下文信息、提高特征表达能力等手段提高分割精度。

然而,在处理多尺度目标和复杂背景时,这些模型仍存在局限性。

为了解决这些问题,本文提出了一种融合多尺度和注意力机制的语义分割模型。

三、模型与方法本文提出的模型主要由两个部分组成:多尺度特征提取和注意力机制融合。

(一)多尺度特征提取多尺度特征提取是提高语义分割性能的关键技术之一。

在本模型中,我们采用了不同尺度的卷积核和池化操作来提取图像的多尺度特征。

具体而言,我们设计了一个包含多种尺度卷积核的卷积层,以捕获不同尺度的目标信息。

此外,我们还采用了池化操作来获取更大尺度的上下文信息。

这些多尺度特征将被用于后续的注意力机制融合。

(二)注意力机制融合注意力机制是一种有效的提高模型性能的技术,可以使得模型更加关注重要的区域。

在本模型中,我们采用了自注意力机制和交叉注意力机制来提高模型的表达能力。

自注意力机制主要用于捕获每个像素的上下文信息,而交叉注意力机制则用于融合不同尺度特征之间的信息。

具体而言,我们通过在卷积层之间引入自注意力和交叉注意力模块,使得模型能够更好地关注重要区域和提取多尺度特征。

四、实验与结果为了验证本文提出的模型的性能,我们在公开的语义分割数据集上进行了一系列实验。

实验结果表明,本文提出的模型在处理多尺度目标和复杂背景时具有更好的性能。

深度神经网络在语音识别中的应用

深度神经网络在语音识别中的应用一、引言语音识别是一项具有挑战性的技术,其能够将口语转化为可执行命令或可供存储的文本。

随着科技的进步,语音识别已经成为了许多设备和应用程序中必备的功能,如语音助手、语音搜索等。

本文将探讨深度神经网络在语音识别中的应用以及其优势。

二、深度神经网络深度神经网络(deep neural network,DNN)是一种人工神经网络的模型,它由多个非线性变换层堆叠而成,一般具有深度超过两层。

每个层的参数是由前面各层的特征自动地学习生成的。

深度神经网络在图像处理、自然语言处理、声音识别等方面具有广泛的应用。

三、深度神经网络在语音识别中的应用在语音识别技术中,深度神经网络起到了重要作用。

当前,深度神经网络已经在许多领域及各个层面展现出了杰出的性能。

而在语音识别中,它也为语音模型的建立提供了新的途径。

传统上,语音识别使用的是基于隐马尔可夫模型和贝叶斯网络等方法。

然而,随着深度神经网络技术的发展,人们不再需要将大量的特征提取和手动设计语音模型。

相反,深度神经网络使用端到端的数据驱动训练方法,从原始语音信号中学习包含有关发音、语速、音量等方面的特征,然后通过模拟出人类大脑处理语言信息的过程来实现语音识别。

深度神经网络的语音识别系统可分为前端和后端。

前端主要是将语音信号转化为一个特征向量,而后端将该向量转化为文字。

前端通常使用声学处理来分析信号,比如将信号转化为声谱图。

在后端部分,深度神经网络负责处理前端产生的数据,识别出语音中的文本信息。

深度神经网络采用的是序列模型,其目的是将语音序列映射到文字或者指令序列中。

四、深度神经网络在语音识别中的优势相对于传统的语音识别方法,深度神经网络在语音识别中具有以下优势:1、端到端训练,减少了特征工程流程的复杂度。

深度神经网络通过自己学习语音特征,无需专家买服务,从而减少了对人类专业知识的依赖。

2、提高了准确性。

深度神经网络在数据驱动下对语音数据的处理更加精细,通过节省特征处理步骤,使其能够更好地适应数据,从而提高语音识别的准确率。

神经网络 论文

神经网络论文以下是一些关于神经网络的重要论文:1. "A Computational Approach to Edge Detection",作者:John Canny,论文发表于1986年,提出了一种基于神经网络的边缘检测算法,被广泛应用于计算机视觉领域。

2. "Backpropagation Applied to Handwritten Zip Code Recognition",作者:Yann LeCun et al.,论文发表于1990年,引入了反向传播算法在手写数字识别中的应用,为图像识别领域开创了先河。

3. "Gradient-Based Learning Applied to Document Recognition",作者:Yann LeCun et al.,论文发表于1998年,介绍了LeNet-5,一个用于手写数字和字符识别的深度卷积神经网络。

4. "ImageNet Classification with Deep Convolutional Neural Networks",作者:Alex Krizhevsky et al.,论文发表于2012年,提出了深度卷积神经网络模型(AlexNet),在ImageNet图像识别竞赛中取得了重大突破。

5. "Deep Residual Learning for Image Recognition",作者:Kaiming He et al.,论文发表于2015年,提出了深度残差网络(ResNet),通过引入残差连接解决了深度神经网络训练中的梯度消失和梯度爆炸问题。

6. "Generative Adversarial Networks",作者:Ian Goodfellow etal.,论文发表于2014年,引入了生成对抗网络(GAN),这是一种通过博弈论思想训练生成模型和判别模型的框架,广泛应用于图像生成和增强现实等领域。

人工智能深度学习算法的新突破

人工智能深度学习算法的新突破人工智能(Artificial Intelligence,简称AI)是一门研究如何使计算机能够像人类一样思考、学习和决策的科学。

深度学习(Deep Learning)则是AI中的一种重要技术,通过构建和训练人工神经网络,实现对大规模数据的自动学习和模式识别。

在过去几年中,人工智能深度学习算法取得了许多重要的新突破,为我们带来了巨大的科技进步和社会变革。

一、强大的计算能力推动了深度学习算法的发展人工智能深度学习算法的新突破之一是得益于计算能力的快速提升。

随着硬件技术的进步,特别是图形处理器单元(GPU)的发展,计算机的计算速度和处理能力得到了大幅度提升,使得更复杂、更庞大的神经网络可以被高效地训练和应用。

例如,在图像识别领域,深度学习算法通过海量的图像数据和强大的计算能力,实现了对物体、人脸等的高准确度识别,大大提升了计算机视觉的能力。

二、深度学习模型的优化和创新推动了算法性能的提升深度学习模型的优化和创新也是人工智能深度学习算法取得新突破的关键。

研究人员通过不断地改进网络结构和学习算法,不仅提高了深度学习模型的准确度和稳定性,还加速了模型的训练过程。

例如,卷积神经网络(Convolutional Neural Networks,CNN)在图像处理领域的成功应用,引入了局部感知和参数共享的概念,大大减少了计算量和参数数量,提高了算法的效率和性能。

另外,递归神经网络(Recurrent Neural Networks,RNN)的提出,使得模型可以处理时间序列数据和自然语言处理等领域的任务。

通过引入长短时记忆(Long Short-Term Memory,LSTM)单元和门控循环单元(Gated Recurrent Unit,GRU),模型可以有效地解决梯度消失和梯度爆炸等问题,实现对长期依赖关系的建模,改善了模型的表达能力。

三、数据的丰富和开放促进了深度学习算法的发展数据是深度学习算法的重要驱动因素之一。

深度学习设计知识测试 选择题 45题

1. 深度学习中的“深度”通常指的是什么?A. 网络中隐藏层的数量B. 网络中节点的数量C. 网络中参数的数量D. 网络中输入层的数量2. 卷积神经网络(CNN)主要用于哪种类型的数据?A. 结构化数据B. 非结构化数据C. 图像数据D. 文本数据3. 在深度学习中,ReLU激活函数的优点是什么?A. 计算简单B. 防止梯度消失C. 输出范围无限D. 以上都是4. 以下哪种优化算法在深度学习中最常用?A. 梯度下降B. 随机梯度下降C. AdamD. 牛顿法5. 批量归一化(Batch Normalization)的主要作用是什么?A. 加速训练B. 防止过拟合C. 提高模型精度D. 以上都是6. 在深度学习中,过拟合通常是由于什么原因造成的?A. 模型太简单B. 数据太多C. 模型太复杂D. 数据太少7. 以下哪种技术可以用来防止过拟合?A. 数据增强B. 正则化C. DropoutD. 以上都是8. 在深度学习中,交叉熵损失函数通常用于哪种任务?A. 回归任务B. 分类任务C. 聚类任务D. 强化学习任务9. 以下哪种网络结构在自然语言处理中应用广泛?A. CNNB. RNNC. LSTMD. 以上都是10. 在深度学习中,注意力机制(Attention Mechanism)的主要作用是什么?A. 提高计算效率B. 增强模型对重要信息的聚焦C. 减少模型参数D. 防止过拟合11. 以下哪种技术可以用来处理序列数据?A. CNNB. RNNC. LSTMD. 以上都是12. 在深度学习中,迁移学习(Transfer Learning)的主要优势是什么?A. 减少训练时间B. 提高模型性能C. 减少数据需求D. 以上都是13. 以下哪种技术可以用来提高模型的泛化能力?A. 数据增强B. 正则化C. DropoutD. 以上都是14. 在深度学习中,生成对抗网络(GAN)的主要应用是什么?A. 图像生成B. 语音识别C. 自然语言处理D. 推荐系统15. 以下哪种技术可以用来生成新的数据样本?A. GANB. CNNC. RNND. LSTM16. 在深度学习中,强化学习(Reinforcement Learning)的主要特点是什么?A. 通过试错学习B. 需要大量标注数据C. 适用于静态环境D. 以上都不是17. 以下哪种技术可以用来处理无监督学习任务?A. 自编码器B. 聚类算法C. 生成模型D. 以上都是18. 在深度学习中,自编码器(Autoencoder)的主要作用是什么?A. 数据压缩B. 特征学习C. 数据生成D. 以上都是19. 以下哪种技术可以用来提高模型的鲁棒性?A. 数据增强B. 正则化C. DropoutD. 以上都是20. 在深度学习中,集成学习(Ensemble Learning)的主要优势是什么?A. 提高模型性能B. 减少训练时间C. 减少数据需求D. 以上都是21. 以下哪种技术可以用来提高模型的解释性?A. 可视化工具B. 特征选择C. 模型简化D. 以上都是22. 在深度学习中,元学习(Meta-Learning)的主要目标是什么?A. 快速适应新任务B. 提高模型性能C. 减少数据需求D. 以上都是23. 以下哪种技术可以用来处理多任务学习?A. 共享参数B. 任务特定的网络C. 多任务损失函数D. 以上都是24. 在深度学习中,知识蒸馏(Knowledge Distillation)的主要作用是什么?A. 模型压缩B. 提高模型性能C. 减少数据需求D. 以上都是25. 以下哪种技术可以用来提高模型的可扩展性?A. 分布式训练B. 模型并行C. 数据并行D. 以上都是26. 在深度学习中,半监督学习(Semi-Supervised Learning)的主要优势是什么?A. 减少标注数据需求B. 提高模型性能C. 加速训练D. 以上都是27. 以下哪种技术可以用来处理不平衡数据集?A. 重采样B. 代价敏感学习C. 集成方法D. 以上都是28. 在深度学习中,主动学习(Active Learning)的主要目标是什么?A. 减少标注数据需求B. 提高模型性能C. 加速训练D. 以上都是29. 以下哪种技术可以用来提高模型的可解释性?A. 可视化工具B. 特征选择C. 模型简化D. 以上都是30. 在深度学习中,对抗训练(Adversarial Training)的主要作用是什么?A. 提高模型鲁棒性B. 减少过拟合C. 加速训练D. 以上都是31. 以下哪种技术可以用来处理动态环境下的学习任务?A. 强化学习B. 迁移学习C. 元学习D. 以上都是32. 在深度学习中,多模态学习(Multi-Modal Learning)的主要目标是什么?A. 整合不同类型的数据B. 提高模型性能C. 减少数据需求D. 以上都是33. 以下哪种技术可以用来处理跨域学习任务?A. 迁移学习B. 元学习C. 多任务学习D. 以上都是34. 在深度学习中,增量学习(Incremental Learning)的主要优势是什么?A. 持续学习新知识B. 减少数据需求C. 提高模型性能D. 以上都是35. 以下哪种技术可以用来处理小样本学习任务?A. 元学习B. 迁移学习C. 数据增强D. 以上都是36. 在深度学习中,注意力机制(Attention Mechanism)的主要作用是什么?A. 提高计算效率B. 增强模型对重要信息的聚焦C. 减少模型参数D. 防止过拟合37. 以下哪种技术可以用来处理序列到序列的任务?A. RNNB. LSTMC. TransformerD. 以上都是38. 在深度学习中,Transformer模型的主要优势是什么?A. 并行计算B. 处理长序列C. 减少训练时间D. 以上都是39. 以下哪种技术可以用来提高模型的泛化能力?A. 数据增强B. 正则化C. DropoutD. 以上都是40. 在深度学习中,胶囊网络(Capsule Networks)的主要作用是什么?A. 提高模型性能B. 减少过拟合C. 提高对图像的理解能力D. 以上都是41. 以下哪种技术可以用来处理图像分割任务?A. CNNB. U-NetC. GAND. 以上都是42. 在深度学习中,U-Net模型的主要优势是什么?A. 处理小数据集B. 提高图像分割精度C. 减少训练时间D. 以上都是43. 以下哪种技术可以用来处理图像生成任务?A. GANB. CNNC. RNND. LSTM44. 在深度学习中,CycleGAN模型的主要作用是什么?A. 图像风格转换B. 图像生成C. 图像分割D. 以上都是45. 以下哪种技术可以用来处理图像超分辨率任务?A. GANB. CNNC. RNND. LSTM答案:1. A2. C3. D4. C5. D6. C7. D8. B9. D10. B11. D12. D13. D14. A15. A16. A17. D18. D19. D20. A21. D22. A23. D24. A25. D26. A27. D28. A29. D30. A31. A32. A33. A34. A35. A36. B37. D38. D39. D40. C41. B42. B43. A44. A45. A。

数据挖掘中的Boosting算法原理解析

数据挖掘中的Boosting算法原理解析数据挖掘是一门利用各种算法和技术来发现并提取数据中隐藏的模式和关联性的学科。

Boosting算法是其中一种常用的机器学习方法,它通过组合多个弱分类器来构建一个强分类器,以提高分类性能。

本文将对Boosting算法的原理进行详细解析。

一、Boosting算法的基本思想Boosting算法的基本思想是通过训练一系列弱分类器(weak learner),然后将它们组合成一个强分类器(strong learner)。

弱分类器指的是分类性能略好于随机猜测的分类器,而强分类器则是具有较高分类性能的分类器。

二、AdaBoost算法AdaBoost(Adaptive Boosting)是Boosting算法的一种实现,它是由Freund和Schapire于1995年提出的。

AdaBoost的核心思想是通过反复调整训练样本的权重,使得先前分类错误的样本在后续训练中得到更多的关注,从而提高分类性能。

具体而言,AdaBoost的训练过程如下:1. 初始化训练样本的权重,通常将它们设置为相等的值。

2. 迭代训练弱分类器。

在每一轮迭代中,根据当前样本权重训练一个弱分类器,并计算其分类错误率。

3. 根据弱分类器的分类错误率,更新样本权重。

分类错误率越低的弱分类器权重越高,分类错误率越高的弱分类器权重越低。

4. 根据更新后的样本权重,计算弱分类器的权重。

分类错误率较低的弱分类器权重较高,分类错误率较高的弱分类器权重较低。

5. 将所有弱分类器组合成一个强分类器。

强分类器的输出是每个弱分类器输出的加权和。

三、Gradient Boosting算法Gradient Boosting是另一种常用的Boosting算法,其基本思想是通过迭代训练一系列弱分类器,并利用梯度下降的方法来最小化损失函数。

与AdaBoost不同,Gradient Boosting在每一轮迭代中,通过拟合当前模型的残差来训练下一个弱分类器。

计算机科学中的深层神经网络应用

计算机科学中的深层神经网络应用深层神经网络(Deep Neural Networks,DNNs)是目前计算机科学领域中最为热门的研究方向之一。

该技术在计算机视觉、语音识别等多个领域有着广泛的应用。

随着深度学习模型的不断优化和数据规模的增加,深层神经网络方法在各个领域的应用逐渐成熟。

在本文中我们将介绍深层神经网络在计算机视觉和自然语言处理领域的应用,以及其在智能交通、智能家居、智能医疗等领域的前景。

1. 计算机视觉领域中的应用在计算机视觉领域,深层神经网络已经成为了基本的工具之一。

1998年,Yann LeCun提出了一个基于深度卷积神经网络的手写数字识别系统,该系统成为了深度学习的催化剂。

现在,深度卷积神经网络在图像识别、目标检测、人脸识别、图像搜索、图像分割等领域有着广泛的应用。

深度卷积神经网络的应用主要基于以下几个方面:(1)特征提取:深度卷积神经网络通过多层卷积层和池化层实现多尺度特征提取,大大提升了图像的表达能力。

(2)分类:深度卷积神经网络通过softmax函数进行分类,将图像分为多个类别。

(3)物体检测:深度卷积神经网络可以对物体进行多类别的定位和识别,例如当前非常流行的Faster R-CNN算法、YOLO算法等。

(4)图像分割:深度卷积神经网络通过将图像分割为不同的区域实现像素级别的图像分割,例如SegNet算法、U-Net算法等。

2. 自然语言处理领域中的应用在自然语言处理领域,深度学习中的循环神经网络和卷积神经网络等模型也已成功应用于许多任务。

例如,语言模型、文本分类、命名实体识别、机器翻译等。

(1)语言模型:深度学习模型可以通过学习大量语料库中的信息来预测下一个词或者下一个句子,有助于提高机器翻译、情感分析等应用的准确性。

(2)文本分类:深度学习模型在文本分类中扮演着重要角色。

它们可以通过学习输入文本的表示来分类不同的文本主题或者意图。

(3)命名实体识别:命名实体识别是指从文本中抽取出专有名词和实体。

基于神经网络的多特征轻度认知功能障碍检测模型

第 62 卷第 6 期2023 年11 月Vol.62 No.6Nov.2023中山大学学报(自然科学版)(中英文)ACTA SCIENTIARUM NATURALIUM UNIVERSITATIS SUNYATSENI基于神经网络的多特征轻度认知功能障碍检测模型*王欣1,陈泽森21. 中山大学外国语学院,广东广州 5102752. 中山大学航空航天学院,广东深圳 518107摘要:轻度认知功能障是介于正常衰老和老年痴呆之间的一种中间状态,是老年痴呆诊疗的关键阶段。

因此,针对潜在MCI老年人群进行早期检测和干预,有望延缓语言认知障碍及老年痴呆的发生。

本文利用患者在语言学表现变化明显的特点,提出了一种基于神经网络的多特征轻度认知障碍检测模型。

在提取自然会话中的语言学特征的基础上,融合LDA模型的T-W矩阵与受试者资料等多特征信息,形成TextCNN网络的输入张量,构建基于语言学特征的神经网络检测模型。

该模型在DementiaBank数据集上达到了0.93的准确率、1.00的灵敏度、0.8的特异度和0.9的精度,有效提高了利用自然会话对老年语言认知障碍检测的准确率。

关键词:轻度认知功能障碍;自然会话;神经网络模型;多特征分析;会话分析中图分类号:H030 文献标志码:A 文章编号:2097 - 0137(2023)06 - 0107 - 09A neural network-based multi-feature detection model formild cognitive impairmentWANG Xin1, CHEN Zesen21. School of Foreign Languages, Sun Yat-sen University, Guangzhou 510275, China2. School of Aeronautics and Astronautics, Sun Yat-sen University, Shenzhen 518107, ChinaAbstract:Mild cognitive impairment (MCI) is both an intermediate state between normal aging and Alzheimer's disease and the key stage in the diagnosis of Alzheimer's disease. Therefore, early detec‐tion and treatment for potential elderly can delay the occurrence of dementia. In this study, a neural net‐work-based multi-feature detection model for mild cognitive impairment was proposed, which exploits the characteristics of patients with obvious changes in linguistic performance. The model is based on ex‐tracting the linguistic features in natural speech and integrating the T-W matrix of the LDA model with the subject data and other multi-feature information as the input tensor of the TextCNN network. It achieved an accuracy of 0.93, a sensitivity of 1.00, a specificity of 0.8, and a precision of 0.9 on the DementiaBank dataset, which effectively improved the accuracy of cognitive impairment detection in the elderly by using natural speech.Key words:mild cognitive impairment; natural speech; neural network model; multi-feature detec‐tion; speech analysisDOI:10.13471/ki.acta.snus.2023B049*收稿日期:2023 − 07 − 18 录用日期:2023 − 07 − 30 网络首发日期:2023 − 09 − 21基金项目:教育部人文社会科学基金(22YJCZH179);中国科协科技智库青年人才计划(20220615ZZ07110400);中央高校基本科研业务费重点培育项目(23ptpy32)作者简介:王欣(1991年生),女;研究方向:应用语言学;E-mail:******************第 62 卷中山大学学报(自然科学版)(中英文)轻度认知障碍(MCI,mild cognitive impair‐ment)是一种神经系统慢性退行性疾病,也是阿尔茨海默病(AD,Alzheimer's disease)的早期关键阶段。

深度学习技术的最新研究进展

深度学习技术的最新研究进展深度学习技术是一种基于神经网络的机器学习算法,具有强大的模式识别能力和灵活性,是当前人工智能领域的热门技术之一。

在最近几年,深度学习技术取得了重大的研究进展,在语音识别、图像识别、自然语言处理、自动驾驶等领域都取得了突破性的进展。

本文将介绍深度学习技术的最新研究进展,包括,在神经网络结构方面的优化、在语音识别领域的新方法、在图像识别领域的进展、在自然语言处理领域的新应用以及在自动驾驶领域的应用等。

神经网络结构的优化神经网络结构的优化是深度学习技术的重要研究方向之一。

近年来,研究人员提出了一系列新的神经网络结构,如残差网络、剪枝神经网络、集成神经网络等。

这些结构不仅有效地提高了神经网络的性能,而且显著减少了神经网络的计算复杂度。

残差网络是目前最先进的深度神经网络结构之一,它的主要思想是引入残差模块来解决深度神经网络的梯度消失和梯度爆炸问题。

据研究表明,在CIFAR-10和ImageNet数据集上,ResNet的性能均超过了以前的最先进的网络结构。

除了残差网络,剪枝神经网络和集成神经网络也取得了很好的效果。

剪枝神经网络通过删除网络中的不必要的连接来降低神经网络的计算复杂度,而集成神经网络采用不同的神经网络结构来共同处理输入数据,有效地减少了过拟合现象。

语音识别领域的新方法语音识别技术是深度学习技术的一个重要应用领域,它已经广泛应用于智能音箱、智能手机、人机交互等领域。

最近,研究人员提出了一种新的语音识别方法,称为端到端学习(End-to-End Learning)。

该方法不再使用传统的语音识别系统,而是直接从语音信号中学习识别模型。

端到端学习是一种更加灵活和高效的语音识别方法,能够更好地适应复杂的语音场景。

与传统的语音识别系统相比,端到端学习还具有更低的延迟和更高的准确性。

最近,几个大型公司已经开始采用端到端学习方法来开发智能音箱和智能手机语音助手等产品。

图像识别领域的进展图像识别技术是深度学习技术的另一个重要应用领域,已经在医疗、安防、工业等领域得到了广泛应用。

深度神经网络原理

深度神经网络原理

深度神经网络(Deep Neural Network,DNN)是一种机器学习模型,它模仿人脑神经网络的结构和工作原理。

该网络由多个神经元层组成,每个神经元层与其他层之间有连接。

每个神经元层接收上一层的输出作为输入,并通过一系列非线性变换和权重调节来计算输出。

隐藏层是DNN的核心部分,它们有助于网络学习到更复杂的特征表示。

输出层通常用于分类或回归任务。

DNN通过反向传播算法进行训练,即通过计算预测输出与真实输出之间的误差,并使用梯度下降法更新网络中的权重和偏置值。

这样一步步迭代训练,直到网络达到预定的性能水平。

深度神经网络的优点之一是它可以通过大量的训练数据学习更复杂的模式和关系。

它在图像识别、自然语言处理、语音识别等领域取得了重大突破,并在许多实际应用中展现出优异的性能。

然而,DNN也存在一些挑战和局限性。

首先,训练深度神经网络需要大量的标记数据和计算资源,以及较长的训练时间。

其次,DNN容易过拟合,因此需要采取适当的正则化措施。

此外,网络结构的选择和调整对DNN的性能也有很大影响。

总的来说,深度神经网络是一种强大的机器学习模型,通过层级化的特征学习和权重调节,可以实现复杂任务的高性能解决

方案。

但在应用中需要根据具体情况进行网络设计、训练和调整,以充分发挥其潜力。

基于神经网络词嵌入模型的单词联想记忆系统设计

件的产生使学生记忆单词的工具和方式更为灵活,并

且可以充分利用碎片化时间来进行单词记忆。 但这

些软件提供的单词背诵方式,仍然是按字母表顺序背

经网络词嵌入模型的单词联想记忆系统。 该系统可

以基于学习语料( 比如四六级考试资料) ,使用基于

神经网络的词嵌入模型构建词嵌入向量,并基于词嵌

入向量对待学习的单词进行关联分析。 同时,系统还

第 12 期

2023 年 6 月

无线互联科技

Wireless Internet Technology

No. 12

June,2023

基于神经网络词嵌入模型的单词联想记忆系统设计

王彬彬,李 强 ∗ ,李若宇

( 淮南师范学院 计算机学院,安徽 淮南 232038)

摘要:针对传统单词记忆软件因缺乏语境与单词关联造成的学习效率低下问题,文章采用 Pytorch 深

association the Pytorch deep learning framework is used to build a word embedding model based on neural networks

train the model on the English corpus to be learned and generate a word embedding vector use the word embedding

运用 SpringBoot、VUE 等 技 术 将 分 析 的 结 果 在 WEB

界面上进行可视化。 学生在学习某一单词时,会展示

诵、随机背诵或者基于单词在语料中出现的频次进行

相关的单词以及对应的语境图片,从而达到通过联想

背诵。 这些背诵方式虽然相对于传统的基于书本的

蚁小二原理

蚁小二原理

蚁小二是一款基于深度学习技术的文章生成器,其原理主要包括两个方面:多层感知机(MLP)和生成对抗网络(GAN)。

多层感知机(MLP)在蚁小二中用于学习文本数据中的单词和短语之间的关系。

通过训练,它可以理解文本中的语法、语义和上下文信息,从而生成符合语法规则和语义逻辑的文本。

MLP的强大之处在于它能够自动提取文本中的特征,并利用这些特征进行文本生成,这使得蚁小二能够快速地生成各种类型的文本数据。

生成对抗网络(GAN)则用于学习文本数据中的单词和短语之间的相似度。

GAN由两个神经网络组成:一个生成器和一个判别器。

生成器的任务是生成与真实文本相似的文本,而判别器的任务是判断生成的文本是否与真实文本相似。

通过不断优化和调整参数,GAN能够使得生成器生成的文本越来越接近真实文本,从而提高了文章的相似度和质量。

蚁小二通过结合MLP和GAN这两种深度学习技术,实现了自动学习和生成文本数据的能力。

在实际应用中,蚁小二可以根据用户的需求生成各种类型的文章、摘要、评论等,并广泛应用于内容营销、数据生产等领域。

此外,蚁小二还支持一键分发到多个自媒体平台,方便用户快速地发布和管理内容,从而提高了工作效率和内容的质量。

未来,随着技术的不断进步和应用场景的不断拓展,蚁小二有望在自然语言处理、人机对话等领域发挥更大的作用,为人们的生活和工作带来更多的便利和价值。

deepcheck的评估算法

deepcheck的评估算法【最新版】目录1.DeepCheck 的概述2.DeepCheck 的评估算法原理3.DeepCheck 的评估算法的优点和不足4.DeepCheck 的未来发展前景正文【1.DeepCheck 的概述】DeepCheck 是一款基于深度学习的计算机视觉模型,其主要用于评估各种计算机视觉算法的性能和准确性。

DeepCheck 的评估算法采用了深度神经网络技术,可以对计算机视觉算法的输出结果进行准确性和可靠性的评估。

【2.DeepCheck 的评估算法原理】DeepCheck 的评估算法原理主要基于深度神经网络的卷积特征提取能力和分类能力。

具体来说,DeepCheck 会将计算机视觉算法的输出结果输入到深度神经网络中,然后深度神经网络会自动提取出输出结果的特征,并根据这些特征进行分类,最终得出评估结果。

【3.DeepCheck 的评估算法的优点和不足】DeepCheck 的评估算法具有许多优点,例如,它可以快速、准确地评估计算机视觉算法的性能和准确性,而且,由于 DeepCheck 采用了深度神经网络技术,因此它可以自动提取出输出结果的特征,从而避免了手动特征工程的繁琐工作。

然而,DeepCheck 的评估算法也存在一些不足,例如,它需要大量的数据进行训练,而且,由于深度神经网络的复杂性,DeepCheck 的评估算法可能存在过拟合的风险。

【4.DeepCheck 的未来发展前景】随着深度学习技术的不断发展,DeepCheck 的评估算法在未来将会得到更广泛的应用。

例如,它可以用于评估自动驾驶汽车的性能和安全性,也可以用于评估医疗影像诊断算法的准确性。

第1页共1页。

深度学习研究综述

深度学习研究综述引言:深度学习是一种机器学习的方法,它模仿了人类大脑的工作方式,通过多层神经网络来学习和理解数据。

深度学习在许多领域中都取得了巨大的成功,包括计算机视觉、自然语言处理和语音识别。

本综述将概述深度学习的起源、发展和应用,并提出一些未来的研究方向。

一、深度学习的起源和发展深度学习最早可以追溯到20世纪80年代,当时的研究人员开始对多层神经网络进行研究。

然而,由于计算资源的限制和算法的不成熟,深度学习并没有得到广泛的应用。

进入21世纪后,随着计算机性能的提高和大数据的普及,深度学习开始迎来了新的发展机遇。

2024年,谷歌研究员Geoffrey Hinton等人提出了一种称为“深度信念网络”的算法,这是深度学习在实际应用中取得突破的重要一步。

随后,一系列针对深度学习算法的改进被提出,包括卷积神经网络、循环神经网络和生成对抗网络等。

二、深度学习的应用领域1. 计算机视觉:深度学习在计算机视觉领域取得了显著的成果。

通过对大量的图像数据进行训练,深度学习可以实现图像分类、目标检测和图像生成等任务。

例如,谷歌的AlphaGo利用深度学习技术在围棋比赛中战胜了人类世界冠军。

2. 自然语言处理:深度学习在自然语言处理领域也有很大的应用潜力。

通过对大量的文本数据进行训练,深度学习可以实现机器翻译、文本分类和情感分析等任务。

例如,谷歌的语音助手Google Assistant就是通过深度学习实现自然语言理解和生成。

3. 语音识别:深度学习在语音识别领域也发挥了重要作用。

通过对大量的语音数据进行训练,深度学习可以实现准确的语音识别和语音合成。

例如,苹果的语音助手Siri就是通过深度学习实现语音交互。

三、深度学习的未来研究方向1.提高模型的鲁棒性和泛化能力:目前的深度学习模型往往对输入的扰动非常敏感,对于未见过的样本也很难进行准确的预测。

未来的研究应该致力于开发更鲁棒的深度学习模型,以应对各种挑战。

2.解决数据稀缺和标注困难的问题:深度学习需要大量的数据进行训练,但在许多领域中,数据往往是稀缺的或者难以标注的。

深度学习应用于自然语言处理

深度学习应用于自然语言处理自然语言处理(Natural Language Processing, NLP)是人工智能领域中的一个重要研究方向。

NLP是指通过计算机技术处理人类自然语言的过程,涉及到文本分析、语音识别、语义理解、机器翻译等多个领域。

而深度学习(Deep Learning, DL)则是当今机器学习领域中的前沿技术,可以更准确地识别和处理复杂模式。

深度学习在自然语言处理领域的应用,也引起了广泛关注。

深度学习原理简介深度学习是一种基于神经网络的算法。

在神经网络的基础上,通过多层不同种类的神经元进行非线性变换,实现对数据深层次的抽象和表示。

其主要原理是带参数的神经网络对输入数据进行逐层变换,最终对输出做出预测。

对于文本数据,深度学习可以实现自动抽取特征和进行分类,有效提高自然语言处理的精度。

深度学习在自然语言处理中的应用深度学习在自然语言处理领域中涉及的应用场景非常广泛。

下面列举一些主要的应用案例。

1. 词向量表示词向量表示(word embedding)是深度学习中常用的自然语言处理方法。

词向量可以将单词表示成固定维度的向量,并且能够通过统计学习的方式学习到单词之间的相似度。

词向量的优点在于,能够处理大量的单词和相应的语义信息,并快速地得到词汇的相似词和对应的上下文信息。

2. 文本分类文本分类是自然语言处理中的一个重要问题。

深度学习可以通过卷积神经网络和循环神经网络等算法实现文本分类。

卷积神经网络可以对文本信息进行空间特征抽取,并通过池化层将文本长度压缩,最终得到文本的分类结果。

循环神经网络则可以处理序列信息,将文本的历史信息考虑进去,从而得到更加准确的分类结果。

3. 机器翻译机器翻译是自然语言处理领域中的一个重要问题,深度学习也在这个领域中得到了广泛的应用。

深度学习通过神经网络对源语言和目标语言之间的映射进行建模,并利用端到端的训练方法进行模型优化。

在机器翻译任务中,深度学习可以不依赖于显式的特征工程,从原始数据中学习到翻译模型的所有特征。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

support vector machines (Enqing et al., 2002) sparse coding spectral clustering

Typical parametric models:

Gaussian models, Gaussian mixture models recursive neural networks deep neural networks (Zhang and Wu, 2013)

10

2 The cochleagram feature is calculated from ∑K k =1 sc ,k where K —frame length, sc ,k —value of the c th channel and k th sample of the frame.

Xiao-Lei Zhang BoostDNN and MRCG for VAD

1 Speech hit rate

Optimization direction

ROC curve

Optimal operating point

0

0 False alarm rate

1

3

Xiao-Lei Zhang

BoostDNN and MRCG for VAD

Intro. Related Work bDNN MRCG Experiments Conclus. Ack

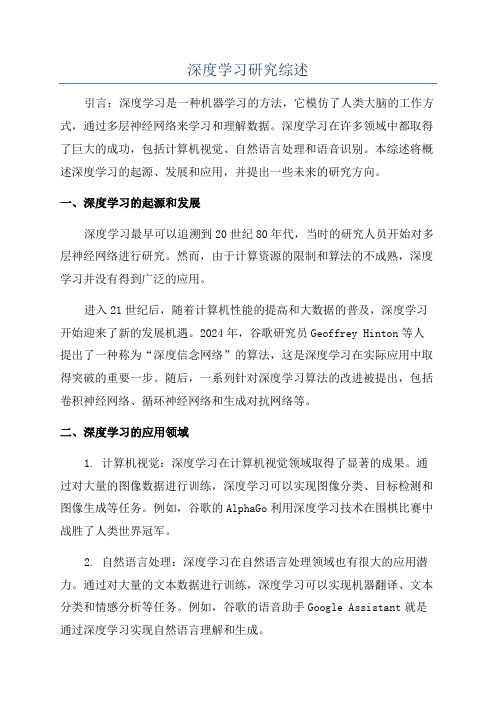

Boosted Deep Neural Networks and Multi-resolution Cochleagram Features for Voice Activity Detection

Xiao-Lei Zhang

∗ Department of Electronic Engineering, Tsinghua University, Beijing, China. Department of Computer Science & Engineering, The Ohio State University, USA (e-mail: huoshan6@).

Frame length = 200 ms; Frame shift = 10 ms

d

CG1

CG3

Smoothing each unit in a 11x11 square window

Smoothing each unit in a 23x23 square window

Frame length

64-D feature

8 September 2014

1

Intro. Related Work bDNN MRCG Experiments Conclus. Ack

Contents

1

Introduction Related Work Boosted Deep Neural Networks Multiresolution Cochleagram Features Experiments Conclusions Acknowledgments

Typical features: DFT, MFCC, Pitch, etc.

Challenges:

How to improve the performance in extremely low SNRs and difficult environments? How to generalize the models to unseen noise types?

Training phase of boosted deep neural networks (bDNN)

a

b

DNN

b

DNN

Figure: Training phase on a corpus {xn , yn }N n=1 . (a) Expanding xn to T T T T xn = [xT n−W , xn−W +1 , . . . , xn , . . . , xn+W −1 , xn+W ] given the half-window size W . (b) Expanding the ground truth label yn to a new (2W + 1)-dimensional target vector yn = [yn−W , yn−W +1 , . . . , yn , . . . , yn+W −1 , yn+W ]T 7

5

Xiao-Lei Zhang BD

Intro. Related Work bDNN MRCG Experiments Conclus. Ack

Related Work

Deep neural networks (DNN): DNNs are multilayer perceptrons with more than one hidden layer.

9

Intro. Related Work bDNN MRCG Experiments Conclus. Ack

Experimental settings

Data sets: Clean speech of AURORA4 mixed with Babble and factory noises from NOISEX-92 at an SNR of [-5 0 5] dB Evaluation metrics: ROC curve and its corresponding AUC Competitive methods:

Bootstrap resamplings:

Bootstrap (Efron, 1979) Key idea: integrating the results of multiple subsets (called bootstrap samples) for a smaller variance than any of the results. Ensemble learning (Schapire, 1990), Key ideas: (i) meaningful weak classifiers, and (ii) diversity between the classifiers. Methods (Dietterich, 2000):

CG4

Speech signal

64-channel gammatone filter

(Frequency range: [80, 5000] Hz)

64-D feature

Time

Frame length

A Delta feature is calculated by ∆xn =

(xn+1 −xn−1 )+2(xn+2 −xn−2 )

Manipulating training examples, input features, hyperparameters, and/or output targets.

6

Xiao-Lei Zhang BoostDNN and MRCG for VAD

Intro. Related Work bDNN MRCG Experiments Conclus. Ack

Brief overview of VADs

Energy based VADs

Typical methods:

energy in the time domain, zero-crossing rate (Rabiner, 1976), pitch detection,

Typical systems:

4

Xiao-Lei Zhang BoostDNN and MRCG for VAD

Intro. Related Work bDNN MRCG Experiments Conclus. Ack

Brief overview of VADs (2)

Machine Learning based VADs (i) view VAD as a binary-class classification problem, and (ii) train various classification models.

64-D feature

64-D feature

64-D feature

Channels

CG2

b c

256-D MRCG feature

256-D Delta feature

256-D DeltaDelta feature Calculating the energy of each frame in each channel

Multiresolution cochleagram (MRCG) (Chen et al., 2014)

a

Time domain noisy speech 64-channel cochleagram:

Frame length = 20 ms; Frame shift = 10 ms

64-channel cochleagram:

G.729B (1998), ETSI Advanced Front-End (ES 202 050, 2004).

A useful technique: Long term smoothing (e.g. 200 ms).

Statistical signal processing based VADs

Typical nonlinear hidden units: sigmoid function, tanh function, and rectified linear function. Typical training methods: backpropagation, pretraining.