Best_Practices_General_Master_Data_Bev

多智能体强化学习的几种BestPractice

多智能体强化学习的几种BestPractice(草稿阶段,完成度40%)多智能体强化学习的几种Best Practice - vonZooming的文章 - 知乎 https:///p/99120143这里分享一下A Survey and Critique of Multiagent Deep Reinforcement Learning这篇综述里面介绍的多智能体强化学习Best Practice。

这部分内容大部分来自第四章,但是我根据自己的理解加上了其他的内容。

1.改良Experience replay buffer1.1 传统的Single-agent场景之下的Replay bufferReplay Buffer[90, 89]自从被提出后就成了Single-Agent强化学习的常规操作,特别是DQN一炮走红之后[72] 。

不过,Replay Buffer有着很强的理论假设,用原作者的话说是——The environment should not changeover time because this makes pastexperiences irrelevantor even harmful.(环境不应随时间而改变,因为这会使过去的experience replay变得无关紧要甚至有害)Replay buffer假设环境是stationary的,如果当前的环境信息不同于过去的环境信息,那么就无法从过去环境的replay中学到有价值的经验。

(画外音:大人,时代变了……别刻舟求剑了)在multi-agent场景下,每个agent都可以把其他的agent当作环境的一部分。

因为其他的agent不断地学习进化,所以agent所处的环境也是在不断变换的,也就是所谓的non-stationary。

因为multi-agent场景不符合replay buffer的理论假设,所以有的人就直接放弃治疗了——例如2016年发表的大名鼎鼎的RIAL和DIAL中就没有使用replay buffer。

streamlit best practice

streamlit best practiceStreamlit是一个用于创建和部署数据科学和机器学习应用程序的开源Python库。

它是专门为数据科学家和机器学习工程师设计的,旨在简化应用程序的构建过程。

在本篇文章中,我们将讨论一些使用Streamlit的最佳实践,以帮助您构建出更好的应用程序。

第一步:安装和设置Streamlit首先,我们需要安装Streamlit库。

通过运行以下命令可以使用pip进行安装:pip install streamlit安装后,您可以在Python脚本中导入Streamlit库:import streamlit as st接下来,您可以使用以下命令来启动Streamlit应用程序:streamlit run your_script.py其中,your_script.py是您的应用程序的Python脚本文件。

运行该命令后,Streamlit服务器将在本地主机的默认端口上启动,您可以在浏览器中打开它以查看和使用应用程序。

第二步:探索Streamlit的基本功能Streamlit提供了许多功能和组件,可用于创建交互式应用程序。

以下是一些基本功能的示例:1. 标题和文本:您可以使用st.title()和st.text()函数来添加标题和文本内容到应用程序。

pythonst.title('My Streamlit App')st.text('Welcome to my app!')2. 侧边栏:您可以使用st.sidebar来创建一个侧边栏,并在其中放置相关控件。

pythonst.sidebar.title('Settings')3. 数据展示:您可以使用st.dataframe()和st.table()函数来展示数据表格。

pythonimport pandas as pddf = pd.DataFrame({'Column 1': [1, 2, 3], 'Column 2': [4, 5, 6]}) st.dataframe(df)4. 图表:Streamlit允许您使用多种绘图库创建图表。

streamlit best practice -回复

streamlit best practice -回复Streamlit是一个开源框架,用于构建数据科学和机器学习应用程序的前端界面。

它被设计成简单易用,同时提供了强大的功能和灵活性,使开发者能够快速建立交互式、可视化的应用程序。

本文将深入探讨Streamlit的最佳实践,以帮助读者更好地使用和优化这个框架。

我们将从安装和基本用法开始,逐步扩展到高级功能和性能优化。

一、安装和基本用法首先,我们需要安装Streamlit。

使用pip命令可以轻松安装Streamlit:pip install streamlit安装成功后,我们可以通过创建一个Python脚本,并导入Streamlit库来开始构建我们的应用程序。

下面是一个简单的例子:pythonimport streamlit as stst.title('Hello Streamlit')st.write('欢迎使用Streamlit!')在这个简单的示例中,我们使用了Streamlit的两个基本函数:title和write。

title函数用于设置应用程序的标题,而write函数用于在页面上显示文本。

二、构建交互式组件Streamlit不仅可以显示文本,还可以通过使用各种交互式组件丰富应用程序的功能。

例如,我们可以添加一个滑动条来调整参数,一个复选框来选择选项,或者一个下拉菜单来选择不同的数据集。

下面是一个使用滑动条和复选框的例子:pythonimport streamlit as st# 滑动条age = st.slider('请选择您的年龄', 0, 100, 25)# 复选框show_data = st.checkbox('显示数据')if show_data:st.write('您选择的年龄是:', age)在这个例子中,我们使用了slider函数来创建一个滑动条,允许用户选择0到100之间的年龄。

Synopsys OptoDesigner 2020.09安装指南说明书

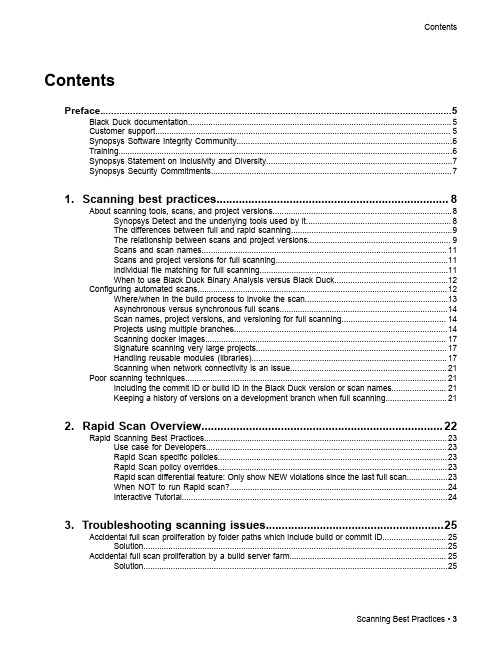

3. Troubleshooting scanning issues........................................................25

Accidental full scan proliferation by folder paths which include build or commit ID............................ 25 Solution......................................................................................................................................25

Contents

Contents

Preface....................................................................................................5

1. Scanning best practices......................................................................... 8

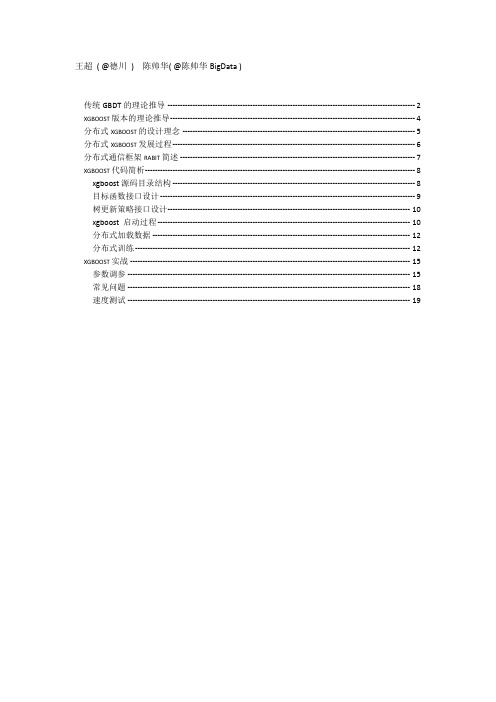

xgboost导读和实战

让平台往接口需求上面去走,最终使得各种比较有效的分布式机器学习 abstraction 的实现在各个平台下面跑。

这里按自己理解给出一个整体框架的理念的分层抽象逻辑。

Gbdt

Lr

…

Interface abstraction(AllReduce,异步 SGD,…)

Yarn

MPI

Openmp …

3.可容错 Rabit 版本的 Allreduce 有一个很好的性质,支持容错,而传统的 mpi 是不支持的。 具体实现方式:Allreduce 每一个节点最后拿到的是一样的结果,这意味着可以让 一些节点记住结果。当有节点挂掉重启的时候,可以直接向还活着的节点索要结

第三版原生支持 Yarn Yarn 为了能自由的掌控各个节点的资源分配并且能使文件均衡的分割到各个节 点,直接把 rabit 作为 yarn 的一个 APP 运行。在这一版里,实现了 c++读写 hdfs 的功能,解决了 streaming 版本中 xgboost 中对文件操作自由不高的问题。

分布式通信框架 rabit 简述

rabit 是容错的 allreduce 实现,在启动 yarn 集群基于 rabit 的任务时,首先在节点 间建立树形的连接关系(下图)来提高节点间的通信效率。建立连接关系后,各 节点可通过 allreduce 接口通信内存单元。

上图是 rabit 中 allreduce 求和的例子。每个节点依次向父节点发送节点值,父节 点接受子节点的值并和父节点自己的值求和后,再往上一层节点发送。最后根节 点得到全部子节点的和并和自己的节点值相加后就得到了所有节点的和,然后将 根节点求得的值沿着树的路径传播给各个节点。allreduce 的求和操作完成后,各 个节点得到了所有节点值的和。 rabit allreduce 支持对连续内存单元简单的 sum max min 操作,也支持自定义的 reduce 操作来对不同节点中的类的数据成员合并。xgboost 的分布式算法主要用 到了自定义的 reduce 操作来合并计算特征候选分割点的统计量,以及合并由候 选分割点得到的区间内样本的统计量。

python gradientboostingregressor参数

python gradientboostingregressor参数GradientBoostingRegressor是sklearn库中的一个回归模型,它的参数解释如下:1. learning_rate:学习率,默认为0.1,表示每一步的步长,权重缩减系数。

2. n_estimators:基学习器的数量,默认为100,即弱学习器的数量,即提升集成中基学习器的数量。

3. loss:代价函数,默认为ls,指定负梯度的损失函数。

ls表示最小二乘回归,lad表示绝对损失回归,huber表示平滑的平均绝对误差,quantile表示分位数回归。

4. criterion:分裂节点时的评价准则,默认为friedman_mse,表示划分质量的评价准则。

5. max_depth:树的最大深度,默认为3,调整深度可以有效调节模型的拟合程度。

6. min_samples_split:节点分裂所需的最小样本数,默认为2,满足该条件的节点才会被分裂。

7. min_samples_leaf:叶节点所需的最小样本数,默认为1,如果叶节点数过多,可以考虑增大该参数。

8. max_features:分裂节点时考虑的最大特征数,默认为None,表示考虑所有特征;可以为sqrt,表示考虑特征数的平方根,log2,表示考虑特征数的对数等。

9. subsample:每棵树随机采样的比例,默认为1,即全部采样。

如果小于1,则可以减小模型的方差。

10. random_state:随机种子,默认为None,表示使用相同的随机数种子,可以获得相同的结果。

11. alpha:L2正则化参数,默认为0,惩罚项的系数,越大,模型越简单,防止过拟合。

12. validation_fraction:用于早期停止训练的验证集占比,默认为0.1,如果代价函数在一定的迭代次数内不再减小,则停止训练。

13. n_iter_no_change:用于早期停止训练的连续迭代次数,默认为None,即不使用该方法。

NORMA 4000 5000 Power Analyzer 用户说明手册说明书

Since some countries or states do not allow limitation of the term of an implied warranty, or exclusion or limitation of incidental or consequential damages, the limitations and exclusions of this warranty may not apply to every buyer. If any provision of this Warranty is held invalid or unenforceable by a court or other decision-maker of competent jurisdiction, such holding will not affect the validity or enforceability of any other provision.

BEGRENZTE GEWÄHRLEISTUNG UND HAFTUNGSBESCHRÄNKUNG

Fluke gewährleistet, daß jedes Fluke-Produkt unter normalem Gebrauch und Service frei von Material- und Fertigungsdefekten ist. Die Garantiedauer beträgt 2 Jahre ab Versanddatum. Die Garantiedauer für Teile, Produktreparaturen und Service beträgt 90 Tage. Diese Garantie wird ausschließlich dem Erster

DS2208数字扫描器产品参考指南说明书

-05 Rev. A

6/2018

Rev. B Software Updates Added: - New Feedback email address. - Grid Matrix parameters - Febraban parameter - USB HID POS (formerly known as Microsoft UWP USB) - Product ID (PID) Type - Product ID (PID) Value - ECLevel

-06 Rev. A

10/2018 - Added Grid Matrix sample bar code. - Moved 123Scan chapter.

-07 Rev. A

11/2019

Added: - SITA and ARINC parameters. - IBM-485 Specification Version.

No part of this publication may be reproduced or used in any form, or by any electrical or mechanical means, without permission in writing from Zebra. This includes electronic or mechanical means, such as photocopying, recording, or information storage and retrieval systems. The material in this manual is subject to change without notice.

sovits train参数

sovits train参数全文共四篇示例,供读者参考第一篇示例:1. batch_size:batch_size参数是指每次输入给模型的数据样本数量。

在训练神经网络模型时,通常会将大量的数据分为小批次进行训练,以提高训练效率和减少内存使用。

较大的batch_size可以加快训练速度,但可能会增加模型的训练时间和资源消耗。

较小的batch_size可以提高模型的收敛性和泛化能力。

2. epochs:epochs参数定义了模型在训练集上的训练次数。

每个epoch会将整个训练集输入给模型进行训练,直到模型收敛。

增加epoch可以提高模型的性能和泛化能力,但也可能导致过拟合。

通常会根据模型的训练情况来调整epochs的数量。

3. learning_rate:learning_rate参数定义了模型在训练过程中的学习速率。

它控制了模型在每一次迭代中更新参数的幅度。

较小的learning_rate可以使模型更加稳定,但可能需要更多的训练时间。

较大的learning_rate可以加快模型的收敛速度,但也可能导致模型不稳定。

通常需要对learning_rate进行调整以获得最佳的性能。

4. optimizer:optimizer参数定义了模型在训练过程中使用的优化器。

优化器负责计算并更新模型的参数,以使模型的损失函数最小化。

常用的优化器包括SGD、Adam、RMSprop等。

不同的优化器有不同的性能和收敛速度,用户可以根据自己的需求选择合适的优化器。

5. loss_function:loss_function参数定义了模型在训练过程中使用的损失函数。

损失函数用于衡量模型预测结果与真实标签之间的差异。

常用的损失函数包括均方误差(MSE)、交叉熵(Cross Entropy)等。

选择合适的损失函数可以使模型更好地拟合数据和提高性能。

6. validation_split:validation_split参数定义了在训练过程中用于验证模型性能的数据集的比例。

association_rules 参数

association_rules 参数在数据挖掘中,关联规则是一种重要的技术,它通过挖掘数据集中不同元素之间的关系,来生成规则,这些规则可以帮助我们更好地理解数据,并发现其中的模式和趋势。

在 Python 的机器学习库 scikit-learn 中,有一个名为 association_rules 的函数,它可以用来生成关联规则。

在这个函数中,有一些重要的参数,下面我们来详细介绍一下这些参数的含义和作用。

1. transactions:这个参数是一个列表,它包含了我们要进行关联规则挖掘的数据集。

每个元素都代表一个交易,其中包含了一些商品或者其他元素。

2. support_threshold:这个参数是一个浮点数,它表示我们要筛选出哪些规则。

只有当一个规则的支持度高于这个阈值时,才会被保留下来。

3. confidence_threshold:这个参数也是一个浮点数,它表示我们要筛选出哪些规则。

只有当一个规则的置信度高于这个阈值时,才会被保留下来。

4. max_length:这个参数是一个整数,它表示要生成的规则的最大长度。

如果设置为 1,那么只会生成包含一个元素的规则。

如果设置为 2,那么会生成包含两个元素的规则,以此类推。

5. metric:这个参数是一个字符串,它表示评估规则质量的指标。

常用的指标有“lift”、“confidence”和“support”。

6. keep_original_transactions:这个参数是一个布尔值,它表示在生成规则的过程中,是否保留原始的交易数据。

如果设置为True,那么会将原始的交易数据保存下来,否则会在生成规则后将其删除。

7. verbose:这个参数是一个布尔值,它表示是否在运行过程中输出详细的信息。

如果设置为 True,那么会输出调试信息和运行进度。

通过调整这些参数,我们可以根据不同的需求,生成不同的关联规则。

在实践中,我们需要根据具体的数据集和分析目的,来选择合适的参数组合,以达到最好的结果。

IBM Cognos Transformer V11.0 用户指南说明书

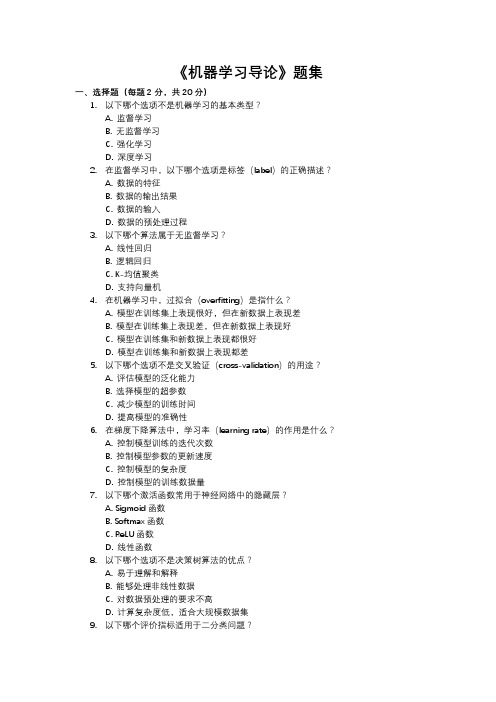

《机器学习导论》题集

《机器学习导论》题集一、选择题(每题2分,共20分)1.以下哪个选项不是机器学习的基本类型?A. 监督学习B. 无监督学习C. 强化学习D. 深度学习2.在监督学习中,以下哪个选项是标签(label)的正确描述?A. 数据的特征B. 数据的输出结果C. 数据的输入D. 数据的预处理过程3.以下哪个算法属于无监督学习?A. 线性回归B. 逻辑回归C. K-均值聚类D. 支持向量机4.在机器学习中,过拟合(overfitting)是指什么?A. 模型在训练集上表现很好,但在新数据上表现差B. 模型在训练集上表现差,但在新数据上表现好C. 模型在训练集和新数据上表现都很好D. 模型在训练集和新数据上表现都差5.以下哪个选项不是交叉验证(cross-validation)的用途?A. 评估模型的泛化能力B. 选择模型的超参数C. 减少模型的训练时间D. 提高模型的准确性6.在梯度下降算法中,学习率(learning rate)的作用是什么?A. 控制模型训练的迭代次数B. 控制模型参数的更新速度C. 控制模型的复杂度D. 控制模型的训练数据量7.以下哪个激活函数常用于神经网络中的隐藏层?A. Sigmoid函数B. Softmax函数C. ReLU函数D. 线性函数8.以下哪个选项不是决策树算法的优点?A. 易于理解和解释B. 能够处理非线性数据C. 对数据预处理的要求不高D. 计算复杂度低,适合大规模数据集9.以下哪个评价指标适用于二分类问题?A. 准确率(Accuracy)B. 召回率(Recall)C. F1分数(F1 Score)D. 以上都是10.以下哪个算法属于集成学习(ensemble learning)?A. 随机森林B. K-近邻算法C. 朴素贝叶斯D. 感知机二、填空题(每空2分,共20分)1.在机器学习中,数据通常被分为训练集、_______和测试集。

2._______是一种常用的数据预处理技术,用于将数值特征缩放到一个指定的范围。

extratreeregressor参数

ExtraTreesRegressor的参数主要包括:

n_estimators:树的数量,默认为100。

criterion:测量分割质量的函数,包

括"squared_error"(默认)和"absolute_error"。

其中,"squared_error"表示均方误差,它等于作为特征选择标准的方差减少以及平均绝对误差的"mae"。

max_depth:树的最大深度。

如果没有设置,那么会扩展节点直到所有叶子都是纯的或直到所有叶子包含少于min_samples_split个样本。

min_samples_split:拆分内部节点所需的最小样本数。

如果设置为int,则将其视为最小数量。

如果是浮点数,那么ceil(min_samples_split * n_samples)是每个拆分的最小样本数。

min_samples_leaf:叶节点所需的最小样本数,默认为1。

以上是ExtraTreesRegressor的主要参数,这些参数会显著影响模型的性能。

建议根据具体问题和数据来调整这些参数。

streamlit best practice -回复

streamlit best practice -回复《Streamlit 最佳实践》Streamlit 是一个用于构建高效的机器学习和数据科学应用程序的开源库。

它允许开发者使用简单的Python 脚本创建交互式应用程序,而无需编写大量的代码。

本文将深入探讨Streamlit 的最佳实践,帮助读者在使用Streamlit 时更加高效和专业。

1. Streamlit 的基本使用首先,我们需要安装Streamlit。

可以使用以下命令在Python 环境中安装Streamlit:pip install streamlit安装完成后,我们可以创建一个基本的Streamlit 应用程序。

在一个Python 文件中,导入Streamlit 模块,并编写一个简单的函数或类来定义应用程序的主要部分。

然后,使用`streamlit run` 命令来运行应用程序。

pythonimport streamlit as stdef main():st.title("Hello Streamlit!")st.write("Welcome to my first Streamlit app.")if __name__ == '__main__':main()在终端中运行以下命令:streamlit run my_app.py现在,你应该可以在浏览器中看到一个简单的Streamlit 应用程序。

这个应用程序显示一个标题和一段文本。

2. 样式和布局Streamlit 提供了一系列方法来控制应用程序的样式和布局。

可以使用`st.markdown()` 和`st.write()` 来呈现文本内容,也可以使用`st.title()`、`st.header()`、`st.subheader()` 等方法来定义不同级别的标题。

要更改文本的样式和格式,可以使用Markdown 语法。

同时,Streamlit 还提供了一些格式化选项,如`st.code()` 和`st.italic()`。

sv的知识点总结

sv的知识点总结Key Concepts of Supervised Learning:1. Data: In supervised learning, the dataset consists of input features and corresponding output labels. The input features could be any type of data, such as images, text, speech, or numerical values, while the output labels are the target variable that the algorithm is trying to predict.2. Training and Testing Data: The dataset is split into a training set and a testing set. The training set is used to train the algorithm, while the testing set is used to evaluate its performance on new, unseen data.3. Model: The model is the algorithm that is used to learn from the training data and make predictions. There are many different types of models used in supervised learning, such as linear regression, logistic regression, decision trees, support vector machines, and neural networks.4. Loss Function: The loss function is a measure of how well the model is performing. It quantifies the difference between the predicted output and the actual output, and the goal of the learning algorithm is to minimize this difference.5. Learning Algorithm: The learning algorithm is the method used to update the model's parameters in order to minimize the loss function. This typically involves using techniques such as gradient descent or backpropagation to adjust the model's weights and biases.6. Evaluation Metrics: There are several metrics used to evaluate the performance of a supervised learning model, such as accuracy, precision, recall, F1 score, and area under the ROC curve (AUC). These metrics can help determine how well the model is performing and whether it is suitable for the intended application.Key Techniques of Supervised Learning:1. Regression: Regression is a type of supervised learning in which the goal is to predict a continuous output variable. Some common regression techniques include linear regression, polynomial regression, and support vector regression.2. Classification: Classification is a type of supervised learning in which the goal is to predicta discrete output variable, such as a category or label. Some common classification techniques include logistic regression, decision trees, random forests, support vector machines, and neural networks.3. Feature Engineering: Feature engineering involves transforming the input data into a format that is more suitable for the learning algorithm. This can involve scaling, normalization, dimensionality reduction, and creating new features based on the existing data.4. Cross-Validation: Cross-validation is a technique used to assess the performance of a supervised learning model. It involves splitting the training data into multiple subsets, training the model on each subset, and evaluating its performance on the remaining data. This can help determine how well the model generalizes to new, unseen data.5. Hyperparameter Tuning: Hyperparameters are the settings of the learning algorithm that are not learned from the training data, such as the learning rate, regularization strength, and the number of hidden layers in a neural network. Hyperparameter tuning involves finding the best configuration of these settings to optimize the model's performance.Applications of Supervised Learning:1. Image Recognition: Supervised learning is used in image recognition tasks, such as identifying objects in a photo, detecting anomalies in medical images, and classifying satellite images for environmental monitoring.2. Speech Recognition: Speech recognition systems use supervised learning to transcribe spoken language into text, and to recognize spoken commands for virtual assistants and smart home devices.3. Natural Language Processing: Supervised learning is used in natural language processing tasks, such as sentiment analysis, machine translation, and named entity recognition.4. Financial Forecasting: Supervised learning is used in finance to predict stock prices, detect fraudulent transactions, and assess credit risk.5. Healthcare: Supervised learning is used in healthcare to diagnose diseases from medical imaging, predict patient outcomes, and personalize treatment plans based on patient data. Limitations of Supervised Learning:1. Data Quality: Supervised learning models are highly dependent on the quality and representativeness of the training data. If the data is biased, noisy, or incomplete, the model's predictions may be inaccurate or unreliable.2. Overfitting: Overfitting occurs when a model performs well on the training data but poorly on new, unseen data. This can happen if the model is too complex, if it is trained on too little data, or if the training data is not representative of the full range of inputs.3. Interpretability: Some supervised learning models, such as neural networks, can be difficult to interpret and understand why they make particular predictions. This can be a limitation in applications where the decision-making process needs to be transparent and explainable.4. Limited Generalization: Supervised learning models may not generalize well to new, unseen data if the training data is not diverse enough, or if the model is too specialized to the training set.In conclusion, supervised learning is a powerful and versatile approach to solving a wide range of prediction and classification problems. It has many practical applications in fields such as image recognition, speech recognition, natural language processing, finance, and healthcare. However, it also has limitations, such as its reliance on high-quality training data, the potential for overfitting, and challenges in interpreting complex models. By understanding the key concepts, techniques, and applications of supervised learning, practitioners can make informed decisions about when and how to deploy this approach to address real-world problems.。

streamlit best practice -回复

streamlit best practice -回复Streamlit是一个用于快速创建数据科学和机器学习应用程序的Python 库。

它的设计理念是简单、易于使用,同时提供强大的功能。

在本文中,我将分享Streamlit的最佳实践,以帮助读者充分利用这个强大的工具。

Streamlit的介绍Streamlit是一种开源的Python库,通过简单的语法和直观的界面,让用户能够快速创建交互式应用程序。

它主要用于数据科学家和机器学习工程师在进行数据分析和模型部署时的交流和展示。

Streamlit的最佳实践1. 保持代码简洁Streamlit的一个重要原则是保持代码的简洁和可读性。

因此,在编写Streamlit应用程序时,应遵循良好的编程实践,例如避免冗余代码,合理命名变量和函数等。

此外,可以使用注释来解释代码的功能和意图,以便阅读代码的人能够更好地理解。

2. 利用缓存功能提高性能Streamlit提供了一个名为`st.cache`的装饰器,可用于缓存结果以提高应用程序的性能。

通过使用这个装饰器,可以避免在每次执行应用程序时重复计算相同的结果。

只有当输入参数发生变化时,缓存的结果才会失效。

这对于耗时的计算或数据加载任务特别有用。

3. 使用布局和容器组织应用程序Streamlit提供了多种布局和容器选项,可用于组织和呈现应用程序的不同部分。

例如,可以使用`st.container`创建一个具有自定义样式的容器。

通过适当地使用布局和容器,可以使应用程序的界面更加直观和易于导航。

4. 添加交互式部件增强用户体验Streamlit提供了许多交互式部件(widgets),如滑块条、下拉菜单和复选框等,用于与用户进行交互。

这些部件可以通过简单的函数调用来添加到应用程序中,并根据用户的输入来改变应用程序的行为。

通过合理地使用这些部件,可以增强应用程序的用户体验。

5. 使用Markdown和图表进行数据可视化Streamlit支持使用Markdown格式的文本和常见的数据可视化库(如Matplotlib和Plotly)来更好地展示和解释数据。

python logisticregression 参数

在Python中,我们可以使用多种库来进行逻辑回归,其中最常用的是scikit-learn。

scikit-learn的LogisticRegression类提供了许多参数来调整模型的行为。

以下是一些常用的参数:1.penalty:这是用于指定正则化类型的参数。

它可以是'l1','l2' 或'elastic_net'。

默认是'l2',也就是L2正则化。

2.C:这是正则化强度的倒数。

C值越大,正则化越弱。

默认值是1.0。

3.dual:如果为True,则求解对偶问题而不是原始问题。

默认是False。

4.tol:优化算法的收敛容忍度。

默认值是1e-4。

5.multi_class:当设置为'auto'时,算法会自动选择是使用"one-vs-rest"还是"multinomial"方法。

默认是'auto'。

6.max_iter:最大迭代次数。

默认是100。

7.class_weight:指定如何计算样本权重。

它可以是'balanced','auto',或者是一个字典,字典的键是类标签,值是对应的样本权重。

默认是None。

8.random_state:随机数生成器的种子。

默认是None。

9.solver:优化问题的求解器。

可以是'newton-cg','lbfgs','liblinear','sag'或'saga'。

默认是'liblinear'。

10.verbose:控制是否打印进度消息。

默认是0。

11.n_jobs:并行运行的CPU数量(在所有核心上)。

默认是None(取决于环境)。

12.pre_dispatch:用于控制预分配多少任务给子进程(对于并行化)。

pytorch面试知识点

PyTorch面试知识点PyTorch是一个基于Torch的开源机器学习库,它提供了一个灵活的深度学习开发框架,因此在面试中对于PyTorch的了解是非常重要的。

下面是一些PyTorch面试中可能会涉及到的知识点。

1. 张量(Tensor)张量是PyTorch中最基本的数据结构,它类似于NumPy中的多维数组。

面试官可能会问你张量的创建方法、操作和索引等相关知识点。

以下是一些常见的张量操作:•创建一个张量:可以使用torch.tensor()函数创建一个新的张量。

还可以使用其他函数如torch.zeros(), torch.ones(), torch.randn()等来创建特定类型的张量。

•张量的操作:PyTorch提供了一系列的张量操作函数,如torch.add(), torch.matmul(), torch.transpose()等。

你应该熟悉这些函数的用法。

•张量的索引:与NumPy类似,你可以使用索引和切片来访问张量的元素。

同时,你还可以使用torch.masked_select()函数根据条件选择张量中的元素。

2. 自动求导(Autograd)PyTorch中的自动求导是其最重要的特性之一,它允许你在模型训练过程中自动计算梯度。

在面试中,你可能会被问到什么是自动求导、如何计算梯度以及如何使用PyTorch的自动求导功能。

以下是一些与自动求导相关的知识点:•自动求导机制:PyTorch使用动态图来实现自动求导。

你可以通过将requires_grad属性设置为True来追踪张量的操作,并使用backward()函数计算梯度。

•梯度计算:PyTorch使用反向传播算法来计算梯度。

你可以通过调用backward()函数在计算图上的某个节点上计算梯度。

•torch.no_grad()上下文管理器:有时候你可能需要在不计算梯度的情况下对张量进行操作。

在这种情况下,你可以使用torch.no_grad()上下文管理器来关闭自动求导功能。

rf默认值用法

rf默认值用法在机器学习中,RF(Random Forest)指的是随机森林算法,它是一种集成学习方法,由多个决策树组成。

在RF算法中,有一些超参数可以用来调整模型的性能和行为。

其中一个常用的超参数是"默认值"(default value),它表示在没有明确指定参数值时,算法会采用的默认选项。

对于不同的机器学习库和框架,RF算法的超参数的默认值会有所不同。

以下是一些常见的RF算法超参数及其默认值的示例:1.n_estimators:指决策树的数量,默认值为100。

2.criterion:指定用于衡量每个决策树分裂的质量指标,默认值为"gini"。

另一个常用选项是"entropy"。

3.max_depth:指定每个决策树的最大深度,默认值为None,表示无限制。

4.min_samples_split:指定进行分裂所需的最小样本数量,默认值为2。

5.min_samples_leaf:指定每个叶节点所需的最小样本数量,默认值为1。

在使用RF算法时,可以根据具体任务和数据集的特点,选择调整超参数的值。

如果未指定超参数值,则算法将使用默认值。

以下是使用Python中scikit-learn机器学习库的RF算法的示例,演示了如何使用默认值创建和训练一个随机森林模型:from sklearn.ensemble import RandomForestClassifierfrom sklearn.datasets import load_iris# 从sklearn加载iris数据集iris = load_iris()X = iris.datay = iris.target# 创建RF分类器模型并训练rf_model = RandomForestClassifier()rf_model.fit(X, y)在上述示例中,RandomForestClassifier的超参数没有进行显式设置,因此将使用RF算法的默认值。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

SAP AG

Customers Beverage

Manufacturer/Wholesaler

G92 Direct Customer C4+++ “Hierarchy”

G70, G72, G92, G93, G94

G70 G65, G66, n G64 Direct Customer C6501 “Cash Payer”

all

SAP AG 2007

Alcoholic Beverage Materials

Material Number Material Type Trading good Trading Good (HAWA) Trading good Empty Scenario

B40120 Colonia Beer B40220 Bavarian Beer

The information in this document is proprietary to SAP. No part of this document may be reproduced, copied, or transmitted in any form or for any purpose without the express prior written permission of SAP AG. This document is a preliminary version and not subject to your license agreement or any other agreement with SAP. This document contains only intended strategies, developments, and functionalities of the SAP® product and is not intended to be binding upon SAP to any particular course of business, product strategy, and/or development. Please note that this document is subject to change and may be changed by SAP at any time without notice. SAP assumes no responsibility for errors or omissions in this document. SAP does not warrant the accuracy or completeness of the information, text, graphics, links, or other items contained within this material. This document is provided without a warranty of any kind, either express or implied, including but not limited to the implied warranties of merchantability, fitness for a particular purpose, or non-infringement. SAP shall have no liability for damages of any kind including without limitation direct, special, indirect, or consequential damages that may result from the use of these materials. This limitation shall not apply in cases of intent or gross negligence. The statutory liability for personal injury and defective products is not affected. SAP has no control over the information that you may access through the use of hot links contained in these materials and does not endorse your use of third-party Web pages nor provide any warranty whatsoever relating to third-party Web pages

SAP AG 2007

Wholesaler C10110 G66 G72, G92

Wholesaler C10120

Wholesaler C10130

G72 Indirect Customer C7503 Object Owner

Direct Customer C6502 Object “Bar”

G64, G65, G66, G70, G72, G93 G65, G66

B40320 Franconia Beer B70210 (crate 20 x 0.5 Liter) B70220 (bottle 0,5l)

G64, G66 all

Empty

all

SAP AG 2007

Materials Beverage

Direct Customer C6503 Object Owner

Indirect Customer C7502 Object “Restaurant”

Non-Alcoholic Beverage Materials

Material Number Material Type Scenario

B30120 lemon soda

G65

SAP AG 2007

Vendors Beverage

Vendor C2000 Scenario G65

C7000 C7010 C7020 C7110 C8500

G94 G82 G84 G81, G94, G65, G76 G65

SAP AG 2007

Other Master Data

Finished Good Trading Good

G64, G66, G70, G72, G93

B30220 orange soda

G64, G66, G72

B70110 Crate 12 x 0.7 Liter B70120: Bottle 0.7 liter

Empty Good

All

Empty Good

Material Number Material Type Scenario

B40420 Super Beer

Finished good

G65, Gtracting Material Packaging Tank Beer

G65

B70130 Can

Master Data Type Driver C6611 Vehicle F6011

Scenario G70 G70

SAP AG 2007

Copyright 2007 SAP AG. All Rights Reserved

No part of this publication may be reproduced or transmitted in any form or for any purpose without the express permission of SAP AG. The information contained herein may be changed without prior notice. Some software products marketed by SAP AG and its distributors contain proprietary software components of other software vendors. Microsoft, Windows, Outlook, and PowerPoint are registered trademarks of Microsoft Corporation. IBM, DB2, DB2 Universal Database, OS/2, Parallel Sysplex, MVS/ESA, AIX, S/390, AS/400, OS/390, OS/400, iSeries, pSeries, xSeries, zSeries, z/OS, AFP, Intelligent Miner, WebSphere, Netfinity, Tivoli, and Informix are trademarks or registered trademarks of IBM Corporation in the United States and/or other countries. Adobe, the Adobe logo, Acrobat, PostScript, and Reader are either trademarks or registered trademarks of Adobe Systems Incorporated in the United States and/or other countries Oracle is a registered trademark of Oracle Corporation. UNIX, X/Open, OSF/1, and Motif are registered trademarks of the Open Group. Citrix, ICA, Program Neighborhood, MetaFrame, WinFrame, VideoFrame, and MultiWin are trademarks or registered trademarks of Citrix Systems, Inc. HTML, XML, XHTML and W3C are trademarks or registered trademarks of W3C®, World Wide Web Consortium, Massachusetts Institute of Technology. Java is a registered trademark of Sun Microsystems, Inc. JavaScript is a registered trademark of Sun Microsystems, Inc., used under license for technology invented and implemented by Netscape. MaxDB is a trademark of MySQL AB, Sweden. SAP, R/3, mySAP, , xApps, xApp, SAP NetWeaver and other SAP products and services mentioned herein as well as their respective logos are trademarks or registered trademarks of SAP AG in Germany and in several other countries all over the world. All other product and service names mentioned are the trademarks of their respective companies. Data contained in this document serves informational purposes only. National product specifications may vary.