思科负载均衡产品介绍-Introduction to Load Balancing

cisco6509 ACE负载均衡主备切换方案

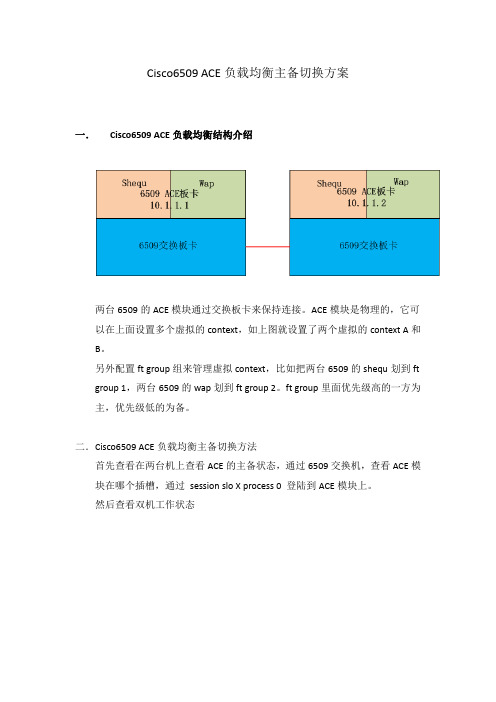

Cisco6509 ACE负载均衡主备切换方案一.Cisco6509 ACE负载均衡结构介绍两台6509的ACE模块通过交换板卡来保持连接。

ACE模块是物理的,它可以在上面设置多个虚拟的context,如上图就设置了两个虚拟的context A和B。

另外配置ft group组来管理虚拟context,比如把两台6509的shequ划到ft group 1,两台6509的wap划到ft group 2。

ft group里面优先级高的一方为主,优先级低的为备。

二.Cisco6509 ACE负载均衡主备切换方法首先查看在两台机上查看ACE的主备状态,通过6509交换机,查看ACE模块在哪个插槽,通过session slo X process 0 登陆到ACE模块上。

然后查看双机工作状态主备切换方法:1.如果开启了抢占模式,通过修改优先级来切换主备。

2.如果没开启抢占模式,可以通过以下命令进行主备切换:双机切换可以以context为单位,X代表group id。

ft switchover X (将备机切为主机)ft switchover X (强制切换主备)ft switchover all (所有context都切换主备)三.ACE模块配置实例。

switch/Admin# sh runGenerating configuration....logging enablelogging timestamplogging history 5logging buffered 5logging persistent 3logging monitor 4peer hostname ACE-hotboot system image:c6ace-t1k9-mz.A4_1_0.binssh maxsessions 3resource-class resourcealllimit-resource all minimum 0.50 maximum unlimitedlimit-resource sticky minimum 30.00 maximum unlimitedclock timezone standard WSTcontext Adminmember resourceallclass-map type management match-any manage2 match protocol http any3 match protocol icmp any4 match protocol ssh any5 match protocol snmp any6 match protocol telnet anypolicy-map type management first-match behavior_manage class managepermitpolicy-map multi-match app-policytimeout xlate 60ft interface vlan 10ip address 10.1.1.1 255.255.255.0peer ip address 10.1.1.2 255.255.255.0no shutdownft peer 1heartbeat interval 100heartbeat count 10ft-interface vlan 10ft group 3peer 1priority 150peer priority 50associate-context Admininservicecontext shequ-aceallocate-interface vlan 200allocate-interface vlan 700-703allocate-interface vlan 705-711allocate-interface vlan 900member resourceallcontext wap-aceallocate-interface vlan 801allocate-interface vlan 806-807allocate-interface vlan 809-810member resourceallft group 1peer 1priority 150peer priority 50associate-context shequ-aceinserviceft group 2peer 1priority 150peer priority 50associate-context wap-aceinserviceusername admin password 123456 role Admin domain default-domain ssh key rsa 1024 forceswitch/Admin#。

负载均衡器部署方式和工作原理

负载均衡器部署方式和工作原理2011/12/16 小柯信息安全在现阶段企业网中,只要部署WEB应用防火墙,一般能够遇到负载均衡设备,较常见是f5、redware的负载均衡,在负载均衡方面f5、redware的确做得很不错,但是对于我们安全厂家来说,有时候带来了一些小麻烦。

昨日的一次割接中,就遇到了国内厂家华夏创新的负载均衡设备,导致昨日割接失败。

在本篇博客中,主要对负载均衡设备做一个介绍,针对其部署方式和工作原理进行总结。

概述负载均衡(Load Balance)由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。

在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。

负载均衡实现方式分类1:软件负载均衡技术该技术适用于一些中小型网站系统,可以满足一般的均衡负载需求。

软件负载均衡技术是在一个或多个交互的网络系统中的多台服务器上安装一个或多个相应的负载均衡软件来实现的一种均衡负载技术。

软件可以很方便的安装在服务器上,并且实现一定的均衡负载功能。

软件负载均衡技术配置简单、操作也方便,最重要的是成本很低。

2:硬件负载均衡技术由于硬件负载均衡技术需要额外的增加负载均衡器,成本比较高,所以适用于流量高的大型网站系统。

不过在现在较有规模的企业网、政府网站,一般来说都会部署有硬件负载均衡设备(原因1.硬件设备更稳定,2.也是合规性达标的目的)硬件负载均衡技术是在多台服务器间安装相应的负载均衡设备,也就是负载均衡器来完成均衡负载技术,与软件负载均衡技术相比,能达到更好的负载均衡效果。

3:本地负载均衡技术本地负载均衡技术是对本地服务器群进行负载均衡处理。

该技术通过对服务器进行性能优化,使流量能够平均分配在服务器群中的各个服务器上,本地负载均衡技术不需要购买昂贵的服务器或优化现有的网络结构。

load balancers 轮询规则

load balancers 轮询规则load balancers(负载均衡器)是一种常见的网络设备,用于将传入的网络流量分配到多个服务器上,以实现高可用性和提高性能。

轮询规则是load balancers中一种常见的负载均衡算法,其工作原理是依次将请求分配给每个服务器,以达到负载均衡的效果。

本文将介绍轮询规则在load balancers中的作用、优点和局限性,并对其应用场景进行探讨。

轮询规则是一种简单而直观的负载均衡算法。

它将请求按照顺序依次分配给每个服务器,确保每台服务器都能够处理一定比例的请求。

这种分配方式可以充分利用服务器资源,提高整体的处理能力。

同时,轮询规则不需要额外的计算和存储开销,对于负载较轻的环境来说,是一种高效且成本较低的负载均衡方案。

轮询规则具有较好的可扩展性。

在新增服务器或移除服务器时,轮询规则可以自动适应,并将请求平均地分配给所有可用的服务器。

这种灵活性使得轮询规则在动态环境下能够快速响应变化,保持系统的稳定性和可用性。

同时,轮询规则还可以根据服务器的处理能力进行权重设置,以实现更加精确的负载均衡。

然而,轮询规则也存在一些局限性。

首先,它无法根据服务器的实际负载情况进行动态调整,可能会导致部分服务器负载过高而影响系统性能。

其次,轮询规则无法考虑服务器的网络延迟和处理速度差异,可能导致某些服务器处理时间过长而影响用户体验。

此外,轮询规则也无法解决服务器故障或网络异常等问题,需要配合其他机制进行故障恢复和容错处理。

针对上述局限性,可以通过引入其他负载均衡算法来进行改进。

例如,可以结合权重算法和健康检查机制,将请求优先分配给负载较轻的服务器,并实时监测服务器的健康状态,及时移除异常服务器,提高系统的稳定性和可用性。

此外,还可以结合会话保持机制,确保用户的请求在同一服务器上处理,以避免会话状态的丢失。

在实际应用中,轮询规则适用于负载均衡要求不高的场景,例如静态网页的访问、文件下载等。

(完整版)LTEMLB负载均衡功能介绍

移动性负载均衡(MLB应用场景分析一、概述随着LTE用户数的快速发展,部分小区的用户数或PRB利用率已接近容量极限,然后其他小区的资源使用率却很低,如何平衡同覆盖或存在重叠覆盖区域的小区间的负载是一个极有意义的课题。

移动性负载均衡(| Mobility Load Balancing ,简称为负载均衡MLB是指eNodeB判断小区的负载状态,当小区处于高负载状态时,将负载高小区中部分UE转移到负载低的小区,平衡异频或异系统之间的负载。

二、负载均衡原理介绍移动性负载均衡(Mobility Load Balancing ,简称为负载均衡MLB是指eNodeB判断小区的负载状态,当小区处于高负载状态时,将负载高小区中部分UE转移到负载低的小区,平衡异频或异系统之间的负载。

Target cell (f2)负载平衡分为触发模式、选择目标小区、负载均衡执行三个阶段。

根据这三个维度可划分为以下各种类型:MLB 目的2.1触发模式负载均衡根据触发模式可以分为空闲态UE预均衡、同步态用户数负载均衡、PRB利用率/PRB评估值负载均衡、下行数传用户数负载均衡等模式,现阶段实现主要负载标准为PRB利用率、同步态用户数、UE预均衡。

2.1.1基于PRB利用率的触发模式启动基于PRB利用率的负载均衡后,eNodeB以每秒为周期测量小区PRB利用率和小区同步态用户数。

若连续5秒内同时满足以下条件,则触发基于PRB利用率的负载均衡。

小区某类PRB利用率》InterFreqMlbThd +LoadOffet小区同步态用户数》MlbMi nU eNumThd +MlbMi nU eNumOffset对于同一方向,小区PRB利用率状态判决的顺序依次为:GBR业务、Non-GBR业务、Total业务。

上下行独立判决,互不影响。

负载均衡触发类型为判决满足负载平衡触发条件的PRB利用率类型,负载平衡触发方向为判决满足负载平衡触发条件的上行/下行方向。

loadbalance(负载均衡)

loadbalance(负载均衡)

https:///s?id=1634386941492502616& wfr=spider&for=pc

https:///fanBlog/p/10936190.html

负载均衡是要在网络传输中做文章的

网站访问量已经越来越大,响应速度越来越慢。

考虑:

Scale Up(也就是Scale vertically)纵向扩展,向上扩展:机器硬件升级,增加配置,如添加CPU、内存。

(往往需要购置新机器)–>旧机器不能利用上。

Scale Out(也就是Scale horizontally)横向扩展,向外扩展:向原有的web、邮件系统添加一个新机器。

–>旧机器仍然可以发挥作用。

负载均衡技术为 scale out 服务。

网络负载均衡是由多台服务器以对称的方式组成一个服务器集合,每台服务器都具有等价的地位,都可以单独对外提供服务而无须其他服务器的辅助。

通过某种负载分担技术,将外部发送来的请求均匀分配到对称结构中的某一台服务器上,而接收到请求的服务器独立地回应客户的请求。

均衡负载能够平均分配客户请求到服务器列阵,借此提供快速获取重要数据,解决大量并发访问服务问题。

网络负载均衡( Load balance)主要用于扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能

力、提高网络的灵活性和可用性,保证即使是在负载很重的情况下它们也能作出快速响应,保证服务不中断。

网络负载均衡可以让客户端用一个逻辑 Internet名称和虚拟IP地址(又称群集IP地址)访问群集,同时保留每台计算机各自的名称。

负载均衡load balance的英文缩写

负载均衡load balance的英文缩写Title: Load Balance (LB): The Cornerstone of Efficient Resource ManagementIntroductionIn the realm ofputing and networking, one term that frequently crops up is "Load Balance" or LB for short. This concept plays a pivotal role in optimizing resource utilization, enhancing system performance, and ensuring fault tolerance. In this article, we will delve into the intricacies of load balancing, its significance, and how it contributes to efficient resource management.What is Load Balancing?Load balancing refers to the methodical distribution of network traffic across multiple servers to optimize resource utilization, enhance responsiveness, and avoid overloading any single server. It is an essentialponent of fault-tolerant systems as it ensures that no single point of failure exists.The Importance of Load BalancingThe importance of load balancing can be summed up in three main points:1. Improved Performance: By distributing the workload evenly across multiple servers, each server operates within its optimal capacity, leading to better overall system performance.2. Enhanced Availability: If one server fails or needs maintenance, the load balancer redirects traffic to other available servers, thereby ensuring continuous service availability.3. Scalability: As the demand for services increases, new servers can be added to the system without disrupting existing services. This allows for easy expansion and scalability of the system.How does Load Balancing Work?Load balancing typically involves the use of a software or hardware device called a load balancer. The load balancer acts as a traffic cop, directing client requests to the various backend servers based on certain predefined algorithms and policies. These algorithms may consider factors such as server availability, server load, geographic location, or specific application requirements.Types of Load Balancing AlgorithmsThere are several types of load balancing algorithms, including:1. Round Robin: Each iing request is assigned to the next available server in a rotation.2. Least Connections: New requests are sent to the server with the fewest active connections.3. IP Hash: A hash function is used to determine which server should handle a request based on the client's IP address.4. Weighted Algorithms: Servers are assigned weights based on their processing power or capacity, and requests are distributed accordingly.ConclusionLoad balancing (LB) is a crucial aspect of modernputing and networking infrastructure. Its ability to distribute workloads efficiently, ensure high availability, and facilitate scalability makes it an indispensable tool for managing resources effectively. Understanding the concepts and mechanisms behind load balancing can help organizations make informed decisions about their IT infrastructure and improve the overall user experience.。

负载均衡(LoadBalance)技术介绍网络服务器-电脑资料

负载均衡(LoadBalance)技术介绍网络服务器-电脑资料大型网络服务商在提供网络服务时,会遇到一些并发请求量很大的情况,电影网站是其中较为典型的一个服务案例,。

比如某些热门影片资源服务器服务或者是在服务高峰期的影片资源服务器都会遇到大并发的请求量。

这时,SERVICE会接收到大量客户端,甚至长时间的大型网络服务商在提供网络服务时,会遇到一些并发请求量很大的情况,电影网站是其中较为典型的一个服务案例。

比如某些热门影片资源服务器服务或者是在服务高峰期的影片资源服务器都会遇到大并发的请求量。

这时,SERVICE会接收到大量客户端,甚至长时间的请求,对service,甚至整个系统是严峻的考验。

遇到这种情况,单个的server往往难以应付,或者性能不好,我们就想到负载均衡,下面笔者根据自己在使用VIEWGOOD流媒体平台过程中的结果对相关的问题进行一些探讨。

负载均衡(Load Balance)由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。

在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。

针对此情况而衍生出来的一种廉价有效透明的方法以扩展现有网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性的技术就是负载均衡(Load Balance)。

各种软件使用的负载均衡策略都不尽相同,在这里,我们以VIEWGOOD的流媒体平台WebMedia为例,具体直观的说明一下关于电影网站的如何实现负载均衡。

在VIEWGOOD的流媒体平台系统中,不需要单独的负载平衡服务器,WEB服务器的负载平衡由WEB服务器自己承担,而点播、直播服务器的负载平衡由负载平衡服务器(与认证计费服务器共用)承担。

交换机负载均衡配置 [Cisco交换机STP负载均衡配置步骤]

![交换机负载均衡配置 [Cisco交换机STP负载均衡配置步骤]](https://img.taocdn.com/s3/m/e7bcf9f80b4e767f5bcfcee5.png)

交换机负载均衡配置[Cisco交换机STP负载均衡配置步骤]Cisco自己开发的PVST、PVST+和Rapid-PVST+l因为是基于VLAN分配生成树实例的,所以它不仅可以实现比IEEE802.1D标准的STP更快的收敛速度,而且还可以实现负载均衡。

接下来是小编为大家收集的Cisco交换机STP负载均衡配置步骤方法,希望能帮到大家。

Cisco交换机STP负载均衡配置步骤的方法CiscoIOS交换机生成树负载均衡配置示例在第11章,我们已了解到,Cisco自己开发的PVST、PVST+和Rapid-PVST+l因为是基于VLAN分配生成树实例的,所以它不仅可以实现比IEEE802.1D标准的STP更快的收敛速度,而且还可以实现负载均衡。

为了避免环路,PVST、PVST+和Rapid-PVST+l仅会在交换机间的一条中继链路对特定VLAN通信激活,其他的都会被全部阻止,以实现在多个中继端口上均衡VLAN通信。

在生成树VLAN通信均衡方案中,又可以通过使STP端口优先级或者STP路径开销在中继端口进行配置。

注意:对于使用STP端口优先级进行的负载均衡,负载均衡的多条中继链路必须与同一个交换机连接;对于使用STP路径开销进行的负载共享,每条用于负载均衡的中继链路可以连接到同一个交换机,也可以连接在两个不同的交换机上。

【说明】IEEE802.1sMSTP生成树模式中同样可以实现VLAN 通信负载均衡,而且同样有两种方案:一种是基于端口优先级的,另一种是基于端口路径开销值的。

但要注意的是,在MSTP 的负载均衡配置中均只需在中继链路的一端配置即可,与本节介绍的SST下的负载均衡配置中的端口优先级方案有些区别,但与端口开销值方案一样。

具体在本章最后介绍的PVST+到MSTP迁移配置示例中有体现。

使用STP端口优先级进行负载均衡的配置示例当在一个交换机上的两个端口形成环路时,交换机使用STP端口优先级来决定哪个端口是启用状态,哪个端口又是阻塞状态的。

loadbalancer 的负载均衡原理

loadbalancer 的负载均衡原理负载均衡是一种信息技术中常用的策略,用于均衡服务器、网络设备或计算资源的工作负载。

在互联网应用和服务端架构中,负载均衡是至关重要的一环,其主要作用是将网络请求合理地分发到不同的服务器上,以避免单一服务器过载,提高整体系统的性能与可靠性。

loadbalancer(负载均衡器)是一种专门设计用于处理负载均衡的设备或软件,其工作原理是将传入的网络请求分发到多个后端服务器上,以实现负载均衡的效果。

在应用层负载均衡中,负载均衡器会基于特定的策略来选择合适的后端服务器并分发请求。

负载均衡器的工作原理可以简要概括为以下几个步骤:1. 接收请求:当用户发送请求时,负载均衡器会首先接收并识别该请求。

这可以通过多种方式实现,例如使用Web服务器作为负载均衡器,或者使用专门的硬件设备。

2. 分析请求:负载均衡器会分析请求的特征,例如请求的目标地址、传输协议、请求负载等。

这些信息可以帮助负载均衡器确定如何选择后端服务器。

3. 选择目标服务器:基于预设的策略或算法,负载均衡器会从可用的后端服务器池中选择一台服务器作为目标。

选择的策略可以是轮询、最少连接数、响应时间等等。

4. 转发请求:一旦确定了目标服务器,负载均衡器会将请求转发给该服务器。

这可以是通过网络层的IP地址转发,也可以是在应用层通过代理服务器转发。

5. 返回响应:后端服务器处理请求并生成响应后,将响应返回给负载均衡器。

负载均衡器再将响应发送给原始请求的客户端。

整个过程中,负载均衡器会根据后端服务器的负载情况动态地调整目标服务器的选择,以保持负载的均衡状态。

此外,在负载均衡中通常还会实现一些监测机制,用于检测后端服务器的健康状态,以便及时排除故障或故障服务器。

总之,负载均衡器通过分发请求到多个后端服务器上,以实现负载均衡、提高可用性和性能的目标。

它是构建高可靠、高性能网络架构的重要组成部分。

负载均衡详解

负载均衡(Load Balance)由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。

在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。

负载均衡(又称为负载分担),英文名称为Load Balance,其意思就是将负载(工作任务)进行平衡、分摊到多个操作单元上进行执行,例如Web服务器、FTP服务器、企业关键应用服务器和其它关键任务服务器等,从而共同完成工作任务。

负载均衡建立在现有网络结构之上,它提供了一种廉价又有效的方法扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。

需要说明的是:负载均衡设备不是基础网络设备,而是一种性能优化设备。

对于网络应用而言,并不是一开始就需要负载均衡,当网络应用的访问量不断增长,单个处理单元无法满足负载需求时,网络应用流量将要出现瓶颈时,负载均衡才会起到作用。

负载均衡有两方面的含义:首先,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高,这就是我们常说的集群(clustering)技术。

第二层含义就是:大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间,这主要针对Web服务器、FTP服务器、企业关键应用服务器等网络应用。

通常,负载均衡会根据网络的不同层次(网络七层)来划分。

其中,第二层的负载均衡指将多条物理链路当作一条单一的聚合逻辑链路使用,这就是链路聚合(Trunking)技术,它不是一种独立的设备,而是交换机等网络设备的常用技术。

现代负载均衡技术通常操作于网络的第四层或第七层,这是针对网络应用的负载均衡技术,它完全脱离于交换机、服务器而成为独立的技术设备。

怎么设置Cisco路由多链路负载均衡

怎么设置Cisco路由多链路负载均衡思科公司已成为公认的全世界网络互联解决方案的领先厂商,其公司出产的一系列路由器更是引领世界,那么你知道怎么设置Cisco 路由多链路负载均衡吗?下面是店铺整理的一些关于怎么设置Cisco路由多链路负载均衡的相关资料,供你参考。

设置Cisco路由多链路负载均衡的方法基于策略的路由允许应用一个策略控制数据包应如何走而非基于路由表选路。

IP路由基于目标地,而PBR允许基于源的路由,即来自何处而应到哪去,从而根据需要走一条特殊的路径。

在网络中实施基于策略的路由有以下优点1、基于源的供应商选择:通过策略路由使源于不同用户组的数据流选择经过不同的Internet连接。

2、服务质量:可以通过在网络边缘路由器上设置IP数据包包头中的优先级或TOS值,并利用队列机制在网络核心或主干中为数据流划分不同的优先级,来为不同的数据流提供不同级别的QoS。

3、负载均衡:网络管理员可以通过策略路由在多条路径上分发数据流。

4、网络管理更加灵活。

双出口配置实例1、R1连接本地子网,R2为边缘策略路由器,R3模拟双ISP接入的Internet环境。

2、要求R1所连接的局域网部分流量走R2-R3间上条链路(ISP1链路),部分流量走R2-R3间下条链路(ISP2链路)从而实现基于源的供应商链路选择和网络负载均衡。

R1#sh run //路由器R1的配置……interface Loopback0 //模拟子网一:192.168.1.0/24ip address 192.168.1.1 255.255.255.0 //模拟子网中第一台主机ip address 192.168.1.2 255.255.255.0 secondary //模拟子网中第二台主机!interface Loopback2 //模拟子网二:192.168.2.0/24 ip address 192.168.2.1 255.255.255.0ip address 192.168.2.2 255.255.255.0 secondary!interface FastEthernet0/0ip address 12.0.0.1 255.255.255.0duplex half!……!router rip //通过RIP协议配置网络的连通性version 2network 192.168.1.0network 192.168.1.0network 12.0.0.0……end-----------------------------R3#sh run //路由器R3的配置Building configuration...……interface Loopback0 //模拟一个连接目标description to internetip address 100.100.100.100 255.255.255.0!interface Serial1/1 //模拟ISP1的接入端口ip address 123.0.0.3 255.255.255.0serial restart-delay 0……interface Serial1/3 //模拟ISP2的接入端口ip address 223.0.0.3 255.255.255.0serial restart-delay 0!router ripversion 2network 100.0.0.0network 123.0.0.0network 223.0.0.0no auto-summary!……end---------------------------------------------------------------------------------R2#sh run //策略路由器R2的配置Building configuration...……interface FastEthernet0/0ip address 12.0.0.2 255.255.255.0ip policy route-map isp-test //在接口上启用策略路由isp-test 进行流量控制duplex half!……interface Serial1/1ip address 123.0.0.1 255.255.255.0serial restart-delay 0interface Serial1/3ip address 223.0.0.1 255.255.255.0serial restart-delay 0……router ripversion 2network 12.0.0.0network 123.0.0.0network 223.0.0.0no auto-summary……logging alarm informationalaccess-list 101 permit ip 192.168.1.0 0.0.0.255 host 100.100.100.100 //访问控制列表101,用于过滤原地址,允许子网192.168.1.0流量通过 */access-list 102 permit ip 192.168.2.0 0.0.0.255 host 100.100.100.100 //访问控制列表102,用于过滤原地址,允许子网192.168.2.0流量通过 */!route-map isp-test permit 10 //定义route-map,取名为isp-test,序列为10match ip address 101 //检查源地址,匹配acl 101set ip default next-hop 123.0.0.3 //指定下一跳地址!route-map isp-test permit 20 //定义isp-test的第二条语句,序列号为20match ip address 102 //检查源地下,匹配acl102set ip default next-hop 223.0.0.3!route-map isp-test permit 30 //定义isp-test的第三条语句,序列号为30set default interface Null0 //丢弃不匹配规定标准的包……end---------------------------------------------------------------------------------R2#sh ip policy //显示应用的策略Interface Route mapFa0/0 isp-accR2#sh route-map isp-test //显示配置的路由映射图route-map isp-test, permit, sequence 10Match clauses:ip address (access-lists): 101Set clauses:ip default next-hop 123.0.0.3Policy routing matches: 0 packets, 0 bytesroute-map isp-test, permit, sequence 20Match clauses:ip address (access-lists): 102Set clauses:ip default next-hop 223.0.0.3Policy routing matches: 0 packets, 0 bytesroute-map isp-test, permit, sequence 30Match clauses:Set clauses:default interface Null0Policy routing matches: 0 packets, 0 bytes====================================== ==================================R1#traceroute //路由跟踪Protocol [ip]: //ip流量Target IP address: 100.100.100.100 //目标地Source address: 192.168.1.1 //源地址为子网一的第一台主机Numeric display [n]:Timeout in seconds [3]:Probe count [3]:Minimum Time to Live [1]:Maximum Time to Live [30]:Port Number [33434]:Loose, Strict, Record, Timestamp, Verbose[none]:Type escape sequence to abort.Tracing the route to 100.100.100.1001 12.0.0.2 72 msec 216 msec 276 msec2 123.0.0.3 288 msec 360 msec * //ISP1入口-------------------------------------------------------------------------------R1# tracerouteProtocol [ip]:Target IP address: 100.100.100.100Source address: 192.168.1.2 //源地址为子网一的第二台主机Numeric display [n]:Timeout in seconds [3]:Probe count [3]:Minimum Time to Live [1]:Maximum Time to Live [30]:Port Number [33434]:Loose, Strict, Record, Timestamp, Verbose[none]:Type escape sequence to abort.Tracing the route to 100.100.100.1001 12.0.0.2 92 msec 188 msec 52 msec2 123.0.0.3 416 msec 436 msec * //ISP1入口----------------------------------------------------------------------------------R1#tracerouteProtocol [ip]:Target IP address: 100.100.100.100Source address: 192.168.2.1 //源地址为子网二的第一台主机Numeric display [n]:Timeout in seconds [3]:Probe count [3]:Minimum Time to Live [1]:Maximum Time to Live [30]:Port Number [33434]:Loose, Strict, Record, Timestamp, Verbose[none]:Type escape sequence to abort.Tracing the route to 100.100.100.1001 12.0.0.2 136 msec 40 msec 144 msec2 223.0.0.3 356 msec * 132 msec //ISP2入口---------------------------------------------------------R1#tracerouteProtocol [ip]:Target IP address: 100.100.100.100Source address: 192.168.2.2 //源地址为子网二中第二台主机Numeric display [n]:Timeout in seconds [3]:Probe count [3]:Minimum Time to Live [1]:Maximum Time to Live [30]:Port Number [33434]:Loose, Strict, Record, Timestamp, Verbose[none]: Type escape sequence to abort.Tracing the route to 100.100.100.1001 12.0.0.2 28 msec 104 msec 200 msec2 223.0.0.3 300 msec * 196 msec //ISP2入口-----------------------------------------------------。

硬件负载均衡介绍

2.1 简单会话保持

简单会话保持也被称为基于源地址的会话保持,是指负载均衡器在作负载均衡时是根据访问请求的源地 址作为判断关连会话的依据。对来自同一IP地址的所有访问 请求在作负载均时都会被保持到一台服务 器上去。在BIG-IP设备上可以为“同一IP地址”通过网络掩码进行区分,比如可以通过对IP地址 进行 的网络掩码,这样只要是来自于这个网段的流量BIGIP都可以认为他 们是来自于同一个用户,这样就将 把来自于网段的流量会话保持到特定的一台服务器上。

◆观察模式(Observed):连接数目和响应时间以这两项的最佳平衡为依据为新的请求选择服务器。当其中某个服务器 发生第二到第7 层的故障,BIG-IP就把其从服务器队列中拿出,不参加下一次的用户请求的分配,直到其恢复正常。

◆预测模式(Predictive):BIG-IP利用收集到的服务器当前的性能指标,进行预测分析,选择一台服务器在下一个时间 片内,其性能将达到最佳的服务器相应用户的请求。(被BIG-IP 进行检测)

接入需要均衡哪些特殊配置?

1

1 会话时间大于设置的时间戳

2 根据源IP配置会话保持

2

负载均衡配置透明模式,将客户端的IP 3 addr传给接入程序。

3

而这一系列的相关的交互过程可能 是由客户到服务器的一个连接的多 次会话完成,也可能是在客户与服 务器之间的多个不同连接里的多次 会话完成。不同连接的多次 会话, 最典型的例子就是基于http的访问, 一个客户完成一笔交易可能需多次 点击,而一个新的点击产生的请求, 可能会重用上一次点击建立起来的 连接,也可 能是一个新建的连接。

思科负载均衡的配置实例

1.负载均衡的介绍软/硬件负载均衡软件负载均衡解决方案,是指在一台或多台服务器相应的操作系统上,安装一个或多个附加软件来实现负载均衡,如DNS 负载均衡等。

它的优点是基于特定环境、配置简单、使用灵活、成本低廉,可以满足一般的负载均衡需求。

硬件负载均衡解决方案,是直接在服务器和外部网络间安装负载均衡设备,这种设备我们通常称之为负载均衡器。

由于专门的设备完成专门的任务,独立于操作系统,整体性能得到大量提高,加上多样化的负载均衡策略,智能化的流量管理,可达到最佳的负载均衡需求。

一般而言,硬件负载均衡在功能、性能上优于软件方式,不过成本昂贵。

本地/全局负载均衡负载均衡从其应用的地理结构上,分为本地负载均衡和全局负载均衡。

本地负载均衡是指对本地的服务器群做负载均衡,全局负载均衡是指在不同地理位置、有不同网络结构的服务器群间做负载均衡。

本地负载均衡能有效地解决数据流量过大、网络负荷过重的问题,并且不需花费昂贵开支购置性能卓越的服务器,可充分利用现有设备,避免服务器单点故障造成数据流量的损失。

有灵活多样的均衡策略,可把数据流量合理地分配给服务器群内的服务器,来共同负担。

即使是再给现有服务器扩充升级,也只是简单地增加一个新的服务器到服务群中,而不需改变现有网络结构、停止现有的服务。

全局负载均衡,主要用于在一个多区域拥有自己服务器的站点,为了使全球用户只以一个IP地址或域名就能访问到离自己最近的服务器,从而获得最快的访问速度,也可用于子公司分散站点分布广的大公司通过Intranet (企业内部互联网)来达到资源统一合理分配的目的。

更高网络层负载均衡针对网络上负载过重的不同瓶颈所在,从网络的不同层次入手,我们可以采用相应的负载均衡技术来解决现有问题。

更高网络层负载均衡,通常操作于网络的第四层或第七层。

第四层负载均衡将一个Internet上合法注册的IP地址,映射为多个内部服务器的IP地址,对每次TCP连接请求动态使用其中一个内部IP地址,达到负载均衡的目的。

负载均衡发展历程

负载均衡发展历程负载均衡(Load Balancing)是一种为了提高系统性能和可靠性的技术。

负载均衡技术最初出现在20世纪60年代,其以提高网络效率和用户体验为目标不断发展,现今已成为互联网应用架构中不可或缺的一部分。

下面将从负载均衡的起源、发展、现状等方面进行介绍。

负载均衡的起源可以追溯到最早的计算机网络时代,当时计算机的性能有限,而用户的需求却不断增长。

因此,为了充分利用计算机资源,并平衡计算机之间的负荷,人们开始研究并提出负载均衡的概念。

最开始的负载均衡方法基本是静态的,如常见的轮询(Round Robin)算法,通过依次将请求分发给不同的服务器,以达到负载均衡的目的。

随着计算机技术的发展和互联网的出现,负载均衡的需求进一步增加。

传统的负载均衡算法难以满足复杂的网络环境和大量用户的需求,因此亟需新的负载均衡方案。

1996年,首个商用负载均衡软件――F5的BIG-IP在市场上推出,这标志着负载均衡技术正式进入商业化阶段。

随着互联网的发展,众多互联网公司开始快速崛起,用户的需求也变得更加复杂和高端化。

这促使负载均衡技术逐渐发展到了第二代,即基于请求的负载均衡技术。

基于请求的负载均衡技术通过分析请求的内容来决定将请求分发给哪个服务器,以实现更精确地负载均衡。

此外,还出现了一些关键性的技术突破,如基于TCP/IP协议的负载均衡技术和反向代理技术,进一步提高了负载均衡的效率和安全性。

随着虚拟化技术的出现,负载均衡技术也得到了进一步的发展。

虚拟化技术能够将物理服务器虚拟为多个逻辑服务器,使得资源的使用更加灵活。

于是,出现了基于虚拟化的负载均衡技术,如基于容器的负载均衡技术和基于虚拟机的负载均衡技术。

这些技术通过将负载均衡的功能嵌入到虚拟化层中,进一步提高了负载均衡的性能和可靠性。

目前,负载均衡技术已经成为大型互联网公司不可或缺的一部分,无论是电子商务、社交媒体还是金融服务,都离不开负载均衡的支持。

负载均衡技术也在不断演进,如基于智能算法的负载均衡技术、SDN(软件定义网络)与负载均衡相结合等。

调度器20—负载均衡—load_balance()函数分析

调度器20—负载均衡—load_balance()函数分析⼀、概述1. 负载均衡的情景包括 tick balance、nohz idle balance 和 new idle balance,最终都会汇聚到 load_balance 函数来完成具体的负载均衡⼯作。

⼆、load_balance 相关数据结构1. struct lb_env在负载均衡的时候,通过 lb_env 结构来表⽰本次负载均衡的上下⽂://fair.cstruct lb_env {//要进⾏负载均衡的domainstruct sched_domain *sd;//此sd中最忙的cpu和rq,均衡⽬标就是从其中拉取任务struct rq *src_rq;int src_cpu;/** 本次均衡的⽬标CPU,均衡尝试从sd中的最忙的cpu的rq上拉取任务到dst cpu的rq上,* 第⼀轮均衡的dst cpu通常为发起均衡的cpu,但后续若有需要,可以从新设定为local* group中其它的cpu.*/int dst_cpu;struct rq *dst_rq;//dst cpu所在sched group的cpu mask,MC层级就是dst cpu⾃⼰,DIE层级是其cluster.struct cpumask *dst_grpmask;/** ⼀般⽽⾔,均衡的dst cpu是发起均衡的cpu,但如果由于affinity原因,src上有任务* ⽆法迁移到dst cpu从⽽⽆法完成负载均衡操作时,会从dst cpu的logcal group中选出* ⼀个新的cpu发起第⼆轮负载均衡。

*/int new_dst_cpu;//均衡时dst cpu的idle状态,其会影响负载均衡的⾛向enum cpu_idle_type idle;/** 对此成员的解释需要结合migration_type成员, calculate_imbalance:* migrate_load:表⽰要迁移的负载量* migrate_util:表⽰要迁移的utility* migrate_task:MC:表⽰要迁移的任务个数,DIE: busiest group需要增加的idle cpu个数* migrate_misfit:设定为1,表⽰⼀次迁移⼀个任务* group_imbalanced:设定为1,表⽰⼀次迁移⼀个任务*/long imbalance;/* The set of CPUs under consideration for load-balancing *//** 负载均衡过程会有多轮操作,不同轮次的操作会涉及不同cpus,此成员表⽰此次均衡* 有哪些cpus参与*/struct cpumask *cpus;/** 负载均衡标志,位掩码。

思科CMTS负载均衡讲义

By Zhimin Zhang

How LB usually work

• Each LBG contains some DS/US channel. • When modem is registered, it will be assigned to

• Traffic statistics has a delay, so CMTS may move to many modems to another channel and have to move it back in next interval.

• Threshold is used to accept somewhat un-balance. So that it will not waste unnecessary resource.

• This is to ensure the service quality.

• “policy”

We don’t want a specific modem to be moved

• Exclude command • “docsis-policy” could be used to disable a

• Dynamic LB

• Move modem whenever not balanced.

• Passive LB

• CMTS ignore the register for modem on overload channel

How to move modem (message send to modem)

modem being moved permanently or for some period.