NMF 非负矩阵分解Matlab代码

MATLAB中的矩阵分解与求逆技巧

MATLAB中的矩阵分解与求逆技巧Matlab作为一种强大的数学软件,提供了许多用于矩阵运算的函数和工具包。

其中,矩阵的分解和求逆操作在很多数学和工程领域中非常常见且重要。

本文将介绍一些在Matlab中进行矩阵分解和求逆的技巧和方法。

1. 矩阵分解矩阵分解是将一个矩阵表示为其他几个矩阵乘积的形式。

在Matlab中,常用的矩阵分解方法有LU分解、QR分解、奇异值分解(SVD)等。

这些分解方法在求解线性方程组、矩阵近似和特征值计算等问题中有广泛的应用。

LU分解是一种将矩阵表示为下三角和上三角矩阵乘积的分解方法。

在Matlab 中,可以使用lu函数来进行LU分解。

例如,对于一个矩阵A,可以使用[l,u] =lu(A)来进行LU分解。

分解后的下三角矩阵可以通过l进行访问,上三角矩阵可以通过u进行访问。

QR分解是将矩阵表示为正交矩阵和上三角矩阵乘积的分解方法。

在Matlab中,可以使用qr函数来进行QR分解。

例如,对于一个矩阵A,可以使用[q,r] = qr(A)进行QR分解。

分解后的正交矩阵可以通过q进行访问,上三角矩阵可以通过r进行访问。

奇异值分解(SVD)是将矩阵表示为三个特殊矩阵乘积的分解方法。

在Matlab 中,可以使用svd函数来进行SVD分解。

例如,对于一个矩阵A,可以使用[U,S,V] = svd(A)进行SVD分解。

分解后得到的矩阵U、S和V可以分别通过U、S 和V进行访问。

这些矩阵分解方法在Matlab中的应用非常广泛。

通过对矩阵的分解,可以更好地理解矩阵的结构和性质,并为相关问题的求解提供便利。

2. 矩阵求逆矩阵求逆是将一个矩阵转化为其逆矩阵的操作。

在Matlab中,可以使用inv函数来进行矩阵求逆。

例如,对于一个矩阵A,可以使用A_inv = inv(A)来求得其逆矩阵。

然而,需要注意的是,并非所有矩阵都是可逆的。

可逆矩阵必须满足矩阵的行列式不为零。

在实际应用中,可以使用det函数来计算矩阵的行列式。

数据降维-NMF非负矩阵分解

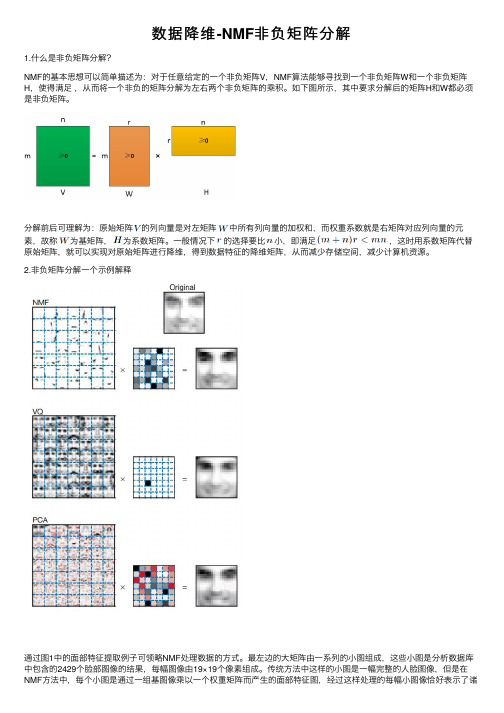

数据降维-NMF⾮负矩阵分解1.什么是⾮负矩阵分解?NMF的基本思想可以简单描述为:对于任意给定的⼀个⾮负矩阵V,NMF算法能够寻找到⼀个⾮负矩阵W和⼀个⾮负矩阵H,使得满⾜,从⽽将⼀个⾮负的矩阵分解为左右两个⾮负矩阵的乘积。

如下图所⽰,其中要求分解后的矩阵H和W都必须是⾮负矩阵。

分解前后可理解为:原始矩阵的列向量是对左矩阵中所有列向量的加权和,⽽权重系数就是右矩阵对应列向量的元素,故称为基矩阵,为系数矩阵。

⼀般情况下的选择要⽐⼩,即满⾜,这时⽤系数矩阵代替原始矩阵,就可以实现对原始矩阵进⾏降维,得到数据特征的降维矩阵,从⽽减少存储空间,减少计算机资源。

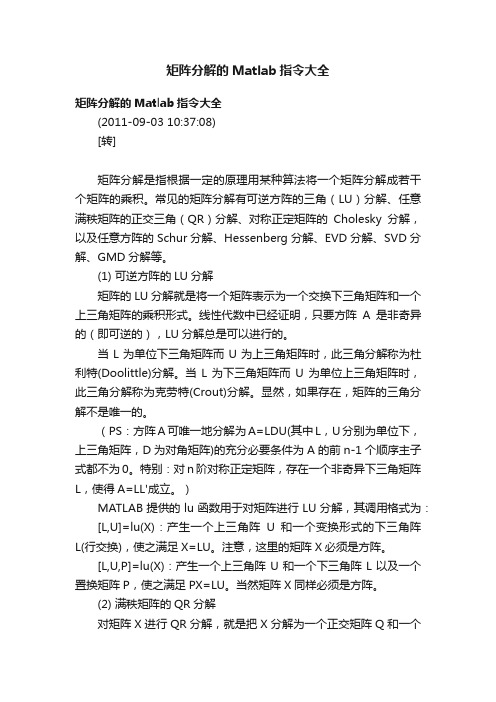

2.⾮负矩阵分解⼀个⽰例解释通过图1中的⾯部特征提取例⼦可领略NMF处理数据的⽅式。

最左边的⼤矩阵由⼀系列的⼩图组成,这些⼩图是分析数据库中包含的2429个脸部图像的结果,每幅图像由19×19个像素组成。

传统⽅法中这样的⼩图是⼀幅完整的⼈脸图像,但是在NMF⽅法中,每个⼩图是通过⼀组基图像乘以⼀个权重矩阵⽽产⽣的⾯部特征图,经过这样处理的每幅⼩图像恰好表⽰了诸如“⿐⼦”、“嘴巴”、“眼睛”等⼈脸局部概念特征,这便⼤⼤压缩了存放的图像数据量。

左边的⼤矩阵由每幅⼩图像的19列⼀起组成矩阵的⼀列,那样它就是19×19=361⾏,2429列。

这个例⼦中,NMF⽅法⽤基图像来代表眼、眉⽑、⿐⼦、嘴、⽿朵、胡⼦等,它们⼀起组成了数据库中的脸。

这样给⼈最先的直觉就是它很好地压缩了数据。

事实上Lee和Seung在他们的论⽂中更深⼊地指出,与⼈类识别事物的过程相似,NMF也是⼀种优化的机制,近似于我们的脑分析和存储⼈脸数据的过程。

这个例⼦中,原图像表⽰这些局部特征的加权组合,这与⼈类思维中“局部构成整体”的概念是相吻合的。

因此,NMF算法似乎体现了⼀种智能⾏为。

3.⾮负矩阵分解NMF的应⽤(1)图像分析 NMF最成功的⼀类应⽤是在图像的分析和处理领域(2)⽂本聚类,数据挖掘(3)语⾳处理(4)机器⼈控制(5)⽣物医药⼯程和化学⼯程。

矩阵分解的Matlab指令大全

矩阵分解的Matlab指令大全矩阵分解的Matlab指令大全(2011-09-03 10:37:08)[转]矩阵分解是指根据一定的原理用某种算法将一个矩阵分解成若干个矩阵的乘积。

常见的矩阵分解有可逆方阵的三角(LU)分解、任意满秩矩阵的正交三角(QR)分解、对称正定矩阵的Cholesky分解,以及任意方阵的Schur分解、Hessenberg分解、EVD分解、SVD分解、GMD分解等。

(1) 可逆方阵的LU分解矩阵的LU分解就是将一个矩阵表示为一个交换下三角矩阵和一个上三角矩阵的乘积形式。

线性代数中已经证明,只要方阵A是非奇异的(即可逆的),LU分解总是可以进行的。

当L为单位下三角矩阵而U为上三角矩阵时,此三角分解称为杜利特(Doolittle)分解。

当L为下三角矩阵而U为单位上三角矩阵时,此三角分解称为克劳特(Crout)分解。

显然,如果存在,矩阵的三角分解不是唯一的。

(PS:方阵A可唯一地分解为A=LDU(其中L,U分别为单位下,上三角矩阵,D为对角矩阵)的充分必要条件为A的前n-1个顺序主子式都不为0。

特别:对n阶对称正定矩阵,存在一个非奇异下三角矩阵L,使得A=LL'成立。

)MATLAB提供的lu函数用于对矩阵进行LU分解,其调用格式为:[L,U]=lu(X):产生一个上三角阵U和一个变换形式的下三角阵L(行交换),使之满足X=LU。

注意,这里的矩阵X必须是方阵。

[L,U,P]=lu(X):产生一个上三角阵U和一个下三角阵L以及一个置换矩阵P,使之满足PX=LU。

当然矩阵X同样必须是方阵。

(2) 满秩矩阵的QR分解对矩阵X进行QR分解,就是把X分解为一个正交矩阵Q和一个上三角矩阵R的乘积形式。

QR分解只能对方阵进行。

MATLAB的函数qr可用于对矩阵进行QR分解,其调用格式为:[Q,R]=qr(X):产生一个一个正交矩阵Q和一个上三角矩阵R,使之满足X=QR。

[Q,R,E]=qr(X):产生一个一个正交矩阵Q、一个上三角矩阵R以及一个置换矩阵E,使之满足XE=QR。

Matlab_中的矩阵分解函数

Matlab 中的矩阵分解函数矩阵分解是指根据一定的原理用某种算法将一个矩阵分解成若干个矩阵的乘积。

常见的矩阵分解有LU分解(三角分解)、QR分解(正交变换)、Cholesky分解,以及Schur分解、Hessenberg分解、奇异分解等。

(1) LU分解(三角分解)lu函数[L,U]=lu(X):产生一个上三角阵U和一个变换形式的下三角阵L(行交换),使之满足X=LU。

注意,这里的矩阵X必须是方阵。

实现LU分解后,线性方程组Ax=b的解x=U\(L\b)或x=U\(L\Pb),这样可以大大提高运算速度。

[L,U,P]=lu(X):产生一个上三角阵U和一个下三角阵L以及一个置换矩阵P,使之满足PX=LU。

当然矩阵X同样必须是方阵。

(设P 是一个m×n的(0,1) 矩阵,如m≤n且P*P′=E,则称P为一个m×n的置换矩阵。

)例1用LU分解求解例1中的线性方程组。

命令如下:A=[2,1,-5,1;1,-5,0,7;0,2,1,-1;1,6,-1,-4];b=[13,-9,6,0]';x=U\(L\b)或采用LU分解的第2种格式,命令如下:[L,U ,P]=lu(A);x=U\(L\P*b)(2) QR分解(正交变换)对矩阵X进行QR分解,就是把X分解为一个正交矩阵Q和一个上三角矩阵R的乘积形式。

QR分解只能对方阵进行。

MATLAB的函数qr可用于对矩阵进行QR分解,其调用格式为:[Q,R]=qr(X):产生一个一个正交矩阵Q和一个上三角矩阵R,使之满足X=QR。

[Q,R,E]=qr(X):产生一个一个正交矩阵Q、一个上三角矩阵R以及一个置换矩阵E,使之满足XE=QR。

实现QR分解后,线性方程组Ax=b的解x=R\(Q\b)或x=E(R\(Q\b))。

例2用QR分解求解例1中的线性方程组。

命令如下:A=[2,1,-5,1;1,-5,0,7;0,2,1,-1;1,6,-1,-4];b=[13,-9,6,0]';x=R\(Q\b)或采用QR分解的第2种格式,命令如下:[Q,R,E]=qr(A);x=E*(R\(Q\b))(3) Cholesky分解如果矩阵X是对称正定的,则Cholesky分解将矩阵X分解成一个下三角矩阵和上三角矩阵的乘积。

非负矩阵分解

非负矩阵分解非负矩阵分解(NonnegativeMatrixFactorization,NMF)是一种重要的数值分解技术,它可以将一个实对称矩阵分解成两个非负矩阵,其中元素都大于等于零。

它可以用来提取相关数据之间的关系,从而从模糊的数据中提取出有价值的信息,因此经常被应用于聚类、概念提取等机器学习的领域中。

首先,要理解NMF,我们需要介绍其基本概念,它是一种矩阵分解技术,一般可以将一个实对称矩阵分解为两个非负的矩阵,这些元素都大于等于零。

其中,一个矩阵称为基矩阵,用来描述数据之间的关系;另一个称为内积矩阵,用来描述数据之间的相关性。

NMF由布罗基-亨利林(Brock-Hennely)在1999年提出,是一种重要的半正则化方法,能够从给定的非负矩阵中恢复出潜在的内容主题,其计算结果可以看作是一种“直观的抽象”,可以给出一个“更容易理解”的表示。

NMF的思想是将一个非负实矩阵X分解成两个非负矩阵W和H,令X≈WH,这两个矩阵的元素均为非负值,分别叫做基矩阵W和内积矩阵H,其计算过程是令X,W,H分别尽可能接近W,H,X,使得W 和H的乘积最小。

W和H可以用来描述原始矩阵X中的数据之间的关系,而不是直接用原始矩阵来表示X。

NMF有很多应用,如用于聚类分析,文档检索,内容提取,图像处理等机器学习领域,其主要的优点是:(1)能够从模糊的数据中提取出有价值的信息,(2)可以自动化,减少神经网络算法中专家知识的应用,(3)可以用于实时处理大量数据,(4)可以用于视觉系统,提出新的视觉模型,从而对计算机视觉系统有很大帮助。

NMF在聚类分析中也有很好的应用,它可以自动发现原始数据中的隐藏信息,并把它们聚合成不同的类别。

它的聚类特性使得它可以用来处理复杂数据集,具有很多分类任务的优点。

例如,可以使用NMF来分析文本数据,将一些紧密相关的文本聚合到一起;可以用来分析视觉数据,将图像中的主要特征提取出来;还可以用来分析声音数据,将语音识别任务简化成一个重要的计算任务。

MATLAB中常见的矩阵分解技术介绍

MATLAB中常见的矩阵分解技术介绍矩阵分解是线性代数中重要的内容之一,它将一个复杂的矩阵分解为多个简单的矩阵相乘的形式,从而可以更好地理解和处理矩阵运算。

在MATLAB中,有许多常见的矩阵分解技术,包括LU分解、QR分解、奇异值分解(SVD)和特征值分解等等。

本文将对这些常见的矩阵分解技术进行介绍。

一、LU分解LU分解是将一个矩阵分解为一个下三角矩阵L和一个上三角矩阵U的乘积,其中L矩阵的对角元素都为1。

LU分解在数值计算中广泛应用,可以用于解线性方程组、求逆矩阵等。

在MATLAB中,可以使用“lu”函数进行LU分解,示例如下:```matlabA = [1, 2, 3; 4, 5, 6; 7, 8, 9];[L, U] = lu(A);```二、QR分解QR分解是将一个矩阵分解为一个正交矩阵Q和一个上三角矩阵R的乘积,其中Q矩阵的列向量都是正交的。

QR分解在数值计算中也具有重要的应用,可以用于求矩阵的秩、解最小二乘问题等。

在MATLAB中,可以使用“qr”函数进行QR 分解,示例如下:```matlabA = [1, 2; 3, 4; 5, 6];[Q, R] = qr(A);```三、奇异值分解(SVD)奇异值分解(SVD)将一个矩阵分解为一个正交矩阵U、一个对角矩阵Σ和另一个正交矩阵V的转置的乘积。

奇异值分解在数据压缩、图像处理、语音识别等领域有着重要的应用。

在MATLAB中,可以使用“svd”函数进行奇异值分解,示例如下:```matlabA = [1, 2; 3, 4; 5, 6];[U, S, V] = svd(A);```四、特征值分解特征值分解将一个可对角化的矩阵分解为一个特征向量矩阵V和一个特征值对角矩阵Λ的乘积。

特征值分解在物理学、工程学等领域中有着广泛的应用,可以用于求解微分方程、震动和振动问题等。

在MATLAB中,可以使用“eig”函数进行特征值分解,示例如下:```matlabA = [1, 2; 3, 4];[V, Lambda] = eig(A);```通过对这些常见的矩阵分解技术的介绍,我们可以发现MATLAB在矩阵分解方面提供了许多方便快捷的函数和工具,使得我们可以更加高效地处理各种复杂的矩阵运算问题。

MATLAB中的矩阵分解与降维技术

MATLAB中的矩阵分解与降维技术随着科学技术的不断发展和数据规模的急剧增加,如何高效地处理和分析大规模数据已成为一个迫切需要解决的问题。

矩阵分解与降维技术在这一领域发挥着重要的作用。

本文将探讨MATLAB中的矩阵分解与降维技术,并介绍其应用于数据处理与分析中的具体实例。

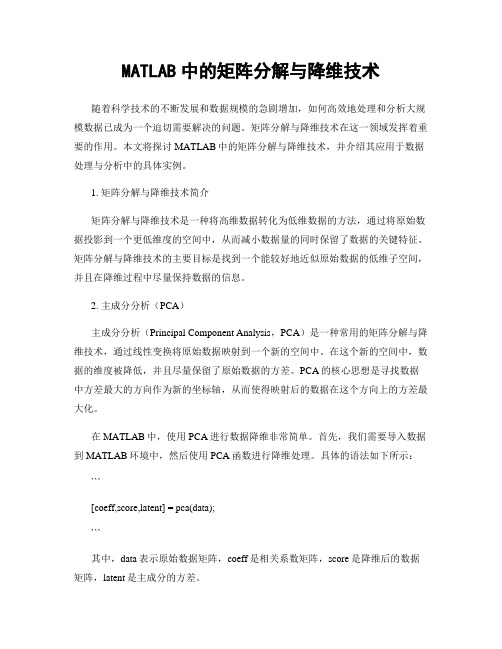

1. 矩阵分解与降维技术简介矩阵分解与降维技术是一种将高维数据转化为低维数据的方法,通过将原始数据投影到一个更低维度的空间中,从而减小数据量的同时保留了数据的关键特征。

矩阵分解与降维技术的主要目标是找到一个能较好地近似原始数据的低维子空间,并且在降维过程中尽量保持数据的信息。

2. 主成分分析(PCA)主成分分析(Principal Component Analysis,PCA)是一种常用的矩阵分解与降维技术,通过线性变换将原始数据映射到一个新的空间中。

在这个新的空间中,数据的维度被降低,并且尽量保留了原始数据的方差。

PCA的核心思想是寻找数据中方差最大的方向作为新的坐标轴,从而使得映射后的数据在这个方向上的方差最大化。

在MATLAB中,使用PCA进行数据降维非常简单。

首先,我们需要导入数据到MATLAB环境中,然后使用PCA函数进行降维处理。

具体的语法如下所示:```[coeff,score,latent] = pca(data);```其中,data表示原始数据矩阵,coeff是相关系数矩阵,score是降维后的数据矩阵,latent是主成分的方差。

3. 奇异值分解(SVD)奇异值分解(Singular Value Decomposition,SVD)是一种将矩阵分解为奇异值和两个酉矩阵的技术,常用于降维、矩阵压缩和数据恢复等领域。

SVD可以对任意大小和形状的矩阵进行分解,并且具有较好的数学性质。

在MATLAB中,使用SVD进行矩阵分解与降维同样非常简单。

我们可以使用svd函数对矩阵进行分解,并得到奇异值、左奇异向量和右奇异向量。

MATLAB矩阵分解

MATLAB矩阵分解矩阵分解是指根据一定的原理用某种算法将一个矩阵分解成若干个矩阵的乘积。

常见的矩阵分解有LU分解(三角分解)、QR分解(正交变换)、Cholesky分解,以及Schur分解、Hessenberg分解、奇异分解等。

(1) LU分解(三角分解)矩阵的LU分解就是将一个矩阵表示为一个交换下三角矩阵和一个上三角矩阵的乘积形式。

线性代数中已经证明,只要方阵A是非奇异(即行列式不等于0)的,LU分解总是可以进行的。

MATLAB提供的lu函数用于对矩阵进行LU分解,其调用格式为:[L,U]=lu(X):产生一个上三角阵U和一个变换形式的下三角阵L(行交换),使之满足X=LU。

注意,这里的矩阵X必须是方阵。

[L,U,P]=lu(X):产生一个上三角阵U和一个下三角阵L以及一个置换矩阵P,使之满足PX=LU。

当然矩阵X同样必须是方阵。

(设P是一个m×n的 (0,1)矩阵,如m≤n且P*P′=E,则称 P为一个m×n的置换矩阵。

)实现LU分解后,线性方程组Ax=b的解x=U(Lb)或x=U(LPb),这样可以大大提高运算速度。

例7-2 用LU分解求解例7-1中的线性方程组。

命令如下:A=[2,1,-5,1;1,-5,0,7;0,2,1,-1;1,6,-1,-4];b=[13,-9,6,0]';[L,U]=lu(A);x=U(Lb)或采用LU分解的第2种格式,命令如下:[L,U ,P]=lu(A);x=U(LP*b)(2) QR分解(正交变换)对矩阵X进行QR分解,就是把X分解为一个正交矩阵Q和一个上三角矩阵R的乘积形式。

QR分解只能对方阵进行。

MATLAB的函数qr 可用于对矩阵进行QR分解,其调用格式为:[Q,R]=qr(X):产生一个一个正交矩阵Q和一个上三角矩阵R,使之满足X=QR。

[Q,R,E]=qr(X):产生一个一个正交矩阵Q、一个上三角矩阵R以及一个置换矩阵E,使之满足XE=QR。

MATLAB中的非负矩阵分解方法详解

MATLAB中的非负矩阵分解方法详解介绍非负矩阵分解(Non-negative Matrix Factorization,简称NMF)是一种常用的数据分析和特征提取方法。

相比于传统的矩阵分解方法,NMF具有许多独特的优势,尤其适用于处理非负数据或稀疏数据。

NMF的基本思想是将一个非负矩阵分解为两个非负矩阵的乘积,其中一个矩阵表示特征的组合权重,另一个矩阵表示特征的表示方式。

这种分解方法可以被看作是一种特征选择和降维的手段,能够提取原始数据中的主要特征信息。

NMF的应用NMF广泛应用于多个领域,包括图像处理、文本挖掘、生物信息学等。

在图像处理领域,通过NMF可以将图像数据分解为基础形状和颜色分布,实现图像的压缩和图像特征的提取。

在文本挖掘领域,NMF可以用于对文本进行主题建模和情感分析。

NMF的算法原理NMF的目标是找到两个非负矩阵W和H,使得原始矩阵V与它们的乘积WH 的近似误差最小。

这个优化问题可以通过迭代算法来求解。

常见的NMF算法有HALS、MU和Lee-Seung算法。

算法1:HALS算法HALS算法是一种基于交替最小二乘法的NMF算法。

它通过固定一个矩阵,求解另一个矩阵的更新值,然后交替迭代,最终找到近似解。

该算法的迭代过程中对更新值进行非负性约束,确保输出的矩阵非负。

HALS算法的具体流程如下:1. 初始化矩阵W和H为非负随机数;2. 固定H,通过最小二乘法求解W的更新值;3. 固定W,通过最小二乘法求解H的更新值;4. 重复步骤2和步骤3,直到满足停止准则。

算法2:MU算法MU算法是一种基于乘法更新规则的NMF算法。

与HALS算法不同,MU算法采用两个非负矩阵的元素逐个更新的方式。

该算法的迭代过程中同样对更新值进行非负性约束。

MU算法的具体流程如下:1. 初始化矩阵W和H为非负随机数;2. 根据乘法更新规则,更新矩阵W和H的元素;3. 重复步骤2,直到满足停止准则。

算法3:Lee-Seung算法Lee-Seung算法是最早提出的NMF算法之一,也是一种基于乘法更新规则的方法。

非负矩阵分解聚类

非负矩阵分解聚类1. 简介非负矩阵分解聚类(Non-negative Matrix Factorization Clustering,NMF)是一种常用的无监督学习算法,用于发现数据集中的潜在模式和隐藏结构。

与其他聚类算法相比,NMF具有以下优点:•可解释性强:NMF将数据矩阵分解为两个非负矩阵的乘积,这两个矩阵分别代表了数据的特征和权重,可以直观地解释聚类结果。

•适用于高维稀疏数据:NMF在处理高维稀疏数据时表现出色,能够提取出有意义的特征。

•可扩展性好:NMF的计算复杂度较低,可以处理大规模数据集。

在本文中,我们将详细介绍NMF算法的原理、应用场景、算法流程以及相关实现和评估指标。

2. 算法原理NMF的核心思想是将一个非负数据矩阵分解为两个非负矩阵的乘积,即将数据矩阵X近似表示为WH,其中W和H是非负的。

给定一个非负数据矩阵X,NMF的目标是找到两个非负矩阵W和H,使得它们的乘积WH能够尽可能地接近原始数据矩阵X。

具体而言,NMF的优化目标可以定义为以下损失函数的最小化:其中,|X-WH|表示原始数据矩阵X与近似矩阵WH的差异,||·||_F表示Frobenius范数,(WH)ij表示矩阵WH的第i行第j列元素。

NMF的求解过程可以通过交替更新W和H来实现,具体步骤如下:1.初始化矩阵W和H为非负随机数。

2.交替更新矩阵W和H,使得损失函数逐步减小,直到收敛:–固定矩阵H,更新矩阵W:–固定矩阵W,更新矩阵H:3.重复步骤2,直到达到指定的迭代次数或损失函数收敛。

3. 应用场景NMF在许多领域都有广泛的应用,包括图像处理、文本挖掘、社交网络分析等。

以下是一些常见的应用场景:•图像分析:NMF可以用于图像分解、图像压缩、图像去噪等任务。

通过将图像矩阵分解为特征矩阵和权重矩阵,可以提取出图像的基础特征。

•文本挖掘:NMF可以用于主题建模、文本分类、关键词提取等任务。

通过将文档-词频矩阵分解为文档-主题矩阵和主题-词矩阵,可以发现文本数据中的主题结构。

NMF Matlab

非负矩阵分解关键词:非负矩阵分解NMF Matlab代码矩阵分解是实现大规模数据处理与分析的一种有效工具. 非负矩阵分解(non-negative matrix factorization,NMF)算法是在矩阵中所有元素均为非负的条件下对其实现的非负分解,这为矩阵分解提供了一种新的思路. 非负矩阵分解方法在智能信息处理和模式识别研究领域具有十分重要的应用意义. 本文介绍非负矩阵分解的基本思想和一些最新的研究成果,结合研究工作讨论在概率模型的框架下实现非负矩阵分解的目标函数和相应的算法,以及非负矩阵分解与知觉过程信息处理的关系,针对模式识别的实际问题给出具体的非负矩阵分解的应用实例,并提出非负矩阵分解及其应用中有待进一步研究的新问题。

function [W H] = nmf(V,r,maxiter);%%-------------------------------------------------------------------- %%% Function: 非负矩阵分解(nonnegative matrix factorization)% Argument:% V:图像矩阵% r: rank for the factorization% maxiter: maximum number of iterations%%-------------------------------------------------------------------- %%%start_time=cputime; % save start timeclose all;clear all;ImShowOn = 1 ; % 1 最后显示结果 0 最后不显示结果if nargin ~= 3 % 设置默认值disp 'Usage: [W H] = nmf(V,r,maxiter)';disp 'Copyright(C) ';V = LoadImage();r = input('Choose your own rank for the factorization [49]:'); if isempty(r)r=49;endmaxiter = input('Choose the maximum number of iterations [100]:'); if isempty(maxiter)maxiter=100;endendV=double(V);[n m]=size(V); % V contains your data in its column vectorsW=rand(n,r); % randomly initialize basisW=W./(ones(n,1)*sum(W)); % normalize column sumsH=rand(r,m); % randomly initialize encodings%eps=1e-9; % set your own toleranceh = waitbar(0,'Nonnegative Matrix Factorization');for iter=1:maxiterH=H.*(W'*((V+eps)./(W*H+eps)));W=W.*(((V+eps)./(W*H+eps))*H');W=W./(ones(n,1)*sum(W));% insert your own graphics calls to visualize W and Hwaitbar(iter/maxiter,h);endclose(h);h = waitbar(0,'Copyright(C) ');web('', '-new');if ImShowOn == 1 % 显示结果subplot(1,2,1);imshow(V,[]);title('Original image');subplot(1,2,2);imshow(W*H,[]);title(['NMFed image','(rank=',num2str(r),',iterations=',num2str(maxiter),')']);end%% -------------------------------------------------------------------- %%function [W,H]=NMF(D,r)sizeD=size(D);n=sizeD(1);m=sizeD(2);W=abs(rand(n,r));H=abs(rand(r,m));for iterate=1:100WD=W'*D;WWH=W'*W*H;for a = 1:rfor u=1:mH(a,u)=H(a,u)*WD(a,u)/WWH(a,u);endendDH=D*H';WHH=W*H*H';for i = 1:nfor a=1:rW(i,a)=W(i,a)*DH(i,a)/WHH(i,a);endendend。

非负矩阵分解算法综述

非负矩阵分解算法综述非负矩阵分解(Non-Negative Matrix Factorization, NMF)是一种常用的非线性降维和特征提取技术,广泛应用于图像处理、文本挖掘、推荐系统等领域。

本文将对非负矩阵分解算法进行综述。

一、基本原理V≈WH其中,W的每一列可以看作是数据的一个潜在特征,H是通过组合这些特征得到的原始数据的表示。

NMF的目标是找到合适的W和H,使得V 和WH的差异最小化。

二、经典NMF算法1. Multiplicative Update(MU)Multiplicative Update算法是最早的NMF方法之一,通过迭代更新W和H的元素来最小化目标函数。

该方法简单易懂,但可能陷入局部最优解。

2. Alternating Nonnegative Least Squares(ANLS)ANLS算法通过最小二乘法对每一轮更新W和H的元素,得到更好的分解结果。

相比于MU算法,ANLS算法更稳定,但计算复杂度较高。

3. Projected Gradient Descent(PGD)PGD方法通过梯度下降法对W和H更新的过程进行限制,使得其始终保持非负。

该方法在稀疏矩阵分解问题中表现较好。

4. Sparse NMFSparse NMF算法是对NMF进行改进,引入了稀疏性约束。

通过加入稀疏性约束,该算法能够产生更加稀疏的特征表示,提高了特征提取的效果。

三、进展和拓展1.随机NMF随机NMF方法通过随机选择分解结果的初始化值,然后在迭代过程中进行更新,可以避免陷入局部最优解。

2.多尺度NMF多尺度NMF方法对输入矩阵进行多尺度分解,可以从不同尺度上捕捉到更丰富的特征信息。

3.核NMF核NMF方法利用核技巧将非负矩阵分解扩展到非线性情况,可以更好地处理非线性特征提取问题。

4.基于深度学习的NMF基于深度学习的NMF算法将NMF与深度学习模型结合,利用深度神经网络进行特征提取和分解,可以处理更加复杂的数据。

matlab矩阵分解

matlab矩阵分解

矩阵分解是一种常用的数学方法,用于将一个复杂的矩阵表示为几个简单矩阵的乘积。

在MATLAB中,有多种矩阵分解的方法,可以帮助我们更好地理解和处理数据。

一种常见的矩阵分解方法是奇异值分解(SVD)。

奇异值分解可以将一个任意大小的矩阵分解为三个矩阵的乘积,分别为左奇异矩阵、奇异值矩阵和右奇异矩阵。

这种分解方法在信号处理、图像压缩等领域有着广泛的应用。

另一种常见的矩阵分解方法是QR分解。

QR分解将一个矩阵分解为一个正交矩阵和一个上三角矩阵的乘积。

这种分解方法在求解线性方程组、最小二乘拟合等问题中非常有用。

除了SVD和QR分解,MATLAB还提供了LU分解、Cholesky分解等多种矩阵分解的方法。

这些分解方法在不同的问题中有着各自的优势和适用范围,可以帮助我们更高效地处理数据和解决问题。

通过矩阵分解,我们可以将复杂的问题简化为更容易处理的形式,从而加快计算速度、降低计算复杂度。

矩阵分解也为数据挖掘、机器学习等领域的算法提供了重要的基础。

在MATLAB中,通过简单的几行代码就可以实现各种矩阵分解的方法,无需手动编写复杂的算法。

这极大地方便了我们在实际工作中的应用,节约了时间和精力。

总的来说,矩阵分解是一种强大的数学工具,在数据处理、信号处理、图像处理等领域有着广泛的应用。

掌握各种矩阵分解的方法,并灵活运用于实际问题中,将有助于提高工作效率和解决难题能力。

MATLAB作为强大的工具软件,为我们提供了丰富的矩阵分解函数,帮助我们更好地理解和利用矩阵分解的方法。

希望大家能够深入学习和应用矩阵分解,发挥其在科研和工程领域的巨大作用。

matlab 矩阵分解

matlab 矩阵分解

【原创实用版】

目录

1.MATLAB 简介

2.矩阵分解的概念与方法

3.MATLAB 中矩阵分解的函数与应用

4.矩阵分解的实际应用案例

5.总结

正文

【1.MATLAB 简介】

MATLAB 是一种广泛应用于科学计算、数据分析、可视化等领域的编程语言。

其强大的矩阵计算能力,使得 MATLAB 在矩阵分解等数学问题中具有极高的应用价值。

【2.矩阵分解的概念与方法】

矩阵分解是将一个矩阵表示为若干个矩阵的乘积,从而简化问题求解的过程。

常见的矩阵分解方法有奇异值分解 (SVD)、主成分分析 (PCA)、LU 分解等。

【3.MATLAB 中矩阵分解的函数与应用】

在 MATLAB 中,可以使用内置函数进行矩阵分解。

例如,使用"svd"函数进行奇异值分解,使用"pca"函数进行主成分分析,使用"lu"函数进行 LU 分解等。

这些函数在实际应用中可以帮助我们快速地对矩阵进行分解,从而简化问题的求解过程。

【4.矩阵分解的实际应用案例】

以奇异值分解为例,该方法在图像压缩、信号处理、数据降维等领域

具有广泛的应用。

通过将原始数据矩阵进行奇异值分解,可以得到一组新的基,从而实现对原始数据的压缩或特征提取。

【5.总结】

MATLAB 作为一种强大的科学计算工具,在矩阵分解等数学问题中具有极高的应用价值。

MATLAB中的矩阵分解与求逆技巧

MATLAB中的矩阵分解与求逆技巧一、LU分解LU分解是将一个矩阵分解为一个下三角矩阵L和一个上三角矩阵U 的乘积。

在MATLAB中,可以使用lu函数进行LU分解,示例代码如下:A=[1,2,3;4,5,6;7,8,10];[L, U] = lu(A);其中,A是需要分解的矩阵,L和U是分解得到的下三角和上三角矩阵。

LU分解常用于求解线性方程组。

二、QR分解QR分解是将一个矩阵分解为一个正交矩阵Q和一个上三角矩阵R的乘积。

在MATLAB中,可以使用qr函数进行QR分解,示例代码如下:A=[1,2,3;4,5,6;7,8,10];[Q, R] = qr(A);其中,A是需要分解的矩阵,Q和R是分解得到的正交矩阵和上三角矩阵。

QR分解常用于求解最小二乘问题和特征值问题。

三、奇异值分解奇异值分解(SVD)是将一个矩阵分解为一个正交矩阵U、一个对角矩阵Σ和一个正交矩阵V的乘积。

在MATLAB中,可以使用svd函数进行奇异值分解,示例代码如下:A=[1,2,3;4,5,6;7,8,10];[U, S, V] = svd(A);其中,A是需要分解的矩阵,U、S和V是分解得到的正交矩阵、对角矩阵和正交矩阵。

奇异值分解常用于矩阵压缩和降维。

四、矩阵求逆在MATLAB中,可以使用inv函数求一个矩阵的逆矩阵,示例代码如下:A=[1,2;3,4];A_inv = inv(A);其中,A是需要求逆的矩阵,A_inv是求得的逆矩阵。

需要注意的是,矩阵A必须是可逆的,否则将会抛出异常。

除了使用inv函数外,还可以使用左除法或右除法来求解线性方程组。

例如,对于方程组AX=B,可以使用X=A\B求解,示例代码如下:A=[1,2;3,4];B=[1;2];X=A\B;其中,A是系数矩阵,B是常数矩阵,X是未知数矩阵。

需要注意的是,系数矩阵A必须是可逆的,否则将无法求解。

以上是MATLAB中常用的矩阵分解和求逆技巧。

通过这些技巧,可以在MATLAB中方便地进行矩阵计算和线性方程组求解,提高计算效率和准确性。

matlab关于矩阵分解和变换的常用命令介绍

+

Review of Linear Algebra Introduction to Matlab

Machine Learning Group

Fall 2014

+

Outline

Linear Matrix

Algebra Basics

Calculus

Value Decomposition (SVD) Decomposition

For orthonormal matrices

For diagonal matrices

+

Dimensions

By Thomas Minka. Old and New Matrix Algebra Useful for Statistics

+

Examples

/

rank(A)

If

A is n by m, then

rank(A)<=

min(m,n) If n=rank(A), then A has full row rank If m=rank(A), then A has full column rank

+

Inverse of a matrix

Special matrices

a 0 0 0 b 0 0 0 c

a c 0 0 b d f 0 0 e g i

diagonal

a b 0 d 0 0

c e f

upper-triangular

0 0 tri-diagonal h j

+

Singular Value Decomposition (SVD)

matlab练习程序(非负矩阵分解)

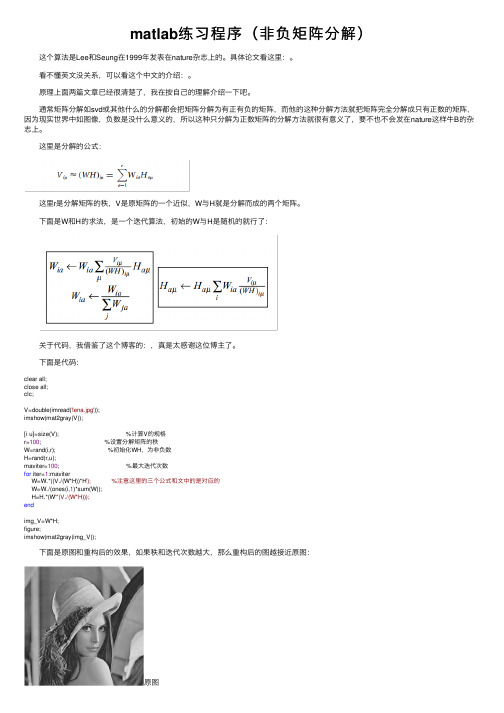

matlab练习程序(⾮负矩阵分解) 这个算法是Lee和Seung在1999年发表在nature杂志上的。

具体论⽂看这⾥:。

看不懂英⽂没关系,可以看这个中⽂的介绍:。

原理上⾯两篇⽂章已经很清楚了,我在按⾃⼰的理解介绍⼀下吧。

通常矩阵分解如svd或其他什么的分解都会把矩阵分解为有正有负的矩阵,⽽他的这种分解⽅法就把矩阵完全分解成只有正数的矩阵,因为现实世界中如图像,负数是没什么意义的,所以这种只分解为正数矩阵的分解⽅法就很有意义了,要不也不会发在nature这样⽜B的杂志上。

这⾥是分解的公式: 这⾥r是分解矩阵的秩,V是原矩阵的⼀个近似,W与H就是分解⽽成的两个矩阵。

下⾯是W和H的求法,是⼀个迭代算法,初始的W与H是随机的就⾏了: 关于代码,我借鉴了这个博客的:,真是太感谢这位博主了。

下⾯是代码:clear all;close all;clc;V=double(imread('lena.jpg'));imshow(mat2gray(V));[i u]=size(V); %计算V的规格r=100; %设置分解矩阵的秩W=rand(i,r); %初始化WH,为⾮负数H=rand(r,u);maviter=100; %最⼤迭代次数for iter=1:maviterW=W.*((V./(W*H))*H'); %注意这⾥的三个公式和⽂中的是对应的W=W./(ones(i,1)*sum(W));H=H.*(W'*(V./(W*H)));endimg_V=W*H;figure;imshow(mat2gray(img_V)); 下⾯是原图和重构后的效果,如果秩和迭代次数越⼤,那么重构后的图越接近原图:原图重构图因为这个是看⾃⼰相关⽅向论⽂偶然在⼀篇论⽂的引⽤中看到了这个算法,所以就稍微了解了⼀下,肯定有不妥的地⽅,就这样吧。

《机器学习》之降维方法-非负矩阵分解(附降维实战源码)

《机器学习》之降维方法-非负矩阵分解(附降维实战源码)大家好,我是机器侠~0.NMF的发展及原理非负矩阵分解(NMF,Non-negative matrix factorization)著名的科学杂志《Nature》于1999年刊登了两位科学家D.D.Lee 和H.S.Seung对数学中非负矩阵研究的突出成果。

该文提出了一种新的矩阵分解思想——非负矩阵分解(Non-negative Matrix Factorization,NMF)算法,即NMF是在矩阵中所有元素均为非负数约束条件之下的矩阵分解方法。

该论文的发表迅速引起了各个领域中的科学研究人员的重视:一方面,科学研究中的很多大规模数据的分析方法需要通过矩阵形式进行有效处理,而NMF思想则为人类处理大规模数据提供了一种新的途径;另一方面,NMF分解算法相较于传统的一些算法而言,具有实现上的简便性、分解形式和分解结果上的可解释性,以及占用存储空间少等诸多优点。

为高效处理这些通过矩阵存放的数据,一个关键的必要步骤便是对矩阵进行分解操作。

通过矩阵分解,一方面将描述问题的矩阵的维数进行削减,另一方面也可以对大量的数据进行压缩和概括。

利用矩阵分解来解决实际问题的分析方法很多,如PCA(主成分分析)、ICA(独立成分分析)、SVD(奇异值分解)、VQ(矢量量化)等。

在所有这些方法中,原始的大矩阵V被近似分解为低秩的V=WH形式。

这些方法的共同特点是,因子W和H中的元素可为正或负,即使输入的初始矩阵元素是全正的,传统的秩削减算法也不能保证原始数据的非负性。

在数学上,从计算的观点看,分解结果中存在负值是正确的,但负值元素在实际问题中往往是没有意义的。

例如图像数据中不可能有负值的像素点;在文档统计中,负值也是无法解释的。

1. NMF原理NMF的基本思想可以简单描述为:对于任意给定的一个非负矩阵V,NMF算法能够寻找到一个非负矩阵W和一个非负矩阵H,使它们的积为矩阵V。

nnmf函数

nnmf函数1. 简介在机器学习中,非负矩阵分解(Non-negative Matrix Factorization,简称NMF)是一种常用的矩阵分解方法。

NMF的基本思想是将一个非负矩阵V分解为两个非负矩阵W和H的乘积,即V ≈ WH。

这种分解可以被视为一种特征提取的方法,将原始的数据矩阵分解为两个具有物理意义的分量矩阵。

在Python中,SciPy库提供了一个用于执行NMF的函数,即nnmf函数。

本文将详细介绍nnmf函数的用法和原理,并给出一些示例代码。

2. nnmf函数的用法nnmf函数的用法非常简单,只需要将待分解的矩阵作为函数的输入参数,并指定分解得到的矩阵的维度。

下面是nnmf函数的基本用法示例:from scipy.linalg import nnmfV = # 待分解的矩阵k = # 分解得到的矩阵的维度W, H = nnmf(V, k)其中,V是待分解的矩阵,可以是一个numpy数组或者稀疏矩阵;k是分解得到的矩阵的维度,通常需要根据具体问题进行选择。

nnmf函数返回分解得到的两个矩阵W和H,其中W的维度为(V.shape[0], k),H的维度为(k, V.shape[1])。

通过调节参数k,可以控制分解得到的矩阵的维度,实现对原始数据的降维。

3. nnmf函数的原理NMF的基本思想是将原始矩阵V近似分解为两个非负矩阵W和H的乘积,即V ≈ WH。

该近似分解的目标是使得原始矩阵V的近似重构误差最小,即最小化||V -WH||。

具体来说,NMF的优化目标可以表示为以下形式的目标函数:argmin_{W,H}||V - WH||其中,||.||表示矩阵的Frobenius范数。

NMF的优化问题可以通过迭代的方式来求解。

nnmf函数采用的是交替最小二乘法(alternating least squares,ALS)来进行优化。

具体来说,ALS算法的求解过程如下:1.将初始解设为W(0)和H(0);2.固定H的值,更新W的值,使得目标函数最小化;3.固定W的值,更新H的值,使得目标函数最小化;4.重复步骤2和步骤3,直到目标函数收敛或达到最大迭代次数。